人脸表情识别作为人脸识别的一个重要分支,目前已经成为人机交互领域的一个研究热点,涉及到各种学科的研究,主要有:心理学、统计学、生物学、计算机学等,是一个比较新颖且有研究前景的方向。其应用也极其广泛,很多已经推广到市场上,进入了普通人的生活。如疲劳驾驶、网络教学、人机交互、医疗领域、娱乐行业。

心理学家Mehrabiadu[1]指出,面部表情在人们交流的过程中传达了55%的有用信息,而语言所传达的有用信息仅仅占到7%。计算机人脸表情识别起源于20世纪70年代末,Suwa等[2]将连续序列的人脸图像标记成20个特征点,并进行跟踪识别,与原模型进行对比以实现表情识别。Paul Ekman[3]通过研究,提出6种最基本的表情,分别是高兴、悲伤、惊奇、生气、厌恶、恐惧。随后他又在此基础上通过大量研究,建立不同的脸部肌肉运动与相应的面部表情映射关系,提出基于面部运动单元(44个运动单元)的面部表情编码系统(facial action coding system, FACS)[3]。随着计算机技术的进步、大数据时代的到来以及GPU等电脑硬件的发展,表情识别在软硬件上都得到了长足的发展,相应的研究机构与表情数据库以及新的算法也越来越多。2012年,在国际计算机视觉比赛ILSVRC上,Hinton和他的学生Alex[4]基于CNN搭建的AlexNet模型获得冠军,将识别率从74.3%提升到84.7%,实现了图像识别领域上的突破性、实质性的进展,此后,更多的学者加入到这一研究中。目前,深度学习算法已将ImageNet数据集的精度提高到了95.06%(人类在ImageNet数据集上的识别率约为94.9%[5])以上,这样的识别率已经跟人的识别能力相当甚至超过人类识别率。

不同的人脸表情数据库能影响表情识别的结果。随着人脸表情识别的研究深入,相应的表情数据库也越来越多,到目前为止,主要数据库有JAFFE[6]数据库、BHU[7]表情库、CK+[8]数据库、MMI[9]数据库、BU-3DFE[10]数据库、GEMEP[11]数据库、FER2013数据库[12]。

1 传统机器学习算法基于传统机器学习的人脸表情识别主要分为3部分:图像预处理、特征提取、特征分类。图像预处理是基础,特征提取是关键、特征分类是目标。

1.1 图像预处理图片预处理能直接影响到特征点的提取以及表情分类的结果,从而影响到表情的识别率。由于各种原因,图片通常会受到一些其他信号的污染,常见的有椒盐噪声(脉冲噪声)、高斯噪声、伽玛噪声、指数分布噪声、均匀分布噪声等。有些图片即使基本不含噪声也会有复杂的背景、光照强弱、遮挡物、年龄等干扰因素,而且,很多数据库的尺寸大小不同,且有些是彩色图像,有些是灰度图像,加之拍摄设备的良莠不齐,这些客观上的干扰因素有必要在识别前进行预处理。通常,图像预处理最主要的过程如图 1所示。

|

Download:

|

| 图 1 图像预处理过程 | |

对于一张输入图片,首先对其进行去噪处理,常用的去噪方法主要有均值滤波(average filter, AF)、中值滤波(median filtering, MF)、自适应中值滤波(adaptive median filtering, AMF)、维纳滤波(wiener filtering, WF)等;人脸检测已经发展成为一个独立的研究方向[13];而尺度、灰度归一化是从图片的色彩信息、图片尺寸大小等方面对图片进行处理,在保证人脸关键特征的前提下减少一定的运算量;最后,直方图均衡化使得图像效果增强。

1.2 特征提取特征提取是整个人脸表情识别系统中最核心的部分,如何在保证图片原有信息的前提下提取出人脸表情的有用信息,在很大程度上能提高人脸表情识别率。而多数特征提取又会出现维数过高等问题,导致出现维数灾难,因此,通常还需进行特征降维以及特征分解等处理。目前,各种特征提取算法不断被提出、改进。

1.2.1 Gabor特征提取Gabor[14]小波核函数具有与人类大脑皮层简单细胞的二维反射区相同的特性,可以更好地描述纹理特征。其最早由D.Gabor提出,基于傅里叶变换,由于Gabor变换无法聚焦,因此研究者又将小波理论与Gabor特征相结合,从而发展成Gabor小波变换。Yu等[15]在Gabor特征的基础上运用线性和非线性合成新的算法。Liu[16]为了解决Gabor无法获取局部表情特征而提出将2个Gabor进行多方向的特征融合算法。Wen[17]首先人工选定一个局部小区域,在此区域上提取Gabor小波系数,然后求其均值,并以此作为纹理特征。

1.2.2 局部二值算法局部二值算法(local binary pattern,LBP)[18]通过计算图像中所包含的每个像素与其局部邻域的点在亮度上的序关系,然后对二值序关系进行编码形成局部二值模式,最后采用多区域直方图作为图像的特征描述。基于LBP的改进算法主要有Guo提出的完全局部二值算法[19](CLBP),该算法较LBP识别性能更好,但同样会造成维数灾难,基于此,他又在Fisher准则的基础上改进了LBP算子(FCL-LBP)[20]。Feng[21]通过建立局部LBP直方图,并连接起来识别面部表情取得了很好的识别率。江南大学周宇旋[22]的改进LBP算法能对单一表情的特有特征做出选择,从而更好地识别人脸表情。Jabid和Chae[23]将LBP算法进一步改进成LDP算法(局部定向模式),该算法对光照具有很好的鲁棒性,且计算量相对较少。局部相位量化[24](LPQ)主要基于短时傅里叶变换,在特征提取上性能稳定。

1.2.3 ASM/AAM主动形状模型[25](active shape model, ASM)由Cootes提出,该算法基于统计模型,一般用来提取表情轮廓上的特征点,这一模型主要利用全局形状模型来匹配人脸初始形状,再建立局部纹理模型,从而较为精确地获取目标的轮廓特征[26]。主动外观模型(active appearance model, AAM)是在ASM基础上发展而来的,该算法克服了ASM采用全局特征的缺点,将局部纹理特征融入其中,同时利用了形状及纹理特征。Cristinacce[27]将PRFR(特征响应增强算子)与AAM融合,用以检测脸部各器官等局部边缘的特征点。侯婕[28]基于人脸各个表情器官改进了ASM算法,定位出人脸的118个特征点,大致将人脸各器官轮廓显示出来。Saatci[29]巧妙地将AAM与支持向量机(support vector machine, SVM)分类器进行级联,从而提高识别率。

1.2.4 Haar-like特征提取Haar-like特征由Viola提出, 如图 2所示,该算法是由几个矩形区域构成的特征模型,这些区域有相同的大小和形状,定义为黑色区域的像素值之和减去白色区域的像素值之和[30]。Haar-like对图像计算具有更高效的运算速度。Xu[31]融合haar-like与Adaboost算法,首先运用Haar-like得到最原始特征,计算整个图片的特征值,然后使用Adaboost进行训练,提取出不同的特征,构造特征子空间。

|

Download:

|

| 图 2 Haar-like特征 | |

光流法[33]是图像序列中的图像亮度/灰度的运动,即空间物体表面上点的运动速度在视觉传感器成像平面上的表达利用。利用Horn-Schunck(H-S)光流将二维速度场与灰度相结合,并对连续运动的人脸图像序列提取运动目标特征;赵晓健[34]为了解决运动物体特征提取的困难,提出一种融合稠密光流轨迹和稀疏编码框架的无监督行为特征提取方法(DOF-SC),该算法对以DOF(稠密光流)轨迹为中心的原始图像进行采样,以此作为轨迹的原始特征。该算法不需采用人工标记特征点,从而降低了一定的复杂度,且采用稀疏矩阵表示特征,理论上不需要降维处理,从而降低了计算机的负荷量。

1.2.6 特征点跟踪法Yun[35]经过研究从视频流上自动提取出20多个点作为人脸模型的特征点,然后运用粒子滤波器来跟踪这些特征点,构建出一个可变的3D表情识别模型。刘玉等[36]提出一种融合KLT和SIFT的特征点跟踪方法,该算法通过对SIFT进行改进,使得特征点分布均匀,不存在聚集现象,然后对KLT匹配算法进行分层迭代设计,在目标发生明显姿态和大小变化条件下,可快速跟踪匹配。

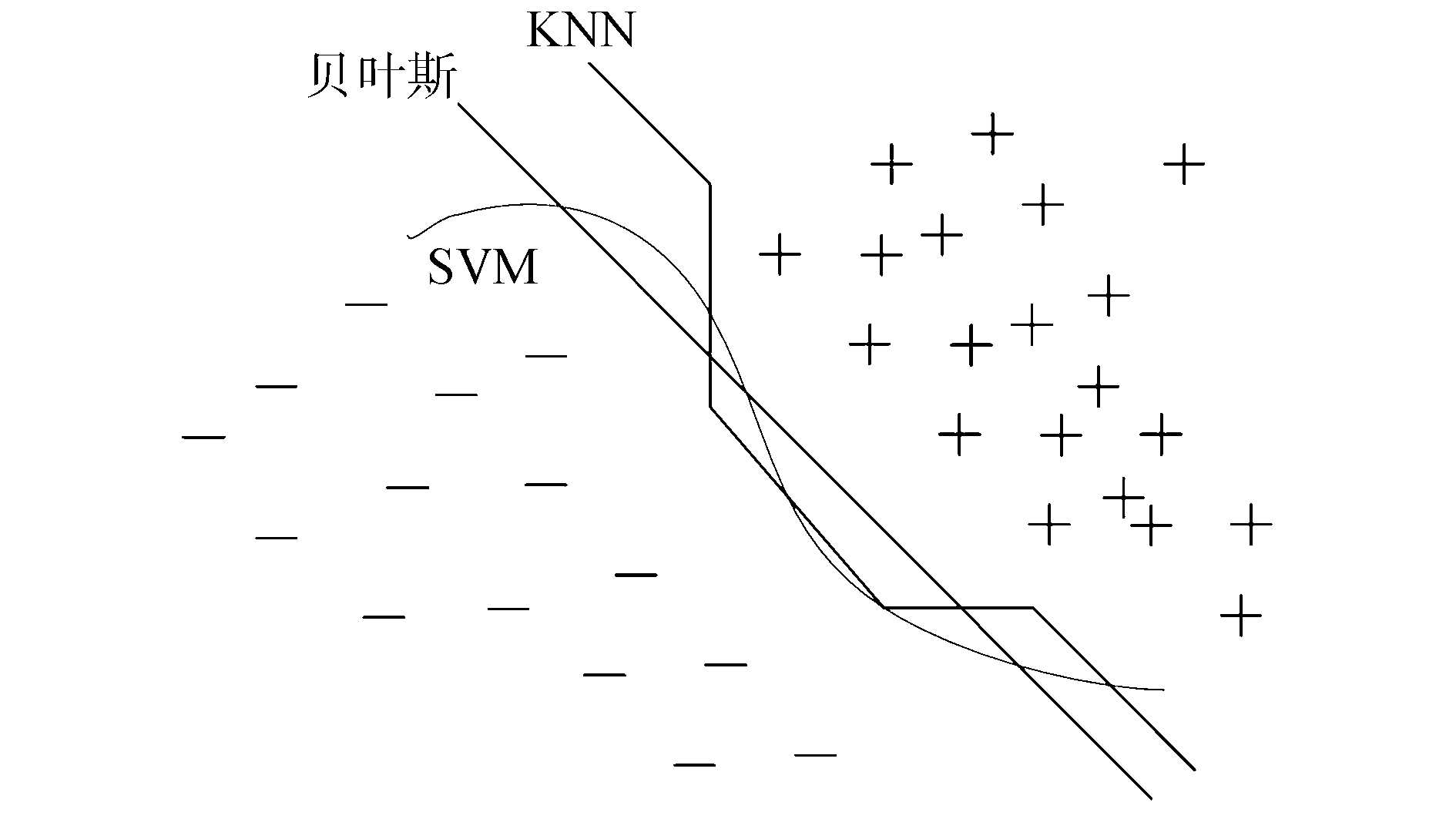

1.3 特征分类算法特征提取完成后,为了降低计算机的计算量,当维数过高时还需特征降维,常用的降维方法有PCA降维法、LDA降维法。影响表情识别率高低的另一关键是如何选取合适的分类器对特征进行分类,通过分类器将待识别表情成功预测成人脸表情。人脸表情识别常见的特征分类算法有K-NN分类算法、SVM分类算法、Adaboost分类算法、贝叶斯分类算法、隐马尔可夫模型分类算法、DBN分类算法等。

1.3.1 K-NN算法最近邻算法中K为可调参数,计算机能否寻找最合适的K值是分类性能好坏的关键。K-NN[32]分类器从测试数据中寻找K个最近邻样本集,把训练好的标签作为样本标签,具有这个样本上的属性。K-NN是一种直接分类未知数据集标签并让计算机自己来“命名”标签的算法。该算法思路简单、容易实现,且所需的样本集不需太大,但该算法分类速度较慢,每当有新样本加入时都要与训练集比较,且各属性的权值一样,导致分类准确率有一定程度的降低。

1.3.2 SVM算法支持向量机即在支持平面上把两类类别划分开来的超平面向量点的算法,SVM[30]基于VC维理论以及结构风险最小原理。通过提供有限样本数据信息,在复杂模型上寻找最优折衷方案,获得最佳的泛化能力;通过核函数将线性不可分的数据映射到更高维次,转化成线性可分的。通过引入核函数,计算机可以有效处理高维数据,一定程度上避免了维数灾难。

1.3.3 Adaboost算法Adaboost[41]算法是一个经典的二分类器算法,通过迭代找出当前训练样本集权重分布的最佳弱分类器,根据该弱分类器调整权重参数,调高分类有误样本的权重参数。在满足阈值的迭代次数后,将若干弱分类器合成一个强分类器。

1.3.4 贝叶斯分类贝叶斯网络[42]是一种基于统计学上的概率网络,通过概率推理将网络图形化。该算法的核心思想即为贝叶斯公式。贝叶斯算法常应用于目标识别、跟踪、医疗诊断、生物学、编码学等。

1.4 算法内在联系与发展趋势传统机器学习算法之间既有区别又有联系,Gabor小波对多尺度、多方向纹理特征变换有很好的鲁棒性,相对其他算法能更好地检测其变化,同时对光照强弱不敏感。但Gabor小波通常作用于全局特征,因此耗费内存大。相比较而言,LBP算子存储空间更少,计算效率更高,但LBP算子对加入噪声的图片,特征提取效率低,同时只考虑图片中心与邻域的像素特征,忽略差值幅度,会导致部分有用特征信息丢失。对于表情特征提取而言,Harr被证明更具优势,因其描述的是面部的局部灰度变化,当全局区域光照稳定时,Harr能提取更多的面部运动单元变化信息。对于AAM与ASM,AAM建立在ASM基础之上,ASM执行效率更高,AAM相对复杂,能更好地拟合纹理特征,识别率相对ASM更高。特征分类方面,SVM应用相对更加广泛,SVM通常先在训练集训练模型,然后用训练好的模型对测试集进行分类,而KNN没有训练过程,仅度量训练数据之间的欧式距离,以此实现分类,原理简单。而Adaboost是通过对训练样本的重采样,解决训练样本不足造成的训练精度低的问题,通常用Adaboost来增强SVM的分类能力。几种分类算法工作机制基本类似[43],如图 3所示,无论哪种分类算法都是由机器学习出一种分类边界,只是有的相对复杂(+,-代表两种类别)。

|

Download:

|

| 图 3 不同分类标准能产生相同的预测结果 | |

表 1列出了部分传统机器学习算法所采用的特征、分类算法及其识别率和所用的数据库。传统机器学习算法经过不断发展,目前已经相对成熟,后续研究方向主要朝向微表情[33]、负面表情发展,如何快速捕捉脸部微表情变化以及解决负面表情识别率较低等问题是研究者需要探索的。

|

|

表 1 部分机器学习算法识别结果 |

2016年AlphaGo与李世石在围棋上的博弈,最终AlphaGo以4:1战胜李世石,这场人机大战表明机器已经在某种程度上战胜人脑。目前传统的机器学习方法已难以满足大数据时代在处理时效、性能以及更加智能化等方面的需求,而深度学习表现了优良的信息处理能力,尤其在分类、识别、目标检测等方面,自2012年以来,成为国内外研究热点,更是在2015年入选Science American年度十大改变世界的创新技术之一[44]。在人脸表情识别方面,深度学习避免了繁琐的图片预处理以及特征提取,较传统方法表现更加优良,对光照、姿态、遮挡物等表情识别鲁棒性更好。

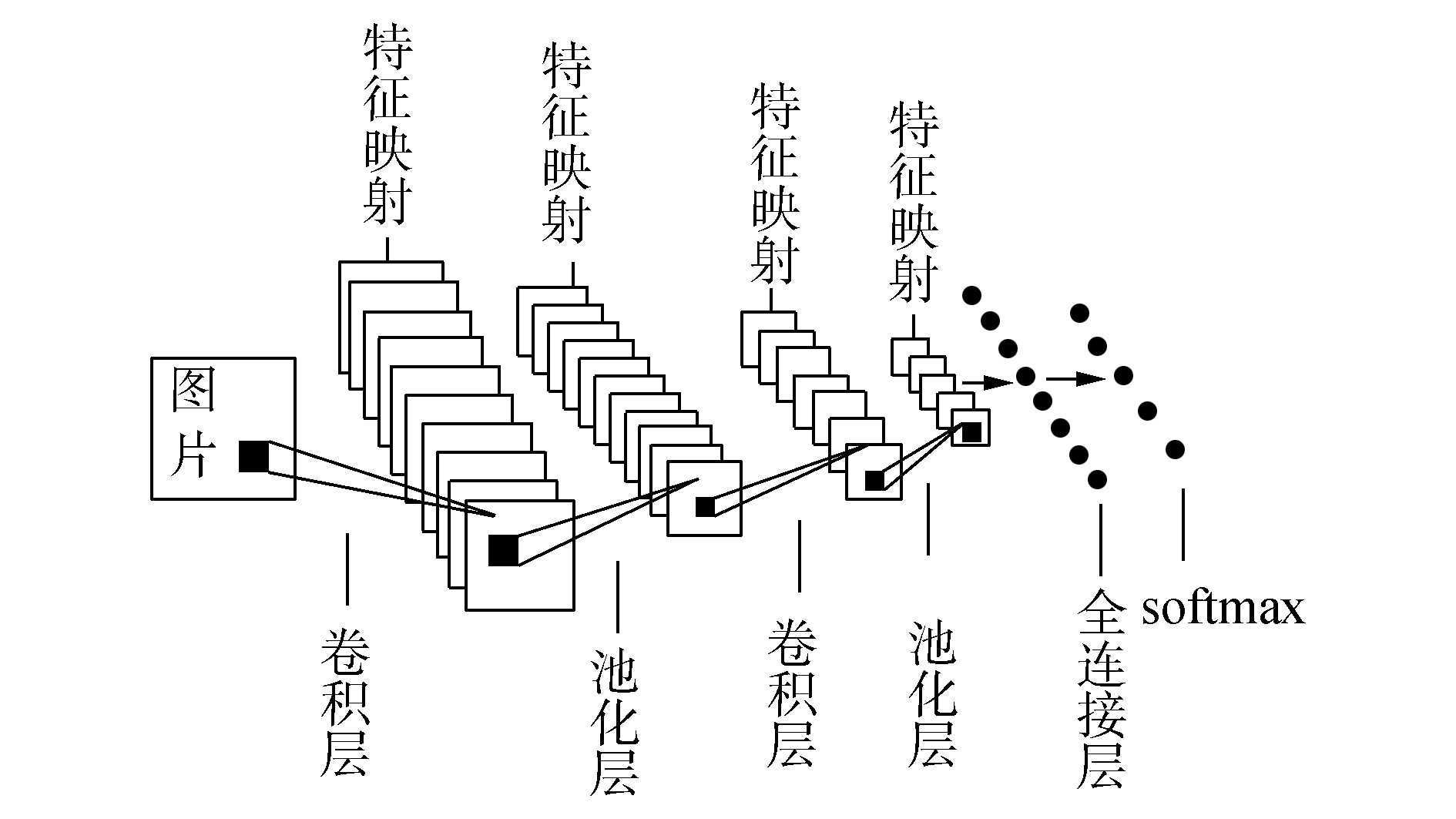

2.1 CNNCNN(convolutional neural network)是一种端到端(end to end)的模式,是人工神经网络(artificial neural network, ANN)的一种改进,其灵感来自研究猫的初级视觉皮层:简单细胞通过接受局部感受野特定边缘发出来的刺激作为响应,以此作为复杂细胞的输入,其网络结构如图 4所示。CNN最大的特点是局部连接性以及权值共享性。这使得网络参数减少,训练速度更快,且有一定的正则化效果。CNN是一个复杂的神经网络,损失函数[50]是评价预测值与真实值之间吻合度的一个评估准则,常用的损失函数有Softmax分类器的互熵损失、hinge损失、L2范数损失、L1范数损失。CNN能解决非线性问题的关键是激活函数[52], 通过函数把“激活的神经元的特征”保留并映射出来,常用的激活函数有tanh、sigmoid、softsign、ReLU、LReLU等。为了防止网络层数过深造成的过拟合现象,增加其泛化能力,CNN一般需要进行正则化操作[52]。常用正则化方法有数据扩增、dropout、L2正则化、dropconnect。另一方面,CNN采用pooling[51](池化层)操作最大限度的降低网络复杂度,让CNN保持一定的局部不变性,从而更加接近动物视觉皮层机制。

|

Download:

|

| 图 4 CNN网络结构 | |

深度信念网络(deep belief network,DBN)基于受限玻尔兹曼机(restricted boltzmannmachine, RBM), 由一层反向前馈传播网络和深度RBM组成。RBM模型将前层输出作为后层输入,进行多个RBM层叠,而每层RBM都包含一个隐层与可见层,与BM(玻尔兹曼机)不同,RBM并没有连接每层的神经元,而是将隐层与可见层通过权值双向连接两层之间的节点。DBN的网络结构与人脑结构的认知过程类似,其对输入信号的提取特征为非监督、逐层抽象提取[38]。DBN是一个从低到高的逐层自主学习过程,具有主动性、准确性的特点。不足是收敛速度慢,容易收敛到局部最优。

2.3 主要算法优化及发展方向深度学习经过几年的发展,在表情识别领域已取得一定成果,Yu[54]构建一个9层CNNs结构,在最后一层连接层采用softmax分类器将表情分为7类,该模型在SFEW2.0数据集上识别率达到61.29%。Lopes[55]在CNN网络前加入预处理过程,探索预处理对精度的影响,最终识别率在CK+数据集上达到97.81%,且训练时间更短。Wang[56]采用softmax训练CNN模型,用triple损失函数调参,并且运用数据增强手段,将识别率提高2%,该模型对难以区分的类间表情(如生气和厌恶)表现优良。Zhao[57]融合MLP和DBN,将DBN无监督特征学习的优势和MLP的分类优势联系起来以提高性能。He[38]结合深度学习与传统机器学习,首先运用LBP/VAR提取初次特征,以初次特征作为DBN的输入实现分类。Li[58]为了解决DBN忽略图片局部特征的问题,将CS-LBP与DBN进行融合。深度学习发展至今,各种模型及其变体被提出,基本模型已不能满足性能需求,结合大量文献数据,人脸表情识别未来发展方向主要体现在提高网络深度、混合模型、与传统机器学习结合、迁移学习、无监督学习等方面,同时移动终端的开发也开始受到关注。

2.4 常用应用框架一个好的开发框架能加快深度学习的开发速度,目前几个主流深度学习框架有:Theano[45]在深度学习中有着鼻祖级的地位,开发于2007年,基于Python,非常适合数据探索,但由于本身太过底层,不支持分布式,因此越来越多的研究者去开发Tensorflow;Tensorflow[46]由google在2015年开源,目前已成为GitHub上最受欢迎的机器学习开源项目,其灵活、通用、可视化良好、可移动的优点让它既可以做研究也适合做产品开发;Keras[47]是深度学习开源框架中的新兴框架,其后台基于(Theano/Tensorflow),采用Python编写,具有容易入门的优点;Caffe[48]开发于2013年,在深度学习框架中有着很重要的地位,尤其在图像分类方面,在研究界代表一流水准,但是它并不能很好地适用于其他深度学习应用,比如语音、文字处理;Torch[49]基于Lua语言编写,由于大多数开发者对Lua比较陌生,导致其推广较难,但其灵活度很高,很容易编写自己的层级,而且有很多训练好的模型。

3 结论深度学习目前已成为计算机视觉等众多科研领域的研究热点。在人脸表情识别领域,深度学习很好地解决了传统机器学习对人脸姿态、光照、遮挡物等敏感问题,提高了表情识别的鲁棒性。传统的人脸表情识别研究有的已经转向微表情方向,有的从2D转向3D人脸建模,构造三维人脸表情识别系统。但这并不代表传统机器学习方法已经被淘汰,结合深度学习,传统机器学习算法或许可以焕发新生。目前传统机器学习与深度学习存在以下需要解决的问题。

1) 深度学习是数据驱动的,带有标注的海量数据集是深度学习算法的基石,正因为有ImageNet这样百万量级且带有标签的数据,才有CNN在ILSVRC等大赛上的表现。但实际上,要构造一个海量且带有标注的数据库显得尤为困难,如何自动给海量无标记数据添加标签也是一个需要重视的方向。

2) 传统机器学习算法在小数据样本分析上占绝对优势,深度学习算法在小样本情况下易发生过拟合现象,如何将这两种现象折衷,创新出一种既能在小数据样本上表现良好,又能在大数据上表现优异的算法是人脸表情识别研究亟待解决的一个关键性问题。

3) 深度学习虽在人脸表情等分类领域具有优良的性能,但目前其理论知识尚不完备,大多数学者都是通过调参的方法去提高识别率,把深度学习当作一个黑匣子使用,如何用理论知识指导实践,用实践促进理论知识的理解是研究者需要解决的。

4) 虽然深度学习在训练好模型之后,识别效率很快,但是在训练阶段是一个漫长的过程,即便采用GPU等硬件加速,对于更深层网络,更海量的数据下训练模型,往往需要花费研究者数天或者更长时间的训练。

5) 表情区分不够细致,目前大部分表情库仍以高兴、悲伤、惊奇、愤怒、厌恶、恐惧、中性等7种基本表情为主,很少有包含更多细微表情的数据库,这成为人机交互走向更加智能化道路的一道阻碍。

综上所述,如何处理与理解深度学习与传统机器学习的关系,取长补短,是未来人脸表情识别研究的重点与方向。

| [1] |

MEHRABIAN A, RUSSELL J A. An approach to environmental psychology[M]. Cambridge, MA: MIT, 1974.

( 0) 0)

|

| [2] |

SUWA M, SUGIE N, FUJIMORA K. A preliminary note on pattern recognition of human emotional expression[C]//Proceedings of the 4thInternational Joint Conference on Pattern Recognition. Kyoto, Japan, 1978: 408-410. http://ci.nii.ac.jp/naid/10000046950

( 0) 0)

|

| [3] |

EKMAN P, FRIESEN W V, HAGERJ C. Facial action coding system(FACS)[M]. Manual, Salt Lake City (USA): A Human Face, 2002.

( 0) 0)

|

| [4] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe, Nevada, 2012: 1097-1105. http://dl.acm.org/citation.cfm?id=2999257

( 0) 0)

|

| [5] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Delving deep into rectifiers: surpassing human-level performance on ImageNetclassification[C]//Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile, 2015: 1026-1034. http://arxiv.org/abs/1502.01852

( 0) 0)

|

| [6] |

LYONSM J, KAMACHIM, GYOBA J. The Japanese Female FacialExpression(JAFFE)database[EB/OL]. http://www.kasrl.org/jaffe.html.

( 0) 0)

|

| [7] |

薛雨丽, 毛峡, 张帆. BHU人脸表情数据库的设计与实现[J]. 北京航空航天大学学报, 2007, 33(2): 224-228. ( 0) 0)

|

| [8] |

LUCEY P, COHN J F, KANADE T, et al. The Extended Cohn-Kanade Dataset (CK+): a complete dataset for action unit and emotion-specified expression[C]//Proceedings of 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Recognition-Workshops. San Francisco, CA, USA, 2010: 94-101. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=5543262

( 0) 0)

|

| [9] |

VALSTAR M F, PANTICM. Induced disgust, happiness and surprise: an addition to the MMI facialexpression database[C]//Proceedings of Int'l Conference on Language Resources and Evaluation, Workshop on EMOTION. Malta, 2010: 65-70. http://www.researchgate.net/publication/284473673_Induced_disgust_happiness_and_surprise_An_addition_to_the_mmi_facial_expression_database

( 0) 0)

|

| [10] |

YIN Lijun, WEI Xiaozhou, SUN Yi, et al. A 3D facial expression database for facial behavior research[C]//Proceedings of the 7th International Conference on Automatic Face and Gesture Recognition. Southampton, UK, 2006: 211-216. http://dl.acm.org/citation.cfm?id=1126340

( 0) 0)

|

| [11] |

VALSTAR M F, MEHU M, JIANG Bihan, et al. Meta-analysis of the first facial expression recognition challenge[J]. IEEE transactions on systems, man, part B (cybernetics), 2012, 42(4): 966-979. DOI:10.1109/TSMCB.2012.2200675 ( 0) 0)

|

| [12] |

GOODFELLOW I J, ERHAN D, CARRIER P L, et al. Challenges in representation learning: a report on three machine learning contests[M]//LEE M, HIROSEA, HOU Zengguan, et al. Neural Information Processing. Berlin Heidelberg: Springer, 2013.

( 0) 0)

|

| [13] |

YANGM H, KRIEGMAN D J, AHUJA N. Detecting faces inimages:a survey[J]. IEEE transactions on patternanalysis and machine intelligence, 2002, 24(1): 34-58. DOI:10.1109/34.982883 ( 0) 0)

|

| [14] |

LEE T S. Image representation using 2D Gabor wavelets[J]. IEEE transactions on pattern analysis and machine intelligence, 1996, 18(10): 959-971. DOI:10.1109/34.541406 ( 0) 0)

|

| [15] |

YU Jiangang, BHANU B. Evolutionary feature synthesis for facial expression recognition[J]. Pattern recognition letters, 2006, 27(11): 1289-1298. DOI:10.1016/j.patrec.2005.07.026 ( 0) 0)

|

| [16] |

LIU Shuaishi, TIAN Yantao, WAN Chuan. Facial expression recognition method based on Gabor multi-orientationfeatures fusion and block histogram[J]. Actaautomaticasinica, 2011, 37(12): 1455-1463. ( 0) 0)

|

| [17] |

WEN Zhen, HUANG T S. Capturing subtle facial motions in 3D face tracking[C]//Proceedings of the 9th IEEE International Conference on Computer Vision. Nice, France, 2003: 1343-1350. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=1238646

( 0) 0)

|

| [18] |

AHONEN T, HADID A, PIETIKÄINEN M. Face recognition with local binary patterns[M]//PAJDLA T, MATASJ. Computer Vision-ECCV 2004. BerlinHeidelberg: Springer, 2004: 469-481.

( 0) 0)

|

| [19] |

GUO Zhenhua, ZHANG Lei, ZHANG D. A completed modeling of local binary pattern operator for texture classification[J]. IEEE transactions on image processing, 2010, 19(6): 1657-1663. DOI:10.1109/TIP.2010.2044957 ( 0) 0)

|

| [20] |

GUO Yimo, ZHAO Guoying, PIETIKÄINEN M. Discriminative features for texture description[J]. Pattern recognition, 2012, 45(10): 3834-3843. DOI:10.1016/j.patcog.2012.04.003 ( 0) 0)

|

| [21] |

FENG X, PIETIKÄINEN M, HADID A. Facial expression recognition based on local binary patterns[J]. Pattern recognition and image analysis, 2007, 17(4): 592-598. DOI:10.1134/S1054661807040190 ( 0) 0)

|

| [22] |

周宇旋, 吴秦, 梁久祯, 等. 判别性完全局部二值模式人脸表情识别[J]. 计算机工程与应用, 2017, 53(4): 163-169, 194. ( 0) 0)

|

| [23] |

JABID T, KABIR M H, CHAE O. Robust facial expression recognition based on local directional pattern[J]. ETRI journal, 2010, 32(5): 784-794. DOI:10.4218/etrij.10.1510.0132 ( 0) 0)

|

| [24] |

LONARE A, JAIN S V. A survey on facial expression analysis for emotion recognition[J]. International journal of advanced research in computer and communication engineering, 2013, 2(12): 4647-4650. ( 0) 0)

|

| [25] |

COOTES T F, TAYLOR C J, COOPER D H, et al. Active shape models-their training and application[J]. Computer vision and image understanding, 1995, 61(1): 38-59. DOI:10.1006/cviu.1995.1004 ( 0) 0)

|

| [26] |

黄建, 李文书, 高玉娟. 人脸表情识别研究进展[J]. 计算机科学, 2016, 43(S2): 123-126. ( 0) 0)

|

| [27] |

CRISTINACCE D, COOTES T, SCOTT I. A multi-stage approach to facial featuredetection[C]//Proceedings of the British Machine Vision Conference. Kingston, 2004: 231-240. http://www.researchgate.net/publication/228953215_A_multi-stage_approach_to_facial_feature_detection

( 0) 0)

|

| [28] |

侯婕. 人脸表情计算技术研究[D]. 苏州: 苏州大学, 2014. http://cdmd.cnki.com.cn/Article/CDMD-10285-1014297091.htm

( 0) 0)

|

| [29] |

SAATCI Y, TOWN C. Cascaded classification of gender and facial expression using active appearance models[C]//Proceedings of the 7th International Conference on Automatic Face and Gesture Recognition. Southampton, UK, 2006: 393-398. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=1613052

( 0) 0)

|

| [30] |

XU Chao, DONG CAICHAO, FENG ZHIYONG, et al. Facial expression pervasive analysis based on Haar-like features and SVM[M]//KHACHIDZEV, WANG T, SIDDIQUI S, et al. Contemporary Research on E-business Technology and Strategy. BerlinHeidelberg: Springer, 2012: 521-529.

( 0) 0)

|

| [31] |

周书仁. 人脸表情识别算法分析与研究[D]. 长沙: 中南大学, 2009. http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=Y1538643

( 0) 0)

|

| [32] |

LIEW C F, YAIRI T. Facial expression recognition and analysis:a comparison study of feature descriptors[J]. IPSJ transactions on computer vision and applications, 2015, 7: 104-120. DOI:10.2197/ipsjtcva.7.104 ( 0) 0)

|

| [33] |

姜波, 解仑, 刘欣, 等. 光流模值估计的微表情捕捉[J]. 浙江大学学报:工学版, 2017, 51(3): 577-583, 589. ( 0) 0)

|

| [34] |

赵晓健, 曾晓勤. 基于稠密光流轨迹和稀疏编码算法的行为识别方法[J]. 计算机应用, 2016, 36(1): 181-187. DOI:10.11772/j.issn.1001-9081.2016.01.0181 ( 0) 0)

|

| [35] |

TIE Yun, GUAN Ling. A deformable 3-D facial expression model for dynamic human emotional state recognition[J]. IEEE transactions on circuits and systems for video technology, 2013, 23(1): 142-157. DOI:10.1109/TCSVT.2012.2203210 ( 0) 0)

|

| [36] |

刘玉, 王敬东, 李鹏. 一种基于SIFT和KLT相结合的特征点跟踪方法研究[J]. 宇航学报, 2011, 32(7): 1618-1625. ( 0) 0)

|

| [37] |

SALAKANIDOU F, MALASSIOTIS S. Real-time 2D+3D facial action and expression recognition[J]. Pattern recognition, 2010, 43(5): 1763-1775. DOI:10.1016/j.patcog.2009.12.009 ( 0) 0)

|

| [38] |

HE Jun, CAI Jianfeng, FANG Lingzhi, et al. Facial expression recognition based on LBP/VAR and DBN model[J]. Application research of computers, 2016, 33(8): 2509-2513. ( 0) 0)

|

| [39] |

ZHAN Yongzhao, CHENG Keyang, CHEN Yabi, et al. A new classifier for facial expression recognition:fuzzy buried Markov model[J]. Journal of computer science and technology, 2010, 25(3): 641-650. DOI:10.1007/s11390-010-9353-x ( 0) 0)

|

| [40] |

李栋. 基于局部纹理特征融合的面部表情识别方法研究[D]. 长春: 吉林大学, 2014. http://cdmd.cnki.com.cn/Article/CDMD-10183-1014266133.htm

( 0) 0)

|

| [41] |

李文书, 何芳芳, 钱沄涛, 等. 基于Adaboost-高斯过程分类的人脸表情识别[J]. 浙江大学学报:工学版, 2012, 46(1): 79-83. ( 0) 0)

|

| [42] |

解仑, 卢亚楠, 姜波, 等. 基于人脸运动单元及表情关系模型的自动表情识别[J]. 北京理工大学学报, 2016, 36(2): 163-169. ( 0) 0)

|

| [43] |

DOMINGOS P. A few useful things to know about machine learning[J]. Communications of the ACM, 2012, 55(10): 78-87. DOI:10.1145/2347736 ( 0) 0)

|

| [44] |

刘栋, 李素, 曹志冬. 深度学习及其在图像物体分类与检测中的应用综述[J]. 计算机科学, 2016, 43(12): 13-23. DOI:10.11896/j.issn.1002-137X.2016.12.003 ( 0) 0)

|

| [45] |

BASTIEN F, LAMBLIN P, PASCANU R, et al. Theano: new features and speed improvements[J]. arXiv: 1211. 5590, 2012. http://arxiv.org/abs/1211.5590

( 0) 0)

|

| [46] |

ABADI M, BARHAM P, CHEN Jianmin, et al. TensorFlow: a system for large-scale machine learning[C]//Proceedings of the 12th USENIX conference on Operating Systems Design and Implementation. Savannah, GA, USA, 2016. http://arxiv.org/abs/1605.08695v2

( 0) 0)

|

| [47] |

SUI Xudong, ZHANG Jinfang, HU Xiaohui, et al. Monitoring target through satellite images by using deep convolutional networks[M]//LEE R. Software Engineering Research, Management and Applications. Cham: Springer, 2016.

( 0) 0)

|

| [48] |

JIAYangqing, SHELHAMER E, DONAHUE J, et al. Caffe: convolutional architecture for fast feature embedding[J]. Arxiv: 1408. 5093, 2014. http://arxiv.org/abs/1408.5093

( 0) 0)

|

| [49] |

BOJARSKI M, DEL TESTA D, DWORAKOWSKI D, et al. End to end learning for self-driving cars[J]. arXiv: 1604. 07316, 2016. http://arxiv.org/abs/1604.07316

( 0) 0)

|

| [50] |

CS231nconvolutionalneuralnetworksforvisualrecognition[EB/OL]. http://cs231n.github.io/neural-networks-2/.

( 0) 0)

|

| [51] |

ZHAO Shichao, LIU Yanbin, HAN Yahong, et al. Pooling the convolutional layers in deep ConvNets for video action recognition[J]. arXiv: 1511. 02126, 2015. http://ieeexplore.ieee.org/document/7878535/

( 0) 0)

|

| [52] |

薛昆南. 基于卷积神经网络的视觉识别研究[D]. 广州: 华南农业大学, 2016. http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=D01037455

( 0) 0)

|

| [53] |

LAJEVARDI S M, HUSSAIN Z M. Higher order orthogonal moments for invariant facial expression recognition[J]. Digital signal processing, 2010, 20(6): 1771-1779. DOI:10.1016/j.dsp.2010.03.004 ( 0) 0)

|

| [54] |

YU Zhiding, ZHANG Cha. Image based static facial expression recognition with multiple deep network learning[C]//Proceedings of 2015 ACM on International Conference on Multimodal Interaction. Seattle, Washington, USA, 2015: 435-442.

( 0) 0)

|

| [55] |

LOPES A T, DE AGUIAR E, OLIVEIRA-SANTOS T. A facial expression recognition system using convolutional networks[C]//Proceedings of the 28th SIBGRAPI Conference on Graphics, Patterns and Images. Salvador, Brazil, 2015: 273-280. http://ieeexplore.ieee.org/document/7314574/

( 0) 0)

|

| [56] |

WANG Jieru, YUAN Chun. Facial expression recognition with multi-scale convolution neural network[M]//CHEN Enqing, GONG Yihong, TIE Yun. Advances in Multimedia Information Processing-PCM 2016. Cham: Springer, 2016.

( 0) 0)

|

| [57] |

ZHAO Xiaoming, SHI Xugan, ZHANG Shiqing. Facial expression recognition via deep learning[J]. IETE technical review, 2015, 32(5): 347-355. DOI:10.1080/02564602.2015.1017542 ( 0) 0)

|

| [58] |

LI Chen, WEI Wei, WANG Jingzhong, et al. Face recognition based on deep belief network combined with center-symmetric local binary pattern[M]//PARK J J, JIN Hai, JEONG Y S, et al. Advanced Multimedia and Ubiquitous Engineering. Singapore: Springer, 2016.

( 0) 0)

|

2018, Vol. 45

2018, Vol. 45