2. 日本德岛大学 智能信息工学部,日本 德岛 7708501

2. Department of Intelligent Information Engineering, Tokushima University, Tokushima 7708501, Japan

语音情感识别是人工智能的一个重大研究领域。人机交互中,语音是最直接的交流方式,对人的情感和认知的研究是人工智能的一个质的进步。语音情感识别是利用计算机对输入语音的情绪状态进行自动化识别。它在心理健康监测、教育辅助、个性化内容推荐、客户服务质量监测等领域具有广阔的应用前景。

目前的语音情感识别主要由以下几个过程构成:预处理、特征提取和情感分类。预处理方面的研究主要集中在数据库的处理和降噪等方面。当使用机器学习进行语音情感识别时,经常需要大量的训练数据,若数据集太少,则会出现过拟合的缺陷。为了能够在小样本数据集上进行算法的训练识别,对样本引进增强变换,增加样本数据量[1],可以达到提高识别率的目的。Chatziagapi等[2]使用生成对抗性网络(generative adversarial nets, GANs)生成声谱图,对原有的样本进行数据增强,在IEMOCAP和FEEL-25k情感数据库上得到的未加权平均召回率为53.6%和54.6%。语音样本中夹杂着混响和附加噪声,这对语音情感识别的性能有不利影响。在预处理阶段,减少或消除混响和加性噪声称为去噪,也称为语音增强[3]。任福继等[4]在2016年提出了一种通过人工修改标签和降低噪音来对数据集进行预处理的方法。川濑友子等[5]提出了一种自动切换降噪参数的方法,使得自动语音识别的准确率最大化。然而,大多数的去噪方法都不能很好地滤除噪音,因为信噪比和峰值信噪比太小。由于不可能对这种高噪声数据进行完全去噪,Yousefi等[6]提出采用增强方法来提高数据质量。但是语音情感识别领域中,使用数据增强方法来提高识别率的研究较少,多被用于图像识别。

与特征提取方面相关的研究有特征选择和特征融合等。Reda Elbarougy等[7]认为,在提取情感特征时,应该考虑声学特征和情感状态之间的相关性。在语音情感识别中,特征选择是提高识别准确率的重要步骤。从语音信号中可以提取出多个特征,然而哪一组特征与说话人的情绪状态最相关还在研究中。到目前为止,与情绪状态相关的特征少之又少。关于情感识别分类阶段,也有不少研究者提出了各种情感分类算法,并推陈出新。Karttikeya等[8]提出了2种监督式学习的语音情感识别方法,但是由于训练样本稀少,在IEMOCAP语料库的识别率只达到了69.1%。

本文针对语音样本不足和现阶段语音情感识别提取的无关特征多的问题,提出了面向数据增强的语音情感识别方法。

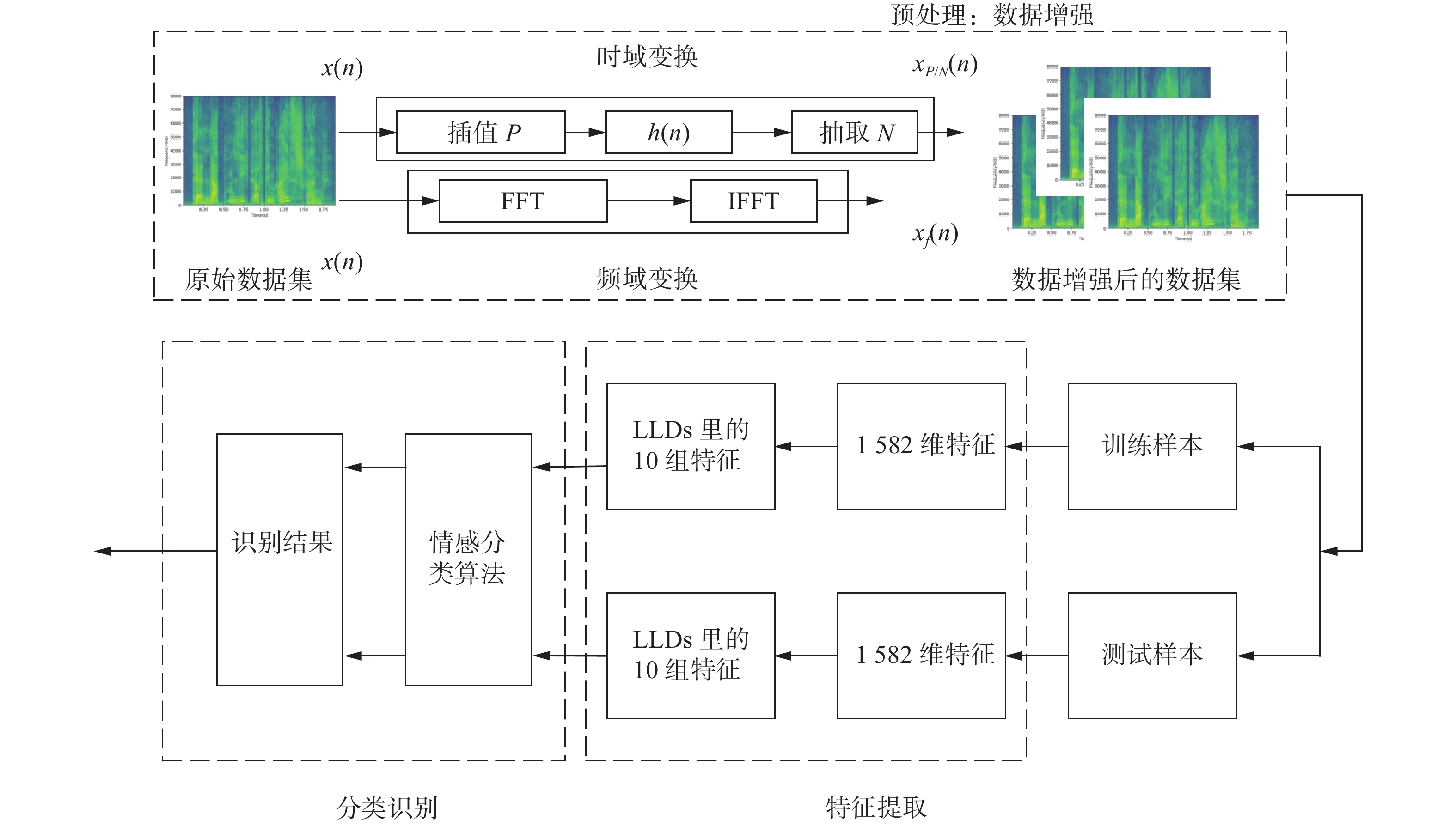

1 研究方法本节介绍了一种面向数据增强的语音情感识别方法,其系统总体结构如图1所示。系统包括预处理、特征提取与分类识别3个过程。在预处理阶段,原始数据集的声音样本首先经过时域和频域2个方向的数据增强形成新的样本。新生成的样本与原始的情感数据库被一起送入特征提取部分。在特征提取过程,使用openSMILE2.3.0提取1 582维的情感特征和10组低级描述特征,然后按照训练和测试比例6:1的概率送入3种分类算法模型中,最后对比得到每种情感的识别结果。

|

Download:

|

| 图 1 基于数据增强的语音情感识别系统 Fig. 1 Speech emotion recognition system based on data enhancement | |

数据增强对解决数据过拟合问题有极大的帮助,主要应用于现在的图像识别等领域,而在语音识别领域的数据增强方法甚少。它是指通过增大训练的数据集来充分利用已有的数据集,达到提高识别率的目的。目前图像识别领域常用的数据增强方法有旋转、翻转变换、缩放变换、噪声扰动和尺度变换等。对原始数据库的图像进行改变来增加数据库样本。Cubuk等[9]提出了一种自动数据增强方法,使用搜索算法来寻找最佳策略,使得神经网络对目标数据集产生最高的验证精度,他们的方法在cifar-10、cifar-100、svhn和imagenet 上达到了最高精度,其中在imagenet 的数据集获得了83.5% 的准确率。

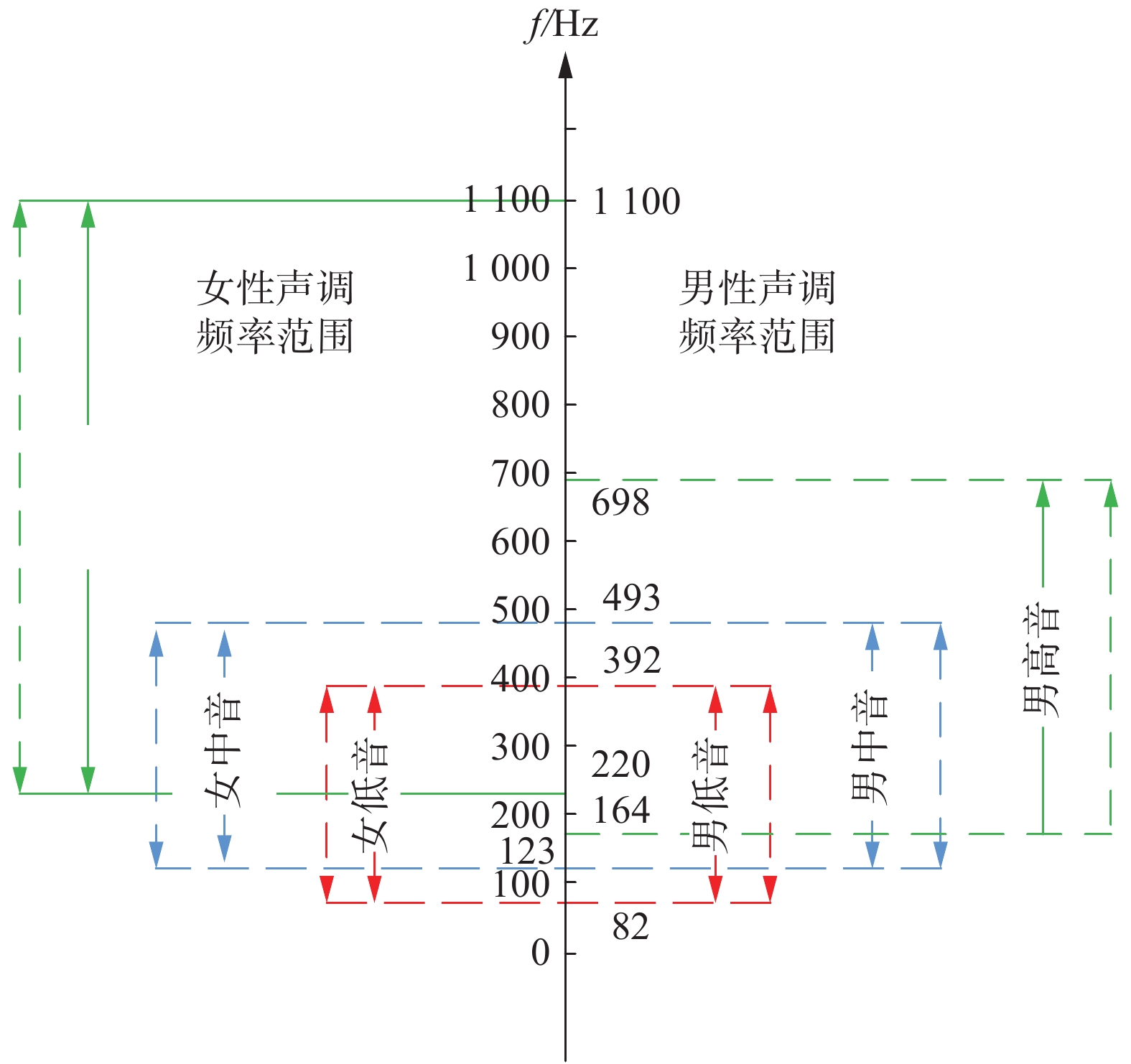

研究语音样本的数据增强要考虑人类声音的特征。人类声音的频率范围主要分为男性和女性2部分。男声的声音分为男高音(Tenor)、男中音(Baritone)和男低音(Bass)。同样,女性的声音也可以分为女高音(Soprano),女中音(Mezzo-soprano)和女低音(Alto)。其声音的实际频率范围如图2所示。研究表明,男低音、男中音与女低音、女中音的声调频率范围相同;女高音比男高音的频率略高;女性声音的平均频率大约是男性声音的平均频率的1~1.75倍。本文所采用的语音情感数据库为德国柏林EMO-DB数据库[10],由10位不同性别(5位男性、5位女性)的专业人员录制。经过筛选得到了最终535条语句,共包含7种情感:生气(Anger)、悲伤(Sadness)、高兴(Happiness)、害怕(Fear)、中性(Neutral)、厌恶(Disgust)和无聊(Boredom)。根据男性声调与女性声调的不同之处,提出了一种基于时频域变换的方法进行数据增强。

|

Download:

|

| 图 2 男性与女性声调频率范围 Fig. 2 Male and female tone frequency range | |

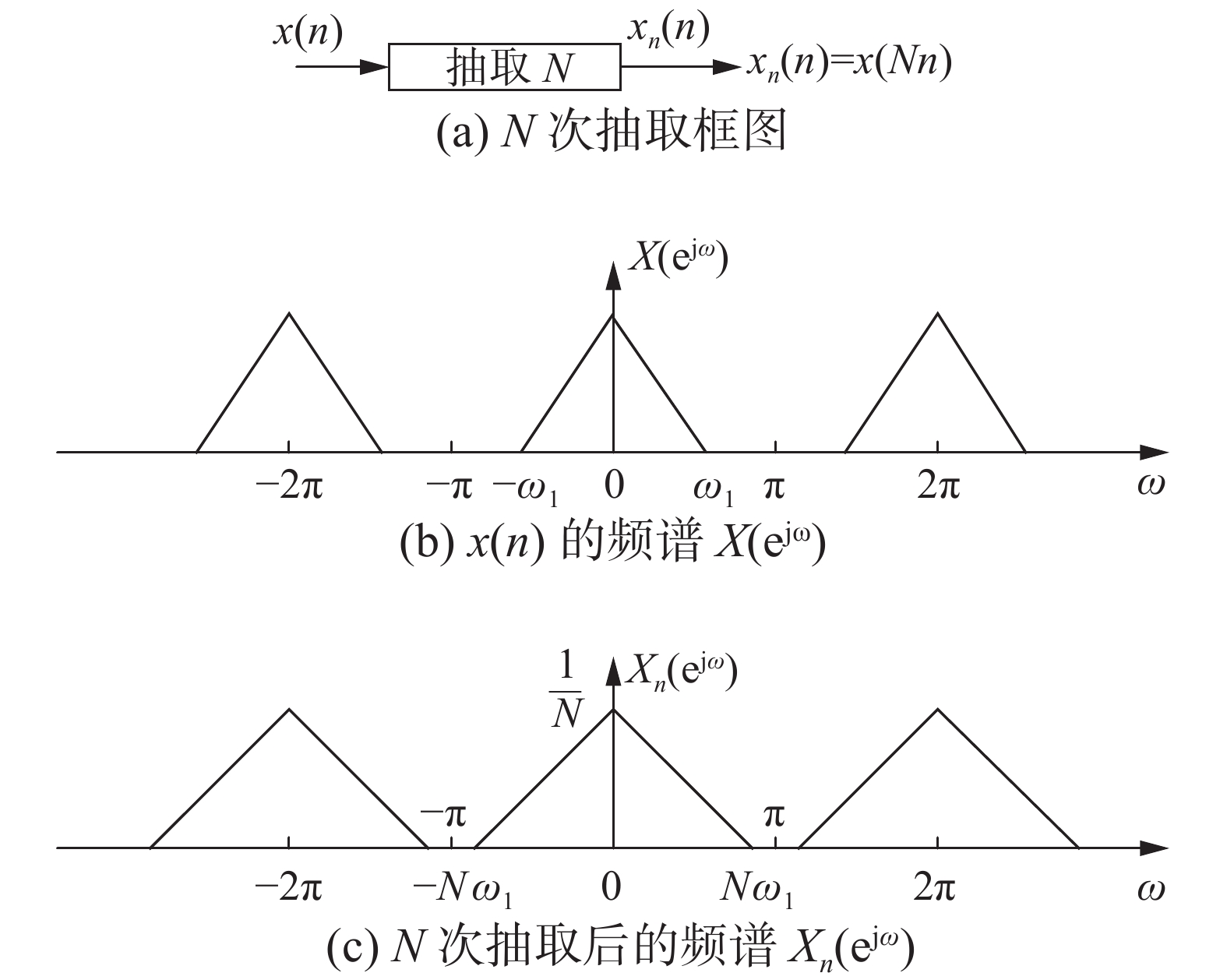

信号在时域上的

|

Download:

|

| 图 3 时域信号的N次抽取 Fig. 3 N-times extraction of time domain signals | |

同理,时域信号的

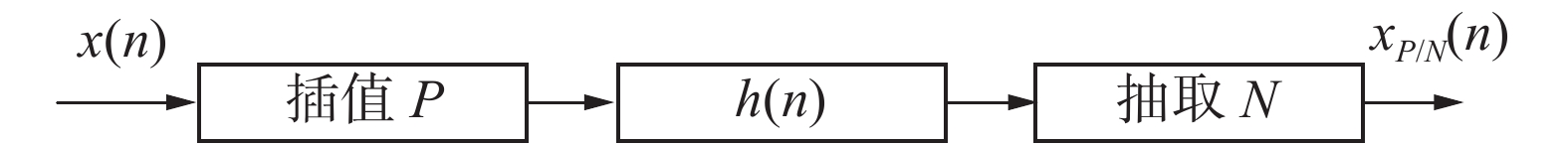

频域变换的目的是改变原始声音样本的频谱,使男女声音互换。基音调整可以看作是频率的一种音阶变换。因为音调的高低是由频率决定的。频率越高,音调就越高。通过对信号进行快速傅里叶变换(fast fourier transformation, FFT),可以在频域内进行变换,将整个频谱向左或向右移动100 Hz。然后进行反向快速傅里叶变换(inverse fast fourier transformation, IFFT)将音高返回到时间域。男声和女声的基本频率可以通过左右变换来改变,从而实现男声和女声的转换。

|

Download:

|

| 图 4 时域信号的P次插值 Fig. 4 P-times interpolation of time domain signals | |

|

Download:

|

| 图 5 时域信号的P/N次变换 Fig. 5 P/N-times transformation of time domain signals | |

语谱图是一种以二维的平面表达三维信息的语音信号频谱图。其横轴代表时间,纵轴代表频率,颜色的深浅代表语音信号的强弱。图6(a)、(b)分别为未使用数据增强方法的样本语谱图和使用了数据增强后的样本语谱图。使用了数据增强后的语谱图,颜色清晰,并未发现模糊或者样本损坏的情况。

|

Download:

|

| 图 6 相同样本的语谱图比较 Fig. 6 Comparison of the spectrogram of same sample | |

本文使用openSMILE2.3.0提取了1 582维的情感特征,该特征集包含的1 582个特征是由34个低级描述特征和34个相应的变量作为68个低级描述特征轮廓值,在此基础上应用21个函数得到1 428个特征,另外,对4个基于音高的低级描述特征及其4个变量系数应用了19个函数得到152个特征,最后附加音高(伪音节)的数量和总体输入的持续时间(2个特征)。此外,还着重分析了10个低级描述符的情感识别率,主要包括:F0Final、F0finEnv、jitterDDp、jitterLocal、logMelFreqBand、lsqFreq、pcm_fftMag_mfcc、pcm_loudness、shimmerLocal、voicingFinalUnclipped[11]。

3 语音情感分类算法在本节详细介绍使用的3种机器学习分类算法:支持向量机、随机森林和K最邻近(K- nearest neighbor)。

3.1 支持向量机支持向量机是Vapnik等[12-14]在20世纪90年代提出的一种新的机器学习方法。它是一种广义的线性分类算法,对数据按监督式学习进行二进制分类。支持向量机的基本思想是通过对非线性可分离样本进行非线性变换,将其输入向量映射到另一个高维空间。为了在这个新空间中实现线性可分,寻找最优分类超平面,使超平面与不同类别的样本集之间的距离达到最大,从而达到最大的泛化能力。它已经演变成4种类型:

1)线性可分类型。

当想要分割2种数据类型时,至少存在一个分割平面,可以使2种类型完全分离,这种类型没有边界最大化,因此不能很好地控制错误,称为线性可分类型。

2) 线性类型。

无法彻底地分割2种数据类型,但可以使绝大多数的数据分割,这种类型称为线性类型。

3) 非线性类型。

当一个类型不是线性可分的时候,支持向量机通过提供一个“软边界”来处理数据分类,即允许一组数据中的一些元素落在另一边,但允许它们通过这个超平面而不产生任何重大异常,允许系统变得不那么严格和更健壮。

4) 核函数。

核函数的目的是将原始被分类数据映射到更高维度的空间去进行分类,将原本线性不可分类型在高纬度变成线性可分。

3.2 K最邻近在模式识别领域,K最邻近算法是一种用于分类和回归的非参数统计方法。输入包含特征空间中K个最接近的训练样本。作为一种应用广泛的分类方法,K最邻近拥有属性简单、无需参数、分类效果好的优点。

其分类的基本思想是:在K最邻近分类中,输出是一个分类组。一个物体的分类是由它的邻居的“多数票”[15-18]决定的。在K个最近邻中最常见的分类(是一个正整数,通常很小)决定了分配给标签的分类。如果

随机森林是一种基于“一组弱估计,组合在一起,形成一个强估计”原理的集成算法,本文设计的随机森林分类器是一组100个决策树。让 X和Y 分别代表情绪的总数和样本的总数。为每个决策树选择一组引导程序样本。然后通过在每个节点上赋予y<Y 变量来构建决策树,直到用尽所有的变量。在树的每个节点上,用它们的变量拟合分类模型,并找出截断点。经过训练,未知样本的种类预测可以通过所有个体树的所有预测等级中的大多数投票来决定[19-22]。

4 实验结果与分析 4.1 提取1 582维特征的识别结果在这一部分,主要介绍基于支持向量机、随机森林和K最邻近3种分类算法的识别率。对于实验数据,本文使用柏林的情感语料库EMO-DB。这是柏林理工大学录制的、德语情感语音数据库。采用7种情绪(生气、无聊、厌恶、害怕、高兴、中性、悲伤)模拟10种情绪(男5例、女5例),共计800句。经过筛选,该语料库保留了233个男性情感句和302个女性情感句,共计535个句子[12]。本文利用数据增强来扩展原始柏林情感语料库,将样本量增加到700个句子。以其中的600个句子作为训练集,100个句子作为测试集。

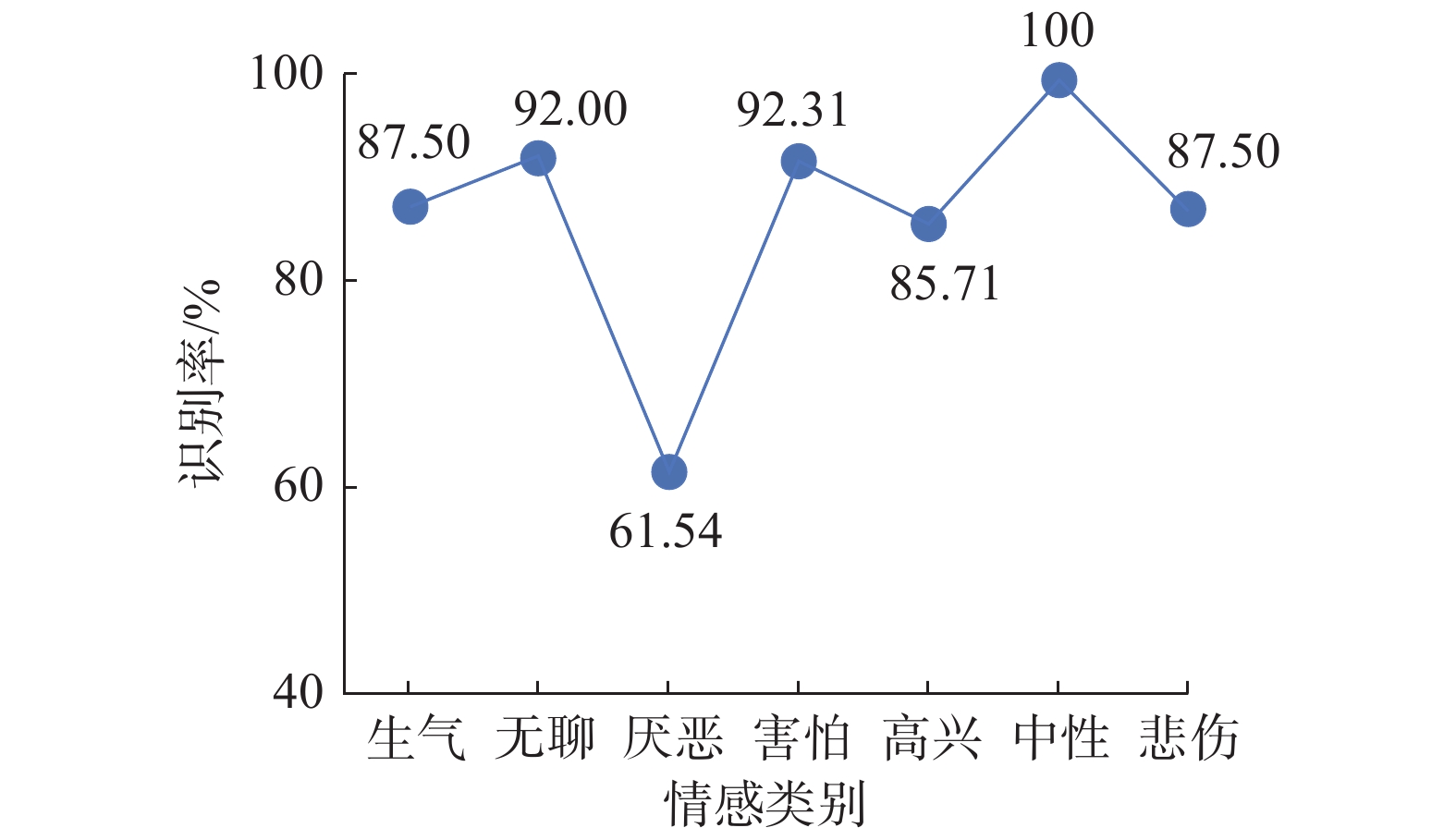

从图7得出,基于支持向量机算法的平均识别率达到86.65%。在这个模型中,无聊、害怕和中性的识别率较高。然而,厌恶的识别率很低。支持向量机算法是解决高维特征分类问题的有效方法。当特征维数大于样本数时,仍然有较好的效果。核函数的数量很多,可以很灵活地解决各种非线性分类回归问题。当样本量不是海量数据时,分类精度高,泛化能力强。

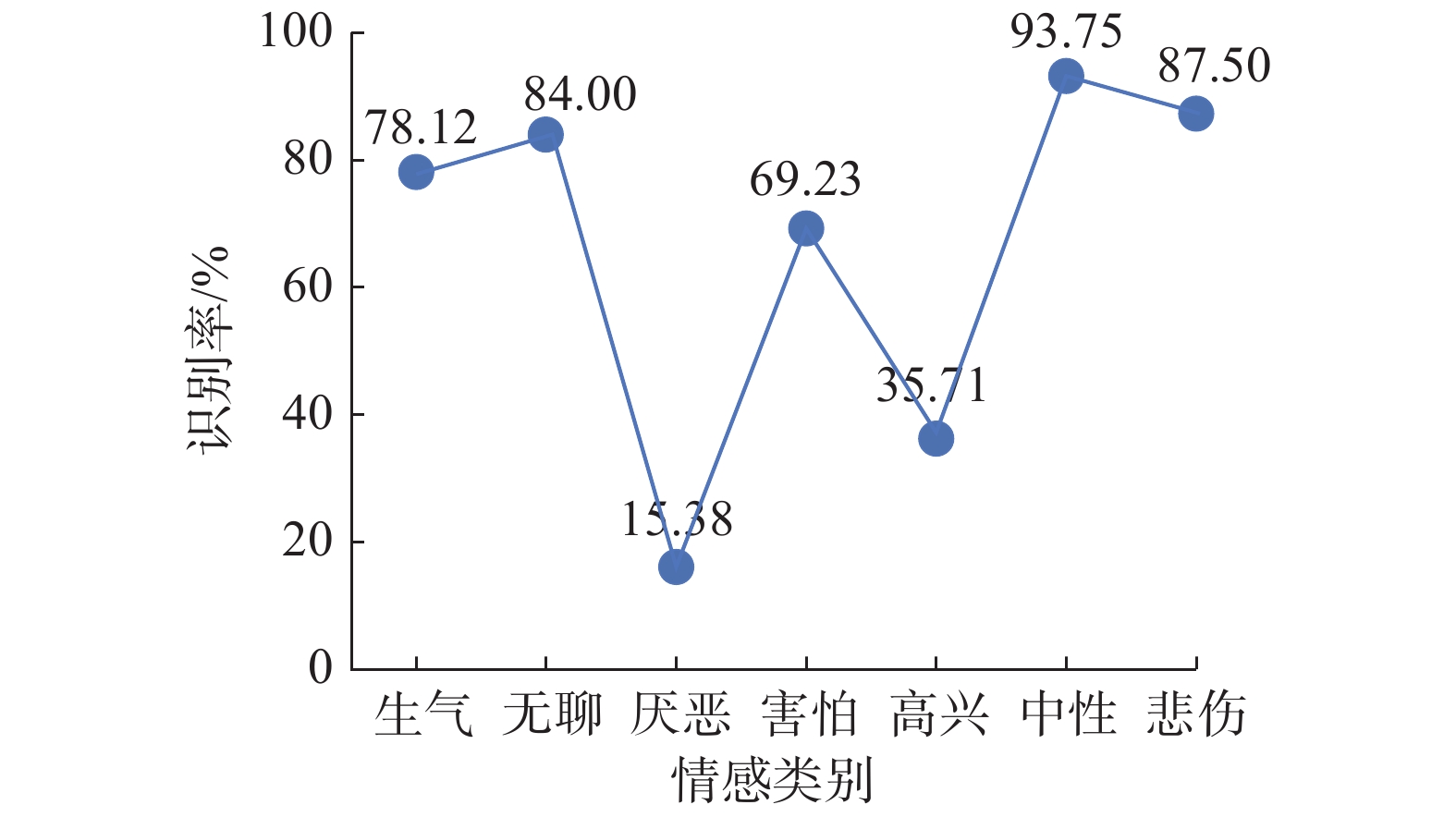

如图8所示,基于随机森林的1 582维特征的识别率中,中性和悲伤的识别率较高,而厌恶的识别率很低,只有15.38%。随机森林的平均识别率为61.14%,与支持向量机算法相比较低。

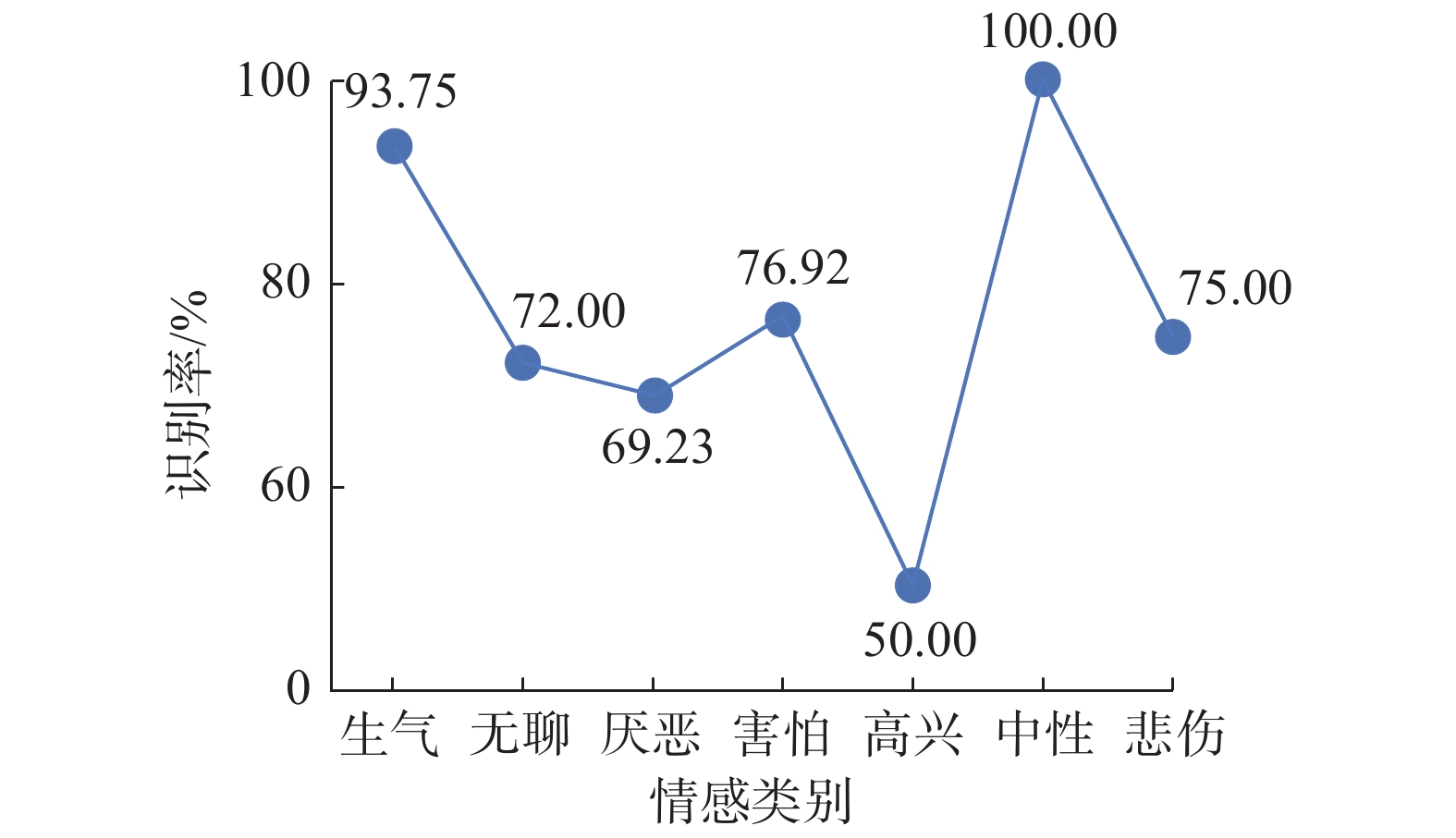

如图9所示,K最近邻算法的平均识别率为79.38%。其中高兴的识别率很低,只有50%,中性的识别率很高。因为K最邻近模型主要依赖于有限的相邻样本,而不是依赖于判别类别域的方法来确定类别。因此,对于交叉或重叠较多的样本集合,K最邻近方法比其他方法更适合。该算法更适合于样本量较大的类域的自动分类。然而,小样本更容易出现分类错误。

|

Download:

|

| 图 7 基于支持向量机的1 582维特征的识别率 Fig. 7 1 582 dimensional features recognition rate based on support vector machine | |

|

Download:

|

| 图 8 基于随机森林的1 582维特征的识别率 Fig. 8 1 582 dimensional features recognition rate based on random forest | |

|

Download:

|

| 图 9 基于K最邻近的1582维特征的识别率 Fig. 9 1 582 dimensional features recognition rate based on k nearest neighbor | |

图10为基于支持向量机、随机森林和K最邻近3种算法的1 582维特征的识别率比较。综上所述,使用了数据增强方法的3种算法的中性感情的识别率普遍比较好;而厌恶识别率相对较低。

表1为未使用数据增强和使用数据增强后的识别结果对比。表格纵轴代表参数为:准确率、宏平均、微平均、召回率、f1权重、汉明损失率、kappa系数和杰卡德相似系数等。对比发现,使用了数据增强后的支持向量机和K最邻近算法识别率提高了。其中,支持向量机算法的准确率提高了2.53%,K最近邻算法的准确率提高了15.73%。然而,随机森林的识别结果较差,其汉明损失率增大了13.1%。

|

Download:

|

| 图 10 3种算法的1 582维特征的平均识别率 Fig. 10 Average recognition rate of 1 582 dimensional features of three algorithms | |

| 表 1 未使用数据增强和使用后的识别结果对比 Tab.1 Comparison of unused data enhancement and used |

表2为10组低级特征的识别结果分析,纵轴分别表示了基频(F0final)、平滑的基频轮廓线(F0finEnv)、帧间抖动(jitter DDp)、局部抖动(jitterLocal)、梅尔频带的对数功率(LogMelFreqBand)、线谱对频率(lspFreq)、梅尔频率倒谱系数(pcm_fftMag_mfcc)、响度(pcm_loudness)、震动(shimmer)和最终基频的可能发声概率(voicingFinalUnclipped)等。根据表2中数据统计,pcm_fftMag_mfcc特征和LogMelFreqBand特征的识别结果较好。其中pcm_fftMag_mfcc特征在3种算法上的精确度分别为74.63%、64.93%和66.42%;LogMelFreqBand特征的精确度分别为84.33%、73.13%和58.21%。面向数据增强方法的语音情感识别方法对LogMelFreqBand特征和pcm_fftMag_mfcc特征的识别性能有一定的提高,改善了传统语音情感识别方法识别率较低的现状。

| 表 2 10组低级描述特征的识别比较 Tab.2 Comparison of 10 sets of low-level descriptive features |

本文引入了一种基于时频域的数据增强方法,提出了将数据增强与语音情感识别结合的策略,并着重分析了与情感有关的特征和语音情感识别的关系。实验结果表明,使用了数据增强方法的支持向量机和K最邻近分类算法的识别率提高了,而随机森林的识别效果并不乐观;此外,改进了传统语音情感识别数据特征多且无关特征多的问题。

| [1] |

吴雪, 宋晓茹, 高嵩, 等. 基于数据增强的卷积神经网络火灾识别[J]. 科学技术与工程, 2020, 20(3): 1113–1117. WU Xue, SONG Xiaoru, GAO Song, et al. Convolution neural network based on data enhancement for fire identification[J]. Science technology and engineering, 2020, 20(3): 1113-1117. (  0) 0)

|

| [2] |

CHATZIAGAPI A, PARASKEVOPOULOS G, SGOUROPOULOS D, et al. Data augmentation using GANs for speech emotion recognition[C]//Proceedings of the 20th Annual Conference of the International Speech Communication Association. Graz, Austria, 2019.

( 0) 0)

|

| [3] |

ESCUDERO J P, NOVOA J, MAHU R, et al. An improved DNN-based spectral feature mapping that removes noise and reverberation for robust automatic speech recognition[J]. arXiv:1803.09016, 2018.

( 0) 0)

|

| [4] |

REN Fuji, MATSUMOTO K. Semi-automatic creation of youth slang corpus and its application to affective computing[J]. IEEE transactions on affective computing, 2016, 7(2): 176–189.

( 0) 0)

|

| [5] |

KAWASE T, NIWA K, HIOKA Y, et al. Automatic parameter switching of noise reduction for speech recognition[J]. Journal of signal processing, 2017, 21(2): 63-71. DOI:10.2299/jsp.21.63 ( 0) 0)

|

| [6] |

YOUSEFI H, KANI A T, KANI I M, et al. Wavelet-based iterative data enhancement for implementation in purification of modal frequency for extremely noisy ambient vibration tests in Shiraz-lran[J]. Frontiers of structural and civil engineering, 2020, 14(2): 446-472. ( 0) 0)

|

| [7] |

ELBAROUGY R, AKAGI M. Feature selection method for real-time speech emotion recognition[C]//Proceedings of the 20th Conference of the Oriental Chapter of the International Coordinating Committee on Speech Databases and Speech I/O Systems and Assessment. Seoul, Korea , 2017: 1–6.

( 0) 0)

|

| [8] |

MANGALAM K, GUHA T. Learning spontaneity to improve emotion recognition in speech[C]//Proceedings of the 19th Annual Conference of the International Speech Communication Association. Hyderabad, India, 2018.

( 0) 0)

|

| [9] |

CUBUK E D, ZOPH B, MANÉ D, et al. AutoAugment: learning augmentation strategies from data[C]//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach, USA, 2019.

( 0) 0)

|

| [10] |

CHEN Mingyi, HE Xuanji, YANG Jing, et al. 3-D convolutional recurrent neural networks with atten-tion model for speech emotion recognition[J]. IEEE signal processing letters, 2018, 25(10): 1440-1444. DOI:10.1109/LSP.2018.2860246 ( 0) 0)

|

| [11] |

SCHULLER B W, STEIDL S, BATLINER A, et al. The INTERSPEECH 2010 paralinguistic challenge[C]//Proceedings of the 11th Annual Conference of the International Speech Communication Association. Makuhari, Chiba, Japan, 2010: 1342–6230.

( 0) 0)

|

| [12] |

BOSER B E, GUYON I M, VAPNIK V N. A training algorithm for optimal margin classifiers[C]//Proceedings of the 5th Annual Workshop on Computational Learning Theory. Pittsburgh, PA, USA, 1992: 144–152.

( 0) 0)

|

| [13] |

VAPNIK V N. The nature of statistical learning theory[M]. New York: Springer-Verlag, 1995.

( 0) 0)

|

| [14] |

VAPNIK V N. An overview of statistical learning the-ory[J]. IEEE transactions on neural networks, 1999, 10(5): 988-999. DOI:10.1109/72.788640 ( 0) 0)

|

| [15] |

戴志诚, 李小年, 陈增照, 等. 基于KNN算法的可变权值室内指纹定位算法[J]. 计算机工程, 2019, 45(6): 310–314.DAI Zhicheng, LI Xiaonian, CHEN Zengzhao, et al. Variable-weight indoor fingerprinting localization algorithm based on KNN algorithm[J]. Computer engineering, 2019, 45(6): 310–314.

( 0) 0)

|

| [16] |

LARIJANI M R, ASLI-ARDEH E A, KOZEGAR E, et al. Evaluation of image processing technique in identifying rice blast disease in field conditions based on KNN algorithm improvement by K-means[J]. Food science & nutrition, 2019, 7(12): 3922–3930.

( 0) 0)

|

| [17] |

SATHISHKUMAR R, KALAIARASAN K, PRABHAKARAN A, et al. Detection of lung cancer using SVM classifier and KNN algorithm[C]//Proceedings of 2019 IEEE International Conference on System, Computation, Automation and Networking. Pondicherry, India, 2019.

( 0) 0)

|

| [18] |

连天友, 余勤. 改进KNN算法对人体身份的识别[J]. 计算机工程与应用, 2019, 55(11): 142-146, 243.LIAN Tianyou, YU Qin. Human identity recognition using improved KNN method[J]. Computer engineering and applications, 2019, 55(11): 142–146, 243.

( 0) 0)

|

| [19] |

PAUL A, MUKHERJEE D P, DAS P, et al. Improved random forest for classification[J]. IEEE transactions on image processing, 2018, 27(8): 4012–4024.

( 0) 0)

|

| [20] |

YEŞILKANAT C M. Spatio-temporal estimation of the daily cases of COVID-19 in worldwide using random forest machine learning algorithm[J]. Chaos, solitons & fractals, 2020, 140: 1–8.

( 0) 0)

|

| [21] |

BUTT A M, BHATTI Y K, HUSSAIN F. Emotional speech recognition using SMILE features and random forest tree[M]. BI Yaxin, BHATIA R, KAPOOR S. Intelligent Systems and Applications. Cham: Springer, 2020.

( 0) 0)

|

| [22] |

DAI Jingzhao, ZHANG Yaan, HOU Jintao, et al. Sparse wavelet decomposition and filter banks with CNN deep learning for speech recognition[C]//Proceedings of 2019 IEEE International Conference on Electro Information Technology. Brookings, SD, USA, 2019.

( 0) 0)

|

2021, Vol. 16

2021, Vol. 16