关系抽取是信息抽取的一个重要组成部分,已被成功用于医学知识发现[1]、知识图谱构建[2]和问答推理[3]等诸多自然语言处理问题。关系抽取是指从非结构化的文本中抽取出实体对之间的三元组信息。

现有关系抽取模型或方法可大体分为2类:序列模型和依赖关系模型。序列模型主要针对单词序列进行建模[4-5],而依赖关系模型则是以句法依存关系树为基础,构建依赖关系模型[6-7]。已有研究表明,相对序列模型而言,依赖关系模型可以利用句法依存树提取出句子中隐藏的非局部语法关系[8-9],进而建立句内长距离的依赖关系。然而,在生成句法依存树时,它常依赖句法结构规则对句子结构进行修剪。这种基于规则的修剪策略可能会删除句子结构所包含的重要隐式信息。为此,Guo等[10]提出了一种基于软修剪的关系提取模型,用以实现模型自主学习句法结构,而无需对句法结构进行硬性修剪。虽然所提模型可以很好地学习句法结构,但是,由于图卷积模型本身的无向性,其对上下文中时序特征的学习能力较弱。

目前,已有学者以句法依存树为基础,提出了多种图神经网络模型,但是所提模型大多是基于图卷积神经网络[11]。图卷积神经网络可以很好地学习图结构数据的信息,却难以有效处理时序数据。这就意味着,面向具备时序特性的文本数据,只依赖图卷积神经网络并不能很好地抽取文本中时序信息。相对图卷积神经网络,长短时记忆神经网络(long short term memory neural network, LSTM)可以有效提取上下文的时序信息。目前,部分学者开始尝试将其用于跨句关系的抽取问题,并提出了多种图长短时记忆神经网络[12-13]。但是,这些方法都是基于修剪后句子结构树的信息来构建图神经网络,依然存在误删有用信息的不足。另外,传统方法对句子结构信息的使用完全依赖于句子结构树。如果句子结构树中蕴含错误信息,很容易累加错误信息。

鉴于此,本文提出一种注意力图长短时记忆神经网络(attention graph long short term memory neural network, AGLSTM)。采用注意力机制与句子结构树相结合的方式建立句子的全局结构信息,生成全局注意力权重矩阵,并将其用于构造AGLSTM模型。所提方法不仅可以充分利用LSTM学习句子的时序结构特征,而且可以根据句法图信息自行学习句子的结构特征。相对于完全依赖句子结构树的传统方法,本文方法是在原始句子结构树的基础上,利用注意力机制使得模型自行学习句子结构中的信息,不仅可以得到更加有效的关系抽取模型,而且鲁棒性更好。

1 相关工作关系抽取是自然语言处理中的一项重要分支任务,在从非结构化文本中抽取结构性信息时起着重要作用。现有主流关系抽取技术可分为2种:远程监督关系抽取[14-15]和有监督关系抽取[5, 16]。

有监督关系抽取法把关系抽取看作一种多分类任务进行处理。早期的研究成果主要是使用核函数等机器学习方法设计分类器[17],并进行关系提取任务。随着深度学习的兴起,深度神经网络已在关系抽取中得到了广泛应用。Zeng等[18]采用深度卷积神经网络(convolutional neural network, CNN)提取词汇级和句子级特征,进而完成关系抽取;Zhang等[16]利用长短时记忆神经网络学习实体对之间的长期依赖性;Zhang等[19]在词嵌入的基础上考虑单词的位置和词性、句子结构依赖等信息,设计了一种新型的长短时记忆神经网络进行关系抽取。马语丹等[20]通过引入注意力机制提取实体的网络环境信息,生成全局的上下文特征。鉴于LSTM对文本信息建模的优越性,以及句子结构信息对文本关系抽取任务的重要性,学者们还提出了结合句子结构信息建模的SDP-LSTM[6]和Tree-LSTM[7]等改进模型。

远程监督关系提取方法借助知识库,利用知识库中包含的知识来对非结构化文本进行标注。这种方法可以自动构建大量训练数据,不仅解决了现有方法数据量不足的缺点,而且增强了模型的跨领域适应能力。Mintz等[21]最早提出了远程监督的基本假设,定义了远程监督任务。然而,远程监督在解决数据量不足的同时,容易带来较大的噪声。为此,越来越多的学者开始关注对远程监督方法的改进研究。Zeng等[22]融合分段卷积神经网络和多实例学习(multiple instance learning,MIL),提出了一种混合关系提取模型。该模型通过PCNN提取句子特征,利用MIL消除错误样本噪声,进而实现远程监督关系抽取。

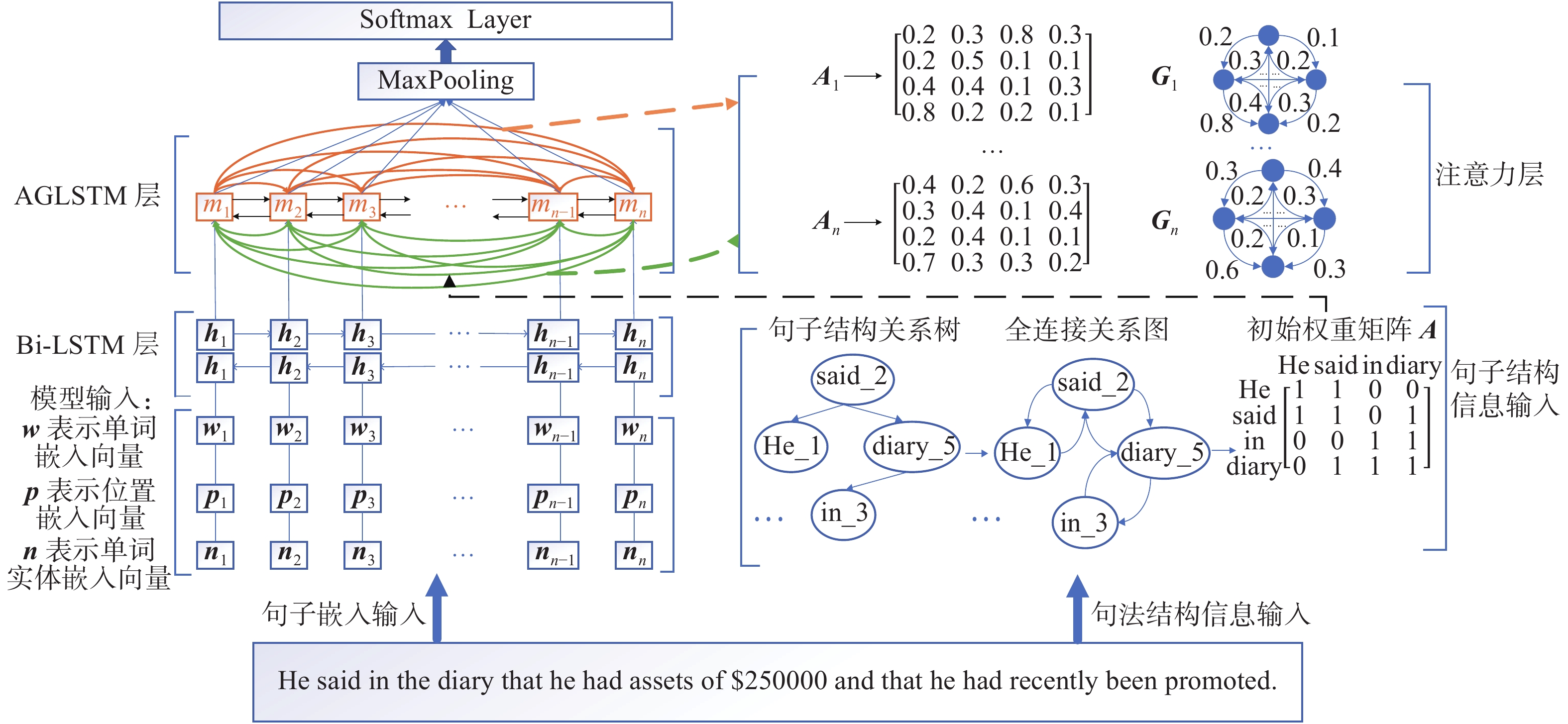

2 所提关系抽取模型 2.1 模型框架为同时学习句法图中句子的结构特征和句子之间的时序结构特征,提出一种新的图神经网络结构,即注意力图长短时记忆神经网络(AGLSTM)。图1给出了融合AGLSTM模型的关系抽取框架。

2.2 Embedding层关系抽取方法需要考虑语料中的实体语义特征和实体位置特征。在自然语言处理领域中,词向量表示常用于表示词的语义信息。本文通过词嵌入方法对整个语料库进行训练,得到语料库的词向量矩阵,其中每个词表示为一个

本文采用Zeng等[18]提出的实体位置嵌入方法引入实体位置信息。将句中每一个单词与实体对

将实体语义特征嵌入与实体位置特征嵌入融合,作为模型嵌入层的输出,即

|

Download:

|

| 图 1 AGLSTM模型的关系抽取框架 Fig. 1 Relation extraction framework based on the AGLSTM model | |

嵌入层输出的特征矩阵

| $\overrightarrow {{{{h}}_t}} = \overrightarrow {{\rm{LSTM}}} ({{{w}}_u},\overrightarrow {{{{h}}_{t - 1}}} )$ |

| $\overleftarrow {{{{h}}_t}} = \overleftarrow {{\rm{LSTM}}} ({{{w}}_u},\overleftarrow {{{{h}}_{t - 1}}} )$ |

最终,将Bi-LSTM的正向和反向隐藏层输出相连接,可以得到输出特征

对文本数据进行语义信息抽取时,不仅要考虑句子所包含单词的特征信息,而且需要挖掘句子本身所蕴含的结构信息。已有大量研究成果将句法结构用于关系抽取,取得了很好的效果。

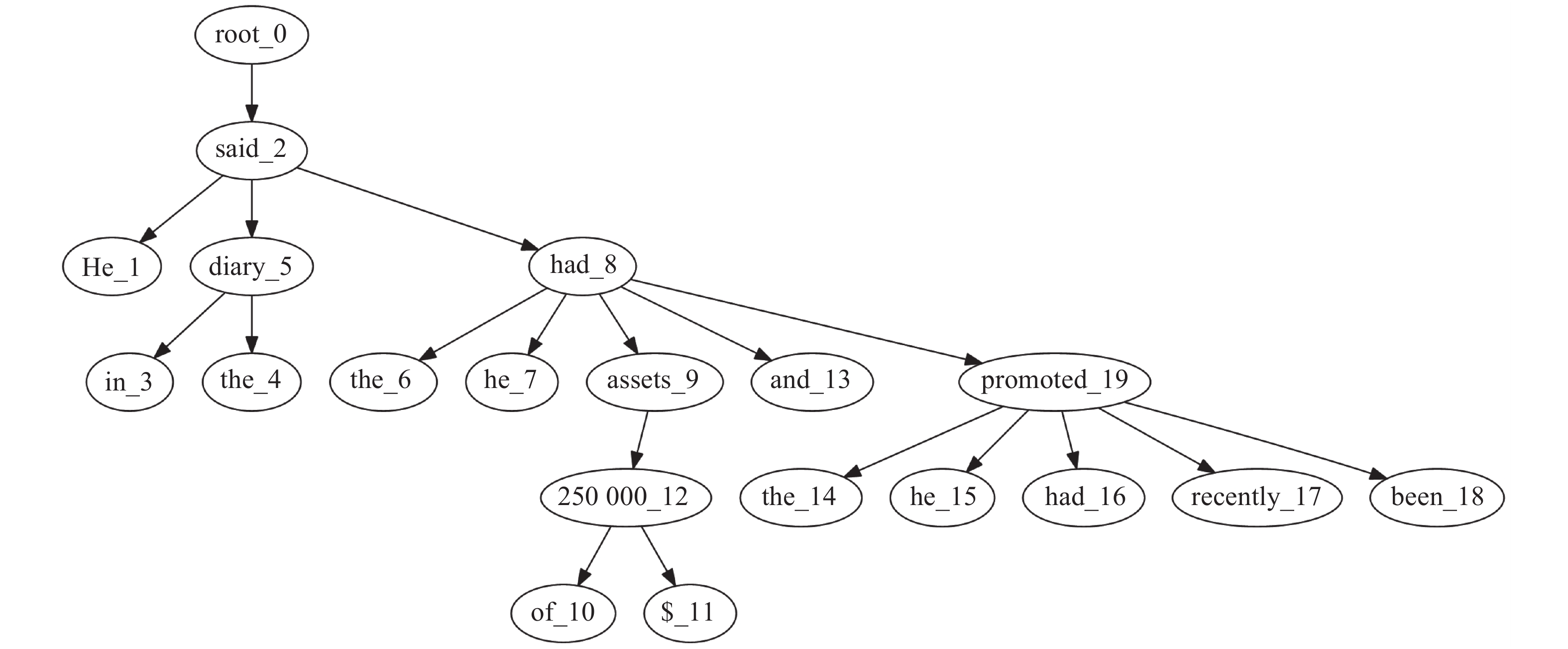

为建立句法结构矩阵,首先利用句法依存分析提取出每个句子序列S={S1,S2, …, Sn}的句法结构。例如,对句子“He said in the diary that he had assets of $250000 and that he had recently been promoted.”进行句法分析,图2给出了它的句法树。接着,将提取出的句法树信息转换成全连接图的矩阵形式。图1右侧句子结构信息输入部分展示了构建初始邻接权重矩阵A的过程,其中,全连接关系图展示了扩展后的依存树。进一步,将依存关系图写成矩阵形式,得到初始的句法结构邻接矩阵

| ${{A}} = \left[ {\begin{array}{*{20}{c}} {a_{11}}& {a_{12}}&\cdots &{a_{1n}} \\ \vdots &\vdots &{}& \vdots \\ {a_{n1}}& {a_{n2}}&\cdots &{a_{nn}} \end{array}} \right] $ |

如图1右侧句子结构信息输入部分中初始权重矩阵所示。将得到的邻接矩阵

现有方法大都依据句法结构信息将句子处理成邻接子树,如图2所示。因为在子树中只有相连叶子结点的单词可以构成联系,这些方法有可能丢失远程单词之间的关联信息。鉴于此,本文采用软修剪策略,将句子的邻接子树转换为全连接的边加权图;并通过注意力的形式,使模型可以根据初始邻接矩阵信息自行训练注意力权重,进而更全面地学习句子的结构信息。

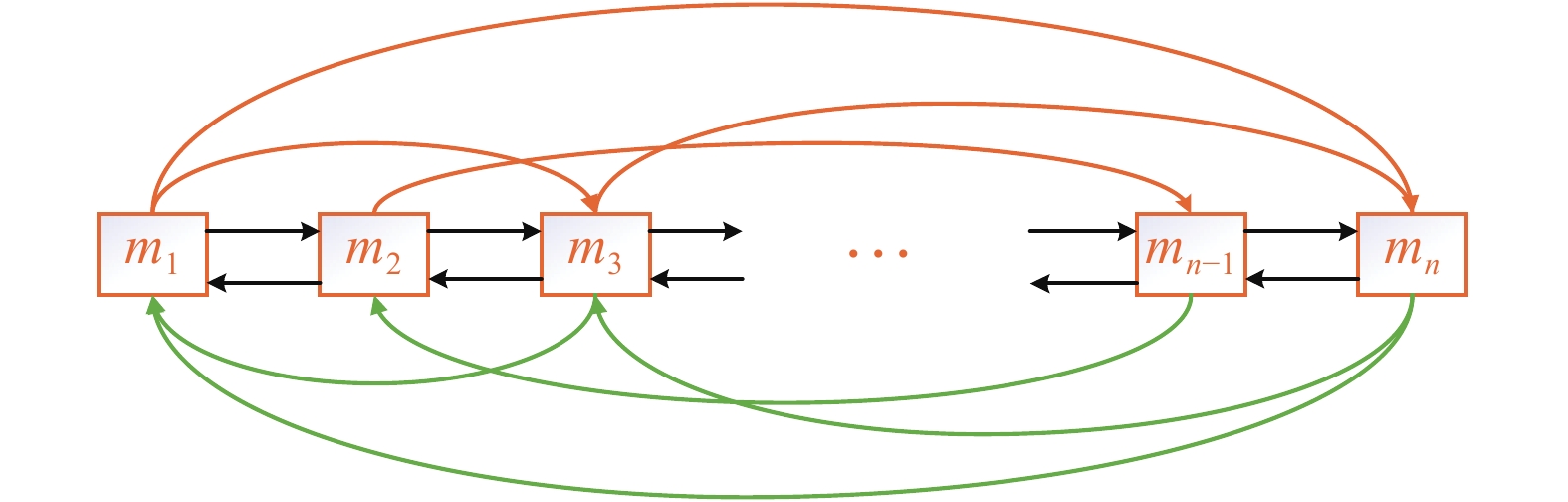

AGLSTM是由图长短时记忆神经网络(graph long short term memory neural network, GLSTM)和注意力机制结合而成,如图1左侧所示。GLSTM中每一个单词节点

|

Download:

|

| 图 2 句法分析树示例 Fig. 2 Schematic diagram of the syntactic analysis | |

|

Download:

|

| 图 3 GLSTM网络结构 Fig. 3 Structure of the GLSTM network | |

在AGLSTM中每2个单词节点之间的边权重为注意力层所得多头注意力矩阵中相应元素的权重值。

| $ {{h}}_j^{{\rm{in}}} = \sum\limits_{(i,j)i \in {\rm{all}}} {{\alpha _{ij}}{{{h}}_i}} $ | (1) |

| $ {{h}}_j^{{\rm{out}}} = \sum\limits_{(j,k)k \in {\rm{all}}} {{\alpha _{jk}}{{{h}}_k}} $ | (2) |

式中:

| ${{{i}}_j} = \sigma ({{{W}}_i}{{{x}}_j} + {{{U}}_{i1}}{{h}}_j^{{\rm{in}}} + {{{U}}_{i2}}{{h}}_j^{{\rm{out}}} + {{{b}}_i})$ | (3) |

| ${{{o}}_j} = \sigma ({{{W}}_o}{{{x}}_j} + {{{U}}_{o1}}{{h}}_j^{{\rm{in}}} + {{{U}}_{o2}}{{h}}_j^{{\rm{out}}} + {{{b}}_o})$ | (4) |

| ${{{f}}_j} = \sigma ({{{W}}_f}{{{x}}_j} + {{{U}}_{f1}}{{h}}_j^{{\rm{in}}} + {{{U}}_{f2}}{{h}}_j^{{\rm{out}}} + {{{b}}_f})$ | (5) |

| ${{{u}}_j} = \sigma ({{{W}}_u}{{{x}}_j} + {{{U}}_{u1}}{{h}}_j^{{\rm{in}}} + {{{U}}_{u2}}{{h}}_j^{{\rm{out}}} + {{{b}}_u})$ | (6) |

| ${{{c}}_j} = {{{f}}_j} \odot {{{c}}_{j - 1}} + {{{i}}_j} \odot {{{u}}_j}$ | (7) |

| ${{{h}}_j} = {{{o}}_j} \odot \tanh ({{{c}}_j})$ | (8) |

式中:

结合注意力机制和GLSTM,构造注意力图长短时记忆神经网络(AGLSTM)。利用注意力机制对句子结构特征进行注意力运算,得到注意力权重矩阵

| ${{{A}}^k} = \left[ {\begin{array}{*{20}{c}} {\alpha _{11}^k}& {\alpha _{12}^k}&\cdots &{\alpha _{1n}^k} \\ \vdots &\vdots &{}& \vdots \\ {\alpha _{n1}^k}& {\alpha _{n2}^k}&\cdots &{\alpha _{nn}^k} \end{array}} \right],\quad k = 1,2, \cdots ,n$ |

式中:每个矩阵

Self-attention机制可以交互计算序列中任意位置,从而捕获整个序列内的依赖关系。具体地,Self-attention计算公式为

| ${{{u}}_t} = \tanh ({{{W}}_w}{{{H}}_{\rm{LSTM}}} + {{{b}}_w})$ |

| ${{{A}}^k} = {\rm{softmax}}({{{W}}_u}{{{u}}_t})$ |

式中:

将得到的注意力权重矩阵

根据多头注意力层,可以得到k个不同的注意力权重矩阵

| ${{{h}}_{{\rm{comb}}}}{{ = }}{{{W}}_{{\rm{comb}}}}{{{h}}_{{\rm{out}}}}{{ + }}{{{b}}_{\rm{comb}}}$ |

式中:

针对最终输出的特征

| $p({{{h}}_i}) = \frac{{{{h}}_{{\rm{comb}}}^i}}{{\displaystyle\sum\limits_{n = 1}^N {{{h}}_{{\rm{comb}}}^n} }},\quad i = 1,2, \cdots ,N$ |

本节在2个常用的关系抽取数据集中验证所提模型的有效性。它们分别是TACRED数据集[19]和SemEval 2010 task 8数据集[23]。

TACRED数据集:该数据集共106264条实例,分为训练集68124条,验证集22 631条,测试集15509条。数据集引入了41种关系类型和一种特殊的“no relation”类型,来描述实例中相关实体对之间的关系。

SemEval 2010 task 8数据集:该数据集主要用于对名词性实体之间的语义关系进行分类。它采用9种关系类型和一种特殊的关系类型“Other”来描述实体对之间的关系。数据集一共包含10 717条实例,其中,8000条实例为训练数据,其余为测试数据。

3.2 模型参数与性能指标采用Adam算法优化本文所提模型,网络隐藏层节点数设置为300。为防止过拟合,在输入层和AGLSTM层同时引入损失率(dropout),并且在目标函数中引入L2正则化项,正则化因子取值为0.001。对于TACRED数据集,模型参数设置学习率为0.7,在输入层和AGLSTM层的损失率都设为0.5。对于SemEval 2010 task8数据集,模型设置学习率为0.5,在输入层和AGLSTM层的损失率分别设为0.5和0.3。采用预训练好的Glove向量[24]对数据集进行词向量训练,生成词嵌入向量;结合实体位置嵌入和NER标签嵌入,生成最终嵌入层向量。

在注意力层,多头注意力机制的参数k会对模型性能产生较大的影响。以SemEval数据集为例,依次设置k=[2,3,4,5,6],下面讨论k值对所提模型性能的影响。表1展示了不同k值下所提模型的F1指标值。可以看出,当k=4时,模型得到了最佳的F1指标值。鉴于此,后续实验中设置k=4。

| 表 1 不同k值下所提模型的实验结果 Tab.1 Experimental results obtained using the proposed model with different k values |

本文采用关系抽取任务中常用的3类评价指标:精确率P、召回率R和F1值。二分类中常用的计算公式为

| $P = \frac{{{\rm{TP}}}}{{{\rm{TP + FP}}}}$ |

| $R = \frac{{{\rm{TP}}}}{{{\rm{TP + FN}}}}$ |

| ${F_1} = \frac{{{\rm{2}}PR}}{{P{\rm{ + }}R}}$ |

式中:TP(true positives)表示将正样本预测为正的样本数;FP(false positives)表示将负样本预测为正的样本数;FN(false nagatives)表示将正样本预测为负的样本数。

3.4 对比算法将AGLSTM模型与10种典型关系抽取方法进行对比,它们分别为

1)逻辑回归模型(logistics regression, LR)。

2)支持向量机模型(support vector machine, SVM)。

3)双向LSTM模型+注意力机制(BiLSTM+Att)[4]:该模型将双向LSTM模型与注意力机制结合进行关系抽取。

4)位置感知注意力LSTM模型(PA-LSTM)[19]:该模型通过对引入实体位置的注意力机制建立模型。

5)最短依存路径LSTM模型(SDP-LSTM)[6]:该模型使用2个实体之间的最短依存路径,并结合LSTM模型进行建模。

6)树结构LSTM模型(tree-LSTM)[7]:不同于以往的顺序LSTM模型,该模型结合句子依存关系树将LSTM推广到树形结构。

7)分段注意力LSTM模型(SA-LSTM)[25]:考虑到部分实体关系信息包含在句子中的某些片段的情况,该模型设置了分段注意力层来进行这种信息的提取,给出了分段注意力LSTM模型。

8)实体感知注意力LSTM模型(EA-LSTM)[26]:结合了实体感知注意力和潜在实体类型,该模型给出了一种新的端到端的神经网络模型。

9)图卷积神经网络模型(GCN)[8]:该模型提出了一种以路径为中心的剪枝策略。结合图卷积网络,在最大限度保留有关内容的同时,GCN能从树中删除无关信息,进一步提高关系抽取的性能。

10)注意力导向图卷积神经网络模型(AGGCN)[10]:该模型给出了一种基于注意力机制的软修剪策略,并采用图卷积进行建模。

在上述10种对比方法中,LR与SVM是基于机器学习的模型;BiLSTM+Att、PA-LSTM、SDP-LSTM、SA-LSTM和EA-LSTM隶属于基于顺序结构的神经网络模型;Tree-LSTM、GCN与AGGCN为基于依赖结构的神经网络模型。本文通过与这3大类模型进行对比,验证所提模型的有效性。

3.5 结果分析 3.5.1 数据集TACRED表2展示了AGLSTM和对比算法处理该数据时得到的3个性能指标值。可以看出:与基于机器学习的模型LR相比,在3个指标(P、R和F1)上,所提AGLSTM模型都获得了最优的指标值。特别地,AGLSTM所得R和F1值明显高于LR所得值。

| 表 2 TACRED数据集实验结果 Tab.2 Experimental results on TACRED |

与3种基于顺序结构的神经网络模型(PA-LSTM、SDP-LSTM和SA-LSTM)相比,AGLSTM获得了明显优于3种算法的P指标值。以PA-LSTM为例,AGLSTM的P指标值提升了8.3;在召回率R指标上,SA-LSTM和PA-LSTM的结果要好于本文所提模型AGLSTM。然而,从综合指标F1值来看,AGLSTM的结果要明显优于3种算法。相对PA-LSTM、SDP-LSTM和SA-LSTM,AGLSTM的F1指标值分别提升了2.4、8.8和0.6。这主要因为,相比基于顺序结构的神经网络模型,AGLSTM可以同时捕捉文本中顺序结构和依赖结构信息。

与基于依赖结构的神经网络模型Tree-LSTM和GCN相比,AGLSTM模型的F1值分别提高了5.1和3.5。这表明,在捕获复杂语法特性模式、建立句子长期依赖关系模型方面,AGLSTM的能力要优于两种对比算法。与AGGCN模型相比,AGLSTM模型的F1值提高了2.4。这说明,AGLSTM在满足捕获句子结构信息的同时,也能很好地捕获上下文的时序信息。另外,在精确率P上,本文所提AGLSTM模型的结果也要明显高于其他模型。综上可见,相比于其他对比算法,AGLSTM模型是一种极具竞争力的关系抽取方法。

3.5.2 数据集SemEval 2010 task 8将AGLSTM模型与多种典型对比算法用于该数据集,表3给出了它们所得的F1指标值。一方面,F1指标是对精确率P和召回率R的统一融合,可以更为全面地反映算法的性能;另一方面,相关对比文献仅仅给出了该数据集的F1值。鉴于此,本文也只使用F1值作为评价指标。

| 表 3 SemEval数据集实验结果 Tab.3 Experimental results on SemEval |

相比TACRED数据集,SemEval数据集的样本规模较小,共有10 717条数据。通过表3可知,所提AGLSTM模型在小规模数据集SemEval上也能取得较好的效果。与基于机器学习的模型SVM相比,7种基于神经网络模型的抽取算法都获得了较好的F1值。这说明,复杂语义信息的提取对语言模型的建立有很大帮助,也对关系抽取的结果产生了很大影响,而神经网络模型更适合进行语义信息的建模。与基于顺序结构的神经网络模型(CNN+Att、Bilstm+Att、SDP-LSTM和PA-LSTM)相比,AGLSTM所得F1值分别提高了1.2、1.3、1.6和2.6;与基于依赖结构的神经网络模型SPTree和GCN相比,AGLSTM模型的F1值分别提高了0.9和0.5。这主要因为,相比这些对比算法,AGLSTM可以同时捕捉文本中顺序结构和依赖结构等2方面信息。

3.6 消融分析表4和表5分别展示了AGLSTM模型在2个数据集上消融分析的结果。针对TACRED数据集,由表3可知:1)删除LSTM层时,AGLSTM的F1值下降了1.8。这说明,利用LSTM对特征进行初次提取对后续GLSTM层的处理有很大的帮助。2)当删除注意力层时,AGLSTM模型的F1结果下降了1.7。这意味着,注意力层在模型机构中起到很重要的作用。3)当移除句法依存信息时,F1结果下降了0.5。本文所提模型是以句子结构为基础实现的注意力机制,所以当除去句子结构信息时,模型使用的注意力机制退化为依据句子顺序序列实现的传统注意力机制。可见,句子结构信息在模型中也起到了较为重要的作用。

| 表 4 TACRED数据集上的消融研究结果 Tab.4 Ablation analyses on TACRED |

| 表 5 SemEval数据集上的消融研究结果 Tab.5 Ablation analyses on SemEval |

类似地,在对SemEval数据集进行分析时发现,当分别去掉句法依存信息、LSTM层、注意力层时,AGLSTM的F1指标值也均有所下降。这些都说明,上述3个结构在模型训练中起了重要的作用。

采用配置为2080Ti的单个GPU进行模型训练,图4、5展示了所提模型在处理数据集TACRED和Semeval时消融分析的训练时长。可以看出,针对2个数据集,AGLSTM模型的运行花费分别为653 min和76 min;当分别除去LSTM层、句子结构信息和注意力机制时,模型的训练时间均有所降低;特别地,当除去注意力机制时,AGLSTM运行时间的减少幅度最为明显。这说明,注意力机制确实对模型复杂度有较大影响,同时它也显著提高了模型的性能。此外,多头注意力机制中的K值也会影响模型的复杂度。当K从2变化到5时,模型训练的时间呈现递增趋势。

|

Download:

|

| 图 4 TACRED数据集下模型训练时间分析 Fig. 4 Model training time analysis under the TACRED dataset | |

|

Download:

|

| 图 5 Semeval数据集下模型训练时间分析 Fig. 5 Model training time analysis under the Semeval dataset | |

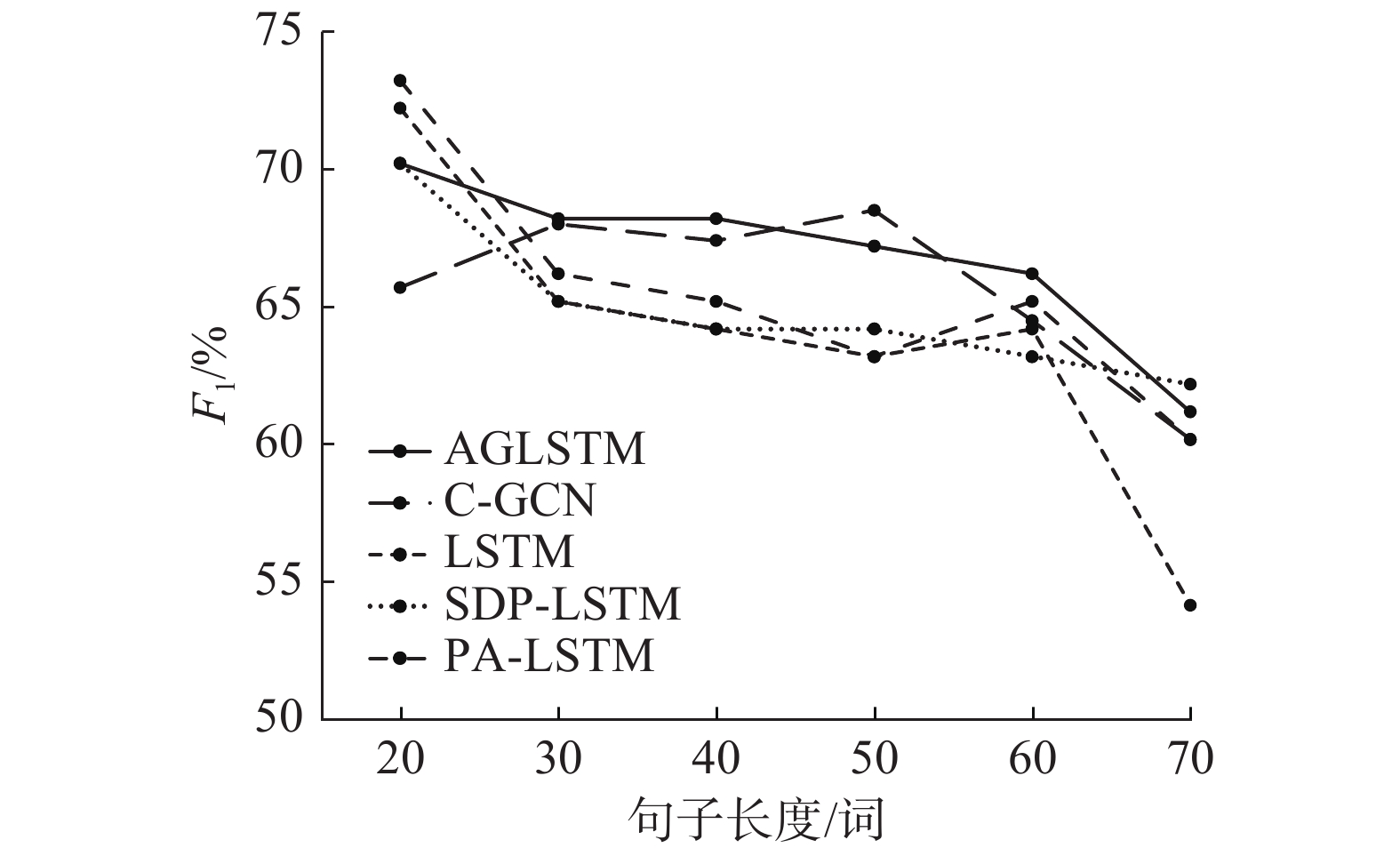

从表2和表3的实验结果可知,相对其他对比模型,在采用相同训练集和测试集的情况下,所提模型在数据集TACRED和SemEval都取得了较高的F1值。这在一定程度上说明所提模型的泛化性好于其他对比模型。针对不同句子长度进行模型泛化性分析,将数据集TACRED划分成不同句子长度的数据集,图6展示了不同句子长度下所提模型的F1值。可以看出:1)当句子长度位于20~60时,所提模型的F1值变化不大,而其他对比模型的F1值变化幅度都要大于本文所提模型。这说明本文所提模型更加稳定,具有更好的泛化性和鲁棒性;2)与SDP-LSTM、PA-LSTM和LSTM等基于顺序神经网络的模型相比,在处理较短句子时,基于图结构神经网络的模型(AGLSTM和GCN)的性能表现略差;但是,对于复杂长句子,AGLSTM和GCN的性能远高于3种基于顺序神经网络的模型。这表明,相对基于顺序神经网络的模型,基于图神经网络的模型可以更好地处理复杂句子。

|

Download:

|

| 图 6 句子长度分析结果 Fig. 6 Results of the sentence length analysis | |

本节通过对模型中使用的注意力机制进行可视化分析,说明所提模型更具可解释性。注意力机制的可视化显示了句中每个单词对于其他词的重要程度,可以通过注意力机制来获得更丰富的词汇表征。图7展示了句子“In an August 2004 Fortune article, Countrywide CEO Angelo Mozilo was mocking WaMu for its stumbles in the mortage business.”的可视化结果。

图7中4个子图分别对应4个注意力机制的头。本文通过全连接构建完整的句子结构,因此每个单词对句子中所有单词均有一个权重,图7中颜色的深浅代表关系权重的高低,即单词之间相关性的强弱。可以看出,图7中对角线的颜色普遍较深,说明每个单词对应自己的权重最大;“Countrywide”和“Angelo Mozilo”是一对实体对,“Countrywide”是一个机构名,它的权重主要集中在“CEO”和“article”等相近的词上;“Angelo Mozilo”是一个人名,它的注意权重主要集中在“CEO”、“was”和“mocking”等表现人物特征的词上。实际上,这些词对“Countrywide”和“Angelo Mozilo”之间关系“org:top_members/ employees”有很重要的预测作用。因此这些词学习到的注意力权重较大,颜色较深;其他单词对于句子结构信息的建模也起着一定的作用,不能完全忽略,其颜色较浅。这些都表明,模型使用的注意力机制可以更好地建模句子的全局结构信息。

|

Download:

|

| 图 7 注意力机制可视化分析 Fig. 7 Visual analysis of the attention mechanisms | |

本文提出了一种新型的注意力图长短时记忆神经网络模型(AGLSTM)。该模型将注意力机制与句子结构树结合,实现了模型自主学习句子结构信息的功能。所提模型不仅拥有很好的捕捉复杂语义关系和依赖结构的能力,并且弥补了图卷积网络对时序信息捕捉能力差的不足。与10种关系提取模型或方法进行对比,实验结果表明,所提模型在关系抽取上具有较佳的性能,其准确率要远高于其他对比模型。在未来工作中,将深入研究句内结构以及句间结构的信息提取,将模型进行完善并应用到句间关系抽取任务。

| [1] |

杨志豪,洪莉,林鸿飞,等. 基于支持向量机的生物医学文献蛋白质关系抽取[J]. 智能系统学报, 2008(4): 361-369. Yang Zhihao, Hong Li, Lin Hongfei, et al. Extraction of information on protein-protein interaction from biomedical literatures using an SVM[J]. CAAI transactions on intelligent systems, 2008(4): 361-369. (  0) 0)

|

| [2] |

李智超. 图文知识图谱中的关系抽取算法研究[D]. 北京: 北京邮电大学, 2018. LI Zhichao. A relation extraction algorithm in multi-modal knowledge graph[D]. Beijing: Beijing University of Posts and Telecommunications, 2018. (  0) 0)

|

| [3] |

张涛,贾真,李天瑞,等. 基于知识库的开放领域问答系统[J]. 智能系统学报, 2018, 13(4): 557-563. ZHANG Tao, JIA Zhen, LI Tianrui, et al. Open-domain question-answering system based on large-scale knowledge base[J]. CAAI transactions on intelligent systems, 2018, 13(4): 557-563. DOI:10.1016/j.ins.2018.12.032 (  0) 0)

|

| [4] |

ZHOU Peng, SHI Wei, TIAN Jun, et al. Attention-based bidirectional long short-term memory networks for relation classification[C]//Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics. Berlin, Germany: Association for Computational Linguistics, 2016: 207−212.

( 0) 0)

|

| [5] |

ZHANG Lei, XIANG Fusheng. Relation classification via BiLSTM-CNN[C]//Proceedings of the 3rd International Conference on Data Mining and Big Data. Shanghai, China: Springer, 2018: 373−382.

( 0) 0)

|

| [6] |

XU Yan, MOU Lili, LI Ge, et al. Classifying relations via long short term memory networks along shortest dependency paths[C]//Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing. Lisbon, Portugal: Association for Computational Linguistics, 2015: 1785−1794.

( 0) 0)

|

| [7] |

TAI K S, SOCHER R, MANNING C D. Improved semantic representations from tree-structured long short-Term memory networks[C]//Proceedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing. Beijing, China: Association for Computational Linguistics, 2015: 1556−1566.

( 0) 0)

|

| [8] |

ZHANG Yuhao, QI Peng, MANNING C D. Graph convolution over pruned dependency trees improves relation extraction[C]//Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. Brussels, Belgium: Association for Computational Linguistics, 2018: 2205−2215.

( 0) 0)

|

| [9] |

甘丽新, 万常选, 刘德喜, 等. 基于句法语义特征的中文实体关系抽取[J]. 计算机研究与发展, 2016, 53(2): 284-302. GAN Lixin, WANG Changxuan, LIU Dexi, et al. Chinese named entity relation extraction based on syntactic and semantic features[J]. Journal of computer research and development, 2016, 53(2): 284-302. DOI:10.7544/issn1000-1239.2016.20150842 (  0) 0)

|

| [10] |

GUO Zhijiang, ZHANG Yan, LU Wei. Attention guided graph convolutional networks for relation extraction[C]//Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence, Italy: ACL, 241−251.

( 0) 0)

|

| [11] |

FU T J, LI P H, MA Weiyun. GraphRel: modeling text as relational graphs for joint entity and relation extraction[C]//Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence, Italy: Association for Computational Linguistics, 2019: 1409−1418.

( 0) 0)

|

| [12] |

PENG Nanyun, POON H, QUIRK C, et al. Cross-sentence N-ary relation extraction with graph LSTMs

[J]. Transactions of the association for computational linguistics, 2017, 5: 101-115. DOI:10.1162/tacl_a_00049 ( 0) 0)

|

| [13] |

SONG Linfeng, ZHANG Yue, WANG Zhiguo, et al. N-ary relation extraction using graph state LSTM[C]//Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. Brussels, Belgium: Association for Computational Linguistics, 2018: 2226−2235.

( 0) 0)

|

| [14] |

ZHOU Peng, XU Jiaming, QI Zhenyu, et al. Distant supervision for relation extraction with hierarchical selective attention[J]. Neural networks, 2018, 108: 240-247. DOI:10.1016/j.neunet.2018.08.016 ( 0) 0)

|

| [15] |

JI Guoliang, LIU Kang, HE Shizhu, et al. Distant supervision for relation extraction with sentence-level attention and entity descriptions[C]//Proceedings of the 31st AAAI Conference on Artificial Intelligence. San Francisco, USA: AAAI Press, 2017.

( 0) 0)

|

| [16] |

ZHANG Shu, ZHENG Dequan, HU Xinchen, et al. Bidirectional long short-term memory networks for relation classification[C]//Proceedings of the 29th Pacific Asia Conference on Language, Information and Computation. Shanghai, China: PACLIC, 2015: 73−78.

( 0) 0)

|

| [17] |

ZELENKO D, AONE C, RICHARDELLA A. Kernel methods for relation extraction[J]. The journal of machine learning research, 2003, 3: 1083-1106. ( 0) 0)

|

| [18] |

ZENG Daojian, LIU Kang, LAI Siwei, et al. Relation classification via convolutional deep neural network[C]//Proceedings of COLING 2014, the 25th International Conference on Computational Linguistics: Technical Papers. Dublin, Ireland: Dublin City University and Association for Computational Linguistics, 2014: 2335−2344.

( 0) 0)

|

| [19] |

ZHANG Yuhao, ZHONG V, CHEN Danqi, et al. Position-aware attention and supervised data improve slot filling[C]//Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. Copenhagen, Denmark: Association for Computational Linguistics, 2017: 35−45.

( 0) 0)

|

| [20] |

马语丹, 赵义, 金婧, 等. 结合实体共现信息与句子语义特征的关系抽取方法[J]. 中国科学: 信息科学, 2018, 48(11): 1533-1545. MA Yudan, ZHAO Yi, JIN Jing, et al. Combining entity co-occurrence information and sentence semantic features for relation extraction[J]. Scientia sinica informationis, 2018, 48(11): 1533-1545. DOI:10.1360/N112018-00157 (  0) 0)

|

| [21] |

MINTZ M, BILLS S, SNOW R, et al. Distant supervision for relation extraction without labeled data[C]//Proceedings of the Joint Conference of the 47th Annual Meeting of the ACL and the 4th International Joint Conference on Natural Language Processing of the AFNLP. Suntec, Singapore: Association for Computational Linguistics, 2009: 1003−1011.

( 0) 0)

|

| [22] |

ZENG D, KANG L, CHEN Y, et al. Distant supervision for relation extraction via piecewise convolutional neural networks[C]//Proceedings of the Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processin. Lisbon, Portugal, 2015: 1753−1762.

( 0) 0)

|

| [23] |

HENDRICKX I, KIM S N, KOZAREVA Z, et al. Semeval-2010 task 8: Multi-way classification of semantic relations between pairs of nominals[C]//Proceedings of the 5th International Workshop on Semantic Evaluation. Uppsala, Sweden: ACM, 2010: 33−38.

( 0) 0)

|

| [24] |

PENNINGTON J, SOCHER R, MANNING C. GloVe: global vectors for word representation[C]//Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing. Doha, Qatar: Association for Computational Linguistics, 2014: 1532−1543.

( 0) 0)

|

| [25] |

YU Bowen, ZHANG Zhenyu, LIU Tingwen, et al. Beyond word attention: using segment attention in neural relation extraction[C]//Proceedings of the 28th International Joint Conference on Artificial Intelligence. Macao, China: IJCAI, 2019: 33−38.

( 0) 0)

|

| [26] |

LEE J, SEO S, CHOI Y S. Semantic relation classification via bidirectional LSTM networks with entity-aware attention using latent entity typing[J]. Symmetry, 2019, 11(6): 785. DOI:10.3390/sym11060785 ( 0) 0)

|

2021, Vol. 16

2021, Vol. 16