危化品仓库中存储物通常是易燃、易爆、腐蚀性强的危险化学品。危化品存储时,有些种类严禁混存,可以混存的有严格距离要求,违反这些规定会引发重大的安全事故,危化品的存储安全是当前亟待解决的问题。针对复杂的危化品仓储环境,前人主要从危险化学品堆垛安全距离[1-4]、堆垛位置布局[5]优化方面来解决问题,这些方法大部分是布置静态摄像头计算距离,但是存在镜头遮挡和计算偏差等问题。将卷积神经网络应用于危化品仓储巡检车视觉中,利用自动巡检车对仓库进行自动巡检,并实时给出反馈是当前研究的热点。实际危化品仓库中光线不清、危化品货物压线、危化品场景多变、仓库巡检路线遮挡等都会造成巡检困难。当场景变化比较多的时候,需要模型具有较强的适应能力。

目前卷积神经网络研究中,网络层数和神经元数目越来越多,模型对特征的刻画和表达能力越来越强,测试准确率不断提高。但是随着参数不断增多,模型复杂度迅速提升,计算复杂度越来越高,计算时间越来越长。然而实际工业应用中,模型需要具备快速的训练方法,较强的适用能力。卷积神经网络必须降低网络的训练时长和计算复杂度才能得到实际的工业应用。因此,基于卷积神经网络的危化品仓储巡检车的视觉模型应当在保持准确率的同时,具有规模小、训练速度快的特点。

在设计卷积神经网络时,需要保持特征提取能力的同时减少参数数量,压缩、修剪网络框架是目前较常用降低计算复杂度的方法。Srinivas等[6]提出了修剪神经元的方法,在神经元显著性最低时删除两个相似神经元中的一个神经元,提高了计算效率,简化了网络架构,但是神经元显著性的量化难于界定。Han等[7]在训练网络架构时探索连接的重要性,修剪不重要的连接以减少连接的数量。在一定程度上,修剪连接可以简化网络架构,但是性能与修剪神经元相比还是差强人意的。Chen等[8]提出了HashedNets,使用一个哈希函数将权重随机分组到HashedNets中,一个HashedNets中的连接将共享相同的参数,参数共享极大地简化了计算过程,加速网络训练速度,但是参数在共享计算时并非对网络架构中的所有神经元都是友好的。在文献[9]中,权值小于阈值的连接将被视为不必要的连接并被删除,对权值进行量化,并对量化后的权值进行霍夫曼编码,进一步压缩网络,精简网络框架,但是阈值的设定需要一定的工作量。网络压缩[10-13]、网络剪枝[14]、Dropout[15-16]的相关改进本质上都是精简网络架构,修剪神经元、修剪神经元之间的连接、Dropout神经元,使网络变得稀疏,简化计算过程。同时,由于在一定程度上抑制提取的特征同化现象,可以有效缓解过拟合的发生。

本文将卷积神经网络应用于危化品仓储巡检车中,主要任务为实现巡检车自主巡检,为加快loss收敛速度对传统卷积神经网络算法进行改进,提出了一种基于泊松分布的Dropout方法。

1 相关工作 1.1 卷积神经网络卷积神经网络[17-19]能够很好地利用图像的结构信息,可以较完整地提取图像中的特征信息。文献[20]研究表明,全链接层可以保证模型表示能力的迁移。

1.2 具体实现搭建网络架构[21],如图1所示,本文的参数设置经过多次在本样本上实验测试,综合考量loss与准确率情况选定而来。

|

Download:

|

| 图 1 网络架构 Fig. 1 Network architecture | |

网络框架参数设置:

首先,将原始图片归一化为

| $ L\left( {\theta ,{\theta ^*},X} \right) = {\rm{MSE}} = \frac{1}{n}{\sum\limits_{i = 1}^n {\left\| {\widetilde {{y_i}}\left( {X,\theta _i^*} \right) - {y_i}\left( {X,{\theta _i}} \right)} \right\|} ^2} $ |

以上的卷积神经网络模型在实验样本中取得了较好的测试结果,但是仍存在训练过程中损失下降及收敛缓慢、对其他危化品仓库场景样本适应性较低的问题。因此,本文对Dropout进行改进,提出基于泊松分布的Dropout方法。

2 PSdropout抽样算法根据观察,不频繁更新的神经元在后期的训练中,最终会以较大的概率被关闭。如果尽早根据网络中神经元节点的历史激活状态进行神经元取舍,理论上可以快速找到作用大的子网络,从而提高网络的训练速度。

2.1 理论分析及算法步骤无Dropout的传统卷积网络计算公式为

| $\begin{array}{c} z_i^{\left( {l + 1} \right)} = w_i^{l + 1}{y^l} + b_i^{l + 1}\\ y_i^{\left( {l + 1} \right)} = f\left( {z_i^{l + 1}} \right) \end{array}$ |

2012年,Hinton[15]在论文中提出Dropout,当一个复杂的神经网络用于训练特征较为简单的数据集时,会很容易出现过拟合现象,主要表现为训练时测试准确率很高、测试时测试准确率很低。为了防止过拟合,可以通过阻止特征检测器的共同作用来提高神经网络的性能。

采用Dropout的网络计算公式为

| $r_j^{\left( l \right)} \sim B\left( {{p_m}} \right)$ | (1) |

| $\mathop {{y^l}}\limits^ \sim = {r^{\left( l \right)}}*{y^{\left( l \right)}}$ | (2) |

| $z_i^{\left( {l + 1} \right)} = w_i^{\left( {l + 1} \right)}\mathop {{y^l}}\limits^ \sim + b_i^{\left( {l + 1} \right)}$ | (3) |

| $y_i^{\left( {l + 1} \right)} = f\left( {z_i^{\left( {l + 1} \right)}} \right)$ | (4) |

Dropout方法神经元去留概率服从伯努利分布,根据式(1)~(4)对网络框架进行更新。DropConnect[24]不再是随机将隐含层节点的输出清0,而是将节点中的每个与其相连的输入权值以一定的概率清0,在输入处修剪掉多余的连接,在Dropout概率设置为0.5时在本层网络中可以节省一半的计算量。以此算法作为实验中的对比算法。

泊松概率分布[25](poisson distribution)描述的是在某段时间或某个空间内发生随机事件次数的概率,也就是根据过去某个随机事件在某段时间或某个空间内发生的平均次数。在PSdropout抽样算法中,统计前一阶段训练中一定步数内的网络框架中全链接层的神经元的修改次数情况,作为下一阶段网络训练更新的指导,基于PSdropout的抽样算法神经元权重的筛选是服从泊松分布的。

采用PSdropout抽样算法的网络计算公式包括:

| ${p_m} = \frac{{{C_w}}}{{{R_{{\rm{times}}}}}}$ | (5) |

| $p_m^\prime = \left\{ \begin{array}{l} 1,\;\;{p_m} \geqslant {p_0} \\ 0,\;\;{p_m} < {p_0} \end{array} \right.$ | (6) |

| $r_j^{(l)} \sim P\left( {p_m^\prime } \right)$ | (7) |

| $\tilde {{y^l}} = r_j^{\left( l \right)}*{y^{\left( l \right)}}$ | (8) |

| $z_i^{\left( {l + 1} \right)} = w_i^{\left( {l + 1} \right)}\tilde {{y^l}} + b_i^{\left( {l + 1} \right)}$ | (9) |

| $y_i^{\left( {l + 1} \right)} = f\left( {z_i^{\left( {l + 1} \right)}} \right)$ | (10) |

首先,根据式(5)记录当前神经元的修改次数

取出张量

按PSdropout更新当前层,公式如式(5)~(10)。

2.2 理论推导Dropout与PSdropout抽样算法不同之处在于神经元的去留服从分布不同,极大似然估计的依据是概率最大的事件最可能发生,在神经元去留问题上,神经元激活不同数目可作为不同事件,改进的PSdropout使具有积极意义的神经元最大化的激活这一事件发生概率可由极大似然估计进行推导。另外,在理论中找相等是很难的,泊松分布和伯努利分布的极大似然相似,即可证明其有一定的相似性。对比伯努利分布与泊松分布,观测二者的极大似然估计值如下:

Dropout:在实验中,神经元去留概率服从伯努力分布:

| $ D = \{ y_1,y_2, \cdots ,y_n\},\;\;y \sim B(\mu ) $ |

似然函数为

| $ L = p\left( {D\left| \mu \right.} \right) = \displaystyle\mathop \Pi \limits_{n = 1}^N p\left( {{y_n}\left| \mu \right.} \right) =\displaystyle \mathop \Pi \limits_{n = 1}^N {\mu ^{{y_n}}}{\left( {1 - \mu } \right)^{\left( {1 - {y_n}} \right)}} $ |

取对数,整理化简:

| $\begin{array}{c}l = \ln p\left( {D\left| \mu \right.} \right) = \displaystyle\sum\limits_{n = 1}^N {\ln \left\{ {{\mu ^{{y_n}}}{{\left( {1 - \mu } \right)}^{\left( {1 - {y_n}} \right)}}} \right\}} = \\ \displaystyle\sum\limits_{n = 1}^N {\left\{ {{y_n}\ln \mu {\rm{ + }}\left( {1 - {y_n}} \right)\ln \left( {1 - \mu } \right)} \right\}}\end{array} $ |

最大化似然函数,取导数为0的极值:

| $ \begin{array}{*{20}{c}} {\dfrac{{{\rm{\partial}} l}}{{\partial \mu }} = \displaystyle\sum\limits_{n = 1}^N {\left\{ {{y_n}\dfrac{1}{\mu }\left( {1 - {y_n}} \right)\dfrac{1}{{1 - \mu }}} \right\}} = \dfrac{1}{{\mu \left( {1 - \mu } \right)}}\left\{ {{y_n} - \mu } \right\} = 0}\\ {{\mu _{{\rm{MLE}}}} = \dfrac{1}{N}\displaystyle\sum\limits_{n = 1}^N {{y_n}} } \end{array} $ |

PSdropout抽样算法:在实验中,神经元的去留服从泊松分布:

| $D = \{ y_1,y_2, \cdots ,y_n\},\; y \sim P(\lambda )$ |

似然函数:

| $L = \mathop \Pi \limits_{n = 1}^N \frac{{{\lambda ^{{y_n}}}}}{{{y_n}!}}{{\rm{e}}^{ - \lambda }} = {{\rm{e}}^{ - n\lambda }}\mathop \Pi \limits_{n = 1}^N \frac{{{\lambda ^{{y_n}}}}}{{{y_n}!}}$ |

取对数,整理化简:

| $l = \ln L = - n\lambda + \sum\limits_{n = 1}^N {\left( {{y_n}\ln \lambda - \ln {y_n}} \right)} $ |

最大化似然函数,取导数为0的极值:

| $ \begin{array}{*{20}{c}} {\dfrac{{\partial l}}{{\partial \lambda }} = - N + \displaystyle\sum\limits_{n = 1}^N {\dfrac{{{y_n}}}{\lambda }} = 0}\\ {{\lambda _{{\rm{MLE}}}} = \dfrac{1}{N}\displaystyle\sum\limits_{n = 1}^N {{y_n}} } \end{array} $ |

两种分布最终的极大似然函数取值相同,因此PSdropout抽样算法的神经元抽样方法的选取是合理的。

3 实验在主频为2.20 GHz,CPU为GTX1080 Ti GPU的服务器上,将典型卷积神经网络模型和改进后的网络模型进行实验并对比结果。

3.1 数据集实验中,选用不同的数据集对原始算法和PSdropout抽样算法的实验结果进行整理,以证明PSdropout抽样算法的有效性。采用智能小车采集彩色160×120大小的实验现场照片,将该数据命名为Car数据集,含有4个训练子集,样本数量为5 000、10 000、15 000、20 000;同时含有1个2 000张照片的测试集。在实验中,使用了深度学习网络架构对Car数据集进行训练。

部分Car原始场景训练数据集如图2所示,该数据集主要是危化品仓库中良好状态下采集的样本,采集样本过程中无障碍物遮挡路线、光线条件良好,拍摄清晰,以最优条件下采集的素材作为实验中的训练集。

|

Download:

|

| 图 2 原始场景样本图 Fig. 2 Sample pictures of original scene | |

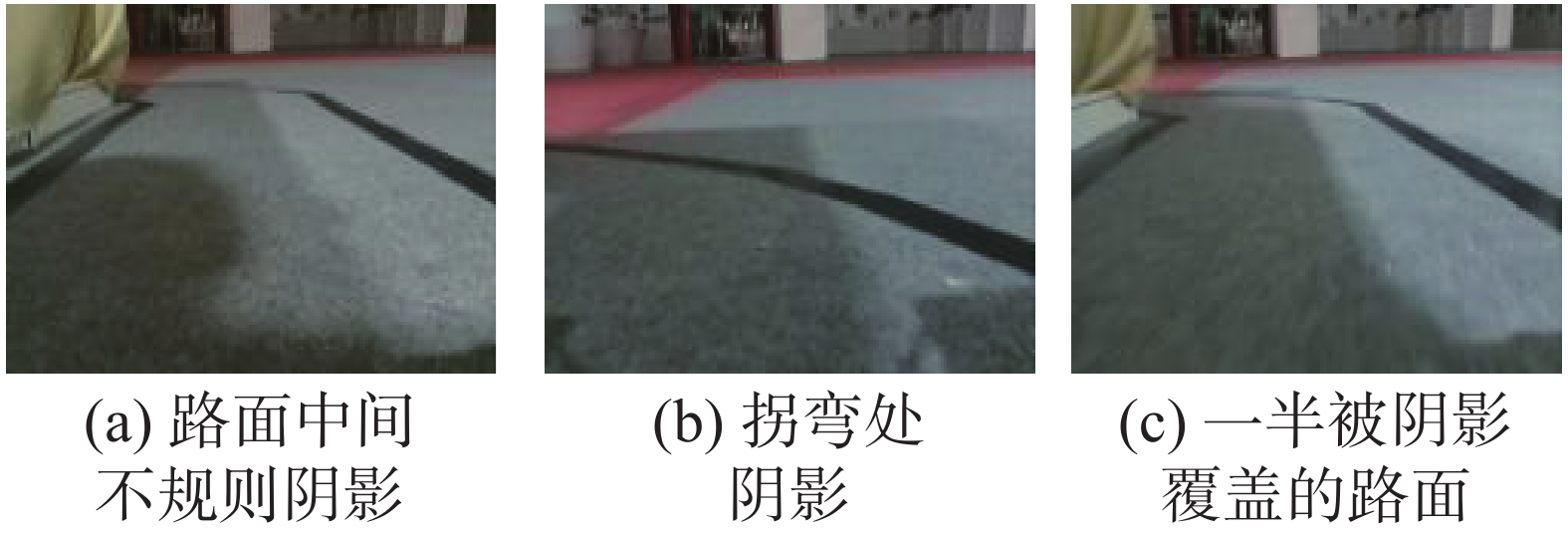

在实际的危化品仓库中,危化品智能巡检车的道路情况并非如实验样本中的理想化状态,实际采集的样本在道路线上存在着光线条件不好、障碍物遮挡道路线、不明物体遮挡道路线等一系列情况,将复杂场景情况下采集的道路样本作为数据集,为以后在实际的危化品仓库中的应用以及重新训练奠定基础。图3为部分复杂样本图。

|

Download:

|

| 图 3 复杂场景样本图 Fig. 3 Sample photos of complex scene | |

在深度学习训练中,训练数据是很重要的,在样本量方面,一是要有尽量多的训练样本,二是要保证样本的分布够均匀。但实际采集数据的过程中,不同样本量的设置训练出来的网络架构以及测试结果也差异较大,为探究PSdropout算法的稳定性,选取数量不同的原始场景样本制作Car数据集进行训练并在Car测试集上进行测试,对loss损失函数结果及测试结果进行分析:采集数据量为5000、10000、15000、20000的样本进行实验,学习率设为固定值,loss测试结果如表1,测试准确率结果如表2。

| 表 1 loss统计结果 Tab.1 Statistical loss results |

| 表 2 测试结果 Tab.2 Statistical test results |

将学习率设置为固定值,进行训练,训练中loss的变化无其他变化因素干扰,可以更好地观测PSdropout引起的变化。横向观测实验结果,就表1的loss统计结果来说,样本量分别定为5000、10000、15000、20000,DropConnect与Dropout相比,达到相同损失率时所用步骤相差不大,DropConnect最终取得的loss值较小,而PSdropout抽样算法相比于Dropout和DropConnect能够以更少的训练轮数步骤取得更小的loss值;就测试结果而言,在4组实验中,PSdropout测试率皆高于前两者。

纵向观测表2的测试结果,随着实验中训练样本的样本量不断增加,在3类实验中可以看到测试准确率处于不断下降状态,因为随着样本量的增加,网络的训练轮数不断增加,网络中的神经元会记忆训练样本,导致过学习现象。而较小的实验样本量训练中,PSdropout抽样算法以较少的训练步数取得了较好的loss值,并且训练出的网络架构测试准确率更高。PSdropout抽样算法为现今面临的样本缺失问题提供了一个新的解决问题思路。综合上述实验中loss的收敛以及测试结果,PSdropout抽样算法对不同数量样本的训练集都有较好的适应能力,该算法是稳定健壮的。

3.3 多场景测试不同危化品仓库的地面与标志线差异较大,图4是一些危化品仓库的实景图,而实际仓库场景多,对于新场景的适应成为识别的一大难点。

|

Download:

|

| 图 4 复杂危化品仓库实景图 Fig. 4 Photos of complex chemical warehouses | |

因此,对多场景的适应能力好坏是评判改进算法的一个重要依据。在不同场景的样本上进行实验,分别用基于Dropout的原始算法、基于DropConnect的对比算法、基于PSdropout抽样算法进行实验,因为DropConnect是对神经元之间的连接的去留进行选择,来抑制过拟合现象,加速训练,与PSdropout算法中舍弃不活跃神经元的方法是一致的,因此选择基于DropConnect的卷积神经网络作为对比算法进行实验,loss结果如表3,测试结果如表4。

| 表 3 Loss统计结果 Tab.3 Statistical loss results |

| 表 4 测试结果 Tab.4 Statistical test results |

根据表3的loss统计结果,原始样本数据集训练完成时,调用原始算法时loss值未达到0.12,调用DropConnect时loss值达到0.12,调用PSdropout抽样算法时loss最低值为0.12;复杂场景样本数据集训练完成时,调用原始算法时loss最低值未达到0.13,调用DropConnect时loss值未达到0.13,调用抽样时loss最低值为0.13。根据表4测试结果,改进算法在原始样本数据集上训练的模型测试结果皆高于原始算法,原始算法在复杂场景样本数据集上训练的模型测试结果高于DropConnect和抽样。在保证正确率相差不大的前提下,PSdropout抽样算法的训练步数明显减少,训练速度提高。

3.4 网络架构适应性测试在实际的应用中,由于危化品仓库的跑道具有多样性、多变性,不同的危化品仓库,地面与标志线差异较大,场景多,对于新场景的适应成为识别的一大难点,因此需要把训练的样本在多种场景内进行应用,所以训练出的网络架构必须有较好的适应性,减少对样本的依赖。采取实验A和B对算法进行适应能力测试。实验A:在原始样本数据集上进行训练,用复杂样本作为测试集进行测试。实验B:在复杂样本数据集上进行训练,用简单样本作为测试集进行测试。表5中记录测试准确率:

| 表 5 适应性测试 Tab.5 Adaptive test results |

进行上述实验旨在检验两个算法训练的网络架构的适应性。由表5适应性测试的结果可以看出PSdropout抽样算法对不同场景的适应能力更强,因为PSdropout算法能尽早抽取出活跃的神经元,网络架构的学习能力更强,删除掉冗余的神经元,对于抑制过拟合现象有较好的贡献。这点对于实际的危化品仓库现今存在的样本采集困难、网络架构适应差等问题,PSdropout抽样算法提供了新的解决思路。

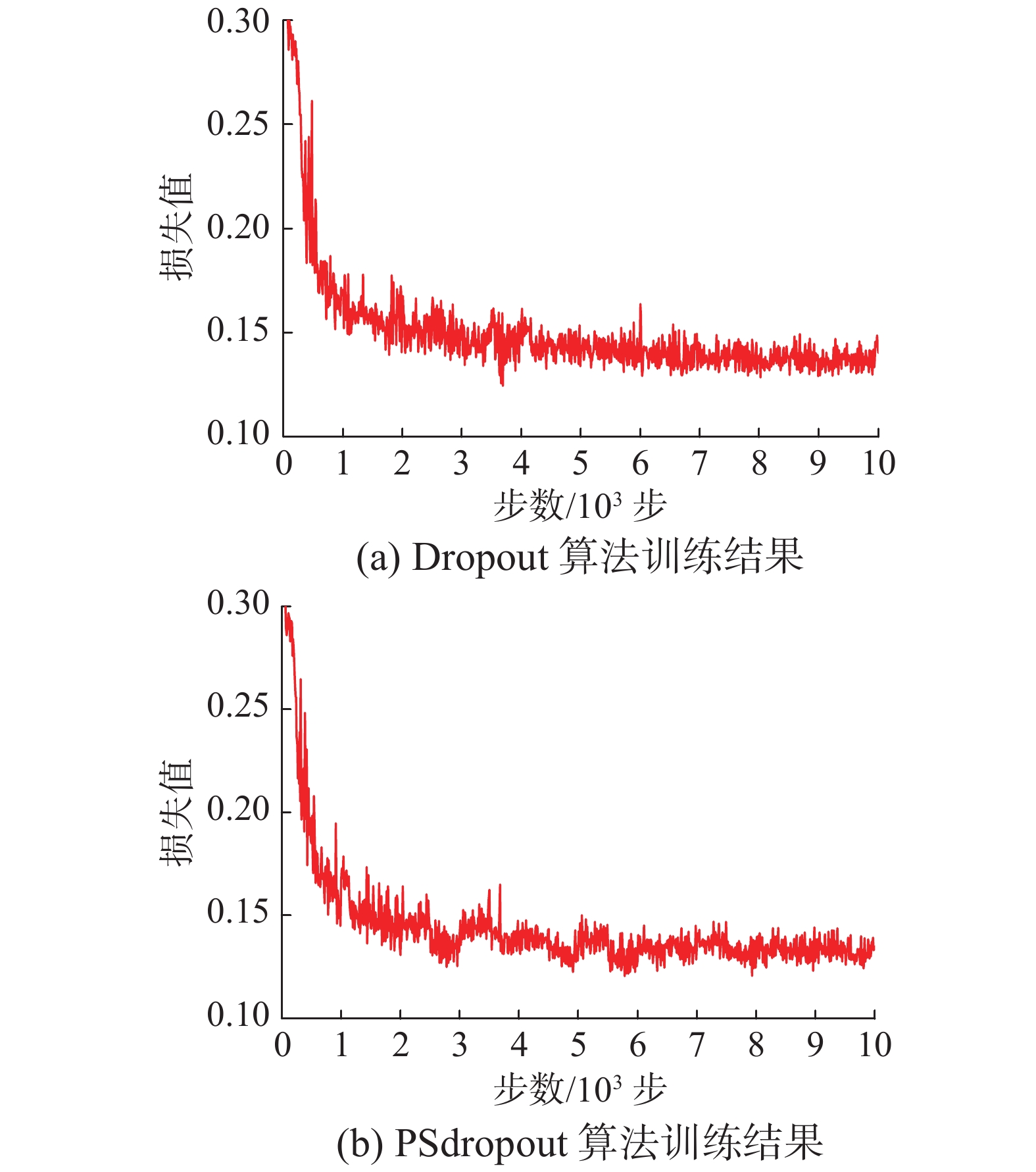

3.5 细节性实验在原始场景数据集上训练,实验参数设置如下。原始算法:batchsize为50,优化函数算法为随机梯度下降算法,实现参数更新,其中,学习率为固定值0.01。PSdropout抽样算法:在原始算法基础上,对训练结果进行统计,每500步统计1次,之后的500步训练根据前500步统计结果计算出式(5)中的P更新,修改次数少的继续抑制,修改次数多的进行激活。在原始场景数据集上实验结果loss函数值统计图如图5所示,横坐标为训练步数,纵坐标为loss值。

|

Download:

|

| 图 5 原始场景数据集上loss统计 Fig. 5 Loss statistics for the original scene data set | |

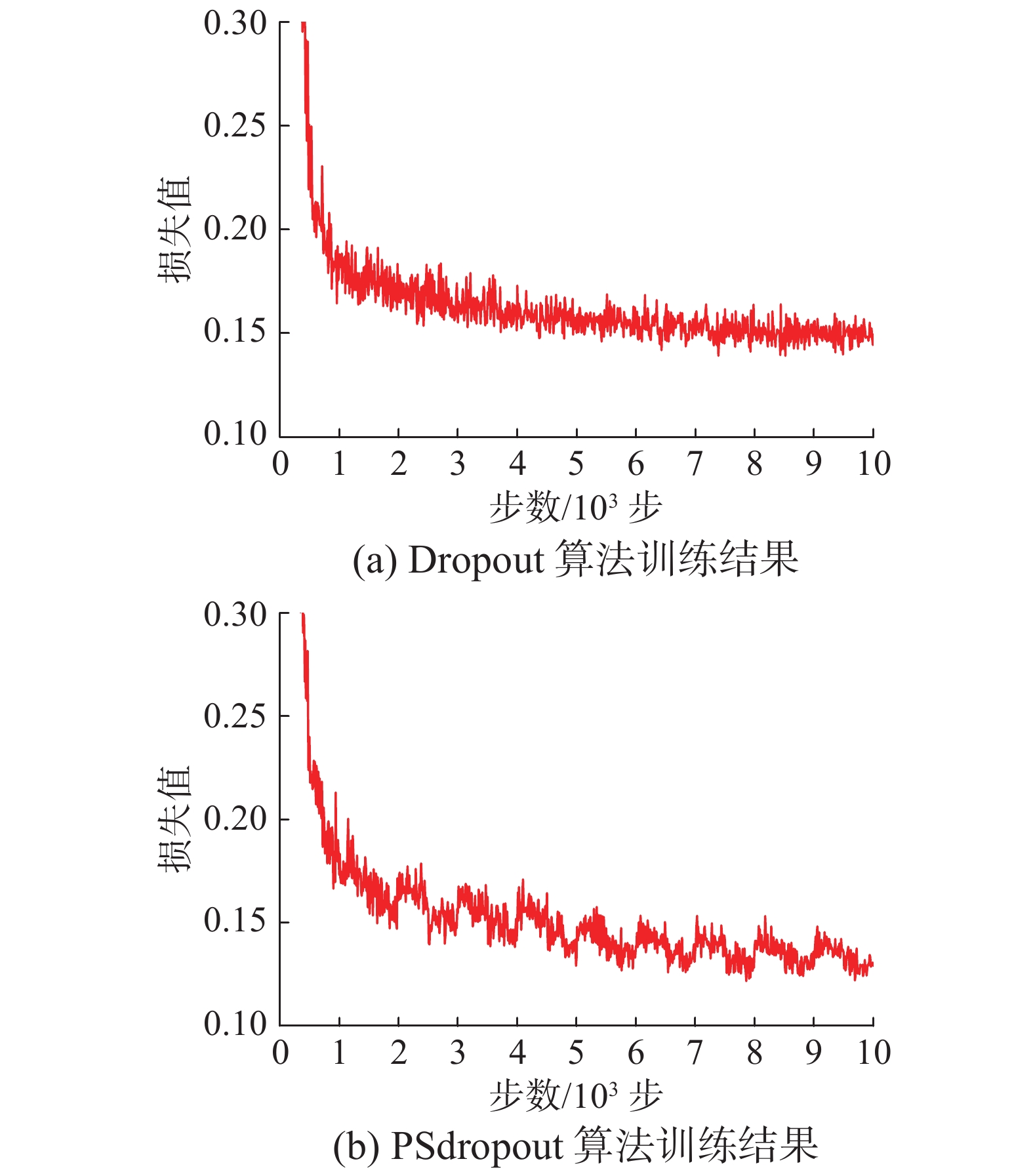

在复杂场景数据集上实验结果loss函数值统计如图6所示。

|

Download:

|

| 图 6 复杂场景数据集上loss统计 Fig. 6 Loss statistics for the complex scene data set | |

原始、复杂场景数据集上的loss统计结果、测试结果如表6所示。

| 表 6 loss及准确率统计结果 Tab.6 Loss and accuracy statistics |

在原始样本数据集上,由原始Dropout和PSdropout抽样的损失函数图(图5、图6)可以看出loss的细节变化情况,训练过程中,调用PSdropout抽样的每500步训练过程中,loss会明显下降到[0.005,0.01]区间,之后的训练在调用Dropout时,loss会在短时间内出现上升趋势。以训练3500~4500步的损失值变化为例分析,3500~4000调用PSdropout抽样算法时,loss的变化整体呈现迅速下降趋势,并且很快取得了loss的一个极小值0.13,低于调用原始dropout时的0.14;训练4000~5000步时,原始dropout的loss值急剧上升,出现这个变化的原因是对于网络架构有消极作用的神经元再次被激活。对以上实验数据整体进行观察,调用dropout算法的loss实验结果波动较大,训练中loss最小值大概为0.129,出现在训练步数为6700时,loss值收敛最终在0.14左右浮动;调用PSdropout抽样算法的loss实验结果,在实验训练过程中波动较小,数据较为稳定,训练中loss最小值大概为0.122,出现在训练步数为4900时,最终loss的收敛值在0.135左右浮动。复杂场景数据集由于道路环境复杂所以训练更为困难,因此,loss值大于原始场景数据集训练的loss;由表6观测测试准确率,PSdropout抽样算法测试结果和原始算法相差不大。综合loss下降速度和测试准确率来看,PSdropout抽样算法效果优于原始算法。

3.6 算法有效性验证实验Mnist数据集为分类实验公共数据集,在训练网络架构中主要提取的特征为手写体数字的边缘轮廓信息,而本实验提取的信息主要为危化品仓库道路样本的特征信息,侧重点同样在于道路边缘,因此,为了测试PSdropout抽样的稳定性与有效性,采用深度学习经典公共数据集Mnist进行实验,训练集6000张图片,测试集为1000张照片,大小为28×28的灰度照片。

对于数据集Mnist使用的损失函数是交叉熵损失函数,因为使用交叉熵能够提高精度和训练速度,函数使用的是交叉熵损失函数。

Mnist1:Mnist数据集,学习率调整形式为自动指数衰减,改进函数统计前1000步的训练结果,后续5000步按统计结果更新。

Mnist2:Mnist数据集,学习率为固定值,改进函数统计前1000步的训练结果,后续9000步按统计结果更新。

表7中记录了loss函数值与测试准确率结果。

| 表 7 Mnist数据集上训练结果 Tab.7 Training results for Mnist data set |

综合表7显示的Mnist数据集上的训练结果,进行分析。在实验Mnist1上,按自动指数衰减的形式进行学习训练,PSdropout抽样算法训练的网络架构获得的loss值下降迅速,最终的收敛值达到0.7,而Dropout算法未达到0.7,而且PSdropout抽样算法与Dropout算法的测试准确率相差不大;在Mnist2实验中,采用固定值学习率进行学习训练,PSdropout抽样算法在训练到10000步时,最终的收敛值达到0.6,而Dropout算法未达到0.6,PSdropout抽样算法测试准确率达到97.84%,而Dropout算法测试准确率为97.06%,而且在训练过程中PSdropout抽样波动更小,表现更为稳定。在Mnist数据集上,相较于调整学习率的学习方式,PSdropout抽样算法更适合固定学习率算法的学习方式。综合实验Mnist1、Mnist2,PSdropout抽样算法是优于Dropout算法的。

4 结束语本文提出将卷积神经网络应用于危化品仓库智能巡检车,为提高loss收敛速度和对新样本的适应性,提出一种基于泊松分布的Dropout方法,即PSdropout抽样算法,将此方法用于卷积神经网络中全链接层,根据前期的权重修改情况对神经元的去留作出取舍,神经元的去留情况服从泊松分布,充分利用神经元选择的历史情况,快速抽取出适合本样本的网络架构。理论上看,在充分利用神经元历史行为的基础上,本文的神经元去留概率与原始的Dropout算法去留概率的最大似然函数类似;实验结果表明,在保持正确率的情况下,训练提前收敛,节约了训练时间,并且提高了巡检车对不同复杂度道路的识别能力。后续可以将该方法与卷积神经网络的模型剪裁方法结合起来,进一步提高卷积神经网络训练速度。

| [1] |

刘学君, 江帆, 戴波, 等. 基于ARM的危化品仓库堆垛安全距离监测装置的研究与开发[J]. 制造业自动化, 2016, 38(4): 11-14, 25. LIU Xuejun, JIANG Fan, DAI Bo, et al. The research and development of stack safe distance monitoring device for the chemicals warehouse based on ARM[J]. Manufacturing automation, 2016, 38(4): 11-14, 25. DOI:10.3969/j.issn.1009-0134.2016.04.004 (  0) 0)

|

| [2] |

李琳. 基于UWB定位的危化品仓库管理的设计和研究[D]. 北京: 北京邮电大学, 2018. LI Lin. Design and research of hazardous chemicals warehouse management based on UWB positioning[D]. Beijing: Beijing University of Posts and Telecommunications, 2018. (  0) 0)

|

| [3] |

戴波, 周泽彧, 张岩, 等. 危化品仓储堆垛安全距离监测系统设计[J]. 化工学报, 2019, 70(002): 707-715. DAI Bo, ZHOU Zeyu, ZHANG Yan, et al. Design of safe distance monitoring system for hazardous chemicals storage stack[J]. CIESC Journal, 2019, 70(002): 707-715. (  0) 0)

|

| [4] |

戴波, 吕昕, 刘学君, 等. 基于UWB四参考点矢量补偿的危化品仓储堆垛货物定位方法[J]. 化工学报, 2016, 67(3): 871-877. DAI Bo, LÜ Xin, LIU Xuejun, et al. A UWB-based four reference vectors compensation method applied on hazardous chemicals warehouse stacking positioning[J]. CIESC journal, 2016, 67(3): 871-877. (  0) 0)

|

| [5] |

DAI Bo, LI Yanfei, REN Haisheng, et al. Research on optimization for safe layout of hazardous chemicals warehouse based on genetic algorithm[J]. IFAC-PapersOnline, 2008, 51(18): 245-250. ( 0) 0)

|

| [6] |

SRINIVAS S, BABU R V. Data-free parameter pruning for deep neural networks[C]//Proceedings of British Machine Vision Conference 2015. Swansea, UK, 2015: 1−12.

( 0) 0)

|

| [7] |

HAN Song, POOL J, TRAN J, et al. Learning both weights and connections for efficient neural networks[C]//Proceedings of the 28th International Conference on Neural Information Processing Systems. Montreal, Quebec, Canada, 2015: 1135−1143.

( 0) 0)

|

| [8] |

CHEN Wenlin, WILSON J, TYREE S, et al. Compressing neural networks with the hashing trick[C]//Proceedings of the 32nd International Conference on Machine Learning. Lille, France, 2015: 2285−2294.

( 0) 0)

|

| [9] |

HAN Song, MAO Huizi, DALLY W J. Deep compression: compressing deep neural networks with pruning, trained quantization and Huffman coding[C]//Proceedings of 2016 International Conference on Learning Representations. San Juan, Pucrto Rico, 2015: 3−7.

( 0) 0)

|

| [10] |

MA Rongrong, NIU Lingfeng. A survey of sparse-learning methods for deep neural networks[C]//Proceedings of 2018 IEEE/WIC/ACM International Conference on Web Intelligence. Santiago, Chile, 2018: 647−650.

( 0) 0)

|

| [11] |

李江昀, 赵义凯, 薛卓尔, 等. 深度神经网络模型压缩综述[J]. 工程科学学报, 2019, 41(10): 1229-1239. LI Jiangyun, ZHAO Yikai, XUE Zhuoer, et al. A survey of model compression for deep neural networks[J]. Chinese journal of engineering, 2019, 41(10): 1229-1239. (  0) 0)

|

| [12] |

纪荣嵘, 林绍辉, 晁飞, 等. 深度神经网络压缩与加速综述[J]. 计算机研究与发展, 2018, 55(9): 1871-1888. JI Rongrong, LIN Shaohui, CHAO Fei, et al. Deep neural network compression and acceleration: a review[J]. Journal of computer research and development, 2018, 55(9): 1871-1888. DOI:10.7544/issn1000-1239.2018.20180129 (  0) 0)

|

| [13] |

王晓华, 杨新艳, 焦李成. 基于多尺度几何分析的复杂网络压缩策略[J]. 电子与信息学报, 2009, 31(4): 968-972. WANG Xiaohua, YANG Xinyan, JIAO Licheng. Compression of complex networks based on multiscale geometric analysis[J]. Journal of electronics & information technology, 2009, 31(4): 968-972. (  0) 0)

|

| [14] |

YU Jie, TIAN Shen. A review of network compression based on deep network pruning[C]//Proceedings of the 3rd International Conference on Mechatronics Engineering and Information Technology. Dalian, China, 2019: 324−335.

( 0) 0)

|

| [15] |

HINTON G E, SRIVASTAVA N, KRIZHEVSKY A, et al. Improving neural networks by preventing co-adaptation of feature detectors[J]. Computer Science, 2012, 3(4): 212−223.

( 0) 0)

|

| [16] |

BALDI P, SADOWSKI P. The dropout learning algorithm[J]. Artificial intelligence, 2014, 210: 78-122. DOI:10.1016/j.artint.2014.02.004 ( 0) 0)

|

| [17] |

周飞燕, 金林鹏, 董军. 卷积神经网络研究综述[J]. 计算机学报, 2017, 40(6): 1229-1251. ZHOU Feiyan, JIN Linpeng, DONG Jun. Review of convolutional neural network[J]. Chinese journal of computers, 2017, 40(6): 1229-1251. DOI:10.11897/SP.J.1016.2017.01229 (  0) 0)

|

| [18] |

李彦冬, 郝宗波, 雷航. 卷积神经网络研究综述[J]. 计算机应用, 2016, 36(9): 2508-2515, 2565. LI Yandong, HAO Zongbo, LEI Hang. Survey of convolutional neural network[J]. Journal of computer applications, 2016, 36(9): 2508-2515, 2565. DOI:10.11772/j.issn.1001-9081.2016.09.2508 (  0) 0)

|

| [19] |

陈先昌. 基于卷积神经网络的深度学习算法与应用研究[D]. 杭州: 浙江工商大学, 2014. CHEN Xianchang. Research on algorithm and application of deep learning based on convolutional neural network[D]. Hangzhou: Zhejiang Gongshang University, 2014. (  0) 0)

|

| [20] |

GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, USA, 2014: 580−587.

( 0) 0)

|

| [21] |

刘亦芃. 一种关于深度学习网络结构的改进策略[D]. 长春: 吉林大学, 2019. LIU Yipeng. A strategy for improving the structure of deep learning network[D]. Changchun: Jilin University, 2019. (  0) 0)

|

| [22] |

杨国亮, 许楠, 李放, 等. 关于非线性激活函数的深度学习分类方法研究[J]. 江西理工大学学报, 2018, 39(3): 76-83. YANG Guoliang, XU Nan, LI Fang, et al. Research on deep learning classification for nonlinear activation function[J]. Journal of Jiangxi University of Science and Technology, 2018, 39(3): 76-83. (  0) 0)

|

| [23] |

张永雄, 王亮明, 李东. 基于多示例深度学习与损失函数优化的交通标志识别算法[J]. 现代电子技术, 2018, 41(15): 133-136, 140. ZHANG Yongxiong, WANG Liangming, LI Dong. Traffic sign recognition algorithm based on multi-instance deep learning and loss function optimization[J]. Modern electronics technique, 2018, 41(15): 133-136, 140. (  0) 0)

|

| [24] |

WAN Li, ZEILER M, ZHANG Sixin, et al. Regularization of neural networks using dropconnect[C]//Proceedings of the 30th International Conference on Machine Learning. Atlanta, GA, USA, 2013: 1058−1066.

( 0) 0)

|

| [25] |

徐玉华, 曾明. 泊松分布性质及应用研究[J]. 长江大学学报(自科版), 2006, 04: 132-133. XU Yuhua, ZENG Ming. Poisson distribution properties and application research[J]. Journal of Yangtze University (Natural Science Edition), 2006, 04: 132-133. (  0) 0)

|

2020, Vol. 15

2020, Vol. 15