2. 中国电子科技集团公司第二十八研究所,江苏 南京 210007;

3. 常州大学 信息科学与工程学院,江苏 常州 213164

2. The 28th Research Institute of China Electronics Technology Group Corporation, Nanjing 210007, China;

3. School of Information Science and Engineering, Changzhou University, Changzhou 213164, China

道路交通标识的探测和检验在快速发展的智能交通领域受到了广泛的关注,其含有的限速、限行、限高提示、车道方向的指示等提示信息,为道路交通的通行效率和通行安全提供了保障,对其内容的研究具有重要意义。

现今有许多针对路标的检测方法,如:采用不同色彩空间[1-3]进行匹配检测的方法,对形状及轮廓[4-6]进行分割提取的方法,或融合形状与色彩特征[7]的检测方法、或采用深度学习、神经网络有关知识进行检测的方法[8-10]。以色彩空间为模板的检测方法最早由Yang等[11]提出,通过提取R层信息,构建待选模板,对路标图像进行粗略分割;因YCbCr色彩空间[12]具有受亮度变化影响较小的特点,采用依据图像Cb、Cr分量进行图像分割;提取形状特征模板的检测识别方法最早由Piccioli等[13]提出,后逐渐改进为SNCC算法[14]。现今采用多尺度的算法来识别检测,如马尔科夫随机场和基于贝叶斯的[15]、基于特征点采样和OSPA距离的[16]识别检测路标的算法,这些算法虽然在速度和准确率上有着特有的优势,但却有着严苛的限制条件,缺乏普适性。深度学习模型可以看作由多个人工神经网络层组成[17],通过构建含有多个隐层的神经网络模型,将低层特征通过逐层非线性特征组合变换,形成更加抽象的高层特征表达。加深模型网络是常用于提高检测识别准确率的方法之一,但随之而来会出现“退化”问题。He等[18]就提出了ResNet (residual neural network),缓解了“退化”现象,但并没有解决梯度爆炸问题。WMW团队提出了SENet (squeeze-and-excitation networks)模型[19],使用特征通道融合的方式,通过建模展现特征通道间依赖关系,从而强化有用特征并抑制无用特征。本文结合SENet和ResNet模型的原理,取各自优点,使用较小的网络层数来达到较高的识别水平。

因此针对上述存在的问题,本文所做的工作是:

1)提出了将HU不变量与色彩空间多尺度相结合进行处理的方法,减少光照影响,并除去复杂背景,降低无用特征被学习到的几率;

2)通过旋转数据增强及归一化操作,对小型数据集进行增强,满足网络训练要求,提高识别准确率;

3)结合SE网络和残差网络结构,构建了自己的网络模型。同时,通过调整相应的参数以适应路标图像的特点,采用浅层网络模型使训练时间得到大幅减少,保证具有较高识别准确率。

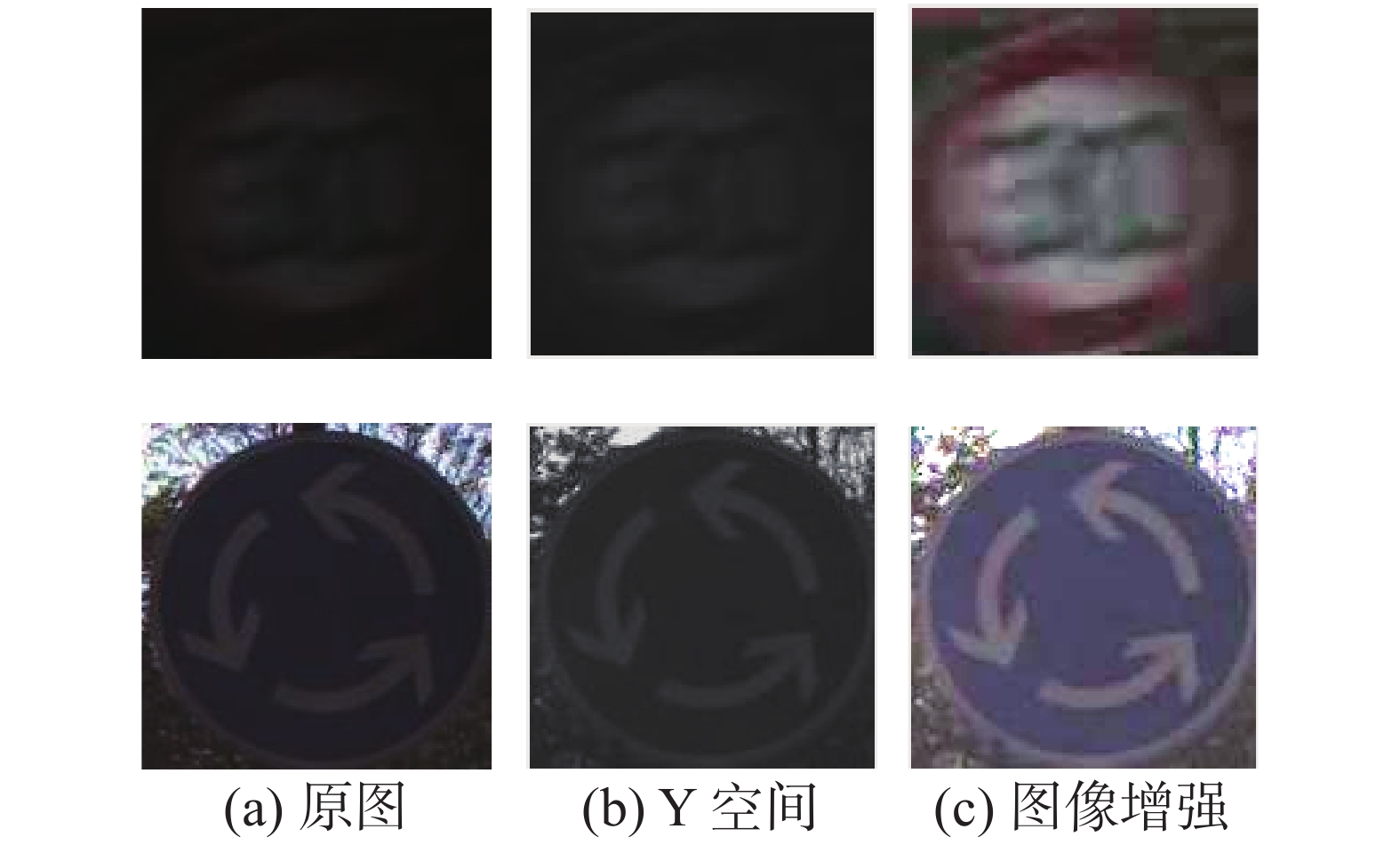

1 图像预处理 1.1 数据集的光照处理环境因素会给交通标识的图像采集工作带来很大的负面影响,从而造成识别困难。本文从RGB和YCbCr两个不同的颜色空间对图像进行阈值划分,从而实现对图像的预处理,降低环境因素干扰。RGB色彩空间模型通过构建红、绿、蓝3个通道的笛卡尔坐标系,来表示色彩图像,通道的取值范围为[0,1]。YCbCr色彩空间较RGB色彩空间能显示图像整体的亮度信息。将RGB图像转换成YCbCr空间表示的具体转换公式[20]为

| $\left[ {\begin{array}{*{20}{c}} Y \\ {{\rm{Cb}}} \\ {{\rm{Cr}}} \end{array}} \right] = \left[ {\begin{array}{*{20}{c}} {16} \\ {128} \\ {128} \end{array}} \right] + \left[ {\begin{array}{*{20}{c}} {0.257}&{0.504}&{0.098} \\ { - 0.148}&{ - 0.291}&{0.439} \\ {0.439}&{ - 0.368}&{ - 0.071} \end{array}} \right]\left[ {\begin{array}{*{20}{c}} R \\ G \\ B \end{array}} \right]$ |

经过空间换算,经过大量实验得到图像亮度阈值在

| ${{R}} = {{R}} + k(1 - {{R}}){\text{·}} {{R}}$ |

式中k为一个可调节参数。

|

Download:

|

| 图 1 曝光不足图像增强 Fig. 1 Insufficient exposure image enhancement | |

对于过曝图片的增强公式

|

Download:

|

| 图 2 过曝图像增强 Fig. 2 Overexposure image enhancement | |

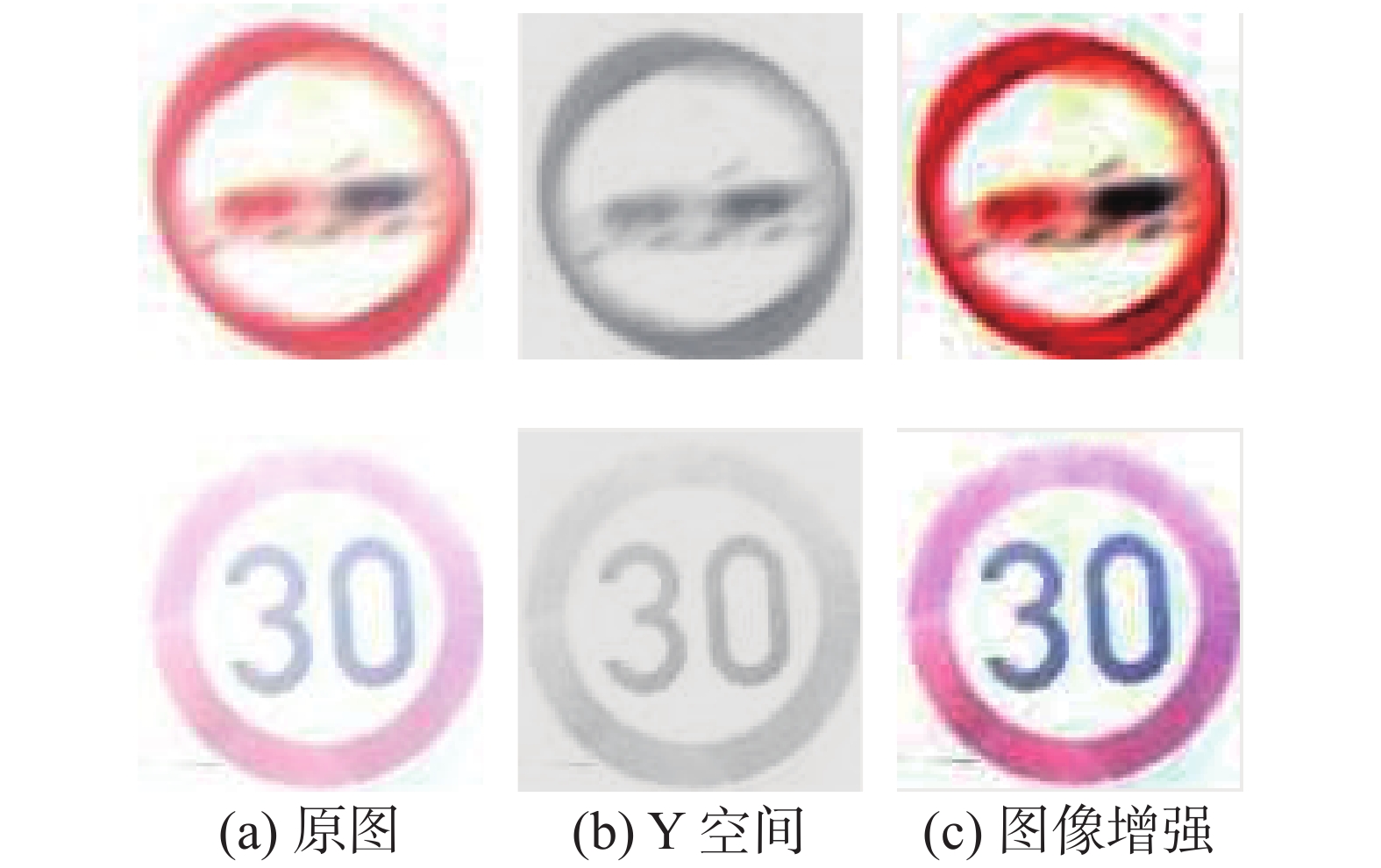

数字图像处理中,通过提取轮廓边界及形状特征进行分割是图像识别领域的一种常用的方法。本文整合交通标识图像的共有形状特征进行特征提取,降低神经网络在数据集训练时的无用特征学习。图3所示为交通标识形状特征图。

|

Download:

|

| 图 3 交通标识形状特征图 Fig. 3 Traffic-sign shape feature chart | |

通过形态学的开闭操作降低图像中的噪声,后用最大类间方差法寻找图像阈值,以阈值为界灰度图像转换为二值图像;最后使用孔洞填充提取图像特征形状。图4为操作示意图。

|

Download:

|

| 图 4 图像形状特征提取 Fig. 4 Shape feature extraction | |

在取得图像的形状特征后,可通过对比轮廓矩[21]的方式判断形状相似度。轮廓的

| ${m_{p,q}} = \int_{ - \infty }^\infty {\int_{ - \infty }^\infty { {I(x,y){x^p}{y^q}}} }\;\;f\left( {x,y} \right){\rm{d}}x{\rm{d}}y $ |

式中:

| ${m_{p,q}} = \sum\limits_{y = 1}^N {\sum\limits_{x = 1}^M {{x^p}{y^q}f(x,y)} } ,\begin{array}{*{20}{c}} {}&{p = 0,1,2, \cdots ;q = 1,2, \cdots} \end{array}$ |

| $\begin{split}&{\mu _{p,q}} = \sum\limits_{y = 1}^N {\sum\limits_{x = 1}^M {{{(x - \bar x)}^p}{{(y - \bar y)}^q}f(x,y)} } \\ &\quad{p = 0,1,2, \cdots;q = 1,2, \cdots } \end{split} $ |

式中

通过二阶和三阶归一化中心矩可以构造出7个不变矩

| $ \begin{array}{l} \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;{{{M}}_{\rm{1}}} = {\eta _{20}} + {\eta _{02}}\\ \;\;\;\;\;\;\;\;\;\;\;\;\;{{{M}}_{2}} = {({\eta _{20}} - {\eta _{02}})^2} + 4\eta _{11}^2\\ \;\;\;\;\;\;\;\;{{{M}}_{\rm{3}}} = {({\eta _{30}} - 3{\eta _{12}})^2} + {(3{\eta _{21}} - {\eta _{03}})^2}\\ \;\;\;\;\;\;\;\;\;\;\;\;\;{{{M}}_{\rm{4}}} = {({\eta _{30}} + {\eta _{12}})^2} + {({\eta _{21}} + {\eta _{03}})^2} \end{array} $ |

| $ \begin{array}{c} {{{M}}_{\rm{5}}} = ({\eta _{30}} - 3{\eta _{12}})({\eta _{30}} + {\eta _{12}})[{({\eta _{30}} + {\eta _{12}})^2} - 3{({\eta _{21}} + {\eta _{03}})^2}] + \\ \begin{array}{*{20}{c}} {}&{}&{(3{\eta _{21}} - {\eta _{03}})({\eta _{21}} + {\eta _{03}})[3{{({\eta _{21}} + {\eta _{03}})}^2} - {{({\eta _{21}} + {\eta _{03}})}^2}]} \end{array} \\ {{{M}}_{\rm{6}}} = ({\eta _{20}} - {\eta _{02}})[{({\eta _{30}} + {\eta _{12}})^2} - {({\eta _{21}} + {\eta _{03}})^2}] + \\ \begin{array}{*{20}{c}} {}&{}&{4{\eta _{11}}({\eta _{30}} + {\eta _{12}})({\eta _{21}} + {\eta _{03}})} \end{array} \\ {{{M}}_{\rm{7}}} = ({\eta _{20}} - {\eta _{02}})[{({\eta _{30}} + {\eta _{12}})^2} - {({\eta _{21}} + {\eta _{03}})^2}] + \\ \begin{array}{*{20}{c}} {}&{}&{ 4{\eta _{11}}({\eta _{30}} + {\eta _{12}})({\eta _{21}} + {\eta _{03}})} \end{array} \end{array} $ |

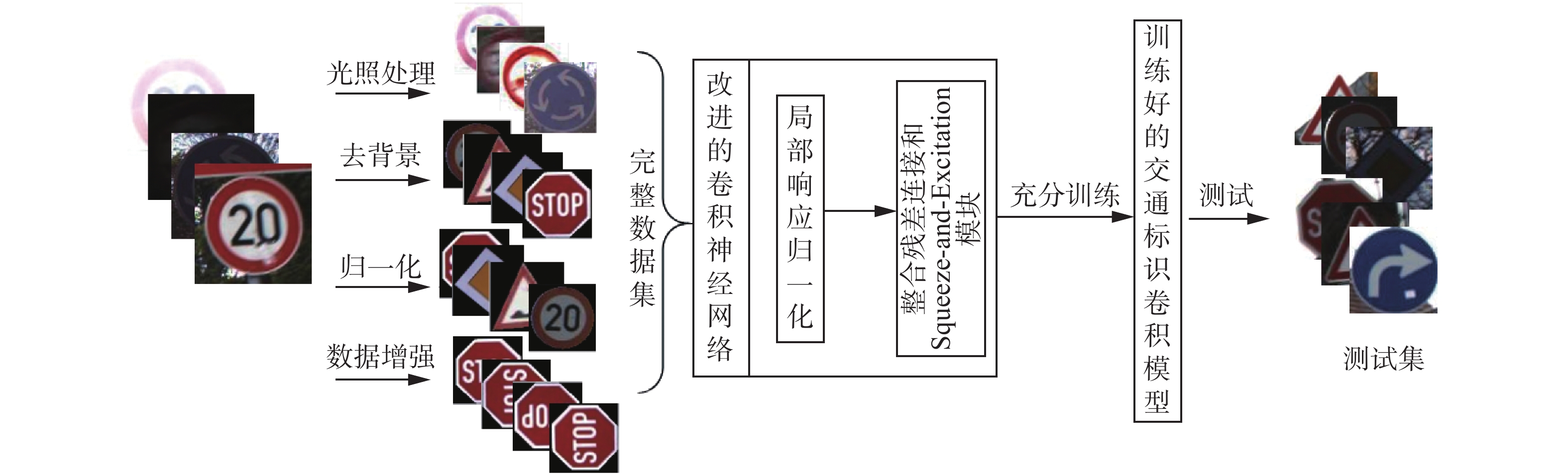

这7个不变矩构成了一组特征向量,通过将交通标识图像与标准轮廓图像形状进行特征向量的匹配,形成mask掩膜,进行路标特征的提取。图5表示mask掩膜的匹配生成及数据集图片的特征提取去背景。

|

Download:

|

| 图 5 掩膜与特征提取 Fig. 5 Mask and decontextualization | |

本文采用三次样条插值的方法[23]将深度学习模型所需的训练集归一化处理到

随着人们对神经网络的深入探索研究,衍生出了名为深度学习的思维理念,其中较为常用的叫卷积神经网络模型。其核心思想是通过反复的迭代,逐层反向调节网络中的权重参数来最小化损失函数同时提高识别率。为解决参数多、复杂度高等问题采用权值共享策略,而其稀疏连接的特性提高了并行处理能力及误差的容忍程度。卷积层(convolution layer)、池化层(pooling layer)和全连接层(Full-connection Layer)是卷积神经网络的主要构成部分;卷积神经网络结构示意图如图6。

|

Download:

|

| 图 6 卷积神经网络结构 Fig. 6 Structure of the convolutional neural network | |

文献[24]针对梯度爆炸问题,提出了一种局部响应归一化的思想,为提高网络模型的泛化能力减少过拟合程度,采用竞争机制,增大局部特征值的差距分化;文献[25]提出一种恒等映射拟合的方法优化深层网络的训练学习。局部响应归一化(local response normalization) 如图7所示:借鉴侧抑制思想,利用附近几层对特征中间层进行平滑处理,计算公式为

| $b_{x,y}^i = \dfrac{{a_{x,y}^i}}{{{{\left(k + \alpha \displaystyle\sum\limits_{j = \max \left(0,i - \frac{n}{2}\right)}^{\min (N - 1,i + \frac{n}{2})} {{{(a_{x,y}^j)}^2}} \right)}^\beta }}}$ |

式中:

|

Download:

|

| 图 7 局部响应归一化示意图 Fig. 7 Local response normalization diagram | |

图8为残差连接示意图,为降低梯度爆炸问题,简化训练学习过程,利用数学运算把式

|

Download:

|

| 图 8 残差连接 Fig. 8 Residual connection | |

深度学习模型的改进方法中,许多都从空间维度进行考量;而SENet(squeeze-and-excitation networks)通过使用特征重标定方法,不引入新的空间维度并考虑特征通道间的关系来进行特征通道融合。Squeeze-and-Excitation可以被任何形式如:

| $ {u_c} = {{{v}}_c} * {{X}} = \sum\limits_{s = 1}^{{C'}} {v_c^s * {x^s}} $ |

式中:

图9是Squeeze-and-Excitation模块思想的直观图。

|

Download:

|

| 图 9 Squeeze-and-Excitation模块 Fig. 9 A Squeeze-and-Excitation block | |

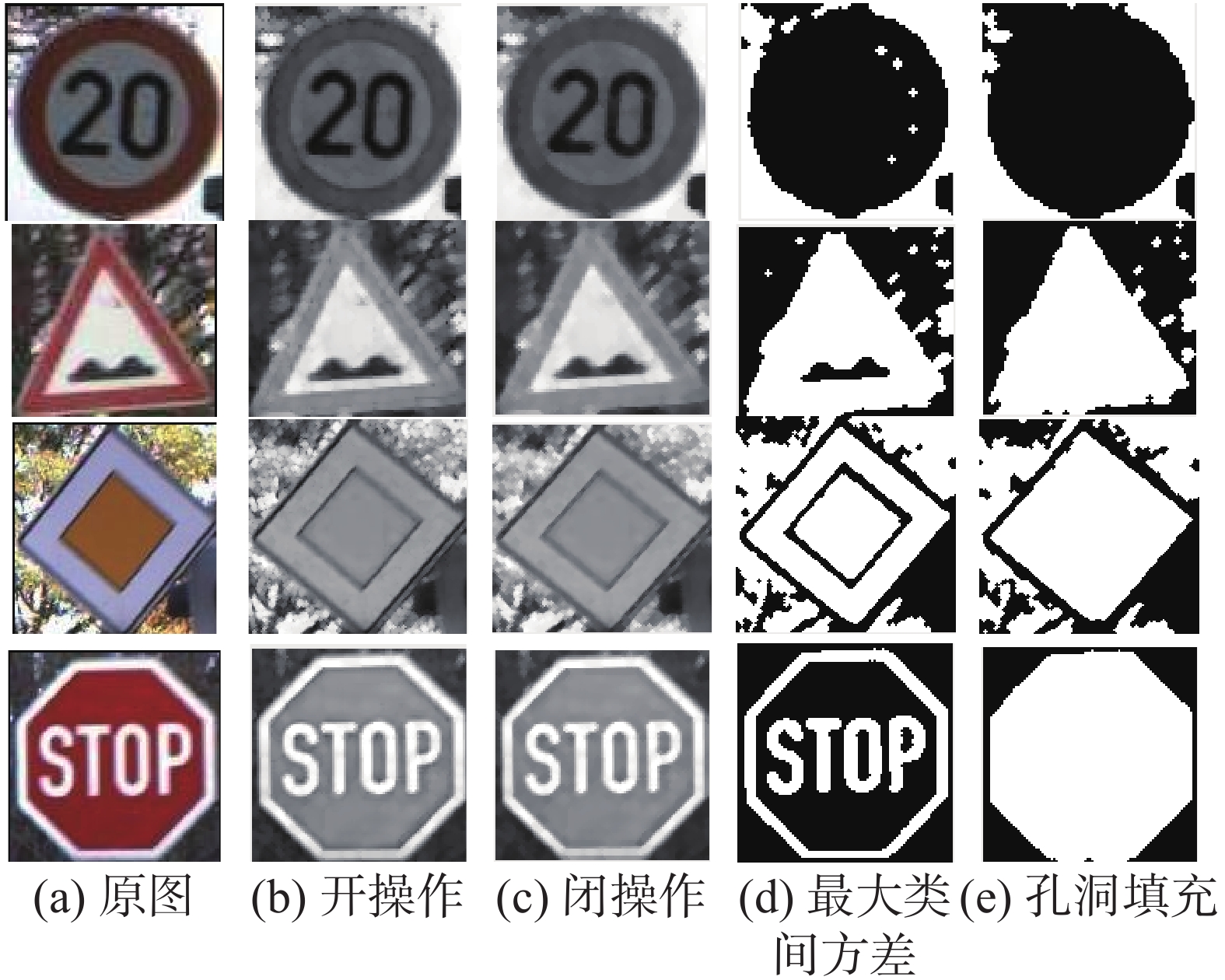

通过整合上述理论与公式,优化网络结构、调节模型参数、结合Squeeze-and-Excitation与残差连接思想,形成本文的算法,具体流程如图10:

1)对数据集进行特征提取及亮度值批量预处理操作;

2)对数据集进行归一化及数据增强操作;

3)结合Squeeze-and-Excitation模块及残差连接思想,调节参数优化网络模型结构,构建自己的网络模型,并对训练集进行充分训练学习;

4)利用训练好的模型结构对任意交通标识图像进行识别检测,验证模型算法。

|

Download:

|

| 图 10 基于深度学习改进的路标识别算法流程 Fig. 10 Improved road sign recognition algorithm flow using deep learning | |

实验采用德国交通标识标准数据库(GTSRB),其包含39209张训练集路标图像及12630张测试集路标图像,共有43类;以及比利时交通标识数据库(BelgiumTSC),其包含4590张训练集图像及2520张测试集图像,共62类。数据集中的图像大小从

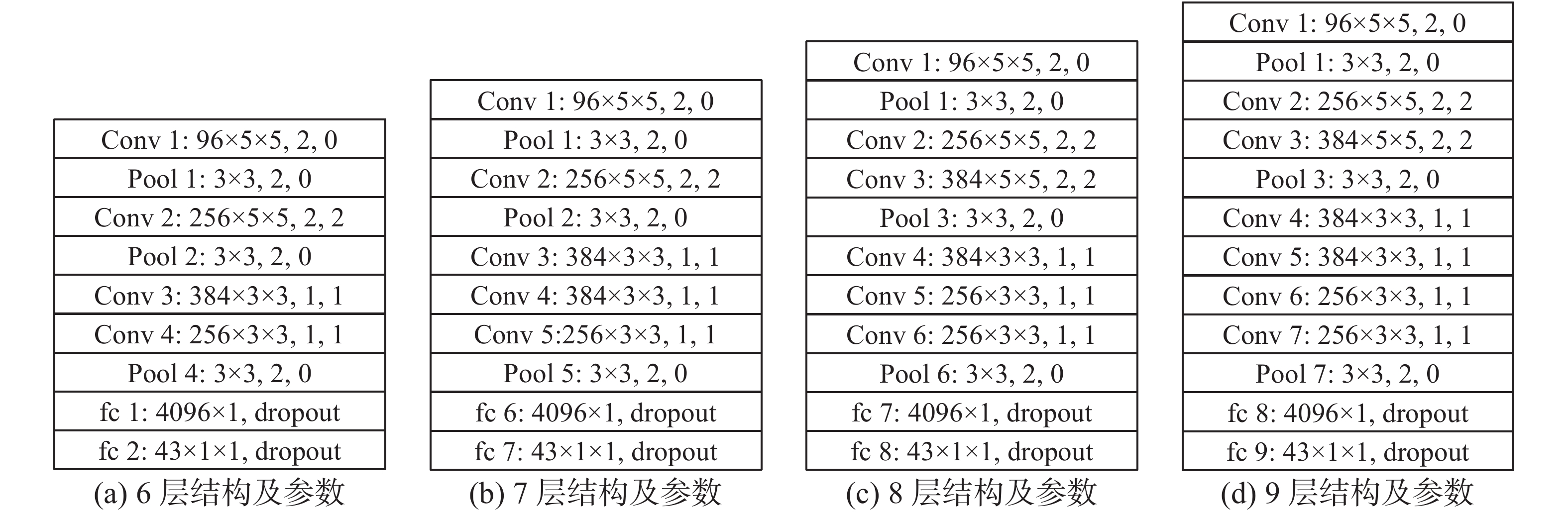

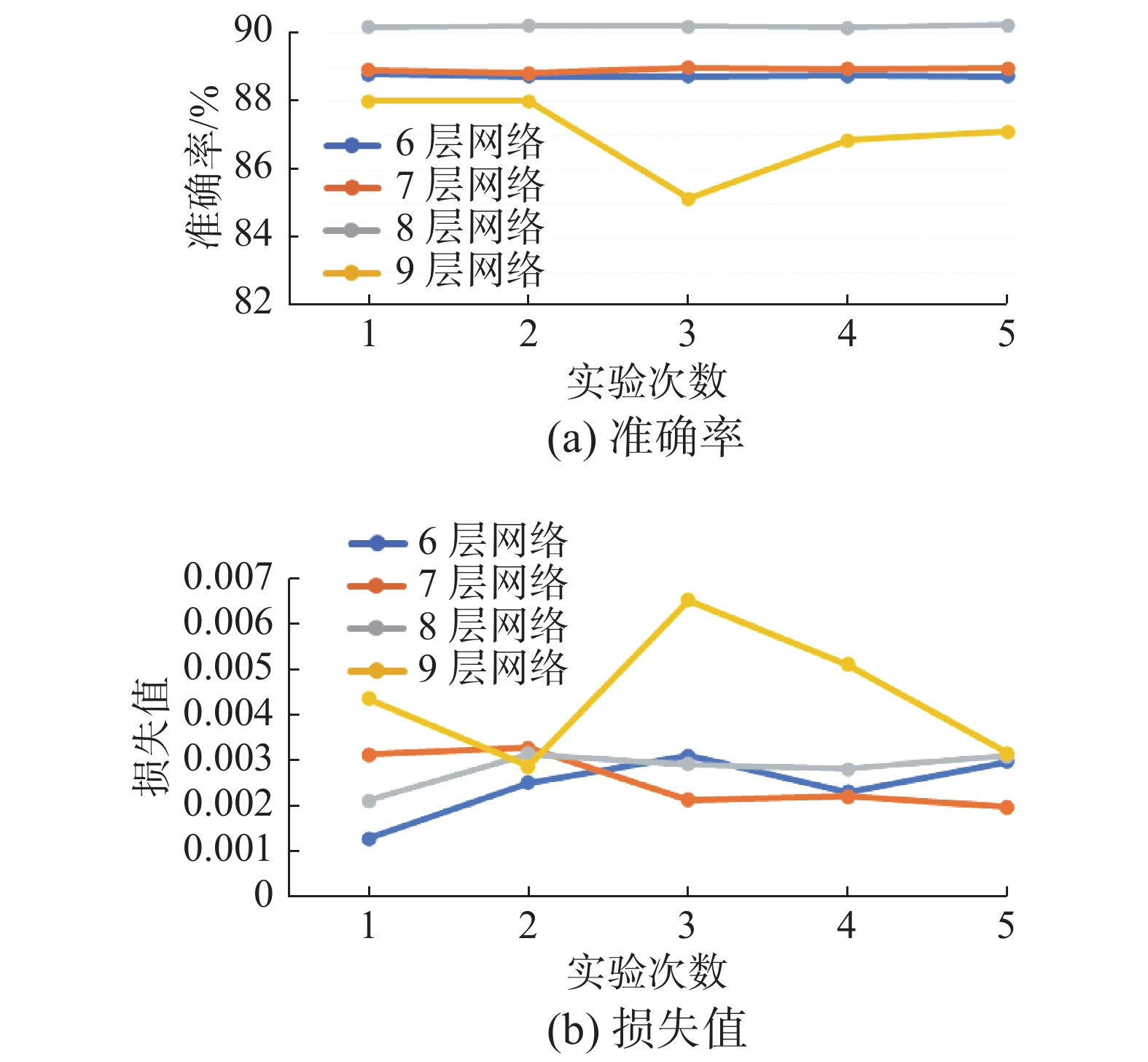

整合Squeeze-and-Excitation Networks思想和残差连接到经典AlexNet网络模型中进行对比实验。表1为经典网络及本文模型训练时间表。图11为模型层级及参数设定,图12和图13为不同深度模型在BelgiumTSC和GTSRB两数据集上的实验结果,迭代次数设置为30000,是多次实验抽取的结果展示,通过实验可得准确率与网络层级并非线性正相关关系,因为梯度爆炸问题,导致实验层级增加到10层之后模型开始无法收敛。

| 表 1 训练时间(比利时数据库) Tab.1 Training time(BelgiumTSC) |

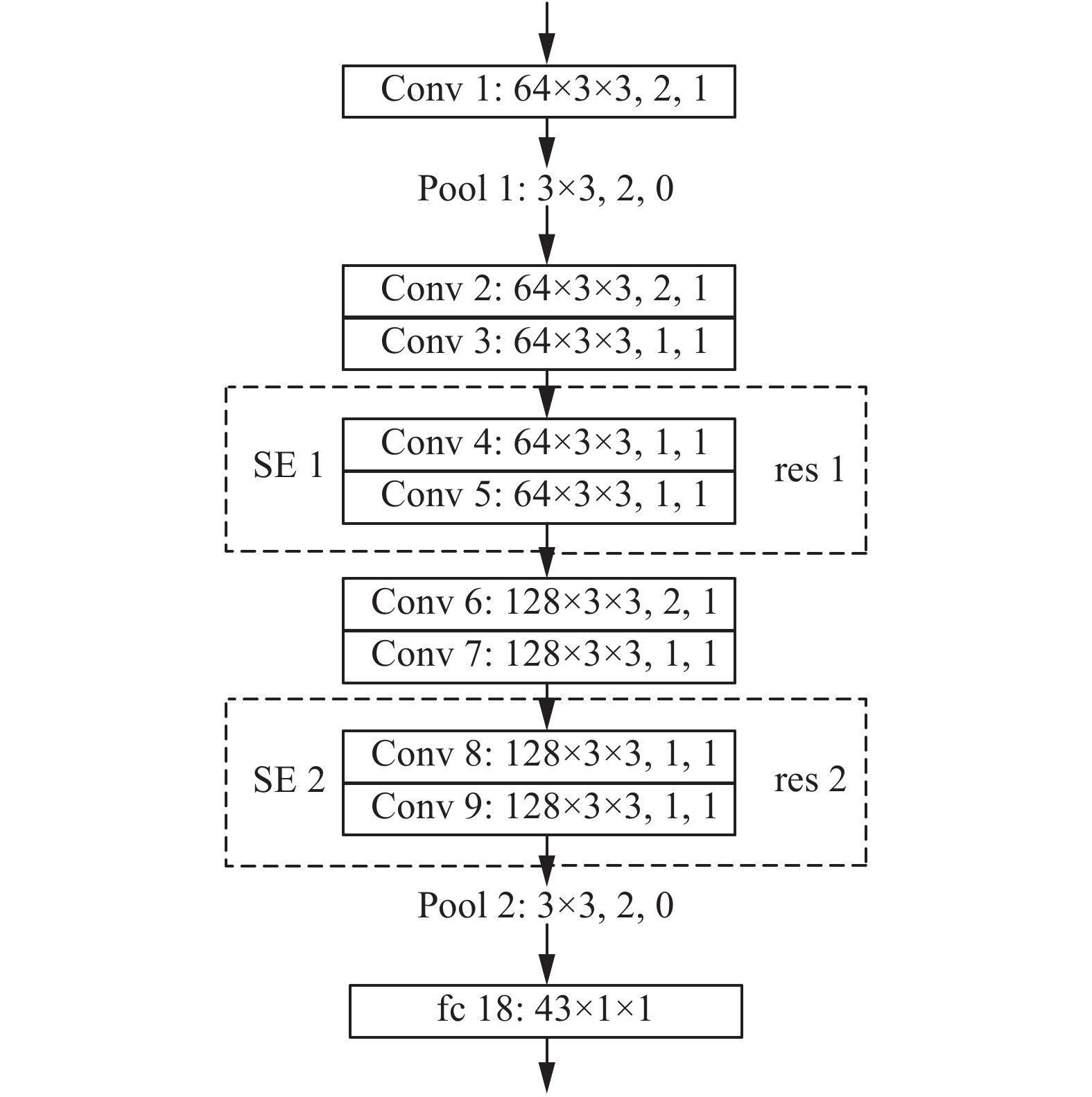

本文的网络模型结构如图14所示,分别为与经典的网络进行原始数据、数据增强及预处理操作不同训练集的对比分析。表2和表3给出了多次实验下不同网络模型的准确率及损失值。由表格实验结果横向对比可知,对数据集进行归一化处理、数据增强操作以及预处理操作能防止过拟合现象,增加模型的识别准确率;同时通过实验结果纵向对比发现残差连接及SENet的思想均能提高网络模型的识别率。综合上述实验结果可得,神经网络模型学习需要大量数据支持,对数据集进行数据增强能有效避免过拟合现象,而对数据的预处理能够减少无效特征的学习从而增加识别准确率;Squeeze-and-Excitation block思想是一个特征重标定的计算模块,为提高识别准确率增加了模型的计算复杂度,延长了训练时间,而残差连接思想简化了网络层级间的运算,降低了训练时间,同时保障了识别准确率。结合两种算法思想形成的本文网络模型结构,在GTSRB数据集上的实验结果表明其识别准确率可以达到99.26%,并且有着较优的训练时长。

| 表 2 图像预处理与残差连接对网络模型影响(比利时数据库) Tab.2 Influence of image preprocessing and residual connection on a network model (BelgiumTSC) |

| 表 3 图像预处理与残差连接对网络模型影响(德国数据库) Tab.3 Influence of image preprocessing and residual connection on a network model (GTSRB) |

|

Download:

|

| 图 11 网络结构模型及参数设置图 Fig. 11 Network structure model and parameter setting | |

|

Download:

|

| 图 12 不同网络深度下的准确率以及损失值(比利时数据库) Fig. 12 Accuracy and loss values of different network depths (BelgiumTSC) | |

|

Download:

|

| 图 13 | |

|

Download:

|

| 图 13 不同网络深度下的准确率以及损失值(德国标准数据库) Fig. 13 Accuracy and loss values of different network depths (GTSRB) | |

|

Download:

|

| 图 14 本文网络结构模型及参数设置 Fig. 14 Network structure model and parameter setting | |

本文提出用基于深度学习方法来实现道路交通标志识别。该方法分为两部分:图像预处理和卷积神经网络模型。在第一部分中,利用不变矩运算、多色彩空间融合和形状特征提取等方法对数据集图像进行归一化、数据增强及去背景特征提取。在第二部分中,结合残差连接思想及Squeeze-and-Excitation block思想形成本文网络模型。由实验可得,本文建立的网络模型识别准确率可达99.26%,并且训练学习时间SENet减少了12%。进一步工作,通过结合主成分分析法思想及自适应阈值调整方法的思想,提取图像特征并进行增强,从而达到尽量减少人工干预的方式,减少神经网络参数的调整和输入,并保证识别的准确率。

| [1] |

KHAN J F, ADHAMI R R, et al. Traffic sign recognition based on pictogram contours[J]. IEEE ninth international workshop on image analysis for multimedia interactive services, 2011, 1(1): 83-96. ( 0) 0)

|

| [2] |

YANG H M, LIU Chaolin, LIU Kunhao, et al. Traffic sign recognition in disturbing environments[C]//Proceedings of the 14th International Symposium on Methodologies for Intelligent Systems. Maebashi City, Japan, 2003: 252−261.

( 0) 0)

|

| [3] |

BARTNECK N, RITTER W. Colour segmentation with polynomial classification[C]//Proceedings of the 11th IAPR International Conference on Pattern Recognition. Vol. II. Conference B: Pattern Recognition Methodology and Systems. The Hague, Netherlands, 1992: 635−638.

( 0) 0)

|

| [4] |

SANDOVAL H, HATTORI T, KITAGAWA S, et al. Angle-dependent edge detection for traffic signs recognition[C]//Proceedings of 2000 IEEE Intelligent Vehicles Symposium. Dearborn, USA, 2000: 308−313.

( 0) 0)

|

| [5] |

BARNES N, ZELINSKY A, FLETCHER L S. Real-time speed sign detection using the radial symmetry detector[J]. IEEE transactions on intelligent transportation systems, 2008, 9(2): 322-332. DOI:10.1109/TITS.2008.922935 ( 0) 0)

|

| [6] |

PAULO C F, CORREIA P L. Traffic sign recognition based on pictogram contours[C]//Proceedings of 2008 IEEE Ninth International Workshop on Image Analysis for Multimedia Interactive Services. Klagenfurt, Austria, 2008: 67−70.

( 0) 0)

|

| [7] |

GAO X W, PODLADCHIKOVA L, SHAPOSHNIKOV D, et al. Recognition of traffic signs based on their colour and shape features extracted using human vision models[J]. Journal of visual communication and image representation, 2006, 17(4): 675-685. DOI:10.1016/j.jvcir.2005.10.003 ( 0) 0)

|

| [8] |

STALLKAMP J, SCHLIPSING M, SALMEN J, et al. Man vs. computer: benchmarking machine learning algorithms for traffic sign recognition[J]. Neural networks, 2012, 32: 323-332. DOI:10.1016/j.neunet.2012.02.016 ( 0) 0)

|

| [9] |

SEEBÖCK P. Deep learning in medical image analysis[D]. Vienna, Vienna: Vienna University of Technology, 2015: 333−338.

( 0) 0)

|

| [10] |

丁頠洋, 刘格, 王贤哲, 等. 基于深度学习的游行示威视频图像检测方法[J]. 指挥信息系统与技术, 2018, 9(6): 75-79. DING Weiyang, LIU Ge, WANG Xianzhe, et al. Demonstration video image detection method based on deep learning[J]. Command information system and technology, 2018, 9(6): 75-79. (  0) 0)

|

| [11] |

YANG H M, LIU C L, LIU K H, et al. Traffic sign recognition in disturbing environments[C]//Foundations of Intelligent Systems, 14th International Symposium, ISMIS 2003.Maebashi, Japan, 2003:28–31.

( 0) 0)

|

| [12] |

ISLAM K T, RAJ R G. Real-time (vision-based) road sign recognition using an artificial neural network[J]. Sensors, 2017, 14(4): 853. ( 0) 0)

|

| [13] |

PICCIOLI G, DE MICHELI E, PARODI P, et al. Robust method for road sign detection and recognition[J]. Image and vision computing, 1996, 14(3): 209-223. DOI:10.1016/0262-8856(95)01057-2 ( 0) 0)

|

| [14] |

房泽平, 段建民, 郑榜贵. 基于特征颜色和SNCC的交通标志识别与跟踪[J]. 交通运输系统工程与信息, 2014, 14(1): 47-52. FANG Zeping, DUAN Jianmin, ZHENG Banggui. Traffic signs recognition and tracking based on feature color and SNCC algorithm[J]. Journal of transportation systems engineering and information technology, 2014, 14(1): 47-52. DOI:10.3969/j.issn.1009-6744.2014.01.009 (  0) 0)

|

| [15] |

ZHOU Jun, BAO Xu, LI Dawei, et al. Traffic video image segmentation model based on Bayesian and spatio-temporal Markov random field[J]. Journal of physics: conference series, 2017, 910(1): 012041. ( 0) 0)

|

| [16] |

陈利, 刘伟峰, 杨爱兰. 基于OSPA距离和特征点采样的路标识别算法[J]. 哈尔滨师范大学自然科学学报, 2017, 33(2): 55-57. CHEN Li, LIU Weifeng, YANG Ailan. A recognition algorithm for road signs based on the OSPA metric and characteristic point sampling[J]. Natural Science Journal of Harbin Normal University, 2017, 33(2): 55-57. DOI:10.3969/j.issn.1000-5617.2017.02.014 (  0) 0)

|

| [17] |

SHEN Dinggang, WU Guorong, SUK H I. Deep learning in medical image analysis[J]. Annual review of biomedical engineering, 2017, 19: 221-248. DOI:10.1146/annurev-bioeng-071516-044442 ( 0) 0)

|

| [18] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 770−778.

( 0) 0)

|

| [19] |

HU Jie, SHEN Li, SUN Gang. Squeeze-and-excitation networks[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 7132−7141.

( 0) 0)

|

| [20] |

张懿, 刘旭, 李海峰. 数字RGB与YCbCr颜色空间转换的精度[J]. 江南大学学报(自然科学版), 2007, 6(2): 200-202. ZHANG Yi, LIU Xu, LI Haifeng. The precision of RGB color space convert to YCbCr color space[J]. Journal of JiangNan University (Natural Science Edition), 2007, 6(2): 200-202. DOI:10.3969/j.issn.1671-7147.2007.02.018 (  0) 0)

|

| [21] |

HU M K. Visual pattern recognition by moment invariants[J]. IRE transactions on information theory, 1962, 8(2): 179-187. DOI:10.1109/TIT.1962.1057692 ( 0) 0)

|

| [22] |

孙即祥. 模式识别中的特征提取与计算机视觉不变量[M]. 北京: 国防工业出版社, 2001.

( 0) 0)

|

| [23] |

温佩芝, 陈晓, 吴晓军, 等. 基于三次样条插值的GrabCut自动目标分割算法[J]. 计算机应用研究, 2014, 31(7): 2187-2190. WEN Peizhi, CHEN Xiao, WU Xiaojun, et al. Automatic target segmentation algorithm of GrabCut based on cubic spline interpolation[J]. Application research of computers, 2014, 31(7): 2187-2190. DOI:10.3969/j.issn.1001-3695.2014.07.065 (  0) 0)

|

| [24] |

ZEILER M D, FERGUS R. Visualizing and understanding convolutional networks[C]//Proceedings of the 13th European Conference on Computer Vision. Zurich, Switzerland, 2014: 818−833.

( 0) 0)

|

| [25] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe, USA, 2012: 1097−1105.

( 0) 0)

|

| [26] |

JIA Yangqing, SHELHAMER E, DONAHUE J, et al. Caffe: convolutional architecture for fast feature embedding[C]//Proceedings of the 22nd ACM International Conference on Multimedia. Orlando, USA, 2014: 675−678.

( 0) 0)

|

2020, Vol. 15

2020, Vol. 15