2. 上海大学 通信与信息工程学院,上海 200444

2. School of Communication & Information Engineering, Shanghai University, Shanghai 200444, China

模糊逻辑和模糊推理被用来描述知识和表达的不确定性。而模糊系统就是由模糊逻辑和模糊推理发展而来的。相比于传统的机器学习模型,模糊系统能够更准确地描述和估计现实中不确定的复杂非线性系统模型[1-4]。近年来,学者们提出了众多的模糊系统建模方法,其中TSK模糊系统因其能够将非线性系统转化为多个局部线性结构的逼近,而成为最受欢迎的模型之一[5-7]。

TSK模糊系统由若干条模糊规则构成,每条模糊规则由前件和后件组成。传统的模糊规则构建依靠专家经验。近年来,数据驱动的模糊规则构建方法受到了充分的研究。通常可以划分为两个步骤:一是使用某种划分规则将训练数据分为若干子体来提取规则前件参数,在实际建模中,通常使用聚类来实现;二是学习优化后件参数,从机器学习的角度,可以视为一个线性回归问题[8-11]。

TSK模糊系统建模是重要的有监督学习的过程,因此需要充分的训练数据。然而,在很多实际应用中,样本数据经常是有限的高维数据,这就不可避免导致了模型的过拟合问题。而多任务学习可以从其他任务中获取相关信息,一定程度弥补训练数据不足的问题,进而提高模型的学习性能[12-17]。在多任务建模中,任务之间往往具有明显的相关性,并存在着共享信息,因此充分利用多个任务间的共享信息进行多任务模糊系统建模,有助于提高每个任务的泛化性能。例如,Jiang等[18]提出了一种利用潜在任务间关系信息的多任务模糊系统,该方法为多个任务学习了一个共享的后件参数来表示任务间的共享信息。然而,这些方法都只着重于任务间后件参数的共享结构,而忽视了如何利用各任务的自身特点。

鉴于此,本文提出了一种新型多任务TSK模糊系统建模方法,在挖掘多任务间共享信息的同时,保留单个任务的特殊性。该方法将多任务的后件参数矩阵分解为共享参数矩阵和特有参数矩阵两个部分:共享参数矩阵表示了任务之间共享的结构信息,而特有参数矩阵保留了每个任务的不同于其他任务的差异信息。本文通过为共享参数矩阵和特有参数矩阵分别引入低秩和稀疏约束来实现这一目标。

1 多任务TSK模糊模型的基本原理经典的单任务TSK模糊系统利用多个局部线性子模型来近似非线性模型。而多任务模糊系统就是多个单任务模糊系统的联合优化。在多任务设置中,

因此,任务

| $ \begin{split} & {{\rm{IF}}\;{x}_{t}^{1}\;{\rm{is}}\;{\boldsymbol{A}}_{t}^{m,1}\wedge {x}_{t}^{2}\;{\rm{is}}\;{\boldsymbol{A}}_{t}^{m,2}\wedge \; \cdots \;\wedge {x}_{t}^{D}\;{\rm{is}}\;{\boldsymbol{A}}_{t}^{m,D}, }\\&\qquad {{\rm{THEN}}\;{\boldsymbol{f}}_{t}^{m}\left({\boldsymbol{x}}_{t}\right)={w}_{t}^{m,0}+{w}_{t}^{m,1}{x}_{t}^{1}+ }\\&\qquad\qquad {{w}_{t}^{m,2}{x}_{t}^{2}+ \cdots +{w}_{t}^{m,D}{x}_{t}^{D} } \end{split} $ | (1) |

式中:

| $ {\mu }_{{\boldsymbol{A}}_{t}^{m,d}}\left({x}_{t}^{d}\right)=\exp\left(-\frac{{\left({x}_{t}^{d}-{c}^{m,d}\right)}^{2}}{2{\sigma }^{m,d}}\right) $ | (2) |

| $ {c}^{m,d}=\frac{\displaystyle \sum _{t=1}^{T}\displaystyle \sum _{i=1}^{{N}_{t}}{\mu }_{t,i}^{m}{x}_{t,i}^{d}}{\displaystyle \sum _{t=1}^{T}\displaystyle \sum _{i=1}^{{N}_{t}}{\mu }_{t,i}^{m}} $ | (3) |

| $ {\sigma ^{m,d}} = h\displaystyle \sum\limits_{t = 1}^T {\displaystyle \sum\limits_{i = 1}^{{N_t}} {\mu _{t,i}^m} } \left( {x_{t,i}^d - {c^{m,d}}} \right) \cdot {\left( {\displaystyle \sum\limits_{t = 1}^T {\displaystyle \sum\limits_{i = 1}^{{N_t}} {\mu _{t,i}^m} } } \right)^{ - 1}} $ | (4) |

式中

定义

| $ \widehat{{\boldsymbol{y}}_{t}}={\boldsymbol{\varPhi }}_{t}{\boldsymbol{w}}_{t} $ | (5) |

式中:

| $ {\varphi }^m({\boldsymbol x}_t)=\frac{\mu^m({\boldsymbol x}_t)}{\displaystyle\sum^M_{k=1}\mu^k({\boldsymbol x}_t)} $ | (6) |

| $ \mu^m({\boldsymbol x}_t)=\prod^D_{d=1}\mu_{{\boldsymbol A}^{m,d}_t}\left(x^d_t\right) $ | (7) |

为方便计算,本文为多任务TSK模糊模型进一步定义

| $ \underset{{\boldsymbol{W}}}{{\rm{min}}}\mathop \sum \limits_{t = 1}^T {||{\boldsymbol{y}}_{t}-{\boldsymbol{\varPhi }}_{t}{\boldsymbol{w}}_{t}||}_{2}^{2}+R\left({\boldsymbol{W}}\right) $ | (8) |

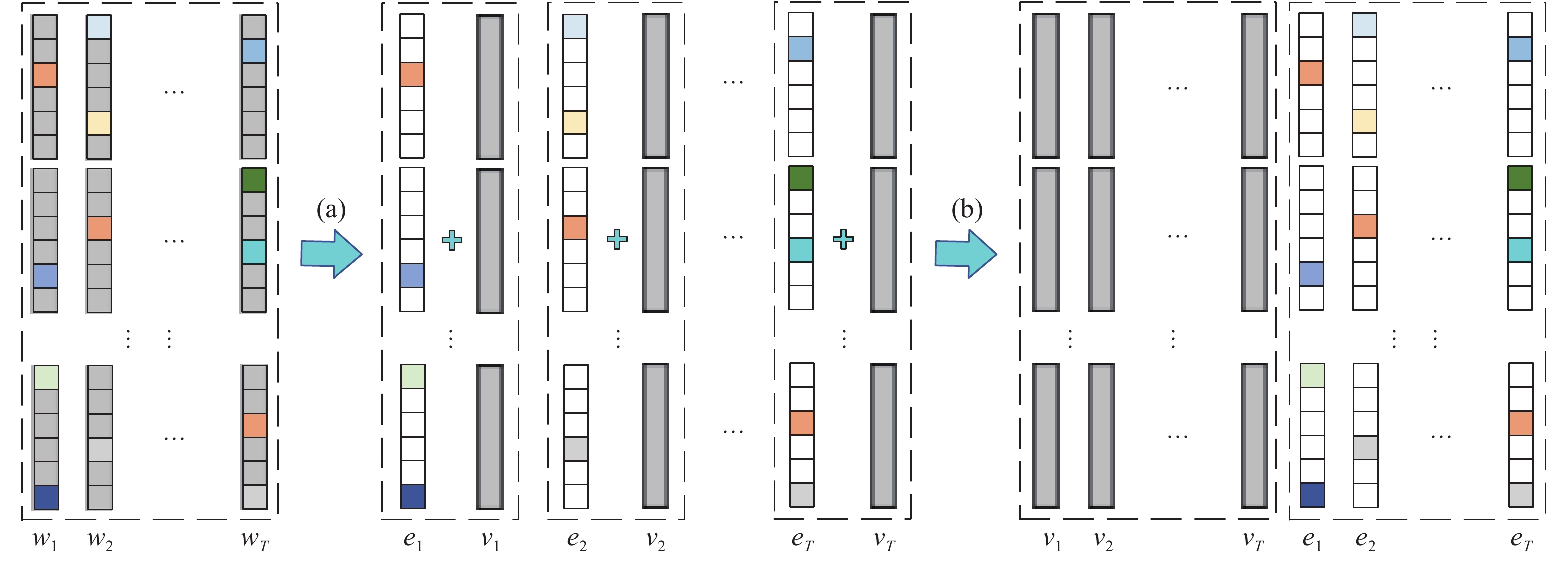

本节在基本多任务模糊系统的基础上,进一步提出新型多任务模糊系统建模方法。考虑到多任务之间是相互关联的,因此可以认为多个任务的模型参数包含着潜在的共享信息;另一方面,各任务的模型参数中都包含了自身不同于其他任务的特有信息。如图1所示,本文将各后件参数联合矩阵

| $ {\boldsymbol{W}}={\boldsymbol{V}}+{\boldsymbol{E}} $ | (9) |

共享参数矩阵

|

Download:

|

|

图 1 后件参数矩阵

|

|

所以,通过对后件参数联合矩阵的分解,再分别施加低秩和行稀疏约束,在多任务建模中兼顾多任务之间共享信息和特有信息的作用,提出了任务间共享和特有结构划分的多任务TSK模糊系统的目标函数,表示如下:

| $ \begin{split} & { \underset{{\boldsymbol{W}}}{\rm{min}}\displaystyle \sum \limits_{t=1}^{T}{||{\boldsymbol{y}}_{t}-{\boldsymbol{\varPhi }}_{t}{\boldsymbol{w}}_{t}||}_{2}^{2}+\alpha {||{\boldsymbol{V}}||}_{*}+\beta {||{\boldsymbol{E}}||}_{{1,2}} }\\&\qquad\qquad\quad { {\rm{s}}.{\rm{t}}.{\boldsymbol{W}}={\boldsymbol{V}}+{\boldsymbol{E}} } \end{split} $ | (10) |

式中:

本文使用增广拉格朗日乘子法[19-20]求解式(10)提出的最优化问题,其增广拉格朗日目标函数为

| $ \begin{split} & \qquad\quad{ \underset{{\boldsymbol{W}},{\boldsymbol{V}},{\boldsymbol{E}},{\boldsymbol{Y}}}{\rm{min}}\displaystyle \sum \limits_{t=1}^{T}{||{\boldsymbol{y}}_{t}-{\boldsymbol{\varPhi }}_{t}{\boldsymbol{w}}_{t}||}_{2}^{2}+\alpha {||{\boldsymbol{V}}||}_{*}+ }\\&\;\;\; { \beta {||{\boldsymbol{E}}||}_{{1,2}}+<{\boldsymbol{Y}},{\boldsymbol{W}}-{\boldsymbol{V}}-{\boldsymbol{E}}>+ } {\dfrac{\mu }{2}||{\boldsymbol{W}}-{\boldsymbol{V}}-{\boldsymbol{E}}||_{2}^{2}} \end{split} $ | (11) |

式中:

| $ \begin{split} & { \underset{{\boldsymbol{W}},{\boldsymbol{V}},{\boldsymbol{E}},{\boldsymbol{Y}}}{\rm{min}}\displaystyle \sum \limits_{t=1}^{T}{||{\boldsymbol{y}}_{t}-{\boldsymbol{\varPhi }}_{t}{\boldsymbol{w}}_{t}||}_{2}^{2}+\alpha {||{\boldsymbol{V}}||}_{*}+ }\\&\;\; {\beta {||{\boldsymbol{E}}||}_{{1,2}}+\dfrac{\mu }{2}||{\boldsymbol{W}}-{\boldsymbol{V}}-{\boldsymbol{E}}+\frac{{\boldsymbol{Y}}}{\boldsymbol{\mu }}||_{2}^{2} } \end{split} $ | (12) |

这是一个包含

1) 固定

| $ \begin{split} & \underset{{\boldsymbol{W}},{\boldsymbol{V}},{\boldsymbol{E}}}{\rm{min}}\frac{{\bf{1}}}{\boldsymbol{N}}\sum\limits _{{\boldsymbol{t}}={\bf{1}}}^{\boldsymbol{T}}{||{\boldsymbol{y}}_{{\boldsymbol{t}}}-{\boldsymbol{\varPhi }}_{{\boldsymbol{t}}}{\boldsymbol{w}}_{{\boldsymbol{t}}}||}_{\bf{2}}^{\bf{2}}+\\&\quad \frac{\boldsymbol{\mu }}{\bf{2}}||{\boldsymbol{W}}-{\boldsymbol{V}}-{\boldsymbol{E}}+\frac{{\boldsymbol{Y}}}{\boldsymbol{\mu }}||_{\bf{2}}^{\bf{2}} \end{split} $ | (13) |

对

| $ \begin{split} & \quad{{\boldsymbol{w}}_{t}={\left(\mu {\boldsymbol{I}}+2{\left({\boldsymbol{\varPhi }}_{t}\right)}^{\rm T}{\boldsymbol{\varPhi }}_{t}\right)}^{-1}\cdot }\\& {[2{\left({\boldsymbol{\varPhi }}_{t}\right)}^{\rm T}{\boldsymbol{y}}_{t}+\mu \left({\boldsymbol{v}}_{t}+{\boldsymbol{e}}_{t}-{\boldsymbol{y}}_{t}/\mu \right)]} \end{split} $ | (14) |

因此,可以进一步得到

| $ {\boldsymbol{W}}=\left({\boldsymbol{w}}_{1},{\boldsymbol{w}}_{2}, \cdots ,{\boldsymbol{w}}_{T}\right) $ | (15) |

2) 固定

| $ \underset{{\boldsymbol{V}}}{\rm{min}}\alpha {||{\boldsymbol{V}}||}_{*}+\frac{\mu }{2}||{\boldsymbol{W}}-{\boldsymbol{V}}-{\boldsymbol{E}}+\frac{{\boldsymbol{Y}}}{\mu }||_{2}^{2} $ | (16) |

使用奇异值阈值算子[22]求解式(16)的低秩问题,

| $ {\boldsymbol{V}}={\mathcal{D}}_{\frac{\alpha }{\mu }}\left({\boldsymbol{W}}-{\boldsymbol{E}}+\left(\frac{1}{\mu }\right){\boldsymbol{Y}}\right) $ | (17) |

3) 固定

| $ \underset{{\boldsymbol{E}}}{\rm{min}}{\boldsymbol{\beta }}{||{\boldsymbol{E}}||}_{{\bf{1}},{\bf{2}}}+{\frac{\boldsymbol{\mu }}{\bf{2}}\left\|{\boldsymbol{W}}-{\boldsymbol{V}}-{\boldsymbol{E}}+\frac{{\boldsymbol{Y}}}{\boldsymbol{\mu }}\right\|}_{\bf{2}}^{\bf{2}} $ | (18) |

式(18)等同于求解如下问题:

| $ \underset{{\boldsymbol{E}}}{\rm{min}}\frac{\beta }{\mu }{||{\boldsymbol{E}}||}_{{1,2}}+\frac{1}{2}||{\boldsymbol{V}}-{\boldsymbol{Q}}||_{2}^{2} $ | (19) |

其中

4) 更新拉格朗日乘子矩阵

| $ {\boldsymbol{Y}}={\boldsymbol{Y}}+\mu \left({\boldsymbol{W}}-{\boldsymbol{V}}-{\boldsymbol{E}}\right) $ | (20) |

| $ \mu ={\rm{min}}(\rho \mu ,{\mu }_{\rm{max}}) $ | (21) |

式中:

最终,本文提出多任务TSK模糊系统建模方法具体描述如下:

算法 MTTSKFS-CS

输入 多任务数据集

输出 多任务的模糊前件和多任务后件参数联合矩阵。

训练过程

1) 生成模糊字典:首先对全部任务的样本使用FCM聚类,获得

2) 联合学习多任务的后件参数:求解式(12),得到

①初始化: 设定

②当式(12)不收敛

使用式(15)更新

使用式(17)更新

使用式(19)更新

使用式(20)更新

使用式(21)更新

end while

return

3) 输出多任务的模糊前件和多任务后件参数联合矩阵。

4 结果与分析 4.1 实验设置为了验证本文提出的多任务建模方法的有效性,在多个真实数据集上进行泛化性能实验。实验中用到的数据集包含2种类型:一种是相同输入不同输出的SIDO数据集,将数据集的每一个输出作为一个回归任务构成一个多任务数据集,数据集的多个任务共享同一个输入数据,但每个任务拥有不同的输入空间到输出空间的映射函数;另一种是不同输入不同输出的DIDO数据集,同样将每一个输出作为一个回归任务,每个任务拥有不同的输入数据和不同的输入空间到输出空间的映射函数。

本节选择的Slump、Parkinsons Telemonitoring、Winequality、House数据集来自UCI Machine Learning Repository数据集网站。Slump数据集用来模拟混凝土的坍落度,涉及到坍落度、流动性和抗压强度3个输出,是一个SIDO数据集。Parkinsons Telemonitoring数据集由来自42名早期帕金森氏症患者的生物医学声音测量组成,用来测量motor和total UPDRS scores,也是一个SIDO数据集。Winequality数据集是一个利用基于理化测试数据来划分葡萄酒质量等级的数据集,包括红葡萄酒和白葡萄酒两个子集,本节分别将每个子集视为一个任务,这是一个DIDO数据集。House数据集被用于波士顿房价预测,在本节根据特征变量“RAD”的值将数据集划分为(Task 1: RAD<5; Task 2: 5<=RAD <7.5; Task 3: RAD>=7.5)3个子集,作为一个DIDO数据集。Multivalued (MV) Data Modeling数据集可以从KEEL Datasets Repository获得,是一个具有特征间依赖关系的人工数据集,本节中根据第8个特征变量可以将数据集划分为两个任务,作为DIDO数据集。表1中列出来了上述所选用的数据集的特征维数、样本数量等具体细节。

| 表 1 多任务数据集的详细信息 Tab.1 Details of the multitask datasets |

我们在实验中比较了几种经典的回归算法,包括多任务和单任务回归算法。算法中涉及到的参数的设置通过5折交叉验证来进行寻优,这些算法的详细介绍以及参数的寻优范围如表2所示。

| 表 2 实验中各算法参数的详细设置 Tab.2 Detailed settings of all algorithm’s parameters |

本文选用RRSE来评价各对比算法的泛化性能,定义如下:

| $ {J}_{\rm{RRSE}}=\sqrt{\sum \limits_{i=1}^{N}{(\widehat{{y}_{i}}-{y}_{i})}^{2}\Bigg/\sum \limits_{i=1}^{N}{(\overline{{y}_{i}}-{y}_{i})}^{2}} $ | (22) |

式中:

我们分别在每个数据集上验证了MTTSKFS-CS及对比算法。

分别计算各模型在每个数据集的每个子任务上的泛化性能,其中“Average”表示算法在每个数据集的所有任务中的平均表现。若算法为单任务算法时,分别对每个子任务进行建模,来评价算法性能。本文提出的MTTSKFS-CS建模方法与对比方法在真实数据集上的实验结果如表3所示。

| 表 3 所有算法在各数据集上的泛化性能比较 Tab.3 Comparison of generalization performance of all algorithms on datasets |

为了进一步说明本文提出的对于后件参数矩阵的低秩和稀疏划分的重要作用,我们将模型在Parkinsons Telemonitoring数据集上训练出的后件参数

|

Download:

|

|

图 2 |

|

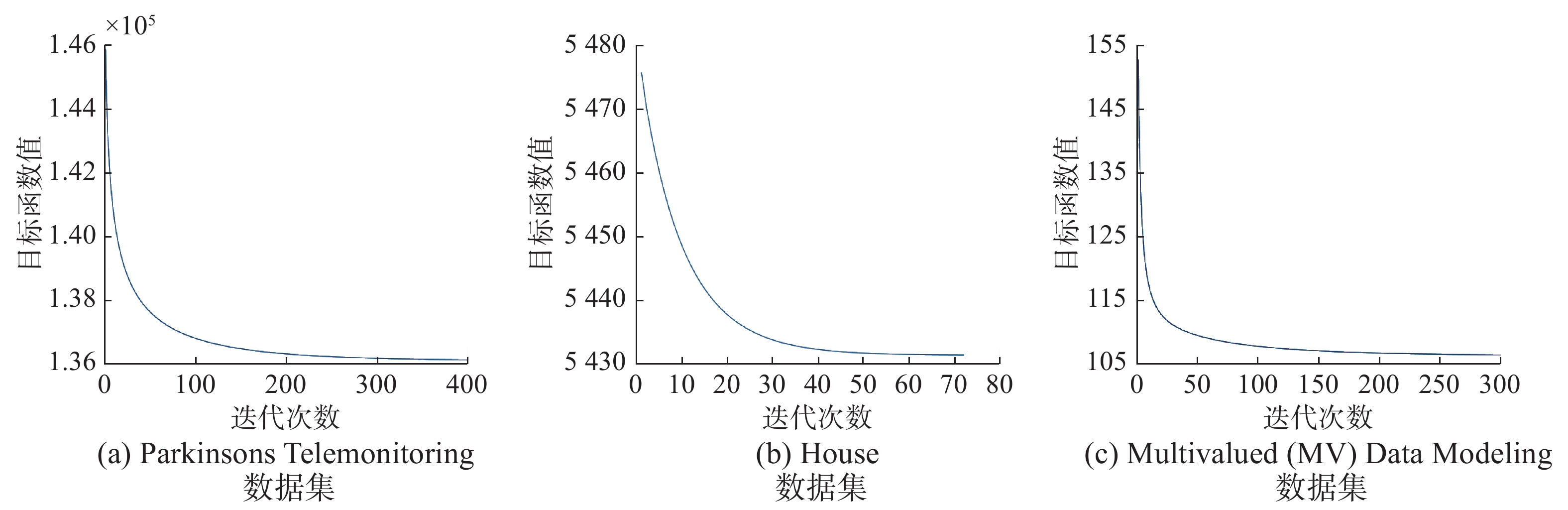

为了进一步研究本文提出的MTTSKFS-CS建模方法的收敛性,我们选取了Multivalued (MV) Data Modeling、Parkinsons Telemonitoring和House 3个数据集,通过交叉验证寻优得到最优参数,并在最优参数的基础上进行收敛性实验。算法在3个数据集上的收敛曲线如图3所示。从收敛曲线中可以看到,算法在前期可以快速收敛,并迅速进入稳定状态。实验结果说明,本文第3节提出的优化方法具有良好的收敛性能,能够真正达到模型最优化的目的,从而使模型获得较高的实用性。

4.5 实验结果分析表3的实验结果证明MTTSKFS-CS方法在大多数任务上获得了比对比算法更好的性能表现。与单任务方法相比,多任务建模方法明显提升了每个任务的预测表现,拥有更好的泛化性能。与多任务算法的对比结果说明,本文提出的方法在利用了多任务之间的的共享信息的同时有效利用了单个任务自身的特有信息,从而获得了更好的表现。对于图2 的可视化结果,我们可以看到,后件参数联合矩阵

|

Download:

|

| 图 3 MTTSKFS-CS方法的收敛曲线 Fig. 3 Convergence curve of MTTSKFS-CS algorithm | |

本文提出了一种新型多任务模糊系统建模方法,首先使用模糊聚类方法获得多任务的模糊前件,然后通过合理划分后件参数联合矩阵为共享参数矩阵和特有参数矩阵,同时兼顾多任务之间的共享信息和各任务的特有信息。最后通过ALM方法求解最优化问题,获得模型的最优解。在多个真实多任务数据集上的实验结果说明了,本文提出的MTTSKFS-CS建模方法能够有效解决传统多任务模型只着重于多任务共享信息的问题。在今后的工作中,如何更好地在建模中平衡共享信息和特有信息将是我们研究的重点。

| [1] |

LI Chaoshun, ZHOU Jianzhong, CHANG Li, et al. T-S fuzzy model identification based on a novel hyperplane-shaped membership function[J]. IEEE transactions on fuzzy systems, 2017, 25(5): 1364-1370. DOI:10.1109/TFUZZ.2016.2598850 ( 0) 0)

|

| [2] |

XU Peng, DENG Zhaohong, CUI Chen, et al. Concise fuzzy system modeling integrating soft subspace clustering and sparse learning[J]. IEEE transactions on fuzzy systems, 2019, 27(11): 2176-2189. DOI:10.1109/TFUZZ.2019.2895572 ( 0) 0)

|

| [3] |

CHANG P C, LIU Chenhao. A TSK type fuzzy rule based system for stock price prediction[J]. Expert systems with applications, 2008, 34(1): 135-144. DOI:10.1016/j.eswa.2006.08.020 ( 0) 0)

|

| [4] |

ZHOU Shangming, GAN J Q. Extracting Takagi-Sugeno fuzzy rules with interpretable submodels via regularization of linguistic modifiers[J]. IEEE transactions on knowledge and data engineering, 2009, 21(8): 1191-1204. DOI:10.1109/TKDE.2008.208 ( 0) 0)

|

| [5] |

DENG Zhaohong, CHOI K S, CHUNG F L, et al. Scalable TSK fuzzy modeling for very large datasets using minimal-enclosing-ball approximation[J]. IEEE transactions on fuzzy systems, 2011, 19(2): 210-226. DOI:10.1109/TFUZZ.2010.2091961 ( 0) 0)

|

| [6] |

JUANG C F, HSIEH C D. TS-fuzzy system-based support vector regression[J]. Fuzzy sets and systems, 2009, 160(17): 2486-2504. DOI:10.1016/j.fss.2008.11.022 ( 0) 0)

|

| [7] |

林得富, 王骏, 张嘉旭, 等. Takagi-Sugeno模糊系统双正则联合稀疏建模新方法[J]. 计算机科学与探索, 2019, 13(6): 1016-1026. LIN Defu, WANG Jun, ZHANG Jiaxu, et al. Novel Takagi-Sugeno fuzzy system modeling method via joint sparse learning using two regularizations[J]. Journal of frontiers of computer science and technology, 2019, 13(6): 1016-1026. DOI:10.3778/j.issn.1673-9418.1804066 (  0) 0)

|

| [8] |

张春香, 王骏, 张嘉旭, 等. 面向自闭症辅助诊断的联合组稀疏TSK建模方法[J]. 计算机科学与探索, 2020, 14(2): 2083-2093. ZHANG Chunxiang, WANG Jun, ZHANG Jiaxu, et al. Novel TSK modeling method with joint group sparse learning for autism aided diagnosis[J]. Journal of frontiers of computer science and technology, 2020, 14(2): 2083-2093. (  0) 0)

|

| [9] |

ZHU Yuanguo. Fuzzy optimal control for multistage fuzzy systems[J]. IEEE transactions on systems, man, and cybernetics, part B (cybernetics), 2011, 41(4): 964-975. DOI:10.1109/TSMCB.2010.2102015 ( 0) 0)

|

| [10] |

JANG J S R. ANFIS: adaptive-network-based fuzzy inference system[J]. IEEE transactions on systems, man, and cybernetics, 1993, 23(3): 665-685. DOI:10.1109/21.256541 ( 0) 0)

|

| [11] |

REZAEE B, ZARANDI M H F. Data-driven fuzzy modeling for Takagi–Sugeno–Kang fuzzy system[J]. Information sciences, 2010, 180(2): 241-255. DOI:10.1016/j.ins.2009.08.021 ( 0) 0)

|

| [12] |

CAVALLANTI G, CESA-BIANCHI N, GENTILE C. Linear algorithms for online multitask classification[J]. Journal of machine learning research, 2010, 11(5): 2901-2934. ( 0) 0)

|

| [13] |

EVGENIOU T, MICCHELLI C A, PONTIL M. Learning multiple tasks with kernel methods[J]. Journal of machine learning research, 2005, 6(4): 615-637. ( 0) 0)

|

| [14] |

ZHANG Jiangmei, YU Binfeng, JI Haibo, et al. Multi-task feature learning by using trace norm regularization[J]. Open physics, 2017, 15(1): 674-681. DOI:10.1515/phys-2017-0079 ( 0) 0)

|

| [15] |

ZHAO Qian, RUI Xiangyu, HAN Zhi, et al. Multilinear multitask learning by rank-product regularization[J]. IEEE transactions on neural networks and learning systems, 2020, 31(4): 1336-1350. DOI:10.1109/TNNLS.2019.2919774 ( 0) 0)

|

| [16] |

ZHONG Shi, PU Jian, JIANG Yugang, et al. Flexible multi-task learning with latent task grouping[J]. Neurocomputing, 2016, 189: 179-188. DOI:10.1016/j.neucom.2015.12.092 ( 0) 0)

|

| [17] |

XUE Ya, LIAO Xuejun, CARIN L, et al. Multi-task learning for classification with dirichlet process priors[J]. Journal of machine learning research, 2007, 8: 35-63. ( 0) 0)

|

| [18] |

JIANG Yizhang, DENG Zhaohong, CHUNG F L, et al. Multi-task TSK fuzzy system modeling using inter-task correlation information[J]. Information sciences, 2015, 298: 512-533. DOI:10.1016/j.ins.2014.12.007 ( 0) 0)

|

| [19] |

WANG Jun, LIN Defu, DENG Zhaohong, et al. Multitask TSK fuzzy system modeling by jointly reducing rules and consequent parameters[J]. IEEE transactions on systems, man, and cybernetics: systems, 2019. DOI:10.1109/TSMC.2019.2930616 ( 0) 0)

|

| [20] |

MENG Fan, YANG Xiaomei, ZHOU Chenghu, et al. The augmented lagrange multipliers method for matrix completion from corrupted samplings with application to mixed gaussian-impulse noise removal[J]. PLoS one, 2014, 9(9): e108125. DOI:10.1371/journal.pone.0108125 ( 0) 0)

|

| [21] |

LIN Zhouchen, LIU Risheng, SU Zhixun. Linearized alternating direction method with adaptive penalty for low-rank representation[C]//Proceedings of 25th Annual Conference on Neural Information Processing Systems. Granada, Spain, 2011: 612−620.

( 0) 0)

|

| [22] |

CAI Jianfeng, CANDÈS E J, SHEN Zuowei. A singular value thresholding algorithm for matrix completion[J]. SIAM journal on optimization, 2010, 20(4): 1956-1982. DOI:10.1137/080738970 ( 0) 0)

|

| [23] |

LIU Guangcan, LIU Zhouchen, YAN Shuicheng. Robust recovery of subspace structures by low-rank representation[J]. IEEE transactions on pattern analysis and machine intelligence, 2013, 35(1): 171-184. DOI:10.1109/TPAMI.2012.88 ( 0) 0)

|

| [24] |

JIANG Pengbo, WANG Xuetong, LI Qiongling, et al. Correlation-aware sparse and low-rank constrained multi-task learning for longitudinal analysis of alzheimer’s disease[J]. IEEE journal of biomedical and health informatics, 2019, 23(4): 1450-1456. DOI:10.1109/JBHI.2018.2885331 ( 0) 0)

|

| [25] |

ZHOU Jiayu, CHEN Jianhui, YE Jieping. Malsar: multi-task learning via structural regularization—user’s manual version 1.1[EB/OL]. (2019-12-12) [2020-07-08] https://github.com/jiayuzhou/MALSAR.

( 0) 0)

|

| [26] |

JUANG C F, CHIU S H, SHIU S J. Fuzzy system learned through fuzzy clustering and support vector machine for human skin color segmentation[J]. IEEE transactions on systems, man, and cybernetics-part A: systems and humans, 2007, 37(6): 1077-1087. DOI:10.1109/TSMCA.2007.904579 ( 0) 0)

|

2021, Vol. 16

2021, Vol. 16