2. 无锡环境科学与工程研究中心,江苏 无锡 214153

2. Wuxi Research Center of Environmental Science and Engineering, Wuxi 214153, China

目标跟踪[1]近年来因其横跨视频监控、无人驾驶、无人飞行器、医学图像分析、空中预警等诸多领域而迅速成为计算机视觉研究的热点之一。目标跟踪的主流方法目前正由生成类方法逐渐转向判别式方法,其中基于相关滤波的目标跟踪算法发展尤为快速[2]。

相关滤波算法由Bolm等提出的最小输出误差平方和[3](minimum output sum of squared error, MOSSE)引入目标跟踪领域。Henriques等采用了HOG特征和循环移位采样方式,提出了核相关滤波器[4](kernelized correlation filter, KCF)跟踪算法,大大提高了跟踪算法的准确率。Martin Danelljan等在MOSSE的基础上增加了一个尺度滤波器用以应对尺度变换的情况,提出了DSST(discriminative scale space tracking)算法[5]。循环移位策略的应用使得基于相关滤波的目标跟踪算法会受到边缘效应的影响,Martin Danellja提出的SRDCF[6](spatially regularized discriminant correlation filter)采用空间正则化惩罚系数取得了一定的效果。之后,Danelljan在2016年提出了C-COT[7](continuous convolution operators for visual tracking)算法,通过差值函数,将不同分辨率的特征图映射到连续的空间域上,计算机效率却降低了。随后,Danelljan于2017年在CVPR上提出了ECO[8](efficient convolution operators),该算法分为手工特征算法(efficient convolution operators handcraft, ECO_HC)和卷积特征算法两个版本。ECO使用高效卷积操作融合多个特征获取特征图,从模型的大小、训练集的更新策略以及模型更新的频率3个方面对C-COT改进,极大地提高了算法的时间与空间效率。2018年,Li等[9]在CVPR上发表了Siam-RPN(siamese-region proposal network)网络架构算法。为了解决Siam-RPN网络架构算法在使用训练好的深层网络时出现的跟踪算法精度下降问题,Li等[10]在2019年CVPR上又提出了Siam-RPN++算法。Fan等[11]为了解决大的尺度问题,在CVPR 2019上提出了多级tracking网络La-SOT(large-scale single object tracking)算法。

本文针对ECO_HC在遮挡方面的不足提出了多特征融合的抗遮挡相关滤波跟踪算法。将FHOG特征和ULBP特征进行自适应加权融合,实现了对目标更精确地定位。再利用高斯掩码函数过滤掉一部分负样本,用以解决循环移位造成的边界效应,缓解模型漂移的情况。最后,根据最大响应值计算的峰值均值比判断目标是否被遮挡,若目标处于正常跟踪状态,则修正卡尔曼滤波器预测的跟踪目标坐标;若目标处于被遮挡状态,则启动目标重定位策略,使用卡尔曼算法预测得出目标位置,并停止模型更新,回溯到之前模型未被污染的状态。

1 ECO_HC跟踪基本原理相关滤波器[12-18]的核心是通过当前帧和前序帧训练的滤波器判定跟踪目标在下一帧的位置。ECO_HC算法首先在第一帧中选定跟踪目标,获取其在图片帧中的实际位置及其他特征信息用以初始化训练跟踪器,后续帧中根据跟踪器中预测的位置对其周围进行采样点响应,取最高响应值的位置为跟踪的目标所在位置,并对跟踪器进行更新。相关滤波是根据前序帧训练的模型去预测跟踪目标下一帧的位置,当跟踪目标发生剧烈变化,比如产生形变或者遮挡时,模型就会学习到错误的信息,受到污染,导致后续帧容易跟踪失败。此外,相关滤波采用了循环移位来丰富样本,这就导致在训练的图像块中,只有万分之一的图像块是真实的样本,因此,解决边界效应对提高模型的准确度有着至关重要的作用。

1.1 相关滤波相关滤波的核心思想如下:若滤波器为h,输入的图像为f,对二者做相关运算求得响应值g:

| $g{\rm{ = }}f \otimes h$ | (1) |

响应值g越大,则f和h的相关度越高。当输出的响应值取最大值时,该响应值对应的位置即为当前跟踪目标的位置。为了提高计算速度,可将式(1)利用快速傅里叶变换转至频域计算:

| ${\cal F}\left( g \right){\rm{ = }}{\cal F}\left( {f \otimes h} \right){\rm{ = }}{\cal F}\left( f \right) \odot {\cal F}{\left( h \right)^ * }$ | (2) |

式中:

| $G{\rm{ = }}F \odot {H^{\rm{*}}}$ | (3) |

对于每一个样本图像fi都存在与其对应的gi,则式(3)可变换为

| ${H_i}^{\rm{*}}{\rm{ = }}\dfrac{{{G_i}}}{{{F_i}}}$ | (4) |

H*的更新公式为

| ${H^{\rm{*}}}{\rm{ = }}\frac{{\displaystyle\sum\nolimits_i {{F_i} \odot } {G_i}^{\rm{*}}}}{{\displaystyle\sum\nolimits_i {{F_i} \odot } {F_i}^{\rm{*}}}}$ | (5) |

最后,对式(5)进行傅里叶逆变换即可求得滤波器h。

1.2 因式分解的卷积操作ECO_HC是在C-COT算法的基础上进行改进的,C-COT通过学习一个含有M个训练样本的集合

| ${J_d}\left\{ {{x^d}} \right\}\left( t \right) = \sum\limits_{n = 0}^{{N_d} - 1} {{x^d}\left[ n \right]} {b_d}\left(t - \frac{T}{{{N_d}}}n\right)$ | (6) |

式中:bd是周期为T(T>0)的插值内核,所得插值特征层

| ${S_f}\left\{ x \right\} = f*J\left\{ x \right\} = \sum\limits_{d = 1}^D {{f^d}*{J_d}} \left\{ {{x^{^d}}} \right\}$ | (7) |

C-COT对于每个维度的特征都训练了一个对应的滤波器,但是其中很多滤波器的贡献不大。因此,ECO_HC在特征提取的阶段使用了原来特征的子集,对于D维特征,ECO_HC选取了其中贡献较大的C个滤波器(C<D)。P是一个

| ${S_{Pf}}\left\{ x \right\} = {\boldsymbol{Pf}}*{\boldsymbol{J}}\left\{ x \right\} = \sum\limits_{c,d} {{p_{d,c}}{f^c}*} {J_d}\left\{ {{x^{d}}} \right\} = {\boldsymbol{f}}*{{\boldsymbol{P}}^{\rm{T}}}{\boldsymbol{J}}\left\{ x \right\}$ | (8) |

式中:P为

ECO_HC更改了训练集的样本更新策略,用高斯混合模型(gaussian mixture model, GMM)生成不同的分量,每个分量是一组相似度较高的样本,分量之间差异较大。GMM的建模如下:

| $p{\rm{(}}x) = \sum\limits_{i = 1}^L {{\pi _l}{\cal N}\left( {x;{\mu _l};{\boldsymbol{I}}} \right)} $ | (9) |

式中:L是高斯分量

| ${\pi _m} = \gamma\; ,\;{\mu _m} = {x_j} $ | (10) |

| ${\pi _n} = {\pi _k} + {\pi _l},{\mu _n} = \frac{{{\pi _k}{\mu _k} + {\pi _l}{\mu _l}}}{{{\pi _k} + {\pi _l}}}$ | (11) |

对于

本文算法是基于ECO_HC实现的目标遮挡后的再定位技术[19-20]。首先,将FHOG特征和ULBP特征进行自适应加权融合;其次,加入高斯形状的掩码函数解决边缘效应,并保留更多的背景信息,减少模型漂移;最后,本算法根据每一帧获取的峰值响应值计算参数峰值均值比(peak-to-average ration,PAR),使用PAR对目标是否被遮挡进行判断。若PAR大于一个固定的阈值,说明目标此时处于正常跟踪状态,根据ECO_HC算法预测的目标位置,修正Kalman算法预测的目标位置,并更新滤波器模型;若PAR小于一个固定的阈值,则说明目标处于遮挡或失踪状态,此时采取目标再定位机制,使用Kalman滤波器预测出当前目标的位置,并回溯到之前未被污染的模型来更新模型。

2.1 ULBP特征提取本文使用ULBP提取的特征来加强FHOG提取的特征。ULBP算法是对LBP(local binary pattern)算法的一种改进,是单维度的特征表述,LBP描述的是图像局部纹理特征。LBP算子是对样本中的每个像素点,选取其为中心的3×3邻域,在该邻域内,将其周围的8个像素值与之比较,大于该像素点的值置1,否则置0,然后按照顺时针方向组合即可产生8位二进制数,即28种模式。但是,过多的二进制模式对于纹理的表达是不利的,过于复杂且较大的信息量,对快速提取目标特征信息是不利的,因此需要的是尽可能少且具有代表性的一些目标特征。因此本文采取了uniform LBP(ULBP),其核心思想是对LBP进行降维,绝大多数LBP模式只包含两次从1到0或者从0到1的跳变,并将最多有两次跳变的归为一个等价模式类,其余的归为混合模式类,通过这样改进,3×3的邻域的二进制模式就由28模式减少为58种,并且不会丢失任何信息,也能减少高频噪声的影响。

在FHOG提取得到的一个31通道的梯度直方图M1的基础上,用ULBP得到的一维特征MULBP与M1的每个通道进行线性加权融合,得到特征图M2。通过大量实验,融合系数

| ${M_2}{\rm{ = }}{M_1}{\rm{ + }}\lambda \cdot {M_{{\rm{ULBP}}}}$ | (12) |

本文在模型更新时采用高斯掩码函数,对跟踪目标的中心取较大的系数,边缘取较小的系数,保留一定的背景信息,缓解边缘不连续性造成的影响,以提高模型的准确性。

二维高斯函数将正态分布应用于图像处理中,随着中心点到边缘的距离增大,取得的加权平均值越小。若

| $F\left( {u{\rm{,}}v} \right) = - \frac{1}{{2\pi {\sigma ^2}}}{{\rm{e}}^{ - \frac{{{u^2} + {v^2}}}{{2{\sigma ^2}}}}}$ | (13) |

因为目标中心位置的样本信息比边界位置上的信息更加重要,所以本文对高斯函数做了相应的改进,使得函数由中心点随着目标框的形状呈椭圆形向图像边缘发散,结合掩码函数,对图像边缘不连续性的地方至0,其余地方至改进过后的高斯函数值。然后将此构造好的掩码矩阵左乘循环移位样本,得以增加真实训练的样本比例,得到的函数如图1(d)所示。定义如下:

| $ G(u{\rm{,}}v) = \left\{ {\begin{split} &{{{\rm{e}}^{ - \dfrac{{\dfrac{{{u^2}}}{{{{\left( {\dfrac{w}{2}} \right)}^2}}} + \dfrac{{{v^2}}}{{{{\left( {\dfrac{h}{2}} \right)}^2}}}}}{{2{\sigma ^2}}}}},}\quad{\left| u \right| \leqslant \dfrac{{W - w}}{2},\left| v \right| \leqslant \dfrac{{H - h}}{2}} \\ &{0,}\quad{\text{其他}} \end{split}} \right. $ | (14) |

式中:假设原始样本的长宽分别为W与H,则w与h分别为目标框的长与宽,则只有在

|

Download:

|

| 图 1 高斯掩码示意 Fig. 1 Illustration of the mask | |

本文在模型更新时使用参数峰值均值比(peak to-average-ratio,PAR)来判断当前目标是否处于遮挡状态。ECO主要采用连续空间域中的卷积算子对训练样本进行隐式差值,通过对一组卷积滤波器来产生目标的连续域置信度图,该图中的最高响应值即为目标位置。而当目标处于遮挡状态的时候,置信度图则会由一个很高峰值变为多个不明显的峰值状态,为了解决目标此状态下容易跟踪失败的问题,本算法引入再跟踪机制。由PAR判断跟踪目标在当前帧中的状态,若PAR不小于阈值

| ${\rm{PAR}} = \dfrac{{\max \left( {f\left( i \right)} \right)}}{{\dfrac{1}{q}\displaystyle\sum\limits_{n = i - q}^{i - 1} {\max \left( {f\left( n \right)} \right)} }}$ | (15) |

式中:

当跟踪目标处于正常跟踪状态时,PAR的值处于一种相对稳定的波动状态而当目标处于遮挡状态时,

|

Download:

|

| 图 2 视频序列Girlmov的PAR时刻值 Fig. 2 PAR time value of Girlmov | |

卡尔曼滤波[21]结合前序帧与当前帧可递推地推测下一帧跟踪目标的位置,从而预测出目标被遮挡后在图片中的位置。若PAR小于阈值

| ${u_i} = {{\boldsymbol{A}}_i}{u_{i - 1}} + {r_i} + {{\boldsymbol{B}}_i}{s_i}$ | (16) |

| ${z_i} = {{\rm{pos}}_i} + {v_i}$ | (17) |

式中:

| $\hat u{^ - _i} = {{\boldsymbol{A}}_i} \cdot {u_{i - 1}} + {{\boldsymbol{B}}_i}{s_i}$ | (18) |

| ${\boldsymbol{C}}_i^ - = {{\boldsymbol{A}}_i}{{\boldsymbol{C}}_{i{\rm{ - }}1}}{{\boldsymbol{A}}_i}' + {{\boldsymbol{Q}}_i}$ | (19) |

式(18)和式(19)是状态预测方程和误差协方差预测方程。上述两个方程中

| ${{\boldsymbol{K}}_i} = \frac{{{{\boldsymbol{C}}_i}{{\boldsymbol{N}}_i}'}}{{{{\boldsymbol{N}}_i}{{\boldsymbol{C}}_i}{{\boldsymbol{N}}_i}' + {{\boldsymbol{R}}_i}}}$ | (20) |

| ${\hat u_i} = \hat u{^ - _i} + {{\boldsymbol{K}}_i}({z_i} - {{\boldsymbol{N}}_i}\hat u{^ - _{i - 1}})$ | (21) |

| ${{\boldsymbol{C}}_i} = {\boldsymbol{C}}_i^ - - {{\boldsymbol{K}}_i}{{\boldsymbol{N}}_i}{\boldsymbol{C}}_i^ - $ | (22) |

式(20)~(22)是状态更新方程,其中K是卡尔曼增益矩阵,C是卡尔曼增益矩阵的误差值,N是修正后的状态转移矩阵,R为修正后的协方差矩阵。式(21)是修正过后的目标中心点的横坐标值。目标中心点纵坐标的预测和更新与横坐标一致,如若启动重定位机制,则将卡尔曼滤波器预测的位置传回原滤波器,并停止模型更新。

本文改进算法的具体流程如图3所示。

|

Download:

|

| 图 3 算法整体流程图 Fig. 3 Algorithm overall flow char | |

本算法的测试平台为Matlab2018b,所有实验均在Intel(R) Core(TM) i5-8250U CPU with NVIDIA GeForce MX150 2G,主频1.6 GHz,8 GB内存配置的windows10 64bit PC系统上完成的。本文算法仍保留ECO_HC算法的基本参数,并在所有测试视频上保持一致,高斯标签带宽

为了验证本算法对抗遮挡问题的有效性,本文选用了数据集Temple Color 128中16个不同程度遮挡的视频进行测试,16个视频分别为Airport_ce、Busstation_ce1、Coke、Face_ce2、Girlmov、Motorbike_ce、Soccer、Suitcase_ce、Surf_ce3、Tiger2、Busstation_ce1、Jogging2、Kite_ce2、Matrix、Basketball、Boat_ce2。除了与ECO_HC[8]进行对比之外,本文还选取了DSST[5]、KCF[4]、SRDCF[6]、STRCF[22]、LDES[23]和SAMF[24]进行比较。本文分别从精确度、成功率、覆盖率和中心误差对算法进行分析。精确度

| $ {\rm{score}} = {\rm{area}}\left( {{R_t} \cap {R_{gt}}} \right)/ {\rm{area}} \left( {{R_t} \cup {R_{gt}}} \right)$ |

为跟踪目标覆盖率,

首先将本算法与ECO_HC算法在16组有不同程度遮挡问题的视频上针对抗遮挡问题进行对比实验,以验证本文算法的有效性。表1中显示了本文算法与ECO_HC在精确度和成功率两个评价指标上的测试结果,可以看出本文算法性能较好。在这10个视频集中,本文算法的平均精确度为87.3%,成功率为76.5%,相比基线算法ECO_HC,分别提升了27.7%和23.7%。由此可见,本文改进后的算法产生了积极的作用。

| 表 1 在视频集上的精确度和成功率 Tab.1 Precision and success rate on the videos |

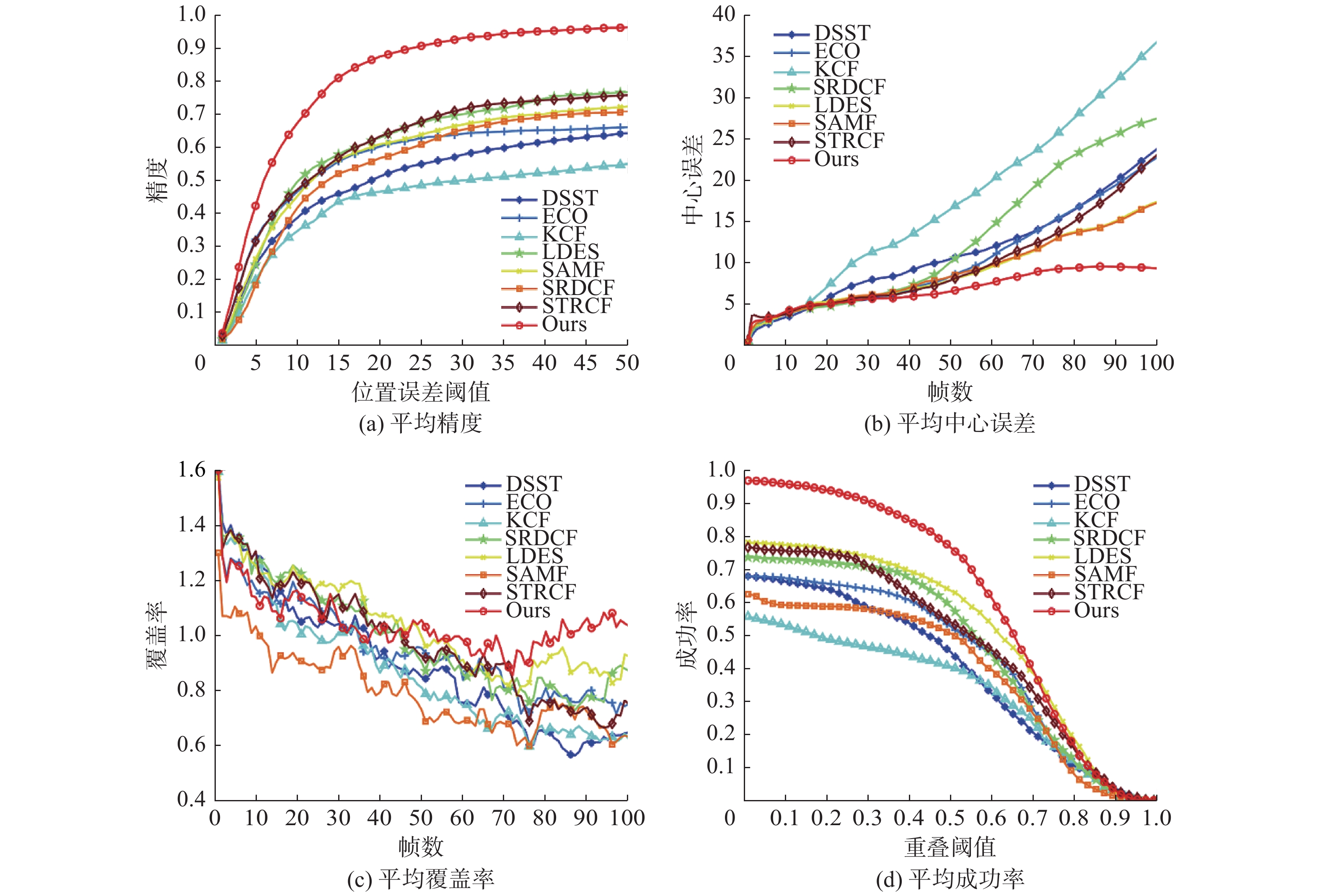

本实验选用DSST[5]、ECO_HC[8]、KCF[4]、SRDCF[6]、STRCF[22]、LDES[23]、SAMF[24]共7种跟踪算法进行性能对比,测评结果如图4所示。在视频序列Airport_ce上,目标受到颜色相同的干扰物遮挡时,DSST、SRDCF、ECO_HC随着遮挡物发生了偏移,例如第80帧、90帧、100帧。在视频序列Busstation_ce1上,第60帧显示的是目标处于较长时间的全遮挡后的位置,只有本文的算法跟上了目标,而其余的7种算法均丢失了跟踪目标。在视频序列Girlmov中,目标发生完全遮挡后,其他几种算法都随着遮挡物发生了漂移,例如第110帧、第120帧、第130帧、第140帧。在视频序列Motorbike_ce中,当目标发生遮挡又重新出现之后,本文算法跟踪准确,而其他算法发生了不同程度的偏移。在视频序列Suitcase_ce中,目标的尺度较小,而遮挡物的尺度较大,遮挡情况比较严重,本文算法较准确地预测出了行李箱的位置,ECO_HC与SRDCF发生了严重的漂移,其余算法则停留在目标被遮挡前的位置,例如第170帧。综合这5个测试视频中的跟踪效果,可见本文算法较好地预测了目标被遮挡后的位置,并且较好地学习了背景信息,优化了模型污染造成的漂移问题,而其他7种算法在处理遮挡问题上效果不佳,本文算法的效果较好。

图5显示了本文算法与其他7种在视频序列上的精确度。在受部分遮挡的视频序列Coke、Tiger2中,除了KCF和DSST外,其他几种算法效果差不多。而当目标遮挡情况严重一点时,比如Soccer和Face_ce2中,LDES、SAMF、ECO_HC的精度些许偏低。但是当目标处于一段时间的完全遮挡,比如视频序列Airport_ce和Busstation_ce1,本文算法的重定位机制以及改进的模型更新算法起到了有效的作用。

|

Download:

|

| 图 4 目标遮挡部分效果 Fig. 4 Part of target occlusion results | |

|

Download:

|

| 图 5 不同算法在不同视频集上的精确度图 Fig. 5 Distance precison diagram of different trackers on different videos | |

表2展示了几种算法在这几个视频序列上的跟踪结果。本文提出的算法在Coke、Tiger2这几个发生较轻微遮挡的视频序列中,精确度与其他算法仅相差0.1%与0.05%,均高于90.7%,而STRCF在这两个视频序列上的结果仅为89.7%和52.6%。在余下几个遮挡严重的视频序列中,KCF算法基本都没有跟上目标,SAMF和STRCF效果好些,精确度分别为60.9%和63.2%,ECO_HC算法的精确度也达到了59.6%,本文算法的优势较为明显,平均精确度能达到87.3%。

| 表 2 不同算法在视频序列上的结果 Tab.2 Results of the videos via different methods |

表3显示了中心误差位置这一评价指标的测试结果,由于存在部分视频序列跟丢的情况,因此7种算法的表现不是很好。DSST、ECO_HC、KCF、SRDCF、LDES的平均中心误差都超过了40。SAMF与STRCF的中心位置误差较小,分别为30.10和32.78。本文算法的中心误差远小于其他几种算法,平均中心误差为8.71,说明本文算法的表现较好。

| 表 3 不同算法在视频序列上的中心误差值 Tab.3 Center location error of the videos via different methods |

表4显示了8种算法在这16个视频序列上的成功率情况,ECO_HC、KCF、SAMF跟丢的情况出现的较多,成功率偏低,分别为0.528、0.450和0.507。SRDCF与STRCF这两个算法对模型污染有较好的效果,在目标被遮挡的情况下表现的效果稍好,平均成功率分别为0.589和0.541。LDES在这7种算法中表现较好,平均成功率达到63.6%。而本文算法的成功率76.5%,较基线方法ECO_HC优势明显。因此,本文算法的抗遮挡性能表现良好。

由于视频序列Matrix只有100帧,所以在绘制图6的平均中心误差和平均覆盖率评价曲线时,截取了16个视频序列的前100帧进行对比。图中红色曲线为本文算法的效果曲线,虽然本算法在覆盖率这一评价指标的前50帧效果一般,但总体效果优势明显,对ECO_HC算法的改进成效不错。由上可知,本文改进的算法相较基线算法在抗遮挡方面有较强的鲁棒性。

| 表 4 不同算法在视频序列上的成功率 Tab.4 Success rate of the videos via different methods |

|

Download:

|

| 图 6 16个视频序列上的平均精确度、平均中心误差、平均覆盖率和平均成功率 Fig. 6 Average distance precision, average center location error, average cover rate and average success rate on 16 videos | |

本文针对ECO_HC算法容易被遮挡以及遮挡后模型污染等情况干扰而导致算法效果不佳的问题,提出了一种融合ULBP特征的目标重定位机制相关滤波算法,有效地解决了由于遮挡因素带来的模型漂移问题,提高了算法跟踪的精度。在视频序列集上的结果显示,本文算法在覆盖率、跟踪成功率、中心误差等评价指标下较其他算法性能较好,具有较强的鲁棒性。本文算法在面对目标发生快速移动时表现效果较差,因此对目标行动轨迹的预测仍需进一步的改进与研究。

| [1] |

吴小俊, 徐天阳, 须文波. 基于相关滤波的视频目标跟踪算法综述[J]. 指挥信息系统与技术, 2017, 8(3): 1-5. WU Xiaojun, XU Tianyang, XU Wenbo. Review of target tracking algorithms in video based on correlation filter[J]. Command information system and technology, 2017, 8(3): 1-5. (  0) 0)

|

| [2] |

张微, 康宝生. 相关滤波目标跟踪进展综述[J]. 中国图象图形学报, 2017, 22(8): 1017-1033. ZHANG Wei, KANG Baosheng. Recent advances in correlation filter-based object tracking: a review[J]. Journal of image and graphics, 2017, 22(8): 1017-1033. DOI:10.11834/jig.170092 (  0) 0)

|

| [3] |

BOLME D S, BEVERIDGE J R, DRAPER B A, et al. Visual object tracking using adaptive correlation filters[C]//Proceedings of 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, CA, USA: IEEE, 2010: 2544−2550.

( 0) 0)

|

| [4] |

HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(3): 583-596. DOI:10.1109/TPAMI.2014.2345390 ( 0) 0)

|

| [5] |

DANELLJAN M, HÄGER G, KHAN F S, et al. Accurate scale estimation for robust visual tracking[C]//British Machine Vision Conference. Nottingham, UK: BMVA Press, 2014.

( 0) 0)

|

| [6] |

DANELLJAN M, HÄGER G, SHAHBAZ KHAN F, et al. Learning spatially regularized correlation filters for visual tracking[C]//Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile: IEEE, 2015: 4310−4318.

( 0) 0)

|

| [7] |

DANELLJAN M, ROBINSON A, KHAN F S, et al. Beyond correlation filters: learning continuous convolution operators for visual tracking[C]//Proceedings of the 14th European Conference on Computer Vision. Amsterdam, The Netherlands: Springer, 2016: 472−488.

( 0) 0)

|

| [8] |

DANELLJAN M, BHAT G, SHAHBAZ KHAN F, et al. ECO: efficient convolution operators for tracking[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA: IEEE, 2017: 6638−6646.

( 0) 0)

|

| [9] |

LI Bo, YAN Junjie, WU Wei, et al. High performance visual tracking with Siamese region proposal network[C]//Proceedings of 2018 IEEE/CVF Computer Vision and Pattern Recognition. Salt Lake City, UT, USA: IEEE, 2018: 6638−6646.

( 0) 0)

|

| [10] |

LI Bo, WU Wei, WANG Qiang, et al. SiamRPN++: evolution of Siamese visual tracking with very deep networks[C]//Proceedings of 2019 Computer Vision and Pattern Recognition (CVPR). Long Beach, CA, USA: IEEE, 2019.

( 0) 0)

|

| [11] |

FAN Heng, LIN Liting, YANG Fan, et al. LaSOT: a high-quality benchmark for large-scale single object tracking[C]//Proceedings of 2019 IEEE/CVF Computer Vision and Pattern Recognition (CVPR). Long Beach, CA, USA: IEEE, 2019.

( 0) 0)

|

| [12] |

HENRIQUES J F, CASEIRO R, MARTINS P, et al. Exploiting the Circulant structure of tracking by detection with kernels[C]//Proceedings of the 12th European Conference on Computer Vision. Florence, Italy: Springer, 2012: 702−715.

( 0) 0)

|

| [13] |

COMANICIU D, MEER P. Mean shift: a robust approach toward feature space analysis[J]. IEEE transactions on pattern analysis and machine intelligence, 2002, 24(5): 603-619. DOI:10.1109/34.1000236 ( 0) 0)

|

| [14] |

MEI Xue, LING Haibin. Robust visual tracking and vehicle classification via sparse representation[J]. IEEE transactions on pattern analysis and machine intelligence, 2011, 33(11): 2259-2272. DOI:10.1109/TPAMI.2011.66 ( 0) 0)

|

| [15] |

GRABNER H, GRABNER M. BISCHOF M. Real-time tracking via on-line boosting[C]//Proceedings of 2006 British Machine Vision Conference. Edinburgh, UK: BMVC, 2006: 47−56.

( 0) 0)

|

| [16] |

DANELLJAN M, SHAHBAZ KHAN F, FELSBERG M, et al. Adaptive color attributes for real-time visual tracking[C]//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA: IEEE, 2014: 1090−1097.

( 0) 0)

|

| [17] |

BERTINETTO L, VALMADRE J, GOLODETZ S, et al. Staple: complementary learners for real-time tracking[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA: IEEE, 2016: 1401−1409.

( 0) 0)

|

| [18] |

VALMADRE J, BERTINETTO L, HENRIQUES J, et al. End-to-end representation learning for correlation filter based tracking[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA: IEEE, 2017: 2805−2813.

( 0) 0)

|

| [19] |

包晓安, 詹秀娟, 王强, 等. 基于KCF和SIFT特征的抗遮挡目标跟踪算法[J]. 计算机测量与控制, 2018, 26(5): 148-152. BAO Xiaoan, ZHAN Xiujuan, WANG QIANG, et al. Anti occlusion target tracking algorithm based on KCF and SIFT feature[J]. Computer measurement and control, 2018, 26(5): 148-152. (  0) 0)

|

| [20] |

闫河, 张杨, 杨晓龙, 等. 一种抗遮挡核相关滤波目标跟踪算法[J]. 光电子·激光, 2018, 29(6): 647-652. YAN He, ZHANG Yang, YANG Xiaolong, et al. A kernelized correlaton filters with occlusion handling[J]. Journal of optoelectronics·laser, 2018, 29(6): 647-652. (  0) 0)

|

| [21] |

FARAGHER R. Understanding the basis of the Kalman filter via a simple and intuitive derivation [Lecture Notes][J]. IEEE signal processing magazine, 2012, 29(5): 128-132. DOI:10.1109/MSP.2012.2203621 ( 0) 0)

|

| [22] |

LI Feng, TIAN Cheng, ZUO Wangmeng, et al. Learning spatial-temporal regularized correlation filters for visual tracking[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA: IEEE, 2018: 4904−4913.

( 0) 0)

|

| [23] |

LI Yang, ZHU Jianke, HOI S C H, et al. Robust estimation of similarity transformation for visual object tracking[C]//Proceedings of the 3rd AAAI Conference on Artificial Intelligence, AAAI 2019, The 31st Innovative Applications of Artificial Intelligence Conference, IAAI 2019, The 9th AAAI Symposium on Educational Advances in Artificial Intelligence, EAAI 2019. Honolulu, Hawaii, USA: AAAI, 2019: 8666−8673.

( 0) 0)

|

| [24] |

LI Yang, ZHU Jianke. A scale adaptive kernel correlation filter tracker with feature integration[C]//Proceedings of 2014 European Conference on Computer Vision. Zurich, Switzerland: Springer, 2014: 254−265.

( 0) 0)

|

2021, Vol. 16

2021, Vol. 16