2. 浙江大学 心理与行为科学系,浙江 杭州 310058

2. Department of Psychology, Zhejiang University, Hangzhou 310058, China

人工智能(AI)技术正在造福人类,但是,目前许多AI系统的研发主要遵循“以技术为中心”的理念[1-5]。研究表明不恰当的AI技术开发导致了许多伤害人类的事故,AI事故数据库已经收集了1000多起事故[6],这些事故包括:自动驾驶汽车撞死行人,交易算法错误导致市场“闪崩”,面部识别系统导致无辜者被捕等。美国工程院院士、计算机教授Shneiderman[4]将围绕“以技术为中心”还是“以人为中心”理念开发AI系统的争议形象化地描述为“AI哥白尼革命”,提出AI开发应该将人类放在中心,而不是算法和AI技术。

近几年来,围绕“以人为中心AI”理念、如何避免AI伤害人类以及产生社会负面影响等方面的研究引起越来越多的重视[2-3, 5-11],目前国内外还没有形成系统化的跨学科工作框架来有效应对这些新挑战及促进这方面工作的开展。中国国家自然科学基金委员会在2020年成立了交叉科学部,在交叉科学高端学术论坛上,受邀的AI、人机交互(human-computer interaction)、人因工程(human factors engineering)等专家一致认为,学科交叉是未来科学发展的必然趋势。

在这样的基于跨学科合作理念的背景下,本文回答以下3个问题:与传统计算技术相比,AI技术带来了什么新挑战?应该如何促进“以人为中心AI”理念在AI研发中的应用?从跨学科合作角度我们应该采取什么策略?本文将进一步阐述我们在2019年提出的“以人为中心AI”(human-centered AI,HCAI)理念[2],系统地提出人−人工智能交互(human-AI interaction,HAII)这一新兴跨学科领域。希望通过倡导HCAI理念和HAII领域,促进AI研发造福于人类,避免潜在的负面影响。

1 AI技术带来的新变化和新挑战 1.1 AI技术的跨时代特征AI界一般认为AI技术主要经历了3次浪潮。前两次浪潮集中在科学探索,局限于“以技术为中心”的视野,呈现出“学术主导”的特征。深度机器学习、算力、大数据等技术推动了第3次浪潮的兴起。在第3次浪潮中,人们开始重视AI技术的应用落地场景,开发对人类有用的前端应用和人机交互技术,考虑AI伦理等问题。同时,AI界开始提倡将人与AI视为一个人机系统,引入人的作用[1, 3]。

可见,第3次浪潮开始围绕“人的因素”来开发AI,促使人们更多地考虑“以人为中心AI”的理念。因此,第3次浪潮呈现出“技术提升+应用开发+以人为中心”的特征[2],意味着AI开发不仅是一个技术方案,还是跨学科合作的系统工程。

1.2 智能时代的新型人机关系AI可以开发成具有自主化(autonomy)特征的智能体。取决于自主化程度,AI系统可以拥有一定程度上的类似于人的认知、学习、自适应、独立执行操作等能力,在特定的场景下可以自主地完成一些特定任务,可以在一些设计未预期的场景中自主地完成以往自动化技术所不能完成的任务[9-11]。

这种智能自主化特征赋予人机系统中机器新的角色。在非智能时代,人类操作基于计算技术,机器充当辅助工具角色。人与AI系统的交互本质上是人与自主智能体的交互。随着AI技术提升,自主智能体有可能从一种支持人类操作的辅助工具的角色发展成为与人类操作员共同合作的队友,扮演“辅助工具+人机合作队友”的双重新角色[11]。

因此,智能时代的人机关系正在演变成为团队队友关系,形成一种“人机组队”(human-machine teaming)式合作[12-13]。智能时代的这种人机关系区别于PC时代的人机交互,对AI研发是挑战和机遇,研发者需要在AI研发中要利用这种人机合作,保证人类能够有效控制AI系统,避免伤害人类。

1.3 人−非AI系统交互与人−AI系统交互的比较人机交互是PC时代形成的跨学科领域,它研究人−非AI计算系统之间的交互。表1比较了人−非AI系统交互与人−AI系统交互之间的一些特征。人−AI系统交互所具备的特征是基于AI系统具有较高的智能自主化程度,有些特征目前还没实现。从表1可见,与人−非智能系统交互相比,人−智能系统交互带来了许多新特征和新问题,也给人−智能系统交互的研究和应用带来了新机遇。

| 表 1 人−非AI计算系统交互与人−AI系统交互的特征比较 Tab.1 Comparative analysis between human interaction with non-AI systems and AI systems |

在人−非智能系统交互中,作为一种支持人类操作的辅助工具,机器依赖于事先设计的规则和算法。尽管人机之间也存在一定程度上的人机合作,但是作为辅助工具的机器是被动的,只有人可以主动地启动这种有限的合作。

AI系统智能体具备的自主化特征使得智能体与人类之间可以实现一定程度上类似于人−人团队之间的“合作式交互”。在特定的操作环境中,这种交互可以是由两者之间双向主动的、分享的、互补的、可替换的、自适应的、目标驱动的以及可预测的等特征所决定的(见表1)。随着AI技术的发展,未来AI系统将更多点地具备这些特征[13]。

由此可见,智能时代人−AI系统交互的新特征以及研究的问题等已经远超出了目前人机交互研究和应用的范围,需要一种新思维来考虑如何更加有效地开展多学科合作来应对人−AI系统交互以及AI系统研发中面临的一系列新特征和新挑战。

2 HAII领域的兴起及领域理念国外针对人−AI系统交互的研究和应用已经展开[12-13]。例如:人−智能体交互[14],人−自主化交互(human-autonomy interaction)[15],人−AI交互[16]。尽管这些工作各有侧重点,但是都是研究人与智能“机器”(智能体、智能代理等)之间的交互。所以,这种交互本质上就是人−AI交互 (human-AI interaction,HAII)。目前还没有一个系统的有关HAII领域的工作框架,有必要正式提倡将HAII作为一个新的多学科交叉领域来推动。

2.1 HAII领域的理念:以人为中心AI近几年,当“以技术为中心”方法影响着AI研发的同时,研究者也在探索基于“以人为中心”的AI开发方法,例如,以人为中心的算法、AI人文设计、包容性设计、基于社会责任的AI[8]。

斯坦福大学在2019年成立了“以人为中心AI”(human-centered AI,HCAI) 研究中心,目的是通过技术提升与伦理化设计手段,开发出合乎人类道德伦理和惠及人类的AI系统[17]。

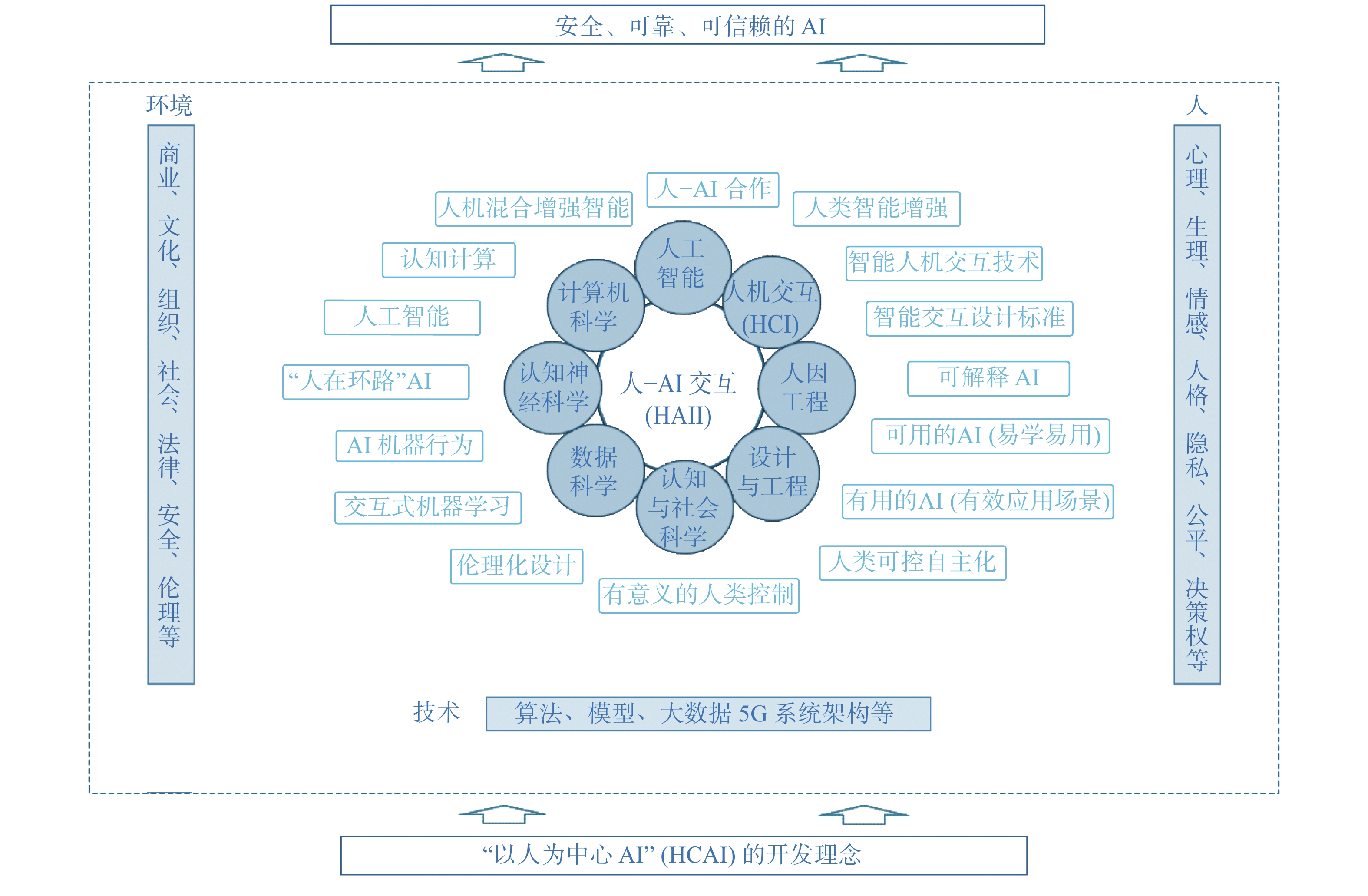

许为[2, 18]在2019年提出了一个“以人为中心AI”(HCAI)的系统概念框架,该框架包括人、伦理、技术3个方面。Shneiderman[19]在2020年提出了一个为开发可靠、安全和可信赖的AI系统的指导框架。HCAI就是指导HAII新领域的理念。以下进一步阐述HCAI理念的3个方面:技术、人、伦理(见图1)[2]。其中,图1概括了各方面工作的主要途径(见图1中围绕3个周边圆形部分的蓝色字体),例如,人的需求、AI应用场景;图1也概括了这些工作要达到的HCAI设计目标(见图1中围绕“以人为中心AI”中心圆形部分的黑色字体),例如,可用的AI、有用的AI。

|

Download:

|

| 图 1 以人为中心AI(HCAI)理念 Fig. 1 Human-Centered AI (HCAI) design philosophy | |

1)“技术”方面:强调3类智能的有机结合。①机器智能:利用算法、大数据、算力等技术来开发机器智能。②人类智能:利用智能增强技术,借助心理学、脑神经技术等方法推动人类智能的增强。③人机混合增强智能:AI界已经认识到单独发展AI技术的路径遇到了瓶颈效应,在高级人类认知方面难以达到人类的智能水平[1, 3,20]。因此,HCAI理念强调将人的作用融入人机系统,通过人机智能的互补,开发人机混合增强智能、AI与人类智能增强技术的整合。目的是开发出可持续发展、强大、人类可控的AI;AI开发的目的是提升人的能力,而不是取代人类。

2)“人”方面:强调在AI系统研发中从人的需求出发,落实有效的应用场景,开发人类认知模型,在AI研发中实施基于“以人为中心”的人机交互设计和方法(建模、设计、测试等)。目的是开发出有用的(满足人的需求、有使用价值)、可用的(易用、易学)、人类拥有最终决控权的AI系统。

3)“伦理”方面:结合跨学科方法、有效开发实践、标准和治理等工作,通过工程设计手段(如“有意义的人类控制”),保证AI开发遵循公平、人的隐私、伦理道德、人的决策权等方面的权益。目的是开发出伦理化、负责任的AI。

HCAI理念强调在AI开发中保持人的中心地位,贯彻技术、人、伦理三方面相互依承的系统化AI开发思维,主张AI开发是一个跨学科协作的系统工程,开发出可靠的、安全的、可信赖的AI系统[2, 19]。

2.2 HAII领域的工作框架针对HAII这一新兴领域,我们作出以下初步的定义。图2示意了人−人工智能交互(HAII)的领域框架,其中,蓝色圆圈部份代表跨学科的主要合作学科,白色长形部份代表本文所讨论的HAII研究和应用的主要问题。

HAII领域理念:以人为中心AI(HCAI)。

HAII领域目的:作为一个跨学科交叉领域,HAII利用AI、计算机科学、人机交互、人因工程、心理学等学科技术和方法,致力于合作研发AI系统,优化人与AI系统之间的交互,注重机器与人类智能的优势互补,全方位考虑AI伦理道德,强调人对AI系统的最终决控权,通过提供一个跨学科的合作平台,在AI系统开发中实现HCAI开发理念,为人类提供安全、可靠、可信赖的AI。

HAII研究和应用范围:狭义地说,HAII涉及到人与AI系统交互的研究和应用;广义地说,任何涉及到由人来使用、影响人的AI研究发都属于HAII的范畴,包括与人产生交互的AI系统的研究和应用领域,如智能手机应用APP、智能人机交互技术、智能决策系统、智能物联网等。如图2所示,HAII从人−机−环境系统的角度来考虑各种因素对人与AI交互的影响,全面了解这些影响有助于发挥AI技术的优势,避免负面影响。

|

Download:

|

| 图 2 人−人工智能交互(HAII)领域示意 Fig. 2 Illustration of the human-AI interaction (HAII) domain | |

HAII领域方法:作为一个跨学科领域,通过多学科方法(建模、算法、设计、工程、测试等)和合作的流程来开发AI系统。这些方法来自这些相关学科,例如计算模型、工程设计方法、行为科学研究方法、人机交互设计等。

HAII领域人员:从事HAII研究和应用的人员包括来自AI、计算机、数据科学、人机交互、心理学、认知神经科学、社会科学等专业人员。广义地来说,大多数从事AI系统研发的人员都属于这个范畴,他们研发的AI系统或多或少都与人交互,都是为了开发出有利于人类的AI系统。

2.3 为什么需要HAII新领域首先,HAII领域为各学科提供了一个合作平台。HAII有助于在一个领域名称(HAII)下,联合参与AI系统研发的跨学科、跨行业专业人员,避免易混淆的名称,这种跨学科合作有助于有效地开发以人为中心的AI系统。

其次,HAII领域强调其研究和应用的对象是AI,不是传统的非AI系统,有助于提醒人们注重AI与非AI系统之间的特征差异,促使人们重视AI技术带来的新挑战和新问题,采用有效的方法来解决AI系统开发中的独特问题。

最后,HAII领域有助于推动HCAI理念在AI研发中的落实。HAII强调AI研发中将人的中心作用整合到系统设计中,避免潜在安全风险问题[8, 20]。

历史上,新技术促进了新领域的产生。进入PC时代,传统“人机交互”(human-machine interaction)领域过渡到新版的“人机交互”(人−计算机交互),但是此“机”非彼“机”[21]。智能时代的机器过渡到AI系统,AI的新特征促使HAII新领域的产生,因此,HAII的出现也是必然的。

我们并不建议将HAII设置为一门独立的新学科,强调HAII是一个新型跨学科领域,希望通过该领域的跨学科、跨行业协同合作来落实HCAI理念。例如,HAII工作需要人机交互人员的参与,他们必须采用新思维开展针对人与AI交互的研究和应用。

2.4 实现HCAI理念面临的挑战和HAII解决方案HAII领域的工作并非刚刚兴起,AI界和其他相关学科已经开展了一些工作。为进一步阐述HAII领域,基于文献综述和分析,表2概括了当前HAII研究和应用的重点、实现HCAI理念的挑战、HAII领域可能的解决方案、期望的HCAI设计目标。表2也引用一些实例,详细内容在本文第3部分讨论。

| 表 2 HAII领域中实现HCAI理念所面临的挑战、HAII可能解决方案、应用实例以及HCAI设计目标 Tab.2 Challenges in realizing the HCAI design philosophy, possible HAII solutions, application examples, and expected HCAI design goals |

从表2可知,首先,为实现基于HCAI理念的设计目标,HAII研究和应用有许多挑战期待解决。不解决这些挑战我们就无法实现HCAI理念,无法开发出安全、可靠、可信赖的AI。

其次,表2概括出了HAII研究和应用的范围。目前来自AI和其他学科的专业人员在开展这方面的工作,这些挑战不是单一学科可以解决的,这正说明了HCAI和HAII工作需要跨学科的协同合作。

最后,HAII领域采用跨学科的方法。HAII研究和应用的挑战、可能的解决方案以及实例都依赖于跨学科方法(建模、工程设计、行为科学方法等),单一学科的方法无法有效地解决这些问题。

40多年前,当PC新技术刚兴起时,开发者基本遵循“以技术为中心”的理念。随着PC的普及,许多用户体验问题随之出现,人们开始意识到“以人为中心设计”理念的重要性,来自计算机科学、人因工程、心理学的专业人员协同推动了人机交互学科的形成和发展。多年的实践,用户体验的理念已经在社会和计算技术界形成共识。

今天,随着AI技术的引进,我们又目睹了类似情景,但是这一次忽略“以人为中心”理念的代价对人类和社会的影响将更为严重[6]。因此,各学科必须再一次协同合作,推动智能时代的“以人为中心设计”版本(即HCAI理念)和HAII领域的工作,更加有效地利用AI技术,扬长避短,为人类服务。

另外,HCAI理念和HAII领域定义的是AI开发中应该遵循的理念、目标及途径等,并非是一个具体模型或算法。我们强调跨学科合作,一旦明确了这些理念、目标及途径等,AI人员就能更加有效地开发出实现HCAI理念、设计目标的模型、算法以及技术。

3 HAII研究和应用的关键问题依据HCAI理念,针对目前AI带来的新挑战,我们从以下几方面分析目前HAII研究和应用的进展,提出今后的重点方向。目前一些AI人员也在开展这方面工作,希望HCAI理念和HAII领域的提出能够强化这些人员的HCAI理念以及跨学科的合作,也希望非AI人员积极参与到HAII研究和应用中。

3.1 人类智能增强自1956年AI概念被提出后,研究者已经开始致力于另一条路径:智能增强 (intelligence augmentation,IA)[41]。智能增强致力于增强人类智能[42-43]。研究人员利用新技术(如心理学、脑机接口、虚拟现实),借助AI技术来推动智能增强的研究和应用[44]。从HCAI理念看,HAII领域与智能增强具有相同目标:利用AI技术来增强人的能力。

AI领域与智能增强领域之间长期存在竞争。一些AI人员认为AI可以取代人类,而智能增强人员认为AI仅仅为智能增强技术提供了新的手段[23]。从HCAI理念分析,AI和智能增强会采用类似的技术,遵循的应该都是扩展人类智能,应该是“以人为中心”的伙伴关系,许多智能方案其实是两种技术的集合,HAII可以为两者的合作起到桥梁的作用。

今后,智能增强研究中有许多问题需要HAII领域的贡献。首先,机器智能无法模仿人类智能的某些维度,HAII提倡从跨学科角度来探索哪种类型的人类智能增强以及技术可以提供有效手段来弥补AI的弱点[45],这需要智能增强人员主动寻求来自AI、心理学、认知神经科学、人因工程学科的支持。

其次,开发AI与智能增强技术最佳组合的应用解决方案将有效促进两种技术之间的合作,从而达到“1+1>2”的效果。HAII领域可以起到一个中间桥梁的作用,从人机交互、心理学等学科角度,从人机交互方式、多模态交互兼容性、人类认知加工水平、AI系统自主化程度等多种维度来开发能够支持人与智能系统有效交互的解决方案。

第三,依据HCAI理念,智能增强专业人员要将人类置于系统方案的中心。HAII领域提倡心理学、认知神经科学等人员积极参与研究。例如,基于可塑性机制,构建认知负荷可控、及时生理反馈、体脑双向交互的新型人机交互研究。这些研究将有效支持在许多应用领域中训练和增强人类智能[46]。

最后,在生物神经层面上寻找AI技术与智能增强技术的整合解决方案。这是当前关注的研究方向之一,例如,脑机融合[47]。HAII提倡AI、认知神经科学、脑成像技术、人机交互等人员合作,优化脑机界面解决方案,通过在生物神经层面上整合AI与智能增强技术来探索有效的人−AI交互手段[48]。

3.2 人机混合增强智能将人类的作用和人类智能引入AI系统将形成人类智能与机器智能的优势互补,从而开发出更强大、可持续发展的人机混合增强智能[1, 20, 48]。

目前,针对混合增强智能的研究基本可分为两类。第一类是在系统层面上的“人在环路”式混合增强智能[49]。这种思路符合HCAI理念,即将人的作用引入AI系统中,形成以人为中心、融于人机关系的混合智能。例如,在“人在环路”范式中,人始终是AI系统的一部分,当系统输出置信度低时,人主动介入调整参数给出合理正确的问题求解,构成提升智能水平的反馈回路[1, 50]。另一种方案是在生物学层面上开发“脑在环路”式混增强智能[3],以生物智能和机器智能深度融合为目标,通过神经连接通道,可以形成对某个功能体的增强、替代和补偿。

第二类混合增强智能是将人类认知模型嵌入AI系统中,形成基于认知计算的混合增强智能[1]。从HCAI理念分析,这类混合增强智能并不是真正意义上的人机混合增强智能,因为这种系统并非能够保证以人机系统为载体来实现人在人机系统中的中心作用和最终决控权。当然,把人类认知模型引入到机器智能中,对于发展机器智能是非常重要的。

HAII领域工作将对人机混合增强智能研究和应用发挥重要作用。首先,HAII领域提倡心理学、认知工程等学科专业人员的合作支持,加速现有心理学等学科成果的转换来支持认知计算的研究,提供有效的认知计算体系架构[51],例如,为提高对非结构化视听觉感知信息的理解能力和海量异构信息的处理效率,HAII领域需要支持AI界在“感知特征的提取、表达及整合”和“模态信息协同计算”等方面的视听觉信息认知计算研究[52]。HAII鼓励将基于认知计算方法与“人在环路”方法(系统、生物学层面)整合的工作思路。基于HCAI理念,这种思路有助于开发出更强大、可持续发展的、人类可控的AI。

第二,开展基于HCAI理念的人机混合智能控制研究。针对人机混合智能系统控制,目前主要有两种方案:“人在回路控制”和“人机协同控制”[53]。AI系统在应急状态时人机之间的高效切换是目前重要研究课题。例如,自主武器系统发射后的追踪控制,自主驾驶车应急状态下的高效人机切换。HCAI理念要求人拥有最终控制权,这需要AI、人机交互等专业人员的合作,寻找有效解决方案。

第三,开展人机混合增强智能系统的人机交互研究。“人在环路”混合智能系统需要与用户交互的交互设计[24]。不同于传统人机交互,用户交互的对象是AI模型,用户界面难以理解,用户与AI交互中存在用户意图的不确定性[1]。HAII研究要求AI专业人员与人机交互、人因工程等专业合作,从智能系统、用户、人机交互设计三方面优化系统设计。例如,开发自然式交互设计,选择有效的心理模型。

最后,开展人类高级认知层面上的人机混合增强智能研究。HAII研究需要AI、认知神经科学、计算机科学、心理学等专业人员的合作。例如,进一步探索人机融合、脑机融合等方面的研究,今后要在更高的认知层次上为脑机智能的叠加(如学习、记忆)建立更有效的模型和算法[44];探索如何将人的决策和经验与机器智能在逻辑推理、演绎推理等方面的优势结合,使人机合作具有高效率[1]。从长远看,人机混合增强智能未来可能形成有效的人机共生[46],通过个体和群体智能融合等途径,最终在系统和生物学层面上实现人机共生和融合[54]。

3.3 人−AI合作智能技术带来了一种新型人机关系:人−AI合作,人−AI系统作为一个组合体比单个实体的工作更加有效[27, 29]。人−AI合作的研究目前在国外是一个热点。HAII研究需要AI、心理学和人因工程等学科的合作,从感知、认知、执行3个层面上开展。

在感知层面,为了有效的人−AI合作,AI系统需要人的模型来支持系统对人类状态的监控(生理、行为、情绪、愿图、能力等);AI系统的人机界面要足够透明,帮助人类了解当前系统状态。例如,人机之间情景意识(态势感知)分享是人−AI合作研究的基本问题之一。研究需要了解如何有效实现人−AI之间基于情景意识模型的的双向沟通[55],目前还缺少针对人−AI合作的情景意识模型和测试方法[56]。今后的HAII工作需要丰富情景意识理论,为人−AI合作建模、认知架构、绩效测评提供支持。

在认知层面,PC时代的人机交互模型已经不能满足智能时代的复杂交互场景。HAII需要构建符合人−AI合作的认知和计算模型[57]。人与AI之间的互信影响人−AI合作的绩效,HAII需要研究信任测量、建模、修复、校正等方面的工作,以及如何量化不同操作场景中人机之间动态化功能交换时所需的信任。不同于传统人机交互,人与AI均需要彼此感知并识别交方的意图与情感,今后研究要进一步探索心理模型、意图识别、情感交互等模型,以及在系统设计中如何实现和验证这些模型。

在执行层面,有效的人−AI合作应该允许在任务、功能、系统等层面上实现决控权在人与AI代理之间的分享。决控权的转移取决于人机双向信任、情景意识共享、合作程度等因素。例如,在自动驾驶车领域,HAII工作需要研究人机控制分享范式、人机共驾所需的情景意识分享、人机互信、风险评估等,保证车辆控制权在人机之间的快速有效切换,确保人拥有最终控制权(包括远程控制等)[58]。HAII研究需要了解在什么条件下人机之间如何完成有效切换,是否可以借助人−AI合作的思路,通过有效人机交互,提供有效的人机控制权转移。HAII今后的工作还应该在以下几方面开展。

首先,HAII需要为人−AI合作的研究开发新理论、模型以及评估和预测人−AI合作团队绩效的方法,这些都是传统人机交互中没有遇到的新问题。HAII领域的工作要支持AI建模以及对建模数据的需求(例如,情景意识、行为、意图、信任)[13],合作开发人−AI合作在各种应用领域的解决方案。

其次,HAII领域需要从行为科学等角度、社会层面上来研究人−AI合作。要研究社会因素(社会责任、道德等)对人−AI合作的影响,研究如何让AI代理担当团队角色并且与人类队友合作[13];研究如何从系统设计角度,通过合适的人机交互方式来发展良好的人机关系(信任,情感等);研究如何有效支持长期人−AI合作(如医用机器人)。

第三,HAII研究要构建人−AI合作场景所需的人机交互建模。与AI人员合作研究对人−AI合作中人机交互建模构成挑战的理论问题,例如,分布式认知理论,基于上下文的知识表征和知识图谱[59],人−AI合作中情感交互、社交互动等方面的认知建模。

最后,HAII需要在真实的操作、社交环境中研究人−AI合作[60]。例如,实验室研究表明,与简单机器人的交互可以增强人的协调性,并且机器人可以直接与人合作[61];人−AI合作中AI与人的认知风格、人格特性等特性相适应时,可增强人机互信与可靠性。今后要在真实社会环境中验证这些人−AI社会互动,这将有助于优化人−AI合作的设计。

3.4 可解释AI深度学习等方法会产生AI“黑匣子”效应,导致用户对AI系统的决策产生疑问,该效应可在各类使用中发生,包括AI在金融股票、医疗诊断、安全检测、法律判决等领域,导致系统决策效率降低、伦理道德等问题,影响公众对AI的信任度。

寻求可解释AI(explainable AI, XAI)已成为AI界的一个研究热点,具有代表性的是DARPA[62]在2016年启动的项目。该项目集中在:1)开发或改进ML技术来获取可解释算法模型;2)借助于先进的人机交互技术,开发可解释AI的用户界面模型;3)评估心理学解释理论来协助可解释AI的研发。

经过多年的努力,AI界开始认识到非AI学科在可解释AI研究中的重要性[63]。Miller等[64]的调查表明,大多数可解释AI项目仅在AI学科内展开。许多AI人员采用“以算法为中心”的方法,加剧了算法的不透明[65]。一些AI人员没有遵循HCAI理念,通常为自己而不是用户构建可解释AI[66]。研究还表明,如果采用行为科学方法,侧重于用户而不是技术,针对可解释AI的研究将更有效[64]。

今后HAII领域的工作主要有以下几方面。首先,研究和开发“以人为中心的可解释AI”解决方案。HAII领域要从人机交互、心理学、人因工程等方面来寻找解决方案。以往许多研究是基于静态和单向信息传达式的解释,今后HAII工作要研究探索式、自然式、交互式解释来设计可解释界面[67-68]。

第二,HAII领域提倡可解释AI研究要进一步挖掘心理学等模型。尽管这些理论和模型通常是基于实验室研究产生,可解释AI研究应该善于利用这些模型,同时验证它们的可行性[68]。HAII的工作可以利用本身交叉学科的特点起到一个中间桥梁作用,加快理论转换,构建有效的界面或计算模型。

最后,HAII领域要开展可理解AI的研究和应用。可解释AI也应该是可理解的[68],可解释性是必要条件,但不是充分条件。从HCAI理念考虑,可理解AI方案应满足终端用户的需求(例如知识水平)。这方面的研究需要行为科学方法的支持以及实验验证[69]。

3.5 人类可控自主化智能自主化技术正在走进人们的工作和生活,但是已有人开始混淆自动化与自主化的概念,这可能导致对技术不恰当的期望和误用[10]。自动化技术按照固定算法、逻辑和规则而产生确定的机器行为。智能系统会拥有不同程度的类似于人的智能(自适应、自我执行等能力),系统输出具不确定性,有可能出现偏差的机器行为。AI的自主化特征对安全和大众心理等负面影响还没有引起足够的重视[70]。

从HCAI理念出发,我们提倡基于“人类可控AI”设计目标的人类可控自主化设计,即智能自主化系统需要人类的监控,人类操作员具有最终的决控权(通过直接或远程操控等方式)[4]。

人因工程界已经对一些复杂领域(航空、航天等)中的自动化系统开展了广泛的研究,已达成共识[71-72]。许多复杂自动化系统存在脆弱性,在设计所规定的操作场景中运行良好,但是在遇到意外事件时,可能导致操作员的“自动化惊讶”现象[71]:操作员无法理解自动化正在做什么,为什么这样做。

Endsley[70]认为在智能自主化系统中,随着系统自主化程度的提高,各单项功能的“自动化”水平也相应提高,这可能会导致操作员对这些功能的关注度降低,在应急状态下出现“人在环外”的现象。对近几年发生的多起自动驾驶车致命事故调查表明,界面模式混淆、“人在环外”、过度信任等问题正是以往自动化系统中出现的典型问题[73-74]。

智能技术中潜在的自主操作性等特征也会造成人们对该技术产生类似于对自动化的过度信任。具有学习能力的自主化系统意味着其操作结果的不确定性可能以意想不到的方式发展,有可能给操作员带来比自动化更强烈的“自动化惊讶”体验。

今后HAII领域的工作可从以下几方面考虑:

首先,HAII领域要针对一些自主化的基本问题展开研究。从人机交互角度充分理解AI自主化特性对人机交互设计的影响,研究自主化对操作员期望、角色等的影响,研究自主化对操作员情绪应激、认知能力、人格特质和沟通属性的影响[75-76]。

其次,HAII领域要在自主系统开发中实现HCAI理念的“人类可控AI”设计目标。目前,尽管人机交互等专业人员参与了自主化系统(如自动驾驶汽车)的研发,但是频频发生的事故提醒我们评估目前的方法[11]。SAE[77]认为L4-L5等级的自动驾驶车不需要人类监控和干预,我们质疑SAE忽略了自动化和自主化之间的本质差异[78],可能对设计、安全、标准化和认证等产生不利影响。高等级自动驾驶汽车是一个“移动式”自主化系统,不是传统的自动化系统。基于HCAI理念,要从人-AI合作、人机互信、态势感知共享、自主化共享等角度探索自主化设计,实现有效的人机共驾及交接[79],任何等级的自动驾驶车都需要确保人是系统的最终决控者(包括远程控制方式)。

最后,实现针对自主化系统的“有意义的人类控制”(meaningful human control)设计目标[40]。HAII工作要落实该目标的实现:1)通过“人在环路”、人机交互设计,保证应急状态下人类可接管或中断系统运行;2)在重要的自主化系统中安装“故障追踪系统”来实现设计改善和人机故障问责制[40],推动HCAI理念中“人类可控AI”设计目标的实现。

3.6 智能人机交互智能化人机交互为HAII领域带来了挑战和机遇。AI系统丰富的应用场景和用户需求需要有效的人机交互范式[80]。现有人机交互方式(如WIMP)局限于有限的感知通道、交互带宽不足、输入/输出带宽不平衡、交互方式不自然等问题,已有研究提出了Post-WIMP的范式[81],这些范式需要HAII工作的验证。多模态融合及并行交互范式是今后HAII的重要研究内容,这方面研究目前主要在AI、计算技术界展开,HAII应该提供跨学科支持。HAII还要在情境感知、意图理解等方面取得更大突破[81-83]。

人−AI合作的新型人机关系对人机界面设计提出了新要求。传统人机界面主要基于“刺激−反应”理念的“指令顺序”式交互,针对智能人机交互(情感、意图识别、上下文检测等)的多模态余度式交互,HAII要设计有效的人机界面来支持人−AI合作所需的情景意识分享、人机互信、人机控制分享等。

HAII领域要开发针对AI系统的人机交互设计标准。现有的标准主要是针对非AI系统,国际标准化组织正在起草人−AI系统交互的设计标准(ISO 9241-810)[36],已有一些针对AI系统的人机交互设计指南[16, 64],但是还需要HAII领域的贡献。

3.7 伦理化AI设计HCAI理念推崇的伦理化AI设计目标是AI界目前普遍关心的重要问题。研究表明,AI人员在职业培训中通常缺乏应用伦理规范进行设计的培训,AI界已经认识到伦理化AI设计需要多学科的合作[84]。专业组织和企业已发布了多套AI伦理准则,但是研究表明在AI系统开发中如何有效落实这些规范有待进一步努力,一些专业人员是在开发后期而不是过程中考虑伦理化设计[85]。因此,HAII领域的一项重要工作是将伦理化AI设计落实在开发过程中。

首先,HAII领域要开展针对AI机器行为的研究。2019年MIT等大学的多名学者在《自然》上发文建议开展AI机器行为的研究[9]。目前从事机器行为研究主要是AI人员,没有受过行为科学的训练。AI机器行为的非确定性,需要从算法、数据、培训、测试等方面来研究影响因素,避免算法偏差。目前,已有基于HCAI理念的机器行为研究,例如,“以人为中心的机器学习”、交互式机器学习等方法[22, 66]。这些方法有助于在开发中解决AI系统极端行为、公平性等问题。

第二,HAII领域可采用跨学科的方法论来支持伦理化AI设计,将人机交互所倡导的迭代式设计和测评方法应用在模型算法训练中,收集算法培训数据,定义用户预期结果并且转化成有效的输入数据,利用早期原型开展用户体验测评,通过迭代式设计和测试来减小算法偏差[86]。

第三,采用“有意义的人类控制”方法将伦理化AI落实在系统设计中[40, 70]。系统设计要保证:1)操作员能够对所使用的自主化技术做出知情且有意识的决策;2)操作员有足够的信息来确保采取合法的行动。另外,在系统设计、测试、专业人员培训等方面采取措施来确保人类对系统的有效控制。“有意义的人类控制”与HCAI理念一致,有利于在设计中实现伦理化AI的目标。

最后,HAII领域要优化AI的开发实践来支持伦理化AI设计。研究表明,目前AI界缺乏有效的伦理化AI设计方法论、指导设计选项的技术细节或详细示例[85]。HAII领域可从“人在环路”AI、人-AI合作等设计思路方面提供帮助。如何将伦理化AI原则嵌入到开发流程、如何提高伦理化AI准则对AI工程师行为的影响、如何提升AI工程师的伦理化设计技能等方面的问题都需要HAII的多学科方案。

4 HAII研究和应用的挑战及对策作为一个新兴领域,在实现HCAI理念的实践中,HAII研究和应用必定面对挑战。

第一,AI人员缺乏对HCAI理念的理解。许多AI人员在开发中基本按照“以技术为中心”的理念,一些人员认为人机交互无法解决的问题目前已被AI技术解决(如语音输入),人机界面不必考虑用户体验;而人机交互等专业人员往往在AI项目产品需求定义后才参与项目,限制了他们对AI系统设计的影响,并且导致一些AI项目的失败[87-89]。

第二,AI系统研发中缺乏有效的跨学科合作。AI人员与非AI人员之间缺乏有效的沟通语言,非AI人士缺乏必要的AI知识,而AI人士缺乏对其他学科的了解[90]。目前,已有研究提出了基于HCAI理念的AI与人机交互专业人员的“配对式AI合作开发流程”[40]以及提升的人机交互方法[91]。

第三,跨学科合作缺乏有效的方法。一些人机交互人员在AI系统开发中仍然采用传统针对非AI系统的方法;许多AI人员不易接受其他学科的方法。目前,人们已经提出了一些方法,例如,“AI优先”方法、“AI作为设计材料”[37, 39]。

为有效实现HCAI理念和开展HAII工作,从以下3个层面提出建议,如图3所示。

|

Download:

|

| 图 3 有效实现HCAI理念以及开展HAII研究和应用的“三层面”策略 Fig. 3 “3-layer” strategy for effectively implementing HCAI and carrying out HAII research and application | |

首先,在AI研发团队层面,建立多学科团队和采用跨学科方法。AI带来的新问题只有采用多学科合作才能找到有效方案。基于HCAI理念来优化现有的AI研发流程,例如,在开发初期制定HCAI设计目标,优化在各个开发流程节点上协同合作。

其次,在AI研发企业组织层面,培育基于HCAI理念的组织文化,制定基于HCAI的开发标准指南,提供HCAI研发资源(跨学科人力资源、HAII项目、跨学科研究设备等),建立高效的AI研发团队。

最后,在AI研发社会层面,培养具备HCAI理念的跨学科复合型人才。例如,在高校开设“AI主修+辅修”、“主修+AI辅修”本科专业,培养针对HAII关键问题的硕博研究生;制定AI发展策略、法规等;开展跨行业、跨学科攻关项目,提倡学术界和工业界之间的协作;设立政府专项基金来支持HAII项目;建立完善的产学研相结合的科研体系,在一些关键行业开展HAII研究和应用。

5 结论1)当前的智能时代呈现出“技术提升+应用开发+以人为中心”的阶段特征。拥有一定程度的学习、自适应、独立执行等能力是智能技术的独特自主化特征,赋予了机器在人机系统中新的角色,带来了新型人机关系:人−AI合作。与人−计算机交互相比,人−AI交互带来了许多新特征和新问题,给AI系统研发带来了新挑战,促使我们重新评估目前所采用的、基于非AI系统的研发策略。

2)为有效解决AI系统研发中的新挑战,本文阐述了HCAI的理念,它强调三方面工作的有机结合。①“技术”:提倡AI技术的发展策略应该注重人类与机器智能的优势互补,将人的作用引入AI系统中,从而产生更强大、可持续发展的人机混合增强智能。AI的目的是提升人的能力,不是取代人。②“人”:强调从人的需求出发,为人类提供有用、可用、人类拥有最终决控权的AI系统。③“伦理”:从人类伦理出发,AI系统研发要避免产生伦理道德等问题,目的是开发出伦理化、负责任的AI。

3)为实现HCAI理念在AI研发中的落实,本文系统提出HAII这一跨学科新领域。HAII领域可以为各学科提供一个有效的合作平台,注重AI技术的新挑战和新问题,有助于推动HCAI理念在AI研发中的落实,开发出安全、可靠、可信赖的AI系统。

4)针对AI带来的新问题,我们提出今后HAII研究和应用的重点方向,它们包括人类智能增强技术、人机混合增强智能、人−AI合作、可解释AI、人类可控自主化、智能人机交互、伦理化AI设计。

5)针对今后HAII实践面对的挑战,从研发团队、研发组织、研发社会环境3个层面上,我们建议:设立多学科研发团队,采用跨学科方法,优化现有AI研发流程;培育HCAI理念的组织文化,开发HCAI标准指南和研发资源;培养跨学科复合型AI人才,政府出台相关政策和法规,积极开展跨学科、跨行业以及关键行业领域的HAII研究和应用。我们展望只要各学科和各行业一起努力,一个基于“以人为中心AI”理念的智能社会时代将会到来。

| [1] |

ZHENG Nanning, LIU Ziyi, REN Pengju, et al. Hybrid-augmented intelligence: collaboration and cognition[J]. Frontiers of information technology & electronic engineering, 2017, 18(2): 153-179. ( 0) 0)

|

| [2] |

XU Wei. Toward human-centered AI: a perspective from human-computer interaction[J]. Interactions, 2019, 26(4): 42-46. DOI:10.1145/3328485 ( 0) 0)

|

| [3] |

吴朝晖. 混合增强智能[EB/OL]. (2019-11-29) [2020-12-30]. https://www.wicongress.org/2020/zh/article/487. WU Zhaohui. Hybrid augmented intelligence[EB/OL]. (2019-11-29) [2020-12-30] https://www.wicongress.org/2020/zh/article/487 (  0) 0)

|

| [4] |

SHNEIDERMAN B. Design lessons from AI’s two grand goals: human emulation and useful applications[J]. IEEE transactions on technology and society, 2020, 1(2): 73-82. DOI:10.1109/TTS.2020.2992669 ( 0) 0)

|

| [5] |

SHNEIDERMAN B. Bridging the gap between ethics and practice: guidelines for reliable, safe, and trustworthy Human-Centered AI Systems[J]. ACM transactions on interactive intelligent systems, 2020, 10(4): 26. ( 0) 0)

|

| [6] |

MCGREGOR S. AI Incidents Database[EB/OL]. 2016, [2021-06-01] https://incidentdatabase.ai/.

( 0) 0)

|

| [7] |

许为. 五论以用户为中心的设计: 从自动化到智能时代的自主化以及自动驾驶车[J]. 应用心理学, 2020, 26(2): 108-128. XU Wei. User-centered design (V): from automation to the autonomy and autonomous vehicles in the intelligence era[J]. Chinese journal of applied psychology, 2020, 26(2): 108-128. DOI:10.3969/j.issn.1006-6020.2020.02.002 (  0) 0)

|

| [8] |

AUERNHAMMER J. Human-centered AI: the role of human-centered design research in the development of AI[M]//BOESS S, CHEUNG M, CAIN R. Synergy–DRS International Conference. 2020.

( 0) 0)

|

| [9] |

RAHWAN I, CEBRIAN M, OBRADOVICH N, et al. Machine behaviour[J]. Nature, 2019, 568(7753): 477-486. DOI:10.1038/s41586-019-1138-y ( 0) 0)

|

| [10] |

KABER D B. A conceptual framework of autonomous and automated agents[J]. Theoretical issues in ergonomics science, 2018, 19(4): 406-430. DOI:10.1080/1463922X.2017.1363314 ( 0) 0)

|

| [11] |

XU Wei. From automation to autonomy and autonomous vehicles: challenges and opportunities for human-computer interaction[J]. Interactions, 2021, 28(1): 48-53. DOI:10.1145/3434580 ( 0) 0)

|

| [12] |

BRILL J C, CUMMINGS M L, EVANS III A W, et al. Navigating the advent of human-machine teaming[J]. Proceedings of the human factors and ergonomics society annual meeting, 2018, 62(1): 455-459. DOI:10.1177/1541931218621104 ( 0) 0)

|

| [13] |

JOHNSON M, VERA A. No AI is an island: the case for teaming intelligence[J]. AI magazine, 2019, 40(1): 16-28. DOI:10.1609/aimag.v40i1.2842 ( 0) 0)

|

| [14] |

PRADA R, PAIVA A. Human-agent interaction: challenges for bringing humans and agents together[C]//3rd International Workshop on Human-Agent Interaction Design and Models Held at AAMAS’2014-13th International Conference on Autonomous Agents and Multi-Agent Systems. Paris, France, 2014: 1−10.

( 0) 0)

|

| [15] |

CUMMINGS M L, CLARE A S. Holistic modelling for human-autonomous system interaction[J]. Theoretical issues in ergonomics science, 2015, 16(3): 214-231. DOI:10.1080/1463922X.2014.1003990 ( 0) 0)

|

| [16] |

AMERSHI S, WELD D, VORVOREANU M, et al. Guidelines for human-AI interaction[M]. Glasgow: ACM, 2019.

( 0) 0)

|

| [17] |

LI F F. How to make A. I. That’s good for people[N]. The New York times, 2018.

( 0) 0)

|

| [18] |

许为. 四论以用户为中心的设计: 以人为中心的人工智能[J]. 应用心理学, 2019, 25(4): 291-305. XU Wei. User-centered design (IV): human-centered artificial intelligence[J]. Chinese journal of applied psychology, 2019, 25(4): 291-305. (  0) 0)

|

| [19] |

SHNEIDERMAN B. Human-centered artificial intelligence: reliable, safe & trustworthy[J]. International journal of human–computer interaction, 2020, 36(6): 495-504. DOI:10.1080/10447318.2020.1741118 ( 0) 0)

|

| [20] |

许为, 葛列众. 智能时代的工程心理学[J]. 心理科学进展, 2020, 28(9): 1409-1425. XU Wei, GE Liezhong. Engineering psychology in the era of artificial intelligence[J]. Advances in psychological science, 2020, 28(9): 1409-1425. DOI:10.3724/SP.J.1042.2020.01409 (  0) 0)

|

| [21] |

许为. 人-计算机交互作用研究和应用新思路的探讨[J]. 人类工效学, 2005, 11(4): 37-40. XU Wei. Recent trend of research and applications on human-computer interaction[J]. Chinese journal of ergonomics, 2005, 11(4): 37-40. DOI:10.3969/j.issn.1006-8309.2005.04.012 (  0) 0)

|

| [22] |

AMERSHI S, CAKMAK M, KNOX W B, et al. Power to the people: the role of humans in interactive machine learning[J]. AI magazine, 2014, 35(4): 105-120. DOI:10.1609/aimag.v35i4.2513 ( 0) 0)

|

| [23] |

HASSANI H, SILVA E S, UNGER S, et al. Artificial intelligence (AI) or intelligence augmentation (IA): what is the future?[J]. AI, 2020, 1(2): 143-155. DOI:10.3390/ai1020008 ( 0) 0)

|

| [24] |

胡源达, 孙效华, 张何辛, 等. 支持人在环路混合智能的交互设计研究[J]. 包装工程, 2020, 41(18): 38-47. HU Yuanda, SUN Xiaohua, ZHANG Hexin, et al. Interaction design in human-in-the-loop hybrid intelligence[J]. Packaging engineering, 2020, 41(18): 38-47. (  0) 0)

|

| [25] |

郑庆华. 人机混合增强智能的典型应用专题前言[J]. 计算机研究与发展, 2020, 57(12): 2479-2480. ZHENG Qinghua. Preface to the applications of human-machine hybrid enhanced intelligence[J]. Journal of computer research and development, 2020, 57(12): 2479-2480. DOI:10.7544/issn1000-1239.2020.qy1201 (  0) 0)

|

| [26] |

O’NEILL T A, MCNEESE N J, BARRON A, et al. Human–autonomy teaming: a review and analysis of the empirical literature[J]. Human factors: the journal of the human factors and ergonomics society, 2020. DOI: 10.1177/0018720820960865.

( 0) 0)

|

| [27] |

DEMIR M, COOKE N J, AMAZEEN P G. A conceptual model of team dynamical behaviors and performance in human-autonomy teaming[J]. Cognitive systems research, 2018, 52: 497-507. DOI:10.1016/j.cogsys.2018.07.029 ( 0) 0)

|

| [28] |

BINDEWALD J M, RUSNOCK C F, MILLER M E. (2017). Measuring human trust behavior in human-machine teams[C]//Proceedings of the AHFE 2017 International Conference on Human Factors in Simulation and Modeling. Los Angeles, USA, 2017.

( 0) 0)

|

| [29] |

BANSAL G, NUSHI B, KAMAR E, et al. Beyond accuracy: the role of mental models in human-AI team performance[C]//Proceedings of the Seventh AAAI Conference on Human Computation and Crowdsourcing. 2019: 2−11.

( 0) 0)

|

| [30] |

OZKAYA I. The behavioral science of software engineering and human–machine teaming[J]. IEEE software, 2020, 37(6): 3-6. DOI:10.1109/MS.2020.3019190 ( 0) 0)

|

| [31] |

HARING K S, MOSLEY A, PRUZNICK S, et al. Robot authority in human-machine teams: effects of human-like appearance on compliance[C]//11th International Conference on Virtual, Augmented and Mixed Reality. Applications and Case Studies. Orlando, USA, 2019: 63−78.

( 0) 0)

|

| [32] |

PETERS N. Interruption timing prediction via prosodic task boundary model for human-machine Teaming[C]//Proceedings of the 2019 Future Information and Communication Conference. San Francisco, USA, 2019: 501−522.

( 0) 0)

|

| [33] |

EHSAN U, TAMBWEKAR P, CHAN L, et al. Automated rationale generation: a technique for explainable AI and its effects on human perceptions[C]//Proceedings of the 24th International Conference on Intelligent User Interfaces. Marina del Ray, USA, 2019: 263−274.

( 0) 0)

|

| [34] |

WINTERSBERGER P, NICKLAS H, MARTLBAUER T, et al. Explainable automation: personalized and adaptive UIs to foster trust and understanding of driving automation systems[C]//12th International Conference on Automotive User Interfaces and Interactive Vehicular Applications. Virtual Event, USA, 2020: 252−261.

( 0) 0)

|

| [35] |

INTEL NEWS. Mobileye and UDELV ink deal for autonomous delivery[EB/OL]. (2021-04-12) [2021-07-01] https://www.intel.com/content/www/us/en/newsroom/news/mobileye-udelv-deal-autonomous-delivery.html#gs.15ib8a

( 0) 0)

|

| [36] |

ISO (International Organization for Standardization). ISO/TR 9241−810: 2020, Ergonomics of human-system interaction–part 810: robotic, intelligent and autonomous systems[S]. BSI Standards Publication, 2020.

( 0) 0)

|

| [37] |

GOOGLE PAIR. People + AI Guidebook: Designing human-centeredAI products [EB/OL]. 2019, [2020-01-01] https://pair.withgoogle.com/ 2019.

( 0) 0)

|

| [38] |

CEREJO J. Design process of human-centered AI — Part2 [EB/OL].2021, [2021-06-01] https://bootcamp.uxdesign.cc/human-centered-ai-design-process-part-2-empathize-hypothesis-6065db967716.

( 0) 0)

|

| [39] |

HOLMQUIST L E. Intelligence on tap: artificial intelligence as a new design material[J]. Interactions, 2017, 24(4): 29-33. ( 0) 0)

|

| [40] |

DE SIO F S, VAN DEN HOVEN J. Meaningful human control over autonomous systems: a philosophical account[J]. Frontiers in robotics and AI, 2018, 5: 15. DOI:10.3389/frobt.2018.00015 ( 0) 0)

|

| [41] |

ENGELBART D C. Augmenting human intellect: a conceptual framework. SRI summary report AFOSR-3223[R]. Washington: Air Force Office of Scientific Research, 1962.

( 0) 0)

|

| [42] |

RAISAMO R, RAKKOLAINEN I, MAJARANTA P, et al. Human augmentation: past, present and future[J]. International journal of human-computer studies, 2019, 131: 131-143. DOI:10.1016/j.ijhcs.2019.05.008 ( 0) 0)

|

| [43] |

STANNEY K M, SCHMORROW D D, JOHNSTON M, et al. Augmented cognition: an overview[J]. Reviews of human factors and ergonomics, 2009, 5(1): 195-224. DOI:10.1518/155723409X448062 ( 0) 0)

|

| [44] |

WU Zhaohui, ZHENG Nenggan, ZHANG Shaowu, et al. Maze learning by a hybrid brain-computer system[J]. Scientific reports, 2016, 6(1): 31746. DOI:10.1038/srep31746 ( 0) 0)

|

| [45] |

王党校, 郑一磊, 李腾, 等. 面向人类智能增强的多模态人机交互[J]. 中国科学: 信息科学, 2018, 48(4): 449-465. WANG Dangxiao, ZHENG Yilei, LI Teng, et al. Multi-modal human-machine interaction for human intelligence augmentation[J]. Science in China informationis, 2018, 48(4): 449-465. (  0) 0)

|

| [46] |

LICKLIDER J C R. Man-computer symbiosis[J]. IRE transactions on human factors in electronics, 1960, HFE-1(1): 4-11. DOI:10.1109/THFE2.1960.4503259 ( 0) 0)

|

| [47] |

吴朝晖, 俞一鹏, 潘纲, 等. 脑机融合系统综述[J]. 生命科学, 2014, 26(6): 645-649. WU Zhaohui, YU Yipeng, PAN Gang, et al. A review of brain- computer fusion systems[J]. Chinese bulletin of life sciences, 2014, 26(6): 645-649. (  0) 0)

|

| [48] |

WU Z, ZHENG N, ZHANG S, et al. Maze learning by a hybrid brain-computer system[J]. Scientific reports, 2016, 6: 1-12. DOI:10.1038/s41598-016-0001-8 ( 0) 0)

|

| [49] |

ZANZOTTO F M. Viewpoint: human-in-the-loop Artificial Intelligence[J]. Journal of artificial intelligence research, 2019, 64: 243-252. DOI:10.1613/jair.1.11345 ( 0) 0)

|

| [50] |

PAN Yunhe. Heading toward artificial intelligence 2.0[J]. Engineering, 2016, 2(4): 409-413. DOI:10.1016/J.ENG.2016.04.018 ( 0) 0)

|

| [51] |

SALVI C, BRICOLO E, KOUNIOS J, et al. Insight solutions are correct more often than analytic solutions[J]. Thinking & reasoning, 2016, 22(4): 443-460. ( 0) 0)

|

| [52] |

郑南宁. 人工智能新时代[J]. 智能科学与技术学报, 2019, 1(1): 1-3. ZHENG Nanning. The new era of AI[J]. Chinese journal of intelligent science and technology, 2019, 1(1): 1-3. DOI:10.11959/j.issn.2096-6652.201914 (  0) 0)

|

| [53] |

赵云波. 人机混合的智能控制[M]//王飞跃, 陈俊龙. 智能控制. 北京: 中国科学技术出版社, 2019.

( 0) 0)

|

| [54] |

SUN R. Potential of full human–machine symbiosis through truly intelligent cognitive systems[J]. AI & society, 2020, 35(1): 17-28. DOI:10.1007/s00146-017-0775-7 ( 0) 0)

|

| [55] |

KITCHIN J, BABER C. A comparison of shared and distributed situation awareness in teams through the use of agent-based modelling[J]. Theoretical issues in ergonomics science, 2016, 17(1): 8-41. DOI:10.1080/1463922X.2015.1106616 ( 0) 0)

|

| [56] |

STANTON N A, SALMON P M, WALKER G H, et al. State-of-science: situation awareness in individuals, teams and systems[J]. Ergonomics, 2017, 60(4): 449-466. DOI:10.1080/00140139.2017.1278796 ( 0) 0)

|

| [57] |

刘烨, 汪亚珉, 卞玉龙, 等. 面向智能时代的人机合作心理模型[J]. 中国科学: 信息科学, 2018, 48(4): 376-389. LIU Ye, WANG Yamin, BIAN Yulong, et al. A psychological model of human-computer cooperation for the era of artificial intelligence[J]. Science in China informationis, 2018, 48(4): 376-389. (  0) 0)

|

| [58] |

FRIDMAN L. Human-centered autonomous vehicle systems: principles of effective shared autonomy [EB/OL]. (2018-10-01) [2021-06-01] https://arxiv.org/pdf/1810.01835.pdf.

( 0) 0)

|

| [59] |

范俊君, 田丰, 杜一, 等. 智能时代人机交互的一些思考[J]. 中国科学: 信息科学, 2018, 48(4): 361-375. FAN Junjun, TIAN Feng, DU Yi, et al. Thoughts on human-computer interaction in the age of artificial intelligence[J]. Science in China informationis, 2018, 48(4): 361-375. (  0) 0)

|

| [60] |

KRAFFT P M, MACY M, PENTLAND A. Bots as virtual confederates: design and ethics[C]//Proceedings of the 2017 ACM Conference on Computer Supported Cooperative Work and Social Computing. Portland, USA, 2017: 183−190.

( 0) 0)

|

| [61] |

CRANDALL J W, OUDAH M, TENNOM, et al. Cooperating with machines[J]. Nature communications, 2018, 9(1): 233. DOI:10.1038/s41467-017-02597-8 ( 0) 0)

|

| [62] |

GUNNING D, STEFIK M, CHOI J, et al. XAI—explainable artificial intelligence[J]. Science robotics, 2019, 4(37): eaay7120. DOI:10.1126/scirobotics.aay7120 ( 0) 0)

|

| [63] |

BOND R R, MULVENNA M, WAN H, et al. Human centered artificial intelligence: weaving UX into algorithmic decision making[C]//International Conference on Human-Computer Interaction. Bucharest, Romania, 2019: 2−9.

( 0) 0)

|

| [64] |

MILLER T, HOWE P, SONENBERG L. Explainable AI: beware of inmates running the asylum. [EB/OL]. (2017-12-01) [2021-06-01] https://arxiv.org/pdf/1712.00547.pdf.

( 0) 0)

|

| [65] |

EHSAN U, WINTERSBERGER P, LIAO Q V, et al. Operationalizing human-centered perspectives in explainable AI[C]//Extended Abstracts of the 2021 CHI Conference on Human Factors in Computing Systems. New York, USA, 2021: 1−6.

( 0) 0)

|

| [66] |

KALUARACHCHI T, REIS A, NANAYAKKARA S. A review of recent deep learning approaches in human-centered machine learning[J]. Sensors, 2021, 21(7): 2514. DOI:10.3390/s21072514 ( 0) 0)

|

| [67] |

ABDUL A, VERMEULEN J, WANG D D, et al. Trends and trajectories for explainable, accountable and intelligible systems: an HCI research agenda[C]//Proceedings of the 2018 CHI Conference on Human Factors in Computing Systems. Montreal, Canada, 2018: 582.

( 0) 0)

|

| [68] |

BRONIATOWSKI D A. Psychological foundations of explainability and interpretability in AI[R]. Gaithersburg: National Institute of Standards and Technology, 2021.

( 0) 0)

|

| [69] |

HOFFMAN R R, KLEIN G, MUELLER S T. Explaining explanation for “explainable AI”[J]. Proceedings of the human factors and ergonomics society annual meeting, 2018, 62(1): 197-201. DOI:10.1177/1541931218621047 ( 0) 0)

|

| [70] |

ENDSLEY M R. From here to autonomy: lessons learned from human-automation research[J]. Human factors: the journal of the human factors and ergonomics society, 2017, 59(1): 5-27. DOI:10.1177/0018720816681350 ( 0) 0)

|

| [71] |

SARTER N B, WOODS D D. How in the world did we ever get into that mode? Mode error and awareness in supervisory control[J]. Human factors: the journal of the human factors and ergonomics society, 1995, 37(1): 5-19. DOI:10.1518/001872095779049516 ( 0) 0)

|

| [72] |

许为. 自动化飞机驾驶舱中人-自动化系统交互作用的心理学研究[J]. 心理科学, 2003, 26(3): 523-524. XU Wei. Psychological studies of human-automation interactions in automated cockpits[J]. Psychological science, 2003, 26(3): 523-524. DOI:10.3969/j.issn.1671-6981.2003.03.040 (  0) 0)

|

| [73] |

BAINBRIDGE L. Ironies of automation[J]. Automatica, 1983, 19(6): 775-779. DOI:10.1016/0005-1098(83)90046-8 ( 0) 0)

|

| [74] |

XU Wei. Status and challenges: human factors in developing modern civil flight decks[J]. Chinese journal of ergonomics, 2004, 10(4): 53-56. ( 0) 0)

|

| [75] |

DE VISSER E J, PAK R, SHAW T H. From ‘automation’ to ‘autonomy’: the importance of trust repair in human–machine interaction[J]. Ergonomics, 2018, 61(10): 1409-1427. DOI:10.1080/00140139.2018.1457725 ( 0) 0)

|

| [76] |

CUMMINGS M L, BRITTON D. Regulating safety-critical autonomous systems: past, present, and future perspectives[M]//PAK R, DE VISSER E J, ROVIRA E. Living with Robots. Amsterdam: Elsevier, 2020: 119−140.

( 0) 0)

|

| [77] |

SAE (Society of Automotive Engineers). J3016_201806, Taxonomy and definitions for terms related to driving automation systems for on-road motor vehicles[S]. SAE, 2018.

( 0) 0)

|

| [78] |

HANCOCK P A. Some pitfalls in the promises of automated and autonomous vehicles[J]. Ergonomics, 2019, 62(4): 479-495. DOI:10.1080/00140139.2018.1498136 ( 0) 0)

|

| [79] |

BIONDI F, ALVAREZ I, JEONG K A. Human-system cooperation in automated driving[J]. International journal of human-computer interaction, 2019, 35(11): 917-918. DOI:10.1080/10447318.2018.1561793 ( 0) 0)

|

| [80] |

许为. 再论以用户为中心的设计: 新挑战和新机遇[J]. 人类工效学, 2017, 23(1): 82-86. XU Wei. User-centered design (II): new challenges and opportunities[J]. Chinese journal of ergonomics, 2017, 23(1): 82-86. (  0) 0)

|

| [81] |

百度. AI–人机交互趋势研究[R]. 百度人工智能交互设计院 (AIID), 2019. Baidu. AI-Human-Computer Interaction Trend Research[R]. Baidu Artificial Intelligence Interaction Design Institute (AIID), 2019. (  0) 0)

|

| [82] |

范向民, 范俊君, 田丰, 等. 人机交互与人工智能: 从交替浮沉到协同共进[J]. 中国科学: 信息科学, 2019, 49(3): 361-368. FAN Xiangmin, FAN Junjun, TIAN Feng, et al. Human-computer interaction and artificial intelligence: from competition to integration[J]. Science in China informationis, 2019, 49(3): 361-368. (  0) 0)

|

| [83] |

葛列众, 许为. 用户体验: 理论和实践[M]. 北京: 中 国人民大学出版社, 2020.

( 0) 0)

|

| [84] |

DONAHOE E. Human centered AI: building trust, democracy and human rights by design[C]//An Overview of Stanford’s Global Digital Policy Incubator and the XPRIZE Foundation’s June 11th Event. Palo Alto, USA, 2018.

( 0) 0)

|

| [85] |

MITTELSTADT B. AI ethics–too principled to fail? [EB/OL]. (2019-01-01) [2021-06-01] https://robotic.legal/wp-content/uploads/2019/05/SSRN-id3391293.pdf.

( 0) 0)

|

| [86] |

BUOLAMWINI J, GEBRU T, GENDER SHADES. Intersectional accuracy disparities in commercial gender classification[C]//Proceedings of the 1st Conference on Fairness, Accountability and Transparency. New York, USA, 2018: 77−91.

( 0) 0)

|

| [87] |

YANG Qian. Machine learning as a UX design material: how can we imagine beyond automation, recommenders, and reminders[C]//Conference on 2018 AAAI Spring Symposium Series: User Experience of Artificial Intelligence. Palo Alto, USA, 2018.

( 0) 0)

|

| [88] |

YANG Q. STEINFELD A. ROSE C. ZIMMERMAN J. Re-examining whether, why, and how human-AI interaction is uniquely difficult to design[C]//Proceedings of the 2020 CHI Conference on Human Factors in Computing Systems. New York, USA, 2020: 1−13.

( 0) 0)

|

| [89] |

BUDIU R, LAUBHEIMER P. Intelligent assistants have poor usability: a user study of Alexa, google assistant, and Siri[R]. Nielsen Norman Group, 2018.

( 0) 0)

|

| [90] |

GIRARDIN F, LATHIA N. When user experience designers partner with data scientists[R]. Palo Alto: AAAI, 2017.

( 0) 0)

|

| [91] |

许为, 葛列众. 人因学发展的新取向[J]. 心理科学进展, 2018, 26(9): 1521-1534. XU Wei, GE Liezhong. New trends in human factors[J]. Advances in psychological science, 2018, 26(9): 1521-1534. DOI:10.3724/SP.J.1042.2018.01521 (  0) 0)

|

2021, Vol. 16

2021, Vol. 16