2. 哈尔滨工程大学 信息与通信工程学院,黑龙江 哈尔滨 150001

2. Department of Information and Communication Engineering, Harbin Engineering University, Harbin 150001, China

近年来,随着人们对航空航天领域开发的重视,卫星、无人机等设备被应用到日常信息获取中来,由它们获取到的遥感图像具有面积大、范围广、信息量大等特点,在工业、农业、军事等领域具有重要的意义[1]。而其中,机载遥感技术以其造价低、灵活性高、平台机动性高等优势成为必备手段之一,被广泛应用到军事无人机侦察、重大自然灾害监测等方面。但是,由于硬件条件的限制,加上距离、气流、运动等外界因素对于采集设备的影响,经常使获取到的机载遥感图像清晰度较差,细节不够丰富,放大时无法识别细节信息[2]。因此,对机载遥感图像进行超分辨率重建处理十分必要。

图像超分辨率(super resolution, SR)重建就是从低分辨率(low resolution, LR)图像中恢复出相应的高分辨率(high resolution, HR)图像的过程[3]。传统的图像SR重建方法,如基于插值的方法、基于重建的方法和基于经典学习的方法等,虽然计算简单易于理解,但是存在以下几个问题:1)重建图像边缘模糊、超分辨能力较差;2)随着放大倍数的增加提高,图像细节信息丢失;3)对训练样本要求较高,需要获取先验知识。近年来,随着深度学习的发展,使得图像超分辨率重建有了新的突破。2014年,Dong等[4]将深度学习的思想引入图像SR重建中来,提出一种基于卷积神经网络的超分辨率重建模型SRCNN,通过学习高、低分辨率图像之间的映射关系,利用卷积层和ReLU激活函数获得学习重建高分辨率图像的能力。2016年,Dong等[5]对之前提出的SRCNN模型进行改进,提出FSRCNN模型,不再需要在网络外部进行放大图片尺寸的操作,同时通过添加收缩层和扩张层,将一个大层用一些小层来代替,实现了速度提升。2016年,Kim等[6]以牺牲收敛速度为代价,通过增加卷积层数来提高重建图像质量,提出了具有20层网络的模型VSDR。但是,由于卷积神经网络在图像细节的恢复上缺乏真实性,在放大倍数较高的时,需要使用很深的网络层数才能有效提取图像的高频细节,而生成对抗网络(GAN)作为深度学习领域的新星,凭借自身强大的图像生成能力,成为图像SR重建领域的佼佼者。2017年,Legid等[7]提出一种基于生成对抗网络的图像超分辨率重建模型SRGAN,利用生成对抗网络自我优化的特性,在图像高频细节纹理恢复上得到了很好的视觉效果,但由于使用JS、KL散度衡量原始生成对抗网络分布间的距离存在缺陷,使得网络训练非常困难。2017年,Arjovsky等[8]提出了沃瑟斯坦式GAN,使用沃瑟斯坦距离代替JS、KL散度来衡量生成分布与真实分布间的距离,有效解决了原始GAN训练不稳定的问题。

因此,基于机载遥感图像对于地物识别和丰富细节的较高要求,针对现有图像SR重建算法存在的问题,本文在SRGAN的基础上提出一种基于改进的生成对抗网络机载遥感图像超分辨率重建方法。在生成器部分采用密集剩余残差块增强整个网络的特征提取能力,将残差网络与密集网络的思想相结合,利用残差缩放和层级之间的直连,将各层提取到的特征信息更好地传递,重建出细节丰富的机载遥感图像;引入WGAN对网络进行优化,解决原始GAN存在的难以训练、生成样本缺乏多样性的问题,并选取以感知损失为主的目标函数优化训练过程,进一步提升图像重建质量。

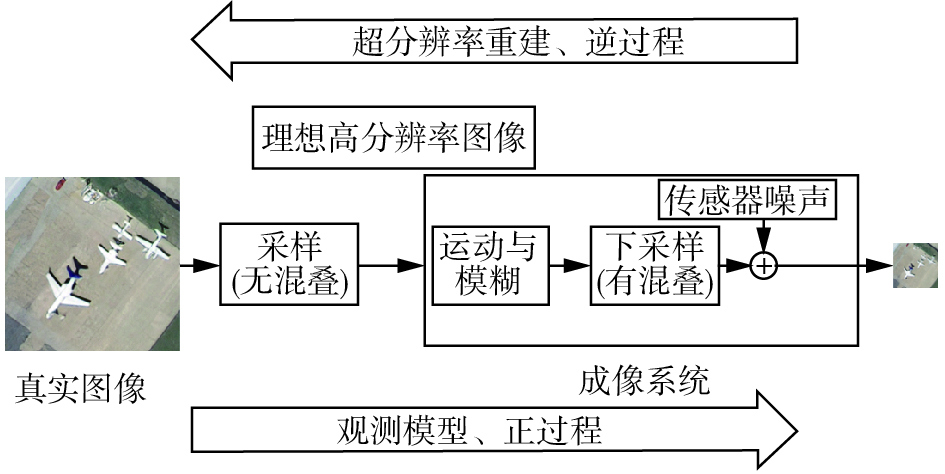

1 相关工作 1.1 超分辨率重建图像超分辨率重建可以从一幅或多幅低分辨率图像中恢复出一幅高分辨率图像,它的原理可以看做是低分辨率图像成像观测模型的逆过程[9]。采集到的真实图像在理想情况下是高分辨率的,但是在经过成像系统时,由于硬件条件的限制(如传感器)和运动等现实情况造成的模糊,使得最终呈现出来的是低分辨率的图像。而图像超分辨率重建恰恰是成像过程的逆过程,如图1所示。

|

Download:

|

| 图 1 成像正过程与超分辨率重建逆过程 Fig. 1 Positive imaging process and inverse process of super-resolution reconstruction | |

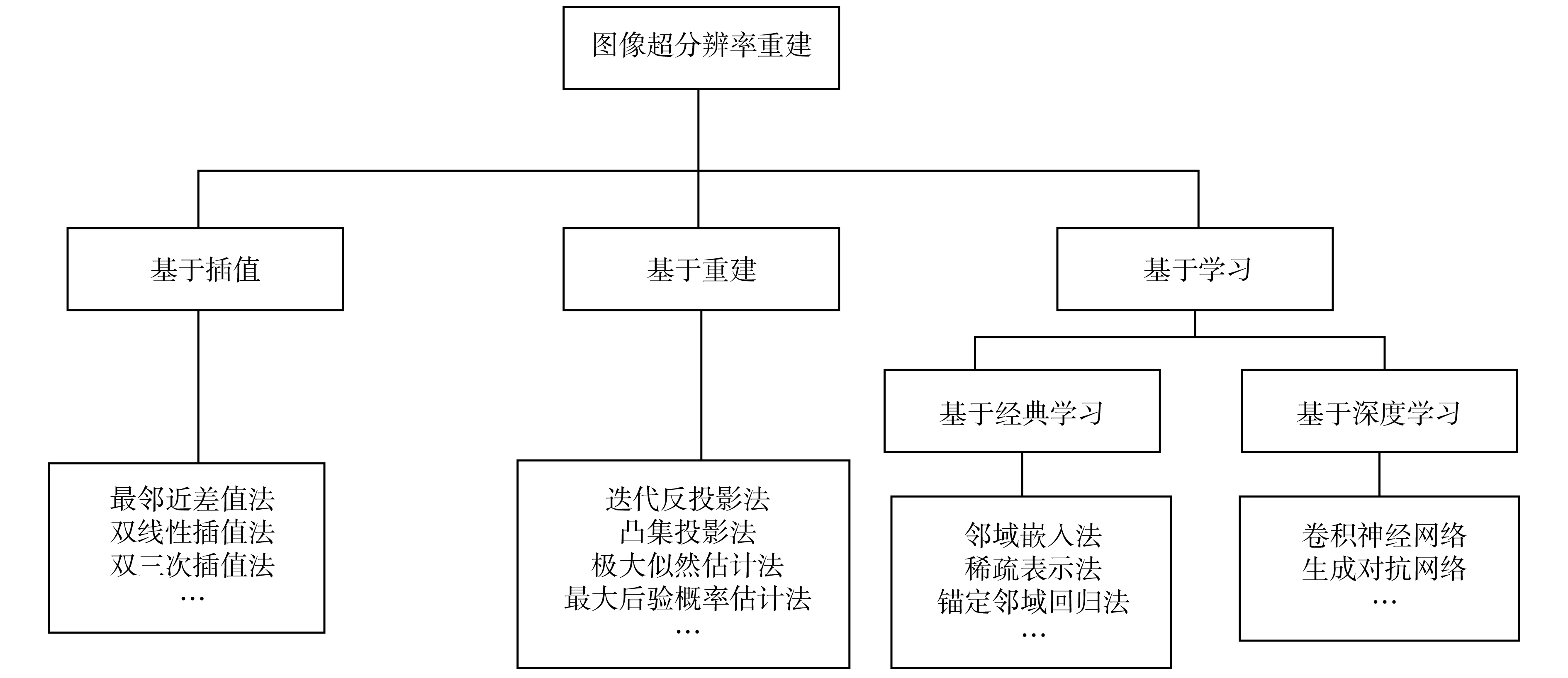

早在1984年,Tsai和Huang等[10]首次将图像超分辨率重建带入人们的视野,随后的几十年间被学者们广泛的研究和应用。图像SR重建的方法分类广泛,根据技术原理的不同大体上可以分为基于插值的方法、基于重建的方法和基于学习的方法[11]。详细的分类如图2所示。在这些方法中,传统的基于插值、重建以及经典学习的方法,虽然计算简单,容易理解和操作,但由于其自身对于图像特征提取的局限性,无法满足机载遥感图像在放大倍数较高时对于图像细节的要求。因此,当深度学习被应用于图像超分辨率重建时,其强大的学习能力使得图像特征能够被保留下来,重建后的图像细节信息更丰富,与传统方法相比重建的效果有了很大的提升。但是,大多数使用卷积神经网络重建出的高分辨率图像其细节往往缺乏真实性,边缘较平滑,图像质量不高。因此,生成对抗网络以其自身具备的图像生成能力使得图像真实细节的重建有了新的突破。

|

Download:

|

| 图 2 图像超分辨率重建方法分类 Fig. 2 Classification of image super-resolution reconstruction methods | |

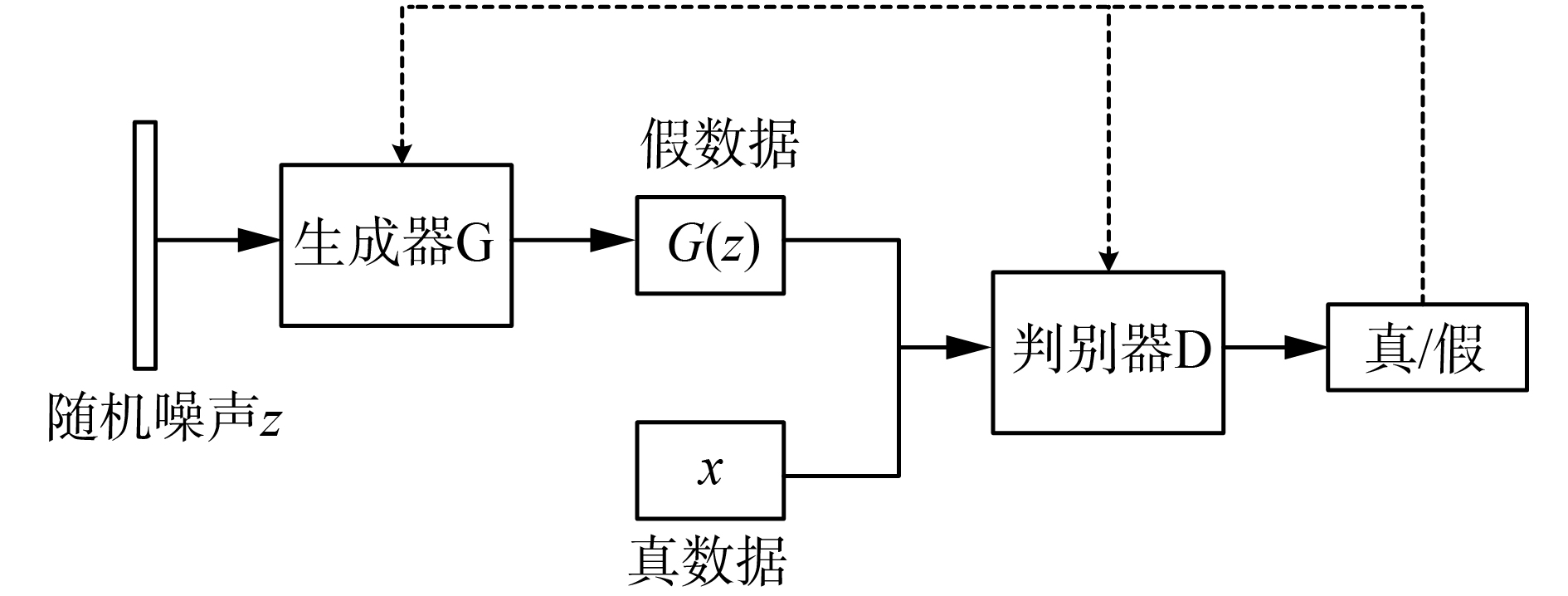

2014年,Goodfellow提出生成式对抗网络(generative adversarial network,GAN)[12]。其核心来源于博弈论中的“纳什均衡”,也就是模拟“二人零和博弈”,即两个人之间是一个无合作的竞争关系,此消彼长,你获益我受损,而且总和守恒为零,所以称之“对抗式”。生成对抗网络顾名思义,就是一种通过对抗的方式,去学习数据分布的生成式模型,分为生成器G和判别器D两个部分,而所谓的对抗,就是指生成器和判别器的互相对抗。生成器尽可能生成逼真样本,判别器则尽可能去判别该样本是真实样本,还是生成的假样本。为了胜过对方,生成器和判别器不断进行对抗和自我优化,各自提高生成能力和判别能力,寻找二者之间的“均衡”,生成式对抗网络的结构如图3所示。

|

Download:

|

| 图 3 生成对抗网络结构 Fig. 3 The structure of the generate adversarial network | |

自提出以来,生成对抗网络就存在着训练困难、生成样本缺乏多样性等问题,许多学者尝试着对其进行改进,但成效甚微。2017年,Arjovsky等[8]提出用沃瑟斯坦(Wasserstein)距离代替原始GAN中生成分布与真实分布之间的KL散度和JS散度,使得在真实分布与生成分布没有重合的情况下,依然能够反映二者的远近,且能够提供有意义的梯度,有效地解决了原始GAN存在的问题。Wasserstein距离可表示为

| $W({P_{r,}}{P_g}) = \mathop {\inf }\limits_{\gamma \sim \prod ({P_{r,}}{P_g})} {E_{(x,y) \sim \gamma }}[\parallel x - y\parallel ]$ |

式中:

| ${L_{({P_{r,}}{P_g})}} = {E_{x \sim {P_r}}}[{f_w}(x)] - {E_{x \sim {P_g}}}[{f_w}(x)]$ |

取最大值得到的

| ${L_{\rm{G}}} = - {E_{x \sim {P_g}}}[{f_w}(x)]$ |

| ${L_{\rm{D}}} = {E_{x \sim {P_g}}}[{f_w}(x)] - {E_{x \sim {P_r}}}[{f_w}(x)]$ |

针对机载遥感图像超分辨率重建过程中存在的问题,本文提出一种基于WGAN的机载遥感图像超分辨率重建模型。模型以生成对抗网络为主体,分别对生成器和判别器做出改进,整体结构如图4所示。整个网络由生成器部分和判别器部分组成:先由生成器网络生成重建的高分辨率图像;再将生成的重建图像与真实图像同时输入判别器网络,由判别器进行判别是真实图像还是重建图像。若判别器能够分辨出重建图像,则证明图像重建质量不佳,此时反馈给生成器继续进行训练;若判别器不能分辨出重建图像与真实图像,则证明生成器已完成训练。

|

Download:

|

| 图 4 网络整体结构 Fig. 4 Overall network structure | |

在生成器部分,先由卷积层提取载遥感图像浅层的特征信息并传递给上采样层;再由特征提取模块进行深层特征的提取和传输;最后经过非线性映射、上采样等操作对图像进行重建。

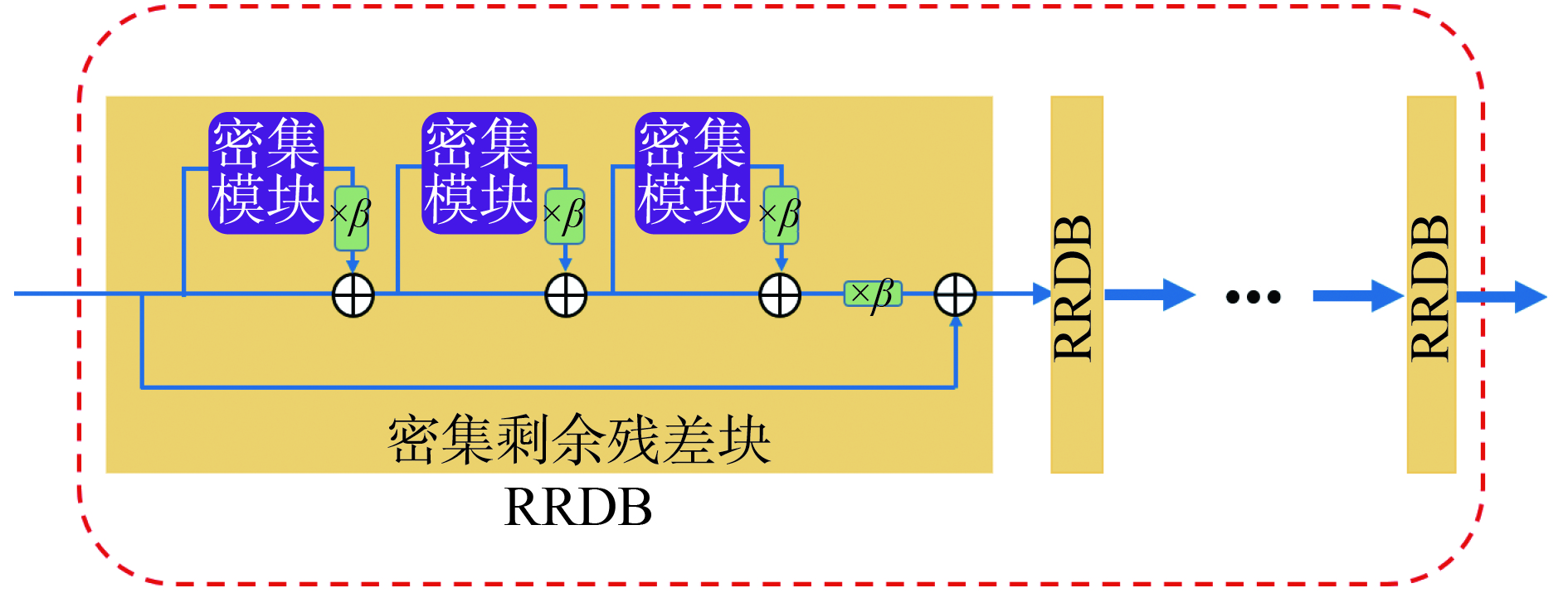

在生成器网络结构的设计上,本文采用密集剩余残差块(residual-in-residual dense block,RRDB)代替SRGAN的特征提取模块,增强模型特征提取能力,通过去除特征提取模块中的批量归一化(batch norm,BN)[13]层减少计算复杂度,并在残差块连接处增加残差缩放来稳定训练过程。

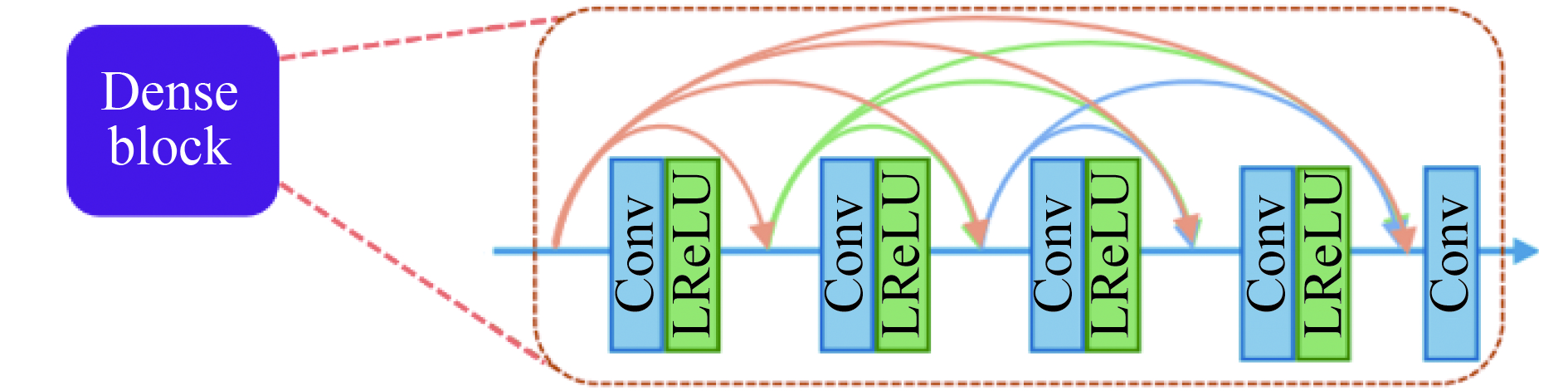

在特征提取模块中,本文采用23个RRDB作为主要组成,每一个RRDB内部都包含3个密集模块(dense block)来代替SRGAN中由两个

|

Download:

|

| 图 5 特征提取模块 Fig. 5 Feature extraction block | |

每个密集模块都由5层卷积网络通过跳跃连接组成,并增加残差缩放将残差乘以0~1之间的常数,然后将它们添加到主传输路径上来保证训练的稳定性,其结构如图6所示。本文采用的缩放因子为0.1。在每个密集块中最后的卷积层紧连着一个恒定的缩放层,当使用大量滤波器时,这些缩放层极大地稳定了训练过程。在密集块中,前4层卷积层后都接有激活函数LeakyReLU[14]层,最后一层只有一个卷积层。通过密集连接的结构用更短跳跃连接的方式有效地保障了各层之间的信息传递,对于每一层来说,它的输入都由之前每一层的特征图组成,并将自己的所有特征图作为下一层的输出。

|

Download:

|

| 图 6 密集模块 Fig. 6 Dense block | |

批量归一化在卷积神经网络中具有重要作用,不仅可以加速网络收敛速度,易于训练深层网络,还可以防止网络过拟合。但是,2017年,Lim等[15]通过实验证明,在图像SR重建领域中,网络结构中加入批量归一化层并不能得到良好的结果,反而会使得训练速度缓慢且不稳定,甚至最后发散。因此,为了训练稳定性和一致性,在设计生成器网络结构时,本文方法去除了传统密集块和残差网络中的批量归一化层,在RRDB中直接将卷积层与激活函数LeakyReLU相连,提高模型泛化能力,减少计算复杂度和内存使用。

2.1.2 判别器网络的设计在判别器部分,生成器的输出即重建出的机载遥感图像,和真实图像同时作为判别器的输入,进入判别器网络,通过判别模块对图像进行判别,最终通过两个密集层预测输入的为真实图像还是重建图像,再反馈给生成器。

在判别器网络结构的设计上,为了解决原始GAN训练困难、生成样本缺乏多样性的问题,本文采用WGAN对判别器进行优化,并去除SRGAN判别器最末层的Sigmoid层。判别网络包含8个卷积层,使用LeakyRelu作为激活函数,随着网络层数加深,特征个数从64增加到512,特征尺寸不断减小。

2.2 损失函数与超参数设置为了实现对于机载遥感图像的清晰重建,根据本文提出的网络结构,选取在生成对抗网络上常用的感知损失作为代价函数对生成器损失进行优化。在生成对抗网络中,感知损失(perceptual loss)是由内容损失和对抗损失共同决定的,其形式为

| ${L_{{\rm{percep}}}} = {L_{{\rm{content}}}} + {10^{ - 3}}{L_{{\rm{Gen}}}}$ |

式中:

| $\begin{array}{l} {L_{{\rm{content}}}} = {L_{{\rm{VGG}}/i,j}} = \dfrac{1}{{{W_{i,j}}{H_{i,j}}}}\displaystyle\sum\limits_{x = 1}^{{W_{i,j}}} {\displaystyle\sum\limits_{y = 1}^{{H_{i,j}}} {({\phi _{i,j}}{{({I^{HR}})}_{x,y}}} } -\\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\; {\phi _{i,j}}{({G_{{\theta _G}}}({I^{HR}}))_{x,y}}{)^2} \end{array}$ |

式中:

由于WGAN的加入,对抗损失作为生成器损失的重要组成,可以表示为

| ${L_{{\rm{Gen}}}} = - {E_{x \sim {P_g}}}[{f_w}(x)]$ |

对应的判别器损失为

| ${L_{\rm{D}}} = {E_{x \sim {P_g}}}[{f_w}(x)] - {E_{x \sim {P_r}}}[{f_w}(x)]$ |

为了更好地训练模型,最终取得更好的重建效果,本文设置的具体实验超参数为:生成器和判别器的学习率均为0.000 1,迭代次数为40万次,在5万次后学习率衰减,batchsize为16,优化算法选择RMSProp。

2.3 评价指标的选取本文选择在图像超分辨率重建上最常用的峰值信噪比(PSNR)来对重建图像进行对比和评价。PSNR的本质是计算原始图像与重建图像像素点之间的误差,从而衡量二者之间的相似情况。其计算方法为

| ${\rm{PSNR}} = 10 \times \lg \Bigg[\frac{{{{({2^n} - 1)}^2}}}{{{\rm{MSE}}}}\Bigg]$ |

式中:

| ${\rm{MSE}} = \frac{{\displaystyle\sum\limits_{i = 1}^M {\displaystyle\sum\limits_{j = 1}^N {({I_{ij}} - I_{ij}')} } }}{{M \times N}}$ |

式中:

为了验证本文方法的有效性和先进性,选择机载遥感图像开放数据集NWPU-RESISC45[16]和UCMerced_LandUse[17]进行实验。NWPU-RESISC45机载遥感图像数据集,包含45个不同场景下的机载遥感图像,包括飞机、港口、湖泊、高速公路、商业区等场景,每类图像有700张,共31 500张图像,图像大小为256×256,随机选择每类56张图像共2 520张图像组成训练集,1 500张组成测试集。UCMerced_LandUse遥感数据集是从USGS国家地图“市区图像”集合中的大图像中提取的,涵盖了21类土地资源遥感图像,每类100张,共2 100张,我们将这2 100张图像作为另一组测试集用于实验的验证。本文采用的实验环境设置如表1所示。

| 表 1 实验环境配置 Tab.1 Experimental environment configuration |

在实验中,用NWPU-RESISC45数据集中的2 520张图像进行训练,并对1 500张图像进行测试。为验证本文方法的先进性,选择具有权威性的图像超分辨率重建领域的经典方法和计算机视觉领域顶级会议ECCV、CVPR上所发表的方法,从数值评价指标和视觉效果两方面与本文方法进行对比。对NWPU-RESISC45测试集中所有的测试图像的PSNR值求均值,可以得到如表2的结果。从表2可以看出,相比于其他方法,本文方法在NWPU-RESISC45测试集上取得了最高的平均PSNR值,较传统Bicubic方法有2.59 dB增益,较FSRCNN方法有2.42 dB增益,较ESPCN方法有2.24 dB增益,较SRGAN方法有1.99 dB增益。验证了本文方法在评价指标上的先进性。

| 表 2 NWPU-RESISC45测试集的PSNR对比 Tab.2 PSNR comparison of NWPU-RESISC45 test set |

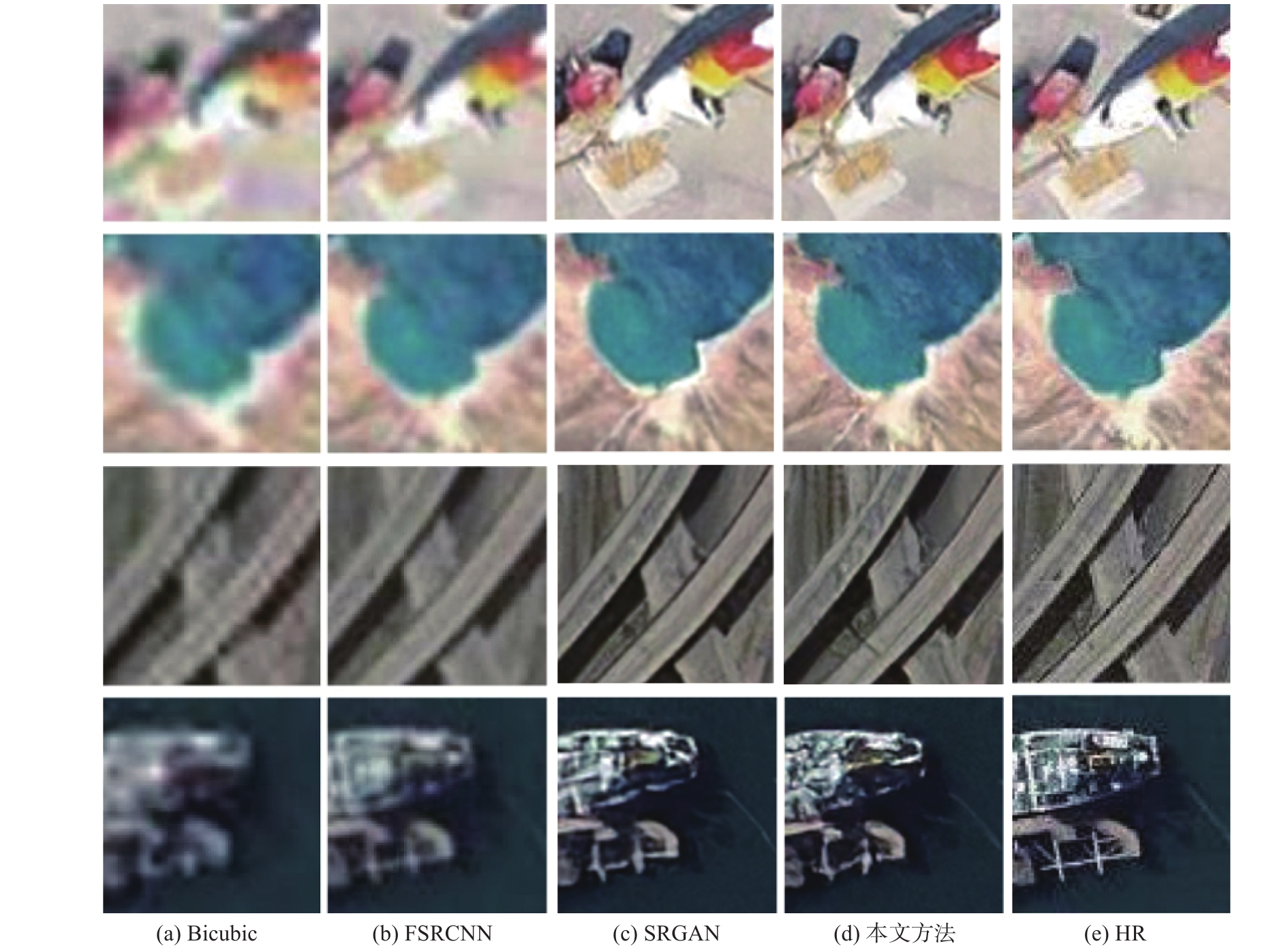

对机载遥感图像重建的视觉效果进行对比分析,对比结果如图7所示。图中(a)~(d)分别对应数据集中的airplane_039、lake_690、overpass_405和ship_010这4张机载遥感图像。每一张图像从左至右分别为使用双三次插值(Bicubic)、FSRCNN、SRGAN和本文方法进行超分辨率重建后的机载遥感图像,以及原始高分辨率图像。

|

Download:

|

| 图 7 NWPU-RESISC45的重建效果对比 Fig. 7 Comparison of reconstruction effect of test set NWPU-RESISC45 | |

从图中可以看出,本文方法能够有效对机载遥感图像进行超分辨率重建,并对原始高清机载遥感图像的地物及细节进行了有效恢复。如第1幅图中,本文方法对于飞机机身红色线条、机场地面线条和机尾等细节部分的重建效果明显优于对比方法;第2幅图中,本文方法对于湖泊边缘和土地的自然纹理的重建也要优于对比方法。为了更加清晰直观地对比各个方法的重建效果,将图7中每个图像中红色方框区域放大,进行对比,如图8所示。由图8的局部放大效果对比图可以看出,本文提出的方法在对于细节的重建上明显优于对比方法,图像的整体质量更高。

|

Download:

|

| 图 8 局部放大效果对比 Fig. 8 Comparison of local magnification | |

可以看出,本文方法能够有效对机载遥感图像进行4倍的重建,相较于其他方法,有更高的PSNR值和更好的重建效果,特别是能够重建出更真实清晰的纹理细节,验证了本文方法的有效性和先进性。为了验证本文提出的机载遥感图像超分辨率重建模型的泛化能力,增加了对数据集UCMerced_LandUse的测试。将训练好的模型在数据集UCMerced_LandUse的2 100张图像上进行测试,并与其他经典方法进行对比,PSNR对比如表3,重建效果和局部放大对比如图9。

| 表 3 UCMerced_LandUse测试集的PSNR对比 Tab.3 PSNR comparison of UCMerced_LandUse test set |

|

Download:

|

| 图 9 测试集UCMerced_LandUse的重建效果对比 Fig. 9 Comparison of reconstruction effect of test set UCMerced_LandUse | |

从表3中可以看出,相比于其他方法,本文方法在UCMerced_LandUse测试集上取得了最高的平均PSNR值,较传统Bicubic方法有1.68 dB增益,较FSRCNN方法有0.4 dB增益,较VDSR方法有0.22 dB增益,较SRGAN方法有0.97 dB增益。验证了本文方法在评价指标上的先进性。从图9中可以看出,本文方法能够有效对数据集UCMerced_LandUse中的机载遥感图像进行4倍重建,且能够保证图像细节纹理的恢复,如草坪上的纹理、道路行车线、电缆阴影以及飞机场上的转弯痕迹等,重建出的图像纹理细节更加真实,边缘更加锐利,整体效果更好。通过对比,充分证明本文方法能够有效对机载遥感图像进行图像特征提取,并恢复出更清晰的细节纹理,且该模型具有对不同机载遥感图像重建的泛化能力。

为了验证WGAN对于训练过程的优化效果,将训练过程中原始GAN网络和使用WGAN后网络的判别器损失函数变化曲线进行对比。选取迭代100次得到的结果进行对比分析,判别器损失函数变化曲线如图10所示,图(a)为原始GAN的判别器损失函数变化曲线,图(b)为WGAN的判别器损失函数变化曲线。通过对比可以看出,原始GAN在迭代55次时趋于平稳,而使用WGAN后迭代30次时趋于平稳。随着迭代次数的增加,使用WGAN的判别器损失函数曲线下降的比原始GAN的更快,而且波动较小,训练进程更加稳定。这充分说明了WGAN对于模型训练的优化作用,提升了整个模型的训练稳定性,同时加快了收敛速度。

|

Download:

|

| 图 10 判别器损失函数变化曲线对比 Fig. 10 Comparison of discriminant loss function curves | |

本文提出的机载遥感图像超分辨率重建模型将生成对抗网络应用到机载遥感图像中,将RRDB作为特征提取模块,使生成器网络有更深层的网络结构和更密集的连接,既可以防止选用较深网络训练时出现退化问题,又可以保证图像的浅层信息和深层信息都能够得到有效的传递,最终重建出细节更丰富、图像更清晰的机载遥感图像的;采用带有感知损失的沃瑟斯坦式生成对抗网络优化判别器,克服了生成对抗网络难以训练的缺点,最终有效对机载遥感图像进行4倍重建。相较于其他方法,本文方法重建出的机载遥感图像具有更真实的细节、更锐利的边缘和更好的重建效果,并通过对比实验,验证了本文方法的有效性、先进性和模型泛化能力。同时,在研究过程中发现,对于不同类别的机载遥感图像重建的效果存在差异,如何有针对性的对不同类别的机载遥感图像进行超分辨率重建是未来研究的主要方向。

| [1] |

赵英时. 遥感应用分析原理与方法[M]. 北京: 科学出版社, 2013.

( 0) 0)

|

| [2] |

罗小波. 遥感图像智能分类及其应用[M]. 北京: 电子工业出版社, 2011.

( 0) 0)

|

| [3] |

石爱业, 徐枫, 徐梦溪. 图像超分辨率重建方法及应用[M]. 北京: 科学出版社, 2016.

( 0) 0)

|

| [4] |

DONG Chao, LOY C C, HE Kaiming, et al. Learning a deep convolutional network for image super-resolution[M]. FLEET D, PAJDLA T, SCHIELE B, et al. Computer Vision- ECCV 2014. Cham: Springer, 2014: 184−199.

( 0) 0)

|

| [5] |

DONG Chao, LOY C C, TANG Xiaoou. Accelerating the super-resolution convolutional neural network[M]. LEIBE B, MATAS J, SEBE N, et al. Computer Vision- ECCV 2016. Cham: Springer, 2016: 391−407.

( 0) 0)

|

| [6] |

KIM J, LEE J K, LEE K M. Accurate image super-resolution using very deep convolutional networks[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA, 2016: 1646−1654.

( 0) 0)

|

| [7] |

LEDIG C, THEIS L, HUSZÁR F, et al. Photo-realistic single image super-resolution using a generative adversarial network[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA, 2017: 105−114.

( 0) 0)

|

| [8] |

ARJOVSKY M, CHINTALA S, BOTTOU L. Wasserstein GAN[J/OL]. (2017-01-26). https://arxiv.org/abs/1701.07875.

( 0) 0)

|

| [9] |

石爱业, 徐枫, 徐梦溪. 图像超分辨率重建方法及应用[M]. 北京: 科学出版社, 2016.

( 0) 0)

|

| [10] |

TSAI R Y, HUANG T S. Multiframe image restoration and registration. Advances in Computer Vision and Image Pro-cessing: JAI Press Inc., 1984, 317−339.

( 0) 0)

|

| [11] |

高春波. 生成对抗网络的图像超分辨率重建[D]. 杭州: 浙江理工大学, 2019. GAO Chunbo. Image super-resolution using a generative adversarial network[D]. Hangzhou: Zhejiang Sci-Tech University, 2019. (  0) 0)

|

| [12] |

GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal, Canada, 2014: 2672−2680.

( 0) 0)

|

| [13] |

IOFFE S, SZEGEDY C. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]//Proceedings of the 32nd International Conference on Machine Learning. Lille, France, 2015: 448−456.

( 0) 0)

|

| [14] |

MASS A L, HANNUN A Y, NG A Y. Rectifier nonlinearities improve neural network acoustic models[C]//Proceedings of the 30th International Conference on Machine Learning. Atlanta, GA, USA, 2013.

( 0) 0)

|

| [15] |

LIM B, SON S, KIM H, et al. Enhanced deep residual networks for single image super-resolution[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Honolulu, HI, USA, 2017: 1132−1140.

( 0) 0)

|

| [16] |

CHENG Gong, HAN Junwei, LU Xiaoqiang. Remote sensing image scene classification: benchmark and state of the art[J]. Proceedings of the IEEE, 2017, 105(10): 1865-1883. DOI:10.1109/JPROC.2017.2675998 ( 0) 0)

|

| [17] |

YANG Yi, NEWSAM S. Bag-of-visual-words and spatial extensions for land-use classification[C]//Proceedings of the 18th ACM SIGSPATIAL International Conference on Advances in Geographic Information Systems. New York, USA, 2010: 270−279.

( 0) 0)

|

2020, Vol. 15

2020, Vol. 15