2. 西安邮电大学 通信与信息工程学院,陕西 西安 710121;

3. 西安邮电大学 电子工程学院,陕西 西安 710121

2. School of Communication and Information Engineering, Xi’an University of Post and Telecommunications, Xi’an 710121, China;

3. School of Electronic Engineering, Xi’an University of Post and Telecommunications, Xi’an 710121, China

由于相机抖动、环境干扰或者物体运动等诸多因素的影响,都会导致生成的图像产生运动模糊[1]。在刑侦、医疗、军事等图像应用领域,需要高质量的图像,而图像的获取却不容易,因此对目标图像复原,是计算机视觉研究领域中一个重要的研究方向[2]。

图像复原的目的是去除模糊和干扰,得到尽可能接近理想图像的复原图像。传统的图像复原方法假设退化模型已知或者可以通过简单的计算得到点扩散函数,利用已知信息有针对性地进行复原。但是在现实生活中,图像退化过程受到各种因素的影响,造成图像退化的结果也不尽相同,因此点扩散函数无法精确得到,所以传统的图像复原方法不能很好地解决图像复原问题。

近几年,计算机视觉领域广泛应用深度学习的方法,并且取得了惊人的成果。Zhou等[3]首次将神经网络用于图像复原,提出了基于离散Hopfield神经网络的图像复原模型;Jain等[4]将卷积神经网络用于图像去噪,证明了卷积神经网络可以直接学习从低质量图像到清晰图像的端到端的非线性映射,能够较好地复原图像;Huang等[5]提出了密集网络(DenseNet)模型,DenseNet能够以连接模式连接密集单元中的任意2个卷积层,实现了特征重用及信息传递,为图像复原提供了新的思路;Zhang等[6]首次将残差学习和批处理归一化引入图像复原,提出去噪卷积神经网络(DnCNN),该网络可训练单一的网络模型进行盲去噪,比针对特定噪声水平训练的方法有更好的性能。Liu等[7]提出非局部循环神经网络(NLRN),利用图像的自我相似度,通过捕捉一个特征与其邻近特征的相关性进行图像重建,有较好的图像复原能力。Guo等[8]使用卷积网络,其包括噪声估计子网络和非盲去噪子网络,并提出非对称学习损失函数,实现真实图像的盲去噪。Cha等[9]提出全卷积自适应图像去噪网络,使用正则化方法获得更鲁棒的自适应性。2014年,Goodfellow等[10]受到博弈论的启发提出生成对抗网络(generative adversarial network, GAN),GAN网络模型由生成网络和判别网络组成,在生成图像方面具有显著的优势。Kupyn等[11]提出了利用生成对抗网络消除运动模糊的方法DeblurGAN,该方法可以有效地消除单张运动模糊。Wang等[12]使用残差生成对抗网络复原退化图片,提高了网络的稳定性和效率。Zhou等[13]提出标签去噪对抗网络(LDAN)用于逆光照明人脸图像,通过生成对抗网络生成的图像来训练深度卷积网络,提高了图像复原效果。这些方法都有效地改善了图像复原效果,但是在复杂的现实环境中使用有一定的局限性。

本文提出一种针对运动模糊的网络模型,以生成对抗网络为框架,生成网络使用残差网络和密集网络结合的残差密集网络(residual dense network, RDN)[14],将模糊图像输入到生成网络中,输出复原图像;判别网络使用深度卷积网络,判断输入图像是否真实。使用内容损失和对抗损失共同优化网络。在公开的GoPro数据集和Celeba数据集上实验,并与其他复原算法对比分析,验证残差密集网络在图像复原中的优势。

1 相关网络 1.1 生成对抗网络生成对抗网络首次提出来后,就获得了广泛的关注,其强大的图像生成能力,使其在图像合成、图像修补、超分辨率、图像复原等方面得到广泛应用。生成对抗网络是深度学习中一种无监督学习网络模型,网络分成生成器(generator, G)和判别器(discriminator, D),生成器模拟真实数据分布情况,以产生相似的样本数据为目的;判别器判断样本是否来自真实数据集。生成对抗网络模型如图1所示。

|

Download:

|

| 图 1 生成对抗网络模型 Fig. 1 GAN model | |

在训练过程中,生成网络

残差密集网络结合残差网络与密集网络,将网络模型中不同单元提取的浅层特征与深度特征融合,在图像复原中取得了很好的效果。

RDN包括浅层特征提取、残差密集单元(residual dense block, RDB)、全局特征融合3部分。首先,对原始图像进行卷积操作提取浅层特征,将浅层特征作为残差密集单元的输入;残差密集单元包含密集连接和局部特征融合,其输出与下一个单元内的各个卷积层直接相关,实现了单元之间的信息连续传递;随后,全局特征融合实现了浅层特征和各个单元提取的不同分层特征之间的全局特征融合,局部特征融合及全局特征融合均以短连接的方式实现,最终的融合特征用于图像重建。由于图像复原中大量的信息复用,充分利用不同单元提取的分层特征,将浅层特征与深层特征结合能够提供丰富的图像细节信息,有利于图像复原。

2 网络模型使用的网络模型包括2个部分:生成网络和判别网络。生成网络是一个RDN网络,判别网络是深度卷积网络。网络模型如图2所示。

|

Download:

|

| 图 2 RDN-GAN网络结构 Fig. 2 Network structure of RDN-GAN | |

生成网络的目的是生成复原图像。生成网络是一个由残差网络和密集网络结合而成的残差密集网络,残差网络能够有效缓解随着网络深度增加引发的梯度消失的现象,这样即使增加网络深度,还能够保持很好的性能和效率;密集网络通过特征复用,能够加强特征传播,减少参数量。由于在进行图像复原的过程中,模糊图像和清晰图像之间的相似度很高,即两者之间会有很多共享的信息,残差网络能够有效地学习两幅图像之间的映射关系,并且结合密集网络结构使得网络更加稳定。

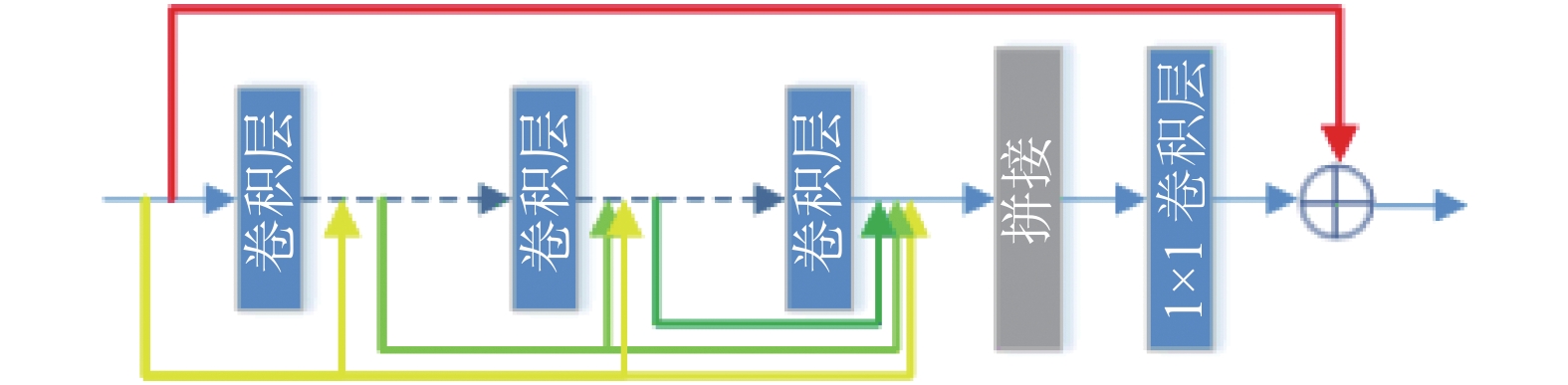

残差网络和密集网络结合形成的RDB作为主要网络单元,RDB结构如图3所示。RDB首先经过一个6层的全卷积网络,根据密集连接机制,每一层的输入都会拼接前面所有层作为额外的输入。由于累计拼接会导致特征层数量过多,所以设置一个1×1的卷积层,用于多通道的特征融合,并起到降维的作用。在最后将输入与输出进行特征融合作为新的输出。在RDB中,输入图像信息的维度不会改变,这样可以避免通过反卷积来进行上采样所造成的棋盘效应(checkerboard artifacts)[15]。

|

Download:

|

| 图 3 RDB结构 Fig. 3 Structure of RDB | |

输入图像首先经过2个卷积层,进行浅层特征提取,得到64个特征图(feature map);接着排列着3个RDB,RDB的输出会通过拼接方式结合,并使用1×1卷积层进行特征融合;然后通过一个卷积层,并与第一次卷积结果相加;最后通过卷积完成密集特征融合,并把特征图转换成输入图像维度,且与输入图像相加,通过tanh激活函数作为最后的输出。生成网络中的所有卷积层,卷积核的大小设置为3×3,步长设置为1,通过填充输入图像边界(Padding)的方式,保持图像的分辨率不变。除了最后一层卷积层之外,每个卷积层之后都跟随一个带泄漏修正线性单元(leaky rectified linear units,LReLU)激活函数。

2.2 判别网络判别网络用于估计输入的图片是来自于训练样本还是生成样本的概率,如果输入来自真实的训练样本,则输出概率越高,如果输入是生成样本,则输出概率越低。判别网络是一个全卷积网络,遵循Radford等[16]的设计样式,判别网络参数设置如表1所示。

| 表 1 判别器网络参数 Tab.1 Parameters of discriminator |

判别网络中全部使用卷积核大小为3×3的卷积层,并且在卷积层后面跟随一个LReLU激活函数。接着经过一个1024的全连接层(fully connected layer,FC),最后通过一维的全连接层,并通过Sigmoid输出判决结果。

3 损失函数损失函数由内容损失函数和对抗损失函数组成,共同优化网络模型,即

| $L = {\lambda _{\rm{1}}}{L_a} + {\lambda _{\rm{2}}}{L_C}$ | (1) |

式中:

内容损失函数通过对比生成图像和真实图像的每个像素值,保证最后的生成图像能够接近理想值。内容损失函数一般使用

| ${L_1} = {\left\| {G({z_i}) - {x_i}} \right\|_1}$ | (2) |

式中:

由于像素间的误差影响,内容损失函数将在所有解的平均值处收敛[18],这会导致复原图像过于平滑,丢失锐利的边缘信息,而模糊依然存在。因此把内容损失函数和对抗损失函数结合起来共同作为损失函数。

假设用于训练的真实图像数据是

| $V(D,G) = {E_{x \sim {p_{\rm{data}}}(x)}}[\ln D(x)]{\kern 1pt} + {E_{z \sim {p_z}(z)}}[\ln (1 - D(G(z)))]$ | (3) |

式中:

| $\mathop {\min }\limits_{\rm{G}} V(D,G) = {E_{z \sim {p_z}(z)}}[\ln (1 - D(G(z)))]$ | (4) |

| $\mathop {\max }\limits_{\rm{D}} V(D,G) = {E_{x \sim {p_{\rm{data}}}(x)}}[\ln D(x)] + {E_{z \sim {p_z}(z)}}[\ln (1 - D(G(z)))]$ | (5) |

由判别器

| $\begin{array}{r} {L_a} = \mathop {\min }\limits_{\rm{G}} \mathop {\max }\limits_{\rm{D}} V(D,G) = {E_{x \sim {p_{\rm{data}}}(x)}}[\ln D(x)]{\kern 1pt} + \\ {E_{z \sim {p_z}(z)}}[\ln (1 - D(G(z)))] \quad\quad\quad\quad\quad\end{array} $ | (6) |

实验使用的数据集包括两部分:一个是Nah等[19]公开的GoPro数据集,另一个是在Celeba[20]部分数据集上添加运动模糊。GoPro数据集包含了使用相机拍摄合成的不同街道视角的模糊图像,整个数据集一共有3214对模糊清晰图像对,其中训练集有2103对图像,测试集有1111对图像。Celeba数据集包括200000张左右的人脸图像,通过拉普拉斯算子筛选清晰图像2500张,通过仿真程序给图像添加9像素的运动模糊,结合清晰图像,制作训练集2 000对图像,测试集500张图像。所有的图像都重新设置大小为

实验中使用批处理大小为1,设置对抗损失权重

实验中设置迭代周期为100个,每个周期迭代一遍训练集图像,每一次交替训练判别器和生成器。

4.3 评价指标为了客观评价复原图像效果,实验使用峰值信噪比(peak signal-to-noise ratio,PSNR)[21]和结构相似性(structural similarity,SSIM)[22]作为评价指标。

PSNR基于对应像素点间的误差来评价图像质量,PSNR的值越高表示图像失真越小,PSNR定义为

| ${\rm{PSNR}} = 20{\rm{lg}}\left(\frac{{{2^n} - 1}}{{\sqrt M }}\right)$ | (7) |

式中:

SSIM以每个像素为中心的小块为单位,同时对比图像块的亮度、对比度和结构,SSIM的值越接近1,表示两图像越接近,SSIM定义为

| ${\rm{SSIM}} = \frac{{(2{\mu _x}{\mu _y} + {C_1})(2{\sigma _{xy}} + {C_2})}}{{(\mu _x^2 + \mu _y^2 + {C_1})(\sigma _x^2 + \sigma _y^2 + {C_2})}}$ | (8) |

式中:

实验使用CPU为Intel i5,内存8 GB,GPU为NVIDA GeForce GTX 980 Ti,同时使用TensorFlow深度学习框架,Python编程语言。本文算法在GoPro数据集上训练30 h,在Celeba数据集上训练24 h。

为了验证本文算法对图像运动模糊的复原效果,选取具有代表性的方法DnCNN模型[6]、DeblurGAN模型[8]和SRNDeblur模型[23],与本文方法进行比较。为了公正地对比各种算法,均使用相同的实验环境和相同的数据集进行训练。

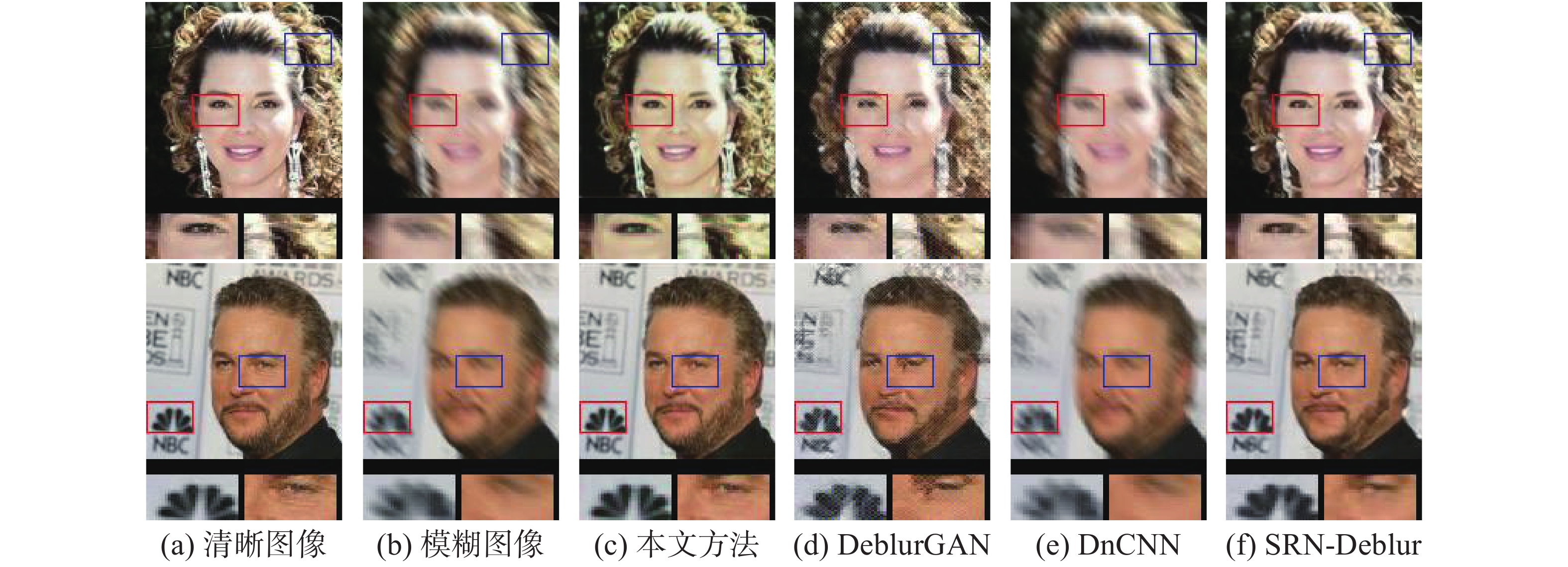

实验结果如图4、5所示,图4为在Celeba数据集上的复原结果,图5为GoPro数据集的复原结果。基于本文方法的复原结果在主观视觉效果中均得到了较好的结果,如在图4中贝壳放大后的纹理,以及路面上的细节都很好地复原了原图信息;而DeblurGAN和SRN-Deblur虽然整体看起来比较清晰,但是放大后可以看出一些细节丢失;DnCNN的复原结果不是很好,有严重的振铃现象。

表2是两组实验的图像质量评价结果,平均耗时为处理测试集中单张图片的平均花费时间。从表2中可以看出,在两个数据集中,本文方法的PSNR和SSIM两种量化指标都要优于其他两种方法。在平均耗时方面,DeblurGAN算法和DnCNN算法的执行速度最快,单张图片耗时最少;SRN-Deblur算法的执行速度最慢,单张图片耗时在30 s左右;本文方法有较快的执行速度,单张图片耗时在1 s左右。

|

Download:

|

| 图 4 Celeba数据集实验结果 Fig. 4 Results of the Celeba dataset | |

|

Download:

|

| 图 5 GoPro数据集实验结果 Fig. 5 Results of the GoPro dataset | |

| 表 2 结果对比 Tab.2 Comparison of the results |

针对相机成像时抖动、环境干扰、物体运动等原因产生的图像运动模糊问题,本文提出了一种利用残差密集网络的端到端图像盲复原方法,残差密集网络结合残差网络和密集网络的优点,通过长短连接的方式提取并融合不同层次的特征,由于图像生成过程中大量信息的复用,提高了图像复原的效果,并使用对抗训练的方式提高网络性能;采用对抗损失和内容损失结合的损失函数优化网络。在GoPro数据集和Celeba数据集上进行实验,通过分析对比,本文方法能够得到较好的复原效果。未来将优化算法,提高网络的训练效率;分析其他退化图像,改进网络模型,使其适用于多种退化图像。

| [1] |

程俊廷, 左旺孟. 快速非均匀模糊图像的盲复原模型[J]. 黑龙江科技大学学报, 2017, 27(2): 196-199. CHENG Junting, ZUO Wangmeng. Fast blind deblurring models for restoration of non-uniform blur images[J]. Journal of Heilongjiang University of Science and Technology, 2017, 27(2): 196-199. DOI:10.3969/j.issn.2095-7262.2017.02.021 (  0) 0)

|

| [2] |

BANHAM M R, KATSAGGELOS A K. Digital image restoration[J]. IEEE signal processing magazine, 1997, 14(2): 24-41. DOI:10.1109/79.581363 ( 0) 0)

|

| [3] |

ZHOU Y T, CHELLAPPA R, VAID A, et al. Image restoration using a neural network[J]. IEEE transactions on acoustics, speech, and signal processing, 1988, 36(7): 1141-1151. DOI:10.1109/29.1641 ( 0) 0)

|

| [4] |

JAIN V, SEUNG S. Natural image denoising with convolutional networks[C]//Advances in Neural Information Processing Systems. Vancouver, Canada, 2009: 769−776.

( 0) 0)

|

| [5] |

HUANG Gao, LIU Zhuang, VAN DER MAATEN L, et al. Densely connected convolutional networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 2261−2269.

( 0) 0)

|

| [6] |

ZHANG Kai, ZUO Wangmeng, CHEN Yunjin, et al. Beyond a Gaussian denoiser: residual learning of deep CNN for image denoising[J]. IEEE transactions on image processing, 2017, 26(7): 3142-3155. DOI:10.1109/TIP.2017.2662206 ( 0) 0)

|

| [7] |

LIU Ding, WEN Bihan, FAN Yuchen, et al. Non-local recurrent network for image restoration[C]//32nd Conference on Neural Information Processing Systems. Montréal, Canada, 2018: 1673−1682.

( 0) 0)

|

| [8] |

GUO Shi, YAN Zifei, ZHANG Kai, et al. Toward convolutional blind denoising of real photographs[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, USA, 2019: 1712−1722.

( 0) 0)

|

| [9] |

CHA S, MOON T. Fully convolutional pixel adaptive image denoiser[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Seoul, Korea (South), 2019: 4159−4168.

( 0) 0)

|

| [10] |

GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal, Canada, 2014: 2672−2680.

( 0) 0)

|

| [11] |

KUPYN O, BUDZAN V, MYKHAILYCH M, et al. DeblurGAN: blind motion deblurring using conditional adversarial networks[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 8183−8192.

( 0) 0)

|

| [12] |

WANG M, LI H, LI F. Generative adversarial network based on resnet for conditional image restoration[EB/OL]. [2021−06−07] https://arxiv.org/abs/1707.04881.

( 0) 0)

|

| [13] |

ZHOU H, SUN J, YACOOB Y, et al. Label denoising adversarial network (LDAN) for inverse lighting of faces[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 6238-6247.

( 0) 0)

|

| [14] |

ZHANG Yulun, TIAN Yapeng, KONG Yu, et al. Residual dense network for image super-resolution[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 2472−2481.

( 0) 0)

|

| [15] |

SAJJADI M S M, SCHÖLKOPF B, HIRSCH M. EnhanceNet: single image super-resolution through automated texture synthesis[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice, Italy, 2017: 4501−4510.

( 0) 0)

|

| [16] |

ADFORD A, METZ L, CHINTALA S. Unsupervised representation learning with deep convolutional generative adversarial networks[EB/OL]. [2021−06−07] https://arxiv.org/abs/1511.06434.

( 0) 0)

|

| [17] |

ZHAO Hang, GALLO O, FROSIO I, et al. Loss functions for image restoration with neural networks[J]. IEEE transactions on computational imaging, 2017, 3(1): 47-57. DOI:10.1109/TCI.2016.2644865 ( 0) 0)

|

| [18] |

WHYTE O, SIVIC J, ZISSERMAN A, et al. Non-uniform deblurring for shaken images[J]. International journal of computer vision, 2012, 98(2): 168-186. DOI:10.1007/s11263-011-0502-7 ( 0) 0)

|

| [19] |

NAH S, KIM T H, LEE K M. Deep multi-scale convolutional neural network for dynamic scene deblurring[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 257−265.

( 0) 0)

|

| [20] |

BENGIO Y, LOURADOUR J, COLLOBERT R, et al. Curriculum learning[C]//Proceedings of the 26th Annual International Conference on Machine Learning. Montreal, Canada, 2009: 41−48.

( 0) 0)

|

| [21] |

佟雨兵, 张其善, 祁云平. 基于PSNR与SSIM联合的图像质量评价模型[J]. 中国图象图形学报, 2006, 11(12): 1758-1763. TONG Yubing, ZHANG Qishan, QI Yunping. Image quality assessing by combining PSNR with SSIM[J]. Journal of image and graphics, 2006, 11(12): 1758-1763. DOI:10.11834/jig.2006012307 (  0) 0)

|

| [22] |

WANG Zhou, BOVIK A C, SHEIKH H R, et al. Image quality assessment: from error visibility to structural similarity[J]. IEEE transactions on image processing, 2004, 13(4): 600-612. DOI:10.1109/TIP.2003.819861 ( 0) 0)

|

| [23] |

TAO Xin, GAO Hongyun, SHEN Xiaoyong, et al. Scale-recurrent network for deep image deblurring[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 8174−8182.

( 0) 0)

|

2021, Vol. 16

2021, Vol. 16