2. 江南大学 物联网工程学院,江苏 无锡 214122

2. School of Internet of Things, Jiangnan University, Wuxi 214122, China

随着计算机视觉领域的发展,目标跟踪在人机交互、视频监控、自动驾驶和机器人等领域得到越来越多的重视和应用。早期的跟踪模型常见的有粒子滤波[1]、Mean shift[2]、相关滤波[3]及其衍生模型[4-8]等。虽然这些传统的跟踪器经过近年来的发展在精度和速度上都有了明显提升,但是对目标特征的提取仍以光流、外观形状、颜色等浅层特征为主,不能捕捉目标语义特征,难以在面对长时跟踪时目标外观形变、被遮挡或出视野等情况下保持鲁棒跟踪。而随着深度学习在跟踪领域的发展,这些问题正逐渐得到改善。

基于深度学习的跟踪器,能有效利用目标的深度特征对目标进行语义级抽象,并拟合目标的运动过程,这大大提高了跟踪精度;且模型的特征提取器在离线时得到了大量标记图片的端到端预训练,这进一步提高了跟踪器在线跟踪速度,使深度学习在目标跟踪领域的应用成为可能。由于目标检测与目标跟踪具有相似性,检测领域的很多算法思想都逐渐被应用于跟踪:MDNet[9]在前一帧的目标周围高斯采样出大量候选框,再利用预训练的二分类器区分候选框中的目标和背景,从而定位目标位置;SiamFC孪生网络模型[10]利用同样结构的CNN(convolutional neural network)网络对初始帧目标和当前帧搜索域提取深度特征,然后通过卷积操作进行相似性计算,得到目标在搜索域位置的响应;RasNet[11]将传统的相关滤波引入孪生网络中,再把检测领域的通道注意力、残差注意力和通用注意力结合,提高了跟踪器的泛化能力,增大了对首帧目标信息的利用率。

然而,基于深度学习的目标跟踪算法,需要收集含有目标信息的正样本,以及含有背景信息的负样本用于模型的迭代训练。但在实际取样中,正样本的可采样数量远远小于负样本,且这些负样本中绝大多数是无意义的简单负样本,对分类器的训练贡献很少。不仅如此,虽然简单负样本的损失值低,但数量庞大,这些值的累积和很可能掩盖了正样本和重要负样本损失值的变化,从而影响模型训练的收敛速度以及跟踪器性能。针对这种不均衡问题,MDNet采用检测领域的难分样本挖掘[12]技术筛选难分负样本,使模型的训练免受大多数简单样本的干扰,但其对难分负样本的采样数量固定,在很多应用场景下难以避免地对简单样本过多采集;FocalLoss[13]对所有的负样本损失值进行抑制,但同时降低了有价值的难分样本对训练的贡献。

此外,长时跟踪时目标不可避免地会出现形变、遮挡和出视野等情况,未采用模型在线更新机制的深度跟踪器往往由于过度依赖首帧特征而导致跟踪漂移或目标丢失。MDNet保留最近

针对上述问题,本文结合MDNet提出了一种深度长时目标跟踪算法LT-MDNet。通过改进收缩损失函数和提出一种全新的高置信度保留样本池,进一步解决类不均衡和模型更新问题。在标准跟踪数据集OTB2015[15]和标准长时数据集UAV20L[16]上的实验结果表明,LT-MDNet有着优越的跟踪性能并能在长时跟踪时的遮挡和目标出视野等复杂情况下保持鲁棒性。

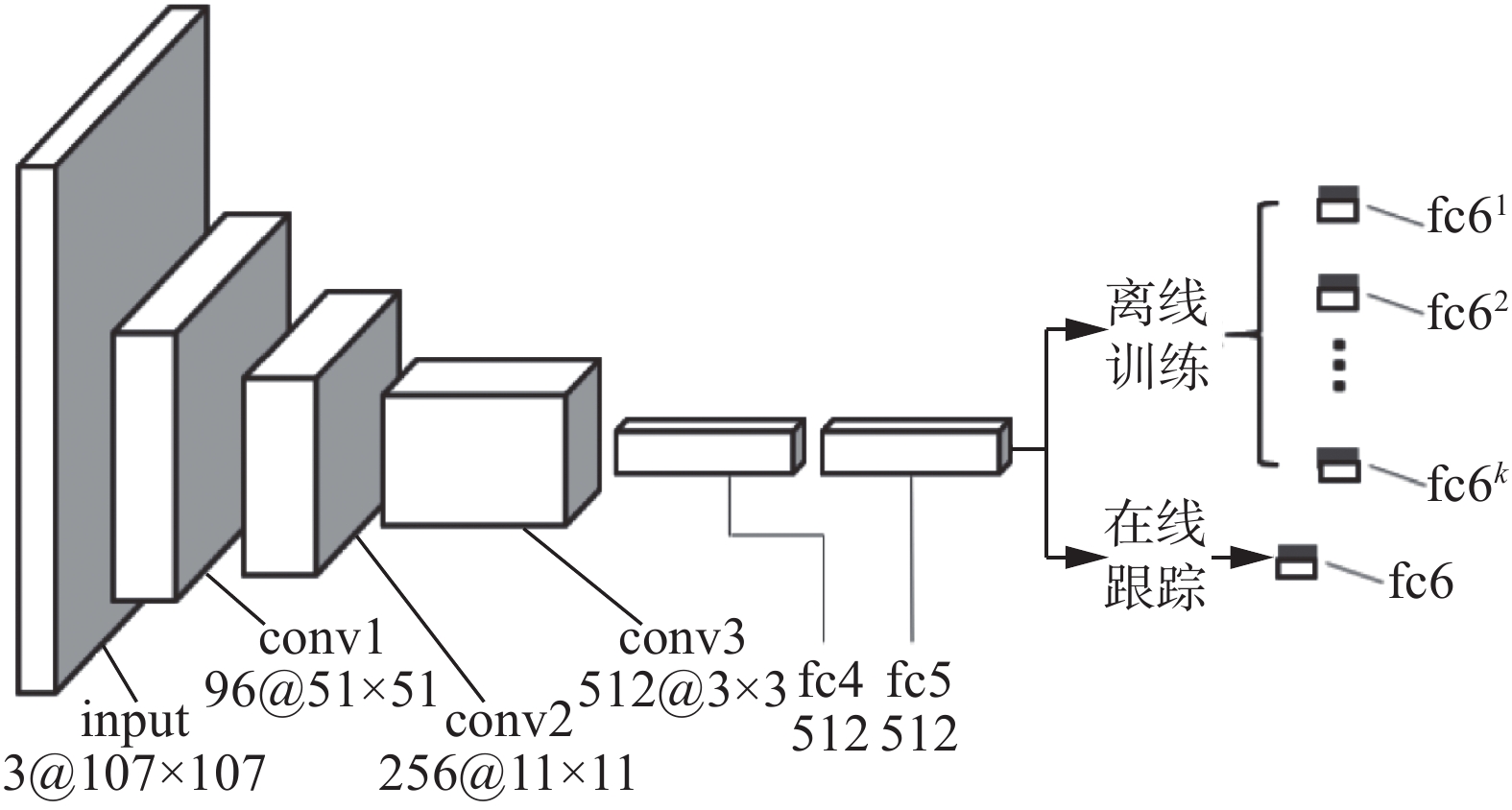

1 MDNet算法MDNet将每一个视频帧序列视为一个单独的域,基于VGG-M[17]架构,提出多域卷积网络。如图1所示,conv1、conv2、conv3、fc4、fc5为域无关的共享层,初始参数通过离线训练得出;fc6(

|

Download:

|

| 图 1 MDNet模型主要结构 Fig. 1 Main architecture of MDNet | |

MDNet将目标搜索域采样出的样本,统一裁剪成107×107大小,输入图1的网络中,通过网络fc6层输出样本属于目标的置信度

| $ L(p,y) = - (y \cdot \ln (p) + (1 - y) \cdot \ln (1 - p)) $ | (1) |

式中:

本文提出的LT-MDNet算法在MDNet基础上通过改进收缩损失函数解决采样时的类不均衡问题,并提出了高置信度保留样本池,以鲁棒更新模型,使模型能够有效应对长时跟踪下的遮挡、出视野等复杂因素。

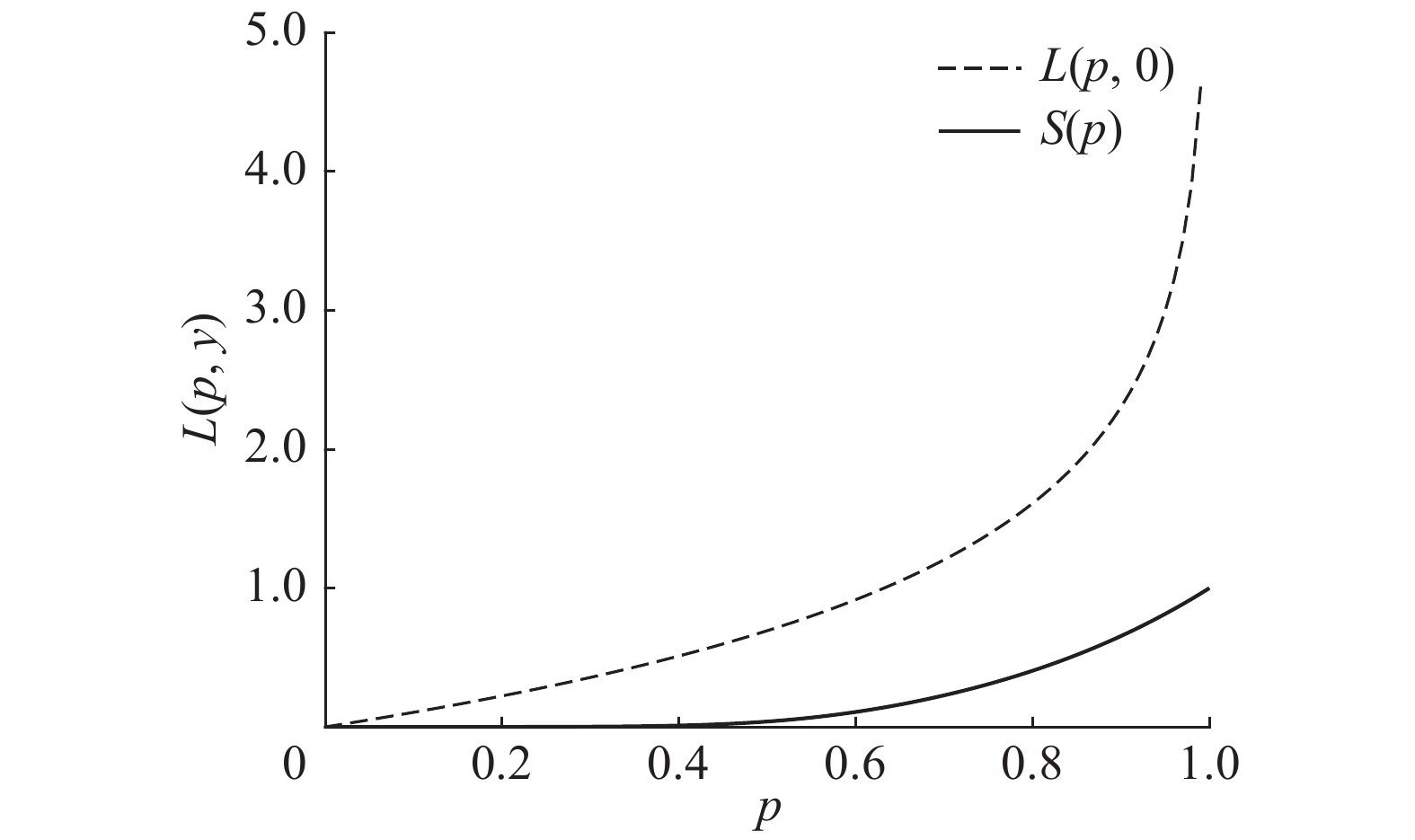

2.1 损失函数从式(1)可以看出,当样本实际为负时,

| $L(p,0) = - \ln (1 - p)$ | (2) |

|

Download:

|

|

图 2 |

|

可见,模型对样本的预测输出越接近真实样本标签0,损失值

为进一步解决上述类不均衡问题,本文结合文献[18]的思想,改进了收缩损失函数,在式(1)的基础上增加了收缩抑制项(见式(3)),通过抑制损失值曲线在

| $ S\left( p \right) = \frac{{{p^4}}}{{1 + \exp \left( {a \left( {c - {p^2}} \right)} \right)}} $ | (3) |

式中:exp(·)能随着模型输出的样本置信度p的变化非线性改变其损失值S(p);a、c为超参数,分别控制损失收缩速度(曲线梯度变化率)和损失值调节敏感范围(S(p)值趋于0时的p区间)。

式(3)损失值变化曲线如图2中实线所示,当

在线训练与离线训练存在本质区别:在线训练迭代次数少,涉及网络层不多,且已经预训练的模型在线更新时只需微调部分参数即可快速收敛,因此,虽然抑制大多数负样本会降低模型的泛化能力,但这样做允许模型对当前视频域存在一定程度过拟合,这在提高跟踪器性能的同时有效降低了训练成本;对

| ${L_S}(p,y) = L(p,y) + \delta S(p)$ | (4) |

式中:

为了尽可能地保留有效跟踪结果使模型更新更为有效,本文设计并实现了基于置信度的跟踪样本池,保留最近最高置信度的跟踪结果样本,并在池满时替换置信度最低的保留样本(第一帧目标永久保留在样本池中)。置信度评估标准,按照当前帧所采样的正样本在fc6层输出的5个最高分类分数的均值计算。样本池的具体工作流程如图3所示。

|

Download:

|

| 图 3 高置信度保留样本池工作流程 Fig. 3 Workflow chart of the high-confidence retention sample pool | |

模型应用了短时更新和长时更新2种更新策略,前者当检测到跟踪失败(置信分数低于0)时利用

LT-MDNet在前帧目标位置周围高斯采样出多个候选正样本,通过预训练和在线更新后的网络模型输出这些候选样本的目标置信度

1)输入视频帧序列和首帧的目标位置,随机初始化fc6层的权值参数

2)采样正样本

3)使用

4)对于第

5)取

6)若

7)若

8)重复步骤4)~7)直至目标跟踪结束。

3 实验结果与分析本文LT-MDNet算法基于PyTorch 1.2.0编程语言和CUDA 10.0深度学习架构实现,实验平台操作系统为Windows 10,处理器为AMD R5-2600 3.4 GHz,GPU为NVIDIA RTX2070,内存16 GB。

为验证模型的有效性、泛化能力和长时跟踪性能,分别在OTB2015和UAV20L数据集上与MDNet[9]、DSLT[18]、SRDCF[6]、TADT[19]、SiamRPN[20]、CIResNet22-FC[21]、MUSTer[22]和BACF[7]等主流跟踪模型进行对比实验,将统计的各数据集上所有图像序列跟踪结果平均值作为最终结果。

3.1 实验设置模型离线训练于IMAGENET-VID[23]目标检测数据集, 每间隔

本文采用跟踪成功率(tracking success rate)和跟踪精度(tracking precision)来比较各跟踪器的性能。

1)跟踪成功率[24]。通过计算跟踪器对目标位置边界的预测框(

| ${\rm{IoU}} = \frac{{|{R_t} \cap {R_a}|}}{{|{R_t} \cup {R_a}|}}$ | (5) |

IoU值越大表示跟踪器的成功率越高,当IoU>0.5时可认为该帧目标被成功跟踪,通过计算成功率图中的曲线下面积(area under curve, AUC)得到模型的跟踪成功率。

2)跟踪精度[24]。通过计算

| $\varepsilon = \sqrt {{{({x_t} - {x_a})}^2} + {{({y_t} - {y_a})}^2}} $ | (6) |

两者的欧氏距离

OTB2015包含100个跟踪视频帧序列,含目标遮挡、尺度变化、出视野等11种常见的复杂跟踪因素,可有效评估跟踪器的综合性能。

图4(a)、(b)为LT-MDNet和对比跟踪器在OTB2015数据集上对所有视频帧序列的跟踪结果的综合统计平均曲线图。可以看出,LT-MDNet的综合跟踪精度为91.6%,成功率为68.2%,分别较对比实验中的最优算法提高0.8%和1.1%。

图4(c)、(d)、(e)、(f)分别为各跟踪器在OTB2015上关于目标遮挡、目标出视野的平均跟踪精度和跟踪成功率,在这些复杂因素下,LT-MDNet跟踪效果均为最优,尤其是对比MDNet,在遮挡因素下均提高了1.8%,在目标出视野因素下则分别提高了2.2%和1.2%。可见,除了综合性能的领先,LT-MDNet在应对目标遮挡、出视野等复杂因素同样保持了良好的跟踪能力和稳定性。

|

Download:

|

| 图 4 LT-MDNet和对比算法在OTB2015上的跟踪结果评估曲线 Fig. 4 Evaluation plots of the tracking results on OTB2015 of contrast algorithms and LT-MDNet | |

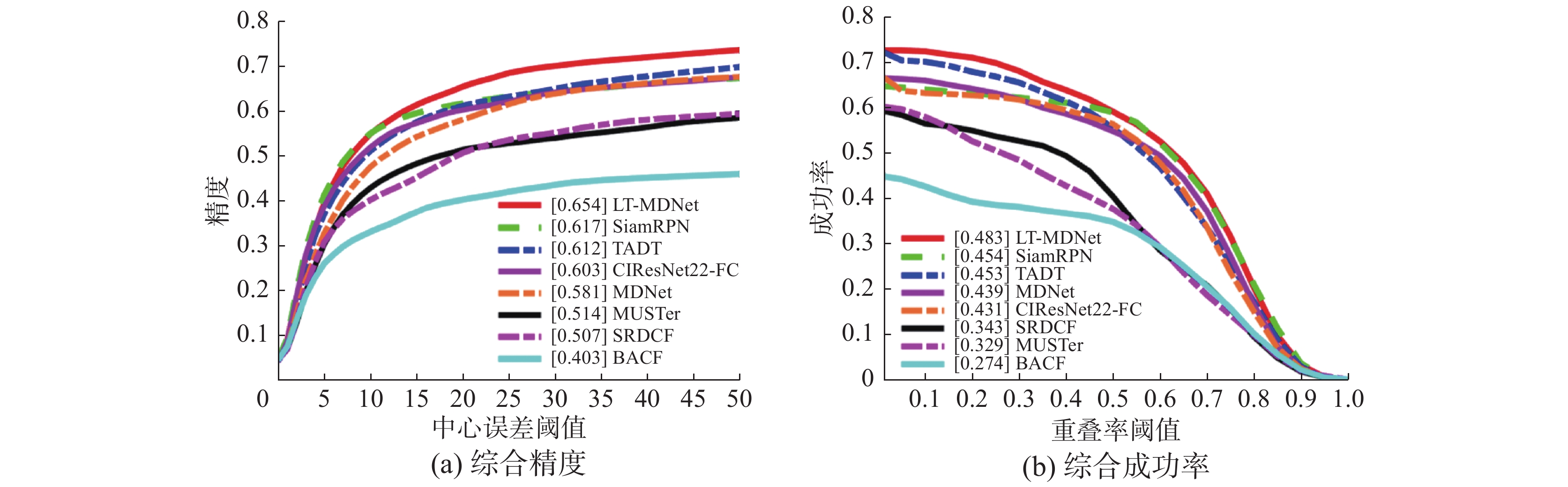

UAV20L包含20个无人机拍摄的视频帧序列,这些序列时间跨度大,目标视野变化剧烈,目标形变也更大,有利于评估跟踪器在长时跟踪环境下的有效性和鲁棒性。本文基于UAV20L数据集与MDNet、TADT、SiamRPN、CIResNet22-FC、BACF、MUSTer和SRDCF等主流长短时跟踪算法进行了对比实验,并通过定量分析和定性分析,进一步验证LT-MDNet在长时跟踪下的跟踪性能。

3.4.1 定量分析图5(a)、(b)分别为各跟踪器在UAV20L的平均跟踪精度和成功率曲线对比图,可以看出LT-MDNet在长时跟踪数据集上性能大幅领先,较最优对比模型的精度和成功率分别提升3.7%、2.9%,较MDNet则分别提升7.3%、4.4%。

|

Download:

|

| 图 5 LT-MDNet和对比算法在UAV20L上跟踪结果评估曲线 Fig. 5 Evaluation plots of the tracking results on UAV20L of contrast algorithms and LT-MDNet | |

针对UAV20L所包含的12个不同的视频属性,即相机运动(CM)、快速运动(FM)、纵横比变化(ARC)、相似目标干扰(SO)、光照变化(IV)、背景杂乱(BC)、视角变化(VC)、尺度变化(SV)、低分辨率(LR)、部分遮挡(PO)、全部遮挡(FO)和目标出视野(OV),表1定量展示了LT-MDNet和各对比跟踪器在应对这些复杂跟踪因素下的平均AUC数据。从表1中可以看出,LT-MDNet在12个视频属性中的10个均保持了最优或次优性能,除在CM、ARC下稍稍落后于MDNet外,其余复杂跟踪环境下均优于MDNet。而究其原因,主要是因为训练集中缺少CM和ARC复杂变化因素,且在线训练时为使模型快速收敛而抑制了大部分简单背景负样本对参数的影响,一定程度上弱化了模型在应对未包含在训练集中的复杂因素时的泛化能力;而在应对已知变化因素时,模型则可以通过有效的离线学习和鲁棒的在线更新机制,迅速适应跟踪视频域内的目标变化并准确定位目标位置。

| 表 1 UAV20L数据集上对比算法与本文LT-MDNet在12个视频属性上AUC的定量对比结果 Tab.1 Quantitative comparison results of the AUC of contrast algorithms and the prossed LT-MDNet algorithm on the 12 video attributes in the UAV20L database |

为了更为直观地对比跟踪器在应对长时跟踪复杂因素下的实际跟踪性能,本文选取了UAV20L中较为典型的4组图像序列,即 uav1、person17、car1、bike1,包含全部12个复杂跟踪因素,并选取了在UAV20L上综合性能最好的5个对比算法(SiamRPN、TADT、MDNet、CIResNet22-FC和SRDCF)与LT-MDNet进行定性实验对比。图6着重对跟踪器在目标快速移动、目标遮挡、目标出视野和目标形变下的实际表现做了展示。

|

Download:

|

| 图 6 LT-MDNet与对比算法在uav1、person17、car1和bike1下的定性对比结果 Fig. 6 Qualitative comparison results of contrast algorithms and the propossed LT-MDNet algorithm on uav1, person17, car1 and bike1 in the UAV20L database | |

图6(a)为对小型飞机这种快速移动的小目标进行跟踪,在第1 088帧,飞机平稳飞行,此时只有LT-MDNet和MDNet可以锁定目标位置;而在第1 529帧和之后的帧序列里,由于飞机航向、目标背景和航拍角度均剧烈变化,除LT-MDNet能由于模型有效更新操作精确锁定目标位置外,其余跟踪器均跟踪失败。

图6(b)中目标行人在第594、1415帧被树叶遮挡,此时LT-MDNet较其他对比跟踪器更能精确捕捉目标轮廓信息,并在随后持续稳定跟踪;SRDCF、MDNet和SiamRPN均在目标重现后失去跟踪能力。

图6(c)中目标汽车在第1 505帧被遮挡、在第1 927帧出视野,从图中可以看出,除LT-MDNet和MDNet外其余跟踪器均在目标被遮挡和出视野时发生了跟踪漂移。

图6(d)中目标小男孩在第2375帧掉转车头,目标外观由男孩正面变成背影,而随后航拍镜头加速向前,目标迅速被甩在后面,其在图像帧中轮廓尺度也剧烈变化。此时,LT-MDNet仍可准确定位目标位置,并保持对目标横纵比信息的有效估计,而其余跟踪器均难以检测目标的准确轮廓,TADT则彻底跟踪失败。

从上述分析可见,LT-MDNet能够在长时跟踪下很好地应对这些复杂因素,在目标遮挡、出视野重现时仍能迅速定位目标;对快速位移、剧烈形变下的目标,在经过模型更新后可以维持鲁棒跟踪,并且较对比算法能更精确地捕捉目标的轮廓信息。

3.5 消融实验为进一步验证LT-MDNet改进的有效性,本文在OTB2015上对模型进行了消融实验,分别测试在MDNet模型基础上所做出的2个主要改进:收缩损失(SK)和高置信度保留样本池(HU),实验环境与模型主要超参数均一致。MDNet+HU、MDNet+SK和LT-MDNet在线跟踪时速度约为3 f/s,与MDNet持平,跟踪成功率(Succ)与跟踪精度(Prec)对比数据如表2所示。实验结果表明,高置信度保留样本池和收缩损失函数均能在不影响跟踪速度的情况下有效提高跟踪器的定位精度和成功率,且两者结合能够协同提高跟踪器性能。

| 表 2 LT-MDNet模型在OTB2015数据集上的消融实验结果 Tab.2 Ablation study results of the LT-MDNet algorithm in the OTB2015 database |

针对长时跟踪时的目标遮挡和出视野问题,本文提出了一种能够有效在线更新的深度跟踪算法LT-MDNet。在难分样本挖掘的基础上,引入改进的收缩损失函数,进一步抑制简单负样本的损失值,以缓和类不均衡问题;在模型在线追踪运动目标时,设计了一种全新的高置信度保留样本池,对在线跟踪时的高置信度正样本进行保留,并在池满时替换最低置信度的保留样本,首帧样本则长期保存在池中;当模型检测到跟踪失败以及跟踪达到特定帧间隔时,利用保留样本池进行在线训练更新模型,以维持跟踪器的长期鲁棒性。在OTB2015标准数据集和UAV20L长时跟踪数据集上与主流跟踪算法对比,LT-MDNet在跟踪精度和成功率上均保持了优越的性能,并能很好地应对目标遮挡和出视野问题。接下来的工作将探索在不同跟踪环境下自适应收缩比

| [1] |

ARULAMPALAM M S, MASKELL S, GORDON N, et al. A tutorial on particle filters for online nonlinear/non-Gaussian Bayesian tracking[J]. IEEE transactions on signal processing, 2002, 50(2): 174-188. DOI:10.1109/78.978374 ( 0) 0)

|

| [2] |

COMANICIU D, MEER P. Mean shift: a robust approach toward feature space analysis[J]. IEEE transactions on pattern analysis and machine intelligence, 2002, 24(5): 603-619. DOI:10.1109/34.1000236 ( 0) 0)

|

| [3] |

BOLME D S, BEVERIDGE J R, DRAPER B A, et al. Visual object tracking using adaptive correlation filters[C]//Proceedings of 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, USA, 2010: 2544−2550.

( 0) 0)

|

| [4] |

HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with Kernelized correlation filters[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(3): 583-596. DOI:10.1109/TPAMI.2014.2345390 ( 0) 0)

|

| [5] |

MUELLER M, SMITH N, GHANEM B. Context-aware correlation filter tracking[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 1396−1404.

( 0) 0)

|

| [6] |

DANELLJAN M, HÄGER G, SHAHBAZ KHAN F, et al. Learning spatially regularized correlation filters for visual tracking[C]//Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile, 2015: 4310−4318.

( 0) 0)

|

| [7] |

KIANI GALOOGAHI H, FAGG A, LUCEY S. Learning background-aware correlation filters for visual tracking[C]//Proceedings of 2017 IEEE International Conference on Computer Vision. Venice, Italy, 2017: 1135−1143.

( 0) 0)

|

| [8] |

宁欣, 李卫军, 田伟娟, 等. 一种自适应模板更新的判别式KCF跟踪方法[J]. 智能系统学报, 2019, 14(1): 121-126. NING Xin, LI Weijun, TIAN Weijuan, et al. Adaptive template update of discriminant KCF for visual tracking[J]. CAAI transactions on intelligent systems, 2019, 14(1): 121-126. (  0) 0)

|

| [9] |

NAM H, HAN B. Learning multi-domain convolutional neural networks for visual tracking[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 4293−4302.

( 0) 0)

|

| [10] |

BERTINETTO L, VALMADRE J, HENRIQUES J F, et al. Fully-convolutional Siamese networks for object tracking[C]//Proceedings of the 14th European Conference on Computer Vision. Amsterdam, The Netherlands, 2016: 850−865.

( 0) 0)

|

| [11] |

WANG Qiang, TENG Zhu, XING Junliang, et al. Learning attentions: residual attentional Siamese network for high performance online visual tracking[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 4854−4863.

( 0) 0)

|

| [12] |

SUNG K K, POGGIO T. Example-based learning for view-based human face detection[J]. IEEE transactions on pattern analysis and machine intelligence, 1998, 20(1): 39-51. DOI:10.1109/34.655648 ( 0) 0)

|

| [13] |

LIN T Y, GOYAL P, GIRSHICK R, et al. Focal loss for dense object detection[C]//Proceedings of 2017 IEEE International Conference on Computer Vision. Venice, Italy, 2017: 2980−2988.

( 0) 0)

|

| [14] |

VALMADRE J, BERTINETTO L, HENRIQUES J, et al. End-to-end representation learning for correlation filter based tracking[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 2805−2813.

( 0) 0)

|

| [15] |

WU Yi, LIM J, YANG M H. Object tracking benchmark[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(9): 1834-1848. DOI:10.1109/TPAMI.2014.2388226 ( 0) 0)

|

| [16] |

MUELLER M, SMITH N, GHANEM B. A benchmark and simulator for uav tracking[C]//Proceedings of the 14th European Conference on Computer Vision. Amsterdam, The Netherlands, 2016: 445−461.

( 0) 0)

|

| [17] |

CHATFIELD K, SIMONYAN K, VEDALDI A, et al. Return of the devil in the details: Delving deep into convolutional nets[EB/OL]. (2014-11-05)[2019-10-01]https://arxiv.org/abs/1405.3531.

( 0) 0)

|

| [18] |

LU Xiankai, MA Chao, NI Bingbing, et al. Deep regression tracking with shrinkage loss[C]//Proceedings of the 15th European Conference on Computer Vision (ECCV). Munich, Germany, 2018: 353−369.

( 0) 0)

|

| [19] |

LI Xin, MA Chao, WU Baoyuan, et al. Target-aware deep tracking[C]//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, USA, 2019: 1369−1378.

( 0) 0)

|

| [20] |

LI Bo, YAN Junjie, WU Wei, et al. High performance visual tracking with Siamese region proposal network[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 8971−8980.

( 0) 0)

|

| [21] |

ZHANG Zhipeng, PENG Houwen. Deeper and wider Siamese networks for real-time visual tracking[C]//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, USA, 2019: 4591−4600.

( 0) 0)

|

| [22] |

HONG Zhibin, CHEN Zhe, WANG Chaohui, et al. Multi-store tracker (muster): a cognitive psychology inspired approach to object tracking[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA, 2015: 749−758.

( 0) 0)

|

| [23] |

RUSSAKOVSKY O, DENG Jia, SU Hao, et al. ImageNet large scale visual recognition challenge[J]. International journal of computer vision, 2015, 115(3): 211-252. DOI:10.1007/s11263-015-0816-y ( 0) 0)

|

| [24] |

ZHANG Shunli, LU Wei, XING Weiwei, et al. Using fuzzy least squares support vector machine with metric learning for object tracking[J]. Pattern recognition, 2018, 84: 112-125. ( 0) 0)

|

2021, Vol. 16

2021, Vol. 16