2. 北京航空航天大学 生物与医学工程学院,北京 100083;

3. 北京航空航天大学 机械工程及自动化学院,北京 100083

2. School of Biological Science and Medical Engineering, Beihang University, Beijing 100083, China;

3. School of Mechanical Engineering and Automation, Beihang University, Beijing 100083, China

软式自主空中加油对接阶段的任务包括加/受油机到达指定加油区域后,从较远距离的双机编队到双机逐渐接近直至受油插头插入锥套的全过程。在这一过程中基于计算机视觉的导引系统需要准确识别锥套,然后对其进行精细地特征提取,接着完成位姿估计等任务,从而指导飞行控制系统和加油对接系统完成精准对接。这一阶段视觉导航任务重要的一环就是对锥套目标的跟踪,稳定的目标跟踪是视觉导引加/受油机进行编队的必要条件,也是后续准确目标识别与精确位姿测量的重要支撑。通过目标跟踪算法在图像中圈选出目标识别与视觉测量的感兴趣区域,可以大幅度减少这些视觉任务的计算量,提高计算速度,从而满足空中编队与加油中计算机视觉实时处理的需求。

目标跟踪作为计算机视觉领域的经典问题,一直以来饱受关注[1],主要解决方法包括经典的目标跟踪算法,如光流法、粒子滤波等,基于相关滤波的方法,如核相关滤波器(kernel correlation filter,KCF)和基于学习的跟踪算法如高效卷积算子跟踪(efficient convolution operators, ECO)及深度学习跟踪(deep learning tracker, DLT)等。但当目标发生姿态、明暗和尺度变化时,现有的许多跟踪算法会出现目标漂移甚至跟踪失败等情况。猛禽涵盖了鸟类传统分类系统中隼形目如老鹰、秃鹫和鸮形目如猫头鹰的所有种,这一类的鸟多具有捕杀动物为食的习性,视觉器官发达,飞翔能力强。猛禽能够稳定跟踪空中、地面以及水中快速运动的猎物,除了依赖优秀的飞行能力,其视觉系统对目标的准确追踪功不可没[2]。现有的模拟猛禽视觉系统的硬件装置[3]与方法[4]也已经有所成就,但仍存在很多可以进一步研究的方向和内容。猛禽视觉通路中的视顶盖是其视觉信息处理过程中的重要核团,不仅处理对侧视网膜输入的信息,还整合脑内同侧与对侧的圆核与视丘传递的目标特征信息,这种双侧信息并行处理的方式更适合于猛禽视网膜的双中央凹结构,并且对于目标跟踪过程也具有一定的指导意义[5]。本文针对自主空中加油对接阶段目标跟踪的需求,模拟猛禽脑内同侧与对侧信息在视顶盖整合处理的机制,建立目标跟踪算法,并进行仿真试验与对比分析。

1 猛禽视顶盖的信息整合与交互处理猛禽中隼形目视网膜的鼻侧和颞侧存在两个中央凹,鼻侧凹较深,颞侧凹较浅,是其视觉特性尤为出色的重要因素,如图1所示[6]。由于两个中央凹的观察方向不同,所以隼形目的视野范围非常大,在水平方向上的视野(除盲区以外的区域)可以达到260°,在垂直方向上也能够达到80°。

|

Download:

|

| 图 1 猛禽视网膜中央凹与视线角度示意图 Fig. 1 Bifovea structure and line of sight of falcon | |

配合这样特别的双凹结构,猛禽脑内存在着复杂的视觉信息处理通路。离顶盖通路是以视网膜−视顶盖−圆核−外纹体为主要核团的视觉通路,离丘脑通路是以视网膜−背外侧膝状体−视丘为主要核团的视觉通路。这两条通路将视网膜获取信息以交叉的方式传递至脑内核团,处理得到目标特征的编码信息,并逐步整合传输至大脑同侧的高级核团,实现视觉信息提取。此外,有研究结果显示脑内核团间也存在向对侧大脑传递信息的神经通路,并且在离丘脑通路与离顶盖通路之间也存在特征信息的传递。在这样复杂的信息交互传递的过程中,视顶盖承担了信息传递中转站的任务,以视顶盖为中心,总结离顶盖和离丘脑通路中与其相关的神经通路如图2所示,视觉信息从视网膜输入,经由对侧视顶盖处理后向同侧和对侧圆核传递,视顶盖同时接收视丘输入的信息。

|

Download:

|

| 图 2 视顶盖中心神经通路 Fig. 2 Tectum centered neural pathway | |

从图2可见,以视顶盖为中心的神经通路主要包括离顶盖通路的一部分(图中不包括与视顶盖无直接信息传递的外纹体)和离丘脑通路中的视丘。研究认为离顶盖通路主要检测获得目标的形状、颜色、亮度和空间细节等信息,完成视觉系统的“模式识别”功能;视丘作为离丘脑通路的中枢环节,主要获取目标的运动朝向、背景情况和视觉定位等信息[7]。由于视丘和视顶盖之间存在信息传递,认为视顶盖处理的目标运动信息极有可能来源于视丘。猛禽脑内核团中的圆核与哺乳的丘脑枕后外侧核同源,而丘脑在哺乳动物中的一个任务就是实现前景与背景的分辨。那么以视顶盖为中心的部分视觉信息脑处理通路的任务可以总结为:视觉信息经由视网膜输入后,传递向对侧视顶盖,提取出目标的部分特征后,传递至视丘;视丘接收到离丘脑通路处理得到目标的方向位置等运动信息,结合从视顶盖收到的特征反向回传至视顶盖;对侧的视顶盖之间通过顶盖上联合和顶盖下联合两个半脑间连接,实现信息在左右半脑之间的传递;视顶盖整合所有浅层特征与信息后,传递至圆核,由圆核进一步进行目标的几何形状、亮度、颜色和精细空间结构的特征辨识处理[8]。

这一部分视觉信息传递过程中的一个重要特点与作用是打破了视觉信息传递过程中交叉传递的壁垒,实现了双侧脑之间的信息融合,包括双侧视顶盖之间的信息传递、视丘向同侧视顶盖的信息传递、视顶盖向对侧视丘的信息传递以及视顶盖向同侧和对侧圆核的信息传递。经过这种传递机制,实现了双眼获取视觉信息在对侧半脑处理后的整合调制。

2 仿猛禽交叉通路的神经网络 2.1 网络的基本结构目标跟踪的任务是在已知视频序列第一帧中目标位置与尺寸的情况下,预测后续视频序列中这一目标的大小和位置。通常人为框选初始目标,由跟踪算法在下一帧中计算出多个候选框,然后提取候选框内的图像特征,并基于特征对这些候选框进行评分,最后选择一个得分最高的候选框作为预测的目标,或者融合多个预测值从而得到更优的预测结果。本文根据视顶盖信息整合与交互的特征处理系统,设计了一种模拟交叉通路的神经网络,跳出双通路信息依赖双目视觉分别获取的思维框架,将单镜头获取的图像分为两路进行处理。首先输入目标模板图像和待跟踪的图像,作为交叉通路的两路信息,模拟猛禽视顶盖与视丘的神经网络特征提取层,对两幅图像进行特征提取;然后模拟视丘−视顶盖−圆核的特征传递整合机制,加入不同特征层之间的融合操作(Concat),整合低级形状纹理特征的同时,提取出两者的高级抽象特征;最终在待跟踪图片特征图上使用目标模板的特征图进行卷积得到卷积响应图。响应最大的区域即为目标的跟踪结果,根据特征图和原图的比例关系,进行等比例放缩完成目标跟踪的任务。整个网络的框架如图3所示。

|

Download:

|

| 图 3 目标跟踪总体框架 Fig. 3 Framework of the target tracking method | |

图3中输入部分的左图为锥套目标模板图像,右图为待跟踪图像,在跟踪算法中以第一帧的目标位置和图像作为标准,两幅图像都经过模拟猛禽单侧特征提取网络提取特征,主要包括卷积神经网络常用的卷积层、池化层以及非线性激活函数,进而得到两者的特征图。以模板图像的特征图作为卷积核,对待跟踪图像的特征图进行卷积操作,得到的卷积响应图,即为待跟踪图像中各个位置与目标模板的相似度值,卷积响应图中较亮的部分即为目标跟踪的响应最大位置也即跟踪结果。

总体来说,仿猛禽交叉通路卷积网络提取整个待跟踪图像和模板图像的特征,直接卷积计算两特征图的相似度找到目标位置,相较于传统网络方法通过遍历的方式生成候选框后对每个候选框提取特征再进行比对的方法,减少了计算量,节省了计算时间。

目标模板图像和待跟踪图像共用同一特征提取网络,由于二者图像尺寸差异,各自的特征图尺寸也不同,具体的卷积层、池化层的参数设置如表1所示。

| 表 1 网络参数设置 Tab.1 Parameters of the network |

在较低层的特征图中,卷积核的尺寸采用了

| 表 2 Concat层参数 Tab.2 Table 1 Parameters of the Concat layer |

Conv2~Conv4指从第2层特征图整合到第4层特征图之前需要进行卷积以及下采样,同样的,Conv3~Conv4指从第3层特征图整合到第4层特征图,两者的下采样均采用了

在神经网络的训练过程中,通过最小化损失函数并不断缩小误差才能获取最优模型。本文算法为了构造有效的损失函数,对搜索区域内的位置点进行了正负样本的区分,即认为目标一定范围内的点是正样本,认为这一范围外的点是负样本,损失函数为逻辑回归损失,具体的损失函数形式如下,最终的卷积响应图中每个点的损失为

| $ \begin{split} \;\\ l(y,v) = \log (1 + \exp ( - y * v))\end{split} $ | (1) |

式中:

| $ L(y,v) = \frac{1}{{\left| D \right|}}\sum\limits_{u \in D} {l(y[u],v[u])} $ | (2) |

其中

提取到目标模板和待跟踪图像的特征后,由卷积响应的相关度计算相似度,其中相似度函数选用交叉相关函数,如下所示:

| $ f(z,x) = \varphi (z) * \varphi (x) + {\left\| b \right\|_1} $ | (3) |

式中:

神经网络中的非线性激活函数主要是为了给神经网络加入一些非线性因素,使得神经网络可以更好地解决较为复杂的非线性问题。ReLU函数实际上是一个分段的线性函数,小于零的输入都会得到零输出,而正值则保持不变,类似于单侧抑制[9]。而ReLU的非线性正是通过这种类似单侧抑制的方法,增加了神经网络参数的稀疏性。由于ReLU在正数区间为常数形式,在负数区间为零,所以不存在由于梯度过小而发生梯度消失的情况,函数形式如下:

| $ {\rm{Relu}}(x) = \left\{ {\begin{array}{*{20}{c}} x{{\rm{,}}\;\;x > 0}\\ 0{{\rm{,}}\; \;x \leqslant 0} \end{array}} \right. $ | (4) |

式中x为神经元的输出。ReLU非线性激活函数相较于需要计算指数的Sigmoid函数来说,实质是一个比较函数,计算量很小,针对神经网络中庞大的神经元计算量来说,大大提高了效率,同时也避免了梯度消失问题。

2.3 双凹扩大搜索策略的目标跟踪在目标跟踪过程中,一个重要的难点就是当目标遇到遮挡或飞出图像后,如何在其再次出现或重新进入图像时继续进行跟踪。很多目标跟踪算法为了节省计算时间,提高跟踪帧率,在跟踪过程中不对跟踪器做在线修改,但是这样就无法应对跟踪场景与目标发生剧烈变化的情况。此外,还有一部分跟踪算法在目标丢失时使用局部搜索策略,只在最后识别到目标的图像位置附近做搜索,无法应对长时跟踪时难以避免的目标完全遮挡和离开图像的问题。

O’Rourke对于红尾鹰、库氏鹰和美洲隼这3种日行性猛禽的感受野结构的研究结果显示,这些不同物种的日行性猛禽的感受野结构上的差异与捕食采用的搜索策略以及在环境中的视觉障碍角度(例如栖息地的开放程度)相关,而不同物种间的眼动角度差异则与觅食策略相关。此外,猛禽双目区域和视觉盲区的大小会由于眼动产生巨大差异,物种间的视觉区域和眼动则会影响栖息过程中的搜索和猎物追踪策略[10]。在视场角有限的情况下,尽量利用双凹的视觉敏锐度可变特性,结合眼动与头动调整最高视觉敏锐度的视野位置,实现对于目标的搜索[11]。这种搜索策略不仅适用于目标不确定情况下的目标分辨,也同样适用于目标遮挡或从场景中消失再入的重新搜索情况。

根据猛禽的双凹−眼动特性,设计一种局部−全局的搜索策略,用于长时目标跟踪。图像通过模拟交叉通路的神经网络得到卷积响应图后,对图像中响应区域求取均值,得到图中

| $ q = \mathop {\arg \max }\limits_{{r_k} \in R} \left( {f(s,{r_k}) - \dfrac{{\hat \alpha \displaystyle\sum\limits_{i = 1}^n {{\alpha _i}f({p_i},{r_k})} }}{{\displaystyle\sum\limits_{i = 1}^n {{\alpha _i}} }}} \right) $ | (5) |

式中:

| $ q = \mathop {\arg \max }\limits_{{r_k} \in R} \left( {\varphi (s) - \frac{{\hat \alpha \displaystyle\sum\limits_{i = 1}^n {{\alpha _i}\varphi ({p_i})} }}{{\displaystyle\sum\limits_{i = 1}^n {{\alpha _i}} }}} \right) * \varphi ({r_k}) $ | (6) |

以学习率

| $ {q_{T{\rm{ + }}1}} = \mathop {\arg \max }\limits_{{r_k} \in R} \left( \frac{{\displaystyle\sum\limits_{t = 1}^T {{\beta _t}\varphi ({s_t})} }}{{\displaystyle\sum\limits_{t = 1}^T {{\beta _t}} }} - \frac{{\displaystyle\sum\limits_{t = 1}^T {{\beta _t}\hat \alpha } \displaystyle\sum\limits_{i = 1}^n {{\alpha _i}\varphi ({p_i},t)} }}{{\displaystyle\sum\limits_{t = 1}^T {{\beta _t}} \displaystyle\sum\limits_{i = 1}^n {{\alpha _i}} }} \right) * \varphi ({r_k}) $ | (7) |

式(7)通过将现有的相似性矩阵转移到另一个特定的域内降低计算量,加快了算法的运行速度。

当目标由于遮挡等原因在原位置消失,或脱离图像范围再次进入时,用深凹−浅凹的视觉焦点转移方式,扩大聚焦范围,重新在浅凹对准的更大范围内搜索确定目标,也就是目标跟踪过程中的再入搜索。在本跟踪方法中,对响应区域的得分设定门限值,当图像极大响应区域的得分均低于门限值时,认为目标从当前图像中消失,需要进行再入搜索。以当前帧计算确定的候选响应区域中得分最高的区域作为搜索中心,以固定步长为扩大搜索半径,逐步扩大目标搜索区域,直至找到目标或完成对序列中全部目标的扩大搜索。

3 仿真实验与结果分析在视觉目标跟踪(Visual Object Tracking,VOT)2017数据集[13]上对本文算法进行测试,并与ECO[14]、DLT[15]、互补学习(staple)[16]和全卷积孪生网络(fully-convolutional siames network, SiamFC)[17]进行对比。在使用NMS方法选定候选目标时,留选得分在0.8~0.95之间的目标作为候选目标,式(5)中总权重系数

| 表 3 算法在VOT2017数据集结果对比 Tab.3 Performance comparison on VOT2017 |

如表3所示,本文所述方法跟踪精度仅略逊于Staple,鲁棒性与ECO相当,但是平均覆盖率结果最好,可见本方法对于精度与鲁棒性的平衡结果较好。由于空中加油问题后续对于跟踪区域进行进一步的计算,所以跟踪精度并不会对加油任务的完成造成太大影响。

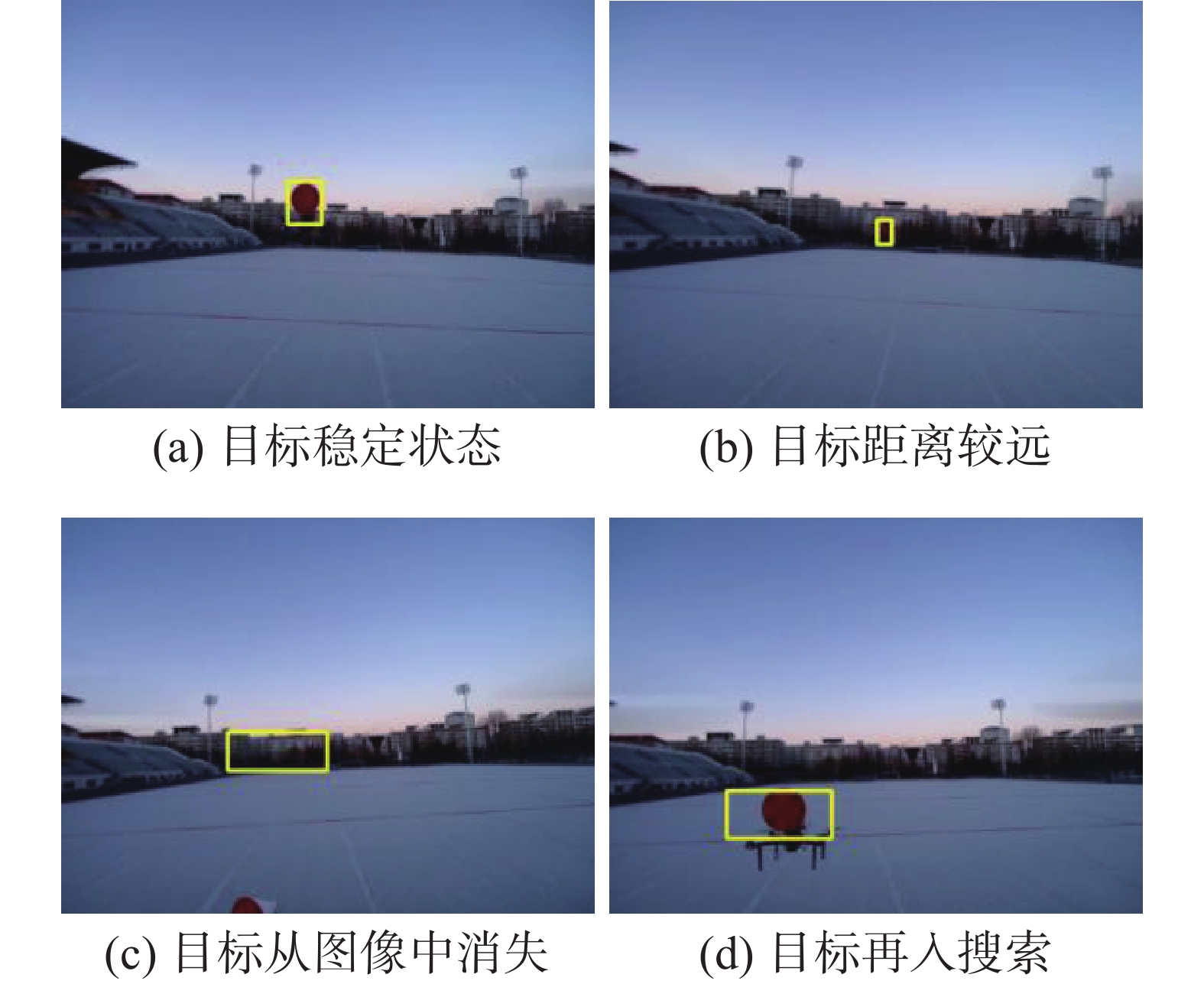

针对自动空中加油问题,搭建了基于旋翼无人机的空中验证平台。使用两架旋翼机模拟软式空中加油过程中的加油机与受油机。模拟加油机上搭载锥套标识,模拟受油机搭载摄像头,采集加油机与锥套图像,并进行跟踪。跟踪结果如图4所示。

可以看出,当目标较为稳定地存在于图像中时,本文所述方法可以连续并且准确地对目标进行跟踪,如图4(a)所示;即使目标在图像中变得较小,并且与背景区域相近,本文所述方法仍能够对实现对目标存在一定形变与误差的跟踪,如图4(b)所示;当目标从图像中消失时,本方法可以根据双凹搜索策略,对目标进行扩大范围的搜索,如图4(c)所示;当目标再次出现在图像中时,可以重新搜索得到这一目标,进行继续跟踪,如图4(d)所示。

|

Download:

|

| 图 4 目标跟踪结果示意图 Fig. 4 Result of the target tracking | |

对于目标跟踪的精度进行定量分析,比较每一帧图像中目标的中心坐标和跟踪区域的中心图像坐标,计算出两者间的像素误差,所得结果如图5所示。

|

Download:

|

| 图 5 目标跟踪误差曲线 Fig. 5 Curve of target tracking error | |

图5中横坐标为目标跟踪序列的帧数,纵坐标为以像素为单位的目标的跟踪误差。从结果中可以看出,在跟踪开始时,对目标的跟踪比较稳定,但随着目标的远离,跟踪误差变大,但是在跟踪的全过程中,跟踪区域的中心和目标中心相差50个像素以内。此外,值得一提的是,使用NVIDIA 1080Ti的GPU,CPU为i7-8700k的地面处理器进行离线跟踪测试时,本文所述方法的计算速度可达110 f/s。

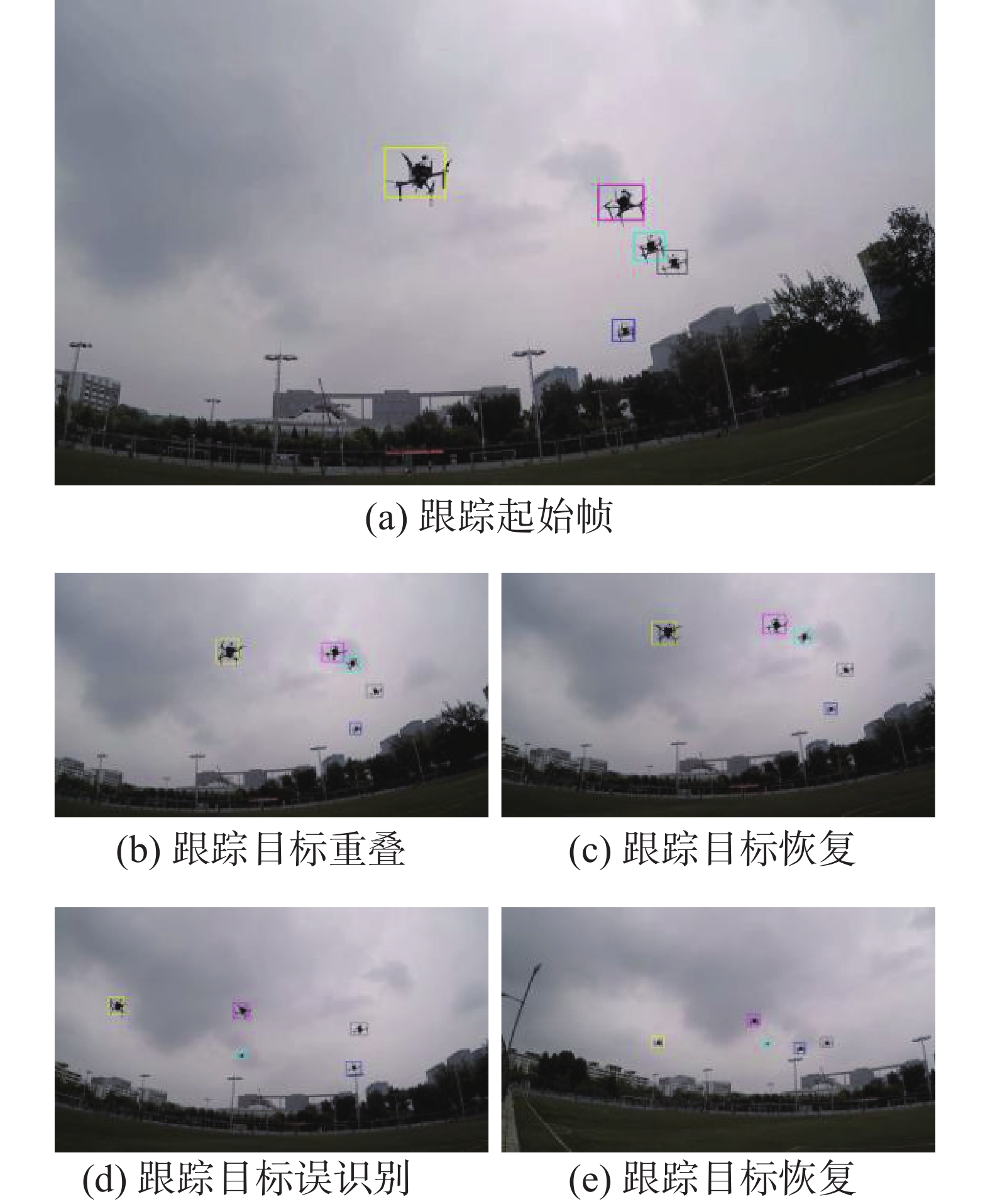

此外,由于本方法同样适用于多目标跟踪问题,针对自主空中加油过程中的伙伴加油问题,测试了本方法对于多目标的跟踪情况,结果如图6所示。

|

Download:

|

| 图 6 目标跟踪结果示意图 Fig. 6 Result of multi target tracking | |

图像序列中共存在5架无人机,图6(a)为跟踪的起始帧,图6(b)中存在两个目标的重合,此时跟踪过程产生了一定误差,当两个无人机在图像中分离后,可以重新实现对两个目标的跟踪,如图6(c)所示。图6(d)所示,无人机的位置与背景中其他物体接近产生误识别后,仍可以在目标与背景位置分割开后实现重新跟踪,如图6(e)。多目标跟踪的误差曲线如图7所示。

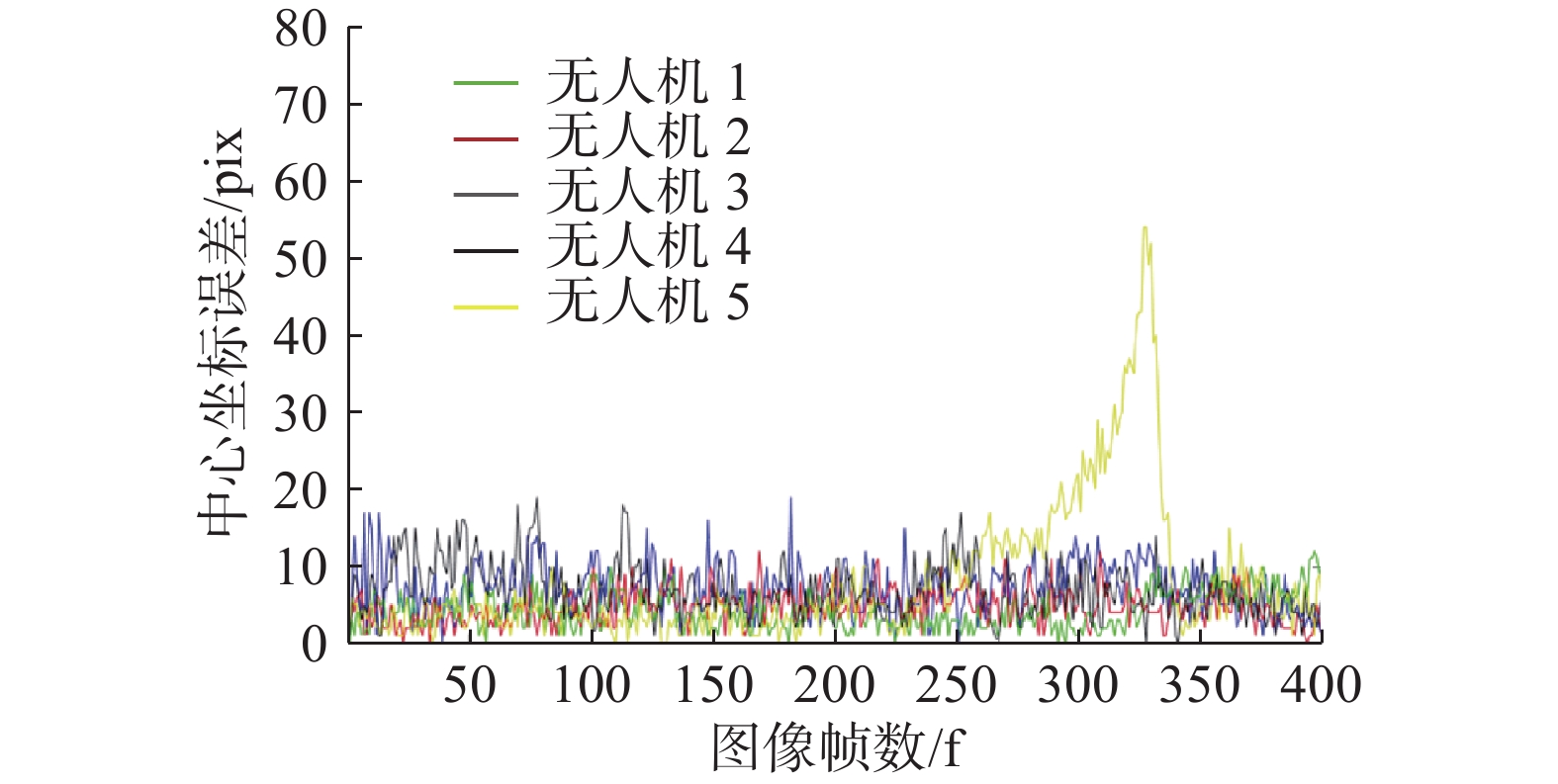

图7中视频序列中5架无人机均保持在图像中。从多目标跟踪误差结果曲线可以看出,在跟踪过程中,存在同背景混淆而造成的误识别导致对无人机5的跟踪产生较大误差,此外整个跟踪过程中的跟踪误差都较小,基本维持在20个像素左右,跟踪效果较好。使用NVIDIA 1080Ti的GPU,i7-8700k的CPU进行5个目标的跟踪任务时,处理速度可达45 f/s。

|

Download:

|

| 图 7 多目标跟踪误差曲线 Fig. 7 Curve of multi target tracking error | |

猛禽视觉系统作为其最强大的感知系统,能够处理很多相对复杂的视觉信息,猛禽获取周围物体的颜色和形状等属性、物体的位置和物体之间的相对位置关系以及发现并稳定跟踪目标的机制,可以为解决自主空中加油过程中的相关任务提供部分思路。

本文对猛禽视觉通路中的一个环节—视顶盖的信息整合与交互处理进行了模拟,并根据其双凹与眼动的视觉特性建立了较为简单的神经网络用于目标跟踪。模拟自主空中加油系统中的视觉导引阶段进行了测试,验证了本文所述方法对于受油目标跟踪的有效性,特别是对于长时跟踪任务可能出现的目标从场景中丢失与再入环节,本文所述方法具有一定的优越性。由于本算法的计算速度较快,图像处理帧率较高,对于跟踪过程中出现的跟踪位置误差问题,还可以考虑通过增加图像采集帧率减小两帧之间目标运动距离的方式解决。

| [1] |

杨戈, 刘宏. 视觉跟踪算法综述[J]. 智能系统学报, 2010, 5(2): 95-105. YANG Ge, LIU Hong. Survey of visual tracking algorithms[J]. CAAI transactions on intelligent systems, 2010, 5(2): 95-105. DOI:10.3969/j.issn.1673-4785.2010.02.001 (  0) 0)

|

| [2] |

赵国治, 段海滨. 仿鹰眼视觉技术研究进展[J]. 中国科学: 技术科学, 2017, 47(5): 514-523. ZHAO Guozhi, DUAN Haibin. Progresses in biological eagle-eye vision technology[J]. Scientia sinica technologica, 2017, 47(5): 514-523. (  0) 0)

|

| [3] |

DENG Yimin, DUAN Haibin. Biological eagle-eye-based visual platform for target detection[J]. IEEE transactions on aerospace and electronic systems, 2018, 54(6): 3125-3136. DOI:10.1109/TAES.2018.2845178 ( 0) 0)

|

| [4] |

DUAN Haibin, DENG Yimin, WANG Xiaohua, et al. Biological eagle-eye-based visual imaging guidance simulation platform for unmanned flying vehicles[J]. IEEE aerospace and electronic systems magazine, 2013, 28(12): 36-45. DOI:10.1109/MAES.2013.6693667 ( 0) 0)

|

| [5] |

段海滨, 张奇夫, 邓亦敏, 等. 基于仿鹰眼视觉的无人机自主空中加油[J]. 仪器仪表学报, 2014, 35(7): 1450-1458. DUAN Haibin, ZHANG Qifu, DENG Yimin, et al. Biologically eagle-eye-based autonomous aerial refueling for unmanned aerial vehicles[J]. Chinese journal of scientific instrument, 2014, 35(7): 1450-1458. (  0) 0)

|

| [6] |

TUCKER V A. The deep fovea, sideways vision and spiral flight paths in raptors[J]. Journal of experimental biology, 2000, 203(24): 3745-3754. ( 0) 0)

|

| [7] |

WATANABE S, MAYER U, BISCHOF H J. Visual wulst analyses " where” and entopallium analyses " what” in the zebra finch visual system[J]. Behavioural brain research, 2011, 222(1): 51-56. DOI:10.1016/j.bbr.2011.03.035 ( 0) 0)

|

| [8] |

HODOS W, KARTEN H J. Brightness and pattern discrimination deficits in the pigeon after lesions of nucleus rotundus[J]. Experimental brain research, 1966, 2(2): 151-167. DOI:10.1016/0006-8993(66)90020-5 ( 0) 0)

|

| [9] |

GLOROT X, BORDES A, BENGIO Y. Deep sparse rectifier neural networks[C]//Proceedings of the Fourteenth International Conference on Artificial Intelligence and Statistics. Lauderdale, USA, 2011: 315−323.

( 0) 0)

|

| [10] |

O'ROURKE C T, HALL M I, PITLIK T, et al. Hawk eyes I: diurnal raptors differ in visual fields and degree of eye movement[J]. PLoS one, 2010, 5(9): e12802. DOI:10.1371/journal.pone.0012802 ( 0) 0)

|

| [11] |

李晗, 段海滨, 李淑宇. 猛禽视觉研究新进展[J]. 科技导报, 2018, 36(17): 52-67. LI Han, DUAN Haibin, LI Shuyu. New progress of the visual system in birds of prey[J]. Science & technology review, 2018, 36(17): 52-67. (  0) 0)

|

| [12] |

NEUBECK A, VAN GOOL L. Efficient non-maximum suppression[C]//Proceedings of the 18th International Conference on Pattern Recognition. Hong Kong, China, 2006: 850−855.

( 0) 0)

|

| [13] |

KRISTAN M, LEONARDIS A, MATAS J, et al. The visual object tracking VOT2017 challenge results[C]//Proceedings of the IEEE International Conference on Computer Vision Workshops. Venice, Italy, 2017: 1949−1972.

( 0) 0)

|

| [14] |

YUN S, CHOI J, YOO Y, et al. Action-decision networks for visual tracking with deep reinforcement learning[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 1349−1358.

( 0) 0)

|

| [15] |

WANG Naiyan, YEUNG D Y. Learning a deep compact image representation for visual tracking[C]//Proceedings of the 26th International Conference on Neural Information Processing Systems. Lake Tahoe, USA, 2013: 809−817.

( 0) 0)

|

| [16] |

BERTINETTO L, VALMADRE J, GOLODETZ S, et al. Staple: complementary learners for real-time tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA, 2016: 1401−1409.

( 0) 0)

|

| [17] |

BERTINETTO L, VALMADRE J, HENRIQUES J F, et al. Fully-convolutional Siamese networks for object tracking[C]//Proceedings of European Conference on Computer Vision. Amsterdam, The Netherlands, 2016: 850−865.

( 0) 0)

|

2019, Vol. 14

2019, Vol. 14