基于表示的分类(representation based classification,RBC)方法通过训练样本来近似表示查询样本,进而对查询样本进行分类[1]。在RBC框架中,如何准确地计算查询样本和每个类之间的相似性,对查询样本的表示和分类起着重要的作用[2]。一般地,RBC方法可以分为基于

在RBC方法中,表示系数可以用来描述样本之间的相似性[5-10],在设计分类器时可直接采用这些表示系数[5-7]。例如,基于线性重构度量的最近邻(linear reconstruction measure nearest neighbor,LRMNN)分类[5]使用

虽然基于表示系数的分类方法在许多实际的人脸识别任务中表现良好,但其分类性能会受到人脸图像变化的显著影响[2],且有些没有考虑过程中数据非平衡的问题[14]。为了进一步提高对人脸图像的分类性能,本文提出了一种基于

本节主要回顾已有的一些RBC方法。给定训练样本

一般的线性重构度量(LRM)问题可表示为

| $\mathop {{{\min}} }\limits_{{s}} \left\| {{{y}} - {{Xs}}} \right\|_2^2$ | (1) |

式中:

| $\mathop {{{\min}} }\limits_{{s}} \left\| {{{y}} - {{Xs}}} \right\|_2^2 + \lambda {\left\| {{s}} \right\|_p}$ | (2) |

式中 :

| ${\hat{{s}}} = {({{{X}}^{\rm{T}}}{{X}} + {\rm{\lambda }}{{I}})^{ - 1}}{{{X}}^{\rm{T}}}{{y}}$ | (3) |

基于表示系数的相似性度量在分类中表现良好[5-6, 8]。如果一个训练样本

| $c = {\rm{arg ma}}{{\rm{x}}_{{{{c}}_i}}}\left\| {{{{\hat{{s}}}}_i}} \right\|$ | (4) |

式中 :

SRC使用

| $c = {\rm{arg ma}}{{\rm{x}}_{{{{c}}_i}}}\sum {{\delta ^{{{{c}}_i}}}} ({\hat{{s}}})$ | (5) |

式中

TPLRMC方法[7]分为两个阶段。首先,利用正则化LRM模型获得查询样本的一个粗略的线性表示,并根据系数的大小依次从所有的训练样本中选择

其次,利用先前选出的

| $\mathop {{{{\rm{min}}}} }\limits_{{s}} \left\| {{{y}} - {{{{\bar X}}s}}} \right\|_2^2 + \lambda {\left\| {{s}} \right\|_p}$ | (6) |

设式(6)的最优解为

根据TPLRMC的思想,利用同类样本表示系数之和(以下称其为类系数)按由大到小的选择策略,经过对查询样本近邻类的多次选择,逐渐缩小训练样本范围,提出一种自适应多阶段线性重构表示的分类(MPRBC)方法。

2.1 MPRBC的基本思想在SRC[3]和TPTSR[4]中,根据训练样本与查询样本之间的残差来对给定查询样本进行分类或选择近邻,是不够准确的[5-7]。这是因为残差只能反映训练样本与查询样本的相似度,而不能反映训练样本对查询样本重构的贡献大小和贡献的正负属性。

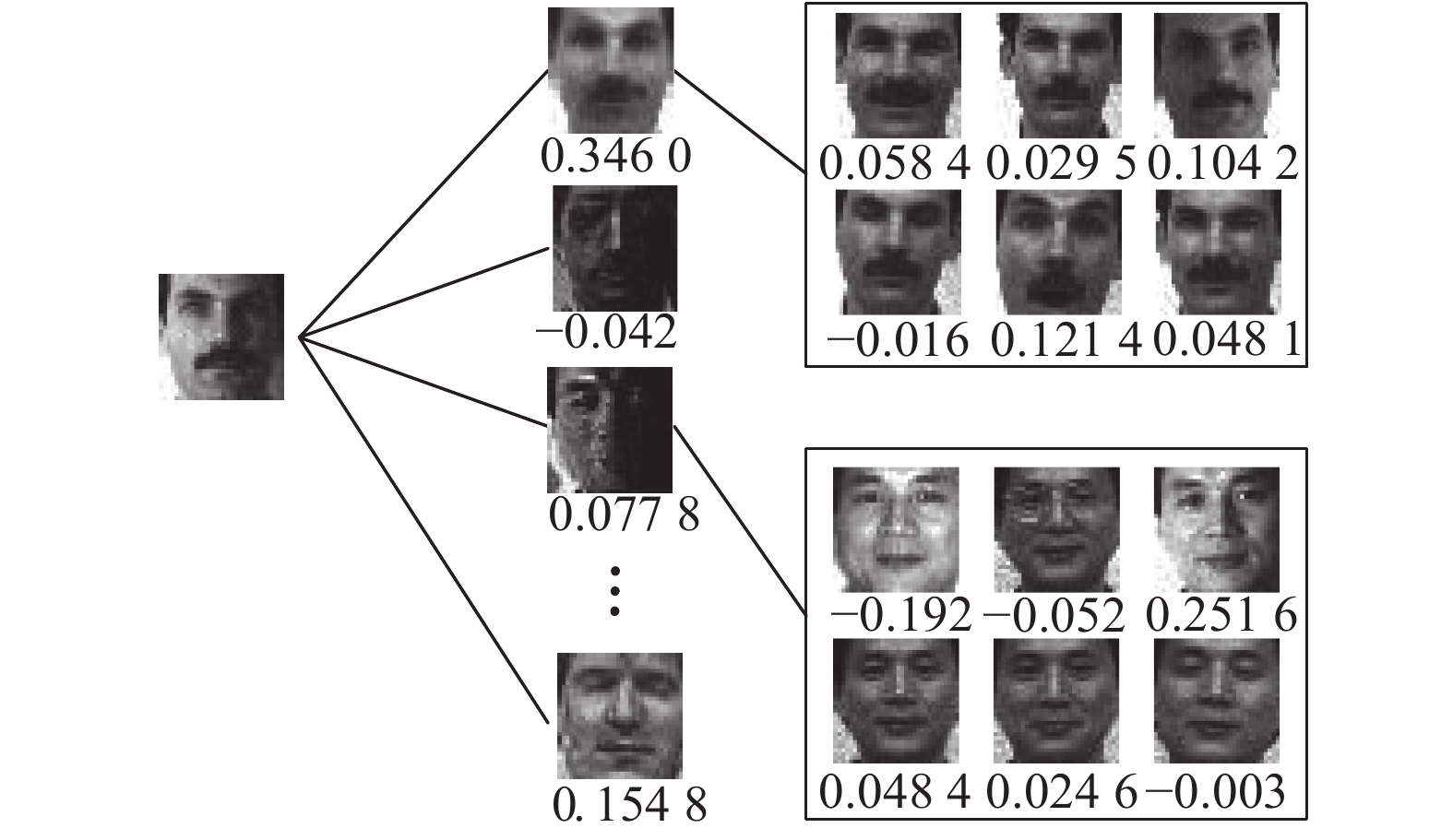

相比利用残差进行分类,直接通过表示系数进行分类,能很好地还原样本之间的关系,且易于实现。LRMNN正是基于此进行分类的,但其也有一定的局限性。例如,当各训练样本的表示系数比较平均时,LRMNN分类的准确性将显著下降。图1给出了重构查询样本时各训练样本的表示系数,由图可见,与查询样本同类的训练样本系数相对比较平均,而最大的表示系数(0.251 6)所对应的训练样本与查询样本是非同类的,此时通过LRMNN算法将得到错误的分类结果。

|

Download:

|

| 图 1 部分训练样本表示系数 Fig. 1 Representation coefficients of some training samples | |

若利用类系数则可得到同类训练样本对重构查询样本的总贡献。在图1中,与查询样本同类的训练样本系数之和(0.3460)最大。此时,利用同类中训练样本做整体协同表示,可以捕捉到更多的变化,其表示能力比单个样本要强,这有利于对查询样本进行正确分类。该思想类似于集成学习中投票的方法,它充分利用了训练样本的类别信息[7],并且可以抵消表示系数较平均时产生的影响,筛选掉系数有较大方差的类,保留的样本数据具有平衡性的特点[14]。但是在类别数较多的数据集上,由于类基数较大,且不同类别训练样本的类系数之间的差异不太明显,这些都会影响分类的精度。

运用TPLRMC算法选择近邻样本之后再进行重构表示的思想,本文使用了多阶段的方法,在每一阶段,利用查询样本重构后类系数的大小,筛选出与查询样本相似类别的所有训练样本,这也是熵减小理论的体现[15]。随着过程的进行,选出的训练样本将集中在少数几类中,这样使得类别之间贡献的区分度更加明显,从而提高了分类精度。以Yale人脸数据集为例,从每一类中选出6张图片作为训练样本,而查询样本来自第15类,通过

|

Download:

|

| 图 2 不同算法的残差或(类)系数 Fig. 2 Residuals or (class) coefficients of different algorithms | |

记在第k阶段训练样本集为

| $\mathop {{\rm{min}}}\limits_{{s}} \left\| {{{y}} - {{{X}}_k}{{s}}} \right\|_2^2 + {\rm{\lambda }}{\left\| {{s}} \right\|_p}$ | (7) |

设式(7)的最优解为

| $c = {\rm{arg ma}}{{\rm{x}}_{{{{c}}_i}}}\sum {{\delta ^{{{{c}}_i}}}} ({{{s}}_k})$ | (8) |

式中:

不同于以往的两阶段算法[4, 11]和多阶段算法[15]需要人为确定选取样本的数目,MPRBC算法可根据类系数的大小自适应地选取样本类别的数目。在前文中已经分析,类系数的大小可以较准确地反映该类对重构查询样本的贡献。当类系数为正时,表示该类对查询样本有正面影响,当类系数为负时,表示该类对查询样本有负面影响。在每一阶段中只选取类系数为正的类进入到下一阶段。

在算法中有两个参数

| ${M_k} = \mathop {\arg \max }\limits_{1 \leqslant M \leqslant {M_{k - 1}}} \left( {\sum_{i = 1}^M {{\rm{SU}}{{\rm{M}}^{{{{c}}_i}}} < } \alpha \times {\rm{SU}}{{\rm{M}}^{{{{c}}^ + }}}} \right)$ | (9) |

式中:

算法1 MPRBC算法

输入 训练样本集

输出 查询样本

1) While

2) 根据式(9)确定

3) 选取与前

4)

5) End while;

6) 根据式(8)确定查询样本

为了验证所提出的自适应多阶段线性重构表示的分类(MPRBC)方法的有效性,选择6个人脸数据集进行实验,各数据集的规模和特征如表1所示。将MPRBC算法的分类精度与RBC方法(如LRMNN(p=1,p=2)[5]、SoC(p=1) [7]、SoC(p=2)、TPLRMC(p=1,p=2)[11])进行比较。对每个数据集,从每类中随机选取

| 表 1 各人脸数据集的属性及特点 Tab.1 Attributes and characteristics of some face databases |

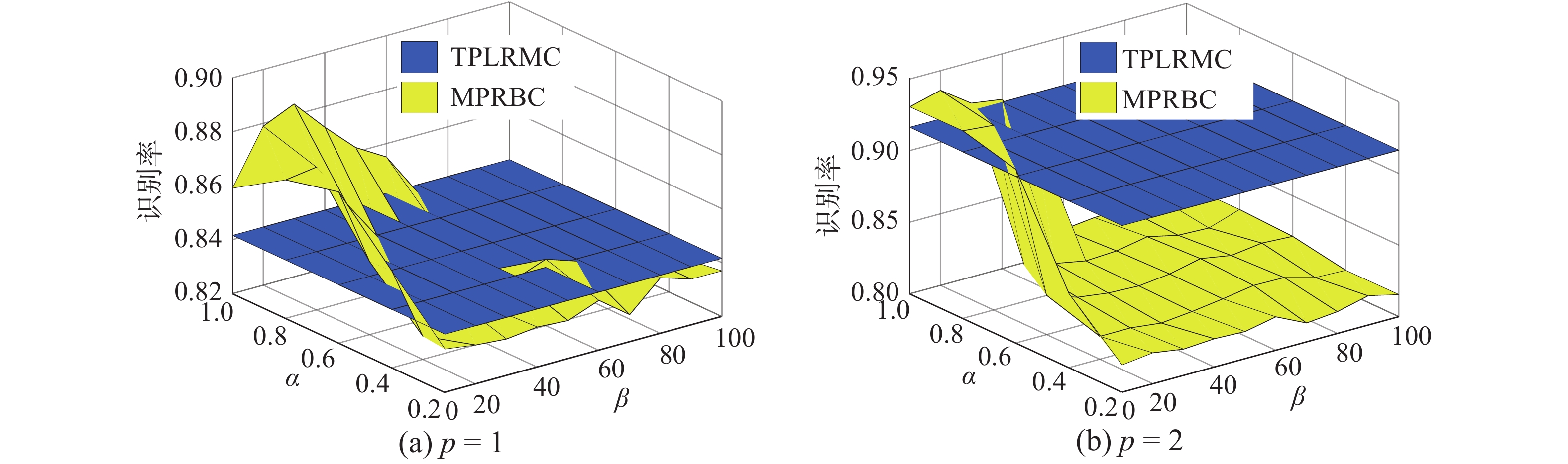

图3给出了在AR数据集上参数

|

Download:

|

| 图 3 AR人脸数据集上的识别率 Fig. 3 Recognition rates on AR face database | |

|

Download:

|

| 图 4 参数α的影响 Fig. 4 Influence of parameter α | |

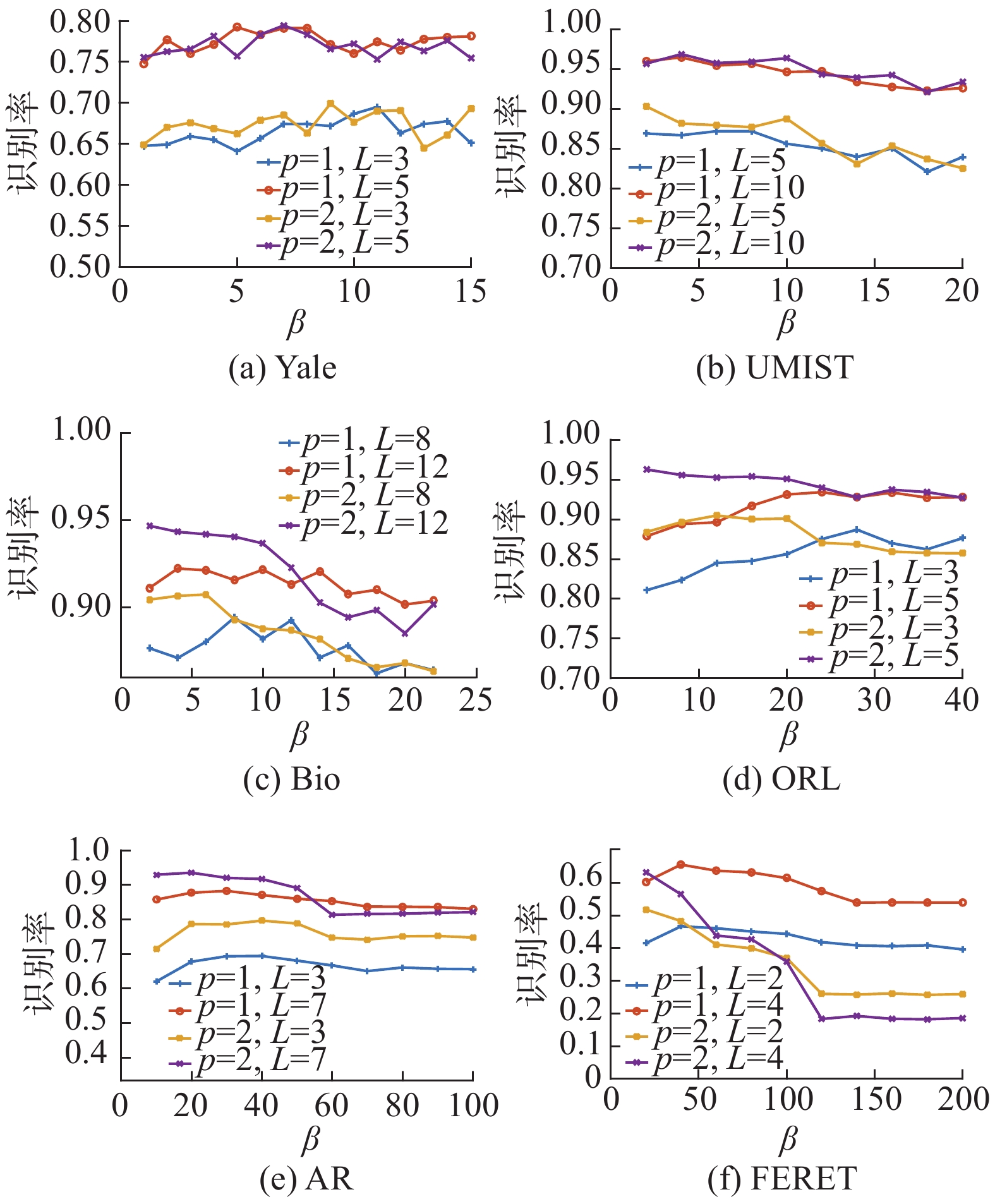

表2给出了MPRBC与其他算法识别精度的比较(MPRBC算法的识别精度由图5中的最高精度确定)。在所有数据集上,MPRBC算法均具有最好的识别性能。SoC算法要比LRMNN算法性能要好,这是因为SoC算法利用了样本的标签,通过同类样本进行协同表示,是一种有监督的算法,而LRMNN算法只考虑单个样本表示的作用。因此根据类系数来进行分类能提高分类精度,这也从侧面说明MPRBC筛选相似类的策略比TPLRMC筛选相似样本的策略更能提高分类性能。另外,SoC算法通过一阶段和TPLRMC算法通过两阶段筛选近邻样本并进行分类,其本质上是一种粗糙的筛选方法,且对于不同的查询样本,选择近邻的个数没有差异性。而MPRBC算法通过多阶段进行近邻类的筛选,是一种精细的筛选方法,且根据查询样本的不同,近邻类的筛选具有差异性。比较MPRBC算法、SoC算法和TPLRMC算法在各数据集上的实验结果,可以观察到多阶段比一阶段和二阶段更能提高分类精度,并且随着数据集样本类别数的增多其分类精度均有明显地提高。

| 表 2 各人脸数据集上的识别精度 Tab.2 Recognition accuracy of some face databases |

|

Download:

|

| 图 5 MPRBC算法在各人脸数据集上的识别率 Fig. 5 Recognition rates of MPRBC on some face databases | |

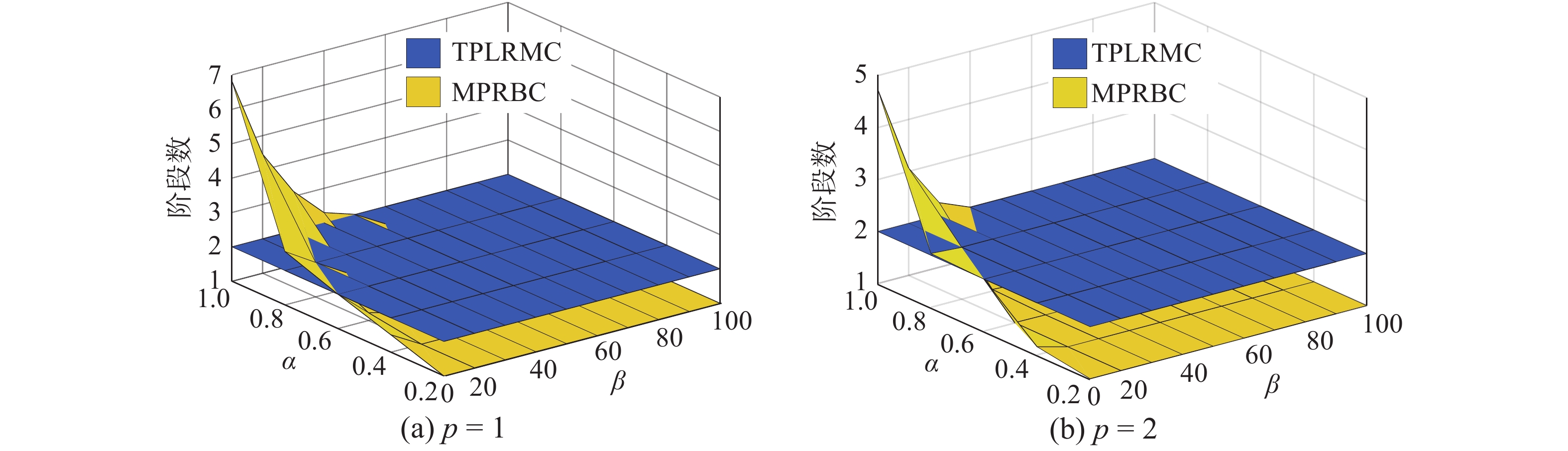

对于每一个查询样本,MPRBC与TPLRMC算法均通过

|

Download:

|

| 图 6 MPRBC的阶段数 Fig. 6 Phase number of MPRBC | |

|

Download:

|

| 图 7 MPRBC各阶段训练样本总数 Fig. 7 Total number of training samples of MPRBC at each stage | |

|

Download:

|

| 图 8 MPRBC的CPU时间 Fig. 8 CPU times of MPRBC | |

当

| 表 3 CPU时间 Tab.3 CPU times |

本文提出了一种自适应多段线性重构表示的分类(MPRBC)方法。基于熵减少原则,通过多阶段的方法,利用同类训练样本表示系数之和筛选样本,将分类集中在类别数较少的训练样本上,使得所选样本在具有较大重构贡献的同时保证了样本的稀疏类概率分布,达到了提高训练样本表示能力的目的。其次,算法拥有基于自适应的选择过程,能对不同查询样本进行差异化表示,并在部分数据集上减小了CPU时间。实验表明,该算法性能优于其他RBC算法,且在类别数较多的数据集上识别精度有明显的提升。

| [1] |

ZHANG Lei, YANG Meng, FENG Xiangchu. Sparse representation or collaborative representation: which helps face recognition[C]//Proceedings of the 2011 International Conference on Computer Vision. Barcelona, Spain, 2011: 471−478.

( 0) 0)

|

| [2] |

XU Yong, LI Xuelong, YANG Jian, et al. Integrating conventional and inverse representation for face recognition[J]. IEEE transactions on cybernetics, 2014, 44(10): 1738-1746. DOI:10.1109/TCYB.2013.2293391 ( 0) 0)

|

| [3] |

WRIGHT J, YANG A Y, GANESH A, et al. Robust face recognition via sparse representation[J]. IEEE transactions on pattern analysis and machine intelligence, 2009, 31(2): 210-227. DOI:10.1109/TPAMI.2008.79 ( 0) 0)

|

| [4] |

XU Yong, ZHANG D, YANG Jian, et al. A two-phase test sample sparse representation method for use with face recognition[J]. IEEE transactions on circuits and systems for video technology, 2011, 21(9): 1255-1262. DOI:10.1109/TCSVT.2011.2138790 ( 0) 0)

|

| [5] |

ZHANG Jian, YANG Jian. Linear reconstruction measure steered nearest neighbor classification framework[J]. Pattern recognition, 2014, 47(4): 1709-1720. DOI:10.1016/j.patcog.2013.10.018 ( 0) 0)

|

| [6] |

CHENG H, LIU Zicheng, HOU Lei, et al. Sparsity-induced similarity measure and its applications[J]. IEEE transactions on circuits and systems for video technology, 2016, 26(4): 613-626. DOI:10.1109/TCSVT.2012.2225911 ( 0) 0)

|

| [7] |

LI Jiang, LU Canyi. A new decision rule for sparse representation based classification for face recognition[J]. Neurocomputing, 2013, 116: 265-271. DOI:10.1016/j.neucom.2012.04.034 ( 0) 0)

|

| [8] |

GAO Shenghua, TSANG I W H, CHIA L T. Laplacian sparse coding, hypergraph laplacian sparse coding, and applications[J]. IEEE transactions on pattern analysis and machine intelligence, 2013, 35(1): 92-104. DOI:10.1109/TPAMI.2012.63 ( 0) 0)

|

| [9] |

QIAO Lishan, CHEN Songcan, TAN Xiaoyang. Sparsity preserving projections with applications to face recognition[J]. Pattern recognition, 2010, 43(1): 331-341. DOI:10.1016/j.patcog.2009.05.005 ( 0) 0)

|

| [10] |

MA Hongxing, GOU Jianping, WANG Xili, et al. Sparse coefficient-based k-nearest neighbor classification[J]. IEEE access, 2017, 5: 16618-16634. DOI:10.1109/ACCESS.2017.2739807 ( 0) 0)

|

| [11] |

GOU Jianping, XU Yong, ZHANG D, et al. Two-phase linear reconstruction measure-based classification for face recognition[J]. Information sciences, 2018, 433–434: 17-36. DOI:10.1016/j.ins.2017.12.025 ( 0) 0)

|

| [12] |

YAN Shuicheng, XU Dong, ZHANG Benyu, et al. Graph embedding and extensions: a general framework for dimensionality reduction[J]. IEEE transactions on pattern analysis and machine intelligence, 2007, 29(1): 40-51. DOI:10.1109/TPAMI.2007.250598 ( 0) 0)

|

| [13] |

FANG Xiaozhao, XU Yong, LI Xuelong, et al. Learning a nonnegative sparse graph for linear regression[J]. IEEE transactions on image processing, 2015, 24(9): 2760-2771. DOI:10.1109/TIP.2015.2425545 ( 0) 0)

|

| [14] |

叶志飞, 文益民, 吕宝粮. 不平衡分类问题研究综述[J]. 智能系统学报, 2009, 4(2): 148-156. YE Zhifei, WEN Yimin, LV Baoliang. A survey of imbalanced pattern classification problems[J]. CAAI transactions on intelligent systems, 2009, 4(2): 148-156. (  0) 0)

|

| [15] |

LIU Fan, TANG Jinhui, SONG Yan, et al. Local structure based multi-phase collaborative representation for face recognition with single sample per person[J]. Information sciences, 2016, 346–347: 198-215. DOI:10.1016/j.ins.2016.02.001 ( 0) 0)

|

| [16] |

QIAN J B. data[EB/OL]. Github, 2019 (2019−05−30) [2019−05]. https://github.com/greatQntgz/MPRBC

( 0) 0)

|

2020, Vol. 15

2020, Vol. 15