2. 中国科学院大学 未来技术学院,北京 100089;

3. 中国科学院 脑科学与智能技术卓越创新中心,上海 200031;

4. 半导体神经网络智能感知与计算技术北京市重点实验室,北京 100083

2. School of Future Technology, University of Chinese Academy of Sciences, Beijing 100089, China;

3. Center for Excellence in Brain Science and Intelligence Technology, Chinese Academy of Sciences, Shanghai 200031, China;

4. Semiconductor Neural Network Intelligent Perception and Computing Technology Beijing Key Lab, Beijing 100083, China

作为计算机视觉领域基础的任务之一,显著性目标检测模拟人类能够分辨不同目标重要程度的视觉机制,提取出图像或视频中感兴趣的信息。利用这一视觉机制可以帮助找到图片中代表场景语义的重要目标或区域,而被广泛应用于图像理解[1]、场景解析[2]、目标追踪[3]等各类计算机视觉任务。显著性目标检测任务一般包含2个步骤:1) 检测出图像或视频中的显著目标;2) 准确地分割出目标的区域。优秀的模型应当能够准确地检测和分割出显著目标,以最大化地保留原始图片信息。同时,作为其他算法的预处理过程,显著性目标检测模型的复杂度需要尽可能的低,从而提高计算效率。

在显著性目标检测任务的发展历史中,首先被提出的是自下而上的计算模型[4-6],将任务定义为寻找图像中的视觉注视点。人的注意力通常会被对比度、颜色和边缘等特征吸引,因此基于中心-周围机制就可以由低级特征计算出视觉注视点。这些方法通常包括3个步骤:1)提取多种低级视觉特征;2)计算显著图;3)检测少数关键点,从中找出视觉注视点。由于缺乏对图片全文信息的利用,单纯依靠低级特征难以在复杂图片中检测出显著目标。为了改进自下而上的计算模型的不足,科研人员提出基于学习的检测方法,引入高级视觉特征如语义一致性来判断目标的显著性。Liu等[7]将显著性目标检测任务定义为二元检测问题,使用类别边框来标记显著目标,建立了第一个大规模图像数据集。对于基于学习的检测方法,算法的关键在于如何从数据中有效地学习出显著目标与背景之间的语义关系。由于提取高级和多尺度特征的能力,卷积神经网络(convolutional neural network, CNN)[8]消除了对手工提取特征的依赖,近年来被广泛应用于各种计算机视觉任务中。基于CNN的显著性目标检测方法相比传统方法具有更加优异的性能,已成为了主流研究方向。Long等[9]提出全卷积神经网络模型(fully convolutional network, FCN),端到端地解决了语义分割问题。如果将显著性目标检测视为二元密集预测任务,则可以使用FCN在数据集上端到端地训练,标记图片中每个像素点的显著性预测结果。如何进一步地提高CNN的网络性能,就成为了显著性目标检测领域的研究热点所在。

CNN通过堆叠卷积层来对图像进行多层级的视觉抽象,较低的卷积层提取例如边缘、角等低级特征,较高的卷积层提取高级语义模式。各级特征图包含了空间上和通道上的信息,但由于卷积核的尺寸限制,往往只有局部的信息得到利用。此外,多级池化操作导致提取特征图分辨率较低,缺乏局部区域的细节特征,无法准确地分割显著目标边缘等细节。针对上述问题,本文提出了一种基于注意力机制的显著性目标检测方法,引入注意力精炼模块来改进网络结构,提高网络对特征图中空间与通道上信息的利用能力,并对低层与高层特征进行融合。在主流的显著性目标检测数据集上进行对比,结果表明本文方法效果优于同类方法。

1 相关工作 1.1 显著性目标检测网络得益于多层级和多尺度特征的提取能力,CNN无需任何先验知识即可检测出显著目标,能够更好地定位目标的边缘实现精准分割。He等[10]使用一维卷积和池化层学习基于区域的超像素特征,计算出各个区域的显著性。Wang等[11]设计2个子网络来单独对低级与高级特征编码,并对2个子网络提取的特征进行拼接,使用2层的多层感知器来判断图像中每个区域的显著性。Wang等[12]设计了基于图像掩模的多尺度R-CNN框架计算各个区域的显著性,使用低级特征对照和背景先验来补充语义特征,同时利用超像素信息来精修目标边缘分割结果。上述几种方法高度依赖分割级的区域信息例如超像素、感兴趣区(region of interest)等,使用图像分类网络来决定每个像素块的显著性。同时由于网络存在最后的全连接层,空间信息和高级语义特征无法得到有效利用,导致全局信息损失。而基于FCN的方法则通过像素级的操作避免了使用全连接层所带来的不足,克服了显著目标边缘检测模糊与不准确的问题。Wang等[13]设计了递归全卷积网络结构,并引入低级参照特征和中心先验知识作为显著性先验图到训练和预测过程中。Liu等[14]提出了DHSNet,在GV-CNN网络输出的全局显著图后,加入分层递归网络来精修显著图。为了避免多级池化造成特征图分辨率较低的问题,Wang等[15]设计金字塔池化模块和多阶段提炼机制来改进网络结构。这些方法改进了传统FCN方法的不足,考虑了全局信息和局部信息的整合,逐层级利用特征图来精修目标边缘等细节。这说明利用像素间的相关信息,对不同尺度的特征进行融合能有效地改善网络性能,取得更好的预测结果。

1.2 注意力机制为了合理利用有限的视觉信息处理能力,人类需要选择整个视觉区域中特定的部分来集中关注,这一机制称为注意力机制[16]。视觉的注意力机制在人类处理复杂的场景信息时起到了至关重要的作用。当面对一个复杂场景时,人类首先快速地浏览场景中的全部内容,利用全局的空间信息寻找场景中最重要的部分。然后集中注意力针对这一部分进行深度感知,实现对场景视觉结构的理解。这一机制可以引入到卷积层对输入信息进行编码输出特征图的过程中。如果卷积层的输入图像尺寸为

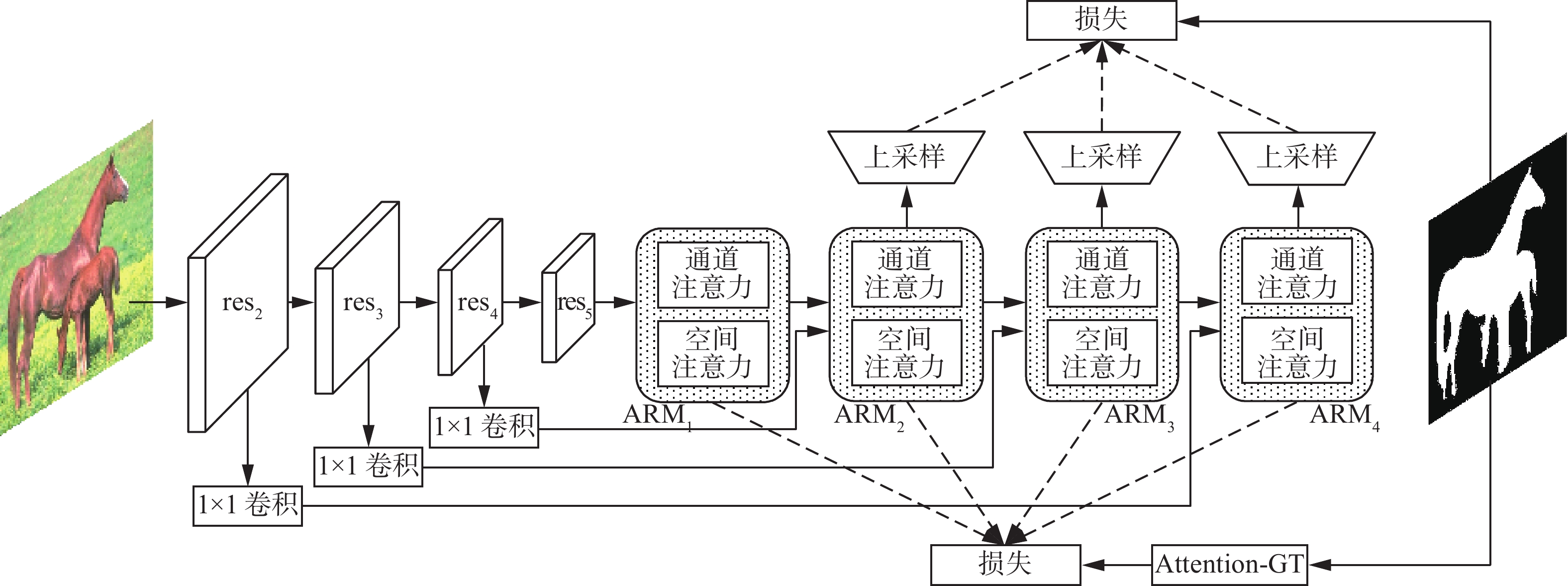

本文在ResNet-50网络[20]的基础上,加入注意力精炼模块(attention refinement module,ARM),网络结构如图1所示。将4个注意力精炼模块逐级相连,上一级的输出与ResNet-50的特征图拼接,作为下一级模块的输入。通过对特征图的多级精炼,融合高级和低级特征精修网络预测显著图的细节。图1中的实线箭头代表着模块输出作为下一级的输入,虚线箭头代表模块的输出用于计算损失训练网络。

|

Download:

|

| 图 1 网络结构 Fig. 1 Network structure | |

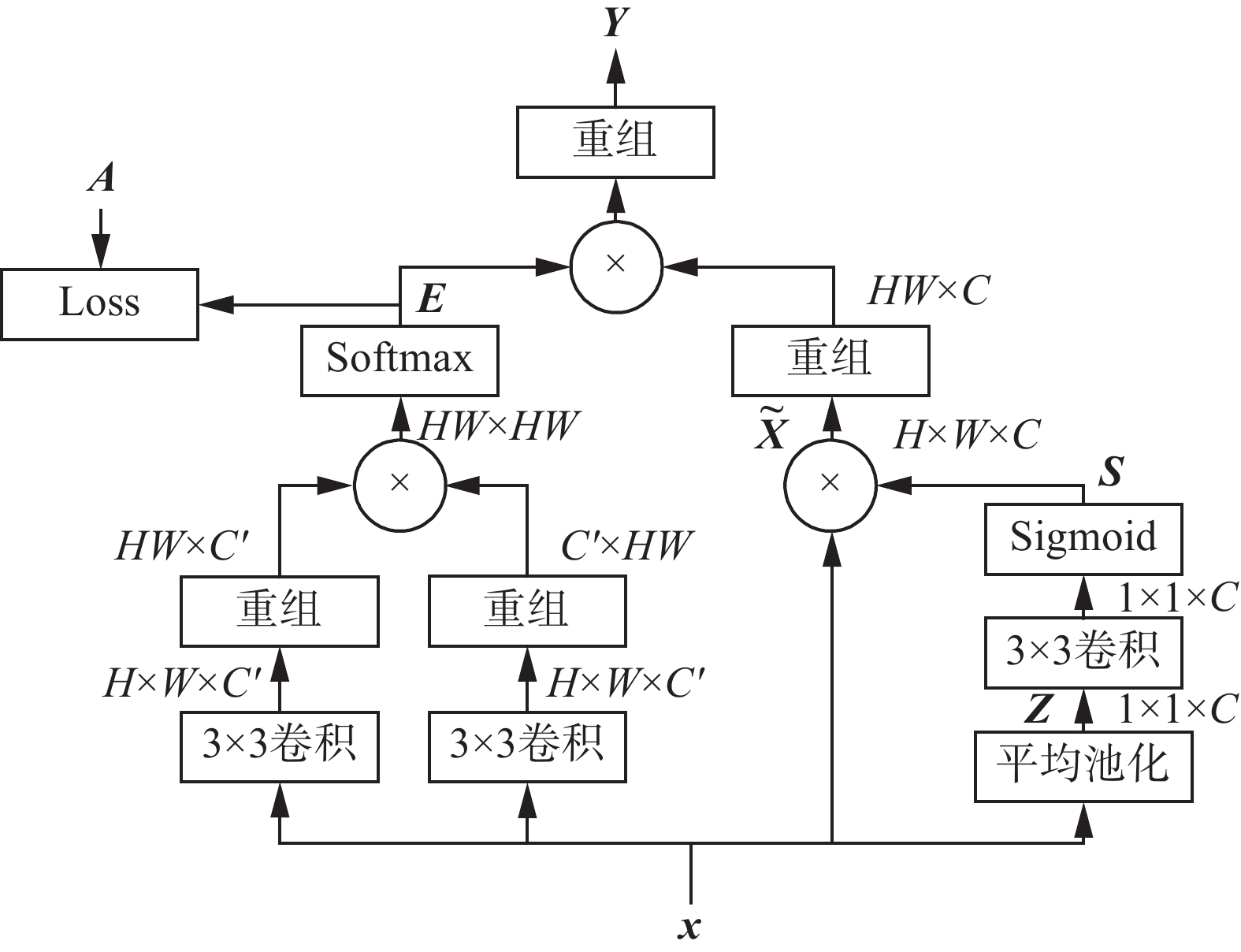

图2为本文的注意力精炼模块,用于处理ResNet-50提取的特征图。注意力精炼模块能够引导网络针对性地处理各个通道上的信息,集中关注空间上更有意义的部分。在网络较低的卷积层中,受限于感受野大小,往往无法利用感受野之外的上下文信息。因此使用全局均匀池化(global average pooling)来得到各个通道上的统计量

| ${z_c} = \frac{1}{{H \times W}}\sum\limits_{i = 1}^H {\sum\limits_{j = 1}^W {{x_c}(i,j)} } $ | (1) |

式中xc(i, j)为在第

|

Download:

|

| 图 2 注意力精炼模块示意 Fig. 2 Attention refinement module | |

对特征图的通道信息整合后,需要基于通道统计量

| ${{s}}{\rm{ = }}\sigma {\rm{(}}{{{W}}_{{1}}}z{\rm{)}}$ | (2) |

式中:

| ${{\tilde {{x}}}_c} = {{{s}}_c}{{{x}}_c}$ | (3) |

式中:

进一步,参考文献[20]中非局部操作(non-local operation),考虑特征图上其他像素对某像素的影响,以此得到空间注意力特征。如果输入特征图

| ${{{y}}_i} = \frac{1}{{C(x)}}\sum\limits_{\forall j} {f({x_i}} ,{x_j})g({x_j})$ | (4) |

式中:

| ${A_{ij}}{\rm{ = }}\left\{ {\begin{array}{*{20}{c}} {1,}&{i,j \in T} \\ {0,}&{i,j \notin T} \end{array}} \right.$ | (5) |

式中:(i, j)为特征图上某个像素的坐标;

通过上述操作,使得网络能够根据输入

为了整合低级和高级特征,把注意力精炼模块与ResNet-50的输出特征图逐级相连,网络结构如图1所示。使用的ResNet-50结构与文献[21]中一致,其最后一级特征图res5是输入图像的32倍下采样。将其输入到ARM1模块,得到输出精炼特征图arm1,接着对arm1进行2倍上采样,使其尺寸与res4特征图相同。

为了将低层特征与高层特征融合,使用res4特征图和ARM2模块对arm1特征图进一步精炼。首先使用1×1卷积层将res4特征图通道数压缩到256,然后与arm1进行拼接,将其作为ARM2模块的输入,得到输出精炼特征图arm2。重复这一步骤,进一步整合res3和res2特征图,产生arm3和arm4精炼特征图。这样,实现了低级和高级特征的融合,使用底层特征优化富有语义信息的高层特征,对预测显著图进行了多级精修。

2.3 损失函数计算把相关矩阵

| ${\ell _k} = {\sum\limits_{i,j} {({E_k}(i,j) - A(i,j))} ^2}$ | (6) |

式中,

对arm2、arm3、arm4精炼特征图分别进行16倍、8倍和4倍上采样,如图1中所示,使用Sigmoid计算每级预测显著图

| ${P_n} = {\rm{Sigmoid}}({{\rm arm}_n})$ | (7) |

选择交叉熵损失函数计算第n模块的

| $\begin{array}{l} {\ell _n} = - \displaystyle\sum\limits_{i,j} {\left[ {{G_n}(i,j) = 1} \right]} \log ({P_n}(i,j))+ \\ \;\;\;\;\; \left[ {{G_n}(i,j) = 0} \right]\log (1 - {P_n}(i,j)) \end{array} $ | (8) |

式中

| ${\rm{Loss}} = \sum\limits_{n = 2}^4 {{\ell _n}} + \sum\limits_{k = 1}^4 {{\ell _k}} $ | (9) |

这样深度监督的训练策略可以使得网络的训练过程更容易收敛,降低训练所需的时间。

3 实验与结果 3.1 实验数据集目前主流的显著性目标检测数据集包括MSRA10K[22]、DUT-OMRON[23]和ECSSD[24]等。这些数据集都包含大量的图片,并且样本分布广泛(动物、植物和生活物体等),因此被当前显著性目标检测算法用于效果对比中。MSRA10K数据集包含10000张图片,本文选用其作为模型的训练集。DUT-OMRON数据集包含5158张拥有复杂背景的图片,考验模型检测内容复杂场景的能力。ECSSD数据集包含1000张不同尺寸目标的复杂图像。本文选择DUT-OMRON和ECSSD数据集作为测试集,对比本文模型与其他模型的效果。

3.2 网络训练本文选择“MXNET”深度学习框架,在2块Titan Xp Pascal GPU上进行网络的训练和测试。首先将MSRA10K训练集中的图片填充到416×416的大小,然后进行原尺寸2/3到3/2之间的随机尺度放缩。最后将图片随机裁剪到416×416像素,减去像素均值,送入网络中进行训练。

本文使用在ImageNet数据集[25]上训练的ResNet-50模型作为网络的初始权重,再在MSRA10K数据集上进行微调(finetune)。本文选择带有冲量(momentum)的随机梯度下降(stochastic gradient descent)作为梯度更新算法,使用文献[26]中的“Poly”学习率调整策略。mini-batch的值设置为16,训练共45000个迭代。基准学习率设置为0.01,下降率指数为0.9。设置冲量值为0.9,权重衰减0.0001。

3.3 评价标准本文使用平均绝对误差(MAE)和F-measure值来评价算法在数据集上的测试结果。MAE定义为输出预测结果

| ${\rm{MAE}} = \frac{1}{{HW}}\sum\limits_{x = 1}^H {\sum\limits_{y = 1}^W {\left| {P(x,y) - G(x,y)} \right|} } $ | (10) |

式中

F-measure是对算法的综合评价指标:

| ${F_\beta } = \frac{{(1 + {\beta ^2}) \cdot {P} \cdot {R}}}{{{\beta ^2} \cdot {P} + {R}}}$ | (11) |

式中:

对比本文方法和其他11种主流的显著性目标检测方法,包括SRM[15]、DRFI[28]、BL[29]、LEGS[11]、MDF[30]、MCDL[31]、DS[32]、DHS[14]、ELD[33]、DCL[34]、KSR[35]和RFCN[13]。使用作者文章中方法和参数设置训练网络,测试得到显著图或者直接使用其提供的显著图,再根据显著图计算在不同测试集上的结果,如表1所示。

| 表 1 本文方法与其他方法效果的对比 Tab.1 Comparison between our method and the others on performance |

从表1可以看到,本文方法表现好过当前主流的显著性检测方法。对于F-measure指标,本文在DUT-OMRON和ECSSD数据集上分别超过表现最佳的SRM方法0.013和0.014。同样,对于MAE指标,本文分别超过SRM方法0.005和0.007。

为了研究注意力精炼模块的效果,在ECSSD数据集上测试了网络处于不同多尺度特征融合阶段时的表现,结果如表2所示。表2中Baseline代表直接使用res5特征图进行32倍上采样得到显著图。可以看到,随着多尺度特征的融合,注意力精炼模块大幅度地提升了网络的表现,F-measure指标提高了0.057,MAE指标降低了接近一半到达了0.049。如图3所示,在ECSSD数据集上的预测结果图说明网络能够成功检测出植物、动物和人等显著目标,并对目标边缘进行准确分割。上述结果证明本文方法提高了网络对特征的利用能力,融合了多尺度的特征精修了预测结果,大幅度提高了网络的性能表现。

| 表 2 不同尺度融合阶段网络性能差异 Tab.2 Performance of our network in different stages |

|

Download:

|

| 图 3 在ECSSD数据集上的预测结果 Fig. 3 Predicted results on ECSSD dataset | |

为了分析本文提出的注意力精炼模块对通道注意力的整合效果,对比了文献[36]中的通道注意力模块(channel attention block)与本文方法在ECSSD数据集上测试的结果,结果如表3所示,其中CAB表示使用通道注意力模块整合通道上的信息,ARM表示使用本文的注意力精炼模块中的通道注意力对特征图进行精炼,而不使用空间注意力。ARM+AS表示使用训练样本真值图对只使用通道注意力的注意力精炼模块进行额外监督。结果可以发现,本文方法相较文章中的方法,F-measure指标提高了0.027,MAE指标降低了0.011,展示出更加优异的通道全局信息整合能力。

| 表 3 通道注意力精炼效果对比 Tab.3 Comparison on channel attention refinement performance |

进一步,对比其他文章中上下文提取模块方法,分析本文提出的注意力精炼模块对空间注意力特征的利用情况,如表4所示。其中DeepLab V2指文献[26]中提出的使用全连接的条件随机场来整合空间信息,PSP-Net为文献[37]中提出的特征金字塔方法,DeepLab V3[38]使用空洞卷积提高网络的感受野,提高网络对多尺度信息的获取能力。根据结果可以发现,本文方法相较性能最好的DeepLab V3方法提高了0.016的F-measure指标,降低了0.008的MAE指标,取得了更加优异的空间注意力精炼效果。

| 表 4 空间注意力精炼效果对比 Tab.4 Comparison on spatial attention refinement performance |

本文提出了一种基于注意力机制的显著性目标检测方法,设计注意力精炼模块融合通道和空间注意力,使得网络能够根据输入特征图选取其中重要的信息。使用训练样本的真值图有监督地训练空间注意力,提高了像素间相关关系的准确性。最后,本文将注意力精炼模块逐级连接,使用低级特征精修高级语义特征,修正预测显著图细节,实现了多尺度特征的融合。在MSRA10K数据集上训练模型后,在DUT-OMRON和ECSSD数据集上进行测试,并在ECSSD数据集上与其他主流通道和空间特征提取方法对比。实现结果表明,与目前主流的显著性目标检测方法相比,本文提出的方法能够更有效地精炼特征图上的通道和空间信息,因此取得了更加优异的效果。

| [1] |

ZHANG Fan, DU Bo, ZHANG Liangpei. Salien-cy-guided unsupervised feature learning for scene classi-fication[J]. IEEE transactions on geoscience and remote sensing, 2015, 53(4): 2175-2184. DOI:10.1109/TGRS.2014.2357078 ( 0) 0)

|

| [2] |

ITTI L, KOCH C, NIEBUR E. A model of saliency-based visual attention for rapid scene analysis[J]. IEEE transactions on pattern analysis and machine intelligence, 1998, 20(11): 1254-1259. DOI:10.1109/34.730558 ( 0) 0)

|

| [3] |

HONG S, YOU T, KWAK S, et al. Online tracking by learning discriminative saliency map with convolutional neural network[C]//Proceedings of the 32nd International Conference on International Conference on Machine Learning. Lille, France, 2015: 597−606.

( 0) 0)

|

| [4] |

TREISMAN A M, GELADE G. A feature-integration theory of attention[J]. Cognitive psychology, 1980, 12(1): 97-136. DOI:10.1016/0010-0285(80)90005-5 ( 0) 0)

|

| [5] |

KOCH C, ULLMAN S. Shifts in selective visual attention: towards the underlying neural circuitry[J]. Human neurobiology, 1985, 4(4): 219-227. ( 0) 0)

|

| [6] |

WOLFE J M, CAVE K R, FRANZEL S L. Guided search: an alternative to the feature integration model for visual search[J]. Journal of experimental psychology: human perception and performance, 1989, 15(3): 419-433. DOI:10.1037/0096-1523.15.3.419 ( 0) 0)

|

| [7] |

LIU Tie, SUN Jian, ZHENG Nanning, et al. Learning to detect a salient object[C]//Proceedings of 2007 IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis, USA, 2007: 1−8.

( 0) 0)

|

| [8] |

LECUN Y, BOTTOU L, BENGIO Y, et al. Gradi-ent-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324. DOI:10.1109/5.726791 ( 0) 0)

|

| [9] |

LONG J, SHELHAMER E, DARRELL T. Fully convo-lutional networks for semantic segmenta-tion[C]//Proceedings of 2015 IEEE Conference on Com-puter Vision and Pattern Recognition. Boston, USA, 2015: 3431−3440.

( 0) 0)

|

| [10] |

HE Shengfeng, LAU R W, LIU Wenxi, et al. Supercnn: a superpixelwise convolutional neural network for salient object detection[J]. International journal of computer vision, 2015, 115(3): 330-344. DOI:10.1007/s11263-015-0822-0 ( 0) 0)

|

| [11] |

WANG Lijun, LU Huchuan, RUAN Xiang, et al. Deep networks for saliency detection via local estimation and global search[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA, 2015: 3183−3192.

( 0) 0)

|

| [12] |

WANG Xiang, MA Huimin, CHEN Xiaozhi. Salient object detection via fast R-CNN and low-level cues[C]//Proceedings of 2016 IEEE International Con-ference on Image Processing (ICIP). Phoenix, USA, 2016: 1042−1046.

( 0) 0)

|

| [13] |

WANG Linzhao, WANG Lijun, LU Huchuan, et al. Sa-liency detection with recurrent fully convolutional net-works[C]//Proceedings of the 14th European Conference on Computer Vision. Amsterdam, the Netherlands, 2016: 825−841.

( 0) 0)

|

| [14] |

LIU Nian, HAN Junwei. Dhsnet: deep hierarchical sali-ency network for salient object detection[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 678−686.

( 0) 0)

|

| [15] |

WANG Tiantian, BORJI A, ZHANG Lihe, et al. A stagewise refinement model for detecting salient objects in images[C]//Proceedings of 2017 IEEE International Conference on Computer Vision. Venice, Italy, 2017: 4039−4048.

( 0) 0)

|

| [16] |

LAROCHELLE H, HINTON G. Learning to combine foveal glimpses with a third-order Boltzmann ma-chine[C]//Proceedings of the 23rd International Conference on Neural Information Processing Systems. Vancouver, Canada, 2010: 1243−1251.

( 0) 0)

|

| [17] |

FU Jianlong, ZHENG Heliang, MEI Tao. Look closer to see better: recurrent attention convolutional neural network for fine-grained image recognition[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, USA, 2017: 4476−4484.

( 0) 0)

|

| [18] |

CHEN Long, ZHANG Hanwang, XIAO Jun, et al. SCA-CNN: spatial and channel-wise attention in convo-lutional networks for image captioning[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, USA, 2017: 6298−6306.

( 0) 0)

|

| [19] |

HU Jie, SHEN Li, SUN Gang. Squeeze-and-excitation networks[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 7132−7141.

( 0) 0)

|

| [20] |

WANG Xiaolong, GIRSHICK R B, GUPTA A, et al. Non-local neural networks[C]//Proceedings of 2018 IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 7794−7803.

( 0) 0)

|

| [21] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 770−778.

( 0) 0)

|

| [22] |

CHENG Mingming, MITRA N J, HUANG Xiaolei, et al. Global contrast based salient region detection[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(3): 569-582. DOI:10.1109/TPAMI.2014.2345401 ( 0) 0)

|

| [23] |

YANG Chuan, ZHANG Lihe, LU Huchuan, et al. Sali-ency detection via graph-based manifold rank-ing[C]//Proceedings of 2013 IEEE Conference on Com-puter Vision and Pattern Recognition. Portland, USA, 2013: 3166−3173.

( 0) 0)

|

| [24] |

YAN Qiong, XU Li, SHI Jianping, et al. Hierarchical saliency detection[C]//Proceedings of 2013 IEEE Con-ference on Computer Vision and Pattern Recognition. Portland, USA, 2013: 1155−1162.

( 0) 0)

|

| [25] |

DENG J, DONG W, SOCHER R, et al. ImageNet: a large-scale hierarchical image database[C]//Proceedings of 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami, USA, 2009: 248−255.

( 0) 0)

|

| [26] |

CHEN L C, PAPANDREOU G, KOKKINOS I, et al. DeepLab: semantic image segmentation with deep con-volutional nets, atrous convolution, and fully connected CRFs[J]. IEEE transactions on pattern analysis and ma-chine intelligence, 2018, 40(4): 834-848. DOI:10.1109/TPAMI.2017.2699184 ( 0) 0)

|

| [27] |

ACHANTA R, HEMAMI S, ESTRADA F, et al. Fre-quency-tuned salient region detection[C]//Proceedings of 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami, USA, 2009: 1597−1604.

( 0) 0)

|

| [28] |

JIANG Huaizu, WANG Jingdong, YUAN Zejian, et al. Salient object detection: a discriminative regional feature integration approach[C]//Proceedings of 2013 IEEE Conference on Computer Vision and Pattern Recognition. Portland, USA, 2013: 2083−2090.

( 0) 0)

|

| [29] |

TONG Na, LU Huchuan, RUAN Xiang, et al. Salient object detection via bootstrap learning[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA, 2015: 1884−1892.

( 0) 0)

|

| [30] |

LI Guanbin, YU Yizhou. Visual saliency based on mul-tiscale deep features[C]//Proceedings of 2015 IEEE Con-ference on Computer Vision and Pattern Recognition. Boston, USA, 2015: 5455−5463.

( 0) 0)

|

| [31] |

ZHAO Rui, OUYANG Wanli, LI Hongsheng, et al. Sali-ency detection by multi-context deep learn-ing[C]//Proceedings of 2015 IEEE Conference on Com-puter Vision and Pattern Recognition. Boston, USA, 2015: 1265−1274.

( 0) 0)

|

| [32] |

LI Xi, ZHAO Liming, WEI Lina, et al. DeepSaliency: multi-task deep neural network model for salient object detection[J]. IEEE transactions on image processing, 2016, 25(8): 3919-3930. DOI:10.1109/TIP.2016.2579306 ( 0) 0)

|

| [33] |

LEE G, TAI Y, KIM J. Deep saliency with encoded low level distance map and high level features[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 660−668.

( 0) 0)

|

| [34] |

LI Guanbin, YU Yizhou. Deep contrast learning for salient object detection[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 478−487.

( 0) 0)

|

| [35] |

WANG Tiantian, ZHANG Lihe, LU Huchuan, et al. Kernelized subspace ranking for saliency detec-tion[C]//Proceedings of the 14th European Conference on Computer Vision. Amsterdam, the Netherlands, 2016: 450−466.

( 0) 0)

|

| [36] |

YU Changqian, WANG Jingbo, PENG Chao, et al. Learning a discriminative feature network for semantic segmentation[C]//Proceedings of 2018 IEEE/CVF Con-ference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 1857−1866.

( 0) 0)

|

| [37] |

ZHAO Hengshuang, SHI Jianping, QI Xiaojuan, et al. Pyramid scene parsing network[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 6230−6239.

( 0) 0)

|

| [38] |

CHEN L C, PAPANDREOU G, SCHROFF F, et al. Rethinking atrous convolution for semantic image segmen-tation[J]. arXiv: 1706.05587, 2017.

( 0) 0)

|

2020, Vol. 15

2020, Vol. 15