聚类技术作为机器学习领域中的一种无监督技术,在检测数据的内在结构和潜在知识方面发挥着重要的作用。在过去的几十年中,许多聚类方法得到了发展,如基于分区的方法(k-means)、基于模型的方法、基于密度的方法、层次聚类方法、模糊聚类方法(fuzzy c-means)和基于图的方法(spectral clustering)[1]。由于谱聚类在处理非凸形结构的数据集方面的高效性,谱聚类在图像分割[2-4]、社区检测[5]、人脸识别[6]等方面得到了广泛的研究和应用。

然而,传统的谱聚类算法在使用高斯核函数构造亲和矩阵时,需要先验信息来设置合适的参数以控制邻域的尺度;并且以距离来度量数据点之间的相似性,没有考虑到整体数据点的变化情况,对于高维数据来说,较难得到更高的聚类精度。近年来有很多学者对谱聚类算法进行了研究。赵晓晓等[7]结合稀疏表示和约束传递,提出一种结合稀疏表示和约束传递的半监督谱聚类算法,进一步提高了聚类准确率。林大华等[8]针对现有子空间聚类算法没有利用样本自表达和稀疏相似度矩阵,提出了一种新的稀疏样本自表达子空间聚类方法,所获得的相似度矩阵具有良好的子空间结构和鲁棒性。Chang等[9]提出了一种通过嵌入标签传播来改进谱聚类的方法,通过密集的未标记数据区域传播标签。以上方法虽然一定程度上提高了谱聚类算法的聚类性能,但是,在大部分谱聚类算法中,高斯核函数中尺度参数

传统的谱聚类以及上述大部分改进的谱聚类算法都是单一的针对距离度量或者尺度参数进行调整,本文从一个新的角度出发,在公理化模糊集(AFS)理论的基础上,结合局部密度估计和共享近邻的定义,提出一种基于AFS理论的共享近邻自适应谱聚类算法——公理化模糊共享近邻自适应谱聚类算法。利用AFS理论提出了一种模糊相似性度量方法,并将其作为谱聚类算法输入的亲和矩阵。同时采用共享近邻的方法发现密集区域样本点分布的结构和密度信息,并且根据每个点所处领域的稠密程度自适应调节参数

在谱聚类中,设

| ${{{S}}_{ij}} = \left\{ {\begin{array}{*{20}{l}} {{{\rm{e}}^{ - \frac{{\left( {{{\left\| {{{ x}_i} - {{ x}_j}} \right\|}^2}} \right)}}{{2{\sigma ^2}}}}}, \quad i \ne j} \\ {0, \quad i = j} \end{array}} \right.$ | (1) |

作为一种简单而有效的聚类准则,归一化割(Ncut)在文献[14]中提出,其定义为

| $ {\rm{Ncut}}\left(A,B \right) = \frac{{{{{y}}^{\rm{T}}}\left( {{{D}} - {{W}}} \right){{y}}}}{{{{{y}}^{\rm{T}}}{{Dy}}}} $ | (2) |

式中:

1)构造图

2)计算对角矩阵

3)计算归一化拉普拉斯矩阵,拉普拉斯矩阵 L 为

| ${{L}} = {{{D}}^{{{ - 1} / 2}}}{{L}}{{{D}}^{{{ - 1} / 2}}} = {{I}} - {{{D}}^{{{ - 1} / 2}}}{{S}}{{{D}}^{{{ - 1} / 2}}};$ |

4)对

5)利用经典的聚类算法如k-means对特征向量空间中的特征向量进行聚类。

1.2 AFS理论AFS理论是刘晓东[15-18]在1998年提出的一种基于AFS代数和AFS结构的模糊理论,AFS理论放弃使用距离度量来计算数据之间的相似性关系,而是将观测数据转化为模糊隶属函数,并实现其逻辑运算。然后,可以从AFS空间而不是原始特征空间中提取信息。在AFS空间中利用模糊关系来构建数据之间的相似性度量。采用模糊隶属度来表示数据之间的距离关系,增强了在处理现实数据中对各种数据集的适应性,为处理离群点提供了有效方法。

在文献[15]中,根据EI代数的定义,对于任意概念集合

设

| $\sum\limits_{i = 1}^3 {\left( {\mathop \Pi \limits_{m \in {A_i}} m} \right)} = \mathop \Pi \limits_{m \in {A_1}} m + \mathop \Pi \limits_{m \in {A_2}} m + \mathop \Pi \limits_{m \in {A_3}} m$ | (3) |

这些基于简单概念的EI代数运算生成的概念被认为复杂的概念。

因此,概念的逻辑表达可以用

| $ E = \left\{ {\sum\limits_{i \in I} {\left( {\mathop \Pi\limits_{m \in {A_i}} m } \right)\Big| {{A_i} \subseteq M,i \in I} } } \right\} $ | (4) |

式中

其中,每个模糊集可以被唯一地分解:

| $\xi = \sum\limits_{i \in I} {\left( {\mathop \Pi\limits_{m \in {A_i}} m } \right)} $ | (5) |

式中

本文提出的亲和矩阵构造方法是建立在AFS理论基础上的,该过程允许我们在发现的判别模糊子空间中表示不同模糊项的样本。这些子空间由模糊隶属函数选择,消除了不明显或噪声特征。因此,它们被认为能够改善内部相似和减少相互相似。此外,利用AFS中定义的模糊隶属度和逻辑运算,放宽了欧氏假设对数据距离推断的影响。更具体地说,本文使用一个样本的隶属度属于另一个样本的描述,用模糊集表示为距离度量。在最初的AFS聚类[19-21]基础上,在AFS空间上构建相似性度量。

首先建立隶属度函数,需要定义以下有序关系:设X是一个样本集合,M是X上的一组模糊集合。对于任意

| ${A_i} \geqslant \left( x \right) = \left\{ {y \in X\left| {x{{\geqslant }_m}y,\,{\rm{for}}\,\,\forall m \in {A_i}} \right.} \right\} \subseteq X$ | (6) |

式中:

对于模糊集合

1)对于

2)对于

3)对于

确定相关性隶属函数首先要确定

设

1)

2)

则称

设

| $ {\mu _\xi }\left( x \right) = \mathop {\sup }\limits_{i \in I} \mathop {\inf }\limits_{\gamma \in {A_i}} \frac{{\sum\limits_{u \in \left( {{A_i}{ \geqslant} \left( x \right)} \right)} {{\rho _\gamma }\left( u \right)} }}{{\sum\limits_{u \in X} {{\rho _\gamma }\left( u \right)} }},\quad \forall x \in X $ | (7) |

| $ {\mu _\xi }\left( x \right) = \mathop {\sup }\limits_{i \in I} \mathop {\inf }\limits_{\gamma \in {A_i}} \frac{{\int_{{A_i}\underline { > \left( x \right)} } {{\rho _\gamma }\left( t \right){\rm{d}}{P_t}} }}{{\sum\limits_\varOmega {{\rho _\gamma }\left( t \right){\rm{d}}{P_t}} }},\quad \forall x \in \varOmega $ | (8) |

如果对于每个

根据以上可知,在 E 中模糊概念的隶属函数可以由

| $ {\mu _\xi }\left( x \right) = \mathop {\sup }\limits_{i \in I} \left\{ {\frac{{\left| {{A_i} \geqslant \left( x \right)} \right|}}{{\left| X \right|}}} \right\} $ | (9) |

| $ {\mu _\xi }\left( x \right)\mathop { = \sup }\limits_{i \in I} \left\{ {\frac{{\left| {y \in X\left| {x{{ \geqslant }_{{\rho _m}}}y,\forall m \in {A_i}} \right.} \right|}}{{\left| X \right|}}} \right\} $ | (10) |

式中

接着设样本集为

| $ B_x^\varepsilon = \left\{ {m \in M\left| {{\mu _m}\left( x \right) \geqslant \max \left\{ {{\mu _m}\left( x \right)} \right\} - \varepsilon } \right.} \right\} $ | (11) |

式中:

| $ {\zeta _x} = \mathop \wedge \limits_{m \in B_x^\varepsilon } m $ | (12) |

式中

| $ {D_{ij}} = 1 - \min \left\{ {{{\bar \mu }_{{\zeta _{{X_i}}}}}\left( {{X_i}} \right),{{\bar \mu }_{{\zeta _{{X_j}}}}}\left( {{X_j}} \right)} \right\} $ | (13) |

| $ {\bar \mu _{{\zeta _{{X_i}}}}}\left( {{X_j}} \right) = \left\{ {{m_k} \in {\zeta _{{X_i}}}\left| {\frac{{\sum\limits_{k = 1}^N {{\mu _{{m_k}}}\left( {{X_j}} \right)} }}{N}} \right.} \right\} $ | (14) |

式中:

在AFS理论的基础上,为了更好地提取数据结构,在AFS空间中建立了距离测量,公式为

| $A\left( {{x_i},{x_j}} \right) = \exp \left( { - \frac{{{D_{ij}}^2}}{{2{\sigma ^2}}}} \right)$ | (15) |

式中

在2.1小节中虽然利用AFS理论在谱聚类算法中构建了新的距离度量,即

| $ A\left( {{x_i},{x_j}} \right) = \left\{\!\!\!\!\! {\begin{array}{*{20}{c}} {\begin{array}{*{20}{l}} {\exp \left( { - \dfrac{{{D_{ij}}^2}}{{{\sigma _i}{\sigma _j}\left( {\operatorname{SNN} \left( {{x_i},{x_j}} \right) + 1} \right)}}} \right),}&{i \ne j} \\ {0,}\quad{i = j} \end{array}} \end{array}} \right. $ | (16) |

式中

| ${\sigma _i} = \frac{1}{K}\sum\limits_{m = 1}^K {d\left( {{x_i},{x_m}} \right)} $ | (17) |

式中:

算法 公理化模糊共享近邻自适应谱聚类算法(AFSSNNSC)

输入 数据集

输出 聚类实际产生

1)首先为数据点的每个特征

2)使用式(10)计算每个数据点的隶属度函数

3)通过式(11)找出模糊项的集合

4)通过

5)根据

6)通过式(17)计算

7)利用式(16)构建亲和矩阵

8)根据

9)计算归一化拉普拉斯矩阵,拉普拉斯矩阵

| ${{L}} = {{{D}}^{{{ - 1} / 2}}}{{L}}{{{D}}^{{{ - 1} / 2}}} = {{I}} - {{{D}}^{{{ - 1} / 2}}}{{S}}{{{D}}^{{{ - 1} / 2}}}$ |

10)对

11)利用经典的聚类算法如k-means对特征向量空间中的特征向量进行聚类。

3 实验与结果分析 3.1 实验环境及性能指标在UCI、USPS手写数字的相同数据集上,采用本文提出的方法和文献[10]的NJW谱聚类(SC)、文献[21]的AFS聚类算法(AFS)、文献[22]的self-tuning spectral clustering(STSC)算法、基于K均值的近似谱聚类(KASP)[23]、基于Nystrom近似谱聚类(Nystrom)[24]和基于地标点谱聚类算法(LSC-R,LSC-K)[25]进行对比实验。本文算法实验是在MATLAB 2014b,计算机的硬件配置为Intel i7-4770 CPU 3.40 GHz、16 GB RAM的平台下进行。为了评估所提算法的聚类性能,本文使用聚类误差(CE)[26]和归一化互信息(NMI)[27]2种性能指标对本文算法与其他聚类方法的聚类结果进行了比较。其中CE被广泛用于评价聚类性能,CE越低聚类性能越好。NMI也是一种广泛使用的评估算法聚类性能的测量标准,NMI越大性能越好。

3.2 UCI数据集实验结果与分析为了验证所提出算法的有效性,本文将所提的算法和其他方法应用于UCI数据库中的11个基准数据集作为测试样本,表1为这11类数据集的特征,分别是数据总量、维数以及类的个数。

| 表 1 UCI实验数据集的特性 Tab.1 Characteristics of the UCI experimental datasets |

基于聚类误差(CE)的实验结果如表2所示,由表2可知所提的方法在大部分实验数据集上均获得了优于对比算法的CE值;所提出的方法在Heart、Hepatitis、Wdbc、Protein和Libras数据集上的CE分别为15.27%、27.14%、6.03%、51.12%、52.31%,相比较AFS算法而言均改进了10%以上,在其他5个数据集上的CE相比较AFS也均有所提高。证明了利用谱理论对相似矩阵进行划分比之前提出的传递闭包理论好得多,考虑到传递闭包方法的验证循环,所提出的方法也相对更快、更容易实现。在Iris、Wine数据集中,所提算法的CE分别为7.42%和2.89%,相对聚类错误率略高于STSC算法。因为这两个数据集中只有150个样本和178个样本,但是差异实际上只有一两个样本,但相对于总体而言,所提算法CE普遍低于其他算法在各数据集上的结果,仍具有较好的优越性;与基于距离度量的方法相比所提算法在给出的所有数据集中都显示出了优越性,在Sonar数据集上更加改进5%以上,本文算法与基于Nystrom近似谱聚类方法相比在所有数据集上均有1%以上的优势。本文算法与基于地标点的谱聚类方法LSC-R和LSC-K相比也展现出较好的聚类性能。这是因为通过模糊隶属函数代替距离度量数据之间的相似性,利用模糊语义结构解释数据之间的复杂的相互关系,增强了算法的鲁棒性。对于Protein、Libras等多聚类数据集,AFS的聚类错误率偏高,因为AFS聚类需要根据每个集群的边界选择最好的数据聚类分区。随着集群规模数量的不断增加,将很难去清晰地找到边界,这样聚类误差也会随之增高。总体而言,与对比文献方法相比,所提算法的CE值在所有实验数据集上均得到了改善,降低了算法的聚类错误率。

| 表 2 UCI数据集上的CE比较 Tab.2 Comparison of CE on the UCI datasets |

在归一化互信息(NMI)中测量的聚类性能如表3所示。所提出的算法的聚类结果NMI与其他方法的NMI相比都得到了改善,尤其在Heart和Protein数据集上,所提算法相对于KASP、SC、STSC、AFS和Nystrom对比算法而言NMI均提高了5%以上。只是在Wine数据集上,所提算法的NMI为87.86%,与其他算法相当,但在整个对比表格中为最好的聚类性能。由于所选Covertype数据集是一个从地图变量预测森林覆盖类型的数据集,它们都主要是在荒野地区发现的,所以覆盖类型在实际地理上是非常接近的,相对于其他数据集而言,这个数据集数据特性更加复杂。所以在Covertype数据集下所有算法的NMI都普遍较低,但是所提算法获得了比其他算法更好的聚类效果。

从实验结果可以看出,STSC不是很稳定,它在Hepatitis和Sonar数据集上的NMI情况都非常差,由于在STSC和本文算法中都考虑到了数据之间的相互关系,利用到了数据邻居的近邻作用,所以可以从中得出结论,与考虑到数据样本关系之间的传统距离度量作为相似性度量相比,采用具有数据样本模糊关系的模糊隶属度作为距离度量,在相似性度量上更具有鲁棒性。总体而言,所提算法相较于对比算法都具有明显的改善。

| 表 3 UCI数据集上的NMI比较 Tab.3 Comparison of NMI on the UCI datasets |

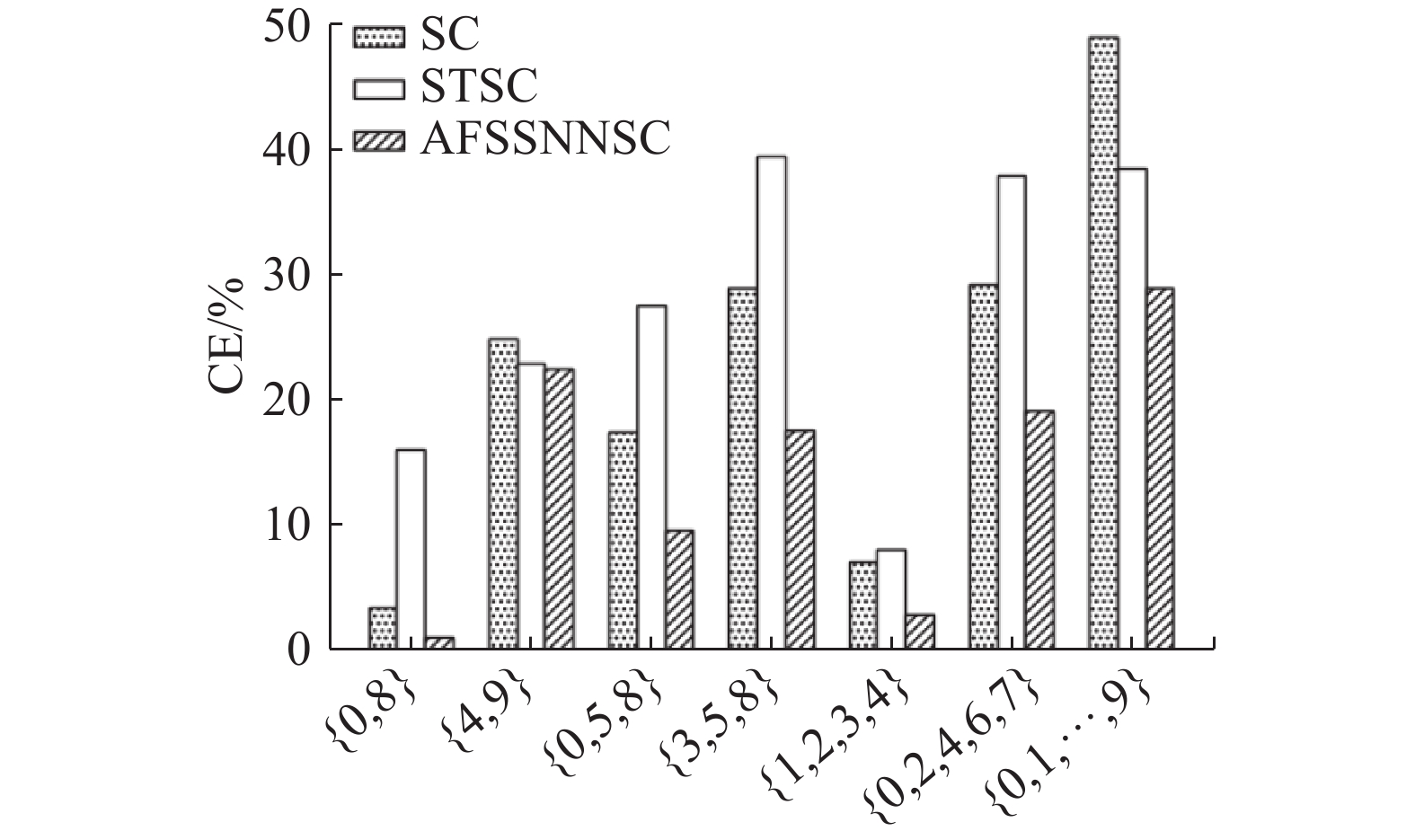

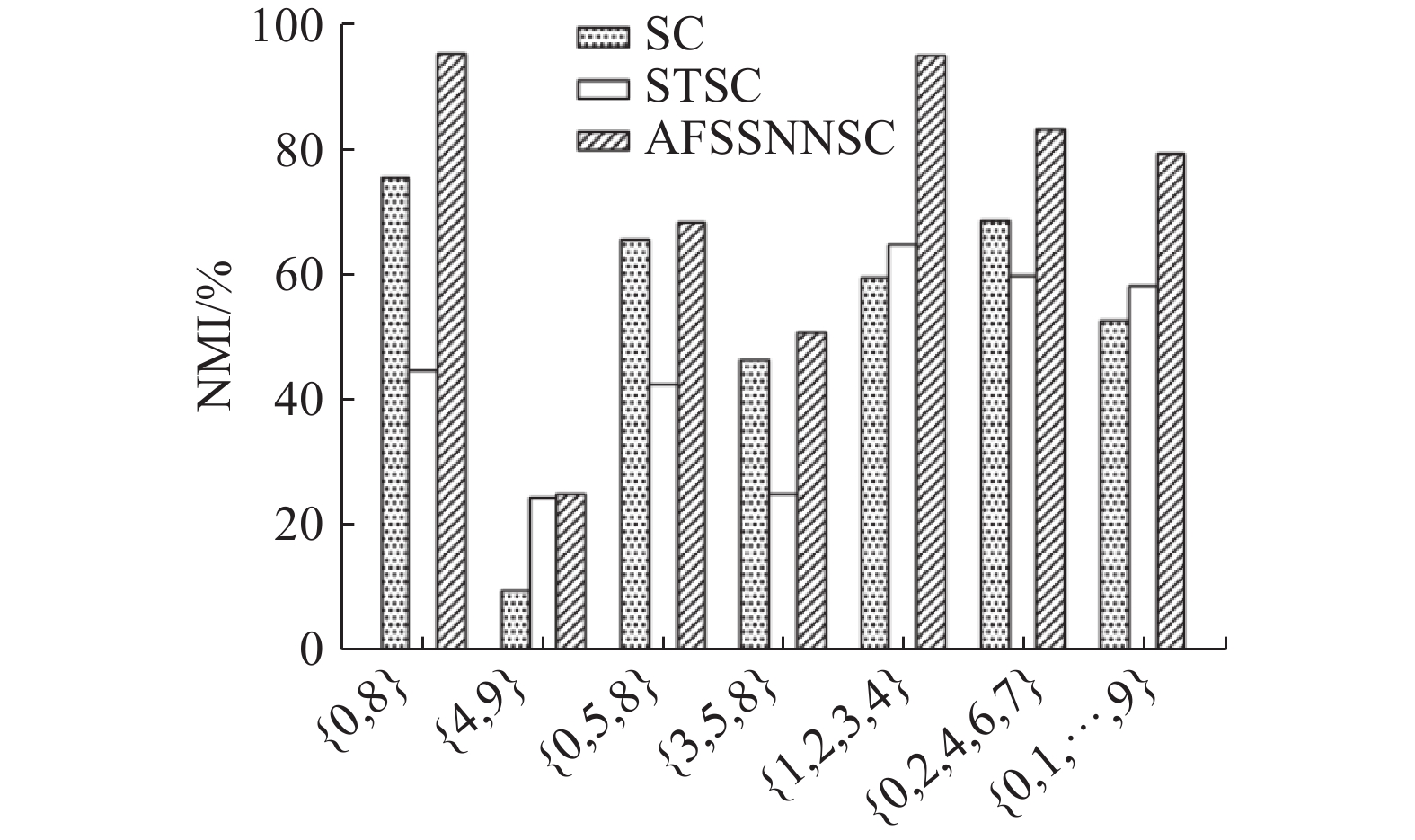

选择两个典型谱聚类算法SC和STSC与所提方法在广泛使用的USPS数据库中的手写数字数据集进行对比实验。该数据集包含美国邮政总局通过扫描信封中的手写数字获得的数字数据。原始扫描的数字是二进制的,大小和方向不同。本文使用的图像经过了大小归一化,得到了1 616张256维的灰度图像。它包含7 291个训练实例和2 007个测试实例(总共9 298个)。为了展示该方法的可伸缩性,考虑了不同数量的集群。具体来说,数字子集{0,8}、{4,9}、{0,5,8}、{3,5,8}、{1,2,3,4}、{0,2,4,6,7}和整个集合{0,1,···,9}用于测试本文提出的算法。这些子集的详细信息如表4所示。分别在每个子集上进行实验,并使用CE和NMI来测量性能。

| 表 4 USPS实验数据集的特性 Tab.4 Characteristics of the USPS experimental datasets |

从图1可以看出,在CE方面,所提算法在所有的情况下都优于STSC和SC,尤其在{0,8}、{0,5,8}、{3,5,8}、{0,2,4,6,7}、{0,1,···,9}数据集上CE均改善了5%以上,甚至在{3,5,8}上CE相较于其他对比算法,所提算法改进了10%以上。总体而言与SC和STSC相比,可以从图1中看出所提出的方法均得到明显的改善。

|

Download:

|

| 图 1 USPS数据集上CE的性能比较 Fig. 1 Performance comparison of CE on the USPS datasets | |

图2显示了基于NMI的USPS数据集的结果。从图2中可以看出,所提出的方法在所有情况下都比SC和STSC有优势。在{0,8}、{1,2,3,4}、{0,1,···,9}上相较于其他对比算法,所提算法的NMI都提高了10%以上,特别是对于具有挑战性的情况{3,5,8}和多类情况{1,2,3,4}、{0,2,4,6,7}、{0,1,···,9},所提出的算法都具有一定的优越性。

|

Download:

|

| 图 2 USPS数据集上NMI的性能比较 Fig. 2 Performance comparison of NMI on the USPS datasets | |

本文提出了一种新的无监督广义数据亲和图的构造方法,该方法具有更强的鲁棒性和更有意义的数据亲和图,以提高谱聚类精度。采用模糊理论定义数据相似度,利用模糊隶属度函数导出亲和图。此外,亲和图不是盲目地相信所有可用变量,而是通过捕捉和通过对每个样本的模糊描述,确定了特征子空间中组合分布的微妙两两相似关系。同时采用共享近邻的方法发现密集区域样本点分布的结构和密度信息,并且根据每个点所处领域的稠密程度自动调节参数

| [1] |

XU Dongkuan, TIAN Yingjie. A comprehensive survey of clustering algorithms[J]. Annals of data science, 2015, 2(2): 165-193. DOI:10.1007/s40745-015-0040-1 ( 0) 0)

|

| [2] |

LIU Hanqiang, ZHAO Feng, JIAO Licheng. Fuzzy spectral clustering with robust spatial information for image segmentation[J]. Applied soft computing, 2012, 12(11): 3636-3647. DOI:10.1016/j.asoc.2012.05.026 ( 0) 0)

|

| [3] |

TUNG F, WONG A, CLAUSI D A. Enabling scalable spectral clustering for image segmentation[J]. Pattern recognition, 2010, 43(12): 4069-4076. DOI:10.1016/j.patcog.2010.06.015 ( 0) 0)

|

| [4] |

ZENG Shan, HUANG Rui, KANG Zhen, et al. Image segmentation using spectral clustering of Gaussian mixture models[J]. Neurocomputing, 2014, 144: 346-356. DOI:10.1016/j.neucom.2014.04.037 ( 0) 0)

|

| [5] |

JIANG J Q, DRESS A W M, YANG Genke. A spectral clustering-based framework for detecting community structures in complex networks[J]. Applied mathematics letters, 2009, 22(9): 1479-1482. DOI:10.1016/j.aml.2009.02.005 ( 0) 0)

|

| [6] |

FORESTIER G, WEMMERT C. Semi-supervised learning using multiple clusterings with limited labeled data[J]. Information sciences, 2016, 361−362: 48-65. DOI:10.1016/j.ins.2016.04.040 ( 0) 0)

|

| [7] |

赵晓晓, 周治平. 结合稀疏表示与约束传递的半监督谱聚类算法[J]. 智能系统学报, 2018, 13(5): 855-863. ZHAO Xiaoxiao, ZHOU Zhiping. A semi-supervised spectral clustering algorithm combined with sparse representation and constraint propagation[J]. CAAI transactions on intelligent systems, 2018, 13(5): 855-863. (  0) 0)

|

| [8] |

林大华, 杨利锋, 邓振云, 等. 稀疏样本自表达子空间聚类算法[J]. 智能系统学报, 2016, 11(5): 696-702. LIN Dahua, YANG Lifeng, DENG Zhenyun, et al. Sparse sample self-representation for subspace clustering[J]. CAAI transactions on intelligent systems, 2016, 11(5): 696-702. (  0) 0)

|

| [9] |

CHANG Yanshuo, NIE Feiping, LI Zhihui, et al. Refined spectral clustering via embedded label propagation[J]. Neural computation, 2017, 29(12): 3381-3396. DOI:10.1162/neco_a_01022 ( 0) 0)

|

| [10] |

NG A Y, JORDAN M I, WEISS Y. On spectral clustering: analysis and an algorithm[C]//Proceedings of the 14th International Conference on Neural Information Processing Systems: Natural and Synthetic. Vancouver, Canada, 2001: 849−856.

( 0) 0)

|

| [11] |

YE Xiucai, SAKURAI T. Robust similarity measure for spectral clustering based on shared neighbors[J]. ETRI journal, 2016, 38(3): 540-550. ( 0) 0)

|

| [12] |

JIA Hongjie, DING Shifei, DU Mingjing. Self-tuning p -spectral clustering based on shared nearest neighbors[J]. Cognitive computation, 2015, 7(5): 622-632. DOI:10.1007/s12559-015-9331-2 ( 0) 0)

|

| [13] |

王雅琳, 陈斌, 王晓丽, 等. 基于密度调整的改进自适应谱聚类算法[J]. 控制与决策, 2014, 29(9): 1683-1687. WANG Yalin, CHEN Bin, WANG Xiaoli, et al. Improved adaptive spectral clustering algorithm based on density adjustment[J]. Control and decision, 2014, 29(9): 1683-1687. (  0) 0)

|

| [14] |

SHI Jianbo, MALIK J. Normalized cuts and image segmentation[J]. IEEE transactions on pattern analysis and machine intelligence, 2000, 22(8): 888-905. DOI:10.1109/34.868688 ( 0) 0)

|

| [15] |

LIU Xiaodong. The fuzzy theory based on AFS algebras and AFS structure[J]. Journal of mathematical analysis and applications, 1998, 217(2): 459-478. DOI:10.1006/jmaa.1997.5718 ( 0) 0)

|

| [16] |

LIU Xiaodong, PEDRYCZ W, ZHANG Qingling. Axiomatics fuzzy sets logic[C]//Proceedings of the12th IEEE International Conference on Fuzzy Systems. St Louis, USA, 2003: 55-60.

( 0) 0)

|

| [17] |

LIU Xiaodong, PEDRYCZ W. Axiomatic fuzzy set theory and its applications[M]. Berlin, Heidelberg: Springer, 2009.

( 0) 0)

|

| [18] |

LIU Xiaodong, PEDRYCZ W, CHAI Tianyou, et al. The development of fuzzy rough sets with the use of structures and algebras of axiomatic fuzzy sets[J]. IEEE transactions on knowledge and data engineering, 2009, 21(3): 443-462. DOI:10.1109/TKDE.2008.147 ( 0) 0)

|

| [19] |

LIU Xiaodong, REN Yan. Novel artificial intelligent techniques via AFS theory: feature selection, concept categorization and characteristic description[J]. Applied soft computing, 2010, 10(3): 793-805. DOI:10.1016/j.asoc.2009.09.009 ( 0) 0)

|

| [20] |

LIU Xiaodong, WANG Xianchang, PEDRYCZ W. Fuzzy clustering with semantic interpretation[J]. Applied soft computing, 2015, 26: 21-30. DOI:10.1016/j.asoc.2014.09.037 ( 0) 0)

|

| [21] |

LIU Xiaodong, WANG Wei, CHAI T. The fuzzy clustering analysis based on AFS theory[J]. IEEE transactions on systems, man, and cybernetics, part B, 2005, 35(5): 1013-1027. DOI:10.1109/TSMCB.2005.847747 ( 0) 0)

|

| [22] |

ZELNIK-Manor L, PERONA P. Self-tuning spectral clustering[C]//Proceedings of the 17th International Conference on Neural Information Processing Systems. Pasadena, USA, 2004: 1601−1608.

( 0) 0)

|

| [23] |

YAN Donghui, HUANG Ling, JORDAN M I. Fast approximate spectral clustering[C]//Proceedings of the 15th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. Paris, France, 2009: 907−916.

( 0) 0)

|

| [24] |

LI Mu, KWOK J T, LU Baoliang. Making large-scale nyström approximation possible[C]//Proceedings of the 27th International Conference on International Conference on Machine Learning. Haifa, Israel, 2010: 631−638.

( 0) 0)

|

| [25] |

CAI Deng, CHEN Xinlei. Large scale spectral clustering via landmark-based sparse representation[J]. IEEE transactions on cybernetics, 2015, 45(8): 1669-1680. DOI:10.1109/TCYB.2014.2358564 ( 0) 0)

|

| [26] |

SCHÖLKOPF B, PLATT J, HOFMANN T. A local learning approach for clustering[C]//Proceedings of the 19th International Conference on Neural Information Processing Systems. Doha, Qatar, 2007: 1529−1536.

( 0) 0)

|

| [27] |

STREHL A, GHOSH J. Cluster ensembles: a knowledge reuse framework for combining partitionings[C]//Proceedings of the 18th National Conference on Artificial Intelligence. Alberta, Canada, 2003: 583–617.

( 0) 0)

|

2019, Vol. 14

2019, Vol. 14