2. 哈尔滨工程大学 自动化学院,黑龙江 哈尔滨 150001

2. College of Automation, Harbin Engineering University, Harbin 150001, China

由于步态容易受到物体遮挡、衣着、视角和携带物等协变量因素的影响,提取到的步态特征呈现很强的类内变化[1-3]。为了解决这一问题,需要设计出更好的步态表征方法,使其更完备地表达有利于识别的步态特征[4-6]。近年来,基于类能量图的方法是步态识别领域中的初级特征提取技术之一。Han等[7]将归一化的一个周期步态图像叠加,提出步态能量图(gait energy image, GEI),像素的浓度代表在该像素位置人体运动的频率。Zhang[8]提出主动能量图(active energy image, AEI),前后帧间信息得到保留,可有效避免背包衣着等的影响,但丢失了步态图像的静态特征。为了克服衣着变化的影响,Bashir等[9]提出步态熵图(gait entropy image, GenI),GEI的动态及静态信息得到有效分割。Lamthw等[10]提出步态流图(gait flow image, GFI),即将光流场引入到步态类能量图中提取步态特征。Lee等[11]计算像素的均值和方差,累积周期中的每帧提出步态概率图(gait probability image, GPI),该方法表征步态帧间时序信息不完备。Deng等[12]计算周期步态轨迹参数提出步态动态图(gait dynamics graph, GDG),但是三维参数的提取过程较复杂。

一些研究人员通过融合不同的类能量图实现特征完备表达。陈实等[13]提出彩色步态运动历史图(color gait history image, CGHI)表征时空步态序列信息。CGHI[13]将3种灰度图像通过分配到RGB通道实现像素级融:单足站立为起点的前向单步运动历史图、对侧足站立为起点的前向单步运动历史图和GEI。Hofmann等[14]通过决策级融合实现步态表征:GEI和深梯度直方能量图(depth gradient histogram energy image, DGHEI),该方法仍存在步态信息丢失的问题。CCA及其改进方法在生物特征融合领域也有较多应用[15-17]。采用串行和并行的方式融合CCA可以得到两组步态特征。但是,串行和并行融合方式的先天不足,使得这种融合方式应用的普适性不是很好。

针对步态特征表达不完备问题,本文提出一种基于加权CCA的多信息融合的步态表征方法。在GFI基础上,首先,将行走的步宽时序信息编码到RGB颜色空间,提升GFI的时序表征能力,得到多通道彩色类能量图;然后,将R、G通道的步态特征进行CCA,对得到的两个新特征加权融合,融合结果与B通道特征重复上述融合过程。保留了初始特征关系属性,得到的新特征融合了更有益识别的步态信息。本文采用彩色类能量图保存步态特征,借助CCA去除特征间的冗余信息,同时将多通道信息融合成单通道,最后采用最近邻分类器识别。

1 三通道彩色类能量图步态流图(gait flow image, GFI)[15]提取的动、静态信息更具区分度,将步态的非正面步宽特征编码到RGB空间,增强了GFI的时序信息,得到三通道彩色类能量图,克服了GFI蕴含的弱时序信息的缺点,包含更多的步态信息。

1.1 生成三通道彩色类能量图对非正面周期步态序列,步宽信息被编码到RGB三通道,即投影到每帧图像的GFI中,生成三通道彩色类能量图,公式为

| $E^{\prime}(x, \mathrm{y})=\sum^{p}\left|F_{i}(x, y) \times G\left(P_{i}\right)\right|$ |

式中:p是四分之一周期的总帧数;Fi(x, y)是第i帧的GFI;Pi是第i帧的步宽;RGB的3个通道分别用

一个步态周期的彩色类能量图定义为

| $E(x,y) = \frac{1}{4}\sum\limits_{i = 1}^4 {E_{}^i(x,y)} $ |

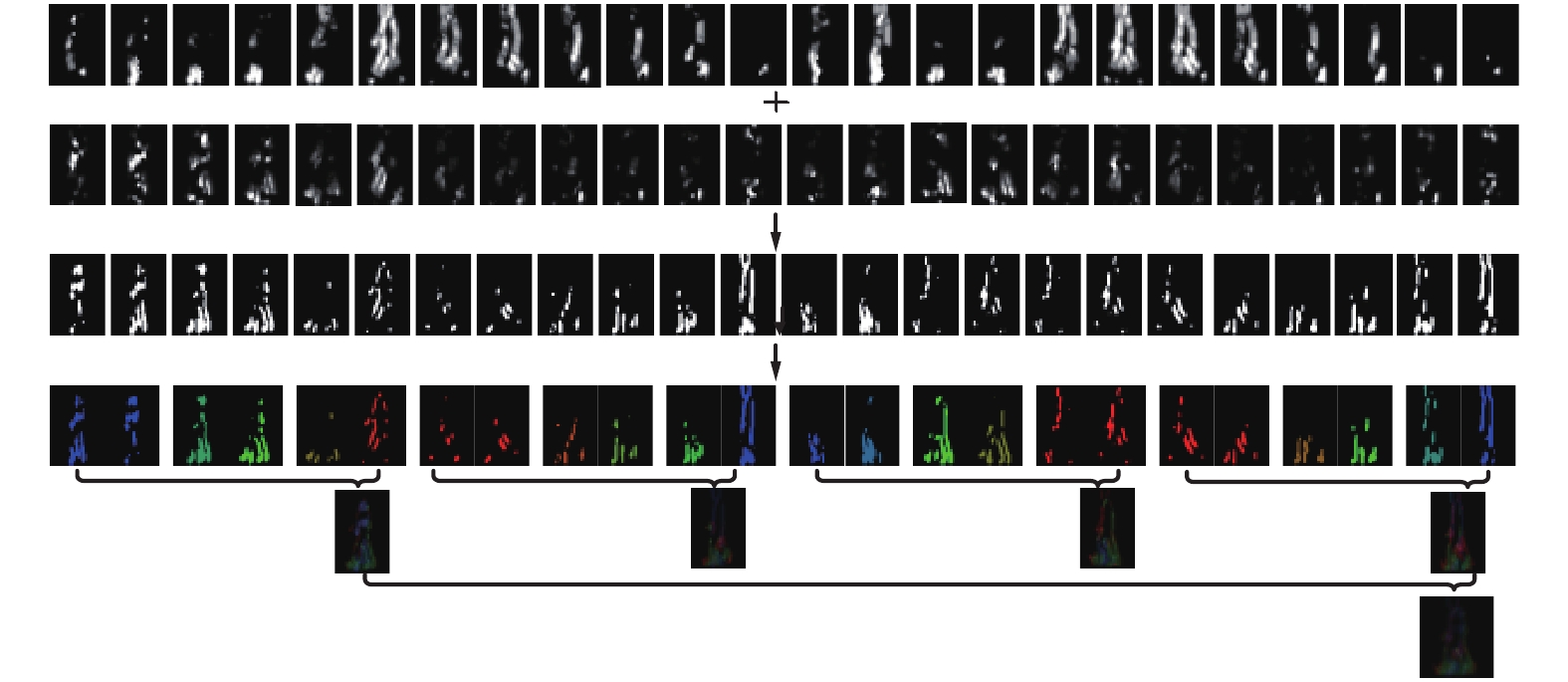

生成过程如图1所示:第1行是水平方向的GFI;第2行是垂直方向的GFI;第3行是水平和垂直方向合成的GFI;第4行是增强时序信息后的彩色类能量图;第5行是前一行生成的彩色类能量图,包含四幅四分之一周期的彩色类能量图;第六行是单周期的彩色类能量图。

|

Download:

|

| 图 1 彩色类能量图步态特征描述 Fig. 1 Colored class energy image gait feature representation | |

采用一种基于步宽信息的线性插值函数关系,将周期步态的时序信息编码到三通道RGB空间,不仅能够提升步态时序特征表达能力,还实现了时序特征的可视化。以四分之一步态周期为例,定义步宽信息Pi:

| ${P_i} = \frac{{{G_i} - {G_{\min }}}}{{{G_{\max }} - {G_{\min }}}}$ |

| ${G_i} = \frac{1}{{({h_2} - {h_1} + 1)}}\sum\limits_{j = {h_1}}^{{h_2}} {({\varDelta _j}} )$ |

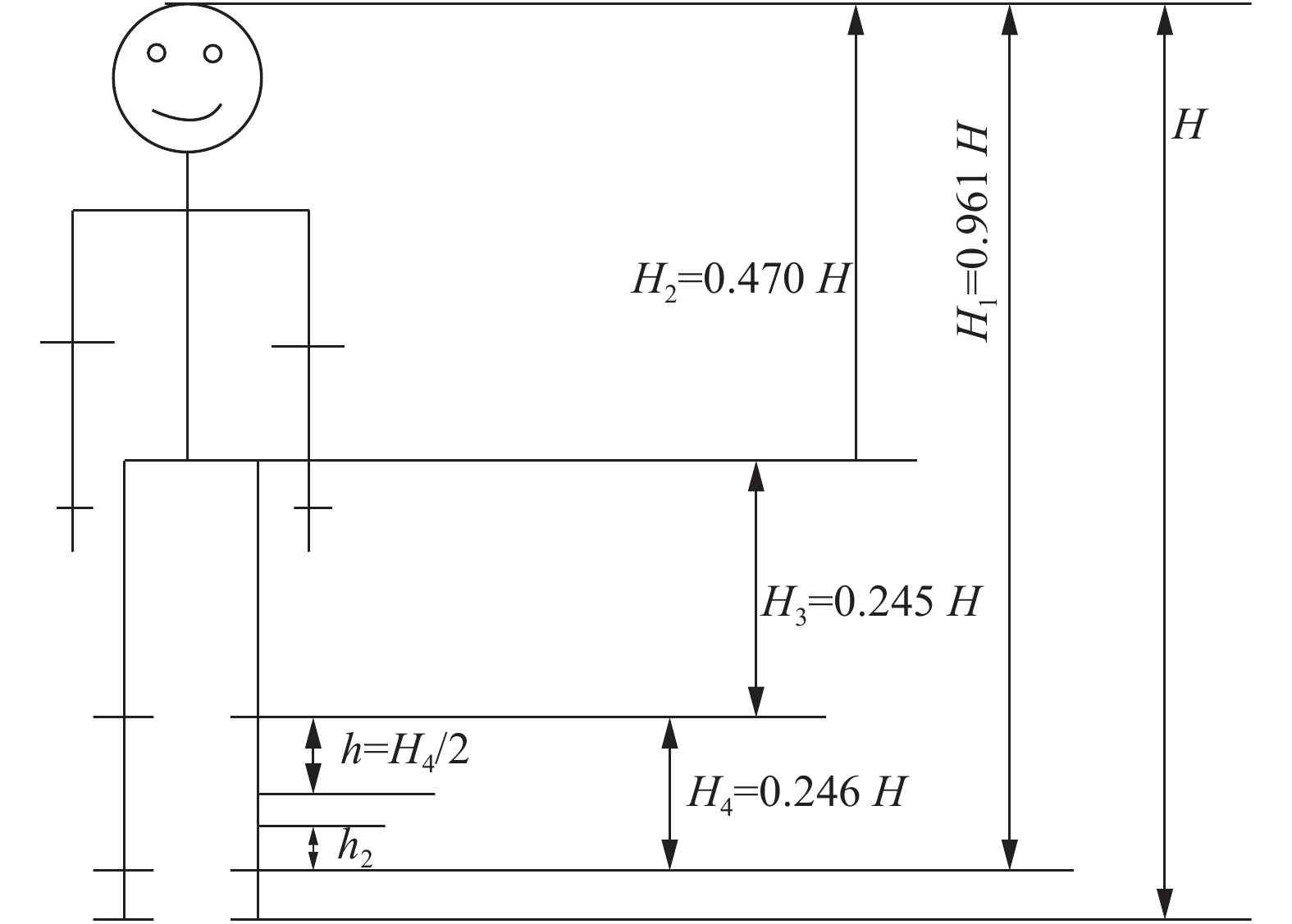

式中:

|

Download:

|

| 图 2 人体测量学比例 Fig. 2 Anthropometric percentages | |

可视化技术能够表示某些随时序变化的数据特征[18],将人体步态的宽度投影到RGB通道进行可视化,I是图像像素的最大值,比如1或255,公式为

| $\begin{array}{l} B\left( {{P_i}} \right) = \left\{ {\begin{array}{*{20}{l}} {\left( {1 - 2{P_i}} \right){{I}},}&{0 \leqslant {P_i} \leqslant \dfrac{1}{2}}\\ {0,}&{\dfrac{1}{2} \leqslant {P_i} \leqslant 1} \end{array}} \right.\\ G\left( {{P_i}} \right) = \left\{ {\begin{array}{*{20}{l}} {2{P_i}{{I}},}&{0 \leqslant {P_i} \leqslant \dfrac{1}{2}}\\ {\left( {2 - 2{P_i}} \right){{I}},}&{\dfrac{1}{2} \leqslant {P_i} \leqslant 1} \end{array}} \right.\\ R\left( {{P_i}} \right) = \left\{ {\begin{array}{*{20}{l}} {0,}&{0 \leqslant {P_i} \leqslant \dfrac{1}{2}}\\ {\left( {2{P_i} - 1} \right){{I}},}&{\dfrac{1}{2} \leqslant {P_i} \leqslant 1} \end{array}} \right. \end{array}$ |

彩色类能量图是多通道图像,采用最近邻分类器进行分类识别时需要先将其变为一维向量,如像素级融合方法,即将彩色图像灰度化:

| ${E_{\rm{T}}}(x,y) = wE_{\rm{T}}^{\rm{B}}(x,y,1) + \nu E_{\rm{T}}^{\rm{G}}(x,y,2) + uE_{\rm{T}}^{\rm{R}}(x,y,3)$ | (1) |

式中

像素级融合能够使一部分信息增强,与此同时,也使得一些对识别有益信息削弱。CCA及其改进的算法将具有相关关系的特征接近,与其他特征远离,可分性较好,能够应用到多通道特征融合。

2.1 CCA理论基础CCA[19]是常用的多元统计分析方法之一,旨在研究变量间的相关关系。CCA旨在寻找两组随机变量各自的线性变换,使得投影后的两组随机向量中对应元素之间的相关性最大。

定义均值是0的两组随机矩阵分别为X和Y,矩阵中样本数均为n,即

| $\rho = \frac{{{\rm{E}}[{{{p}}_x}^{\rm T}{{X}}{{{Y}}^{\rm T}}{{{p}}_y}]}}{{\sqrt {{\rm{E}}[{{p}}_x^{\rm{{\rm T}}}{{X}}{{{X}}^{\rm T}}{{{p}}_x}] {\rm{E}}[{{p}}_y^{\rm{{\rm T}}}{{Y}}{{{Y}}^{\rm T}}{{{p}}_y}]} }}$ | (2) |

式中

| $\begin{gathered} \mathop {\max }\limits_{{{{p}}_x},{{{p}}_y}} r = \mathop {\max }\limits_{{{{p}}_x},{{{p}}_y}} {{p}}_x^{\rm T}{{X}}{{{Y}}^{\rm T}}{{{p}}_y} \\ {\rm{s}}{\rm{.t}}{\rm{.}}\;\;\; {{p}}_x^{\rm T}{{X}}{{{X}}^{\rm T}}{{{p}}_x} = 1,\quad{{p}}_y^{\rm T}{{Y}}{{{Y}}^{\rm T}}{{{p}}_y} = 1 \\ \end{gathered} $ | (3) |

利用拉格朗日乘子法可以解决式(3)的优化问题:

| $L = {{p}}_x^{\rm T}{{X}}{{{Y}}^{\rm T}}{{{p}}_y} + {{\textit{λ}}_x}(1 - {{p}}_x^{\rm T}{{X}}{{{X}}^{\rm T}}{{{p}}_x}) + {{\textit{λ}} _y}(1 - {{p}}_y^{\rm T}{{Y}}{{{Y}}^{\rm T}}{{{p}}_y})$ |

得

| ${{X}}{{{Y}}^{\rm T}}{({{Y}}{{{Y}}^{\rm T}})^{ - 1}}{{Y}}{{{X}}^{\rm T}}{{{p}}_x} = {{\textit{λ}}^2}{{X}}{{{X}}^{\rm T}}{{{p}}_x}$ | (4) |

求解式(4),选取前

彩色类能量图的3个通道特征分别为XR、XG、XB,特征维数m×n,其中

加权CCA融合彩色类能量图算法步骤如下:

1) 对XR和XG执行CCA,得到

2)

| ${{{X}}_{{\rm{RG}}}} = \psi ({{X}}{'_{\rm{R}}},{{X}}{'_{\rm{G}}}) = \alpha {{X}}{'_{\rm{R}}} + \beta {{X}}{'_G}$ | (11) |

式中:

3)对XRG和XB执行CCA,对得到的

| ${{{X}}_{{\rm{RGB}}}} = \psi ({{X}}{'_{{\rm{RG}}}},{{X}}{'_{\rm{B}}}) = \delta {{X}}{'_{{\rm{RG}}}} + \gamma {{X}}{'_{\rm{B}}}$ | (12) |

式中:

这种融合方法的优点在于:可分性较好,初始特征关系得到保留,加权融合得到的新特征具有更多有益于识别的信息。另外,若XRGB的维数较大,可对XRGB降维。在运算速度上,与其他融合方式相比,如串行或并行融合,特征维数没有增加且在实数域运算,显然具有最低的运算量。

2.3 计算复杂度分析对于分辨率为xy,包含步态图像帧数为

本文所提算法的有效性实验在USF HumanID[20]步态数据集上进行。实验的测试平台为IntelCore 2.5 GHz的CPU、4 GB内存、Windows 7操作系统,测试代码在MATLAB2016a上编译运行。

以双脚支撑为计算步态周期的起始点,一个步态序列可得到几幅单周期的类能量图,然后将这几幅平均成一幅进行分析。采用最近邻分类器进行识别。本文进行了3组实验:第1组,与其他类能量图相比,本文提出算法的识别率;第2组,权值

在执行CCA时,广义特征值分解会遇到“维数灾难”,为了避免这一问题,先对彩色类能量图降维,采用奇异值分解(SVD)算法,选取特征值之和的99.9%对应的向量,然后再进行CCA。本文采用奇异值分解(SVD)实现PCA。

3.1 多通道彩色类能量图有效性实验将本文提出的CCA融合三通道表征标记为CFR,采用像素级加权融合三通道特征得到的步态表征标记为PFR,并对比了其他常用的步态表征方法,如步态能量图GEI、步态流图GFI。表1中CFR对应参数取值为

| 表 1 本文算法表征步态特征性能对比 Tab.1 Comparison of the performances of gait features representation methods % |

表1中,与GEI、GFI相比,Rank1指标下,CFR将平均识别率提高了15.72%、14.22%,PFR将平均识别率提高了5.5%、4%;CFR较PFR识别率提高了10.22%;Rank5指标也得到了大幅度提升。分析表1中数据可知,本文提出的三通道彩色类能量图作为步态表征是有效的,描述了更多有利于识别的动态、静态和时序信息;提出的基于加权CCA融合多通道信息的步态表征包含较多有益于识别的信息,取得最优识别性能。

3.2 参数对本文提出的表征方法性能的影响权值参数α、β、δ、γ影响本文提出算法的识别性能。为了分析参数取值对识别性能的影响,进行了81组实验,参数取值范围为0.1~0.9,表2给出了10组参数的实验结果。

| 表 2 参数对本文提出算法识别率的影响 Tab.2 Influence of parameters on the proposed algorithm’s recognition rate % |

将测试的对象A~L分为3类:第Ⅰ类,要依靠静态信息进行识别;第Ⅲ类,主要依靠动态信息和时序信息进行识别;第Ⅱ类介于上述两类之间,静态、动态及时序信息在识别时占有的地位相同。由表2、表3可知:R、G通道加权系数α、β一定时,随着B通道加权系数γ减小,第Ⅰ、Ⅱ、Ⅲ类及总的平均识别率均呈上升趋势,当γ进一步减小,识别率会略微下降。以α=0.5为例,γ = 0.3相较γ = 0.9的情况下平均识别率提高了6.41%;第I类平均识别率提高了10.4%,第Ⅱ类平均识别率提高了6%,第Ⅲ类平均识别率提高了4.4%。

| 表 3 参数对本文提出算法每类平均识别率的影响 Tab.3 Average recognition rates using different parameters in the methodsproposed for each class % |

2.3节从理论上分析了生成表4各类能量图的计算复杂度,进一步,本文在USF数据库上做了生成类能量图的时间对比实验。在多数情况下,单幅类能量图生成时间很短,为便于记录及对比分析,表4中的时间为Gallery组(即训练组)生成类能量图时间的总和,通过表4中数据可知,实验结果与计算复杂度的理论分析一致。生成CFR 、PFR时间相对较长,但在本实验平台下,每秒仍能处理90帧以上数据图像,可以满足实时步态识别系统的需求。

| 表 4 生成各步态特征时间对比 Tab.4 Comparisons of generation time of gait characteristics |

本文提出了一种新的步态表征方法。该方法增强了GFI时序信息的表达,采用CCA去除特征间的冗余信息的同时将多通道信息融合成单通道,使得新特征具有更丰富有益识别的信息,在协变量变化较大的USF数据集进行实验,由实验数据可知,本文提出的方法使得识别率得到了显著的提升。

下一步打算对本文算法直接选取已有的类能量图分配到RGB通道;为了降低计算复杂度,可将融合算法CCA方法扩展到非线性耦合度量学习空间。

| [1] |

CHEN Xin, WENG Jian, LU Wei, et al. Multi-gait recognition based on attribute discovery[J]. IEEE transactions on pattern analysis and machine intelligence, 2018, 40(7): 1697-1710. DOI:10.1109/TPAMI.2017.2726061 ( 0) 0)

|

| [2] |

GADALETA M, ROSSI M. IDNet: smartphone-based gait recognition with convolutional neural networks[J]. Pattern recognition, 2018, 74: 25-37. DOI:10.1016/j.patcog.2017.09.005 ( 0) 0)

|

| [3] |

BEN Xianye, ZHANG Peng, LAI Zhihui, et al. A general tensor representation framework for cross-view gait recognition[J]. Pattern recognition, 2019, 90: 87-98. DOI:10.1016/j.patcog.2019.01.017 ( 0) 0)

|

| [4] |

EL-ALFY H, MITSUGAMI I, YAGI Y. Gait recognition based on normal distance maps[J]. IEEE transactions on cybernetics, 2018, 48(5): 1526-1539. DOI:10.1109/TCYB.2017.2705799 ( 0) 0)

|

| [5] |

AGGARWAL H, VISHWAKARMA D K. Covariate conscious approach for Gait recognition based upon Zernike moment invariants[J]. IEEE transactions on cognitive and developmental systems, 2018, 10(2): 397-407. DOI:10.1109/TCDS.2017.2658674 ( 0) 0)

|

| [6] |

何逸炜, 张军平. 步态识别的深度学习: 综述[J]. 模式识别与人工智能, 2018, 31(5): 442-452. HE Yiwei, ZHANG Junping. Deep learning for gait recognition: a survey[J]. Pattern recognition and artificial intelligence, 2018, 31(5): 442-452. (  0) 0)

|

| [7] |

HAN Ju, BHANU B. Individual recognition using gait energy image[J]. IEEE transactions on pattern analysis and machine intelligence, 2006, 28(2): 316-322. DOI:10.1109/TPAMI.2006.38 ( 0) 0)

|

| [8] |

ZHANG Erhu, ZHAO Yongwei, XIONG Wei. Active energy image plus 2DLPP for gait recognition[J]. Signal processing, 2010, 90(7): 2295-2302. DOI:10.1016/j.sigpro.2010.01.024 ( 0) 0)

|

| [9] |

BASHIR K, XIANG Tao, GONG Shaogang. Gait recognition without subject cooperation[J]. Pattern recognition letters, 2010, 31(13): 2052-2060. DOI:10.1016/j.patrec.2010.05.027 ( 0) 0)

|

| [10] |

LAM T H W, CHEUNG K H, LIU J N K. Gait flow image: a silhouette-based gait representation for human identification[J]. Pattern recognition, 2011, 44(4): 973-987. DOI:10.1016/j.patcog.2010.10.011 ( 0) 0)

|

| [11] |

LEE C P, TAN A W C, TAN S C. Gait probability image: an information-theoretic model of gait representation[J]. Journal of visual communication and image representation, 2014, 25(6): 1489-1492. DOI:10.1016/j.jvcir.2014.05.006 ( 0) 0)

|

| [12] |

DENG Muqing, WANG Cong, ZHENG Tongjia. Individual identification using a gait dynamics graph[J]. Pattern recognition, 2018, 83: 287-298. DOI:10.1016/j.patcog.2018.06.002 ( 0) 0)

|

| [13] |

陈实, 马天骏, 黄万红, 等. 用于步态识别的多层窗口图像矩[J]. 电子与信息学报, 2009, 31(1): 116-119. CHEN Shi, MA Tianjun, HUANG Wanhong, et al. A multi-layer windows method of moments for gait recognition[J]. Journal of electronics and information technology, 2009, 31(1): 116-119. (  0) 0)

|

| [14] |

HOFMANN M, GEIGER J, BACHMANN S, et al. The TUM gait from audio, image and depth (GAID) database: Multimodal recognition of subjects and traits[J]. Journal of visual communication and image representation, 2014, 25(1): 195-206. DOI:10.1016/j.jvcir.2013.02.006 ( 0) 0)

|

| [15] |

XING Xianglei, WANG Kejun, YAN Tao, et al. Complete canonical correlation analysis with application to multi-view gait recognition[J]. Pattern recognition, 2016, 50: 107-117. DOI:10.1016/j.patcog.2015.08.011 ( 0) 0)

|

| [16] |

GAO Lei, QI Lin, CHEN Enqing, et al. Discriminative multiple canonical correlation analysis for information fusion[J]. IEEE transactions on image processing, 2018, 27(4): 1951-1965. DOI:10.1109/TIP.2017.2765820 ( 0) 0)

|

| [17] |

石强, 张斌, 陈喆, 等. 异质影像融合研究现状及趋势[J]. 自动化学报, 2014, 40(3): 385-396. SHI Qiang, ZHANG Bin, CHEN Zhe, et al. Fusion techniques for heterogeneous images: a survey[J]. Acta automatica sinica, 2014, 40(3): 385-396. (  0) 0)

|

| [18] |

WANG Chen, ZHANG Junping, WANG Liang, et al. Human identification using temporal information preserving gait template[J]. IEEE transactions on pattern analysis and machine intelligence, 2012, 34(11): 2164-2176. DOI:10.1109/TPAMI.2011.260 ( 0) 0)

|

| [19] |

SUN Shiliang. A survey of multi-view machine learning[J]. Neural computing and applications, 2013, 23(7/8): 2031-2038. ( 0) 0)

|

| [20] |

SARKAR S, PHILLIPS P J, LIU Z, et al. The humanID gait challenge problem: data sets, performance, and analysis[J]. IEEE transactions on pattern analysis and machine intelligence, 2005, 27(2): 162-177. DOI:10.1109/TPAMI.2005.39 ( 0) 0)

|

2019, Vol. 14

2019, Vol. 14