2. 天津工业大学 电工电能新技术天津市重点实验室,天津 300387

2. Key Laboratory of Advanced Electrical Engineering and Energy Technology, Tianjin Polytechnic University, Tianjin 300387, China

运动目标的识别与跟踪在军事、安防、工业生产等领域中有着广泛的应用前景[1-3]。实时跟踪系统对跟踪方法的运算量一般有着较为严苛的要求[4-7]。但过于简化的跟踪方法对目标特征描述不够充分,造成难以适应复杂场景下跟踪准确性的要求。尤其当目标所处场景的光照不稳定时,跟踪系统对跟踪方法的适应能力就会提出更高要求[8-10]。在现有跟踪方法中,Meanshift算法由于具有运算量小,计算速度快等优点而得到较快发展[11]。在Meanshift算法基础上所提出的Camshift改进算法能够适应目标缩放变化等需求,改善了跟踪性能[12-13]。为了提高跟踪方法对复杂场景的适应能力,通过融合多种辅助特征信息、抑制背景信息或突出目标显著性信息等方式,又提出了一系列的改进跟踪方法[14-16],如基于显著性加权直方图模型[17]及融合边缘纹理特征的直方图模型[18]的跟踪方法等。

Meanshift算法、Camshift算法以及各种改进方法均是利用目标的色度(Hue)直方图模型来描述目标的基本特征,利用反向投影实现目标的定位跟踪[12-18]。因此目标直方图模型的稳定性和准确性直接影响着跟踪性能。现有Camshift等跟踪方法采用精确集合的定义选取划分阈值[12-18],而实际跟踪过程中,由于光照变化等干扰因素会造成场景图像的色度产生一定的漂移。从而引起目标直方图模型的不稳定,降低了目标跟踪的性能。

为了提高直方图模型对色度漂移的抑制能力,结合模糊集合理论,提出了目标模糊直方图模型建立方法,弱化了色度等级划分阈值的作用,根据目标的模糊直方图定义了新的反向投影方式,实现目标定位与跟踪,有效抑制光照变化等干扰因素对目标跟踪性能的影响,提高跟踪方法的适应能力。

1 模糊直方图模型目标直方图模型由于具有旋转不变性及计算量小等优点,在许多跟踪方法中得到有效应用。通常选择HSV颜色空间中H(色度)分量建立直方图模型。设色度值H的定义域为[0,180],色度等级划分为m级,0~h1为第1个等级,hj-1~hj为第j个等级,hm-1~ 180为第m个等级,目标区域中像素点i的坐标为(xi,yi),其色度等级值表示为b(xi,yi),这样目标色度直方图模型可建立为qʹ={qʹu},

| ${q'_u} = \sum\limits_{i = 1}^s {\delta [b({x_i},{y_i}) - u]} $ | (1) |

式中s为目标区域中所包含像素点的数量。式(1)所建立的直方图模型是采用精确集合的方法进行色度等级的划分。因此光照变化等干扰,会造成目标直方图模型不稳定,严重影响目标跟踪方法的性能。

模糊集合能够通过弱化集合划分阈值的方式实现不确定知识表示,从而可改善模型描述的鲁棒性,因此提出了基于模糊隶属度划分的目标直方图模型表示方法。

选择梯形色度隶属度函数,则第k个色度模糊等级的隶属度函数μk(h)描述为

| ${\mu _k}(h) = \left\{ \begin{aligned} & \frac{{h - {h_{k - 2}}}}{{{h_{k - 1}} - {h_{k - 2}}}},\quad{h_{k - 2}} < h \leqslant {h_{k - 1}} \\ & 1,\quad{h_{k - 1}} < h \leqslant {h_k} \\ & \frac{{{h_{k + 1}} - h}}{{{h_{k + 1}} - {h_k}}},\quad{h_k} < h \leqslant {h_{k + 1}} \\ & 0,\quad h \leqslant {h_{k - 2}} \text{或} h > {h_{k + 1}} \end{aligned} \right.$ |

基于上述模糊划分的色度模糊直方图模型可表示为q={qu},

| ${q_u} = \sum\limits_{i = 1}^s {{\mu _u}h({x_i},{y_i})} $ | (2) |

式(2)所建立的直方图模型由于相邻色度等级之间没有明显的界限,弱化了色度等级阈值对直方图模型的影响,从而可有效抑制色度漂移和光照变化产生的干扰,提高目标直方图模型的稳定性。

2 基于模糊直方图模型的跟踪方法利用式(2)的目标模糊直方图进行反向投影,可建立跟踪场景的概率分布图。由于采用模糊直方图模型,因此反向投影方式与传统方法有所不同。设跟踪场景中像素点(x,y)的色度值为h(x,y),根据式(2)模糊直方图模型定义反向投影概率分布图中该点的像素灰度值p(x,y)为

| $p(x,y) ={\rm{INT}} \left[ {\frac{{\displaystyle\sum\limits_{u = 1}^m {{\mu _u}h(x,y) \cdot {q_u} \times 255} }}{{\max \{ {q_j}|j = 1,2,\cdots,m\} \displaystyle\sum\limits_{u = 1}^m {{\mu _u}[h(x,y)]} }}} \right] $ | (3) |

式中INT()为取整函数。根据色度模糊等级的划分,同一色度值隶属于不同的色度等级,因此,式(3)采用加权平均方式求得场景图像反向投影概率分布图中各像素的灰度值,灰度值越大,表示该点为目标区域中的点的概率越大。基于式(3)的反向投影方式,目标跟踪的具体流程可描述为:

1)选定跟踪目标区域,利用式(2)建立目标区域的色度模糊直方图模型;

2)获取当前跟踪场景,利用式(3)求取当前跟踪场景的反向投影概率分布图;

3)根据场景反向投影概率分布图中各像素点的灰度值,求取跟踪搜索窗的质心坐标(xc,yc),即

| ${x_c} = \frac{{\displaystyle\sum\limits_{x,y} {x \cdot p(x,y)} }}{{\displaystyle\sum\limits_{x,y} {p(x,y)} }}$ |

| ${y_c} = \frac{{\displaystyle\sum\limits_{x,y} {y \cdot p(x,y)} }}{{\displaystyle\sum\limits_{x,y} {p(x,y)} }}$ |

4)自适应调整跟踪搜索窗的边长,即

| $l = 2\sqrt {\sum\limits_{x,y} {p(x,y)/256} } $ |

5)平移跟踪搜索窗的中心至质心位置,并重复3)~5),直到移动距离小于设定阈值;

6)更新跟踪目标的长L、宽W及方向角θ,即

| $L = \sqrt {\frac{{A + \sqrt {{B^2} + {C^2}} }}{2}} $ |

| $W = \sqrt {\frac{{A - \sqrt {{B^2} + {C^2}} }}{2}} $ |

| $\theta = \frac{1}{2}\arctan \frac{B}{C}$ |

其中:

| $A = \frac{{\displaystyle\sum\limits_{x,y} {p(x,y)({x^2} + {y^2})} }}{{\displaystyle\sum\limits_{x,y} {p(x,y)} }} - (x_c^2 + y_c^2)$ |

| $B = 2\left[ {\frac{{\displaystyle\sum\limits_{x,y} {xyp(x,y)} }}{{\displaystyle\sum\limits_{x,y} {p(x,y)} }} - {x_c}{y_c}} \right]$ |

| $C = \frac{{\displaystyle\sum\limits_{x,y} {p(x,y)({x^2} - {y^2})} }}{{\displaystyle\sum\limits_{x,y} {p(x,y)} }} - (x_c^2 - y_c^2)$ |

7)返回1),根据新确定的目标区域重建目标模糊直方图模型,对下一帧场景图像进行定位跟踪。

跟踪方法中采用模糊集合实现色度等级的划分,并利用加权平均的解模糊方法建立了场景图像的反向投影概率分布图,可有效抑制光照变化和色度漂移等干扰因素对目标模型的影响。

3 实验结果分析 3.1 色度漂移直方图模型比较图1为相同视角下相邻采样间隔得到的两帧场景图像。

|

Download:

|

| 图 1 不同采样时刻场景 Fig. 1 Scenes sampled at different times | |

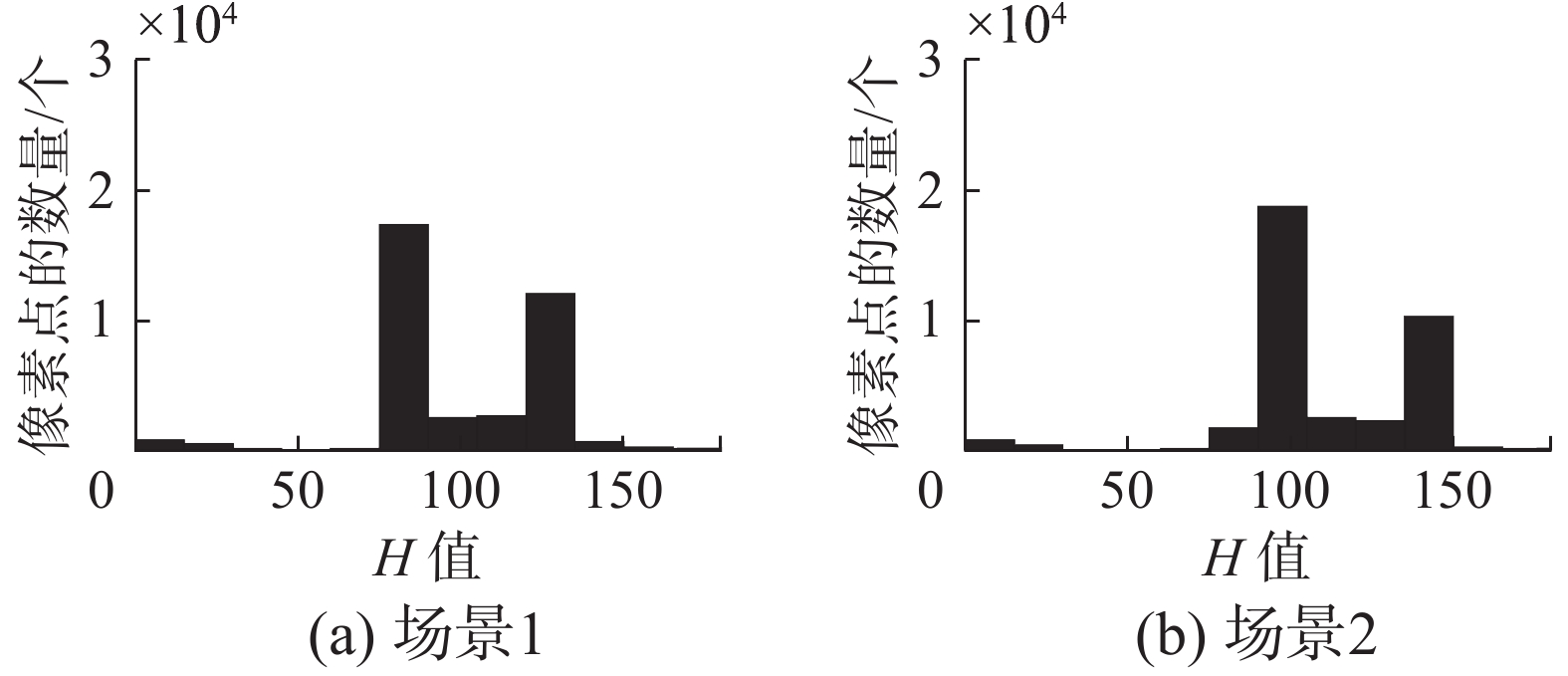

由于采样差异,两个场景图像中存在微小的色度差异。场景中白框内的区域设定为目标。将色度区间均匀分为12个等级,即m=12,采用精确集合划分方式建立两帧场景中目标的直方图模型,如图2所示。

|

Download:

|

| 图 2 不同采样时刻场景图中目标直方图 Fig. 2 Target histograms in the scenes sampled at different times | |

由图2可见,场景1中的目标直方图与场景2中的目标直方图相比,二者有明显差异。这是由于色度等级划分阈值附近的色度值发生了微弱的漂移,从而导致不同时刻同一目标的直方图模型差异很大。分别采用图2中的两个直方图模型进行反向投影,得到图1中两个场景的概率分布图如图3和图4所示。

|

Download:

|

| 图 3 基于场景1的直方图所得反向投影 Fig. 3 Projection images based on the histogram in scene 1 | |

|

Download:

|

| 图 4 基于场景2的直方图所得反向投影 Fig. 4 Projection images based on the histogram in scene 2 | |

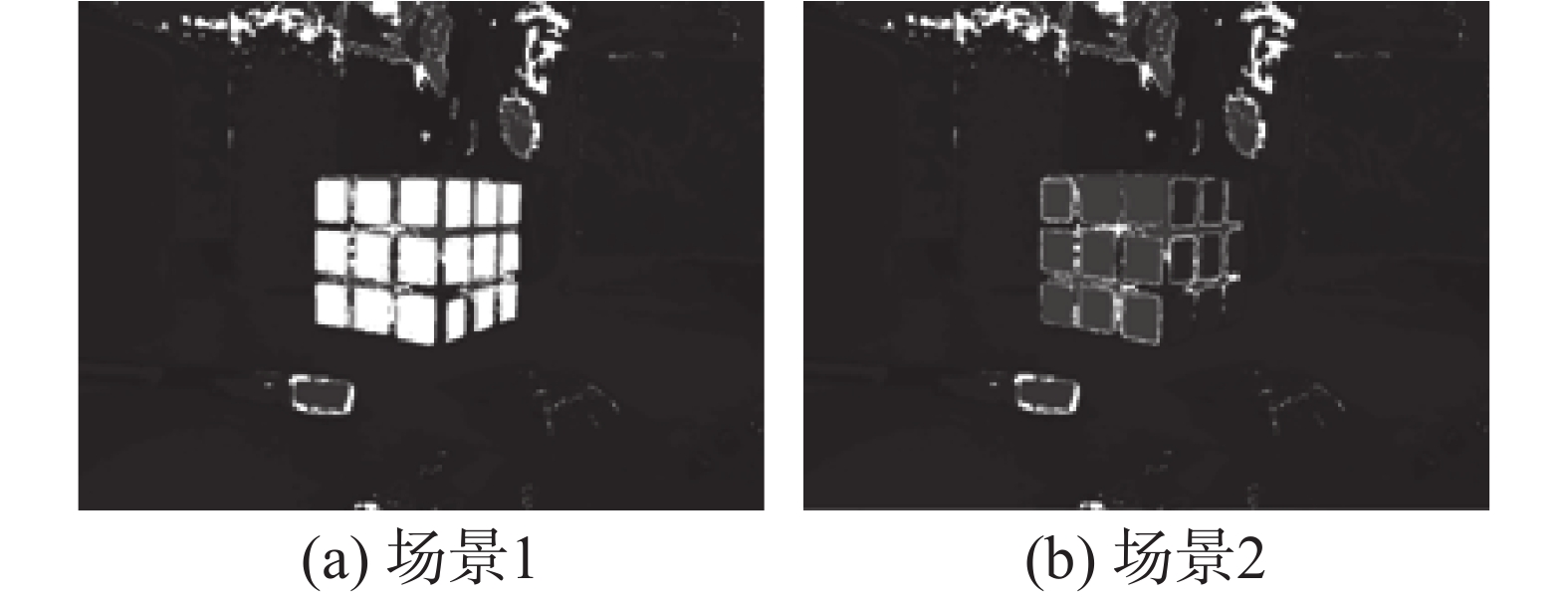

图3和图4中越白的区域其灰度值越大,表示属于目标的概率越大。从结果可见,由于同一目标在不同采样时刻的直方图模型存在明显差异,因此利用场景中的目标直方图模型进行反向投影,目标区域具有较大概率值,而利用非场景中目标直方图模型进行反向投影,目标区域的概率值明显降低,容易造成目标定位不准确,甚至定位错误。在跟踪算法中,均采用前一帧场景中目标的直方图对当前场景进行反向投影,因此容易造成跟踪不稳定,甚至跟踪失败。

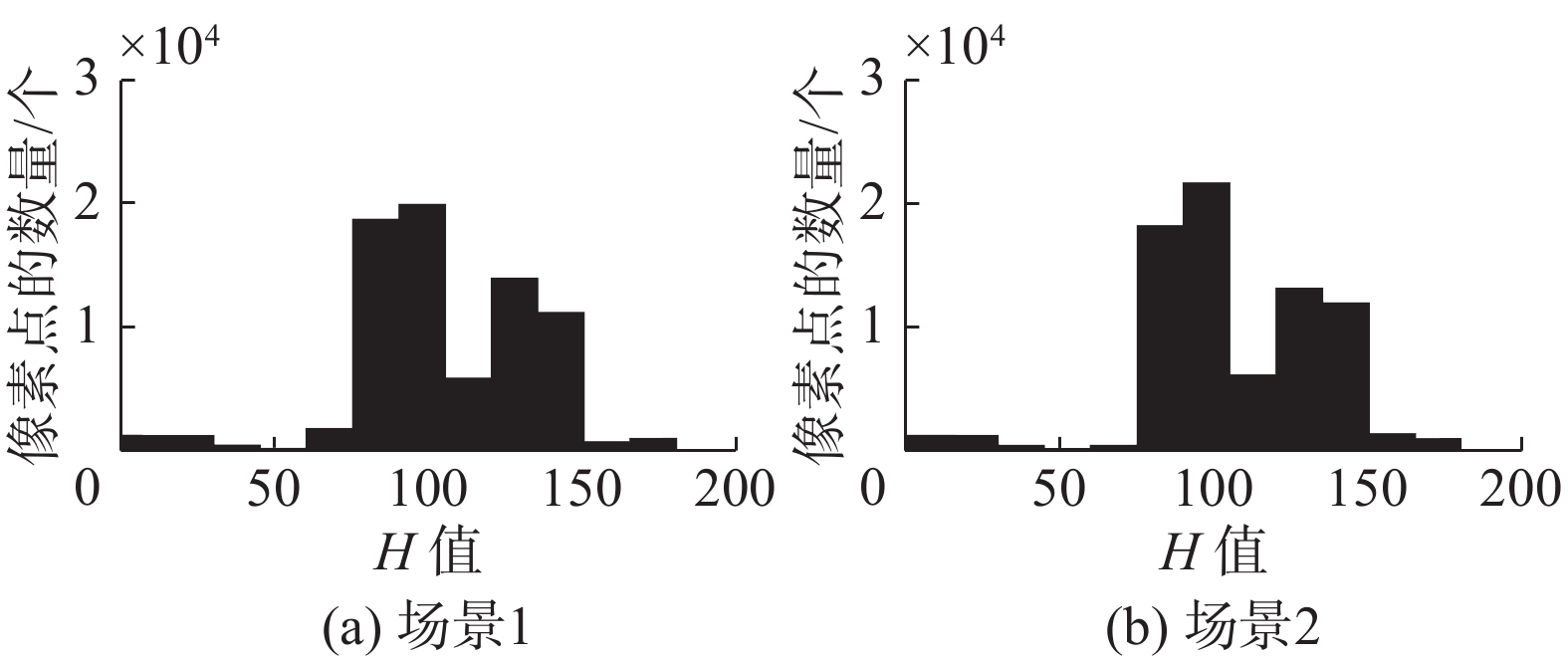

图5给出了基于模糊划分的两帧图像中目标区域的模糊直方图模型。

|

Download:

|

| 图 5 不同采样时刻场景图中目标模糊直方图 Fig. 5 Target fuzzy histograms in the scenes samples at different times | |

由图5可见,采用模糊划分建立目标区域的直方图模型时,两个场景中目标直方图模型的像素点均集中在相同的4个等级中,且两个直方图模型差异不大。这是由于色度等级采用模糊划分,弱化了划分阈值的作用,当色度在小范围内发生漂移时,对直方图模型的影响并不大,提高了所建直方图模型的稳定性。

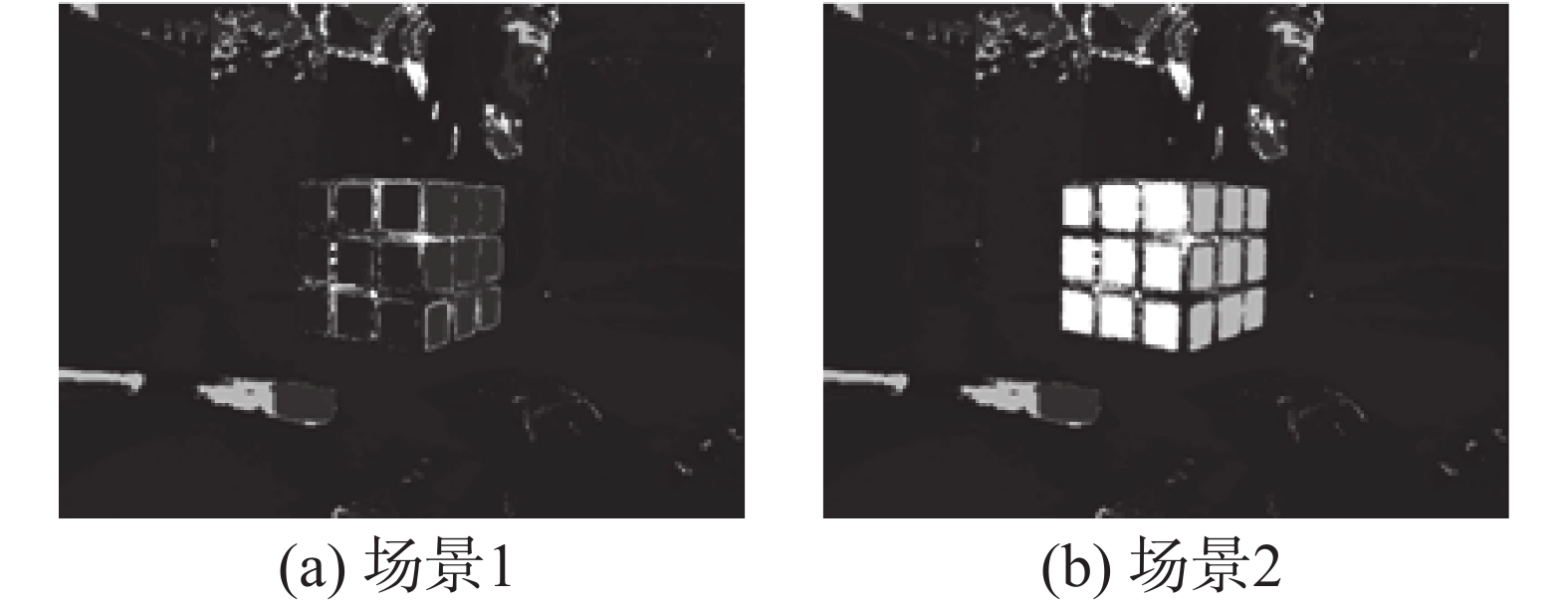

采用图5中的两个直方图模型进行反向投影,分别建立两个场景的概率分布图如图6和图7所示。

|

Download:

|

| 图 6 基于场景1的目标模糊直方图所得反向投影 Fig. 6 Projection images based on the target fuzzy histogram in scene 1 | |

从图6和图7的反向投影概率分布图可见,由于两个场景中目标的直方图模型相似,因此两个场景中的目标区的像素点都具有较大的概率值,即像素点的灰度值较大,这样目标能够很好地从场景图像中显现出来,有利于提高目标定位的准确性。

|

Download:

|

| 图 7 基于场景2的目标模糊直方图所得反向投影 Fig. 7 Projection images based on the target fuzzy histogram in scene 2 | |

采用传统直方图模型、显著性直方图模型[17]、多特征融合直方图模型[18]以及本文方法对不同光照情况下的目标进行对比跟踪实验。

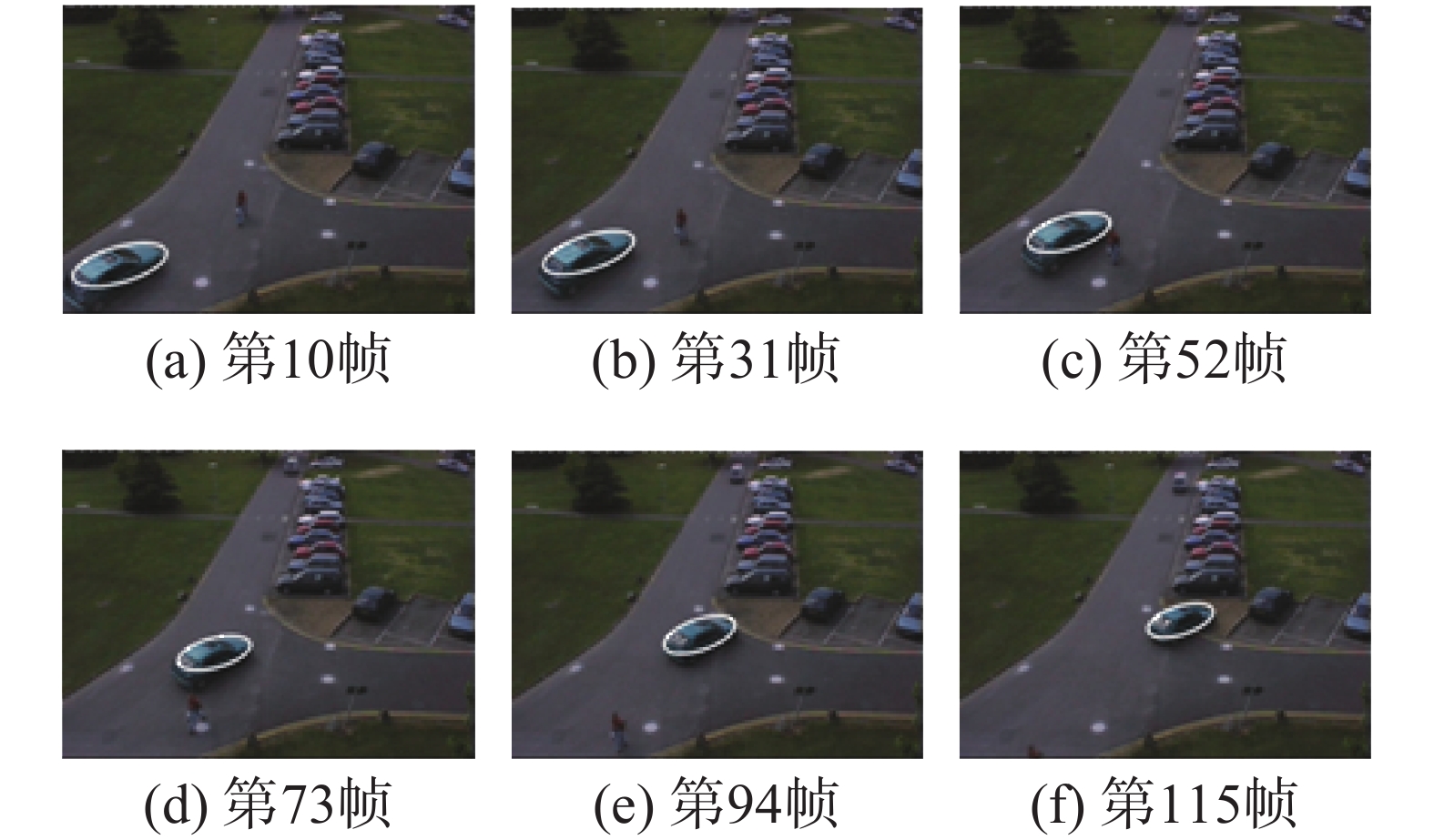

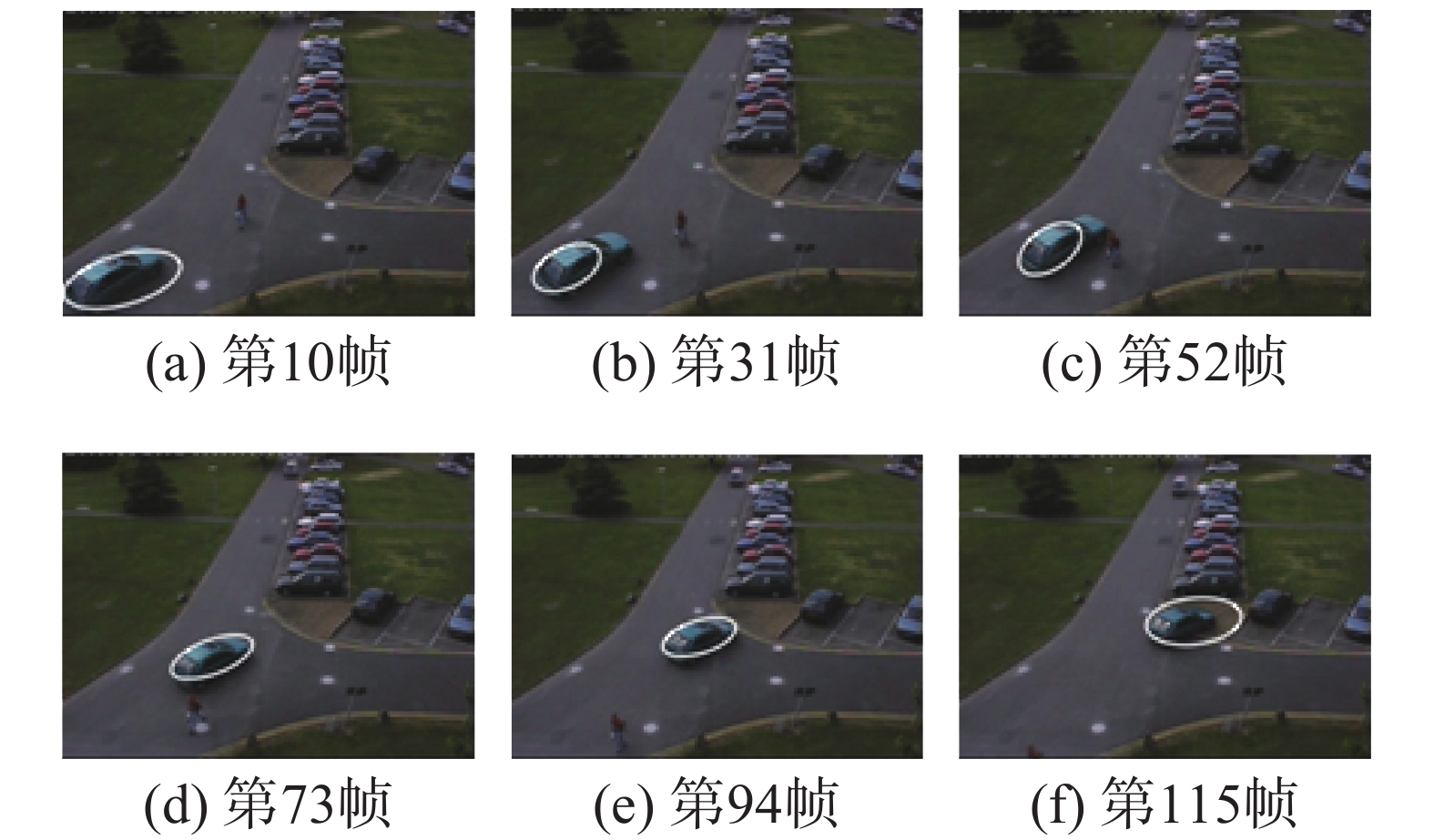

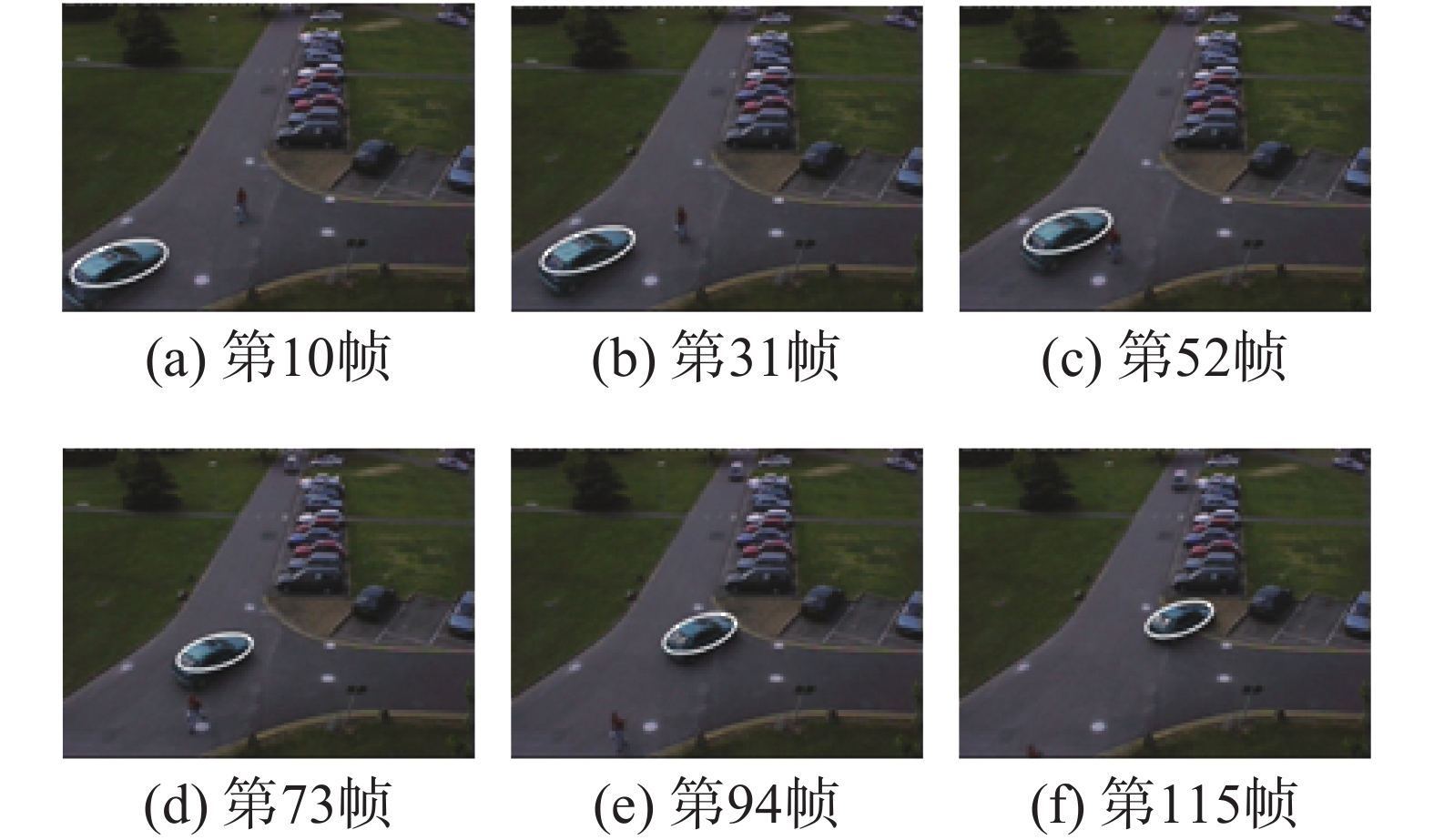

实验一 对PETS2001目标跟踪测试库中Camera2.mov视频中的车辆目标进行跟踪,视频光照稳定,目标明显,跟踪情况较为简单。上述4种跟踪方法所得跟踪结果如图8~11所示。

|

Download:

|

| 图 8 传统直方图模型跟踪效果 Fig. 8 Tracking result based on the traditionsl histogram model | |

|

Download:

|

| 图 9 显著性直方图模型跟踪效果 Fig. 9 Tracking result based on the saliency histogram model | |

|

Download:

|

| 图 10 多特征融合直方图模型跟踪效果 Fig. 10 Tracking result based on multiple features fusion histogram model | |

|

Download:

|

| 图 11 模糊直方图模型跟踪效果 Fig. 11 Tracking result based on fuzzy histogram model | |

从跟踪实验结果可见,由于目标所处场景光照稳定,目标色度漂移不明显,目标与其周围背景的颜色也有较明显的差异,因此跟踪情况较为简单。上述各种跟踪方法均可较为准确地完成目标跟踪任务。

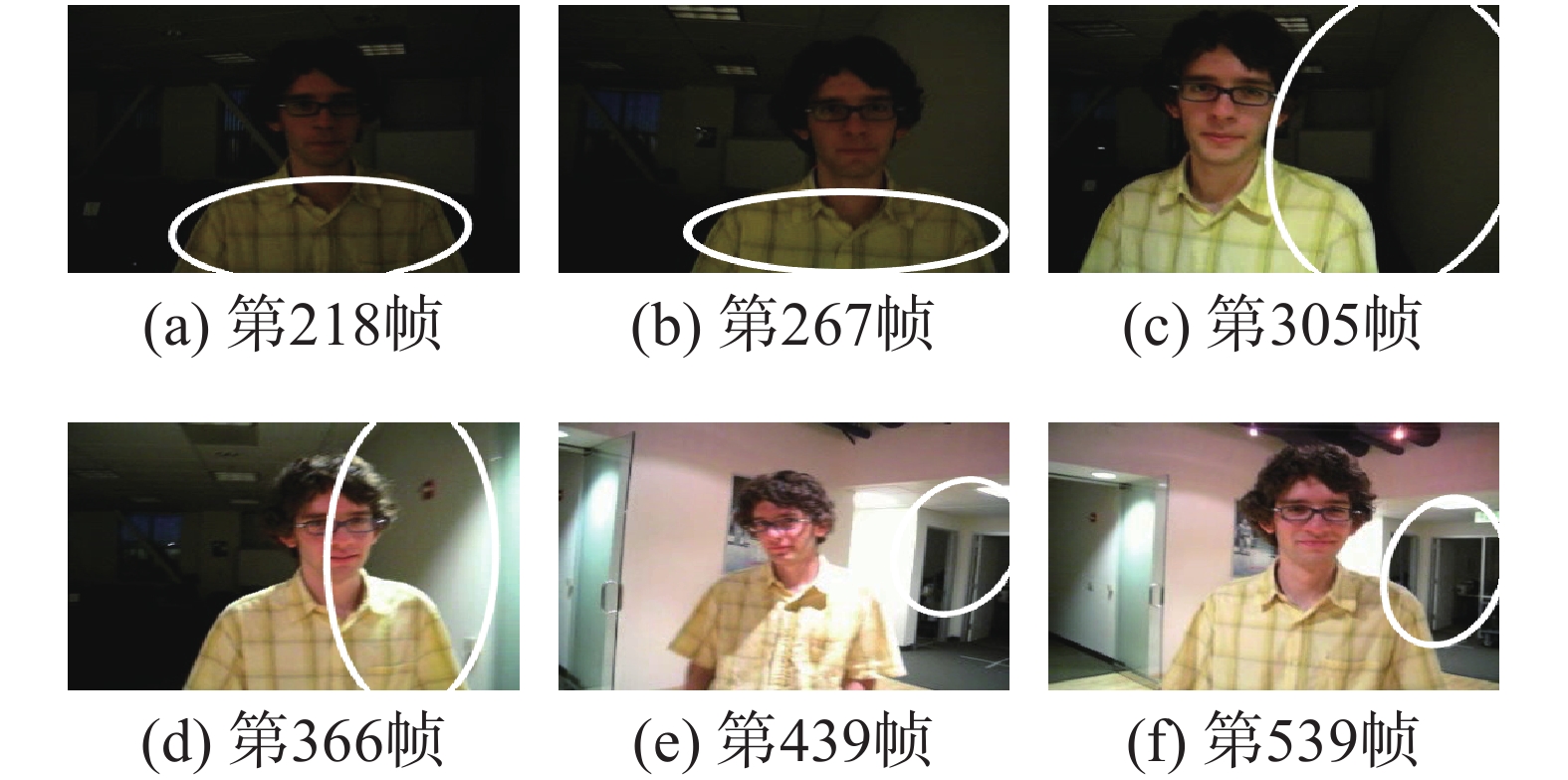

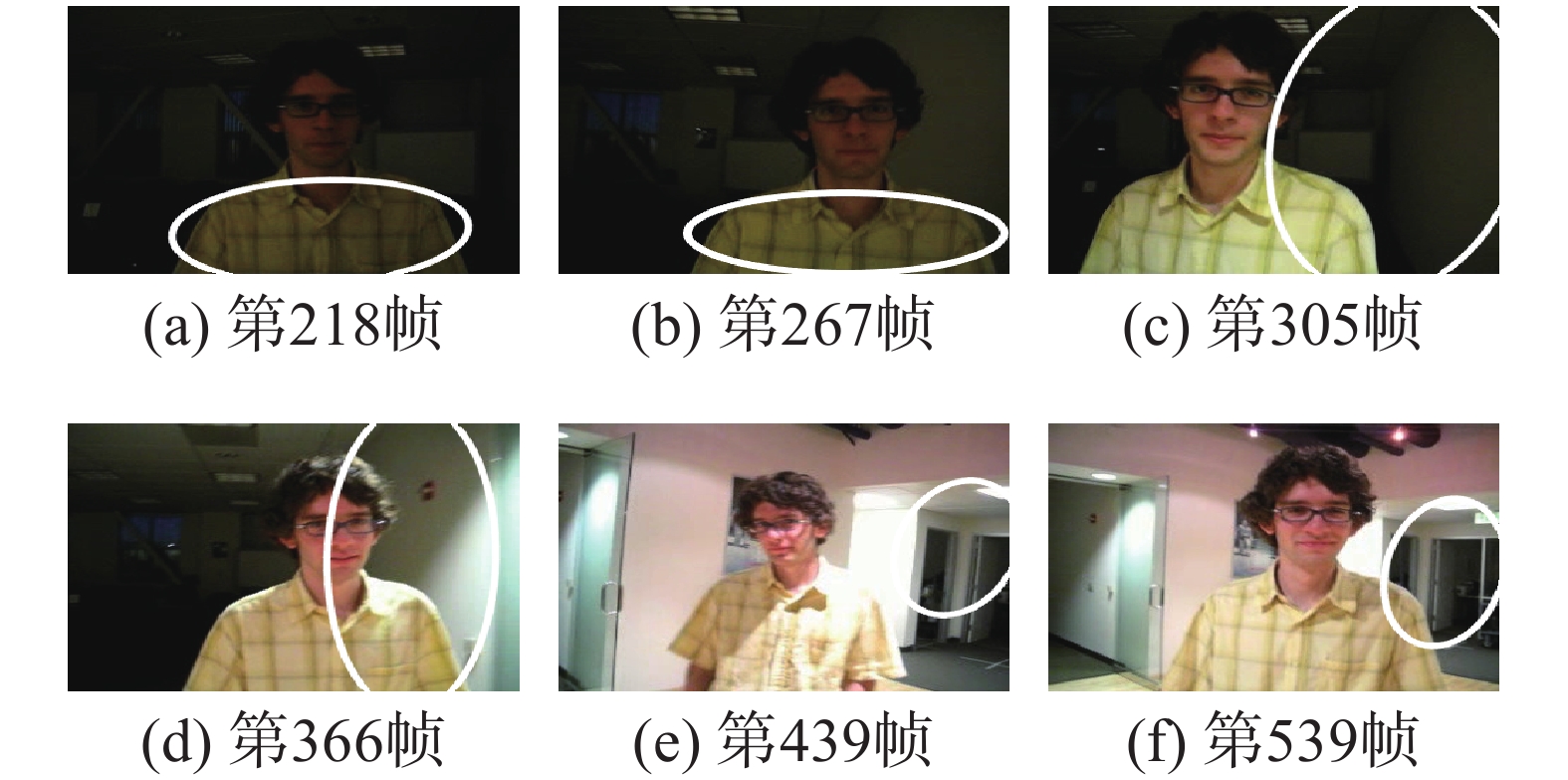

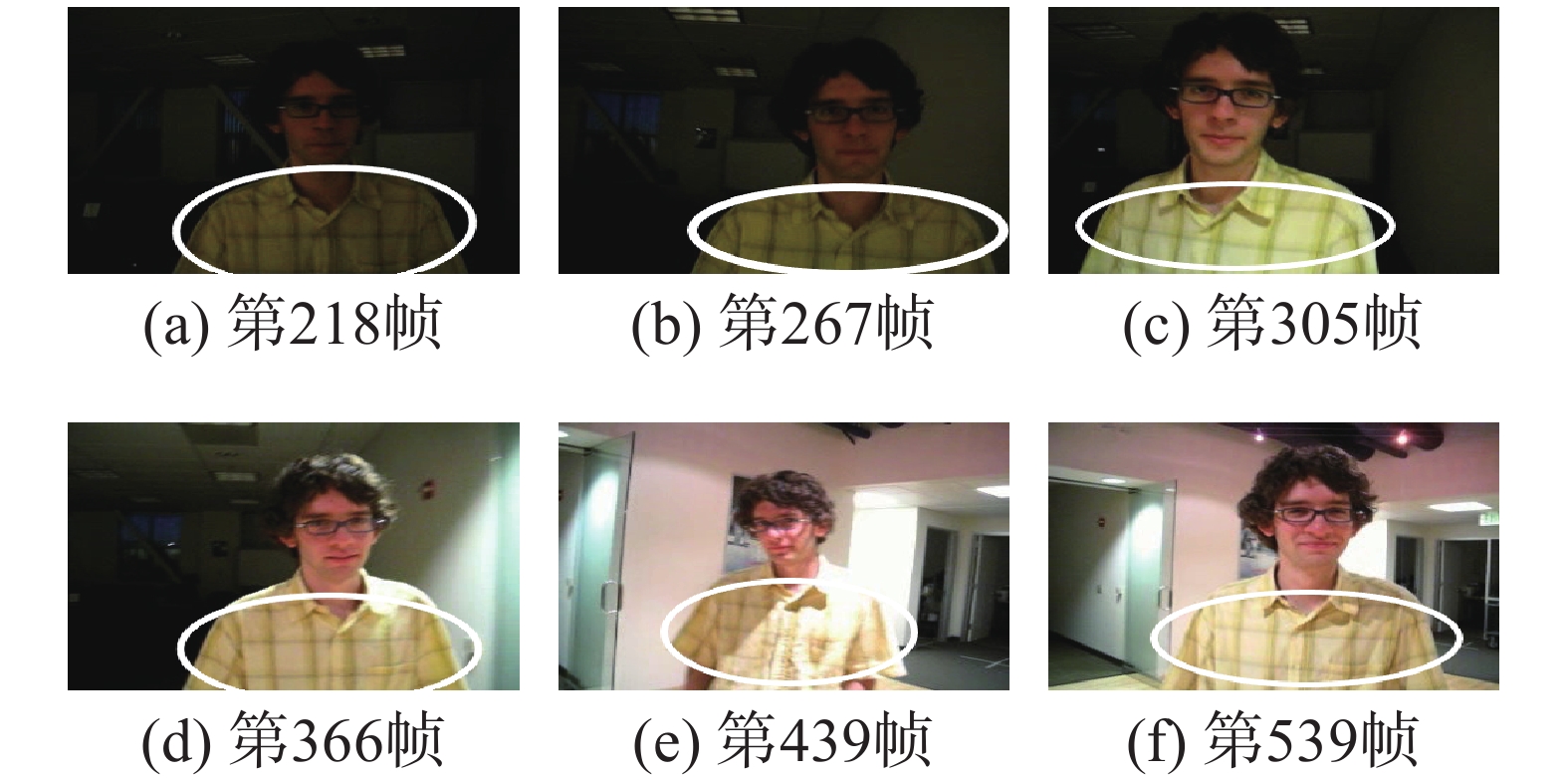

实验二 选择Visual Tracker Benchmark跟踪视频库中David序列图像中的人体目标进行跟踪。该跟踪场景中运动目标的光照由暗到亮变化显著,色度漂移明显,目标跟踪难度增大。图12~15给出了上述4种跟踪方法所得跟踪结果。

|

Download:

|

| 图 12 传统直方图模型跟踪效果 Fig. 12 Tracking result based on the traditional histogram model | |

|

Download:

|

| 图 13 显著性直方图模型跟踪效果 Fig. 13 Tracking result based on the saliency histogram model | |

|

Download:

|

| 图 14 多特征融合直方图模型跟踪效果 Fig. 14 Tracking result based on multiple features fusion histogram model | |

|

Download:

|

| 图 15 模糊直方图模型跟踪效果 Fig. 15 Tracking result based on fuzzy histogram model | |

由跟踪结果可见,跟踪过程中David从光线阴暗的房间走到明亮的房间,行走过程中目标由暗变亮,色度发生很大的变化,传统直方图模型无法适应强光照变化的干扰,很快导致跟踪失败。显著性直方图模型及多特征直方图模型方法利用所结合的辅助特征能够在一定程度上改善跟踪方法的适应能力,但当光照变化激烈时,所融合的特征也会受到严重干扰而变得不稳定,最终无法完成跟踪任务。本文采用模糊直方图模型对目标进行描述,提高了目标模型的稳定性,对跟踪过程中的色度漂移能够起到有效抑制,因此即使在光照发生明显变化时,仍然能够保证跟踪结果的鲁棒性。

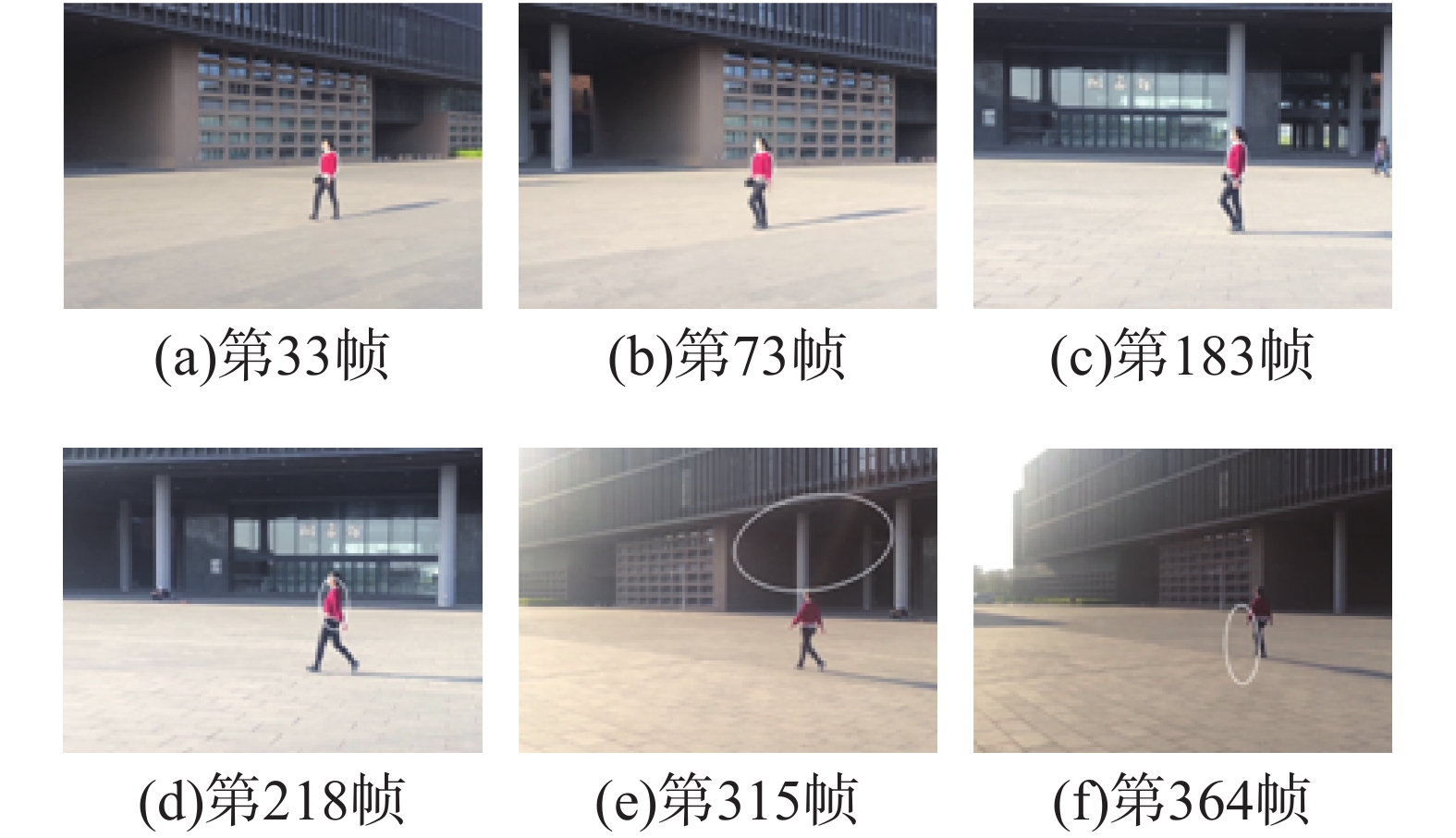

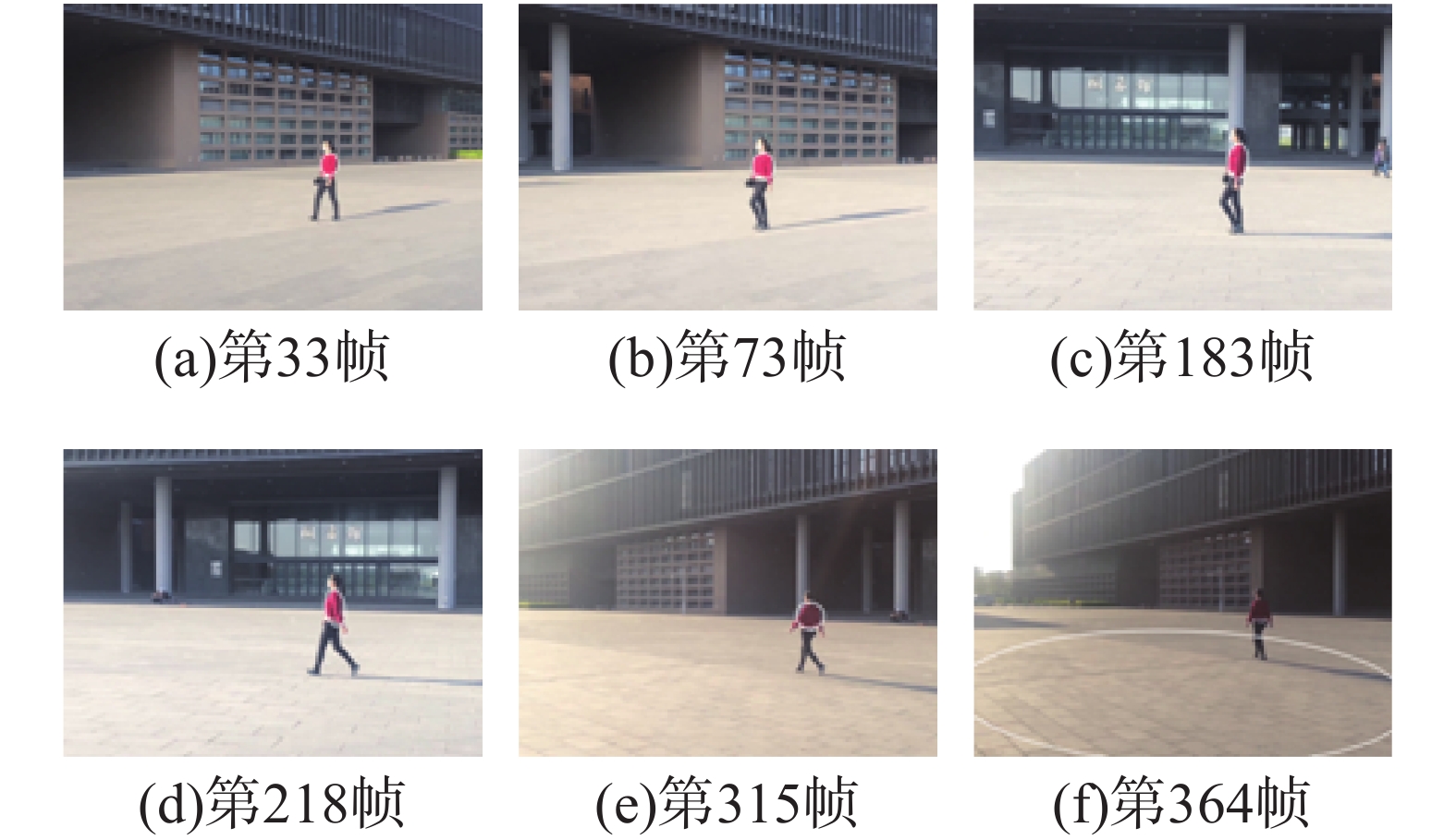

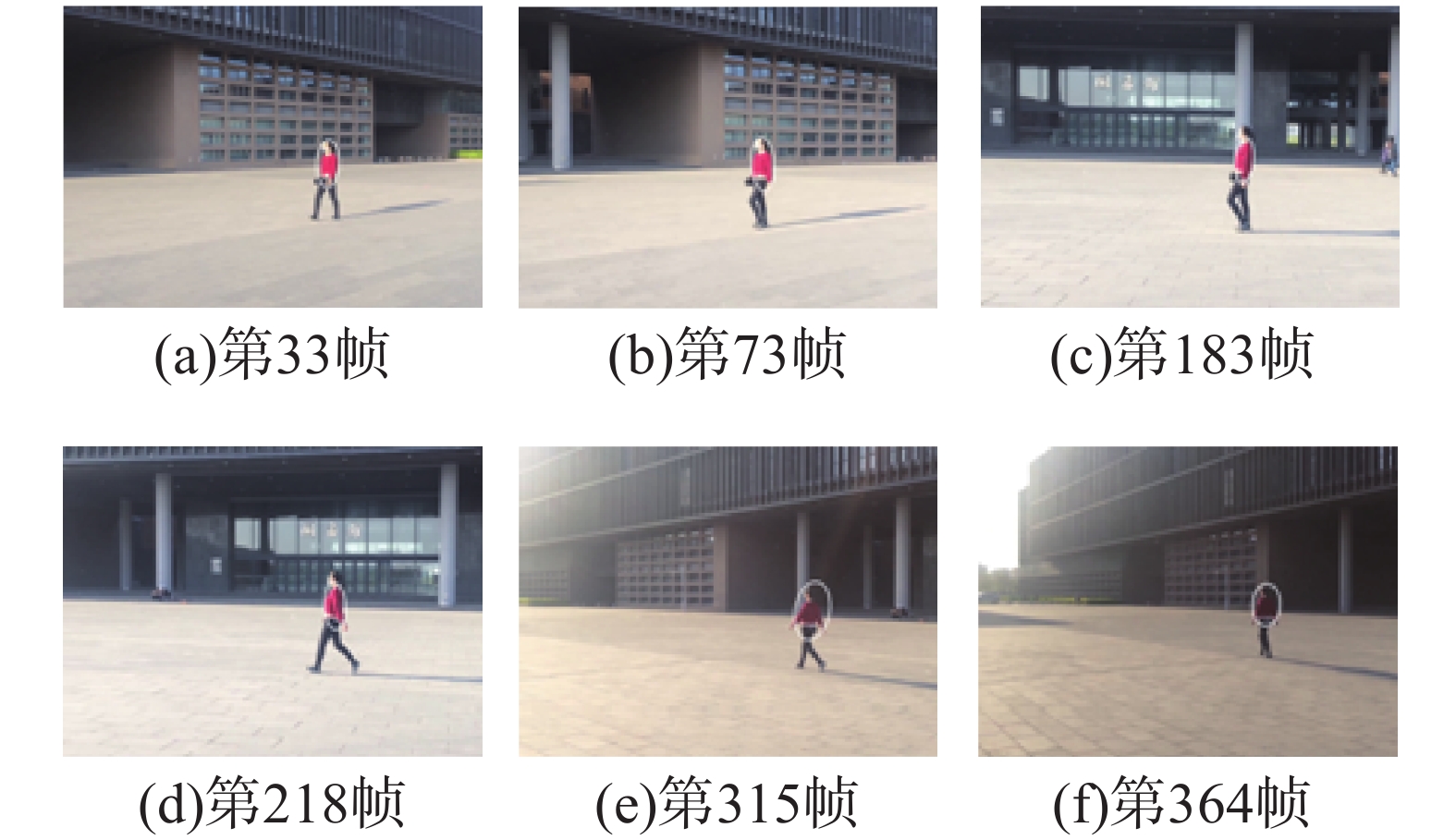

实验三 对实际光照变化复杂的运动目标进行跟踪实验,目标运动过程中分别处于顺光、侧光以及逆光等光照状态下,目标区的色度变化明显,准确定位难度较大。上述各跟踪方法的跟踪结果如图16~19所示。

|

Download:

|

| 图 16 传统直方图模型跟踪效果 Fig. 16 Tracking result based on the traditional histogram model | |

|

Download:

|

| 图 17 显著性直方图模型跟踪效果 Fig. 17 Tracking result based on the saliency histogram model | |

|

Download:

|

| 图 18 多特征融合直方图模型跟踪效果 Fig. 18 Tracking result based on multiple features fusion histogram model | |

|

Download:

|

| 图 19 模糊直方图模型跟踪效果 Fig. 19 Tracking result based on fuzzy histogram model | |

由于目标运动过程中光照变化较大,因此目标区的色度变化明显,由图16可见,传统直方图模型对光照变化十分敏感,目标从侧光变为逆光的过程中,目标定位错误,造成跟踪失败。在图17中,由于目标处于不同的光照条件下,目标的显著性色度信息因为色度漂移也会变得不稳定,因此导致跟踪效果不够理想,最终无法完成目标全过程的跟踪。在图18中,多特征融合直方图模型所融合的辅助特征能够在一定程度上改善目标定位的准确性,但当光照变化严重时,辅助特征也会发生不稳定变化,导致最终目标丢失。由图19可见,本文方法对色度化具有较好的适应能力,模糊直方图对光照变化引起的色度漂移具有良好的鲁棒性,通过及时更新目标模型,跟踪方法能够完成目标在顺光、侧光以及逆光下的跟踪。

3.3 性能分析实验一、二、三的结果给出了跟踪方法的定位性能,除此之外,计算速度也是评价跟踪方法性能的主要指标。实验中有的跟踪方法无法完成全过程跟踪,因此本文给出了有效跟踪时单帧平均跟踪时间及最大跟踪时间,如表1所示。

| 表 1 单帧跟踪对比时间 Tab.1 Tracking time of the single frame |

由表1可见:传统直方图模型建立简单,运算量最小;基于显著性直方图模型由于需要计算背景与目标信息的差异,因此建模所需计算量有所增加;多特征融合直方图模型由于需要提取边缘、纹理等辅助特征,因此建模过程中计算量增加较多。而本文方法在建立直方图模型时仅是色度等级划分方式有所不同,因此模型建立以及目标定位过程中所涉及的计算量与基本Camshift方法相当,跟踪过程中单帧最大运算时间小于40 ms,满足电视跟踪等系统的实时性要求。

4 结束语针对跟踪场景中光照不稳定造成目标色度漂移,从而影响跟踪性能的问题,提出了基于模糊直方图模型的目标跟踪方法,采用模糊划分色度等级的方式建立目标直方图模型,弱化了色度划分阈值对直方图模型的影响,降低了目标模型对光照变化等干扰的敏感性,提高了跟踪方法的适应性。跟踪实验结果表明,在光照变化明显等情况下,与传统跟踪方法相比,该方法具有更好的跟踪性能,能够完成在不同光照条件下的目标跟踪,且目标定位与跟踪所需计算量较小,运算时间满足实时性的要求。

| [1] |

QU Shiru, LIU Ningning. Face detection and tracking method based on SMQT and CAMSHIFT[J]. Journal of computational information systems, 2015, 11(14): 5153-5162. ( 0) 0)

|

| [2] |

黄晋英, 宋国浩, 兰艳亭, 等. 交比不变的Camshift跟踪方法[J]. 光学精密工程, 2016, 24(4): 945-953. HUANG Jinying, SONG Guohao, LAN Yanting, et al. Camshift tracking based on constant cross ratio[J]. Optics and precision engineering, 2016, 24(4): 945-953. (  0) 0)

|

| [3] |

刘威, 陈先桥, 初秀民. 基于置信规则推理方法的雷达目标跟踪[J]. 哈尔滨工程大学学报, 2016, 37(6): 826-831. LIU Wei, CHEN Xianqiao, CHU Xiumin. Radar target tracking via belief rule-based methodology[J]. Journal of Harbin Engineering University, 2016, 37(6): 826-831. (  0) 0)

|

| [4] |

王春平, 王暐, 刘江义, 等. 基于色度饱和度−角度梯度直方图特征的尺度自适应核相关滤波跟踪[J]. 光学精密工程, 2016, 24(9): 2293-2301. WANG Chunping, WANG Wei, LIU Jiangyi, et al. Scale adaptive kernelized correlation filter tracking based on HHS-OG feature[J]. Optics and precision engineering, 2016, 24(9): 2293-2301. (  0) 0)

|

| [5] |

朱齐丹, 韩瑜, 蔡成涛. 全景视觉非线性核相关滤波目标跟踪技术[J]. 哈尔滨工程大学学报, 2018, 39(7): 1220-1226. ZHU Qidan, HAN Yu, CAI Chengtao. Omni-directional visual object tracking using nonlinear kernelized correlation filters[J]. Journal of Harbin Engineering University, 2018, 39(7): 1220-1226. (  0) 0)

|

| [6] |

LIU Shenshen, ZHOU Pu, MA Chanyu. Athlete tracking model based on morphological noise removal camshift algorithm[J]. International journal of earth science and engineering, 2015, 8(5): 2246-2251. ( 0) 0)

|

| [7] |

于蕾, 夏业儒, 杨良洁. 改进理解诊断跟踪系统的目标跟踪方法[J]. 应用科技, 2018, 45(4): 76-81. YU Lei, XIA Yeru, YANG Liangjie. A target tracking algorithm for the improved understanding, diagnosing and tracking system[J]. Applied science and technology, 2018, 45(4): 76-81. (  0) 0)

|

| [8] |

YIN Minghao, ZHANG Jin, SUN Hongguang, et al. Multi-cue-based CamShift guided particle filter tracking[J]. Expert systems with applications, 2011, 38(5): 6313-6318. DOI:10.1016/j.eswa.2010.11.111 ( 0) 0)

|

| [9] |

HUANG Danchi, LI Lijuan. Face tracking algorithm based on improved Camshift and surf algorithm[J]. Journal of computational information systems, 2015, 11(3): 893-901. ( 0) 0)

|

| [10] |

HSIA C H, LIOU Y J, CHIANG J S. Directional prediction camshift algorithm based on adaptive search pattern for moving object tracking[J]. Journal of real-time image processing, 2016, 12(1): 183-195. DOI:10.1007/s11554-013-0382-x ( 0) 0)

|

| [11] |

修春波, 卢少磊, 任晓. 基于微分信息融合的Mean Shift改进跟踪算法[J]. 系统工程与电子技术, 2014, 36(5): 1004-1009. XIU Chunbo, LU Shaolei, REN Xiao. Improved mean shift tracking algorithm based on differential information[J]. Systems engineering and electronics, 2014, 36(5): 1004-1009. DOI:10.3969/j.issn.1001-506X.2014.05.31 (  0) 0)

|

| [12] |

修春波, 魏世安, 万蓉凤. 二维联合特征模型的自适应均值漂移目标跟踪[J]. 光电子·激光, 2015, 26(2): 342-351. XIU Chunbo, WEI Shian, WAN Rongfeng. CamShift target tracking based on two-dimensional joint characteristics[J]. Journal of optoelectronics·laser, 2015, 26(2): 342-351. (  0) 0)

|

| [13] |

张天翼, 杨忠, 韩家明, 等. 基于连续自适应均值漂移和立体视觉的无人机目标跟踪方法[J]. 应用科技, 2018, 45(2): 55-59. ZHANG Tianyi, YANG Zhong, HAN Jiaming, et al. Approach of vision navigation of UAV based on continuously adaptive mean-shift and stereo vision[J]. Applied science and technology, 2018, 45(2): 55-59. (  0) 0)

|

| [14] |

刘明华, 汪传生, 王宪伦. 基于多特征自适应融合的均值迁移目标跟踪算法[J]. 光电子·激光, 2015, 26(8): 1583-1592. LIU Minghua, WANG Chuansheng, WANG Xianlun. Mean-shift target tracking algorithm based on adaptive multi-features fusion[J]. Journal of optoelectronics·laser, 2015, 26(8): 1583-1592. (  0) 0)

|

| [15] |

夏瑜, 吴小俊, 李菊, 等. 基于多特征自适应融合的分类采样跟踪算法[J]. 光电子·激光, 2016, 27(3): 325-331. XIA Yu, WU Xiaojun, LI Ju, et al. Classified sampling tracking algorithm based on adaptive multiple features fusion[J]. Journal of optoelectronics·laser, 2016, 27(3): 325-331. (  0) 0)

|

| [16] |

杨超, 蔡晓东, 王丽娟, 等. 一种改进的CAMshift跟踪算法及人脸检测框架[J]. 计算机工程与科学, 2016, 38(9): 1863-1869. YANG Chao, CAI Xiaodong, WANG Lijuan, et al. An improved CAMShift tracking algorithm and a face detection framework[J]. Computer engineering and science, 2016, 38(9): 1863-1869. DOI:10.3969/j.issn.1007-130X.2016.09.019 (  0) 0)

|

| [17] |

修春波, 魏世安. 显著性直方图模型的Camshift跟踪方法[J]. 光学精密工程, 2015, 23(6): 1749-1757. XIU Chunbo, WEI Shian. Camshift tracking with saliency histogram[J]. Optics and precision engineering, 2015, 23(6): 1749-1757. (  0) 0)

|

| [18] |

林建华, 刘党辉, 邵显奎. 多特征融合的Camshift算法及其进一步改进[J]. 计算机应用, 2012, 32(10): 2814-2816, 2820. LIN Jianhua, LIU Danghui, SHAO Xiankui. Multi-feature fusion Camshift algorithm and its further improvement[J]. Journal of computer applications, 2012, 32(10): 2814-2816, 2820. (  0) 0)

|

2019, Vol. 14

2019, Vol. 14