2. 江西农业大学 软件学院,江西 南昌 330045

2. School of Software, Jiangxi Agricultural University, Nanchang 330045, China

随着物联网及信息技术的发展,数据资源呈海量特征。在数据量不断增大的同时,数据标注结构的复杂度也在增加,传统的单标记学习已不能满足现实应用的需求,因此多标记学习的重要性逐渐突显。在多标记学习中,每个样本在一个特征向量下,可能同时隶属于多个类别标记。近年来,多标记学习问题已成为机器学习、数据挖掘和模式识别等领域的研究热点之一[1-4]。

波兰数学家Pawlak教授于1982年提出的粗糙集理论是一种用于处理不精确、不完全和不相容知识的数学工具[5],近年来,该理论在机器学习和数据挖掘领域得到了广泛的应用[6-7]。属性约简,又称特征选择,是粗糙集理论的核心内容之一,其目的是在保持分类能力不变的条件下,删除不相关或冗余特征。与单标记学习一样,多标记学习也面临着“维数灾难”的挑战。高维数据不仅影响算法的执行效率,也降低了分类器的分类性能,而特征降维技术是解决维数灾难的有效方法。目前,针对单标记数据特征降维技术的研究较为广泛,而针对多标记数据特征降维技术的研究相对较少。因此,基于多标记学习特征选择的研究具有重要的理论和应用意义。另外,在现实应用领域中,数据特征的获取往往需要花费一定的代价,为此从代价敏感的视角研究多标记特征选择问题显得尤为重要。

1 相关工作近年来,在多标记特征提取方面已经取得一些有意义的研究成果。如Sun等[8]提出的多标记降维方法(LDA),其直接将单标记特征降维的方法应用于多标记特征降维中,忽略了标记之间的相关性。Zhang等[9]采用核矩阵进行映射降维,设计了一种最大化依赖度的多标记特征降维方法(MDDM)。Yu等[10]提出了一种有监督的多标记潜在语义索引降维方法(MLSI)。多标记特征提取能够实现特征降维的效果,但由于其忽略了标记之间的关联以及损失了原始特征的物理含义,这对多标记学习问题的研究造成了较大的困难。

多标记特征选择通过设计特征度量准则从原始特征中剔除冗余或不相关特征,得到一组相对最优的特征子集,从而可有效降低特征空间的维数,提升算法的分类性能。特征选择的结果能够保持原始特征的物理含义,使得多标记学习的研究更容易理解。目前许多研究人员针对多标记特征选择开展研究,段洁等[11]重新定义了多标记邻域粗糙集的下近似和依赖度的计算方法,在此基础上,设计了一种基于邻域粗糙集的特征选择算法(ARMLNRS)。王晨曦等[12]从每个标记对样本不同分组的角度出发,提出了基于信息粒化的多标记特征选择算法(MFIG)。Lin等[13]在乐观、中立和悲观这3种不同的视角下,通过3种基于邻域互信息准则进行特征选择。刘景华等[14]通过引入局部子空间模型,构建了一种基于局部子空间的多标记特征选择算法(MFSLS)。上述算法的计算复杂度相对较大。后来Lee等[15]通过特征信息熵之差最大化和正向搜索的方法选择特征子集,设计时间复杂度较低的特征选择算法,但其没有给出和分析的信息熵阈值对特征子集的影响。张振海等[16]利用信息增益下的阈值选择设计了一种多标记特征选择算法(MLFSIE)。综上所述,这些多标记特征选择算法并未考虑到特征的代价敏感问题。

在许多实际应用领域中,获取和采集数据是需要花费代价的,因此从代价敏感的视角研究多标记学习具有重要的意义。针对当前多标记特征选择算法的计算复杂度较大且未考虑特征代价的问题,提出了一种面向代价敏感数据的多标记特征选择算法。首先,该方法计算出特征与标记集合之间的信息增益,在此基础上重新定义了特征重要度的计算方法,并根据服从正态分布的特征重要度与特征代价的标准差之间的差值,提出了一种合理的阈值选择方法,从而实现对冗余或不相关特征的剔除,同时能得到总代价较低的特征子集。为了验证算法的有效性,利用Mulan平台上的真实多标记数据集进行实验比较和分析,通过实验结果进一步验证算法的有效性和可行性。

2 基本知识 2.1 多标记学习在粒计算理论中,多标记数据可表示成一个多标记决策表

定义1 给定多标记决策表

| ${R_a} = \{ ({x_i},{x_j}) \in U \times U,f({x_i},a) = f({x_j},a)\} $ |

定义2 给定多标记决策表

| $ {R_{{l_t}}} = \{ ({x_i},{x_j}) \in U \times U,f({x_i},{l_t}) = f({x_j},{l_t})\} $ |

基于条件信息熵下的特征选择是研究者从信息观视角对高维数据进行特征选择,该方法可有效地度量信息的不确定性程度。

定义3 给定多标记决策表

| $H(B) = - \sum\limits_{i = 1}^q {p({X_i})} \log p({X_i})$ |

当信息熵

定义4 给定多标记决策表

| $H(L{\rm{|}}B) = - \sum\limits_{i = 1}^q {p({X_i})} \sum\limits_{j = 1}^p {p({Y_j}|{X_i})} \log \; p({Y_j}|{X_i})$ |

由定义4可知,当

定义5 给定多标记决策表

| ${\rm {IG}}(L{\rm{|}}B) = H(L) - H(L{\rm{|}}B)$ |

信息增益

为了使得各个特征与标记之间的信息增益值在同一量纲下比较,需先对信息增益的值进行归一化处理:

| ${\rm{NIG}}(L{\rm{|}}B) = \frac{{{\rm {IG}}(L{\rm{|}}B)}}{{H(B) + H(L)}}$ |

在机器学习和数据挖掘领域,代价敏感学习是十大最具有挑战性问题之一[17]。因此,将特征代价引入到多标记特征选择具有重要的意义。

定义6 给定基于测试代价的多标记决策表

| ${\rm{CSIG}}(D{\rm{|}}{a_i}) = {\rm{NIGS}}(D{\rm{|}}{a_i})^{\rm{*}} - {\mathop{\rm Cos}\nolimits} {\rm{t}}({a_i})^*$ |

由定义5可得,标记集合

| ${\rm{NIGS}}(D{\rm{|}}{a_i}) = \sum\limits_{t = 1}^k {{\rm{NIG}}({l_t}{\rm{|}}{a_i})} $ |

为了获取合理的阈值,使得信息增益的值服从正态分布:

| ${\rm{NIGS}}(D{\rm{|}}{\rm{ }}{a_i})^{\rm{*}} = \frac{{{\rm{NIGS}}(D{\rm{|}}{\rm{|}}{a_i}) - \mu }}{\sigma }$ |

式中:

| $\mu {\rm{ = }}\frac{1}{k}\left(\sum\limits_{t = 1}^k {{\rm{NIG}}({l_t}{\rm{|}}{a_i}} )\right)$ |

| $\sigma = \sqrt {\frac{1}{k}\sum\limits_{t = 1}^k {{{\left[{\rm{NIG}}({l_t}|{a_i}) - \mu \right]}^2}} } $ |

在计算测试代价下的标记集合下特征重要度之前,需先将特征代价进行归一化处理:

| ${\mathop{\rm Cos}\nolimits} {\rm{t(}}{{{a}}_i}{{\rm{)}}^*} = \frac{{{\mathop{\rm Cos}\nolimits} {\rm{t(}}{a_i}{\rm{) - min(Cost(}}{a_j}{\rm{))}}}}{{{\rm{max(Cost(}}{a_j}{\rm{)) - min(Cost(}}{a_j}{\rm{))}}}}$ |

式中:

定义7 给定基于测试代价的多标记决策表

| $\delta {\rm{ = }}\frac{1}{m}\sum\limits_{i = 1}^m {\left| {{\rm{CSIG}}(D{\rm{|}}{a_i})} \right|} - {\mathop{\rm Cos}\nolimits} {\rm{t}}.\sigma $ |

式中:

| ${\mathop{\rm Cos}\nolimits} {\rm{t}}.\sigma = \sqrt {\frac{1}{m}\sum\limits_{i = 1}^m \left[{{\mathop{\rm Cos}\nolimits} {\rm{t}}({a_i})} - {\mathop{\rm Cos}\nolimits} {\rm{t}}.\mu \right]^2} $ |

| ${\mathop{\rm Cos}\nolimits} {\rm{t}}.\mu {\rm{ = }}\frac{1}{m}\left(\sum\limits_{i = 1}^m {{\mathop{\rm Cos}\nolimits} {\rm{t}}({a_i})} \right)$ |

式中:

性质1 若特征

证明 由信息论理论结合定义4和定义5可推导出,

对于任意特征

性质2 标记集合D 在特征

证明 由性质1可得,若单个标记与特征

性质3 阈值

证明 由性质2和定义7可知,特征代价的标准差

根据上述分析可知,在多标记学习算法中,一个特征不仅与某一标记具有相关性,也可能同时与多个标记具有相关性,因此需要计算单个特征与标记集合之间的相关性。在此基础上,从代价敏感学习的视角,提出了一种基于测试代价的特征重要度;然后根据服从正态分布的特征重要度以及特征代价的标准差设计出一种合理的阈值选择方法;最后,通过计算的阈值删除冗余或不相关的特征。

本文提出的代价敏感数据的多标记特征选择算法(CSMLFSIE)具体步骤如下:

算法 代价敏感数据的多标记特征选择算法(CSMLFSIE)

输入 多标记决策表

输出 特征子集 Red。

1)初始化

2)对于

①计算在特征集 A 下每个特征的信息增益

②每个特征相对于每个标记的条件信息熵

3)对于

4)对于

①计算标记集合下每个特征的重要度

②计算阈值

5)对于

若

6)输出特征子集 Red,算法结束。

4.2 时间复杂度分析代价敏感数据的多标记特征选择算法中:步骤1)初始化一个变量存放特征选择后的特征子集,其时间复杂度为

为了分析本文算法在计算复杂度上的优越性,将本文算法分别与CSMLPA[19]算法和MLDM算法进行比较。CSMLPA算法是基于文献[20]的正区域模型设计的,并且考虑了测试代价的多标记特征选择算法,算法采用的是向前启发式搜索策略,其计算复杂度主要消耗在计算加入单个特征到特征子集后的正域大小,时间复杂度为

为了验证本文的CSMLFSIE算法的性能,从Mulan数据集中选取了Emotions、Birds和Yeast 这3个真实数据集进行实验测试和分析。实验将算法CSMLFSIE与MLFSIE、CSMLPA、MLPA和MLDM进行对比分析,其中,MLFSIE[16]是一类基于信息熵的多标记特征选择算法,CSMLPA算法是基于文献[20]的正区域模型设计的考虑了测试代价的多标记特征选择算法,MLPA是一种利用文献[20]中的正区域模型改进的多标记特征选择算法,MLDM算法是基于文献[21]的差别矩阵方法改进的多标记特征选择算法。最后通过IBLR-ML多标记分类器验证上述算法特征选择结果的分类性能。

实验过程中首先采用以上5种特征选择算法分别对3个数据集进行特征降维,然后使用分类算法对降维后的数据集采用10倍交叉验证法验证算法的有效性。本实验的测试环境:CPU为Inter(R) Core(TM) i5-4590s (3.0 GHz),内存8.0 GB,算法编程语言为Python和Java,使用的开发工具分别是记事本和Eclipse 4.7。

5.1 数据集实验中选取的3个真实数据集的相关信息如表1所示,表中Yeast[22]数据集描述的是酵母菌的基因功能分类,Emotions[23]数据集是来自于某音乐学院的音频剪辑,Birds[24]数据集通过鸟叫声的记录来区分鸟的种类。其中,Yeast数据集涉及的是生物信息领域,而Emotions和Birds数据集涉及的是音频信息领域。表1中对数据集中的实例个数、特征数、标记数、标记基数和总代价进行了描述,其中,标记基数用于统计训练集中实例的平均标记个数,总代价是指利用正态分布函数为数据集中的所有特征生成的代价总和。

| 表 1 多标记数据集 Tab.1 Multi-label datasets |

文中选用了代价约简率以及平均分类精度(average precision,AP)、汉明损失(Hamming loss,HL)、覆盖率(Coverage)、1错误率(one error,OE)、排序损失(ranking loss,RL)这5种多标记评价性能指标来评价算法性能。给定一组多标记对象集合

1) 代价约简率是考虑特征代价的特征子集

| ${\rm{PC}} = \frac{{{\mathop{\rm Cos}\nolimits} {{\rm t}_B}(D)}}{{{\mathop{\rm Cos}\nolimits} {{\rm t}_A}\left( D \right)}}$ |

2) 平均分类精度(AP)是指在标记预测序列中,排在相关标记之前的标记仍是相关标记的比率:

| ${\rm{AP}}{\rm{ = }}\frac{1}{m}\sum\limits_{i = 1}^m {\frac{1}{{{\rm{|}}{Y_i}{\rm{|}}}}} \sum\limits_{\lambda \in {Y_i}} {\frac{{|\left\{ {{\lambda{\text{′}}} \in {Y_i}:{r_i}({\lambda {\text{′}}}) \leqslant {r_i}(\lambda )} \right\}|}}{{{r_i}(\lambda )}}} $ |

3) 汉明损失(HL)是指预测出的标记与实际标记的平均差异值:

| ${\rm{HL}} = \frac{1}{m}\sum\limits_{i = 1}^m {\frac{{|{Y_i}\varDelta {Z_i}|}}{M}} $ |

其中

4) 覆盖率(Coverage)是指所有对象实际包含的所有标记所需最大的排序距离:

| ${\rm{Coverage}}{\rm{ = }}\frac{1}{m}\sum\limits_{i = 1}^m {\mathop {\max }\limits_{{\textit{λ}} \in {Y_i}} } \,{r_i}({\textit{λ}}) - 1$ |

5) 1错误率(OE)是指预测出的标记排序最靠前的标记不在实际对象中的比率:

| ${\rm{OE}}{\rm{ = }}\frac{1}{m}\sum\limits_{i = 1}^m {\delta (\mathop {\arg \min }\limits_{{\textit{λ}}\in {Y_i}} {r_i}({\textit{λ}}))} $ |

若

6) 排序损失(RL)是指预测出的标记中实际不包含的标记比实际包含的标记排序高的比率:

| $ \begin{split} {\rm{RL}} = & \frac{1}{m}\sum\limits_{i = 1}^m {\dfrac{1}{{\left\| {{Y_i}} \right\|\left\| {{{\overline Y}_i}} \right\|}}} \times\\ & |\left\{ {\left( {{{\textit{λ}}_a},{{\textit{λ}}_b}} \right):{r_i}\left( {{{\textit{λ}}_a}} \right) > {r_i}\left( {{{\textit{λ}}_b}} \right)} \right.\left( {{{\textit{λ}}_a},{\lambda _b}} \right) \in {Y_i} \times {{\overline Y}_i}\} | \end{split} $ |

平均分类精度越大说明分类性能越好,代价约简率、汉明损失、覆盖率、1错误率、排序损失越小说明分类性能越好。

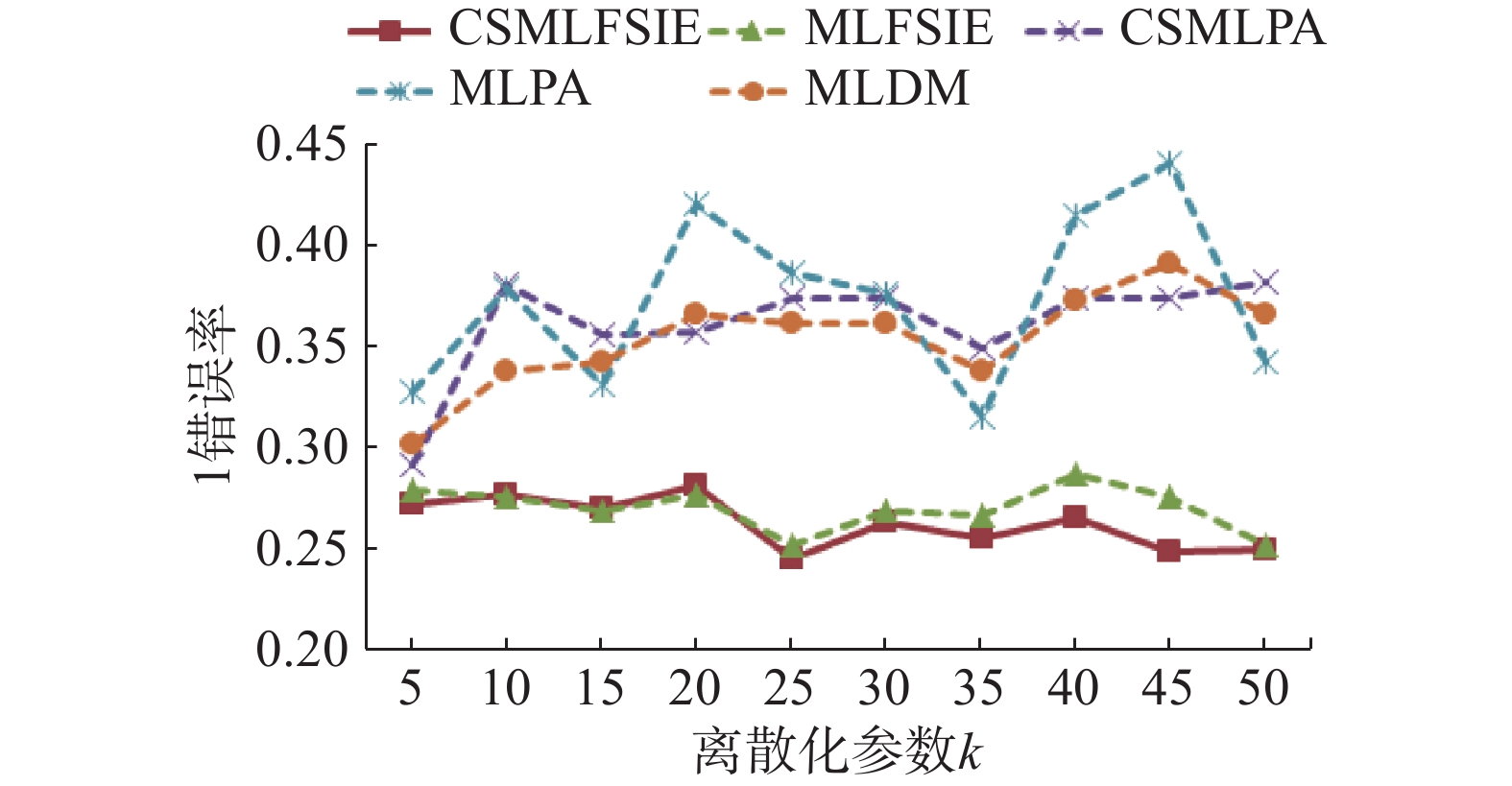

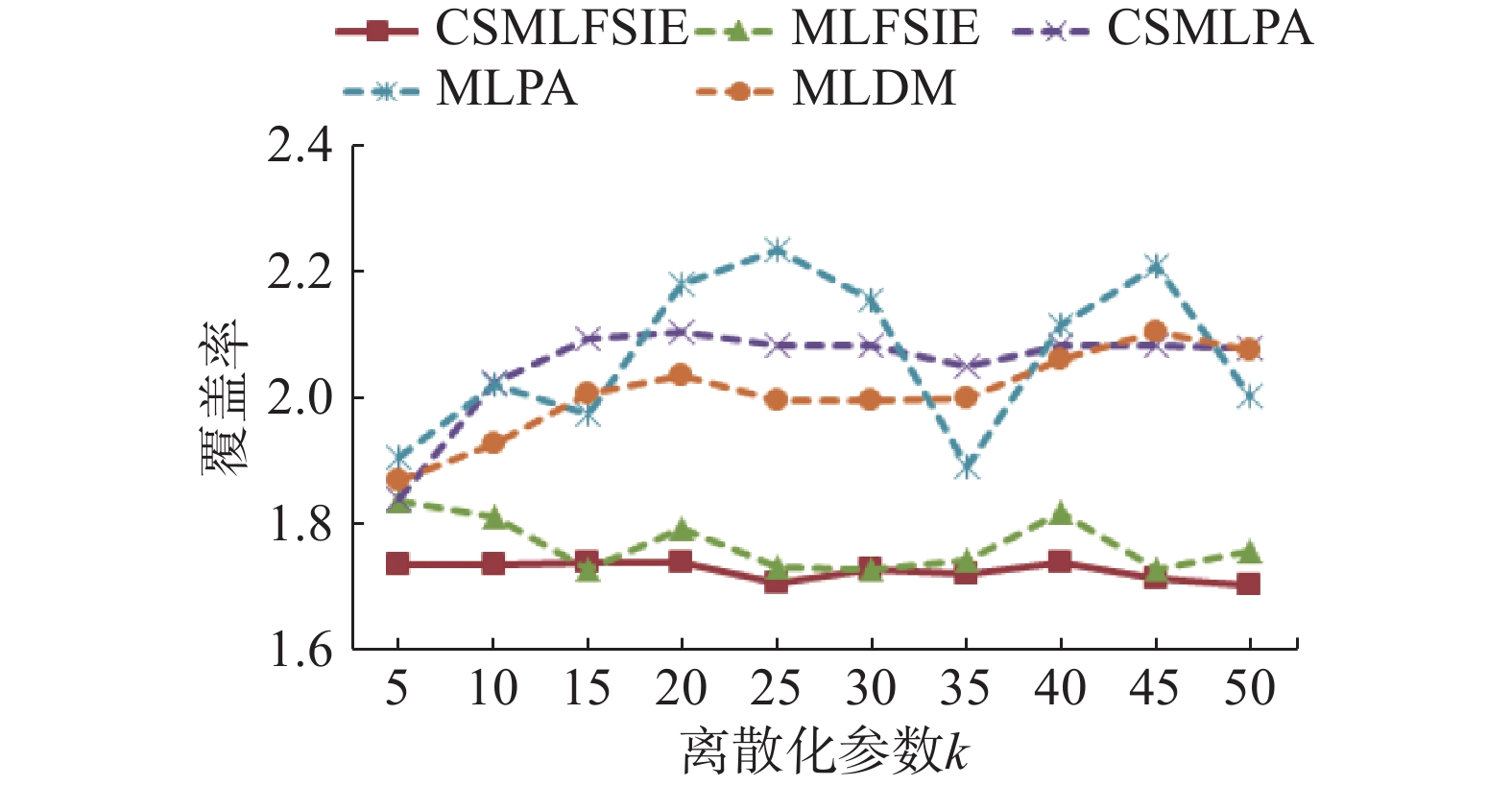

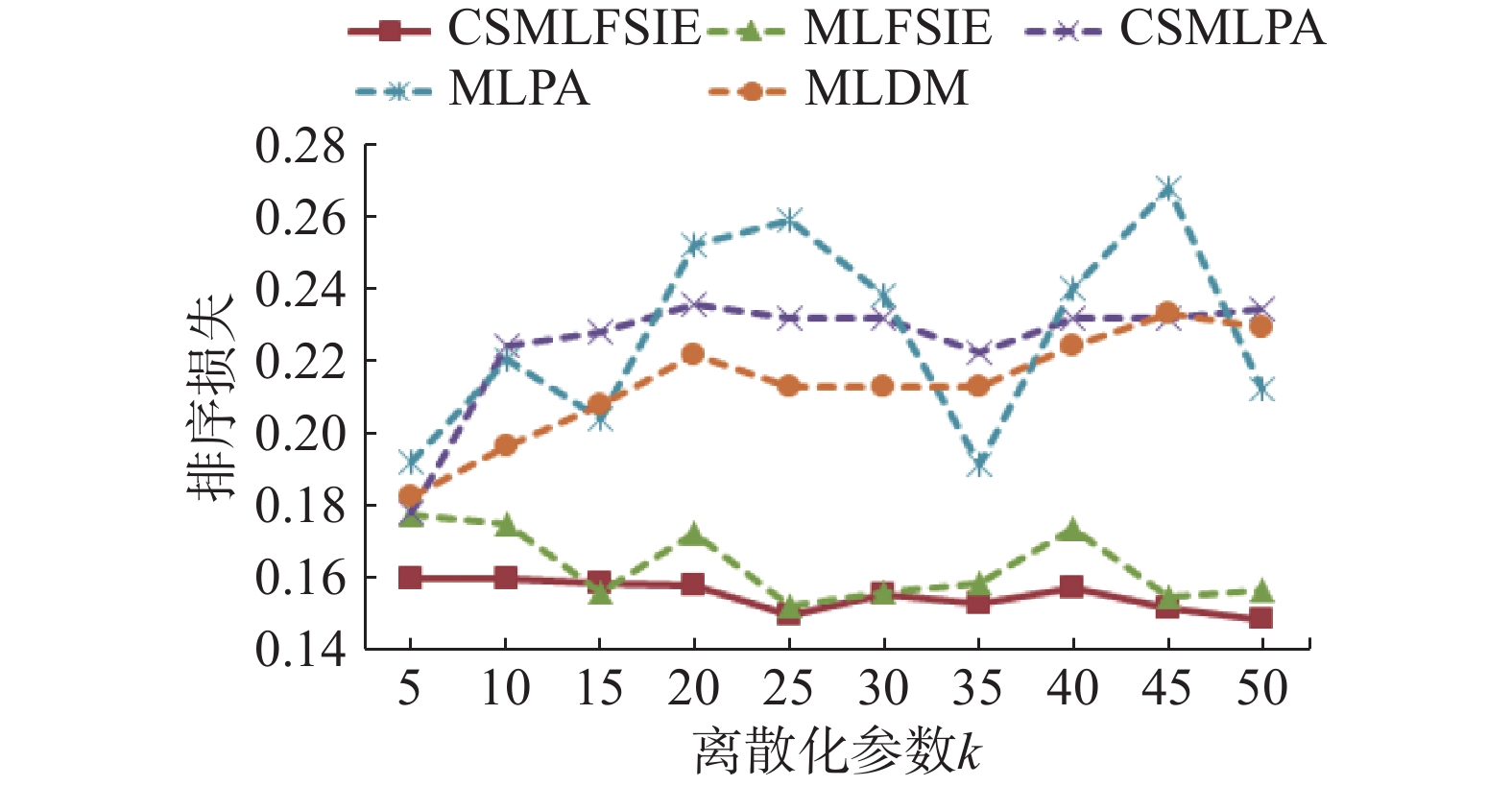

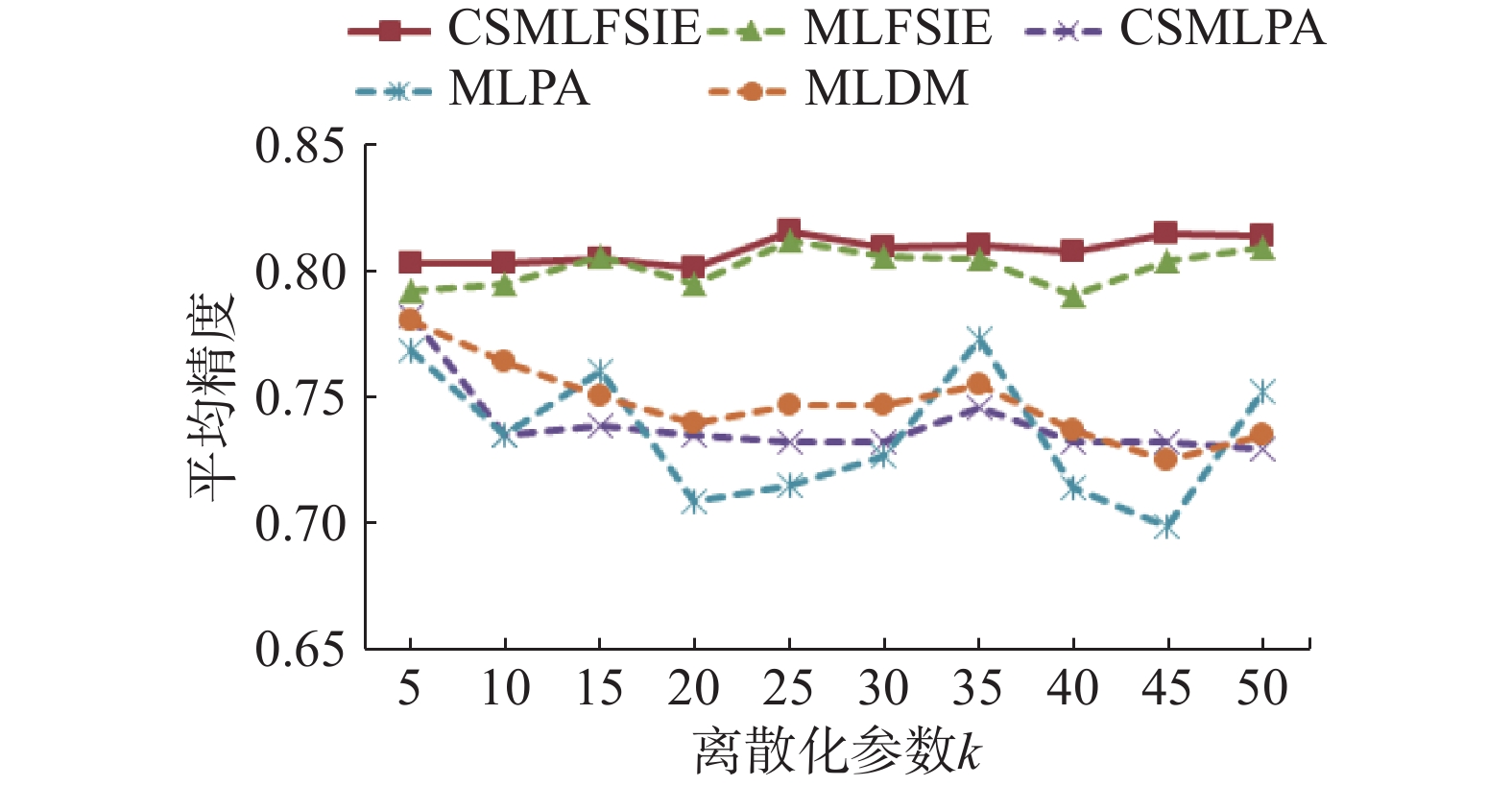

5.3 实验结果及比较 5.3.1 离散参数由于本文所选择的3个多标记数据集的特征值都包含连续型数据,但CSMLFSIE算法处理的是离散型特征变量,因此对于多标记数据集的处理需要对特征值进行离散化处理。在实验过程中发现,

由图1~5可知,CSMLFSIE和MLFSIE算法的5项分类性能随离散化参数增加变化较为平缓,CSMLPA、MLPA和MLDM算法的5项分类性能随离散化参数增加变化较为显著,其中,变化较显著的是MLPA算法,5项分类性能随离散化参数

|

Download:

|

| 图 1 汉明损失随着离散化参数增加的变化曲线 Fig. 1 Variation of Hamming loss with increase in the discretization parameter | |

|

Download:

|

| 图 2 1错误率随着离散化参数增加的变化曲线 Fig. 2 Variation of one error rate with increase in the discretization parameter | |

|

Download:

|

| 图 3 覆盖率随着离散化参数增加的变化曲线 Fig. 3 Variation of coverage with increase in the discretization parameter | |

|

Download:

|

| 图 4 排序损失随着离散化参数增加的变化曲线 Fig. 4 Variation of ranking loss with increase in the discretization parameter | |

|

Download:

|

| 图 5 平均精度随着离散化参数增加的变化曲线 Fig. 5 Variation of average precision with increase in the discretization parameter | |

综上所述,与其他4种算法相比,随离散化参数增加,CSMLFSIE算法的5项分类性能变化最为平缓,即离散化参数的变化对CSMLFSIE算法影响最小,因此CSMLFSIE算法的稳定性和健壮性更优。

5.3.2 实验对比实验过程中将训练数据集和测试数据集相结合,采用10倍交叉验证法来验证算法的有效性,实验结果采用评价指标的平均值和标准差表示。另外,由于Mulan数据集自身并不含测试代价,因此本文采用正态分布函数为每个特征生成测试代价,其中,正态分布函数的取值以100为期望,以30为标准差。

表2~4中表示在正态分布函数下,用5种多标记特征选择算法分别对Yeast、Emotions和Birds这3个数据集进行特征降维,并用IBLR-ML分类算法验证降维后的特征子集的分类性能,同时,与原始数据集的分类性能进行对比。表2~4中给出的数据是AP取最优值时,所对应的PC、HL、OE、Coverage、RL和k的值。另外,各项评价指标的最优值用黑体标注,↓表示该项指标值越小算法的分类性能越好,↑表示该项指标的值越大算法的分类性能越好。

| 表 2 Yeast数据集的实验结果比较 Tab.2 The comparisons of Yeast datasets |

| 表 3 Emotions数据集的实验结果比较 Tab.3 The comparisons of Emotions datasets |

| 表 4 Birds数据集的实验结果比较 Tab.4 The comparisons of Birds datasets |

由表2~4中的5种多标记分类性能评价指标的结果可以看出,CSMLFSIE算法总体优于其他4种算法,较为明显的有Coverage、HL和AP这3项性能指标。同时,通过CSMLFSIE算法进行特征降维后,特征子集的分类性能优于原始数据集,其中,最为突出的是在PC这项指标上。另外,由表2~4可知,各个算法分类性能最优时,所对应的离散化参数k的取值也存在差异。由表2中的Yeast数据集可知,由本文CSMLFSIE算法降维后的特征子集的分类性能较优,其降维后的特征子集PC的值与MLFSIE、CSMLPA、MLPA和MLDM算法相比,分别减少了0.92%、14%、13.47%和12.68%;同时,AP分别提高了0.13%、2.54%、2.54%和3.26%,且OE、Coverage和RL值相对较优。另一方面,CSMLFSIE算法降维之后的特征子集与原始数据集相比,PC的值为2.34%,比原始数据集减少了97.66%,且其他5项分类性能评价指标的值更优,其中,AP的值提高了0.37%,HL、OE、Coverage、RL值分别降低了0.02%、0.66%、3.6%和0.16%。

针对Emotions数据集,由本文CSMLFSIE算法选择的特征子集的分类性能总体较优,根据表3中各项性能指标的结果可知,除HL和OE性能指标之外,其他3项多标记分类性能指标的值最优,且总测试代价PC的值最小。CSMLFSIE 算法与MLPA算法相比,PC的值同为6.47%,但AP的值却提高了6.26%,同时,HL、OE、Coverage和RL的值都显著降低。由此可知,CSMLFSIE算法要优于MLPA算法。CSMLFSIE算法与MLFSIE算法相比,PC的值减少了12.49%,另外,Coverage、RL和AP这3项性能指标相对更优,因此CSMLFSIE算法总体优于MLFSIE算法。此外,CSMLFSIE算法与CSMLPA和MLDM算法相比,PC的值分别减少了15.36%和10.61%,其HL、OE、Coverage、RL和AP这5项性能指标的值更优。

从表4中的Birds数据集可以看出,CSMLFSIE算法选择后的特征子集的分类性能与Raw Data相比,除HL这项性能指标之外,其他4项性能指标的值都更优,PC的值也减少了88.65%,因此CSMLFSIE算法选择后的特征子集的分类性能总体优于Raw Data。CSMLFSIE算法与MLFSIE算法相比,Coverage、RL和AP的值较优,PC的值减少了35.89%。CSMLFSIE算法与CSMLPA算法相比,PC的值减少了10.18%,AP的值由59.05%提高至61.71%,HL、OE、Coverage和RL的值分别降低了0.08%、2.18%、21.21%和0.79%。CSMLFSIE算法与MLPA算法和MLDM算法相比,AP的值分别提高了4.25%、4.37%,HL、OE、Coverage和RL的值有所下降,但PC的值分别增加了8.88%、8.7%。由此可知,由CSMLFSIE算法选择的特征子集的分类性能总体较优。

另外,由表2~4可知,针对CSMLPA算法,3个数据集的离散化参数k取值为5时,其降维后特征子集的分类性能最优;针对CSMLFSIE算法进行离散化处理时,参数值为45时,Yeast数据集和Birds数据集降维后的特征子集的分类效果较佳,而对于Emotions数据集来说,离散化参数取25较优;针对MLFSIE算法和MLPA算法,在3个数据集降维后的特征子集的分类性能最优时,所对应的离散化参数的取值也不同;针对MLDM算法,对于Yeast数据集和Emotions数据集,离散化参数取5时,降维后的特征子集的分类性能较优,在Birds数据集中,离散化参数取值为25较好。由此可知,各个算法的分类性能与离散化参数k的取值相关,降维后的特征子集影响着分类器的分类性能。

综上所述,原始数据集中存在大量冗余和不相关特征,且这些特征直接影响了分类器的分类性能,综合各项性能评价指标可知,CSMLFSIE算法总体优于其他4种算法,达到了较好的特征降维的效果。

6 结束语传统的基于多标记的特征选择算法往往忽略了每个特征获取和采集所需花费的代价问题,为此,本文提出了一种代价敏感数据的多标记特征选择算法,该算法利用信息熵分析特征与标记之间的相关性,利用均匀分布函数和正态分布函数为特征生成测试代价,从代价敏感的研究视角,构建一种新特征重要度准则。然后,根据服从正态分布的特征重要度和特征代价的标准差设置阈值,通过阈值剔除冗余和不相关特征。通过对3个真实数据集实验结果的分析与比较,验证了本文算法的有效性和高效性。但是,该算法并未充分考虑标记之间的相关性以及误分类代价的问题,这也是我们下一步的研究工作。

| [1] |

ZHANG Minling, ZHOU Zhihua. A review on multi-label learning algorithms[J]. IEEE transactions on knowledge and data engineering, 2014, 26(8): 1819-1837. DOI:10.1109/TKDE.2013.39 ( 0) 0)

|

| [2] |

TSOUMAKAS G, KATAKIS I, VLAHAVAS I. Random -Labelsets for multilabel classification[J]. IEEE transactions on knowledge and data engineering, 2011, 23(7): 1079-1089. DOI:10.1109/TKDE.2010.164 ( 0) 0)

|

| [3] |

郑伟, 王朝坤, 刘璋, 等. 一种基于随机游走模型的多标签分类算法[J]. 计算机学报, 2010, 33(8): 1418-1426. ZHENG Wei, WANG Chaokun, LIU Zhang, et al. A multi-label classification algorithm based on random walk model[J]. Chinese journal of computers, 2010, 33(8): 1418-1426. (  0) 0)

|

| [4] |

李宇峰, 黄圣君, 周志华. 一种基于正则化的半监督多标记学习方法[J]. 计算机研究与发展, 2012, 49(6): 1272-1278. LI Yufeng, HUANG Shengjun, ZHOU Zhihua. Regularized semi- supervised multi-label learning[J]. Journal of computer research and development, 2012, 49(6): 1272-1278. (  0) 0)

|

| [5] |

PAWLAK Z. Rough sets[J]. International journal of computer and information sciences, 1982, 11(5): 341-356. DOI:10.1007/BF01001956 ( 0) 0)

|

| [6] |

PAWLAK Z, SO-Winski R. Rough set approach to multi-attribute decision analysis[J]. European journal of operational research, 1994, 72(3): 443-459. DOI:10.1016/0377-2217(94)90415-4 ( 0) 0)

|

| [7] |

刘清. Rough集及Rough推理[M]. 北京: 科学出版社, 2001.

( 0) 0)

|

| [8] |

SUN Liang, JI Shuiwang, YE Jieping. Multi-label dimensionality reduction[M]. Florida: CRC Press, 2013: 20–22.

( 0) 0)

|

| [9] |

ZHANG Yin, ZHOU Zhihua. Multi-label dimensionality reduction via dependence maximization[C]//Proceedings of the 23rd National Conference on Artificial Intelligence. Chicago, Illinois, 2008: 1503−1505.

( 0) 0)

|

| [10] |

YU Kai, YU Shipeng, TRESP V. Multi-label informed latent semantic indexing[C]//Proceedings of the 28th Annual International ACM SIGIR Conference on Research and Development in Information Retrieval. Salvador, Brazil, 2005: 258−265.

( 0) 0)

|

| [11] |

段洁, 胡清华, 张灵均, 等. 基于邻域粗糙集的多标记分类特征选择算法[J]. 计算机研究与发展, 2015, 52(1): 56-65. DUAN Jie, HU Qinghua, ZHANG Lingjun, et al. Feature selection for multi-label classification based on neighborhood rough sets[J]. Journal of computer research and development, 2015, 52(1): 56-65. DOI:10.7544/issn1000-1239.2015.20140544 (  0) 0)

|

| [12] |

王晨曦, 林耀进, 唐莉, 等. 基于信息粒化的多标记特征选择算法[J]. 模式识别与人工智能, 2018, 31(2): 123-131. WANG Chenxi, LIN Yaojin, TANG Li, et al. Multi-label feature selection based on information granulation[J]. Pattern recognition and artificial intelligence, 2018, 31(2): 123-131. (  0) 0)

|

| [13] |

LIN Yaojin, HU Qinghua, LIU Jinghua, et al. Multi-label feature selection based on neighborhood mutual information[J]. Applied soft computing, 2016, 38: 244-256. DOI:10.1016/j.asoc.2015.10.009 ( 0) 0)

|

| [14] |

刘景华, 林梦雷, 王晨曦, 等. 基于局部子空间的多标记特征选择算法[J]. 模式识别与人工智能, 2016, 29(3): 240-251. LIU Jinghua, LIN Menglei, WANG Chenxi, et al. Multi-label feature selection algorithm based on local subspace[J]. Pattern recognition and artificial intelligence, 2016, 29(3): 240-251. (  0) 0)

|

| [15] |

LEE J, LIM H, KIM D W. Approximating mutual information for multi-label feature selection[J]. Electronics letters, 2012, 48(15): 929-930. DOI:10.1049/el.2012.1600 ( 0) 0)

|

| [16] |

张振海, 李士宁, 李志刚, 等. 一类基于信息熵的多标签特征选择算法[J]. 计算机研究与发展, 2013, 50(6): 1177-1184. ZHANG Zhenhai, LI Shining, LI Zhigang, et al. Multi-label feature selection algorithm based on information entropy[J]. Journal of computer research and development, 2013, 50(6): 1177-1184. DOI:10.7544/issn1000-1239.2013.20121277 (  0) 0)

|

| [17] |

YANG Qiang, WU Xindong. 10 challenging problems in data mining research[J]. International journal of information technology & decision making, 2006, 5(4): 597-604. ( 0) 0)

|

| [18] |

徐章艳, 刘作鹏, 杨炳儒, 等. 一个复杂度为max(O(|C||U|),O(|C|2|U/C|))的快速属性约简算法

[J]. 计算机学报, 2006, 29(3): 391-399. XU Zhangyan, LIU Zuopeng, YANG Bingru, et al. A quick attribute reduction algorithm with complexity of max(O(|C||U|),O(|C|2|U/C|)) [J]. Chinese journal of computers, 2006, 29(3): 391-399. DOI:10.3321/j.issn:0254-4164.2006.03.006 (  0) 0)

|

| [19] |

WU Binglong, QIAN Wenbin, HUANG Qin, et al. Cost-Sensitive multi-label feature selection algorithm based on positive approximation[C]//Fuzzy Systems and Data Mining IV-Proceedings of FSDM 2018. Bangkok, Thailand, 2018: 381−386.

( 0) 0)

|

| [20] |

QIAN Yuhua, LIANG Jiye, PEDRYCZ W, et al. Positive approximation: an accelerator for attribute reduction in rough set theory[J]. Artificial intelligence, 2010, 174(9/10): 597-618. ( 0) 0)

|

| [21] |

WEI Wei, WU Xiaoying, LIANG Jiye, et al. Discernibility matrix based incremental attribute reduction for dynamic data[J]. Knowledge-based systems, 2018, 140: 142-157. DOI:10.1016/j.knosys.2017.10.033 ( 0) 0)

|

| [22] |

ELISSEEFF A, WESTON J. A kernel method for multi-labelled classification[C]//Proceedings of the 14th International Conference on Neural Information Processing Systems: Natural and Synthetic. Vancouver, Canada, 2001: 681−687.

( 0) 0)

|

| [23] |

TROHIDIS K, TSOUMAKAS G, KALLIRIS G, et al. Multi-label classification of music into emotions[C]//Proceedings of the 9th International Society for Music Information Retrieval Conference. Philadelphia, PA, 2008: 325−330.

( 0) 0)

|

| [24] |

BRIGGS F, HUANG Yonghong, RAICH R, et al. The 9th annual MLSP competition: new methods for acoustic classification of multiple simultaneous bird species in a noisy environment[C]//Proceedings of 2013 IEEE International Workshop on Machine Learning for Signal Processing. Southampton, UK, 2013: 22−25.

( 0) 0)

|

2019, Vol. 14

2019, Vol. 14