2. 山东财经大学 计算机科学与技术学院,山东 济南 250014

2. School of Computer Science & Technology, Shandong University of Finance and Economics, Ji’nan 250014, China

近年来,显著性检测在图像处理和计算机视觉领域中愈发重要,并且得到了广泛研究和应用。显著性检测的本质是模拟人类的视觉注意机制提取图像中最引人注意的区域,目前已被广泛应用于图像分割[1]、目标识别[2]、像压缩[3]以及图像检索[4]等领域。

显著性检测方法通常可分为两种模型:自底向上(bottom-up)[5−10]和自顶向下(top-down)[11−12]。自底向上一般是快速的、数据驱动的显著性提取模型。Cheng等[5]提出了基于区域对比度的显著性检测算法,用于测量全局对比度差异;Harel等[6]提出了一种基于图形的显著性模型检测图像中的显著物体;Erdem[7]使用从局部图像块提取的图像特征的协方差矩阵来计算最终的显著性图;Murray等[8]设计了一种特殊的颜色外观显著性检测模型;Shi[9]通过图形模型提出了一种分层图像显著性目标检测方法,以产生最终显著性等级;Yang等[10]通过基于图形的流形排序实现图像元素(像素或区域)与前景或背景线索的相似性的排序。

与自底向上相反,自顶向下通常是慢速的、任务依赖的、目标驱动的显著性提取。自顶向下的方法通常依赖于学习框架,采用高层线索和先验知识进行显著性检测。文献[11]中提出了通过学习条件随机场进行特征组合,并引入动态显著特征以实现显著目标的检测。最近,文献[12]提出了一种结合字典学习和条件随机场的自上而下的视觉显著性模型。

一般情况下,使用基于学习框架的显著性检测模型的检测效果会比较好,但是其检测效果会很大程度上依赖于模型的训练样本,训练的过程也会使计算复杂度增加。非学习类的显著性检测模型通常是以底层特征为线索进行显著性检测,如对比度先验、中心先验、背景先验等。这些方法一般只对简单的场景有效,当背景与检测对象相似时,这类方法将无法准确地检测出目标物体。

本文提出基于Object Proposals并集的显著性检测模型。首先我们利用Object Proposals的有效信息预测背景区域的位置并得到背景图,然后基于纹理特征以及全局对比度进行显著性检测,最后将三者进行融合得到最终的显著图。

1 Object ProposalsObject Proposals是一系列包含目标对象的候选区域,它通常以预处理的形式广泛应用于各种视觉任务。Alexe等[13]提出了对象度量(objectness measure)的概念,量化一个图像窗口覆盖对象的可能性;Cheng等[14]提出二值化规范梯度(BING)特征,有助于用对象评分(objectness score)搜索对象。本文使用Edge Boxes[15]算法生成Proposals,得到的Proposals会包含丰富的对象级特征,我们利用这些特征判断显著目标的位置并预测背景区域。

对于图像I,首先使用SLIC算法[16]得到超像素图,

|

Download:

|

| 图 1 目标候选框 Fig. 1 Object Proposals | |

在目标集合A中,针对图1(b)、(c)的现象,对包含大量背景区域的候选框进行删除。受文献[17-19]的启发,本文中使用基于超像素的边界连通性对候选框进行筛选。用BndCon(∙)表示边界连通性,其本质是描述一个区域与图像边界的连通程度[20]。BndCon(∙)的定义为

| ${\rm{BndCon}}\left( {{{\rm{sp}}_i}} \right) = \frac{{{\rm{Le}}{{\rm{n}}_{{\rm{bnd}}}}\left( {{{\rm{sp}}_i}} \right)}}{{\sqrt {{\rm{Area}}\left( {{{\rm{sp}}_i}} \right)} }}$ |

式中:Area(spi)的含义是区域中存在的超像素数目,而Lenbnd(spi)则是与边界相邻的超像素的数目。BndCon(spi)的值越大,则表明边界上的超像素数目越多,也就是该区域是背景区域的可能性越大。若一个候选框计算得到的BndCon(spi)很大,我们则认为这个候选框包含了很多背景区域,并从A中将其删除。最终得到的目标集合能尽量去除背景区域的影响,更新后的目标集合记作A–。

2 基于Object Proposals并集的显著性检测 2.1 构建基于OP并集的背景图定义得到的目标集合

| $O\left( {{{\rm{sp}}_i}} \right) = \mathop \sum \limits_{j = 0}^n o\left( {{b_j}} \right) \cdot \delta,\; {{{\rm{sp}}_i} \in {b_j}} $ |

o(bj) 表示候选框bj的目标分数,若超像素spi属于候选框bj,δ(∙)则取值为1,否则为0。

通过计算A–中所有超像素的(pi)值,可以得到最终的OP并集,然后用φ划分目标对象和背景区域,如下:

| $\varPhi \left( {{{\rm{sp}}_i}} \right) = \left\{ {\begin{array}{*{20}{c}}\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!\!0,\\{O\left( {{{\rm{sp}}_i}} \right),}\end{array}\begin{array}{*{20}{c}}\!\!\!\!\!\!\!\!\!\!\!\!{O\left( {{{\rm{sp}}_i}} \right) \leqslant \varphi }\\{{\text{其他}}}\end{array}} \right.$ |

式中

|

Download:

|

| 图 2 本文的显著性检测模型 Fig. 2 Our proposed saliency model | |

纹理[21-22]通常反应的是图像的某种局部化性质,一般表现为图像像素点某邻域内灰度级或者颜色的变化。在图像中彩色像素并不是一个随机的组合,而是有一定含义的排列,不同排列会形成不同的纹理,这些纹理特征则可用于对图像中的空间信息进行一定程度的定量描述。

在本文中,使用选择性纹理[23]获得纹理显著性。首先,将纹理表达式通过k-means[24]算法进行聚类,并将聚类中心作为代表纹理[23],最后每个纹理特征都可以用其最近的代表纹理进行表示。使用的滤波器组是高斯导数以及其希尔伯特变换沿着y轴旋转得到的,具体为

| ${f_g}\left( {x,y} \right) = \frac{{{{\rm{d}}^2}}}{{{{\rm{dy}}{{^2}}}}}\left( {\frac{1}{\mu }\exp {{\left( {\frac{y}{\sigma }} \right)}^2}\exp {{\left( {\frac{x}{{\sigma l}}} \right)}^2}} \right)$ |

| ${f_h}\left( {x,y} \right) = {\rm{Hilbert}}\left( {{f_g}\left( {x,y} \right)} \right)$ |

式中:μ是标准化常数,σ和l分别是尺度参数和方向参数。对于图像I的第i个像素Ii的纹理显著性定义如下:

| ${S_1}\left( {{I_i},{R_i}} \right) = \mathop \sum \limits_{{I_j} \ne {I_i},{I_j} \in {R_i}} D\left( {{I_i},{I_j}} \right)$ |

式中:Ri表示Ii所在的区域,

| $D\left( {{I_i},{I_j}} \right) = \parallel {{{t}}_i} - {{{t}}_j}{\parallel _2}$ |

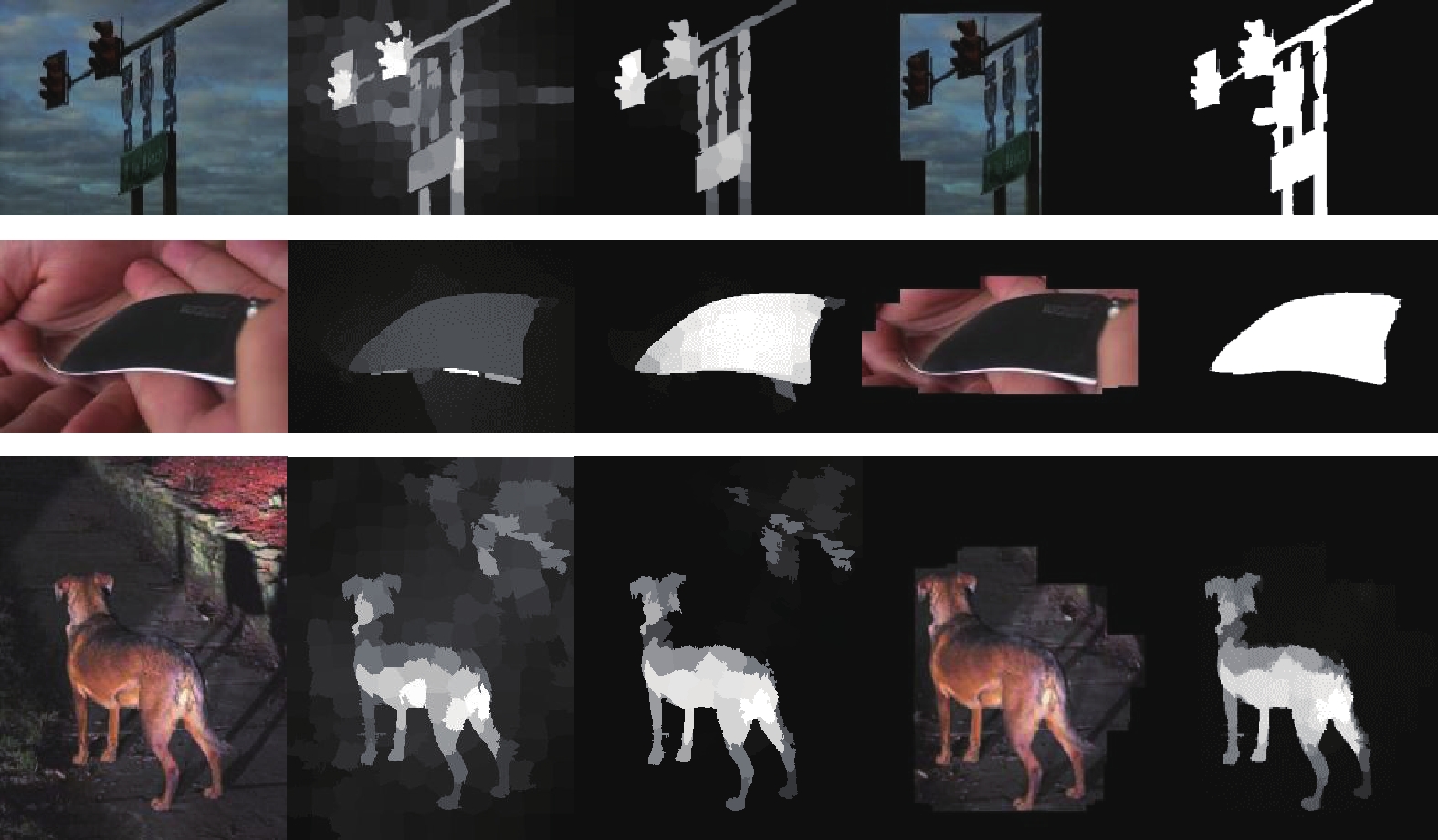

式中ti和tj分别是像素Ii和Ij的纹理特征。图2中的第3列是选择性纹理检测[23]的结果,可以看出纹理显著性检测能够区分出不同纹理的对象,但结果依然会包含背景中的部分纹理内容,比如第3行的纹理检测结果。

2.3 全局对比度显著性空间加权对比度在文献[5,18]中已被证明是有效的显著性检测方法。在文献[5]中是将图片分割成若干区域,计算区域及颜色对比度,再用每个区域与其他区域对比度加权和定义此区域的显著性。本文中直接在第1节中获得的超像素基础上进行计算。对于任意超像素spi,在CIE LAB色彩空间中计算超像素spi的颜色平均值ci以及平均像素坐标di,并将di归一化到[0,1]。对于超像素spi,其空间加权区域对比度为

| ${S_2}\left( {{{\rm{sp}}_i}} \right) = \mathop \sum \limits_{j \ne i,} \parallel {{{c}}_{{i}}} - {{{c}}_{{j}}}\parallel \cdot {\rm{exp}}\left( { - \frac{{\parallel {{{d}}_{{i}}} - {{{d}}_{{j}}}\parallel }}{{2\sigma _p^2}}} \right)$ |

式中:σp为空间加权参数,σp越小,空间权值的影响就会越大,这样就可以使较近的区域对当前区域的显著性值产生较大的影响。本文中,σp2取值0.2。图2中的第2列是全局对比度的检测结果,全局对比度图能进一步凸显前景区域,加深纹理检测图中的显著目标的显著程度。

2.4 显著性融合将得到的背景图(2.1节)、纹理显著图(2.2节)以及全局对比显著图(2.3节)进行融合。首先将纹理显著图和全局对比度显著图进行融合,旨在结合二者的优势,相互补充,优化显著图。

| ${\rm{Sal}} = {\rm{norm}}\left( {{S_1}} \right) + {\rm{norm}}\left( {{S_2}} \right)$ |

式中norm(∙)是对得到的显著图进行归一化。在这里选择“+”是因为纹理检测和全局对比度检测可以相互补充,此外,通过加运算可以使前景区域分布更均匀[19]。

在得到融合显著图Sal后,使用2.1节中得到的背景图对显著图Sal的背景区域进行抑制,从而提高显著图的准确率。

| ${{S}} = {\rm{Sal}}\times \varPhi \left( {O\left( {{p_i}} \right) \leqslant \varphi } \right)$ |

式中

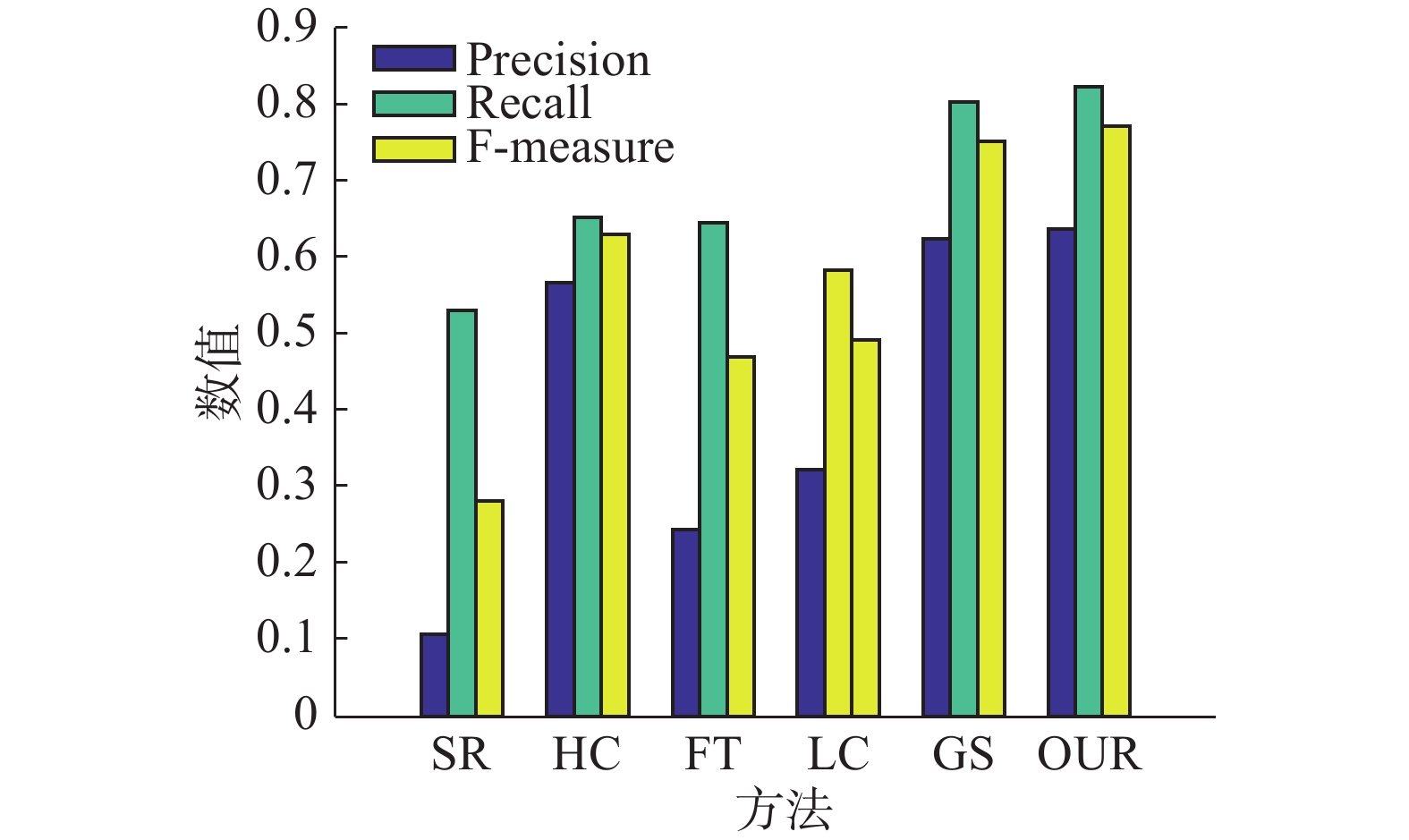

本文在MSRA1000公开数据集对本文的显著性模型进行了测试,并与一些经典的算法进行比较:SR[25]、HC[5]、FT[26]、LC[27]、GS[28]。实验过程中,使用的代码均采用作者公开的代码。

图3是将本文的显著性检测模型与其他5种算法进行比较的效果图。从图中可以看出在MSRA1000数据集上本文提出的显著性检测模型比SR、HC、FT、LC相比效果有很大提升;与GS相比,本文的显著性检测图前景分布更均匀,且背景区域得到了明显抑制。

|

Download:

|

| 图 3 显著图的视觉效果对比图 Fig. 3 Visual comparison of saliency maps | |

为了更全面地测试方法的性能,使用PR曲线、F-measure进一步与其他方法进行比较。

对于得到的显著图,设定阈值Tf∈[0,255]来得到二值分割图,并与ground truth进行比较得到准确率和召回率。除此之外,我们还记算了F-measure衡量总体的检测效果,

| ${F_\beta } = \frac{{\left( {1 + {\beta ^2}} \right){\rm{Precision}} \times {\rm{Recall}}}}{{{\beta ^2}{\rm{Precision}} + {\rm{Recall}}}}$ |

β2取值为0.3。由图4~5可知,本文方法与SR、HC、FT、LC相比,准确率和召回率、F-measure都有很大提升。与GS相比,由图5可以看出,在召回率相同时,大部分情况下我们的方法准确率更高,也存在小部分结果其准确率微低于GS,但从图4也能够看出在平均情况下,无论是准确度、召回率还是F-measure,本文方法均略高于GS。

|

Download:

|

| 图 4 统计指标的对比结果 Fig. 4 Quantitative comparison results | |

|

Download:

|

| 图 5 正确率–召回率曲线 Fig. 5 Precision-recall curves | |

本文提出的基于Object Proposals并集的显著性检测模型,首先利用Object Proposals计算背景图,然后将纹理和全局对比度结合进行显著性检测,最后利用背景图抑制背景区域得到最终显著图。实验结果表明,本文提出的显著性检测模型取得了较好的效果。

| [1] |

王超, 王浩, 王伟, 等. 基于优化ROI的医学图像分割与压缩方法研究[J]. 重庆邮电大学学报: 自然科学版, 2015, 27(2): 279-284. WANG Chao, WANG Hao, WANG Wei, et al. Study of optimized ROI based medical image segmentation and compression method[J]. Journal of Chongqing university of posts and telecommunications: natural science edition, 2015, 27(2): 279-284. (  0) 0)

|

| [2] |

杨林娜, 安玮, 林再平, 等. 基于空间距离改进的视觉显著性弱小目标检测[J]. 光学学报, 2015, 35(7): 0715004. YANG Linna, AN Wei, LIN Zaiping, et al. Small target detection based on visual saliency improved by spatial distance[J]. Acta optica sinica, 2015, 35(7): 0715004. (  0) 0)

|

| [3] |

ITTI L. Automatic foveation for video compression using a neurobiological model of visual attention[J]. IEEE transactions on image processing, 2004, 13(10): 1304-1318. DOI:10.1109/TIP.2004.834657 ( 0) 0)

|

| [4] |

CHEN Tao, CHENG Mingming, TAN Ping, et al. Sketch2photo: internet image montage[J]. ACM transactions on graphics, 2009, 28(5): 1-10. ( 0) 0)

|

| [5] |

CHENG Mingming, MITRA N J, HUANG Xiaolei, et al. Global contrast based salient region detection[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(3): 569-582. DOI:10.1109/TPAMI.2014.2345401 ( 0) 0)

|

| [6] |

HAREL J, KOCH C, PERONA P. Graph-based visual saliency[C]//Proceedings of the 19th International Conference on Neural Information Processing Systems. Cambridge, MA, USA, 2007: 545–552.

( 0) 0)

|

| [7] |

ERDEM E, ERDEM A. Visual saliency estimation by nonlinearly integrating features using region covariances[J]. Journal of vision, 2013, 13(4): 11. DOI:10.1167/13.4.11 ( 0) 0)

|

| [8] |

MURRAY N, VANRELL M, OTAZU X, et al. Saliency estimation using a non-parametric low-level vision model[C]//Proceedings of the 2011 IEEE Conference on Computer Vision and Pattern Recognition . Washington, DC, USA, 2011: 433–440.

( 0) 0)

|

| [9] |

SHI Jianping, YAN Qiong, XU Li, et al. Hierarchical image saliency detection on extended CSSD[J]. IEEE transactions on pattern analysis and machine intelligence, 2016, 38(4): 717-729. DOI:10.1109/TPAMI.2015.2465960 ( 0) 0)

|

| [10] |

YANG Chuan, ZHANG Lihe, LU Huchuan, et al. Saliency detection via graph-based manifold ranking[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. Washington, DC, USA, 2013: 3166–3173.

( 0) 0)

|

| [11] |

LIU Tie, YUAN Zejian, SUN Jian, et al. Learning to detect a salient object[J]. IEEE transactions on pattern analysis and machine intelligence, 2011, 33(2): 353-367. DOI:10.1109/TPAMI.2010.70 ( 0) 0)

|

| [12] |

YANG Jimei, YANG M H. Top-down visual saliency via joint CRF and dictionary learning[C]//Proceedings of Conference on Computer Vision and Pattern Recognition (CVPR). Washington, DC, USA, 2012: 2296–2303.

( 0) 0)

|

| [13] |

ALEXE B, DESELAERS T, FERRARI V. Measuring the objectness of image windows[J]. IEEE transactions on pattern analysis and machine intelligence, 2012, 34(11): 2189-2202. DOI:10.1109/TPAMI.2012.28 ( 0) 0)

|

| [14] |

CHENG Mingming, ZHANG Ziming, LIN Wenyan, et al. BING: Binarized normed gradients for objectness estimation at 300fps[C]//Proceedings of IEEE conference on computer vision and pattern recognition. Columbus, OH, USA, 2014: 3286–3293.

( 0) 0)

|

| [15] |

ZITNICK C L, DOLLáR P. Edge boxes: Locating object proposals from edges[C]//Proceedings of European Conference on Computer Vision. Cham: Springer, 2014: 391–405.

( 0) 0)

|

| [16] |

ACHANTA R, SHAJI A, SMITH K, et al. SLIC superpixels compared to state-of-the-art superpixel methods[J]. IEEE transactions on pattern analysis and machine intelligence, 2012, 34(11): 2274-2282. DOI:10.1109/TPAMI.2012.120 ( 0) 0)

|

| [17] |

HUANG Fang, QI Jinqing, LU Huchuan, et al. Salient object detection via multiple instance learning[J]. IEEE transactions on image processing, 2017, 26(4): 1911–1922. ( 0) 0)

|

| [18] |

PERAZZI F, KRÄHENBÜHL P, PRITCH Y, et al. Saliency filters: Contrast based filtering for salient region detection[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Providence, RI, USA, 2012: 733–740.

( 0) 0)

|

| [19] |

XI Tao, ZHAO Wei, WANG Han, et al. Salient object detection with spatiotemporal background priors for video[J]. IEEE transactions on image processing, 2017, 26(7): 3425-3436. DOI:10.1109/TIP.2016.2631900 ( 0) 0)

|

| [20] |

ZHU Wangjiang, LIANG Shuang, WEI Yichen, et al. Saliency optimization from robust background detection[C]//Proceedings of IEEE conference on computer vision and pattern recognition. Columbus, OH, USA, 2014: 2814–2821.

( 0) 0)

|

| [21] |

刘丽, 匡纲要. 图像纹理特征提取方法综述[J]. 中国图象图形学报, 2009, 14(4): 622-635. LIU li, KUANG Gangyao. Overview of image textural feature extraction methods[J]. Journal of image and graphics, 2009, 14(4): 622-635. (  0) 0)

|

| [22] |

王佐成, 薛丽霞. 一种新的纹理基元发现及表达方法[J]. 重庆邮电大学学报: 自然科学版, 2011, 23(1): 115-120. WANG Zuocheng, XUE Lixia. A new representation method of image texton[J]. Journal of Chongqing university of posts and telecommunications: natural science edition, 2011, 23(1): 115-120. (  0) 0)

|

| [23] |

WANG Qi, YUAN Yuan, YAN Pingkun. Visual saliency by selective contrast[J]. IEEE transactions on circuits and systems for video technology, 2013, 23(7): 1150-1155. DOI:10.1109/TCSVT.2012.2226528 ( 0) 0)

|

| [24] |

HARTIGAN J A, WONG M A. Algorithm as 136: a k-means clustering algorithm[J]. Journal of the royal statistical society. series c (applied statistics), 1979, 28(1): 100-108. ( 0) 0)

|

| [25] |

HOU Xiaodi, ZHANG Liqing. Saliency detection: a spectral residual approach[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis, MN, USA, 2007: 1–8.

( 0) 0)

|

| [26] |

ACHANTA R, HEMAMI S, Estrada F, et al. Frequency-tuned salient region detection[C]//Proceedings of Conference on Computer vision and pattern recognition. Miami, FL, USA, 2009: 1597–1604.

( 0) 0)

|

| [27] |

ZHAI Yun, SHAH M. Visual attention detection in video sequences using spatiotemporal cues[C]//Proceedings of the 14th ACM international conference on Multimedia. New York, NY, USA, 2006: 815–824.

( 0) 0)

|

| [28] |

WEI Y, WEN F, ZHU W, et al. Geodesic saliency using background priors[J]. Computer vision-ECCV 2012, 2012: 29-42. ( 0) 0)

|

2018, Vol. 13

2018, Vol. 13