2. 纽约州立大学 宾哈姆顿大学, 纽约 13902;

3. 国家电网管理学院, 北京 102200

2. Binghamton University-SUNY, New York 13902, USA;

3. State Grid Management Institute, Beijing 102200, China

医疗电子病历(electronic medical records, EMR)目前已经成为实施疾病治疗和医疗保健的基础,它包含了大量与患者相关的病程记录,因此被广泛地应用于各个医疗保健相关的领域[1]。调查发现,接近83%的医生表示他们目前都在使用EMR系统或者准备使用[2]。在与EMR相关的语义信息挖掘任务中,命名实体识别(named entity recognition, NER)是基础,也是至关重要的一个步骤,例如:知识图谱构建[3]、文本检索[4]、文本分类[5]和信息抽取[6]等领域中都需要识别命名实体。

命名实体识别可以看作是一个序列标注任务[7-8],通过提取出来的信息来查找实体并将其分为一组固定的类别。传统实现NER的2种方法是基于规则的学习方法和有监督的学习方法,其中有监督的学习方法占主导地位。基于规则学习的解决方法是假设可用的训练数据已全部标记(即所有包含在文档中的实体都被标记)的前提下,再从文档中找到候选实体的标签序列。

目前,中文医疗领域的命名实体识别问题依然面临很多挑战,主要原因如下:1)医疗电子病历中大部分是半结构或非结构化的数据,并且很多信息是叙述性的,无结构信息,不适用于单纯利用语法结构上下文特征进行医疗概念的发现和抽取;2)医学术语通常具有模糊性和表达不一致的特点,例如:“慢性阻塞性肺疾病”也可以缩写为COPD(chronic obstructive pulmonary disease), 这会造成特征维度高、计算量大;3)需要大量人工标注的语料库作为训练集,且大多数传统NER方法是通过词向量来提取特征的,这在中文医疗文本中会导致部分语义信息割裂,并且数据量越大消耗的人工标注量就越多,因此很难在现实中得到广泛应用。

近年来,深度学习因其在图像处理、音频识别、自然语言处理等领域的优异表现吸引了大量的关注,表现了其良好的图像、音频的特征信息抽取能力,同时在NLP(natural language processing)领域的应用也越来越多[9-10]。深度学习的主要特点是通过其自身的深层网络结构来自主地学习更深层的特征及规律,因此可以大大减轻人工标注的时间,并且具有较强的鲁棒性和泛化性。其中循环神经网络(recurrent neural network, RNN)是一个序列模型,它具有时序记忆的特点,能够考虑词与词之间的顺序,从而能将词与词之间的语义联系体现出来,因此可以较好地应用于序列标注的任务中。目前,深度学习在NER任务中的应用并不少见,但大多数是关于英文医疗领域的,在中文领域中的成果尚不多见,仍需学者们不断研究和扩展。

针对以上问题,本文提出了一种结合医疗本体语义知识和标注数据集的弱监督方法来处理训练语料标注不全的NER任务。首先,基于现有的医疗本体提取语义特征,并在语义特征的基础上提取字符特征,再利用RNN模型时序记忆的特点来提取命名实体相关的上下文信息,并将提取的特征作为训练模型RNN的输入,最后通过softmax获得中文医疗文本中的标签序列。1)结合医疗领域广泛存在的医疗本体进行医疗文本的语义概念特征抽取,将其与现有的词与字向量特征进行融合在一起,通过基于RNN的弱监督学习方法进行命名实体识别,提高了中文医疗命名实体识别的准确率。2)基于某医院真实临床文本数据集进行了实验验证,将本文提出的基于语义特征融合的弱监督学习方法与现有概念实体识别方法进行了性能对比,对实验结果进行了分析与讨论。

在1996年的MUC-6会议上命名实体首次被提后,NER在英文领域的应用逐渐成熟。现有的大多数NER工作是基于假设没有领域本体知识的情况下, 主要通过标注的训练集来学习。例如Li等[11]训练了条件随机场(conditional random fields, CRF)和支持向量机(support vector machines, SVM)2种分类模型。结果表明,CRF的性能比SVM高。Lei等[12]构建并对比了CRF、SVM、最大熵马尔可夫(MEMM)和结构化的支持向量机(SSVM)4种模型,并在医疗数据集中对4类实体进行了实体识别,其中SSVM的准确率最高。何林娜等[13]提出了一种基于特征耦合泛化(feature coupling generalization,FCG)的实体识别方法并结合CRF来自动的识别医疗文献中的药物名称。

虽然CRF在大多数NER任务上都取得了较高的准确率,但是该方法的特征选择过程较为繁琐,随着特征的增多模型会变得尤为复杂,从而造成召回率的急剧下降,可移植性差。近年来,基于深度学习的NER工作也相继展开。Guillaume等[14]提出了一种基于长短时记忆网络(long short term memory, LSTM)和CRF结合的命名实体识别方法,用来识别英文人名、地名等实体。Dong等[15]提出了利用卷积神经网络(convolutional neural networks, CNN)进行特征提取的方法来进行命名实体识别。Li等[16]使用RNN并结合词字特征来构建医疗领域的命名实体识别模型。杨培等[17]提出了一种基于字词特征并结合注意力机制的实体识别方法,该方法通过神经网络LSTM来训练实体识别分类器,并采用CRF产生最后的实体标签分类结果。

显然,通过这些方法获得的命名实体识别分类器的知识仅来源于作为训练集的标注语料库,从而造成其性能对大规模充分标注的数据有很强的依赖性。本文的工作充分考虑医疗领域大量医疗本体存在的事实和中文医疗文本自身的特点,通过从已有的医疗本体中获取部分命名实体知识并与训练集中已标注的知识相结合来进行序列学习分类器的构建,有效提高了准确率。

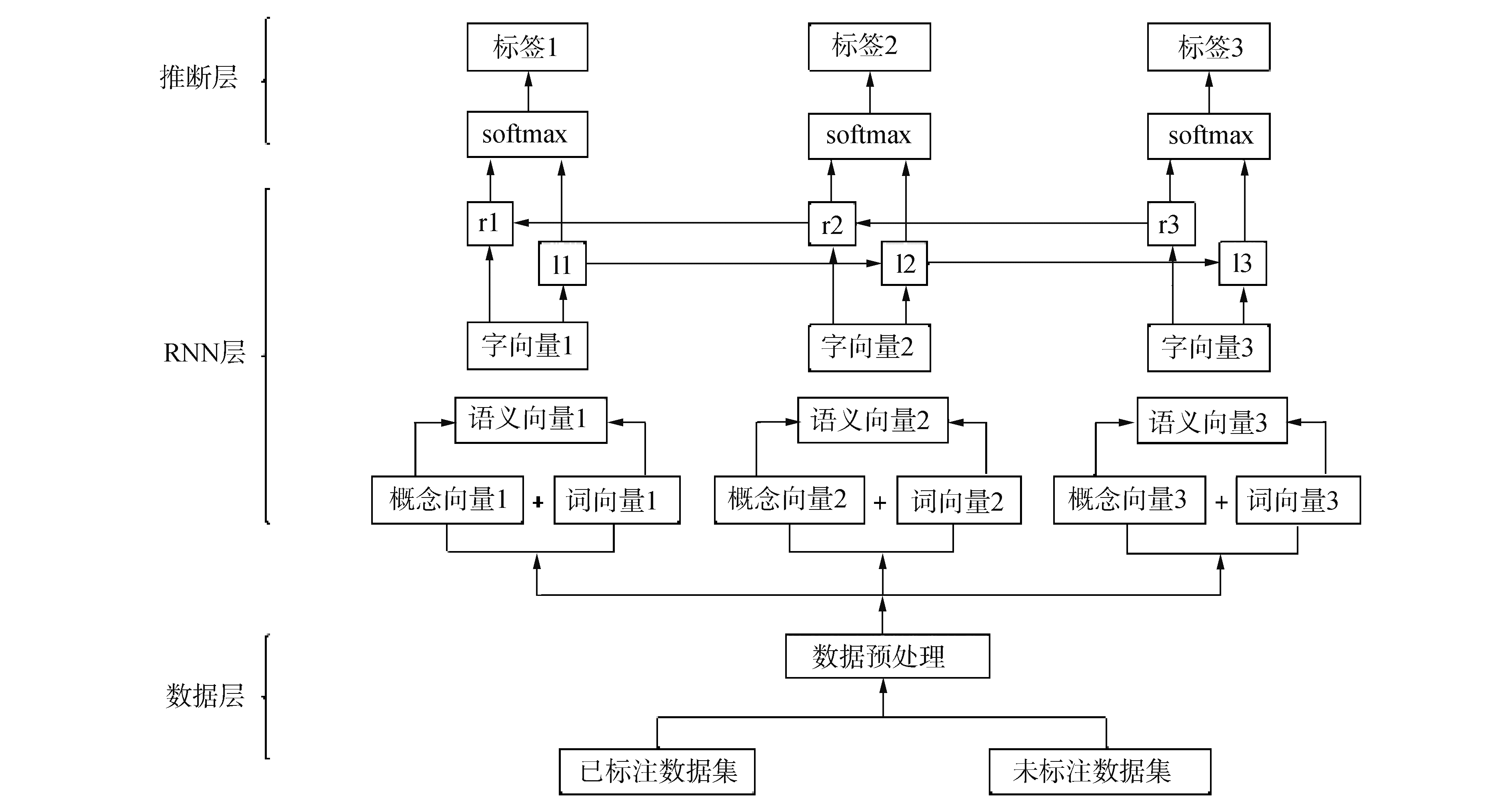

1 基于多粒度特征融合的命名实体识别方法本文提出的基于循环神经网络的语义和字符向量结合的命名实体识别模型整体结构,如图 1所示。

|

Download:

|

| 图 1 基于RNN的语义和字符向量相结合的命名实体识别模整体结构 Fig. 1 The model architecture of combining semantic and character embedding based on RNN | |

语义特征包含概念特征和词特征2个部分。其中,概念是指由多个包含语义的单独词汇组成的一个特殊的领域术语, 例如,慢性阻塞性肺疾病。词是指一个单独的语义词汇,例如,困难。本文对于那些能够从领域本体里映射出概念的,就提取概念特征;对那些不能提取概念的直接提取词特征,最后通过CBOW(continuous bag-of-words model)模型提取语义特征。

1) 概念特征表示。

由于医疗术语通常是由多个词组成,仅考虑词特征会使语义信息割裂,因此在本文的方法中加入了概念特征。首先,将所有稀疏标记的语料库根据特殊符号切分成较短的汉子字符串(包括标点符号、数字和空格符)并去除停用词;其次,将预处理后的字符串映射在构建好的医疗本体中,通过最大匹配法来提取本体中的概念;最后,采用一种基于本体计算概念特征相似度的方法来降低语义特征的维度,从而减少计算量。具体流程如算法1所示。

算法1 概念特征提取

输入:数据集D(包含已标注数据集和未标注数据集),本体O;

输出:概念特征。

1) 进行概念特征提取;

2) 通过特殊符号将数据集D切分为汉字字符串L,L=(L1, L2, …, Ln);

3) 将字符串L映射到本体O;

4) For匹配字符串L中的每一个字符;

5) 如果Lmax=Llen (Lmax为字符串的最大初始匹配长度,Llen为字符串的长度);

6) 则字符串整体为一个概念;

7) 如果Lmax < Llen

则i=1 (i为字符串中字符的位置);

8) 如果L1 < Lmax,

9) 则i=i+1;

10) 直到匹配到Li=Lmax,

11) End for

12) 将Lmax从L中抽取出来,并将Lmax的左右两边分为2个新的待切分字符串。

2) 词特征表示。

将词输入到模型中是深度学习方法在处理NLP任务时的首要步骤,因为它能够从大量已标注和未标注的数据中学习到有用的语义和语法信息。传统的机器学习方法通常采用词袋模型(bag of words)表示词向量特征。例如,One-hot Representation[18],该模型在处理离散数据时有一定的优势,但是它没有考虑词与词之间的顺序,因此,不能很好地体现出词与词之间的语义联系,不适用于实体识别这样的序列标注任务;其次,随着数据量的增大,特征维度将会呈现爆炸式增长,会给后期的运算带来很大的压力。与高维、稀疏的词袋模型相比,分布式词向量表示具有低维,密集的特点更适用于实体识别任务。

目前常用的分布式词向量表示模型有word2vec[19]和GolVe[20]等,本文采用word2vec中的CBOW模型来提取语义特征。CBOW的训练目标使平均对数的概率最大化:

| $ L(D) = \frac{1}{N}\sum\limits_{i = K}^{N - K} {{\rm{log}}} P({y_i}|{y_{i - K}}, \cdots ,{y_{i + K}}) $ | (1) |

式中:K为数据集D中目标词的上下文信息;yi为数据集D中的语义。

1.1.2 字符向量特征表示字符是中文中最自然的语言单位[21],与词不同,字符主要关注的是词语拼写的特点而不是词语本身的语义。由于中文不间断的书写特性,字符向量也能够表达词语的语义信息,例如:“瘦弱”一词,既可以根据上下文来判断该词的语义特征,也可以通过该词的字符“瘦”和“弱”来直接判断语义。因此,在中文命名实体识别的任务中,字符向量不仅可以辅助判断语义特征还可以通过字意达到预测新词的效果。

本文采用CEW[22] (character-enhanced word embeddding)模型来学习字符特征并结合语义特征一起进行训练。该模型在word2vec的CBOW模型的基础上进行了改进。结合语义向量和字符向量的CWE模型具体的计算方式为:

| $ {Q_i} = {\mathit{\boldsymbol{y}}_i} \oplus \frac{1}{{{y_n}}}\sum\limits_{k = 1}^{{y_n}} {{\mathit{\boldsymbol{z}}_k}} $ | (2) |

式中:yi为语义Yi的语义向量;zk为yn中第k个字符向量;yn为语义Yi所包含的字符个数;Qi由语义向量和其平均字符向量组合运算得出。

组合运算⊕有2个运算方式:相加或者结合计算。相加就是将语义向量和字符向量的平均值相加,其中语义向量和字符向量位数相等,如|yi|=|zk|。另一方面,也可以通过结合的方式,词向量和字符向量的平均值相加得到Qi,并且Qi的向量维度为|yi|+|zk|。通过实验证明,2种运算方法的性能差别不大,但在效率方面,相对于结合运算方法的维度高、复杂性大的特点,加法的运算效率更高。因此,本文采用了相加的运算方法来提取字符向量:

| $ {\mathit{\boldsymbol{Q}}_i} = {\mathit{\boldsymbol{y}}_i} + \frac{1}{{{y_n}}}\sum\limits_{k = 1}^{{y_n}} {{\mathit{\boldsymbol{z}}_k}} $ | (3) |

循环神经网络(RNN)[23]是一个序列模型,每个神经元不仅能够沿层间向上传递信息,还可以传输给下一个序列,因此比其他的神经网络更适用于序列标注的任务。RNN具有一个隐藏单元,即:

| $ {h_t} = \sigma (W{x_t} + U{h_{t - 1}} + b) $ | (4) |

式中:ht为t时刻的输出,由输入xt在t-1时刻的ht-1隐藏单元一起决定;σ为激活函数,例如sigmoid、tanch或者ReLU (rectified liner unit)等;W、U为权重向量;b为偏差向量。

理论上,RNN是可以处理任意长度的序列标注任务。然而,实验表明:由于RNN的存储记忆功能过于简单,随着序列长度的增加会产生梯度消失或者梯度爆炸的问题,因此RNN不能够学习与当前时刻较远的信息。为了解决这个问题,LSTM和GRU (gate recurrent unit)模型被相继提出。

本文采用了双向RNN、双向LSTM和双向GRU模型,分别表示为BRNN、BiLSTM和BGRU(包括前向和反向),用来解决当前时刻只能获得上文,而不能获得下文信息的问题。这里,使用

长短时记忆网络(LSTM)在1997年被Hochreiter和Schmidhuber提出,主要为了解决RNN的梯度消失问题[24]。LSTM能够处理无界任意长度的顺序输入,并返回输入中每个步骤的序列信息。相对于传统的RNN模型,LSTM可以处理长期依赖的问题,在每个时刻步骤中都包含了控制门(输入门、遗忘门和输出门),允许网络忘记、记忆和更新上下文记忆,并减轻了梯度消失等问题。

| $ {{c_t} = {f_t}{c_{t - 1}} + {i_t} \odot {{\tilde c}_t}} $ | (5) |

| $ {{{\tilde c}_t} = g({W_c}{x_t} + {U_c}{h_{t - 1}} + {b_c})} $ | (6) |

| $ {{h_t} = {o_t} \odot g({c_t})} $ | (7) |

式中:

| $ {{i_t} = \sigma ({W_i}{x_t} + {U_i}{h_{t - 1}} + {b_i})} $ | (8) |

| $ {{f_t} = \sigma ({W_f}{x_t} + {U_f}{h_{t - 1}} + {b_f})} $ | (9) |

| $ {{o_t} = \sigma ({W_o}{x_t} + {U_o}{h_{t - 1}} + {b_o})} $ | (10) |

式中:it、ft、ot分别为时间节点t的输入、遗忘、输出门;σ为非线性函数。每一个控制门的参数都由2个矩阵和1个偏差向量组成,因此,3个控制门的矩阵参数分别为Wi、Ui、Wf、Uf、Wo、Uo,偏差参数为bi、bf、bo。LSTM的记忆单元参数分别为Wc、Uc和bc。这些参数在训练和储存时的每一步都进行更新。

门控神经网络(GRU)与LSTM的目标一样,都是为了解决RNN长期记忆和反向传播中的梯度消失或者爆炸问题。不同的是,GRU将LSTM中3个控制门整合为更新门和重置门[25]。GRU的整体结构为:

| $ {{h_t} = (1 - {z_t}) \odot {h_{t - 1}} + {z_t} \odot {{\tilde h}_t}} $ | (11) |

| $ {{{\tilde h}_t} = g({W_h}{x_t} + {U_h}({r_t} \odot {h_{t - 1}}) + {b_h})} $ | (12) |

| $ {{z_t} = \sigma ({W_z}{x_t} + {U_z}{h_{t - 1}} + {b_z})} $ | (13) |

| $ {{r_t} = \sigma ({W_r}{x_t} + {U_r}{h_{t - 1}} + {b_r})} $ | (14) |

式(13)和式(14)分别代表GRU的2个控制门,其中zt代表更新门,rt代表重置门。GRU降低了LSTM的模型结构的复杂度,并且减少了训练参数从而降低训练难度,因此,GRU也是当前神经网络中流行的算法。本文同样采取双向GRU(BGRU)来获得与当前时刻相关的上下文信息。

如图 1所示,本文的模型采用了深度学习模型RNN并结合了语义特征和字符特征,将现有的医疗本体与训练集相结合来获取命名实体知识。由于医疗术语大多是由多个词组成,仅考虑词特征会造成语义信息割裂,因此首先基于本体提取概念特征,对于不能提取概念特征的直接进提取词特征,概念特征和词特征统称为语义特征。

由于在中文中,大部分字符本身就含有一些语义信息,例如:疼痛,即使该词在训练预料库里从未出现过,也可以根据该词的字面信息“疼”和“痛”来判断语义,因此在语义特征的基础上提取了字符特征。对于因医疗术语表达不一致所造成的特征维度高、计算量大的问题,本文通过一种基于本体计算概念特征相似度的方法来降低语义特征的维度,以而减少计算量。

本方法的主要目的是通过提取不同粒度的文本特征来提高命名实体识别的准确率。整体流程如算法2所示。

算法2 基于RNN的弱监督实体识别

输入:数据集D(包含已标注数据集和未标注数据集),本体O;

输出:命名实时识别的预测标签。

1) For对于切分好的语义集(包含概念集和词集){G1, G2, …,GN}∪{C1, C2, …,CN}∈Y;

2) 计算

3) End For

4) For对于每一个语义特征

yi∈(y1, y2, …, yn)提取字符特征

5) 计算

6) End For

7) 将融合字符特征的语义特征映射到本体O;

8) If有概念特征gi和gk对应本体概念oi∈O;

9) 通过余弦相似度计算gi和gk到本体概念oi的相似度距离;

10) Else If小于相似度阈值α;

11) gi和gk分别为本体中的一个独立概念(α的取值范围在0.82~0.92,由于实验中α为0.87时误差最小,因此设为0.87);

12) Else If大于相似度阈值α;

13) 认为yj和yk为同一个概念;

14) 初始化:RNN训练模型。

其中,1)、2)为CBOW的语义特征提取,4)、5)为用CEW的方法提取字符特征,7)、13)为基于本体计算概念特征相似度的方法来降低语义特征的维度,14)为启用RNN相关模型来进行实体标签预测。

2 实验和结果 2.1 数据集和参数设置本文采用了合作医院的真实数据集,共15 589份电子病历,包含普通外科、内科等17类疾病。每份病历包含入院、出院、病程3分记录,由主诉、既往史、检查、治疗手段4部分组成。表 1为电子医疗病历数据集的构成。

| 表 1 电子医疗病历语料库的统计 Table 1 Statistics of EMR corpus |

实验中将电子医疗病历数据集分为:训练集(已标注)、训练集(未标注)、验证集(用于调整模型的超参数)和测试集(用来评估模型的泛化性)。已标注数据集中的数据标注任务是由医生与医学相关专业的学生共同完成的。为了克服单独测试结果过于片面以及训练数据不足的问题,本文在训练时采用5折交叉的方法,每次选取4个子集作为训练集,1个子集作为验证集,不断重复,直到所有的子集都作为训练集和验证集并且完成训练。

表 2为模型的超参数设置,对于字符少于4位的进行补0操作,采用随机梯度下降算法(stochastic gradient descent, SGD)对模型进行优化。为了防止过拟合,在模型的每层加入了批次正则化(bath normalization),并且引入了dropout训练策略[26]。大量实验证明,该方法能够在不同程度上有效防止过拟合现象。

| 表 2 模型在实验中的超参数 Table 2 The hyper-parameters of model in experiment |

在全部的数据集中,实体分为如下4类:

1) 疾病:包含电子病历中病人的现病史、既往史、家族病史和医生根据患者的身体状况做出的诊断。例如:慢性肺源性心脏病、急性阻塞性肺疾病、高血压等。

2) 症状:表示患者向医生陈诉(或者别人代诉)的不适感觉或异常感觉,也包括严重程度的修饰成分。例如:喘息、头痛、恶心等。

3) 检查:指通过实验室检查或体格检查来判断患者所患疾病。例如:胸部X线、血常规、肺功能等。

4) 治疗:指治愈疾病、缓解或改善症状所用的治疗方法。例如:药物、呼吸机、手术等。

考虑到实体识别也是一个序列标注任务,由于医疗实体通常由多个词组成,因此本文采用广泛应用的BIESO标签机制:O表示不属于任何概念的实体,B、I、E分别表示一个实体的第一个词、中间词和结尾词。S代表该词本身就是一个实体。

2.3 评价标准本文采用实体识别常用的几个评价标准来衡量本文提出方法的有效性:准确率(precision)、召回率(recall)和F1值。

准确率指正确识别出的命名实体占总识别出的比例,召回率是指正确识别出的命名实体数量占文件中所包含的实体数量的比例。设置A为被成功识别出的实体数量,B为未被成功识别出的实体数量,C为模型错误地将非命名实体识别为命名实体的数量。

准确率为:

| $ P = \frac{A}{{A + C}} $ | (15) |

召回率为:

| $ R = \frac{A}{{A + B}} $ | (16) |

准确率和召回率并不总是同时达到峰值(它们甚至常常呈负相关)。为了在这2个标准之间做出权衡,实验也采用了考虑这2个标准的F1测度来衡量实体识别的有效性:

| $ {F_1} = \frac{{2PR}}{{P + R}} $ | (17) |

本文实验分为3个部分:首先,对比CRF、Rule-base、SVM 3种传统方法与本文提出的基于RNN的语义和字符特征结合的方法的性能,即分别对全部已标数据集和加入部分未标数据集的识别性能进行了对比;其次,为了说明概念特征在中文医疗命名实体识别任务中的重要性,对基于RNN的词字向量结合模型和基于RNN的语义和字符向量结合模型进行了对比;最后,对RNN相关的3种模型(RNN、LSTM和GRU)的性能进行比较。

表 3和表 4为CRF、Rule-based、SVM方法与本文基于RNN的语义和字符向量结合的弱监督方法在全部已标注数据集与加入未标注数据集的性能对比结果。实验结果表明,基于RNN的方法优于其他3种传统方法。在全部已标数据集和加入未标数据集中,基于BGRU的词字向量结合模型的效果是最好的,分别达到了86.35%和84.54%。不同的是,在表 3全部已标注数据集中,本文方法只比传统方法的准确率提高了1.5%~4.2%,这说明传统方法在处理有监督学习任务时也有不错的表现。但是,由表 4可以看出,在加入未标数据集后,本文方法比着传统方法的准确率提高了2.2%~6.1%。由此可以看出,RNN相关模型的时序记忆功能对弱监督的实体识别任务有着非常重要的影响。总的来说,在训练语料库不充分时本文方法表现更好,这十分有助于解决如今大量人工标注耗时耗力的问题。

| 表 3 传统方法与基于RNN的语义和字符向量结合模型在全部已标数据集上的性能对比 Table 3 The comparison of the performance between the model of combining semantic and character embedding base on RNN and traditional methods on fully labeled dataset |

| 表 4 传统方法与基于RNN的语义和字符向量结合模型在部分未标数据集上的性能对比 Table 4 The comparison of the performance between combining semantic and character embedding base on RNN model and traditional methods on a part of unlabeled dataset |

表 5和表 6分别描述了基于RNN的词字向量结合模型和基于RNN的语义和字符向量结合模型在全部已标数据集上的性能对比。从实验结果可以看出,语义和字符向量结合模型比词字向量结合模型的准确率提高了0.62%。由此可以说明,在中文医疗领域的命名实体识别任务中概念特征也是非常重要的,因为它能够防止语义信息割裂,保持语义的完整性。从表 6中可以观察到,在基于RNN的语义和字符向量结合模型中BiLSTM和BGRU的表现都比BRNN好,这也验证了前文提到的RNN模型不能处理较长序列的任务,因为随着序列长度的不断增加会出现梯度消失或者爆炸的情况。总的来说:基于RNN相关模型的弱监督方法由于具有时序记忆功能更适合处理实体识别等序列标注的任务,尤其针对训练语料库不全的情况;在命名实体识别的任务中,概念特征能够防止语义信息割裂,提高命名实体的准确率;在RNN相关的模型中,由于BRNN不能处理较长序列任务,因此比BiLSTM和BGRU方法的性能低。其次,本文提出的命名实体识别方法也存在一定的局限性:对领域本体的依赖性较高,本文提出的概念特征是从本体中获取的,高质量的语义特征抽取依赖于高质量的外部领域本体库。分类器构建的学习过程中计算复杂性较高,例如一个字符串在本体中可能会匹配出多个概念,而且特征融合造成特征维度的增加也会增加分类器构建的学习时间。由于目前公开的中文电子病历数据集很难获取到,因此本文的实验部分只在合作医院提供的数据集上进行。

| 表 5 基于RNN的词字向量结合模型 Table 5 Model of combining word and character embedding base on RNN |

| 表 6 基于RNN的语义和字符向量结合模型 Table 6 Combining semantic and character embedding base on RNN model |

1) 从医疗本体中提取概念特征可以保持中文术语语义的完整性,并降低人工标注成本,提高命名实体识别的准确率。

2) 通过实验表明,相比BRNN、BiLSTM和BGRU更擅长处理较长序列的文本。

3) 基于真实临床医疗文本挖掘的实验验证了本文提出的方法在实际应用中的有效性。

在未来的工作中,将会进一步考虑命名实体识别的时间复杂性,通过将一个字符串匹配出的多个相关概念进行相关度排序,来降低特征维度,从而提高分类器学习的速度;同时将继续寻找适用于中文医疗文本挖掘的公开评测数据集进行更全面的性能比较和算法的改进研究。

| [1] |

SOBEL A E K. The move toward electronic health records[J]. Computer, 2012, 45(11): 22-23. DOI:10.1109/MC.2012.387 (  0) 0)

|

| [2] |

FRIDSMA D. Electronic health records: the HHS perspective[J]. Computer, 2012, 45(11): 24-26. DOI:10.1109/MC.2012.371 (  0) 0)

|

| [3] |

李涓子, 侯磊. 知识图谱研究综述[J]. 山西大学学报(自然科学版), 2017, 40(3): 454-459. LI Juanzi, HOU Lei. Reviews on knowledge graph research[J]. Journal of Shanxi University (natural science edition), 2017, 40(3): 454-459. (  0) 0)

|

| [4] |

BRAUER F, HUBER M, HACKENBROICH G, et al. Graph-based concept identification and disambiguation for enterprise search[C]//Proceedings of the 19th International Conference on World Wide Web. North Carolina, Raleigh, USA, 2010: 171-180.

(  0) 0)

|

| [5] |

ZHENG Zhicheng, LI Fangtao, HUANG Minlie, et al. Learning to link entities with knowledge base[C]//Proceedings of Human Language Technologies: The 2010 Annual Conference of the North American Chapter of the Association for Computational Linguistics. Stroudsburg, 2010: 483-491. https://www.researchgate.net/publication/220817356_Learning_to_Link_Entities_with_Knowledge_Base

(  0) 0)

|

| [6] |

WANG Pu, DOMENICONI C. Building semantic kernels for text classification using Wikipedia[C]//Proceedings of the 14th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. Nevada, Las Vegas, USA, 2008: 713-721. https://www.researchgate.net/publication/221653419_Building_semantic_kernels_for_text_classification_using_wikipedia

(  0) 0)

|

| [7] |

张晓艳, 王挺, 陈火旺. 命名实体识别研究[J]. 计算机科学, 2005, 32(4): 44-48. ZHANG Xiaoyan, WANG Ting, CHEN Huowang. Research on named entity recognition[J]. Computer science, 2005, 32(4): 44-48. DOI:10.3969/j.issn.1002-137X.2005.04.014 (  0) 0)

|

| [8] |

WU Yonghui, JIANG Min, LEI Jianbo, et al. Named entity recognition in Chinese clinical text using deep neural network[J]. Studies in health technology and informatics, 2015, 216: 624-628. (  0) 0)

|

| [9] |

尹宝才, 王文通, 王立春. 深度学习研究综述[J]. 北京工业大学学报, 2015, 41(1): 48-59. YIN Baocai, WANG Wentong, WANG Lichun. Review of deep learning[J]. Journal of Beijing University of Technology, 2015, 41(1): 48-59. (  0) 0)

|

| [10] |

CHO K, VAN MERRIËNBOER B, GULCEHRE C, et al. Learning phrase representations using RNN encoder-decoder for statistical machine translation[J]. arXiv: 1406.1078, 2015: 148-156. https://www.researchgate.net/publication/262877889_Learning_Phrase_Representations_using_RNN_Encoder-Decoder_for_Statistical_Machine_Translation

(  0) 0)

|

| [11] |

LI Dingcheng, KIPPER-SCHULER K, SAVOVA G. Conditional random fields and support vector machines for disorder named entity recognition in clinical texts[C]//Proceedings of the Workshop on Current Trends in Biomedical Natural Language Processing. 2008: 94-95. https://www.researchgate.net/publication/234782767_Conditional_random_fields_and_support_vector_machines_for_disorder_named_entity_recognition_in_clinical_texts?ev=auth_pub

(  0) 0)

|

| [12] |

LEI Jianbo, TANG Buzhou, LU Xueqin, et al. A comprehensive study of named entity recognition in Chinese clinical text[J]. Journal of the American medical informatics association, 2014, 21(5): 808-814. DOI:10.1136/amiajnl-2013-002381 (  0) 0)

|

| [13] |

何林娜, 杨志豪, 林鸿飞, 等. 基于特征耦合泛化的药名实体识别[J]. 中文信息学报, 2014, 28(2): 72-77. HE Linna, YANG Zhihao, LIN Hongfei, et al. Drug name entity recognition based on feature coupling generalization[J]. Journal of Chinese information processing, 2014, 28(2): 72-77. DOI:10.3969/j.issn.1003-0077.2014.02.011 (  0) 0)

|

| [14] |

LAMPLE G, BALLESTEROS M, SUBRAMANIAN S, et al. Neural architectures for named entity recognition[C]//Proceedings of the 2016 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. San Diego, California, 2016: 260-270. https://www.researchgate.net/publication/305334469_Neural_Architectures_for_Named_Entity_Recognition

(  0) 0)

|

| [15] |

DONG Xishaung, QIAN Lijun, GUAN Yi, et al. A multiclass classification method based on deep learning for named entity recognition in electronic medical records[C]//Proceedings of 2016 New York Scientific Data Summit. New York, NY, USA, 2016: 1-10. https://www.researchgate.net/publication/310622391_A_multiclass_classification_method_based_on_deep_learning_for_named_entity_recognition_in_electronic_medical_records

(  0) 0)

|

| [16] |

LI Jianqiang, ZHAO Shenhe, YANG Jijiang, et al. WCP-RNN: a novel RNN-based approach for Bio-NER in Chinese EMRs[J]. The journal of supercomputing, 2020, 76(3): 1450-1467. DOI:10.1007/s11227-017-2229-x (  0) 0)

|

| [17] |

杨培, 杨志豪, 罗凌, 等. 基于注意机制的化学药物命名实体识别[J]. 计算机研究与发展, 2018, 55(7): 1548-1556. YANG Pei, YANG Zhihao, LUO Ling, et al. An attention-based approach for chemical compound and drug named entity recognition[J]. Journal of computer research and development, 2018, 55(7): 1548-1556. (  0) 0)

|

| [18] |

WANG Jing, WANG Meng, LI Peipei, et al. Online feature selection with group structure analysis[J]. IEEE transactions on knowledge and data engineering, 2015, 27(11): 3029-3041. DOI:10.1109/TKDE.2015.2441716 (  0) 0)

|

| [19] |

MIKOLOV T, SUTSKEVER I, CHEN Kai, et al., Distributed representations of words and phrases and their compositionality[C]//Proceedings of the 26th International Conference on Neural Information Processing Systems. Stateline, 2013: 3111-3119. https://www.researchgate.net/publication/257882504_Distributed_Representations_of_Words_and_Phrases_and_their_Compositionality

(  0) 0)

|

| [20] |

WANG Anran, WANG Jian, LIN Hongfei, et al. A multiple distributed representation method based on neural network for biomedical event extraction[J]. BMC medical informatics and decision making, 2017, 17(S3): 171. DOI:10.1186/s12911-017-0563-9 (  0) 0)

|

| [21] |

SHIJIA E, YANG Xiang. Chinese named entity recognition with character-word mixed embedding[C]//Proceedings of the 2017 ACM on Conference on Information and Knowledge Management. Singapore, 2017: 2055-2058.

(  0) 0)

|

| [22] |

CHEN Xinxiong, XU Lei, LIU Zhiyuan, et al. Joint learning of character and word embeddings[C]//Proceedings of the 24th International Conference on Artificial Intelligence. Buenos Aires, 2015: 1236-1242.

(  0) 0)

|

| [23] |

ZAREMBA W, SUTSKEVER I, VINYALS O. Recurrent neural network regularization[J]. arXiv: 1409.2329, 2014: 263-271.

(  0) 0)

|

| [24] |

BENGIO Y, SIMARD P, FRASCONI P. Learning long-term dependencies with gradient descent is difficult[J]. IEEE transactions on neural networks, 1994, 5(2): 157-166. (  0) 0)

|

| [25] |

DEY R, SALEM F M. Gate-variants of Gated Recurrent Unit (GRU) neural networks[C]//Proceedings of 2017 IEEE 60th International Midwest Symposium on Circuits and Systems. Boston, MA, USA, 2017: 1597-1600.

(  0) 0)

|

| [26] |

SRIVASTAVA N, HINTON G, KRIZHEVSKY A, et al. Dropout: a simple way to prevent neural networks from overfitting[J]. Journal of machine learning research, 2014, 15(1): 1929-1958. (  0) 0)

|

| [27] |

ZHANG Yuejie, XU Zhiting, ZHANG Tao. Fusion of multiple features for chinese named entity recognition based on CRF model[C]//Proceedings of the 4th Asia Information Retrieval Symposium. Harbin, 2008: 95-106. https://www.researchgate.net/publication/221055509_Fusion_of_Multiple_Features_for_Chinese_Named_Entity_Recognition_Based_on_CRF_Model

(  0) 0)

|

| [28] |

XU Yan, HONG Kai, TSUJII J, et al. Feature engineering combined with machine learning and rule-based methods for structured information extraction from narrative clinical discharge summaries[J]. Journal of the American medical informatics association, 2012, 19(5): 824-832. DOI:10.1136/amiajnl-2011-000776 (  0) 0)

|

| [29] |

WANG Jianhong, PENG Yousong, LIU Bin, et al. Extracting clinical entities and their assertions from Chinese electronic medical records based on machine learning[C]//Proceedings of the 20163rd International Conference on Materials Engineering, Manufacturing Technology and Control. Taiyuan, 2016: 46-52.

(  0) 0)

|

2020, Vol. 41

2020, Vol. 41