视频显著性区域检测与人类视觉注意机制密切相关,它能够模仿人类视觉系统自动搜索感兴趣区域的行为,使用图像处理的方法将视频中最易引起注意的区域提取出来。对于图像的分析处理以及计算资源的分配具有重要意义,在目标识别[1]、图像检索[2],自适应压缩[3]等领域拥有较为广阔的应用前景。

过去十几年,学者们提出了许多针对单帧静态图像的显著性区域检测算法。Itti等[4]提出基于多尺度图像特征融合的显著性检测算法,计算灰度、颜色对和方向这3个图像特征的多尺度中心-周边差异,并将它们线性融合得到显著性图。Hou等[5]提出了基于频域的谱残差(spectrum residual,SR)检测模型,认为频谱域上的统计奇异对应图像的显著区域。Achanta等[6]提出了基于频率调谐(frequency-tuned,FT)的显著性计算方法,利用颜色特征的中央-周边算子来得到显著图。FT算法对于简单场景中的大目标检测能力较强,但对于复杂背景中噪声的干扰鲁棒性一般。Cheng等[7]提出了一种基于区域颜色对比度(region contrast,RC)的方法,利用颜色直方图与空间信息计算的显著图,能够得到完整且可定义的显著区域。

视频与静态图像的显著性区域检测有很大的差别,由于运动信息的引入以及背景复杂性的增加,视频显著性处理的复杂度相对较高,目前这方面的研究较少,且没有能够较好地兼顾不同背景情况的检测算法。Itti等[8]最早提出了针对视频图像的显著性区域检测算法,在原始静态Itti模型中引入了运动特征,将连续两帧图像在不同尺度的差异作为运动产生的显著性。Harel等[9]提出了一种基于图的不相似性度量的显著性计算方法(graph-based visual saliency,GBVS),该方法通过求解二维图像马尔可夫链的平衡分布得到视频显著图。GBVS算法的鲁棒性较好,但在显著区域边缘容易造成大面积的模糊。Guo等[10]提出了基于四元傅里叶变换相位谱(phase spectrum of quaternion Fourier transform,PQFT)的视频显著性区域检测方法,利用时空特征傅里叶变换的相位谱确定显著性区域。PQFT方法将相邻两帧之间的差异作为运动信息,当背景中存在动态干扰时,检测效果欠佳。Wang等[11]提出了基于感知测量(saliency-aware geodesic, SAG)的视频显著性区域检测方法,通过计算超像素与边缘像素的测地距离生成时空显著图。该方法主要依赖于图像的边缘特征和运动梯度特征,在复杂纹理场景下容易产生噪声区域。

上述视频显著性区域检测算法仅将相邻两帧之间的变化作为运动信息,在时间显著性的计算上存在一定的局限,动态干扰的鲁棒性较差,易将背景中存在如树叶、草的晃动等干扰的位置误判为显著性区域;并且在时空信息融合阶段,目前的算法大多采取简单的线性相加或相乘的方式,将运动信息与亮度、对比度等图像底层特征同等对待[10],事实上,不同背景条件下,运动信息与底层空间信息对于显著性的贡献并不是均等的。根据心理学研究,当背景静止不动时,相对于底层空间特征,时域的运动更能吸引人的注意[12];当摄像头平动时,局部运动信息不再突出,图像对比度、亮度等空间特征更能引起人的注意。目前的显著性检测方法大多没有考虑到不同背景情况下运动信息对显著性影响程度不一的事实,对不同情形视频的显著性区域检测效果差距较大,不具有通用性。

针对上述问题,本文提出了一种基于时空信息自适应融合的视频显著性区域检测算法,分别从时间、空间维度提取视频图像的显著性信息,并提出自适应加权的显著图融合方式。

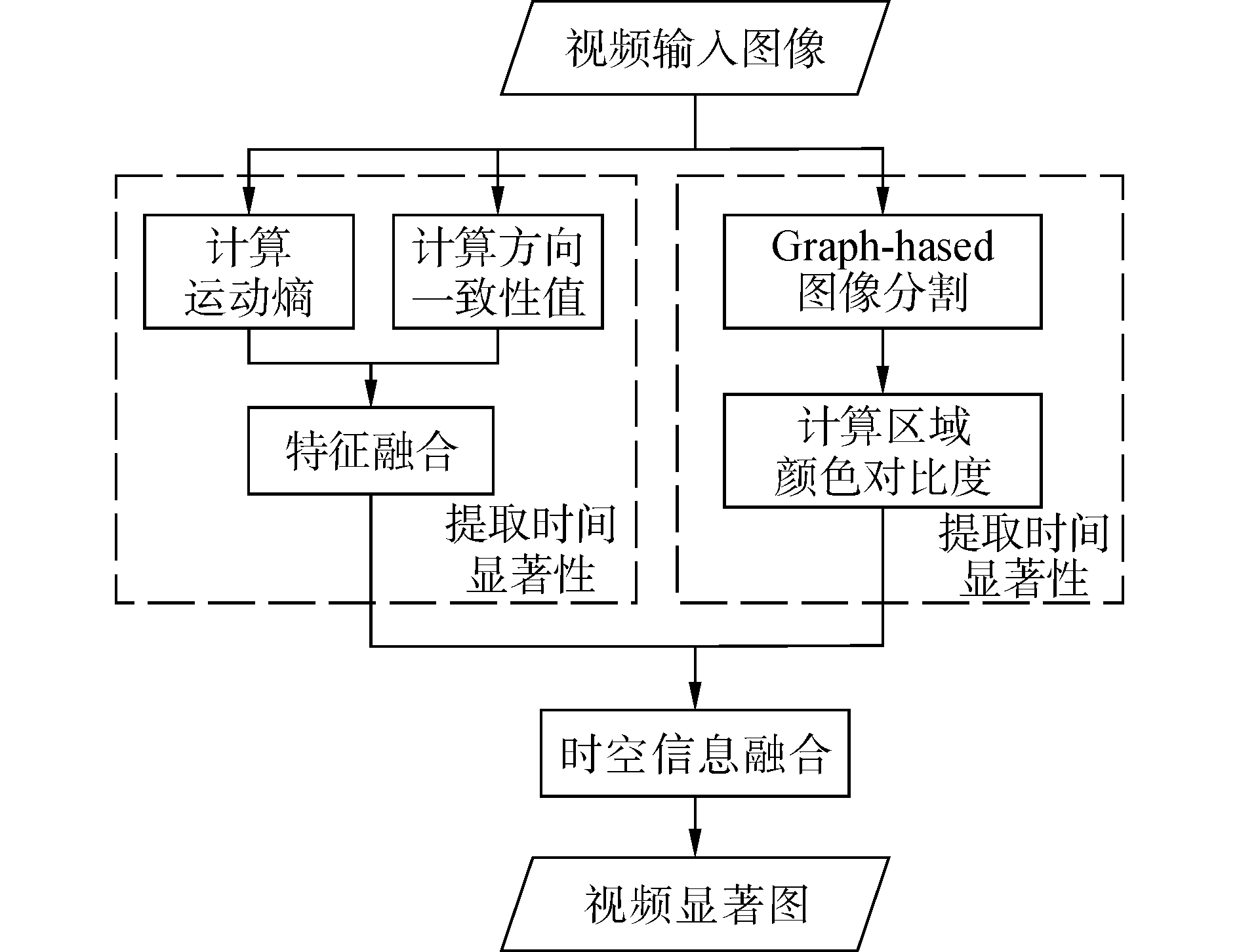

1 基于时空信息融合的视频显著性区域检测算法视频由连续多帧图像组成,帧之间的强相关性使得视频图像在时间维度上包含更丰富的运动信息。神经生物学研究发现,相比纹理、颜色等图像底层空间特征,人类视觉系统对场景中的运动信息更为敏感[14]。因此视频显著性在包括图像固有底层特征所造成的空间显著性基础上,更应考虑图像序列在时域上的运动信息对于显著性的影响。基于以上理论,本文提出了如图 1所示的时空显著性信息融合框架,该框架主要包括时间显著性提取、空间显著性提取以及时空信息融合三个部分。

|

Download:

|

| 图 1 本文算法基本框架 Fig. 1 The basic framework of this paper | |

算法对第t帧视频图像的具体处理过程如下:1)时间显著性方面,依据时域运动的连续性,对包括第t帧在内的连续τ帧的运动信息进行处理,计算得到该帧中每点的运动熵,表征该点在连续多帧中的运动强度;依据运动的方向一致性,利用夹角余弦法计算第t帧中每点与邻域点的方向一致性值,以衡量各点与邻域点的运动方向相似程度;将运动熵值与方向一致性值进行特征融合以提取时间显著性,并构建时间显著图。2)空间显著性方面,为了确保显著性区域完整且可描述,采用基于图的图像分割方法对第t帧视频图像进行分割,对于其中的某一区域,计算与其他区域颜色对比度之和,作为该区域的空间显著值;以此类推,遍历图像中各个区域,从而实现空间显著性提取,得到该帧输入图像对应的空间显著图。3)时空信息融合阶段,根据人眼对不同背景条件视频的主观感知,提出一种自适应加权的时空信息融合方法,通过设置动态权重自适应融合时间显著图与空间显著图,得到第t帧图像对应的视频显著图。

1.1 时间显著性提取视频显著性区域内像素点的运动具有连续性和方向一致性的特点,可以很好地与背景区分开。本文提出一种鲁棒的时间显著性计算方法,引入“运动熵”和“方向一致性值”共同描述时间显著性,并进一步构造时间显著图。其中“运动熵”表征像素点在连续多帧之内的运动强度,“方向一致性”特征用于描述像素点与其邻域其他点的运动方向相似程度。在计算时间显著性之前,利用光流法[15]提取运动矢量场Ft(i, j)=[ut(i, j), vt(i, j)],点(i, j)在第t~t+1帧之间运动矢量的幅值和方向分别如下:

| $ {\rm{ma}}{{\rm{g}}_t}\left( {i,j} \right) = \sqrt {u_t^2\left( {i,j} \right) + v_t^2\left( {i,j} \right)} $ | (1) |

| $ {\theta _t}\left( {i,j} \right) = \arctan \frac{{{v_t}\left( {i,j} \right)}}{{{u_t}\left( {i,j} \right)}},\theta \in \left[ { - {\rm{ \mathsf{ π} }}/2,{\rm{ \mathsf{ π} }}/2} \right] $ | (2) |

视频中的显著性区域通常保持连续且稳定的运动。依据运动的连续性,本文引入“运动熵”表征像素点在连续多帧内的运动强度,第t帧中点(i, j)的“运动熵”可通过计算该点在连续τ帧的运动幅值的平方和得到。为了进一步提升算法性能,在计算过程中引入指数衰落因子以弱化较远帧对当前帧的影响。具体计算如下:

| $ {E_t}\left( {i,j} \right) = \sum\limits_{\varphi = 0}^{\tau - 1} {{\omega _\varphi }{{\left[ {{\rm{ma}}{{\rm{g}}_{t + \varphi }}\left( {i,j} \right)} \right]}^2}} $ | (3) |

式中:ωφ=e-φ为指数衰落因子;τ为参与计算的连续帧数,本文中取值为5。“运动熵”能够反映目标在一段时间内的运动情况,显著性区域由于保持持续稳定的运动,因此运动熵值较高,而背景中存在突发扰动的区域呈现不规律的运动,运动熵值较低。利用连续多帧信息计算“运动熵”,能在一定程度上抑制背景中微小扰动的影响,比仅将相邻两帧之间的变化作为运动信息更加真实。

1.1.2 方向一致性值视频显著性区域内各点的运动具有一致或近似一致的方向,若某区域内各点的运动方向差异较大,则该区域可能位于存在微小扰动的背景中。本文引入“方向一致性”特征,用于度量像素点与邻域点运动矢量的方向相似程度。夹角余弦值可用于度量矢量之间角度的大小,其值越大,两个矢量的方向越相近,计算公式如下:

| $ {\rm{dist}}\left[ {{\mathit{\boldsymbol{F}}_t}\left( {i,j} \right),{\mathit{\boldsymbol{F}}_t}\left( {m,n} \right)} \right] = \frac{{{\mathit{\boldsymbol{F}}_t}\left( {i,j} \right) \cdot {\mathit{\boldsymbol{F}}_t}\left( {m,n} \right)}}{{\left\| {{\mathit{\boldsymbol{F}}_t}\left( {i,j} \right)} \right\| \times \left\| {{\mathit{\boldsymbol{F}}_t}\left( {m,n} \right)} \right\|}} $ | (4) |

方向一致性值可通过计算像素点与邻域点运动矢量的夹角余弦值之和得到。对于第t帧中的点(i, j),选定大小为(N×N)的邻域(本文中N取4),分别计算Ft(i, j)与其邻域内其他点的运动矢量的夹角余弦值,并进行累加求和,得到该点的方向一致性值,计算公式如下:

| $ {D_t}\left( {i,j} \right) = \sum\limits_{\begin{array}{*{20}{c}} {\left( {m,n} \right) \in {\mathit{\Omega }_{\left( {i,j} \right)}}\left( N \right)}\\ {\left( {m,n} \right) \ne \left( {i,j} \right)} \end{array}} {{\rm{dist}}\left[ {{\mathit{\boldsymbol{F}}_t}\left( {i,j} \right),{\mathit{\boldsymbol{F}}_t}\left( {m,n} \right)} \right]} $ | (5) |

式中:Ω(i, j)(N)表示以点(i, j)为中心,窗口长度为N的邻域像素集合。某区域的方向一致性值越大,表明该区域中各点的运动方向越相近,属于显著性区域的可能更高。因此,方向一致性值的计算能够进一步区分扰动背景和显著性区域。

1.1.3 特征融合融合“运动熵”和“方向一致性”特征信息,可以实现时间显著性的度量,第t帧图像对应的时间显著图TSmapt的计算如下:

| $ {\rm{TSma}}{{\rm{p}}_t} = {E_t}{D_t} $ | (6) |

视频中的显著性区域具有持续稳定运动,因此时间显著值较高,背景中存在突发扰动区域的运动呈现不规律以及间歇性,因此时间显著值较小。TSmapt的计算综合考虑连续几帧内的运动强度以及与当前帧邻域范围其他点的运动方向一致程度,能够突出连续运动的区域,从而实现鲁棒的时间显著性估计。

1.2 空间显著性提取视频图像包含颜色对比度、亮度,轮廓等固有的底层信息。在众多底层信息中,人类视觉系统对颜色对比度最为敏感,能够快速捕获图像中与周围相比对比度较大的区域。因此,颜色对比度对视频显著性的贡献不容忽视。本文采用目前公认性能较优的基于区域颜色对比度的方法(region contrast,RC)[7]计算空间显著性,用以弥补运动信息忽略了颜色特征空间分布的缺点,并保证显著性区域的空间完整,具体的计算过程如下。

1) 采用Graph-Based[16]图像分割方法将图像分割为不同的区域,进行区域级的颜色对比度计算,则区域r1和r2的颜色对比度可表示为

| $ {D_r}\left( {{r_1},{r_2}} \right) = \sum\limits_{i = 1}^{{n_1}} {\sum\limits_{j = 1}^{{n_2}} {f\left( {{c_{1,i}}} \right)f\left( {{c_{2,j}}} \right)D\left( {{c_{1,j}},{c_{2,j}}} \right)} } $ | (7) |

式中:f(ck, i)为颜色i在区域rk的所有nk种颜色中出现的概率,k={1, 2}。D(c1, i, c2, j)为区域r1中的颜色c1, i和区域r2中的颜色c2, j在Lab颜色空间的距离。

2) 对于区域rk,通过计算它与其他区域的空间距离加权颜色对比度得到该区域的空间显著性值:

| $ \begin{array}{*{20}{c}} {S\left( {{r_k}} \right) = \sum\limits_{{r_i} \ne {r_k}} {\exp \left( { - {D_s}\left( {{r_k},{r_i}} \right)/\sigma _s^2} \right)} \times \omega \left( {{r_i}} \right) \times }\\ {{D_r}\left( {{r_k},{r_i}} \right)} \end{array} $ | (8) |

式中:ω(ri)为区域ri中包含的像素数,Ds(rk, ri)为区域rk和ri的欧氏距离,σs2为权值控制系数。对于第t帧图像,计算该帧图像中各区域的空间显著性值,进而得到第t帧图像的空间显著图SSmapt。

1.3 时空信息融合本文提出一种自适应加权的时空信息融合方法,根据时间显著性信息动态调整时间显著图与空间显著图的融合权重,确保在不同背景情况下均能得到较为准确的检测结果。时空信息融合所得视频显著图FSmapt的定义如下:

| $ {\rm{FSma}}{{\rm{p}}_t} = {\lambda _S} \times {\rm{SSma}}{{\rm{p}}_t} + {\lambda _T} \times {\rm{TSma}}{{\rm{p}}_t} $ | (9) |

式中:λS、λT分别为空间显著图SSmapt和时间显著图TSmapt的自适应动态权值,计算公式如下:

| $ \left\{ \begin{array}{l} {\lambda _T} = \frac{{\max \left( {{\rm{T}}{{\rm{S}}_{{\rm{ma}}{{\rm{p}}_t}}}} \right) - {\rm{mean}}\left( {{\rm{T}}{{\rm{S}}_{{\rm{ma}}{{\rm{p}}_t}}}} \right)}}{{{\rm{mean}}\left( {{\rm{T}}{{\rm{S}}_{{\rm{ma}}{{\rm{p}}_t}}}} \right)}}\\ {\lambda _S} = 1 - {\lambda _T} \end{array} \right. $ | (10) |

式中:mean(TSmapt)为时间显著图TSmapt中各点值的平均值,max(TSmapt)为TSmapt中的最大值。

当视频中的背景不动,只有小范围的区域存在运动时,mean(TSmapt)的值很小,且与TSmapt的峰值相差很大,此时λT增大,强调时间显著性的影响;当背景随显著区域一起运动时,视频中的运动信息较为平均,则λT减小,λS增大,为空间显著图赋予一个较大的权值,强调空间显著性的影响。自适应动态加权的融合方式,能够根据不同背景情况,自适应调整时间和空间显著图的比重,既考虑了运动容易引起注意的特点,又合理地度量了空间显著性,符合人类感知过程的相关规律。

2 实验结果与分析为验证本文算法的有效性和先进性,将本文提出的算法在Segtrack数据集[13]、Dataset 2014数据集[17]和VOT 2016数据集[18]共12段视频上进行定性和定量评价。所选数据库中的视频全面并具有代表性,涵盖了目标大小不一、背景信息不同的各种情况,并提供了手工标记的真实显著性区域Ground Truth,用于后续定量分析比较各算法的检测效果。选择目前5种主流显著性区域检测算法与本文算法进行比较,这些算法包括GBVS[9]、PQFT[10]、FT[6]、SAG[11],RC[7]。其中,RC为本文空间显著性计算部分所采用的算法。FT虽然为静态图像的显著性检测算法,但因其具有计算速度快的特点,部分文献把它作为视频显著性的估计算法。实验的软件环境为Visual Studio 2013,硬件条件为Intel Celeron CPU G1840,4.00 GB内存。

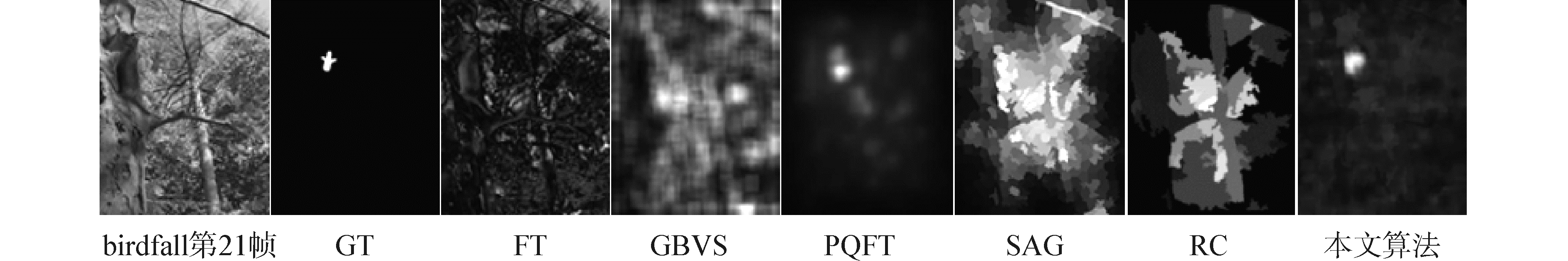

2.1 定性分析首先从定性角度对本文算法的性能进行评价。选取不同情形的视频序列进行测试,用以分析不同背景条件下的显著性区域检测效果。下面对选取的测试视频所对应的场景进行介绍:1)highway视频中,车辆由远及近高速运动,真实的显著性区域为车辆所在位置,该视频背景静止且场景包含大块匀质区域;2)birdfall视频中,一只鸟在林中从上向下飞行,真实的显著性区域为飞鸟所处的位置,该视频背景中存在树叶飘动等微小扰动且纹理极为复杂;3)pedestrians视频中,行人在街道上相向运动,真实的显著性区域为行人所在位置,摄像机在拍摄过程中存在抖动,因此该视频背景存在动态干扰;4)cheetah视频中,一只羚羊在草原上快速奔跑,真实的显著性区域为羚羊所在位置,该视频背景与显著性区域颜色相似,场景纹理较为复杂,并且摄像机随羚羊的运动平动。

图 2~5为本文算法与对比算法在不同情形测试视频上的显著性区域检测结果。由图 2可知,对于背景静止且包含大块匀质区域的常规场景,FT、GBVS、PQFT、SAG以及本文算法均取得了较好的检测效果。RC算法为仅利用颜色对比度信息的空间显著性计算方法,无法筛选出视频中的运动信息,因此该算法将背景误判为显著性区域,检测效果较差,进一步强调了运动信息对视频显著性的重要性。本文提出了鲁棒的时间显著性计算方法,能够较为准确地提取出视频中的运动信息,并且该视频中运动信息较为集中,在时空信息融合阶段,本文提出的自适应融合方法能够自主调节时间显著性在整体显著性中所占比例,因此能够较好地检测出显著性区域。

|

Download:

|

| 图 2 常规场景中的显著性区域检测 Fig. 2 The saliency detection of common scene | |

|

Download:

|

| 图 3 复杂纹理背景下的显著性区域检测 Fig. 3 The saliency detection of complex texture scene | |

|

Download:

|

| 图 4 摄像机抖动情况下的显著性区域检测 Fig. 4 The saliency detection of shaking situation | |

|

Download:

|

| 图 5 背景纹理复杂且摄像机平动情况下的显著性区域检测 Fig. 5 The saliency detection of complex texture and moving scene | |

图 3表明,在背景纹理复杂且显著性区域较小的情况下,多数显著性区域检测算法已不能很好地抑制背景中树叶飘动等动态干扰。FT算法过于依赖于图像的边缘特征,因此不能很好地区分显著性区域与背景;GBVS算法受复杂背景的影响,检测结果中产生了大面积模糊;SAG算法将背景中存在微小扰动的位置误判为显著性区域,效果较差;PQFT算法能够大致检测出显著性区域,但在区域轮廓边界产生了模糊;本文算法在时间显著性计算过程中采取了多帧运动信息估计和方向一致性度量,使其在一定程度上能够抵抗背景中树叶的动态干扰,因此在该视频上取得了较好的检测效果。

如图 4所示,摄像机存在微小抖动的情况下,FT算法只能检测出大致轮廓,不能均匀地突出显著性区域;GBVS算法的检测结果中存在大面积模糊;PQFT算法将背景中的栏杆等位置误判为显著性区域;SAG和本文算法检测效果较好。特别地,由于采用了鲁棒的时间显著性计算方法,本文算法能够克服摄像机的轻微抖动带来的干扰,并且较为准确地检测出显著性区域。

图 5表明,背景纹理复杂且摄像头平动的情况下,FT算法只能检测出显著性区域的部分边缘,无法均匀地突出显著位置;GBVS算法的检测结果存在大面积模糊区域,且将背景中的不相关位置误判为显著性区域,检测效果较差;PQFT的检测结果较为模糊;SAG算法以及本文算法检测效果较好。表明本文算法同样适用于背景发生变化(例如摄像头平动)的情况,当场景中运动信息较为平均时,显著性区域的运动信息已经不再突出,此时图像底层空间信息对于显著性的贡献更大,本文算法根据场景中运动信息的分布情况自适应调节融合权重,提高空间显著图的权值,以适应摄像机平动的情况,从而克服了背景运动带来的动态干扰。

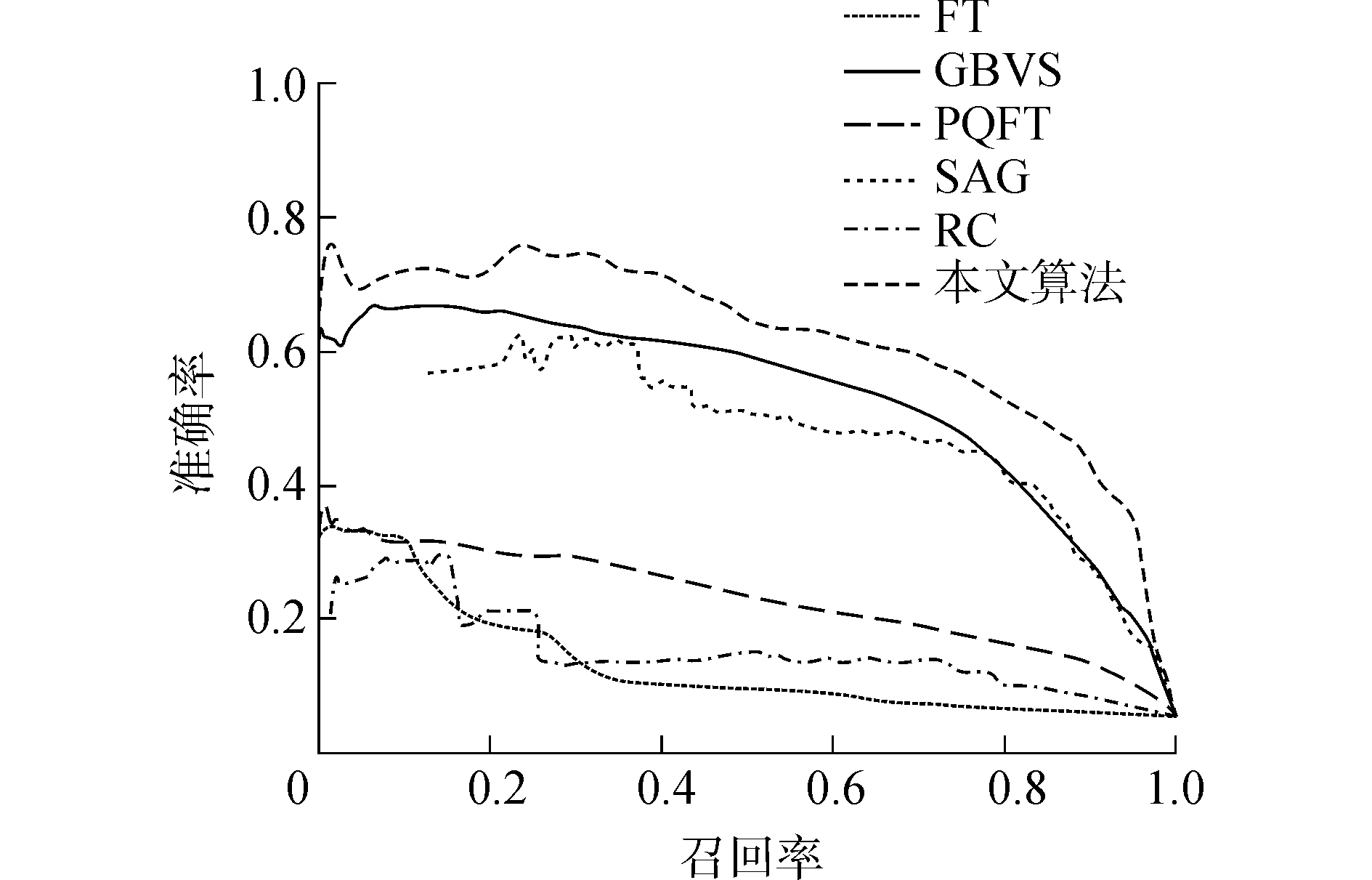

2.2 定量比较为了更客观、精确地评价几种算法的性能,本文选用显著性检测领域常用的准确率-召回率曲线、F指标[19]对本文算法与对比算法进行性能评价。

1) 准确率-召回率

准确率定义为检测到正确显著点的数目与检测到所有显著点的数目之比。召回率定义为检测到正确显著点的数目与实际显著点的数目之比。用[0, 255]内256个整数阈值对显著图进行二值化分割,计算每个阈值下的准确率(precision)和召回率(recall),得到准确率-召回率曲线,曲线对显著性区域检测算法的评价准则为:在相同的召回率下,准确率越高则算法的性能越好。本文算法与对比算法的准确率-召回率曲线如图 6所示,由实验结果可知,本文算法的显著性区域检测效果明显优于对比算法。

|

Download:

|

| 图 6 准确率-召回率曲线 Fig. 6 The curves of precision-recall | |

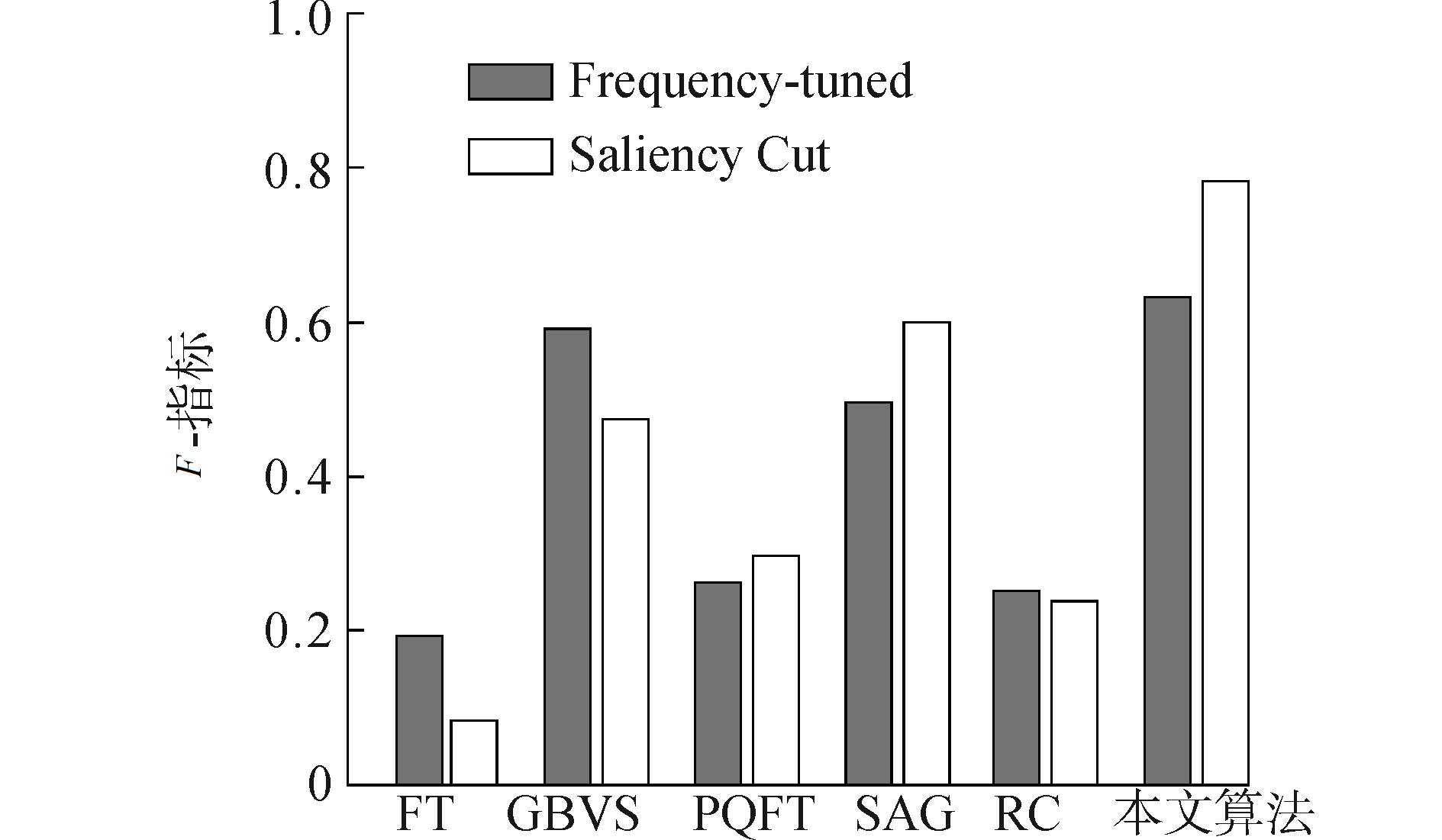

2) F指标

F指标是融合准确率和召回率的综合评价指标,具体计算公式如下:

| $ F = \frac{{\left( {1 + {\beta ^2}} \right) \times {\rm{precision}} + {\rm{recall}}}}{{{\beta ^2} \times {\rm{precision}} + {\rm{recall}}}} $ | (11) |

与文献[19]相同,式中的β2值设置为0.3。F指标表示算法提取真实显著性区域的同时抑制非显著性区域的能力,其值越大,算法的检测性能越强。由于F值受不同分割方法的影响较大,为了准确比较本文算法与对比算法的性能,本文实验中分别采用文献[16, 19]方法对显著图进行分割,再计算F指标。图 7为本文算法与对比算法在测试数据库上的F指标评价结果。由图 7可知,在不同分割方式下,本文算法均取得了最高的F值,表明本文算法在提取真实显著性区域的同时,抑制非显著性区域的能力较强。

|

Download:

|

| 图 7 F指标比较 Fig. 7 The histogram of F-measure | |

由实验结果可知,本文算法在定性分析和定量比较上均取得了较好的效果。不同测试视频的定性结果表明,本文算法能够较为精确地检测出视频中的显著性区域,并且能够很好地克服背景中的微小扰动以及相机运动等干扰的影响,适用于不同背景条件下的视频显著性区域检测。准确率-召回率曲线、F指标的定量评价结果表明,本文算法的性能优于对比算法,进一步验证了本文算法的有效性和鲁棒性。

3 结论1) 基于鲁棒的时间显著性计算方法,实现了时间显著性信息的准确提取,并进一步滤除了背景中动态扰动的影响。

2) 通过引入基于区域颜色对比度的空间显著性计算方法,确保了显著性区域的空间完整。

3) 自适应加权的时空信息融合方法,能够根据不同背景情况动态调整时、空显著图的融合权重,从而得到较为准确的检测结果。

4) 本文算法在检测精确度和鲁棒性等方面均优于现有视频显著性区域检测算法。

| [1] |

赵燕熙, 尚振宏, 刘辉, 等. 动态背景下空时特性均显著的运动目标检测[J]. 计算机工程与应用, 2017, 53(5): 170-175. ZHAO Yanxi, SHANG Zhenhong, LIU Hui, et al. Spatiotemporal salient moving object detection in dynamic background[J]. Computer engineering and applications, 2017, 53(5): 170-175. (  0) 0)

|

| [2] |

FENG Songhe, XU De, YANG Xu. Attention-driven salient edge(s) and region(s) extraction with application to CBIR[J]. Signal processing, 2010, 90(1): 1-15. (  0) 0)

|

| [3] |

GURAYA F F E, CHEIKH F A, MEDINA V. A novel visual saliency model for surveillance video compression[C]//Seventh International Conference on Signal Image Technology & Internet-Based Systems. Dijon, 2011: 298-305.

(  0) 0)

|

| [4] |

ITTI L, KOCH C, NIEBUR E. A model of saliency-based visual attention for rapid scene analysis[J]. IEEE transactions on pattern analysis and machine intelligence, 1998, 20(11): 1254-1259. DOI:10.1109/34.730558 (  0) 0)

|

| [5] |

HOU Xiaodi, ZHANG Liqing. Saliency detection: a spectral residual approach[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis, USA, 2007: 1-7.

(  0) 0)

|

| [6] |

ACHANTA R, HEMAMI S, ESTRADA F, et al. Frequency-tuned salient region detection[C]//IEEE Conference on Computer Vision and Pattern Recognition. Miami, 2009: 1597-1604.

(  0) 0)

|

| [7] |

CHENG Mingming, MITRA N J, HUANG Xiaolei, et al. Global contrast based salient region detection[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(3): 569-582. DOI:10.1109/TPAMI.2014.2345401 (  0) 0)

|

| [8] |

ITTI L. Realistic avatar eye and head animation using a neurobiological model of visual attention[J]. Proceedings of SPIE, 2003, 5200: 64-78. (  0) 0)

|

| [9] |

SCHÖLKOPF B, PLATT J, HOFMANN T. Graph-based visual saliency[C]//Advances in Neural Information Processing Systems (NIPS). Cambridge, 2010: 545-552.

(  0) 0)

|

| [10] |

GUO Chenlei, MA Qi, ZHANG Liming. Spatio-temporal saliency detection using phase spectrum of quaternion fourier transform[C]//IEEE Conference on Computer Vision and Pattern Recognition. Anchorage, 2008: 1-8.

(  0) 0)

|

| [11] |

WANG Wenguan, SHEN Jianbing, PORIKLI F. Saliency-aware geodesic video object segmentation[C]//IEEE Conference on Computer Vision and Pattern Recognition. Boston, 2015: 3395-3402.

(  0) 0)

|

| [12] |

贺俊.基于视觉注意机制的物体显著性研究[D].上海: 上海交通大学, 2009. HE Jun. Object salience detection based on visual attention mechanism[D]. Shanghai: Shanghai Jiao Tong University, 2009. (  0) 0)

|

| [13] |

TSAI D, FLAGG M, NAKAZAWA A, et al. Motion coherent tracking using multi-label MRF optimization[J]. International journal of computer vision, 2012, 100(2): 190-202. DOI:10.1007/s11263-011-0512-5 (  0) 0)

|

| [14] |

CULIBRK D, MIRKOVIC M, ZLOKOLICA V, et al. Salient motion features for video quality assessment[J]. IEEE transactions on image processing, 2011, 20(4): 948-958. DOI:10.1109/TIP.2010.2080279 (  0) 0)

|

| [15] |

FARNEBÄCK G. Two-frame motion estimation based on polynomial expansion[M]//BIGUN J, GUSTAVSSON T. Image Analysis. Berlin, Heidelberg: Springer, 2003: 363-370.

(  0) 0)

|

| [16] |

FELZENSZWALB P F, HUTTENLOCHER D P. Efficient graph-based image segmentation[J]. International Journal of Computer Vision, 2004, 59(2): 167-181. DOI:10.1023/B:VISI.0000022288.19776.77 (  0) 0)

|

| [17] |

WANG Yi, JODOIN P M, PORIKLI F, et al. CDnet 2014: an expanded change detection benchmark dataset[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition Workshops. Columbus, 2014: 393-400.

(  0) 0)

|

| [18] |

KRISTAN M, LEONARDIS A, MATAS J, et al. The visual object tracking VOT2016 challenge results[M]//HUA GANG, JÉGOU H. Computer Vision-ECCV 2016 Workshops. Cham: Springer, 2016: 777-823.

(  0) 0)

|

| [19] |

BORJI A, CHENG Mingming, JIANG Huaizu, et al. Salient object detection:a benchmark[J]. IEEE transactions on image processing, 2015, 24(12): 5706-5722. DOI:10.1109/TIP.2015.2487833 (  0) 0)

|

2018, Vol. 39

2018, Vol. 39