2. 南京理工大学 机械工程学院, 江苏 南京 210094;

3. 东南大学 自动化学院, 江苏 南京 210096

2. School of Mechanical Engineering, Nanjing University of Science and Technology, Nanjing 210094, China;

3. School of Automation, Southeast University, Nanjing 210096, China

路标检测是移动机器人场景认知与导航的重要前提[1]。机器人所使用的路标可分为人工路标和自然路标两类。其中,人工路标多是指经过特殊设计的颜色或纹理结构信息图案,也包括数字、字母以及二维条码等。这些图案一般都是用纸片打印制作,通过环境光照明使摄像机感光成像,容易受环境光照变化的影响,稳定性较差,其存在也对原始环境有所改变,具有一定的局限性[2-3]。自然路标是指利用环境中原有的场景作为标记进行定位导航。常规做法包括利用地图几何特征,抽取Voronoi图交叉点作为显著地点的方法[4];从激光测距与视觉等传感器提取环境中门框、告示牌、物品等标志物体,并从物体特征中学习地点模型[5]等。上述方法的优点是不破坏原有环境,普适性好,但计算复杂、鲁棒性不强。究其原因,主要是因为自然路标的检测和提取比较复杂,常需要保存机器人视野中的所有图像信息,然后进行特征的提取、存储、检测、匹配等。考虑到一个典型的室内场景图像中往往存在太多的特征点,或者在室内导航过程中,检测到数据库中存在类似的场景,再加上局部特征点维度等因素,往往会导致应用所需的计算复杂度过高。为了解决上述问题,Luke等[6]将聚类方法引入路标识别中,取得了一定的效果。然而,由于此类方法依然是在整幅图像上提取特征,还是存在较大的计算量。同时,如果场景图像发生动态变化,基于聚类的结果往往也会存在稳定性不够的缺陷。因此,如何选择有意义的场景并兼顾环境拓扑特征稀疏分布性成为了一个重要的问题。受到视觉注意机制的技术手段[7-9]的启发,本文提出一种基于视觉显著性的室内自然路标提取方法。不同于在整个图像场景提取和匹配视觉特征,本方法仅通过在视觉注意算法提取的显著路标区域来进行后续特征提取与匹配,提供有效的机器人导航所需路标信息。

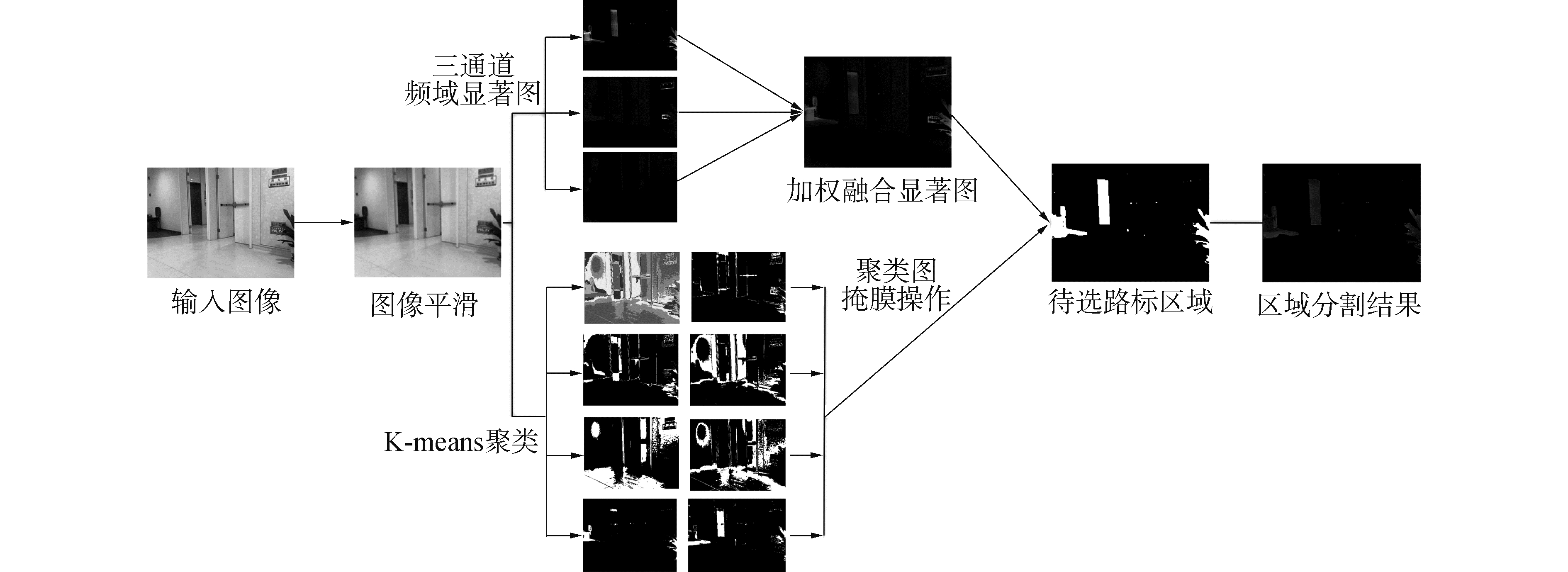

1 基于频域特性的显著区域提取由于人类视觉系统对于高对比度信息十分敏感。根据频域知识,图像的高频信息决定图像的细节部分,低频决定图像的总体轮廓。图像的频率是表征图像中灰度变化的剧烈程度,是灰度在平面空间上的梯度。基于上述理论,本文首先对于输入图像进行平滑预处理之后,在对立色彩空间分别计算各通道在频域空间的显著图,并进行融合。最后,结合图像聚类结果,进行显著路标分割。具体的算法框架结构如图 1。

|

Download:

|

| 图 1 显著路标提取算法框架 Fig. 1 Illustration of the main phases of algorithm | |

利用频域方法计算图像显著性时,具有相同频率特性的像素将具有相同的显著性值。为了获得均匀的显著图,应对于原始图像首先进行平滑处理。

本文利用L0梯度最小化算法[10]来进行图像平滑,该滤波器是一种基于稀疏策略的全局平滑滤波器,具有通过去除小的非零梯度,抚平不重要的细节信息,以及增强图像显著性边缘的优点。其中算法中用于约束图像水平和垂直方向梯度数目的核心公式为:

| $ \mathop {{\rm{min}}}\limits_f \sum\limits_p {{{\left( {{f_p} - {g_p}} \right)}^2}} + {\rm{ \mathsf{ λ} }} \cdot c\left( f \right) $ | (1) |

式中λ是平滑系数,λ值越大,图像越平滑,相应地,图像细节保留得就越少。

在采用该方式进行图像平滑操作时,由于平滑系数λ需要人工设定,这样往往就需要针对固定的场景图像进行反复测试才能找到最佳的值。一旦更换了机器人运动场景,则需要重新测试。联想到实际的场景应用,每个场景里的图片数量都比较多,同时每张图片的复杂度又都不尽相同,因此人工设定平滑参数方式缺乏实际可操作性。

考虑到背景单一的图像需要的平滑程度较小,复杂图像则需要较大的平滑力度。因此,如果能够大致衡量出单张图像的内容复杂度,就可以据此来设计对应的平滑系数,达到自适应平滑的目的。

文中提出一种基于图像熵理论的自动计算平滑参数的方法。图像熵是一种图像特征的统计形式,熵值可以用于衡量图像的信息复杂度。由于在图像中,背景区域往往拥有统一的纹理信息,因此熵是确定的。前景目标出现后,它就破坏了背景的纹理结构的特性,从而引起了图像熵的变化。通常物体所在区域的熵值会比较大,而背景则具有一致性的特点。文中采用式(2)计算单张图像的熵值:

| $ {H_{{R_i}}} = - \sum\nolimits_{v = 0}^{255} {{p_v}{\rm{ln}}{p_v}} $ | (2) |

式中pv是图像强度v的直方图形式概率表示。在实际的计算中,根据经验将图像熵值映射到[0, 9],同时为了避免过度平滑现象,本文采用λ=0.005H来计算最终的平滑系数值。

1.2 候选显著区域提取对于移动机器人导航应用环境,一个鲁棒而稳定的自然路标区域,应满足以下5点要求:

1) 区域所占图像的比例尺寸上有一定的限制,不能太小,也不能过大;

2) 能够均匀突出显示整个路标区域;

3) 具有明确的对象边界;

4) 忽略由纹理、噪声引起的高频块效应;

5) 有效输出全分辨率显著图。

根据上述要求,结合图像频域信息特性,如果设Wlt为低频阈值,Wht为高频阈值。为了满足1),强调最大的显著性目标,那么Wlt必须非常小,这也同时满足2)要求,强调整体显著性区域。另外,为了很好地定义显著性目标的边界,也需要保留高频部分,满足3)要求。同时,考虑到4)对于噪声的限定,因此,最终应该指定较宽的频率范围[Wlt,Wht]。算法在该部分使用多个高斯差分的结合作为带通滤波器:

| $ \begin{array}{l} {D_{{\rm{oG}}}}\left( {x, y} \right) = \frac{1}{{2{\rm{ \mathsf{ π} }}}}\left[ {\frac{1}{{\sigma _1^2}}{{\rm{e}}^{ - \frac{{\left( {{x^2} + {y^2}} \right)}}{{2\sigma _1^2}}}} - \frac{1}{{\sigma _2^2}}{{\rm{e}}^{ - \frac{{\left( {{x^2} + {y^2}} \right)}}{{2\sigma _2^2}}}}} \right] = \\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;G(x, y, {\sigma _1}) - G(x, y, {\sigma _2}) \end{array} $ | (3) |

式中:σ1和σ2是对应高斯的标准差(σ1>σ2)。当设定2个高斯方差成一定比例时,则高斯差分的联合表示为:

| $ \begin{array}{l} \sum\limits_0^{N - 1} {G\left( {x, y, {\rho ^{n + 1}}\sigma } \right)} - G(x, y, {\rho ^n}\sigma ) = \\ \;\;\;\;\;\;\;\;G(x, y, \sigma {\rho ^N}) - G\left( {x, y, \sigma } \right) \end{array} $ | (4) |

当取比例为1.6时,每做一次高斯差分,就相当于是一个边缘检测器,那么将所有的高斯差分结合起来,就等于把所有的边缘检测器从不同的尺度空间中结合起来。也就是说,每做一次高斯差分就保留一定范围的频率,把所有的高斯差分结合起来就是把所有的频率搜集起来,最终达到显著性检测的要求了。本文参照FT方法[9]的设置,σ1取值无穷大(相当于计算整幅图像的均值),而σ2取一个小的高斯核,可以滤去一些噪声。最后得到方程为:

| $ S\left( {x, y} \right) = \left\| {{\mathit{\boldsymbol{I}}_u} - {\mathit{\boldsymbol{I}}_{{\rm{wht}}}}\left( {x, y} \right)} \right\| $ | (5) |

在对图像进行高斯滤波,得到滤波后的图像之后,不同于文献[9]的做法,本文选择在对立色彩颜色空间(opponent color space)计算像素的显著性值。对立色彩空间的3个通道与RGB空间的转换关系:

| $ \left\{ \begin{array}{l} I = \left( {R + B + G} \right)/3\\ {R_G} = R - G\\ {B_Y} = B - \left( {R + G} \right)/2 \end{array} \right. $ | (6) |

目前,大多数视觉注意模型都是在CIELab颜色空间上进行显著性值的计算。在对立色彩空间上计算显著性的研究不多。但是该颜色模型依据视觉信息处理机制,可以模拟视网膜神经节细胞的响应,更加贴切人类视觉对于颜色的反应机制,并且在前期视觉显著性的计算中也得到了部分验证[11-12]。

与大多数文献将I、RG、BY 3个通道同等对待不同,实际的研究过程中发现,当在该颜色空间上进行像素显著性值计算的时候,一般都是一个或2个通道表现得非常好,另外的通道对于最终的计算不起或者起到副作用。图 2分别表示原始输入图像、I、RG、BY通道图像,对应的在I、RG、BY通道上计算得到的显著图以及GT(groud truth)标准参考图。在第1行邮箱图片中可以看出,RG通道是最有用的,RG通道的显著图与参考标准图非常接近。而BY通道看上去对于最终的融合显著图并没有什么贡献。再比如旗帜图像中的I通道,帆船图像中的BY通道,可以看出他们都应该对图像最终的显著图有比较重要的贡献,而对应旗帜图像的RG通道以及帆船图像的I通道对于最终结果则并不重要。因此本文考虑,在此种情况下不应该将三通道同等对待,而应该根据某种原则进行加权组合。

|

Download:

|

| 图 2 对立颜色空间各通道显著图 Fig. 2 Saliency computation in the opponent color space | |

由于并不是每个对立颜色空间通道都对最终的显著图提供了有用的信息,不适宜采用简单的取最大值或者平均值的方式来融合各个通道的显著图信息。另一方面,考虑整幅图像中的像素数量,显著性像素的数量相较于背景区域会占据较小的比例份额,即显著物体或区域在整幅图像中应占据小部分。

基于上述原则,本文提出一种加权融合的方式来解决通道显著图融合的问题,并取得较为满意的效果,具体的步骤如下所示。

1) 分别计算出I、RG、BY通道的显著图。

2) 分别计算出各个通道显著图像的平均显著值,并统计超过该平均值的像素数量百分比,分别用NI、NRG、NBY表示。

3) 计算各通道的加权系数,计算公式为:

| $ w = \left\{ \begin{array}{l} {\rm{min}}\left( {1, 1 - {{\left( {N - r} \right)}^2}} \right), \;\;\;\;\;\;\;\;\;\;\;\;N \le r\\ {\rm{max}}\left( {0, 0.5 - {{\left( {N - r} \right)}^{1/2}}} \right), \;\;\;\;\;\;其他 \end{array} \right. $ | (7) |

式中:N是2)中每通道超平均值的像素百分比;r是人工根据经验设定的参考系数,文中根据后期的实验效果,选用r=0.3。

4) 计算最终的图像显著图,计算公式为:

| $ {S_{gs}} = {\rm{Norm}}\left( {\sum {{W_I}{S_I}} , {W_{RG}}{S_{RG}}, {W_{BY}}{S_{BY}}} \right) $ | (8) |

式中:SI、SRG、SBY分别代表对立颜色空间I、RG、BY的显著图;wI、wRG、wBY分别代表对应的权重系数(由3)计算得到),Norm代表归一化。

2 基于聚类算法的显著区域分割各通道频域显著图进行加权融合之后,考虑到路标一致性和噪声的因素,引入聚类方法进行模型优化,并对于图像的聚类结果和最终的显著图进行分割提取,从而得到最终的自然路标候选区域。文中采用Hill-Climbing K-means方法[13]进行聚类。该算法可以自动确定聚类数量,并基于颜色直方图的像素点个数,将能到达同一个峰值的颜色区域认为是同一类,并据此进行图像分割。

在得到图像的分割结果之后,结合频域显著性检测得到的三通道显著图进行显著图优化工作。利用图像聚类的结果对于最终的显著图进行掩膜操作,得到显著图与每类聚类图像的交集图像。然后,利用计算每类交集图像的显著性值:

| $ {V_k} = \frac{1}{{\left| {{r_k}} \right|}} = \sum\limits_{i, j \in {r_k}} {{m_{i, j}}} $ | (9) |

式中:|rk|代表分割区域的像素面积;mi, j代表区域中所有的显著值。在得到每类交集图交集图像的显著值之后,利用设定自适应阈值T,进行交集图像的选择:

| $ T = \frac{1}{{W \times H}}\sum\limits_{x = 0}^{W - 1} {\sum\limits_{y = 0}^{H - 1} {S\left( {x, y} \right)} } $ | (10) |

式中:W和H是显著图的宽度和高度;S(x, y)是对应坐标(x, y)点的显著值。当Vk大于T时,则认为该交集图像为具有显著性,从而保留;否则丢弃,最终得到待选路标区域。

3 实验结果与分析移动机器人导航要求自然路标在环境发生一定程度变化时,能够被稳定地被检测到。为了验证显著性在路标检测中的意义,在非结构环境下,利用美国NI公司的DaNI机器人配备单目摄像头和测距传感器等获得图像和距离信息,图像分辨率为320×240,导航阶段采用RootSIFT特征。机器人直行最大运动速度为500 m/s。旋转速度最大为4(°)/s, 上位机硬件配置为八核2.2 GHZ,8 G内存PC机,不使用GPU加速。本文利用改装的DaNI机器人硬件平台,选取了校园办公室、活动区、图书馆走廊3个室内场景,以及一个室外场景,采集相应环境图像进行显著路标的稳定性验证。部分场景范例如图 3所示。

|

Download:

|

| 图 3 实验场景示例 Fig. 3 Examples of experimental scene pictures | |

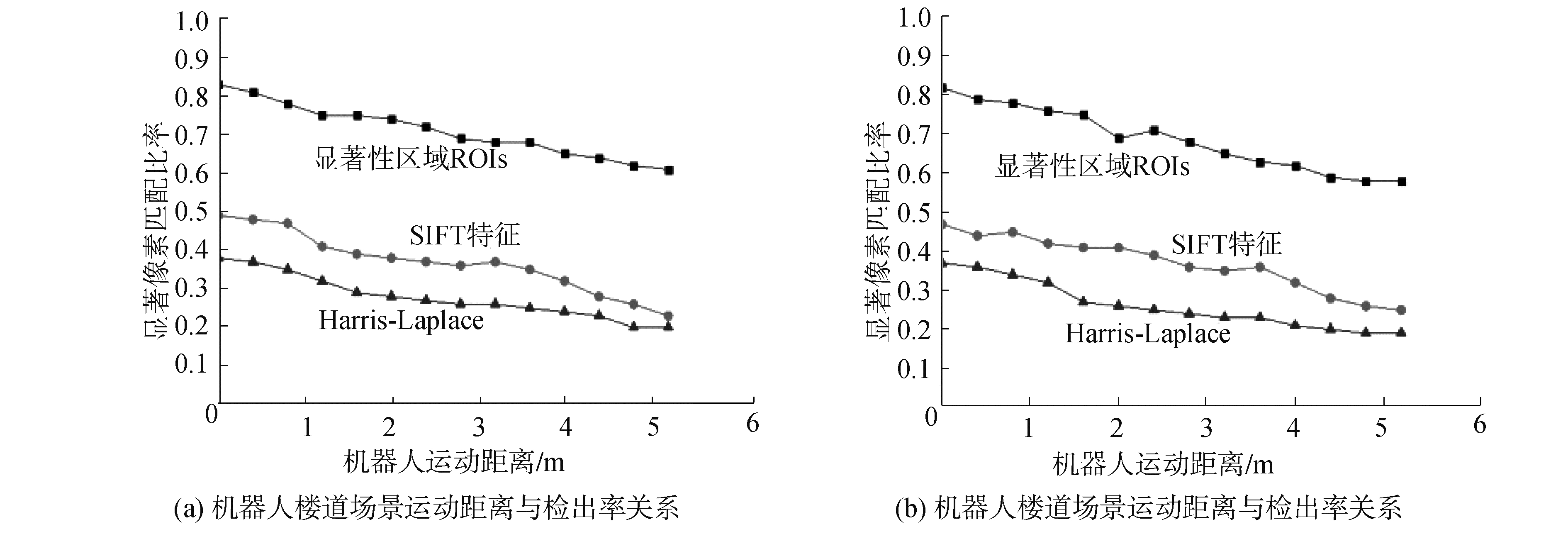

图 4是活动室范例场景的示例图像。其中图 4(a)和图 4(c)对应活动区电梯和走廊间的不同帧图像,图 4(b)和图 4(d)代表原图对应的显著图。图 5的2幅XY图是对应场图景中,机器人行动距离的变化与对应显著像素区域检出率之间的关系。由图 5可以看出,显著性区域在不同帧中被持续检出,当尺度或者机器人视角发生改变时,相比较于其他方法,可以保持较高的识别率。另外,当机器人远离的时候,尽管当前显著像素区域的检出率有所下降,但是此时往往有新的显著区域被检出(新的路标候选区域),不会影响到最终的机器人状态定位和导航准确率。

|

Download:

|

| 图 4 活动室场景及其显著区域示例 Fig. 4 Example of the activity room and its salient areas | |

|

Download:

|

| 图 5 机器人运动中显著区域像素检测率 Fig. 5 Salient pixels detection rate during the robot motion | |

导航阶段选取校园的图书馆场景验证本文算法的有效性。实验开始前,首先需要手动操控机器人沿既定路径行走一次,期间机器人自动提取显著性路标,并按照路标发现时间顺序存储对应路标特征点以及坐标信息。也就是说,当机器人穿过测试环境时,保持了区域的时间顺序,这主要是为了后期基于路标的导航应用。当完成了全部环境的漫游之后,采用显著场景路标点为全局拓扑节点,以连接边连接了相邻的拓扑节点构成图结构,结合机器人的位姿信息,将相邻节点之间的基坐标关系附加在节点间的连接边区域[14],离线利用路径学习方法形成路标数据库,并构建环境拓扑地图。

当机器人实际导航过程中,系统首先识别至少一个显著路标来进行自定位。一旦机器人成功地完成了定位工作,它就可以仅仅利用简单的搜索算法计算出可行路径。然后,导航系统使用最初识别的路标,以及数据库中记忆的下一个路标和当前路标的坐标关系进行逐步导航,随后不断重复该过程,直到机器人到达其指定目的地。本文选取了经典的fastSLAM方法[15]以及最近的ORB-SLAM方法[16]进行比较。其中本文方法运行在Windows10系统中,对比方法都是开源代码,可在GitHub中下载。其中,fastSLAM基于ubuntu 14.04,ORB-SLAM方法基于在ubuntu 14.04和ros indigo环境。

对于每个测试环境,首先运行机器人通过所有路径一次进行训练。然后本文在2个场景分别运行机器人5次进行测试。在测试过程中,记录了机器人测距的轨迹,通过使用手动校准的测距读数设置机器人位置。并规定理想导航本身的基准是路径的中心。图 6是图书馆二层场景下完成的导航任务的轨迹记录,其中路标节点是代表性的拓扑节点,不同方法用不同形状图形表示。

|

Download:

|

| 图 6 图书馆场景下不同方法导航轨迹 Fig. 6 Navigation trails of different methods in the library | |

从图中可以看出,尽管3种方法都可以完成导航任务,但是效率和准确率都有所区别。机器人导航执行效率如表 1所示。其中fastSLAM算法关注的是移动机器人运动路径的递归估计和基于估计路径的对于环境特征位置的独立估计问题,其中的机器人定位问题采用粒子滤波算法解决,建图问题采用扩展卡尔曼滤波算法解决。然而,由于扩展卡尔曼滤波算法的线性化处理误差较大和移动机器人系统的噪声不是高斯白噪声等问题,其位姿估计的误差会比较大。同时,fastSLAM方法的导航轨迹相对比较偏离,这与fastSLAM方法固有的诸如其需要计算雅可比矩阵,难以满足一致性要求,容易产生粒子退化等缺陷也有一定关系。而ORB-SLAM方法是近年来的比较完备的单目SLAM算法。该方法利用ORB特征完成了机器人的定位和导航任务。ORB-SLAM优化了关键帧选取和地图构建的方法,在处理速度、追踪效果和地图精度上都取得了不错的效果。但是,由于ORB构建的地图比较稀疏,这也会造成基于该地图的机器人应用遇到比较大的困难。同时,ORB方法中诸如特征匹配的阈值,回环图像对比的阈值等关键参数都是经验设定,在不同场景下对应值不同,效果会产生比较大的差异。本文方法基于前期的路标数据库信息,在拓扑地图的指引下,不考虑机器人的全局定位,具有较强的鲁棒性,准确度也是几种方法中最好的。然而,虽然本文算法采用了视觉注意机制来限制特征点提取与匹配的区域,但是由于RootSIFT算子本身的局限性,执行的效率上略低于ORB-SLAM方法。

| 表 1 不同方法的导航效率及轨迹对比 Table 1 Comparison of the navigation efficiency and trajectory results from different calculation methods |

1) 相较于其他显著性计算模型方法,本文利用频域方法,在对立颜色空间计算场景显著性,并提出了自适应的加权融合策略得到场景显著图。该方法可以均匀突出显示整个路标区域,输出全分辨率显著图,符合导航所需自然路标的要求。

2) 尽管颜色特性在显著性检测中非常重要,然而,对于在场景前景和背景颜色相近时,文中方法容易提取失败。后续需要进一步引入纹理、形状等特征,提升模型的鲁棒性。

| [1] |

KUNII Y, KOVACS G, HOSHI N. Mobile robot navigation in natural environments using robust object tracking[C]//2017 IEEE 26th International Symposium on Industrial Electronics. Edinburgh, UK, 2017: 1747-1752. https://www.researchgate.net/publication/319029003_Mobile_robot_navigation_in_natural_environments_using_robust_object_tracking

(  0) 0)

|

| [2] |

PFRUNDER A, BORGES P V K, ROMERO A R, et al. Real-time autonomous ground vehicle navigation in heterogeneous environments using a 3D LIDAR[C]//2017 IEEE/RSJ International Conference on Intelligent Robots and Systems. Vancouver, BC, Canada, 2017: 2601-2608. https://www.researchgate.net/publication/321820708_Real-time_autonomous_ground_vehicle_navigation_in_heterogeneous_environments_using_a_3D_LiDAR

(  0) 0)

|

| [3] |

BEINHOFER M, MVLLER J, BURGARD W. Effective landmark placement for accurate and reliable mobile robot navigation[J]. Robotics and autonomous systems, 2013, 61(10): 1060-1069. DOI:10.1016/j.robot.2012.08.009 (  0) 0)

|

| [4] |

CHOSET H, NAGATANI K. Topological simultaneous localization and mapping (SLAM):toward exact localization without explicit localization[J]. IEEE transactions on robotics and automation, 2002, 17(2): 125-137. (  0) 0)

|

| [5] |

ZEIDAN B, DASGUPTA S, WÖRGÖTTER F, et al. Adaptive landmark-based navigation system using learning techniques[M]//DEL POBIL A P, CHINELLATO E, MARTINEZ-MARTIN E, et al. International Conference on Simulation of Adaptive Behavior. Cham: Springer, 2014, 8575: 121-131.

(  0) 0)

|

| [6] |

LUKE R H, KELLER J M, SKUBIC M, et al. Acquiring and maintaining abstract landmark chunks for cognitive robot navigation[C]//2005 IEEE/RSJ International Conference on Intelligent Robots and Systems. Edmonton, Alta., Canada, 2005: 2566-2571. http://www.researchgate.net/publication/224623531_Acquiring_and_maintaining_abstract_landmark_chunks_for_cognitive_robot_navigation

(  0) 0)

|

| [7] |

吴鹏, 徐洪玲, 李雯霖, 等. 基于区域检测的多尺度Harris角点检测算法[J]. 哈尔滨工程大学学报, 2016, 37(7): 969-973. WU Peng, XU Hongling, LI Wenlin, et al. Multi-scale Harris-corner detection algorithm based on region detection[J]. Journal of Harbin Engineering University, 2016, 37(7): 969-973. (  0) 0)

|

| [8] |

ZHAO Chunhui, ZHOU Yihui, WEI Yanyan, et al. Visual saliency landmark detection algorithm based on DNN feature extraction[C]//2016 35th Chinese Control Conference. Chengdu, China, 2016: 5551-5556. https://www.researchgate.net/publication/308501338_Visual_saliency_landmark_detection_algorithm_based_on_DNN_feature_extraction

(  0) 0)

|

| [9] |

ACHANTA R, HEMAMI S, ESTRADA F, et al. Frequency-tuned salient region detection[C]//2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami, FL, USA, 2009: 1597-1604. https://www.researchgate.net/publication/286980217_Frequency-tuned_salient_region_detection

(  0) 0)

|

| [10] |

XU Li, LU Cewu, XU Yi, et al. Image smoothing via L0 gradient minimization[J]. ACM transactions on graphics, 2011, 30(6): 1-12. (  0) 0)

|

| [11] |

YANG Hanpei, LI Weihai. Edge-aware saliency detection via novel graph model[M]//ZENG B, HUANG Q, EL SADDIK A, et al. Pacific-Rim Conference on Multimedia. Cham: Springer, 2018: 45-55.

(  0) 0)

|

| [12] |

FRINTROP S, WERNER T, GARCÍA G M. Traditional saliency reloaded: A good old model in new shape[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA, 2015: 82-90. https://www.researchgate.net/publication/275211165_Traditional_Saliency_Reloaded_A_Good_Old_Model_in_New_Shape

(  0) 0)

|

| [13] |

OHASHI T, AGHBARI Z, MAKINOUCHI A. Hill-climbing algorithm for efficient color-based image segmentation[C]//International Conference on Signal Processing, Pattern Recognition, and Applications. ACTA, 2003: 17-22.

(  0) 0)

|

| [14] |

钱堃, 马旭东, 戴先中, 等. 基于显著场景Bayesian Surprise的移动机器人自然路标检测[J]. 模式识别与人工智能, 2013, 26(6): 571-576. QIAN Kun, MA Xudong, DAI Xianzhong, et al. Natural landmark detection of mobile robots based on bayesian surprise of salient scenes[J]. Pattern recognition and artificial intelligence, 2013, 26(6): 571-576. DOI:10.3969/j.issn.1003-6059.2013.06.008 (  0) 0)

|

| [15] |

MONTEMERLO M, THRUN S. FastSLAM:a scalable method for the simultaneous localization and mapping problem in robotics[M]. Berlin: Springer, 2007: 63-90.

(  0) 0)

|

| [16] |

MUR-ARTAL R, MONTIEL J M M, TARDÓS J D. ORB-SLAM:a versatile and accurate monocular slam system[J]. IEEE transactions on robotics, 2015, 31(5): 1147-1163. DOI:10.1109/TRO.2015.2463671 (  0) 0)

|

2019, Vol. 40

2019, Vol. 40