多数据集学习(multi-block learning)是指算法在处理分类、聚类等机器学习问题时所涉及的数据集不止一个。其核心在于算法可以挖掘数据集之间潜在的"相关性"。例如,在脑科学中的功能磁共振成像(functional magnetic resonance imaging, fMRI)图像与外界激励信号[1]、在社交数据分析中的多重关系学习(multi-relational learning)与推荐系统[2-3],以及多摄像头视频处理等[4]。由于单数据集方法无法利用数据集之间的共同信息,因此越来越多的学者关注多数据集算法,特别是如何从多个数据集中提取共同特征与个体特征。

对多数据集早期的研究可以追溯到典型相关分析(canonical correlation analysis,CCA)与偏最小二乘(partial least square, PLS)。然而这些算法只能同时处理两个数据集。为了克服该缺点,关于多数据的CCA与PLS的研究成果被提出[5-9]。这些算法虽然可以同时处理多个数据集,但是数据集之间只能以简单的结构共享信息,这限制了算法在实际中的应用。近年来,学者们在社交数据分析和图像处理等领域发表了关于多数据集特征提取的算法[10-13],这些算法在解决特定问题上得到了较好的性能但是其附加约束限制了算法的应用范围。

相比于传统的单数据集特征提取问题,本文将多数据集特征提取需要解决的关键问题总结为以下三点:1)不同数据集的概率分布可能是不同的;2)数据集之间的相关性结构是复杂多样的;3)数据集共享特征的方法多样。有些特征存在于全部数据集中、有些共同特征存在于部分数据集中,而有些特征仅存在于一个数据集中。

1 多数据集联合特征提取数学建模为了解决多数据集联合特征提取困难的问题,本文提出一种新的多数据集特征提取算法。本算法利用张量的广义并行因子(candecomp/parafac,CP)分解拟合每个数据集。对任意数据集Xk, k=1, 2,…, K,模型将数据集分解为

| $ {\mathit{\boldsymbol{X}}_k} \approx {f_k}\left( {\left[ {\left[ {{\mathit{\boldsymbol{U}}_{\left\{ {i \in {I_k}} \right\}}}} \right]} \right]} \right) $ | (1) |

式中:Ik表示属于Xk的角标集,U{i∈Ik}表示潜在矩阵集{Ui|i∈Ik},fk:R→R表示作用在每一个元素上的非线性映射,[[·]]表示kruskal乘积[14]。由式(1)可以看出,每一个数据集Xk被建模成张量并分解为若干潜在特征矩阵U{i∈Ik}的kruskal乘积。在多数据集学习中,模型通过共享潜在矩阵的方式共享信息,即若两个数据集Xi与Xj存在共同特征,则满足Ii∩Ij≠Ø。

1.1 广义多线性模型多数据集学习的关键问题之一是不同数据集的样本可能服从不同的概率分布。由于传统的矩阵/张量分解算法假设全部数据集服从相同的概率分布,因此利用传统方法拟合异构多数据集时拟合误差变大。为了同时有效拟合异构的多个数据集,本模型扩展了广义线性模型(generalized linear model, GLM)到异构的多张量数据集中。不失一般性,假设一个三阶张量X∈RI×J×K以及它的潜在重构张量Z∈RI×J×K。定义X与Z之间的Bregman散度为

| $ \begin{array}{*{20}{c}} {{B_F}\left( {\mathit{\boldsymbol{Z}}\left\| \mathit{\boldsymbol{X}} \right.} \right) = }\\ {\sum\limits_{i = 1}^I {\sum\limits_{j = 1}^J {\sum\limits_{k = 1}^K {{F_{i,j,k}}\left( {{\mathit{\boldsymbol{z}}_{i,j,k}}} \right) + F_{i,j,k}^ * \left( {{\mathit{\boldsymbol{x}}_{i,j,k}}} \right) - {\mathit{\boldsymbol{z}}_{i,j,k}}{\mathit{\boldsymbol{x}}_{i,j,k}}} } } } \end{array} $ | (2) |

式中:Fi, j, k:R→R表示非线性映射,Fi, j, k*:R→R表示Fi, j, k的凸共轭,即

| 表 1 不同概率分布下非线性变换的表达式 Tab.1 Various functions Fijk for four members of the exponential family |

多数据集学习的关键问题之一是其复杂的相关结构。这里的相关结构是指数据集之间在各自模式上共享信息的一种拓扑结构。现有算法中JIVE[15]、LCPTD[16],只考虑了数据集之间特定的相关结构,并没有给出描述数据集之间相关结构的数学模型。因此,本文利用超图理论提出一种新的多数据相关结构描述方法。首先给出模型中节点与边的定义:节点(node)表示个体数据集Xk, k=1, 2, …, K;边(edge)表示潜在矩阵Ui, i=1, 2, …, I。

与传统图模型相比,超图模型的一个边可以连接多于两个节点。这种"连接"正好可以用来描述多数据集之间共享信息的方式。对于给定结构,可以用关系矩阵A∈RK×I描述。其中,K表示数据集的个数,I表示潜在矩阵的个数,A中任意元素ak, i服从

| $ {a_{k,i}} = \left\{ \begin{array}{l} 1,\;\;\;i \in {I_k}\\ 0,\;\;\;其他 \end{array} \right. $ | (3) |

举例说明,假设有三个矩阵并且它们均在模式1(行模式)具有共同潜在特征。则对应的关系矩阵可以表示为

| $ \mathit{\boldsymbol{A}} = \left[ {\begin{array}{*{20}{c}} 1&1&0&0\\ 1&0&1&0\\ 1&0&0&1 \end{array}} \right] $ | (4) |

由式(4)可以看出,数据集个数等于3,潜在矩阵个数等于4。并且数据集之间共享第一个潜在矩阵U1。若将关系矩阵A按行求和,可以得到不同数据集的模式数。该例的示意图与超图描述如图 1所示。由图 1可以看出,全部数据集X1, X2, …, X3被分解成潜在矩阵乘积的形式。并且全部数据沿模式1集共享潜在矩阵U1。根据其超图表示也可知,矩阵(边)U1连接了全部数据集(节点)。因此,矩阵(边)U1反映了数据集(节点)X1, X2, …, X3的共同信息。

|

Download:

|

| 图 1 多数据集共同特征提取示意图与超图 Fig. 1 A graphical representation of a group of datasets | |

由图 1所示,所有的数据集被假设为沿模式1共享相同的潜在矩阵。该矩阵的每一列作为潜在特征包含于全部数据集之中。然而在大多数实际数据中,不同数据集之间只共享部分特征,或者只有部分数据集共享特征。因此需要将共同特征细分为全局共同特征与局部共同特征。对全局与局部共同特征的定义首次出现在文献[17]中。该文献利用分层提取的方法实现共同特征的分类。然而该方法的计算复杂度随数据集的数量呈指数增长。因此,为了降低复杂度,本文通过引入辅助模式提出了一种新的潜在特征分类方法。该方法可以将提取的特征自动划分为全局共同特征、局部共同特征,和个体特征。

假设一个三阶张量X∈RI×J×K,引入辅助模式后被建模成一个四阶张量X∈RI×J×K×1。因此对该张量进行4阶CP分解时可以得到

| $ \mathit{\boldsymbol{X}} \approx \left[ {\left[ {{\mathit{\boldsymbol{U}}_1},{\mathit{\boldsymbol{U}}_2},{\mathit{\boldsymbol{U}}_3},{\mathit{\boldsymbol{U}}_4}} \right]} \right] = \sum\limits_i {{u_{4,i}}\left[ {\left[ {{\mathit{\boldsymbol{U}}_{1,i}},{\mathit{\boldsymbol{U}}_{2,i}},{\mathit{\boldsymbol{U}}_{3,i}}} \right]} \right]} $ | (5) |

式中:U4为向量,u4, i表示U4的第i个元素,Uk, i, k=1, 2, …, 3表示矩阵Uk的第i列。由式(5)可知,引入辅助模式等价于引入了向量U4。并且U4可以被看作是其余模式上潜在特征的权值。因此,U4取值的大小决定了数据集是否包含了该特征。在多数据集特征提取中,多个数据集可能包含相同的潜在矩阵。但如果这些数据集都被各自引入辅助模式,不同的数据集则可以在共同潜在矩阵中选择若干列作为自己的特征。进而实现了全局共同特征、局部共同特征,和个体特征的选取。

为了有效分类特征,通常希望由辅助模式引入的权值向量具有稀疏性。因此,在进行张量分解时最直接的方法是引入对权值向量的L1范数正则化。然而需要指出,L1范数的不光滑性会导致分解计算困难。为了得到一种更加光滑的稀疏性正则化方法,本文利用张量CP分解的特点进一步引入额外的辅助模式,并且对权值向量进行L2范数正则化。此时,式(5)可以修改为

| $ \begin{array}{*{20}{c}} {\mathit{\boldsymbol{X}} \approx \left[ {\left[ {{\mathit{\boldsymbol{U}}_1},{\mathit{\boldsymbol{U}}_2},{\mathit{\boldsymbol{U}}_3},{\mathit{\boldsymbol{U}}_4},{\mathit{\boldsymbol{U}}_5}} \right]} \right] = }\\ {\sum\limits_i {{u_{4,i}}{u_{5,i}}\left[ {\left[ {{\mathit{\boldsymbol{U}}_{1,i}},{\mathit{\boldsymbol{U}}_{2,i}},{\mathit{\boldsymbol{U}}_{3,i}}} \right]} \right]} } \end{array} $ | (6) |

式中:U4、U5为引入的权值向量。由机器学习基本理论可知,L2范数正则化等价于对变量引入高斯分布的先验知识。假设u4, i、u5, i、∀i是相互独立的高斯分布随机变量,其均值为零,方差分别为σ12和σ22。则其乘积wi=u4, iu5, i, ∀i的概率分布为

| $ p\left( {{w_i}} \right) = \frac{{{{\rm{K}}_0}\left( {\frac{{\left| {{w_i}} \right|}}{{{\sigma _1}{\sigma _2}}}} \right)}}{{{\rm{ \mathsf{ π} }}{\sigma _1}{\sigma _2}}} $ | (7) |

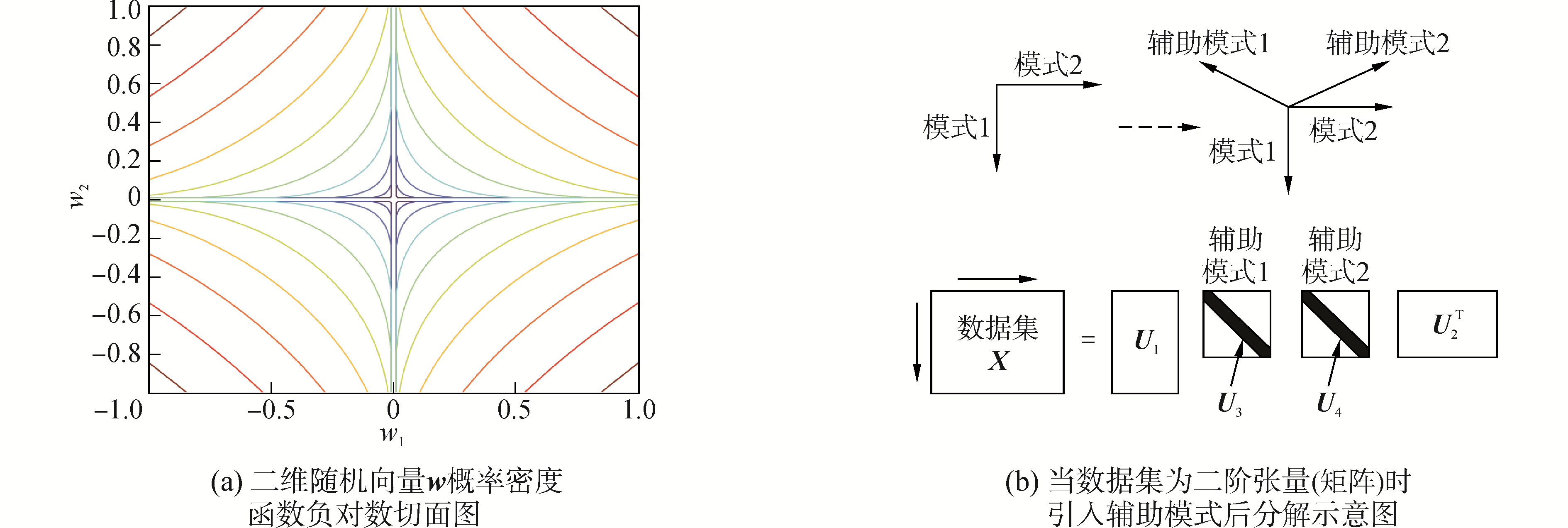

式中:K0(·)为第二类修正贝塞尔函数,并且w=[w1, w2, …, wR]的元素之间相互独立。图 2给出了数据集引入辅助模式后的分解示意图,以及当w为二维向量且σ12=σ22时其概率密度函数的切面图。由图 2可知,w的分布结构类似于桥正则化(bridge regularization)[18],概率密度函数p(wi)主要集中在零值附近。这使得算法在训练过程中w倾向于选择零值,进而获得稀疏的结果。然而需要指出,这种新的正则化方法也具有和桥正则化一样的缺点,即其表达式是非凸的。这导致基于凸优化的学习算法可能收敛到局部极值点。

|

Download:

|

| 图 2 辅助模式与高斯正则化 Fig. 2 Auxiliary modes and Gaussian regularization | |

利用前文介绍的基本框架,提出一种新的多数据集特征提取方法,并称该方法为广义多线性混合效应模型(generalized multi-linear mixed effects model, GMMM)。假设有K个数据集,I个潜在矩阵,数据集的IM矩阵为A∈RK×I。则多数据集的全局共同特征、局部共同特征,和个体特征可以通过求解以下函数极值得到

| $ \begin{array}{*{20}{c}} {L\left( {{\mathit{\boldsymbol{U}}_1},{\mathit{\boldsymbol{U}}_2}, \cdots ,{\mathit{\boldsymbol{U}}_I}} \right) = }\\ {\sum\limits_{k = 1}^K {{B_{{F_k}}}\left( {\left[ {\left[ {{\mathit{\boldsymbol{U}}_{\left\{ {i \in {I_k}} \right\}}}} \right]} \right]\left\| {{\mathit{\boldsymbol{X}}_k}} \right.} \right)} + \sum\limits_{i = 1}^I {{\lambda _i}{P_i}\left( {{\mathit{\boldsymbol{U}}_i}} \right)} } \end{array} $ | (8) |

式中:BFk(·‖·), k=1, 2, …, K为式(2)给出的Bregman散度。Ik表示Ui属于Xk的角标集,其取值可以通过Matlab运算Ik=find(A(k, :)=1)得到。Pi(·)与λi分别表示正则化项和对应的调节参数,其中,i=1, 2, …, I。一般潜在矩阵的正则化表达式可以依据先验知识确定;由辅助模式引入的权值向量的正则化表达式选择2节介绍的L2范数。在式(8)中,算法通过选择不同的非线性变换Fk(·), k=1, 2, …, K拟合不同概率分布的数据集;通过由IM矩阵计算出的角标集Ik实现复杂相关结构下潜在特征的共享;通过对辅助模式引入的权值向量进行L2范数正则化实现全局、局部以及个体特征的分类。

为了搜索函数(8)的极值,函数对潜在矩阵Ui的梯度表示为

| $ \begin{array}{*{20}{c}} {\nabla {L_{{U_i}}} = \sum\nolimits_{k,s.t.{a_{k,i}} = 1} {\left[ {\left( {{{\dot F}_k}\left( {\left[ {\left[ {{\mathit{\boldsymbol{U}}_{\left\{ {k \in {I_k}} \right\}}}} \right]} \right]} \right) - } \right.} \right.} }\\ {{{\left. {\left. {{\mathit{\boldsymbol{X}}_k}} \right) \otimes {\mathit{\boldsymbol{W}}_k}} \right]}_{\left( {\sum\limits_{j = 1}^i {{a_{k,j}}} } \right)}} \cdot \left[ {\mathop \odot \limits_{l \in {I_k},l \ne i} {\mathit{\boldsymbol{U}}_l}} \right] + {\lambda _i}{{\dot P}_i}\left( {{\mathit{\boldsymbol{U}}_i}} \right),\forall i} \end{array} $ | (9) |

式中:[·](i), ∀i表示将张量沿第i个模式进行矩阵化。

利用梯度式(9),任意基于梯度的优化算法均可以用来搜索目标函数式(8)的极小值。由文献[20]可知,共轭梯度法(conjugated gradient, CG)和拟牛顿的L-BFGS算法通常可以在张量CP分解中获得更快的收敛速度。因此本文在数值仿真实验中类比文献[20]也采用CG与L-BFGS算法实现目标函数(8)的求解,而算法细节不在文中赘述。

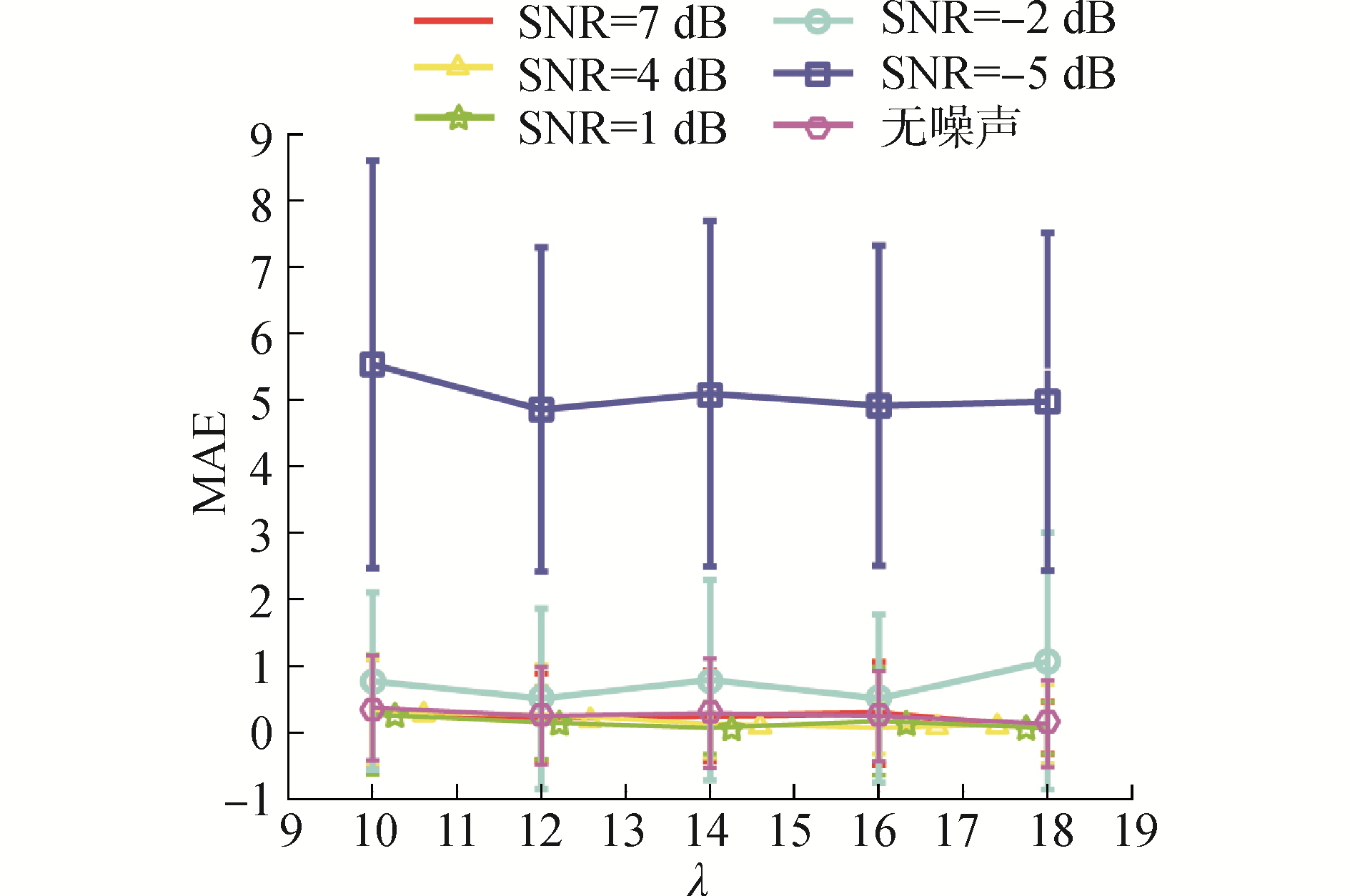

4 数值仿真与实验 4.1 语音信号特征分析仿真从"ICALAB"工具箱提供的"25speakersHALO.mat"文件中选取25段音频样本作为原始特征。每个样本的维度等于1 000,并且进行了移除均值、归一化方差处理。这些特征中,任意选择3段音频样本作为全局共同特征,9段音频作为局部共同特征,以及其余的12段音频作为个体特征,并利用这些特征与随机正交矩阵相乘产生三个矩阵作为数据集。产生的数据集按照图 1所示沿模式1共享特征,并引入一定信噪比SNR的高斯白噪声作为干扰。仿真中算法设置如下:对每一个数据集引入两个辅助模式,并对所有潜在矩阵进行L2范数正则化;假设数据服从高斯分布,并根据表 1选择相应的非线性变换;设置算法初始CP秩等于25;利用仿真确定最优的参数λi, i=1, 2, …, I。仿真利用估计出的全局、局部,以及个体特征个数的平均绝对误差(mean absolute error, MAE)以及准确度(percentage of accuracy, PA)作为性能指标。这些指标均由独立10次重复实验平均所得。表 2给出了不同信噪比下MAE和PA的仿真结果。由表 2可知,当信噪比大于0 dB时算法可以正确估计出多数据集中全局共同特征、局部共同特征,和个体特征的个数。需要指出,在无噪声条件下算法仍可能错误估计出特征个数。这是因为目标函数(8)并不是一个凸函数。因此,基于凸优化的算法可能收敛到局部极值点。该问题可以通过选择初始值或多次计算缓解。图 3给出了MAE随λ变化曲线。由图 3可知,算法在不同λ取值下性能稳定。

|

Download:

|

| 图 3 不同信噪比下MAE随λ变化曲线 Fig. 3 Comparison of MAE with different values of λ | |

| 表 2 特征提取不同信噪比下算法MAE与PA性能 Tab.2 MAE and PA of feature extraction with different SNR |

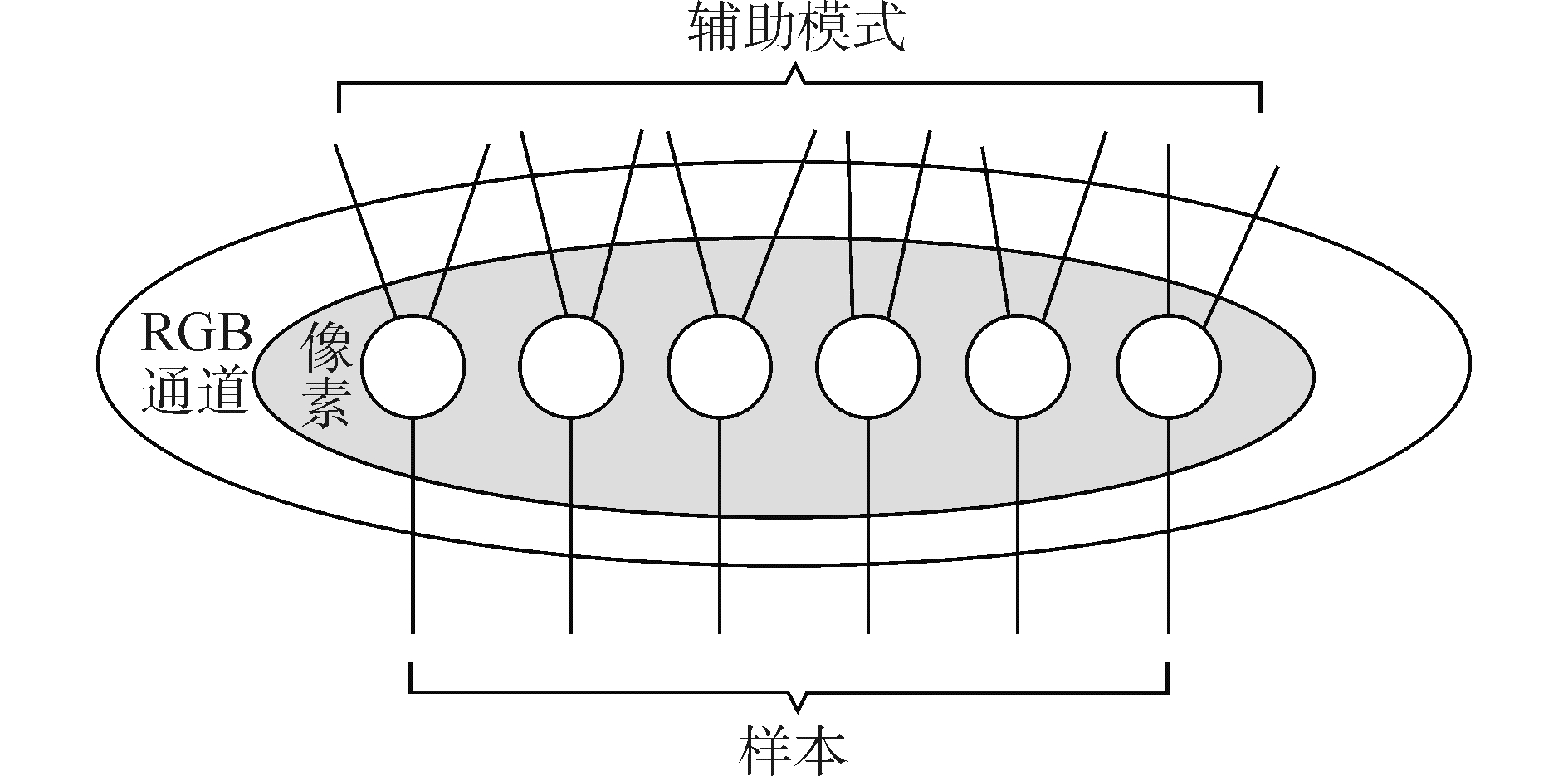

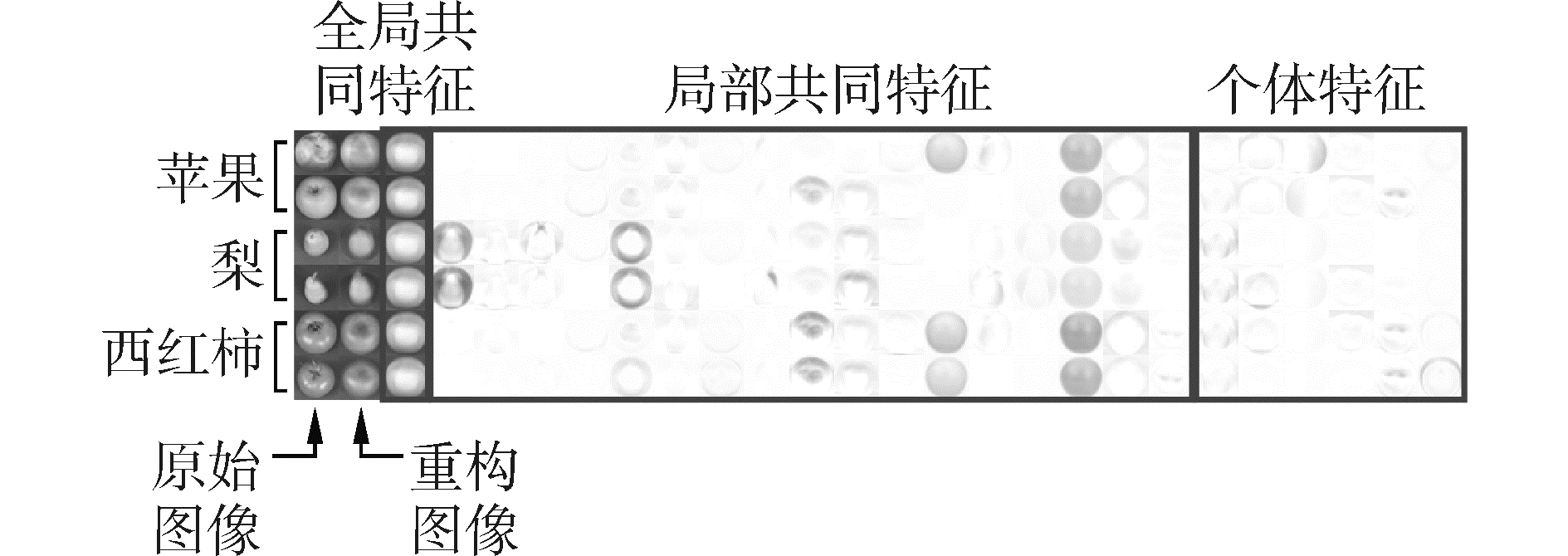

本节通过图像特征提取验证GMMM算法有效性。第一个实验选择ETH-80数据库,并从该数据库中选择6组水果图像作为样本。这6组图像分别是2组苹果、2组梨和2组西红柿。算法将每一个数据集建模成一个三阶张量(像素(1 024)×RGB通道(3)×样本(41))。实验希望6组数据集具有全局共同特征,相同水果的数据集具有局部共同特征。数据集间相关性图模型如图 4所示。算法配置如下:λ=1,初始秩R=30,数据分布假设为泊松分布。实验结果如图 5所示。通过数据学习,GMMM在6组数据集中得到1个全局共同特征、17个局部共同特征,以及6个个体特征。由图 5可知,被提取的全局共同特征反映了6组图像的蓝色背景信息;局部共同特征反映了相同水果的轮廓和形状等信息;而个体特征反映了不同水果的纹路等细节信息。

|

Download:

|

| 图 4 数据集相关图模型 Fig. 4 Graph model of dependence of datasets | |

|

Download:

|

| 图 5 多数据集特征提取结果 Fig. 5 Results of feature extraction for multi-datasets | |

第二个实验选择JAFFE数据库中的若干图像作为学习样本。本实验选择来自同一女性不同表情的4幅图像。GMMM算法参数设置如下:每1幅图像建模成一个矩阵,并假设服从泊松分布;选择λ=0.84,初始秩R=50;4幅图像沿矩阵的两个轴共享特征,并为每幅图像引入两个辅助模式。作为对比,本实验将4幅图像建模成一个3阶张量,利用相同秩的非负张量分解(non-negative tensor factorization, NTF)[21]提取共同特征。实验结果如图 6所示。由图 6可以看出,在相同秩的条件下GMMM不仅可以更好的拟合数据,并且提取出的全局、局部和个体特征具有一定物理含义。例如,GMMM提取出的全局共同特征反映了4幅图像中女性的发型信息,而局部共同特征反映了五官的信息。然而利用NTF算法提取出的特征并不具有可解释的物理意义。

|

Download:

|

| 图 6 GMMM与NTF算法特征值提取性能比较 Fig. 6 Performance comparison for feature extraction between GMMM and NTF | |

由以上实验结果可知,GMMM可以有效地从多个数据集中提取出全局、局部共同特征和个体特征。并且这些特征通常反映了数据集间共享和独有的信息。

4.3 人脸识别人脸识别是机器学习领域的经典问题。因此,本小节将GMMM作为特征提取方法应用到人脸识别中。实验选择扩展的耶鲁脸B(extended Yale face database B)数据库作为样本。实验前,首先将所有图像裁剪到32×32像素,将每一幅图像映射成向量,并将全部样本按给定大小随机划分成训练与测试样本。在GMMM中,不同类别的训练样本被定义成多个数据集,并将提取出的个体特征作为投影子空间的一组基向量。在识别中,测试样本将向该特征空间进行投影,并将投影结果导入训练好的分类器进行识别。

作为对比,实验选择了主成分分析(principal component analysis, PCA)、局部保留投影(locality preserving projection, LPP)[22]进行特征提取,并利用k邻近(k-nearest neighbors, KNN)算法作为分类器(k=5)。GMMM使用10折交叉验证确定参数λ,其他算法通过性能比较得到最优参数设置。表 3给出了10次独立重复实验下不同算法的识别错误概率。由表 3可知,利用GMMM算法进行特征提取不仅识别准确度高于其他算法,并且需要的特征维度也低于其他算法。这说明GMMM提取出的个体特征反映了不同类别的核心信息。

| 表 3 不同训练样本下人脸识别错误概率性能比较 Tab.3 Comparison of error rate of facial recognition with different size of training samples |

推荐系统是典型的多数据集学习问题。其目的是利用已有数据对用户的偏好或选择进行预测。从机器学习的角度分析,推荐系统的核心是数据修复问题。本实验将利用GMMM对MovieLen-100k数据中的用户评分数据进行预测。MovieLen-100k不仅包含了943个用户对1 682个电影的100 000条评分记录(1~5分),而且包含了用户和电影的简单信息,例如用户年龄、性别、职业,电影标题、日期,和类型等。实验中,GMMM将这些数据建模成三个矩阵数据集,分别是用户电影(user-movie, UM)矩阵、电影类型(movie-genre,MG)矩阵,和用户属性(user-profile,UP)矩阵。同时假设UM矩阵中的元素服从二项分布;其余两个矩阵中的元素服从伯努利分布。并且,在实验中等概率随机移除UM矩阵中的若干元素作为测试样本。为比较性能,实验同时利用Fast MMMF[23]和CMF[24]算法预测数据。GMMM算法的参数配置如下:模型初始秩R=30;各个潜在矩阵的正则化参数λ=[28, 28, 28, 2, 2, 2, 2];数据集间的IM矩阵定义为为

| $ \mathit{\boldsymbol{A}} = \left[ {\begin{array}{*{20}{c}} 1&1&1&0&0&0&0\\ 1&0&0&1&1&0&0\\ 0&1&0&0&0&1&1 \end{array}} \right] $ | (10) |

Fast MMMF和CMF算法的参数由10折交叉验证得出。实验通过10次独立重复实验并计算预测数据与实际数据的MAE进行性能评价。表 4给出了在不同训练集大小条件下各个算法的MAE性能比较。由表 4可知,GMMM在不同训练集大小条件下MAE指标均好于Fast MMMF和CMF算法。其原因在于Fast MMMF和CMF算法仅假设多数据集之间共享潜在特征。而GMMM算法进一步将共享的潜在特征细分为全局、局部共同特征和个体特征。这种结构的引入帮助每个数据集计算出更为合适的特征并正确的预测出结果。

| 表 4 不同训练集大小下各算法MAE性能比较 Tab.4 MAE of rating prediction with different missing percentage |

1) 相比于传统方法,本文模型将广义线性模型引入高阶张量,并且利用超图模型以及辅助模态解决了特征分类等问题。

2) 算法提取的全局、局部共同特征和个体特征不仅可以正确反映数据集之间共享和独占的信息,并且相比于传统算法,本文算法可以提高人脸识别和推荐系统问题分类和预测的准确度。

| [1] |

MITCHELL T M, SHINKAREVA S V, CARLSON A, et al. Predicting human brain activity associated with the meaning of nouns[J]. Science, 2008, 320(5880): 1191-1195. DOI:10.1126/science.1152876 (  0) 0)

|

| [2] |

NICKEL M. Tensor factorization for relational learning[D]. München: LMU München, 2013.

(  0) 0)

|

| [3] |

NICKEL M, TRESP V, KRIEGEL H P. A three-way model for collective learning on multi-relational data[C]//Proceedings of the 28th International Conference on Machine Learning. Bellevue, Washington, USA, 2011: 809-816.

(  0) 0)

|

| [4] |

CHEN C Y, GRAUMAN K. Inferring unseen views of people[C]//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA, 2014: 2011-2018.

(  0) 0)

|

| [5] |

CORREA N M, ADALI T, LI Yiou, et al. Canonical correlation analysis for data fusion and group inferences[J]. IEEE signal processing magazine, 2010, 27(4): 39-50. DOI:10.1109/MSP.2010.936725 (  0) 0)

|

| [6] |

KARHUNEN J, HAO Tele, YLIPAAVALNIEMI J. Finding dependent and independent components from related data sets:a generalized canonical correlation analysis based method[J]. Neurocomputing, 2013, 113: 153-167. DOI:10.1016/j.neucom.2013.01.018 (  0) 0)

|

| [7] |

VÍA J, SANTAMARÍA I, PÉREZ J. A learning algorithm for adaptive canonical correlation analysis of several data sets[J]. Neural networks, 2007, 20(1): 139-152. (  0) 0)

|

| [8] |

ZHANG Xiao, LIAO Shizhong. Tensor completion via multi-shared-modes canonical correlation analysis[J]. Neurocomputing, 2016, 205: 106-115. DOI:10.1016/j.neucom.2016.05.001 (  0) 0)

|

| [9] |

LÖFSTEDT T, TRYGG J. OnPLS-a novel multiblock method for the modelling of predictive and orthogonal variation[J]. Journal of chemometrics, 2011, 25(8): 441-455. (  0) 0)

|

| [10] |

马建阳, 张宝鹏. 基于多任务学习的多源数据分类研究[J]. 计算机应用研究, 2018, 35(11). MA Jianyang, ZHANG Baopeng. Research of classification method for multi-source data based on multi-task learning[J]. Application research of computers, 2018, 35(11). (  0) 0)

|

| [11] |

ZHANG Xiao, HU Qinghua, LIAO Shizhong. Multi-tensor completion with shared factors from multiple sources[J]. Scientia sinica informationis, 2016, 46(7): 819-833. (  0) 0)

|

| [12] |

SINGH A P, GORDON G J. Relational learning via collective matrix factorization[C]//Proceedings of the 14th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. Las Vegas, Nevada, USA, 2008: 650-658.

(  0) 0)

|

| [13] |

LI Chao, ZHAO Qibin, LI Junhua et al. Multi-tensor completion with common structures[C]//Proceedings of the 29th AAAI Conference on Artificial Intelligence. Austin, Texas, 2015: 2743-2749.

(  0) 0)

|

| [14] |

LI Chao, GUO Lili, CICHOCKI A. Multi-tensor completion for estimating missing values in video data[C]//Proceedings of 2014 Joint 7th International Conference on Soft Computing and Intelligent Systems (SCIS) and 15th International Symposium on Advanced Intelligent Systems. Kitakyushu, Japan, 2014: 1339-1342.

(  0) 0)

|

| [15] |

KRUSKAL J B. Three-way arrays:rank and uniqueness of trilinear decompositions, with application to arithmetic complexity and statistics[J]. Linear algebra and its applications, 1977, 18(2): 95-138. DOI:10.1016/0024-3795(77)90069-6 (  0) 0)

|

| [16] |

LOCK E F, HOADLEY K A, MARRONM J S, et al. Joint and individual variation explained (JIVE) for integrated analysis of multiple data types[J]. The annals of applied statistics, 2013, 7(1): 523-542. DOI:10.1214/12-AOAS597 (  0) 0)

|

| [17] |

YOKOTA T, CICHOCKI A, YAMASHITA Y. Linked PARAFAC/CP tensor decomposition and its fast implementation for multi-block tensor analysis[C]//Proceedings of the 19th International Conference on Neural Information Processing. Doha, Qatar, German, 2012: 84-91.

(  0) 0)

|

| [18] |

LÖFSTEDT T, HOFFMAN D, TRYGG J. Global, local and unique decompositions in OnPLS for multiblock data analysis[J]. Analytica chimica acta, 2013, 791: 13-24. DOI:10.1016/j.aca.2013.06.026 (  0) 0)

|

| [19] |

FU W J. Penalized regressions:the bridge versus the lasso[J]. Journal of computational and graphical statistics, 1998, 7(3): 397-416. (  0) 0)

|

| [20] |

ZHAO Qibin, ZHANG Liqing, CICHOCKI A. Bayesian CP factorization of incomplete tensors with automatic rank determination[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(9): 1751-1763. DOI:10.1109/TPAMI.2015.2392756 (  0) 0)

|

| [21] |

ACAR E, DUNLAVY D M, KOLDA T G. A scalable optimization approach for fitting canonical tensor decompositions[J]. Journal of chemometrics, 2011, 25(2): 67-86. DOI:10.1002/cem.v25.2 (  0) 0)

|

| [22] |

CICHOCKI A, ZDUNEK R, PHAN A H, et al. Nonnegative matrix and tensor factorizations:applications to exploratory multi-way data analysis and blind source separation[M]. Chicherter: John Wiley & Sons, 2009: 450-455.

(  0) 0)

|

| [23] |

HE Xiaofei, NIYOGI P. Locality preserving projections[C]//Proceedings of Neural Information Processing Systems 16. Vancouver, Canada, 2003, 16: 153-161.

(  0) 0)

|

| [24] |

RENNIE J D M, SREBRO N. Fast maximum margin matrix factorization for collaborative prediction[C]//Proceedings of the 22nd International Conference on Machine Learning. Bonn, Germany, 2005: 713-719.

(  0) 0)

|

2018, Vol. 39

2018, Vol. 39