——

在历经数次浮沉之后,人工智能(Artificial Intelligence,AI)技术正经历一场传播狂潮,并对社会生活各方面产生深刻的影响。随着技术的不断发展成熟,人工智能技术或以替代或以辅助的形式,已经参与到了人类的决策过程当中,并被广泛应用于提高不同行业的决策质量。在私营部门不断取得的显著效益等多方面因素的共同作用下,政府部门正开始加速采用此技术,并探索将其应用到公共决策当中。如美国多个州的法院使用算法系统对罪犯进行风险评估,以估计累犯风险、支持保释和判决;英国的“智能高速公路”结合人工智能、大数据以及传感器等,对道路交通流量进行管理和预测;杭州的城市管理者通过“城市大脑”配置公共资源,做出科学决策,提高治理效能。

然而,关于使用人工智能技术进行管理决策,是存在争议的。这种争议主要集中在准确性、有效性和偏见等方面,而在强调合法性、公平性的公共决策中,这种争议更甚。在合法性方面,人工智能并不具备和人类相同的法律地位。因此,是否能赋予人工智能参与公共决策的权利,在法律上尚不明确。[1]在有效性方面,对于一些非常规的或较为复杂的公共决策,人类所特有的直觉和意识等特质往往发挥着更重要的作用。因此,在这些决策方面,人工智能技术做出的决策并不一定会比人类更好。[2]而从公平性方面来看,人工智能需要学习过去的数据、经验等,并在此基础之上进行新的决策,因此它有可能会强化或放大过去决策中存在的偏见,[3]从而导致公平性和歧视等问题。此外,责任鸿沟也是需要重点考虑的问题。如果使用人工智能进行公共决策造成了不良的社会后果,那么到底应由谁承担相应的责任。[4]

本文重点关注使用人工智能进行公共决策对公众信任的影响。文中的“信任”是指公众对人工智能参与公共决策的可靠性、有效性和安全性的心理预期。[5]人工智能参与制定决策被认为会影响到公众的信任,因为它通常是不透明的,可能会引入偏见。[6]本文预计,公众的信任程度可能取决于公共管理者和人工智能技术在决策中的参与情况,以及公共决策本身的特征。根据祖里迪斯(Zouridis)等人[7]以及纳格加尔(Nagtegaal)[8]的研究,人工智能参与公共决策的方式主要有三种:为人类提供支持;对人类进行赋能;完全取代人类。本文检验了这些不同决策方式对公众信任的影响,并假设公众的信任程度会因决策对象的类型而不同。具体而言,本文主要研究以下问题:在定量型和定性型两种不同类型的公共决策情形之下,公众对于人工智能参与公共决策的三种方式的信任是否存在显著的差异?如果存在差异,那么导致差异的原因又是什么?

人工智能参与公共决策,可能有悖于政府治理中的合法性、有效性以及公平性等基本准则和价值追求。本文探讨公众对于人工智能参与公共决策的信任问题,这对厘清人工智能在公共决策中的适用边界与范围,从而推动公共决策与社会治理的良性发展,具有重要的现实意义。近年来,实验法由于具备有效排除无关变量的显著优势,在公共管理学界引起了高度的重视,但是具体到本研究主题的相关研究中,实验法的应用还较为罕见。因此本文使用实验的方法对人工智能、信任等相关议题的研究,对于拓展相关领域的研究方法,也有一定的学术价值。

二、研究背景 1. 人工智能人工智能是一门综合了计算机科学、信息论、神经生理学、语言学、哲学等多种学科发展起来的交叉学科,是一个不断迅速扩展的技术研究领域。[9]由于其与高级统计分析的重叠以及不断发展的能力,目前学界尚未对其形成统一定义,[10]但本质上它是一种建立在机器学习、自然语言处理等多种技术基础上的计算机系统,具有智能化特征,并能以更灵活的方式为人类服务。[11]在决策制定过程中使用的人工智能技术,更确切来说应该指的是算法:“一种被应用到系统中的,用于在特定分析领域内分析任务的抽象数学结构”[12],或者是“一种基于统计模型或决策规则,在没有明确人工干预的情况下自动做出决策的数学公式”。[13]

2. 公共决策中人工智能的价值与应用已经有文献对人工智能在政府部门工作中的价值与影响进行了分析,主要包括降低成本、提高效率、减轻工作负担、提升服务质量等。具体到公共决策方面,人工智能技术的价值也是显而易见的。第一,人工智能有助于决策者快速全面获取、深度发掘分析与决策对象有关的所有信息,这将有助于提升公共部门宏观调控政策的精准性和针对性。[14]第二,人工智能与决策者的有机结合能有效地监管公共部门决策。运用自动化算法配合人工决策,可以显著减少服务处理中的欺诈和错误。[15]第三,人工智能可以支持公共部门汇总和分析社会公众的政策偏好和需求,以更好地理解政策措施将在什么情况下有效,并合理调配有限资源。[16]

在实际的公共决策实践中,已经有部分政府尝试使用人工智能技术。从广义上说,人工智能系统既可以用来支持或者帮助人类决策者,也可以取代他们。[17]具体而言,这些应用又可以分为三种情况:第一种情况,公共决策完全实现自动化,人工智能替代了公共管理者的角色。换句话说,技术是决定性的,管理者完全没有决策的权力。第二种情况,在决策的过程中,人工智能技术对公共管理者进行赋能或者增强,在决策的过程中对人类形成辅助,最终的决策仍然由人类作出。一个例子就是预测性警务。[18]第三种情况,人工智能技术作为对人类的支持,但实际在决策过程中并没有被使用。

3. 信 任信任代表的是对人工智能的可靠性、有效性和安全性等的一种信念。[5]对于人工智能技术而言,鉴于信任既是公众接受和使用它的重要因素,又是决定公众在多大程度上采纳它做出的决策的关键前因,[19]因此研究者对此给予了密切的关注。一方面,有研究分析了人工智能参与决策对于公众信任的影响,并指出人工智能技术在决策中存在的技术安全、隐私侵犯、公平性等问题,都会对公众信任产生显著影响。[2]另一方面,也有研究对电子商务、智能医疗等背景下,影响公众对人工智能技术的信任的因素进行了一定探讨。结果表明,人工智能技术本身的性能与特征,如可靠性[20]、智能性[21]、拟人性[22],是影响信任的关键前因。研究同时也发现,公众的相关知识与技能水平[23]、自身的创新性和开放性[24]等个体特质,也会影响到对人工智能技术的信任水平。

前人的研究,为理解人工智能参与公共决策对公众信任的影响,提供了有益借鉴,但不足之处同样值得重视。首先,公共管理领域缺乏对相关问题的定量探讨。虽然部分研究初步讨论了使用人工智能技术进行公共决策时的信任问题,但这些研究主要是从质性分析的角度进行探讨,对影响信任的因素以及相应作用机制的理解还不够深入。如果公众不信任有人工智能参与制定公共决策,很可能会影响到政府部门的治理效能,甚至进一步影响政府的合法性。[20]因此,进一步厘清这一问题十分必要。其次,缺乏对决策本身特征的关注。已有研究主要从人工智能的技术属性和公众自身的个体特质两个方面,探讨了影响公众对人工智能信任的因素,但是对于决策本身特征的关注还不足。实际上,任务本身的类型、复杂程度等特征,也可能会对公众信任产生影响。[25]

三、研究假设根据李敏京(Min Kyung Lee)的研究,可以把决策分为:(1)满足人工智能技术的IF-THEN类型规则体系,更多需要“机械”技能,如处理定量数据以进行客观测量或规则清晰的定量决策;(2)决策时更注重价值平衡和更具灵活性的,更多需要人类仍然占优势地位的技能如主观和直观判断、理解和情感表达以及浏览社会细微差别的定性决策。[13]相关研究指出,对于不同的公共决策类型,当由人工智能技术进行决策时,公众在信任程度方面会存在显著的差异。[26]

我们预期,对于定量型决策,公众会更倾向于信任人工智能参与制定决策。有研究认为,人工智能善于处理简单和重复性的任务,[27]擅长解决边界清晰、具有良好结构性(模块化或“可分解”)的问题,因而其提出的解决方案或制定的决策也具有标准化的特征。[28]Lee的研究指出,对于“量化”任务,如基于预测客户数量的工作安排,算法和人类被认为是同等公平的。[13]肯·帕里(Ken Parry)等人的研究也表明,在低复杂性决策方面,人工智能用可计算的标准实现了一些定量目标,制定的决策已经超越了人类。[29]据此,本文认为,对于规则清晰、主要涉及定量运算的公共决策,即涉及有限数量变量且相对无争议的量化任务,公众将倾向于信任由人工智能技术决策。在这些情况下,人工智能可以快速、准确地制定决策。这就引出了下面的假设:

假设1:对于定量型的公共决策,由人工智能制定的决策更可能获得公众信任。

在涉及更高程度的模糊性和不确定性的决策活动中,无法将决策过程简化为一个明确的目标函数来描述,这就需要决策制定者在决策过程中综合运用判断和直觉等能力,通盘考虑所有因素并做出更为复杂的判断。[30]显而易见,人类在这方面的优势更明显。[27]尽管实践中都是从技术角度提升人工智能的性能,但其抽象思维和界定问题的能力依然不如人类,因而应适当要求人工智能和人类在决策中进行分工。[28]类似的观点也得到了其它研究的印证,Lee认为,对于涉及情绪和人类交互的任务,人类决策者比人工智能更受青睐。[13]穆罕默德·侯赛因·贾拉希(Mohammad Hossein Jarrahi)也指出,解剖复杂社会系统迷宫的责任往往不在人工智能的能力范围内。[31]因此,人类在理解模糊决策情况下错综复杂的社会和政治动态方面继续享有比较优势,这为由人类进行决策提供了独特的位置。据此,我们预期,对于规则不明、涉及主观判断的公共决策,由人类进行决策将得到社会公众的更多支持。由此,我们提出:

假设2:对于定性型的公共决策,公众将更倾向于信任由人类决策制定者制定的决策。

四、研究方法与设计 1. 研究方法近年来,实验法因其控制无关变量的独特优势,受到了越来越多公共管理学者的追捧。对此,有研究认为,实验法的显著优势在于可以通过随机化的实验操纵排除无关变量干扰,从而观察到自变量对因变量的“净效应”。[32]因此,相较于其他研究方法,实验法被认为是探讨因果关系的最有效方法,是因果推论的黄金法则。[33]

从类型上看,实验可分为实验室实验、问卷(调查)实验、现场(田野)实验、自然实验和准实验等五类。[34]本研究中采用了第二种问卷实验。问卷实验作为一种科学、严谨的研究方法,主要是在实验设计中采用问卷调查的形式来呈现实验刺激材料,发现社会现象之间的因果联系,帮助学者探寻实验对象的本质。问卷实验同样包含实验设计的基本要素,即由研究者操控的外生性干预和对被试的随机化处理。[35]问卷实验通过向被试呈现不同的问卷版本进行实验操纵,被试随机得到一种版本的问卷并作答。和其它实验类型相比,问卷实验虽然对环境的控制较弱,但由于发放问卷具有简单易操作的突出优势,因而在公共管理实验研究中得到了广泛使用。[36]

2. 研究设计本研究建立在Lee[22]和Nagtegaal[8]的基础之上,但是将研究扩展到了公众对公共决策的信任方面。在研究中,本文进行了两项实验。实验1采用的是受试者间设计,并以3所学校公共管理学科的本科生为样本,探讨了公众对于由人工智能技术参与两种不同类型的公共决策的信任问题。实验2是作为实验1的复制而设计的,但使用了受试者内设计,这使本文能够评估在多种类型决策主体并列的情况下,公众对人工智能技术参与公共决策的信任情况是否会与实验1的结果不同。同时,实验2选用的是Credamo网络问卷平台的用户作为样本,因此能进一步对实验1中得出的结论进行检验,从而增强研究结论的外部效度。

本研究中设定的定量型和定性型公共决策分别是个人所得税计算和司法判定。个人所得税的计算是由法律决定的,相应的规则比较明确,因此主要涉及的是定量计算。而司法判定是一项较为复杂的公共决策实践,涉及到的因素众多,并且一定程度上还需要结合实际问题进行价值判断与分析,属于定性决策。

根据当前公共决策当中常见的三种决策制定主体,即人工智能技术、人工智能技术+公共管理者、公共管理者,以及定量决策和定性决策两种不同公共决策类型,实验1设计了一个随机分组3*2混合设计实验,并总共将形成3个实验组分别代表当前在公共决策当中的三种常见决策方式。[8]根据研究主题,我们的因变量是信任,使用直接测量的方式。如“你信任上述决定公众个人所得税的方式吗?”受访者可以在7分李克特量表上从1(“完全不信任”)到7(“完全信任”)中选择一个数字。最后,我们要求参与者在一个开放式问题中解释他们评分的原因。根据实验设计,最终测量得到6组信任值(Tr),如表1所示。实验结束后,对测量结果进行描述统计,检验独立样本T、配对样本T,进行定性分析等,检验与分析使用人工智能进行不同的公共决策,对于公众信任程度的影响。

| 表 1 双因素被试间实验设计 |

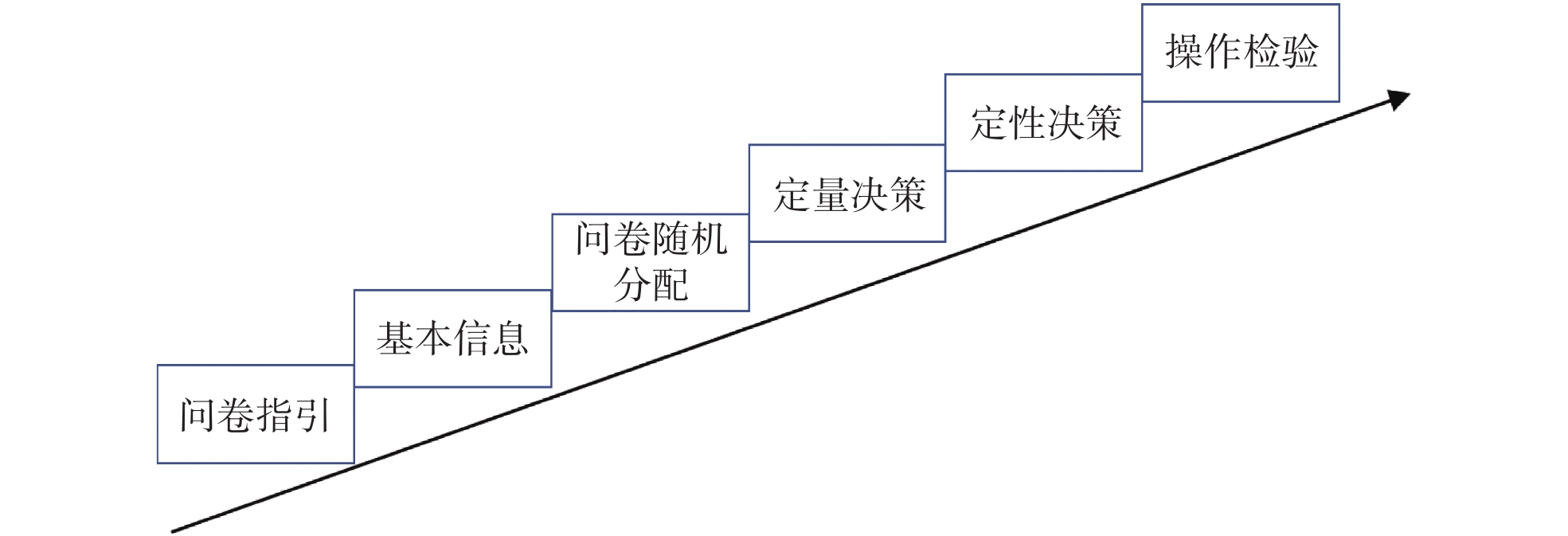

实验1中的被试为3所大学公共管理相关专业的本科生。他们随机得到三个版本问卷中的一个。参与调查的被试者首先被问及一些关于人工智能及其应用的相关问题,如是否了解人工智能、使用经历等。其次被要求根据实验设定的定量型公共决策场景,判定对不同决策主体所做的公共决策的信任程度并说明原因。再次,被要求在实验设定的定性型公共决策场景下,重复上述过程。最后,设计了检测题项“根据你阅读到的上述材料,是由( )决定个人所得税和进行司法判定?”,来检验被试是否真正接收到了上述实验干预信息。实验流程见图1。

|

1 实验1流程图 |

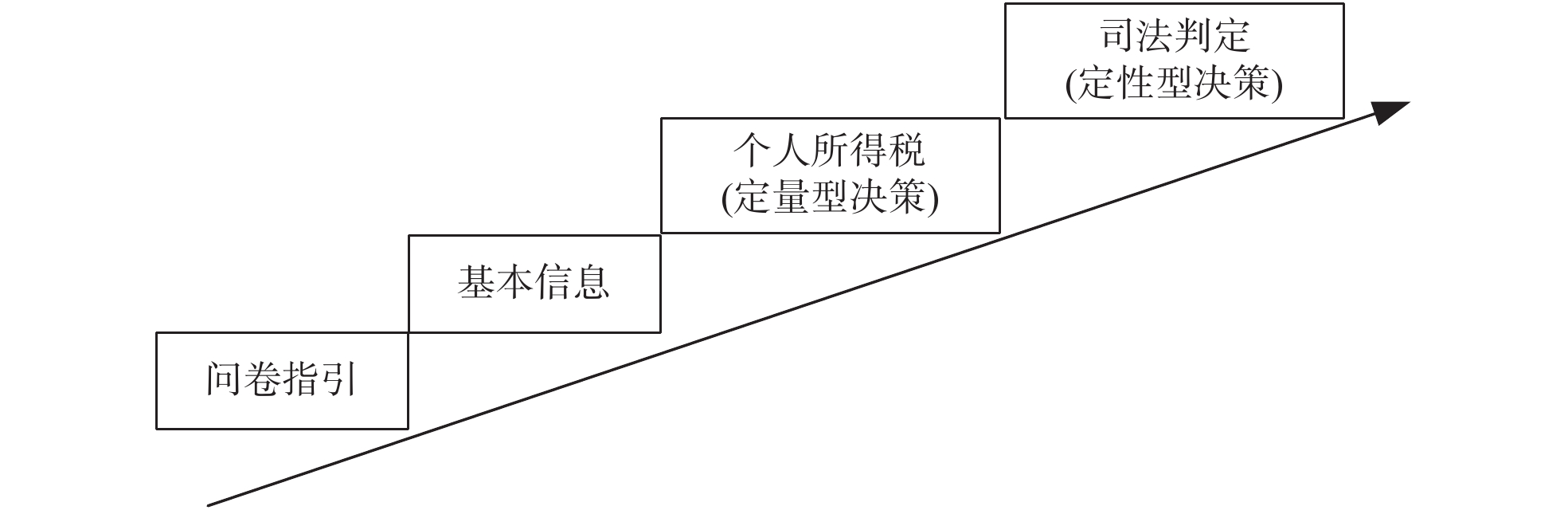

作为对实验1的重复和检验,本文进一步设计了实验2。在实验场景设定上,实验2中使用了和实验1相同的两种公共决策场景,以确保研究的严谨性。在研究设计上,实验2采用了将决策主体并列的方式,让被试对由3种不同决策制定主体(人工智能/人工智能+公共管理者/公共管理者)做出相同公共决策的信任程度,分别进行评分。具体的操作上,同样采用的是直接测量的方式,让被试在7分李克特量表上回答“你觉得你在多大程度上可以信任由下述方式来决定个人应缴纳的所得税/进行司法判决?”。实验2流程如下图2所示。此外,考虑到以大学生作为实验被试可能会存在样本的代表性问题,因此在实验2的被试选择上,本研究通过Credamo网络问卷平台选取了200名被试,以进一步对实验1的研究结论进行检验。

|

2 实验2流程图 |

为检验实验1中各实验组是否符合随机性要求,需要对各组被试的性别、对人工智能的了解程度、人工智能的关注度和使用体验等因素进行平衡检验(Balance Test)。数据分析结果显示,各实验组被试的上述因素,在0.05的水平上不存在显著差异。以上平衡检验结果表明,本实验对被试的抽样符合随机要求,具有良好的均衡性,能很好地避免系统误差。平衡检验结果见表2。

对于实验2,本研究统计了各被试的主要人口统计学因素如性别、年龄、受教育程度、年收入等,结果如下表3所示。

| 表 2 实验组平衡检验结果 |

| 表 3 受访者相关统计信息 |

在实验1中,本文以不同公共决策类型为主体内因素,以不同类型决策方式为主体间因素,使用SPSS 24.0的混合方差分析功能分析了不同公共决策类型与决策方式的交互作用,结果显示,二者的交互作用显著[F(2,137)=19.128,p=0.000<0.001]。上述结果表明,在不同的公共决策类型中,决策方式对公众信任的影响是不同的。我们通过两个独立的方差分析来解释这种效应。

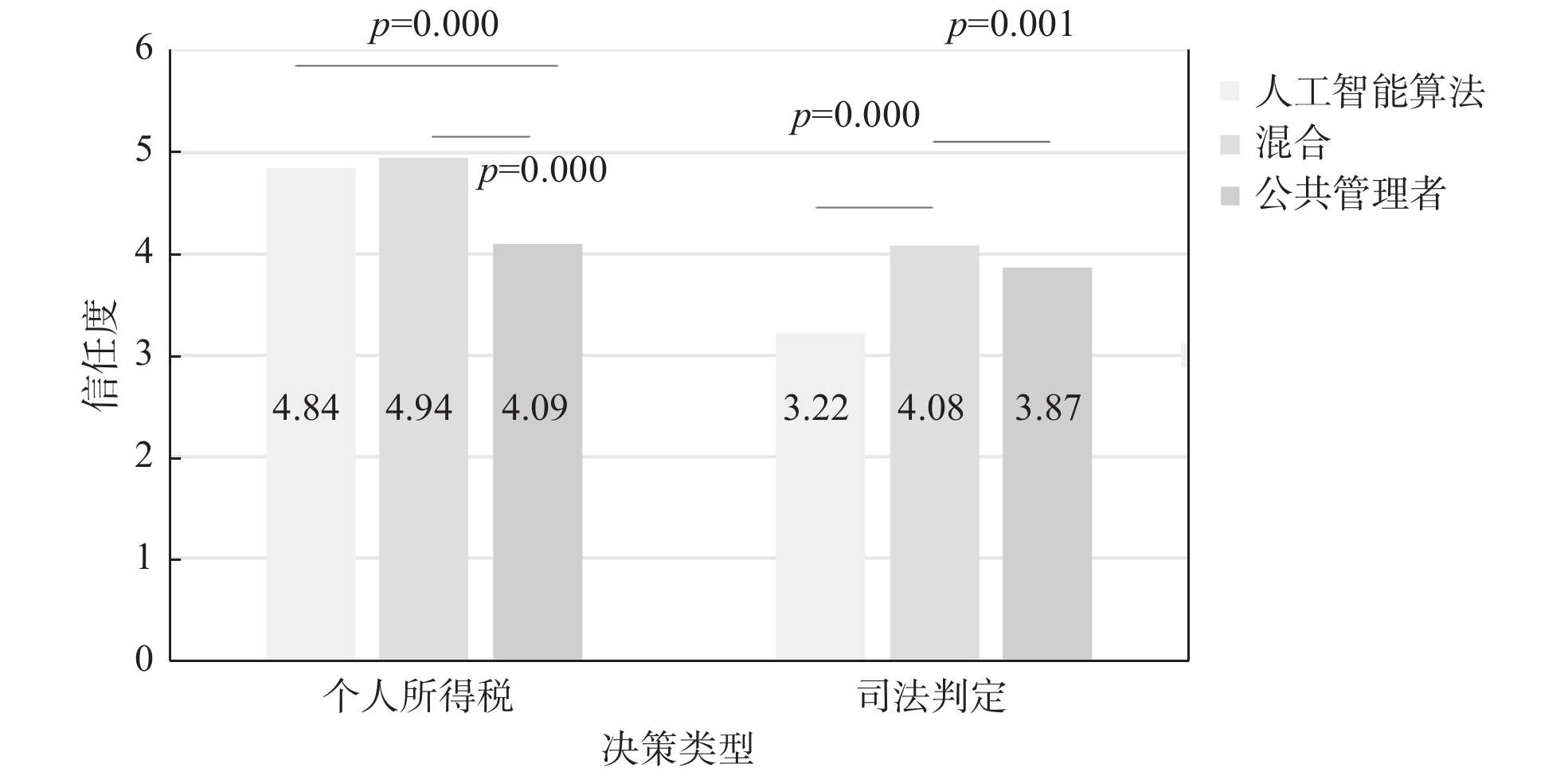

对于定量型公共决策个人所得税计算,方差分析的结果显示不同实验组之间,在信任程度方面具有显著的差异[F(2,137)=16.669,p=0.000<0.001]。事后检验分析表明,公共管理者条件下(M=4.09,SD=0.949)与人工智能条件下(M=4.84,SD=0.796)(p=0.000<0.001, Cohen's d=0.856)、以及与混合条件下(M=4.94,SD=0.550)(p=0.000<0.001, Cohen's d=1.096),公众的信任程度存在明显的差异。这一结果表明,在定量型公共决策场景下,相比于由公共管理者作为决策主体,被试对于由人工智能作为决策主体进行公共决策的信任程度更高,即本研究的假设1成立。同时,人工智能条件下与混合条件下,公众的信任程度不存在显著差异(p=0.644, Cohen's d=0.146)。研究结果见图3。

|

3 不同实验组公众信任比较 |

对于定性型的公共决策司法判定,方差分析的结果显示不同实验组之间,在信任程度方面有显著差异[F(2,137)=10.717,p=0.000<0.001]。事后检验分析表明,人工智能条件下(M=3.22,SD=1.330)与公共管理者条件下(M=3.87,SD=0.757)(p=0.001<0.01, Cohen's d=0.601)、以及与混合条件下(M=4.08,SD=0.556)(p=0.000<0.001, Cohen's d=0.841),公众的信任程度存在明显的差异。这意味着,在定性型公共决策场景下,相比于由公共管理者作为决策主体进行决策,被试对于由人工智能作为决策主体进行决策的信任程度更低,本研究的假设2同样成立。同时,在人工智能条件下与公共管理者条件下,公众的信任程度不存在显著差异(p=0.267, Cohen's d=0.316)。结果见图3。

对于实验2,即受试者内复制实验,双向重复测量ANOVA 表明公共决策类型和决策主体间存在显著的交互作用(F=520.566,p=0.000< 0.001)。可见,在两种不同类的公共决策场景中,公共决策主体类型的影响不同。为此,本研究进一步使用配对T检验来探索决策类型的主要影响。

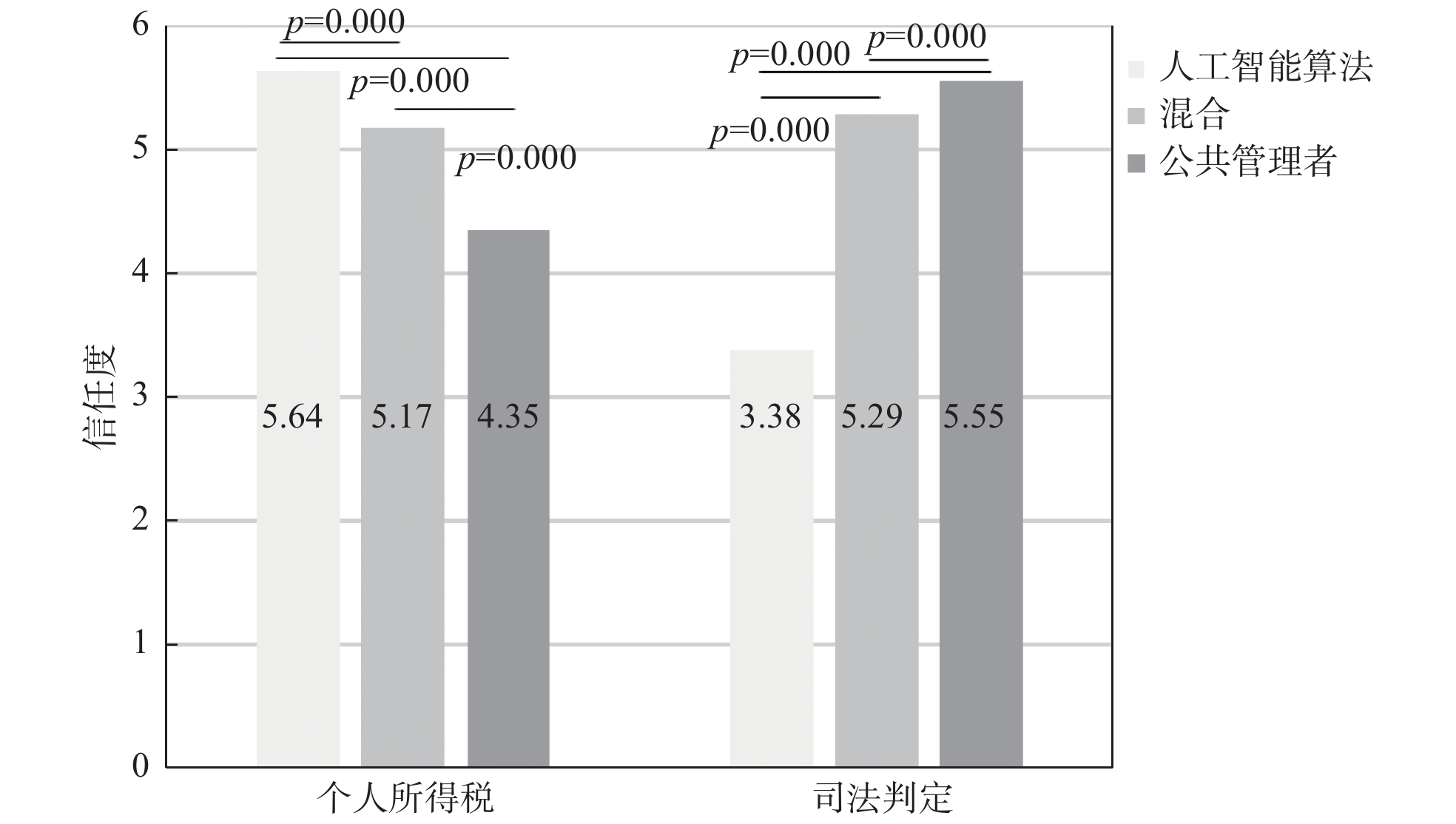

对于定量型公共决策场景个人所得税计算,结果显示在不同决策主体情况下,公众的信任程度有显著差异。其中,在由人工智能技术作为决策主体的情况下(M=5.64,SD=0.665)与由公共管理者作为决策主体的情况下(M=4.35,SD=1.065)(p=0.000<0.001)、以及与混合条件下(M=5.17,SD=0.794)(p=0.000<0.001),公众的信任程度均存在明显的差异。这与实验1中的研究结果相同。对于定性型公共决策场景司法判决,结果显示在不同决策主体情况下,信任程度有显著差异。其中,对由人工智能技术进行决策(M=3.38,SD=0.911),由公共管理者进行决策(M=5.29,SD=0.759)(p=0.000<0.001),以及混合决策(M=5.55,SD=0.547)(p=0.000<0.001),公众的信任程度均存在明显差异。这同样与实验1的结果相同。综上,在实验2中,本文的假设1和假设2同样成立。研究结果如图4所示。

|

4 实验2结果图 |

上述数据分析结果表明,对于定量型公共决策,公众认为由人工智能参与决策的信任度更高。而对于定性型公共决策,公众认为公共管理者和人工智能共同制定决策的信任水平更高。我们尝试从开放性问题中做一个概要的定性讨论,以作解释。

首先,对于定量型公共决策,由人工智能单独制定的决策,比由人类制定的决策,具有更高的信任程度。因为人工智能算法被认为是客观的,其计算结果也更准确,而公共管理者则被视为是主观的,其计算也很有可能会出现错误。这一观点得到了实验被试的支持。较多被试均指出,人工智能算法具有准确、客观的特征,因此出现差错的概率比较小。如有的被试提到“由计算机计算个人所得税误差或歧义比较小,每个人的个人所得税都走相同的程序”,因此“按设定的程序计算就很公平”。与此相反,“计算机计算不带有主观因素”,而“有时候人会带有主观色彩”,因此“不能实现完全公平”。

另外,和公共管理者独立制定决策比较起来,公众也更加倾向于青睐由人工智能和公共管理者协同制定的决策。这也可以从被试的回答中找到依据。例如,有被试回答到,“人工智能和人的判断相结合,可以实现理性和感性的结合,有利于减少失误。”“计算机计算的数据相对准确,加上政府部门人员根据实际情况进行判断,使得结果更加可信”。类似的回答还有,如“计算机算法数据精准,方便快捷,再加上工作人员基于现实的判断,二者结合使得结果更加可信。”“计算机的算法比较客观,政府部门工作人员可以用客观数据来调整个人的主观判断。”。

对于定性型公共决策,公众认为由公共管理者参与制定的决策,比由人工智能单独做出的决策,具有更高的信任程度。这是因为定性型公共决策的决策过程需要考虑的价值平衡、规则等因素较多,这就更加依赖于人类所特有的情景判断等能力。正如被试在回答中提到的一样,“司法判定存在错综复杂的关系,不好用计算机程序设定”,“计算机没有独立的思维,程序运行相对较为死板,没有或几乎很少能根据实际情况来断定”。另外,还有很多被试提到,“司法判定是道德与法律并存的,有时候不是计算机就能做出裁断,需要考虑人道主义因素”,“人工智能在情感上与人类相比,还是差点的,而司法判定不仅要依靠法理,也需要人情”。这启迪我们,在涉及情感判断等人类所特有的特征时,人工智能技术相对于公共管理者具有天然的劣势。

六、结论与讨论作为人工智能技术最重要的应用之一,人工智能技术逐渐开始在复杂、日益多样化的环境中扮演半自治甚至完全决策者的角色。[37]但与此同时,争议也从未间断。这在强调公平正义的政府部门决策中体现得更为明显。这种争议推动本文对于人工智能参与公共决策的公众信任问题进行研究,并试图通过调查实验的方法、采用定量定性相结合的方式,对相关问题进行实证探讨。本文认为,探讨这个问题是十分有价值和必要的,因为这关系到公共决策的合法性和公众的接受度。

本文的研究结果表明,人工智能参与公共决策对于公众信任的影响,会因决策的类型而有所区别。具体而言,对于定量型公共决策,公众认为由人工智能进行决策(无论是独立还是与公共管理者协同),其信任程度较高。这表明,对于较多涉及定量计算或者规则比较明晰的定量型决策,公众更倾向于信赖人工智能,因为它被认为是客观无偏的,能够保证所有人都受到公平的待遇,而如果由人类做出决策,则有可能会因主观偏见或者计算误差等,导致决策的不公平。对于定性型公共决策,相对于人工智能单独做出的决策,由人类参与制定的决策(人类单独做出或者与人工智能共同做出),具有更高的信任水平。这种差异可以归因于这样一种信念,即人工智能不能处理涉及和依赖人类技能的实践,例如同情心和创造力。公众认为这些因素很难衡量。因此,本文认为在定性型的公共决策中,人工智能只适宜成为公共管理者的决策伙伴,而不是成为他们的替代者。[38]

本研究的启示在于,要积极探索与推动人工智能技术在公共决策中的应用。首先,对于规则清晰、问题界限明确的定量型公共决策,应该积极探索自动化决策(无论是替代人类还是辅助人类)的可能,发挥人工智能算法运算快速准确、公正客观的优势,既避免人为决策的主观性和可能出现的错误,又有效地将公共管理人员从这些耗时耗力的常规性决策中释放出来,以从事更有价值性和创造性的工作。[11]其次,对于涉及人类特有的情景判定、情感交互、价值判断与平衡等特征的定性型公共决策,虽然由人工智能取代公共管理者进行决策并不可取,但是将其纳入公共决策过程,协助公共管理者进行决策,同样具有极大价值。正如有的研究者提到的,在以不确定性、复杂性和模糊性为典型特征的决策过程中,“凭借更大的计算信息处理能力和分析方法,人工智能可以在解决复杂性时扩展人类的认知,而人类仍然可以在组织决策中提供更全面、直观的方法”。[31]

本研究的不足也同样值得关注。首先,本文使用调查实验的研究方法,其优点是可以控制被试基于同样的情景做出判断,缺点则是被试需要假想身处相应的情境,这在一定程度上增加了研究效度受损的可能性。[39]其次,本文对于公共决策类型的划分以及相应实验场景的设定,一定程度上是根据自身的判断,因此可能会导致研究的严谨性受损,同时也有可能使得研究结论在推广上有一定的局限性。最后,本文只从决策类型的角度,探究人工智能参与公共决策对公众信任的影响。但事实上,人工智能技术参与公共决策,无论是对于公众的信任还是政府的采纳,需要考虑的因素很多,这是本文力所不逮的。

今后,围绕人工智能和公共决策这一话题,还需对以下问题展开研究:第一,从定性讨论、定量论证等角度出发,研究目前人工智能参与公共决策存在的合法性、有效性、公平性、可责性等问题,提出切实可行的解决方案。第二,针对人工智能参与公共决策制定,对公众其他方面的感知(如公平、程序正义等)的影响,进行更多维、全面的实证研究,并据此为公共管理者提供切实可行的实践建议。第三,针对人工智能可能在公共决策中扮演的三种角色——支持、增强以及完全替代,探讨其适用场景及其相应的边界,即厘清哪些场景更适合完全由人工智能进行决策,哪些场景人工智能只能作为人类决策者的决策辅助。

| [1] |

王张华. 人工智能时代的政府治理: 挑战与应对.

行政与法, 2019(8): 53-59.

DOI: 10.3969/j.issn.1007-8207.2019.08.007. |

| [2] |

冉龙亚, 陈涛, 孙宁华. 人工智能时代的政府治理: 机遇与挑战.

中国科技论坛, 2021(12): 1-9.

|

| [3] |

Banerjee S, Singh P K, Bajpai J. A Comparative Study on Decision-Making Capability Between Human and Artificial Intelligence. Singapore: Springer Singapore, 2017: 203–210.

|

| [4] |

陈涛, 冉龙亚, 明承瀚. 政务服务的人工智能应用研究.

电子政务, 2018(3): 22-30.

|

| [5] |

McKnight H D, Choudhury V, Kacmar C. The Impact of Initial Consumer Trust on Intentions to Transact with a Web Site: a Trust Building Model.

The Journal of Strategic Information Systems, 2002, 3(11): 297-323.

|

| [6] |

Janssen M, Kuk G. The Challenges and Limits of Big Data Algorithms in Technocratic Governance. Government Information Quarterly, 2016, 33(3): 371-377.

|

| [7] |

Zouridis S, Eck M, Bovens M. Automated Discretion. In: Evans T. , Hupe P. (eds) Discretion and the Quest for Controlled Freedom. Palgrave Macmillan, Cham, 2020: 313-329.

|

| [8] |

Nagtegaal R. The Impact of Using Algorithms for Managerial Decisions on Public Employees' Procedural Justice.

Government Information Quarterly, 2021, 38(1): 101536.

DOI: 10.1016/j.giq.2020.101536. |

| [9] |

Russell S J, Norvig P N. Artificial Intelligence: A Modern Approach.

Applied Mechanics & Materials, 2010, 263(5): 2829-2833.

|

| [10] |

Center for Public Impact. Destination Unknown: Exploring the Impact of Artificial Intelligence on Government. https://arxiv.org/pdf/1503.07810.pdf. [2021-10-10].

|

| [11] |

Eggers W D, Schatsky D, Viechnicki P. AI-augmented Government: Using Cognitive Technologies to Redesign Public Sector Work. Deloitte Center for Government, 2017. https://www2.deloitte.com/content/dam/insights/us/articles/3832_AIaugmentedgovernment/DUP _AI-augmented-government.pdf.

|

| [12] |

Mittelstadt B D, Allo P, Taddeo M, et al. The Ethics of Algorithms: Mapping the Debate.

Big Data & Society, 2016, 3(2): 1245638655.

|

| [13] |

Lee M K. Understanding Perception of Algorithmic Decisions: Fairness, Trust, and Emotion in Response to Algorithmic Management.

Big Data & Society, 2018, 5(1): 1245846356.

|

| [14] |

程淑琴, 倪东辉. 大数据时代政府绩效评估与创新研究.

安庆师范学院学报(社会科学版), 2016, 35(5): 97-101.

|

| [15] |

Janssen M, Kuk G. Big and Open Linked Data (BOLD) in Research, Policy, and Practice.

Journal of Organizational Computing and Electronic Commerce, 2015, 26(1-2): 3-13.

|

| [16] |

Clarke A, Margetts H. Governments and Citizens Getting to Know Each Other? Open, Closed, and Big Data in Public Management Reform.

Policy & Internet, 2014, 6(4): 393-417.

|

| [17] |

Duan Y, Edwards J S, Dwivedi Y K. Artificial Intelligence for Decision Making in the Era of Big Data – Evolution, Challenges and Research Agenda.

International Journal of Information Management, 2019, 48: 63-71.

DOI: 10.1016/j.ijinfomgt.2019.01.021. |

| [18] |

Meijer A, Wessels M. Predictive Policing: Review of Benefits and Drawbacks.

International Journal of Public Administration, 2019, 42(12): 1031-1039.

DOI: 10.1080/01900692.2019.1575664. |

| [19] |

Gillath O, Ai T, Branicky M S, et al. Attachment and Trust in Artificial Intelligence.

Computers in Human Behavior, 2021, 115: 106607.

DOI: 10.1016/j.chb.2020.106607. |

| [20] |

Aoki N. An Experimental Study of Public Trust in AI Chatbots in the Public Sector.

Government Information Quarterly, 2020, 37(4): 101490.

DOI: 10.1016/j.giq.2020.101490. |

| [21] |

Sidlauskiene J. What Drives Consumers’ Decisions to Use Intelligent Agent Technologies? A Systematic Review.

Journal of Internet commerce, 2021, : 1-38.

|

| [22] |

Pelau C, Dabija D, Ene I. What makes an AI Device Human-like? The Role of Interaction Quality, Empathy and Perceived Psychological Anthropomorphic Characteristics in the Acceptance of Artificial Intelligence in the Service Industry.

Computers in Human Behavior, 2021, 122: 106855.

DOI: 10.1016/j.chb.2021.106855. |

| [23] |

Kaplan A D, Kessler T T, Brill J C, et al. Trust in Artificial Intelligence: Meta-Analytic Findings.

Hum Factors, 2021, : 823484060.

|

| [24] |

Bawack R E, Wamba S F, Carillo K D A. Exploring the Role of Personality, Trust, and Privacy in Customer Experience Performance During Voice Shopping: Evidence from SEM and Fuzzy Set Qualitative Comparative Analysis.

International Journal of Information Management, 2021, 58: 102309.

DOI: 10.1016/j.ijinfomgt.2021.102309. |

| [25] |

Ingrams A, Kaufmann W, Jacobs D. In AI We Trust? Citizen Perceptions of AI in Government Decision Making. Policy & Internet, 2021.

|

| [26] |

Busch P A, Henriksen H Z, Sæbø Ø. Opportunities and Challenges of Digitized Discretionary Practices: a Public Service Worker Perspective.

Government Information Quarterly, 2018, 35(4): 547-556.

DOI: 10.1016/j.giq.2018.09.003. |

| [27] |

董帅, 范长军, 瞿崇晓等. 关于人工智能应用于管理决策的几点思考.

企业改革与管理, 2021(8): 5-7.

|

| [28] |

Bolander T. What do We Loose When Machines Take the Decisions?.

Journal of Management and Governance, 2019, 23(4): 849-867.

DOI: 10.1007/s10997-019-09493-x. |

| [29] |

Parry K, Cohen M, Bhattacharya S. Rise of the Machines.

Group & Organization Management, 2016, 41(5): 571-594.

|

| [30] |

Shrestha Y R, Ben-Menahem S M, von Krogh G. Organizational Decision-Making Structures in the Age of Artificial Intelligence.

California Management Review, 2019, 61(4): 66-83.

DOI: 10.1177/0008125619862257. |

| [31] |

Jarrahi M H. Artificial Intelligence and the Future of Work: Human-AI Symbiosis in Organizational Decision Making.

Business Horizons, 2018, 61(4): 577-586.

DOI: 10.1016/j.bushor.2018.03.007. |

| [32] |

Kantowitz B H, Roediger H L, Elmes D G. Experimental Psychology: Understanding Psychology Research. Cambridge: Wadsworth Publishing, 2008.

|

| [33] |

Falk A, Heckman J J. Lab Experiments Are a Major Source of Knowledge in the Social Sciences.

Science, 2009, 326(5952): 535-538.

DOI: 10.1126/science.1168244. |

| [34] |

Blom-Hansen J, Morton R, Serritzlew S. Experiments in Public Management Research.

International Public Management Journal, 2015, 2(18): 151-170.

|

| [35] |

Sniderman P M. The Logic and Design of the Survey Experiment: An Autobiography of a Methodological Innovation. Cambridge: Cambridge University Press, 2011.

|

| [36] |

代涛涛, 陈志霞. 行为公共管理研究中的实验方法: 类型与应用.

公共行政评论, 2019, 12(6): 166-185.

DOI: 10.3969/j.issn.1674-2486.2019.06.009. |

| [37] |

Davenport T H, Julia K. Just How Smart are Smart Machines?.

MIT Sloan Management Review, 2016, 57(3): 21-25.

|

| [38] |

Wesche J S, Sonderegger A. When Computers Take the Lead: The Automation of Leadership.

Computers in Human Behavior, 2019, 101: 197-209.

DOI: 10.1016/j.chb.2019.07.027. |

| [39] |

李晓倩, 刘求实. 购买服务中公众对非营利机构与营利性机构信任差异的实验研究.

中国非营利评论, 2018, 22(2): 95-114.

|

——

2022, Vol. 12

2022, Vol. 12