近些年,运动目标检测被广泛用于视频检测及工业检测等方面。运动目标检测主要功能是快速、准确地将视频中的运动目标提取出来[1]。

部分学者提出,利用颜色图像信息或者是深度图像信息进行目标检测[2]。文献[3]利用深度图像信息进行目标检测,再利用“与运算”进行特征信息融合,改善了目标与背景模型距离较近的问题,但是没有考虑到光照突变对实验本身的影响。文献[4]采用颜色信息进行前景目标的检测,但是当背景模型是复杂多变的情况时,该种方法难以解决问题。文献[5]分别利用彩色图像特征与深度图像特征进行目标检测,通过逻辑运算将特征信息进行融合处理,但当边缘存在噪声点时,检测效果明显降低,且存在漏检现象[6]。

针对以上存在的问题,本文在RGB色彩空间模型的基础上,采用SOFM模型改善色彩空间颜色的真实性;再根据像素值的边缘特性以及上一帧图像的检测信息,为分类器分配合适的权重值,解决彩色视频检测存在的问题。

1 颜色空间建模由于大部分视频都为彩色视频,因此视频图像的特征信息可以作为运动目标检测判断依据[7]。不同彩色图像对应不同的颜色特征信息,导致颜色空间的选择成为影响前景检测性能的重要因素。

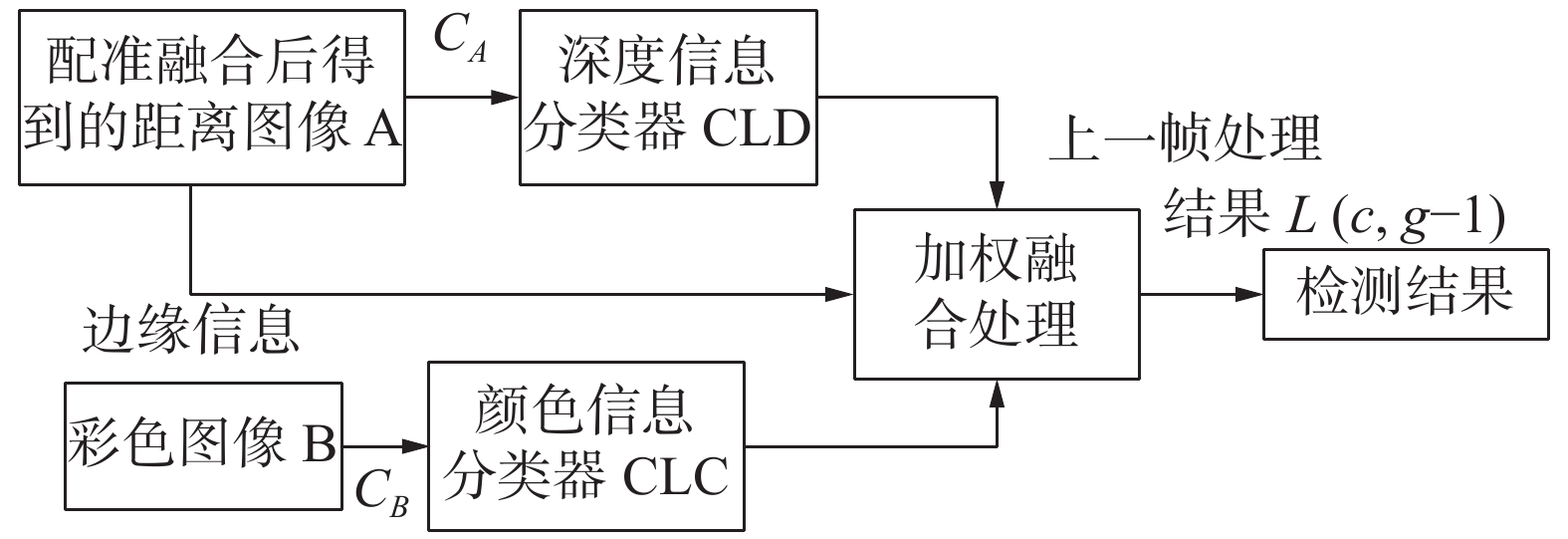

本文采用SOFM模型空间模型完成运动目标检测,如图1所示。

|

Download:

|

| 图 1 目标检测流程 | |

SOFM模型通过已有背景模型进行训练,像素值认为是样本,对前景模型目标进行判断[8]。若视频任意位置Y处的颜色值记为S,公式如下:

| ${P_Y}(S) = \theta \alpha $ | (1) |

| $Y + \theta \beta = 1$ | (2) |

式中:α表示背景模型;β表示移动对象;θ表示约束参数。式(1)表示S与Y的概率关系,式(2)则是对相关参数进行定义。

此背景模型主要利用混合概率表示每一类像素对应的特征信息,完成任何颜色前景背景模型的创建,构建模型如式(3)及式(4)所示:

| ${P_Y}(\left. S \right|\beta ) = F(S)$ | (3) |

| $F(S) = \left\{ \begin{array}{l} 1/g(L),S\inL\\ 0,{\text{其他}} \end{array} \right.$ | (4) |

式中:L表示颜色总空间;g(L)表示L的三维卷积。从式(4)中可以看出,由于每一个神经元对应一组输入数据集,并且任意位置点的背景像素值与场景特征有关联。因此,利用概率自组织映射模型可以解决任意像素的背景颜色分布[9]:

| ${P_Y}(\left. S \right|\alpha ) = \frac{1}{M}\sum\limits_{j = 1}^M {{P_Y}(\left. S \right|j)} $ |

式中M代表SOFM模型的神经元个数。

假设神经元分布在一个矩阵空间里,则任何两个神经元K、G的欧氏距离记为

| $(K,G) = \left\| {TK - TG} \right\|$ |

式中:l(K,G)代表神经元K、G之间的拓扑距离;TK、TG表示K、G在矩形空间里所处位置信息。

为减小算法的冗余度,可以把映射中的神经元作为一个高斯概率密度分布模型[10],如式(5)所示:

| ${P_Y}(S) = (2{\rm{{\text{π}} }}) \times {\sigma ^{ - D}} \times \exp \Bigg( - \frac{{{{\left\| 3 \right\|}^2}}}{{2{\sigma ^2}}}\Bigg)$ | (7) |

| $\sigma _2^2 \leqslant \sigma _Y^2 \leqslant \sigma _1^2$ | (8) |

式中:σ2代表方差;σ1表示σ的上边界;σ2表示σ的下边界。式(6)的约束条件能够保证SOFM模型准确地描述输入像素的分布。

2 基于混合信息的运动目标检测 2.1 距离图像与彩色图像的配准当获取视频场景的视频序列以后,得到视频序列的内外部参数,再对视频序列的距离图像信息和彩色图像信息进行融合配准处理,最终距离图像获取的分辨率与彩色图像获取的分辨率一致[11]。

2.2 运动目标检测本文优化算法的流程图,如图2所示。

|

Download:

|

| 图 2 基于混合信息的优化流程 | |

在RGB色彩空间处理基础上,首先利用经配准融合处理的距离图像和彩图图像,构建像素级分类器CLC和CLD;其次,输入图像的像素c,将深度图像信息CA送至CLD分类器进行处理,颜色图像信息CB送至CLC分类器进行处理,二者输出的结果形成一个新的矩阵

| ${{{\mathit{\boldsymbol{Q}}}}_C} = \left[ \begin{gathered} q({w_{nc}})\left| {{C_A}\mathop {}\limits^{} q({w_{mc}})\left| {{C_A}} \right.} \right. \\ q({w_{nc}})\left| {{C_B}\mathop {}\limits^{} q({w_{mc}})\left| {{C_B}} \right.} \right. \end{gathered} \right]$ | (9) |

式中:

| $q({w_j}\left| c \right.) = {w_A} \cdot q({w_j}\left| {{c_A}} \right.) + {w_B} \cdot q({w_j}\left| {{c_B}} \right.),j \in \left\{ {nc,mc} \right\}$ | (8) |

式中:

配准融合处理的距离图像存在如下问题:1)由于视频中的场景信息不相同,导致配准融合处理过后的距离图像,出现信息缺失[13];2)由于图像自身存在较大的边缘噪声,进而导致边缘的信息误差值大[14]。针对以上存在的问题,结合颜色信息和深度信息对区域的差异影响,故选择一种权重值选取方案,操作流程如下所示:

1)对第g帧的像素c进行深度信息判断[15],当像素c获得深度信息时,执行步骤2);否则,采用颜色图像信息对运动目标进行检测,公式为

| $\left\{ \begin{gathered} {w_A}(c,g) = {\rm{0}} \\ {w_B}(c,g) = {\rm{1}} \\ \end{gathered} \right.$ |

式中:

2)选择Prewitt算子对像素c进行边缘区块检测处理,当像素c的梯度值

3)当深度信息受边缘噪声较大影响时,需要对权重值进行调整,以此减小边缘噪声影响,权重调整公式为

| $\left\{ \begin{gathered} {w_A}(c,g) = {w_{\min }} \\ {w_B}(c,g) = {w_{\max }} \end{gathered} \right.,F(c) > H$ |

4)当运动目标逐渐向背景模型移动时,会导致CLD分类器出现漏检现象。故本文加入了视频上一帧的检测结果L(c,g−1)对权重值重新进行分配。

①当L(c,g−1)被判定为背景模型时,按照式(12)进行权重值选择:

| $\left\{ \begin{gathered} {w_A}(c,g) = {w_{\min }} \\ {w_B}(c,g) = {w_{\max }} \end{gathered} \right.,F(c) > H,L(c,g - 1) \in {w_{nc}}$ | (13) |

②当L(c,g−1)被判定为运动目标时,则需要对第g−1帧的像素c存在的深度图像信息与CLD分类器的距离关系进行计算,公式为

| $\kappa (c,g - 1) = \left| {{c_{A,g - 1}} - {\mu _{c,g - 1}}} \right|/{\sigma _{c,g - 1}}$ |

式中:

| $\begin{array}{l} \left\{ \begin{array}{l} {w_A}(c,g) = {w_{\min }} + \dfrac{{{w_{\max }} - {w_{\min }}}}{{1 + Q\exp {{( - B(\kappa ({Y_c},g - 1)))}^{1/\upsilon }}}}\\ {w_B}(c,g) = 1 - {w_A}({Y_c},g) \end{array} \right. \end{array}$ |

式中:

文章利用CLC分类器、CLD分类器,得到每一种分类器像素c的概率值

| $\begin{gathered} q({w_j}\left| c \right.) = {w_A} \cdot \frac{{q({c_A}\left| {{w_k}} \right.)}}{{q({c_A}\left| {{w_{nc}}} \right.) + q({c_A}\left| {{w_{mc}}} \right.)}} + \\ {w_B} \cdot \frac{{q({c_B}\left| {{w_k}} \right.)}}{{q({c_B}\left| {{w_{nc}}} \right.) + q({c_B}\left| {{w_{mc}}} \right.)}},k \in \left\{ {nc,mc} \right\} \end{gathered} $ |

式中,

本文实验采用TOF相机进行视频采集,分辨率为1 800×1 080。为验证本文改进算法的有效性,本文对运动目标与背景模型颜色类似、背景模型运动和光照突变3种不同类型的室内视频帧序列进行仿真。本文所有实验均采用MATLAB 2018b软件进行仿真分析。

3.1 实验参数的设定本文算法受到诸多参数的限制影响,这些参数的设定值将会对算法产生影响,为保证算法在整体上获得良好性能优势,在结合大量实验数据的基础上对表1的参数值进行设定。

|

|

表 1 算法参数的设定 |

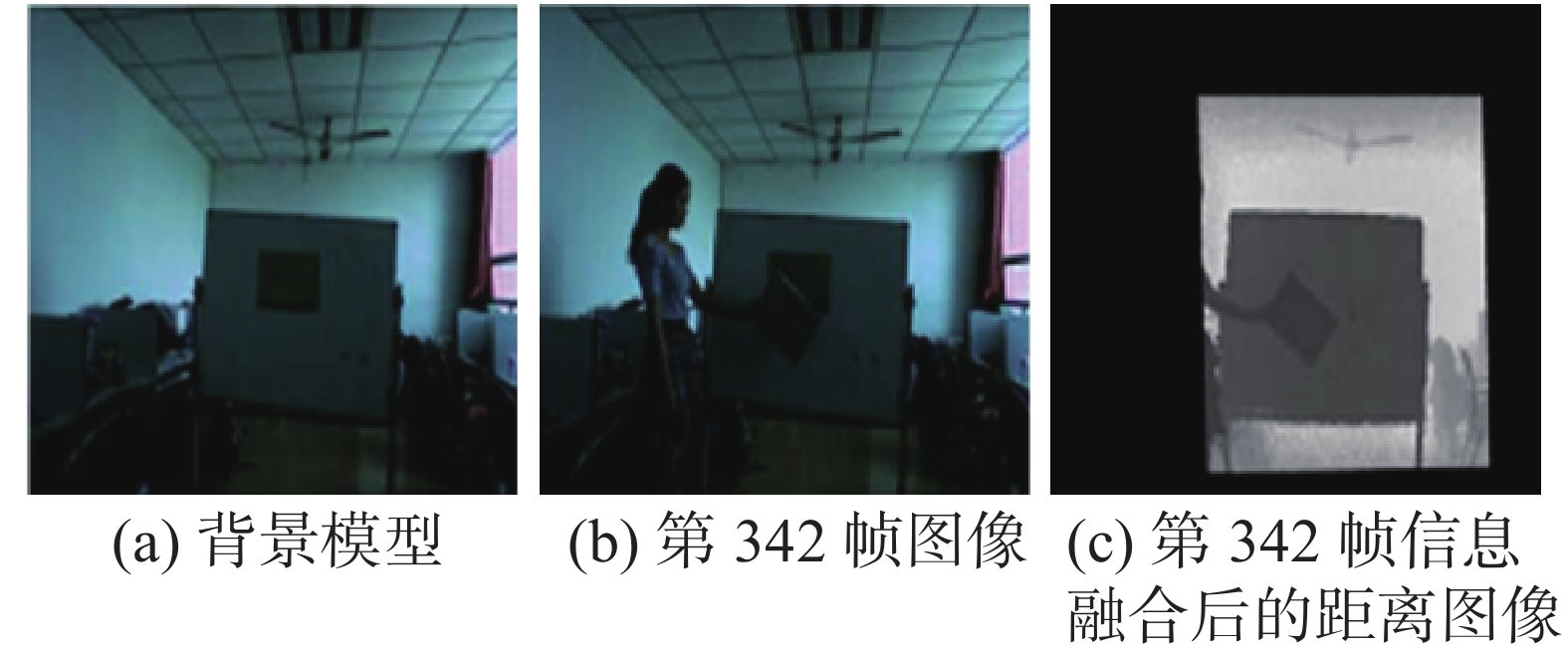

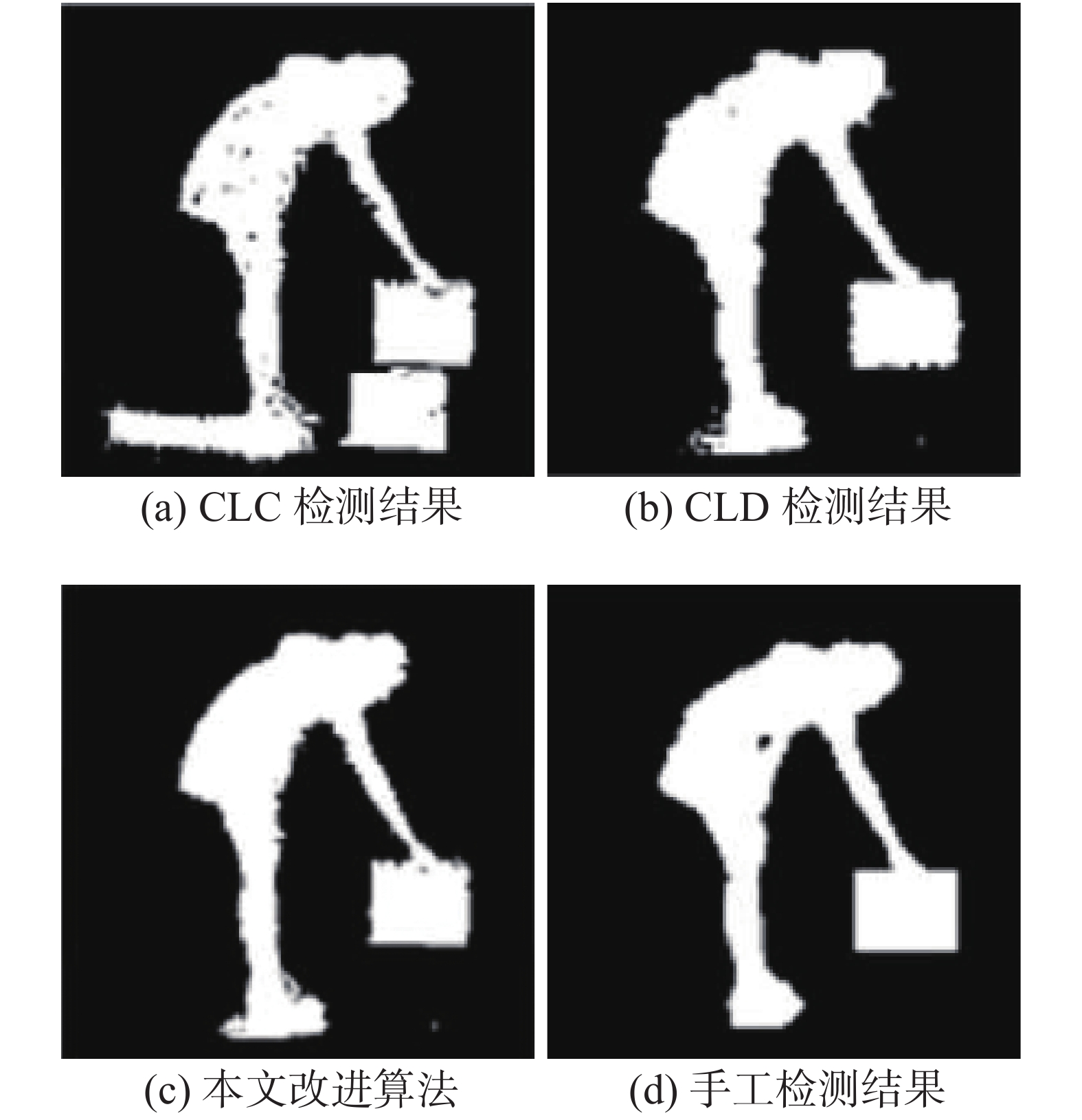

当运动目标与背景模型颜色相同时,序列1背景模型见图3(a)所示,图3(b)选择的盒子颜色与背景模型颜色相同。为保证实验结果的准确性,只保留图3(b)中的盒子部分,如图3(c)所示。在图4(a)中,采用CLC分类器进行目标检测,从图中明显看出,检测结果存在严重缺失;在图4(b)中,利用CLD分类器融合特征信息进行目标检测,检测的目标基本完整,但由于噪声点的影响,导致检测出的目标边缘不清晰;图4(c)采用本文改进算法进行目标检测,该算法检测效果最佳。与图4(d)手工检测结果对比,两者检测结果相近。

|

Download:

|

| 图 3 序列1第342帧图像 | |

|

Download:

|

| 图 4 序列1检测结果 | |

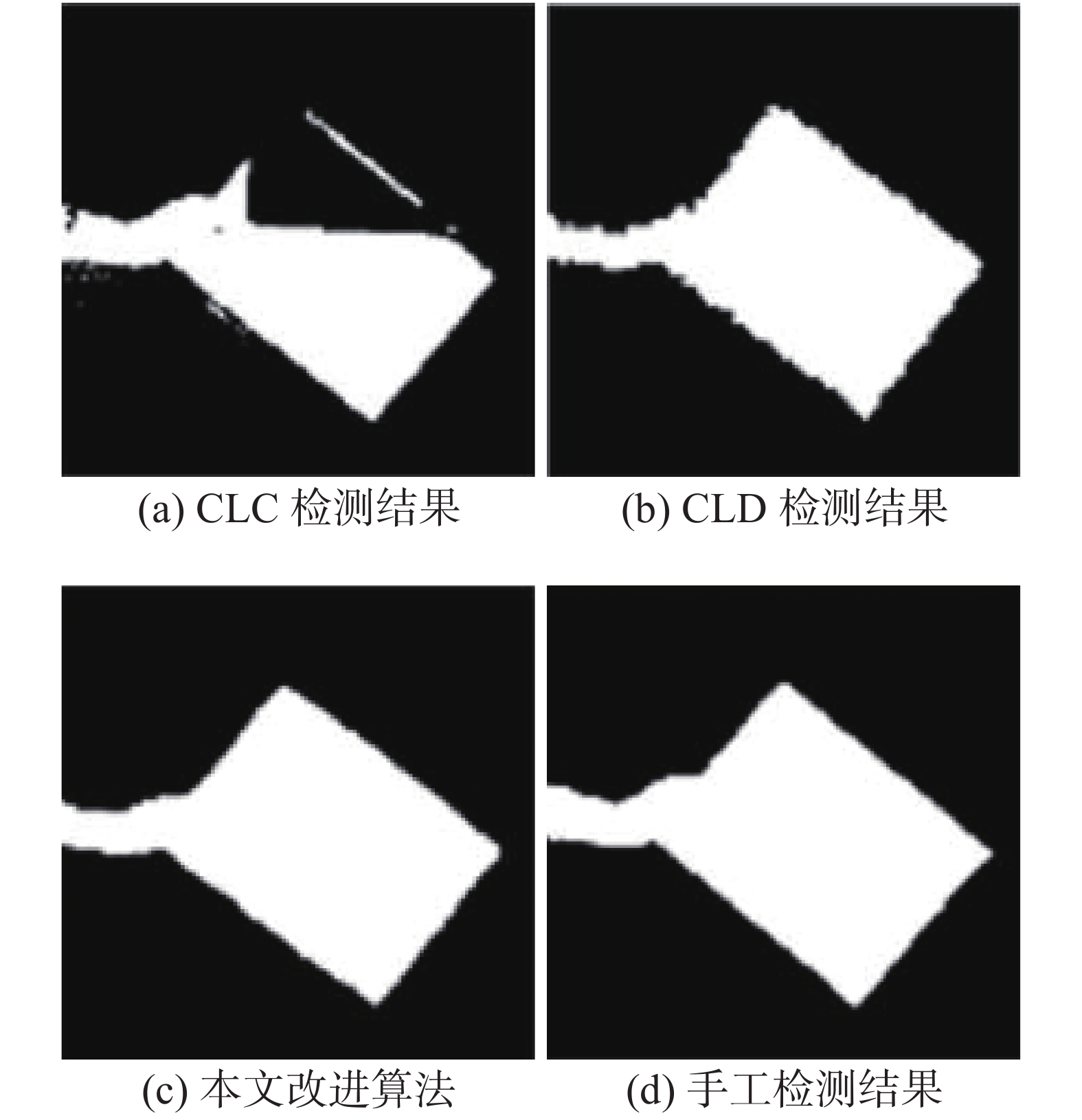

若背景模型快速移动时,序列2的背景模型如图5(a)所示,在图5(b)中,第165帧图像背景模型开始运动,图5(c)为第342帧信息融合后的距离图像。图6(a)是采用CLC分类器对背景模型进行更新,此时,检测图中出现“鬼影”;图6(b)是采用CLD分类器依据本文提出的背景更新策略,对背景中移动物体进行判断,且有效克制了“鬼影”现象,但由于噪声点的影响,导致检测出的目标边缘不清晰;图6(c)采用改进算法进行目标检测,本文改进算法可以对运动的背景模型进行快速、准确判断,且有效消除了“鬼影”区域,检测效果最佳,与图6(d)手工检测结果基本相同。

|

Download:

|

| 图 5 序列2第165帧图像 | |

|

Download:

|

| 图 6 序列2检测结果 | |

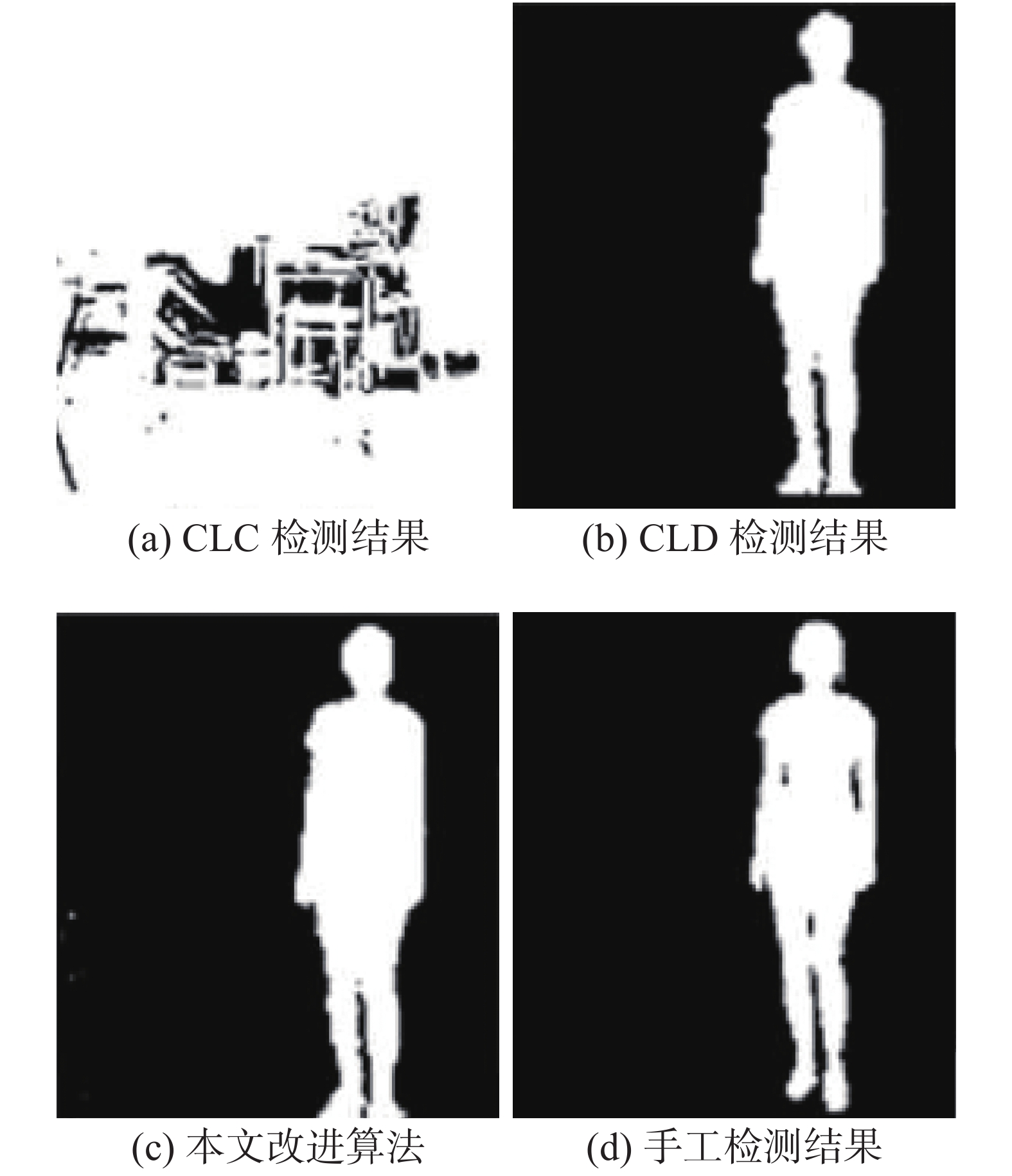

序列3为光照突变的视频序列,第769帧时光照突变。为保证实验结果的准确性,仍然对检测目标进行截取处理;为确保实验检测结果的一般性,在进行图像截取时,截取部分未进行特征信息融合处理。在图7的检测结果图中,图7(a)采用CLC分类器不能适应光照快速突变;图7(b)利用CLD分类器融合特征信息进行目标检测,检测的目标基本完整,但由于噪声点的影响,导致检测出的目标边缘不清晰;图7(c)采取的本文算法虽无法获取距离图像的完整信息,但受到光照突变的影响较小,与图7(d)的手工检测结果相对比,存在些许差异,但从整体来讲,本文算法可以有效抑制“鬼影”以及光照突变的情况。

|

Download:

|

| 图 7 序列3第769帧检测结果 | |

为了更加准确地对3种算法进行评估分析,选定多个评价指标对其进行评估,评估参数主要包括召回率(Re)、精度(Pr)、F数,其中,召回率、F数、精度的值越大,说明算法的性能越好;计算公式为

| ${{\rm{P}}_{\rm{r}}} = \frac{{{\rm{TP}}}}{{{\rm{TP}} + {\rm{FP}}}}$ | (17) |

| ${{\rm{R}}_{\rm{e}}} = \frac{{{\rm{TP}}}}{{{\rm{TP + FN}}}}$ | (18) |

| ${\rm{F}} = {\rm{2RP}}({\rm{R + P}})$ | (19) |

式中:TP表示被成功检测为运动目标时的像素值;TN表示被成功检测为背景模型时的像素值;FN表示被错判为背景模型时的像素值;FP表示被错判为运动目标时的像素值;F数表示对Pr和Re两项指标进行综合评价,F数可以更加全面地对算法的性能进行综合评估。表2为几种算法的评估对比。

从表2数据可以看出,采用本文算法所得到的精度、召回率以及F数均为最优,验证了本文改进算法的可行性。

|

|

表 2 3种算法的综合评估指标 |

1)采用SOFM模型有效改善了色彩空间模型的真实性;

2)在SOFM模型基础上,利用CLC和CLD分类器进行检测,有效避免了光照突变、背景模型颜色相似、背景模型运动等问题;

3)通过对召回率、精度、F数的综合考评分析。本文采用算法的评价指标均为最优,进而验证了本文算法的可行性。

| [1] |

郑浦, 白宏阳, 李政茂, 等. 抖动干扰下运动目标精准检测与跟踪算法设计[J]. 仪器仪表学报, 2019, 40(11): 90-98. ( 0) 0)

|

| [2] |

刘伟, 郝晓丽, 吕进来. 自适应混合高斯建模的高效运动目标检测[J]. 中国图象图形学报, 2020, 25(1): 113-125. DOI:10.11834/jig.190155 ( 0) 0)

|

| [3] |

刘明明, 李震霄, 郑丽丽, 等. 一种新的鲁棒无监督显著性目标检测方法[J]. 中国科技论文, 2019, 14(12): 1356-1361. ( 0) 0)

|

| [4] |

任宇杰, 杨剑, 刘方涛, 等. 基于SSD和MobileNet网络的目标检测方法的研究[J]. 计算机科学与探索, 2019, 13(11): 1881-1893. DOI:10.3778/j.issn.1673-9418.1906023 ( 0) 0)

|

| [5] |

欧阳梓标, 牛燕雄, 谢朋言. 一种改进的基于ViBe的运动目标检测方法[J]. 半导体光电, 2018, 39(2): 260-263. ( 0) 0)

|

| [6] |

张超婕, 余勤. 时空RPCA在复杂场景下的运动目标检测[J]. 计算机工程与设计, 2020, 41(1): 197-202. ( 0) 0)

|

| [7] |

王凯, 吴敏, 姚辉, 等. 改进Mode算法与双门限融合的目标检测方法[J]. 小型微型计算机系统, 2019, 40(10): 2215-2220. DOI:10.3969/j.issn.1000-1220.2019.10.035 ( 0) 0)

|

| [8] |

魏志强, 纪筱鹏, 冯业伟. 基于自适应背景图像更新的运动目标检测方法[J]. 电子学报, 2005, 33(12): 2261-2264. DOI:10.3321/j.issn:0372-2112.2005.12.038 ( 0) 0)

|

| [9] |

娄康, 朱志宇, 葛慧林. 基于目标运动特征的红外目标检测与跟踪方法[J]. 南京理工大学学报, 2019, 43(4): 455-461. ( 0) 0)

|

| [10] |

孙洁, 钱蕾. 基于边缘计算模型的智能视频监控的研究[J]. 计算机与数字工程, 2019, 47(2): 402-406. DOI:10.3969/j.issn.1672-9722.2019.02.029 ( 0) 0)

|

| [11] |

刘少华, 张茂军, 熊志辉, 等. 一种鲁棒高效的视频运动目标检测与跟踪算法[J]. 自动化学报, 2009, 35(8): 1055-1062. ( 0) 0)

|

| [12] |

崔华, 田尚伟, 王伟, 等. 基于三维包络展开的车型识别[J]. 中国科技论文, 2019, 14(11): 1241-1248. ( 0) 0)

|

| [13] |

李庆忠, 何东晓, 等. 基于聚类的背景建模与运动目标检测方法[J]. 计算机工程与应用, 2008, 44(8): 193-195, 203. DOI:10.3778/j.issn.1002-8331.2008.08.057 ( 0) 0)

|

| [14] |

许益成, 谭文安, 陈丽婷. 基于改进混合高斯模型的运动目标检测算法[J]. 控制工程, 2018, 25(4): 630-635. ( 0) 0)

|

| [15] |

易诗, 张洋溢, 聂焱, 等. 红外图像中快速运动目标的检测与跟踪方法[J]. 红外技术, 2019, 41(3): 268-272. ( 0) 0)

|

| [16] |

刘小静, 薛峰. 基于边缘对比差分算法的运动目标检测[J]. 计算机工程, 2018, 44(10): 246-251. ( 0) 0)

|

2021, Vol. 48

2021, Vol. 48