信号特征的提取方法主要为傅里叶变换、小波分析等,提取的特征参量主要为信号的幅值、能量、频率等。小波分析是目前常用的信号分解方法,经小波分解,时域信号可分解为不同频段的时域信号。但是小波变换不具有自适应性,小波基的选择比较困难,小波参数的选择将直接影响到最后的诊断结果[1−4],存在很大的人为因素的影响。同时共振解调存在与小波变换相同的缺陷,需要人为地选择一些参数,也不具有自适应性[5−7]。

EMD算法是一种信号分解方法,把信号分解为一系列平稳的信号分量,且分量按频率由高到低排列,与小波分析相比不用人为地选择小波基。但是目前的研究主要考虑EMD分解的某一部分分量,摒弃了大量的信号特征信息,且特征参量多只考虑幅值、能量等信息[8]。张志刚等[9]在提取滚动轴承的故障特征时利用了灰色关联度和互信息来改进EMD算法,但是两者都只能度量EMD分量的一个尺度,也就是相关性。胡爱军等[10]利用了峭度准则进行特征提取时只选择了一个固有模态函数(intrinsic mode function,IMF)分量,移除了大量的特征信息。

在特征的选择方面,众多学者在选择算法和特征评价中取得了丰硕的研究成果。要明确起关键作用的特征组,首先必须明确选择的算法,再者就是制定相应的评价准则对所提取的特征向量进行评价分析[11]。同时,特征样本数越多就会造成模型越复杂,训练的速度也越慢,因此数据降维也是一个研究的热点。通常数据信号的降维从两个方面来考虑:其一就是直接提取特征子集抽取特征;其二就是用线性或者非线性的方式通过变换空间实现信号特征的降维。第2种方法是目前运用的主流。线性映射的方法主要有主成分分析(principal component analysis,PCA)、线性判别分析(linear discriminant analysis,LDA)。PCA可以提取信号主要的信息,但是该方法需要计算协方差矩阵,计算量较大;LDA原理比较简单,容易理解,但是计算较复杂;而利用核函数的特征降维方法最后的结果受核的选择的影响[12]。

为了解决上面提到的问题,本文提出一种基于EMD的特征提取与识别方法。利用信号的信息熵构建基于信息熵的均值特征向量,同时引入模糊聚类对特征向量进行再选择,探讨不同聚类数下的特征向量对识别结果的影响。首先对信号数据进行EMD分解,求取各个分量的信息熵,基于信息熵构建均值特征向量;然后基于模糊聚类算法对均值向量进行特征降维选择;最后利用BP神经网络进行识别训练。

1 基于信息熵的特征向量构建 1.1 信息熵理论熵是随机变量不确定性的度量。如果一个离散型随机变量

| $H(X) = - \sum\limits_{x \in A} {p(x)\log p(x)} $ |

EMD是一种会把信号分解为一系列平稳信号分量的分解方法,且分量按频率由高到低排列。目前在缺陷检测、状态监测、特征向量的构建以及信号去噪等方面得到了普遍且成熟的应用,取得了丰硕的学术成果。经验模态分解步骤如下:

假设待分解信号模型为:

| $f(t) = s(t) + n(t)$ |

式中:

1)计算出信号

2)求取全部极大值点连接起来生成的包络线

3)对2条包络线求取平均值为

| ${m_0}(t) = \frac{{{u_0}(t) + {v_0}(t)}}{2}$ | (1) |

并记信号与平均值

| ${h_0}(t) = f(t) - {m_0}(t)$ |

4)判断

5)记

| $f(t) = \sum\limits_{k = 1}^n {{c_k}(t) + {r_n}(t)} $ |

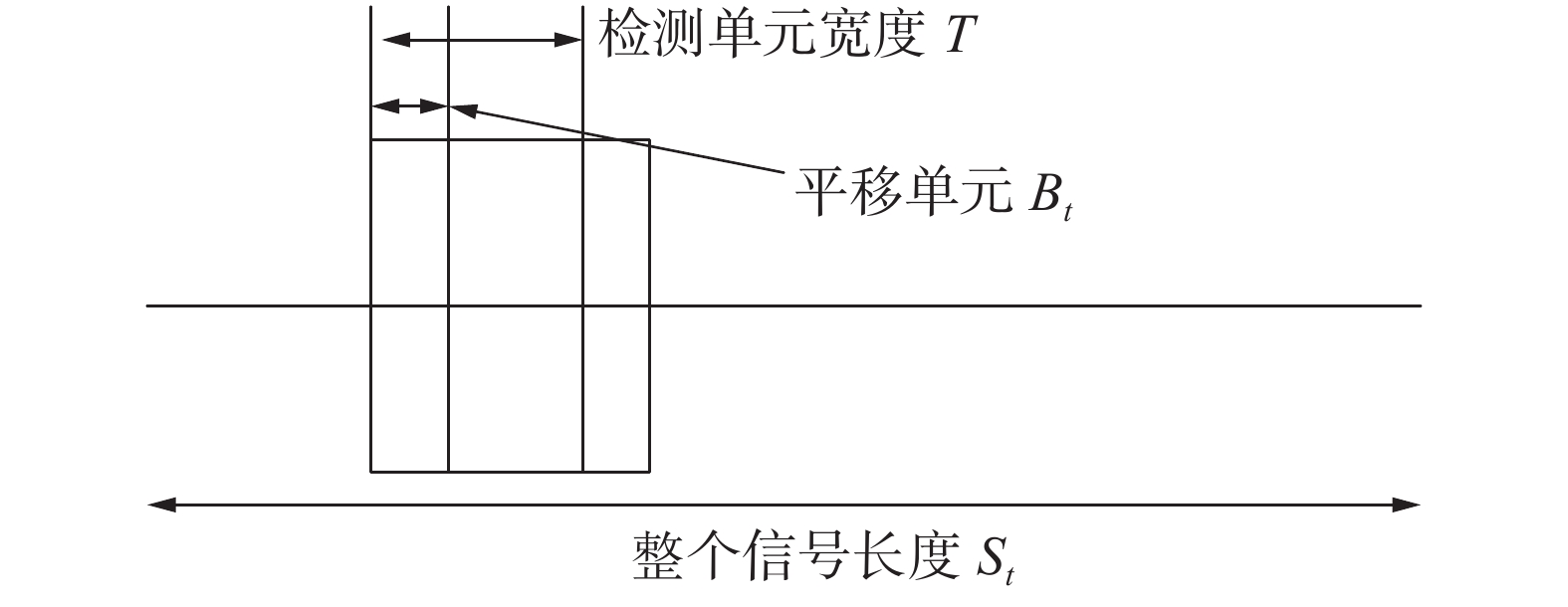

为了构建桩基缺陷数据的基于信息熵的均值特征向量,利用EMD方法对缺陷信号进行分解。分解后的分量为了方便求取信息熵,在时间轴上选取固定长度的信号作为一个检测单元,然后再依次平移检测单元,完成整个信号长度的计算。检测单元、平移距离如图1所示。

|

Download:

|

| 图 1 信号截取设定示意 | |

检测单元宽度T和平移距离

| $\frac{T}{8} < {B_t} < \frac{T}{4}。$ |

信息熵的求解重点是概率

假设存在论域

模糊C均值聚类(fuzzy c-means,FCM)方法第一次由E Ruspini在论文中进行较完整的阐述。随着其他学者对该方法的进一步研究,把算法在具体的应用方法上进行了推广,开始应用于模糊聚类的相关领域。这种推广大大加速了FCM算法在实际工程中的应用。FCM算法进行聚类的主要原理是通过迭代的方式对目标函数进行计算更新,直到达到理想的聚类效果。通过隶属度函数,判断每一个元素属于一个类的程度,完成每一个类的划分,只要在程序中设定了聚类数,后续的处理将会自动地自适应完成[14−15]。

FCM算法的目标函数为

| ${J_1}(U, P) = \sum\limits_{i = 1}^c {\sum\limits_{k = 1}^n {{u_{ik}}{{({d_{ik}})}^2}} } $ |

式中

FCM算法执行步骤如下:

1)给定聚类数c(1<c<n)、模糊指数m(m>1)、最大迭代次数T、收敛的精度

2)根据公式

3)根据公式

4)判断是否满足停止条件(达到最大迭代次数或者达到收敛精度),如果满足就停止,否则继续执行步骤2)。

2.2 基于模糊聚类算法的数据处理假定待处理的基于信息熵的均值向量为

| ${{X}} = \{ {x_1}, {x_2}, \cdots , {x_N}\} $ | (1) |

首先对式(2)重新进行构造,构成用于模糊聚类的输入矩阵。以长度

| ${{A}} = \left[ {\begin{array}{*{20}{c}} {{x_{11}}}&{{x_{12}}}&{\cdots }&{{x_{1n}}} \\ {{x_{21}}}&{{x_{22}}}&{\cdots }&{{x_{2n}}} \\ \vdots &{\cdots }&{\cdots }& \vdots \\ {{x_{m1}}}&{{x_{m2}}}&{\cdots }&{{x_{mn}}} \end{array}} \right]$ | (2) |

式(2)与(3)的对应关系如表1所示。

|

|

表 1 均值向量与重构矩阵各元素对应关系 |

从矩阵A我们可以看出,该矩阵有

| ${{B}} = {\left[ {\begin{array}{*{20}{c}} {{y_{11}}}&{{y_{12}}}&{\cdots }&{{y_{1n}}} \\ {{y_{21}}}&{{y_{22}}}&{\cdots }&{{y_{2n}}} \\ \vdots &{\cdots }&{\cdots }& \vdots \\ {{y_{c1}}}&{{y_{c2}}}&{\cdots }&{{y_{cn}}} \end{array}} \right]_{c < m}}$ | (3) |

根据式(4)中的降维矩阵B生成新的特征向量,表示为

|

|

表 2 新特征向量与降维矩阵关系 |

这样原本的均值向量X就被简化为了特征向量F。然后把新构建的特征向量作为神经网络的输入用于对缺陷信息进行识别分类。

在应用FCM算法时,有

本文聚类数

| $L(c) = \displaystyle\frac{{\displaystyle\sum\limits_{i = 1}^c {\displaystyle\sum\limits_{j = 1}^n { u_{ij}^m } } ||{p_i} - \overline x |{|^2}/(c - 1)}}{{\displaystyle\sum\limits_{i = 1}^c {\displaystyle\sum\limits_{j = 1}^n { u_{ij}^m ||{x_j} - {p_i}|{|^2}/(n - c)} } }}$ | (4) |

式中

但是在文中利用式(5)确定聚类数c并不可行,因为每一个缺陷我们有50组数据,但是对每一组数据来说都可能存在不同的最佳聚类数,这样就会导致构建的新特征向量维数不相同,也就无法作为神经网络的输入。以扩颈桩数据为例,第1、3组数据计算得到的

|

|

表 3 扩颈桩第1组数据不同聚类数

|

|

|

表 4 扩颈桩第3组数据不同聚类数

|

从表3我们可以看出,当

指数

利用模糊聚类算法对相空间重构后的矩阵进行聚类分析,对于同类的行向量合并,达到对重构的矩阵降维的效果;把降维后的矩阵再重构回一维特征向量,构建一种新的特征向量,实现对特征向量的选择。

3 实验仿真分析根据上述的新的特征向量的构建规则对基于信息熵的均值向量进行优化处理。步骤总结如下:

1)把基于信息熵的均值特征向量进行相空间重构;

2)利用FCM算法进行聚类分析;

3)根据分类结果构造聚类后的矩阵;

4)根据聚类后的矩阵生成新的特征向量。

由基于信息熵的均值向量的仿真实验结果可知,基于信息熵的均值向量共有52个特征元素,在末尾补2个零元素,首先设定

| ${{A}} = \left[ {\begin{array}{*{20}{c}} {{{34}}{{.59}}}&{{{35}}{{.57}}}&{{{34}}{{.18}}}&{{{33}}{{.88}}}&{{{34}}{{.58}}}&{{{34}}{{.46}}}&{{{34}}{{.42}}}&{{{34}}{{.58}}}&{{{35}}{{.68}}} \\ {35.78}&{36.09}&{34.73}&{34.53}&{33.72}&{33.76}&{34.26}&{35.27}&{34.64} \\ {35.58}&{33.89}&{35.27}&{35.14}&{36.23}&{34.39}&{35.18}&{36.37}&{35.76} \\ {35.13}&{34.26}&{33.82}&{33.73}&{34.69}&{34.49}&{33.95}&{36.24}&{35.53} \\ {35.53}&{32.25}&{35.40}&{35.97}&{35.71}&{34.45}&{34.45}&{35.37}&{36.10} \\ {36.56}&{35.66}&{29.20}&{20.98}&{14.17}&{10.31}&{1.10}&0&0 \end{array}} \right]$ | (5) |

对式(6)中的矩阵A进行模糊聚类算法处理,设定聚类数

| ${{U}} = \left[ {\begin{array}{*{20}{c}} {0.89}&{{{0}}{{.86}}}&{0.01}&{0.82}&{0.90}&{4.11 \times {{10}^{ - 12}}} \\ {5.80 \times {{10}^{ - 4}}}&{9.08 \times {{10}^{ - 4}}}&{2.16 \times {{10}^{ - 5}}}&{7.32 \times {{10}^{ - 4}}}&{5.64 \times {{10}^{ - 4}}}&{1.00} \\ {0.11}&{0.13}&{0.99}&{0.18}&{0.09}&{3.78 \times {{10}^{ - 12}}} \end{array}} \right]$ |

聚类结果如表5所示。

|

|

表 5 当聚类数为3时缩颈桩分类结果 |

根据分类结果,生成新的优化特征向量,并利用该向量进行基于BP神经网络的识别训练,同时输出为设定的如表6所示的网络编号。

|

|

表 6 缺陷类型以及相对应的网络编号 |

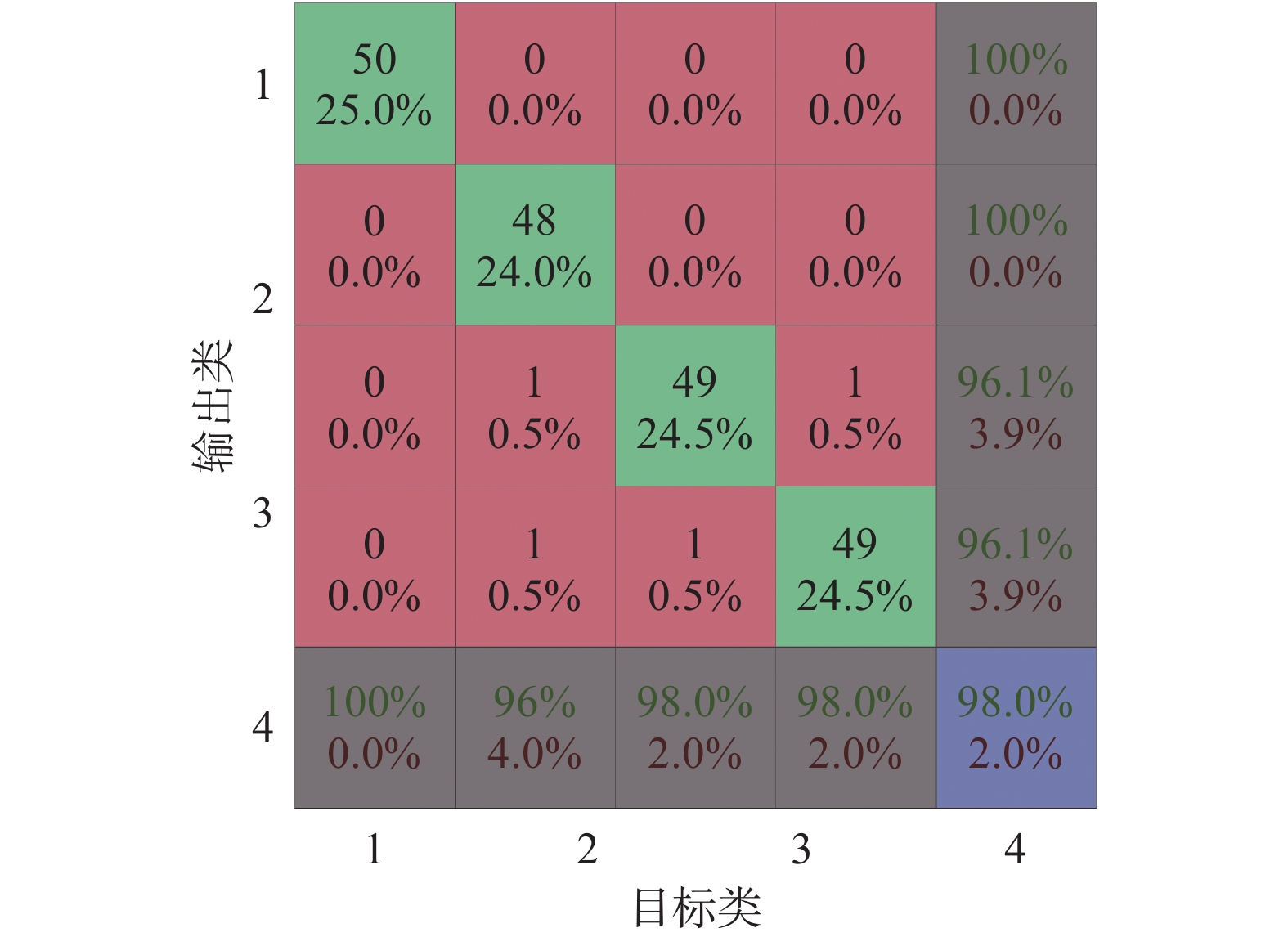

经过BP神经网络识别后,识别率与差错率如图2所示。

|

Download:

|

| 图 2 基于聚类数为3时的优化特征识别分类结果 | |

从图2的识别结果可以看出,基于模糊聚类处理的优化特征向量具有很好的识别结果,识别率达到了98%。然而单次的仿真实验具有一定的随意性,没有说服力。

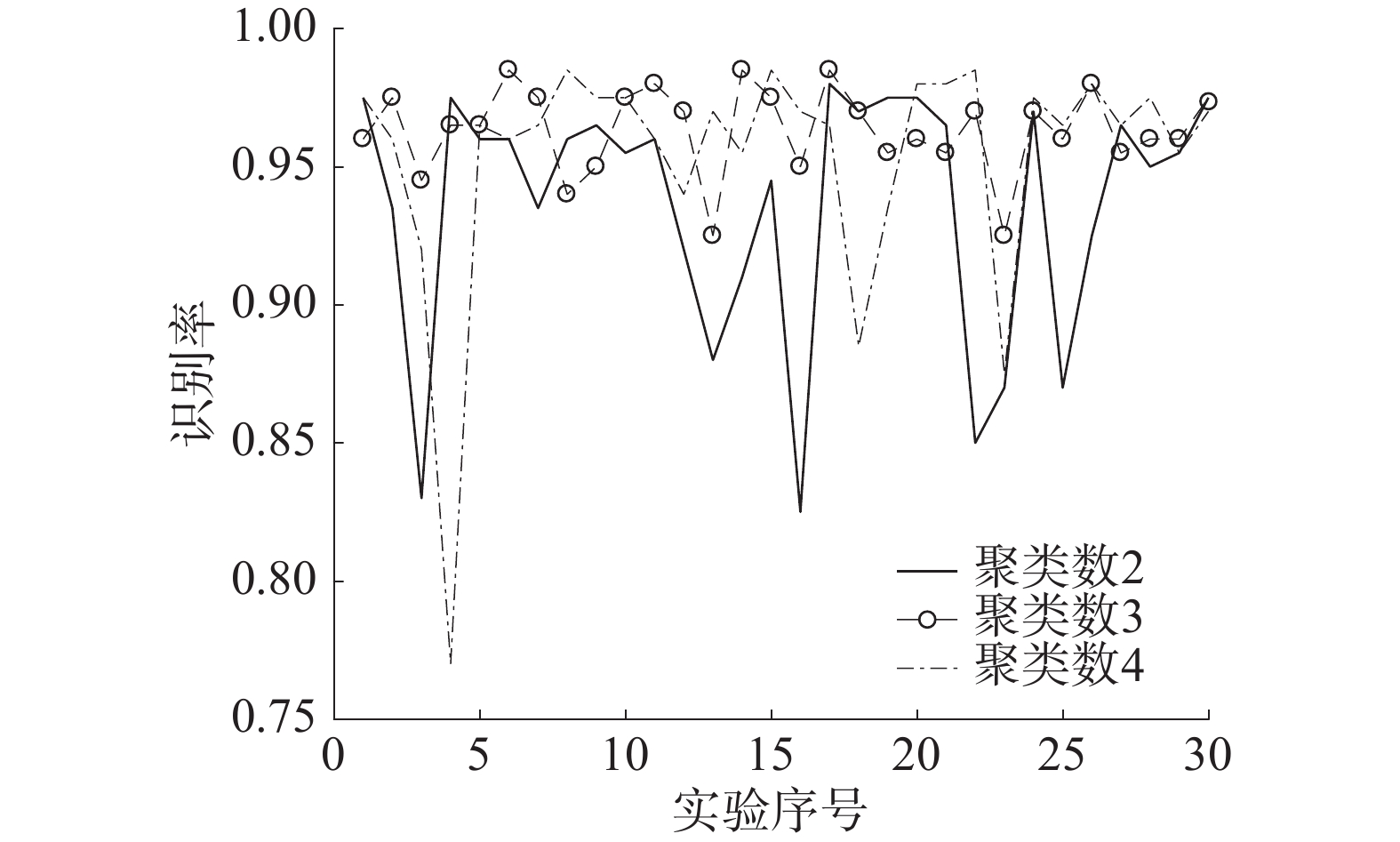

表7、图3为聚类数

|

|

表 7 不同聚类数下的识别率对比 |

|

Download:

|

| 图 3 30次仿真实验识别率对比 | |

从表7可以看出,在10、20、30次实验的情况下,聚类数为3时的识别率均高于当聚类数为2、4时的识别率;同时从图3可以看出,当聚类数为3时识别率最平稳,没有出现其他2种情况的大波动。

PCA降维是目前应用比较广泛的降维方法,本文对于2种算法在降维后,维数为3时的识别率和时间开销进行了分析,分析结果如表8所示。

|

|

表 8 模糊聚类与PCA方法降维后构建的特征识别分析 |

从表8可以看出,2种方法相比,基于模糊聚类构建的新特征取得的识别率明显高于PCA方法构建的特征,同时所消耗的时间显著缩短。因而基于模糊聚类方法降维显著地优于PCA降维。

4 结论本文主要解决桩基缺陷信号的特征提取、降维与识别。基于EMD分解构建了基于信息熵的均值特征向量;引入模糊聚类的相关技术方法,对基于信息熵的均值特征向量进行相空间重构然后进行降维,实现特征向量的降维选择。所取得的结论如下:1)通过30次仿真实验以及10次与PCA的对比实验验证了基于信息熵的均值特征向量以及基于模糊聚类构建的新特征向量取的了理想的识别效果;2)从识别率和稳定性2个方面考虑了不同聚类数对识别结果的影响,实验结果显示当聚类数为3时识别效果最好。

本文构建了一种有效的特征类型,具有实际的应用价值,但是在聚类数的选择中只能通过仿真实验获取,还需要进一步的研究。

| [1] |

ALI J B, FNAIECH N, SAIDI L, et al. Application of empirical mode decomposition and artificial neural network for automatic bearing fault diagnosis based on vibration signals[J]. Applied acoustics, 2015, 89: 16-27. DOI:10.1016/j.apacoust.2014.08.016 ( 0) 0)

|

| [2] |

刘明贵, 岳向红, 杨永波, 等. 基于Sym小波和BP神经网络的基桩缺陷智能化识别[J]. 岩石力学与工程学报, 2007, 26(S1): 3484. ( 0) 0)

|

| [3] |

何岭松, 李巍华. 用Morlet小波进行包络检波分析[J]. 振动工程学报, 2002, 15(1): 119-122. DOI:10.3969/j.issn.1004-4523.2002.01.025 ( 0) 0)

|

| [4] |

朱艳萍, 包文杰, 涂晓彤, 等. 改进的经验小波变换在滚动轴承故障诊断中的应用[J]. 噪声与振动控制, 2018, 38(1): 199-203. DOI:10.3969/j.issn.1006-1355.2018.01.039 ( 0) 0)

|

| [5] |

刘金朝, 丁夏完, 王成国. 自适应共振解调法及其在滚动轴承故障诊断中的应用[J]. 振动与冲击, 2007, 26(1): 38-41. DOI:10.3969/j.issn.1000-3835.2007.01.011 ( 0) 0)

|

| [6] |

王平, 廖明夫. 滚动轴承故障诊断的自适应共振解调技术[J]. 航空动力学报, 2005, 20(4): 606-612. DOI:10.3969/j.issn.1000-8055.2005.04.015 ( 0) 0)

|

| [7] |

邴智刚, 李威霖, 陈锋, 等. 基于虚拟仪器的旋转机械主轴故障在线监测系统研究[J]. 机电工程, 2016, 33(6): 722-726. ( 0) 0)

|

| [8] |

LI Zipeng, CHEN Jinglong, ZI Yanyang, et al. Independence-oriented VMD to identify fault feature for wheel set bearing fault diagnosis of high speed locomotive[J]. Mechanical systems and signal processing, 2017, 85: 512-529. DOI:10.1016/j.ymssp.2016.08.042 ( 0) 0)

|

| [9] |

张志刚, 石晓辉, 陈哲明, 等. 基于改进EMD与滑动峰态算法的滚动轴承故障特征提取[J]. 振动与冲击, 2012, 31(22): 80-83. DOI:10.3969/j.issn.1000-3835.2012.22.016 ( 0) 0)

|

| [10] |

DJEBALA A, BABOURI M K, OUELAA N. Rolling bearing fault detection using a hybrid method based on empirical mode decomposition and optimized wavelet multi-resolution analysis[J]. The international journal of advanced manufacturing technology, 2015, 79(9/10/11/12): 2093-2105. DOI:10.1007/s00170-015-6984-7 ( 0) 0)

|

| [11] |

SUN Zehang, BEBIS G, MILLER R. Object detection using feature subset selection[J]. Pattern recognition, 2004, 37(11): 2165-2176. DOI:10.1016/j.patcog.2004.03.013 ( 0) 0)

|

| [12] |

KARAMIZADEH S, ABDULLAH S M, ZAMANI M, et al. Pattern recognition techniques: studies on appropriate classifications[M]//SULAIMAN H, OTHMAN M, OTHMAN M, et al. Advanced Computer and Communication Engineering Technology. Cham: Springer, 2015: 791−799.

( 0) 0)

|

| [13] |

孟宗, 李姗姗, 王亚超. 基于LMD和局域时频熵的旋转机械故障诊断方法[J]. 计量学报, 2015, 36(1): 77-81. DOI:10.3969/j.issn.1000-1158.2015.01.17 ( 0) 0)

|

| [14] |

RUSPINI E H. A new approach to clustering[J]. Information and control, 1969, 15(1): 22-32. DOI:10.1016/S0019-9958(69)90591-9 ( 0) 0)

|

| [15] |

BEZDEK J C. Objective function clustering[M]//Pattern recognition with fuzzy objective function algorithms. Boston, MA: Springer, 1981: 43−93.

( 0) 0)

|

| [16] |

BEZDEK J C. A physical interpretation of fuzzy ISODATA[M]//DUBOIS D, PRADE H, YAGER R R. Readings in Fuzzy Sets for Intelligent Systems. San Francisco, USA: Morgan Kaufmann Pub, 1993: 615−616.

( 0) 0)

|

| [17] |

BEZDEK J C, HATHAWAY R J, SABIN M J, et al. Convergence theory for fuzzy c-means: counterexamples and repairs[J]. IEEE transactions on systems, man, and cybernetics, 1987, 17(5): 873-877. DOI:10.1109/TSMC.1987.6499296 ( 0) 0)

|

| [18] |

PAL N R, BEZDEK J C. On cluster validity for the fuzzy c-means model[J]. IEEE Transactions on fuzzy systems, 1995, 3(3): 370-379. DOI:10.1109/91.413225 ( 0) 0)

|

2019, Vol. 46

2019, Vol. 46