|

收稿日期: 2015-06-10; 修改日期: 2015-12-30;

优先数字出版日期: 2016-05-25

基金项目: 国家重点基础研究发展计划(973计划)(编号:2012CB719906);国家自然科学基金(编号:41201428);测绘遥感信息工程国家重点实验室开放研究基金项目(编号:13R01);地理国情监测国家测绘地理信息局重点实验室项目(编号:2014NGCM15);对地观测技术国家测绘地理信息局重点实验室开放基金项目(编号:K201504);中南大学中央高校基本科研业务费专项(编号:2014ZZTS250);交通运输部科技项目(编号:2009353-344-570);广东省交通运输厅科技项目(编号:2010-02-051)

第一作者简介:

陈杰(1980-),男,副教授,研究方向为遥感影像检索及场景理解。E-mail:cjcsu@163.com

中图分类号: TP701

文献标识码: A

文章编号: 1007-4619(2016)03-0397-12

|

摘要

从低层视觉特征与地物空间关系特征对影像内容进行描述,建立检索模板与目标影像间的相似性直方图表达,提出一种适用于高分辨率遥感影像检索的新方法。首先,利用Quin+树将大幅面原始遥感影像分解为一系列同尺寸的序列子块;然后,分别提取各子块的低层视觉特征与地物关系特征,并以子块为基元构建候选子块的特征直方图;最后,对比检索模板与候选子块间的特征直方图相似性,实现高分辨率遥感影像的检索。使用多幅多源高分辨率遥感影像进行实验,结果表明本文方法对耕地、水系、建筑物等地类的检索精度大都维持在0.8以上,且各项检索性能指标均优于已有的两种遥感图像检索算法。

关键词

遥感影像检索 , Quin+树 , 空间伴生关系 , 空间方位关系 , 直方图匹配

Abstract

Image retrieval is a key technology for data acquisition and knowledge transformation under the background of remote sensing data. Remote sensing images with high spatial resolution provide Object details and diverse structures of land features, thereby making differences in local visual feature as evident. Most existing retrieval methods represent and model image contents on the basis of low-level visual features of the image, leading to limited retrieval performance of high-resolution remote sensing image. This paper presents a novel retrieval method for high-spatial resolution remote sensing image; the proposed method utilizes abundant information about the spatial distribution and structure of land features. In the proposed method, data on low-level visual features and land-feature relations are utilized to represent the content of remote sensing images. Firstly, Quin+ tree is used to decompose the original large-sized image into a feature block sequence with a fixed size. Lowlevel visual features and land-feature relation descriptions are then extracted from the corresponding feature block. Feature histograms for candidate blocks are constructed according to the descriptions of the feature blocks. In each feature block, low-level visual information is represented using color and texture histograms. Moreover, land-feature spatial relation information is modeled as Object-direction and category co-occurrence histograms. Finally, the similarity between the query template and all candidate blocks is determined according to the feature histograms. Candidate blocks with high similarity values are selected as the final retrieval results. Several high-resolution remote sensing images of QuickBird and ZY-3 are used in the experiments to confirm the effectiveness of the proposed method. Based on the retrieval results of the proposed method, the average retrieval precision of water, farmland, buildings, and other categories are higher than 0.75. In addition, the proposed method is compared with two typical CBIR methods. Quantitative evaluation indicates that the proposed method yields optimal results. The proposed method can significantly improve the retrieval performance because it considers the description of space relationship information among different land features.

Key words

Remote sensing image retrieval , Quin+ tree , Spatial symbiotic relation , Spatial direction relation , Histogram matching

1 引言

对地观测技术的迅速发展使人类对地球的综合观测能力达到空前水平,对地观测卫星遥感数据日获取量近3 TB,人类已经迈入了遥感大数据时代(李德仁等,2014)。在此背景下,如何对海量影像数据进行高效的组织、管理和检索,进而满足用户对感兴趣影像的快速浏览和查询需求,成为限制当前遥感信息提取与共享技术发展的瓶颈和难题(程起敏,2004)。遥感影像检索技术作为缓解该瓶颈难题的有效技术之一,已受到广泛关注和研究(程起敏,2011)。

遥感影像检索技术脱胎于计算机领域的图像检索技术。早期的遥感影像检索主要参照数据查询模式以文档、关键词等文本描述的方式实现,但工作量大、效率低下而无法满足大规模的应用需求。遥感影像检索技术的研究,随着19世纪90年代基于内容图像检索技术CBIR(Content Based Image Retrieval)的出现而步入迅速发展时期(陆丽珍等,2004;Scott等,2005;万其明等,2010)。经过近20年的发展,研究者逐渐发现基于图像低层视觉特征(如颜色、纹理、形状等)的CBIR方法,实际性能往往受制于图像数据本身的视觉特征复杂程度。有研究表明,图像语义信息的引入可明显提高CBIR系统的智能性和精确度(Liu等,2007)。近年来,基于语义的图像检索SBIR(Semantic Based Image Retrieval)已逐渐成为图像检索领域的热门研究方向(李士进等,2010;Kang等,2011;Zhao等,2012),其中在遥感图像检索上代表性工作有:Liu等(2012)在分割结果基础上获取影像的语义信息的描述,然后通过EM算法建立语义、影像、分割区域之间的语义联系实现遥感影像的区域检索;Wang等(2013)以面向对象分类结果基础,通过对影像整体视觉特征和地物方位关系的描述实现一套完整的遥感影像检索系统;Dos Santos等(2013)提出基于多尺度分类结果的词袋特征尺度演化特性的遥感影像内容表达模型;Wang等(2013)基于概念领域模型对影像对象空间关系的描述,实现了两影像对象间简单场景的语义检索。

回顾遥感影像检索研究可以发现,现有方法大都仅从影像的低层视觉特征出发,对影像内容进行描述和建模,忽略了对遥感影像(尤其是高分辨率遥感影像)上地物空间分布信息的描述。事实上,随着遥感影像空间分辨率的提高,影像所能承载和表达的地物细节和结构更加丰富多样,使得影像局部视觉特征的差异性更加明显。因此,若直接采用基于低层视觉特征描述的检索方法用于高分辨率遥感影像检索,其性能将非常有限。基于上述分析,本文将以CBIR方法为基础,重点对高分辨率遥感影像的地物空间分布信息进行描述和建模,提出一种“按例查询”模式的高分辨率遥感影像新检索算法。在多幅QuickBird影像和资源3号影像上进行实验,以证实和比较所提检索方法的有效性。

2 方法原理

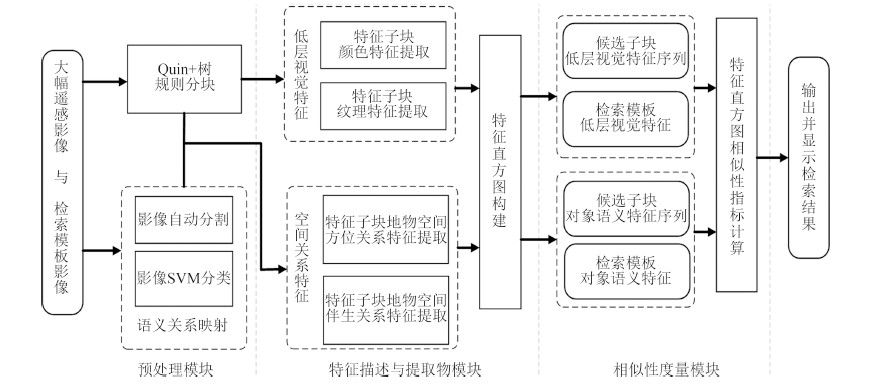

本文检索算法由预处理、特征描述与提取、相似性度量3大模块组成,如图 1所示。“预处理模块”主要用于实现大幅面目标影像和检索模版的自动分块,以及地物语义关系映射的建立。其中,影像数据的分块与组织将在2.1中详细介绍。在“特征描述与提取模块”中,将高分辨率遥感影像内容信息分为反映影像细节信息的视觉特征,与反映影像场景构成的地物空间关系两方面,并对这两类信息分别进行特征描述与提取,获取其相应特征向量并作归一化处理。在“相似度量模块”中,先分别对两类特征向量进行相似性度量,再以两类相似性指标的加权和来度量检索模板与候选子块间的总相似性,继而依据总相似性指标值降序排列输出较优检索结果。

2.1 影像分块组织

在使用检索模版对大幅面遥感影像进行检索前,需先将影像分解为多个局部影像块,以便于后续对检索模板与各局部影像块分别进行相似性计算。其中,分块规则的选择决定了大幅面影像分解后,局部影像块的数目以及各局部影像块间的重叠度。进而,它还会直接影响到检索检索算法的精度。目前,较常用的遥感影像分块技术有:Tile分块、Quad树、Quin树与Nona树等。Quin+树是李德仁和宁晓刚(2006)对Quin树提出的改进方法。该分块方法的第L级分解可获得${2^{2L+1}} - {2^L}+1$个影像子块,各级分解中各子块的平均块覆盖率和最小覆盖率分别为68.75%和50%,要明显高于Quad树的56.25%和25%、Quin树的63.5%和25%,与Nona树的76.56%和56.25%较为接近,且其前三级分块的冗余数据比率要比Nona树冗余数据比率分别低100%、150.05%和177.04%。对比可知,Quin+树是常用分块方法中平衡子块覆盖率与数据冗余比率间矛盾的最可行的方法,因此本文选用Quin+树对大幅面影像进行分块处理。

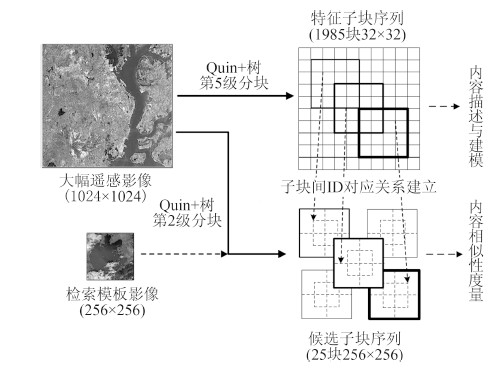

本文将所有经Quin+树规则分块处理后,直接用于影像内容特征描述和提取的影像子块统称为特征子块,其尺寸的选取与影像分辨率及子块内像元均质性有关;将所有与给定检索模板尺寸相同,直接用于与检索模板进行相似性度量和作为检索结果输出的影像子块统称为候选子块。图 2给出了一个在大小为1024×1024的大幅影像上使用尺寸为256×256的模板进行检索的影像分块和组织示意图。首先,大幅影像被分解为1985个32×32的特征子块;然后分别对各特征子块进行特征描述和提取;接着根据Quin+分块规则建立起25个尺寸为256×256的候选子块的ID与对应481个尺寸为32×32特征子块ID间的归属对应关系;并按照候选子块ID与特征子块ID间的对应关系,将每个候选子块内的影像内容用与之对应的481个特征子块的影像内容的组合来表达。通过将候选子块分解为特征子块并分别进行特征描述和提取,不仅可以明显减少特征统计的计算量,而且还能够将如颜色均值、方差等全局影像特征的统计范围限定在候选子块中尺寸较小的局部区域内,提高了这些全局图像特征对高分辨率遥感影像局部特征变化的捕捉能力,进而解决直接将这些全局特征应用于大尺寸遥感影像特征表达时,其特征表述能力普遍不强的问题。

2.2 视觉特征描述

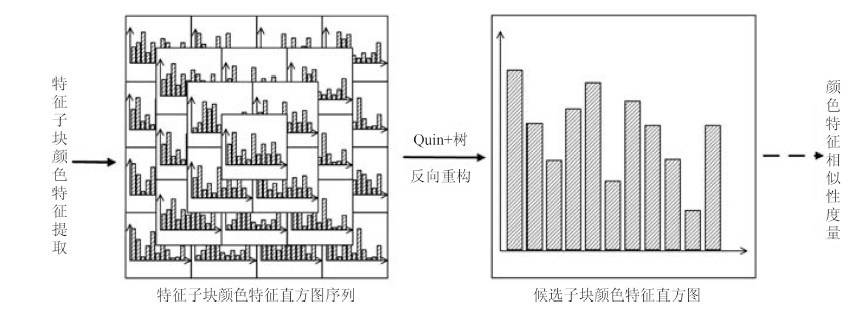

低层视觉特征是遥感影像最直观的可视化特征,被广泛应用于CBIR中(Deselaers等,2008)。其中,颜色与纹理是最常使用的两类视觉特征(Liu和Yang,2013;Akgül等,2011)。本文对每个特征子块分别提取颜色、纹理特征,并将相应特征向量分别表示成特征子块颜色、纹理直方图。为降低计算复杂度,根据Quin+规则将在同一候选子块内的所有特征子块的颜色、纹理直方图组合到候选子块上,即由此生成对应候选子块的颜色、纹理直方图。

分别计算特征子块内所有像元灰度值的均值${u_{{\rm{color}}}}$与灰度方差${\sigma _{{\rm{color}}}}$,作为描述该特征子块内颜色信息的特征统计量,记作${F_{{\rm{color}}}}=\left\{ {{u_{{\rm{color}}}},{\sigma _{{\rm{color}}}}} \right\}$。对于影像的纹理特征,本文采用2D Gabor对其进行纹理描述(万其明等,2010;Wang等,2013)。纹理提取过程如下式所示:

| $E(x,y)=I(x,y)\otimes h(x,y)$ | (1) |

| ${u_{{T_ - }k}}={{\sum\limits_{x=1}^n {\sum\limits_{y=1}^n {E(x,y)} } } \over {n \times n}}$ | (2) |

| ${\sigma _{{T_ - }k}}=\sqrt {{{{{\sum\limits_{x=1}^n {\sum\limits_{y=1}^n {\left[ {E(x,y)- {u_{{T_ - }k}}} \right]} } }^2}} \over {n \times n}}} $ | (3) |

式中,n为特征子块影像的行列数。其计算过程描述如下:首先,构建一组3个中心频率、4个主轴方向的12通道纹理滤波器h(x,y);然后,使用该组滤波器分别对特征子块影像I(x,y)进行空间卷积,在子块影像滤波器响应图E(x,y)上得到12维纹理特征向量;最后,将该特征向量所有通道上的平均响应值${u_{T - k}}$和方差${\sigma _{{T_ - }k}}$作为描述该特征子块的纹理特征统计量,记作${F_{{\rm{texture}}}}=\left\{ {({u_{T - k}},{\sigma _{T - k}})|k=1,2,3...12} \right\}$。

在完成对所有特征子块的颜色与纹理特征描述和建模后,按照2.1节中的数据组织要求,将特征子块的颜色和纹理特征直方图以逐bin累加的方式组合到对应候选子块上,并构建用于相似性度量的候选子块颜色、纹理直方图。如图 3所示,将特征子块颜色特征组合到对应候选子块并构建其颜色特征直方图。

2.3 地物空间关系描述

高分辨率的遥感影像上丰富的地物细节和结构信息,使得原本光谱相似的同类地物在实际影像上的视觉表现出明显差异,使得“同物异谱”现象十分普遍。因此,仅采用低层视觉特征将无法对高分辨率遥感影像承载的地物信息进行有效描述,这会直接导致该类方法在应用于高分辨率影像检索时性能欠佳。对此,在低层视觉特征描述基础上,本文加入对影像不同地物之间空间关系的描述,以改善高分辨率影像的检索性能。具体地,先采用面向对象的分割与分类方法引入地物语义对象,再通过描述语义对象的空间分布及其相互空间关系,实现对高分辨率遥感影像内容的较高层次表达。

2.3.1 语义对象构建

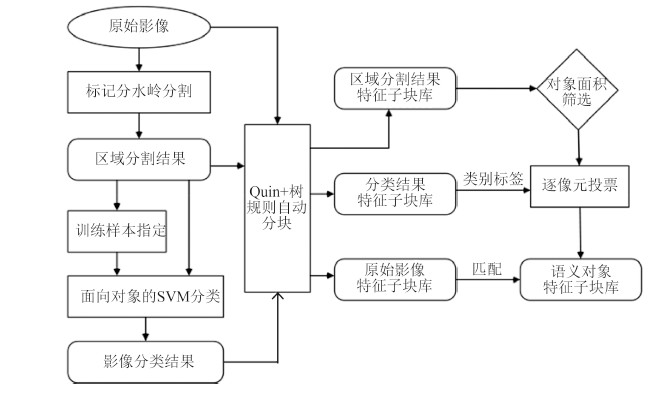

对影像分割所得图像对象赋予相应的地类语义标记,建立起影像对象与具体地物类别间的对应关系(Wang等,2013)。如图 4所示,影像对象的语义映射过程如下:

步骤1 用标记分水岭变换对原始影像进行分割获得图像对象(ENVI分割参数为Edge=50,Lamda=68);

步骤2 选取一定数量的图像对象作为训练样本。基于各样本对象的灰度、GLCM纹理特征,使用SVM方法(分类参数为σ=0.03,C=0.25)对所有图像对象进行分类;

步骤3 分别用Quin+规则将影像分割图与分类图分解为与特征子块同尺寸的分割子块和分类子块,再将分割子块、分类子块按子块空间位置与特征子块进行匹配;

步骤4 在任一特征子块范围内,遍历特征子块类所有占像素面积比(对象像素面积/特征子块总面积)在3%以上的对象,根据对应分类子块提供的类别标记,以逐像元投票的方式确定各区域对象的地物类别标记,并将其设为有效语义对象;

步骤5 重复步骤4直至遍历所有特征子块。

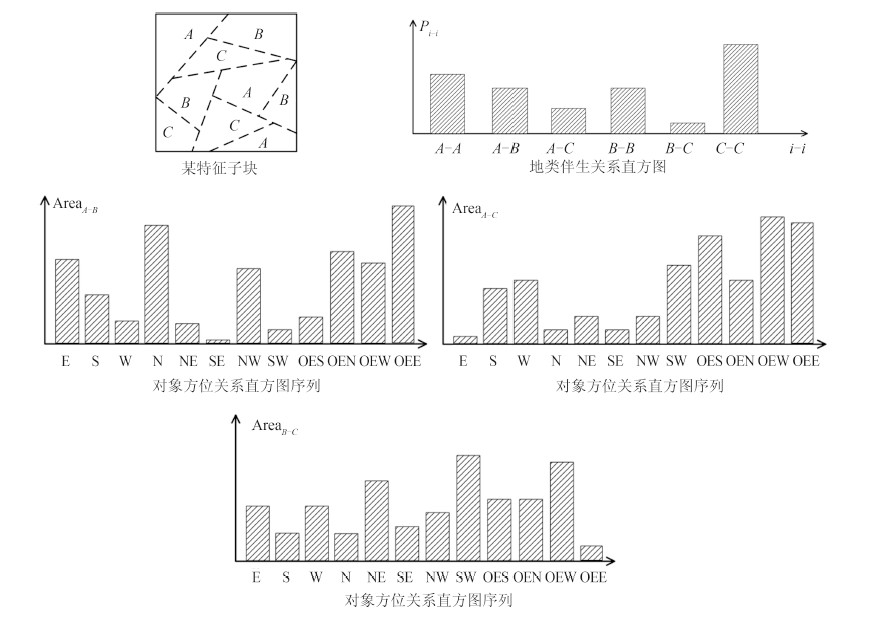

2.3.2 语义特征提取

在完成语义对象构建后,分别提取特征子块内语义对象的空间方位特征与地类伴生特征,作为特征子块内地物空间关系信息的描述,并分别表达为方位关系直方图与地类伴生关系直方图。图 5给出了在特征子块上分别提取对象语义特征的示意图。

(1) 语义对象方位关系直方图构建

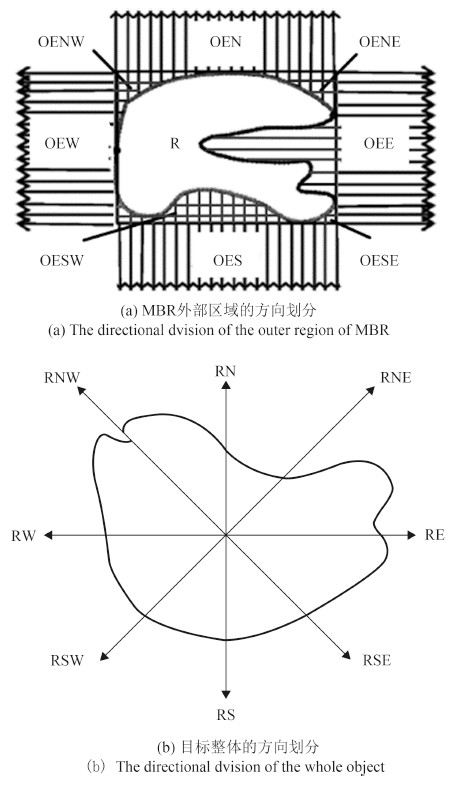

方位关系描述了地物在空间上的顺序和位置关系,是反映地物的空间结构和布局的基础,也是空间语义信息的重要部分(闫浩文和郭仁忠,2003)。因此,对影像中地物方位关系信息的描述,能显著提高影像“内容”对地物场景信息的表达能力。本文将特征子块内地物间复杂空间方位关系进行简化,表达成方位关系直方图${H_{{\rm{Direct}}}}=\left\{ {{H_i}|i=1,2{,_{}}{{...}_{}}n} \right\}$。如果特征子块内的语义对象分属K个地物类别,那么该特征子块内将有$C_k^2$种不同地物类型的两两组合(如图 5中的A-B、B-C等,)。因此,对应直方图序列HDirect将由$C_K^2$个子方位关系直方图组成,每一个子直方图Hi对应一种地类的组合。其中,各子方位关系直方图Hi的横轴中每个bin对应一个确定的空间方位(如E/W/S/N等,),即Hi横轴bins的总数目等于语义对象间可能存在的空间方位关系数目,纵轴为特征子块内对应地类组合下存在某空间方位关系时对应语义对象的像元面积累计值。

横轴bins数目与选用的语义对象空间方位关系描述模型的选择有关,目前常用的对象方位关系描述模型有2DString投影、Voronoi图、方向关系矩阵等模型。本文方法采用基于拓扑约束的方向关系描述模型DRBTRM(Direction Relation Based on Topological Reference Model)(唐雪华等,2014),对特征子块内语义对象间的空间方位关系进行描述。如图 6所示,DRBTRM根据目标对象与参考对象及其最小外接矩形MBR(Minimal Bounding Rectangle)间的拓扑关系,将参考对象周围空间划分为以下3个层次:(1)外部方位关系:描述参考对象与目标对象相距较远时的空间方位关系。其方向的划分方法与经典的九方向关系矩阵相同;(2)MBR外部方位关系:主要描述目标对象离参考对象距离较近,但未直接与参考对象相交,而仅与参考目标的MBR相交时的空间方位关系。如图 7(a)所示,该层次的方向片的定义与参考对象的边界有关;(3)目标整体方位关系,主要描述当目标对象与参考对象直接相交时的空间方位关系,此时方向片的定义由参考对象自身的中心参考点位置决定。

由于特征子块内的语义对象实质上是由影像分割生成的区域对象,特征子块中不存在对象与对象拓扑相交的情况。因而,在语义对象方位关系描述时,只需考虑DRBTRM的前两层方位关系。为了简化计算,在计算DRBTRM的MBR外部方位关系时,仅考虑OEE、OES、OEW和OEN4个主方向,而复合方向不作考虑。因此,特征子块内任意一种地物组合的两语义对象间,只有12种可能的空间方位关系,即本文中每个子方位关系直方图的横轴将有12个bin,分别对应图 6、7中的E、S、W、N、NE、SE、NW、SW、OES、OEN、OEW和OEE区域。

(2) 语义对象地类伴生关系直方图构建

为进一步细化“内容”对高分辨遥感影像中地物场景的描述,对特征子块内两种地类(包括同类,如耕地-耕地、耕地-水系等)在空间上相互伴生出现的规律信息进行统计和描述,并将其表达成一个语义对象地类伴生特征直方图HCoOc。该直方图的横轴每一个bin对应该特征子块内两种地类伴生的组合。若某特征子块内的语义对象分属K个地物类别,那么该子块内将有$C_{K+1}^2$种地物类别两两组合,即该特征子块HCoOc的横轴将有$C_{K+1}^2$个bins。而HCoOc的纵轴为该子块内各地类组合伴生出现的频数Pi-j。

在任一子块内地物类别A与地物类别B的伴生关系可用这两种地物类别的语义对象在同一子块内同时出现的频次来表示。若用${S_{{A_i}}}$表示地类A的语义对象i的像素面积,${S_{{B_j}}}$为地类B的语义对象j的像素面积,ST为特征子块的总像素面积,那么任意地类B的某语义对象j伴生于地类A的语义对象i的伴生面积${S_{{A_i} - {B_j}}}$可表示为语义对象i的像素面积${S_{{A_i}}}$与除自身以外特征子块剩余像素面积$({S_T} - {S_{{A_i}}})$的比值,再乘以语义对象j的像素面积${S_{{B_j}}}$,即${S_{{A_i} - {B_j}}}=[{S_{{A_i}}}/({S_T} - {S_{{A_i}}})]{S_{{B_j}}}$;该语义对象j伴生于语义对象i的伴生频数可以表示为其伴生面积${S_{{A_i} - {B_j}}}$与特征子块总面积ST的比值,即${P_{{A_i} - {B_j}}}={S_{{A_i} - {B_j}}}/{S_T}$;该特征子块内地类B伴生于地类A的总伴生频数PA-B可表示为地类B所有语义对象分别伴生于地类A的各语义对象的伴生频数${P_{{A_i} - {B_j}}}$的总和,即

| ${P_{A-B}}=\sum\limits_{i=1}^m {\sum\limits_{j=1}^n {{P_{{A_i} - {B_j}}}} } $ | (4) |

式中,m、n分别对应特征子块中地类A、B的语义对象数目。而地类A与地类B的相互伴生关系的频数PA-B可以用地类A伴生与地类B的伴生频数PA-B与地类B伴生于地类A的伴生频数PB-A的均值表示。因此,任意特征子块内地物类别A与B的伴生频数PA-B最终可用如下公式计算:

| ${P_{A-B}}={1 \over {2{S_T}}}\sum\limits_{i=1}^m {\sum\limits_{j=1}^n {\left[ {{S_{{A_i}}}{S_{{B_j}}}\left({{1 \over {{S_T} - {S_{{A_i}}}}}+{1 \over {{S_T} - {S_{{B_j}}}}}} \right)} \right]} } $ | (5) |

在完成所有特征子块的对象语义特征提取后,与前文类似,需要将特征子块的方位关系直方图序列与地类伴生关系直方图按照地类对(如耕地-水系或水系-建筑等)分别以逐bin累加的方式组合到对应的候选子块上,并构建相应的对象语义特征直方图。

2.4 相似性度量

CBIR中常用的相似性度量方法有直方图求交、欧氏距离、相关系数、K-L散度、卡方距离等(冯德瀛,2013)。根据包倩和郭平(2007)对常见影像相似性度量模型的对比实验结果可知,当影像特征用频数直方图表达时,使用直方图求交和卡方距离度量模型进行相似性度量的检索结果较为稳定。本文采用直方图求交方式对影像内容的相似性进行度量,其计算公式如下

| $Si{m_F}\left({Q,{I_B}} \right)= \sum\limits_{i = 0}^L {\min \left[ {H_Q^F(i),H_{{I_B}}^F(i)} \right]} {\rm{ /}}\sum\limits_{i = 0}^L {H_Q^F(i)} $ | (6) |

式中,$H_Q^F(i)$与$H_{{I_B}}^F(i)$分别为检索模板影像Q与候选子块IB对应各特征F(Color,Texture,Direct,CoOc)经归一化处理后的特征直方图,L为对应直方图的量化级数。

检索模板影像Q与影像数据库中任一候选子块IB间的“内容”总相似性SIM(Q,IB),可定义为它们间低层视觉特征相似性SimVis(Q,IB)与对象语义特征相似性SimObj(Q,IB)的加权之和。其中,SimVis(Q,IB)与SimObj(Q,IB)又可以分别表示为颜色特征相似性SimColor(Q,IB)与纹理特征相似性SimTexture(Q,IB)的加权之和,以及语义对象方位关系特征相似性SimDirect(Q,IB)与地类伴生关系特征相似性SimCoOc(Q,IB)的加权之和,具体计算公式为

| $SIM\left({Q,{I_B}} \right)={u_{Vis}}Si{m_{Vis}}\left({Q,{I_B}} \right)+{u_{obj}}Si{m_{Obj}}\left({Q,{I_B}} \right)$ | (7) |

| $Si{m_{Vis}}\left({Q,{I_B}} \right)={u_{{\rm{Color}}}}Si{m_{{\rm{Color}}}}\left({Q,{I_B}} \right)+{u_{{\rm{Texture}}}}Si{m_{{\rm{Texture}}}}\left({Q,{I_B}} \right)$ | (8) |

| $Si{m_{Obj}}\left({Q,{I_B}} \right)={u_{{\rm{Direct}}}}Si{m_{{\rm{Direct}}}}\left({Q,{I_B}} \right)+{u_{{\rm{CoOc}}}}Si{m_{{\rm{CoOc}}}}\left({Q,{I_B}} \right)$ | (9) |

式中,uVis、uobj、uColor、uTexture、uDirect、uCoOc分别为低层视觉特征、对象语义特征、颜色特征、纹理特征、语义对象方位关系特征以及地物伴生关系特征相似性的对应权重。它们之间存在如下关系:uVis+uobj=1,uColor+uTexture=1和uDirect+uCoOc=1。本文经多次重复试验将上述权值分别确定为:(uVis=0.3,uObj=0,7)、(uColor=0.45,uTexture=0.55)、(uDirect=0.5,uCoOc=0.5)。

在影像检索时,相似性度量模块利用式(6)分别计算模板影像Q与各候选子块$I_B^{(k)}$间的$Si{m_{{\rm{Color}}}}(Q,I_B^{(k)})$、$Si{m_{{\rm{Texture}}}}(Q,I_B^{(k)})$、$Si{m_{{\rm{Direct}}}}(Q,I_B^{(k)})$和$Si{m_{{\rm{CoOc}}}}(Q,I_B^{(k)})$,并分别按照式(7)、(8)、(9)加权求和,得到模板Q与各候选子块间的$Si{m_{Vis}}(Q,I_B^{(k)})$与$Si{m_{Obj}}(Q,I_B^{(k)})$以及总相似性指标$SIM(Q,I_B^{(k)})$。最后,将所有候选子块影像按其总相似性$SIM(Q,I_B^{(k)})$大小降序排列并输出。

3 结果及分析

3.1 实验数据

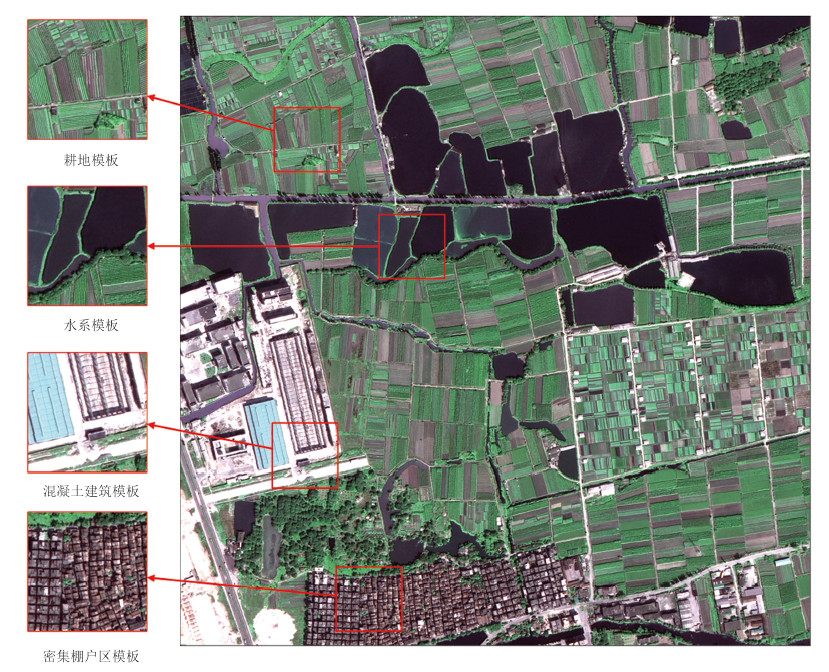

本文在Matlab7.1环境下采用多幅不同尺寸的QuickBird与ZY-3影像数据进行对比实验。其中,空间分辨率为0.61 m的QuickBird三波段真彩色影像3幅,尺寸分别为2048×2048(A)、2048×2048(B)和1024×1024(C),2004年摄于东莞市市郊;空间分辨率为6 m的ZY-3真彩色影像2幅(D、E),尺寸都为1024×1024,2013年摄于长沙市市郊。分别从上述大幅面影像上截取统一尺寸(QuickBird为256×256,ZY-3为128×128)的耕地、水系、混凝土建筑区等典型地物检索模板各8块。图 8展示了实验中采用的QuickBird影像A及部分检索模板。

3.2 实验结果

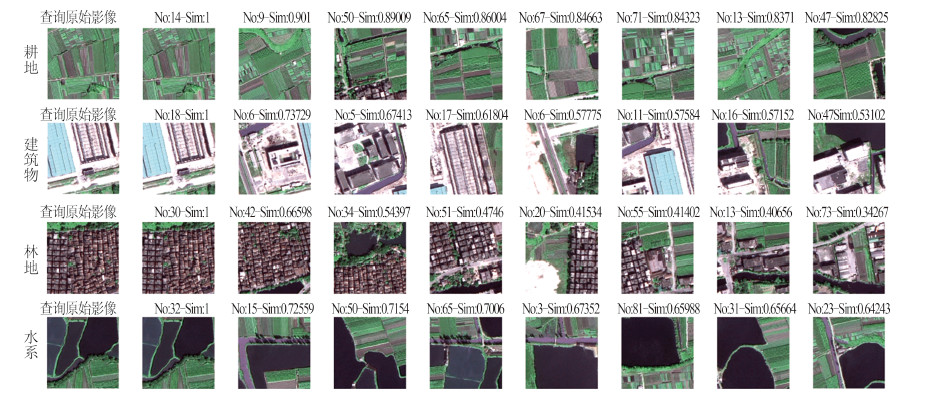

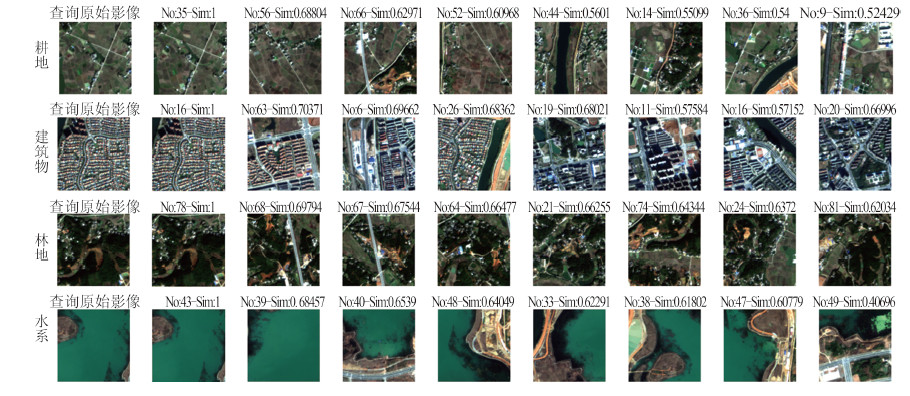

为了验证本文方法的有效性,在上述5幅真实高分辨率遥感影像上分别进行多组检索实验(即实验1)。受篇幅所限,此处仅给出在影像A(图 9)和影像D(图 10)上对耕地、水系、建筑物等地物类型进行检索的实验结果。

图 8和图 9中,每一行对应一种地物类型的检索。其中,每一行的第1列为输入的检索模版,第2至9列分别为与检索模版相似性较高的前8幅候选子块(包括子块ID、总相似性指标值以及子块影像)。由检索结果直观比较可知,本文方法能够实现在大幅面QuickBird和ZY-3影像中对耕地、建筑物、水系等典型地物的有效检索。

为了定量评价本文方法的实际检索性能,实验采用CBIR技术中被广泛应用的性能评价准则——查准率P和查全率R(李晓丽,2010)为评价指标,即

| $$ \left\{ {\begin{array}{*{20}{l}} {P = \frac{m}{N} \times 100\% }\\ {R = \frac{m}{M} \times 100\% } \end{array}} \right. $$ | (10) |

式中,N为一次检索实验返回的影像个数,M为数据库中与检索模板相似的影像总数,m为一次检索实验返回结果中与检索模板相似的影像个数。表 1为实验一中各地类模板在五幅目标影像中各进行3次重复实验的平均检索精度$(\bar P,\bar R)$统计情况。

表 1 三种地类检索实验平均检索精度

Table 1 Average retrieval accuracy for the different templates

| 影像来源 | 影像序号 | 特征子块尺寸 | 候选子块尺寸 | 输出数目N | 耕地模板 | 水系模板 | 建筑物模板 | |||

| 平均查准率/(%) | 平均查全率/(%) | 平均查准率/(%) | 平均查全率/(%) | 平均查准率/(%) | 平均查全率/(%) | |||||

| QuickBird | A | 32×32 | 256×256 | 20 | 93.7 | 8.70 | 95.2 | 15.5 | 93.6 | 21.6 |

| B | 32×32 | 256×256 | 20 | 83.3 | 29.2 | 83.3 | 27.0 | 92.9 | 36.1 | |

| C | 32×32 | 256×256 | 11 | 94.5 | 28.3 | 75.0 | 53.0 | 94.4 | 28.3 | |

| ZY-3 | D | 32×32 | 128×128 | 11 | 94.4 | 27.6 | 94.4 | 31.5 | 97.2 | 22.9 |

| E | 16×16 | 128×128 | 11 | 87.5 | 30.9 | 91.7 | 25.0 | 97.2 | 18.0 | |

由上表数据可知,实验一中各组影像对各地类检索的平均查准率$\bar P$均超过了75%,且大部分维持在90%以上,表明本文方法能够实现对各组实验影像中对耕地、水系、建筑物等地类的有效检索。同时比较五组不同影像的实验结果数据可知,本文方法在不同目标影像上对同类地物检索的平均精度相近,这说明它对不同的数据源、分辨率、图幅大小等影像的检索具有一定的稳定性。由式(10)可知,在单次检索中,当输出影像数目N固定时,检索结果的查全率R和查准率P间存在如下关系:R=PN/M,即对于某一给定目标影像,其检索结果的查全率与查准率成正比关系,当P=100%时,检索结果的查全率达到理想值$\overset{\lower0.5em\hbox{$\smash{\scriptscriptstyle\frown}$}}{R}=N/M$。以表 1中影像A为例,耕地模板的实际平均查准率Pr=93.7%,实际平均查全率Rr=8.70%,根据上述查准率与查全率的关系有:Pr/Rr=N/M=$\overset{\lower0.5em\hbox{$\smash{\scriptscriptstyle\frown}$}}{R}$=9.29%,即影像A中耕地模板检索的平均查全率理想值为9.29%。同理对比可知,上表中各实验的平均查全率实际上是十分接近各自理想值的。

为进一步了解本文检索方法的实际性能,将本文方法与另两种遥感影像检索方法进行对比(实验2)。两种方法分别为:陆丽珍等(2004)提出的融合颜色和纹理特征的遥感影像检索方法,它是典型的基于低层视觉的CBIR检索方法(简称为CCT方法);Kang等(2011)提出的基于局部不变特征的影像检索方法,它将影像内容表达成一系列具有明显抽象语义信息的视觉单词(Bag of Words,BoW),属于典型的基于语义的影像检索方法(简称为BoW方法)。考虑到BoW方法中码本尺寸对检索性能有直接影响,在此对比实验中对码本尺寸为100、200、300和400的BoW方法均分别进行实验。

实验2是分别在影像B、D上对上述3种方法进行对比实验的。为了避免实验受偶然因素影响,针对每幅影像分别使用3种不同地类检索模板,各进行3次重复实验取其平均精度$(\bar P,\bar R)$。相应实验结果的统计于表 2,受篇幅所限,具体检索影像结果不作展示。

表 2 实验2不同方法实验结果的平均检索精度对比

Table 2 Accuracy comparison for the different retrieval methods in experiment 2

| 算法类型 | 影像 序号 | 检索耗时 (秒秒) | 输出数目N | 耕地模板 | 水系模板 | 建筑物模板 | |||

| 平均查 准率/(%) | 平均查全率/(%) | 平均查准率/(%) | 平均查全率/(%) | 平均查准率/(%) | 平均查全率/(%) | ||||

| 本文算法 | B | 2.060.02 | 20 | 83.3 | 29.2 | 83.3 | 27.0 | 92.9 | 36.1 |

| D | 0.710.01 | 11 | 94.4 | 27.6 | 94.4 | 31.5 | 97.2 | 22.9 | |

| CCT方法 | B | 1.600.02 | 20 | 57.3 | 22.5 | 56.3 | 23.2 | 70.0 | 26.0 |

| D | 0.510.01 | 11 | 58.3 | 17.1 | 52.8 | 12.4 | 37.5 | 11.5 | |

| BoW-100 | B | 1.851.06 | 20 | 70.0 | 22.2 | 38.8 | 21.5 | 40.0 | 21.5 |

| D | 0.670.19 | 11 | 58.0 | 15.6 | 60.2 | 18.4 | 43.2 | 9.30 | |

| BoW-200 | B | 1.861.05 | 20 | 65.6 | 20.8 | 36.9 | 20.5 | 42.1 | 33.7 |

| D | 0.680.19 | 11 | 50.0 | 13.4 | 59.1 | 18.1 | 51.1 | 11.0 | |

| BoW-300 | B | 1.921.10 | 20 | 82.5 | 26.2 | 62.5 | 34.7 | 40.7 | 32.6 |

| D | 0.690.19 | 11 | 52.3 | 14.0 | 63.6 | 19.4 | 51.1 | 11.0 | |

| BoW-400 | B | 2.001.13 | 20 | 70.0 | 22.2 | 42.5 | 23.6 | 29.3 | 23.4 |

| D | 0.700.19 | 11 | 53.4 | 14.3 | 59.1 | 18.1 | 48.9 | 10.5 | |

| 注:上表中给出的检索耗时是使用10幅不同检索模板进行重复试验计算得到的统计值。此处统计的检索耗时仅指进行检索实验中从给定检索模板开始至系统输出相应检索结果过程的总耗时,因此影像分块、BoW码本构建等可在检索前预先完成的过程的耗时均未统计。 | |||||||||

对实验2的结果进行对比可见,本文方法在各目标影像上的检索精度指标均明显优于CCT方法和BoW方法。仔细分析各组实验结果,可得出以下结论:

(1) 在CCT方法的低层视觉特征的基础上,增加对影像中地物关系的描述可明显提高算法对高分辨影像的检索性能。

(2) 本文采用的地物空间关系信息对高分辨遥感影像的语义描述能力,要明显要强于基于SIFT特征构建的BoW方法。

(3) BoW方法的检索性能要整体优于CCT方法,该结果与SIFT et al,局部特征对影像信息的描述能力,要强于颜色、纹理等低层视觉特征的事实基本一致。

(4) 本文方法的平均检索耗时要比CCT方法约高出35%,这主要是由于本文方法在影像内容描述时,在CCT方法基础上增加了对地物关系的描述引起的。

本文方法的平均检索耗时,在各组实验影像上均与BoW方法的平均耗时相当,但BoW方法在不同检索模板的试验中,其检索耗时波动明显(标准差达到1.13 s),而本文方法在不同模板的实验上检索耗时却相对平稳。引起该现象的主要原因是:不同检索模板中,可提取的SIFT特征点数目差异较大,因此导致BoW方法在不同模板上,提取其视觉单词分布特征所消耗的时间有明显差异,进而影响到该类方法检索耗时。

综上所述,在遥感影像内容描述中添加地物空间关系描述,对于高分辨率遥感影像检索效果的提升具有明显积极作用。

4 结论

本文提出了一种面向高分辨率遥感影像的自动检索方法。该方法从高分辨遥感影像特点出发,充分利用了低层视觉特征与地物空间关系两方面影像内容信息,既考虑了经典视觉特征对影像整体和细节信息的描述,又顾及了面向对象方法在影像内容空间特征表达上的优势。研究结果表明,结合低层视觉与地物关系特征描述的检索算法,能够实现对QuickBird、ZY-3等高分辨率遥感影像的有效检索。本文方法的特点是充分利用了地物对象及对象空间关系。对比实验结果表明,该方法可适用于空间分辨率较高的遥感图像检索,这为进一步提高CBIR技术在遥感领域的应用提供一定参考。

今后将尝试在现有地物关系特征描述的基础上,增加对高分辨率遥感影像复杂地物场景信息的语义描述,以进一步提升检索准确度。

参考文献(References)

-

Akgül C B, Rubin D L, Napel S, Beaulieu C F, Greenspan H, Acar B.2011.Content-based image retrieval in radiology:current status and future directions. Journal of Digital Imaging, 24 (2) : 208–222 . [DOI:10.1007/s10278-010-9290-9]

-

Bao Q, Guo P.2007.Comparative studies on similarity measures for remote sensing image retrieval based on histogram. Journal of Remote Sensing, 10 (6) : 893–900 . [DOI:10.3321/j.issn:1007-4619.2006.06.010] ( 包倩, 郭平. 2007. 基于直方图的遥感图像相似性检索方法比较. 遥感学报, 10 (6) : 893–900. [DOI:10.3321/j.issn:1007-4619.2006.06.010] )

-

Cheng Q M. 2004. Research on Key Technologies for Content-based Retrieval from Remote Sensing Image Database. Beijing:Chinese Academy of Sciences:3-25

-

Cheng Q M. Remote Sensing Image Retrieval Technologies. Wuhan : Wuhan University Press 2011 : 1 -27. ( 程起敏. 2011. 遥感图像检索技术. 武汉 : 武汉大学出版社 : 1 -27. )

-

Deselaers T, Keysers D, Ney H.2008.Features for image retrieval:an experimental comparison. Information Retrieval, 11 (2) : 77–107 . [DOI:10.1007/s10791-007-9039-3]

-

Dos Santos J A, Gosselin P H, Philipp-Foliguet S, Torres R D S , Falcao A X.2013.Interactive multiscale classification of high-resolution remote sensing images. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 6 (4) : 2020–2034 . [DOI:10.1109/JSTARS.2012.2237013]

-

Feng D Y. 2013. Similarity Search Methods for Image Retrieval. Shanghai:Shanghai Jiaotong University:18-40

-

Kang L W, Hsu C Y, Chen H W, Lu C S, Lin C Y, Pei S C.2011.Feature-based sparse representation for image similarity assessment. IEEE Transactions on Multimedia, 13 (5) : 1019–1030 . [DOI:10.1109/TMM.2011.2159197]

-

Li D R, Ning X G.2006.A new image decomposition method for content-based remote sensing image retrieval. Geomatics and Information Science of Wuhan University, 31 (8) : 659–662 . [DOI:10.3321/j.issn:1671-8860.2006.08.001] ( 李德仁, 宁晓刚. 2006. 一种新的基于内容遥感图像检索的图像分块策略. 武汉大学学报(信息科学版), 31 (8) : 659–662. [DOI:10.3321/j.issn:1671-8860.2006.08.001] )

-

Li D R, Zhang L P, Xia G S.2014.Automatic analysis and mining of remote sensing big data. Acta Geodaetica et Cartographica Sinica, 43 (12) : 1211–1216 . ( 李德仁, 张良培, 夏桂松. 2014. 遥感大数据自动分析与数据挖掘. 测绘学报, 43 (12) : 1211–1216. )

-

Li S J, Tao J, Wan D S, Feng J.2010.Content-based remote sensing image retrieval using co-training of multiple classifiers. Journal of Remote Sensing, 14 (3) : 493–506 . ( 李士进, 陶剑, 万定生, 冯钧. 2010. 多分类器实例协同训练遥感图像检索. 遥感学报, 14 (3) : 493–506. )

-

Li X L. 2010. Study on the Evaluation Index System for CBIR Systems from Users' Perspective. Shanghai:Shanghai Jiaotong University:23-36

-

Liu G H, Yang J Y.2013.Content-based image retrieval using color difference histogram. Pattern Recognition, 46 (1) : 188–198 . [DOI:10.1016/j.patcog.2012.06.001]

-

Liu T T, Zhang L P, Li P X, Lin H.2012.Remotely sensed image retrieval based on region-level semantic mining. EURASIP Journal on Image and Video Processing, 2012 : 4 [DOI:10.1186/1687-5281-2012-4]

-

Liu Y, Zhang D S, Lu G J, Ma W Y.2007.A survey of content-based image retrieval with high-level semantics. Pattern Recognition, 40 (1) : 262–282 . [DOI:10.1016/j.patcog.2006.04.045]

-

Lu L Z, Liu R Y, Liu N.2004.Remote sensing image retrieval using color and texture fused features. Journal of Image and Graphics, 9 (3) : 328–333 . ( 陆丽珍, 刘仁义, 刘南. 2004. 一种融合颜色和纹理特征的遥感图像检索方法. 中国图象图形学报, 9 (3) : 328–333. )

-

Scott G, Klaric M and Shyu C. 2005. Modeling multi-Object spatial relationships for satellite image database indexing and retrieval//Proceedings of the 4th International Conference on Image and Video Retrieval. Singapore:Springer:247-256 [DOI:10.1007/11526346_28]

-

Tang X H, Qin K, Meng L K.2014.A qualitative matrix model of direction-relation based on topological reference. Acta Geodaetica et Cartographica Sinica, 43 (4) : 396–403 . ( 唐雪华, 秦昆, 孟令奎. 2014. 基于拓扑约束的方向关系定性描述模型. 测绘学报, 43 (4) : 396–403. )

-

万 其明, 汪 闽, 张 星月, 蒋 圣, 谢 玉林.2010.基于五叉树分解与多特征直方图匹配的高分辨遥感图像检索. 地球信息科学学报, 12 (2) : 275–281 . [DOI:10.3724/SP.J.1047.2010.00275]

-

Wang M, Wan Q M, Gu L B, Song T Y.2013.Remote-sensing image retrieval by combining image visual and semantic features. International Journal of Remote Sensing, 34 (12) : 4200–4223 . [DOI:10.1080/01431161.2013.774098]

-

Yan H W, Guo R Z.2003.Research on formal description model of directional relationships. Acta Geodaetica et Cartographica Sinica, 32 (1) : 42–46 . ( 闫浩文, 郭仁忠. 2003. 空间方向关系形式化描述模型研究. 测绘学报, 32 (1) : 42–46. )

-

Zhao L J, Tang J K, Yu X J, Li Y Z, Mi S J and Zhang C W. 2012. Content-based remote sensing image retrieval using image multi-feature combination and SVM-based relevance feedback//Recent Advances in Computer Science and Information Engineering. Berlin Heidelberg:Springer:761-767[DOI:10.1007/978-3-642-25781-0_112]