2. 上海无线电设备研究所,上海 200090;

3. 杭州海康威视数字技术股份有限公司,浙江 杭州 310052

2. Shanghai Radio Equipment Research Institute, Shanghai 200090, China;

3. Hangzhou Hikvision Digital Technology Co., Ltd., Hangzhou 310052, China

以多旋翼为主的低空小型无人机已广泛应用于环境监测、电力巡查、农业植保、影像航拍、摄影测量、5G移动基站[1]等工业、军事、民用领域,在其市场快速增长的同时,无人机的“黑飞”与“滥飞”也对个人隐私及公共安全产生了严重的威胁和挑战[2]。无人机防控不仅是城市安全和隐私保护的问题,更是关系到国家安全与形象的大事,因此迫切需要研发一整套完整有效的技术手段以实现对低空飞行器的监测和防控。

Shi等[3]对反无人机监控手段进行详细的介绍和对比,反无人机监测主要有雷达、射频、音频及视觉探测4种方式,4种方式各有优劣。雷达探测通过无人机反射的回波测量无人机的速度、方位,但雷达成本高、辐射大、易受地面杂波影响,不适用于城市环境;射频探测利用无人机与遥控器之间的通信或图传信号对无人机进行检测与定位,但射频天线成本较高,检测受无人机通信协议限制;音频探测利用麦克风阵列对无人机旋翼发出的声音进行检测与定位,但作用距离较短,且易受环境噪声和多径效应影响。视觉检测利用摄像机获取监控区域的视频,利用图像特征进行无人机检测与跟踪。由于视觉监测方式成本低、普适性强、检测距离较远且能直观显示检测结果,已成为反无人机监测领域研究的热点。

目标检测是计算机视觉最基础的任务之一,自计算机视觉诞生以来,一直是学术界研究的重点领域。视觉目标检测算法可分为传统目标检测算法和深度学习目标检测算法。传统目标检测算法通常使用滑动窗口生成大量候选区域,然后在提取其人工设计特征后使用机器学习算法对目标进行检测与识别,但这些方法检测效率低下,且对复杂背景中形态多样、姿态多变的目标检测效果不佳[4-5]。

随着图形处理器(graphics processing unit, GPU)并行计算技术的快速发展与深度学习算法的兴起,基于深度学习的目标检测算法发展迅速,其主要可以分为一阶段和二阶段目标检测算法。一阶段深度学习目标检测将图像中的所有位置均视作潜在目标,通过神经网络直接产生目标的类别与位置,检测速较快,但精度相对于二阶段目标检测算法略有不如,代表算法有基于 anchor机制的YOLO(you only look once)系列算法[6]、SSD(single shot multibox detector)算法[7]和基于特征点的CornerNet[8]、CenterNet[9]。除了基于深度卷积神经网络架构的目标检测算法外,基于Tranformer的目标检测算法也是一阶段目标检测算法的重要分支[10]。二阶段深度学习算法将目标检测划分为候选区域生成、候选区域分类与边界框调整两个阶段,代表算法为RCNN(region-based convolutional neural networks)系列目标检测算法[11]。候选区域生成的目的在于快速准确地找出图像中目标可能存在的区域,除了最暴力的多尺度滑动窗口法,研究者们还提出了基于图像分割的超像素聚类候选区域生成方法,如基于图结构的图像分割算法[12]和选择性搜索算法[13],此类方法消除规则网格、固定形状与尺度对候选区域的限制。窗口评分候选区域生成方法如Objectness[14]、EdgeBoxes[15]等是另一类重要候选区域生成方法,此类算法对每个滑动矩形窗口是否包含物体进行评分,并只能返回矩形候选框而非目标轮廓,速度相较于超像素聚类方法更快。除非窗口采样比较密集,窗口评分候选区域生成法的位置精度都较低。Faster RCNN[16]首次将基于锚框的候选区域生成网络(region proposal network, RPN)引入并将其嵌入到Fast RCNN的检测网络中,实现了整个检测框架端到端的优化。如何实现快速准确且适用于尺度目标检测的候选区域生成方法仍是目标检测研究领域的重要研究方向之一。第二阶段对候选区域进行分类与边界框调整一般通过卷积神经网络实现,经典的卷积神经网络模型有AlexNet、VGG Net、GoogleNet、ResNet、MobileNet、ResNeX和ShuffleNet等[17],为兼顾神经网络模型的可训练性、推理速度与精度,对于特征任务,现在通常采用神经网络结构搜索的方法以获取最优的网络模型[18]。在检测到无人机后,需要控制云台对快速飞行的无人机进行持续伺服追踪,使无人机一直保持在摄像机的视角中[19]。在云台伺服追踪过程中,仍需对视频中的无人机进行检测,为云台的控制算法提供反馈信息。在确认视频图像中目标的类别与位置后,仍持续地对后续的每一帧高分辨率图像进行全局检测是对计算资源的浪费,为快速高效地对画面中位置已知的无人机进行跟踪,本文采用基于局部搜索的图像单目标跟踪算法对后续视频中的无人机进行跟踪定位。基于局部检测的相关滤波目标跟踪算法是单目标跟踪算法的经典方法之一,此类算法利用循环卷积和快速傅里叶变换高效地训练分类器,并可以快速对局部区域内的跟踪目标进行检测与定位,其代表算法有最小均方误差和输出跟踪算法[20]、核相关滤波跟踪算法[21]、尺度自适应跟踪算法[22]等。在刚引入深度学习时,只是使用卷积神经网络特征替换方向梯度直方图(histogram of oriented gradient, HOG)[5]等手工特征,使相关滤波器能获得更鲁棒的跟踪能力,如C-COT(continuous convolution operators tracking) [23]、ECO(efficient convolution operators)[24]等。完全端到端的深度学习跟踪算法肇始于2016年牛津大学Luca Bertinetto等[25]提出的Siamese-fc孪生网络目标跟踪,在此基础上Siam RPN[26]、Siam Mask[27]等深度学习目标跟踪相继提出。虽然深度学习目标跟踪算法的性能更佳,其检测速度比相关滤波目标跟踪算法慢得多,但是这种可实现快速处理的相关滤波目标跟踪算法在后续帧的局部搜索区域会随转运的摄像机发生偏移,导致跟踪失败。

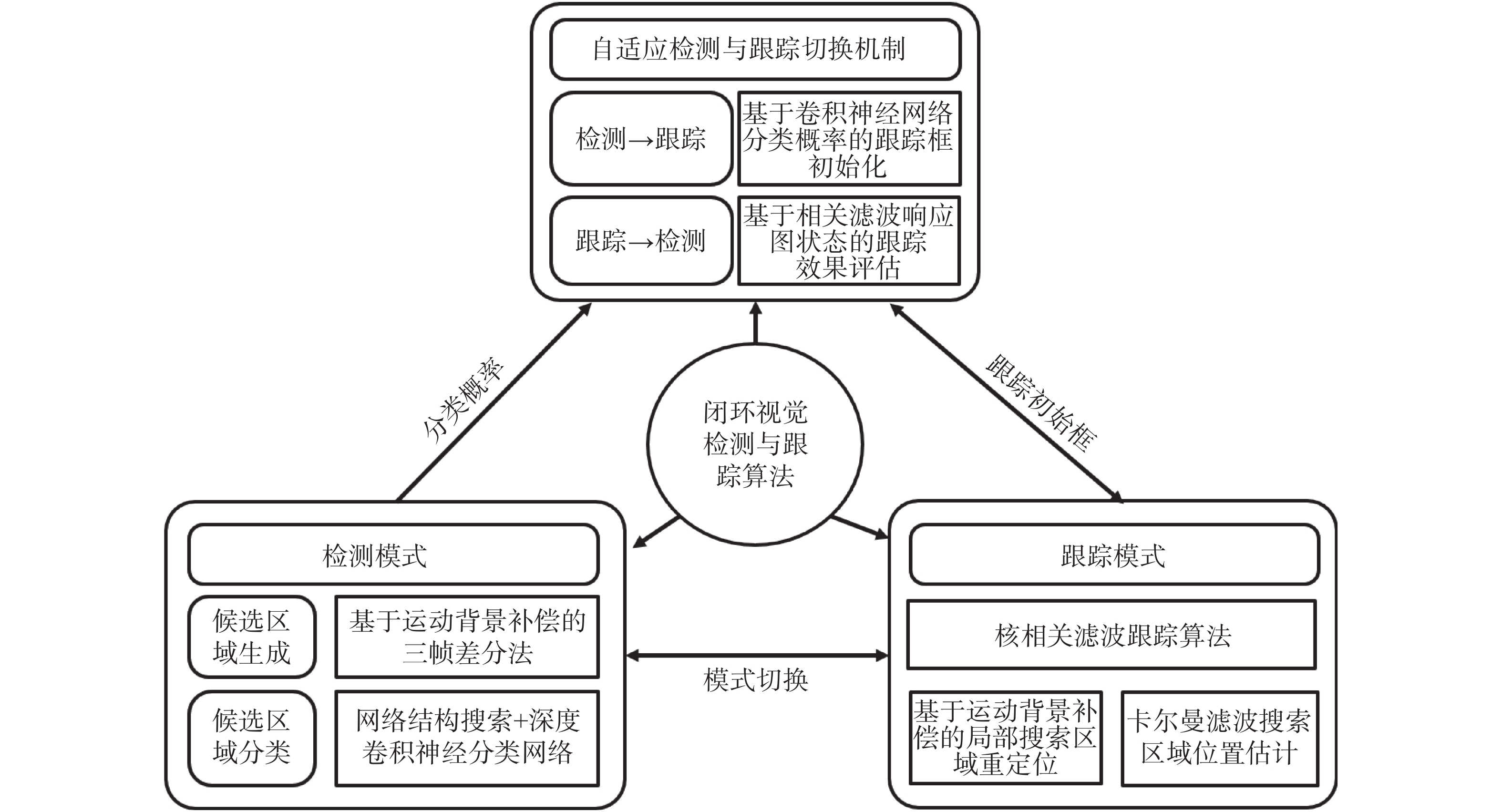

为实现全方位、高复杂、远距离环境下的对无人机的实时准确检测、识别与跟踪,本文通过高清云台摄像机对监测范围进行持续动态扫描,并提出了一种反无人机视觉闭环检测与跟踪框架。本文的主要贡献如下:

1)提出了一种适用于云台摄像机定点巡航的二阶段目标检测算法,此算法首先对由于摄像机运动产生的视频背景运动进行补偿,然后使用三帧差分法生成运动目标候选区域,并使用由神经网络结构搜索得到的深度卷积神经网络进行分类识别,可在不缩小高清视频图像的情况下实现对复杂动态背景中无人机的快速准确检测;

2)提出了一种基于背景补偿和卡尔曼滤波的局部搜索区域重定位策略改进了核相关跟踪算法,解决了由于高清云台摄像机伺服追踪引局部搜索区域偏移问题,在视频背景运动的情况下也能对快速飞行的无人机进行准确、稳定地跟踪;

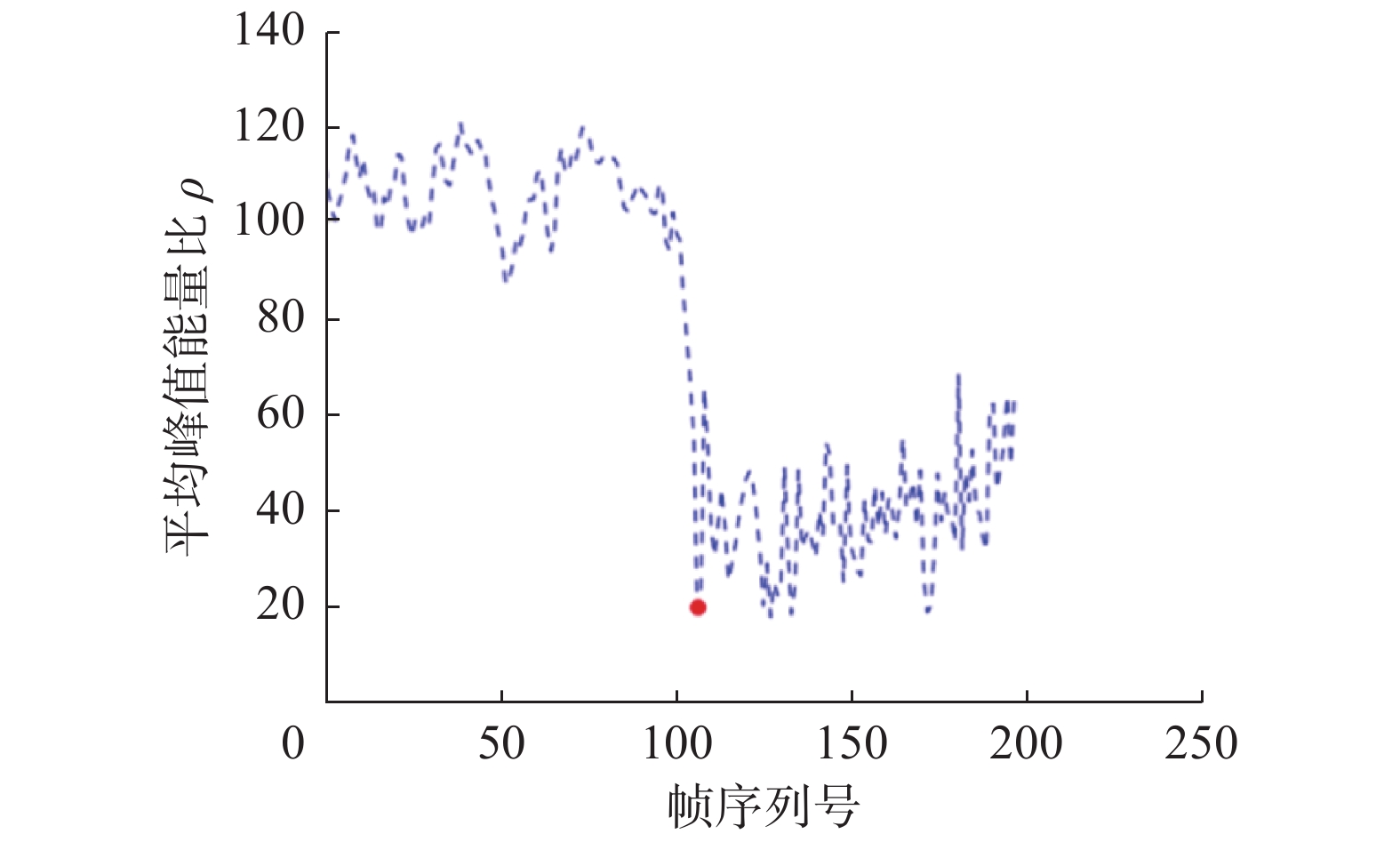

3)提出了一种自适应切换机制将检测模块和跟踪模块结合成一个闭环系统,通过深度卷积神网络的分类结果自动为跟踪模块提供初始化跟踪框,并使用相关滤波跟踪响应图的平均峰值能量比和最大峰值能量来表征跟踪效果的优劣,在跟踪失败时自动切换至检测模式。

1 算法基本框架本文提出了一种适用于云台摄像机动态扫描状态的自适应闭环无人机检测与跟踪算法,包含检测与跟踪两种模式,并通过一种自适应切换机制将检测模式与跟踪模式有机结合在闭环框架中,算法的框架图如图1所示。

|

Download:

|

| 图 1 算法框架 Fig. 1 Algorithm framework | |

首先本文采用高清云台摄像机对中近程近地动态复杂背景进行定点巡航扫描,此时摄像机处于检测模式,使用基于运动背景补偿三帧差分法提出候选目标并通过一个轻量级的深度卷积神经分类网络对候选目标进行分类;根据自适应检测–跟踪切换机制,当目标属于无人机的概率大于预设阈值时,摄像机切换到跟踪模式,采用引入了局部搜索区域重定位策略的相关滤波跟踪算法对无人机进行跟踪;自适应检测–跟踪机制将根据相关滤波响应图的状态对跟踪效果进行评估,若跟踪效果较好,云台摄像机将根据跟踪结果对无人机进行持续地伺服追踪;若跟踪失败,云台摄像机则重新切换到定点巡航检测模式。算法的可视化流程如图2所示。

2 检测模式算法设计云台摄像机定点巡航状态下的检测模式采用如图2所示的两阶段目标检测框架。准确且快速的候选区域生成对实时目标检测至关重要。入侵的无人机基本都是处于飞行状态,故可采用运动目标检测算法提取候选区域,然后再使用深度卷积神经网络对其进行分类识别。但定点巡航状态的云台摄像机采集的视频背景是动态变化的,无法使用传统的帧间差分法或背景减除法进行运动目标检测。光流法可检测运动背景中的运动目标,但其计算量太大,无法实现对高清视频的实时处理。为实现摄像机巡航状态下运动目标检测,本文提出了一种基于运动背景补偿的三帧差分法对疑似运动目标进行检测。

|

Download:

|

| 图 2 算法可视化流程 Fig. 2 Visualization of the algorithm flowchart | |

为消除定点巡航时旋转的云台摄像机产生的自运动效应,本文提出了一种运动背景补偿算法对前后视频帧进行背景对齐。在计算机视觉中,平面的单应性被定义为从一个平面到另一个平面的投影映射。由于远距离的摄像机成像场景可被近似成一个平面,并且无人机等运动目标仅占视频画面的极小部分,在云台摄像机旋转时,连续两帧视频背景之间由于摄像机转动产生的运动可由一个

| $\left[ \begin{array}{l} x_i^k \\ y_i^k \\ 1 \\ \end{array} \right] = {{\boldsymbol{H}}_{kl}}\left[ \begin{array}{l} x_i^l \\ y_i^l \\ 1 \\ \end{array} \right]$ |

式中:

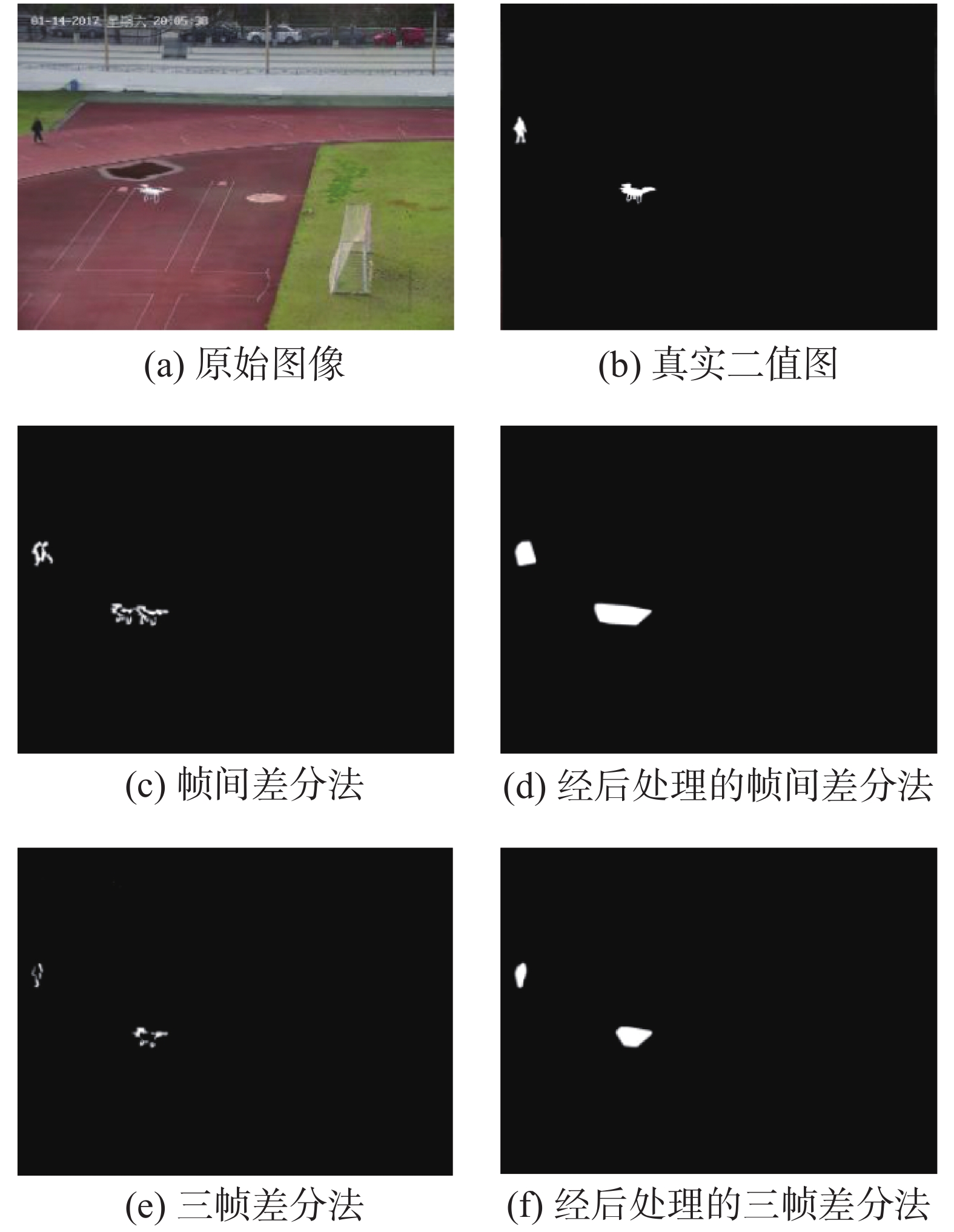

为消除复杂背景对目标检测的影响和快速提取目标候选区域,本节将对运动目标候选区域生成算法进行介绍。由于背景减除法[31]需要对背景进行建模与持续维护,不适用于快速运动的背景,而帧间差分法[32]直接将相邻视频帧作为背景,背景不积累,算法简单、计算量小,比较适合本文场景。帧间差分法对相邻帧图像对应位置像素作差值计算,由于前后帧的背景已通过运动背景补偿进行配准,若相邻帧图像对应位置的像素差小于预设阈值,则可认为此处为背景像素;反之,若相邻帧图像对应位置的像素差值大于某阈值,则标记为前景,即视频中运动目标所在区域。但无人机往往飞行较快,导致帧间差分法受到“鬼影”干扰,即无人机在前后帧的所在区域都会被误认为运动目标候选区域,造成误检。为了消除“鬼影”现象,本文采用了三帧差分法对运动背景补偿后的连续三帧视频图像

| $ \begin{array}{c} {\boldsymbol{D}}_k^1\left( {x,y} \right) = \left\{ {\begin{array}{*{20}{c}} {1,\quad \left| {{{\boldsymbol{I}}_k}(x,y) - {{\boldsymbol{I}}_{k(k - 1)}}(x,y)} \right| \geqslant \theta }\\ {0,\quad\left| {{{\boldsymbol{I}}_k}(x,y) - {{\boldsymbol{I}}_{k(k - 1)}}(x,y)} \right| < \theta } \end{array}} \right.\\ {\boldsymbol{D}}_k^2\left( {x,y} \right) = \left\{ {\begin{array}{*{20}{c}} {1,\quad\left| {{{\boldsymbol{I}}_k}(x,y) - {{\boldsymbol{I}}_{k(k + 1)}}(x,y)} \right| \geqslant \theta }\\ {0,\quad\left| {{{\boldsymbol{I}}_k}(x,y) - {{\boldsymbol{I}}_{k(k + 1)}}(x,y)} \right| < \theta } \end{array}} \right.\\ {{\boldsymbol{D}}_k}{\rm{(}}x,y) = {\boldsymbol{D}}_k^1\left( {x,y} \right) \cap {\boldsymbol{D}}_k^2\left( {x,y} \right) \end{array}$ |

式中

|

Download:

|

| 图 3 运动背景补偿前后的运动目标检测效果对比 Fig. 3 Comparison of the moving target detection results before and after background motion compensation | |

在生成运动目标候选区域后,本文设计了一个深度卷积神经分类网络对候选区域进行分类,判断其是否为无人机。为提高检测速度,可以先根据无人机形状的先验信息将区域外接矩形横纵比小于1或大于3的候选区域筛除。为兼顾分类的实时性和准确度,本文以运算量和准确度为优化目标,结合复合模型扩张方法与神经网络结构搜索寻找面向分类任务最优的网络深度、宽度与分辨率[18],设计了一个高效的轻量级深度卷积神经分类网络EfficientNet-B0,其主干网络的结构如图2和表1所示。

|

Download:

|

| 图 4 不同运动目标区域生成算法效果对比 Fig. 4 Comparisons of different moving region proposal generation methods | |

| 表 1 EfficientNet-B0的网络结构 Tab.1 Architecture of EfficientNet-B0 |

首先将输入图像缩放为

当检测到无人机后,算法将切换到跟踪模式,在此模式下,结合局部搜索区域重定位策略的核相关滤波跟踪算法将对经检测算法初始化的无人机在画面中的位置进行持续跟踪,同时为使无人机保持在视频画面中,云台控制算法以目标在视频画面中离视频中心的距离与方位为反馈量,采用比例−积分−微分(proportion integration differential, PID)控制算法控制云台转动对无人机进行伺服追踪[19]。

3.1 核相关滤波跟踪算法原理由Henriques等[21]提出的核相关滤波跟踪算法是一种判别式局部区域跟踪算法,在当前帧训练一个局部区域目标检测器,使用该目标检测器在下一帧的邻近区域对目标进行搜索,并使用新的检测结果更新目标检测器,检测速度可达每秒几百帧。为避免密集采样带来的重复特征提取和复杂训练过程的高耗时,核相关滤波跟踪器以检测器提供的初始检测框为正样本,提取其fHOG[37]特征图

| $ \underset{W}{\mathrm{min}}{\sum\limits _{i=1}^{m\times n}(\phi ({p}_{i}){\boldsymbol{w}}-{g}_{i}{)}^{2}}+\lambda {\Vert {\boldsymbol{w}}\Vert }^{2}$ |

式中:

| $ \begin{array}{l} \quad \quad \quad \quad \quad \quad \quad{\boldsymbol{\alpha }} = {\mathcal{F}^{ - 1}}\left( {\dfrac{{\mathcal{F}({\boldsymbol{G}})}}{{\mathcal{F}({{\boldsymbol{k}}^{{\boldsymbol{pp}}}}) + \lambda }}} \right) \\ {{\boldsymbol{k}}^{{\boldsymbol{pp}}}} = \exp \left( { - \dfrac{1}{{{\sigma ^2}}}\left( {{{\left\| {\boldsymbol{p}} \right\|}^2} + {{\left\| {{{\boldsymbol{p}}'}} \right\|}^2} - 2{\mathcal{F}^{ - 1}}\left( {\displaystyle\sum {\mathcal{F}{{({\boldsymbol{p}})}^*} \odot \mathcal{F}({\boldsymbol{p}})} } \right)} \right)} \right) \\ \end{array} $ |

式中:

在原核相关滤波算法中,该检测器是在上一帧目标所在位置的中心点的矩形区域内进行搜索,得到跟踪响应图

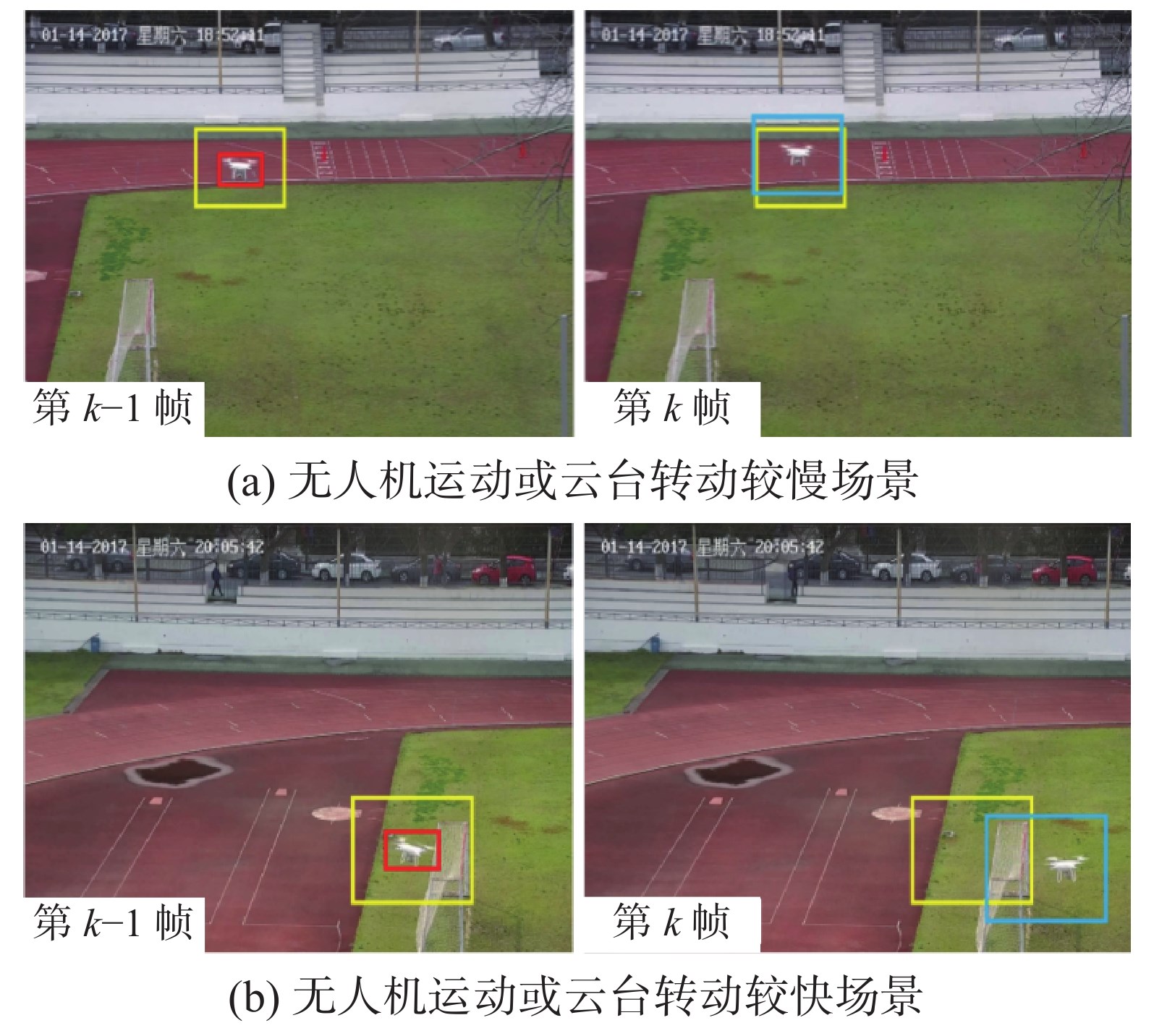

由于云台摄像机在追踪无人机过程中自身的转动,即使无人机在物理空间中是静止的,其在视频不同帧中的图像坐标也将出现变化,另外当无人机飞行速度较快时,它可能会飞出局部搜索框,为了更准确地跟踪无人机,在上一帧的相同位置对无人机进行跟踪是不合理的,为实现在动态追踪的云台摄像机中对快速运动的无人机进行跟踪,本文对无人机在下一帧中的搜索位置进行预测和补偿,以实现搜索区域重定位,使核相关滤波跟踪算法在云台摄像机转动导致背景运动时仍能对快速飞行的无人机进行稳定的跟踪。

为消除云台转动引起的局部搜索区域偏移,本文将通过运动背景补偿实现。与2.1小节所述方法相同,首先通过在跟踪前后两帧图像

| $\begin{array}{l} \Delta {x^k} = \dfrac{1}{N}\displaystyle\sum\limits_{i = 1}^N {(x_i^k - x_i^{k - 1})} \\ \Delta {y^k} = \dfrac{1}{N}\displaystyle\sum\limits_{i = 1}^N {(y_i^k - y_i^{k - 1})} \\ \end{array} $ |

在补偿搜索区域位置由于云台转动引起的自运动偏移后,为进一步提高核相关滤波算法对快速飞行无人机的跟踪性能,本文将通过卡尔曼滤波[41]对新一帧中的局部搜索区域位置进行估计。假设无人机在第

| $\begin{array}{l} {\boldsymbol{X}}_m^k = {\boldsymbol{A}}{{\boldsymbol{X}}^{k - 1}} + {{\boldsymbol{w}}^k} \\ {\boldsymbol{Z}}_m^k = {\boldsymbol{BX}}_m^k + {{\boldsymbol{v}}^k} \\ \end{array} $ |

式中:

| $\begin{array}{l} {{{\hat{\boldsymbol P}}}_k} = {\boldsymbol{A}}{{\boldsymbol{P}}_{k - 1}}{{\boldsymbol{A}}^{\rm{T}}} + {\boldsymbol{Q}} \\ {{\boldsymbol{K}}_k} = {{{\hat{\boldsymbol P}}}_k}{{\boldsymbol{B}}^{\rm{T}}}{({\boldsymbol{A}}{{{\hat{\boldsymbol P}}}_k}{{\boldsymbol{A}}^{\rm{T}}} + {\boldsymbol{R}})^{ - 1}} \\ {\hat{\boldsymbol X}}_m^k = {\boldsymbol{A\tilde X}}_m^{k - 1} \\ {\tilde{\boldsymbol X}}_m^k = {\hat{\boldsymbol X}}_m^k + {{\boldsymbol{K}}_k}({\boldsymbol{Z}}_m^k - {\boldsymbol{B\hat X}}_m^k) \\ {{\boldsymbol{P}}_k} = (I - {{\boldsymbol{K}}_k}{\boldsymbol{B}}){{{\hat{\boldsymbol P}}}_k} \\ \end{array} $ |

式中:

图5给出了2种不同情况下局部搜索区域重定的跟踪效果示意图,图5(a)为无人机运动较慢情形,是否进行局部搜索区域重定位在这种条件下对目标跟踪效果影响不大,但是在图5(b)所示无人机运动速度较快或者云台旋转较快时,无人机在第

|

Download:

|

| 图 5 局部搜索区域重定位跟踪效果示意 Fig. 5 Illustration of tracking algorithms with and without local search area relocation | |

为实现检测模式与跟踪模式的自适应切换,本文设计了一种自适应切换机制,将前文提到的检测模式与跟踪模式整合到一个闭环框架中。如前文所述,检测模式的检测结果可为跟踪算法提供精确可靠的初始框,具体地,当深度卷积神经分类网络分类结果中,属于无人机的概率超过某阈值的目标检测框即跟踪算法的初始跟踪框。

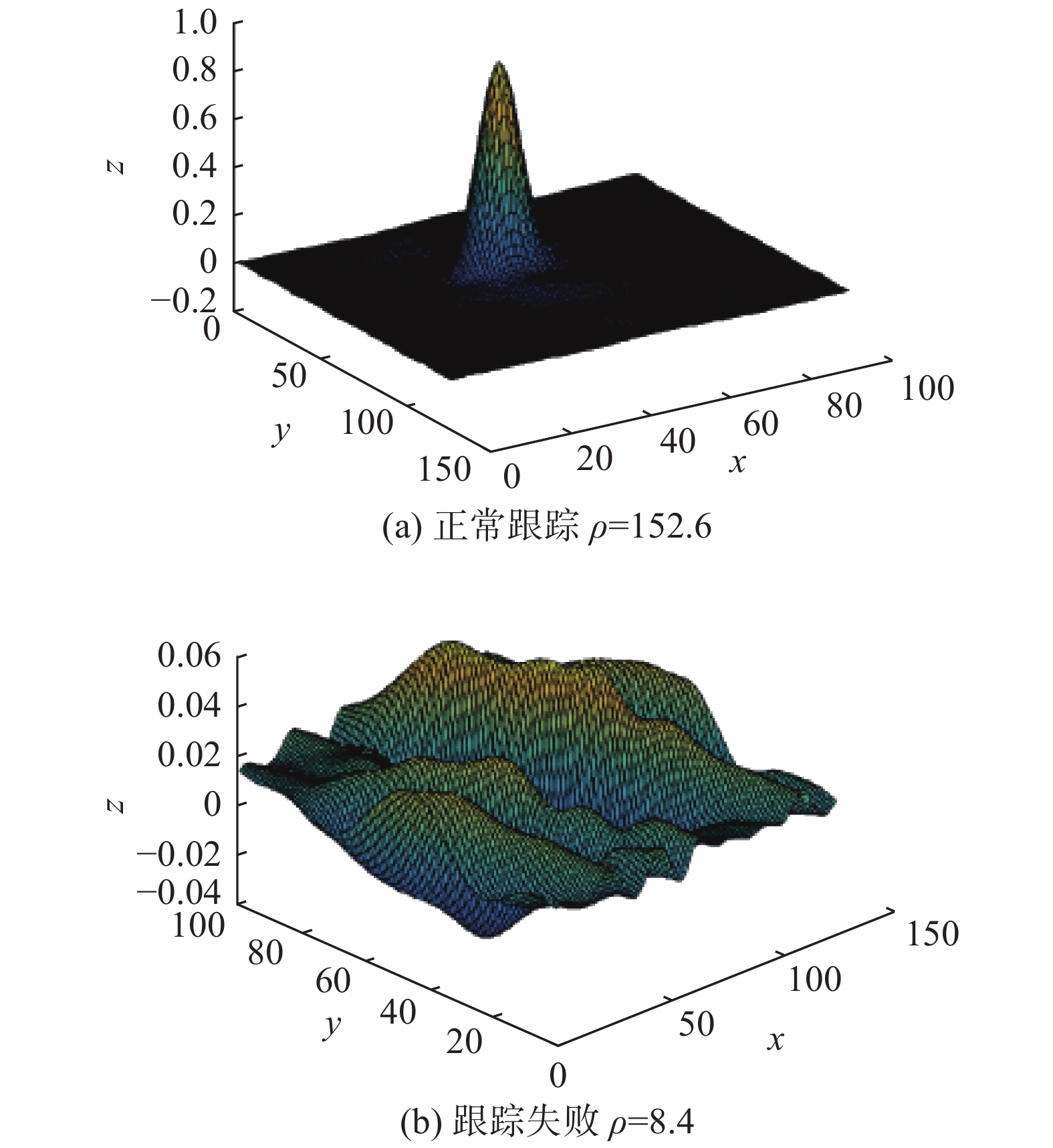

在对无人机进行跟踪的过程中,遮挡、光线变化、模糊、目标变形等因素均会造成跟踪失败,一旦跟踪失败,算法会自动切换至检测模式,为此本文根据核相关滤波跟踪响应图提出了一种自动跟踪效果评估机制。如图2所示,无人机在搜索框中的位置是由响应图

| $\rho = {{{\tau ^2}} / {\sum\limits_{i = 1}^m {\sum\limits_{j = 1}^n {{\boldsymbol{\varOmega }}{{\left( {i,j} \right)}^2}} } }}$ |

| $\tau = \mathop {\max }\limits_{i = 1,j = 1}^{m,n} \left( {{\boldsymbol{\varOmega }}\left( {i,j} \right)} \right)$ |

式中:

|

Download:

|

| 图 6 正常跟踪和跟踪失败时的响应图对比 Fig. 6 Response maps of good and bad tracking | |

|

Download:

|

|

图 7 平均峰值能量比

|

|

为验证本文提出的反无人机视觉闭环检测与跟踪算法的有效性,本文对算法的不同模式和整体性能都做了详尽的测试和评估。

5.1 运动目标候选区域生成算法为测试检测模式中的基于运动背景补偿的运动目标检测算法,本文采用开源数据集changeDetection[42]中PTZ摄像机目标下的4个图像序列作为测试集,使用准确率P、召回率r和F1分数对检测结果进行评估,其具体定义为

| $ p {\rm{ = }}\frac{{{\rm{TP}}}}{{{\rm{TP + FP}}}},r{\rm{ = }}\frac{{{\rm{TP}}}}{{{\rm{TP + FN}}}},{F_{\rm{1}}}{\rm{ = }}\frac{{{\rm{2}} {{p}} {{r}}}}{{{{p + r}}}}$ |

式中:TP为检测正确的前景像素点个数;FP为将背景检测成前景的像素个数(误检);FN为将前景检测为背景的像素个数(漏检)。本文提出的算法与已有算法EFIC[43]、WeSamBE[44]在此数据集上的比较结果如表2所示。

| 表 2 运动目标检测算法性能比较 Tab.2 Comparisons of moving target detection |

由表2可知,本文提出的算法虽然在准确率上相较于EFIC、WeSamBE较低,但其召回率与F1参数均是3种算法中最高的,在候选区域生成阶段应尽可能发现可能的目标,故相较于准确率,候选区域生成算法更关注召回率指标。

5.2 深度卷积神经分类网络为评估本文中的深度卷积神经分类网络,本文构建了一个无人机分类数据集,包含复杂环境下的无人机图像作为正样本,共600张,另包含了飞机、鸟类、行人、树木等负样本图像,共200张,如图8所示,数据集中训练集和测试集的比例为7∶3。

|

Download:

|

| 图 8 无人机分类数据集 Fig. 8 Drone classification dataset | |

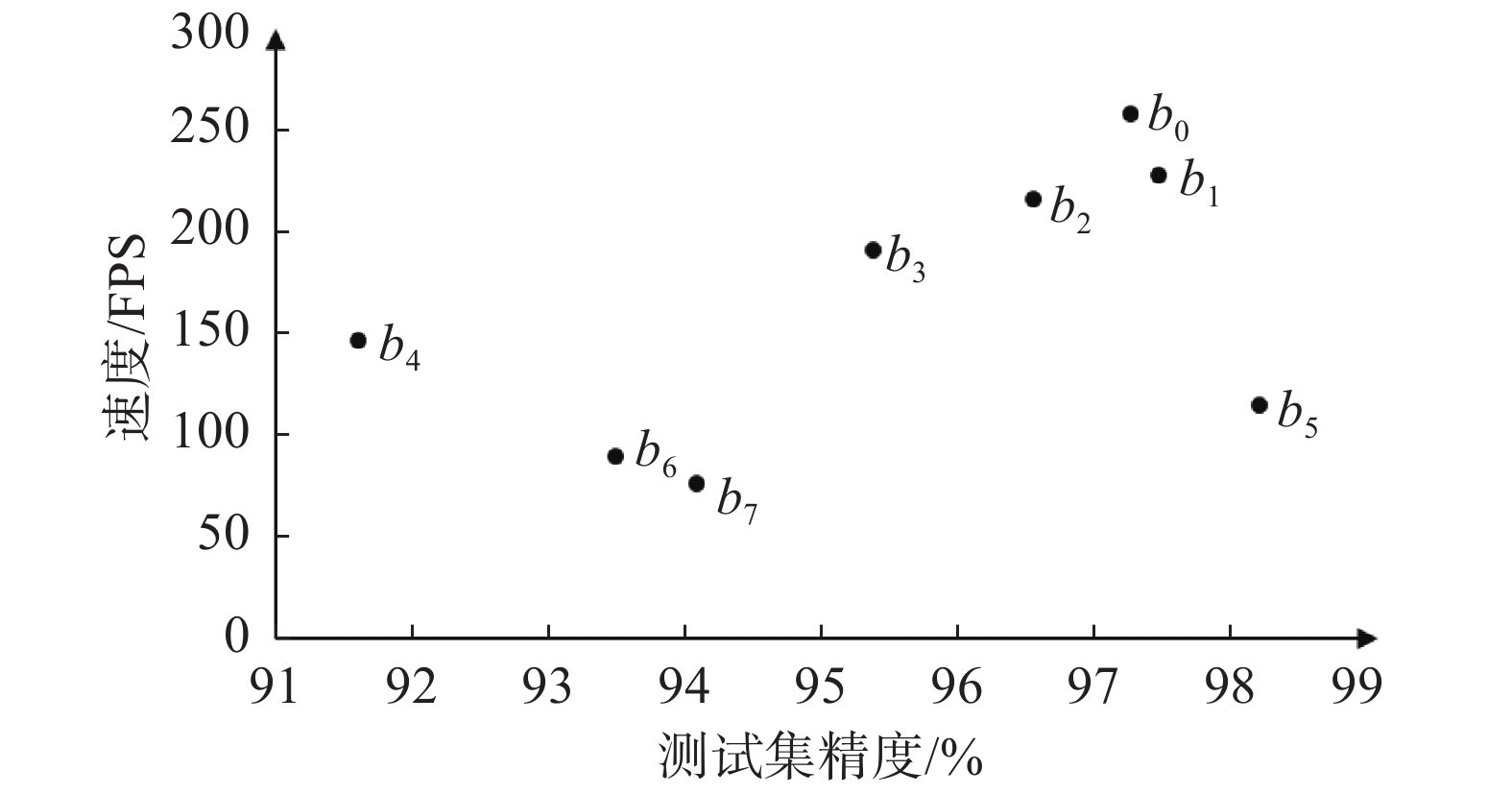

为在达到高精度的同时兼顾运算速度,实验通过网络结构搜索,共生成了8种不同尺寸的网络(EfficientNet-b0~b7),其参数量依次增加,前向计算速度逐渐降低。由于在本文面向的场景中,分类类别数量较少,如果盲目应用参数量较大的网络,反而会提升过拟合风险并降低分类精度。为实现精度与速度的平衡,实验在所构成的分类数据集上依次评测所有生成的EfficientNet系列网络,使用单块Tesla T4 GPU,实验结果如图9所示。结果表明,EfficientNet-b0的分类准确率和速度可达到97.2%和258 FPS,在达到无人机辨别任务精度要求的同时,满足检测系统的速度要求,综合性能最好。

5.3 核相关滤波跟踪算法实验结果为评估局部搜索区域重定位核相关滤波跟踪算法,本文构建了一个无人机检测与跟踪测试数据集,包含24段云台摄像机拍摄视频片段,图像大小均为2 048

|

Download:

|

| 图 9 EfficientNet系列网络的性能对比评估 Fig. 9 Performance assessment of EfficientNet networks | |

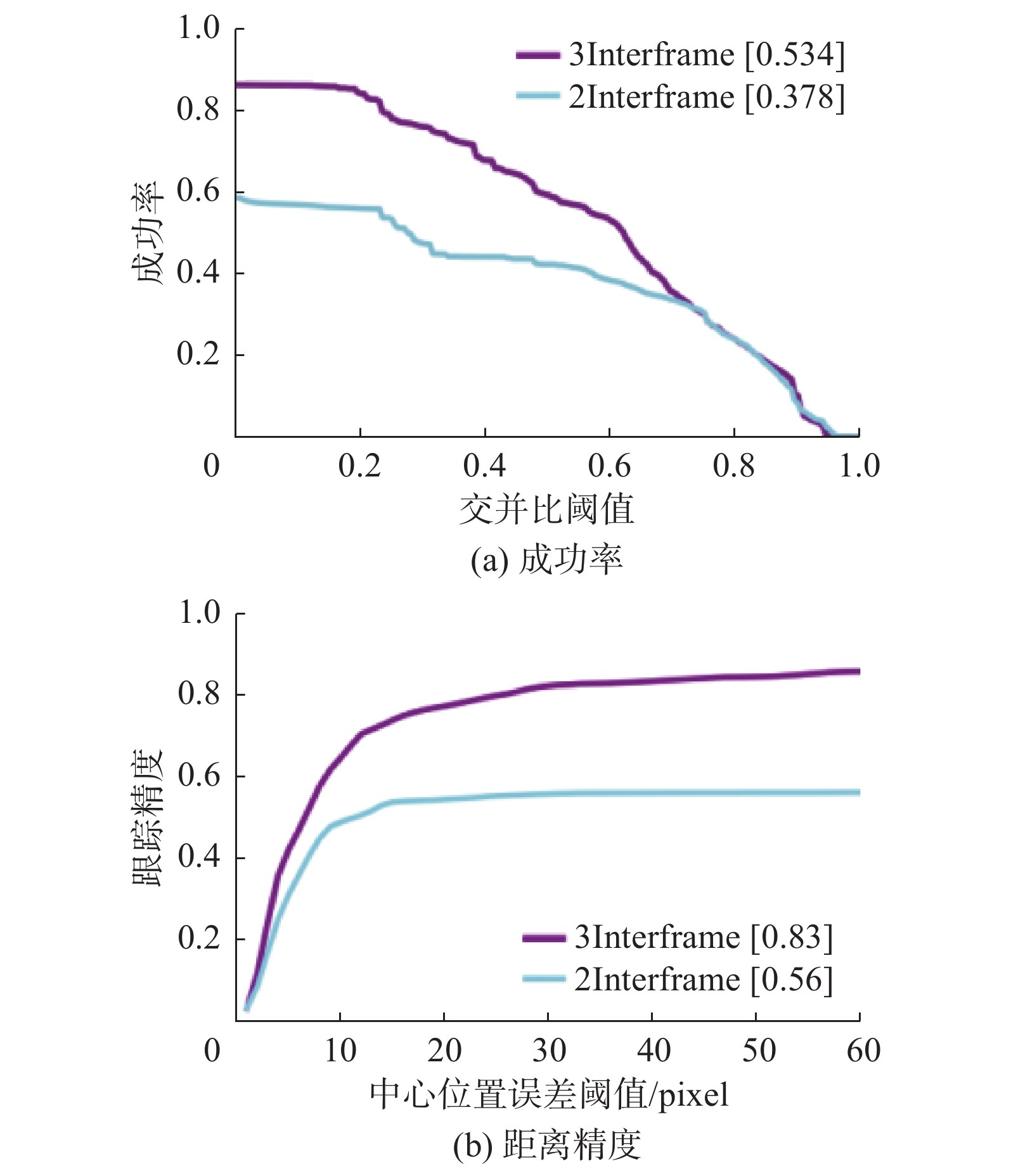

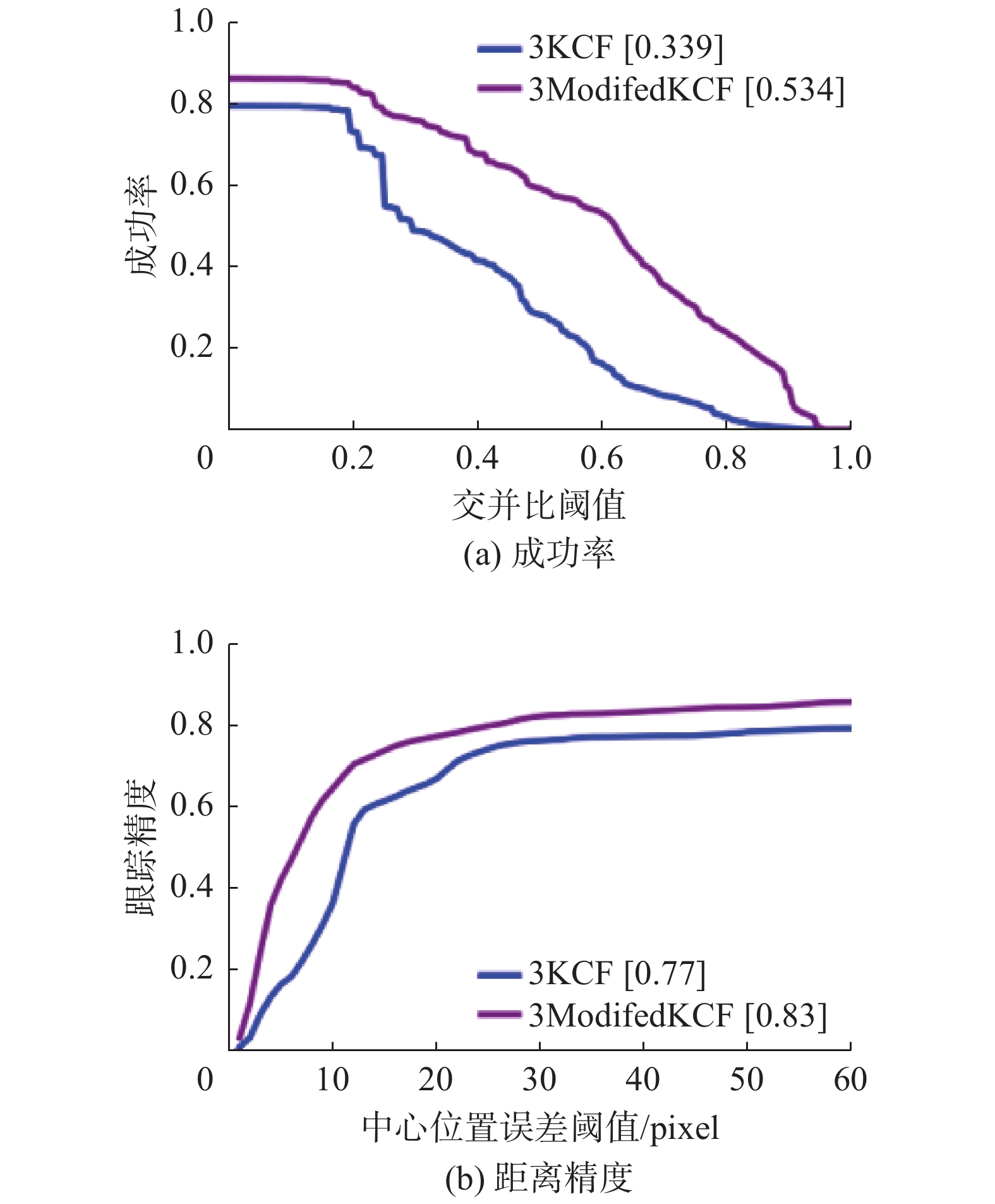

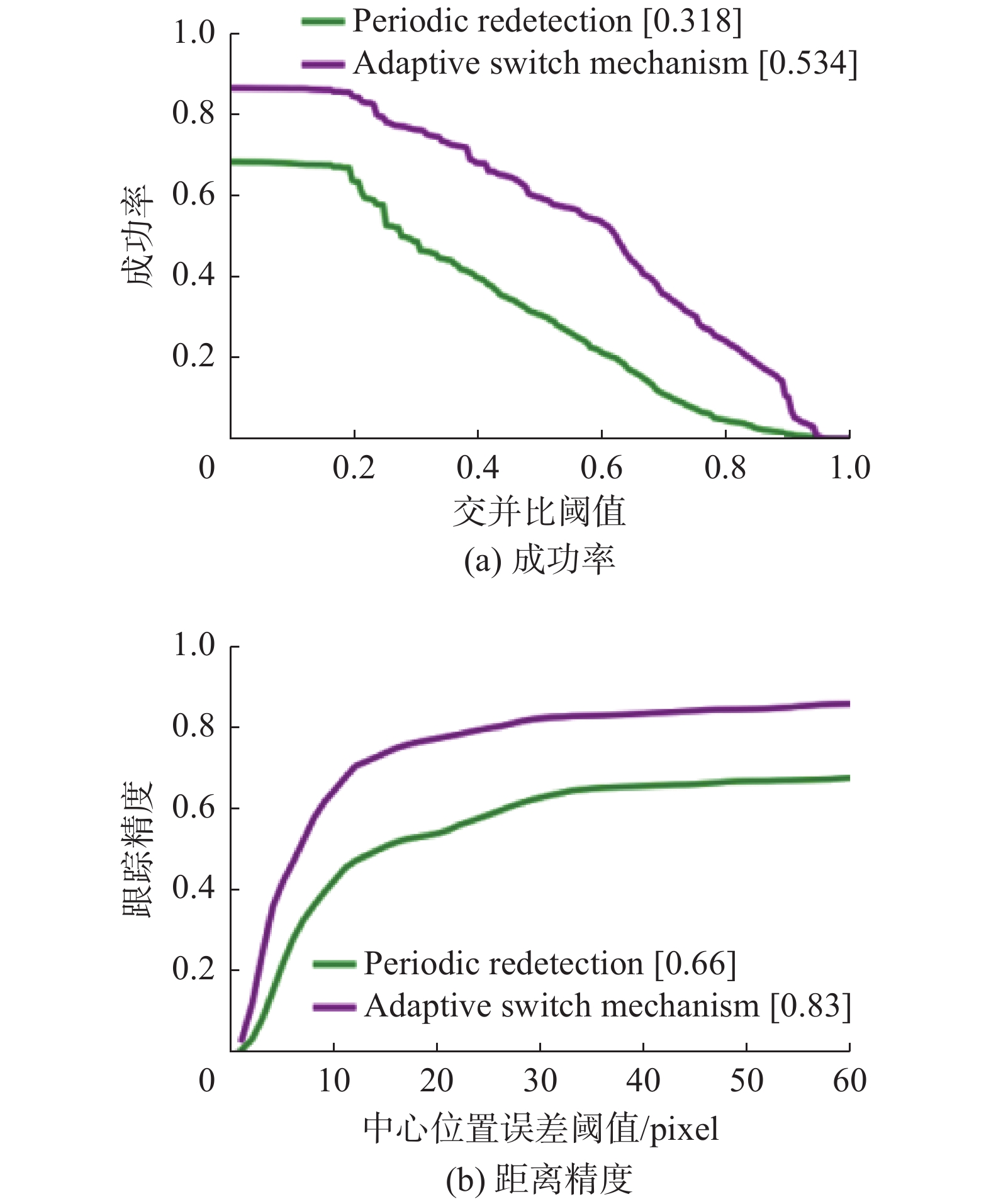

由于影响闭环检测与跟踪算法的因素很多,为详尽地探究不同因素对跟踪性能的影响,本文进行了一系列消融性实验。在控制了其他因素相同的条件下,首先本文对比了基于帧间差分法和基于三帧差分法检测器初始化跟踪器对跟踪效果的影响,其跟踪效果如图10所示。由图10可知,基于三帧差分的检测算法的跟踪框初始化方法可取得更好的跟踪效果;然后对比了改进前后的核相关滤波跟踪对跟踪效果,如图11所示,使用了局部搜索区域重定位策略的核相关滤波跟踪算法跟踪效果更佳;最后验证了自适应检测跟踪切换机制对目标跟踪的影响,与之作为对比,比较算法每隔固定时间(实验设置为30帧)对跟踪器进行初始化,两种检测–跟踪切换机制的跟踪效果如图12所示。由图12可知自适应检测–跟踪切换机制下的目标跟踪效果优于固定周期检测–跟踪切换机制。

|

Download:

|

| 图 10 不同初始化方法的成功率和距离精度 Fig. 10 Success plot and precision plot of the tracker with different initialization method | |

|

Download:

|

| 图 11 核相关滤波跟踪改进前后的成功率和距离精度 Fig. 11 Success plot and precision plot of the tracker with and without searching area relocation | |

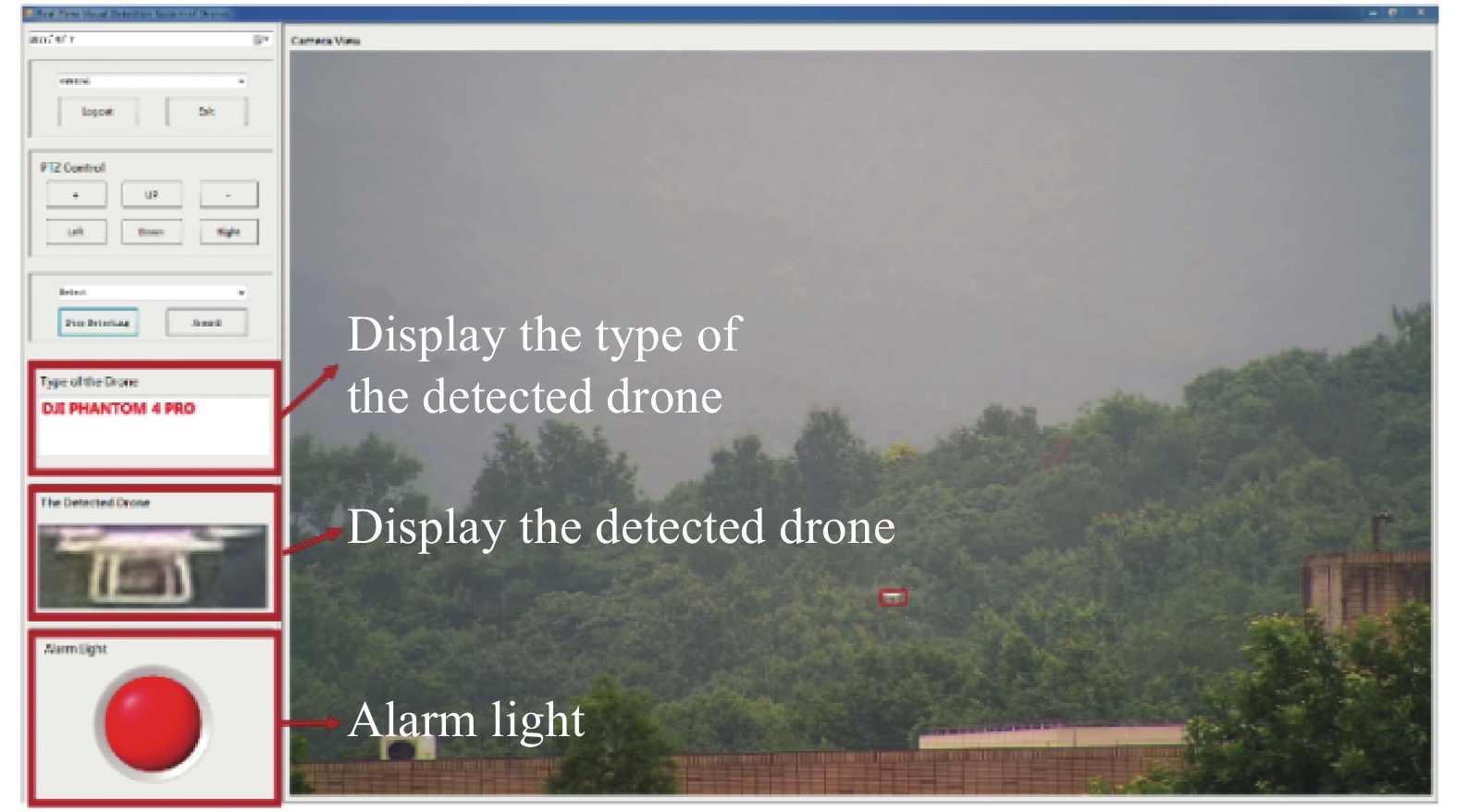

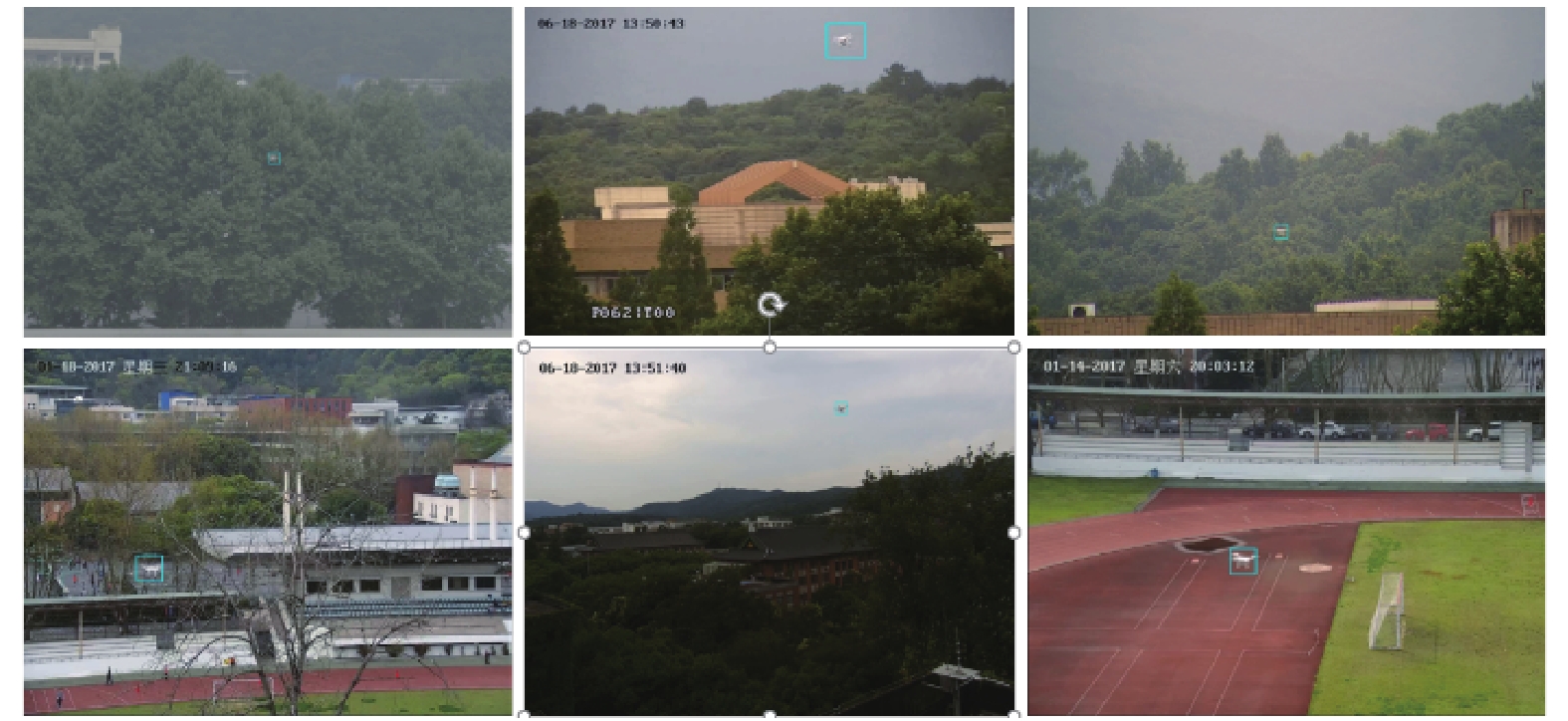

在实际测试中,本文以CPU型号为Intel core i7-7700、内存8 GB、GPU为11 GB的Nvidia GeForce GTX 1080ti计算机为中央处理器,使用4路型号为HIKVISION DS2DF7330IW的云台摄像机对周边区域进行定点巡航扫描,视频图像分辨率为2 048

|

Download:

|

| 图 12 基于自适应切换机制与固定周期切换机制的跟踪成功率和距离精度 Fig. 12 Success plot and precision plot of the tracker with adaptive switching and periodic redetection mechanisms | |

|

Download:

|

| 图 13 系统人机图像交互界面 Fig. 13 Graphic user interface of the system | |

| 表 3 不同检测算法性能比较 Tab.3 Comparisons of different detection algorithm |

|

Download:

|

| 图 14 实际实验场景检测与跟踪效果 Fig. 14 Detection and tracking results of field tests | |

本文提出了一个适用于高清云台摄像机定点巡航扫描状态的无人机闭环检测与跟踪算法,此算法通过一种自适应检测–跟踪切换机制将检测模式和跟踪模式有机的结合在了一个闭环框架中,可实现快速实时、准确、稳定的无人机检测、识别与跟踪。与以往工作不同,本文在目标检测模块中提出了一个快速准确、无需对高清视频图像进行尺度缩小的二阶段目标检测框架;并用局部搜索区域重定位策略改进了核相关跟踪算法;最后提出了一种自适应切换机制实现了检测模块和跟踪模块的自动切换。大量实验和实际测试也证明了算法不同模式与自适应闭环框架的有效性。

| [1] |

SUN Yuyi, CHEN Jiming, HE Shibo, et al. High-confidence gateway planning and performance evaluation of a hybrid LoRa network[J]. IEEE internet of things journal, 2021, 8(2): 1071−1081.

( 0) 0)

|

| [2] |

FLOREANO D, WOOD R J. Science, technology and the future of small autonomous drones[J]. Nature, 2015, 521(7553): 460−466.

( 0) 0)

|

| [3] |

SHI Xiufang, YANG Chaoqun, XIE Weige, et al. Anti-drone system with multiple surveillance technologies: architecture, implementation, and challenges[J]. IEEE communications magazine, 2018, 56(4): 68−74.

( 0) 0)

|

| [4] |

XIE Jiayang, YU Jin, WU Junfeng, et al. Adaptive switching spatial-temporal fusion detection for remote flying drones[J]. IEEE transactions on vehicular technology, 2020, 69(7): 6964−6976.

( 0) 0)

|

| [5] |

DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C]//Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego, USA, 2005: 886−893.

( 0) 0)

|

| [6] |

REDMON J, FARHADI A. YOLOv3: an incremental improvement[J]. arXiv preprint arXiv: 1804.02767, 2018.

( 0) 0)

|

| [7] |

LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: single shot MultiBox detector[C]//Proceedings of the 14th European Conference on Computer Vision. Amsterdam, The Netherlands, 2016: 21−37.

( 0) 0)

|

| [8] |

LAW H, DENG Jia. CornerNet: detecting objects as paired keypoints[C]//Proceedings of the 15th European Conference on Computer Vision. Munich, Germany, 2018: 765−781.

( 0) 0)

|

| [9] |

DUAN Kaiwen, BAI Song, XIE Lingxi, et al. CenterNet: keypoint triplets for object detection[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Seoul, Korea (South), 2019: 6568−6577.

( 0) 0)

|

| [10] |

CARION N, MASSA F, SYNNAEVE G, et al. End-to-end object detection with transformers[C]//Proceedings of the 16th European Conference on Computer Vision. Glasgow, UK, 2020: 213−229.

( 0) 0)

|

| [11] |

GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Columbus, USA, 2014: 580−587.

( 0) 0)

|

| [12] |

FELZENSZWALB P F, HUTTENLOCHER D P. Efficient graph-based image segmentation[J]. International journal of computer vision, 2004, 59(2): 167−181.

( 0) 0)

|

| [13] |

UIJLINGS J R R, VAN DE SANDE K E A, GEVERS T, et al. Selective search for object recognition[J]. International journal of computer vision, 2013, 104(2): 154−171.

( 0) 0)

|

| [14] |

ENDRES I, HOIEM D. Category independent object proposals[C]//Proceedings of the 11th European Conference on Computer Vision. Heraklion, Greece, 2010: 575−588.

( 0) 0)

|

| [15] |

ZITNICK C L, DOLLÁR P. Edge boxes: locating object proposals from edges[C]//Proceedings of the 13th European Conference on Computer Vision. Zurich, Switzerland, 2014: 391−405.

( 0) 0)

|

| [16] |

REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[C]//Proceedings of the 28th International Conference on Neural Information Processing Systems. Montreal, Quebec, Canada, 2015: 91−99.

( 0) 0)

|

| [17] |

CANZIANI A, PASZKE A, CULURCIELLO E. An analysis of deep neural network models for practical applications[J]. arXiv preprint arXiv: 1605.07678, 2016.

( 0) 0)

|

| [18] |

TAN Mingxing, LE Q V. EfficientNet: rethinking model scaling for convolutional neural networks[C]//Proceedings of the 36th International Conference on Machine Learning. Long Beach, USA, 2019: 6105−6114.

( 0) 0)

|

| [19] |

ZHANG Lei, XU Ke, YU Shiqi, et al. An effective approach for active tracking with a PTZ camera[C]//Proceedings of IEEE International Conference on Robotics and Biomimetics. Tianjin, China, 2010: 1768−1773.

( 0) 0)

|

| [20] |

BOLME D S, BEVERIDGE J R, DRAPER B A, et al. Visual object tracking using adaptive correlation filters[C]//Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, USA, 2010: 2544−2550.

( 0) 0)

|

| [21] |

HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(3): 583−596.

( 0) 0)

|

| [22] |

DANELLJAN M, HÄGER G, KHAN F S, et al. Discriminative scale space tracking[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(8): 1561−1575.

( 0) 0)

|

| [23] |

DANELLJAN M, ROBINSON A, KHAN F S, et al. Beyond correlation filters: learning continuous convolution operators for visual tracking[C]//Proceedings of the 14th European Conference on Computer Vision. Amsterdam, The Netherlands, 2016: 472−488.

( 0) 0)

|

| [24] |

DANELLJAN M, BHAT G, SHAHBAZ KHAN F, et al. ECO: efficient convolution operators for tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 6931−6939.

( 0) 0)

|

| [25] |

BERTINETTO L, VALMADRE J, HENRIQUES J F, et al. Fully-convolutional siamese networks for object tracking[C]//Proceedings of the European Conference on Computer Vision. Amsterdam, The Netherlands, 2016: 850−865.

( 0) 0)

|

| [26] |

LI Bo, YAN Junjie, WU Wei, et al. High performance visual tracking with Siamese region proposal network[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 8971−8980.

( 0) 0)

|

| [27] |

WANG Qiang, ZHANG Li, BERTINETTO L, et al. Fast online object tracking and segmentation: a unifying approach[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, USA, 2019: 1328−1338.

( 0) 0)

|

| [28] |

DÉNIZ O, BUENO G, BERMEJO E, et al. Fast and accurate global motion compensation[J]. Pattern recognition, 2011, 44(12): 2887−2901.

( 0) 0)

|

| [29] |

RUBLEE E, RABAUD V, KONOLIGE K, et al. ORB: an efficient alternative to SIFT or SURF[C]//Proceedings of International Conference on Computer Vision. Barcelona, Spain, 2011: 2564−2571.

( 0) 0)

|

| [30] |

FISCHLER M A, BOLLES R C. Random sample consensus: a paradigm for model fitting with applications to image analysis and automated cartography[J]. Communications of the ACM, 1981, 24(6): 381−395.

( 0) 0)

|

| [31] |

BRUTZER S, HÖFERLIN B, HEIDEMANN G. Evaluation of background subtraction techniques for video surveillance[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Colorado Springs, USA, 2011: 1937 −1944.

( 0) 0)

|

| [32] |

CHENG Yuanhang, WANG Jing. A motion image detection method based on the inter-frame difference method[J]. Applied mechanics and materials, 2014, 490: 1283−1286.

( 0) 0)

|

| [33] |

SERRA J, VINCENT L. An overview of morphological filtering[J]. Circuits, systems and signal processing, 1992, 11(1): 47−108.

( 0) 0)

|

| [34] |

GRAHAM R L, YAO F F. Finding the convex hull of a simple polygon[J]. Journal of algorithms, 1983, 4(4): 324−331.

( 0) 0)

|

| [35] |

HU Jie, SHEN Li, SUN Gang. Squeeze-and-excitation networks[C]//Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 7132−7141.

( 0) 0)

|

| [36] |

GHIASI G, LIN T Y, LE Q V. DropBlock: a regularization method for convolutional networks[C]//Proceedings of 33nd Conference on Neural Information Processing Systems. Montréal, Canada, 2018: 10750−10760.

( 0) 0)

|

| [37] |

FELZENSZWALB P F, GIRSHICK R B, MCALLESTER D, et al. Object detection with discriminatively trained part-based models[J]. IEEE transactions on pattern analysis and machine intelligence, 2010, 32(9): 1627−1645.

( 0) 0)

|

| [38] |

HOERL A E, KANNARD R W, BALDWIN K F. Ridge regression: some simulations[J]. Communications in statistics, 1975, 4(2): 105−123.

( 0) 0)

|

| [39] |

SCHÖLKOPF B, SMOLA A J. Learning with kernels: support vector machines, regularization, optimization, and beyond[M]. Cambridge: MIT Press, 2002.

( 0) 0)

|

| [40] |

GRAY R M. Toeplitz and circulant matrices: a review[J]. Foundations and trends® in communications and information theory, 2006, 2(3): 155−239.

( 0) 0)

|

| [41] |

KIM Y, BANG H. Introduction to Kalman filter and its applications[M].GOVAERS F. Introduction and Implementations of the Kalman Filter. IntechOpen, 2019.

( 0) 0)

|

| [42] |

GOYETTE N, JODOIN P M, PORIKLI F, et al. Changedetection.net: a new change detection benchmark dataset[C]//Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. Providence, USA, 2012: 1−8.

( 0) 0)

|

| [43] |

ALLEBOSCH G, DEBOEVERIE F, VEELAERT P, et al. EFIC: edge based foreground background segmentation and interior classification for dynamic camera viewpoints[C]//Proceedings of the 16th International Conference on Advanced Concepts for Intelligent Vision Systems. Catania, Italy, 2015: 130−141.

( 0) 0)

|

| [44] |

JIANG Shengqin, LU Xiaobo. WeSamBE: a weight-sample-based method for background subtraction[J]. IEEE transactions on circuits and systems for video technology, 2018, 28(9): 2105−2115.

( 0) 0)

|

2021, Vol. 16

2021, Vol. 16