2. 湖南大学 机器人视觉感知与控制技术国家工程实验室,湖南 长沙 410082

2. National Engineering Laboratory for Robot Vision Perception and Control Technology, Hunan University, Changsha 410082, China

无人机因其隐蔽性高、体积小、机动性强等优点,已被广泛应用于智慧交通、抢险救灾、军事侦察、航拍等领域[1]。随着计算机视觉与人工智能技术的不断发展,面向无人机的目标跟踪算法,因能使无人机执行更多自主任务,成为了当下研究的热点[2]。无人机在执行跟踪任务过程中,由于平台的运动与图像的不稳定性,往往会使拍摄的图像序列视角变化更大、目标尺度变化快、背景模糊、遮挡频繁等。因此,研究一种高效而鲁棒的目标跟踪算法,对无人机的应用具有重要的价值与意义。

近年来,以CSK(circulant structure of tracking-by-detection with kernels)[3]、KCF(kernelized correlation filters)[4]为代表的传统相关滤波算法,因其明显的速度优势在无人机目标跟踪领域中得到广泛关注。但是,基于传统方法的目标跟踪算法利用手工设计的特征提取器,往往对目标的变化不鲁棒,在一些复杂条件下的无人机跟踪过程中,效果并不理想。随着深度学习技术的发展,深度网络因其良好的特征表达能力,相较传统的特征提取方法已取得了明显的优势。如C-COT(continuous convolution operators for visual tracking)[5]、ECO(efficient convolution operators for tracking)[6],利用离线训练获取特征提取网络,使跟踪精度得到了显著提升,但是算法的运行速度难以满足无人机目标跟踪的实时性要求。2017年,Tao等[7]提出SINT(Siamese instance search tracking)算法,首次将孪生网络应用于目标跟踪领域。之后,Bertinetto等[8]提出了SiamFC(Siamese fully convolutional),一种基于孪生网络全卷积目标跟踪算法,采用端到端的方式直接训练整个网络,该算法在速度与精度上都取得了较好的效果,这也使得孪生网络在跟踪领域受到了越来越多的重视。CFNet(correlation filter network)[9]在孪生网络框架中引入了相关滤波层。SiamRPN(Siamese region proposal network)[10]中,开创性地引入了目标检测中的RPN(region proposal network)[11]网络到孪生网络跟踪中,将相似度计算问题转化为目标分类与回归问题,并在大规模的数据集上进行离线训练,使算法在速度和精度上都取得了明显优势。但时,RPN网络同时也存在着目标置信度不能准确表征目标框准确度、目标框无法迭代修正以及超参数较多等问题[12]。

本文针对图像序列的无人机目标跟踪问题,提出了一种基于孪生网络的目标跟踪算法,能在嵌入式无人机机载电脑上实时运行。该算法主要包括3部分:为提升特征提取网络的特征表达能力同时保障算法的实时性能,引入MobileNetV2[13]作为主干网络并采用一种基于偏移量学习的方式,解决网络平移不变性的问题;引入了一种新的目标尺度估计模块,可预测出目标框与真实框的重叠率IoU,并以此为指导,对目标框进行迭代修正;最后,利用网络多层特征,采用残差融合的策略进一步提升网络性能。针对因完全遮挡导致目标跟丢的问题,本文设计了一个基于MoblieNetV2的实时高效的显著性检测算法,可轻易地嵌入目标跟踪框架中。在跟丢时,切换到显著性检测算法对目标进行再检测以恢复跟踪。

1 目标跟踪算法设计 1.1 基于孪生网络的跟踪算法原理传统的基于孪生网络的目标跟踪算法,根据目标的相似度来对目标进行跟踪[8],通过学习一个相似性函数f(z,x),将模板图像z与搜索图像x分别作为模板分支与搜索分支的输入,在第一帧时,通过卷积网络

| ${{{f}}_{{\theta }}}\left( {{{z}},{{x}}} \right) = {{{\varphi }}_{{\theta }}}\left( {{z}} \right) * {{{\varphi }}_{{\theta }}}\left( {{x}} \right) + {{b}} \cdot {{I}}$ |

式中:

孪生网络对目标相似性的学习是基于全卷积网络的平移不变性基础上的,令

| ${{f}}\left( {{{z}},{L_\tau }{{x}}} \right)\left[ u \right] = {{f}}\left( {{{z}},{{x}}} \right)\left[ {u - \tau } \right]$ | (1) |

式(1)表示将目标在搜索区域进行平移后,其映射到得分置信度特征图相应位置的值与平移之前保持不变,这让网络的训练与实际的跟踪具有意义。同时网络具有严格的结构对称

利用全卷积网络的这些特性,模板图像与搜索图像可以使用不同分辨率的图片,通过输入尺寸更大的搜索图像,可以使模板图像在其不同的子窗口进行滑窗检测,得到目标的得分置信度特征响应图。响应图中的每一个点与搜索图像中的每一个子窗口一一对应,表示该子窗口区域与目标的相似度,以此实现对目标的跟踪。

1.2 基于MobileNetV2的目标跟踪算法原理目标跟踪模算法包含了2个模块,分别是目标得分估计模块、目标尺度估计模块,其网络结构图如图1所示。利用目标得分模块可得到目标在图像中的初始位置,再利用目标尺度估计模块对目标位置及其目标框大小进行迭代修正,得到目标最终的位置及尺度估计。

|

Download:

|

| 图 1 目标跟踪算法网络结构 Fig. 1 Object tracking network structure | |

为了提升特征提取网络性能同时保障算法的实时性,本文引入MobileNetV2作为特征提取网络。对于图1中的目标得分估计模块,由于该网络中加入了padding,使孪生网络的平移不变性遭到破坏[14],导致网络学习遭到严重的中心偏置,造成跟踪失败。为解决这一问题,本文通过一种目标偏移量学习的方式,使网络能预测出目标在两帧图像之间的偏移量而不是相似度,这使得深度网络通过学习的方式获取到全卷积网络平移不变性的特性,成功引入MobileNetV2作为特征提取网络。同时,为了适应于目标跟踪任务,将MobileNetV2的第4个bottleneck块和第6个bottleneck块的下采样率设为1,使网络的总下采样率由32调整为8,并通过加入空调卷积层来增加网络的感受野[15],最后在网络的输出部分增加一个

在目标得分估计模块,采用偏移量学习的方式进行训练,通过引入一个偏移量t=(tx,ty),表示目标相对于得分置信度特征响应图中心点c的偏移量,其值等于(Tx/s,Ty/s),其中,Tx、Ty表示训练时,通过数据增强的方式对图像目标区域随机产生的平移量,s表示网络的总下采样率。将与目标偏移后的中心点的距离在一定范围内的点视为正样本,其余的点都为负样本,则目标得分估计模块的标签ys表示为

| ${{{y}}_s} = \left\{ {\begin{array}{*{20}{l}} { + 1,\quad s\left\| {u - c - t} \right\| \leqslant 16} \\ { - 1,\quad \text{其他} } \end{array}} \right.$ | (2) |

式中

本文在孪生网络的基础上,新增了一个目标尺度估计模块,将MobileNetv2提取到的模板特征与搜索特征进行卷积,得到一个包含目标信息的特征图,再通过一个

| $\begin{gathered} f\left( {x,y} \right) = \sum\limits_{i,j} {\max \left( {0,1 - \left| {x - i} \right|} \right) \times } \\ {\rm{ }}\max \left( {0,1 - \left| {y - i} \right|} \right) \times {w_{i,j}} \end{gathered} $ |

| ${{P}}\left( {{\rm{bin,}}{{I}}} \right){\rm{ = }}\int_{{y_1}}^{{y_2}} {\int_{{x_1}}^{{x_2}} {f\left( {x,y} \right){\rm{d}}x{\rm{d}}y} } /S$ |

式中:

在实际跟踪时,目标尺度估计模块根据目标得分模块得到目标

| $ \frac{{\partial {{P}}\left( {{\rm{bin}},{{I}}} \right)}}{{\partial {x_{1,j}}}} = \frac{{{{P}}\left( {{\rm{bin}},{{I}}} \right)}}{{{x_{2,j}} - {x_{1,j}}}} - \frac{{\displaystyle\int_{{y_{1,j}}}^{{y_{2,j}}} {f\left( {{x_{1,j}},{y_j}} \right)} {\rm{d}}y}}{{\left( {{x_{2,j}} - {x_{1,j}}} \right)\left( {{y_{2,j}} - {y_{1,j}}} \right)}} $ |

其他坐标导数同理可得,因此通过梯度上升法可对目标边界框进行迭代修正,使目标IoU最大:

| $\begin{gathered} {\rm{grad = }} {\nabla _{{x_{1,j}},{y_{_{1,j}}},{x_{2,j}},{y_{_{2,j}}}}}{{F}}\left( {{{P}}\left( {({x_{1,j}},{y_{1,j}},{x_{2,j}},{y_{2,j}}),{{I}}} \right)} \right) \end{gathered} $ |

| $\left( {{x_{1,j}},{y_{1,j}},{x_{2,j}},{y_{2,j}}} \right) = ({x_{1,j}},{y_{1,j}},{x_{2,j}},{y_{2,j}}) + \lambda \cdot {\rm{grad}}$ |

式中:F表示全连接层;P表示PrPool;

为了充分利用MobileNetV2网络的多层特征,利用MobileNetV2的bottleneck3、bottleneck5、bottleneck7分别对模板图像与搜索图像提取特征进行卷积,得到在3个不同层下的特征输出

对于目标得分估计模块,本文采用一种残差融合的策略,将

| ${L_s}\left( {{{{y}}_{{{s,}}}}{\rm{score}}} \right) = \frac{1}{{\left| {\rm{score}} \right|}}\sum\limits_{u \in {{M}}} {l\left( {{{{y}}_{{s}}}\left[ u \right],{\rm{score}}\left[ u \right]} \right)} $ |

| $l\left( {{{{y}}_{{s}}},{\rm{score}}} \right) = \log (1 + \exp ( - {{{y}}_{{s}}}{\rm{score}}))$ |

式中:

对于目标尺度估计模块,在网络训练时,将目标边界框的groundtruth加入一个高斯噪声,生成16个不同的边界框,并保证每个边界框与groundtruth的IoU大于0.1,将这16个边界框映射到MobileNetV2在目标尺度估计模块所提取到的特征

| ${\rm{IoU}} = {{F}}\left( {{{c}}\left( {{{P}}\left( {{\rm{bin}},{{{I}}_1},{{{I}}_2},{{{I}}_3}} \right)} \right)} \right)$ |

式中:

| ${L_{\rm{iou}}} = \frac{1}{{2n}}{\sum\limits_{i = 1}^n {\left\| {{y_{{\rm{iou}},i}} - {\rm{Io}}{{\rm{U}}_i}} \right\|} ^2}$ |

式中:

| $L = {L_{\rm{iou}}} + \lambda \cdot {L_s}$ |

式中

在ILSVRC2015、Lasot[17]、Coco、GOT-10k[18]数据集中每次以相同的概率随机选取一个数据集,并在数据集中随机选取一个视频帧中相隔一定距离的图像对(Coco数据集选取一对相同的图片作为数据扩充),采用平移、缩放、翻转、模糊等数据增强手段对图像对进行处理,最后将图像对输入到网络进行训练。利用随机梯度下降法来训练网络参数,共训练20代,前5代学习率从

当目标发生完全遮挡时,由于无法检测到目标,导致目标丢失。当目标再次出现在视野中时,算法已经无法跟踪到目标。如果此时能知道目标可能存在的区域,并对这些区域进行检测,则能再次恢复对目标的跟踪。因此,可利用人眼视觉注意力机制,对图像的显著性区域进行检测,以恢复跟踪。

2.1 显著性检测算法设计本文所设计的显著性检测算法包含3部分,分别是特征提取网络、编码网络、解码网络。首先将图像输入到特征提取网络得到图像各层次的通用特征,再利用编码网络得到图像的显著性特征,最后通过解码网络得到显著性图的预测,网络的整体结构如图2所示。

|

Download:

|

| 图 2 显著性检测算法网络结构 Fig. 2 Saliency detection network structure | |

基于深度学习的显著性检测算法[19-22]多采用VGG16[23]作为特征提取网络,并已取得不错的效果,但是却难以在无人机机载处理器上实时运行。因此本文同样采用MobileNetV2作为显著性检测算法的特征提取网络,同时为了将其预训练模型迁移到显著性检测任务中,需要对其结构进行一些调整。MobileNetV2原本是适用于图像分类的网络,因此下采样率很高,且最后通过全连接层进行分类。为了应用于显著性检测,首先去掉了MobileNetV2网络最后的全连接层以及多余的卷积池化层。由于显著图是一种像素级的预测,太大的网络下采样率会损坏预测的精度。因此,将MobileNetV2的bottleneck4和bottleneck6的步长设为1,这样使网络的总下采样率为8,保障了输出显著性图的分辨率。同时,在减少下采样率后,为了保持调整后的网络和预训练模型中的网络具有相似的感受野,在最后4个bottleneck结构中加入空洞卷积。

2.1.2 编、解码网络在语义分割任务中,同时利用网络不同层之间的特征,有利于分割的空间细节恢复[24]。而显著性检测同样是一种像素级的预测,虽然不需要准确地找出目标及其边界的像素,多层特征同样有利于显著性图的预测[22]。因此,对于编码网络,本文同时利用MobileNetV2的bottleneck3、bottleneck5、bottleneck7模块的输出,将这3层的输出表示为

在SALICON数据集[25]上对网络进行训练,该数据集包含了10000张训练图片,5000张验证图片,5000张测试图片,笔者利用CoCo数据集中的图片,通过鼠标运动代替眼动追踪系统,对数据集进行标注,经验证这2种方式标注产生的显著性图具有高度的相似性。

通过将网络输出的显著性图归一化到

| $L\left( {{{{y}}^{{t}}},{{{y}}^{{p}}}} \right) = \sum\limits_i {y_i^t} \log \left( {\frac{{{ y}_i^t}}{{{ y}_i^p + \varepsilon }}} \right) - \frac{{\sigma \left( {{{{y}}^{{p}}},{{{y}}^{{t}}}} \right)}}{{\sigma \left( {{{{y}}^{{p}}}} \right) \cdot \sigma \left( {{{{y}}^{{t}}}} \right)}}$ |

式中:

利用Adam[27]优化算法,对网络参数进行优化,共训练10代,每次同时训练10张图片,学习率为

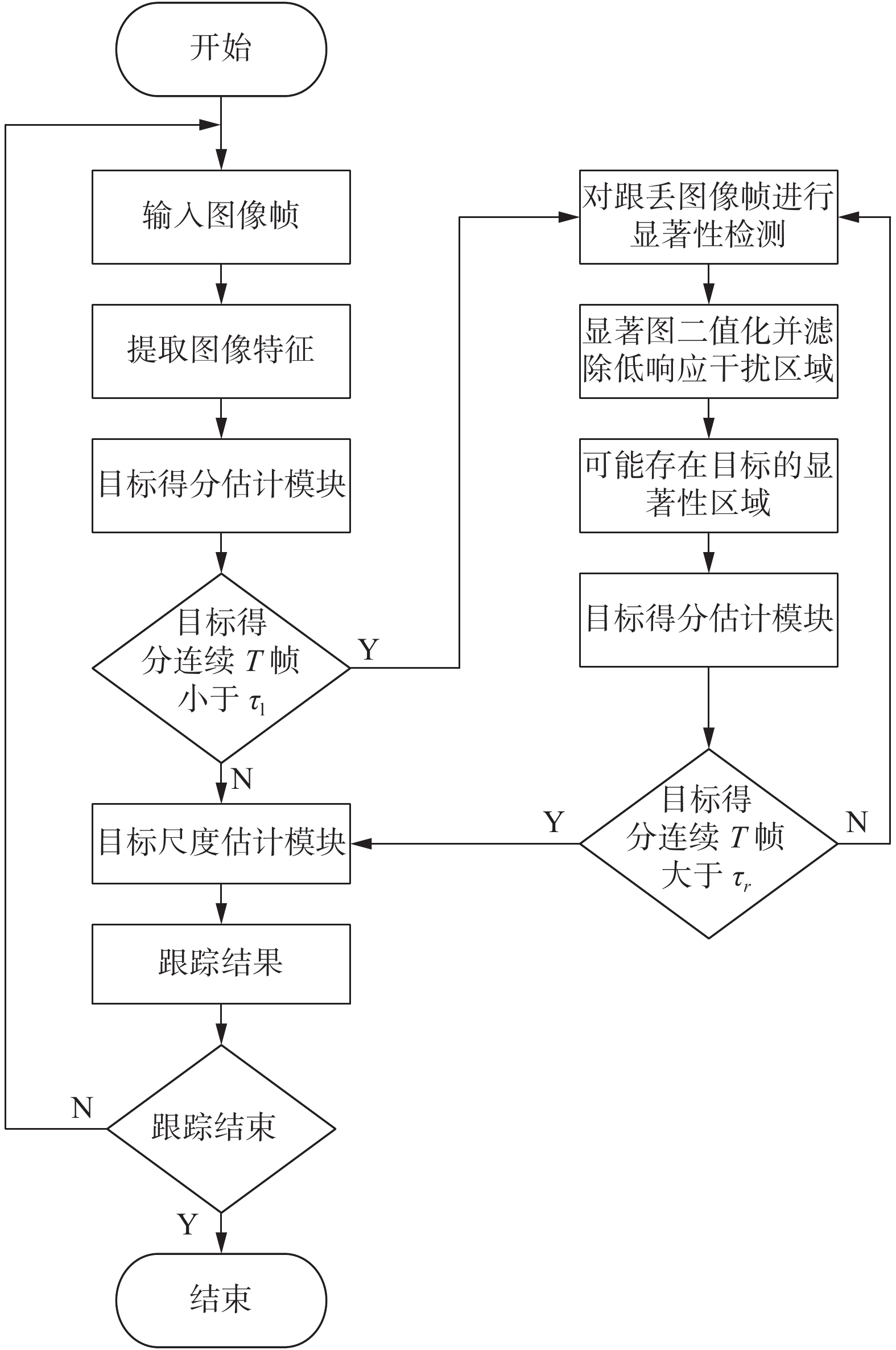

为实现对目标的再检测,将所设计的显著性检测算法嵌入到目标跟踪算法框架中。其具体的框架流程如图3所示。在跟踪过程中如果目标得分连续

|

Download:

|

| 图 3 算法整体框架流程 Fig. 3 Overall framework structure of the algorithm | |

为了对无人机目标跟踪算法进行实验测试,首先在UAV123数据集上对目标跟踪算法性能进行验证,实验采用的平台为:Intel(R) CoreTM i9-9900k, Nvidia RTX2080ti。最后,在六旋翼飞行器平台上对跟踪算法进行了测试验证,该飞行器搭载Jetson Xavier NX作为机载处理器,采用Realsense D435相机实时获取图像信息。

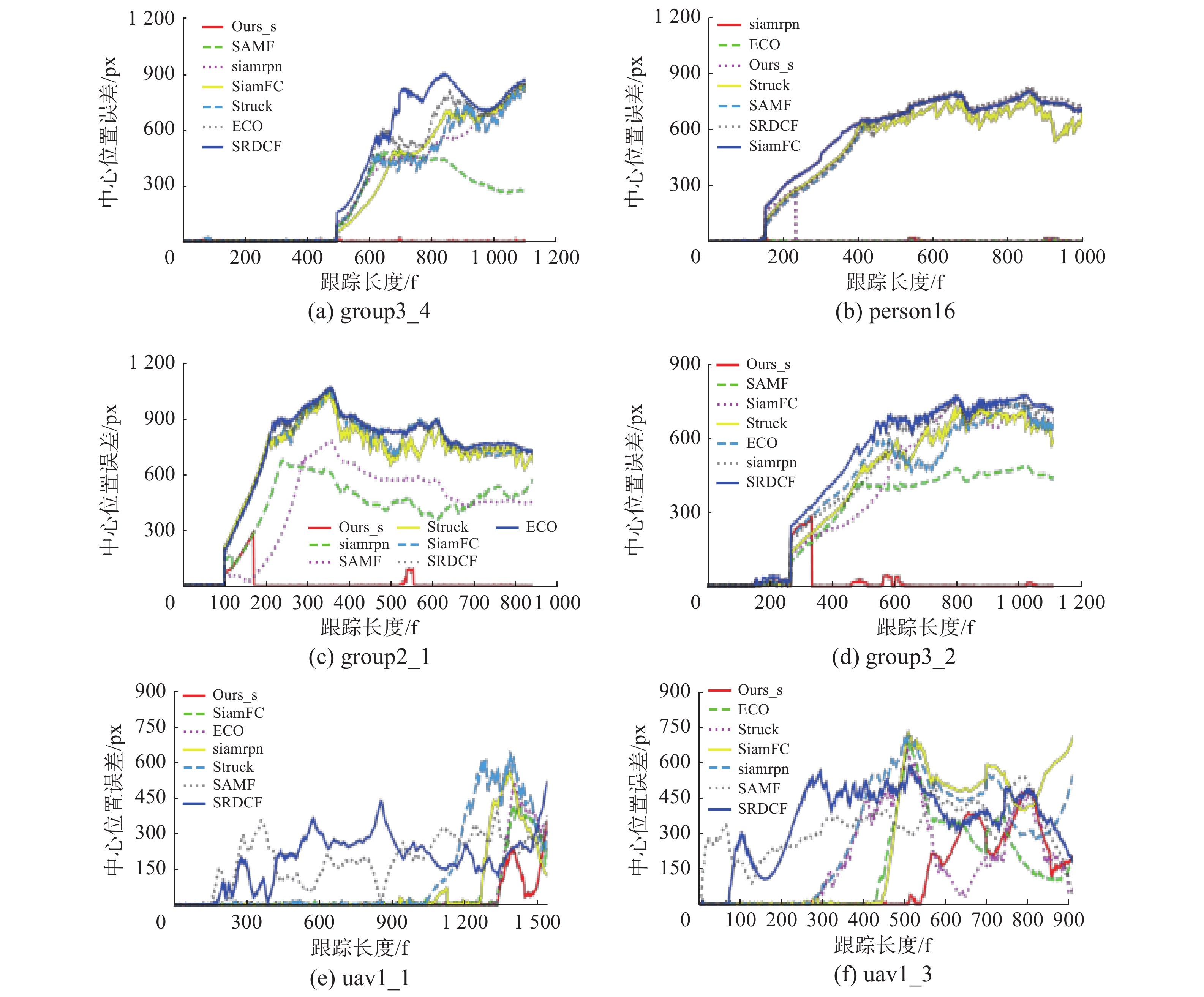

3.1 目标跟踪算法实验测试为对本文目标跟踪算法进行测试,选取UAV123[28]数据集作为测试序列,该数据集包含了123个无人机拍摄的视频序列,涵盖了目标遮挡、尺度变化、视角变化、背景复杂、相似目标、光照变化、相机运动等12种复杂情况。无人机在飞行过程中视角变化、运动幅度大,因此该数据集具有较高挑战难度。将本文算法与ECO[6]、SiamFC[8]、SiamRPN[10]、SAMF[29]、SRDCF[30]、STRUCK[31]这6种跟踪算法进行实验效果对比,采用覆盖率与中心位置误差2种评价指标进行定量分析。覆盖率表示预测目标框与真实目标框的重叠率,中心位置误差表示预测目标框中心与真实目标框中心的欧氏距离。最后利用成功率图与准确率图对测试结果进行表示,其中,成功率图表示在不同覆盖率阈值下,满足覆盖率阈值要求的视频图像帧与总视频图像帧的比率。准确率表示在不同中心位置误差阈值下,满足中心位置误差阈值要求的视频图像帧与总视频图像帧的比率。

将本文算法与这6种算法在UAV123数据集上的12种不同情况进行对比。本文算法的综合平均成功率达到了0.602,平均准确率达到了0.810,几乎在各种情况下的性能都优于其他算法,并且本文算法在完全遮挡、超出视野、背景复杂、快速运动、视觉变化、尺度变化等情况下的性能相较其他算法都有明显的优势。UAV123数据集12种情况下的部分成功率与准确率结果如图4所示,其中Ours_s表示结合再检测模块的跟踪算法。

|

Download:

|

| 图 4 UAV123数据集测试结果 Fig. 4 Tracking results of UAV123 dataset | |

为了进一步验证再检测模块对跟踪算法性能的提升,对未加入再检测模块的跟踪算法进行测试,并与加入再检测模块后的算法对比,其测试的结果如表1、2所示。其中,Ours表示仅利用本文图1中所提的跟踪算法,Ours_s表示进一步结合再检测模块的跟踪算法。

| 表 1 再检测模块成功率性能对比 Tab.1 Performance comparison of the success rate of re-detection module |

| 表 2 再检测模块准确率性能对比 Tab.2 Performance comparison of the accuracy of re-detection module |

在加入再检测模块后,跟踪算法在完全遮挡情况下的性能具有明显提升,对超出视野的情况,由于数据集大部分目标超出视野再回到视野中时,目标位置变化不大,所以不需要再检测模块也能恢复对目标的跟踪,这也说明了本文算法在没有加入再检测模块时,相较于其他算法,在超出视野的情况下也具有明显的优势,这得益于基于偏移量学习的目标得分估计模块,在目标回到视野时能准确识别出目标,以及尺度估计模块,对目标当前位置和尺度进行修正。对于背景复杂情况下性能的提升,是由于再检测模块解决了部分因背景复杂而导致目标跟丢失的视频序列,如group2_1、group2_3、group3_2、group3_4等。这使得当遮挡等问题解决时,在背景复杂情况下的性能也得到了提升。而快速运动、尺度变化、视角变化等情况,再检测模块只发挥了较小的作用。

进一步,选取group2_1、group3_2、group3_4等遮挡情况下的视频序列,将其每帧的中心位置误差进行分析,结果如图5所示。本文算法在所有数据集测试时,为了便于分析,在目标跟丢失,仍然用跟踪算法进行跟踪,以获取跟丢失时的目标框位置,进行误差分析,同时利用再检测模块获取恢复跟踪后的目标位置。而在实际应用中,当目标跟丢失时应停止运行跟踪算法,只运行再检测模块,直到重定位到目标。

|

Download:

|

| 图 5 中心位置误差曲线 Fig. 5 Center position error curve | |

以group3_2为例,目标在200多帧时因遮挡跟丢,这时所有算法的中心位置误差都发生显著变化,并逐渐变高。在300多帧时,本文算法因再检测模块的作用,重新识别到目标,恢复跟踪,使中心位置误差又回到了较低的位置,明显改善了跟踪性能。对于person16,由于SiamRPN和ECO算法在目标跟丢时,目标框位置刚好与目标再次出现在视野中的位置相近,使得目标能恢复跟踪,因此整体中心位置误差较小。而本文算法则通过再检测模块恢复了跟踪,由于有一段跟丢的图像序列,因此整体误差变大。对于uav1_1和uav1_3,由于目标频繁地离开视野再回到视野,并且背景模糊,所有算法位置误差都产生了较大波动。相较于其他算法本文算法依然能使中心误差维持在一个更低的水平。

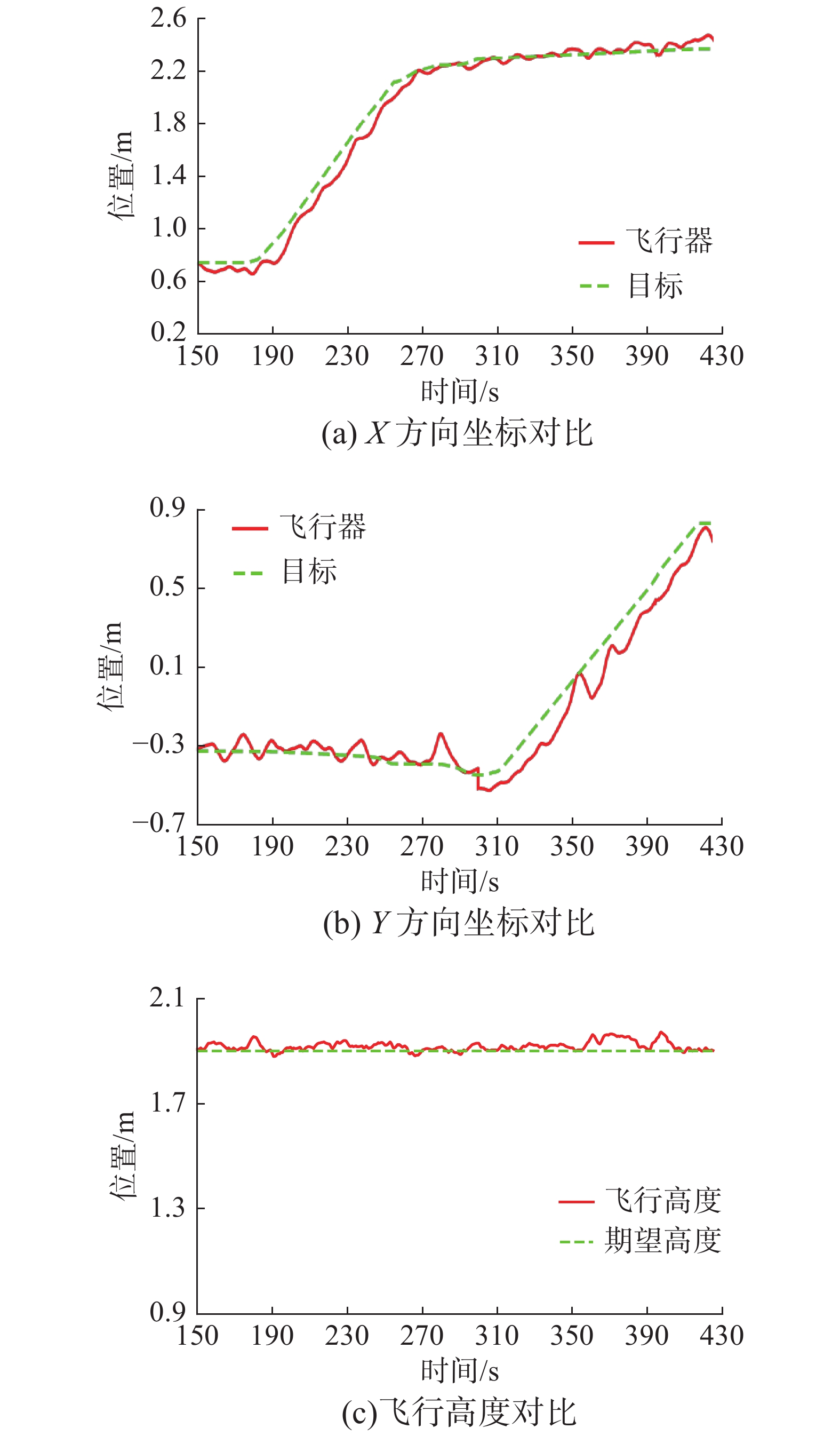

3.2 无人机跟踪实验为了验证该算法在飞行器目标跟踪系统中的可行性,本文利用自主搭建的六旋翼飞行器进行实验。将Realsense D435相机水平安装在飞行器底部,以实时获取图像信息;通过搭载的Nvidia Xavier NX处理器实时地对输入图像运行跟踪算法;通过ROS系统实现地面站与机载处理器以及飞控之间的通信。最后用于飞行器对地面移动机器人进行自主跟踪,在跟踪过程中,使飞行器的飞行高度保持在1.9 m,偏航角保持在

|

Download:

|

| 图 6 六旋翼飞行器结构 Fig. 6 Hexarotor structure diagram | |

|

Download:

|

| 图 7 跟踪结果 Fig. 7 Tracking results | |

为了对跟踪轨迹进行分析,利用定位系统,获取地面移动机器人坐标。将未发生遮挡时的地面移动机器人与飞行器的X、Y方向坐标以及飞行器当前高度与期望高度进行对比,结果如图8所示。从跟踪坐标曲线可以看出:在150~280 s时,目标(地面移动机器人)主要沿X方向运动,由于目标移动速度高于飞行器,这时飞行器X坐标值略微低于目标X坐标值,跟随在其后,而飞行器Y坐标围绕目标Y坐标上线波动,保持在目标Y坐标中心附近;在280~400 s,目标主要沿Y方向移动,这时飞行器Y坐标值略微低于目标Y坐标值,跟随在其后,而飞行器X坐标围绕目标X坐标上下波动,保持在目标X坐标中心附近。总体来看,飞行器与目标在X、Y方向的坐标误差始终保持在20 cm以内,飞行器的飞行高度与期望高度保持在10 cm以内,保障了飞行器对目标的稳定跟踪。

|

Download:

|

| 图 8 跟踪坐标曲线 Fig. 8 Tracking coordinate curve | |

本文针对旋翼飞行器目标跟踪问题提出了一种基于MobileNetV2的孪生网络目标跟踪算法,该算法通过目标得分模块估计出目标初始位置,在获取初始位置后,利用目标尺度估计模块对目标位置及尺度进行迭代修正,通过多层特征融合,进一步提升算法性能。针对目标完全遮挡问题,本文提出了一种基于显著性检测的目标再检测算法,利用对显著性区域的再检测,恢复对目标的跟踪,并通过仿真实验证明了跟踪算法性能及再检测模块的作用,最后,通过实现飞行器对目标的跟踪,证明了该算法的可行性。

| [1] |

徐怀宇, 黄伟, 董明超, 等. 无人机目标跟踪综述[J]. 网络新媒体技术, 2019, 8(5): 11-20. XU Huaiyu, HUANG Wei, DONG Mingchao, et al. Overview of UAV object tracking[J]. Journal of network new media, 2019, 8(5): 11-20. DOI:10.3969/j.issn.2095-347X.2019.05.002 (  0) 0)

|

| [2] |

刘芳, 孙亚楠, 王洪娟, 等. 基于残差学习的自适应无人机目标跟踪算法[J]. 北京航空航天大学学报, 2020, 46(10): 1874-1882. LIU Fang, SUN Yanan, WANG Hongjuan, et al. Adaptive UAV target tracking algorithm based on residual learning[J]. Journal of Beijing University of Aeronautics and Astronautics, 2020, 46(10): 1874-1882. (  0) 0)

|

| [3] |

HENRIQUES J F, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]//12th European Conference on Computer Vision. Florence, Italy, 2012: 702−715.

( 0) 0)

|

| [4] |

HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(3): 583-596. DOI:10.1109/TPAMI.2014.2345390 ( 0) 0)

|

| [5] |

DANELLJAN M, ROBINSON A, KHAN F S, et al. Beyond correlation filters: learning continuous convolution operators for visual tracking[C]//14th European Conference on Computer Vision. Amsterdam, The Netherlands, 2016: 472−488.

( 0) 0)

|

| [6] |

DANELLJAN M, BHAT G, KHAN F S, et al. Eco: efficient convolution operators for tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 6638−6646.

( 0) 0)

|

| [7] |

TAO Ren, GAVVES E, SMEULDERS A W M. Siamese instance search for tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 1420−1429.

( 0) 0)

|

| [8] |

BERTINETTO L, VALMADRE J, HENRIQUES J F, et al. Fully-convolutional Siamese networks for object tracking[C]//European Conference on Computer Vision. Amsterdam, The Netherlands, 2016: 850−865.

( 0) 0)

|

| [9] |

VALMADRE J, BERTINETTO L, HENRIQUES J, et al. End-to-end representation learning for correlation filter based tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 2805−2813.

( 0) 0)

|

| [10] |

LI Bo, YAN Junjie, WU Wei, et al. High performance visual tracking with Siamese region proposal network[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 8971−8980.

( 0) 0)

|

| [11] |

REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 39(6): 1137-1149. ( 0) 0)

|

| [12] |

JIANG Borui, LUO Ruixuan, MAO Jiayuan, et al. Acquisition of localization confidence for accurate object detection[C]//Proceedings of the European Conference on Computer Vision (ECCV). Munich, Germany, 2018: 816−832.

( 0) 0)

|

| [13] |

SANDLER M, HOWARD A, ZHU Menglong, et al. MobileNetv2: inverted residuals and linear bottlenecks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 4510−4520.

( 0) 0)

|

| [14] |

LI Bo, WU Wei, WANG Qiang, et al. Siamrpn++: evolution of Siamese visual tracking with very deep networks[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, USA, 2019: 4277−4286.

( 0) 0)

|

| [15] |

YU F, KOLTUN V. Multi-scale context aggregation by dilated convolutions[EB/OL]. (2020−12−29)[2021−01−10] https://arxiv.org/abs/1511.07122, 2016.

( 0) 0)

|

| [16] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 770−778.

( 0) 0)

|

| [17] |

FAN Heng, LIN Liting, YANG Fan, et al. LaSOT: a high-quality benchmark for large-scale single object tracking[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, USA, 2019: 5369−5378.

( 0) 0)

|

| [18] |

HUANG Lianghua, ZHAO Xin, HUANG Kaiqi. GOT-10k: a large high-diversity benchmark for generic object tracking in the wild[J]. IEEE transactions on pattern analysis and machine intelligence, 2021, 43(5): 1562-1577. DOI:10.1109/TPAMI.2019.2957464 ( 0) 0)

|

| [19] |

CORNIA M, BARALDI L, SERRA G, et al. Predicting human eye fixations via an LSTM-based saliency attentive model[J]. IEEE transactions on image processing, 2018, 27(10): 5142-5154. DOI:10.1109/TIP.2018.2851672 ( 0) 0)

|

| [20] |

KRONER A, SENDEN M, DRIESSENS K, et al. Contextual encoder-decoder network for visual saliency prediction[J]. Neural networks, 2020, 129: 261-270. DOI:10.1016/j.neunet.2020.05.004 ( 0) 0)

|

| [21] |

WANG Wenguan, SHEN Jianbing. Deep visual attention prediction[J]. IEEE transactions on image processing, 2018, 27(5): 2368-2378. DOI:10.1109/TIP.2017.2787612 ( 0) 0)

|

| [22] |

CORNIA M, BARALDI L, SERRA G, et al. A deep multi-level network for saliency prediction[C]//2016 23rd International Conference on Pattern Recognition (ICPR). Cancun, Mexico, 2016: 3488−3493.

( 0) 0)

|

| [23] |

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. (2020−12−19)[2021−01−10] https://arxiv.org/abs/1409.1556, 2014.

( 0) 0)

|

| [24] |

LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA, 2015: 3431−3440.

( 0) 0)

|

| [25] |

JIANG Ming, HUANG Shengsheng, DUAN Juanyong, et al. SALICON: saliency in context[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA, 2015: 1072−1080.

( 0) 0)

|

| [26] |

JETLEY S, MURRAY N, VIG E. End-to-end saliency mapping via probability distribution prediction[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 5753−5761.

( 0) 0)

|

| [27] |

KINGMA D P, BA J. Adam: a method for stochastic optimization[EB/OL]. (2020−12−29)[2021−01−10] https://arxiv.org/abs/1412.6980, 2014.

( 0) 0)

|

| [28] |

MUELLER M, SMITH N, GHANEM B. A benchmark and simulator for UAV tracking[C]//14th European Conference on Computer Vision. Amsterdam, The Netherlands, 2016: 445−461.

( 0) 0)

|

| [29] |

LI Yang, ZHU Jianke. A scale adaptive kernel correlation filter tracker with feature integration[C]//European Conference on Computer Vision. Zurich, Switzerland, 2014: 254−265.

( 0) 0)

|

| [30] |

DANELLJAN M, HÄGER G, KHAN F S, et al. Learning spatially regularized correlation filters for visual tracking[C]//Proceedings of the IEEE International Conference on Computer Vision. Santiago, Chile, 2015: 4310−4318.

( 0) 0)

|

| [31] |

HARE S, GOLODETZ S, SAFFARI A, et al. Struck: structured output tracking with kernels[J]. IEEE transactions on pattern analysis and machine intelligence, 2016, 38(10): 2096-2109. DOI:10.1109/TPAMI.2015.2509974 ( 0) 0)

|

2021, Vol. 16

2021, Vol. 16