2. 国家林业草原林业智能信息处理工程技术研究中心,北京 100083;

3. 中国科学院 半导体研究所,北京 100083;

4. 中国科学院大学 微电子学院,北京 100045

2. Engineering Research Center for Forestry-oriented Intelligent Information Processing of National Forestry and Grassland Administration, Beijing 100083, China;

3. Institute of Semiconductors, Chinese Academy of Sciences, Beijing 100083, China;

4. School of Microelectronics, University of Chinese Academy of Sciences, Beijing 100045, China

线条肖像画,是描绘人物形象的一种绘画方式,是一种独具风格的艺术表现形式。线条肖像画具有非常悠久的历史,发展至今仍十分流行,世界各国的艺术家经常举办相关艺术展,甚至在公园、广场等场所也常会遇到正在进行线条肖像画创作的街头艺术家。众所周知,线条肖像画以线条的形式真实、生动地体现人物特征,其创作需要很高的专业能力和艺术功底,是一项具有创意性、专业性且精细化程度高、极耗时、耗力的艺术活动,如何使用计算机来代替人类绘画成为一个热点问题[1]。随着计算机视觉及人工智能技术的蓬勃发展,各行各业都涌现出了多种多样的智能机器人以满足不同的需求,而艺术创作一直被视为机器人智能的重要表现[2]。因而,探索面向机器艺术的线条肖像画艺术创作方法已成为人工智能与艺术融合的研究热点,如何提取凸显人物特征的线条并简洁展现成为创作的关键。

当前,线条提取方法通常基于边缘检测算法,通过设计各种边缘检测算子,检测灰度图像的一阶微分和二阶微分的响应来获取边缘,从而生成线条肖像画图像,如:一阶微分检测边缘的滤波算子Sobel、交叉梯度Roberts算子,二阶微分拉普拉斯算子(laplace operator)、Marr-Hildreth算子、DoG算子(difference-of-gaussians, DoG)等。Canny[3]检测算法由于计算简单、边缘定位准确,在边缘检测领域广泛使用。Laplacian算子基于检测二阶微分来检测边缘,Marr-Hildreth算子是一种经过高斯平滑的拉普拉斯变换。Gooch等[4]利用2个高斯滤波核的差(difference-of-gaussians,DoG)来近似表示Marr-Hildreth算子[5],大大节省了计算量,并取得了较好的线条提取效果。但由于DoG滤波的核是各项同性的,不能很好地考虑图像自身边缘的流向性,因而往往会出现一些杂乱的短线条干扰线条特征的表达。针对这一问题,Kang等[6]提出了基于流的高斯差分(flow-based difference of gaussian,FDoG)算法,使用基于流的各向异性滤波器替代传统边缘检测算子,有效减少了线条的断裂现象,提高了线条的连贯性与平滑性,同时抑制了噪声。然而,这种方法仍具有一定的局限性,如对颜色不同但亮度近似的2个灰度域的边界提取效果并不理想。为此,很多专家学者基于FDoG算法进行了大量优化改进的尝试。Wang等[7]在FDoG的基础上提出了一种梯度引导方法,实现了对亮度相近颜色不同区域的边缘检测。王山东等[8-9]基于FDoG算法提出了基于特征流的抽象线条画绘制方法,将高斯一阶导滤波结果和高斯差分滤波结果进行混合作为边缘检测的微分响应,所生成的线条图像对线条位置的检测更为准确,但其线条却十分复杂。柳有权等[10]提出了一种建筑线条生成方法,检测建筑物的直线并强化直线的切向流,以突出建筑物的线条特征,但这种面向具有规则几何结构的线条生成方法对于人脸这类不规则图像的线条提取却难以适用。与FDoG构建切向流场的方式不同,Kyprianidis等[11]提出用结构张量构建图像的切向流场,这种方法容易实现但是对噪声比较敏感。Winnemöller等[12]提出的XDoG算法通过微调可以形成多种不同风格的效果。此外,随着深度学习技术的发展,基于神经网络的线条生成方法也应运而生[13-16],但这些方法多为黑盒系统,难以有针对性地进行参数量化调整,因此无法实现对线条的调控,应用效果受限。

综合上述分析,目前主流的线条提取算法往往生成复杂的线条以保持可辨识的人脸特征,且对不同区域线条提取的精细程度采用统一调整的方式,使得线条肖像画总体线条较复杂、机器人机械臂绘图时间较长。鉴于此,本文提出了一种基于语义分割的简洁线条肖像画生成方法,利用语义分割技术,将人脸图像划分为不同区域,进而利用不同区域之间的边缘,得到人脸主轮廓线条和五官区域线条,以优化边缘切向流场;进一步,采用不同的参数配置,分区域进行线条生成,实现对细节无关区域的线条简化和细节重点区域的线条加强,最终达到肖像线条总体简洁、个性化特征可辨识、有效缩短机器人机械臂绘制时间的目标。

1 相关技术 1.1 人脸语义分割图像语义分割是图像处理领域的一个热点问题,目的是理解图像的语义信息,按照图像中的语义分析进行分割,本文利用语义分割按照人脸图像中内容的不同,将人脸图像划分为不同区域,为后续的分区域图像处理奠定基础。图像语义分割的方法可以分为2种,一种是基于区域分类的图像语义分割方法,另一种是基于深度学习的像素级图像语义分割方法。在基于深度学习的像素级图像语义分割方法中,DeepLab系列 ADDIN EN.CITE.DATA[17-20]取得了公认的效果,该系列的主要特点是采用空洞卷积来代替传统卷积,在没有增加参数的情况下,增大了感受野。其中DeepLabV3+采用了编码解码的结构,在解码阶段使用了编码阶段的信息来优化目标的细节。本文采用DeepLabV3+来构建人脸语义分割模型,对人脸图像的不同区域进行划分,从而实现针对性的图像处理操作,生成简洁线条肖像画。

1.2 FDoG方法FDoG是一种各项异性边缘检测滤波器,可以根据图像自身的一些局部方向特征改变滤波的过程,相比于各项同性滤波器能够检测到具有一致性的线条。FDoG算法主要包括2个过程:

1)构造图像边缘切向流场。边缘切向流(edge tangent flow, ETF)是垂直于梯度、表示局部边缘流曲线的正切向量,用

| $ \begin{aligned} \!\!\!\! \!\! {t^{{\rm{new}}}}\left( x \right) = \dfrac{1}{k}\mathop {\displaystyle\sum \limits_{y \in \Omega \left( x \right)}} \phi (x,y){t^{\rm{cur}}}\left( y \right){\omega _s}\left( {x,y} \right) {\omega _m}\left( {x,y} \right){\omega _d}\left( {x,y} \right) \end{aligned} $ | (1) |

式中:

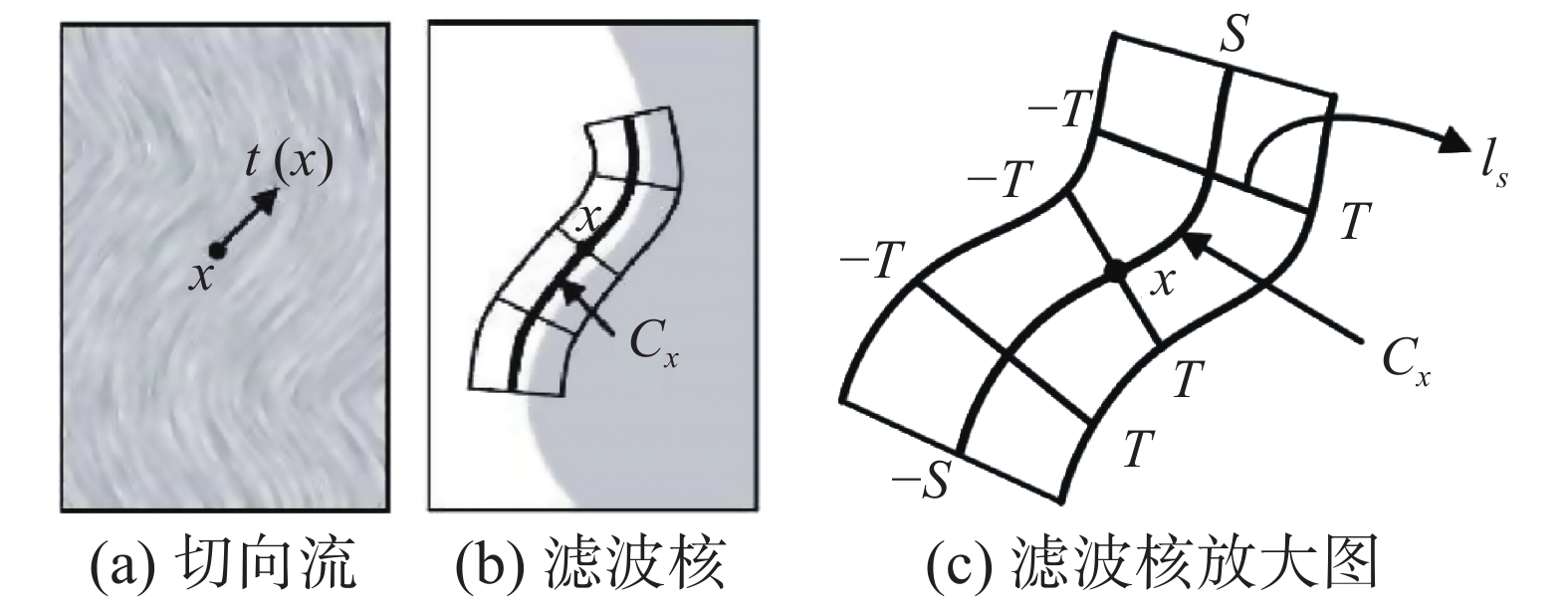

2)基于ETF的高斯差分滤波线条提取。基于切向流场进行滤波核卷积以提取线条,如图1所示。首先,设置高斯差分卷积核沿着曲线

| $ F\left( s \right) = \mathop\int\limits_{ - T}^T \left( {{G_{{\sigma _c}}}\left( t \right) - \rho {G_{{\sigma _s}}}\left( t \right)} \right)I\left( {{l_s}\left( t \right)} \right){\rm{d}}t $ | (2) |

| $ H\left( x \right) = \mathop \int \limits_{ - s}^s {G_{{\sigma _m}}}\left( s \right)F\left( s \right){\rm{d}}s $ | (3) |

式中:

|

Download:

|

| 图 1 基于ETF的高斯差分卷积 Fig. 1 Flow-based DoG convolution | |

本文在人脸语义分割基础上,提出了简洁线条肖像画生成方法(concise line portrait generation based on semantic segmentation, CLPG-SS),总体框架如图2所示。首先,在对人脸图像预处理后,对其进行人脸语义分割,得到不同的人脸区域;然后,针对分割得到的头发、面部、颈部、五官等区域,利用FDoG方法提取得到区域边缘轮廓及五官细节线条;在此基础上,进行ETF优化,从而加强轮廓线条和五官细节对应位置的方向;最后,将预处理后的人脸图像与线条提取结果进行融合,并利用优化后的ETF与语义分割结果,针对不同的分割区域调整FDoG参数,以实现对细节无关区域的线条过滤和细节重点区域的线条加强,得到简洁线条肖像画。

|

Download:

|

| 图 2 基于语义分割的简洁线条肖像画生成方法(CLPG-SS)总体架构 Fig. 2 The overall architecture of Concise line portrait generation method based on semantic segmentation ( CLPG-SS) | |

本文人脸图像预处理主要包括人脸检测、特征点定位、人脸归一化、绘图区域裁剪等。其中,人脸归一化操作包括人脸图像的旋转、缩放,以使不同人脸图像保持在同一尺度下。

2.2 人脸语义分割五官反映了一个人有别于他人的主要特征,能表现容貌、表情、年龄等,是人脸特征中最为传神、最具辨识性的特征。因此,本文的思路是尽可能提取并保留完整线条来展现五官特征。同时,轮廓线条也可以一定程度展现人脸的特征,如人脸的轮廓可以反映脸型、胖瘦等,头发的轮廓能反映发型、长短等。因此,本文将人脸与头发的轮廓线条也作为主要特征。而人脸的其他区域,如发丝、颈部等则与人脸的特征相关性不高,故本文将这些区域归为细节无关区域,尽可能做线条简化处理,以降低线条肖像画的复杂度,提高机器人机械臂绘制的效率。

鉴于此,本文针对上述不同区域的处理需求,采用DeepLabV3+语义分割技术,基于CelebAMask-HQ人脸语义分割数据集,构建人脸语义分割模型,实现对人脸不同区域的分割。为了降低模型学习的复杂度并提高人脸分割的准确率,本文对CelebAMask-HQ人脸语义分割数据集的人脸区域划分方式进行了优化,将左右眉毛、左右眼睛、左右耳朵分别归为一类,确定了11种类别,即:头发、面部、颈部、眉毛、眼睛、鼻子、上嘴唇、下嘴唇、口腔、耳朵、背景。

为了提高模型的鲁棒性与泛化能力,本文在人脸语义分割模型训练过程中,对人脸图像及其语义标注图像做了数据增强处理,包括对比度调整、亮度调整、颜色变化、添加不同噪声、添加不同程度模糊、不同程度旋转、不同尺度缩放、替换多样化背景等,以适应在实际应用过程中环境差异、姿态差异等情况。

2.3 线条肖像画生成 2.3.1 线条提取针对人脸语义分割得到的头发、面部、颈部、五官等区域,基于FDoG方法,分别设置2组不同的参数,分别实现头发、面部和颈部区域的边缘轮廓及五官细节线条的提取。

2.3.2 ETF优化在用FDoG进行线条提取时,常因不同区域肤色相近、光照变化等情况导致出现线条提取不完整或五官细节不显著等问题,补充或加强边缘轮廓或细节线条的方向将对改善上述问题起到积极作用。为此,本文提出ETF优化方法,引入单调递增函数

| $ \begin{aligned} {t}^{{\rm{new}}}\left(x\right)=&\dfrac{1}{k}{\displaystyle\sum\limits_{y \in \Omega \left( x \right)}} {\phi (x,y){t^{\rm{cur}}}\left( y \right){\omega _s}\left( {x,y} \right)}\times \\ &{\omega }_{m}\left(x,y\right){\omega }_{d}\left(x,y\right){\omega }_{l}\left(x,y\right) \end{aligned} $ | (4) |

| $ \begin{aligned} {\omega }_{l}\left(x,y\right)=&\dfrac{1}{2}\left(1+{\rm{tanh}}\left[\eta \left({\psi }_{l}\left(y\right)-{\psi }_{l}\left(x\right)\right)\right]\right)\\ &{\psi }_{l}={\rm{ETF}}_{\rm{outline}}+{\rm{ETF}}_{\rm{detail}} \end{aligned} $ |

式中:

本文以预处理后的人脸图像和提取的线条为基础进行图像调和,如式(5)所示。

| $ \begin{aligned} {I_m}\left( {x,y} \right) = {I_{\rm{o}}}\left( {x,y} \right) {I_{\rm{outline}}}\left( {x,y} \right)/255 {I_{\rm{detail}}}\left( {x,y} \right)/255 \end{aligned} $ | (5) |

式中:

采用调和图像

| 表 1 FDoG核心参数对线条肖像画生成效果的影响 Tab.1 The influence of FDoG’s core parameters on the effect of line portrait |

在此基础上,提出分区域参数设置策略,如表2所示。

| 表 2 分区域参数设置策略 Tab.2 Regional parameter setting strategy |

具体说明如下:

1)头发区域:最大程度去除细节线条、保留主轮廓线条,且尽可能保持主轮廓线条的连贯性。考虑到性别、装饰等因素影响,头发区域可能略有差异,因此设置

2)面部区域:最大程度保留轮廓线条,减少面部噪声;

3)颈部区域:尽可能保持轮廓线条的连贯性;

4)眉眼区域:主要包括眉毛、眼睛,由于最为传神的特征体现在眉眼中,因此在线条生成时,要尽可能保留细节,以体现出不同人的个性化特征;

5)其他五官区域:主要包括鼻子、上嘴唇、下嘴唇、口腔、耳朵,考虑到机器人机械臂快速绘制的需求,仅保留大致轮廓即可;

6)背景区域:将背景区域直接置为白色以去除背景的影响,因此无需再对背景进行参数设置。

3 实验及结果分析 3.1 实验设计实验设备:包括图像采集装置、四轴机械臂和计算机(CPU:Intel Core i5 4 590,内存:8 GB)。

实验数据:采用CelebAMask-HQ人脸语义分割数据集,包含30 000张人脸图像。其中,随机选取27 000张作为训练集,用于构建人脸语义分割模型;剩余3 000张作为测试集,用于生成简洁线条肖像画。

对比方法:Canny算法、FDoG方法。

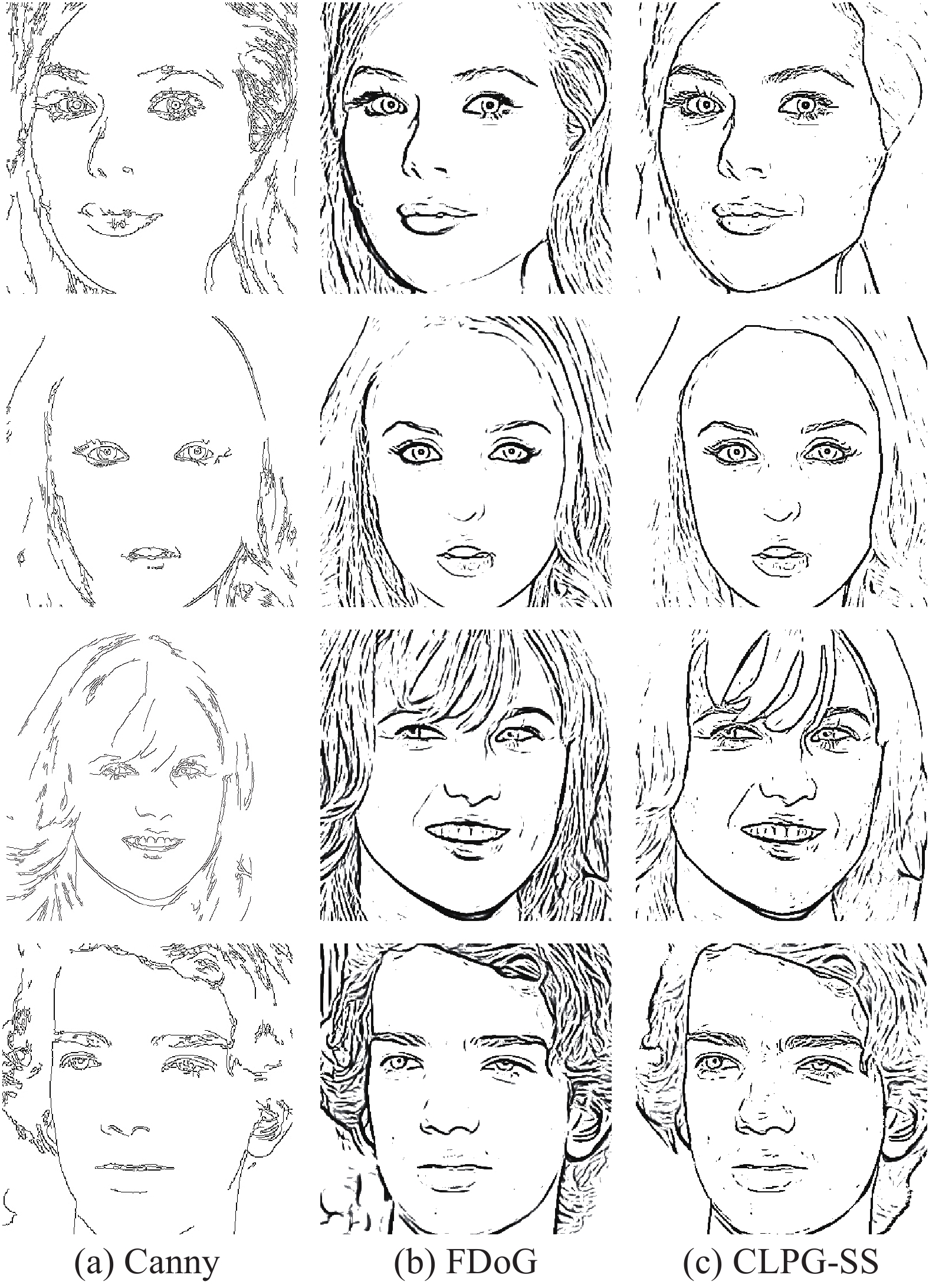

3.2 实验结果及分析 3.2.1 线条提取结果针对预处理后人脸图像的线条提取结果如图3所示。针对图3(a)的头发、面部、颈部语义分割区域,提取边缘轮廓,设置FDoG参数为

基于CLPG-SS的线条肖像画生成结果及与Canny算法、FDoG方法的比较,针对头发区域大小及性别,随机选取4幅图像进行展示,如图4所示,五官部分局部放大如图5所示。可以看出,Canny边缘检测算法所生成的线条宽度一致,无轻重之分,而且对人脸五官等较为重要的线条并未很好地检出,不利于人脸特征的表达,缺少层次感,总体线条效果较为凌乱,无法辨识。FDoG算法虽然能够很好地保持人脸局部特征,但是对于一些视觉上具有明显界限而颜色对比度上没有太大区别的边界,并不能很好地提取线条,如图4中的下巴位置,未能检测到该处的轮廓线条。相比上述2种方法所取得的效果,本文提出的CLPG-SS方法具有较强优势。从图4中可以看出,CLPG-SS方法明显检测到了Canny和FDoG无法检测到的下巴线条,且强化了人脸五官的细节,线条更加流畅、五官层次感更强。此外,CLPG-SS方法加强了头发的主轮廓,精简了头发区域的线条细节,非常有利于提高机械臂的绘制效率。

|

Download:

|

| 图 3 轮廓和五官图 Fig. 3 Outline and facial features details pictures | |

|

Download:

|

| 图 4 线条肖像画生成结果比较 Fig. 4 Comparison of line portrait generation results | |

进一步,本文考察了FDoG中不同参数对线条肖像画生成的影响,如图6所示。图6(a)中,可以观察到提取的线条较细,凸显了人脸中的细节特征,但总体线条较为杂乱,且线条轮廓提取并不完整;图6(b)所提取线条的强度得到增强,但主轮廓仍不完整;图6(c)中,线条完整性得到提高,如提取到了下巴处的轮廓,但同时噪声也得到了放大;图6(d)中 检测到了更多的短线条,但面部、头发区域的噪声得到了放大。由此可见,不同的参数设置会得到从视觉上来说非常不同的线条效果,为本文进行分区域参数设置提供了思路。

|

Download:

|

| 图 5 线条肖像画生成结果局部放大图 Fig. 5 Partial enlarged image of line portrait generation result | |

|

Download:

|

| 图 6 不同参数的线条肖像画生成结果 Fig. 6 Line drawing images with different parameters | |

为了体现ETF优化方法对线条肖像画的增强效果,以图4中的原图为例,对实验结果进行分析,如图7所示。图7(a)为未经过优化的FDoG线条图,图7(b)为仅进行ETF优化的结果,图7(c)为在优化ETF的同时,对人脸图像进行分区域参数设置的效果,即本文提出的CLPG-SS方法。不难发现,相较于FDoG方法,ETF的优化强化了人脸轮廓和五官细节的线条,但是头发区域明显线条过多,不利于机械臂的绘制。而ETF优化与分区域参数设置结合所生成的线条效果整体更为简洁,有效地减少了头发线条的数量,保留了能够体现头发走向的部分重要线条,且五官的细节得到了进一步的增强,原始人脸的特征清晰可辨,降低了机械臂绘图时间,提高了机械臂的绘制效率。

|

Download:

|

| 图 7 ETF优化和分区域参数设置对线条肖像画生成的影响 Fig. 7 The influence of ETF optimization and regional parameter settings on the generation of line portraits | |

为了考察不同方法对机器人机械臂绘图效率的影响,从测试集中按照头发长短、头发区域面积大小等因素随机选择了10张图像,利用CLPG-SS方法、Canny算法、FDoG方法分别生成线条肖像画,由机械臂进行绘制,并统计机械臂的绘图时间,结果如表3所示。从表3中可见,Canny算法的平均时间最少,分析其原因主要是由于Canny算法检测的线条为单像素宽度线条,总体绘图矢量点较少,所以平均时间最短,但其效果最差,绘制出的效果图可辨识效果最差。而FDoG方法和本文所提出的CLPG-SS方法,绘图时间虽然较Canny方法长,但效果较Canny方法有了很大程度的提高。与FDoG方法相比,CLPG-SS方法生成的线条肖像画人脸五官清晰可辨识,平均绘制时间更少,且最长绘制时间几乎是FDoG的一半,这得益于对细节无关区域的线条简化,很大程度上降低了机械臂的绘图时间。

| 表 3 不同方法生成的线条肖像画机械臂绘制时间的对比 Tab.3 Comparison of the drawing time of the line portrait manipulator generated by different methods |

本文提出了一种基于语义分割的简洁线条肖像画生成方法CLPG-SS。该方法通过人脸语义分割将人脸图像划分为头发、面部、颈部、五官等11个区域,利用FDoG方法提取得到区域边缘轮廓及五官细节线条,并建立ETF优化方法以加强轮廓线条和五官细节对应位置的方向,采用不同分割区域设置不同FDoG参数的策略,最终得到既保留了人脸的关键特征又适合机械臂快速绘制的简洁线条肖像画。实验结果验证了CLPG-SS对轮廓以及五官细节有更准确的提取,更加突出了人脸线条的特点,该算法实现简单可靠。

| [1] |

孟盼盼. 肖像绘制机器人技术研究[D]. 合肥: 中国科学技术大学, 2011. MENG Panpan. Research on auto-portrait robot technology[D]. Hefei: University of Science and Technology of China, 2011. (  0) 0)

|

| [2] |

董肖莉. 基于人脸图像的机器肖像艺术技术研究[D]. 北京: 中国科学院大学, 2018. DONG Xiaoli. Research on technologies of machine artistic portrait based on facial images[D]. Beijing: University of Chinese Academy of Sciences, 2018. (  0) 0)

|

| [3] |

CANNY J. A computational approach to edge detection[J]. IEEE transactions on pattern analysis and machine intelligence, 1986, 8(6): 679–698.

( 0) 0)

|

| [4] |

GOOCH B, REINHARD E, GOOCH A. Human facial illustrations: creation and psychophysical evaluation[J]. ACM transactions on graphics, 2004, 23(1): 27–44.

( 0) 0)

|

| [5] |

MARR D, HILDRETH E. Theory of edge detection[J]. Proceedings of the royal society B: biological sciences, 1980, 207(1167): 187–217.

( 0) 0)

|

| [6] |

KANG H, LEE S, CHUI C K. Coherent line drawing[C]// Proceedings of the 5th International Symposium on Non-photorealistic Animation and Rendering. San Diego, CA, USA, 2007: 43–50.

( 0) 0)

|

| [7] |

WANG Shandong, MA Ziyang, LIU Xuehui, et al. Coherence-enhancing line drawing for color images[J]. Science China information sciences, 2013, 56(11): 1–11.

( 0) 0)

|

| [8] |

王山东, 刘学慧, 陈彦云, 等. 基于特征流的抽象线条画绘制[J]. 计算机学报, 2014, 37(3): 611–620. WANG Shandong, LIU Xuehui, CHEN Yanyun, et al. Abstract line drawings from photographs using flow-based filters[J]. Chinese journal of computers, 2014, 37(3): 611–620. (  0) 0)

|

| [9] |

WANG Shandong, WU Enhua, LIU Youquan, et al. Abstract line drawings from photographs using flow-based filters[J]. Computers and graphics, 2012, 36(4): 224–231.

( 0) 0)

|

| [10] |

柳有权, 吴宗胜, 王山东, 等. 建筑物图像的线条画生成算法[J]. 软件学报, 2012, 23(S2): 34-41. LIU Youquan, WU Zongsheng, WANG Shandong, et al. Line drawing technique for building images[J]. Journal of software, 2012, 23(S2): 34-41. (  0) 0)

|

| [11] |

KYPRIANIDIS J E, KANG H, DÖLLNER J. Image and video abstraction by anisotropic Kuwahara filtering[J]. Computer graphics forum, 2009, 28(7): 1955–1963.

( 0) 0)

|

| [12] |

Winnemöller H, Kyprianidis J E, Olsen S C. XDoG: an extended difference-of-Gaussians compendium including advanced image stylization[J]. Computers and graphics, 2012, 36(6): 740-753. ( 0) 0)

|

| [13] |

ZHANG Liliang, LIN Liang, WU Xian, et al. End-to-end photo-sketch generation via fully convolutional representation learning[C]//Proceedings of the 5th ACM on International Conference on Multimedia Retrieval. Shanghai, China, 2015: 627-634.

( 0) 0)

|

| [14] |

ZHU Junyan, PARK T, ISOLA P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]//Proceedings of 2017 IEEE International Conference on Computer Vision. Venice, Italy, 2017: 2223–2232.

( 0) 0)

|

| [15] |

TAIGMAN Y, POLYAK A, WOLF L. Unsupervised cross-domain image generation[J]. arXiv: 1611.02200, 2016.

( 0) 0)

|

| [16] |

SASAKI K, IIZUKA S, SIMO SERRA E, et al. Learning to restore deteriorated line drawing[J]. The visual computer, 2018, 34(6/8): 1077–1085.

( 0) 0)

|

| [17] |

CHEN L C, PAPANDREOU G, KOKKINOS I, et al. Semantic image segmentation with deep convolutional nets and fully connected CRFs[C]//Proceedings of the 3rd International Conference on Learning Representations. San Diego, CA, USA, 2014.

( 0) 0)

|

| [18] |

CHEN L C, PAPANDREOU G, KOKKINOS I, et al. DeepLab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE transactions on pattern analysis and machine intelligence, 2018, 40(4): 834–848.

( 0) 0)

|

| [19] |

CHEN L C, PAPANDREOU G, SCHROFF F, et al. Rethinking atrous convolution for semantic image segmentation[J]. arXiv preprint arXiv: 1706.05587, 2017.

( 0) 0)

|

| [20] |

CHEN L C, ZHU Yukun, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]//Proceedings of the 15th European Conference on Computer Vision (ECCV). Munich, Germany, 2018: 801–818.

( 0) 0)

|

2021, Vol. 16

2021, Vol. 16