随着汽车仪表生产过程的自动化需求不断提高,如何开发出一种高效、实时的指针检测方法成为当前人工智能领域的热点课题[1-3]。面对自动检测技术不断激增的需求[4-5],大多数企业仍采用人工视觉视检的方法来检测仪表指针,人工检测方法受工作状态影响,导致检测标准难以统一,无法满足流水线上仪表的产量需求,检测效率和精度也随之受到影响。由于指针目标较小,对应的像素中包含的特征很少,会导致存在漏检的情况。

现有的仪表指针检测主要基于经典图像处理方法来实现[6],通过匹配目标形状与颜色特征来检测指针位置[7-9]。例如,文献[10]中,作者提出了一种改进的中心投影法,通过定位圆形比例区域来匹配指针轮廓获得指针位置。Hao等[11]基于OpenCV提出并实现了一种汽车仪表自动检测指针系统;Gao等[12]提出了一种鲁棒的字符分割分类器,该分类器是通过级联定向梯度直方图HOG/支持向量机SVM二进制分类器来识别仪表板指针。基于形状特征与颜色特征的方法抗噪性较好,但提取的信息并不充分,且计算量大对硬件支持需求较大,没有考虑实时性与泛化性的需求。因此研究一种汽车仪表指针快速实时检测方法具有重要的现实意义。

近年来,深度学习方法在图像的识别和检测方面涌现了许多优秀成果,成为当前热点研究领域[13-15]。例如,曹锦纲等[16]提出一种基于生成式对抗网络应用于交通场景运动模糊图像增强,能够以较好的图像视觉效果完成模糊图像的增强。文献[17]通过卷积神经网络(CNN)与循环神经网络(RNN)结合,能够实现交通场景端到端语义描述,具有很好的鲁棒性。Ren等[18]提出基于卷积神经网络的Faster R-CNN算法,该网络拥有较强的语义表达和特征表达能力,泛化性能良好。Wu等[19]基于Faster R-CNN实现不同尺度的人脸面部检测,提高了人脸检测的效率。文献[20]使用Faster R-CNN网络实现了人、车及动物等铁路异物的侵限检测,取得了较好的效果。深度学习使得识别与检测纳入一个整体流程,实现端到端的学习[21-24]。

鉴于以上研究,本文提出了一种基于改进Faster R-CNN汽车仪表指针实时检测方法。采用RoI Align层替代原始的RoI Pooling层,保留了小目标的完整像素信息。基于双线性内插方法使特征聚集过程连续化,缩短了特征映射的计算时间。通过多组不同类型的仪表指针实验,在检测时间和检测精度上进行实验评估,验证了所提方法的高效性和实时性。

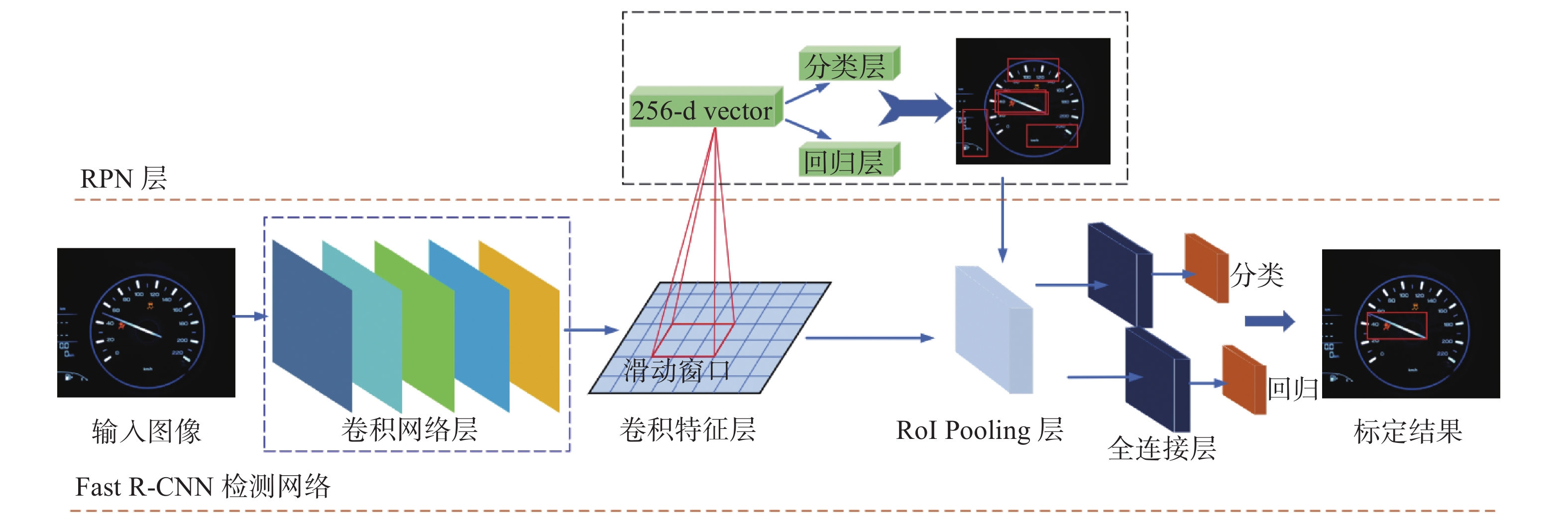

1 Faster R-CNN检测原理Faster R-CNN算法网络框架如图1所示。整体框架由区域建议网络(region proposal network, RPN)和Fast R-CNN检测网络两部分构成。当图像输入网络后,由检测网络中的卷积网络层提取仪表指针特征,得到卷积特征层。卷积特征层被后续的RPN层与检测网络层共享。RPN层使用锚点与特征层,获取指针位置信息并输入到RoI Pooling中,RoI层利用所得到指针位置,进一步微调指针在原图像中的位置,获取仪表指针的精确位置信息,输出标定结果。

|

Download:

|

| 图 1 Faster R-CNN整体框架 Fig. 1 Faster R-CNN overall framework | |

RPN是一个全卷积网络,用来得到候选区域并输出一组矩形区域建议。它使用一个

获得的9个锚点用来预测9个候选区域,每个候选区域用一个四维向量

| $ F[{{\boldsymbol{A_x}}},{{\boldsymbol{A_y}}},{{\boldsymbol{A_w}}},{{\boldsymbol{A_h}}}] = [{\boldsymbol{G'_x}},{\boldsymbol{G'_y}},{\boldsymbol{G'_w}},{\boldsymbol{G'_h}}] $ | (1) |

式中:

平移:

| $ \begin{array}{l} {\boldsymbol{G'_x}} = {\boldsymbol{A_w}} \cdot {d_{\boldsymbol{x}}}\left( {\boldsymbol{A}} \right) + {\boldsymbol{A_x}} \\ {\boldsymbol{G'_y}} = {\boldsymbol{A_h}} \cdot {d_{\boldsymbol{y}}}\left( {\boldsymbol{A}} \right) + {\boldsymbol{A_y}} \\ \end{array} $ | (2) |

缩放:

| $ \begin{array}{l} {\boldsymbol{G'_w}} = {{\boldsymbol{A_w}}} \cdot \exp ({d_{\boldsymbol{w}}}) \\ {\boldsymbol{G'_h}}= {\boldsymbol{A_h}} \cdot \exp ({d_{\boldsymbol{h}}}) \\ \end{array} $ | (3) |

式中

计算边界框的回归:

| $ \begin{array}{l} {t_{\boldsymbol{x}}} = \left( {{\boldsymbol{x}} - {{\boldsymbol{x}}_a}} \right) \div {{\boldsymbol{w}}_a} \\ {t_{\boldsymbol{y}}} = \left( {{\boldsymbol{y}} - {{\boldsymbol{y}}_a}} \right) \div {{\boldsymbol{h}}_a} \\ {t_{\boldsymbol{w}}} = {\rm{log}}\left( {{\boldsymbol{x}} \div {{\boldsymbol{x}}_a}} \right) \\ {t_{\boldsymbol{h}}} = {\rm{log}}\left( {{\boldsymbol{h}} \div {{\boldsymbol{h}}_a}} \right) \\ \end{array} $ | (4) |

式中:

对于单一图像,损失函数定义为

| $ L({p_i},{t_i}) = \frac{1}{{{N_{{\rm{cls}}}}}}\sum\limits_i^{} {{L_{\rm{cls}}}\left( {{P_i},{P_i}^*} \right)} + \lambda \frac{1}{{{N_{{\rm{reg}}}}}}\sum\limits_i^{} {{L_{{\rm{reg}}}}\left( {{t_i},{t_i}^*} \right)} $ | (5) |

分类和回归损失函数分别为

| $ {L_{{\rm{cls}}}}({P_i},P_i^*) = - {\rm{log}} [{P_i}P_i^* + (1 - P_i^*)(1 - {P_i})] $ | (6) |

| $ {L_{{\rm{reg}}}}({t_i},t_i^*) = R({t_i} - t_i^*) $ | (7) |

式中:

从图1中可以得到,Fast R-CNN作为检测网络,卷积网络层由卷积、Relu和池化组成,负责对输入图像提取特征,对于全图只进行一次区域特征的提取,减少了特征的搜索时间。RoI Pooling层由共享特征卷积层与RPN层给出的多个建议区域作为输入。全连接层结构实现将高维数据进行一系列非线性变换,通过卷积操作将对应指针区域合并成固定大小的特征图,利用标定框回归实现指针检测框修正以更加准确的位置,输出指针检测结果。

检测网络实现流程如下:

1) 使用卷积网络层提取图片中指针的特征;

2) 通过RPN网络给出的建议区域,判定是否属于检测目标指针;

3) 使用标定框回归来不断逼近真实目标区域;

4) 通过全连接网络层回归获取指针精确的位置;

5) 输出指针检测结果。

2 改进Faster R-CNN实现指针检测改进的Faster R-CNN指针检测实现流程(见图2),包括在线实时检测与离线训练模型两个过程。在线实时检测通过加载待检测指针图像,网络对其进行学习与检测,给出指针检测结果。离线训练通过工业机采集仪表指针数据之后,以预训练的模型在数据集上进行训练,通过特征提取和学习不同类型的仪表指针,得到优化后的指针检测模型,根据指针类型不同,通过反馈机制实现检测模型的及时更新。离线训练能够保证模型适应不同类别仪表指针,提升模型迁移能力。对于所获得的更新之后的训练模型,在线实时检测可以调用更新之后的网络模型,实现将待检测的仪表指针数据集加载进去并实现自动给出检测结果,完成在线实时检测。

|

Download:

|

| 图 2 检测算法流程 Fig. 2 Detection algorithm flow | |

为保证算法检测准确度,本文从真实指针仪表生产线获取工业机录制的仪表指针转动视频,按照固定帧数裁剪成图片集,图片分辨率为2 448×2 050,再使用LabelImg标注软件转换成VOC2007[25]数据集格式,构成网络模型预训练的数据集。VOC格式数据集主要包括:1)训练样本集、验证样本集和测试样本集;2)每个样本图像对应的XML信息文件;3)样本图像类别标签的TXT文件。为了保证预训练模型的泛化能力,通过收集并扩充不同类别的指针仪表添加到数据集中,数据集总量为8000张,对其按比例进行划分,以总体数据集的70%作为训练样本集,20%作为验证样本集,10%作为测试样本集。

2.2 网络改进检测网络中的RoI Pooling层,在特征计算中需要通过两次量化操作来得到回归框的位置,输出固定大小的特征映射。两次量化操作是不连续的且像素计算形式为整数(见图3),计算过程会舍去小数点后的数值,从而丢失图像像素。而对于小目标检测,像素的丢失可能会导致特征的丢失,以至于检测不到目标对象。同时,两次的量化操作也会增加网络的计算时间,影响实时性。

|

Download:

|

| 图 3 RoI Pooling与RoI Align改进实现机制 Fig. 3 Improved implementation mechanism of RoI Pooling and RoI Align | |

针对两次量化操作导致的图像像素丢失问题,本文采用RoI Align层取代RoI Pooling层的策略进行改进。改进的机制是使用双线性内插取代两次量化操作,使得特征聚集的计算变成一个连续的过程。RoI Align层通过遍历每一个候选区域,能以浮点数的形式计算回归框的位置,保留了像素坐标的小数部分而不作量化处理,有效提高了小目标的检测能力。改进前后的效果如图3所示,对于大小为960×960的特征区域,如果使用原始的RoI Pooling层,第一次量化操作舍去了0.9个像素,缩放到原图就是30个像素的差别,并且像素的分辨率越大,丢失的像素信息越多。与之相比,使用RoI Align层的改进处理,完整地保留了图像的像素信息,在检测准确度上得到了较大的提升。双线性内插算法定义如下:

沿

| $ f(x,{y_1}) \approx \frac{{{x_2} - x}}{{{x_2} - {x_1}}}f({Q_{11}}) + \frac{{x - {x_1}}}{{{x_2} - {x_1}}}f({Q_{21}}) $ | (8) |

| $ f(x,{y_2}) \approx \frac{{{x_2} - x}}{{{x_2} - {x_1}}}f({Q_{12}}) + \frac{{x - {x_1}}}{{{x_2} - {x_1}}}f({Q_{22}}) $ | (9) |

式中:

沿

| $ f(x,y) \approx \frac{{{y_2} - y}}{{{y_2} - {y_1}}}f(x,{y_1}) + \frac{{y - {y_1}}}{{{y_2} - {y_1}}}f(x,{y_2}) $ | (10) |

目标线性插值的结果为

| $ \begin{array}{l} f(x,y) \approx \dfrac{{{y_2} - y}}{{{y_2} - {y_1}}}\left( {\dfrac{{{x_2} - x}}{{{x_2} - {x_1}}}f({Q_{11}}) + \dfrac{{x - {x_1}}}{{{x_2} - {x_1}}}f({Q_{21}})} \right) + \\ \quad\quad \dfrac{{y - {y_1}}}{{{y_2} - {y_1}}}\left( {\dfrac{{{x_2} - x}}{{{x_2} - {x_1}}}f({Q_{12}}) + \dfrac{{x - {x_1}}}{{{x_2} - {x_1}}}f({Q_{22}})} \right) \\ \end{array} $ | (11) |

对式(10)求偏导,可得

| $ \frac{{\partial L}}{{\partial {x_i}}} = \sum\limits_r {\sum\limits_j {\left[ {d\left( {i,{i^*}(r,j)} \right) < 1} \right]} } \left( {1 - \Delta h} \right)\left( {1 - \Delta w} \right)\frac{{\partial L}}{{\partial {y_r}_j}} $ | (12) |

式中:

双线性内插计算步骤为:针对加载图像信息,设定图像矩阵为

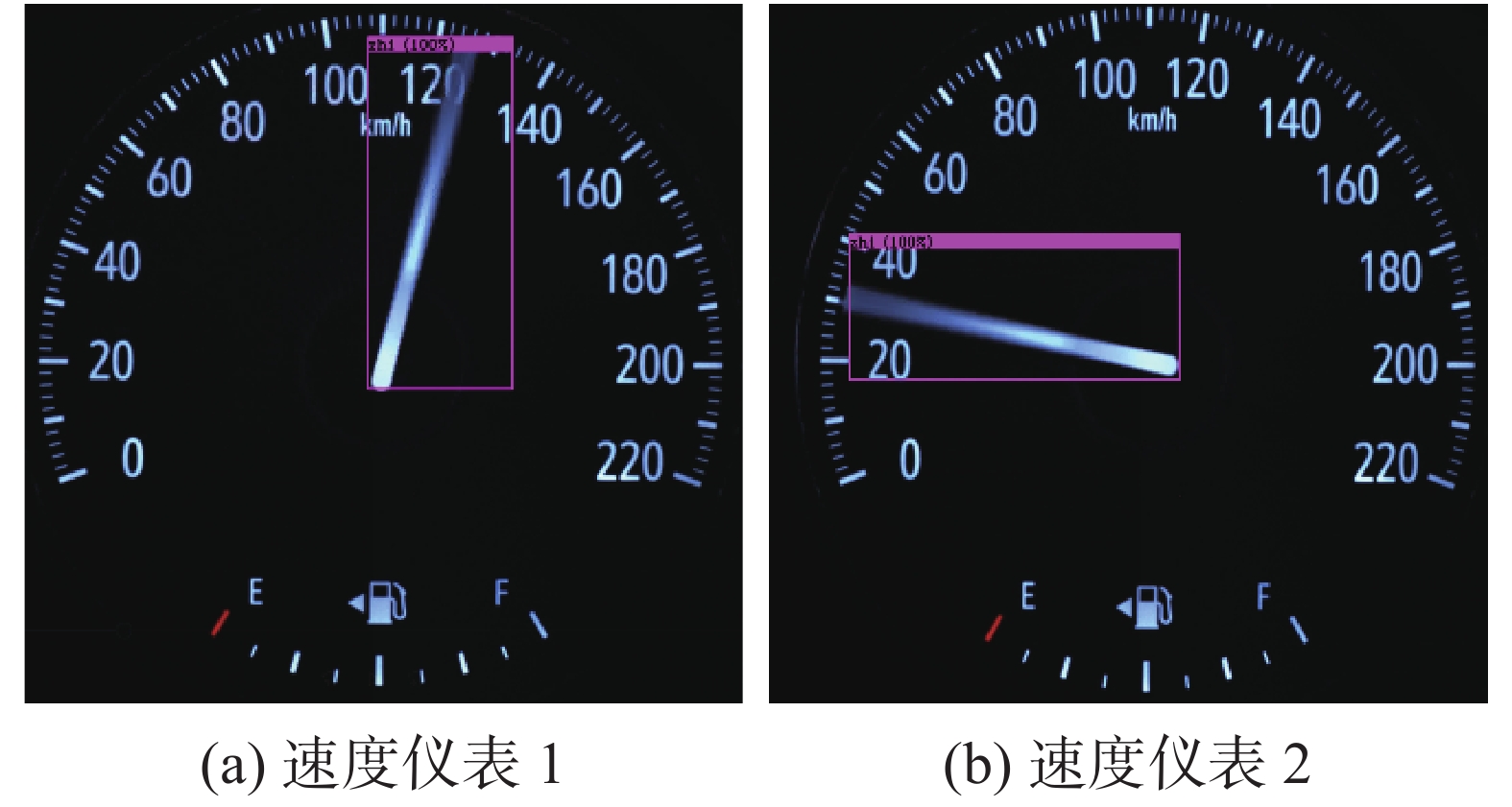

本实验基于Caffe深度学习平台,操作系统为Ubuntu16.04,网络选用端到端的训练方式。修改网络结构之后,同时调整网络超参数。网络学习率初始化为0.01,一共迭代13000次,迭代到8500次时将学习率改为0.001。得到训练模型之后,随机选取测试集中的样本,使用所得到的训练模型检测不同类别的仪表指针图片,评估模型的检测能力测试结果如图4所示。由图4(a)~(d)可知,对于不同的两类速度仪表指针,本文采用的方法可以有效地标定出指针的准确位置。针对图4(e)、(f)中不同类型的转速仪表盘指针,同样具有较准确的检测效果,表明改进网络能有效地提取并学习仪表指针的高维特征,证明实际生产环境下,改进的Faster R-CNN算法对于仪表指针的检测是可行和有效的。

|

Download:

|

| 图 4 不同类型的仪表指针检测结果 Fig. 4 Different types of instrument pointer test results | |

为了验证训练模型的泛化能力,使用未经过训练的不同类型速度仪表指针图片作为检测样本,测试结果如图5所示。从图5可知,不同类型的仪表外观差异很大,表盘颜色和指针形状变化明显。对于未经过训练的仪表样本,本文方法依然可以检测并准确地标出指针的位置,表明所训练的模型具有较强的泛化能力与迁移能力。

本文所提的检测网络为两阶段网络,为了验证所提算法网络性能,将本文方法与单阶段检测网络YOLO-v3进行了比较,实验结果如图6所示。

|

Download:

|

| 图 5 迁移实验检测结果 Fig. 5 Migration test results | |

|

Download:

|

| 图 6 YOLO-v3检测结果 Fig. 6 YOLO-v3 test results | |

从YOLO-v3实验结果可知,单阶段网络可以实现仪表指针检测,但是存在指针检测区域有偏差且准确率不高的问题。YOLO-v3网络将采集的特征直接用于检测,虽然降低了检测时间,但缺少标定框的回归与参数学习,导致其检测准确率相对较低,计算性能如表1所示。

| 表 1 单张图片检测时间和精度对比 Tab.1 Single-image detection time and accuracy comparison |

进一步验证本文算法的有效性,对现有的Hough方法采用相同的数据集进行实验,实验结果如图7所示。检测时间和精度对比由表1可见,Hough直线检测需要计算坐标并将其映射到另一坐标空间点的峰值,导致其运算检测时间较长,且易受到图片中其他直线空间复杂度干扰,导致检测精度低,算法鲁棒性较差。

|

Download:

|

| 图 7 Hough算法检测结果 Fig. 7 Hough algorithm test results | |

将本文算法与YOLO-v3网络、经典Hough方法以及HOG/SVM方法进行对比,具体结果如表1所示。经过计算,本文提出的改进Faster R-CNN算法在验证集的平均测试精度高达92.7%,在单个GPU上单张图片的平均检测时间约为0.197 s,优于其他方法检测精度与检测时间,可达到实时检测的目的。以上结果表明,改进方法能够实现仪表指针快速检测且满足准确度的要求,满足指针仪表在实际检测应用中的需求。

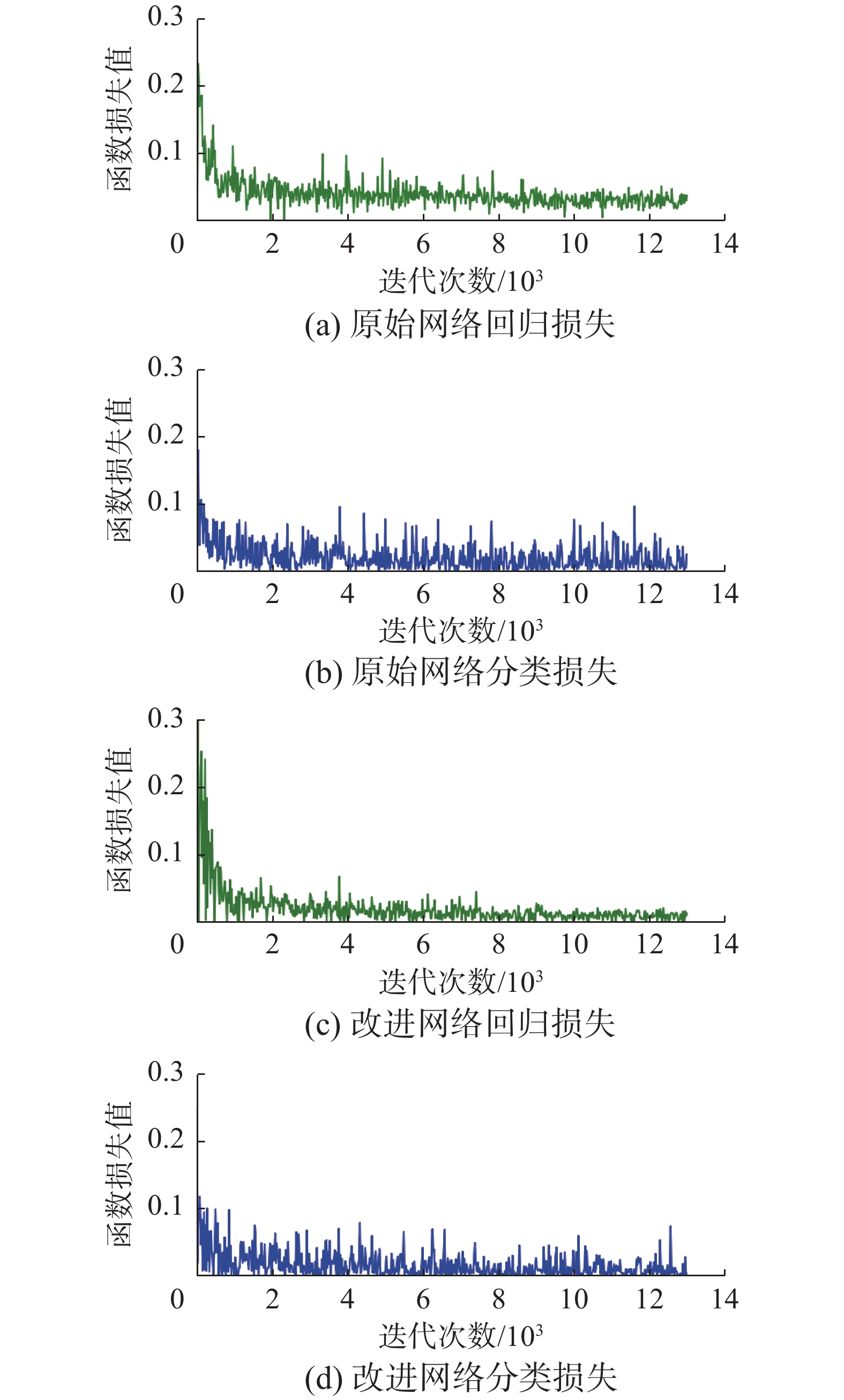

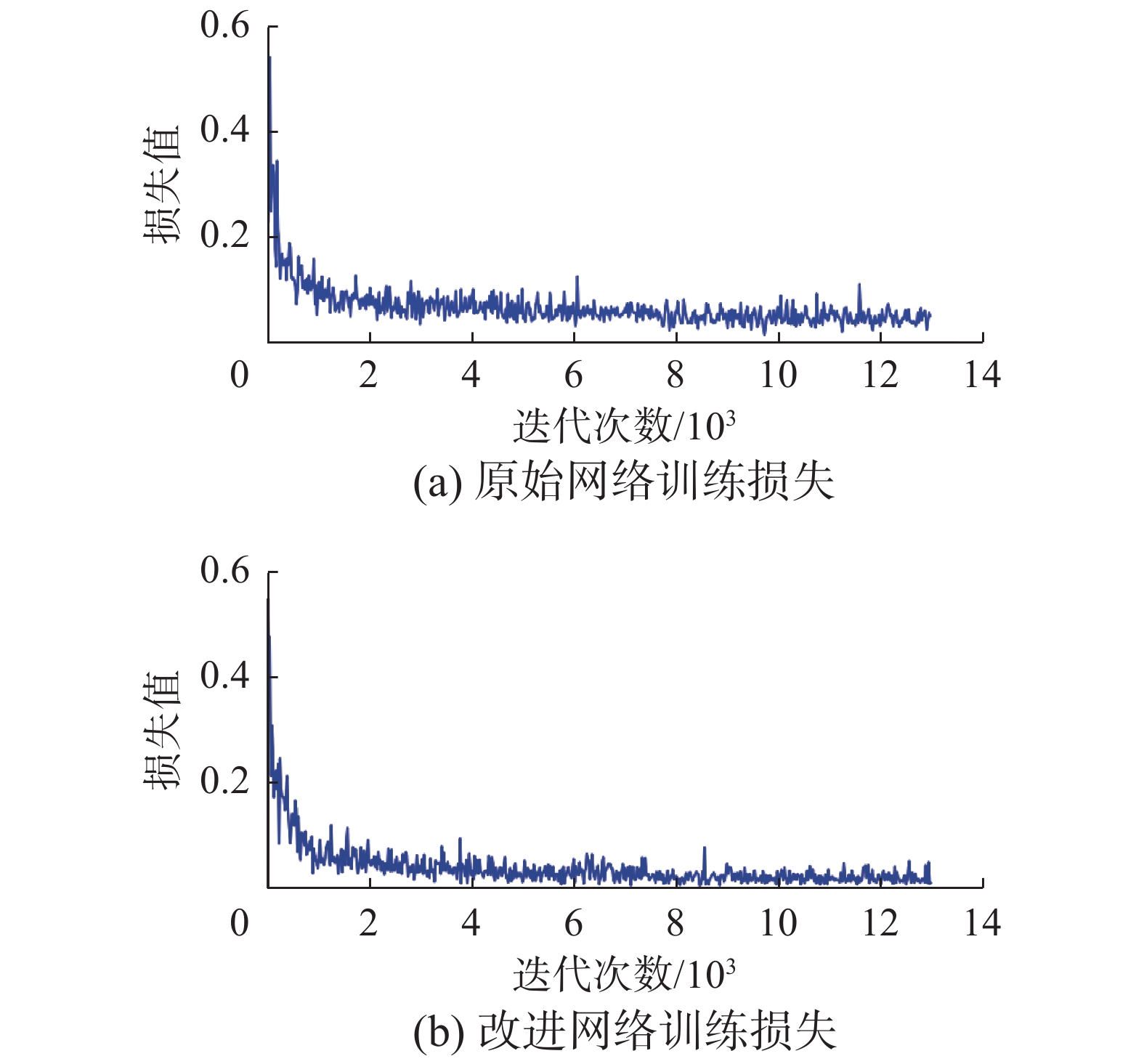

为了保证模型学习性能,原始与改进的网络分别在训练8500次的时候改变一次学习率,训练过程的各阶段网络损失如图8、9所示。图8(a)、(b)是原始Faster R-CNN的回归与分类损失曲线,图8(c)、(d)表示改进Faster R-CNN的回归与分类损失曲线。图9是训练损失曲线对比。结合图8和图9可知,原始的网络损失出现波动,且下降不稳定。改进网络能够更快地收敛速度下降,且下降稳定,出现波动小。损失值快速下降表明改进Faster R-CNN网络可以有效地学习仪表指针的特征,回归损失能够快速收敛,并且加以更正标定框完成指针检测。

|

Download:

|

| 图 8 回归与分类损失曲线对比 Fig. 8 Comparison of the regression and classification loss curves | |

|

Download:

|

| 图 9 训练损失曲线对比 Fig. 9 Comparison of the training loss curves | |

汽车的仪表指针快速实时检测是汽车制造行业生产过程自动化与智能化迫切需要攻破的技术难题。实际生产环境中,人工视检任务繁重,自动化程度低,检测难度较大。本文以深度学习主流框架Faster R-CNN为基础,通过改进网络层架构,提高图像特征传递能力,调整超参数,实现了仪表指针的快速检测。通过实验结果验证,单张图片检测时间为0.197 s,检测精度达到92.7%,证明了所提方法的有效性和实时性。后续的迁移测试表明训练的模型具有良好的迁移泛化能力。

| [1] |

BEHAINE C A R, SCHARCANSKI J. Remote visual monitoring of analogue meter displays using deformable models[J]. IET science, measurement & technology, 2014, 8(4): 228-235. ( 0) 0)

|

| [2] |

BAO Haojing, TAN Qingchang, LIU Siyuan, et al. Computer vision measurement of pointer meter readings based on inverse perspective mapping[J]. Applied sciences, 2019, 9(18): 3729. DOI:10.3390/app9183729 ( 0) 0)

|

| [3] |

韩绍超, 徐遵义, 尹中川, 等. 指针式仪表自动读数识别技术的研究现状与发展[J]. 计算机科学, 2018, 45(S1): 54-57. HAN Shaochao, XU Zunyi, YIN Zhongchuan, et al. Research review and development for automatic reading recognition technology of pointer instruments[J]. Computer science, 2018, 45(S1): 54-57. (  0) 0)

|

| [4] |

袁立祥, 龙斌, 杨志伟, 等. 基于智能网络信息系统的车轮加工自动化生产线设计与应用[J]. 机械设计, 2019, 36(S1): 295-297. YUAN Lixiang, LONG Bin, YANG Zhiwei, et al. Design and application of wheel automatically processing production line based on intelligent network information system[J]. Journal of machine design, 2019, 36(S1): 295-297. (  0) 0)

|

| [5] |

李光平, 唐月夏. 自动化生产线装配单元三维仿真平台的构建[J]. 实验技术与管理, 2020, 37(1): 141-144, 148. LI Guangping, TANG Yuexia. Construction of 3D simulation platform for assembly unit of automatic production line[J]. Experimental technology and management, 2020, 37(1): 141-144, 148. (  0) 0)

|

| [6] |

杨虹, 张雅声, 尹灿斌. 空间目标的ISAR成像及轮廓特征提取[J]. 北京航空航天大学学报, 2019, 45(9): 1765-1776. YANG Hong, ZHANG Yasheng, YIN Canbin. ISAR imaging and contour feature extraction of space targets[J]. Journal of Beijing University of Aeronautics and Astronautics, 2019, 45(9): 1765-1776. (  0) 0)

|

| [7] |

ALEGRIA E C, SERRA A C. Automatic calibration of analog and digital measuring instruments using computer vision[J]. IEEE transactions on instrumentation and measurement, 2000, 49(1): 94-99. DOI:10.1109/19.836317 ( 0) 0)

|

| [8] |

岳娟, 高思莉, 李范鸣, 等. 具有近似仿射尺度不变特征的快速图像匹配[J]. 光学精密工程, 2020, 28(10): 2349-2359. YUE Juan, GAO Sili, LI Fanming, et al. Fast image matching algorithm with approximate affine and scale invariance[J]. Optics and precision engineering, 2020, 28(10): 2349-2359. DOI:10.37188/OPE.20202810.2349 (  0) 0)

|

| [9] |

JAFFERY Z A, DUBEY A K. Architecture of noninvasive real time visual monitoring system for dial type measuring instrument[J]. IEEE sensors journal, 2013, 13(4): 1236-1244. DOI:10.1109/JSEN.2012.2231940 ( 0) 0)

|

| [10] |

CHI Jiannan, LIU Lei, LIU Jiwei, et al. Machine vision based automatic detection method of indicating values of a pointer gauge[J]. Mathematical problems in engineering, 2015, 2015: 1-19. ( 0) 0)

|

| [11] |

HAO Zelong, CHEN Xuhui, HU Jianqiang, et al. OpenCV-based automatic detection system for automobile meter[J]. Applied mechanics and materials, 2014, 615: 149-152. DOI:10.4028/www.scientific.net/AMM.615.149 ( 0) 0)

|

| [12] |

GAO Huijun, YI Ming, YU Jinyong, et al. Character segmentation-based coarse-fine approach for automobile dashboard detection[J]. IEEE transactions on industrial informatics, 2019, 15(10): 5413-5424. DOI:10.1109/TII.2019.2905662 ( 0) 0)

|

| [13] |

王建新, 王子亚, 田萱. 基于深度学习的自然场景文本检测与识别综述[J]. 软件学报, 2020, 31(5): 1465-1496. WANG Jianxin, WANG Ziya, TIAN Xuan. Review of natural scene text detection and recognition based on deep learning[J]. Journal of software, 2020, 31(5): 1465-1496. (  0) 0)

|

| [14] |

HOU Tianyue, AN Yi, CHANG Qi, et al. Deep-learning-assisted, two-stage phase control method for high-power mode-programmable orbital angular momentum beam generation[J]. Photonics research, 2020, 8(5): 715-722. DOI:10.1364/PRJ.388551 ( 0) 0)

|

| [15] |

张新钰, 高洪波, 赵建辉, 等. 基于深度学习的自动驾驶技术综述[J]. 清华大学学报(自然科学版), 2018, 58(4): 438-444. ZHANG Xinyu, GAO Hongbo, ZHAO Jianhui, et al. Overview of deep learning intelligent driving methods[J]. Journal of Tsinghua University (science and technology edition), 2018, 58(4): 438-444. (  0) 0)

|

| [16] |

曹锦纲, 李金华, 郑顾平. 基于生成式对抗网络的道路交通模糊图像增强[J]. 智能系统学报, 2020, 15(3): 491-498. CAO Jingang, LI Jinhua, ZHENG Guping. Enhancement of blurred road-traffic images based on generative adversarial network[J]. CAAI transactions on intelligent systems, 2020, 15(3): 491-498. (  0) 0)

|

| [17] |

曲仕茹, 席玉玲, 丁松涛. 基于深度学习的交通场景语义描述[J]. 西北工业大学学报, 2018, 36(3): 522-527. QU Shiru, XI Yuling, DING Songtao. Image caption description of traffic scene based on deep learning[J]. Journal of Northwestern Polytechnical University, 2018, 36(3): 522-527. DOI:10.3969/j.issn.1000-2758.2018.03.017 (  0) 0)

|

| [18] |

REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 ( 0) 0)

|

| [19] |

WU Wenqi, YIN Yingjie, WANG Xingang, et al. Face detection with different scales based on Faster R-CNN[J]. IEEE transactions on cybernetics, 2019, 49(11): 4017-4028. DOI:10.1109/TCYB.2018.2859482 ( 0) 0)

|

| [20] |

徐岩, 陶慧青, 虎丽丽. 基于Faster R-CNN网络模型的铁路异物侵限检测算法研究[J]. 铁道学报, 2020, 42(5): 91-98. XU Yan, TAO Huiqing, HU Lili. Railway foreign body intrusion detection based on Faster R-CNN network model[J]. Journal of the China railway society, 2020, 42(5): 91-98. DOI:10.3969/j.issn.1001-8360.2020.05.012 (  0) 0)

|

| [21] |

FANG Fen, LI Liyuan, ZHU Hongyuan, et al. Combining Faster R-CNN and model-driven clustering for elongated object detection[J]. IEEE transactions on image processing, 2019, 29: 2052-2065. ( 0) 0)

|

| [22] |

LIU Xiaobo, WANG Huaiyuan, JING Hongdi, et al. Research on intelligent identification of rock types based on Faster R-CNN method[J]. IEEE access, 2020, 8: 21804-21812. DOI:10.1109/ACCESS.2020.2968515 ( 0) 0)

|

| [23] |

CHENG Gong, HAN Junwei, ZHOU Peicheng, et al. Learning rotation-invariant and Fisher discriminative convolutional neural networks for object detection[J]. IEEE transactions on image processing, 2019, 28(1): 265-278. DOI:10.1109/TIP.2018.2867198 ( 0) 0)

|

| [24] |

刘召, 张黎明, 耿美晓, 等. 基于改进的Faster R-CNN高压线缆目标检测方法[J]. 智能系统学报, 2019, 14(4): 627-634. LIU Zhao, ZHANG Liming, GENG Meixiao, et al. Object detection of high-voltage cable based on improved Faster R-CNN[J]. CAAI transactions on intelligent systems, 2019, 14(4): 627-634. (  0) 0)

|

| [25] |

EVERINGHAM M, VAN GOOL L, WILLIAMS C K I, et al. The PASCAL visual object classes (VOC) challenge[J]. International journal of computer vision, 2010, 88(2): 303-338. DOI:10.1007/s11263-009-0275-4 ( 0) 0)

|

2021, Vol. 16

2021, Vol. 16