对于野外移动机器人,利用实时定位与地图(simultaneous localization and mapping, SLAM)技术和多源感知信息建立三维环境模型和自主定位,是移动机器人在未知环境中自主导航的关键。野外环境地形复杂、特征稀疏等因素对传统视觉测量有不利影响,而基于三维激光雷达(light detection and ranging, LiDAR) 可以有效应对环境光照和纹理的变化。在结构化环境模型更新过程中,机器人低速运动产生的累计误差可以近似求解[1]。随着野外作业任务对机器人时空覆盖率要求的不断提高,移动机器人的平均速度将比现阶段有较大提升,由于机器人快速移动引起的本体剧烈振动和姿态变化,对车体稳定性和颠簸等状态下的位姿估计带来了更严峻挑战[2-3]。

用于移动机器人环境感知的传感器可分为主动式和被动式[4],其中激光雷达具有宽视场(field of view, FOV)、不受光照影响等优点,在SLAM 等任务中已经得到广泛运用,在视觉退化等场景中可以提供更为鲁棒和准确的位姿估计。由陀螺仪和加速度计等构成的惯性导航系统(inertial navigation system, INS),可以根据测量得到的载体三轴加速度和三轴角速度等信息,利用惯导解算算法计算载体位置和姿态,具有自主性好、短时精度高等优点。在大范围场景建图实践应用中,根据实时动态差分(real-time kinematic, RTK)与INS的组合导航结果[5],将估计的姿态作为先验因子进行后端优化。在基于互补滤波的INS姿态估计中,由于估计精度受制于载体的动态条件,主要应用于融合定位等场景。

由激光雷达与惯性导航系统构成的组合导航系统,利用信息融合方式可以实现姿态信息的校正,称为激光雷达惯性里程计 (LiDAR-inertial odometry, LIO) [6],但由于图优化计算具有代价高等问题,使得LIO在一些情形下的实时性难以满足要求。Zhang等[7]提出的激光雷达里程计与地图构建方法(lidar odometry and mapping, LOAM),采用点到边和点到面的联合配准方法估计LiDAR的相对运动,在双线程上分别运行高频率的激光里程计和低频率的地图构建模块,可以满足实时性需求,但后端缺少回环检测对漂移进行修正,且未将GNSS等测量数据用于位姿估计。Tian等[8]进一步提出轻量级LOAM (lightweight and ground-optimized LOAM, LeGO-LOAM),通过增加点云分割处理模块降低点云规模并存储关键帧的特征。针对缺乏结构化特征的野外环境,基于单纯点云配准的位姿估计和地图构建误差累计较大[9-11]。在Cartographer等应用中[12-13],前端数据的松耦合和后端以点云匹配为约束的优化仍属于松耦合的框架,有必要结合前后端分层优化的思路,进一步提高系统的性能[14-15]。

Zhao 等[16]提出鲁棒激光惯性里程计与建图 (laser-inertial odometry and mapping, LIOM)方法对LiDAR和INS测量数据联合优化,但由于数据量过大,实时性难以有效保证。Liu Ming团队[17-18]提出基于紧耦合框架的激光雷达惯性状态估计器(lidar-inertial state estimator, LINS)。Shan 等[19] 采用因子图优化方法,并将帧—局部地图用于帧间匹配,实验结果表明其具有更高定位精度和鲁棒性。点云配准算法利用连续点云对机器人位姿进行估计,其中迭代最邻近点(iterative closest point, ICP)已得到广泛运用,但对于大规模点云情形,存在配准效率低、实时性差等问题。此外,当机器人以大转角运动时,两帧数据之间变化剧烈,点云配准算法可能发生失效等问题[20-21]。

多传感器数据融合算法可以分成基于滤波和优化两种,其中滤波算法复杂度较低,在处理非线性误差方面仍需改进。基于优化的算法具有精度高的特点,但在实时性方面存在不足。Kaess等[22]提出基于因子图(factor graph)的增量式平滑的全优化算法,每次仅优化更新被影响的变量节点,可以维持全优化的稀疏特性。研究表明[23-24]采用基于贝叶斯树的因子图优化算法,有效降低了连续配准造成的累计误差,在开阔野外环境定位精度达到分米级。

针对融合LiDAR和INS的野外移动机器人自主导航,目前有关机器人匀速移动等假设具有一定局限性,本文根据机器人快速转弯和移动时车体振动和姿态变化等情形,从以下几个方面展开分析:首先讨论组合系统的架构,针对现有研究方法性能退化问题,利用IMU的姿态信息为点云配准和点云畸变消除提供先验信息,将其作为观测约束在优化计算中进行考虑。在特征提取和信息融合方面提出改进思路,利用IMU的预积分与LiDAR的scan-to-map构成优化函数,结合误差状态卡尔曼滤波器 (error state Kalman filter, ESKF)迭代修正机器人的位姿,结合实验数据分析了方法的有效性。

1 组合导航算法概述多传感紧耦合算法流程一般可分为5个部分:1)数据预处理:利用IMU预积分得到的相对运动估计对特征点畸变进行校正;2)将连续时刻的激光里程计特征点进行匹配,估计LiDAR的相对运动;3)基于校正后的特征点与局部地图配准,更新局部地图;4)回环检测,利用间隔关键帧构成的小回环为转角提供更多约束,可用于提升激光里程计的鲁棒性,而大回环则可以通过建立闭环约束并修正全局累计误差;5)基于紧耦合的数据融合,包含LiDAR里程计、IMU预积分和地图配准等,进而得到机器人全局一致的位姿。本文所提算法的流程图如图1所示,其中标号为文中对应公式。

|

Download:

|

| 图 1 算法流程图 Fig. 1 The flowchart of the algorithm | |

通过融合LiDAR点云描述和机器人运动学信息,进一步分析移动平台颠簸对LiDAR点云畸变和视觉图像模糊的影响。具体方案如下:

1) 针对机器人的姿态变化引起的点云图像扰动,采用组合导航系统信息对坐标转换中的旋转矩阵

| ${n_p} = f(\varPsi ,\varPhi ,{P^{{S_i}}}) = {{R}}_b^n({{R}}_{{s_i}}^b{{{P}}^{{S_i}}} + {{T}}_{{s_i}}^b) + {{T}}_b^n$ | (1) |

式中:

2) 对三维点云数据的不确定性和量测点误差进行研究并建立对应误差模型,将量测点投影到二维平面,则其分布在栅格

| $\begin{array}{c} P\left( {({n_{{p_x}}},{n_{{p_y}}}) \in {{\rm{g}} _{ij}}} \right) \approx \\ ({x_{i + }} - {x_{i - }})({y_{i + }} - {y_{i - }}) \cdot P\left( {\dfrac{{{x_{i + }} + {x_{i - }}}}{2},\dfrac{{{y_{i + }} + {y_{i - }}}}{2}} \right) \\ \end{array} $ | (2) |

利用式(3)对多层环境栅格地图的每个栅格平均高程值进行更新:

| ${\hat \xi _N} = \frac{{\displaystyle\sum\nolimits_{n = 1}^N {{P_n}{{\hat e}_n}} }}{{\displaystyle\sum\nolimits_{n = 1}^N {{P_n}} }}$ | (3) |

式中:

3) 针对环境特征点稀少引起的近似误差增大和目标函数陷入极小值点的问题,可以采用闭环检测等方式抑制漂移的影响。在此基础上,利用高斯过程模型对LiDAR运动速度进行估计并利用惯性信息修正位姿,进而对环境模型更新进行优化,实现机器人环境特征的完整映射。

2 LiDAR/INS数据融合方法 2.1 数据预处理IMU在

| $ \begin{array}{c} {\hat \omega _t} = {\omega _t} + b_t^\omega + n_t^\omega \\ {\hat a_t} = {{C}}_t^{bn}({a_t} - g) + b_t^a + n_t^a \end{array} $ |

式中:

| ${{{x}}_i} = \left[ {\begin{array}{*{20}{c}} {{{{R}}_i}}&{{{{p}}_i}}&{{{{v}}_i}}&{{b_i}} \end{array}} \right]$ |

式中:

基于上述分析,移动机器人在

| ${{{v}}_{t + \Delta t}} = {{{v}}_t}{{ + g}}\Delta t{\rm{ + }}{{C}}_t^{bn}({\hat a_t} - b_t^a - n_t^a)\Delta t$ |

| ${{{p}}_{t + \Delta t}} = {{{p}}_t}{\rm{ + }}{{{v}}_t}\Delta t{\rm{ + }}\frac{1}{2}{{g}}\Delta {t^2}{\rm{ + }}\frac{1}{2}{{C}}_t^{bn}({\hat a_t} - b_t^a - n_t^a)\Delta {t^2}$ |

| ${{{R}}_{t + \Delta t}} = {{C}}_t^{bn}\exp ({\hat \omega _t} - b_t^\omega - n_t^\omega )\Delta t$ |

利用IMU预积分理论计算相邻

| $\begin{array}{c} \Delta {{{v}}_{ij}} = {{R}}_i^{\rm{T}}({{{v}}_j} - {{{v}}_i} - g\Delta {t_{ij}}) \\ \Delta {{{p}}_{ij}} = {{R}}_i^{\rm{T}}({{{p}}_j} - {{{p}}_i} - {{{v}}_i}\Delta {t_{ij}} - \frac{1}{2}g\Delta t_{ij}^2) \\ \Delta {{{R}}_{ij}} = {{R}}_i^{\rm{T}}{{R}}_j^{} \\ \end{array} $ |

针对车体快速转弯等运动情形,考虑在一个优化任务里执行点云畸变补偿和点云匹配,计算激光点采集时刻和相对于该帧点云初始时刻的姿态变化量,在点云配准时将畸变补偿的残差作为误差函数的一部分,对LiDAR位姿之间的IMU运动信息进行积分,并将积分得到的相对位姿于因子图中的匹配位姿实施图优化,实验结果表明,该方法可以进一步提高定位和建图的精度。

2.2 点云分割与特征提取本文在点云分割和特征提取阶段,考虑加入基于区域生长的分割方法和地面提取算法,根据被分割物体的点云个数判断其是否为稳定特征,进而对地面提取之后剩余的点云进行聚类分析,可以在一定程度上减小动态物体对建图的影响,同时可以有效降低

假设在

| $c = \frac{1}{{\left| S \right| \cdot \left\| {{r_i}} \right\|}}\left\| {\sum\limits_{j \in S,j \ne i} {({r_j} - {r_i})} } \right\|$ |

其中,粗糙度值较大的非地面点定义为边缘点

| ${{{M}}_i} = \left\{ {M_i^e,M_i^p} \right\}$ |

式中:

帧间匹配的算法主要有基于迭代临近点和基于正态分布变换,针对野外大范围空旷场景特征稀少等引起的LOAM出现退化现象,参考CPFG (closet probability and feature grid) SLAM方法,将基于ICP平面特征提取和基于NDT的点特征结合,进而从雷达单帧和拼接的多帧点云数据中提取得到环境特征。利用基于距离阈值判断关键帧的方法对地图进行保存,从而保证了所建立地图的稀疏性。在后端加入基于ICP算法的闭环检测,可以在检测到闭环时降低累积漂移误差,使所建地图达到全局一致性的效果。

针对车体快速转弯等引起点云变形等问题,本文采用IMU的预积分因子与激光的scan-to-map两项构成优化函数,更新计算每帧激光的位姿,并将IMU的预测量作为优化的初值。对于边缘特征

| ${d_e} = \frac{{\left| {(p_{i + 1,k}^e - p_{i,u}^e) \times (p_{i + 1,k}^e - p_{i,v}^e)} \right|}}{{(p_{i,u}^e - p_{i,v}^e)}}$ |

点到平面的距离

| ${d_p} = \frac{{\left| {(p_{i + 1,k}^p - p_{i,u}^p) \cdot (p_{i,u}^p - p_{i,v}^p) \times (p_{i,u}^p - p_{i,w}^p)} \right|}}{{\left| {(p_{i,u}^p - p_{i,v}^p) \times (p_{i,u}^p - p_{i,w}^p)} \right|}}$ |

计算式(4)最小值并根据Gauss-Newton方法得到最优的转换矩阵:

| $\mathop {{\rm{min}}}\limits_{{T_{i + 1}}} \left\{ {\sum\limits_{p_{i + 1,k}^e \in ^\prime F_{i + 1}^e} {{d_e} + \sum\limits_{p_{i + 1,k}^p \in ^\prime F_{i + 1}^p} {{d_p}} } } \right\}$ | (4) |

进一步得到

本文采用基于迭代误差状态卡尔曼滤波(error state Kalman filter, ESKF)方法对最小化非线性约束求解,进而更新状态,根据得到的全局位姿信息进行地图构建。迭代ESKF在量测更新中增加一步迭代优化,进而得到状态收敛时的最优解,可以有效降低传统EKF舍弃高阶误差项带来的算法误差。

在基于LIO紧耦合模型,将状态估计误差定义为

| ${{x}}_{k + 1}^k{{ = h(}}{}^ - {{x}}_{k + 1}^k{\rm{,}}{\text{δ}} {{x}}{\rm{)}} = \left[ {\begin{array}{*{20}{c}} {{}^ - q_{k + 1}^k \otimes \exp ({\text{δ}} \theta )} \\ {{}^ - p_{k + 1}^k + {\text{δ}} p} \\ {{}^ - v_{k + 1}^k + {\text{δ}} v} \\ {{}^ - b + {\text{δ}} b} \end{array}} \right]$ |

其中

| $\mathop {\min }\limits_{{\text{δ}} {{x}}} {\left\| {{\text{δ}} {{x}}} \right\|_{{{({P_k})}^{ - 1}}}} + {\left\| {f({{x}}_{k{\rm{ + }}1}^k)} \right\|_{{{({{{J}}_k}{{{M}}_k}{{J}}_k^{\rm{T}})}^{ - 1}}}}$ | (5) |

| ${{{K}}_{k,j}} = {{{P}}_k}{{H}}_{k,j}^{\rm{T}}{({{H}}_{k,j}^{}{{{P}}_k}{{H}}_{k,j}^{\rm{T}} + {{{J}}_{k,j}}{{{M}}_k}{{J}}_{k,j}^{\rm{T}})^{ - 1}}$ |

| ${\text{δ}} {{{x}}_{j + 1}} = {\text{δ}} {{{x}}_j} + {{{K}}_{k,j}}({{H}}_{k,j}^{}{\text{δ}} {{{x}}_j} - f({{x}}_{k + 1}^k))$ | (6) |

在每次迭代过程中,根据更新的匹配边缘和平面,进一步最小化度量误差,进而计算更新的雅克比矩阵和增益。

当迭代n步后终止,更新的协方差方程表示为

| $\begin{array}{c} {{{P}}_{k + 1}} = ({{I}} - {{{K}}_{k,n}}{{{H}}_{k,n}}){{{P}}_k}{({{I}} - {{{K}}_{k,n}}{{{H}}_{k,n}})^{\rm{T}}} + {{{K}}_{k,n}}{{{M}}_k}{{K}}_{k,n}^{\rm{T}} \end{array} $ |

经过ESKF迭代,根据得到

基于上述对移动机器人环境建模与定位研究的分析,搭建如图2所示的野外移动机器人实验平台,搭载有Xsens MTi-G-710 IMU 和Velodyne VLP-16线LiDAR,数据输出频率分别为200 Hz和10 Hz。在校园开阔环境开展了移动机器人环境建模和自主导航实验,移动机器人的大致运动轨迹如图3所示,从红色曲线可知机器人在运动过程中存在急转弯等情形。

|

Download:

|

| 图 2 野外移动机器人实验平台 Fig. 2 Experimental setup of the field mobile robot | |

|

Download:

|

| 图 3 校园环境移动机器人运动路线图 Fig. 3 The trajectory of the field mobile robot in campus environment | |

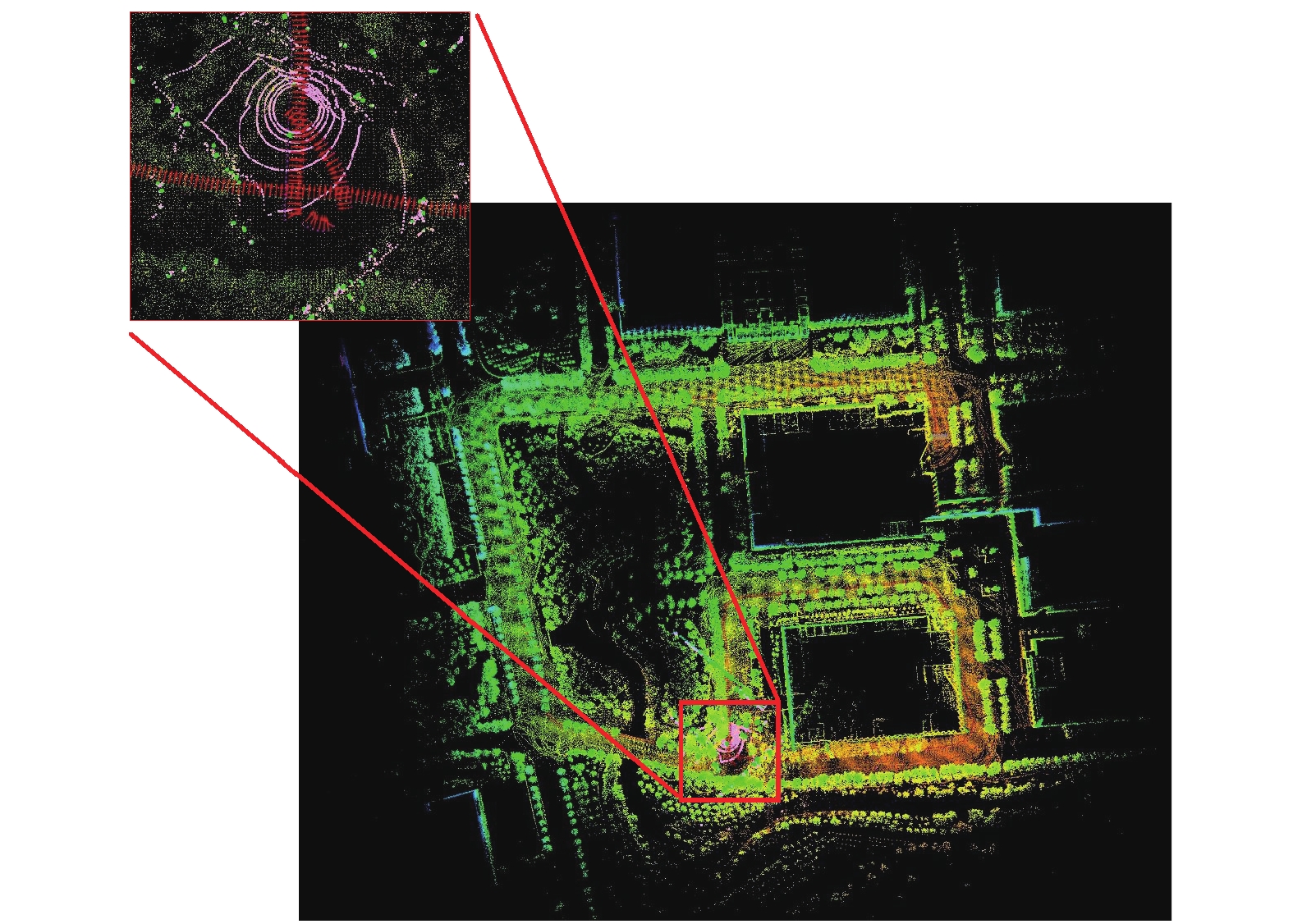

从图4可知当机器人急转弯运动时,基于LeGO-LOAM的三维激光点云地图出现畸变,红色标识为机器人急转弯时出现的点云畸变,本文采用IMU的预积分因子与激光的scan-to-map 2项构成优化函数,用于计算每帧激光的位姿,并且将IMU的预测量作为优化的初值,可以保证在急速旋转的情况下仍可以为优化提供良好的初值估计,实验结果如图5所示。蓝色标识为算法优化后的机器人路径。基于LOAM、LeGO-LOAM和本文提出的方法对移动机器人定位结果如图6所示,在机器人直线行驶阶段LOAM与所提方法的计算结果近似,在如图5所示蓝色框标识区域,即机器人完成快速转弯等运动时,本文方法相对于LOAM和LeGo-LOAM具有更好的稳定性。

|

Download:

|

| 图 4 基于LeGO-LOAM的三维激光点云地图 Fig. 4 3D LiDAR point cloud map based on LeGO-LOAM | |

|

Download:

|

| 图 5 基于改进LeGO-LOAM的三维激光点云地图 Fig. 5 3D LiDAR point clouds map based on optimized LeGO-LOAM (The optimized trajectories are marked in blue) | |

|

Download:

|

| 图 6 基于LOAM, LeGO-LOAM和scan-to-map(以scan-map表示)优化方法的实验结果比较 Fig. 6 The comparison of experimental results obtained by LOAM, LeGO-LOAM and the optimized scan-to-map (represented by scan-map) method | |

从结果可以看出本文方法能够很好地表示机器人的运动轨迹,尤其小范围内的转动运动。由于机器人在进入小范围空间时,LOAM和LeGO-LOAM的精度迅速下降,计算不同算法定位结果的均方根误差如表1所示,进一步验证了本文方法的有效性。

| 表 1 基于不同算法的实验结果均方根误差比较 Tab.1 RMSE of the experimental results by different algorithms |

针对野外移动机器人环境建模和定位问题,本文从数据预处理、点云分割与特征提取、激光里程计和信息融合等方法对组合系统进行分析,结合移动机器人运动特性分析激光点云畸变等问题,提出基于IMU的预积分与scan-to-map的融合方法,通过构建优化函数并对每帧激光的位姿、优化初值进行更新,实验结果表明本文方法相对于LeGO-LOAM、LOAM具有更好的环境建模和位置估计精度。此外,高精度的定位和地图构建对于运载体的智能行为有重要影响,地图中可能存在的移动物体会将建图问题进一步复杂化,下一步考虑融合环境的语义信息,根据点云语义分割识别动态物体,将带有语义标签的物体进行数据关联,利用几何信息构建约束关系,进而提高机器人的建图和定位精度。

| [1] |

HIDALGO-CARRIó J, POULAKIS P, KIRCHNER F. Adaptive localization and mapping with application to planetary rovers[J]. Journal of field robotics, 2018, 35(6): 961-987. DOI:10.1002/rob.21790 ( 0) 0)

|

| [2] |

YOUNG S H, MAZZUCHI T A, SARKANI S. A framework for predicting future system performance in autonomous unmanned ground vehicles[J]. IEEE transactions on systems, man, and cybernetics: systems, 2017, 47(7): 1192-1206. DOI:10.1109/TSMC.2016.2563403 ( 0) 0)

|

| [3] |

陈成, 何玉庆, 卜春光, 等. 基于四阶贝塞尔曲线的无人车可行轨迹规划[J]. 自动化学报, 2015, 41(3): 486-496. CHEN Cheng, HE Yuqing, BU Chunguang, et al. Feasible trajectory generation for autonomous vehicles based on quartic bezier curve[J]. acta automatica sinica, 2015, 41(3): 486-496. (  0) 0)

|

| [4] |

倪志康, 厉茂海, 林睿, 等. 基于三维激光雷达与RTK融合的SLAM研究[J]. 制造业自动化, 2020, 42(7): 51-54. NI Zhikang, LI Maohai, LIN Rui, et al. Research on SLAM based on 3D Lidar and RTK fusion[J]. Manufacturing automation, 2020, 42(7): 51-54. DOI:10.3969/j.issn.1009-0134.2020.07.013 (  0) 0)

|

| [5] |

CADENA C, CARLONE L, CARRILLO H, et al. Past, present, and future of simultaneous localization and mapping: toward the robust-perception age[J]. IEEE transactions on robotics, 2016, 32(6): 1309-1332. DOI:10.1109/TRO.2016.2624754 ( 0) 0)

|

| [6] |

YE H, CHEN Y, LIU M. Tightly coupled 3D lidar inertial odometry and mapping[C]//Proceedings of 2019 IEEE International Conference on Robotics and Automation. Montreal, Canada, 2019: 3144−3150.

( 0) 0)

|

| [7] |

ZHANG J, SINGH S. Laser-visual-inertial odometry and mapping with high robustness and low drift[J]. Journal of field robotics, 2018, 35(8): 1242-1264. DOI:10.1002/rob.21809 ( 0) 0)

|

| [8] |

SHAN T, ENGLOT B. LeGO-LOAM: lightweight and ground-optimized lidar odometry and mapping on variable terrain[C]//Proceedings of 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems. Madrid, Spain, 2018: 4758−4765.

( 0) 0)

|

| [9] |

HESS W, KOHLER D, RAPP H, et al. Real-time loop closure in 2D LIDAR SLAM[C]//Proceedings of 2016 IEEE International Conference on Robotics and Automation. Stockholm, Sweden, 2016: 1271−1278.

( 0) 0)

|

| [10] |

FORSTER C, CARLONE L, DELLAERT F, et al. On-manifold preintegration for real-time visual-inertial odometry[J]. IEEE transactions on robotics, 2017, 33(1): 1-21. ( 0) 0)

|

| [11] |

BOSSE M, ZLOT R, FLICK P. Zebedee: design of a spring-mounted 3-D range sensor with application to mobile mapping[J]. IEEE transactions on robotics, 2012, 28(5): 1104-1119. DOI:10.1109/TRO.2012.2200990 ( 0) 0)

|

| [12] |

李帅鑫, 李广云, 王力, 等. Lidar/IMU 紧耦合的实时定位方法[J/OL]. 自动化学报, https://doi.org/10.16383/j.aas.c190424. LI Shuaixin, LI Guangyun, WANG Li, et al. Lidar/IMU tightly coupled real-time localization method[J/OL]. Acta automatica sinica, https://doi.org/10.16383/j.aas.c190424. (  0) 0)

|

| [13] |

CHEN C, HE Y, GU F, et al. A Real-time relative probabilistic mapping algorithm for high-speed off-road autonomous driving[C]//Proceedings of 2015 IEEE/RSJ International Conference on Intelligent Robots and Systems. Hamburg, Germany, 2015: 6252−6258.

( 0) 0)

|

| [14] |

GENTIL C L, VIDAL-CALLEJA T, HUANG S. 3D lidar-IMU calibration based on upsampled preintegrated measurements for motion distortion correction[C]//Proceedings of 2018 IEEE International Conference on Robotics and Automation. Brisbane, Australia, 2018: 2149−2155.

( 0) 0)

|

| [15] |

GAO H, ZHANG X, YUAN J, et al. A novel global localization approach based on structural unit encoding and multiple hypothesis tracking[J]. IEEE transactions on instrumentation and measurement, 2019, 68(11): 4427-4442. DOI:10.1109/TIM.2018.2890455 ( 0) 0)

|

| [16] |

ZHAO S, FANG Z, LI H, et al. A robust laser-inertial odometry and mapping method for large-scale highway environments[C]//Proceedings of 2019 IEEE/RSJ International Conference on Intelligent Robots and Systems. Macau, China, 2019: 1285−1292.

( 0) 0)

|

| [17] |

NEUHAUS F, TILMAN K, ROBERT K, et al. MC2SLAM: Real-time inertial lidar odometry using two-scan motion compensation[C]//Proceedings of 2018 German Conference on Pattern Recognition, Stuttgart, Germany, 2018: 60−72.

( 0) 0)

|

| [18] |

张雪涛, 方勇纯, 张雪波, 等. 基于误差状态卡尔曼滤波估计的旋翼无人机输入饱和控制[J]. 机器人, 2020, 42(4): 394-405. ZHANG Xuetao, FANG Yongchun, ZHANG Xuebo, et al. Error state Kalman filter estimator based input saturated control for rotorcraft unmanned aerial vehicle[J]. robot, 2020, 42(4): 394-405. (  0) 0)

|

| [19] |

SHAN T, ENGLOT B, MEYERS D, et al. LIO-SAM: Tightly-coupled Lidar Inertial Odometry via Smoothing and Mapping[C]//Proceedings of 2020 IEEE/RSJ International Conference on Intelligent Robots and Systems. Las Vegas, USA, 2020: 1−8.

( 0) 0)

|

| [20] |

KAESS M, RANGANATHAN A, DELLAERT F. iSAM: incremental smoothing and mapping[J]. IEEE transactions on robotics, 2008, 24(6): 1365-78. DOI:10.1109/TRO.2008.2006706 ( 0) 0)

|

| [21] |

BLOESCH M, BURRI M, OMARI S, et al. Iterated extended Kalman filter based visual-inertial odometry using direct photometric feedback[J]. The international journal of robotics research, 2017, 36(10): 1053-72. DOI:10.1177/0278364917728574 ( 0) 0)

|

| [22] |

MERRIAUX P, DUPUIS Y, BOUTTEAU R, et al. Robust robot localization in a complex oil and gas industrial environment[J]. Journal of field robotics, 2018, 35(2): 213-30. ( 0) 0)

|

| [23] |

HEMANN G, SINGH S, KAESS M. Long-range GPS-denied aerial inertial navigation with LIDAR localization[C]//Proceedings of 2016 IEEE/RSJ International Conference on Intelligent Robots and Systems. Daejeon, Korea, 2016: 1659−1666.

( 0) 0)

|

| [24] |

WAN G, YANG X, CAI R, et al. Robust and precise vehicle localization based on multi-sensor fusion in diverse city scenes[C]//Proceedings of 2018 IEEE International Conference on Robotics and Automation. Brisbane, Australia, 2018: 4670−4677.

( 0) 0)

|

| [25] |

SHAMSELDIN T, MANERIKAR A, ELBAHNASAWY M, et al. SLAM-based Pseudo-GNSS/INS localization system for indoor liDAR mobile mapping systems[C]//Proceedings of 2018 IEEE/ION Position, Location and Navigation Symposium. Monterey, USA, 2018: 197−208.

( 0) 0)

|

| [26] |

JI K, CHEN H, DI H, et al. CPFG-SLAM: a robust simultaneous localization and mapping based on LIDAR in off-road environment[C]//Proceedings of 2018 IEEE Intelligent Vehicles Symposium (IV). Changshu, China, 2018: 650−655.

( 0) 0)

|

| [27] |

HANTEN R, KUHLMANN P, OTTE S, et al. Robust real-time 3D person detection for indoor and outdoor applications[C]//Proceedings of 2018 IEEE International Conference on Robotics and Automation. Brisbane, Australia, 2018: 2000−2006.

( 0) 0)

|

| [28] |

SHAO W, VIJAYARANGAN S, LI C, et al. Stereo visual inertial LiDAR simultaneous localization and mapping[C]//Proceedings of 2019 IEEE/RSJ International Conference on Intelligent Robots and Systems. Macau, China, 2019: 370−377.

( 0) 0)

|

| [29] |

PANG F, CHEN Z, PU L, et al. Depth enhanced visual-inertial odometry based on multi-state constraint Kalman filter[C]//Proceedings of 2017 IEEE/RSJ International Conference on Intelligent Robots and Systems. Vancouver, Canada, 2017: 1761−1767.

( 0) 0)

|

| [30] |

LEUTENEGGER S, LYNEN S, BOSSE M, et al. Keyframe-based visual-inertial odometry using nonlinear optimization[J]. The international journal of robotics research, 2014, 34(3): 314-334. ( 0) 0)

|

2020, Vol. 15

2020, Vol. 15