机器人与智能制造是国家制造2025的主攻方向和工业4.0的核心技术,为实施制造业创新驱动发展战略和加速制造业转型升级提供有利支撑。传统的工业机器人工作过程主要以示教或离线编程的方式执行预定指令,不利于加工柔性和智能化程度的提高[1-3]。机器人按预先编制的模式工作,当环境变化不被机器人感知时,容易造成加工误差,无法满足产品质量要求,或增加产品报废率,影响企业产品质量等级或增加生产成本。因此,基于实时信息感知反馈的机器人柔性位姿控制,是提高机器人智能化水平和产品质量的有利条件[4-5]。机器人智能化程度的提高有赖于传感器技术和信息技术的发展,其中,将机器视觉感知与机器人反馈控制技术相结合,有效利用视觉传感器信息感知能力,自适应地控制机器人执行决策,已成为提高机器人柔性和智能化水平的一个重要支撑条件[6-7]。

机器人视觉伺服控制研究领域涉及图像处理、模式识别、机器人运动学、机器人动力学以及控制理论等。20世纪90年代以来,基于信息感知的工业机器人柔性加工方法得到广泛的关注并进入快速发展阶段[8]。基于视觉的机器人控制形式在很大程度上克服了机器人自身、视觉系统以及外部环境的不确定性,使机器人定位和跟踪精度有极大的提高。Espiau等[9]较早地开展了机器人视觉伺服控制算法的研究。Belousov等[10]基于计算机网络远程控制方式对机器人实时目标抓取技术进行了研究,并采用仿真技术研究了目标定位和运动轨迹跟踪方法。Chaumette等[11]提出了基于21/2D视觉伺服控制方法,对视觉伺服经典控制方法进行了优化,并开展了机器人工业应用测试。Schmidt等[12]采用“眼在手”方式,将单目相机固定于机器人末端,通过在工件表面粘贴标记物实现定位抓取,目标标记方式可有效提高检测和控制精度。尹湘云等[13]基于支持向量机回归的机器人视觉定位,简化了控制策略并提高了机器人的控制精度。Ishibashi等[14]提出了基于双目立体视觉的机器人定位方法,实现了目标对象的快速、非接触三维定位,但该方法存在特征点难以匹配,较适合于特征点显著的目标物体。Wilson等[15]将单目摄像头安装在机器人执行器末端,借助物体已知特征点,通过扩展卡尔曼滤波器,研究了轨迹控制和目标跟踪技术,该方法可在动态环境中具备一定的可靠性。陈影等[16]采用点云切片法得到熔覆路径上的点集,运用非均匀有理B样条拟合得到加工点的曲线,从而得到枪头的运动轨迹,该方法提高了算法实现的可行性和可靠性。Park等[17]采用厚度映射法对物体表面进行三维重建,同时生成磨削路径,主要应用于船舶和飞机螺旋桨磨削加工,该方法验证了机器人数字化对大型雕刻面进行重塑和刀具路径生成的有效性。董铃等[18]采用基于三维视觉的激光再制造机器人离线自动编程系统,采用梯度重心法提取激光条纹的中心线,依据极限几何理论进行特征匹配,根据三角原理得到零件的表面点云数据,该算法在一定程度上提高了测量精度,具有较好的理论和实用价值。

目前,在面向工业应用的机器人手眼协调技术领域,由于存在外界光照干扰或加工工件形状复杂等因素,提高机器人动态环境适应能力和实现精确路径引导技术仍是研究热点。其中,机器人手眼关系标定、视觉有效信息获取、成像与控制模式以及视觉检测控制精度等仍需开展进一步的研究工作。本文鉴于前人的研究成果,以激光切割机器人视觉引导为研究背景,为克服环境光照干扰、切割工件形状复杂以及检测和控制精度低等问题,提出了一种基于双目CCD激光扫描3D成像的“眼在外”(Eye-to-hand:ETH)工业机器人末端(TCP)运动轨迹在线修正方法。以激光切割机器人视觉引导为研究背景,降低加工过程机器人对物理工装定位精度的依赖。首先,为提高机器人视觉控制精度,研究了目标工件双目3D激光扫描成像空间点云坐标精确提取方法;其次,融合ETH控制特点和扫描成像系统结构,建立了一种机器人TCP运动轨迹相对偏差在线补偿方法。该方法可用于混合多形状物料的识别、抓取与分拣工作。

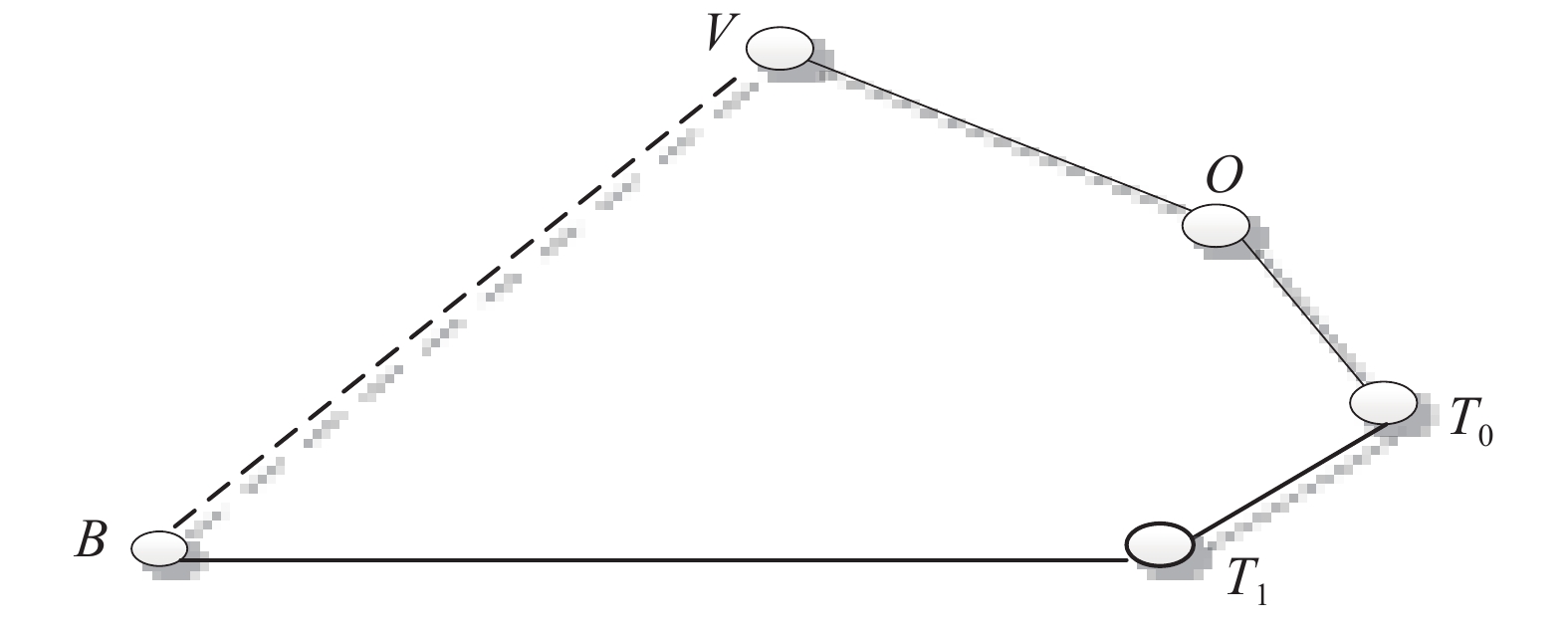

1 实验系统构建 1.1 手眼关系与目标检测方法文中机器人视觉信息反馈系统采用了眼在外独立工作方式(Eye-to-hand),因此,利用检测坐标点调整机器人末端执行器姿态,需将工件坐标系和机器人末端执行器坐标系统一到基坐标系下,确定机器人基座坐标系B和摄像机坐标系D之间的变换关系,转换关系矩阵可由手眼标定完成[19-20]。本系统由于采用双目激光扫描方式,因此,为便于确定手眼关系,在系统中定义了两个已知坐标原点,如图1所示,一是由示教获得的机器人工作原点,二是双目3D扫描成像系统扫描原点(双目CCD 3D点云数据在系统结构不变的情况由ICP算法进行一次配准,并确定配准变换矩阵参数不变)。基于以上定义可知,系统中视觉坐标系D与机器人基坐标系B位姿相对固定,基坐标系B与工具中心坐标系之间的转换矩阵可由机器人内部参数确定,位于工作原点中的工具中心点坐标系T1与扫描原点视觉成像坐标系V可通过一次标定获得并确定不变。此处,为便于计算,特将视觉坐标系原点V定义在扫描原点,在双目激光扫描系统标定过程中,将被扫描目标点云坐标确定在V坐标下,具体检测方法不作为本文重点论述。因此,扫描获得的目标物体上某一点

| ${}^B{{\boldsymbol{P}}_p} = {}^B{{\boldsymbol{T}}_{{T_1}}}\times{}^{{T_1}}{{\boldsymbol{T}}_V}\times{}^V{{\boldsymbol{P}}_p}$ | (1) |

式中:

依据正运动学求解过程,图1中目标坐标系内点

| ${}^B{\boldsymbol{P}} = {}_V^B{\boldsymbol{R}}\times{}^V{\boldsymbol{P}} + {}_V^B{\boldsymbol{t}}$ | (2) |

式中:

| $\begin{split} {}^{{T_1}}{\boldsymbol{P}} = {}_B^{{T_1}}{\boldsymbol{R}}\times{}^B{\boldsymbol{P}} + {}_B^{{T_1}}{\boldsymbol{t}} ={}_B^{{T_1}}{\boldsymbol{R}}\times({}_C^B{\boldsymbol{R}}\times{}^C{\boldsymbol{P}} + {}_C^B{\boldsymbol{t}}) + {}_B^{{T_1}}{\boldsymbol{t}} \end{split} $ | (3) |

式中:

|

Download:

|

| 图 1 系统手眼坐标系空间转换关系 Fig. 1 Spatial transformation relationship of system hand to eye coordinate system | |

对式(2)和(3)引入齐次坐标变换矩阵如下:

| $\left[ {\begin{array}{*{20}{c}} {{}^B{\boldsymbol{P}}} \\ 1 \end{array}} \right] = \left[ {\begin{array}{*{20}{c}} {{}_V^B{\boldsymbol{R}}}&{{}_V^B{\boldsymbol{t}}} \\ 0&1 \end{array}} \right] \left[ {\begin{array}{*{20}{c}} {{}^V{\boldsymbol{P}}} \\ 1 \end{array}} \right]$ | (4) |

| $\left[ {\begin{array}{*{20}{c}} {{}^{{T_1}}{\boldsymbol{P}}} \\ 1 \end{array}} \right] = \left[ {\begin{array}{*{20}{c}} {{}_B^{{T_1}}{\boldsymbol{R}}}&{{}_B^{{T_1}}{\boldsymbol{t}}} \\ 0&1 \end{array}} \right] \left[ {\begin{array}{*{20}{c}} {{}^B{\boldsymbol{P}}} \\ 1 \end{array}} \right]$ | (5) |

令

| ${}^B\tilde {\boldsymbol{P}} = {}_V^B{\boldsymbol{T}}{}^V\tilde {\boldsymbol{P}}$ | (6) |

| ${}^{{T_1}}\tilde {\boldsymbol{P}} = {}_B^{{T_1}}{\boldsymbol{T}}{}^B\tilde {\boldsymbol{P}} = {}_B^{{T_1}}{\boldsymbol{T}}{}_V^B{\boldsymbol{T}}{}^V\tilde {\boldsymbol{P}}$ | (7) |

式中变换矩阵

|

Download:

|

| 图 2 手眼标定关系 Fig. 2 Hand-eye calibration relationship | |

图2中,类似于空间尺寸链计算过程,

| $_{\boldsymbol{V}}^{\boldsymbol{B}}{\boldsymbol{T}} = _{{{\boldsymbol{T}}_{\boldsymbol{1}}}}^{\boldsymbol{B}}\!\!{\boldsymbol{T}} \times _{{{\boldsymbol{T}}_{\boldsymbol{0}}}}^{{{\boldsymbol{T}}_{\boldsymbol{1}}}}{\boldsymbol{T}} \times _{\boldsymbol{O}}^{{{\boldsymbol{T}}_{\boldsymbol{0}}}}{\boldsymbol{T}} \times _{\boldsymbol{V}}^{\boldsymbol{O}}{\boldsymbol{T}}$ | (8) |

式中:

| ${}_O^B{\boldsymbol{T}} = {}_C^B{\boldsymbol{T}}{}_O^V{\boldsymbol{T}}$ | (9) |

由以上推导可知,通过运动学计算,将机械臂的各关节角度输入到机械臂控制器,驱动机械臂完成指定任务。

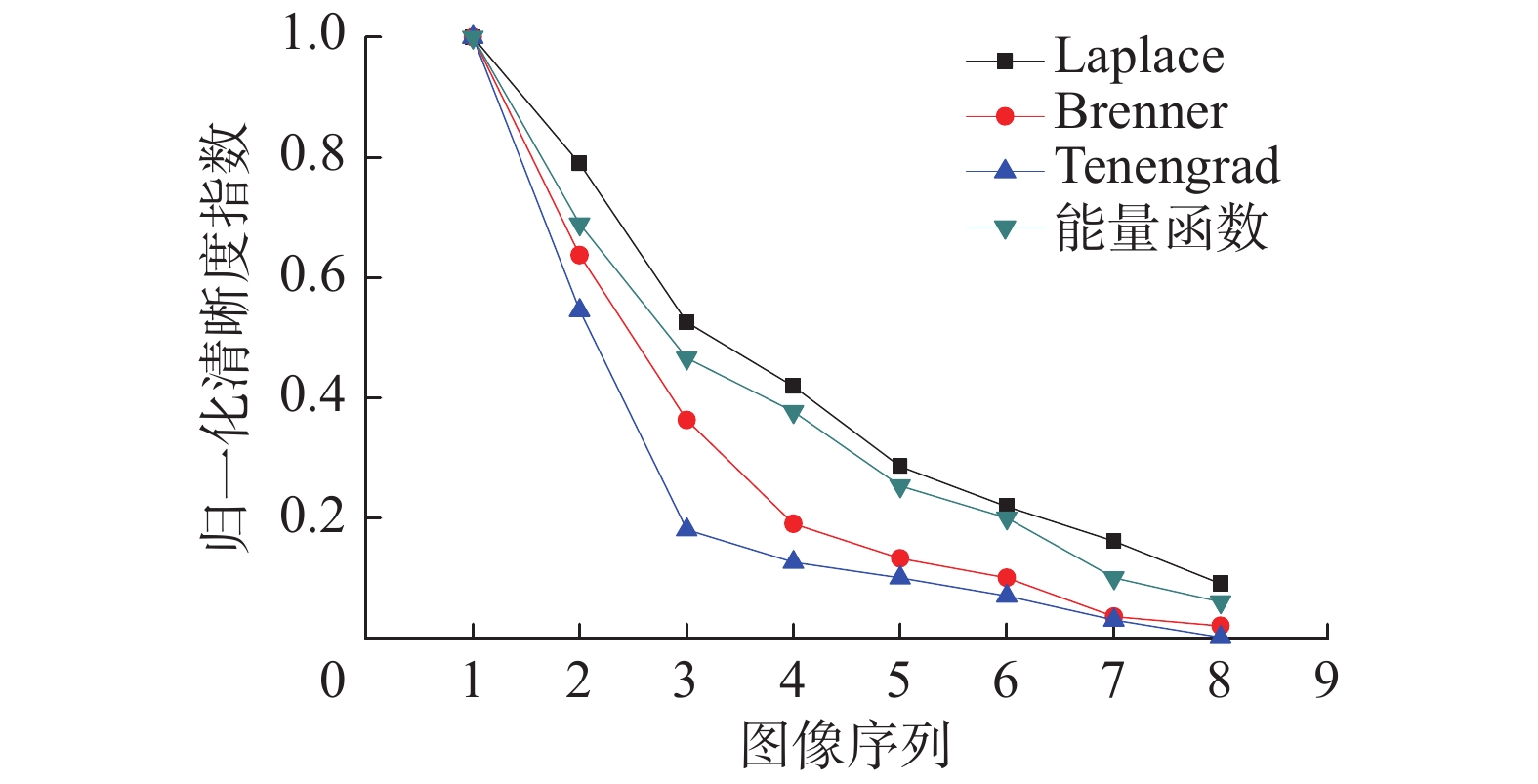

通过机器人视觉引导工作过程可知,视觉系统检测精度是提高机器人加工过程偏差修正可靠性的一个必要条件,本实验系统采用主动成像方法,针对机器人所处光照不均、亮度变化环境下,对不同清晰度评价函数进行了理论分析和实验研究,确定了激光线最佳成像方法。实现CCD在不同光积分时间和聚焦(离焦)状态下有效提取激光线调制信息变化情况,提高扫描系统在复杂变化环境下的鲁棒性。基于此,实验中同时考虑激光线成像清晰度曲线的单峰性和计算实时性因素,综合对比不同图像清晰度评价函数的清晰度指数计算结果,依据图像清晰度变化的灵敏度响应,如图3所示,确定了基于Tenengrad图像梯度的清晰度自适应控制方法。

|

Download:

|

| 图 3 不同图像清晰度评价函数清晰度计算响应结果对比 Fig. 3 Comparison of sensitivity response of different image definition evaluation functions | |

在实时获取激光线清晰图像的前提下,机器人工作目标点云的精确检测取决于激光线调制信息的精确提取。本文对比研究了目前较为常用的结构光中心线提取算法,包括极值法[21]、Steger[22]算法、曲线拟合法[23]、模板法[24]以及本文确定的自适应灰度重心法[25]等。实验中,依据所选激光线特征,首先对激光线条像使用高斯分布动态阈值进行自适应二值化处理,其阈值函数表达式如下:

| $T(x) = a{{\rm{e}}^{{{({T_n} - b)}^{2/{c^2}}}}}$ | (10) |

式中:

根据检测实时性和检测精度需求,文中对于激光线进一步单像素处理采用灰度重心法求出,其重心坐标表达式如下:

| $\left\{ \begin{array}{l} {x_o} = \displaystyle\sum\limits_{i = 1}^M {\displaystyle\sum\limits_{j = 1}^N {i \cdot I(i,j)} } /\displaystyle\sum\limits_{i = 1}^M {\displaystyle\sum\limits_{j = 1}^N {I(i,j)} } \\ {y_o} = \displaystyle\sum\limits_{i = 1}^M {\displaystyle\sum\limits_{j = 1}^N {j \cdot I(i,j)} } /\displaystyle\sum\limits_{i = 1}^M {\displaystyle\sum\limits_{j = 1}^N {I(i,j)} } \end{array} \right.$ | (11) |

式中:

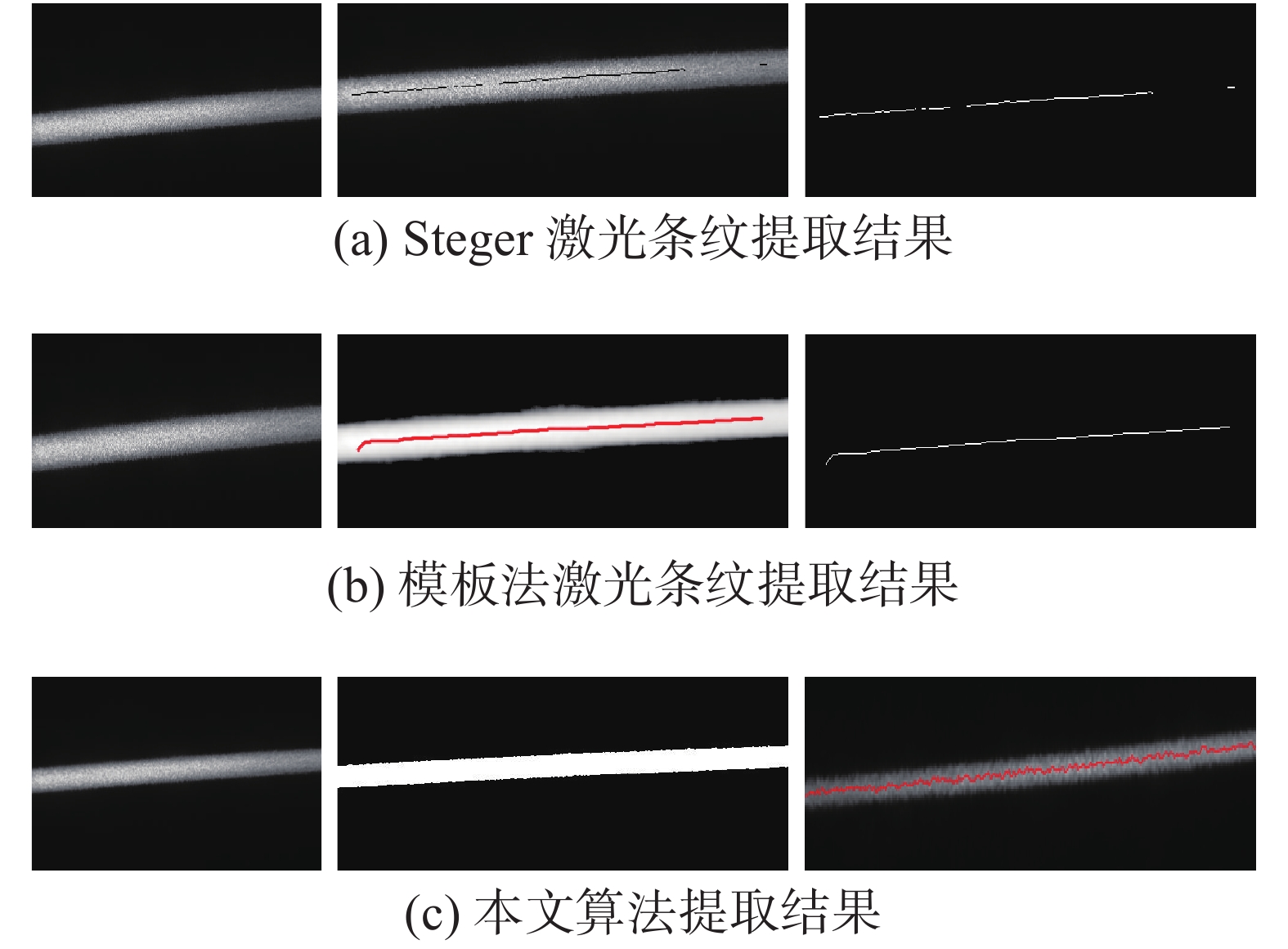

特定环境下,算法的抗噪性能会影响检测精度[26],算法设计应根据所选激光线特征以及环境易变情况而定,一般不存在最优或通用性条纹提取算法。图4分别为最佳成像状态下Steger算法、模板法和文中算法激光先中心点提取结果。实际应用中,结构光辅助测量图像中心线提取过程中,光条宽度越小、目标面对比度越高、平顺性越好,算法设计性能会越高。

|

Download:

|

| 图 4 激光条纹提取形态对比 Fig. 4 Comparison of laser fringe extraction results | |

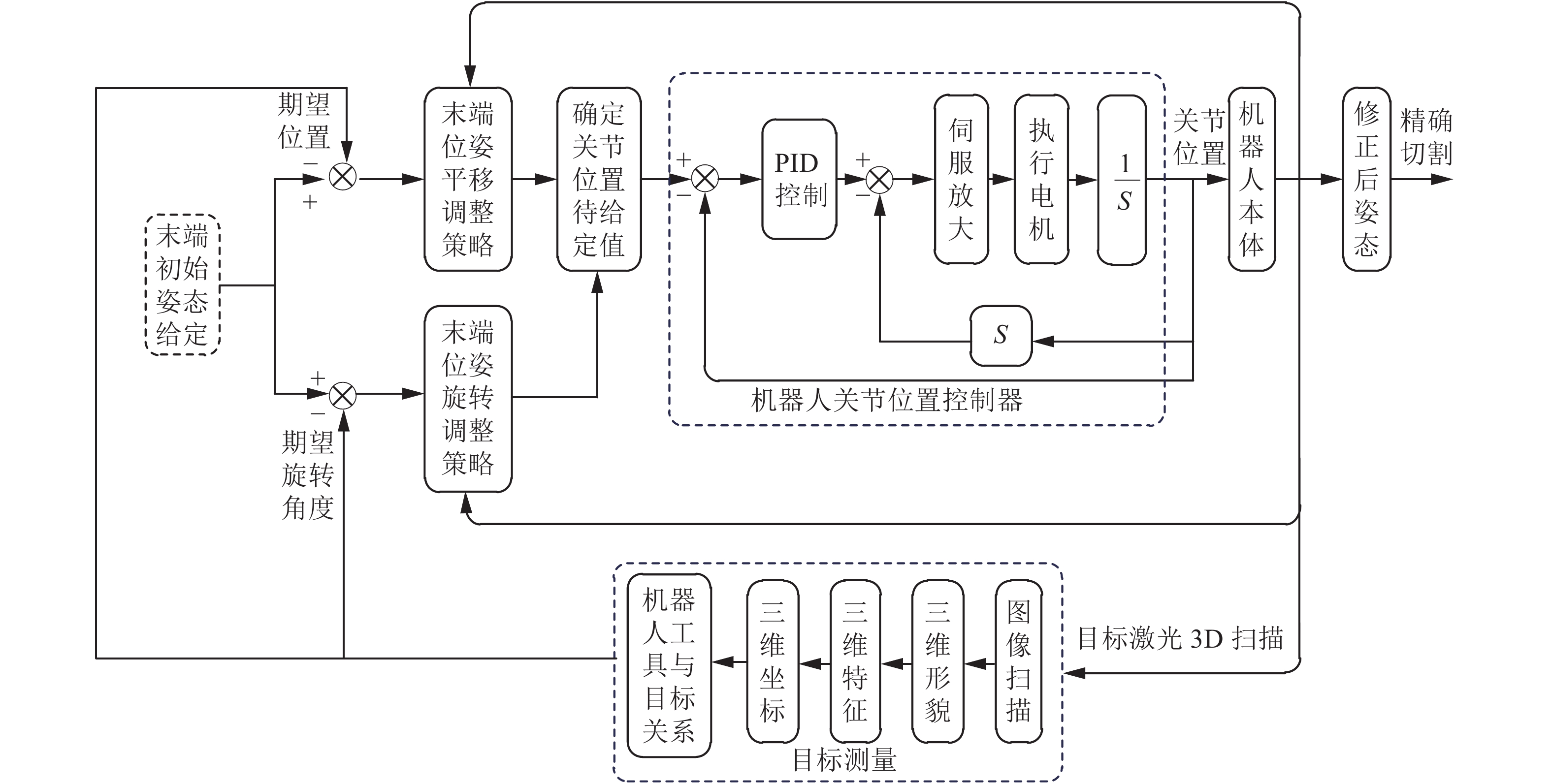

通过双目3D激光扫描成像技术旨在实现被测件的三维形貌和笛卡尔空间姿态的精确检测,输出用于工具中心点位姿的旋转和平移量,并将结果传递给机器人关节控制器修正执行器姿态。该方法便于实现基于图像和位置的机器人混合视觉伺服控制,进一步保证了基于图像和基于位置的伺服控制的优点(本文在该方面不做进一步论述)。图5为文中设计的基于双目激光3D扫描成像机器人加工点修正和控制方法示意图。

该修正方法的优点在于结合了双目激光扫描大视野低遮挡的三维量化检测优势,基于此,在被测目标z方向提取旋转坐标时可采用两个特征值获得,其一是被测目标在z坐标方向的距离值;其二是结合目标投影畸变获得。如图6(a)、(b)所示,当目标定位存在偏差(如一侧高于另一侧)图像将发生投影畸变,此时可根据畸变程度与标准图形反推工件姿态。由于已获得被检测目标三维形貌,因此,被测件与计算机输入的标准件在空间上可以快速进行匹配。另一方面是被加工件在二维平面中姿态的读取,包括二维空间中的平移和旋转量,如图6(c)所示,读取值为实际检测值与标准定位图像在二维平面的平移和旋转偏差。

|

Download:

|

| 图 5 基于双目激光三维扫描成像的机器人控制方法 Fig. 5 Robot control method based on Binocular Laser 3D scanning imaging | |

|

Download:

|

| 图 6 基于图像信息检测的目标姿态提取方式 Fig. 6 Image information detection-based approach to target attitude extraction | |

传统的单目激光三角测量系统,对于复杂三维曲面其测量精度易受激光入射角影响,或在某些区域出现成像遮挡问题,产生视觉盲区。文中采用双目扫描和图像ICP配准方式优化了成像空间,采用激光直射和双目斜射扫描激光调制信息,并根据系统标定参数输出被测目标点云坐标。对于机器人在工件上的连续工作路径,通过选择边界特征点,采用NURBS曲线拟合得到工件边界曲线,拟合方法如下[27]:

| $ P(u) = \frac{{\displaystyle\sum\limits_{i = 0}^n {{N_{i,k}}(u){W_i}{D_i}} }}{{\displaystyle\sum\limits_{i = 0}^n {{N_{i,k}}(u){W_i}} }} $ | (12) |

式中:

| $\begin{aligned}{N_{i,k}}(u) = \frac{{u - {u_i}}}{{{u_{i + k}} - {u_i}}}{N_{i,k - 1}}(u) + \frac{{{u_{i + k + 1}} - u}}{{{u_{i + k + 1}} - {u_{i + 1}}}}{N_{i + 1,k - 1}}(u)\\ {\text{且}}{N_{i,0}}(u) = \left\{ \begin{array}{l} 1,\quad{u_i} \leqslant u \leqslant {u_{i + 1}}\\ 0,\quad{\text{其他}} \end{array} \right. \quad\quad\quad\end{aligned}$ | (13) |

式中:

通常情况下,采用NURBS曲线拟合,需要控制节点矢量、顶点以及权因子参数,其中,通过控制顶点的位置和数量可以更清晰地调整曲线的形状,为简化计算,假定权因子

| $P(u) = \sum\limits_{i = 0}^n {{N_{i,k}}(u)} {D_i}$ | (14) |

对于每个边界测量离散点

| ${P_j} \approx P({u_j}) = \sum\limits_{i = 0}^n {{N_{i,k}}} (u){D_i}$ | (15) |

式中:

为使拟合的曲线与离散点的偏差总和最小,偏差总和与控制顶点函数表示为

| $P({D_0},{D_1}, \cdots, {D_n}) \!=\! {\sum\limits_{j = 0}^m {\left| {p({u_j}) - {p_j}} \right|} ^2} \!=\! \sum\limits_{j = 0}^m {{{\left| {\sum\limits_{i = 0}^n {{N_{i,k}}({u_j}){D_j} - {p_j}} } \right|}^2}} $ | (16) |

由式(12)~(15),可以求解出各个控制顶点的值,故可以确定NURBS拟合的工件边缘路径曲线。采用NURBS进行修正点曲线的拟合,通过调整控制顶点和权值,可以实现复杂曲线的精确拟合。

通过拟合工件加工路径的3D特征点,可精确获取机器人工作路径的3D空间姿态调整信息。根据加工路径曲线拟合数据,完成修正点到机器人坐标系的转化,实现检测点和机器人控制点坐标系的统一。基于此,可通过已知检测点的逆运动学求解,得到加工机器人各个关节旋转角度,并由控制器输出指令完成路径引导。以图1中已定义坐标系为例,机器人的末端坐标系为T0,工具坐标系为T1。取边界测量数据中一点作为当前的加工点,其位置矢量为

| ${}_p^B{\boldsymbol{T}} = \left[ {\begin{array}{*{20}{c}} {{{\boldsymbol{\upsilon}} _t}}&{{{\boldsymbol{\upsilon}} _e}}&{{{\boldsymbol{\upsilon}} _n}}&{\boldsymbol{P}} \\ 0&0&0&1 \end{array}} \right]$ | (17) |

根据变换式,需要将检测点的数据转换成机器人位姿,转换关系如下:

| ${}_{{T_0}}^B{{\boldsymbol{T}}_P} \cdot {}_{{T_1}}^{{T_0}}{\boldsymbol{T}} = {}_p^B{\boldsymbol{T}}$ | (18) |

式中:

| $ {}_{{T_0}}^B{{\boldsymbol{T}}_P} = {}_p^B{\boldsymbol{T}}{}_{{T_1}}^{{T_0}}{{\boldsymbol{T}}^{ - 1}} $ | (19) |

| ${\boldsymbol{\varTheta}} = {\Gamma ^{ - 1}}({}_{{T_0}}^B{{\boldsymbol{T}}_P})$ | (20) |

式中:

因此,通过遍历各加工路径点,可获得机器人位姿变化矩阵,并通过逆运动学求解各个关节的旋转角度,串联各个边界测量点,完成机器人加工路径引导。

2 实验结果分析本文通过搭建实验平台,采用越疆Dobot机器人首先对三维混合物料抓取方法进行了实验研究。通过物料的三维形貌测量实现机器人按形状次序(同形状按z值排序)控制夹具坐标系的空间定位。图7(a)、(b)分别为软件实验系统和测试平台,其中,双目CCD采样频率为14帧/s(分辨率:2592×1944)。系统中主要采用双目扫描检测和三维形态坐标提取,与机器人形成闭环控制视觉引导系统,实现物料的识别、抓取和分拣工作。

|

Download:

|

| 图 7 双目CCD激光扫描成像混合物料识别与抓取实验 Fig. 7 Identification and grab experiment of mixed materials based on binocular CCD laser scanning imaging | |

实验2为注塑件边缘毛刺激光切割路径加工点检测与路径曲线拟合实验,图8为检测目标三维形貌测量与点云坐标重构图像,图8(b)为目标双目扫描与配准过程示意图,系统中考虑到数据处理速度和系统刚性,配准过程中平移和旋转矩阵参数均采用IPC初始化方式进行确定,后续过程仅按确定参数进行配准以完成最终三维图像生产。图8(c)、(d)分别为三维扫描重构图和机器人加工(机器人切割)路径视觉引导三维空间坐标点。通过三维形态特征提取反映工件边界的特征点,NURBS拟合生成切割轨迹并进行视觉坐标系转换到机器人基座坐标系的转换,通过逆运动学求解,得到机器人一系列关节的角度,以此控制激光切割机器人进行末端位姿修正。

|

Download:

|

| 图 8 注塑件三维形貌扫描与加工路径提取 Fig. 8 Three dimensional morphology scanning and machining path extraction on injection modeling object | |

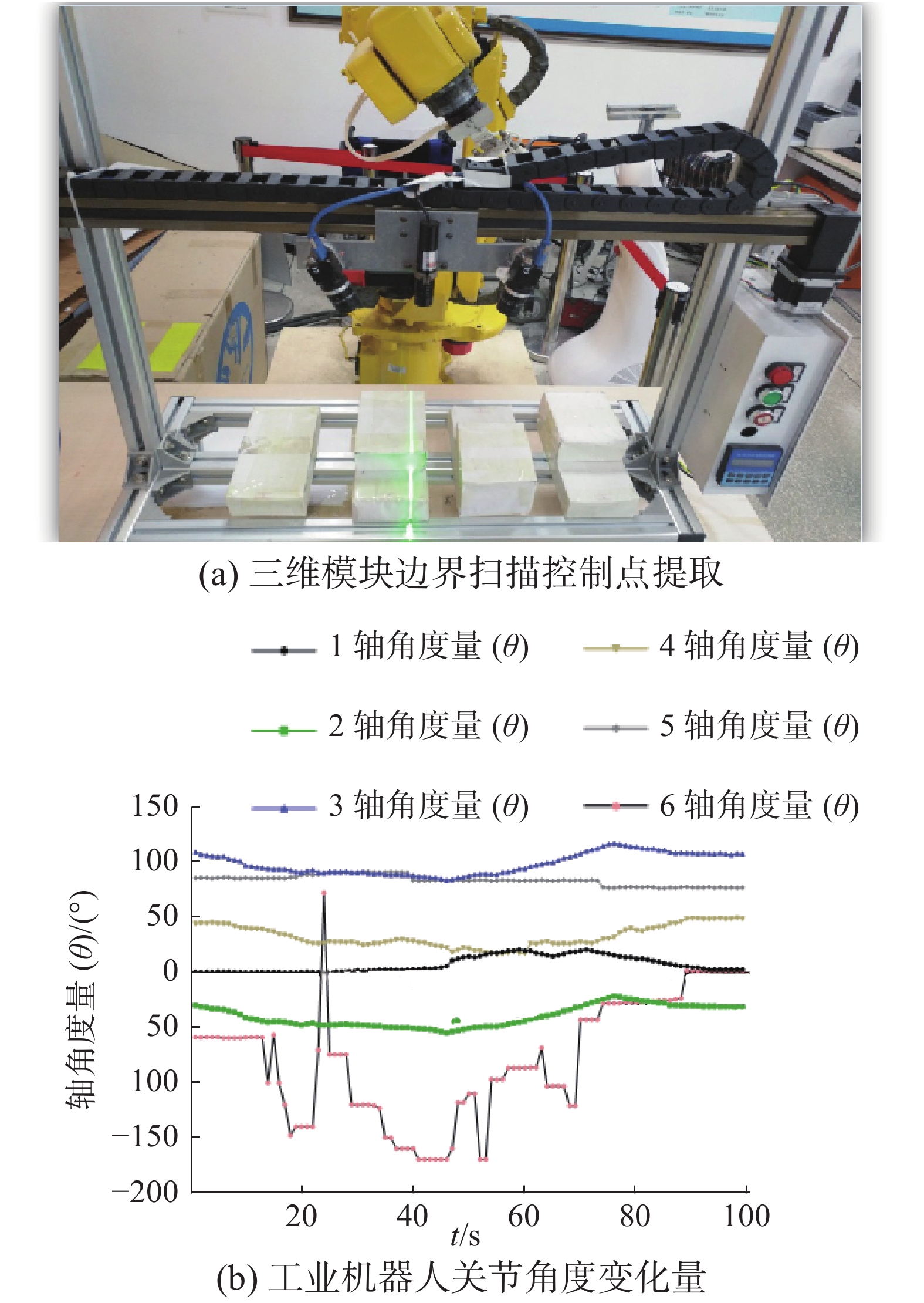

实验3通过FANUC6自由度工业机器人进行了实验测试,基于双目三维扫描方式提取的三维模块边界控制点对机器人工具中心点加工路径进行引导。图9所示为机器人完成切割路径引导后各个关节的角度变化曲线。通过实验研究,证明采用双目三维扫描成像与视觉伺服融合控制的方式,针对特定应用对象,有利于提高工业机器人三维曲面空间的加工柔性。

|

Download:

|

| 图 9 三维模块边界扫描与机器人路径引导关节角度控制曲线 Fig. 9 3D module boundary scanning and robot path guide joint angle control curve | |

本文以激光切割机器人视觉引导为研究背景,为克服环境光照干扰、切割工件形状复杂以及检测和控制精度低等问题,基于工业机器人手眼协调控制理论,对机器人眼在外(Eye-to-hand)视觉引导系统的设计和控制方法进行了研究,提出了一种基于双目CCD 激光扫描3D成像的眼在外(Eye-to-hand)TCP切割路径在线修正方法。首先,为提高机器人视觉引导控制点的提取精度,研究了双目3D激光扫描成像目标工件空间点云坐标精确检测方法;其次,融合Eye-to-hand控制特点和三维扫描成像系统结构,构建了一种机器人TCP运动轨迹在线视觉修正方法,并通过实验研究对文中所提方法进行了验证,文中方法同时可应用于机器人混合多形状物料的识别、抓取与分拣工作,提高机器人的工作柔性程度,对工业实际应用奠定了基础。

| [1] |

谭民, 王硕. 机器人技术研究进展[J]. 自动化学报, 2013, 39(7): 963-972. TAN Min, WANG Shuo. Research progress on robotics[J]. Acta automatica sinica, 2013, 39(7): 963-972. DOI:10.3724/SP.J.1004.2013.00963 (  0) 0)

|

| [2] |

王麟琨, 徐德, 谭民. 机器人视觉伺服研究进展[J]. 机器人, 2004, 26(3): 277-282. WANG Linkun, XU De, TAN Min. Survey of research on robotic visual servoing[J]. Robot, 2004, 26(3): 277-282. DOI:10.3321/j.issn:1002-0446.2004.03.019 (  0) 0)

|

| [3] |

贾丙西, 刘山, 张凯祥, 等. 机器人视觉伺服研究进展: 视觉系统与控制策略[J]. 自动化学报, 2015, 41(5): 861-873. JIA Bingxi, LIU Shan, ZHANG Kaixiang, et al. Survey on robot visual servo control: vision system and control strategies[J]. Acta automatica sinica, 2015, 41(5): 861-873. DOI:10.16383/j.aas.2015.c140724 (  0) 0)

|

| [4] |

蔡鹤皋. 机器人技术的发展与在制造业中的应用[J]. 机械制造与自动化, 2004, 33(1): 6-7, 10. CAI Hegao. Decelopment and application of robot techniques in manufacture[J]. Machine building & automation, 2004, 33(1): 6-7, 10. DOI:10.3969/j.issn.1671-5276.2004.01.003 (  0) 0)

|

| [5] |

尹仕斌, 任永杰, 刘涛, 等. 机器视觉技术在现代汽车制造中的应用综述[J]. 光学学报, 2018, 38(8): 0815001. YIN Shibin, REN Yongjie, LIU Tao, et al. Review on application of machine vision in modern automobile manufacturing[J]. Acta optica sinica, 2018, 38(8): 0815001. DOI:10.3788/AOS201838.0815001 (  0) 0)

|

| [6] |

袁文礼. 机器人装配中的视觉引导定位技术分析[J]. 科技与创新, 2017(10): 55. YUAN Wenli. Analysis of vision guided positioning technology in robot assembly[J]. Science and technology & innovation, 2017(10): 55. DOI:10.15913/j.cnki.kjycx.2017.10.055 (  0) 0)

|

| [7] |

章炜. 机器视觉技术发展及其工业应用[J]. 红外, 2006, 27(2): 11-17. ZHANG Wei. Development of machine vision and its industrial applications[J]. Infrared, 2006, 27(2): 11-17. DOI:10.3969/j.issn.1672-8785.2006.02.003 (  0) 0)

|

| [8] |

王天苗, 陶永. 我国工业机器人技术现状与产业化发展战略[J]. 机械工程学报, 2014, 50(9): 1-13. WANG Tianmiao, TAO Yong. Research status and industrialization development strategy of Chinese industrial robot[J]. Journal of mechanical engineering, 2014, 50(9): 1-13. DOI:10.3901/JME.2014.09.001 (  0) 0)

|

| [9] |

ESPIAU B. Effect of camera calibration errors on visual servoing in robotics[M]//YOSHIKAWA T, MIYAZAKI F. Experimental Robotics III. Berlin, Heidelberg: Springer, 1994, DOI: 10.1007/BFb0027594.

( 0) 0)

|

| [10] |

BELOUSOV I R, CHELLALI R, CLAPWORTHY G J. Virtual reality tools for internet robotics[C]//Proceedings 2001 ICRA. IEEE International Conference on Robotics and Automation (Cat. No. 01CH37164). Seoul, Korea: IEEE, 2001, DOI: 10.1109/ROBOT.2001.932882.

( 0) 0)

|

| [11] |

CHAUMETTE F, HUTCHINSON S. Visual servo control. I. Basic approaches[J]. IEEE robotics & automation magazine, 2006, 13(4): 82-90. DOI:10.1109/MRA.2006.250573 ( 0) 0)

|

| [12] |

SCHMIDT B, WANG Lihui. Automatic work objects calibration via a global-local camera system[J]. Robotics and computer-integrated manufacturing, 2014, 30(6): 678-683. DOI:10.1016/j.rcim.2013.11.004 ( 0) 0)

|

| [13] |

尹湘云, 殷国富, 胡晓兵, 等. 基于支持矢量机回归的机器人视觉系统定位精度[J]. 机械工程学报, 2011, 47(1): 48-54. YIN Xiangyun, YIN Guofu, HU Xiaobing, et al. Accuracy of robot vision system based on support vector machine regression[J]. Journal of mechanical engineering, 2011, 47(1): 48-54. (  0) 0)

|

| [14] |

ISHIBASHI S. The stereo vision system for an underwater vehicle[C]//Proceedings of the OCEANS 2009-EUROPE. Bremen, Germany: IEEE, 2009.

( 0) 0)

|

| [15] |

WILSON W J. Visual servo control of robots using Kalman filter estimates of relative pose[J]. IFAC proceedings volumes, 1993, 26(2): 633-638. DOI:10.1016/S1474-6670(17)48804-5 ( 0) 0)

|

| [16] |

陈影, 孙文磊, 黄勇, 等. 激光熔覆曲面零件再制造的机器人路径规划[J]. 中国激光, 2017, 44(5): 73-83. CHEN Ying, SUN Wenlei, HUANG Yong, et al. Robot path planning of laser cladding and remanufacturing of curved surface parts[J]. Chinese journal of lasers, 2017, 44(5): 73-83. DOI:10.3788/CJL201744.0502001 (  0) 0)

|

| [17] |

PARK J W, CHO H U, CHUNG C W, et al. Modeling and grinding large sculptured surface by robotic digitization[J]. Journal of mechanical science and technology, 2012, 26(7): 2087-2091. DOI:10.1007/s12206-012-0520-6 ( 0) 0)

|

| [18] |

董玲, 杨洗陈, 雷剑波. 基于机器视觉的激光再制造机器人离线自动编程研究[J]. 中国激光, 2013, 40(10): 109-116. DONG Ling, YANG Xichen, LEI Jianbo. Off-line automatic programming research of laser remanufacturing robot based on machine vision[J]. Chinese journal of lasers, 2013, 40(10): 109-116. DOI:10.3788/CJL201340.1003006 (  0) 0)

|

| [19] |

雷金周, 曾令斌, 叶南. 工业机器人单目视觉对准技术研究[J]. 光学精密工程, 2018, 26(3): 733-741. LEI Jinzhou, ZENG Lingbin, YE Nan. Research on industrial robot alignment technique with monocular vision[J]. Optics and precision engineering, 2018, 26(3): 733-741. DOI:10.3788/OPE.20182603.0733 (  0) 0)

|

| [20] |

杨守瑞, 尹仕斌, 任永杰, 等. 机器人柔性视觉测量系统标定方法的改进[J]. 光学精密工程, 2014, 22(12): 3239-3246. YANG Shourui, YIN Shibin, REN Yongjie, et al. Improvement of calibration method for robotic flexible visual measurement systems[J]. Optics and precision engineering, 2014, 22(12): 3239-3246. DOI:10.3788/OPE.20142212.3239 (  0) 0)

|

| [21] |

李莹莹, 张志毅, 袁林. 线结构光光条中心提取综述[J]. 激光与光电子学进展, 2013, 50(10): 9-18. LI Yingying, ZHANG Zhiyi, YUAN Lin. Survey on linear structured light stripe center extraction[J]. Laser & optoelectronics progress, 2013, 50(10): 9-18. DOI:10.3788/LOP50.100002 (  0) 0)

|

| [22] |

李伟明, 彭国, 高兴宇, 等. 线激光光条中心快速提取算法[J]. 中国激光, 2020, 47(3): 0304002. LI Weiming, PENG Guo, GAO Xingyu, et al. Fast extraction algorithm for line laser strip centers[J]. Chinese journal of lasers, 2020, 47(3): 0304002. DOI:10.3788/CJL202047.0304002 (  0) 0)

|

| [23] |

刘枝梅, 邓文怡, 娄小平. 结构光测量系统中光条中心的提取算法[J]. 北京机械工业学院学报, 2009, 24(1): 42-45. LIU Zhimei, DENG Wenyi, LOU Xiaoping. Extraction algorithm of light stripes center in the measurement system of structured light[J]. Journal of Beijing institute of machinery, 2009, 24(1): 42-45. DOI:10.3969/j.issn.1674-6864.2009.01.011 (  0) 0)

|

| [24] |

刘振, 李声, 冯常. 基于互相关算法的激光条纹中心提取[J]. 中国激光, 2013, 40(5): 197-202. LIU Zhen, LI Sheng, FENG Chang. Laser stripe center extraction based on cross-correlation algorithm[J]. Chinese journal of lasers, 2013, 40(5): 197-202. DOI:10.3788/CJL201340.0508004 (  0) 0)

|

| [25] |

吴剑波, 崔振, 赵宏, 等. 光刀中心自适应阈值提取法[J]. 半导体光电, 2001, 22(1): 62-64. WU Jianbo, CUI Zhen, ZHAO Hong, et al. An adaptive threshold method for light-knife center acquisition[J]. Semiconductor optoelectronics, 2001, 22(1): 62-64. DOI:10.3969/j.issn.1001-5868.2001.01.017 (  0) 0)

|

| [26] |

ZHAO Liming, OUYANG Qi, CHEN D, et al. Study on CCD laser scanning flatness measurement method for hot rolled strip[J]. Ironmaking & steelmaking, 2015, 42(8): 600-607. ( 0) 0)

|

| [27] |

孙玉文, 吴宏基, 刘健. 基于NURBS的自由曲面精确拟合方法研究[J]. 机械工程学报, 2004, 40(3): 10-14. SUN Yuwen, WU Hongji, LIU Jian. Research on the method of accurate NURBS surface fitting to scattered points[J]. Chinese journal of mechanical engineering, 2004, 40(3): 10-14. DOI:10.3321/j.issn:0577-6686.2004.03.003 (  0) 0)

|

| [28] |

闫继宏, 郭鑫, 刘玉斌, 等. 一种模块化机械臂的设计与运动学分析[J]. 哈尔滨工业大学学报, 2015, 47(1): 20-25. YAN Jihong, GUO Xin, LIU Yubin, et al. The design and kinematic analysis of a modular manipulator[J]. Journal of Harbin Institute of Technology, 2015, 47(1): 20-25. DOI:10.11918/j.issn.0367-6234.2015.01.004 (  0) 0)

|

2021, Vol. 16

2021, Vol. 16