2. 中国科学院 网络化控制系统重点实验室,辽宁 沈阳 110016;

3. 中国科学院 沈阳自动化研究所,辽宁 沈阳 110016;

4. 中国科学院 机器人与智能制造创新研究院,辽宁 沈阳 110169

2. Key Laboratory of Networked Control Systems, Chinese Academy of Sciences, Shenyang 110016, China;

3. Shenyang Institute of Automation, Chinese Academy of Sciences, Shenyang 110016, China;

4. Institutes for Robotics and Intelligent Manufacturing, Chinese Academy of Sciences, Shenyang 110169, China

一些特殊的工作场景如带电作业,由于其危险的工作环境使得工人们在工作时往往处于危险环境中如高压和高空[1]。力反馈遥操作机器人能够让使用者在安全的距离外通过主端设备控制从端设备进行作业,因而被广泛应用于带电作业以及其他危险环境的工作。人机协同技术能够将人的决策能力实时地融入到机器人的自主控制中,提高机器人在复杂环境下作业的能力和可靠度,从而提高其对复杂环境下作业的适应能力[2-3]。

自Rosenberg首次提出虚拟夹具技术[4]以来,国内外学者对力反馈装置与人机协同系统进行了一系列的研究。主要集中于操作者的控制辅助以及与从端环境的交互和触觉信息的感知方面[5-8]。Lee等[6]提出了一种机器人控制方法,操作者通过在实时视频图像上绘制所需的参考路径,据此生成机器人移动的实际路径并产生虚拟引导力协助操作者操作移动机器人完成相关动作。Nikolaidis等[9]提出了人机相互适应的人机协同方法,通过MOMDP计算用户的目标分布概率,在保持人的信任的同时引导操作者向最优目标前进。Wang等[10]提出了一种共享控制遥操作方法,通过利用多自由度机械臂的冗余自由度,在不影响机械臂末端位置的情况下实现机械臂本体对动态障碍物进行避障。

由于主端和从端设备的结构不同,操作者只能对从端设备的一部分进行控制。所以目前这个方向的研究大多将从端视为一个等效质点,注重于从端的位置(如移动机器人和机械臂末端)[11-13]。传统基于人工势场法的虚拟力引导方法会将机械臂末端受到的斥力和引力叠加后通过力反馈设备反馈给操作者[11-14]。这种方法由于目标吸引力的存在导致操作者感受到的力并不适合于引导操作者进行机械臂本体避障任务。此外,对于6自由度机械臂的目标抓取操作而言,往往需要操作者操作机器人末端以需要的姿态到达目标位置[15]。但在直接遥操作中,操作者往往难以将机械臂移动到某一精确的位置和姿态,并且由于人的手臂和手腕构成了一个耦合系统,二者的运动通常会相互影响,导致在操作过程中经常不可避免地会出现操作偏差。

因此,本文研究了一种基于虚拟力引导的遥操作方法。基于从端机械臂末端、障碍物和目标点的相对位置,通过在预定义路径周围构建管道形虚拟力场,结合障碍物的斥力与虚拟力场的约束力,生成趋近目标的同时进行避障操作的力引导。通过构建锥形虚拟力场并对操作者的输出进行限制,生成协助抓取任务的力引导,同时减少操作者的误操作。

1 基于虚拟力引导目标抓取方法目标抓取任务可以分为趋近目标点和到达目标点两个阶段。在趋近目标阶段,通过构建管道形虚拟力场(以下简称管形力场),利用管形力场内部的受约束空间协助操作者避开障碍物后尽可能再回到预定义的路径上。当机械臂末端趋近目标点到达一定的距离后,通过构建锥形虚拟力场(以下简称锥形力场)协助操作者到达目标点实施抓取任务。

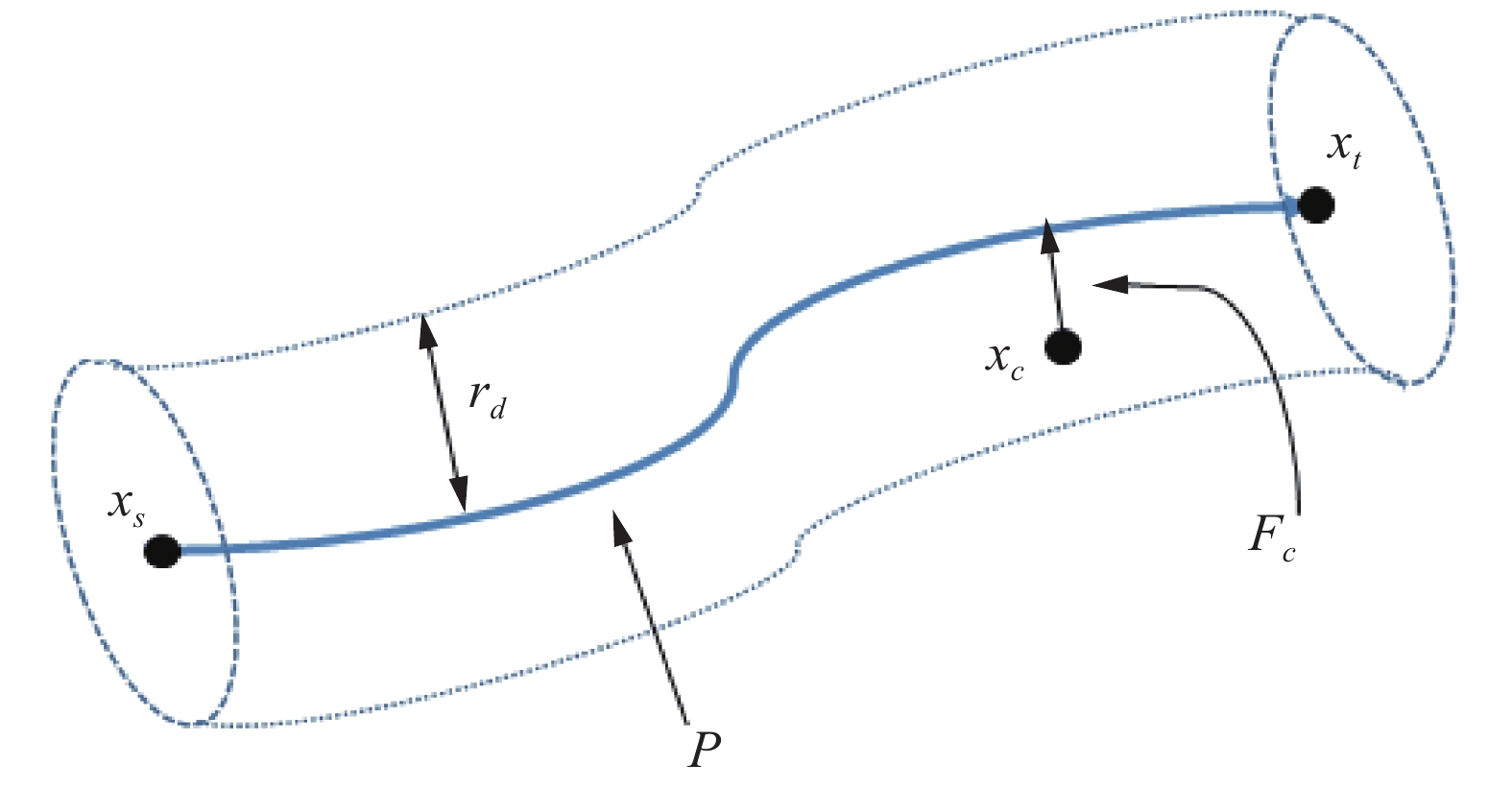

1.1 管道形虚拟力场的构建在本系统中,我们使用forbidden region virtual fixture (FRVF)[8]来限制机械臂的末端不要过多地偏离理想的路径。

假设P是一条预定义的路径(可由任意轨迹规划算法生成)。以P为轴线,

| $\left\| {P(s({{\boldsymbol{x}}_{{c}}}) - {{\boldsymbol{x}}_{{c}}})} \right\| = \min \left\| {P(s) - {{\boldsymbol{x}}_{{c}}}} \right\|$ | (1) |

|

Download:

|

| 图 1 管形虚拟力场示意 Fig. 1 Virtual force field of pipe | |

力场中的约束力可以定义为

| ${F_c} = {k_c}\delta ({{\boldsymbol{x}}_{{c}}})$ | (2) |

式中:

| $\delta ({{\boldsymbol{x}}_{{c}}}) = {{\boldsymbol{x}}_{{c}}} - s({{\boldsymbol{x}}_{{c}}})$ | (3) |

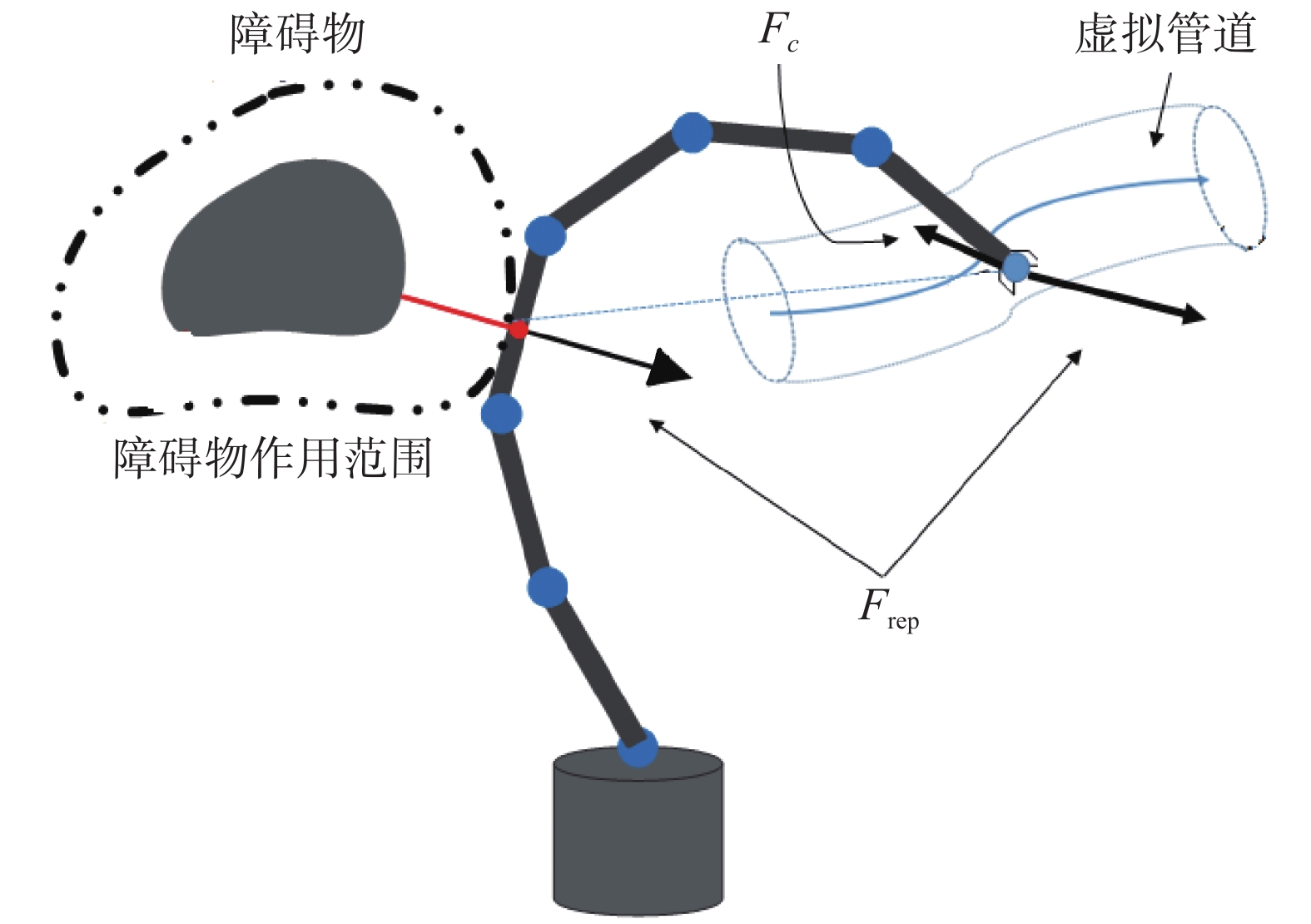

针对传统人工势场法不适用于引导操作者进行机械臂本体避障的问题,提出的改进避障引导策略如图2所示,由目标点对机械臂产生的引力被管形力场所产生的约束力代替,以防止产生错误的力引导信息。值得注意的是,我们所提的方法基于一个前提,即由于遥操作是一个human-in-the-loop系统,操作者根据人的决策能力结合系统给与的力觉引导做出合理的操作,所以系统反馈给操作者的引导信息并不需要是完美的[2-3]。

|

Download:

|

| 图 2 避障任务的虚拟力引导 Fig. 2 Virtual force guidance for obstacle avoidance | |

对于斥力场的构建,其通常的表达式如式(4)所示。当机械臂本体或者末端进入障碍物的作用范围时,作用在机械臂本体的斥力被映射到机械臂末端,经主端的力反馈设备反馈给操作者。距离障碍物越近,机械臂所受到的斥力越大。

| ${{\boldsymbol{U}}_{{\rm{rep}}}} = \left\{ \begin{aligned} & {\frac{1}{2}{\eta _{{\rm{rep}}}}{{\left(\frac{1}{\rho } - \frac{1}{{{\rho _0}}}\right)}^2},}\quad{\rho < {\rho _0}} \\ & {0,}\quad{\rho \geqslant {\rho _0}} \end{aligned}\right.$ | (4) |

式中:

障碍物所产生的斥力大小为斥力场对距离的导数,其表达式为

| ${{\boldsymbol{F}}_{{\rm{rep}}}} = - \nabla {{\boldsymbol{U}}_{{\rm{rep}}}} = \left\{ \begin{aligned} & {{\eta _{{\rm{rep}}}}\left(\frac{1}{\rho } - \frac{1}{{{\rho _0}}}\right)\frac{1}{{{\rho ^2}}}\nabla \rho ,}\quad{\rho < {\rho _0}} \\ & {0,}\quad{\rho \geqslant {\rho _0}} \end{aligned} \right.$ | (5) |

则操作者受到的引导力为机械臂在工作空间中受到的引力与斥力的合,其表达式为

| ${{\boldsymbol{F}}_{{\rm{to}}}} = {{\boldsymbol{F}}_{{c}}} + {{\boldsymbol{F}}_{{\rm{rep}}}}$ | (6) |

若存在多个障碍物,则式(6)可变为

| ${{\boldsymbol{F}}_{{\rm{to}}}} = {{\boldsymbol{F}}_{{c}}} + \sum\limits_{i = 1}^n {{{\boldsymbol{F}}_{i{\rm{,rep}}}}} $ | (7) |

式中:

约束力一直指向管形力场的中轴线(预定义路径),则约束力的方向与斥力的方向的夹角会接近一条直线,所以约束力的加入不会对避障任务造成不利影响。当避障任务完成之后,操作者感受到的力引导只由虚拟力场产生,用于协助操作者跟随预定义的路径移动。

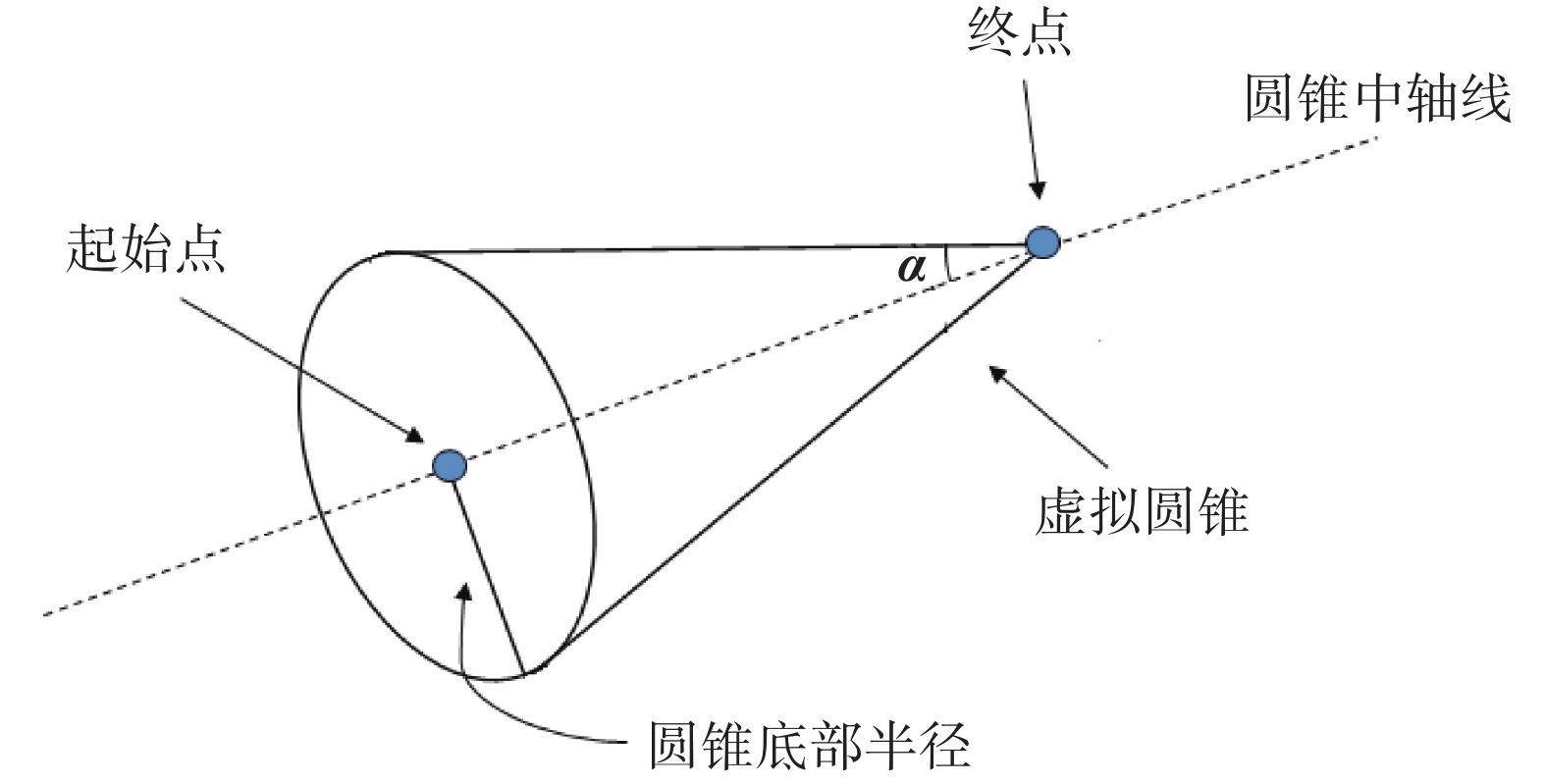

1.3 锥形虚拟力场的构建当机械臂末端足够接近目标点后,操作者需要调整手臂和手腕来操作机械臂到达理想的位置和姿态。与管形力场的构建方法类似,当机械臂末端与目标点之间的距离小于一个特定的距离(即

| ${\boldsymbol{\alpha }} = \frac{{({{\boldsymbol{x}}_{{t}}} - {{\boldsymbol{x}}_{{s}}})}}{{\left\| {{{\boldsymbol{x}}_{{t}}} - {{\boldsymbol{x}}_{{s}}}} \right\|}}$ | (8) |

|

Download:

|

| 图 3 锥形虚拟力场示意 Fig. 3 Conical virtual force field | |

给定一个机械臂末端的笛卡尔空间位置

| ${{\boldsymbol{n}}_{{o}}}({{\boldsymbol{x}}_{{c}}}) = ({\boldsymbol{I}} - {\boldsymbol{a}}{{\boldsymbol{a}}^{\rm{T}}})({{\boldsymbol{x}}_{{t}}} - {{\boldsymbol{x}}_{{c}}})$ | (9) |

| ${{\boldsymbol{n}}_{{R}}}({{\boldsymbol{x}}_{{c}}}) = ({\boldsymbol{a}}{{\boldsymbol{a}}^{\rm{T}}})({{\boldsymbol{x}}_{{t}}} - {{\boldsymbol{x}}_{{c}}})$ | (10) |

定义

| ${{\rm{condition}}_{{\rm{in}}}}({{\boldsymbol{x}}_{{c}}}) \equiv \left\| {{{\boldsymbol{n}}_{{O}}}({{\boldsymbol{x}}_{{c}}})} \right\| \leqslant {d_{{\rm{cone}}}}$ | (11) |

| ${d_{{\rm{cone}}}} = \left\| {{{\boldsymbol{n}}_{{R}}}({{\boldsymbol{x}}_{{c}}})} \right\|\tan \alpha $ | (12) |

若

根据所建立的锥形力场,可以计算出虚拟引导的力,其表达式为

| ${{\boldsymbol{F}}_{{p}}} = {k_n}{{\boldsymbol{n}}_{{O}}}({{\boldsymbol{x}}_{{c}}}) + {k_2}{{\boldsymbol{n}}_{{R}}}({{\boldsymbol{x}}_{{c}}})$ | (13) |

| ${k_n} = {k_1}\left( {1 + \frac{{d_c}{{\left\| {{{\boldsymbol{n}}_{{R}}}({{\boldsymbol{x}}_{{c}}})} \right\|}^2}}{{\left\| {{d_{{\rm{cone}}}}} \right\|}}} \right)$ | (14) |

其中

对于机械臂末端姿态调整的虚拟力引导,其计算方式与对末端位置的引导一样。假设

| ${{\boldsymbol{F}}_{{{VG}}}} = \left[ {\begin{array}{*{20}{c}} {{{\boldsymbol{F}}_{{P}}}} \\ {{{\boldsymbol{F}}_{{R}}}} \end{array}} \right] = {k_n}\left[ {\begin{array}{*{20}{c}} {{{\boldsymbol{n}}_{{O}}}({{\boldsymbol{x}}_{{c}}})} \\ {{{\boldsymbol{\theta }}_{{t}}} - {{\boldsymbol{\theta }}_{{c}}}} \end{array}} \right] + {k_2}\left[ {\begin{array}{*{20}{c}} {{{\boldsymbol{n}}_{{R}}}({{\boldsymbol{x}}_{{c}}})} \\ 0 \end{array}} \right]$ | (15) |

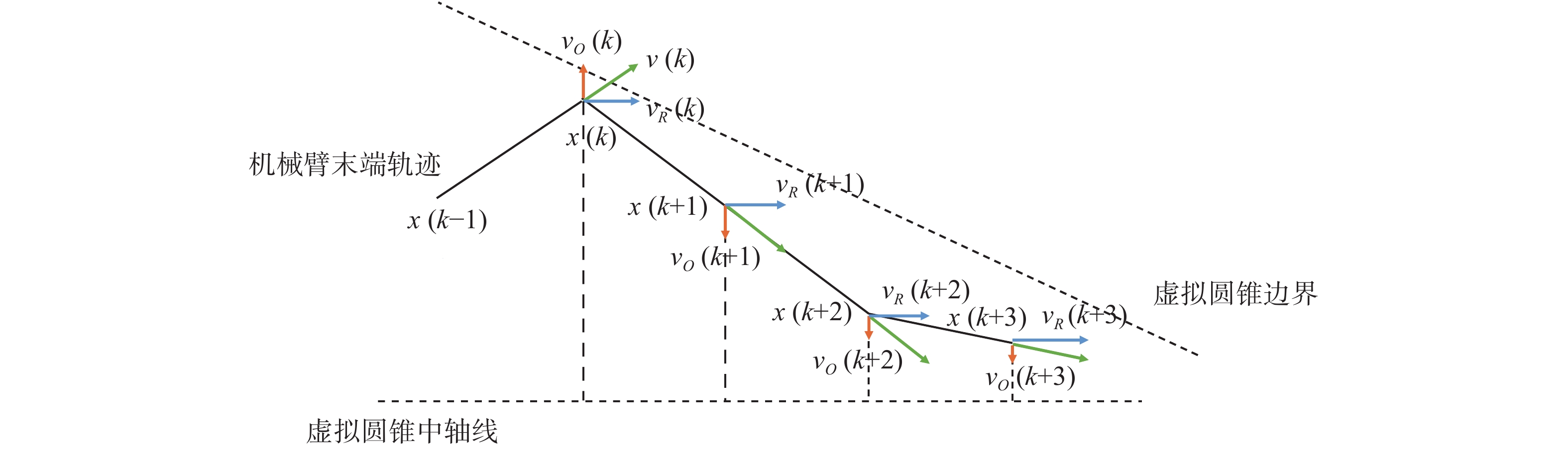

如图4所示,为了实现对操作者输出的限制,以下信息将会被用到:采样时间

对一个机械臂末端速度

| ${\boldsymbol{v}}(k) = {{\boldsymbol{v}}_{{O}}}(k) + {{\boldsymbol{v}}_{{R}}}(k)$ | (16) |

| ${{\boldsymbol{v}}_{{O}}}(k) = ({\boldsymbol{I - a}}{{\boldsymbol{a}}^{\rm{T}}}){\boldsymbol{v}}(k)$ | (17) |

| ${{\boldsymbol{v}}_{{R}}}(k) = ({\boldsymbol{a}}{{\boldsymbol{a}}^{\rm{T}}}){\boldsymbol{v}}(k)$ | (18) |

式中:

此时,加入一个调整参数

| ${\boldsymbol{v}}(k) = \mu (k){{\boldsymbol{v}}_{{O}}}(k) + {{\boldsymbol{v}}_{{R}}}(k){\rm{ }}$ | (19) |

通过调节参数

在人机协作领域,存在一个如何分配机器人自主性能与人的操作权重的问题。许多学者对该问题进行了研究和探讨[2-3, 16-18],但当前还没有一个公认的权重分配方案。结合实际操作需求,本文认为人在大多数时间可以顺从机器人的自主决策和引导,但一旦人想要自己进行操作就应该拥有足够的控制权限。故将参数

| $\mu (k) = \left\{ \begin{aligned} & 1,\quad{d(k) \geqslant {d_{{\rm{cone}}}}(k)} \\ & {\frac{{0.8}d(k)}{{{d_{{\rm{cone}}}}(k)}} + 0.2},\quad{0 \leqslant d(k) \leqslant {d_{{\rm{cone}}}}(k)} \end{aligned}\right.$ | (20) |

式中:

|

Download:

|

| 图 4 速度矢量分解 Fig. 4 Examples of decomposed velocity vectors | |

|

Download:

|

|

图 5 参数

|

|

本文所提基于虚拟力引导的遥操作系统由一个主从控制子系统和深度相机组成,如图6所示。

|

Download:

|

| 图 6 虚拟引导力遥操作系统结构 Fig. 6 Virtual force guidance teleoperation system | |

相机用于获取目标点位置、障碍物位置和从端机械臂与障碍物的相对距离。从端设备为一个UR5协作机器人,主端为一个Virtuose 6D力反馈仪,能够与操作者实现力觉交互。在实验中,从端机械臂向主端发送位置和速度信息,而主端力反馈设备结合从端发送的信息和相机发送的距离信息计算出引导力并反馈给操作者;同时向从端发送速度指令用以控制从端设备的运动。

2.1 机械臂避障实验在机械臂本体避障实验中,我们仅考虑障碍物和目标物都为静态且唯一的情况。根据机械臂末端、障碍物和目标物的位置建立起斥力场和管形力场,并计算出虚拟力引导(由式(6)得出),通过主端反馈给操作者。操作者根据这些力反馈信息对从端机械臂进行操作,最终避过障碍物并接近目标点。当机械臂避过障碍物后,机械臂末端距离目标点10 cm内即可判定为完成实验。当机械臂本体碰到障碍物则实验失败。

实验在两种场景中进行(如图7所示),两个场景的目标点位置和机械臂初始位置相同,但障碍物的位置不同,两场景中障碍物分别作用于机械臂的末端和连杆。我们分别在两个场景中使用本文所提虚拟力引导方法、文献[7]所提力感知方法和无力引导操作方法分别进行多次实验,实验结果如表1和表2所示。

|

Download:

|

| 图 7 机械臂避障实验的实验环境 Fig. 7 Experimental environment for obstacle avoidance | |

| 表 1 障碍物作用于机械臂末端避障实验结果 Tab.1 Experimental results of the obstacle approaching the end |

图8(a)和图8(b)~(d)分别是一次避障实验中,在3种方法协助下的机械臂末端的轨迹和其末端与预定义路径的偏差。可见,在虚拟力引导的情况下,当机械臂在障碍物的作用范围内时,障碍物对机械臂的斥力对操作者的引导占主要作用从而避免碰撞发生。操作者可以在虚拟力的引导下完成避障任务。同时,相较于文献[7]所提力感知引导方法,由于管形力场的作用,机械臂末端轨迹更接近障碍物表面,使得末端与预定义路径的最大偏差大幅减小。并且在完成了避障任务后,末端与预定义路径的偏差能快速缩小。此外,即使没有受到指向目标点的力引导,操作者依然能够通过自身的决策能力结合管形力场提供的约束力快速完成实验任务,缩短耗时,且机械臂末端的与预定于路径的偏差在较小的范围之内。图8(e)是一次当障碍物作用于机械臂连杆时3种方法的机械臂末端轨迹对比,其中红色路径为机械臂与障碍物发生碰撞的点。可见基于人工势场的力感知方法没有考虑到机械臂连杆的作用,导致会产生错误的引导信息,使得与障碍物发生碰撞的概率增加。而虚拟力能够正确地引导操作者完成操作任务。

| 表 2 障碍物作用于机械臂连杆避障实验结果 Tab.2 Experimental results of the obstacle approaching the links |

|

Download:

|

| 图 8 | |

与避障实验相似,在精细操作的实验中,目标点的位置和目标姿态不变,而机械臂末端的初始位置和姿态不同。实验在有引导力、无引导力和仅有运动约束3种条件下进行。操作者操作机械臂末端从初始点移动到目标点,并完成姿态的调整。当机械臂末端与目标点的距离小于1 cm且后3个关节旋转角度与目标角度相差小于

| 表 3 目标抓取实验结果 Tab.3 Results of the object grasping experiment |

图9(a)和图9(b)~(d)分别是有力引导、无力引导以及仅运动约束作用下的一次目标抓取操作实验中机械臂末端的轨迹对比和与圆锥轴线的偏差对比。可以看出,相较于在仅有运动约束的协助方法,在锥形力场的引导下操作者能够在实验开始阶段便快速接近圆锥轴线并向目标点接近。表明虚拟引导力的加入能够提高操作者对从端设备的操作效率。同时大幅减轻操作者的操作负担。而相较于无力引导的直接遥操作方法,运动约束的加入能够减小在机械臂末端接近轴线后路径偏差的波动,有效低降低在精细操作时由于人手的生理构造造成的操作偏差。

|

Download:

|

| 图 9 不同协助下的机械臂末端轨迹 Fig. 9 Trajectory and deviation of the end of the manipulator with different assistance | |

本文,主要关注于力反馈遥操作系统中的两个问题:1)在进行避障任务时从端的机械臂应被视为一个整体而非一个等效质点来控制;2)由于人手构造的问题,在进行目标抓取任务时操作者往往难以将机械臂移动到较为精确的位置和姿态。

针对第一个问题我们提出了一个改进方案,基于机械臂和障碍物的位置信息,结合人工势场法和虚拟夹具构建对障碍物的斥力场和管形力场,能够为操作者提供相应的导向力,协助操作者完成机械臂的整体避障任务,接近目标点。对于第二个问题,当机械臂末端需要到达目标点时,构建出基于位置和旋转角的锥形力场来辅助操作者到达目标点并调整姿态。此外,使用了一种输出限制方法以减少操作者在精细操作时的操作失误。最后通过相关的实验验证了该方法能有效提高远程操作的效率,降低操作失误的发生频率。

| [1] |

刘金存. 带电作业机器人主从控制的研究[D]. 济南: 山东建筑大学, 2014. LIU Jincun. Master-slave control research of live working robot[D]. Ji’nan: Shandong Jianzhu University, 2014. (  0) 0)

|

| [2] |

DRAGAN A D, SRINIVASA S S. A policy-blending formalism for shared control[J]. The international journal of robotics research, 2013, 32(7): 790-805. DOI:10.1177/0278364913490324 ( 0) 0)

|

| [3] |

JAVDANI S, ADMONI H, PELLEGRINELLI S, et al. Shared Autonomy via hindsight optimization for teleoperation and teaming[J]. The international journal of robotics research, 2018, 37(7): 717-742. DOI:10.1177/0278364918776060 ( 0) 0)

|

| [4] |

ROSENBERG L B. Virtual fixtures: perceptual tools for telerobotic manipulation[C]//Proceedings of 1993 IEEE Virtual Reality Annual International Symposium. Seattle, WA, USA, 1993: 76−82.

( 0) 0)

|

| [5] |

BU Wanghui, LIU Guangjun, LIU Chengju. Online generation of virtual fixture for bilateral teleoperation based on intention recognition[C]//Proceedings of 2016 International Conference on Advanced Robotics and Mechatronics (ICARM). Macau, China, 2016: 122−126.

( 0) 0)

|

| [6] |

LEE K H, PRUKS V, RYU J H. Development of shared autonomy and virtual guidance generation system for human interactive teleoperation[C]//Proceedings of the 14th International Conference on Ubiquitous Robots and Ambient Intelligence (URAI). Jeju, Korea (South), 2017: 457−461.

( 0) 0)

|

| [7] |

ROZENBLIT J W, FENG C, RIOJAS M, et al. The computer assisted surgical trainer: design, models, and implementation[C]//Proceedings of 2014 Summer Simulation Multiconference. Monterey, USA, 2014: 211−220.

( 0) 0)

|

| [8] |

BALACHANDRAN R, KOZLOVA N, OTT C, et al. Non-linear local force feedback control for haptic interfaces[J]. IFAC-PapersOnLine, 2018, 51(22): 486-492. DOI:10.1016/j.ifacol.2018.11.587 ( 0) 0)

|

| [9] |

NIKOLAIDIS S, ZHU Yuxiang, HSU D, et al. Human-robot mutual adaptation in shared autonomy[C]//Proceedings of the 12th ACM/IEEE International Conference on Human-Robot Interaction (HRI). Vienna, Austria, 2017: 294−302.

( 0) 0)

|

| [10] |

WANG Xinyu, YANG Chenguang, MA Hongbin, et al. Shared control for teleoperation enhanced by autonomous obstacle avoidance of robot manipulator[C]//Proceedings of 2015 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Hamburg, Germany, 2015: 4575−4580.

( 0) 0)

|

| [11] |

HONG M, ROZENBLIT J W. A haptic guidance system for Computer-Assisted Surgical Training using virtual fixtures[C]//Proceedings of 2016 IEEE International Conference on Systems, Man, and Cybernetics (SMC). Budapest, Hungary, 2016: 2230−2235.

( 0) 0)

|

| [12] |

LIU Manlu, LING Qiang, ZHANG Jing, et al, Bilateral control of teleoperation manipulator based on virtual force aware guidance[C]//Proceedings of 2017 IEEE International Conference on Cybernetics and Intelligent Systems (CIS) and IEEE Conference on Robotics, Automation and Mechatronics (RAM). Ningbo, China, 2017: 231−236.

( 0) 0)

|

| [13] |

BOWYER S A, DAVIES B L, BAENA F R. Active constraints/virtual fixtures: a survey[J]. IEEE transactions on robotics, 2014, 30(1): 138-157. DOI:10.1109/TRO.2013.2283410 ( 0) 0)

|

| [14] |

WANG Wenrui, ZHU Mingchao, WANG Xiaoming, et al. An improved artificial potential field method of trajectory planning and obstacle avoidance for redundant manipulators[J]. The international journal of advanced robotic systems, 2018, 15(5). DOI:10.1177/1729881418799562 ( 0) 0)

|

| [15] |

BETTINI A, MARAYONG P, LANG S, et al. Vision-assisted control for manipulation using virtual fixtures[J]. IEEE transactions on robotics, 2004, 20(6): 953-966. DOI:10.1109/TRO.2004.829483 ( 0) 0)

|

| [16] |

MARAYONG P, BETTINI A, OKAMURA A. Effect of virtual fixture compliance on human-machine cooperative manipulation[C]//Proceedings of 2002 IEEE/RSJ International Conference on Intelligent Robots and Systems. Lausanne, Switzerland, 2002: 1089−1095.

( 0) 0)

|

| [17] |

KIM D J, HAZLETT-KNUDSEN R, CULVER-GODFREY H, et al. How autonomy impacts performance and satisfaction: results from a study with spinal cord injured subjects using an assistive robot[J]. IEEE transactions on systems, man, and cybernetics - part A: systems and humans, 2012, 42(1): 2-14. DOI:10.1109/TSMCA.2011.2159589 ( 0) 0)

|

| [18] |

YOU E, HAUSER K. Assisted teleoperation strategies for aggressively controlling a robot arm with 2D input[M]//DURRANT-WHYTE H, ROY N, ABBEEL P. Robotics: Science and Systems VII. Los Angeles: MIT Press, 2012: 354−361.

( 0) 0)

|

2021, Vol. 16

2021, Vol. 16