2. 山东建筑大学 计算机科学与技术学院,山东 济南 250101

2. School of Computer Science and Technology, Shandong Jianzhu University, Ji’nan 250101, China

随着社会的发展,各种司法案件数量也在快速增加。相似案例匹配技术受到了广泛关注,传统匹配工作方式还是司法工作人员筛选大量司法文书,只能根据经验或者主动搜索去匹配对比相关司法案例文书,这些方法往往不能做到面面俱到,所以可能会产生不同的匹配结果,同时成本较大、效率低。因此,现有方法从庞大的司法案例数据集中寻找相似的匹配结果,会耗费巨大的人力物力并且随着司法案件的进一步增多,工作量也会进一步增大。而当前机器学习等人工智能技术的发展为司法案例的匹配提供了可行、高效的技术和手段。把人工智能、大数据等信息处理技术引入司法案例匹配任务不仅可以提升相关司法部门监督执法能力,而且提高了办案效率,更为迈入新型司法发展道路打下基础。

对于司法案例文书的相似性匹配来说,传统的基于关键词匹配技术只能发掘出浅层的语义关系,并不能挖掘出具体司法案例之间的复杂语义匹配信息[1]。此外,传统的方法为了追求精度,通常将案件文书转化为实值表示,然后通过计算实值表示之间的距离来衡量相似度,并判定匹配程度。然而,当待匹配的司法案例文书数据规模较大时,遍历文书库的计算开销也会很大,因此这种方法不适用于大规模的相似案例匹配场景。随着机器学习的发展,机器学习模型越来越多地被用于文本之间的复杂信息进行匹配。近年来,最近邻搜索的代表方法——哈希方法因其低存储、计算效率高等优点引起广泛关注。

哈希方法[2]可以将文档、图像、视频等多媒体转换成一个紧凑的二进制编码,并保留原始数据间的相似性关系。该二进制编码(也称哈希码)间的距离度量使用的是海明距离,其可以通过硬件的异或运算进行快速求解。因此,哈希方法在存储和效率上具有极大的优势。但是,司法相似案例文书在特征空间中总是聚在一起,其映射而成的哈希码碰撞几率很大,难以做到精准识别。因此,针对现有问题,本文提出的方法通过引入三元组损失函数[3]来实现减小类内距离增大类间距离的作用,使得最终学习得到的哈希码更具区分性,提高相似司法文书匹配的准确度。同时,哈希方法因其二值的表示形式,可以大大提升检索的速度,对大规模司法案例数据匹配效率的提升具有较大的价值。

1 相关工作哈希学习模型可以分成两类:无监督方法和监督方法。无监督方法仅使用无标签信息的训练数据来学习哈希码。经典的无监督方法包括:局部敏感哈希(locality-sensitive Hashing,LSH)[4],LSH通过随机映射的方法产生哈希码;谱哈希(spectral Hashing,SH)[5]是把哈希编码的过程看作图分割的问题,利用图割算法生成哈希;基于图的哈希方法(Hashing with graphs,AGH)[6]利用锚点图建立一个易于处理的低秩邻接矩阵来进行哈希学习;迭代量化哈希(iterative quantization,ITQ)[7]首先使用主成分分析进行降维处理,然后学习得到最优旋转矩阵来减少量化损失。

有监督哈希学习方法利用监督信息学习样本数据之间的关系,其性能一般优于无监督的方法。例如,二元重建嵌入方法(binary reconstructive embedding,BRE)[8]通过最小化输入特征距离与相应哈希码距离的重构误差来学习哈希函数;最小损失哈希学习方法(minimal loss Hashing,MLH)[9]通过最小化铰链类损失函数来实现哈希学习;核监督哈希(supervised Hashing with kernels,KSH)[10]是一种基于核函数的监督哈希方法。

随着深度网络的发展,深度学习技术被广泛应用于计算机领域,如图像分类[11-13]、目标检测[14]等。深度学习的思想来源于对人工神经网络的研究,其结构就是包含多个隐含层的多层感知机。最早提出的基于深度学习的哈希方法是语义哈希,该方法首先训练受限玻尔兹曼机,然后通过训练好的模型对数据进行哈希编码。近几年,深度哈希学习算法在图像检索方面取得了很大进展[15-17]。与传统的哈希学习方法不同,深度哈希通过使用深度神经网络来代替线性投影的方法,进而学习二进制编码。例如,深度哈希(deep Hashing,DH)[18]使用深度神经网络获取图像数据的分层非线性变换来学习二进制编码。Yang等[19]提出监督语义保留深度哈希(supervised semantics-preserving deep Hashing,SSDH),该方法通过最小化分类误差的目标函数来训练模型,并且在深度网络隐含层的输出中得到哈希函数。深度学习方法可以很好地提取原始样本深层次特征,哈希学习方法在大规模的数据任务中具备独特的优势,因此深度哈希学习方法成为当前的研究热点。

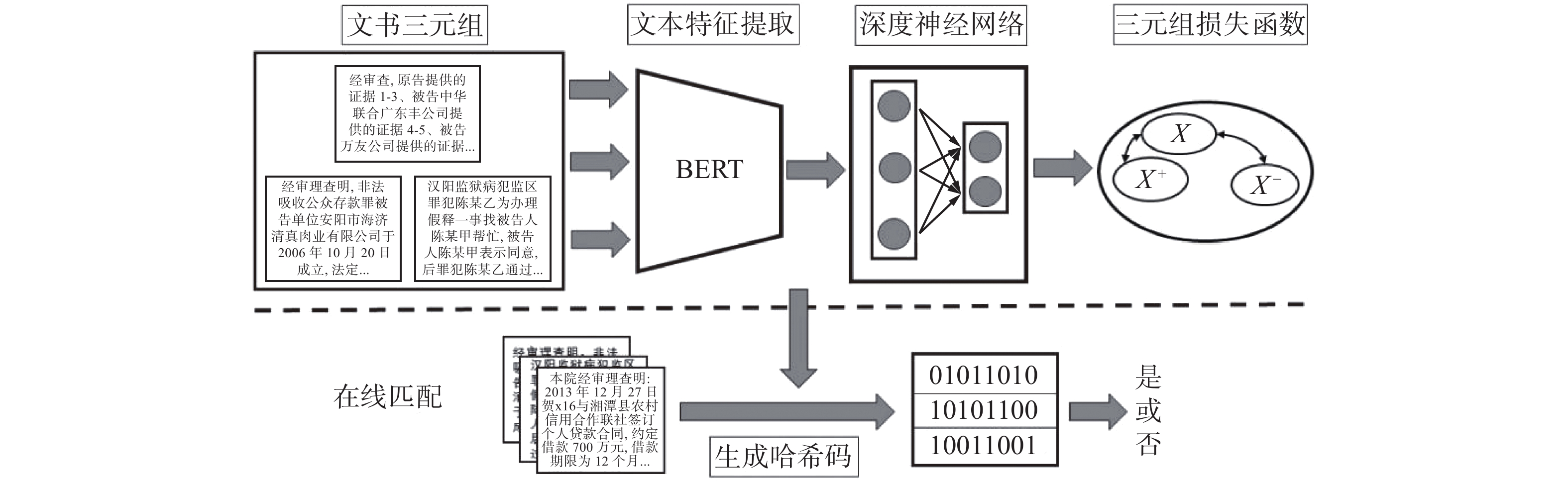

如图1所示,本文提出一种基于三元组深度哈希学习的相似案例匹配方法,将司法案例文书转换成二进制编码形式,不仅解决了存储开销和匹配速度等问题,也很大程度上保留了原始文书之间的相似关系,该方法适用于大规模的相似案例匹配的场景。

|

Download:

|

| 图 1 基于三元组深度哈希的架构 Fig. 1 Architectural overview based on the deep Hashing of triples | |

基于深度哈希学习算法的优良性能,本文提出了一种基于三元组深度哈希的司法相似案例匹配方法。该方法可以有效提升司法案例匹配效率。

假设I是文本空间,哈希学习的目标是得到一个映射

目前研究者通常采用向量空间模型来描述文本向量,但是如果直接用分词算法和词频统计方法得到的特征项来表示文本向量中的各个维,那么这个向量的维度将是非常的大。这种未经处理的文本矢量不仅给后续工作带来巨大的计算开销,使得整个处理过程的效率非常低,同时也会损害分类、聚类算法的精确性。因此,为提升特征表示的精度和效率,需要对文本向量做进一步净化处理,在保证原文含义的基础上,寻找对文本特征类别最具代表性的特征表示。解决这一问题最有效的办法就是通过特征来选择降维。本文使用中文自然语言处理模型BERT[20]进行司法案例文书的特征表示。在保留文书语义的前提下,尽可能地降低文书的文字数量,以便于降低文书特征表示的维度。

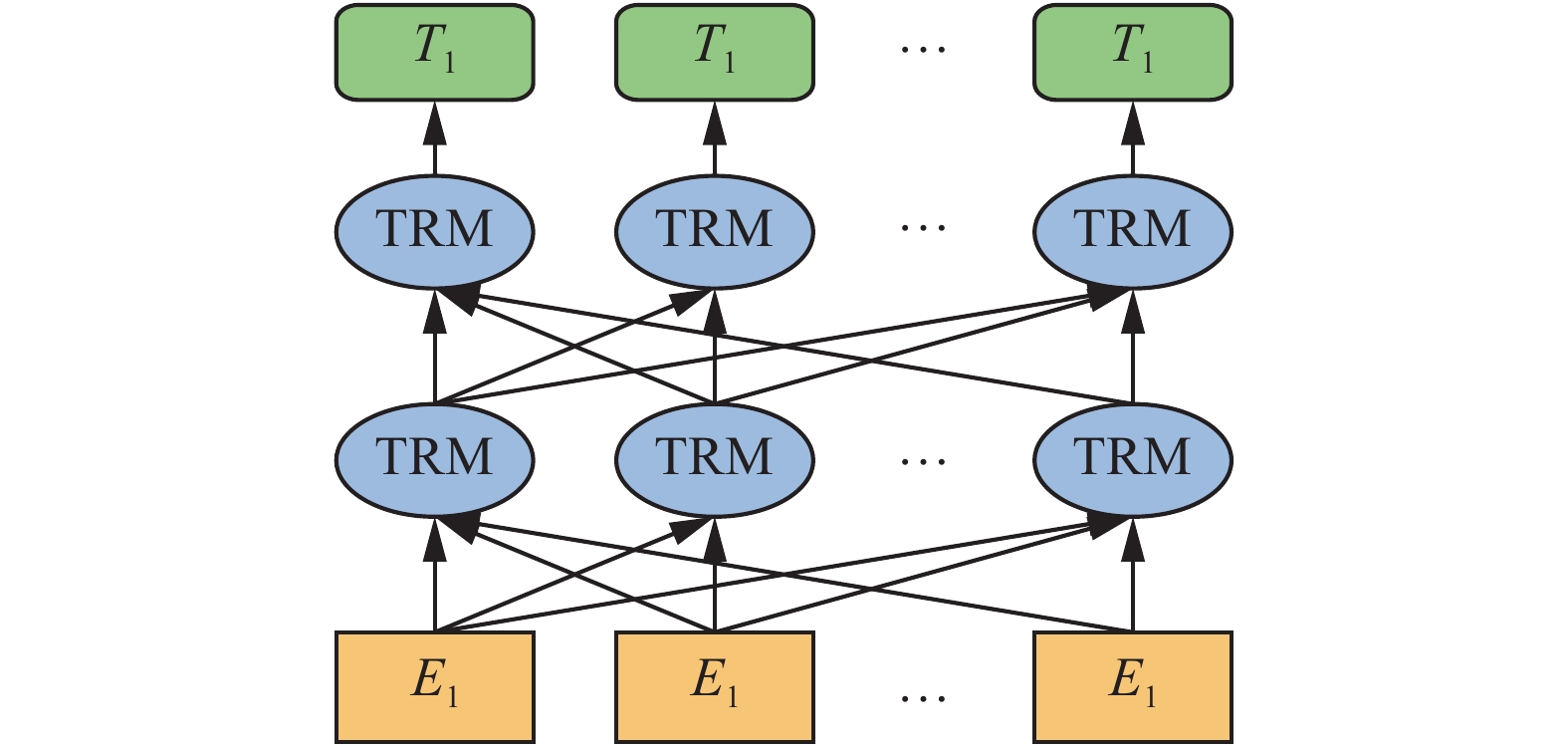

BERT模型的目标是利用大规模无标注语料训练获得包含丰富语义信息的文本特征。BERT模型的主要输入是文本中各个字/词的原始词向量,该向量既可以随机初始化,也可以利用Word2Vector[21]等算法进行预训练作为初始值;模型输出是文本中各个字/词融合了全文语义信息后的向量表示,BERT模型如图2所示。

|

Download:

|

| 图 2 BERT模型示意 Fig. 2 Schematic diagram of BERT | |

对于数据集中的司法案例文书,本文首先利用文本预处理手段去除掉数字、标点符号、没有实际意义的虚词等文字;然后,将文书按1024个汉字为一组,输入到预训练好的BERT中文模型中,得到768维的向量表示。重复此步骤,直到得到文书各组的特征表示,并将其拼接成完整的特征表示。特别地,对于不够1024个汉字的文书片段,用数字0补齐。

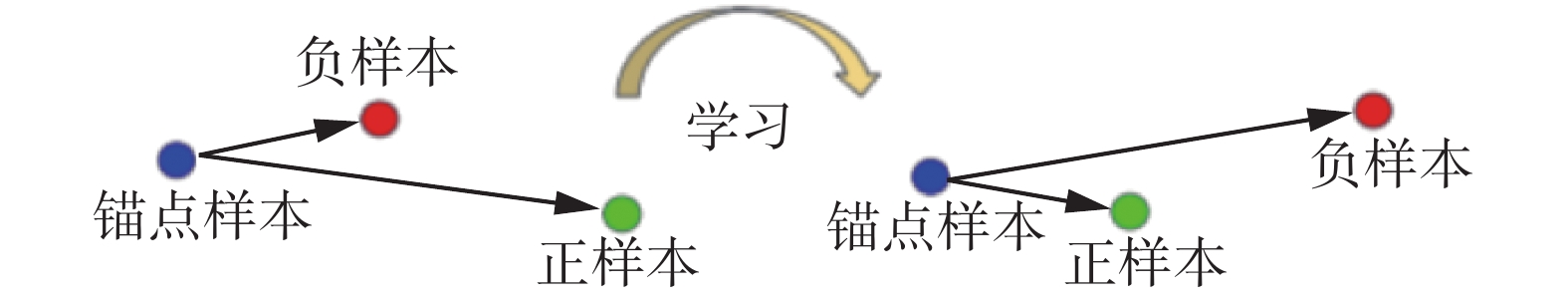

2.2 基于三元组文书相似度的损失函数在现有的监督哈希方法中,辅助信息多采用成对类标签的形式,用来表示样本对的语义相似或者不相似。这些方法中的损失函数通过成对类标信息来建立,但这种处理方式只有成对样本之间相似性的精确数值,缺乏了更丰富的语义信息。为了解决上述问题,基于三元组的类标信息被提出来[20]。与成对类标信息不同,三元组类标信息描述3个样本之间的相互关系。如图3所示,一个三元组包含一个锚点样本、一个正样本和一个负样本,并且锚点样本与正样本的相似度大于锚点样本与负样本的相似度。基于三元组的类标信息比成对类标信息更容易获得,并且对于给出的成对相似的辅助信息,很容易地生成一组三元约束。

|

Download:

|

| 图 3 三元组关系示意 Fig. 3 Diagram of triple relationship | |

本文提出的方法使用三元排序损失[21]的变体来保持样本的相对相似性。具体地,给定

| $\begin{array}{c} {L_{{\rm{triplet}}}}(F(I),F({I^ + }),F({I^ - })) = \\ \max (0,{\left\| {F(I) - F({I^ + })} \right\|_2} - {\left\| {F(I) - F({I^ - })} \right\|_2} + g) \\ {\rm{s}}{\rm{.t}}{\rm{.}}\;\;F(I),F({I^ + }),F({I^ - }) \in {\left[ {0,1} \right]^q} \end{array} $ | (1) |

式中:g是度量匹配文书对与不匹配文书对之间距离的阈值参数,本文使用多个阈值进行了实验,在这里取g=0.5。对于给定的三元组

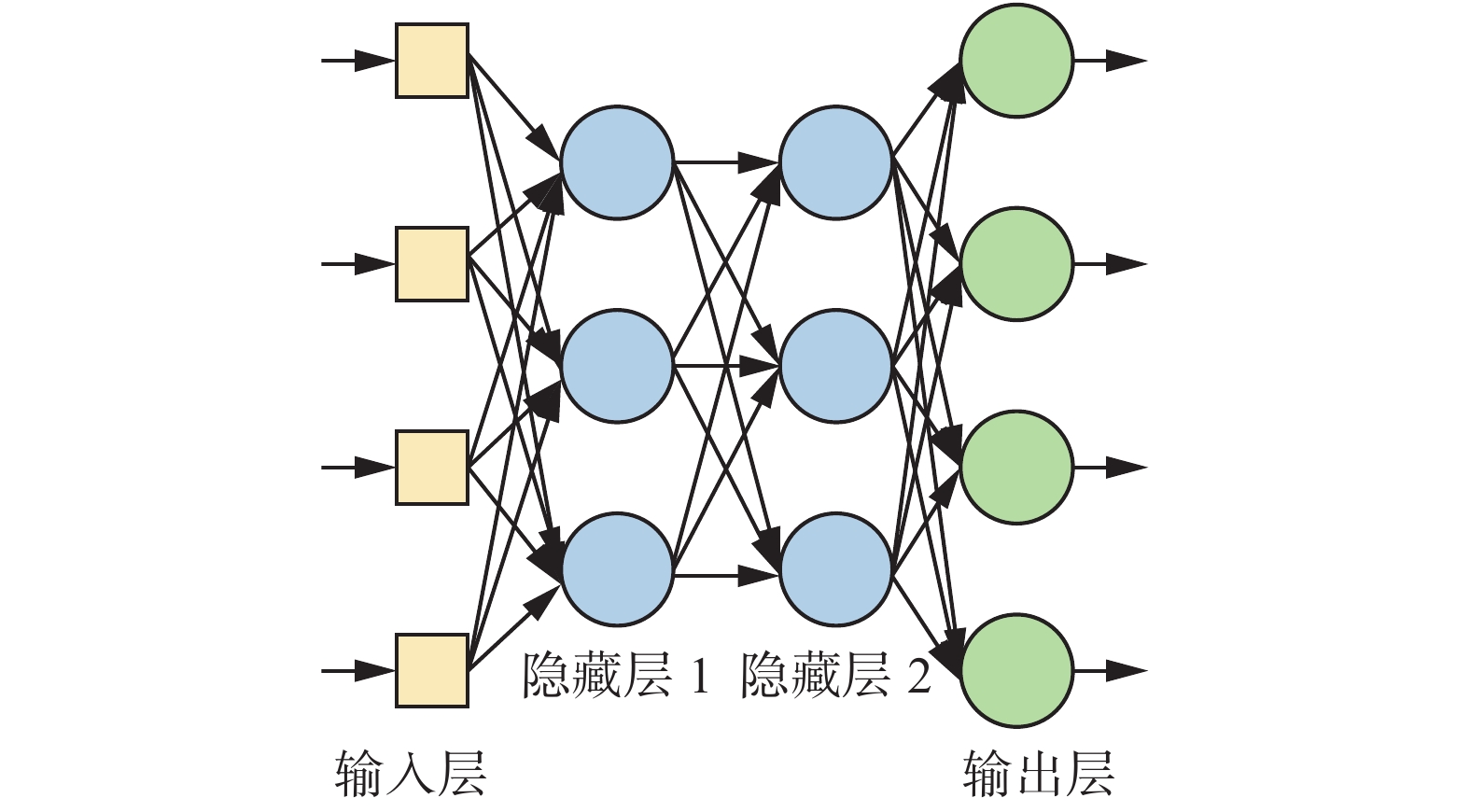

在此模块中,用自然语言处理模型BERT提取的文书特征表示作为输入,利用深度神经网络学习一个从文书特征到海明空间哈希码的非线性映射,用于生成未知文书的哈希表示[22]。特别地,采用式(2)所示的损失函数构建哈希学习模型:

| $\begin{array}{c} {L_{{\rm{triplet}}}}(F(I),F({I^ + }),F({I^ - })) = \\ \max (0,{\left\| {F(I) - F({I^ + })} \right\|_2} - {\left\| {F(I) - F({I^ - })} \right\|_2} + {\rm{0}}.5) \\ {\rm{ s}}{\rm{.t}}{\rm{.}}\quad F(I),F({I^ + }),F({I^ - }) \in {\left( {0,1} \right)^k} \end{array} $ | (2) |

式中:

|

Download:

|

| 图 4 深度神经网络模型 Fig. 4 Depth neural network model | |

第一个隐含层采用Relu激活函数,与传统的S型激活函数相比,Relu函数能够有效缓解梯度消失问题而且收敛速度快,其在深度神经网络中的使用加速了深度网络的直接监督式训练的突破。它的函数表达式为

| $f(x) = \max (0,x)$ | (3) |

第二个隐含层采用Sigmoid激活函数,将输出映射到0与1之间。Sigmoid函数公式为

| $f(x) = \frac{1}{{1 + {{\rm{e}}^{ - x}}}}$ | (4) |

对于神经网络的优化训练,本文采用随机梯度下降法来实现。梯度下降法是为了找到最优的权重参数,最小化损失函数。通过对损失函数求导得到梯度方向,梯度下降的公式为

| $\theta = \theta - \eta \frac{{{\rm{d}}J(\theta )}}{{{\rm{d}}\theta }}$ | (5) |

式中:

基于预训练的BERT模型与三元组深度学习模型,生成文书的哈希表示,进而根据哈希码计算海明距离来进行相似性匹配,相关步骤如图5所示。

|

Download:

|

| 图 5 相似司法案例文本匹配框架 Fig. 5 Framework of similar judicial matching | |

具体地,给定新的文书,首先,进行特征提取,采用文本预处理方式,对文书内容进行缩减,然后按1024汉字长度进行分组,并分别将每组汉字输入到预训练的BERT中文模型;然后将每组汉字的特征表示做融合拼接,得到文书的特征表示。其次,将文书的特征表示输入到预训练的哈希学习深度神经网络,得到文书的实数表示。进一步,采用0.5的阈值将实数表示二值化,即大于0.5的转化为1,小于0.5的转化为0。最后,一个汉字的文书转化为了长度为K的哈希码。在做文书匹配时,采用哈希距离的大小来衡量两个文书的相似度。算法的实现步骤:

1)初始化算法的基本参数:深度神经网络参数

2)对于输入的案例文书数据集

3)对于每一个案例文书三元组,根据式(2)计算锚点样本与正负样本间距离,最小化损失函数;

4)使用SGD随机梯度下降算法更新参数

5)重复2)、3),直至循环次数达到最大迭代次数;

6)在深度神经网络中输入测试案例数据集,计算出测试集哈希码:

7)根据汉明距离计算两个文书的相似度,输出匹配结果。

3 实验与结果 3.1 度量标准该实验采用匹配准确度进行度量[23],准确率公式定义为

| $A = \frac{{p + t}}{n}$ | (6) |

式中:

本文将在“中国裁判文书网”公开的司法文书数据集上检验方法的性能。首先概要介绍一下实验中用到的数据集。

此数据集中每份数据由三篇司法案例文书组成,对于每篇文书,根据提供的事实描述。对于每份数据,本文用

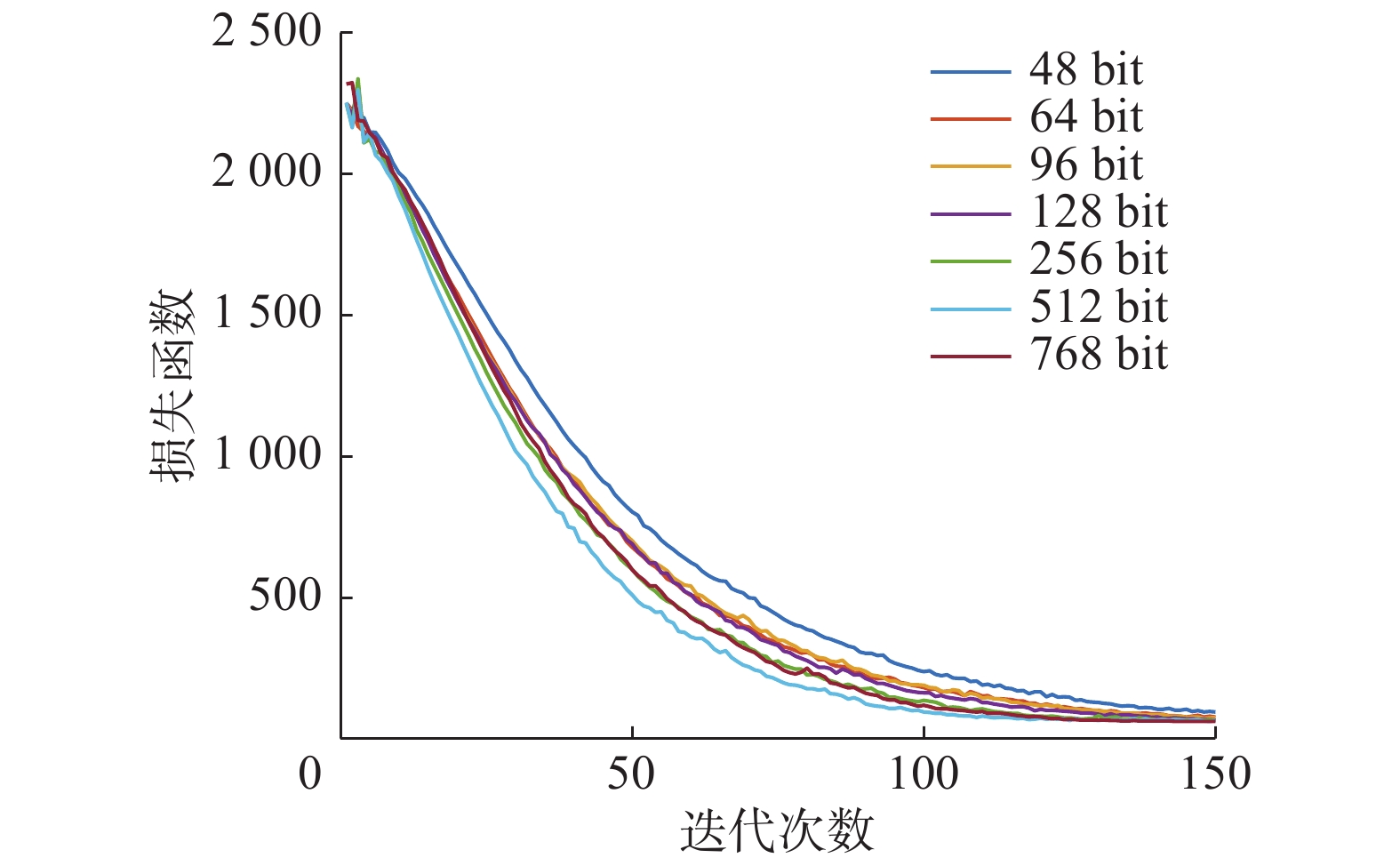

本文在公开的司法文书数据集上进行了实验以检验算法的性能,分别使用48、64、96、128、256、512、768 bit哈希码进行实验,并将本文的方法与SH[5]、PCA-ITQ[24]、PCA-RR[24]、MFH[25]等哈希学习方法进行比较,实验结果如表1所示。表1为数据集在不同编码位数下,不同方法案例匹配的准确率。由表1可以看出,本文的方法具有较高的准确度。

| 表 1 本文方法与其他算法准确度比较 Tab.1 Accuracy comparison between the method and other algorithms |

本文方法采用预训练的BERT中文模型与哈希学习的三元组深度神经网络模型,解决了传统相似司法案例文书匹配存储开销大、效率低等问题。该方法在不同哈希编码的位数下的准确率均高于其他方法,证实了本文算法的有效性和优越性。

本文对算法的收敛性进行了实验,实验结果如图6所示。由图6可以看出,在不同的哈希编码位数下,目标函数均具备良好的收敛性。

|

Download:

|

| 图 6 不同哈希编码位数的目标函数收敛情况 Fig. 6 Convergence of the objective function for different bits of the Hashing code | |

本文提出了一种基于三元组深度哈希的司法案例相似性匹配方法。该方法主要思路是通过三元组损失函数来训练深度神经网络,使得最终得到的哈希码保留文书样本原有的相似关系,并且具备相同语义数据之间的距离尽可能小,不同语义数据之间的距离尽可能大的特点。该方法采用哈希学习技术极大地降低了文书表示的存储开销,提高了相似案例匹配的速度,适用于大规模的相似案例匹配的场景。

本文的主要贡献如下:

1)本文提出了一种基于三元组深度哈希学习的相似案例匹配方法,通过将司法案件文书转化为哈希码来进行快速相似度匹配。该方法在得到文书的特征表示的基础上建立基于三元组文书相似度的损失函数项,并利用深度神经网络生成未知文书的哈希表示,利用哈希码进行相似性匹配,提高了匹配效率。

2)使用中文自然语言处理模型BERT提取文书的特征表示。在保留文书语义的前提下,尽可能地降低文书的文字数量,以便于降低压缩文书特征表示的维度。

3)应用公开的法律文书数据集的实验结果表明本文提出的相似案例匹配算法提高了相似案例匹配的速度和准确度,适用于大规模的相似案例匹配的场景。

实验结果表明,本文提出的相似案例匹配方法在准确率和效率方面优于已有方法。

| [1] |

贾君枝, 毛海飞. 基于法律框架网络本体的语义匹配技术研究[J]. 情报理论与实践, 2008, 31(1): 124-128. JIA Junzhi, MAO Haifei. Research on the semantic matching technology based on the Chinese legal framenet ontology[J]. Information studies: theory & application, 2008, 31(1): 124-128. (  0) 0)

|

| [2] |

INDYK P, MOTWANI R. Approximate nearest neighbors: towards removing the curse of dimensionality[C]//Proceedings of the 30th Annual ACM Symposium on Theory of Computing. Dallas, USA, 1998: 604−613.

( 0) 0)

|

| [3] |

LAI Hanjiang, PAN Yan, LIU Ye, et al. Simultaneous feature learning and hash coding with deep neural networks[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA, 2015: 3270−3278.

( 0) 0)

|

| [4] |

GIONIS A, INDYK P, MOTWANI R. Similarity search in high dimensions via hashing[C]//Proceedings of the 25th International Conference on Very Large Data Bases. Edinburgh, Scotland, 1999: 518−529.

( 0) 0)

|

| [5] |

WEISS Y, TORRALBA A, FERGUS R. Spectral hashing[C]//Proceedings of the 21st International Conference on Neural Information Processing Systems. Vancouver, Canada, 2008: 1753−1760.

( 0) 0)

|

| [6] |

LIU Wei, WANG Jun, KUMAR S, et al. Hashing with graphs[C]//Proceedings of the 28th International Conference on Machine Learning. Bellevue, USA, 2011: 1−8.

( 0) 0)

|

| [7] |

GONG Yunchao, LAZEBNIK S, GORDO A, et al. Iterative quantization: a procrustean approach to learning binary codes for large-scale image retrieval[J]. IEEE transactions on pattern analysis and machine intelligence, 2013, 35(12): 2916-2929. DOI:10.1109/TPAMI.2012.193 ( 0) 0)

|

| [8] |

KULIS B, DARRELL T. Learning to hash with binary reconstructive embeddings[C]//Proceedings of the 22nd International Conference on Neural Information Processing Systems. Vancouver, Canada, 2009: 1042−1050.

( 0) 0)

|

| [9] |

NOROUZI M, FLEET D J. Minimal loss hashing for compact binary codes[C]//Proceedings of the 28th International Conference on International Conference on Machine Learning. Bellevue, USA, 2011: 353−360.

( 0) 0)

|

| [10] |

LIU Wei, WANG Jun, JI Rongrong, et al. Supervised hashing with kernels[C]//Proceedings of 2012 IEEE Conference on Computer Vision and Pattern Recognition. Providence, USA, 2012: 2074−2081.

( 0) 0)

|

| [11] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe, USA, 2012: 1097−1105.

( 0) 0)

|

| [12] |

SZEGEDY C, LIU Wei, JIA Yangqing, et al. Going deeper with convolutions[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA, 2015: 1−9.

( 0) 0)

|

| [13] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Delving deep into rectifiers: surpassing human-level performance on ImageNet classification[C]//Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile, 2015: 1026−1034.

( 0) 0)

|

| [14] |

SZEGEDY C, TOSHEV A, ERHAN D. Deep neural networks for object detection[C]//Proceedings of the 26th International Conference on Neural Information Processing Systems. Lake Tahoe, Nevada, USA, 2013: 2553−2561.

( 0) 0)

|

| [15] |

LIN K, YANG H F, HSIAO J H, et al. Deep learning of binary hash codes for fast image retrieval[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Boston, USA, 2015: 27−35.

( 0) 0)

|

| [16] |

XIA Rongkai, PAN Yan, LAI Hanjiang, et al. Supervised hashing for image retrieval via image representation learning[C]//Proceedings of the 28th AAAI Conference on Artificial Intelligence. Québec City, Québec, Canada, 2014: 2156−2162.

( 0) 0)

|

| [17] |

李泗兰, 郭雅. 基于深度学习哈希算法的快速图像检索研究[J]. 计算机与数字工程, 2019, 47(12): 3187-3192. LI Silan, GUO Ya. Fast image retrieval based on hash algorithm in depth learning[J]. Computer and digital engineering, 2019, 47(12): 3187-3192. (  0) 0)

|

| [18] |

LIONG V E, LU Jiwen, WANG Gang, et al. Deep hashing for compact binary codes learning[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA, 2015: 2475−2483.

( 0) 0)

|

| [19] |

YANG H F, LIN K, CHEN Chusong. Supervised learning of semantics-preserving hashing via deep neural networks for large-scale image search[J]. Computer Science, 2015, 10(12): 131−138.

( 0) 0)

|

| [20] |

DEVLIN J, CHANG Mingwei, LEE K, et al. BERT: pre-training of deep bidirectional transformers for language understanding[C]//Proceedings of 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Minneapolis, USA, 2019: 4171−4186.

( 0) 0)

|

| [21] |

汪静, 罗浪, 王德强. 基于Word2Vec的中文短文本分类问题研究[J]. 计算机系统应用, 2018, 27(5): 209-215. WANG Jing, LUO Lang, WANG Deqiang. Research on Chinese short text classification based on Word2Vec[J]. Computer systems & applications, 2018, 27(5): 209-215. (  0) 0)

|

| [22] |

LI Xi, LIN Guosheng, SHEN Chunhua, et al. Learning hash functions using column generation[C]//Proceeding of the 30th International Conference on Machine Learning, 2013: 142−150.

( 0) 0)

|

| [23] |

NOROUZI M, FLEET D J, SALAKHUTDINOV R. Hamming distance metric learning[C]//Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe, USA, 2012: 1061−1069.

( 0) 0)

|

| [24] |

GONG Yunchao, LAZEBNIK S. Iterative quantization: a procrustean approach to learning binary codes[C]//Proceedings of CVPR 2011. Providence, USA, 2011: 817−824.

( 0) 0)

|

| [25] |

SONG Jingkun, YANG Yi, HUANG Zi, et al. Effective multiple feature hashing for large-scale near-duplicate video retrieval[J]. IEEE transactions on multimedia, 2013, 15(8): 1997-2008. DOI:10.1109/TMM.2013.2271746 ( 0) 0)

|

2020, Vol. 15

2020, Vol. 15