2. 河北师范大学 数学科学学院,河北 石家庄 050024

2. College of Mathematics and Information Science, Hebei Normal University, Shijiazhuang 050024, China

概念格理论[1]是在形式背景中进行数据分析的一个重要工具,由Wille教授在1982年提出,从本质上描述了对象集和属性集的内在联系。

目前,概念格理论已在信息检索[2-4]、数据挖掘[5-7]、机器学习[8-10]等领域取得了广泛应用。吴伟志等[11]将粒计算与概念格理论进行结合,研究了保持概念格的粒结构不变的属性约简。米据生等分别从变精度[12]和公理化[13]角度考虑概念格约简问题。针对大型数据集,陈锦坤等[14-15]将图论理论与概念格理论进行结合,提出了一种快速属性约简方法。邵明文等[16]从形式概念分析理论角度提出一种从信息表中提取决策规则的方法。李金海等[17-18]针对决策形式背景提出了一种新的知识认知和约简框架,并给出约简算法,进一步提出了保持由全体对象集构造的决策规则不变的情况下的属性约简方法[19]。三支形式概念分析[20]的提出丰富了概念格理论,魏玲和任睿思进一步研究了三支概念格的属性约简[21]与决策规则提取[22]。李俊余等[23]研究了基于同余关系的不协调决策形式背景的属性约简。

如何简化概念格结构,从而便于提取用户所需信息是该领域的一个重要问题。上述研究中,往往默认形式背景中所有属性重要度是相同的,然而在实际问题中,可能仅需针对特定属性进行数据挖掘,即不同属性的重要性是不同的。张继福等[24]通过对概念格的内涵引入权值,提出一种加权概念格,拓广了概念格的结构。张素兰等[25]在此基础上提出了一种基于信息熵和偏差分析的加权概念格的内涵权重获取方法。但上述两种加权概念格并没有考虑到对象权重的问题。

概念格需储存由形式背景获取的全部概念及属性间的偏序关系,使概念格构造过程变得异常困难。同时随着大数据时代的到来,需要分析的数据越来越多,如果想要将其中所有概念提取出来,并根据概念间的偏序关系构成概念格,难度进一步加大。因此,如何删除无用的属性和对象,降低构造概念格的难度,使提取的规则更加简洁就成为我们应该考虑的重要问题。本文通过信息熵给出单个属性权重后,进一步给出对象权重和重要度偏差的定义,利用3个阈值对冗余数据进行删除,缩小了概念格的规模,提高了构造概念格的时间效率,并且能够让决策规则的提取过程更为简洁高效。

1 预备知识首先简单介绍形式背景中的相关知识。

定义1 设

| $f(X) = \{ a \in A:{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} \forall x \in X,{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} (x,a) \in I\} $ |

| $g(B) = \{ x \in U:{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} \forall a \in B,{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} (x,a) \in I\}。$ |

定义2 设

定义 3 设

定义4 设

| $({X_{\rm{1}}},{B_{\rm{1}}}) \leqslant ({X_2},{B_2})$ |

另外,两个概念的上下确界定义分别为

| $({X_{\rm{1}}},{B_{\rm{1}}}) \vee ({X_{\rm{2}}},{B_{\rm{2}}}){\kern 1pt} = (g{\kern 1pt} f({X_{\rm{1}}} \cup {X_{\rm{2}}}{\rm{), }}{B_{\rm{1}}} \cap {B_{\rm{2}}})$ |

| $({X_{\rm{1}}},{B_{\rm{1}}}) \wedge ({X_{\rm{2}}},{B_{\rm{2}}}){\kern 1pt} = ({X_{\rm{1}}} \cap {X_{\rm{2}}}{\rm{, }}fg({B_{\rm{1}}} \cup {B_{\rm{2}}}))$ |

定义5 设

| $H(a) = - \sum\limits_{i = 1}^{{n}} {P(a/{x_i})} {\log _2}P(a/{x_i})$ |

信息熵值越大,表示对象集

定义6 设

| $d(x) = \frac{{\displaystyle\sum\limits_{j = 1}^t {w{\kern 1pt} {\kern 1pt} {\kern 1pt} ({a_{{s_j}}})} }}{t}$ |

通过定义6获取的对象权重能够反映该对象的总体信息量,但是却忽略了该结果可能存在偏差,不利于获得具有一定偏差的信息。

定义7 对象

| $D(x) = \sqrt {\frac{1}{{t - 1}}\sum\limits_{j = 1}^t {{{(w{\kern 1pt} {\kern 1pt} ({a_{{s_j}}}) - d(x))}^2}} } $ |

由重要度偏差定义,特规定当

通过定义对象权重和对象重要度偏差能够更全面地考虑形式背景中隐含的知识。

2.2 对象加权概念格及其构造在无专家给定属性权重时,需通过信息熵公式求出属性对应的信息量,再进行归一化处理获得每个属性的权重。按照对象对于属性是否感兴趣,给出属性权重阈值为

设对象重要度偏差阈值为

通过删除不满足给定的属性权重阈值

算法1 对象强加权概念格的构造算法

输入

输出 对象强加权概念格。

1) for

2)

3) end for

4) initialize

5) for

6) if

7)

8) end if

9) compute

10)

11) end for

12) if

13) delete

14) end if

15)

16) return

通过2.2节中给出的对象强加权概念格的构造过程,能够帮助我们获取更为简单的概念格。如在决策形式背景中,利用该方法对于条件概念格进行简化,则能够大大降低概念提取的难度。

定义8 设

| $U/{R_D} = \{ {[x]_D}:\!\!\!\!\!{\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} {\kern 1pt} x \in U\} {\rm{ = \{ }}{D_1}{\rm{,}}{D_2}, \cdots ,{D_r}{\rm{\} }}$ |

其中:

设

下面给出具体算法。

算法2 粒决策规则获取算法

输入

输出 粒决策规则

1) compute

2)

3) for

4) if

5)

6) end if

7)

8) end for

9) compute

10) for all

11) if

12)

13) end if

3 实验和分析 3.1 应用举例由表1给出人才市场大学生就业信息,处理后构成形式背景

| 表 1 形式背景

|

1)直接构造概念格

由表1给出的形式背景直接构造的概念格如图1所示,共12个概念结点。

|

Download:

|

|

图 1 由F=( U,A,I )构造的概念格

Fig. 1 Concept lattice of

|

|

2)对象加权概念格

给定

| ${H_{\rm{1}}}(a) = - {P_{\rm{1}}}(a) \times {\log _2}{P_{\rm{1}}}(a) = {\kern 1pt} = - \frac{5}{6} \times {\log _2}\frac{5}{6} = 0.219\;2$ |

由计算可知:

| $H(A) = {H_{\rm{1}}}(a) + {H_{\rm{1}}}(b) + {H_{\rm{1}}}(c) + {H_{\rm{1}}}(d) + {H_{\rm{1}}}(e) = {\rm{2}}{\rm{.068\;2}}。$ |

可获得各属性权重,分别为:

对于对象1来说,

| ${d_{\rm{1}}}(1) = \frac{{{w_{\rm{1}}}(a){\rm{ + }}{w_{\rm{1}}}(b)}}{2} = 0.{\rm{15}}$ |

| $ {d_{\rm{1}}}(2) = \frac{{{w_{\rm{1}}}(a){\rm{ + }}{w_{\rm{1}}}(d){\rm{ + }}{w_{\rm{1}}}(e)}}{{\rm{3}}} = 0.2 $ |

| $ {d_{\rm{1}}}({\rm{3}}) = \frac{{{w_{\rm{1}}}(a){\rm{ + }}{w_{\rm{1}}}(b) + {w_{\rm{1}}}(c){\rm{ + }}{w_{\rm{1}}}(e)}}{{\rm{4}}} = 0.1{\rm{87\;5}} $ |

| ${d_{\rm{1}}}({\rm{5}}) = \frac{{{w_{\rm{1}}}(b){\rm{ + }}{w_{\rm{1}}}(e)}}{2} = 0.{\rm{215}}$ |

| ${d_{\rm{1}}}({\rm{6}}) = \frac{{{w_{\rm{1}}}(a){\rm{ + }}{w_{\rm{1}}}(b) + {w_{\rm{1}}}(d)}}{{\rm{3}}} = 0.183\;{\rm{3}}。$ |

则可获得子形式背景

| 表 2 形式背景

|

由表2给出的形式背景构造的概念格如图2所示,共9个概念结点,即为对象加权概念格。

|

Download:

|

|

图 2 由

|

|

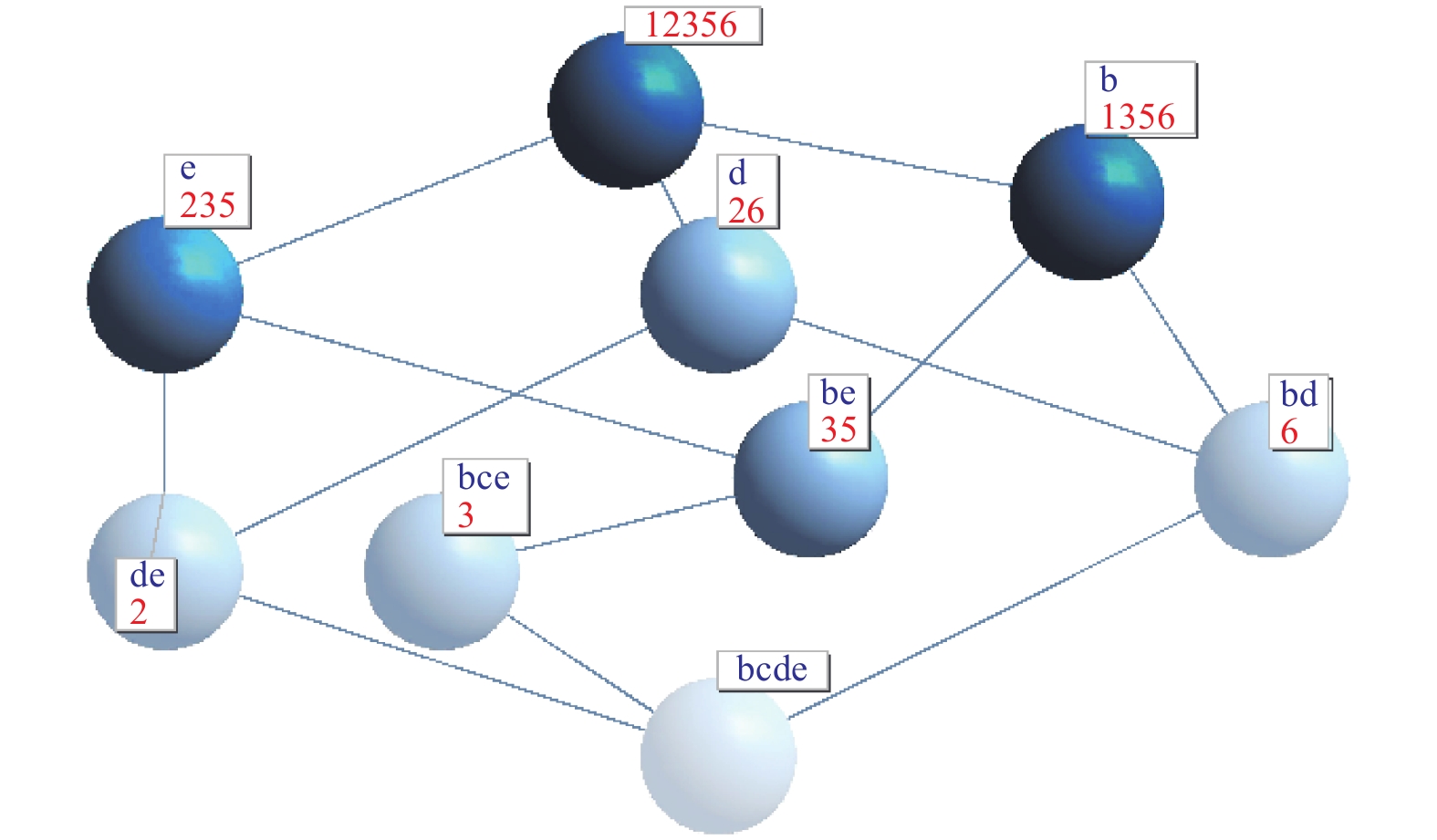

3)对象强加权概念格

给定

| ${D_{\rm{1}}}({\rm{1}}) = \sqrt {{{({w_{\rm{1}}}(a) - {d_{\rm{1}}}({\rm{1}}))}^2} + {{({w_{\rm{1}}}(b) - {d_{\rm{1}}}({\rm{1}}))}^2}} {\rm{ = 0}}{\rm{.057}}$ |

| ${D_{\rm{1}}}({\rm{2}}) = \sqrt {\frac{{{{({w_{\rm{1}}}(a) - {d_{\rm{1}}}({\rm{2}}))}^2} + {{({w_{\rm{1}}}(d) - {d_{\rm{1}}}({\rm{2}}))}^2} + {{({w_{\rm{1}}}(e) - {d_{\rm{1}}}({\rm{2}}))}^2}}}{{{\rm{3}} - 1}}} {\rm{ = 0}}{\rm{.078}}$ |

由于

| ${D_{\rm{1}}}({\rm{3}}) = \sqrt {\frac{{{{({w_{\rm{1}}}(a) - {d_{\rm{1}}}({\rm{3}}))}^2} + {{({w_{\rm{1}}}(b) - {d_{\rm{1}}}({\rm{3}}))}^2} + {{({w_{\rm{1}}}(c) - {d_{\rm{1}}}({\rm{3}}))}^2} + {{({w_{\rm{1}}}(e) - {d_{\rm{1}}}({\rm{3}}))}^2}}}{{{\rm{4}} - 1}}} {\rm{ = 0}}{\rm{.056}}。$ |

| ${D_{\rm{1}}}({\rm{5}}) = \sqrt {{{({w_{\rm{1}}}(b) - {d_{\rm{1}}}({\rm{5}}))}^2} + {{({w_{\rm{1}}}(e) - {d_{\rm{1}}}({\rm{5}}))}^2}} {\rm{ = 0}}{\rm{.035}}。$ |

| ${D_{\rm{1}}}({\rm{6}}) = \sqrt {\frac{{{{({w_{\rm{1}}}(a) - {d_{\rm{1}}}({\rm{6}}))}^2} + {{({w_{\rm{1}}}(b) - d({\rm{6}}))}^2} + {{({w_{\rm{1}}}(d) - {d_{\rm{1}}}({\rm{6}}))}^2}}}{{{\rm{3}} - 1}}} {\rm{ = 0}}{\rm{.07}}。$ |

则可获得子形式背景

| 表 3 形式背景

|

表3给出的形式背景构造的概念格如图3所示,共5个概念结点,即为对象强加权概念格。

|

Download:

|

|

图 3 由

|

|

通过上述计算能够看到本文提出的对象强加权概念格能够通过删除不必要的对象和属性,缩小形式背景的规模,从而实现简化概念格构造过程的目的。且通过这种方法能够简化概念形式,便于我们在之后进行规则提取。

4)粒决策规则提取

在表1的基础上给出决策形式背景

| 表 4 决策形式背景

|

由表4可知

由上述计算过程可直接获取

由算法2可获得粒决策规则:

| $\{ b,e\} \Rightarrow \{ 1\} $ |

| $\{ b,c,e\} \Rightarrow \{ 1\} $ |

| $\{ b,d\} \Rightarrow \{ 0\} $ |

可进一步简化规则得:

| $\{ b,e\} \Rightarrow \{ 1\} $ |

| $\{ b,d\} \Rightarrow \{ 0\} $ |

通过本文算法对于概念格进行简化后提取规则,可知本岗位更倾向于招聘数学专业且拥有教师资格证的应聘者,与现实背景相符。

对于没有删除冗余属性、冗余对象、偏差对象的情况,也即直接用表2所示的决策形式背景获取条件概念格,然后利用算法2获取粒决策规则,结果如下:

| $\{ a,d\} \Rightarrow \{ 0\} $ |

| $\{ b,e\} \Rightarrow \{ 1\} $ |

| $\{ a,d,e\} \Rightarrow \{ 0\} $ |

| $\{ a,b,d\} \Rightarrow \{ 0\} $ |

| $\{ a,b,c,e\} \Rightarrow \{ 1\} $ |

进一步简化规则可得

| $\{ a,d\} \Rightarrow \{ 0\} $ |

| $\{ b,e\} \Rightarrow \{ 1\} $ |

可知本岗位更倾向于招聘拥有教师资格证的数学专业的应聘者,这也是符合实际情况的。可见,通过本文构造的对象强加权概念格仍能够保持原决策规则的关键信息,即教育机构更愿意录取数学专业有教师资格证的应聘者,而且能够简化规则获取的过程。

3.2 实验分析在内存为 8 GB,操作系统为 Windows 10 的计算机上,用Matlab软件实现了本文算法、经典概念格构造算法及文献[25]的算法。选用UCI数据集中的ZOO数据集进行实验,该数据集共有101条记录, 18项属性。对数据集的预处理,包括去掉决策属性,将数值属性布尔化等,最后获取了共100条记录, 20项属性的形式背景,以20条动物记录为单位将其划分为5个子形式背景。将子形式背景依次进行合并,分别采用本文算法、经典算法及文献[25]的算法构造合并后的整体概念格,对比其分别获取的概念结点个数,以此对比其执行效率,具体如表5所示。

| 表 5 3种算法执行效率对比 Tab.5 Comparison of the execution efficiencies of the three algorithms |

由实验结果可知,记录数逐渐增多,概念结点也会随之递增。由于经典算法在构造概念格的过程不会删除任何信息,因此该算法会获得最多的概念结点,同样会导致构造时间最长,执行效率最低。而文献[25]中的算法虽然减少了19.4%的冗余结点,但其构造的概念格规模仍然较为复杂。本文算法相较于经典算法减少了66%的冗余结点,相较于文献[25]中的算法减少了59.2%的冗余结点,极大缩短了构造概念格的时间,提升了概念格的构造效率,有利于提取用户关心的知识信息。

4 结束语删除冗余概念,提升概念格构造效率是概念格理论的重要问题。本文通过信息熵获取了形式背景中数据隐含的属性权重,利用属性权重给出了对象权重及对象重要度偏差,并进一步给出满足阈值要求的对象强加权概念格的构造算法。本文的方法能够有效避免产生冗余概念,获得结构更简单的概念格,同时也能够进一步简化规则获取过程。

但本文仍有许多不足,比如在给出对象权重时采取的是均值法,把对象具有的属性作为个体去考虑,并没有将考虑对象具有的属性作为一个整体具有的特征。而且本文对于2.3节中给出的决策规则时仅从条件属性集角度出发构造了对象强加权概念格,并没有充分考虑决策属性隐含的信息。未来将进一步研究这些问题。

| [1] |

WILLE R. Restructuring lattice theory: an approach based on hierarchies of concepts[M]//RIVAL I. Ordered Sets. Dordrecht: Springer, 1982: 445−470.

( 0) 0)

|

| [2] |

SUTTON A, MALETIC J I. Recovering UML class models from C++: a detailed explanation[J]. Information and software technology, 2007, 49(3): 212-229. DOI:10.1016/j.infsof.2006.10.011 ( 0) 0)

|

| [3] |

黄微, 高俊峰. 基于概念格的Web学术信息搜索结果的二次组织[J]. 现代图书情报技术, 2010(5): 8-12. HUANG Wei, GAO Junfeng. A second organization of academic retrieved results based on concept lattice[J]. New technology of library and information service, 2010(5): 8-12. (  0) 0)

|

| [4] |

沈夏炯, 叶曼曼, 甘甜, 等. 基于概念格的信息检索及其树形可视化[J]. 计算机工程与应用, 2017, 53(3): 95-99. SHEN Xiajiong, YE Manman, GAN Tian, et al. Information retrieval based on concept lattice and its tree visualization[J]. Computer engineering and applications, 2017, 53(3): 95-99. DOI:10.3778/j.issn.1002-8331.1507-0017 (  0) 0)

|

| [5] |

MISSAOUI R, GODIN R, BOUJENOUI A. Extracting exact and approximate rules from databases[C]//Proceedings of SOFTEKS Workshop on Incompleteness and Uncertainty in Information Systems. Berlin, Heidelberg: Springer, 1993: 209−222.

( 0) 0)

|

| [6] |

康向平, 苗夺谦. 一种基于概念格的集值信息系统中的知识获取方法[J]. 智能系统学报, 2016, 11(3): 287-293. KANG Xiangping, MIAO Duoqian. A knowledge acquisition method based on concept lattice in set-valued information systems[J]. CAAI transactions on intelligent systems, 2016, 11(3): 287-293. (  0) 0)

|

| [7] |

LIU Yong, KANG Xiangping, MIAO Duoqian, et al. A knowledge acquisition method based on concept lattice and inclusion degree for ordered information systems[J]. International journal of machine learning and cybernetics, 2019, 10(11): 3245-3261. DOI:10.1007/s13042-019-01014-4 ( 0) 0)

|

| [8] |

张功亮, 陈钰, 周茜, 等. 基于领域本体的信息语义相关检索[J]. 计算机工程, 2011, 37(20): 33-35, 38. ZHANG Gongliang, CHEN Yu, ZHOU Xi, et al. Information semantic relativity retrieval based on domain ontology[J]. Computer engineering, 2011, 37(20): 33-35, 38. DOI:10.3969/j.issn.1000-3428.2011.20.012 (  0) 0)

|

| [9] |

刘保相, 孟肖丽. 基于关联分析的气象云图识别问题研究[J]. 智能系统学报, 2014, 9(5): 595-601. LIU Baoxiang, MENG Xiaoli. The study on nephogram recognition based on relational analysis[J]. CAAI transactions on intelligent systems, 2014, 9(5): 595-601. (  0) 0)

|

| [10] |

陈湘, 吴跃. 基于概念格挖掘GIS中的关联规则[J]. 计算机应用, 2011, 31(3): 686-689. CHEN Xiang, WU Yue. Mining association rules of geographic information system based on concept lattice[J]. Journal of computer applications, 2011, 31(3): 686-689. DOI:10.3724/SP.J.1087.2011.00686 (  0) 0)

|

| [11] |

WU Weizhi, LEUNG Y, MI Jusheng. Granular computing and knowledge reduction in formal contexts[J]. IEEE transactions on knowledge and data engineering, 2009, 21(10): 1461-1474. DOI:10.1109/TKDE.2008.223 ( 0) 0)

|

| [12] |

MI Jusheng, WU Weizhi, ZHANG Wenxiu. Approaches to knowledge reduction based on variable precision rough set model[J]. Information sciences, 2004, 159(3−4): 255-272. ( 0) 0)

|

| [13] |

MI Jusheng, LEUNG Y, WU Weizhi. Approaches to attribute reduction in concept lattices induced by axialities[J]. Knowledge-based systems, 2010, 23(6): 504-511. DOI:10.1016/j.knosys.2010.03.007 ( 0) 0)

|

| [14] |

CHEN Jinkun, LI Jinjin. An application of rough sets to graph theory[J]. Information sciences, 2012, 201: 114-127. DOI:10.1016/j.ins.2012.03.009 ( 0) 0)

|

| [15] |

CHEN Jinkun, MI Jusheng, XIE Bin, et al. A fast attribute reduction method for large formal decision contexts[J]. International journal of approximate reasoning, 2019, 106: 1-17. DOI:10.1016/j.ijar.2018.12.002 ( 0) 0)

|

| [16] |

SHAO Mingwen, LEUNG Y, WU Weizhi. Rule acquisition and complexity reduction in formal decision contexts[J]. International journal of approximate reasoning, 2014, 55(1): 259-274. DOI:10.1016/j.ijar.2013.04.011 ( 0) 0)

|

| [17] |

LI Jinhai, MEI Changlin, LV Yuejin. Knowledge reduction in decision formal contexts[J]. Knowledge-based systems, 2011, 24(5): 709-715. DOI:10.1016/j.knosys.2011.02.011 ( 0) 0)

|

| [18] |

LI Jinhai, MEI Changlin, LV Yuejin. Knowledge reduction in real decision formal contexts[J]. Information sciences, 2012, 189: 191-207. DOI:10.1016/j.ins.2011.11.041 ( 0) 0)

|

| [19] |

LI Jinhai, MEI Changlin, WANG Junhong, et al. Rule-preserved object compression in formal decision contexts using concept lattices[J]. Knowledge-based systems, 2014, 71: 435-445. DOI:10.1016/j.knosys.2014.08.020 ( 0) 0)

|

| [20] |

QI Jianjun, WEI Ling, YAO Yiyu. Three-way formal concept analysis[C]//Proceedings of the 9th International Conference on Rough Sets and Knowledge Technology. Shanghai: Springer, 2014: 732−741.

( 0) 0)

|

| [21] |

REN Ruisi, WEI Ling. The attribute reductions of three-way concept lattices[J]. Knowledge-based systems, 2016, 99: 92-102. DOI:10.1016/j.knosys.2016.01.045 ( 0) 0)

|

| [22] |

WEI Ling, LIU Lin, QI Jianjun, et al. Rules acquisition of formal decision contexts based on three-way concept lattices[J]. Information sciences, 2020, 516: 529-544. DOI:10.1016/j.ins.2019.12.024 ( 0) 0)

|

| [23] |

LI Junyu, WANG Xia, WU Weizhi, et al. Attribute reduction in inconsistent formal decision contexts based on congruence relations[J]. International journal of machine learning and cybernetics, 2017, 8(1): 81-94. DOI:10.1007/s13042-016-0586-z ( 0) 0)

|

| [24] |

张继福, 张素兰, 郑链. 加权概念格及其渐进式构造[J]. 模式识别与人工智能, 2005, 18(2): 171-176. ZHANG Jifu, ZHANG Sulan, ZHENG Lian. Weighted concept lattice and incremental construction[J]. Pattern recognition and artificial intelligence, 2005, 18(2): 171-176. DOI:10.3969/j.issn.1003-6059.2005.02.008 (  0) 0)

|

| [25] |

张素兰, 郭平, 张继福. 基于信息熵和偏差的加权概念格内涵权值获取[J]. 北京理工大学学报, 2011, 31(1): 59-63. ZHANG Sulan, GUO Ping, ZHANG Jifu. Intension weight value acquisition of weighted concept lattice based on information entropy and deviance[J]. Transactions of Beijing Institute of Technology, 2011, 31(1): 59-63. (  0) 0)

|

2020, Vol. 15

2020, Vol. 15