2. 徐州工业职业技术学院 信息工程学院,江苏 徐州 221114

2. School of Information Engineering, Xuzhou College of Industrial Technology, Xuzhou 221114, China

聚类[1-3]是一种将数据集划分为若干组或类,使类内相似性最大,类间相似性最小的方法。现有文献提出,传统的聚类方法有k均值算法(k-means)[4]、FCM算法[5]、子空间聚类等。它们虽然简单,但缺乏处理复杂数据结构的能力,当样本为凸型时,这些算法对数据的处理有较好的效果,当样本空间为非凸时,算法容易陷入局部最优。为解决这一难题,谱聚类应运而生,它不受样本空间形状限制,聚类结果为全局最优解。在这些算法中,由于谱类算法便于实现、性能良好,已被广泛应用于图像分割、信息检索、人脸识别等领域。

谱聚类来源于图论中的最小切割问题[6-8]。众所周知,数据通过非线性变换,将数据映射到高维特征空间后,数据将变得线性可分。因此,可以通过各种非线性变换,例如基于核的方法,提高高维特征空间中输入数据的特征表示能力。然而,以往的谱聚类方法一般只注重数据降维、优化时间复杂度等,而不是进一步提高数据特征的表示能力。在聚类任务中,数据的特征表示是至关重要的,通过反复的实验和一系列的工作,获得良好的数据特征表示是提高聚类准确度的保证。

ELM[9-11]最初用于训练“广义”单隐层前馈神经网络(SLFN),具有快速学习、良好的泛化能力和特征表示能力,被广泛应用于各种机器学习任务,如回归和分类等[12-14]。近年来,ELM已经扩展到聚类,一般是在ELM获得的嵌入特征空间中进行聚类。ELM的隐层参数选择是随机的,和输入数据无关,与常用的反向传播训练算法相比,ELM最大限度地减小了训练误差和输出权的范数。根据Bartlett理论[15],最小化输出权值范数将产生更好的泛化能力。

自编码器(Auto Encoder AE)[16-17]是深度学习中的一种无监督学习方法,能够从大量数据中自动学习到数据中的有效特征[18-20]。传统自编码器就是一种在输出层重建输入数据并且结构对称的神经网络。常见的自编码器有降噪自编码器、稀疏自编码器、收缩自编码器和卷积自编码器等[21]。使用自编码器进行特征提取要比特征分解快,并让目标值等于输入值,是一种尽可能复现输入信号的神经网络。

基于以上启发,本文将极限学习机(ELM)和自编码器(AE)结合起来改进谱聚类,提出了一种基于ELM-AE嵌入特征空间的谱聚类算法。

1 相关工作 1.1 谱聚类算法谱聚类的概念起源于谱划分,将数据聚类转化为无向图的多路划分问题求解,尤其适用于数据集非凸的情况[22-23]。假设数据集有n个数据点,目标是将所有数据点划分到c个簇中。谱聚类[24]首先将数据点看作图的顶点,根据数据点成对相似性,先用欧氏距离计算距离矩阵,再使用高斯核函数将距离矩阵构造为相似矩阵并计算出所对应的拉普拉斯矩阵,谱方法是基于相似拉普拉斯矩阵的特征值和特征向量进行聚类的方法,将这些特征向量构造为低维的特征子空间,再在这个特征子空间上使用诸如k-means的聚类方法进行聚类,NJW谱聚类算法[24]是一个典型的谱聚类算法。下面简单介绍该方法的原理。

给定一组数据集

1)根据一定的相似矩阵生成方式构建样本的相似矩阵,

| ${{{W}}_{{ij}}} = \exp ( - ||{{{x}}_{{i}}} - {{{x}}_{{j}}})|{|^2}/2{\sigma ^2})$ |

式中:当

2)根据相似矩阵

| ${{{d}}_{{ii}}} = \sum _{{j}}{{{w}}_{{ij}}} $ |

3)根据

| ${{L}} = {{D}} - {{W}}$ |

4)对

| ${{{L}}_{{\rm{norm}}}} = {{{D}}^{{{ - 1} / 2}}}{{{LD}}^{ - 1/2}}$ |

还可以表示为

| ${{{L}}_{{\rm{norm}}}}{\rm{ = }}{{{D}}^{{\rm{ - }}1/2}}{{{WD}}^{{\rm{ - }}1/2}}$ |

5)接下来计算标准化后的拉普拉斯矩阵的前k个最小特征值对应的特征向量

6)将

极限学习机自编码器[19]是一种既可以再现输入数据也可以自行编码的神经网络方法,具有极限学习机的计算速度快、精确率高等特点。与传统的极限学习机相似,ELM-AE包含输入层、单隐含层以及输出层;不同的是,ELM-AE的输出层与输入层相等。给定一个训练样本,ELM-AE的模型结构包括M个输入层节点、J个隐层节点和M个输出层节点。ELM-AE的隐含层输出可以用式(1)表示:

| $ {{h}} = {{g}}({{ax}} + {{b}}),\;\; {{{{a}}^{\rm{T}}}{{a}} = {{I}},{{{b}}^{\rm{T}}}{{b}} = 1} $ | (1) |

式中:

| $ {{h}}({{{x}}_{{i}}}){{\beta }} = {{{x}}_{{i}}}^{\bf{T}},\;\;{{i}}=1,2,\cdots ,N $ | (2) |

式中:

| $\mathop {\min }\limits_{{\beta }} \;\;{{{L}}_1} = \frac{1}{2}{\left\| {{\beta }} \right\|^2} + \frac{C}{2}{\left\| {{{X}} - {{H\beta }}} \right\|^2}$ | (3) |

式中:C是平衡经验风险与结构风险的参数。通过取

| ${{\beta }} = \left\{ {\begin{array}{*{20}{c}} {{{\left( {\dfrac{{{I}}}{C} + {{{H}}^{\rm{T}}}{{H}}} \right)}^{ - 1}}{{{H}}^{\rm{T}}}{{X}},}\quad{N \geqslant J} \\ {{{{H}}^{^{\rm{T}}}}{{\left( {\dfrac{{{I}}}{C} + {{H}}{{{H}}^{\rm{T}}}} \right)}^{ - 1}}{{X}},}\quad{N < J} \end{array}} \right.$ | (4) |

前面从理论层面分析了谱聚类及ELM-AE的特征提取方法。传统的谱聚类是将原始数据样本作为聚类初始值,而在实际应用中数据通常冗余且复杂,能够从原始数据中充分挖掘内在信息,通过机器学习算法进行特征学习,使用获得的数据特征空间进行谱聚类将有效提高聚类质量。ELM可以随机初始化输入权重和偏置并得到相应的输出权重,然而随机生成的输入权值和偏差会导致ELM隐层的输出不能很好地代表原始样本的特征。ELM-AE是一种能够重建输入信号的人工神经网络算法,和自动编码器一样,ELM-AE无需迭代可以获得原始样本的主要特征,与传统的ELM不同的是,ELM-AE通过选择随机权重和随机偏差正交,可以获得更高的性能。通过ELM-AE的输出β实现从特征空间到原始输入数据的转换,使得输出数据等于输入数据。

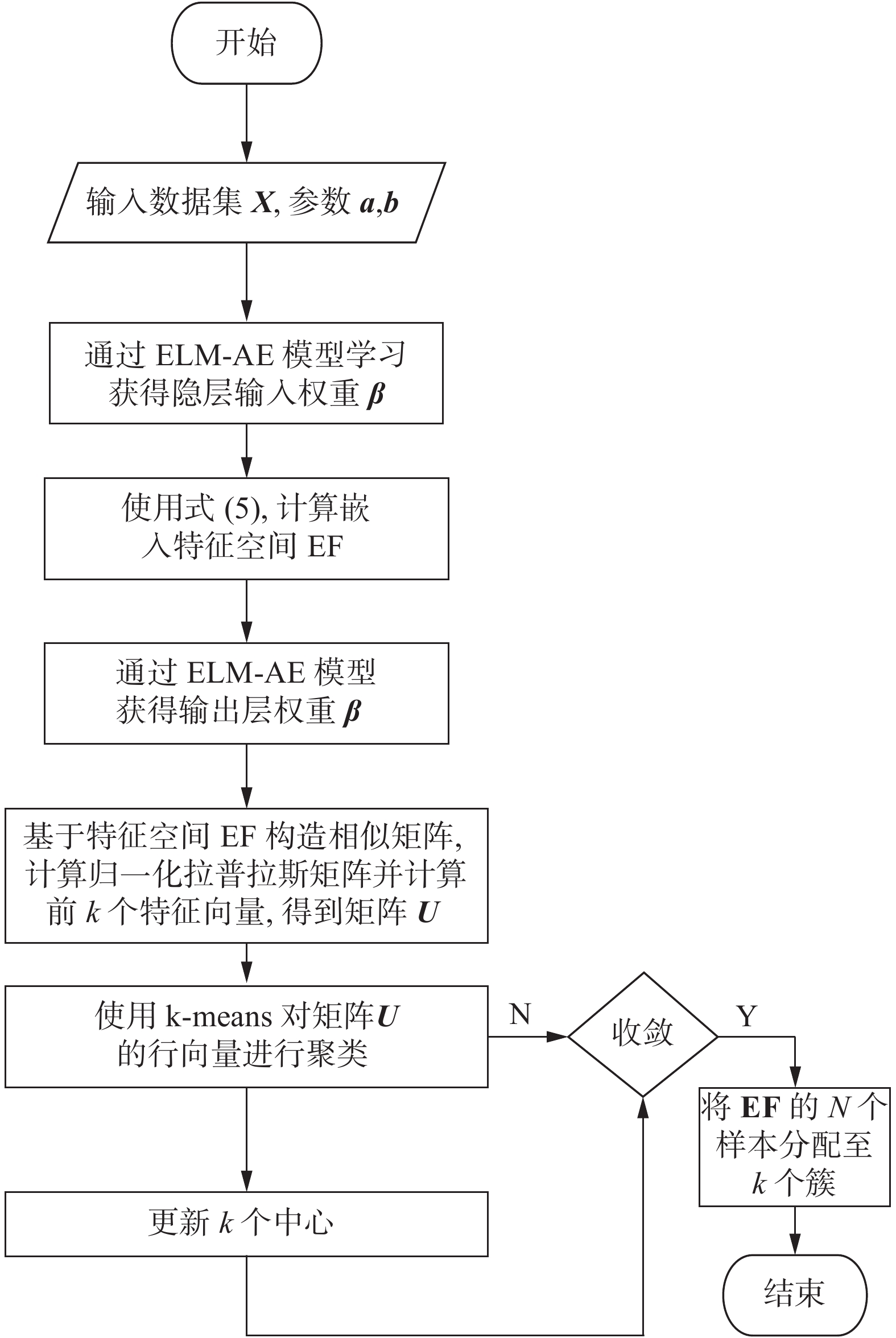

本文提出的基于ELM-AE嵌入特征空间的谱聚类是将ELM-AE的特征空间作为聚类原始值,从而提高聚类性能。SC-ELM-AE模型包含输入层、单隐层和输出层,其模型结构如图1,也具有M个输入层节点,J个隐藏层节点和M个输出层节点,然后如图所示通过ELM-AE获得输出层权值β,ELM-AE输出层的嵌入特征(embedding feature,EF)可由式(5)计算:

| $ {\bf{EF}} = {{f}}\left( {{{X}}{{{\beta }}^{\rm{T}}}} \right) $ | (5) |

然后采用归一化谱聚类算法将ELM-AE的嵌入特征(EF)作为聚类输入数据点进行聚类。SC-ELM-AE算法流程如图1所示。基于ELM-AE嵌入特征空间的谱聚类算法(SC-ELM-AE)流程详见算法1。

算法1 基于ELM-AE嵌入特征空间的谱聚类

输入 数据集样本

输出 基于EF空间的N个样本的k个簇。

1)初始化由N个隐藏层神经元组成的ELM-AE网络,计算隐藏层的输出

2)使用式(3)、(4)计算ELM-AE的输出层权值;

3)使用式(5)计算嵌入特征EF,激活函数使用

4)得到嵌入特征样本

5)在

6)构造归一化对称拉普拉斯矩阵

7)将矩阵

8)归一化矩阵

9)利用k-means算法对矩阵

|

Download:

|

| 图 1 SC-ELM-AE算法流程 Fig. 1 Flow of SC-ELM-AE algorithm | |

为了验证基于ELM-AE嵌入特征空间的谱聚类算法的有效性,选取了UCI机器学习数据库中的5个常用数据集进行验证测试,数据集的基本特征如表1所示。

| 表 1 实验中使用的UCI数据集 Tab.1 UCI datasets used in the experiments |

实验在MATLAB R2016b环境下实现,运行在Windows 10上,实验中使用的计算机CPU 型号为Inter(R)Core(TM)i5-8250U @1.60 GHz,内存为8 GB。本文所有实验中,ELM-AE模型包含输入层、输出层、隐藏层,为了方便实验,隐藏层、输出层的激活函数都采用sigmoid函数。

实验使用的对比算法分别为:传统谱聚类[25](spectral clustering,SC)、k-means聚类、基于无监督极限学习机(unsupervised extreme learning machine US-ELM)的K-means聚类、基于ELM-AE嵌入特征的无监督极限学习机[26](unsupervised extreme learning machine based on embedded features of ELM-AE, US-EF-ELM)k-means聚类算法。

本文中,k-means、SC、US-ELM和US-EF-ELM所有算法在数据集上运行10次,记录平均结果和标准差。根据文献[20]在所有数据集上,US-ELM隐藏节点数和US-EF-ELM隐藏节点数均设置为2 000,US-ELM和US-EF-ELM的激活函数均为sigmoid函数。在SC-EF-ELM中,从{100、200、500、1000、2 000}中选择隐藏节点个数,激活函数也为sigmoid函数。在US-ELM、US-EF-ELM和SC-EF-ELM中,正则化参数选取范围为{10−4, 10−3, 10−2, 10−1, 100, 101, 102, 103, 104},在SC和SC-EF-ELM中,核函数为高斯核函数,其中高斯核函数的参数为样本间的中值距离。

3.2 性能指标假设数据集

| $ {{F}} = \frac{{\left( {{{{a}}^2} + 1} \right){{PR}}}}{{{{{a}}^2}({{P}} + {{R}})}} $ |

当参数

| $ {{{F}}_1} = \frac{{2{{PR}}}}{{{{P}} + {{R}}}} $ |

式中:P是精确率(precision)度量值;R是召回率(recall)度量值。

ACC表示聚类结果中被正确划分的数据点比例:

| ${\rm{ACC}} = \sum\limits_{{i}}^{{N}} {\delta ({{{y}}_{{i}}},{\rm{map}}({{y}}_{{i}}'))} /{{n}}$ |

式中:n表示数据样本的个数;当x=y时,则

NMI 衡量的是算法的划分质量:

| ${\rm{NMI}} = \frac{{\displaystyle\sum\limits_{{i}}^{{k}} {\displaystyle\sum\limits_{{j}}^{{{{k}}'}} {\left| {{{{C}}_{{i}}} \cap {{C}}_{{j}}'} \right|\log \dfrac{{{{n}}\left| {{{{C}}_{{i}}} \cap {{C}}_{{j}}'} \right|}}{{|{{{C}}_{{i}}}||{{C}}_{{j}}'|}}} } }}{{\sqrt {\displaystyle\sum\limits_{{{i}} = 1}^{{k}} {|{{{C}}_{{i}}}|\log \dfrac{{|{{C}}{}_{{i}}|}}{{{n}}} \cdot \displaystyle\sum_{{{j}} = 1}^{{{{k}}'}} {|{{C}}_{{j}}'|\log \dfrac{{|{{C}}_{{j}}'|}}{{{n}}}} } } }}$ |

NMI的值越大,聚类有效性越好。

3.3 实验结果所提出的SC-ELM-AE与k-means、SC、US-ELM和US-EF-ELM在5个数据集上的表现对比见表2。

| 表 2 提出的SC-ELM-AE算法5个UCI数据集上的性能比较 Tab.2 Performance comparison of the proposed SC-ELM-AE on five UCI datasets |

从表2中可以看出,本文所提出的SC-ELM-AE算法在聚类准确率上与对比算法相比在5个数据集上都有了较大提升。例如,对于高维数据集PEMS-SF,本文所提算法与对比算法相比在ACC上分别提升了33.2%、32.75%、31.46%、26.68%平均提升了31.02%。

SC-ELM-AE聚类算法利用ELM-AE模型无需迭代即可获得低维特征表示空间,尽可能多地保留了原始数据集的丰富信息,使获得的聚类结果更加准确。实验数据结果表明,本文提出的SC-ELM-AE算法在进行实验的数据集上与对比算法相比聚类精度有较大的提升,这也验证了本文所提算法的合理性和有效性。

为了验证提出的SC-ELM-AE算法在增加隐含层节点后的表现,在实验中将ELM-AE模型结构的隐含层节点数从100增加到2 000,并在数据集WDBC和PEMS-SF上基于ELM-AE的嵌入特征空间进行快速谱聚类,实验结果如图2、3所示。

|

Download:

|

| 图 2 在数据集PEMS-SF上SC-ELM-AE的性能变化 Fig. 2 Performances for SC-ELM-AE on dataset PEMS-SF | |

从图2可以看出:将ELM-AE特征表示空间作为谱聚类输入,从(10−4,10−3,10−2)中选取正则化参数,当隐藏节点较小,ACC、F-measure和NMI值较低。而在(10−1,100,101,102,103,104)选取正则化参数时,隐藏节点数量的变化基本不会引起算法性能的波动。

|

Download:

|

| 图 3 在数据集WDBC上SC-ELM-AE的性能变化 Fig. 3 Performances for SC-ELM-AE on dataset WDBC | |

从图3可以看出,本文提出的SC-ELM-AE始终是稳定的。因此,可以推断参数的选择对算法性能的影响不大,在合适的正则化参数下,采用很少的隐藏节点即可实现较高的聚类精度,与传统的聚类方法相比,所提出的SC-ELM-AE算法具有更强的实用性。此外,在UCI的其他3个基准数据集上进行验证,实验结果与推断一致,也证明了所提SC-ELM-AE的性能的有效性。

4 结束语本文提出了一种通过ELM-AE特征表示空间的谱聚类算法。它利用ELM-AE将输入的原始数据集转化为数据特征表示空间,再对特征表示空间样本集进行谱聚类,利用ELM-AE获得的特征空间可以更好地反映出原始数据的主要信息且计算成本较低;使用ELM-AE进行特征提取,提高了聚类的准确性。通过实验验证了本文算法在有效性和准确性两方面优于现有的谱聚类算法,能够快速有效地处理复杂高维数据。在未来的工作中需要考虑如何在保证聚类精确的情况下进一步提高聚类的速度以及对大规模数据的处理。

| [1] |

BERKHIN P. A survey of clustering data mining techniques[M]//KOGAN J, NICHOLAS C, TEBOULLE M. Grouping Multidimensional Data. Berlin, Heidelberg: Springer, 2006: 25−71.

( 0) 0)

|

| [2] |

孙吉贵, 刘杰, 赵连宇. 聚类算法研究[J]. 软件学报, 2008, 19(1): 48-61. SUN Jigui, LIU Jie, ZHAO Lianyu. Clustering algorithms research[J]. Journal of software, 2008, 19(1): 48-61. DOI:10.3724/SP.J.1001.2008.00048 (  0) 0)

|

| [3] |

刘兵. Web数据挖掘[M]. 俞勇, 薛贵荣, 韩定一, 译. 北京: 清华大学出版社, 2011.

( 0) 0)

|

| [4] |

WU Junjie, LIU Hongfu, XIONG Hui, et al. K-means-based consensus clustering: a unified view[J]. IEEE transactions on knowledge and data engineering, 2015, 27(1): 155-169. DOI:10.1109/TKDE.2014.2316512 ( 0) 0)

|

| [5] |

WANG Yangtao, CHEN Lihui. Multi-view fuzzy clustering with minimax optimization for effective clustering of data from multiple sources[J]. Expert systems with applications, 2017, 72: 457-466. DOI:10.1016/j.eswa.2016.10.006 ( 0) 0)

|

| [6] |

VAN LUXBURG U. A tutorial on spectral clustering[J]. Statistics and computing, 2007, 17(4): 395-416. DOI:10.1007/s11222-007-9033-z ( 0) 0)

|

| [7] |

JIA Hongjie, DING Shifei, XU Xinzheng, et al. The latest research progress on spectral clustering[J]. Neural computing and applications, 2014, 24(7/8): 1477-1486. ( 0) 0)

|

| [8] |

蔡晓妍, 戴冠中, 杨黎斌. 谱聚类算法综述[J]. 计算机科学, 2008, 35(7): 14-18. CAI Xiaoyan, DAI Guanzhong, YANG Libin. Survey on spectral clustering algorithms[J]. Computer science, 2008, 35(7): 14-18. DOI:10.3969/j.issn.1002-137X.2008.07.004 (  0) 0)

|

| [9] |

HUANG Guangbin, CHEN Lei, SIEW C K. Universal approximation using incremental constructive feedforward networks with random hidden nodes[J]. IEEE transactions on neural networks, 2006, 17(4): 879-892. DOI:10.1109/TNN.2006.875977 ( 0) 0)

|

| [10] |

ZHANG Rui, LAN Yuan, HUANG Guangbin, et al. Universal approximation of extreme learning machine with adaptive growth of hidden nodes[J]. IEEE transactions on neural networks and learning systems, 2012, 23(2): 365-371. DOI:10.1109/TNNLS.2011.2178124 ( 0) 0)

|

| [11] |

HUANG Guangbin, ZHOU Hongming, DING Xiaojian, et al. Extreme learning machine for regression and multiclass classification[J]. IEEE transactions on systems, man, and cybernetics, part B (cybernetics), 2012, 42(2): 513-529. DOI:10.1109/TSMCB.2011.2168604 ( 0) 0)

|

| [12] |

DA SILVA B L S, INABA F K, SALLES E O T, et al. Outlier Robust Extreme Machine Learning for multi-target regression[J]. Expert systems with applications, 2020, 140: 112877. DOI:10.1016/j.eswa.2019.112877 ( 0) 0)

|

| [13] |

ZENG Yijie, LI Yue, CHEN Jichao, et al. ELM embedded discriminative dictionary learning for image classification[J]. Neural networks, 2020, 123: 331-342. DOI:10.1016/j.neunet.2019.11.015 ( 0) 0)

|

| [14] |

WU Chao, LI Yaqian, ZHAO Zhibiao, et al. Extreme learning machine with multi-structure and auto encoding receptive fields for image classification[J]. Multidimensional systems and signal processing, 2020, 31(4): 1277-1298. DOI:10.1007/s11045-020-00708-1 ( 0) 0)

|

| [15] |

BARTLETT P L. The sample complexity of pattern classification with neural networks: the size of the weights is more important than the size of the network[J]. IEEE transactions on information theory, 1998, 44(2): 525-536. DOI:10.1109/18.661502 ( 0) 0)

|

| [16] |

HINTON G E, SALAKHUTDINOV R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006, 313(5786): 504-507. DOI:10.1126/science.1127647 ( 0) 0)

|

| [17] |

BENGIO Y, YAO Li, ALAIN G, et al. Generalized denoising auto-encoders as generative models[C]//Proceedings of the 26th International Conference on Neural Information Processing Systems. Lake Tahoe, Nevada: Curran Associates Inc., 2013: 899−907.

( 0) 0)

|

| [18] |

BALDI P. Autoencoders, unsupervised learning and deep architectures[C]//Proceedings of the 2011 International Conference on Unsupervised and Transfer Learning workshop. Washington, USA: JMLR. org, 2011: 37−50.

( 0) 0)

|

| [19] |

袁非牛, 章琳, 史劲亭, 等. 自编码神经网络理论及应用综述[J]. 计算机学报, 2019, 42(1): 203-230. YUAN Feiniu, ZHANG Lin, SHI Jinting, et al. Theories and applications of auto-encoder neural networks: a literature survey[J]. Chinese journal of computers, 2019, 42(1): 203-230. (  0) 0)

|

| [20] |

VINCENT P, LAROCHELLE H, LAJOIE I, et al. Stacked denoising autoencoders: learning useful representations in a deep network with a local denoising criterion[J]. Journal of machine learning research, 2010, 11(12): 3371-3408. ( 0) 0)

|

| [21] |

刘帅师, 程曦, 郭文燕, 等. 深度学习方法研究新进展[J]. 智能系统学报, 2016, 11(5): 567-577. LIU Shuaishi, CHENG Xi, GUO Wenyan, et al. Progress report on new research in deep learning[J]. CAAI Transactions on intelligent systems, 2016, 11(5): 567-577. (  0) 0)

|

| [22] |

李建元, 周脚根, 关佶红, 等. 谱图聚类算法研究进展[J]. 智能系统学报, 2011, 6(5): 405-414. LI Jianyuan, ZHOU Jiaogen, GUAN Jihong, et al. A survey of clustering algorithms based on spectra of graphs[J]. CAAI transactions on intelligent systems, 2011, 6(5): 405-414. DOI:10.3969/j.issn.1673-4785.2011.05.004 (  0) 0)

|

| [23] |

FILIPPONE M, CAMASTRA F, MASULLI F, et al. A survey of kernel and spectral methods for clustering[J]. Pattern recognition, 2008, 41(1): 176-190. DOI:10.1016/j.patcog.2007.05.018 ( 0) 0)

|

| [24] |

NG A Y, JORDAN M I, WEISS Y. On spectral clustering: analysis and an algorithm[C]//Proceedings of the 14th International Conference on Neural Information Processing Systems: Natural and Synthetic. Vancouver, British Columbia, Canada: MIT Press, 2001: 849−856.

( 0) 0)

|

| [25] |

KASUN L L C, ZHOU H, HUANG G B, et al. Representational learning with extreme learning machine for big data[J]. IEEE intelligent systems, 2013, 28(6): 31-34. ( 0) 0)

|

| [26] |

DING Shifei, ZHANG Nan, ZHANG Jian, et al. Unsupervised extreme learning machine with representational features[J]. International journal of machine learning and cybernetics, 2017, 8(2): 587-595. DOI:10.1007/s13042-015-0351-8 ( 0) 0)

|

2021, Vol. 16

2021, Vol. 16