监控视频中的人体检测和跟踪一直是研究的热点,在人工智能、安全监控和人机交互等领域有广泛的应用[1-4]。通过建立背景模型,利用背景差分法检测目标具有检测速度快、准确度高和易实现的特点,得到了广泛的研究[5-9]。但缺点是会因为背景模型中包含目标像素而在检测中产生“鬼影”。背景差分法包括GMM (Gaussian mixture model)、Vibe、CodeBook、Color (基于颜色信息的背景建模检测方法) 等算法[10-15]。Shahbaz等[16]将检测算法分为了三类,并利用大型真实标准数据集对算法进行定量和定性比较。Wren等[17]首次提出使用单高斯模型对简单背景建模,对单一背景有较好的效果。为了提高算法的鲁棒性,算法需要适应在复杂背景情况下的建模[18]。Stauffer等[19]提出利用K个高斯分布对背景的每一个像素建模,实现了对汽车和行人的分类和跟踪。Zivkovic等[20]提出将混合高斯模型中的K值根据背景的复杂度自适应调整,提高了算法的执行效率。以上提出的高斯背景建模算法建模速度快,对运动目标有较好的检测效果,但是对缓慢运动或静止的目标会检测不完整。Kim等[21]利用CodeBook算法对动态目标进行检测,算法在室内外的效果都比较好并且适应小范围周期运动的背景。Barnich等[22-23]提出一种有效的ViBe目标检测算法,该算法实现简单并且运行效率高。针对ViBe不足,国内外学者也对其进行了许多改进[24-26]。文献[24]利用多帧平均法改进Vibe的建模过程并给出自适应半径阈值的计算方法。文献[25]通过利用时空梯度改进ViBe算法。文献[26]通过灰度空间信息构建像素生命长度字典改进ViBe。文献[21-26]算法虽然可以检测出较为完整的目标,但是依然无法准确剔除目标像素,会使检测结果可能产生“鬼影”。现阶段抑制 “鬼影”的方法分为两类: 1) 在建模阶段通过剔除目标像素去除“鬼影”;2) 目标检测阶段将“鬼影” 检测为背景并且更新进背景内。Codebook通过过滤初始化码本中的目标像素削弱“鬼影”的影响。ViBe采用首帧建模思想,若首帧存在目标,则会产生严重“鬼影”。文献[24-26]产生的“鬼影”都需要利用背景模型的更新消除。St-Charles P L等[27-28]利用背景的快速更新去除“鬼影”,但过快的更新容易将目标更新进背景内,会使目标检测不完整。由上述算法看出,在建模阶段有效地从背景模型中剔除目标像素是一个关键问题,否则 “鬼影”会影响检测结果。

为了有效解决建模阶段包含目标像素造成的 “鬼影”问题,本文结合混合高斯模型和拓扑结构提出GMMT算法,在背景建模阶段剔除目标像素,在目标检测阶段利用邻域相关性实现目标分割,有效地抑制了“鬼影”。

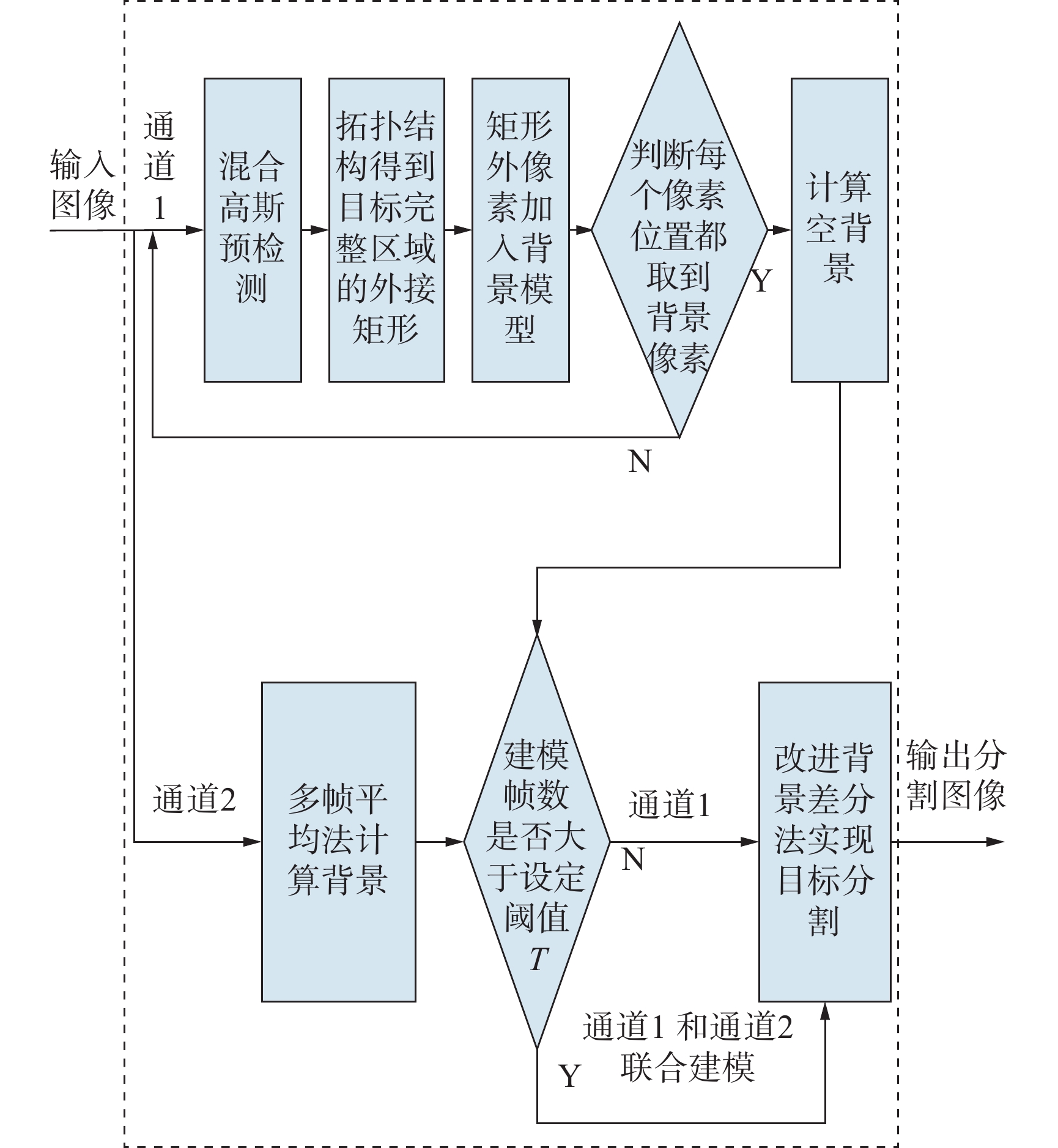

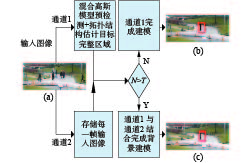

1 算法概述本文提出的GMMT算法需要先进行背景建模,然后利用背景模型实现目标检测。在背景建模阶段采用双通道建模方式,通道一利用混合高斯模型进行预检测,接着利用Meanshift确定分散区域之间的联系,在区域之间生成网状拓扑结构[29],形成统一的整体并计算整体区域的外接矩形。最后将矩形外的像素加入背景模型中,利用多帧平均法计算空背景; 通道二保留背景建模阶段的输入帧,直接利用多帧平均法计算空背景。通过设置建模帧数阈值T判断建模方式,若建模帧数小于T,则使用通道一建模,否则使用双通道联合建模。在目标检测阶段,利用改进的背景差分法考虑邻域像素的相关性检测目标并且进一步消除背景建模阶段由于抑制不彻底而遗留的“鬼影”。GMMT算法通过这两个阶段的处理,可以有效地抑制“鬼影”,实现目标分割。图1中为GMMT的框图结构。

|

Download:

|

| 图 1 GMMT算法框图 Fig. 1 Block diagram of GMMT | |

首先,对人体静止、缓慢运动和快速运动加以定义。本文中人体静止是指人体不走动,但是上肢或者下肢在摆动角区间

“鬼影”即为虚假目标,通常是由于背景模型中包含目标像素造成的。当利用背景模型进行背景差分时,若背景模型中包含目标像素,而待检测帧的对应位置不包含真正的目标时,依然会检测出目标,此时就形成了“鬼影”。背景建模的难点就在于目标像素会进入背景模型中。其中,在目标静止或运动缓慢时“鬼影”问题尤为严重。因为背景像素会被目标像素长期遮挡,无法采集到真实的背景像素,这样会在检测过程中产生 “鬼影”。GMMT通过利用混合高斯模型和拓扑结构剔除目标1像素,建立有效的背景模型。

2.1 混合高斯模型混合高斯模型由于更新速度快,所以可以有效地检测目标的运动信息。混合高斯模型的概率函数可表达为

| $p({x_N}) = \sum\limits_{j = 1}^K {{w_j}\eta ({x_N},{\theta _j})} $ | (1) |

式中:

GMMT利用混合高斯模型检测目标的运动信息。图2为混合高斯模型对目标运动信息的检测结果。由图2可看出,运动快速的目标检测完整,运动缓慢和静止的目标检测不完整。图2中(b)和(d)可看出,目标静止或运动缓慢时,变化最明显的位置是目标边缘。

|

Download:

|

| 图 2 混合高斯模型对不同运动状态目标的检测结果 Fig. 2 Detection results of Gaussian mixture model for objects in different moving states | |

为了建立有效的背景模型,需要将检测到的目标像素和未检测到目标像素全部剔除,GMMT将混合高斯模型检测得到的运动目标信息作为先验信息,然后利用拓扑结构估计未检测到的目标像素。

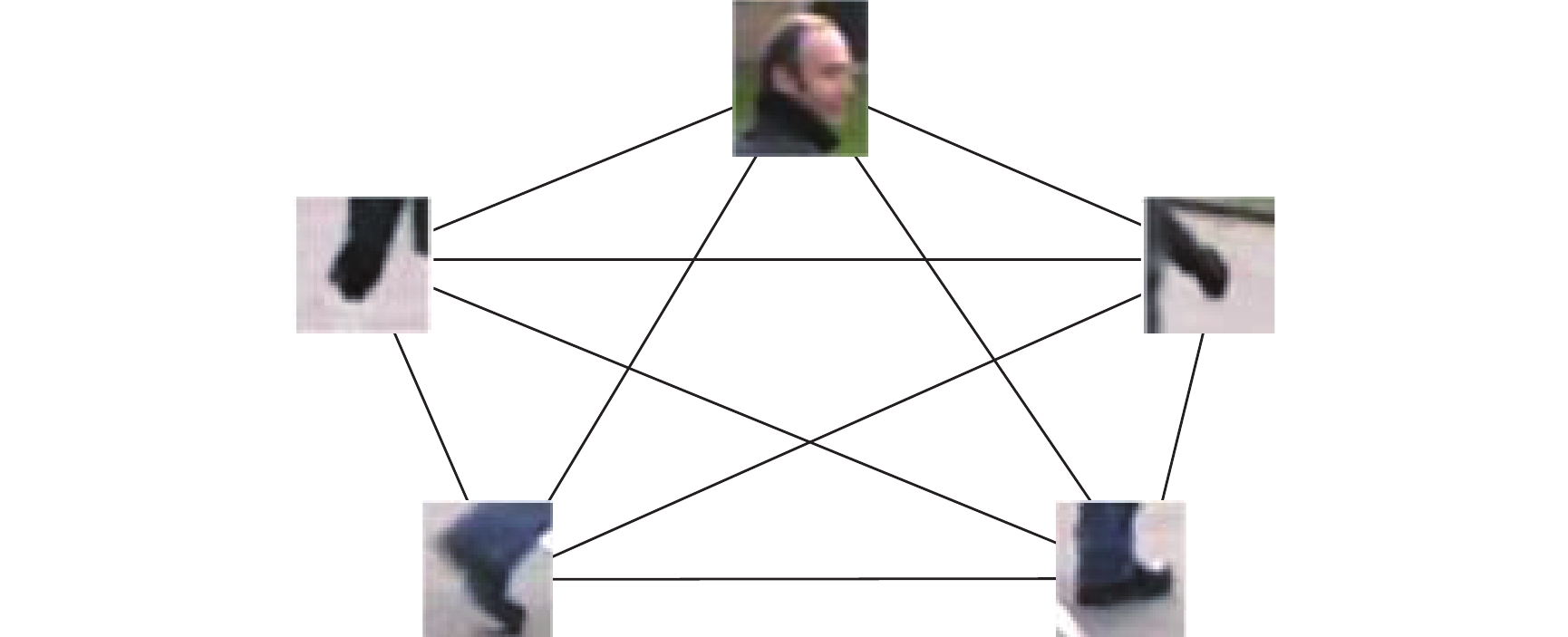

2.2 利用拓扑估计目标完整区域受到网状拓扑结构在计算机网络中应用的启发,本文将网状拓扑结构应用于目标区域的估计。图3为网状拓扑结构1示意图,图中身体各部分表示节点,直线表示连接关系。从图中可以看出利用网状拓扑结构可以充分将分散的身体运动区域连接为一个整体。GMMT就是利用拓扑结构这种将所有分散个体连接成统一整体的思想。由图2可知,不易检测的像素容易出现在目标内部,而易检测像素出现在目标边缘,所以GMMT充分利用目标边缘的变化信息,用网状拓扑结构将边缘所有的运动像素连接。在GMMT中将已检测到的目标区域抽象节点,然后使用Meanshift算法确定节点之间的连接关系。

|

Download:

|

| 图 3 网状拓扑结构 Fig. 3 Mesh topology | |

Meanshift聚类采用欧式距离判断点是否为当前聚类的兴趣点。为了使算法更好地适应对人体区域的聚类,GMMT中利用更符合人体长宽比的矩形框代替欧式距离判断。下面是Meanshift的具体步骤:

1)首先随机选取一个未被标记的点作为聚类中心center;

2)找出以center为中心长宽比为2的矩形框区域内所有的数据点集合N,认为集合N属于同一聚类C,并记录数据点在该类出现的次数加1;

3)计算以center为起始到集合N中每一个元素的向量,将向量相加得到shift向量;

4)使center沿着shift向量移动,即

5)重复步骤2)~4),直至shift向量很小,GMMT设置shift为0时迭代停止,该过程遇到的全部点属于聚类C;

6)重复步骤1)~5),直至所有的点都被访问;

7)若一个聚类中心在另一个聚类中心的长宽比为2的矩形框区域内,则合并两个聚类并将数据点出现的次数也合并;

8)按照每个点不同类的访问频率进行分类,将点分配给访问频率最大的聚类。

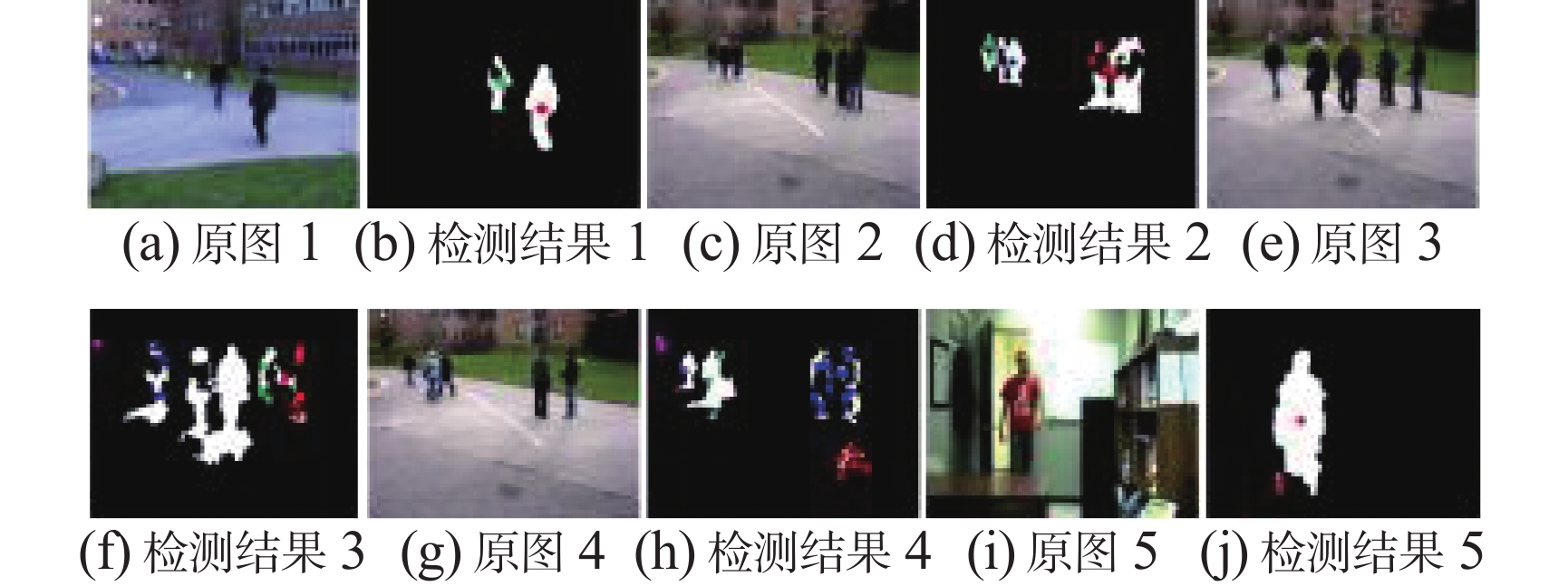

通过Meanshift将混合高斯模型检测后图像中的区域聚类,同一目标或相邻很近目标分离的区域被聚类为一类。通过在多个场景进行测试,Meanshift采用长宽为200×100的矩形框。在利用Meanshift聚类前,利用混合高斯模型预检测得到的图像需要进行形态学运算去除过小的噪声点。图4为利用Meanshift得到的聚类结果,彩图表示原图,二值图表示对原图预检测后聚类的结果,不同的颜色表示不同的类别。从(b)、(d)、(f)、(h)和(j)可以看出,Meanshift将同一目标或相邻目标分散的区域聚为一类。需要注意的是图(h)中红色聚类为目标造成的阴影区域,GMMT算法在背景建模阶段会将目标造成的阴影像素当作目标像素处理。

|

Download:

|

| 图 4 Meanshift聚类结果 Fig. 4 Results of Meanshift clustering | |

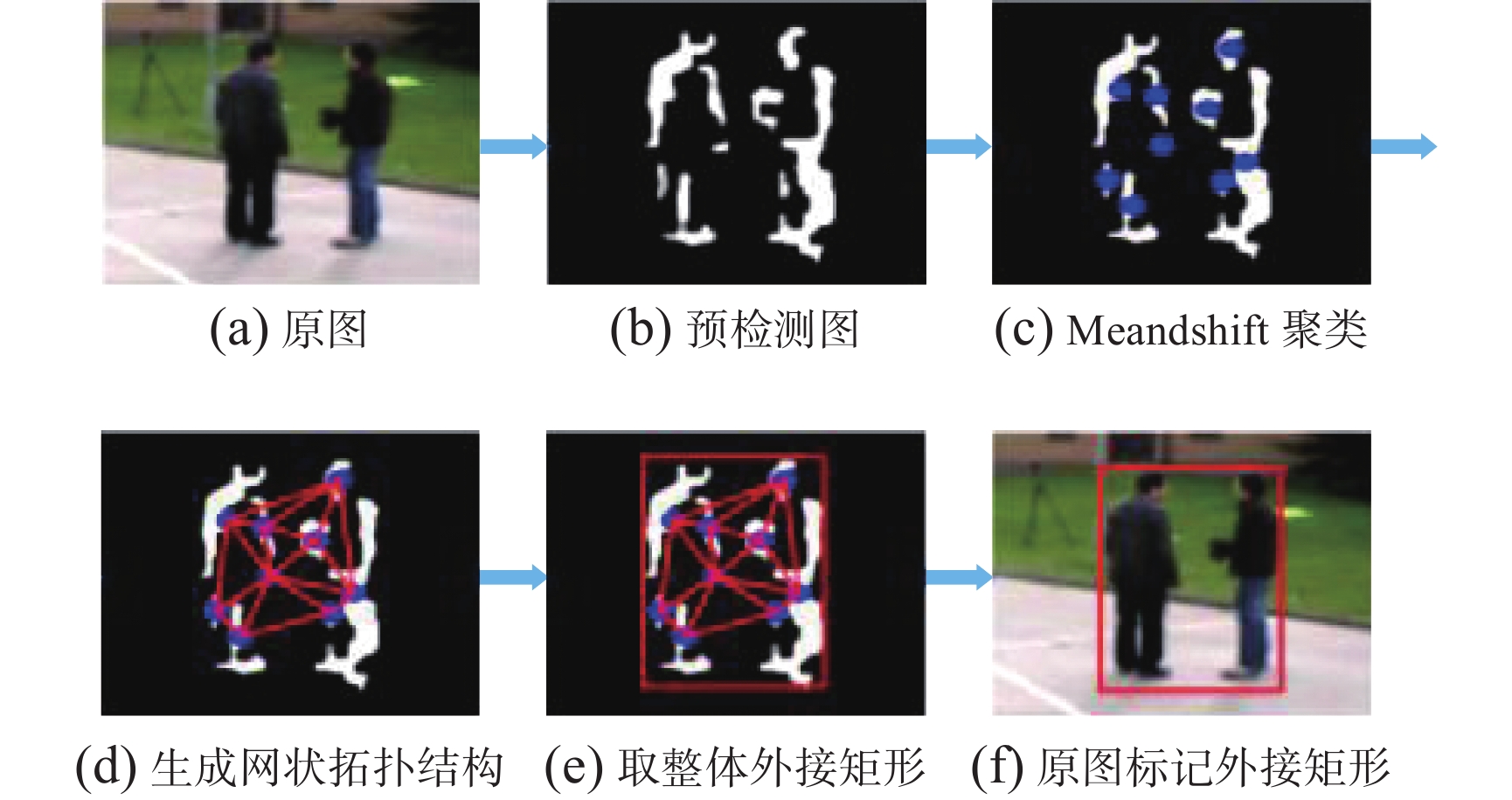

由Meanshift确定点之间的联系后,在同一类点内生成网状拓扑结构,将分散的区域连接成一个整体并得到整体区域的外接矩形。图5为利用网状拓扑结构将分散区域连接的流程图,聚类过程的介绍以图4(h)中蓝色聚类为例。图5(d)为利用网状拓扑结构思想将分散的目标区域连接在一起,然后在图5(e)中取整体区域的外接矩形,最后图5(f)为将外接矩形在原图中标记。网状拓扑会在每个节点连接多条边,目的是将同一类的区域全部连接在一起。通过估计目标区域得到的外接矩形内包含已检测的目标像素(白色区域)和未检测到的目标像素。背景建模时将矩形框内的像素全部剔除,这样可以尽可能剔除所有的目标像素,达到有效抑制“鬼影”的目的。

|

Download:

|

| 图 5 估计目标区域流程 Fig. 5 Process of estimate target area | |

得到背景像素后需要计算空背景,利用背景差分法实现目标检测。在计算空背景时考虑到部分背景像素可能由于目标长期遮挡背景或背景长期剧烈变化(如树枝剧烈晃动)不能采集到稳定的背景像素,所以GMMT算法如图6所示采用双通道的方式计算背景模型。

|

Download:

|

| 图 6 双通道计算背景流程 Fig. 6 Process of two channel computing background | |

通道1 根据2.2节和2.3节介绍的方法剔除目标像素,当所有的背景像素出现至少一次后就计算空背景。计算背景公式为

| ${\rm{Bg}}(x,y) = \left(\sum\limits_{i = 1}^N {{\rm{Mode}}{{\rm{l}}_i}(x,y)} \right)/{\rm{cou}}(x,y)$ | (2) |

式中:

通道2 存储每一帧输入的图像

如图6所示为GMMT算法利用双通道计算空背景,输入图像中示例场景建模帧数大于200,图(b)中矩形框内为通道一无法采集的背景像素,图(c)中矩形框为使用联合建模采集的背景像素。阈值T可以按照实验时所能接受的建模帧数上限设置,本文设置建模所用帧数阈值T=200帧。若建模帧数小于T时,则只用通道一完成背景建模;否则采用通道一与通道二联合建模。因为建模帧数不小于T说明通道一存在无法采集的背景像素。如图6中示例场景由于人群密集导致在建模帧数上限内存在无法采集的背景像素(图(b)矩形框内的黑色像素),所以将无法采集的背景像素利用通道二多帧平均法填补。通过通道一建模和双通道联合建模对比可发现,双通道联合建模填补了缺失的背景像素。

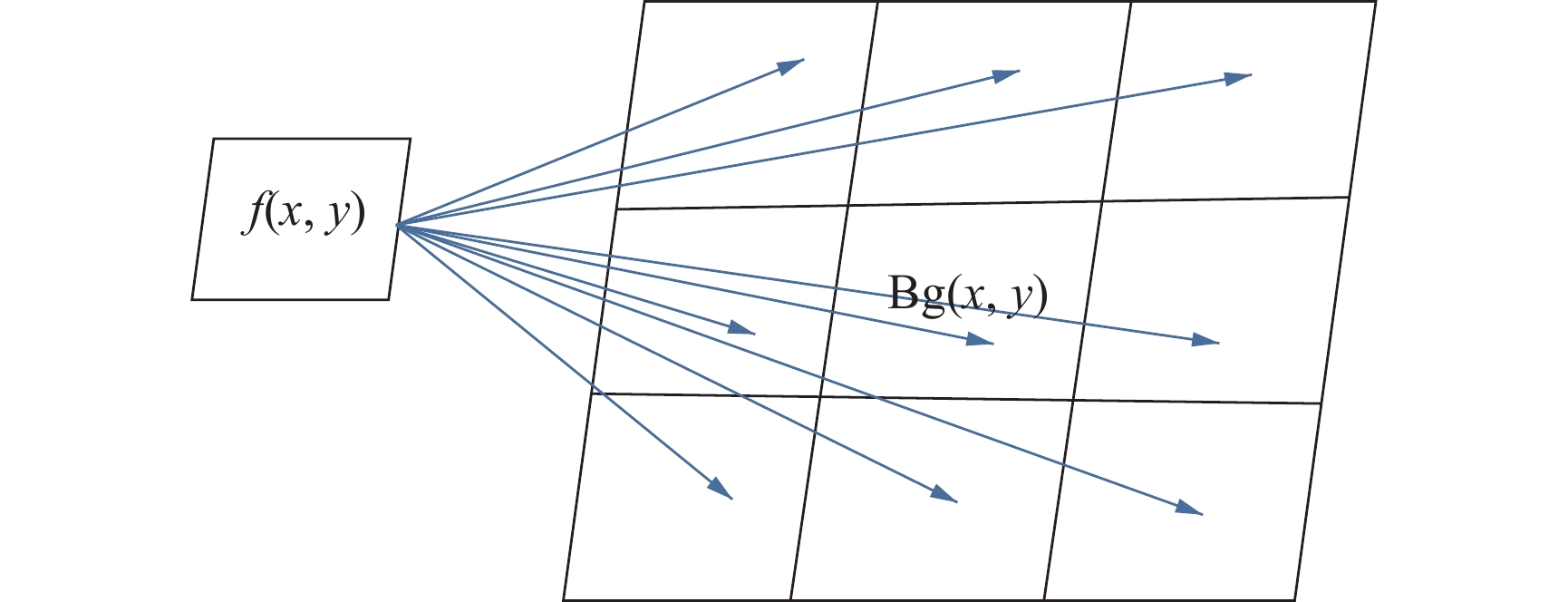

3 目标分割GMMT使用背景差分法将人体与背景分离,这样可以使算法快速地实现目标检测。传统的背景差分法只考虑了单个像素,没有考虑像素邻域的相关性。像素邻域的分布是比较相似的,可以借助像素邻域之间的相似性提高算法的鲁棒性。如图7所示为像素

|

Download:

|

| 图 7 当前像素和与其对应的空背景8邻域像素 Fig. 7 Current pixel and its corresponding empty background 8 neighborhood pixels | |

改进的背景差分法计算方法为

| $\begin{gathered} {\rm{dif}}(x,y) = \arg \min (|f(x,y) - \\ {\rm{Bg}}(x + m,y + n)|)\quad m,n = - 1,0,1 \\ \end{gathered} $ | (3) |

改进的背景差分法使像素

|

Download:

|

| 图 8 改进的背景差分法处理动态背景和消除“鬼影” Fig. 8 Improved background difference method deals with dynamic background and eliminates “ghosts” | |

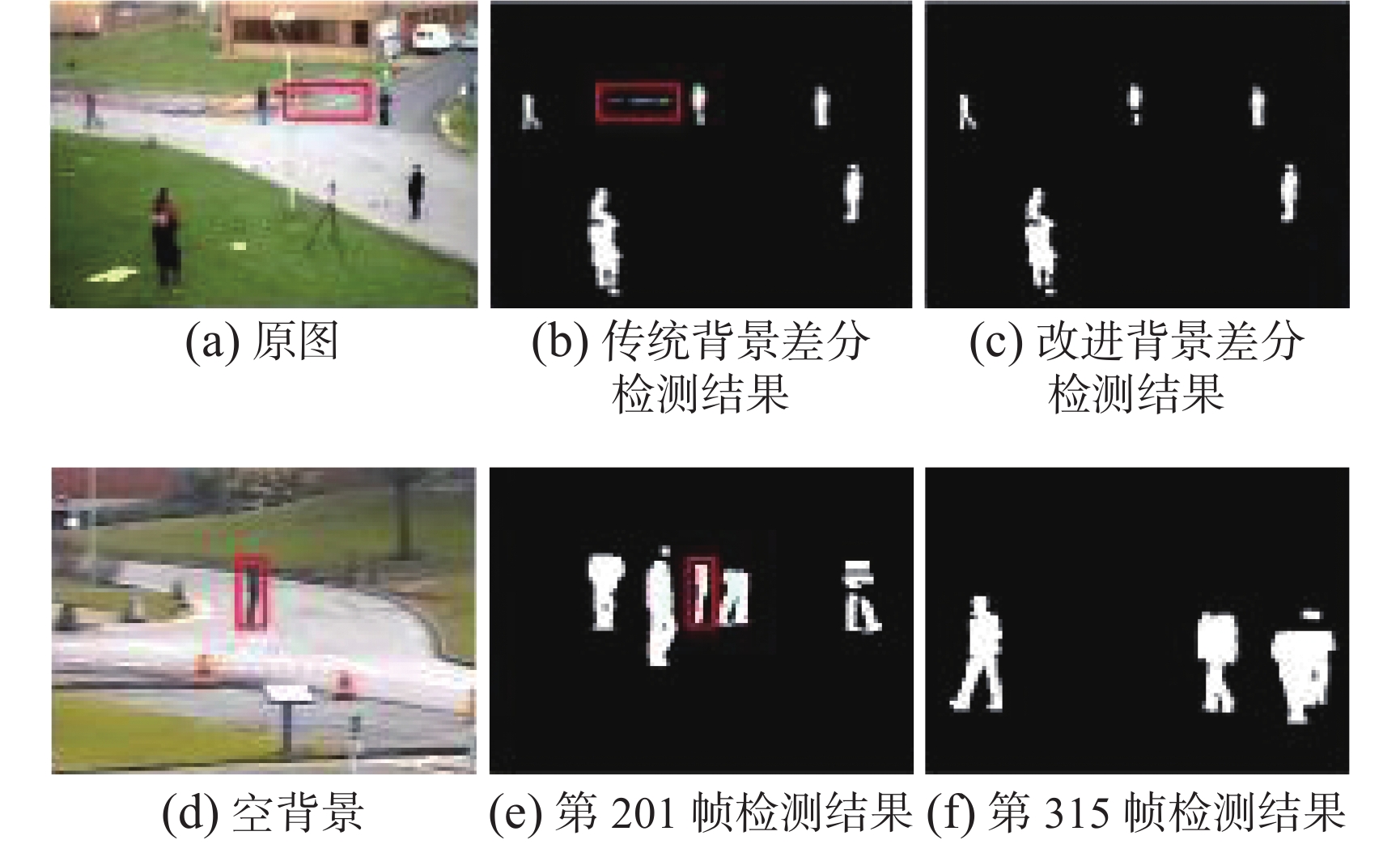

为了验证GMMT可以在建模时准确地剔除目标像素,本文与文献[21] CodeBook算法、文献[23]Vibe算法、文献[27]Subsense算法和文献[28]Pawcs算法在Dataset2012数据库、Camera- Parameter数据库和LightSwitch数据库进行比较。由于建模阶段经常在场景中出现目标,为了验证算法可以有效剔除背景模型中的目标像素,所用场景背景建模时的每一帧都存在目标。表1中为测试用的场景起始帧和测试帧在数据库中的帧位置。

| 表 1 测试场景信息 Tab.1 The information of test scenes |

从图9中每种算法在不同场景下的建模效果对比可以看出,Codebook、Vibe、Subsense和Pawcs背景模型中包含了大量的目标像素,而GMMT建立的背景模型剔除了目标像素,建立的背景更符合真实场景。

图10为算法在各场景中的检测结果,从图10中可以看出Codebook和Vibe算法在检测结果中产生了较多的“鬼影”,Subsense产生了较少的“鬼影”,Pawcs和GMMT没有产生“鬼影”。因为Subsense和Pawcs算法背景更新速度快,所以经过一段时间更新后可以消除“鬼影”,但是过快的更新会使运动缓慢或静止的目标更新进背景内,会使目标检测不完整。GMMT在背景建模阶段就消除了目标像素,使检测结果没产生“鬼影”。

|

Download:

|

| 图 9 算法在不同场景下的建模效果 Fig. 9 Modeling effect of the algorithm in different scenes | |

|

Download:

|

| 图 10 算法在不同场景中的检测结果 Fig. 10 Result of algorithms in each scene | |

“鬼影”像素为

最后,本文对各算法的运行效率进行分析。本文所用的实验环境为WIN7 64位、Inter Core i5-3230M CPU、VS2017搭配OpenCV2.4.9。如表3所示为各算法在数据库上的平均运行时间,可以看出GMMT在保证检测效果的基础上有较高的运行效率,算法复杂度较低。

| 表 2 算法在各场景的检测结果中

|

| 表 3 在数据集上不同算法处理的图像数量 Tab.3 Average number of images processed by the algorithm per second on the dataset |

GMMT算法使用双通道建模方式和改进的背景差分法实现背景建模和目标分割。通道一利用混合高斯模型预检测和拓扑结构连接分散区域的方式剔除目标像素,通道二采用多帧平均法。双通道建模保证了算法在复杂背景下完成建模并且有效地剔除目标像素抑制“鬼影”。改进的背景差分法可快速分割目标并利用邻域信息消除“鬼影”。通过与Codebook、Vibe、Subsense和Pawcs的对比,证明了GMMT算法的有效性。算法有效地抑制了 “鬼影”并且保持了较高召回率。

背景建模会受多种因素的影响,现阶段主要可以概括为4个方面:1)光照的缓慢变化和突然变化问题;2)背景会不断发生变化的动态背景问题;3)背景中物体、运动目标等形成的阴影问题;4)由视频采集设备造成的噪声问题。这些问题都会影响背景建模和目标检测的效果,所以算法需要适应多模态的背景、相机抖动和PTZ相机等复杂环境,这是以后需要努力的方向。

| [1] |

昝孟恩, 周航, 韩丹, 等. 粒子滤波目标跟踪算法综述[J]. 计算机工程与应用, 2019, 55(5): 8-17. ZAN Mengen, ZHOU Hang, HAN Dan, et al. Survey of particle filter target tracking algorithms[J]. Computer engineering and applications, 2019, 55(5): 8-17. DOI:10.3778/j.issn.1002-8331.1809-0242 (  0) 0)

|

| [2] |

李明杰, 刘小飞, 张福泉, 等. 基于粒子滤波和背景减除的多目标检测与跟踪算法[J]. 计算机应用研究, 2018, 35(8): 2506-2509. LI Mingjie, LIU Xiaofei, ZHANG Fuquan, et al. Multi target detection and tracking algorithm based on particle filtering and background subtraction[J]. Application research of computers, 2018, 35(8): 2506-2509. DOI:10.3969/j.issn.1001-3695.2018.08.067 (  0) 0)

|

| [3] |

杜鹃, 吴芬芬. 高斯混合模型的运动目标检测与跟踪算法[J]. 南京理工大学学报, 2017, 41(1): 41-46. DU Juan, WU Fenfen. Movement target tracking algorithm by using Gaussian mixture model[J]. Journal of Nanjing University of Science and Technology, 2017, 41(1): 41-46. (  0) 0)

|

| [4] |

陈聪, 杨忠, 宋佳蓉, 等. 一种改进的卷积神经网络行人识别方法[J]. 应用科技, 2019, 46(3): 51-57. CHEN Cong, YANG Zhong, SONG Jiarong, at al. An improved pedestrian detection method based on convolutional neural network[J]. Applied science and technology, 2019, 46(3): 51-57. (  0) 0)

|

| [5] |

丁哲, 陆文总. 基于Vibe背景建模的运动目标检测算法[J]. 计算机系统应用, 2019, 28(4): 187-191. DING Zhe, LU Wenzong. Moving target detection algorithm based on vibe background modeling[J]. Computer systems & applications, 2019, 28(4): 187-191. (  0) 0)

|

| [6] |

左军辉, 贾振红, 杨杰. 基于改进背景减法的视频图像运动目标检测[J]. 计算机工程与设计, 2020, 44(5): 1367-1372. ZUO Junhui, JIA Zhenhong, YANG Jie. Moving object detection in video image based on improved background subtraction[J]. Computer engineering and design, 2020, 44(5): 1367-1372. (  0) 0)

|

| [7] |

YANG Dan, ZHAO Chenqiu, ZHANG Xiaohong, at al. Background modeling by stability of adaptive features in complex scenes[J]. IEEE transactions on image processing, 2018, 27(3): 1112-1125. DOI:10.1109/TIP.2017.2768828 ( 0) 0)

|

| [8] |

MOUDGOLLYA R, MIDYA A, SUNANIYA A K, et al. Dynamic background modeling using intensity and orientation distribution of video sequence[J]. Multimedia tools and applications, 2019, 78(4): 22537-22554. DOI:10.1007/s11042-019-7575-7 ( 0) 0)

|

| [9] |

ZHOU Anran, XIE Weixin, PEI Jihong. Background modeling in the Fourier domain for maritime infrared target detection[J]. IEEE transactions on circuits and systems for video technology, 2020, 30(8): 2634-2649. DOI:10.1109/TCSVT.2019.2922036 ( 0) 0)

|

| [10] |

HUYNH-THE T, HUA C H, TU N A, et al. Locally statistical dual-mode background subtraction approach[J]. IEEE access, 2019, 7: 9769-9782. DOI:10.1109/ACCESS.2019.2891084 ( 0) 0)

|

| [11] |

DEWAN P, KUMAR R. Detection of object in motion using improvised background subtraction algorithm[C] //Proceedings of 2017 International Conference on Trends in Electronics and Informatics. Tirunelveli, India, 2017: 651−656.

( 0) 0)

|

| [12] |

刘晓芳, 周航, 韩权, 等. 基于视觉的步态识别研究综述[J]. 小型微型计算机系统, 2018, 39(8): 1685-1692. LIU Xiaofang, ZHOU Hang, HAN Quan, et al. Survey of vision-based gait recognition[J]. Journal of Chinese computer systems, 2018, 39(8): 1685-1692. DOI:10.3969/j.issn.1000-1220.2018.08.010 (  0) 0)

|

| [13] |

刘相锋, 周航. 步态识别技术及其在视频监控中的应用[J]. 电视技术, 2011, 35(1): 119-121. LIU Xiangfeng, ZHOU Hang. Gait recognition technology and application in video surveillance[J]. Video engineering, 2011, 35(1): 119-121. DOI:10.3969/j.issn.1002-8692.2011.01.034 (  0) 0)

|

| [14] |

金静, 党建武, 王阳萍, 等. 一种基于鲁棒局部纹理特征的背景差分方法[J]. 计算机工程与科学, 2017, 39(8): 1513-1519. JIN Jing, DANG Jianwu, WANG Yangping, et al. A background subtraction method based on robust local texture features[J]. Computer engineering & science, 2017, 39(8): 1513-1519. DOI:10.3969/j.issn.1007-130X.2017.08.020 (  0) 0)

|

| [15] |

孙挺, 齐迎春, 耿国华. 基于帧间差分和背景差分的运动目标检测算法[J]. 吉林大学学报(工学版), 2016, 46(4): 1325-1329. SUN Ting, QI Yingchun, GENG Guohua. Moving object detection algorithm based on frame difference and background subtraction[J]. Journal of Jilin University (Engineering and Technology Edition), 2016, 46(4): 1325-1329. (  0) 0)

|

| [16] |

SHAHBAZ A, KURNIANGGORO L, WAHYONO, et al. Recent advances in the field of foreground detection: an overview[M]//KRÓL D, NGUYEN N T, SHIRAI K. Advanced Topics in Intelligent Information and Database Systems. Cham: Springer, 2017: 261−269.

( 0) 0)

|

| [17] |

WREN C R, AZARBAYEJANI A, DARRELL T, et al. Pfinder: real-time tracking of the human body[J]. IEEE transactions on pattern analysis and machine intelligence, 1997, 19(7): 780-785. DOI:10.1109/34.598236 ( 0) 0)

|

| [18] |

YONG Hongwei, MENG Deyu, ZUO Wangmeng, et al. Robust online matrix factorization for dynamic background subtraction[J]. IEEE transactions on pattern analysis and machine intelligence, 2018, 40(7): 1726-1740. DOI:10.1109/TPAMI.2017.2732350 ( 0) 0)

|

| [19] |

STAUFFER C, GRIMSON W E L. Adaptive background mixture models for real-time tracking[C]//Proceedings of 1999 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Fort Collins, USA, 1999: 246−252.

( 0) 0)

|

| [20] |

ZIVKOVIC Z. Improved adaptive Gaussian mixture model for background subtraction[C]//Proceedings of the 17th International Conference on Pattern Recognition. Cambridge, UK, 2004: 28−31.

( 0) 0)

|

| [21] |

KIM K, CHALIDABHONGSE T H, HARWOOD D, et al. Real-time foreground–background segmentation using codebook model[J]. Real-time imaging, 2005, 11(3): 172-185. DOI:10.1016/j.rti.2004.12.004 ( 0) 0)

|

| [22] |

BARNICH O, VAN DROOGENBROECK M. ViBE: A powerful random technique to estimate the background in video sequences[C]// 2009 IEEE International Conference on Acoustics, Speech and Signal Processing. Taipei, China, 2009: 945−948.

( 0) 0)

|

| [23] |

BARNICH O, VAN DROOGENBROECK M. ViBe: a universal background subtraction algorithm for video sequences[J]. IEEE transactions on image processing, 2011, 20(6): 1709-1724. DOI:10.1109/TIP.2010.2101613 ( 0) 0)

|

| [24] |

杨丹, 戴芳. 运动目标检测的ViBe算法改进[J]. 中国图象图形学报, 2018, 23(12): 1813-1828. YANG Dan, DAI Fang. Improved ViBe algorithm for detection of moving objects[J]. Journal of image and graphics, 2018, 23(12): 1813-1828. DOI:10.11834/jig.180304 (  0) 0)

|

| [25] |

LIU Shanyi. An improved ViBe moving object detection algorithm based on spatial-temporal gradient of image[C]//Proceedings of 2016 International Conference on Progress in Informatics and Computing. Shanghai, China, 2016: 192−197.

( 0) 0)

|

| [26] |

MIN Weidong, FAN Mengdan, GUO Xiaoguang, et al. A new approach to track multiple vehicles with the combination of robust detection and two classifiers[J]. IEEE transactions on intelligent transportation systems, 2018, 19(1): 174-186. DOI:10.1109/TITS.2017.2756989 ( 0) 0)

|

| [27] |

ST-CHARLES P L, BILODEAU G A, BERGEVIN R. SuBSENSE: a universal change detection method with local adaptive sensitivity[J]. IEEE transactions on image processing, 2015, 24(1): 359-373. DOI:10.1109/TIP.2014.2378053 ( 0) 0)

|

| [28] |

ST-CHARLES P L, BILODEAU G A, BERGEVIN R. Universal background subtraction using word consensus models[J]. IEEE transactions on image processing, 2016, 25(10): 4768-4781. DOI:10.1109/TIP.2016.2598691 ( 0) 0)

|

| [29] |

朱海滨. 网络拓扑发现技术探析[J]. 网络安全技术与应用, 2017(3): 26-27. ZHU Haibin. Analysis of network topology discovery technology[J]. Network security technology & application, 2017(3): 26-27. DOI:10.3969/j.issn.1009-6833.2017.03.019 (  0) 0)

|

2021, Vol. 16

2021, Vol. 16