随着科技的飞速发展,当今社会已迎来新的智能时代,智能交通系统为智能城市的发展创造了重要条件,智能交通系统的道路交通信息来源于拍摄设备上传的道路交通图片。由于拍摄设备抖动或是车辆在行驶的过程中采集到的图像会有不同程度的运动模糊,这给道路交通管理带来了极大的不便。同时,在自动驾驶中,控制中心是根据车载摄像头拍摄到的道路交通图像来规划行驶路线,以减轻驾驶员的操作疲劳程度。由于道路中的物体运动,会造成所拍摄到的图像模糊。将增强的图像应用在自动驾驶感知模块,可以增强自动驾驶的容错力。因此,研究道路交通运动模糊图像的增强对智能城市的进步与发展有着重要的现实意义。

运动模糊图像IB通常可以理解为清晰图像IS和某个模糊核K的卷积加上噪声N作用的结果[1],用数学模型可以表达为

目前针对道路交通场景下的运动模糊图像增强的深度学习研究较少,而道路交通运动模糊图像的增强有重要价值。为提高道路交通模糊图像增强的质量,本文提出了一种基于生成式对抗网络的多尺度提取图像特征值多路径学习的模型。模型通过多尺度卷积核神经网络来进行特征值提取,采用多路径模式下的局部残差学习与全局残差学习相结合,进行多权重的递归学习,判别网络和生成网络间的对抗训练,最后利用生成网络生成清晰图像。

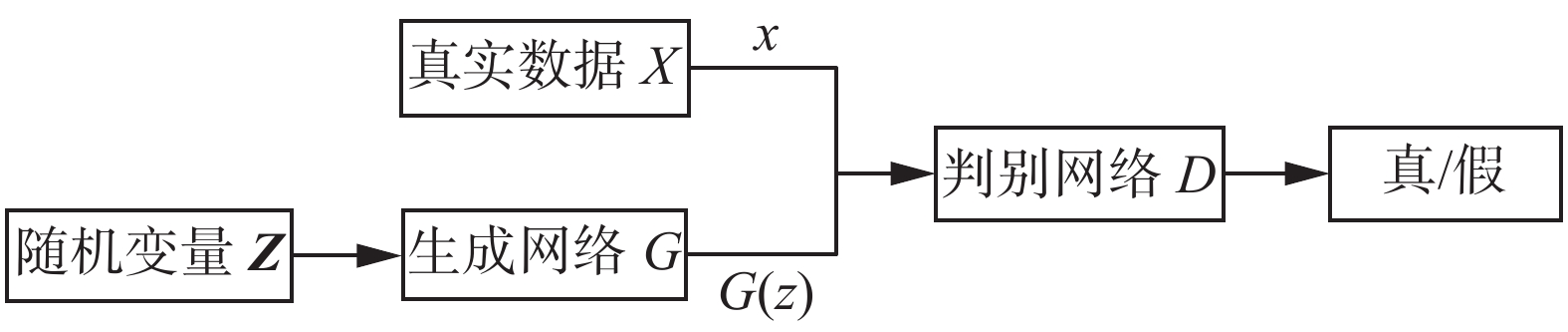

1 生成式对抗网络生成式对抗网络(generative adversarial network, GAN)是由Goodfellow等[16]于2014年设计的一种生成式模型,其核心思想是二人零和博弈,生成式对抗网络模型是由一个生成网络G和一个判别网络D组成。生成网络G通过不断学习真实数据的概率分布,利用学习到的分布模型生成新的数据。判别网络D的作用是将真实数据与生成网络G生成的数据区别开。判别网络能使生成网络在没有较多的图像先验知识的情况下仍然可以很好地去学习真实数据,生成网络与判别网络进行对抗训练相互进行参数优化,提高各自的生成和判别能力,最终使通过生成网络生成的数据可以与真实数据十分相近。生成式对抗网络原始模型框架如图1所示。

|

Download:

|

| 图 1 GAN结构 Fig. 1 GAN structure | |

随机噪声向量

生成网络G的损失函数为

| $\mathop {\min }\limits_G \left( {D,G} \right) = {{\rm E}_{{{\rm{z}}_\sim}{{{p}}_{\rm{z}}}(z)}}[{\rm{log}}(1 - D(G(z)))]$ | (1) |

判别网络D的损失函数为

| $\begin{array}{c} \mathop {\max }\limits_D V\left( {D,G} \right) = {{\rm E}_{_{x\sim}{{{p}}_{{\rm{data}}}}(x)}}[\log (D(x)) +\\ {{\rm E}_{{{\rm{z}}_\sim}{{{P}}_{\rm{z}}}(z)}}[(1 - D(G(z)))]] \\ \end{array} $ | (2) |

模型的总体损失函数为

| $\begin{array}{c} \mathop {\min }\limits_G \mathop {\max }\limits_D V\left( {D,G} \right) = {{\rm E}_{_{x\sim}{{{p}}_{{\rm{data}}}}(x)}}[\log (D(x)] J+ \\ {{\rm E}_{{{\rm{z}}_\sim}{{{p}}_{\rm{z}}}(z)}}[1 - D(G(z))] \\ \end{array} $ | (3) |

式中:

在最开始的生成式对抗网络研究中,输入的是随机噪声,经生成网络映射成图像,随着生成式对抗网络的发展,后来越来越多的研究采用图像[13-14,17-18]或者视频[19-20]输入代替噪声输入,这使得生成网络的生成质量和效率得到了进一步提升。

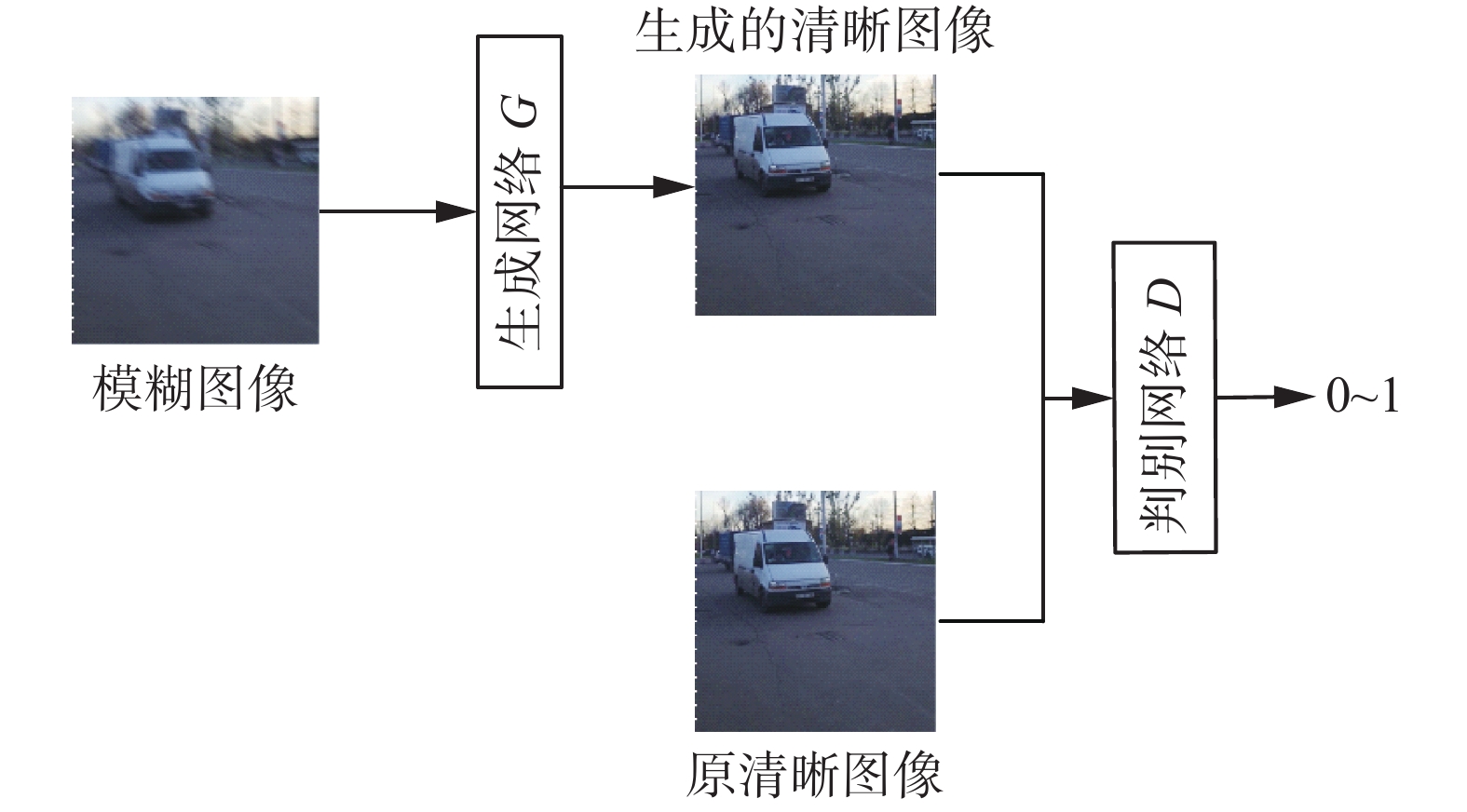

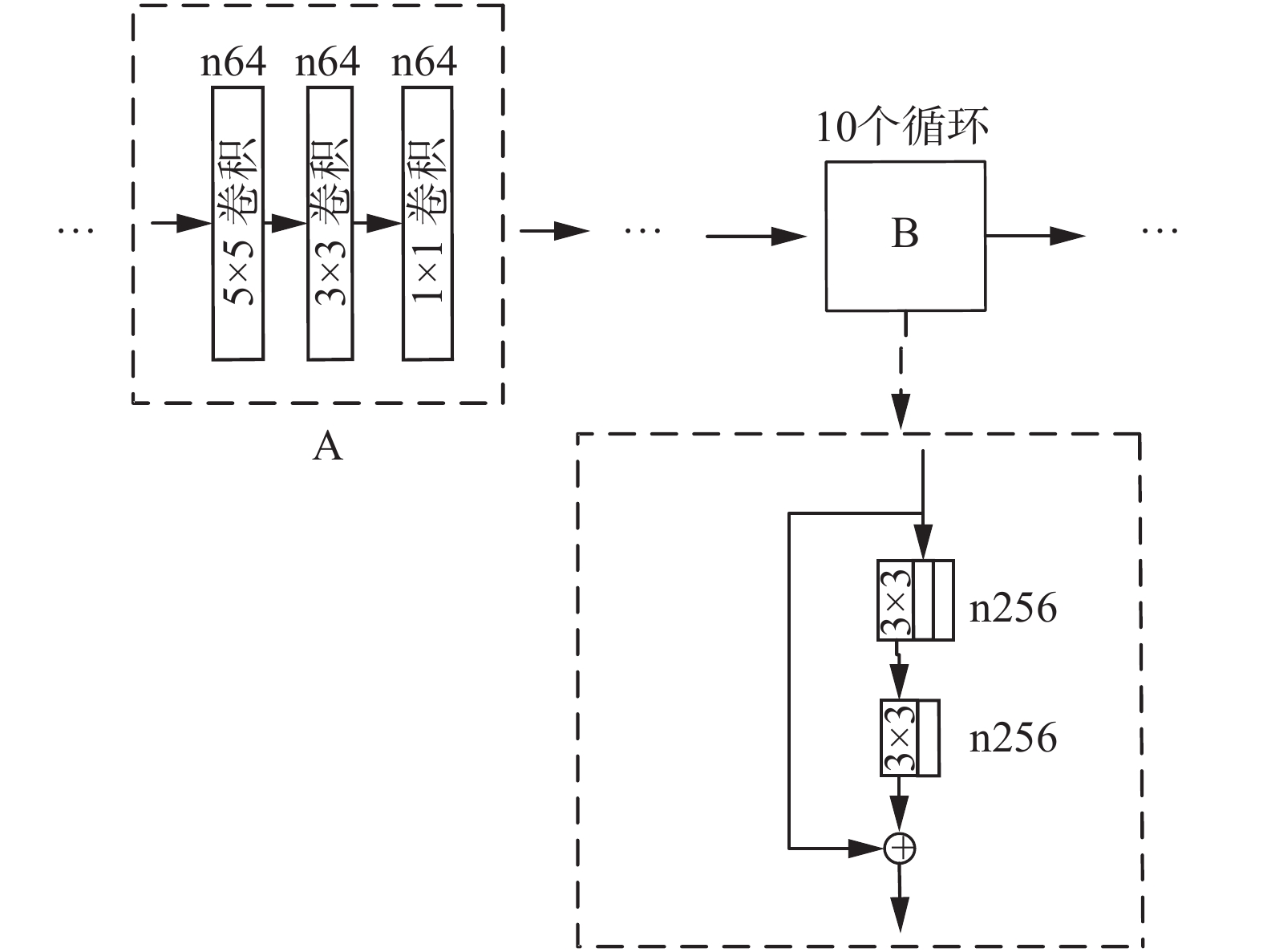

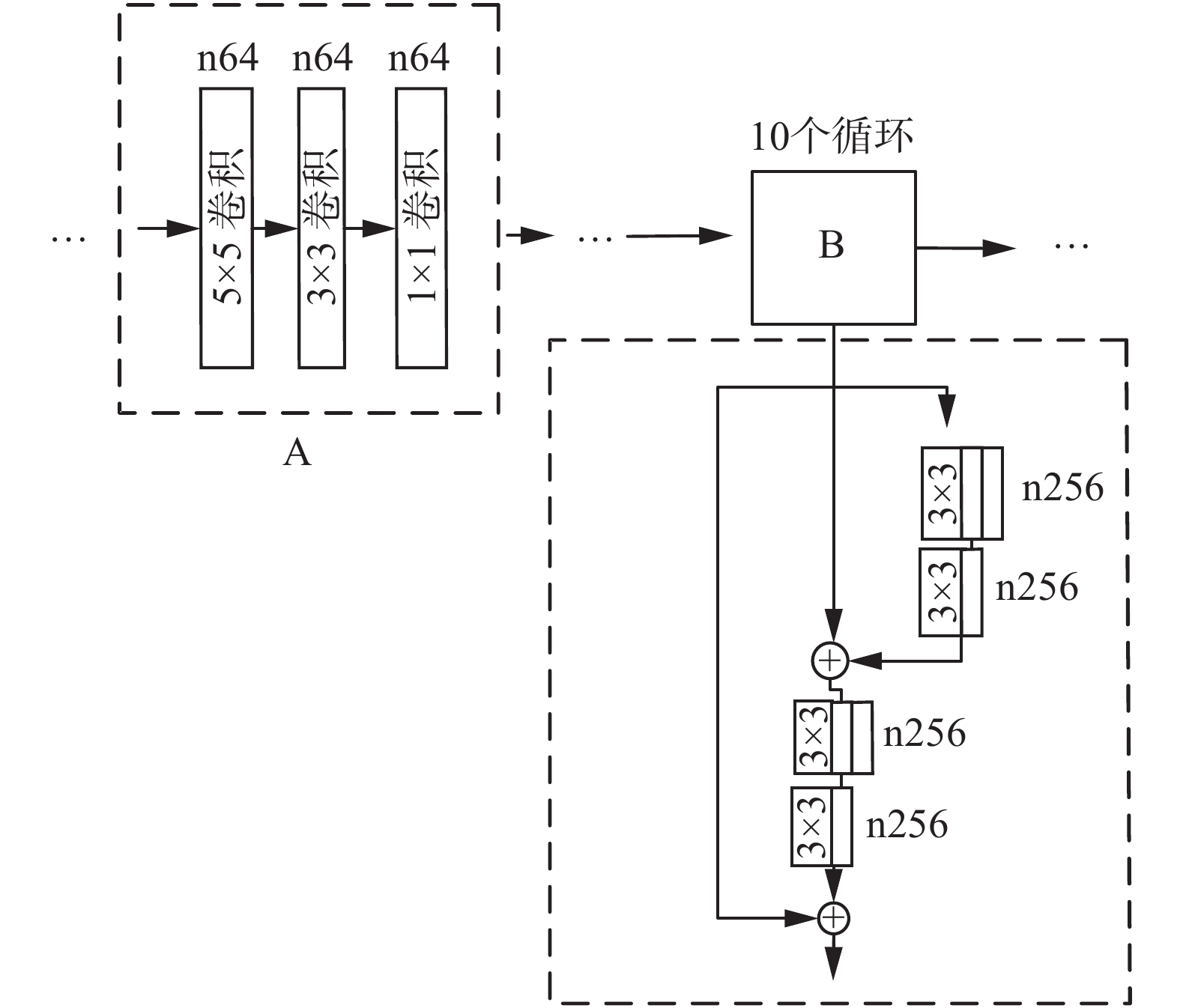

2 基于生成式对抗网络的多尺度多路径模型 2.1 网络结构设计本文提出的模型整体框架图如图2所示。为了更好地提取出图像数据信息,本文在设计生成网络中,主要有2个创新点:1)采用多尺度卷积核神经网络进行特征值提取;2)使多路径模式的局部残差学习与全局残差学习相结合,进行多权重的递归学习。利用多尺度卷积核提取特征值的本质是使用不同尺寸的卷积核对图像进行卷积操作,从而获得图像在不同尺度下采集到的不同类型的特征信息,因而能提取到更加丰富和细腻的特征信息。多路径模式下的局部与全局学习相结合,采用多权重的递归学习,实现各卷积层的参数共享,深浅层特征融合,采用残差学习,提高了网络的性能。这些都有利于使模糊增强图像更加清晰和细节更加丰富。本文生成网络框架如图3所示。

|

Download:

|

| 图 2 本文提出模型的整体框架 Fig. 2 Overall framework of the proposed model | |

|

Download:

|

| 图 3 本文提出的生成网络框架 Fig. 3 Diagram of the framework of the generated network | |

图3中:A部分为多尺度神经网络;B部分为1个多路径模式下的学习;instanceNorm和convTranspose分别代表归一化和反卷积层;n为通道数;s为步长;tanh和relu是激活函数。本文提出的生成网络框架图包含一个卷积核尺寸为7×7×64的卷积,步长为1,多尺度卷积的卷积核尺寸分别为5×5×64、3×3×64、1×1×64,步长为1,卷积融合后进行instanceNorm和relu处理,之后进行卷积核尺寸为3×3×128、3×3×256的卷积处理,步长为2,每步卷积跟随instanceNorm和relu处理,随后进入步长为1、卷积核为3×3×256的多路径模式的局部残差学习与全局残差学习,每步卷积跟随instanceNorm和relu处理,经过循环学习5次后,进行两次步长为2、卷积核为3×3×128和3×3×64的反卷积操作,每步反卷积跟随instanceNorm和relu处理,最后进行一次卷积核为7×7×64的卷积和tanh操作。

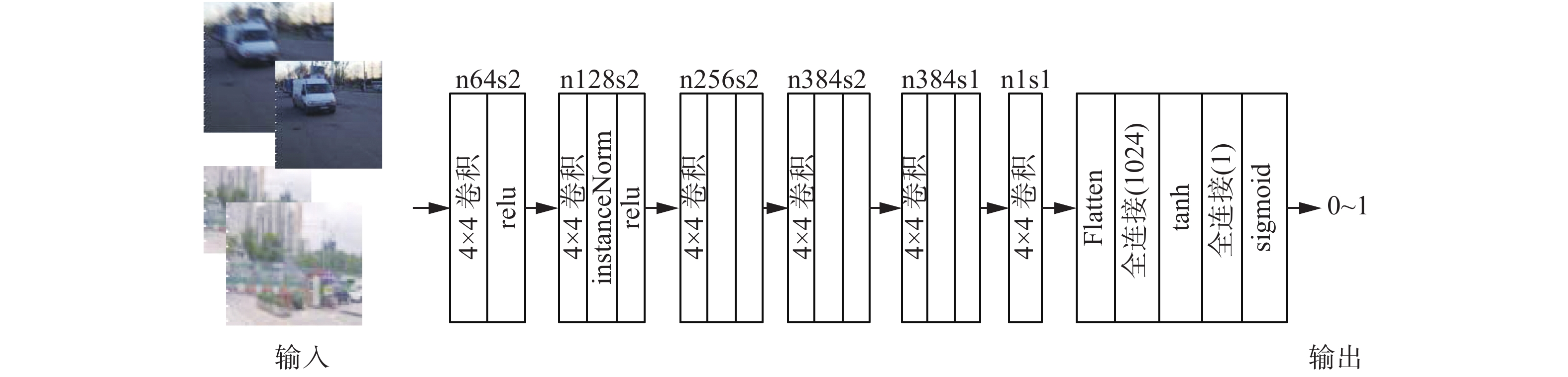

为充分考虑到像素间的联系,选用了PathcGAN[21]作为判别网络,其每次只输入N×N个像素点,然后让判别器对这N×N个像素点判断其是否为真,采用类似CNN滑窗的方法得到每个N×N框的判别器输出值,将这些输出值进行平均得到最后判别器的输出结果。本文采用的判别网络框架结构如图4所示。

|

Download:

|

| 图 4 判别网络框架 Fig. 4 Framework of the discriminant network | |

sigmoid是激活函数。生成网络生成的清晰图像和原清晰图像输入判别网络,先进行步长为2、卷积核为4×4×64的卷积,跟随relu处理,之后依次经过步长为2、卷积核为4×4×128、4×4×256、4×4×384的卷积,再进行一个步长为1、卷积核为4×4×384的卷积,每步卷积跟随instanceNorm和relu处理,接着经过步长为1、卷积核为4×4×1的一次卷积,经flatten、全连接1、tanh、全连接2、sigmoid操作后产生0~1之间的值。

2.2 损失函数本文的损失函数由两部分构成,即对抗网络损失

为使训练过程更好地收敛,采用的是WGAN-GP[17]中的对抗网络损失,对每个样本独立地施加梯度惩罚,损失函数为

| $\begin{array}{c} {L_{{\rm{adv}}}} = {{\rm{E}}_{{{{z}}_\sim}{{{p}}_{\rm{z}}}(z)}}D(G(z)) - {{\rm{E}}_{_{x\sim}{{{P}}_{{\rm{data}}}}(x)}}(D(x)) + \\ \lambda {{\rm{E}}_{{\partial _\sim}{{{p}}_\partial }}}[{(||{\nabla _\partial }D(\partial )|{|_2} - 1)^2}] \\ \end{array} $ | (4) |

式中:

采用感知损失[18]来帮助恢复图像内容,感知损失是基于生成和目标图像特征映射的差异。它定义为

| ${L_{\rm{c}}} = \frac{1}{{{\rm{ }}{W_{i,j}}{\rm{ }}{H_{i,j}}}}\sum\limits_{x = 1}^{{\rm{ }}{W_{i,j}}} {\sum\limits_{y = 1}^{{\rm{ }}{H_{i,j}}} {{{\left( {{\varphi _{i,j}}{{\left( {{I_S}} \right)}_{x,y}}{\rm{ - }}{\varphi _{i,j}}{{\left( {G\left( {{I_B}} \right)} \right)}_{x,y}}} \right)}^{\rm{2}}}} }\\ $ | (5) |

先使用ImageNet进行预训练VGG19,其中

模型的总体损失函数为

| ${L_{{\rm{loss}}}} = {L_{{\rm{adv}}}} + \beta {L_{\rm{c}}}$ | (6) |

现有公开的道路交通模糊图像数据库较少,为了更好地训练本文的模型,我们从网络图像库、GoPro数据集搜集了3000对图像组成了数据集,每一对图像包含一张模糊图和与之对应的清晰图像。所有数据集图像都是道路交通场景下的图像,图像中包含道路、行人、车辆等,其中的2 000对模糊清晰图像对作为模型的训练集,剩下的1000对作为测试集。在输入神经网络模型之前,将图像对的分辨率大小设置为256×256。

3.2 质量评价图像的质量评价方法主要分为两种:一种是主观评价,另一种是客观评价。主观评价依靠的是观察者的视觉效果来反映图像的质量,客观评价是通过数学模型定性地评价图像质量。本文采用的是客观评价中常用的2种图像质量评价方法,即峰值信噪比(PSNR)和结构相似度(SSIM),实验结果数据取的是全部测试图像的平均值。峰值信噪比是通过计算对应像素点间的误差来判断图像质量的好坏,其值越高表示失真越小,说明图像与原图越接近。结构相似度是将感知误差的度量转移到对感知结构失真的度量,其值越大越好。

3.3 网络训练本文的模型是建立在pycharm平台上,采用深度学习Keras框架实现,选用自适应矩估计(ADAM)算法来优化损失函数。通过训练数据不断更新神经网络权重,经过多次训练调优,学习率α定为0.0001,β1=0,β2=0.9。采用道路交通模糊图像作为直接输入,每50对图像为一次训练,设置的最大迭代次数为1000,实验步骤如下:

1)先固定生成网络G,不使生成网络G的参数更新,使用原清晰图像训练判别网络D,5次迭代训练保存1次参数。

2)用生成网络G生成的清晰图像,使用生成得到的清晰图像训练判别网络D,5次迭代训练保存1次参数。

3)固定判别网络D,不使判别网络D的参数更新,使用损失训练生成网络G,5次迭代训练保存1次参数。

4)重复1)~3),直到生成网络G可以生成判别网络D分辨不出的图像。

为证明本文提出的多尺度多路径模型的优越性,设置了3个对照模型,命名为模型b、模型c和模型d,模型主要区别在图3生成网络的A和B两部分,A部分网络分为多尺度和非多尺度卷积,B部分网络分为多路径和链模式学习,用“√”表示模型中含此部分,模型分类如表1所示。

| 表 1 模型分类 Tab.1 Model classification |

模型b与本文提出的网络模型的不同点是:模型b的A部分网络结构使用卷积核为5×5、3×3、1×1的卷积依次卷积,B部分网络结构采用链模式的局部残差学习,具体模型结构如图5所示。

|

Download:

|

| 图 5 模型b生成网络框架 Fig. 5 Framework of model b generation network | |

模型c与本文提出的网络模型的不同点是:模型c的A部分网络结构使用卷积核为5×5、3×3、1×1的卷积依次卷积,B部分网络结构采用多路径模式的局部残差学习与全局残差学习相结合,进行多权重的递归学习,具体不同点的模型结构如图6所示。

|

Download:

|

| 图 6 模型c生成网络框架 Fig. 6 Framework of model c generation network | |

模型d与本文提出的网络模型的不同点是:模型d的A部分网络结构使用卷积核为5×5、3×3、1×1的多尺度卷积,B部分网络结构采用链模式的局部残差学习,具体不同点的模型结构如图7所示。

|

Download:

|

| 图 7 模型d生成网络框架 Fig. 7 Framework of model d generation network | |

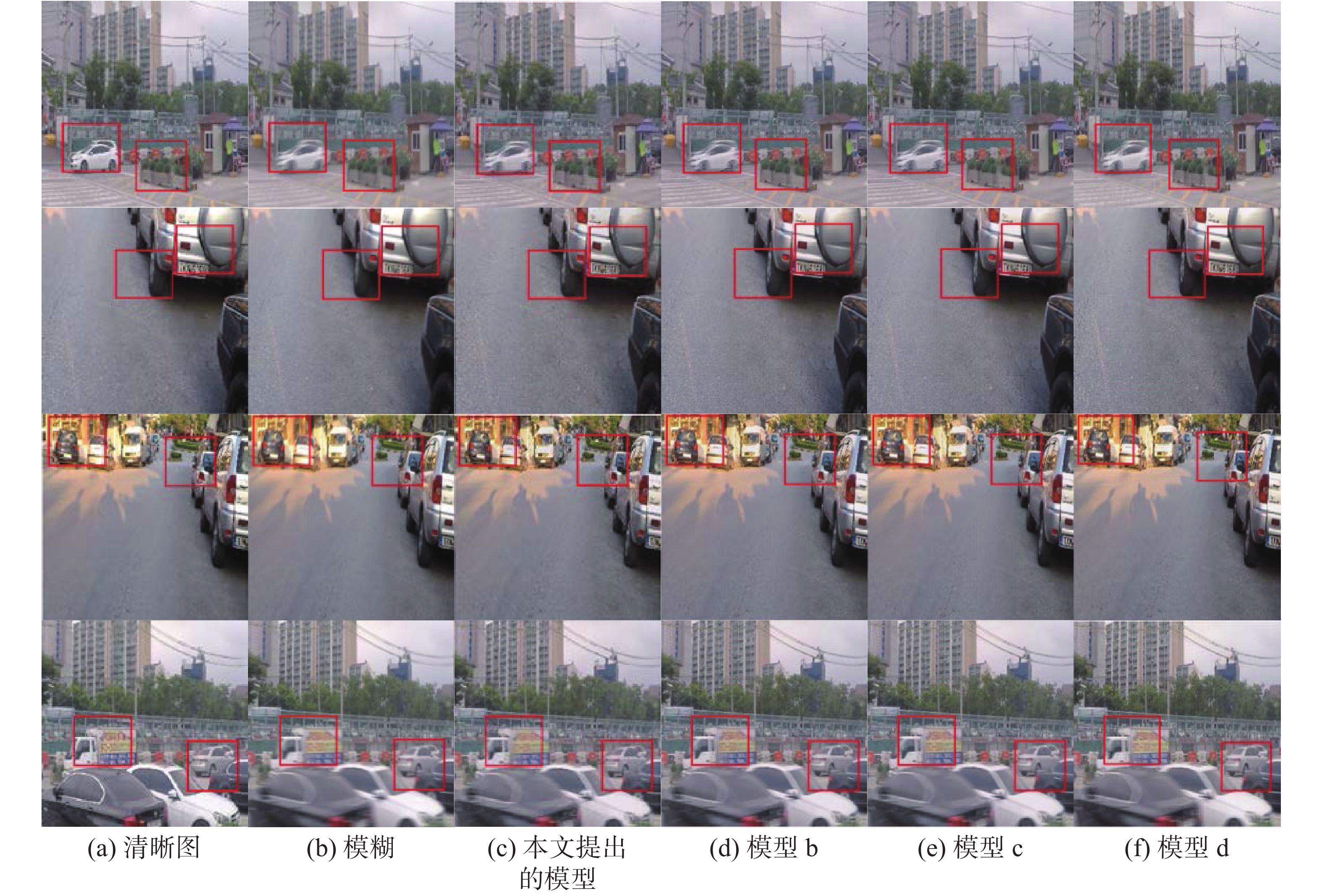

首先使用本文自建的数据集分别对本文提出的模型、模型b、模型c、模型d进行了对照实验,实验结果如表2所示,图8是选取了测试集中的4幅图像的实验效果图。

| 表 2 图像质量评价结果 Tab.2 Results of image quality evaluations |

|

Download:

|

| 图 8 实验结果对比图 Fig. 8 Comparison of experimental results | |

从图8中可以看到本文算法模型处理后的图像更加细腻,边缘的细节较清晰。由表2的图像质量评价结果的数据可以看出,本文算法模型的峰值信噪比(PSNR)是27.27,结构相似度(SSIM)是0.8991,PSNR和SSIM皆高于模型b、模型c和模型d的峰值信噪比和结构相似度,证明了本文提出网络结构的有效性。

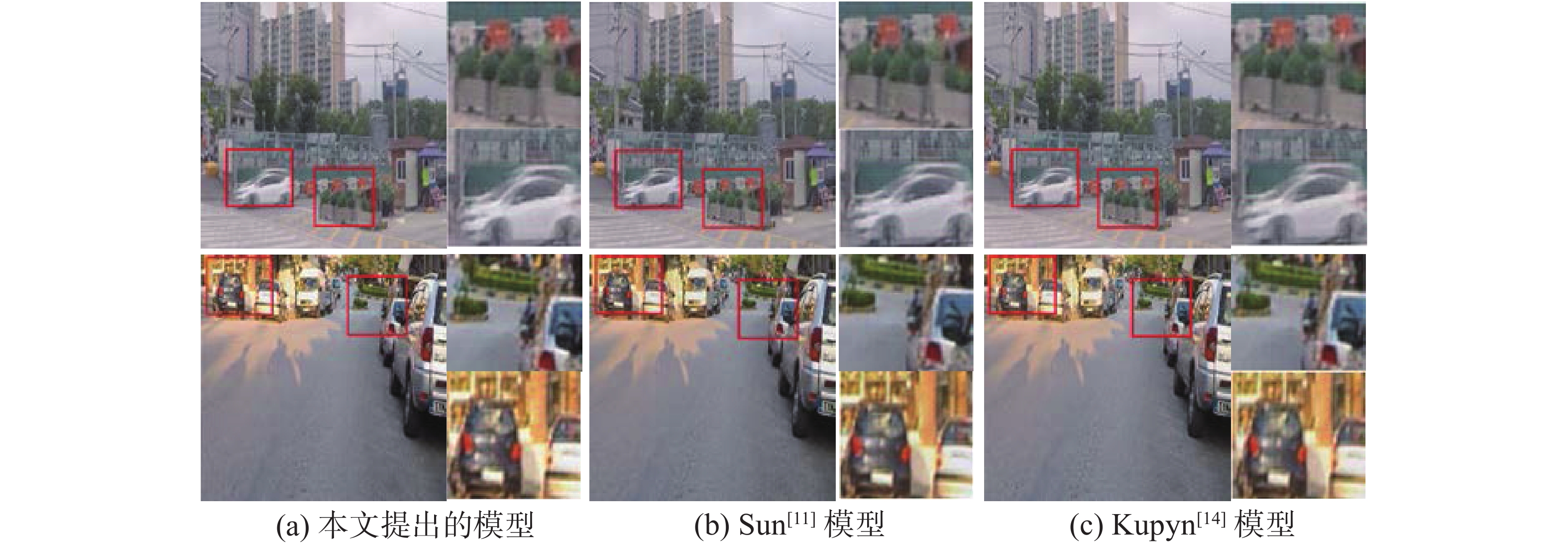

为说明本文提出模型的优越性,我们对Sun等[11]及Kupyn等[14]提出的模型进行了对比实验,使用上述本文自建的数据集,实验结果如表3所示,图9是选取了测试集中4幅图像的实验效果图。

| 表 3 图像质量评价结果 Tab.3 Results of image quality evaluations |

|

Download:

|

| 图 9 与其他模型对比结果 Fig. 9 Comparison with other models | |

从图9中可以看到,Sun等[11]的方法在处理图像边缘模糊增强时,效果不是很好,细节不够丰富,文献[11]和文献[14]的方法都会出现失真,而经本文模型处理后的图像在主观的视觉感受方面取得了较好的效果。从表3中可以看到,Sun等[11]提出的模型峰值信噪比为24.81,Kupyn等[14]提出的模型峰值信噪比为26.31,而本文提出的模型的峰值信噪比达到了27.27,同时本文提出的模型的结构相似度达到了0.8991,皆高于另外两个模型的结构相似度。因此,本文算法模型无论是从峰值信噪比还是从结构相似度上来看都要优于其他的算法。

4 结束语针对道路交通场景下的模糊图像,基于生成式对抗网络,本文提出了一个利用多尺度提取图像特征值多路径学习的模型,通过判别网络和生成网络间的对抗训练,端到端生成清晰图像。经过实验表明,生成图像的细节更加丰富,无论是主观还是客观,本文提出的模型针对道路交通场景下的模糊图像增强,都取得了较好的效果。虽然实验证明了该算法的优越性,但是生成图像与原始图像相比还存在差距,仍需要进一步优化网络结构和调整参数。

| [1] |

陈春雷, 叶东毅, 陈昭炯. 多局部模糊核融合的图像盲去模糊算法[J]. 光子学报, 2018, 47(10): 205-215. CHEN Chunlei, YE Dongyi, CHEN Zhaojiong. Blind image deblurring via multi-local kernels’ fusion[J]. Acta photonica sinica, 2018, 47(10): 205-215. DOI:10.3788/gzxb20184710.1010002 (  0) 0)

|

| [2] |

BAHAT Y, EFRAT N, IRANI M. Non-uniform blind deblurring by reblurring[C]//Proceedings of 2017 IEEE International Conference on Computer Vision. Venice, Italy, 2017: 3306−3314.

( 0) 0)

|

| [3] |

CHAN T F, WONG C K. Total variation blind deconvolution[J]. IEEE transactions on image processing, 1998, 7(3): 370-375. DOI:10.1109/83.661187 ( 0) 0)

|

| [4] |

CHO S, LEE S. Fast motion deblurring[J]. ACM transactions on graphics, 2009, 28(5): 1-8. ( 0) 0)

|

| [5] |

XU Li, JIA Jiaya. Two-phase kernel estimation for robust motion deblurring[C]//Proceedings of the 11th European Conference on Computer Vision. Crete, Greece, 2010: 157−170.

( 0) 0)

|

| [6] |

XU Li, ZHENG Shicheng, JIA Jiaya. Unnatural l0 sparse representation for natural image deblurring[C]//Proceedings of 2013 IEEE Conference on Computer Vision and Pattern Recognition. Portland, USA, 2013: 1107−1114.

( 0) 0)

|

| [7] |

GOLDSTEIN A, FATTAL R. Blur-kernel estimation from spectral irregularities[C]//Proceedings of the 12th European Conference on Computer Vision. Florence, Italy, 2012: 622−635.

( 0) 0)

|

| [8] |

PAN Jinshan, HU Zhe, SU Zhixun, et al. Deblurring text images via l0-regularized intensity and gradient prior[C]//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, USA, 2014: 2901−2908.

( 0) 0)

|

| [9] |

PAN Jinshan, SUN Deqing, PFISTER H, et al. Blind image deblurring using dark channel prior[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 1628−1636.

( 0) 0)

|

| [10] |

SCHULER C J, HIRSCH M, HARMELING S, et al. Learning to deblur[J]. IEEE transactions on pattern analysis and machine intelligence, 2016, 38(7): 1439-1451. DOI:10.1109/TPAMI.2015.2481418 ( 0) 0)

|

| [11] |

SUN Jian, CAO Wenfei, XU Zongben, et al. Learning a convolutional neural network for non-uniform motion blur removal[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA, 2015: 769−777.

( 0) 0)

|

| [12] |

XIAO Lei, WANG Jue, HEIDRICH W, et al. Learning high-order filters for efficient blind deconvolution of document photographs[C]//Proceedings of the 14th European Conference on Computer Vision. Amsterdam, The Netherlands, 2016: 734−749.

( 0) 0)

|

| [13] |

NAH S, KIM T H, LEE K M. Deep multi-scale convolutional neural network for dynamic scene deblurring[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 257−265.

( 0) 0)

|

| [14] |

KUPYN O, BUDZAN V, MYKHAILYCH M, et al. DeblurGAN: blind motion deblurring using conditional adversarial networks[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, USA, 2018: 8183−8192.

( 0) 0)

|

| [15] |

MIRZA M, OSINDERO S. Conditional generative adversarial nets[J/OL]. [2019 –03 –29].https: //arxiv.org/abs/1411.1784.

( 0) 0)

|

| [16] |

GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems. Cambridge, USA, 2014: 2672−2680.

( 0) 0)

|

| [17] |

GULRAJANI I, AHMED F, ARJOVSKY M, et al. Improved training of Wasserstein GANs[C]//Proceedings of 31st Annual Conference on Neural Information Processing Systems. Long Beach, USA, 2017: 5769−5779.

( 0) 0)

|

| [18] |

JOHNSON J, ALAHI A, LI Feifei. Perceptual losses for real-time style transfer and super-resolution[C]//Proceedings of the 14th European Conference on Computer Vision. Amsterdam, The Netherlands, 2016: 694−711.

( 0) 0)

|

| [19] |

KIM T H, LEE K M, SCHÖLKOPF B, et al. Online video deblurring via dynamic temporal blending network[C]//Proceedings of 2017 IEEE International Conference on Computer Vision. Venice, Italy, 2017: 4058−4067.

( 0) 0)

|

| [20] |

SU Shuochen, DELBRACIO M, WANG Jue, et al. Deep video deblurring for hand-held cameras[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 237−246.

( 0) 0)

|

| [21] |

ISOLA P, ZHU Junyan, ZHOU Tinghui, et al. Image-to-image translation with conditional adversarial networks[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, USA, 2017: 5967−5976.

( 0) 0)

|

2020, Vol. 15

2020, Vol. 15