可见光遥感影像中的舰船识别是遥感信息处理应用的一个热点研究问题,在敌情监测、战略部署以及船只监控等方面发挥着重要作用。其中,近岸舰船的细粒度识别问题更具有挑战性,相关研究也较少,相比于远海区域的舰船目标,近岸舰船目标的识别存在着以下难点:近岸舰船目标所处的海陆背景环境更加复杂;近岸舰船目标短边尺度较小,准确定位较为困难;近岸舰船往往并排停靠,难以有效地进行实例分离;不同类别的近岸舰船目标在颜色和纹理上具有很高的相似性,要实现细粒度的舰船类别分类有较高的挑战性。

传统的舰船识别算法往往借助于严格的先验知识以及人工设计的复杂特征,其中文献[1]通过对直线段进行分析和组合实现了舰船目标检测,但容易受陆地上建筑物和道路等的干扰;雷琳等[2]提出利用Hausdorff距离来衡量候选目标轮廓与给定舰船模板的相似性,并通过滑动窗口来搜索舰船目标,但该方法受限于舰船模板的单一性而难以检测种类多样的近岸舰船目标;文献[3]利用形状、纹理和长宽比等人工特征,使用支持向量机实现了5类舰船目标的识别,但人工特征表达能力较弱故无法完成细粒度的舰船目标分类,同时也难以与已有的舰船检测方法相结合实现端到端的识别。

基于深度学习的方法凭借优异的特征提取能力,得到了人们的广泛关注,其中,Lin等[4]基于语义分割的框架利用全卷积网络将遥感影像分割为海洋、陆地、船身和船头尾4类,最后采用后处理方法来完成舰船区域的提取,该方法需要繁杂的数据标注,同时也不能实现舰船类别的识别;Yang等[5]改进了任意方向的深度目标识别算法,提出了密集连接的多尺度特征金字塔融合网络实现了端到端的舰船检测,取得了一定的效果,但也没有实现舰船目标的细粒度识别。

近年来,基于对抗学习的深度生成模型得到了广泛关注[6],在遥感信息处理方面也得到了应用,Xu等[7]利用生成对抗网络来生成样本辅助遥感影像的场景分类。在自然场景目标识别方面,Wang等[8]利用对抗学习的方法生成遮挡掩码来增强识别网络对目标遮挡、变形等的鲁棒性。由于近岸舰船目标中的部分类别往往存在样本不足的问题,限制了网络的细粒度分类能力,通过引入生成对抗网络可以实现数据增强,辅助分类器探索数据的流形分布,有利于最大化分类间隔从而提升类别判别能力,但目前还没有相关的研究。

本文针对近岸舰船目标细粒度识别的问题,提出了一个基于深度学习的舰船识别框架。该算法能够输出倾斜边界框从而实现更精确的舰船定位;采用了级联的独立分类子网络来完成细粒度的舰船识别,可以避免多任务学习的方式对分类任务的影响;然后利用一种对抗学习的方法,通过引入生成样本来进一步增强分类子网络的类别判别能力;最后在多类别的舰船目标数据集上进行了对比试验,结果表明,本文设计的新算法可以有效提升舰船目标的平均识别精度。

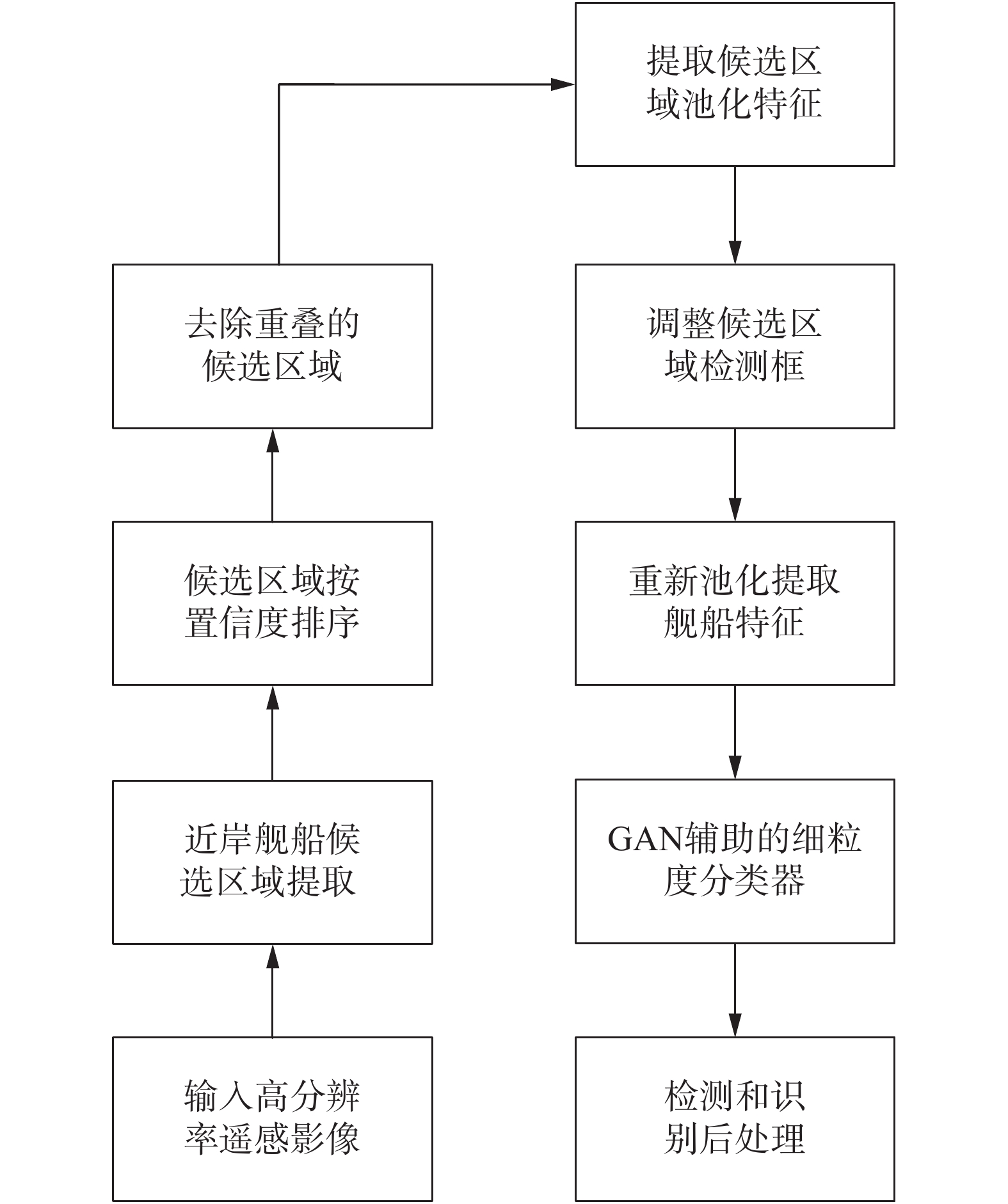

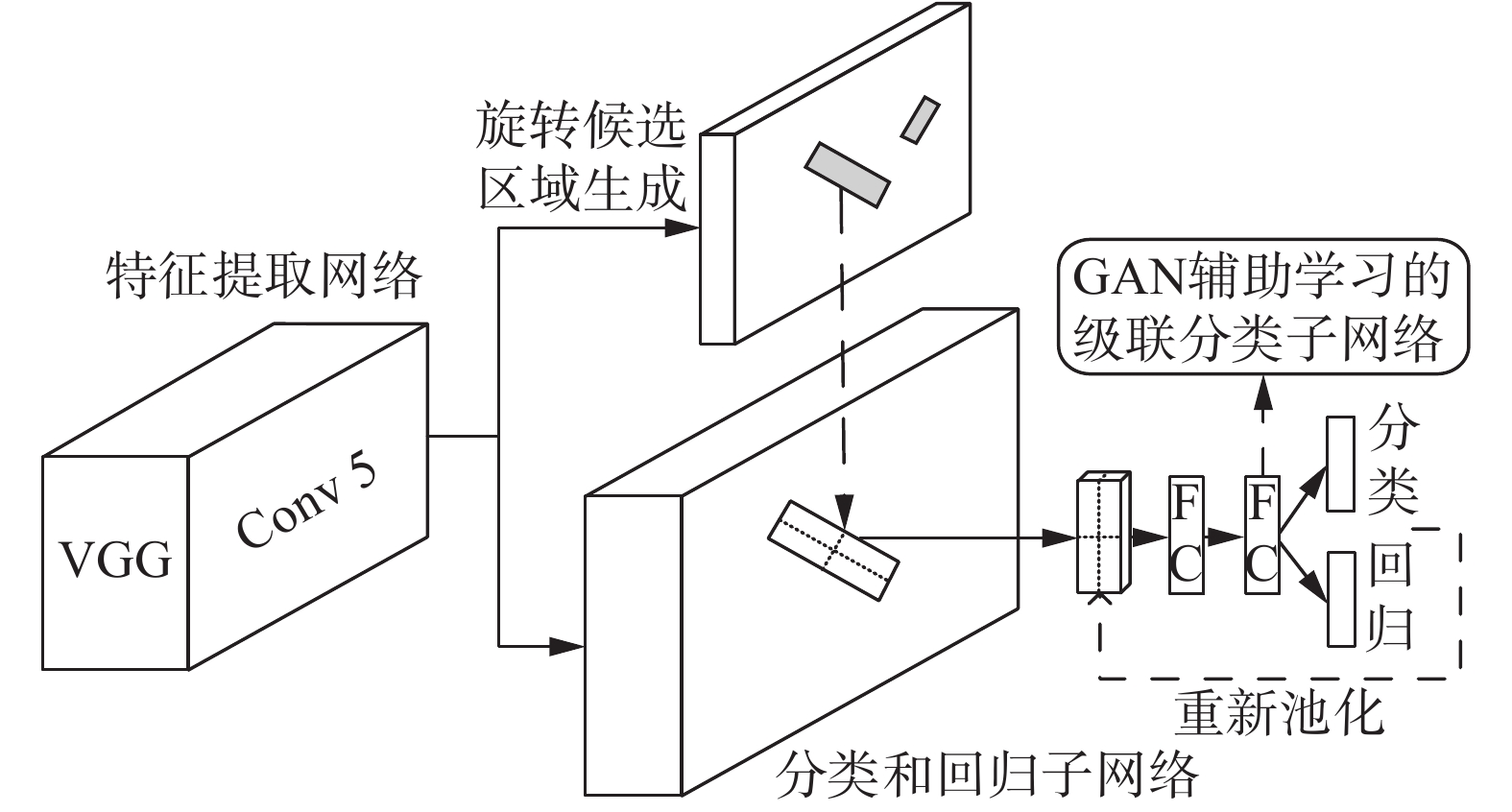

1 算法基本框架本文算法的主要流程如图1所示,首先针对舰船目标角度分布多样性的特点使用了旋转候选区域网络RRPN[9]提取舰船候选区域,然后去除重叠度过高或背景较为简单的区域,接着利用旋转区域池化模块提取固定长度的区域特征,并进行候选区域的初步分类、候选检测框调整和角度回归,调整后的候选检测框会被重新池化并使用级联分类子网络实现细粒度分类,最后对目标框进行后处理作为最终的识别结果。整个网络的基本框架如图2所示,可以分为主干检测网络和GAN辅助学习的级联分类子网络两个部分。其中,主干检测网络属于两阶段的目标检测方法,用于实现舰船目标的定位和初步分类,使用端到端的方式进行训练,第一阶段和第二阶段采用了与文献[10]相同的损失函数。

|

Download:

|

| 图 1 本文算法流程图 Fig. 1 Flow chart of the proposed method | |

|

Download:

|

| 图 2 本文的舰船目标识别算法框架 Fig. 2 Framework of the proposed ships recognition network | |

GAN辅助学习的分类子网络用于实现舰船目标的细粒度识别,该部分与主干网络的第二阶段形成级联,以第二阶段的最后一个共享的全连接层特征作为输入特征进行训练,将在下文进行详细介绍。

2 GAN辅助学习的细粒度分类子网络生成对抗网络辅助学习的细粒度分类子网络在结构上由两部分组成:判别器和生成器,二者均是全连接神经网络。前者既参与生成对抗网络的训练,又作为单独的分类子网络完成舰船的细粒度识别,如图3中所示,判别器是包含一个残差连接的全连接网络。在训练阶段,判别器使用主干检测网络输出的所有候选区域作为训练样本,通过与真实目标进行匹配并采样保持正负样本比例为1∶3,在测试时会首先过滤掉主干网络输出的背景概率较高的候选区域,然后利用重新池化后的特征做细粒度识别,最后进行非极大值抑制并输出检测框。相比于主干检测网络中的分类器,使用判别器作为最终的细粒度分类子网络具有以下3个优点:1)在训练判别器网络时可以使用来自不同图像中的更大批量,从而稳定整个训练过程中的梯度;2)判别器网络不进行坐标的进一步微调,从而不会受限于多任务训练方式带来的最优化问题,有利于充分发挥子网络的类别判别能力[11];3)判别器在训练时使用的特征来源于第二阶段输出检测框的池化特征,经过重新匹配后与第二阶段分类器形成了级联有利于提取更精确的区域特征。

|

Download:

|

| 图 3 基于GAN的区域分类子网络 Fig. 3 GAN based region classification sub-network | |

为了进一步增强判别器细粒度的类别判别能力,本文引入了一个生成网络,通过对抗学习的方式参与到判别器的训练中,如图3所示,二者共同组成了一个生成对抗网络。生成器根据指定的输入标签和随机向量来模仿候选舰船区域的深度抽象特征,其最后一层采用tanh激活函数[12],并引入可学习的仿射变换层将特征变换到相同的数值范围。

整个子网络的训练共分为两个阶段:1) 交替训练生成器和判别器,直到生成器能够生成较高质量的抽象特征;2) 固定生成器,利用生成的样本和真实样本一起重新训练判别器,迭代总步数与不使用生成样本一致。生成器在训练过程中会最大化判别器输出相应标签的概率,即:

以上所述的利用生成对抗网络来辅助细粒度分类子网络训练的方法,可以从两个角度进行理论上的解释:从数据增强的角度,生成样本和真实样本具有一定的特征相似性,可以辅助分类器的训练,缓解近岸舰船目标样本的稀缺性问题,从而获得更好的分类性能;从流形学习的角度,生成样本往往存在于流形空间真实数据存在概率较低的区域,生成样本的引入可以帮助分类器学习数据的流形分布,从而增加真实样本与分类边界的距离,进而提高分类器的泛化能力。下文将通过实验对本小节所提方法的有效性进行验证。

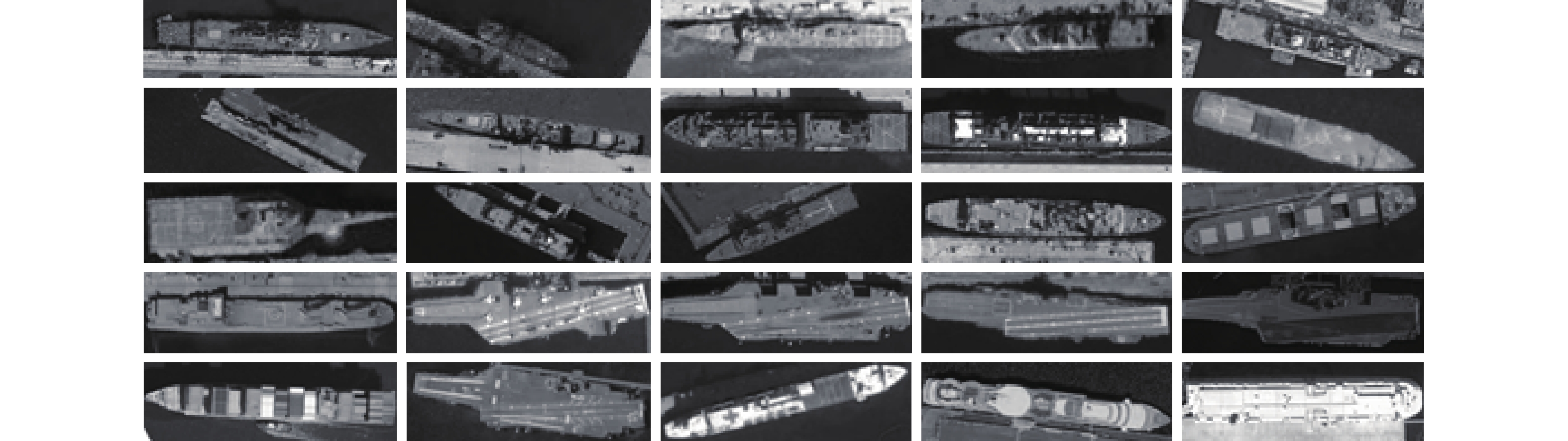

3 实验分析 3.1 数据集本文实验数据集图像的分辨率均为1 m左右,单张图像尺寸在1 000~3 000像素之间,通过随机数据增强,最终可获取有效训练样本4 926张,大小均为480×640。所有标注船只被分成了25个细粒度类别,表1展示了其中的主要细分类别,每一类别的样本缩略图如图4所示。

| 表 1 训练数据集的主要类别 Tab.1 Main categories of the training dataset |

|

Download:

|

| 图 4 数据集各类别缩略图 Fig. 4 Thumbnail of each category in dataset | |

舰船类目标往往具有较为极端的长宽比,并且短边尺度通常较小,因此我们将主干网络的超参数设置如下:

1) 预设框尺度设置为64、128、256、512,长宽比设置为3∶1、5∶1、7∶1,旋转角度设置为9个(从−35°~125°平均划分)。

2)为了避免在区域池化的过程中引入量化误差,使用了旋转区域池化模块的插值改进版[5],有利于短边较小的目标提取更精准的区域特征。

3)候选区域生成阶段的正样本设为与任一真实目标IoU超过0.5且角度偏差小于15°的预设框,与所有真实目标IoU都小于0.2的预设框被设为负样本。

4)第二阶段候选区域的训练批量大小设为256,正负样本比例设为1∶1,正样本IoU阈值设为0.4,池化区域大小改为10×5,全连接层隐藏单元数量均为1 024。

主干网络在训练时图像大小设为640×480,初始学习率为0.001,使用动量随机梯度下降优化算法迭代6×10−4步,学习率衰减系数为0.1,衰减步数为4×10−4、5×10−4、5.5×10−4、5.8×10−4步。权重衰减系数为5×10−4。级联分类器单独进行训练30个周期,生成器训练15个周期,每个批量大小为3张图像。

3.3 实验对比本文使用文献[13]中的评测指标对舰船识别结果进行量化,首先我们训练了主干网络作为基准算法,结果如表2所示。通过引入级联的独立分类器,模型的平均识别准确率略有提升,与端到端的训练方式可以利用数据增强来扩充训练样本相比,直接训练级联分类器往往受限于训练样本的单一性,因此直接训练并不能充分地发挥级联分类器的优势。实验发现,通过对训练样本添加标准差随迭代步数衰减的高斯加性噪声,分类网络的性能可以得到进一步提升。

| 表 2 实验对比 Tab.2 Comparison of results |

本文实验表明,相比于高斯加性噪声,使用生成样本做数据增强更为高效,如表2所示。基于GAN来辅助训练分类器平均识别精度提升了2%,准确率也得到了较大提升。由于级联分类网络并没有进一步的检测框调整,因此识别精度的提升主要是来源于分类子网络细粒度的类别判别能力的提升,从而直接验证了本文算法的有效性。

与其他开源的基于深度学习的方法相比,本文算法在识别细粒度的近岸舰船目标上也有明显优势。如表2所示,TextBoxes++[14]是单阶段的任意方向文本目标检测器,同样适用于长宽比偏大且朝向任意的近岸舰船目标检测,但其平均精度仅为38.5%,主要原因是单阶段目标检测器对短边尺度较小的舰船检测并不友好,且该算法也没有对高层网络的语义信息和低层网络的细节信息进行恰当的特征融合,从而对细粒度类别舰船的判别能力较差。Faster R-CNN[15]是经典的两阶段目标检测器,与本文算法不同的是在训练和测试时采用了水平边界框,因此这类方法定位精度较低,检测结果往往会包含过多的冗余背景区域,不利于提取精确的舰船区域特征用于类别判别,同时也无法区分舰船目标的朝向,如表2所示,该算法平均精度较低,仅为57.3%。可见,近岸舰船目标的细粒度识别问题对算法的类别判别能力有着较高的要求,本文所提的GAN辅助学习的分类子网络能在一定程度上提升整个网络的细粒度类别判别能力。

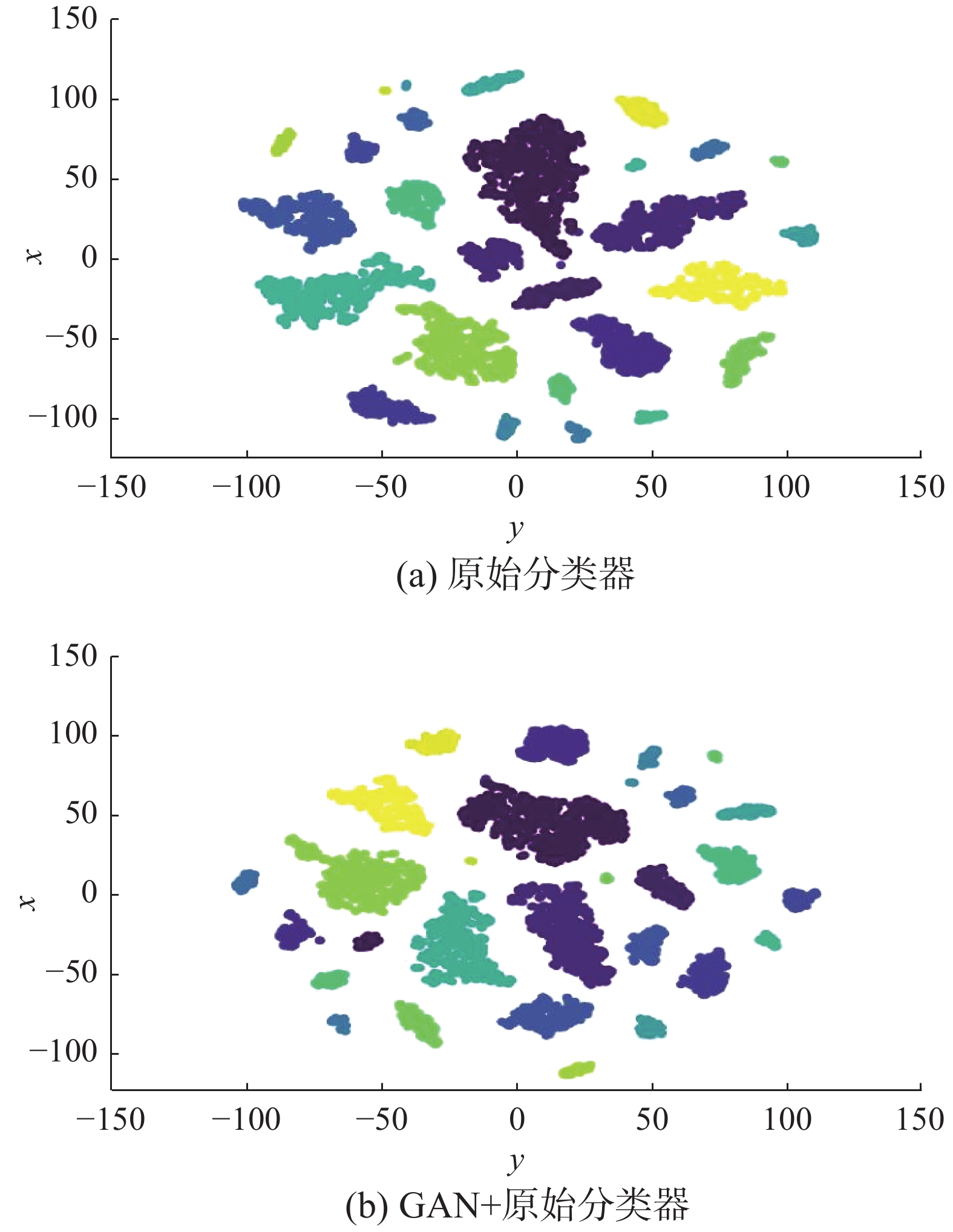

为了深入理解GAN辅助训练对分类子网络带来的影响,本文使用tSNE[16]可视化工具对分类子网络最后一层的特征进行了可视化,如图5所示,其中相同颜色的数据点表示同一类别。经过对比可以发现,加入生成样本后训练得到的分类网络其特征的类内差异变小,相同类别的数据点更接近于圆形分布,这就意味着新的分类器具有更好的类间可分性。最后,本文对生成器的合成样本所对应的分类器特征也进行了可视化,如图6所示,大多数类别的生成样本具有较高的质量,既有良好的类间可分性,又具有一定的类内差异性,这有利于后续分类子网络的训练。

|

Download:

|

| 图 5 分类器特征可视化 Fig. 5 Feature visualization of the classifier | |

|

Download:

|

| 图 6 生成样本的分类器特征可视化 Fig. 6 Feature visualization of the generated samples | |

图7是本文算法检测结果的可视化图像,图中展示了算法在不同港口区域的舰船检测结果,不同的数字编号表示不同的类别,与图4中的排列顺序保持一致。首先,从检测结果可以看出本文算法对亮度变化、尺度变化和陆地背景的干扰都具有良好的鲁棒性,同时可以有效地识别出多种类别的近岸舰船目标。其次,如图所示,算法具有良好的细粒度类别判别能力,既能借助形状信息进行细粒度的类别分类:如类别3和类别7在内部结构上很相似,仅在舰船大小上有差异;同时也能够利用局部细节信息对形状相似的类别进行区分:如类别1和类别4大小相似,只在局部细节上具有差异比如类别4尾部是方形,而类别1的尾部是梯形。

|

Download:

|

| 图 7 实验结果可视化 Fig. 7 Visualization of the detection results | |

本文提出了一个利用生成对抗网络辅助训练的舰船目标细粒度识别框架,通过设计级联的分类子网络,并利用生成样本来辅助学习,可以有效地提升分类子网络细粒度的类别判别能力,最后平均识别精度得到了较大提升。本文算法适用于通用的两阶段目标识别网络,且在实际应用中可将级联分类器的参数整合入主干网络实现端到端的推理,但如何将对抗学习的方法与主干网络结合起来实现端到端的训练,有待进一步的深入研究。

| [1] |

LIN Jiale, YANG Xubo, XIAO Shuangjiu, et al. A line segment based inshore ship detection method[M]//DENG Wei. Future Control and Automation. Berlin, Heidelberg: Springer, 2012: 261–269.

( 0) 0)

|

| [2] |

雷琳, 粟毅. 一种基于轮廓匹配的近岸舰船检测方法[J]. 遥感技术与应用, 2007, 22(5): 622-627. LEI Lin, SU Yi. An inshore ship detection method based on contour matching[J]. Remote sensing technology and application, 2007, 22(5): 622-627. DOI:10.3969/j.issn.1004-0323.2007.05.009 (  0) 0)

|

| [3] |

李毅, 徐守时. 基于支持向量机的遥感图像舰船目标识别方法[J]. 计算机仿真, 2006, 23(6): 180-183. LI Yi, XU Shoushi. A new method for ship target recognition based on support vector machine[J]. Computer simulation, 2006, 23(6): 180-183. DOI:10.3969/j.issn.1006-9348.2006.06.048 (  0) 0)

|

| [4] |

LIN Haoning, SHI Zhenwei, ZOU Zhengxia, et al. Fully convolutional network with task partitioning for inshore ship detection in optical remote sensing images[J]. IEEE geoscience and remote sensing letters, 2017, 14(10): 1665-1669. DOI:10.1109/LGRS.2017.2727515 ( 0) 0)

|

| [5] |

YANG Xue, SUN Hao, FU Kun, et al. Automatic ship detection of remote sensing images from google earth in complex scenes based on multi-scale rotation dense feature pyramid networks[J]. arXiv preprint arXiv: 1806.04331, 2018.

( 0) 0)

|

| [6] |

GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems. Montréal, Canada, 2014: 2672–2680.

( 0) 0)

|

| [7] |

XU Suhui, MU Xiaodong, CHAI Dong, et al. Remote sensing image scene classification based on generative adversarial networks[J]. Remote sensing letters, 2018, 9(7): 617-626. DOI:10.1080/2150704X.2018.1453173 ( 0) 0)

|

| [8] |

WANG Xiaolong, SHRIVASTAVA A, GUPTA A. A-fast-RCNN: hard positive generation via adversary for object detection[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA, 2017: 1063–6919.

( 0) 0)

|

| [9] |

MA Jianqi, SHAO Weiyuan, YE Hao, et al. Arbitrary-oriented scene text detection via rotation proposals[J]. IEEE transactions on multimedia, 2018, 20(11): 3111-3122. DOI:10.1109/TMM.2018.2818020 ( 0) 0)

|

| [10] |

GIRSHICK R. Fast R-CNN[C]//Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile, 2015: 1440–1448.

( 0) 0)

|

| [11] |

CHENG Bowen, WEI Yunchao, SHI Honghui, et al. Revisiting RCNN: on awakening the classification power of faster RCNN[C]//Proceedings of the 15th European Conference on Computer Vision. Munich, Germany, 2018: 473–490.

( 0) 0)

|

| [12] |

RADFORD A, METZ L, CHINTALA S. Unsupervised representation learning with deep convolutional generative adversarial networks[J]. arXiv preprint arXiv: 1511.06434, 2015.

( 0) 0)

|

| [13] |

EVERINGHAM M, VAN GOOL L, WILLIAMS C, et al. The PASCAL visual object classes challenge 2007(VOC2007) results[EB/OL]. University of Oxford, 2007. http://host.robots.ox.ac.uk/pascal/VOC/.

( 0) 0)

|

| [14] |

LIAO Minghui, SHI Baoguang, BAI Xiang. TextBoxes++: a single-shot oriented scene text detector[J]. IEEE transactions on image processing, 2018, 27(8): 3676-3690. DOI:10.1109/TIP.2018.2825107 ( 0) 0)

|

| [15] |

REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[C]//Proceedings of the 28th International Conference on Neural Information Processing Systems. Montréal, Canada, 2015: 91–99.

( 0) 0)

|

| [16] |

VAN DER MAATEN L, HINTON G. Visualizing data using t-SNE[J]. Journal of machine learning research, 2008, 9(11): 2579-2605. ( 0) 0)

|

2020, Vol. 15

2020, Vol. 15