2. 辽宁工程技术大学 智能工程与数学研究院,辽宁 阜新 123000;

3. 辽宁工程技术大学 数学与系统科学研究所,辽宁 阜新 123000

2. Institute of Intelligence Engineering and Mathematics, Liaoning Technical University, Fuxin 123000, China;

3. Institute of Mathematics and Systems Science, Liaoning Technical University, Fuxin 123000, China

视频目标跟踪(video object tracking, VOT)是计算机视觉领域的重要研究方向,综合了图像分析与处理、模式识别、人工智能、自动控制等领域的先进技术,在视觉导航、机器人、智能交通、视频监控等方面具有广泛应用[1- 2]。但在实际应用中仍面临诸多困难与挑战,主要包括光照变化、尺度变化、目标遮挡、背景干扰、非刚体形变、旋转、运动模糊等。因此近年来一些目标跟踪算法被提出[3-6],其中基于相关滤波的目标跟踪采用密集采样策略,利用频域中的快速傅里叶变换(fast fourier transformation, FFT)代替空间卷积运算,进行相关滤波的训练,通过对后续帧进行相关滤波快速定位目标,因其跟踪精度及实时性显著提升而被广泛关注。

最小输出平方误差和(minimum output sum of squared error, MOSSE)[7]滤波器最早将相关滤波用于目标跟踪,该方法采用单一的灰度特征,速度远高于其他算法,但准确度一般。之后在MOSSE算法基础上,一系列改进算法被提出[8-13]。其中CSK[8]采用单一的灰度特征,易受背景复杂、目标和背景颜色相似的影响,KCF[9]采用方向梯度直方图HOG特征,CN[10]中采用颜色特征,运用自适应降维方法将11维颜色特征降为2维用于目标跟踪,均得到了较好的跟踪效果。文献[14]将原始图像的灰度特征、颜色特征及HOG特征融合,提高了跟踪性能。随着深度学习的发展,许多算法将深度学习提取的特征同现有的特征进行融合[15-17],同样提高了跟踪性能。

虽然上述算法取得了较好的跟踪效果,但是在存在严重背景干扰及目标遮挡等情况下,仍容易发生跟踪失败的情况。为了在严重背景干扰及目标遮挡情况下更好地完成跟踪,考虑到图像的边缘特征作为图像的基本特征,携带了原始图像的绝大部分信息,而HOG特征是分块提取图像的局部特征,两个特征具有一定的互补性,从而提出一种基于特征融合方法及自适应模型更新策略的相关滤波目标跟踪算法——多特征自适应相关滤波目标跟踪算法,通过选择边缘特征和HOG特征的线性加权融合结果作为目标特征,加强对边缘特征的学习;采用基于奇异值特征向量相似度的自适应模型更新策略,避免了每一帧都更新模型造成的重复计算,降低了错误更新的概率,更好适应了背景干扰及目标遮挡等问题。

1 算法描述相关滤波跟踪算法的总体框架是根据视频第一帧中给定的目标位置提取图像块,训练、学习得到相关滤波器;对后续的每一帧,从上一帧目标位置的区域提取图像块用来检测;提取图像块的特征,同时加余弦窗口平滑边缘;利用离散傅里叶变换进行相关滤波操作;通过傅里叶变换得到响应图谱,具有最大响应值的位置就是要预测的目标位置;提取估计位置的目标外观,训练和更新相关滤波器。

1.1 相关滤波目标跟踪算法将一张图片以

| $\varepsilon {\rm{ = }}{\left\| {\sum\limits_{l = 1}^d {{h^l} * {f^l} - g} } \right\|^2} + \lambda \sum\limits_{l = 1}^d {{{\left\| {{h^l}} \right\|}^2}} $ | (1) |

式中:

| ${H^l} = \frac{{\bar G{F^l}}}{{\displaystyle\sum\limits_{k = 1}^d {{{\bar F}^k}{F^k} + \lambda } }}$ | (2) |

式(1)中正则化参数缓解了

| $A_t^l = (1 - \eta )A_{t - 1}^l + \eta {\bar G_t}F_t^l$ | (3) |

| ${B_t} = (1 - \eta ){B_{t - 1}} + \eta \displaystyle\sum\limits_{k = 1}^d {\bar F_t^k} F_t^k$ | (4) |

式中:

| $y = {F^{ - 1}}\left\{ {{{\displaystyle\sum\limits_{l = 1}^d {{{\bar A}^l}{Z^l}} }}\Bigg/{{(B + \lambda) }}} \right\}$ | (5) |

图像中的边界信息携带了原始图像的绝大部分信息,描述了图像的整体边缘特征,可以通过边缘线就能识别出一个物体,因此对图像边缘特征的提取与学习一定程度上影响了对后续处理的精度;HOG特征是分块提取图像的局部特征;因此通过将两种特征进行融合,可以更好地掌握图像的特征,为目标跟踪的后续工作提供更加精确的特征表示。

在特征提取阶段采用线性加权方式融合边缘特征和HOG特征作为目标特征,具体流程如下:

1)分别提取目标区域的边缘特征

2)初始化融合参数

3)计算边缘特征与HOG特征融合后的目标特征:

其中

同离线跟踪相比,在线跟踪方式的优势在于可以实时对模型进行更新,增加了跟踪的鲁棒性,目前主要的更新方式有以下3种:

1)每一帧都进行更新[18]。这种更新方式过于频繁,增加了错误更新的概率,同时增加了模型漂移的可能。

2)当响应分数低于一定阈值才进行模型更新[6]。减少了更新频率,增加了对模型的判断。

3)计算正负样本的响应分数,当二者的差值低于一定阈值时更新模型[19]。

本文提出了一种基于奇异值特征向量相似性的模型自适应更新策略:首先将预测区域图像矩阵与真实区域图像矩阵进行奇异值分解,然后计算分解后得到的奇异值特征向量之间的余弦距离,来表征预测区域和真实区域的相似程度,并与给定阈值比较以决定模型是否更新。

矩阵奇异值分解(singular value decomposition, SVD)是矩阵特征提取的一种主要方法,它通过将复杂的矩阵转换为代表矩阵特征的更小、更简单的几个子矩阵相乘来实现矩阵特征提取。图像的奇异值特征向量具有正交变换、旋转等代数和几何上的不变性,同时具有稳定性和抗噪性,因此在模式识别、图像分析等领域中应用广泛[20]。

定义1 设

定理1 设

| ${{A}}{\rm{ = }}{{U}}\left( {\begin{array}{*{20}{c}} {{\varSigma }} &0 \\ 0&0 \end{array}} \right){{{V}}^{\rm{H}}}$ | (6) |

式中:矩阵

基于奇异值特征向量相似性的模型自适应更新算法流程如下:

1)分别对预测区域与真实区域图像矩阵进行奇异值分解,得到预测区域与真实区域图像的奇异值特征向量

2)利用余弦距离计算

| $\lambda = \frac{{{{{M}}_1} \cdot {{{M}}_2}}}{{\left| {{{{M}}_1}} \right| \cdot \left| {{{{M}}_2}} \right|}}$ |

3)若

通过对大量数值实验结果的对比分析可知,当

基于边缘特征和HOG特征的融合策略和奇异值特征向量相似性的自适应模型更新策略,本文提出了一种新的相关滤波目标跟踪算法——多特征自适应相关滤波目标跟踪算法。算法流程如下:

1)根据给定的视频第1帧目标位置,提取边缘特征及HOG特征;

2)根据视频内容设定特征融合参数,计算得到融合后的特征值;

3)训练、学习相关滤波器;

4)提取下一帧目标位置特征,进行相关滤波操作,得到预测区域;

5)计算预测区域与真实区域的奇异值特征向量相似度;

6)若相似度大于设定的阈值,则进行相关滤波器更新,若相似度小于设定的阈值,则不更新;

7)重复4)~6)。

2 实验结果与分析 2.1 数据集说明为了验证基于特征融合及自适应模型更新的相关滤波目标跟踪算法的有效性,选取视频跟踪标准数据集OTB-50和OTB-100中存在背景干扰问题的18组视频序列进行数值实验,其中9组同时存在目标遮挡问题,各组视频序列的帧数、目标大小以及存在的问题信息见表1。

| 表 1 测试视频信息 Tab.1 Test video information |

为了评估目标跟踪算法的性能,本文使用如下评估指标[11]:中心位置误差(center location error, CLE)、区域重叠准确率(region overlap precision, OP)、距离精度(distance precision, DP)、跟踪速度(frames per second, FPS)、跟踪长度(tracking length, TL)。其中CLE为检测到的目标中心与真实目标中心间的平均欧氏距离,OP为检测区域与真实区域重叠面积超过一定阈值的视频帧数占视频总帧数的百分比,DP为中心位置误差小于一定阈值的视频帧数占总帧数的百分比,FPS为每秒处理的视频帧数,TL为从跟踪开始到中心位置误差下降到一定阈值以下的帧数。CLE的值越小,OP、DP、FPS、TL的值越大,跟踪效果越好。

2.3 实验分析本文共设计3组实验,第1组实验在18组测试视频上对现有的两种算法(基于多维特征的DSST[12]算法、基于HOG特征的SRDCF算法[13])和本文的算法的跟踪效果进行对比;第2组实验重点测试算法在同时具有背景干扰及目标遮挡问题的视频序列上的跟踪效果;第3组实验对比3种跟踪算法的跟踪速度。

1)跟踪效果对比实验

对18组存在背景干扰的视频进行实验,为确定每组视频的最优融合参数

| 表 2 3种算法在18组视频序列上的跟踪效果 Tab.2 The tracking effect of 3 algorithms on 18 groups of video sequences |

2)背景干扰及目标遮挡下的跟踪实验

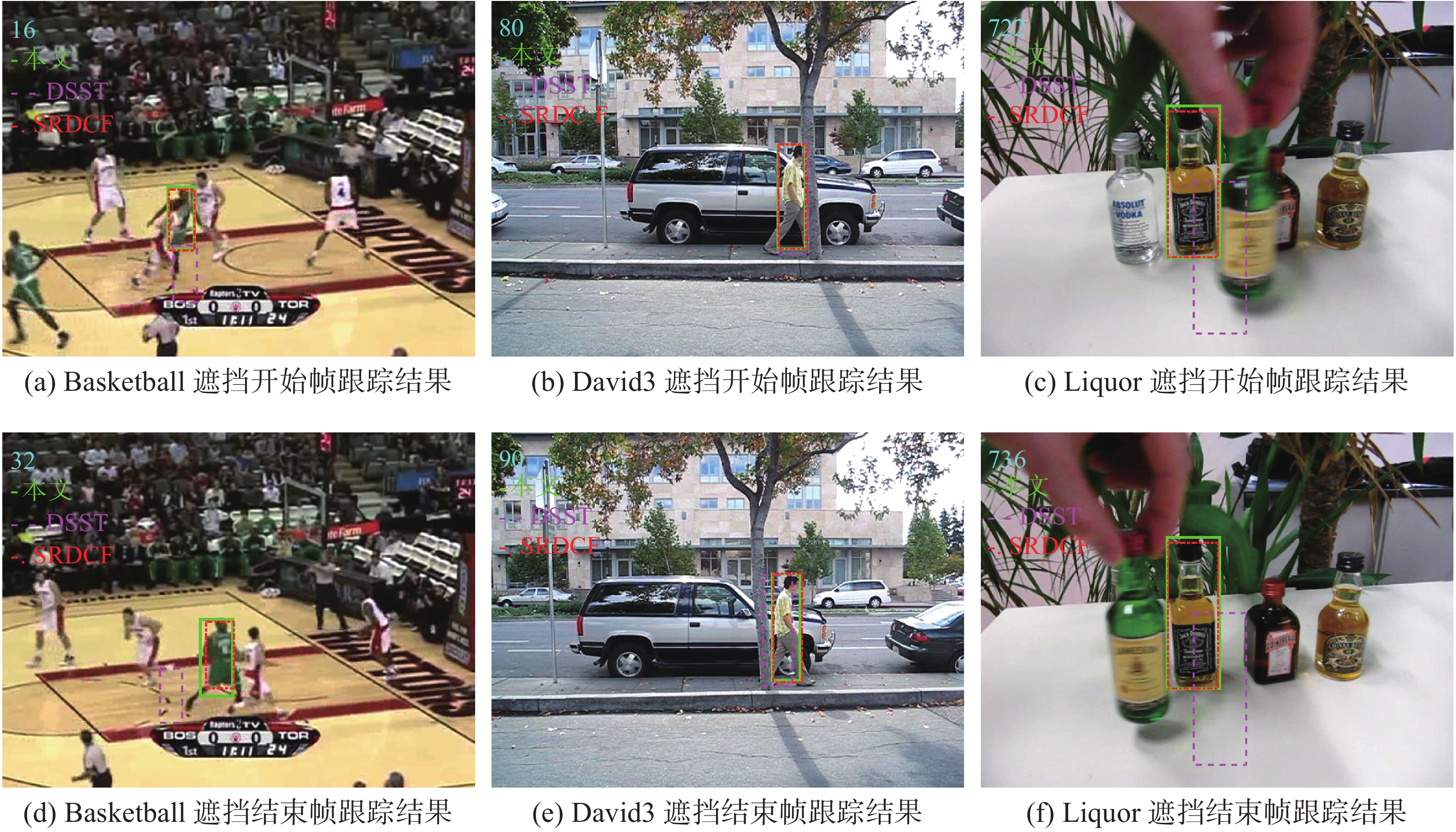

对存在严重背景干扰及目标遮挡的3组视频Basketball、David3和Liquor序列进行实验,图1所示为3组视频的跟踪曲线。从图1中(a)~(c)可以看出,在Basketball数据集中,当期望重叠率为0.5时,本章算法的重叠面积精度高于DSST算法、SRDCF算法;在David3数据集中,本文算法的重叠面积精度略低于SRDCF算法,优于DSST算法;在Liquor数据集中,本文算法的重叠率精度取得了同SRDCF算法相近的结果,优于DSST算法。由图(d)~(f)的距离精度可以看出,当期望像素误差为20时,在Basketball数据集中,本文算法的距离精度远远高于SRDCF算法和DSST算法;在David3数据集中,本文算法取得同SRDCF算法,但都远远高于DSST算法;在Liquor数据集中,本文算法的距离精度,略高于SRDCF算法,远高于DSST算法。当距离精度为0.8时,Basketball、David3、Liquor 3个数据集中,本文算法的误差像素均低于SRDCF和算法DSST算法。由图(g)~(i)的跟踪长度可以看出,当期望像素误差为20时,在Basketball数据集中,本文算法的跟踪长度大于SRDCF算法及DSST算法;在David3数据集中,本文算法和SRDCF算法具有相同的跟踪长度,但都大于DSST算法;在Liquor数据集中,本文算法略大于SRDCF算法和DSST算法。综合下来,同其他两种算法相比,本文算法的跟踪效果更好。

图1中3组视频的实验数据如表2中第1、5、10行所示,结合其他测试视频的对比结果,本文所提算法在多数测试视频上的性能好于DSST算法。其中,在Coke和Singer2等测试视频中的性能也达到与DSST算法相近的性能,在存在遮挡问题的视频中各项评价指标均好于DSST,与SRDCF相比,本文提出的算法平均CLE降低5.79,DP提高15.27%,OP提高3.04%。

|

Download:

|

| 图 1 3组背景干扰及目标遮挡下跟踪曲线 Fig. 1 Tracking curves of 3 groups of background interference and target occlusion | |

图2所示为遇到严重背景干扰及目标遮挡到遮挡结束时的跟踪结果,可以看出,视频Basketball、David3、Liquor分别在第16帧、第80帧、第722帧发生严重遮挡,分别在第32帧、第90帧、第736帧遮挡结束,在遮挡结束时本文算法和SRDCF都可以准确地继续跟踪目标,DSST发生跟丢或偏移。结果表明,在发生严重背景干扰及目标遮挡情况下本文算法的跟踪性能更好。

|

Download:

|

| 图 2 3组背景干扰及目标遮挡下的跟踪结果 Fig. 2 Tracking results of 3 groups of background interference and target occlusion | |

3)跟踪速度对比实验

视频跟踪算法在保证跟踪性能的前提下,同时还要考虑跟踪速度的问题,本文算法同两种对比算法在18组视频序列上的跟踪速度如表3所示,相比于DSST算法平均19 f/s的跟踪速度,本文算法在特征提取阶段加入边缘特征的融合,模型更新阶段加入区域相似性计算,增加了计算量,从而导致跟踪速度有所下降,平均跟踪速度为8.95 f/s。但相比于DSST算法的另一个改进SRDCF算法的平均4.26 f/s的跟踪速度,本文算法的速度提高了1倍,同时在准确率及跟踪的鲁棒性上有所提高。

| 表 3 3种算法跟踪速度对比 Tab.3 Tracking speed contrast of 3 algorithms |

本文对DSST相关滤波目标跟踪算法进行了改进,提出了融合边缘特征和HOG特征的特征提取策略和基于奇异值特征向量相似度的模型自适应更新策略,通过两种策略的结合实现了一种新的相关滤波目标跟踪算法——多特征自适应相关滤波目标跟踪算法,实验表明本文所提出的算法在存在严重背景干扰和目标遮挡的情况下仍能很好地进行跟踪,提高了算法精度。在严重背景干扰和目标遮挡的情况下仍能准确进行跟踪,提高了算法精度和鲁棒性。

由于特征自适应相关滤波目标跟踪算法采用了边缘特征和HOG特征的融合,并在模型更新阶段加入了相似性计算,因此加大了计算量,速度相比于DSST有所下降,但仍高于SRDCF,在准确率和鲁棒性上有所提高,后续研究工作可围绕进一步解决计算上所带来的速度下降问题、进一步改进特征融合的方式,以及将深度学习所提取的特征与现有特征进行自适应融合等方面展开,使改进的算法能够同时兼顾实时性、鲁棒性和准确性的要求。

| [1] |

CHEN Zhe, HONG Zhibin, TAO Dacheng. An experimental survey on correlation filter-based tracking[J]. arXiv: 1509.05520, 2015.

( 0) 0)

|

| [2] |

张微, 康宝生. 相关滤波目标跟踪进展综述[J]. 中国图象图形学报, 2017, 22(8): 1017-1033. ZHANG Wei, KANG Baosheng. Recent advances in correlation filter-based object tracking: a review[J]. Journal of image and graphics, 2017, 22(8): 1017-1033. DOI:10.11834/jig.170092 (  0) 0)

|

| [3] |

VALMADRE J, BERTINETTO L, HENRIQUES J F, et al. End-to-end tracking[J]. arXiv: 1704.06036, 2017.

( 0) 0)

|

| [4] |

刘新卉. 基于深度信息的核相关滤波目标跟踪算法研究[D]. 深圳: 哈尔滨工业大学, 2017. LIU Xinhui. Research on kernel correlation filter object tracking algorithm based on depth information[D]. Shenzhen: Harbin Institute of Technology, 2017 (  0) 0)

|

| [5] |

董艳梅. 基于相关滤波器的目标跟踪技术[D]. 北京: 北京理工大学, 2015. DONG Yanmei. Visual object tracking based on correlation filters[D]. Beijing: Beijing Institute of Technology, 2015. (  0) 0)

|

| [6] |

朱明敏, 胡茂海. 基于相关滤波器的长时视觉目标跟踪方法[J]. 计算机应用, 2017, 37(5): 1466-1470. ZHU Mingmin, HU Maohai. Long-term visual object tracking algorithm based on correlation filter[J]. Journal of computer applications, 2017, 37(5): 1466-1470. DOI:10.11772/j.issn.1001-9081.2017.05.1466 (  0) 0)

|

| [7] |

BOLME D S, BEVERIDGE J R, DRAPER B A, et al. Visual object representation learning for correlation filter based tracking using adaptive correlation filters[C]//2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, USA, 2010: 2544−2550.

( 0) 0)

|

| [8] |

HENRIQUES J F, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]//European conference on computer vision. Berlin, Germany, 2012: 702−715.

( 0) 0)

|

| [9] |

HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(3): 583-596. DOI:10.1109/TPAMI.2014.2345390 ( 0) 0)

|

| [10] |

DANELLJAN M, SHAHBAZ K F, FELSBERG M, et al. Adaptive color attributes for real-time visual tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Columbus, USA, 2014: 1090−1097.

( 0) 0)

|

| [11] |

WU Y, LIM J, YANG M H. Online object tracking: A benchmark[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Portland, USA, 2013: 2411−2418.

( 0) 0)

|

| [12] |

DANELLJAN M, HӒGER G, KHAN F, et al. Accurate scale estimation for robust visual tracking[C]//British Machine Vision Conference. Nottingham, UK, 2014:1-11.

( 0) 0)

|

| [13] |

DANELLJAN M, HAGER G, SHAHBAZ K F, et al. Learning spatially regularized correlation filters for visual tracking[C]//Proceedings of the IEEE International Conference on Computer Vision. Santiago, Chile, 2015: 4310−4318.

( 0) 0)

|

| [14] |

LI Y, ZHU J. A scale adaptive kernel correlation filter tracker with feature integration[C]//European Conference on Computer Vision. Zurich, Switzerland, 2014: 254−265.

( 0) 0)

|

| [15] |

DANELLJAN M, HAGER G, KHAN F S, et al. Con volutional features for correlation filter based visual tracking[C]//IEEE International Conference on Computer Vision Workshop. Santiago, Chile, 2015: 621−629.

( 0) 0)

|

| [16] |

白冰, 钟必能, 欧阳谷. 融合分层卷积特征和尺度自适应核相关滤波器的目标跟踪[J]. 小型微型计算机系统, 2017, 38(9): 2062-2066. BAI Bing, ZHONG Bineng, OUYANG Gu. Object tracking based on hierarchical convolution feature and scale adaptive kernel correlation filter[J]. Journal of chinese computer systems, 2017, 38(9): 2062-2066. DOI:10.3969/j.issn.1000-1220.2017.09.027 (  0) 0)

|

| [17] |

MA C, HUANG J B, YANG X, et al. Hierarchical convo- lutional features for visual tracking[C]//IEEE International Conference on Computer Vision. Santiago, Chile, 2015: 30 74−3082.

( 0) 0)

|

| [18] |

KALAL Z, MIKOLAJCZYK K, MATAS J. Tracking- learning-detection[J]. IEEE Transactions on software engineering, 2011, 34(7): 1409-1422. ( 0) 0)

|

| [19] |

BERTINETTO L, VALMADRE J, HENRIQUES J F, et al. Fully-convolutional siamese networks for object tracking[C]//European Conference on Computer Vision. Amsterdam, Netherlands, 2016: 850−865.

( 0) 0)

|

| [20] |

洪子泉, 杨静宇. 用于图像识别的图像代数特征抽取[J]. 自动化学报, 1992, 18(2): 233-238. HONG Ziquan, YANG Jingyu. Algebraic feature extraction of images for recognition[J]. Acta automatica sinica, 1992, 18(2): 233-238. (  0) 0)

|

2020, Vol. 15

2020, Vol. 15