2. 长沙理工大学 计算机与通信工程学院,湖南 长沙 410114

2. School of Computer and Communication Engineering, Changsha University of Science and Technology, Changsha 410114, China

行人检测是判断输入的图像或视频中是否含有行人,并准确的找出行人的具体位置。行人检测作为目标检测的一个子方向,在视频监控、行人识别[1]、图像检索以及先进的驾驶员辅助系统等领域有着广泛的应用[2]。由于行人具有非刚性属性,决定了行人检测不同于普通的目标检测,另外存在着许多制约行人检测的因素,如现实场景中背景的复杂多样性、光照变化、行人遮挡、姿态变化、拍摄角度多样化、实时性要求、小目标行人等。这些因素给行人检测带来了巨大的挑战,因此行人检测一直是计算机视觉领域中的研究热点和难点。

传统的行人检测的效果依赖于特征的选取以及分类器的学习。一个好的特征即使结合简单的分类器仍能够取得不错的检测效果,所以传统的行人检测研究重点在于行人的特征提取及分类。尽管传统的行人检测算法取得了不少的研究成果,但是在实际生活场景的检测效果依然不理想。近年来深度学习的方法在目标检测、语音识别、图像分类等方面取得了突破性的进展,与传统检测算法相比,卷积神经网络(CNN)通过权值共享,大大减少了网络的参数,进而降低了算法复杂度。CNN的卷积运算以及下采样能很好的学习到图像的颜色、纹理等特征,使之对图像的缩放、平移具有很好的鲁棒性。因此,深度学习算法在行人检测领域里的检测精度以及实时性都优于传统算法。

针对真实场景下的行人检测精度不高,小目标行人的漏检率较高的问题,本文对目前优秀的深度模型进行了改进。通过引出SSD[3]网络模型中更底层特征做检测以及增加输入图像大小来增加深度模型的分辨率,提高了对小目标行人的检测性能。卷积网络中的底层特征能检测到尺寸较小的目标,而深层特征可以检测到尺寸较大的目标,因此引出SSD网络中多层输出特征图,将检测结果综合后确定目标位置。此外,训练数据集的数量跟数据集样本的多样性也是深度学习算法取得优秀成果的主要原因。因此本文采用车载摄像头拍摄了各种场合、光照、遮挡、姿态等复杂的背景下的行人视频,在INRIA[4]行人数据集上,扩增了一个复杂场景下的行人数据集CSUSTPD。

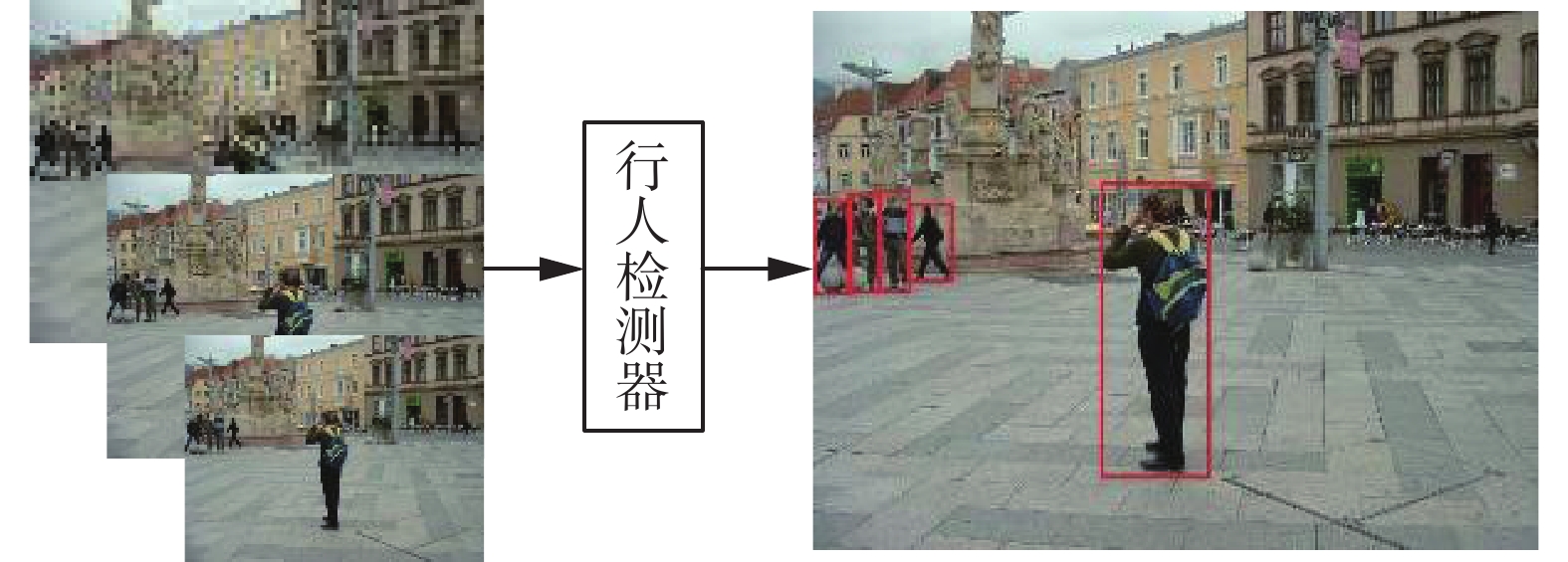

1 相关工作传统的行人检测流程主要由行人图像输入、行人的特征提取、分类与定位、检测结果等几个模块组成[5],其研究重点在于行人的特征提取及分类,比较常见的特征提取算子有SIFT[6]、Haar[7]、梯度方向直方图HOG[4]等;代表性的分类器有神经网络、Adaboost[8]、支持向量机SVM[9]、随机森林RF[10]等。基于HOG特征的提取极大地推动了行人检测的发展,并随后出现了在HOG特征上融合颜色特征、纹理特征等诸多算法;2005年Dalal等[4]提出了HOG结合分类器SVM的算法,取得了较好的效果,并陆续提出的ACF(aggregated channel features)[11]、LDCF[12]等算法都具有很好的检测效果。2015年Zhang等[13]把HOG特征结合光流特征进一步提高了行人检测性能。针对在同一张图像有不同尺寸的目标时,传统方法主要有两种处理方法:1)将原始图像转换成不同尺寸大小的图像输入固定尺寸的滑动窗口分别提取特征,该方法的检测精度较好,但是计算复杂,其流程如图1所示;2)用固定大小不变的图像输入多尺度缩放的滑动窗进行特征提取。方法2)避免了测试图像的多尺度计算,检测速度较快但其精度比较差。

|

Download:

|

| 图 1 多尺度输入图像检测流程 Fig. 1 Object detection with multi-scale input | |

2012年Krizhevsky等[14]在ImageNet竞赛上训练出一个8层的卷积神经网络,取得了视觉领域竞赛ILSVRC 2012的冠军。在此之后,深度学习算法层出不穷,典型的算法有VGG-Net[15]、R-CNN[16]、Faster R-CNN[17];Redmon等[18]提出的YOLO直接在输出层回归目标位置与类别,加快了目标检测速度及精度;Liu等[3]提出了SSD融合卷积层的多层输出特征做检测,进一步提高了目标检测精度。由于CNN提取的特征比传统特征更具鲁棒性,其良好的特征表达能力提高了行人检测性能,因此许多研究学者将深度学习算法应用于行人检测领域。文献[19]引入级联CNN网络在拥挤场景中准确地检测行人;Hosang等[20]利用SquaresChnFtrs[21]产生行人候选窗口用于训练AlexNet[14]。文献[22]利用光流卷积神经网络对光流图序列中提取行人特征,该特征具有较强的全局描述能力;Tian等[23]利用深度学习结合部件模型解决行人检测中的遮挡问题。文献[24]采用级联的Adaboost检测器对行人目标进行初步筛选,再用迁移学习技术训练卷积神经网络来提高检测精度;Zhang等[25]利用级联的决策森林来分类RPN网络(region proposal network)产生的行人候选窗口。

训练深度CNN模型时,数据集的数量跟数据集样本的多样性能增强算法检测的泛化能力。现有的行人数据集如Daimler行人数据集[26]含训练样本集有正样本大小为18×36和48×96的图像。较早公开的MIT行人数据集[27]含924张宽高为64×128行人图像,肩到脚的距离约80像素。该数据库只含正面和背面两个视角,无负样本,并且未区分训练集和测试集。NICTA行人数据集[28]标注要求行人高度至少要大于40个像素。这些数据集训练样本存在从大图像中剪切出的单个行人图像、分辨率偏低、对小目标行人无标注的问题,且行人数据集训练样本背景单一。因此,这些数据集不适合用于训练深度卷积网络模型。

2 SSD网络SSD算法是一种直接预测目标边界框的坐标和类别的检测算法,整个网络没有生成候选窗口的过程。SSD算法的骨干网络结构是VGG16[15],将VGG16最后两个全连接层改成卷积层再增加4个卷积层构造网络结构。表1展示了整个SSD网络中每个卷积层中卷积核的大小、数目,卷积的步长,特征图有无填充以及每层输出特征图的大小。图2为SSD算法的目标检测流程图,SSD检测算法分别把conv4_3、fc7、conv6_2、conv7_2、conv8_2和conv9_2等6个不同卷积层的特征图引出做检测,其特征图与两个3×3的卷积核卷积后得到两个输出,分别作为分类时使用的置信度以及回归时使用的位置信息。将每层计算结果合并后传递给损失层,该层对所有层的检测结果进行综合,通过非极大值抑制输出目标的检测结果。

| 表 1 SSD网络参数表 Tab.1 Parameters of SSD Network |

|

Download:

|

| 图 2 SSD目标检测流程图 Fig. 2 Detection flowchart for SSD object algorithm | |

SSD算法关键核心点是同时采用底层和顶层的特征图做检测。在不同层卷积输出的若干特征图中的每个位置处评估不同纵横比的默认框。默认框是指在特征图的每个网格上都有一系列固定大小的框。每个网格有k个默认框,每个默认框预测c个目标类别的分数和4个偏移。若特征图的大小为mn,即有mn个特征图网格,则该特征图共有(c+4)×k×m×n个输出。在训练阶段,将默认框和真实框(ground truth box)进行匹配,一旦匹配成功,则默认框即为正样本,反之则为负样本。根据置信度的损失值对负样本进行排序,得到靠前的负训练样本,使得正负样本的比例保持在3:1。在预测阶段,得到默认框的偏移及目标类别相应的置信度。

SSD网络的目标损失函数表示为

| $L({{x}},c,l,g) = \frac{1}{N}({L_{\rm conf}}(x,c) + \alpha {L_{\rm loc}}(x,l,g))$ | (1) |

式中:N为匹配到的默认框个数;l为预测框;g为真实框;c为多类别目标的置信度;Lloc为位置损失;Lconf为置信度损失;

位置损失是预测框l和真实框g之间的smoothL1损失[29],如式(2)所示,通过对边界框的坐标中心点(x,y)以及宽度w和高度h的偏移进行回归,使得位置损失最小。

| ${L_{\rm loc}}(x,l,g) = \sum\limits_{i \in ({\rm Pos})}^N {\sum\limits_{m \in \{ cx,cy,w,h\} } {x_{ij}^k{\rm smoot}{h_{L1}}(L_i^m - \hat g_j^m)} } $ | (2) |

式中:

置信度损失是多类别置信度c的softmax损失如式(3)所示。

| ${L_{\rm conf}}(x,c) = - \sum\limits_{i \in {\rm Pos}}^N {x_{ij}^p} \log (\hat c_i^p) - \sum\limits_{i \in {\rm Neg}} {\log (\hat c_i^0)} $ | (3) |

式中:

相比现有的目标检测方法,SSD算法不管是在检测速度还是检测精度上都取得了非常优秀的效果,但受卷积神经网络中特定特征层感受野大小限制,单独一层的特征无法应对多姿态多尺度的行人[30]。因此,本文提出了改进的SSD模型用于行人检测。

3 多层卷积特征的行人检测算法 3.1 基于改进SSD的行人检测算法随着深度学习的快速发展,CNN已经广泛地应用于目标检测中,在实时性和准确性上都优于传统算法的性能。SSD算法是以VGG16网络模型为基础的前向传播的深度卷积网络模型,对卷积后得到的特征图分别预判目标位置跟类别置信度,实现快速且精准目标检测效果。但原始SSD算法对同一张图像中小尺寸目标检测效果较差,主要原因有两点:1)输入图像在深度卷积神经网络中经过网络的卷积、池化后特征图变小,原始SSD算法conv4_3输出的特征图与原始输入图像相比缩小至原来的1/8,特征图的变小导致检测的目标丢失了大部分的细节信息,在训练阶段严重的影响了算法对各项参数的学习,且后续的fc7、conv6_2等层输出的特征图缩小更多,对算法的训练影响更大;2)输入图像分辨率的大小对SSD算法的影响。训练的图像较小,卷积池化后得到的特征图会对应地减小,使得训练阶段SSD网络参数的学习不完全造成过拟合;若输入图像较大,网络学习的参数大量增加,使得算法计算复杂度增加,速度减慢。

本文在权衡算法的精准度及实时性的基础上,对SSD模型更底层的输出特征图进行特征提取,获取更多特征图的纹理、边缘等细节信息,增强了SSD模型对行人目标的检测性能,提升对小目标行人的检测能力。图3为本文基于改进SSD模型的行人检测(pedestrian detection based on improved SSD,PDIS)框架,行人图像通过改进SSD卷积网络中的各卷积层输出多层次特征图,并在多层次的特征图上提取特征做检测,将多层特征图的检测结果进行综合实现行人检测。由图3的特征图可视化结果可知,底层卷积conv3_3输出的特征图比较大,且纹理、轮廓信息明确,因此该层的特征图可以提取到小目标行人的细节信息。conv9_2卷积层输出的特征图变得很小,原始图像的大部分信息丢失,尤其小物体信息丢失严重,因此该层只能获取较大目标的行人信息。随着网络层数增加,原始图像的信息会随着输出特征的尺寸变小而减少。底层输出特征图可以检测较小的行人目标,深层输出的特征可以检测较大的行人目标,因此PDIS通过结合多层特征图检测结果,提升了多尺寸行人的检测性能。

|

Download:

|

| 图 3 PDIS框架 Fig. 3 PDIS framework | |

PDIS模型通过引出SSD卷积网络中更底层conv3_3输出的特征图做检测。图4为本文改进之一的PDIS流程图,应用SSD算法卷积层conv3_3、conv4_3、conv7、conv6_2、conv7_2、conv8_2和conv9_2等7个输出层的特征图做检测,图中可以看出不同卷积层输出的特征图可以检测图像中不同尺度的行人,conv3_3输出的特征图能检测到图像中尺度很小的行人,但对尺寸大的行人检测效果很差;卷积层conv9_2输出的特征图可以检测图像中的尺寸较大的行人,但对小尺寸行人检测效果不理想。因此PDIS模型把网络中各层次输出的特征图由底层到深层依次引出做检测,检测到行人目标尺寸越来越大。尽管每一层对图像整体的检测效果不理想,但综合所有层的检测达到了精准的行人检测结果。因此,本文通过修改后的SSD网络,应用多个卷积层输出的特征图做检测,实现了图像中多尺度的行人检测问题,增加了算法的行人检测分辨率,提升了对图像中尺寸相对较小行人的检测效果。

|

Download:

|

| 图 4 PDIS流程 Fig. 4 PDIS flowchart | |

PDIS在每层输出特征图上的每个特征图网格预设有4个默认框,在不同输出层的特征图上有不同尺寸大小的默认框,在同一个特征图上又有不同纵横比的默认框,实现了图像中各种形状和尺寸大小的目标检测。行人的高度跟宽度之比一般在1∶1、2∶1、3∶1、1∶2这些比例内,不同于原始SSD算法,本文将默认框的纵横比ar设置为符合行人的4种比例分别为1∶1、2∶1、3∶1、1∶2,加速了行人区域定位。且默认框的尺度定义为

| ${{{s}}_k} = {s_{\min }} + \displaystyle\frac{{{s_{\max }} - {s_{\min }}}}{{m - 1}}(k - 1),k \in [1,m]$ | (4) |

式中:

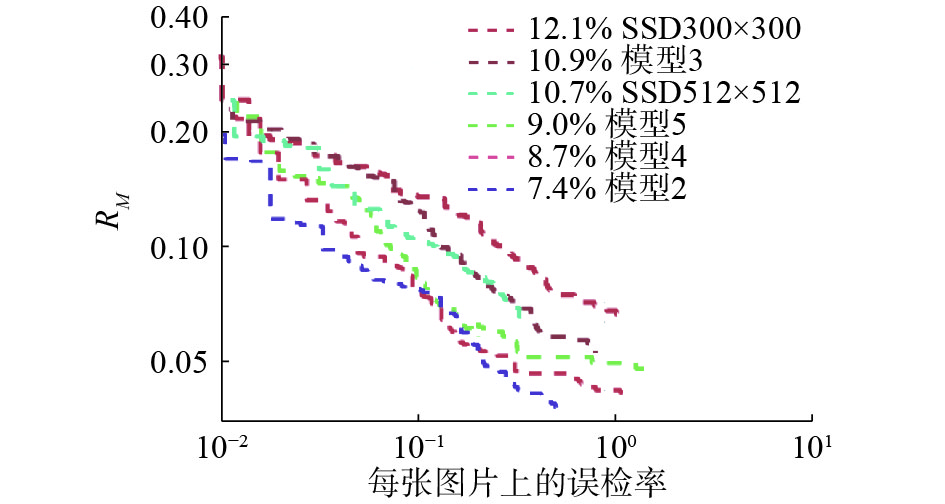

PDIS模型融合多层特征图的特征做检测,解决了同一张图像中不同尺度的目标检测问题。通过研究用不同层输出特征图以及网络输出层的数量对算法行人性能的影响,本文在原始SSD的基础上引出更底层卷积conv3_3的特征图做检测,在该层的特征图上提取特征获得了原始输入行人图像的更多细节信息。实验表明引出卷积conv3_3的输出特征图做检测,特征维度的计算复杂度相应的增加,实时性相比原始SSD算法有所下降,但依然能满足行人检测实时性的要求,并相比原始SSD算法对小尺寸行人检测性能提升很高。同时,研究了融合不同卷层基输出的特征图对算法的影响。在引出底层conv3_3的输出特征图做检测的基础上,训练了多个组合不同输出特征图的网络模型:模型2引出conv3_3、conv4_3、fc7、conv6_2、conv7_2、conv8_2和conv9_2等7个卷积层的特征图做检测,模型3引出conv3_3、fc7、conv6_2、conv7_2、conv8_2和conv9_2等6个卷积层的特征图做检测,模型4引出conv3_3、conv5_3、conv6_2、conv7_2、conv8_2和conv9_2等6个卷积层的特征图做检测,模型5引出conv3_3、conv5_3、conv6_2、conv8_2和conv9_2等5个卷积层的特征图做检测。在扩增的行人数据集分别训练各个PDIS网络模型,利用INRIA行人数据集的测试集分别对模型进行测试。实验表明:不同的网络模型在引出不同的特征层以及引出不同层的数目直接影响网络模型的检测效果,改进的模型2取得了最好的检测性能。

此外,为了进一步提升PDIS模型对小目标的检测能力,通过增加输入图像的分辨率提升算法检测性能的鲁棒性。原始的SSD算法输入图像大小为300×300。在CNN中经过卷积、池化特征图不断减小,原始SSD算法最底层conv4_3引出特征图大小为38×38,相比原始图像缩小至原来的1/8,在原始图像中一个8×8的目标在conv4输出的特征图表现为一个像素点,该目标的细节信息完全丢失。卷积输出的特征图会随网络层数的增加而减小。导致训练阶几乎无法学习到小目标物体的信息。因此,数据集的训练图像分辨率大小很大程度影响了卷积神经网络的学习,训练图像分辨率太小,训练时模型很难收敛,检测精度低。本文把训练预设输入图像尺寸大小从300×300变大到512×512,增加卷积后输出特征图的分辨率,能获得原图像中更加丰富、更加细节的信息。测试结果表明:用放大的行人图像训练PDIS模型能够检测到同一张图像中更小尺寸的行人,进一步提升了行人小目标检测效果。

3.2 数据集扩增增加数据集的多样性来训练PDIS模型可以增强算法检测的泛化能力。一般使用单一的行人数据集训练卷积网络模型时,在其本身数据集上测试的效果会很理想,然而在其他数据集上测试时效果往往不好。因此,行人数据集所包含的样本的数量、样本背景的多样性以及样本中有无对小尺寸行人目标的标注等因素,在训练CNN的过程中会严重影响算法的学习。在训练卷积神经网络时,深度模型学习的参数往往比较多,用于训练的样本数据量太少,容易造成网络过拟合。此外,现有的行人数据集公布时间较早,而且训练样本基本是从较大图像中剪切出的单个行人图像,背景单一,像素分辨率普遍偏低,因此不适合用于训练深度卷积网络模型。

为了增强PDIS模型在行人检测领域的泛化能力,本文对已有的INRIA行人数据集进行了扩增。首先,INRIA行人数据集的选取:INRIA行人数据集是目前使用最多的静态行人检测数据集。其中包含沙滩、机场、城市、山等复杂的场景,且拍摄条件多样,存在光线变化、人体遮挡等情形,符合本文所需求的行人样本的背景多样性。其次,扩增INRIA行人数据集:INRIA行人数据集中训练集的正样本只包含614张图像(包含2 416个行人),用于训练CNN模型的数量远远不够。本文在各种天气、场景、光照下采集了数万张图像,并对图像进行人工筛选标注,目前已有5 000多张图像用于训练。部分数据如图5所示,扩增的行人数据集中包含学校、街道、车站等不同场景下的样本,组合成一个复杂背景下的真实场景行人数据集,并对训练样本中姿态变化、遮挡、小目标的行人都进行了标注,如:骑自行车、打伞、拥挤,图像中像素很小的行人等。扩增的数据集图像使得行人数据集样本背景复杂化、多样化,并大大增加了对小目标行人标注数目。实验表明:采用本文扩充的行人数据集训练PDIS模型,不管在真实场景下还是小目标行人检测PDIS都取得了非常优秀的效果。

|

Download:

|

| 图 5 真实场景下的训练样本 Fig. 5 Training samples in real scenes | |

本文应用漏检率、准确率来衡量检测算法的性能,通过在INRIA行人数据集的测试集上测试训练好的模型,记录每张图像检测窗口,计算检测框跟真实框的IOU值。假设检测框为

| ${\rm IOU} = \frac{{{\rm area}(B{B_{dt}} \cap B{B_{gt}})}}{{{\rm aera}(B{B_{dt}} \cup B{B_{gt}})}} > 0.5$ | (5) |

在

| 表 2 行人统计量 Tab.2 Pedestrian statistics |

漏检率RM (Miss Rate)定义为

| $ R_M = \frac{{\rm FN}}{{{\rm FN} + {\rm TP}}}$ | (6) |

准确率RP (Precision Rate)定义为

| $R_P = \frac{{\rm TP}}{{{\rm TN} + {\rm FP}}}$ | (7) |

式中:TP、FP、FN分别表示将行人样本分类成行人样本数、将非行人样本分类为行人样本数、将行人样本分类成非行人样本数。

4.2 实验环境与模型对比本文的实验环境为Ubuntu14.04系统,处理器型号为Intel® Xeon(R) CPU E5-2670 v3 @ 2.30 GHz×24,显卡型号为GeForce GTX TITAN X,显存12 GB,内存32 GB。

本文在INRIA行人数据集上,扩增成一个5 000多张图像的数据集,在该数据集上训练了的6个不同的模型,如表3所示,输入图像的大小会直接影响算法的精度和实时性,SSD 300×300比SSD 512×512输入图像小,在INRIA的测试集上测试,一张图像的平均测试时间快了一倍多,但检测精度有所下降;将原始的SSD网络模型conv3_3的特征图引出做检测,并在此基础上融合多个卷基层的特征图做检测,提出了表3的4个检测模型。实验表明引出conv3_3的特征图的模型,相比原始SSD模型在每张图像的平均检测速度有所下降,但测试一张图像最慢速度依然达到0.16s,满足行人检测的实时性要求,并相比原来的SSD算法,本文算法准确率达到了93.8%,漏检率下降至7.4%。

| 表 3 不同模型的检测率 Tab.3 Detection rates of different models |

6种模型在INRIA的测试集上RM-FPPI曲线如图6所示,模型2在INRIA的测试集上取得了最好的检测效果。

|

Download:

|

| 图 6 6种模型在INRIA数据集上RM-FPPI曲线 Fig. 6 Miss Rate-FPPI curves of 6 models on INRIA dataset | |

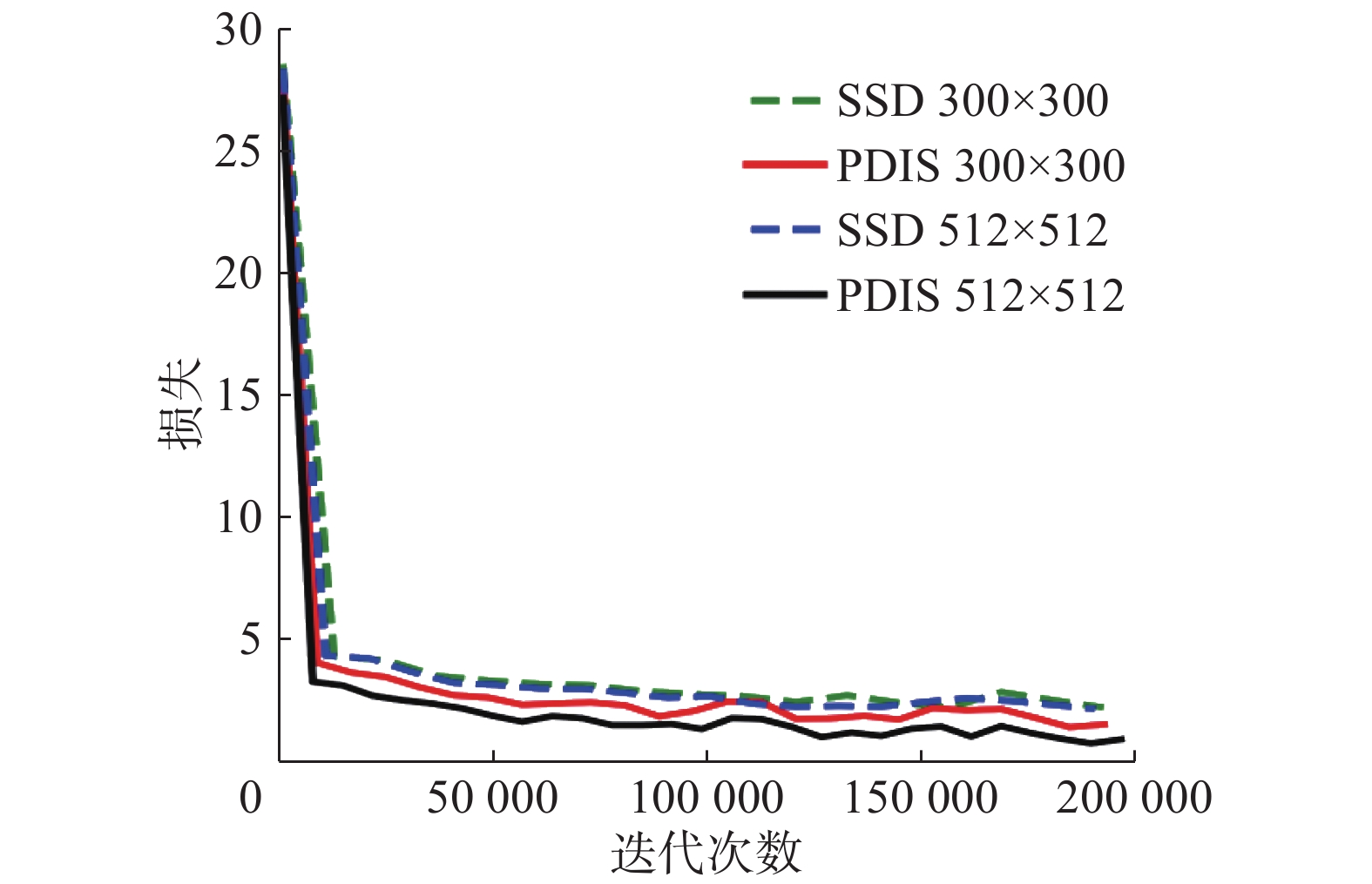

在训练过程中采用本文扩增的数据集,分别用300×300与512×512的图像训练原始的SSD模型及本文改进的模型2,如图7所示,使用300×300的图像训练原始模型时,无法学习到扩增数据集中的小尺寸行人,导致训练loss曲线收敛效果最差,而增加输入图像大小能有效提高收敛效果,利用大小相同的图像分别训练SSD模型与PDIS模型,PDIS的Loss曲线收敛效果较好。因此,本文增加图像大小来训练PDIS模型,能够得到最好的检测模型。

|

Download:

|

| 图 7 不同算法的loss下降曲线 Fig. 7 Loss curves of different algorithms | |

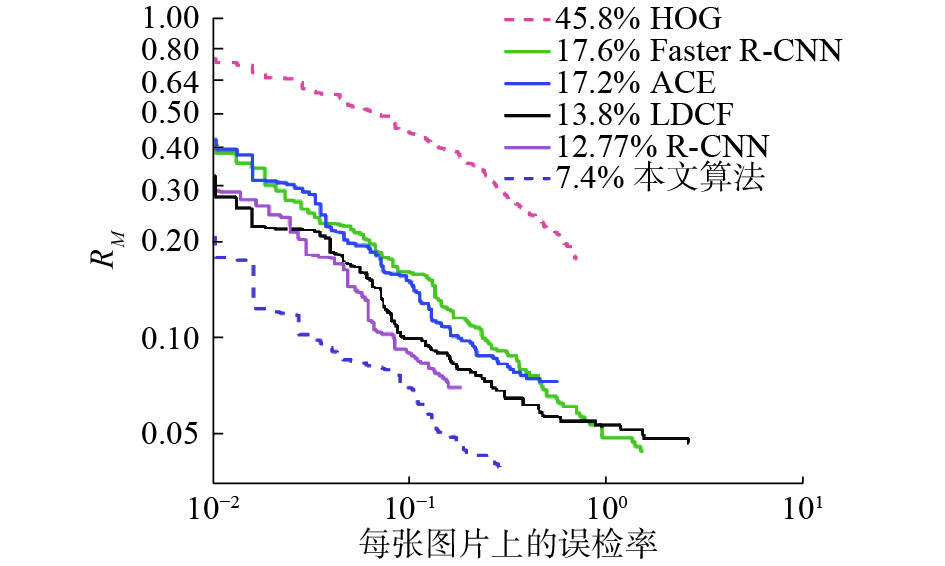

利用当前流行的多个算法在INRIA的测试集上进行测试,实验表明:在扩增的INRIA行人数据集训练PDIS模型的测试漏检率比现有的比较流行的算法都要低,如表4所示,本文的算法取得了最好的效果。

| 表 4 不同算法在INRIA行人数据集的漏检率 Tab.4 Miss rates of different algorithms in the INRIA pedestrian dataset |

不同算法在INRIA的测试集上Miss Rate-FPPI曲线如图8所示,可以看出本文算法在INRIA的测试集上取得了最好的检测效果。

|

Download:

|

| 图 8 不同算法在INRIA数据集上RM-FPPI曲线 Fig. 8 Miss Rate-FPPI curves of different algorithms on INRIA dataset | |

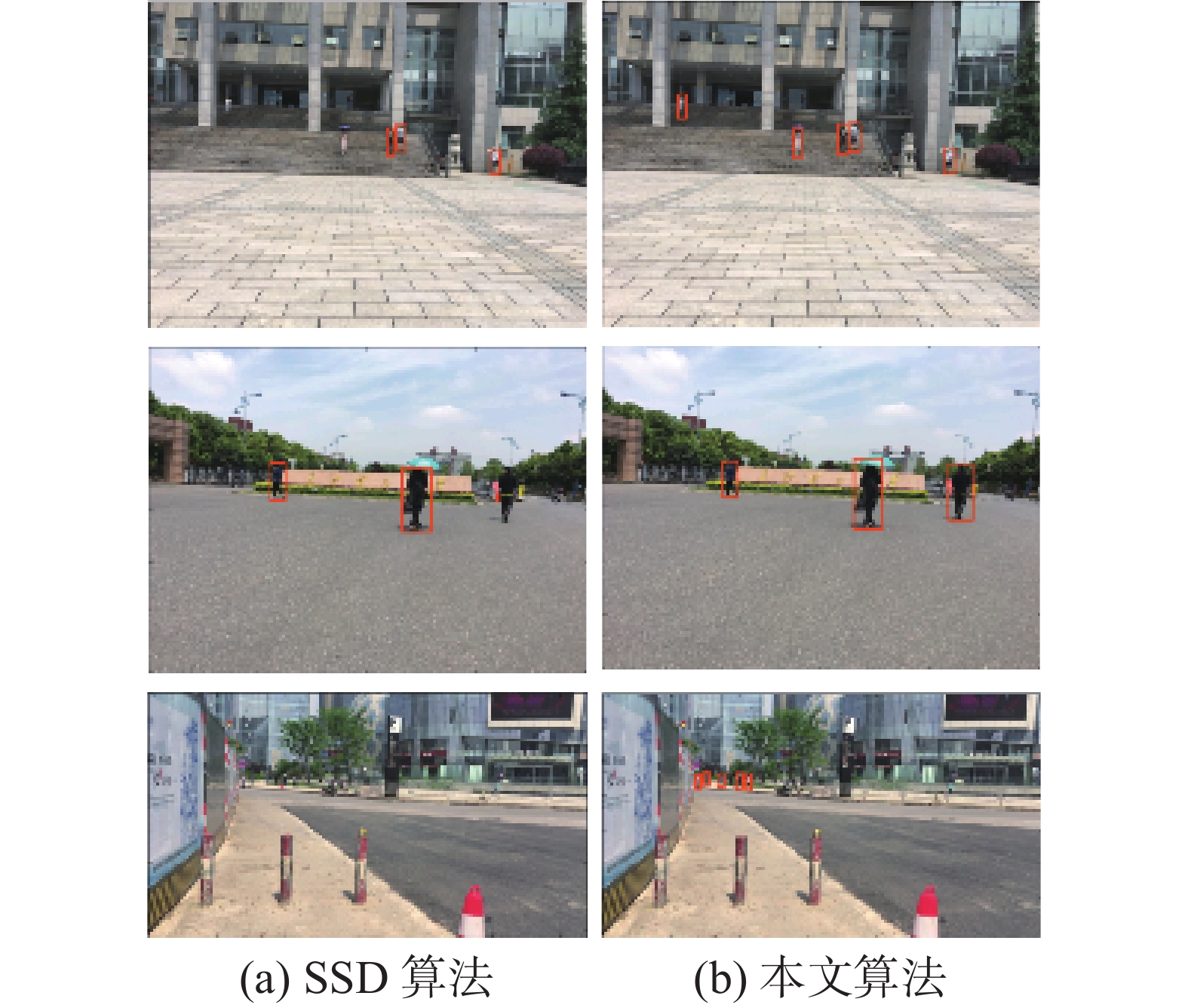

本文对真实场景中拍摄的200张图像进行了测试,从中挑选了3张代表性的图像在2个不同的模型上分别检测,其结果如图9所示,可以看出,针对图像中的大目标行人,PDIS与SSD相比具有同等的检测能力甚至更优;而对图像中的小目标行人,SSD检测性能很差,但PDIS在小目标检测上达到了非常好的性能,漏检率更低。

|

Download:

|

| 图 9 不同算法的行人检测结果 Fig. 9 Pedestrian detection results for different algorithms | |

本文通过引出SSD网络模型中更底层特征图做检测以及增加输入图像大小来增加深度模型的分辨率,相比原始的SSD算法,改进的SSD模型提高了对小目标行人的检测性能。另外增加INRIA数据集的数量跟多样性也是本文算法检测性能提升的主要原因。尽管通过扩增的INRIA数据集训练改进的SSD模型取得较好的检测效果,但检测性能还有待优化。下一步研究工作主要针对两点:1)应用本文算法在多个基准行人数据集(如Caltech行人数据集等)上进行实验,针对每个数据集的测试结果进行统计分析,优化本文算法的检测性能;2)继续扩充行人数据集的数量跟多样性能够进一步的提升算法的检测性能。

| [1] |

宋婉茹, 赵晴晴, 陈昌红, 等. 行人重识别研究综述[J]. 智能系统学报, 2017, 12(6): 770-780. SONG Wanru, ZHAO Qingqing, CHEN Changhong, et al. Survey on pedestrian re-identification research[J]. CAAI transactions on intelligent systems, 2017, 12(6): 770-780. (  0) 0)

|

| [2] |

YE Qixiang, LIANG Jixiang, JIAO Jianbin. Pedestrian detection in video images via error correcting output code classification of manifold subclasses[J]. IEEE transactions on intelligent transportation systems, 2012, 13(1): 193-202. DOI:10.1109/TITS.2011.2167145 ( 0) 0)

|

| [3] |

LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: single shot multibox detector[C]//Proceedings of 2016 European Conference on Computer Vision. Cham, Germany, 2016: 21–37.

( 0) 0)

|

| [4] |

DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C]//IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego, USA, 2005: 886–893

( 0) 0)

|

| [5] |

苏松志, 李绍滋, 陈淑媛, 等. 行人检测技术综述[J]. 电子学报, 2012, 40(4): 814-820. SU Songhi, LI Shaozi, CHEN Shuyuan, et al. A survey on pedestrian detection[J]. Acta electronica sinica, 2012, 40(4): 814-820. (  0) 0)

|

| [6] |

LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International journal of computer vision, 2004, 60(2): 91-110. DOI:10.1023/B:VISI.0000029664.99615.94 ( 0) 0)

|

| [7] |

VIOLA P, JONES M. Rapid object detection using a boosted cascade of simple features[C]//Proceedings of the 2001 IEEE Computer Society Conference Computer Vision and Pattern Recognition. Kauai, USA, 2001: 511–518.

( 0) 0)

|

| [8] |

FERREIRA A J, FIGUEIREDO M A T. Boosting algorithms: a review of methods, theory, and applications[M]. New York, USA: Springer, 2012: 35–85.

( 0) 0)

|

| [9] |

VAPNIK V. The nature of statistical learning theory[M]. 2nd eds. New York: Springer-Verlag, 2000.

( 0) 0)

|

| [10] |

BREIMAN L. Random forests[J]. Machine learning, 2001, 45(1): 5-32. DOI:10.1023/A:1010933404324 ( 0) 0)

|

| [11] |

DOLLÁR P, APPEL R, BELONGIE S, et al. Fast feature pyramids for object detection[J]. IEEE transactions on pattern analysis and machine intelligence, 2014, 36(8): 1532-1545. DOI:10.1109/TPAMI.2014.2300479 ( 0) 0)

|

| [12] |

NAM W, DOLLÁR P, HAN J H. Local decorrelation for improved detection[J]. Advances in neural information processing systems, 2014, 1: 424-432. ( 0) 0)

|

| [13] |

ZHANG Shanshan, BENENSON R, SCHIELE B. Filtered channel features for pedestrian detection[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA, 2015: 1751–1760.

( 0) 0)

|

| [14] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[J]. Advances in neural information processing systems, 2012, 25(2): 1097-1105. ( 0) 0)

|

| [15] |

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[J]. arXiv: 1409.1556, 2014.

( 0) 0)

|

| [16] |

GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, USA, 2014: 580–587.

( 0) 0)

|

| [17] |

REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 ( 0) 0)

|

| [18] |

REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, USA, 2016: 779–788.

( 0) 0)

|

| [19] |

王梦来, 李想, 陈奇, 等. 基于CNN的监控视频事件检测[J]. 自动化学报, 2016, 42(6): 892-903. WANG Menglai, LI Xiang, CHEN Qi, et al. Surveillance event detection based on CNN[J]. Acta automatica sinica, 2016, 42(6): 892-903. (  0) 0)

|

| [20] |

HOSANG J, OMRAN M, BENENSON R, et al. Taking a deeper look at pedestrians[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, USA, 2015: 4073–4082.

( 0) 0)

|

| [21] |

BENENSON R, OMRAN M, HOSANG J, et al. Ten years of pedestrian detection, what have we learned?[C]//Proceedings of 2014 European Conference on Computer Vision. Cham, Germany, 2015: 613–627.

( 0) 0)

|

| [22] |

吕静, 高陈强, 杜银和, 等. 基于双通道特征自适应融合的红外行为识别方法[J]. 重庆邮电大学学报(自然科学版), 2017, 29(3): 389-395. LYU Jing, GAO Chenqiang, DU Yinhe, et al. Infrared action recognition method based on adaptive fusion of dual channel features[J]. Journal of Chongqing university of posts and telecommunications (natural science edition), 2017, 29(3): 389-395. (  0) 0)

|

| [23] |

TIAN Yonglong, LUO Ping, WANG Xiaogang, et al. Deep learning strong parts for pedestrian detection[C]//Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile, 2015: 1904–1912.

( 0) 0)

|

| [24] |

张雅俊, 高陈强, 李佩, 等. 基于卷积神经网络的人流量统计[J]. 重庆邮电大学学报(自然科学版), 2017, 29(2): 265-271. ZHANG Yajun, GAO Chenqiang, LI Pei, et al. Pedestrian counting based on convolutional neural network[J]. Journal of Chongqing university of posts and telecommunications (natural science edition), 2017, 29(2): 265-271. (  0) 0)

|

| [25] |

ZHANG Liliang, LIN Liang, LIANG Xiaodan, et al. Is faster r-cnn doing well for pedestrian detection?[C]//Proceeding of 2016 European Conference on Computer Vision. Cham, Germany, 2016: 443–457.

( 0) 0)

|

| [26] |

ENZWEILER M, GAVRILA D M. Monocular pedestrian detection: survey and experiments[J]. IEEE transactions on pattern analysis and machine intelligence, 2009, 31(12): 2179-2195. DOI:10.1109/TPAMI.2008.260 ( 0) 0)

|

| [27] |

MOHAN A, PAPAGEORGIOU C, POGGIO T. Example-based object detection in images by components[J]. IEEE transactions on pattern analysis and machine intelligence, 2001, 23(4): 349-361. DOI:10.1109/34.917571 ( 0) 0)

|

| [28] |

OVERETT G, PETERSSON L, BREWER N, et al. A new pedestrian dataset for supervised learning[C]//Proceedings of 2008 IEEE Intelligent Vehicles Symposium. Eindhoven, Netherlands, 2008: 373–378.

( 0) 0)

|

| [29] |

GIRSHICK R. Fast R-CNN[C]//Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile, 2015: 1440–1448.

( 0) 0)

|

| [30] |

王成济, 罗志明, 钟准, 等. 一种多层特征融合的人脸检测方法[J]. 智能系统学报, 2018, 13(1): 138-146. WANG Chengji, LUO Zhiming, ZHONG Zhun, et al. Face detection method fusing multi-layer features[J]. CAAI transactions on intelligent systems, 2018, 13(1): 138-146. (  0) 0)

|

2019, Vol. 14

2019, Vol. 14