2. 无锡职业技术学院 物联网技术学院,江苏 无锡 214121

2. School of Internet of things technology, Wuxi Institute of Technology, Wuxi 214121, China

1985年,Powell提出多变量插值的径向基函数(radical basic function, RBF)方法。1988年,Moody和Darken[1]提出了一种神经网络结构,即RBF神经网络。该网络能够以任意精度逼近任意连续函数,非线性拟合能力强,具有很强的鲁棒性,因此应用广泛,如海洋表面温度预测[2]、网络安全态势预测[3]、智能轮椅自适应控制[4]、失业率预测[5]、电力系统的可用输电能力在线估计[6]、在线恶意垃圾邮件检测[7]等。随着应用范围的推广,研究者们发现RBF神经网络仍存在一些不足,制约其进一步的发展和应用,故许多专家学者提出了一些改进算法,如有学者提出对神经网络的结构进行优化,相关学习算法主要有两大类:1)先构造复杂的网络结构,再通过训练精简网络结构,如韩敏等[8]提出了一种改进的RAN算法,该方法采用样本的输入输出信息对网络进行初始化,再根据FPE剪枝策略对网络结构进行简化;2)先采用精简的网络结构,再通过训练增大网络规模,直至达到泛化要求,如Platt等[9]提出了一种资源分配网络,该方法首先创建一个精简网络,当网络出现异常模式时,通过分配新单元和修改已有单元参数来进行学习,直至网络稳定。基于聚类的RBF神经网络隐含层数据中心一般通过K-means聚类算法获得,故有学者提出对该聚类方法进行优化以提高算法泛化性能[10-12]。此外,还有一些学者研究各种基于进化算法的RBF神经网络[13-15]。如Lacerda等[13]提出使用遗传算法优化学习参数;Shekhar等[14]提出使用模拟退火算法确定神经网络的连接权值;Alexandridis等[15]提出使用粒子群算法和模糊均值法确定隐含层的中心,改进网络的结构等。

从上述文献综述可以发现,以往的研究主要围绕RBF神经网络的网络结构和参数设计展开,所解决问题的场景是采集到的数据能反映数据集的分布情况,但在实际应用中,信息采集器或传感器设备可能会出现故障,导致采集到的数据不完整。训练样本不完整,或多或少都会影响RBF神经网络的学习效率,使网络的推广能力变差。训练样本反映数据集总体分布的程度对算法的泛化性能有着重要的影响。到目前为止,样本数量和质量对RBF神经网络算法泛化性能影响方面的研究还不多。针对上述问题,本文将迁移学习思想引入RBF神经网络,提出已标签样本少时的RBF神经网络学习算法。所谓迁移学习,就是学习已有的源领域知识来解决目标领域中已标签样本数量较少甚至没有的学习问题[16-17]。该思想已广泛应用于分类、回归、概率密度估计等各类机器学习领域。本文在文献[18]提出的

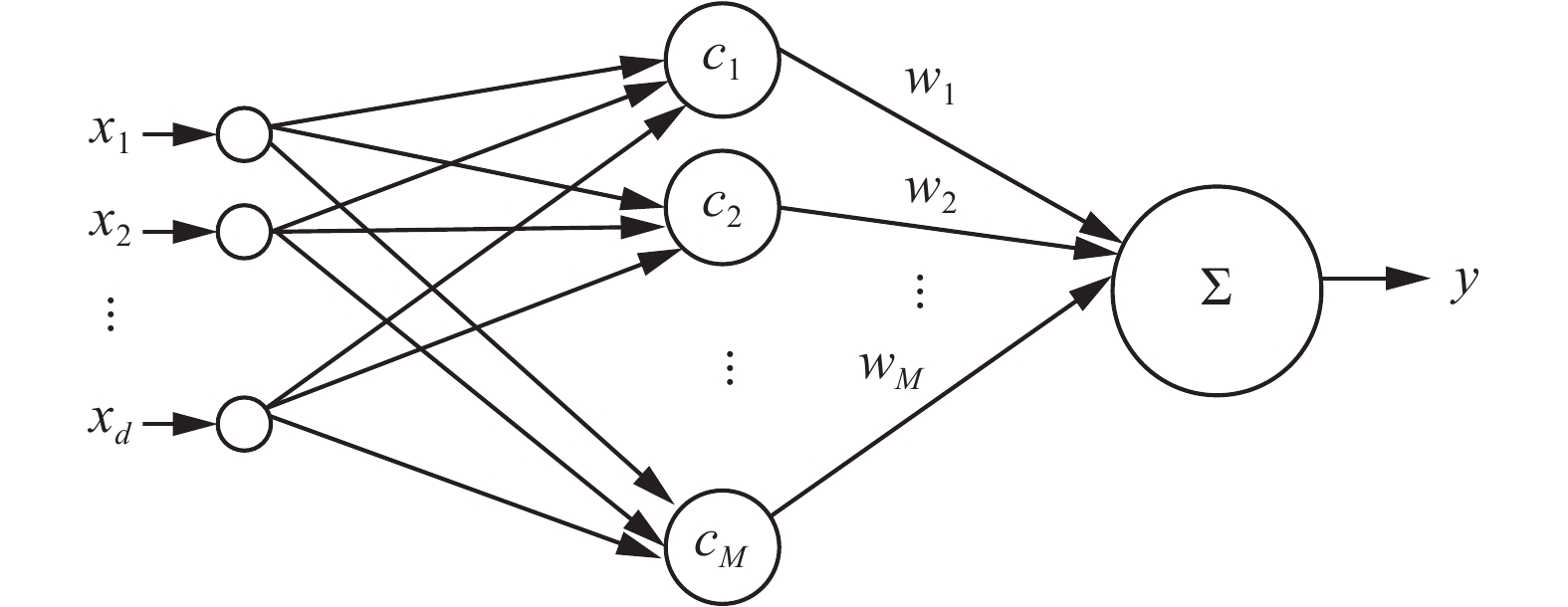

RBF神经网络由输入层、隐含层和输出层组成,由图1所示。其中,

|

Download:

|

| 图 1 RBF神经网络模型 Fig. 1 The model of RBF neural network | |

在RBF神经网络中,输入层接收训练样本;隐含层节点通过径向基函数执行一种非线性变化,将输入空间映射到一个新的空间,若该径向基函数定义为高斯函数,设

| $\phi \left( {\left\| {{{x}} - {{{c}}_i}} \right\|} \right) = \exp \left( { - \frac{{{{\left\| {{{x}} - {{{c}}_i}} \right\|}^2}}}{{{\delta _i}}}} \right)$ | (1) |

输出层节点在该新空间实现线性加权组合。设

| $y = f\left( {{x}} \right) = \sum\limits_{i = 1}^M {{w_i}\phi \left( {\left\| {{{x}} - {{{c}}_i}} \right\|} \right)}\quad\quad i = 1,2, \cdots ,M$ | (2) |

由第1节介绍可知,RBF神经网络的参数有3个,径向基函数的中心向量

| $c_{ik}^{} = \frac{{\displaystyle\sum\limits_{j = 1}^n {{\mu _{ji}}{x_{jk}}} }}{{\displaystyle\sum\limits_{j = 1}^n {{\mu _{ji}}} }},\delta _i^{} = h\frac{{\displaystyle\sum\limits_{j = 1}^n {{\mu _{ji}}{{\left\| {{{{x}}_j} - {{{c}}_i}} \right\|}^2}} }}{{\displaystyle\sum\limits_{j = 1}^n {{\mu _{ji}}} }}$ | (3) |

令

| ${{{\tilde x}}_g} = {\left[ {{{\tilde x}^1}\,\,{{\tilde x}^2}\,\, \cdots \,\,{{\tilde x}^M}} \right]^{\rm{T}}}$ | (4) |

通过式(3)得到径向基函数的中心

设

| $y = {{{p}}_g}^{\rm{T}}{{{\tilde x}}_g}$ | (5) |

由式(5)可知,当径向基函数隐含层被估计后,网络的输出可转换成一个线性模型。

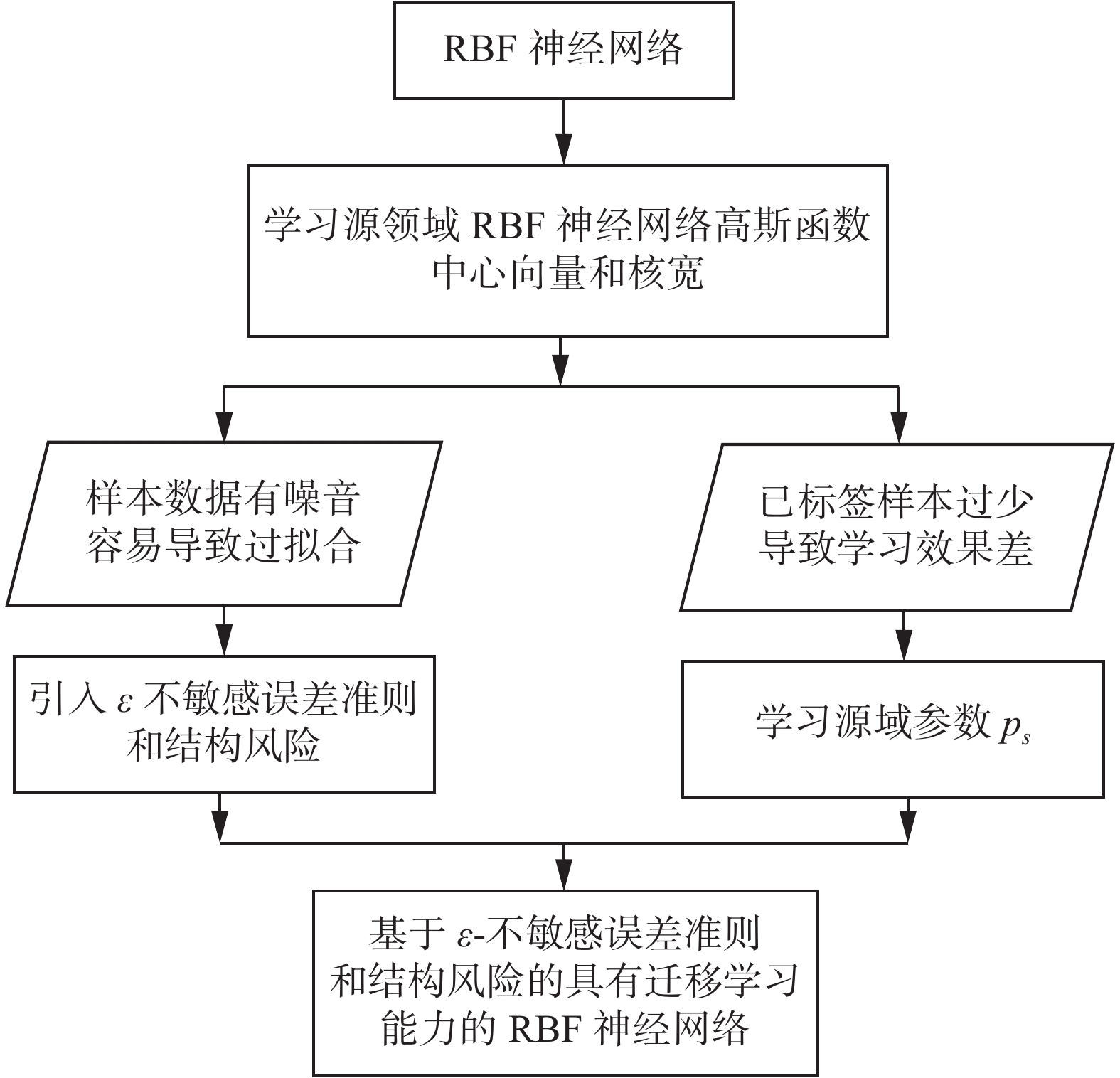

3 具有迁移学习能力的RBF神经网络对于经典的RBF神经网络算法中的参数

|

Download:

|

|

图 2 |

|

下面具体介绍算法的实现。

设源领域高斯函数中心向量集

1)设

| ${{{c}}_{gi}} = {{{c}}_i},\delta _{gi}^{} = {h_g}\frac{{{\delta _i}}}{{{h_s}}},i = 1,2, \cdots ,M$ | (6) |

2)引入

首先,给出

定义 (线性)

| ${L^\varepsilon }\left( {{{x}},y,f} \right) = {\left| {y - f\left( {{x}} \right)} \right|_\varepsilon } = \max \left( {0,{{\left| {y - f\left( {{x}} \right)} \right|}_\varepsilon }} \right)$ |

式中:

对于式(5)线性模型,其对应的

| $\begin{gathered} \sum\limits_{i = 1}^n {{{\left| {y_i^o - {y_i}} \right|}_\varepsilon }} = \sum\limits_{i = 1}^n {\max \left( {0,\left| {y_i^o - {y_i}} \right| - \varepsilon } \right)} = \\ \sum\limits_{i = 1}^n {\max \left( {0,\left| {{{{p}}_g}^{\rm{T}}{{{{\tilde x}}}_{gi}} - {y_i}} \right| - \varepsilon } \right)} \\ \end{gathered} $ | (7) |

式中:

对于式(7),

| $\left\{ {\begin{array}{*{20}{c}}{{y_i} - {{{p}}_g}^{\rm{T}}{{{{\tilde x}}}_{gi}} < \varepsilon + \xi _i^{}}\\{{{{p}}_g}^{\rm{T}}{{{{\tilde x}}}_{gi}} - {y_i} < \varepsilon + \xi _i^*}\end{array}} \right.,\xi _i^{} \geqslant 0,\xi _i^* \geqslant 0$ | (8) |

本算法的目的是要使式(7)表示的

| $\begin{gathered} \min \sum\limits_{i = 1}^n {\left( {{\xi _i} + \xi _i^*} \right)} \\ {\rm{s.t.}}\left\{ {\begin{array}{*{20}{c}} {{y_i} - {{{p}}_g}^{\rm{T}}{{{{\tilde x}}}_{gi}} < \varepsilon + \xi _i^{}} \\ {{{{p}}_g}^{\rm{T}}{{{{\tilde x}}}_{gi}} - {y_i} < \varepsilon + \xi _i^*} \end{array}} \right.,{\xi _i} \geqslant 0,\xi _i^* \geqslant 0 \\ \end{gathered} $ | (9) |

接着,加入结构化风险项。支持向量机是结构风险最小化原则的一种实现,学习支持向量机的实现方法,引入正则化项

| $\begin{gathered} \mathop {\min }\limits_{{{p}},{\xi _i},{\xi _i}^*} \frac{1}{2}{\left\| {{{{p}}_g}} \right\|^2} + C\sum\limits_{i = 1}^n {\left( {{\xi _i} + {\xi _i}^*} \right)} \\{\rm{s.t.}}\left\{ {\begin{array}{*{20}{c}} {{y_i} - {{{p}}_g}^{\rm{T}}{{{{\tilde x}}}_{gi}} < \varepsilon + \xi _i^{}} \\ {{{{p}}_g}^{\rm{T}}{{{{\tilde x}}}_{gi}} - {y_i} < \varepsilon + \xi _i^*} \end{array}} \right.,{\xi _i} \geqslant 0,\xi _i^* \geqslant 0,i = 1,2, \cdots ,n \\ \end{gathered} $ | (10) |

最后,为了使本文提出算法具有迁移学习能力,在学习源领域径向基函数的中心向量和核宽后,加入学习源领域模型参数

| $\begin{gathered} \mathop {\min }\limits_{{{p}},{\xi _i},{\xi _i}^*} \frac{1}{2}{\left\| {{{{p}}_g}} \right\|^2} + C\sum\limits_{i = 1}^n {\left( {{\xi _i} + {\xi _i}^*} \right)} + \frac{\lambda }{2}{\left\| {{{{p}}_s} - {{{p}}_g}} \right\|^2} \\{\rm{s.t.}}\left\{ {\begin{array}{*{20}{c}} {{y_i} - {{{p}}_g}^{\rm{T}}{{{{\tilde x}}}_{gi}} < \varepsilon + \xi _i^{}} \\ {{{{p}}_g}^{\rm{T}}{{{{\tilde x}}}_{gi}} - {y_i} < \varepsilon + \xi _i^*} \end{array}} \right.,{\xi _i} \geqslant 0,\xi _i^* \geqslant 0,i = 1,2, \cdots ,n \\ \end{gathered} $ | (11) |

引入拉格朗日乘子,构造出式(11)的拉格朗日函数:

| $\begin{gathered} L = \frac{1}{2}{\left\| {{{{p}}_g}} \right\|^2} + C\sum\limits_{i = 1}^n {\left( {{\xi _i} + {\xi _i}^*} \right)} + \frac{\lambda }{2}{\left\| {{{{p}}_s} - {{{p}}_g}} \right\|^2} + \\ \sum\limits_{i = 1}^n {{\alpha _i}\left( {{y_i} - {{{p}}_g}{}^{\rm{T}}{{{{\tilde x}}}_{gi}} - \varepsilon - {\xi _i}} \right)} + \sum\limits_{i = 1}^n {{\alpha _i}^*\left( {{{{p}}_g}{}^{\rm{T}}{{{{\tilde x}}}_{gi}} - {y_i} - \varepsilon - {\xi _i}^*} \right)} - \\ \sum\limits_{i = 1}^n {{\beta _i}} {\xi _i} - \sum\limits_{i = 1}^n {{\beta _i}^*} {\xi _i}^* \\ \end{gathered} $ | (12) |

式(12)相应的对偶问题形式为

| $\begin{gathered} \mathop {\max }\limits_{{\alpha }} - \frac{{\displaystyle\sum\limits_{i = 1}^n {\sum\limits_{j = 1}^n {\left( {{\alpha _i} - {\alpha _i}^*} \right)\left( {{\alpha _j} - {\alpha _j}^*} \right){{{{\tilde x}}}_{gi}}^{\rm{T}}{{{{\tilde x}}}_{gj}}} } }}{{2\left( {1 + \lambda } \right)}} + \\ \sum\limits_{i = 1}^n {{\alpha _i}\left( {{y_i} - \varepsilon - \frac{\lambda }{{\left( {1 + \lambda } \right)}}{{{p}}_s}^{\rm{T}}{{{{\tilde x}}}_{gi}}} \right)} + \\ \sum\limits_{i = 1}^n {{\alpha _i}^*\left( { - {y_i} - \varepsilon + \frac{\lambda }{{\left( {1 + \lambda } \right)}}{{{p}}_s}^{\rm{T}}{{{{\tilde x}}}_{gi}}} \right)}\\ {\rm{s.t.}}\quad\quad 0 \leqslant {\alpha _i}^{(*)} \leqslant C \\ \end{gathered} $ | (13) |

利用式(13)得到最优解:

| ${{{p}}_g} = \displaystyle\frac{{\displaystyle\sum\limits_{i = 1}^n {\left( {{\alpha _i} - {\alpha _i}^*} \right){{{{\tilde x}}}_{gi}}} + \lambda {{{p}}_s}}}{{\left( {1 + \lambda } \right)}}$ | (14) |

基于上述分析,基于

1) 学习源领域径向基函数中心向量和核宽,确定hg值,带入式(6),得目标领域高斯函数中心向量cgi和核宽δgi;

2) 将目标领域高斯核中心向量cgi和核宽δgi带入式(1)得

3) 求解式(13)对应的二次规划问题;

4) 利用式(13)求得的二次规划最优解,根据式(14)求得隐含层和输出层之间的权值

5) 利用公式

上述算法参数设置除高斯函数核宽中的可调参数hg外,还有式(13)需设置的3个参数,分别是

本节利用模拟数据集和在谷氨酸发酵过程中采集的真实数据集对本文所提算法进行实验验证。在4.2节和4.3节分别描述模拟数据集和真实数据集的构成及实验结果分析。为了突显本文所提算法的优势,两组实验在3个场景下进行,场景1为目标域数据集RBF神经网络算法训练;场景2为源领域历史数据集和目标领域当前数据集RBF神经网络算法合并训练;场景3为加入源领域历史知识的目标领域数据集

为了有效评估算法的性能,采用如下性能指标[18]:

| $J = \sqrt {{{\frac{1}{N}\sum\limits_{i = 1}^N {{{\left( {{y_i}' - {y_i}} \right)}^2}} }/{\left[ {\frac{1}{N}\sum\limits_{i = 1}^N {{{\left( {{y_i} - \bar y} \right)}^2}} } \right]}}} $ |

式中:N表示测试样本规模,yi表示第i个样本的采样输出,

在已标签数据较少而导致RBF神经网络预测精度降低的前提下,验证本文所提算法可通过学习相关历史领域知识提高预测精度。所设计的模拟数据集符合以下两个原则:1)当前数据集和历史数据集既存在相关性,又有自己的数据分布特点;2)当前目标域数据集已标签样本较少,无法反映出数据集的整体分布情况。

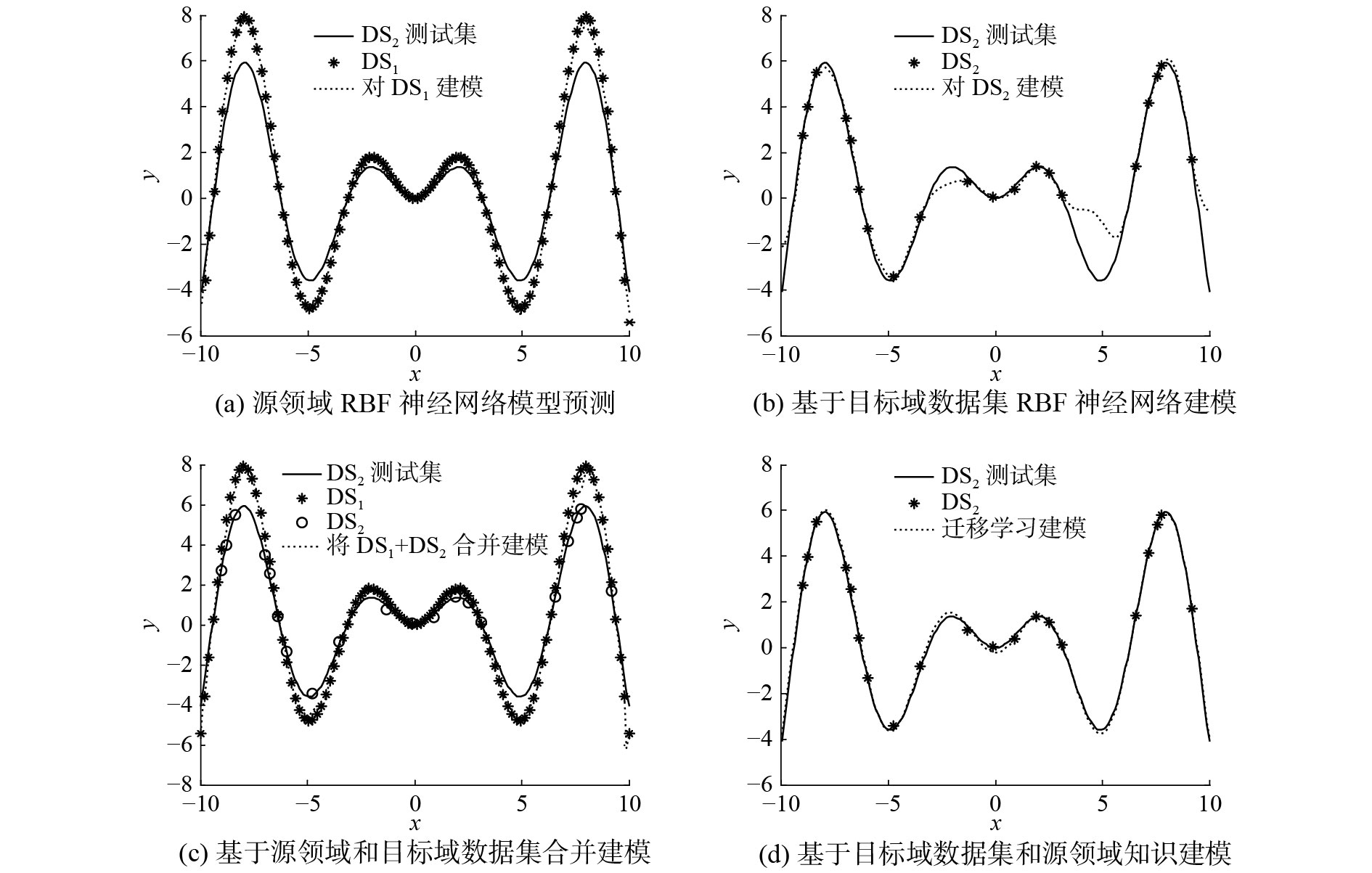

为了表征以上两个原则,采用函数

|

Download:

|

| 图 3 目标域场景函数和源域场景函数 Fig. 3 Target domain functions and source domain functions | |

实验在相关系数

| 表 1 各种算法在模拟数据集上的泛化性能比较 Tab.1 Comparison of generalization performance of various algorithms on artificial data sets |

|

Download:

|

| 图 4 相关系数为0.75时,各算法性能 Fig. 4 The performance of each algorithm on r is 0.75 | |

1) 观察表1和图1(a)可知,若直接使用源域模型对目标领域测试集进行预测,目标领域和源领域差异由r为0.9时的0.106 1增大到r为0.65时的0.521 9。随着r系数的减小,源领域与目标域数据分布差异增大,误差增幅明显。

2) 目标域数据集规模较小,存在某些数据段缺失的现象,不能反映目标域数据集的整体分布,如图4(b)所示。传统RBF神经网络算法可以对当前采样数据集逼近,但无法对缺失的地方进行弥补,导致仅用目标域数据集进行训练泛化性能不高,如表1和图4(b)所示。

3) 将源领域数据集和目标域数据集合并训练,算法性能较仅用源领域进行训练并没有明显提高,如表1和图4(c)所示。其原因是源领域数据集对目标领域数据集来说,规模很小,其对于建模的影响作为可容忍噪声忽略了。此外,一些高度机密的源领域历史数据集很难获取,合并训练并不一定能实现。

4) 从表1和图4(d)可知,基于历史知识的迁移学习算法具有较好的性能。和仅用目标领域数据集训练相比,缺失的部分通过历史知识的学习加以弥补,提高了泛化性能;和源领域及目标领域数据集合并训练相比,不仅提高了精度,且因为学习的是知识,而不是所有历史数据集参与训练,历史场景数据还具有保密性。

由此,可以得出结论,本文所提算法解决了RBF-NN算法不具有迁移学习能力的问题。

4.3 真实数据集实验本部分实验数据来自工厂采集到的真实发酵数据集[19]。该数据集记录了食品发酵过程中记录下的21批数据,每批数据有14条记录,共有294条记录。该数据集记录了发酵过程的采样时间(h),葡萄糖浓度(Glucose concentration),菌体浓度(Thalli concentration)和谷氨酸浓度(Glutamic acid concentration)。其输出为下一时刻的葡萄糖浓度(h+1)、菌体浓度(h+1)和谷氨酸浓度(h+1)。将前1~16批数据共224条记录作为源领域数据集;剩余的5批数据中,17~19批数据42条记录中,任意选取20条记录作为目标域数据集,数据集已标签样本较少,不能反映数据集的整体分布情况;20~21批数据作为目标域测试数据集。

实验中,用3个单输出系统进行仿真,且将RBF、

观察图5和表2,可以得出如下结论,因目标域训练集已标签数据较少,而RBF和

|

Download:

|

| 图 5 各种算法泛化性能比较 Fig. 5 Comparison of generalization performance of various algorithms | |

| 表 2 各种算法于真实发酵数据集上性能比较 Tab.2 Comparison of performance of various algorithms on real fermentation data sets |

RBF神经网络算法基于最小平方误差准则,对小样本数据集或存在噪声的数据集容易过拟合而导致泛化性能下降。

已有RBF神经算法及其改进算法大多未考虑采样样本不能反映数据集整体分布而导致算法泛化性能降低的情况。本文通过采用知识迁移的思想,提出能充分学习源领域知识的具有迁移学习能力的RBF神经网络学习算法。本文所提方法并不需要大量源领域样本参与目标领域模型的建立,仅是学习源领域的高斯核中心向量及核宽以及源领域模型参数帮助数据存在一定程度的信息缺失的目标领域建立模型,这是传统的RBF神经网络学习算法所不具备的。通过合成数据实验以及真实发酵过程的仿真实验,验证了本文方法较之于传统方法具有更好适应性。但本文方法采用网格搜索策略和交叉验证方法来获得各个参数的值,加大了获取各参数最优值的工作量,在今后的工作中,将致力于研究两个领域间的相关性与

| [1] |

MOODY J, DARKEN C J. Fast learning in networks of locally-tuned processing units[J]. Neural computation, 1989, 1(2): 281-294. DOI:10.1162/neco.1989.1.2.281 ( 0) 0)

|

| [2] |

RYU D, LIANG Faming, MALLICK B K. Sea surface temperature modeling using radial basis function networks with a dynamically weighted particle filter[J]. Journal of the American statistical association, 2013, 108(501): 111-123. DOI:10.1080/01621459.2012.734151 ( 0) 0)

|

| [3] |

李方伟, 郑波, 朱江, 等. 一种基于AC-RBF神经网络的网络安全态势预测方法[J]. 重庆邮电大学学报: 自然科学版, 2014, 26(5): 576-581. LI Fangwei, ZHENG Bo, ZHU Jiang, et al. A method of network security situation prediction based on AC-RBF neural network[J]. Journal of Chongqing university of posts and telecommunications: natural science edition, 2014, 26(5): 576-581. (  0) 0)

|

| [4] |

樊劲辉, 贾松敏, 李秀智. 基于RBF神经网络的全向智能轮椅自适应控制[J]. 华中科技大学学报: 自然科学版, 2014, 42(2): 111-115. FAN Jinhui, JIA Songmin, LI Xiuzhi. Adaptive control for omni–directional intelligent wheelchairs based on RBF neural network[J]. Journal of Huazhong university of science and technology: nature science edition, 2014, 42(2): 111-115. (  0) 0)

|

| [5] |

STASINAKIS C, SERMPINIS G, THEOFILATOS K, et al. Forecasting us unemployment with radial basis neural networks, Kalman filters and support vector regressions[J]. Computational economics, 2016, 47(4): 569-587. DOI:10.1007/s10614-014-9479-y ( 0) 0)

|

| [6] |

PRATHIBA R, BALASINGHMOSES M, DEVARAJ D, et al. Multiple output radial basis function neural network with reduced input features for on-line estimation of available transfer capability[J]. Control engineering and applied informatics, 2016, 18(1): 95-106. ( 0) 0)

|

| [7] |

ALI S H A, OZAWA S, NAKAZATO J, et al. An online malicious spam email detection system using resource allocating network with locality sensitive hashing[J]. Journal of intelligent learning systems and applications, 2015, 7(2): 55866. ( 0) 0)

|

| [8] |

韩敏, 穆云峰. 一种改进的RAN网络结构优化算法[J]. 控制与决策, 2007, 22(10): 1177-1180. HAN Min, MU Yunfeng. Improved learning algorithm for optimizing RAN network structure[J]. Control and decision, 2007, 22(10): 1177-1180. DOI:10.3321/j.issn:1001-0920.2007.10.021 (  0) 0)

|

| [9] |

PLATT J. A resource-allocating network for function interpolation[J]. Neural computation, 1991, 3(2): 213-225. DOI:10.1162/neco.1991.3.2.213 ( 0) 0)

|

| [10] |

SARIMVEIS H, DOGANIS P, ALEXANDRIDIS A. A classification technique based on radial basis function neural networks[J]. Advances in engineering software, 2006, 37(4): 218-221. DOI:10.1016/j.advengsoft.2005.07.005 ( 0) 0)

|

| [11] |

RAITOHARJU J, KIRANYAZ S, GABBOUJ M. Training radial basis function neural networks for classification via class-specific clustering[J]. IEEE transactions on neural networks and learning systems, 2016, 27(12): 2458-2471. DOI:10.1109/TNNLS.2015.2497286 ( 0) 0)

|

| [12] |

PEDRYCZ W. Conditional fuzzy clustering in the design of radial basis function neural networks[J]. IEEE transactions on neural networks, 1998, 9(4): 601-612. DOI:10.1109/72.701174 ( 0) 0)

|

| [13] |

LACERDA E, DE CARVALHO A, LUDERMIR T. Evolutionary optimization of RBF networks[J]. International journal of neural systems, 2001, 11(3): 287-294. DOI:10.1142/S0129065701000734 ( 0) 0)

|

| [14] |

SHEKHAR S, AMIN M B. Generalization by neural networks[J]. IEEE transactions on knowledge and data engineering, 1992, 4(2): 177-185. DOI:10.1109/69.134256 ( 0) 0)

|

| [15] |

ALEXANDRIDIS A, CHONDRODIMA E, SARIMVEIS H. Radial basis function network training using a nonsymmetric partition of the input space and particle swarm optimization[J]. IEEE transactions on neural networks and learning systems, 2013, 24(2): 219-230. DOI:10.1109/TNNLS.2012.2227794 ( 0) 0)

|

| [16] |

PAN S J, YANG Qiang. A survey on transfer learning[J]. IEEE transactions on knowledge and data engineering, 2010, 22(10): 1345-1359. DOI:10.1109/TKDE.2009.191 ( 0) 0)

|

| [17] |

张雅俊, 高陈强, 李佩, 等. 基于卷积神经网络的人流量统计[J]. 重庆邮电大学学报: 自然科学版, 2017, 29(2): 265-271. ZHANG Yajun, GAO Chenqiang, LI Pei, et al. Pedestrian counting based on convolutional neural network[J]. Journal of Chongqing university of posts and telecommunications: natural science edition, 2017, 29(2): 265-271. (  0) 0)

|

| [18] |

桑庆兵, 邓赵红, 王士同, 等. 基于ε-不敏感准则和结构风险的鲁棒径向基函数神经网络学习

[J]. 电子与信息学报, 2012, 34(6): 1414-1419. SANG Qingbing, DENG Zhaohong, WANG Shitong, et al. ε-insensitive criterion and structure risk based radius-basis-function neural-network modeling [J]. Journal of electronics & information technology, 2012, 34(6): 1414-1419. (  0) 0)

|

| [19] |

邓乃扬, 田英杰. 支持向量机: 理论、算法与拓展[M]. 北京: 科学出版社, 2009: 63–80.

( 0) 0)

|

| [20] |

蒋亦樟, 邓赵红, 王士同. ML型迁移学习模糊系统[J]. 自动化学报, 2012, 38(9): 1393-1409. JIANG Yizhang, DENG Zhaohong, WANG Shitong. Mamdani-Larsen type transfer learning fuzzy system[J]. Acta automatica sinica, 2012, 38(9): 1393-1409. (  0) 0)

|

2018, Vol. 13

2018, Vol. 13