年龄相关性黄斑变性,青光眼和糖尿病视网膜病变是欧洲可预防性失明的最常见原因[1]。通过眼底图像中血管和病变的形状和结构能轻易地检测出这些疾病。同时,眼底照片是人眼内表面的投影彩色图像,属于非侵入方式检查视网膜进行疾病诊断的方法[2]。因此,对视网膜血管进行有效地分割,进而分析视网膜血管的形态属性来辅助前面提到的疾病的诊断、筛查、治疗和评估,具有重要的应用价值。

视网膜图像一般通过点光源提供光照,然后通过摄像机拍摄获取。这种获取方式会导致图像光照不均匀,血管与图像背景的对比度较小,加大了血管末梢被检测出来的难度。此外,视网膜血管错综复杂,完全依赖人工进行分割,非常耗费资源。人体视网膜涉及到个人隐私,导致了图像的获取难度较大,因此,视网膜数据集都比较小。面对这些状况,国内外研究者做了大量的研究。

视网膜血管图像中像素的上下文等信息对于图像分割非常重要,传统的只利用像素的局部信息而忽略上下文等信息的分割算法效果普遍不佳。Orlando等[3]提出基于条件随机场的分割方法,以完全连通的条件随机场为基本模型,使用支持向量机学习该模型的参数,但准确率低于87%;Magdalena提出基于数学形态学的分割方法,该方法结合了形态学和离散小波变换,准确率也没有超过90%;Kharghanian等[5]提出基于小波变换的视网膜分割方法,将分割定性为像素二分类,利用Gabor小波和线算子提取分类特征进行分类,在DRIVE数据库上的最高准确率为94.69%;Akram MU等[6]提出基于阈值的分割方法,先进行视网膜结构化增强,再使用多层阈值方法进行分割,该操作流程的准确率为94.85%。在国内,蒋芸[7]利用生成对抗网络对视网膜图像进行分割,基于改进的生成器部分,他们在DRIVE的精度为96.08%;梁礼明等[8]先增大图像对比度,再基于DenseNet和U-Net对视网膜图像进行分割,DRIVE数据集上的平均准确度为96.74%。

2012年Alex等[9]堆叠多个卷积并用GPU加速计算,成为ImageNet图像分类竞赛的冠军,而FCN[10]则开启了卷积神经网络用于图像分割的新征程。2016年,U-Net模型,采用编码-解码的对称结构,通过卷积下采样获取图像特征,插值或反卷积上采样逐步修复物体的细节和空间维度,解决了生物医学图像中小样本数据分割的难题。卷积神经网络能取得如此好的分类、分割效果,主要原因是利用了图像中像素的各种高级特征信息,如上下文特征与纹理特征等。深度卷积神经网络中常用深度堆叠卷积块[9, 11-13]或利用空洞卷积[14],逐渐扩大卷积的感受域获取高级特征信息。此外,利用不同感受域的卷积特征,如多路径网络RefineNet[15]与特征金字塔网络FPN [16],能进一步提升图像分割的效果。鉴于深度学习在图像分割中的广泛应用,视网膜血管分割也引入了深度学习方法,且取得非常显著的成绩。比如基于U-Net改进的R2U-Net[17]模型,利用递归结构与残差结构增大上下文信息的获取程度,达到95.56%的准确率;而LadderNet[18]通过级联U-Net,构造了多条从输入到输出的路径,使分割准确率超过了R2U-Net。可见,对像素的上下文等信息利用越充分,分割效果往往越好。

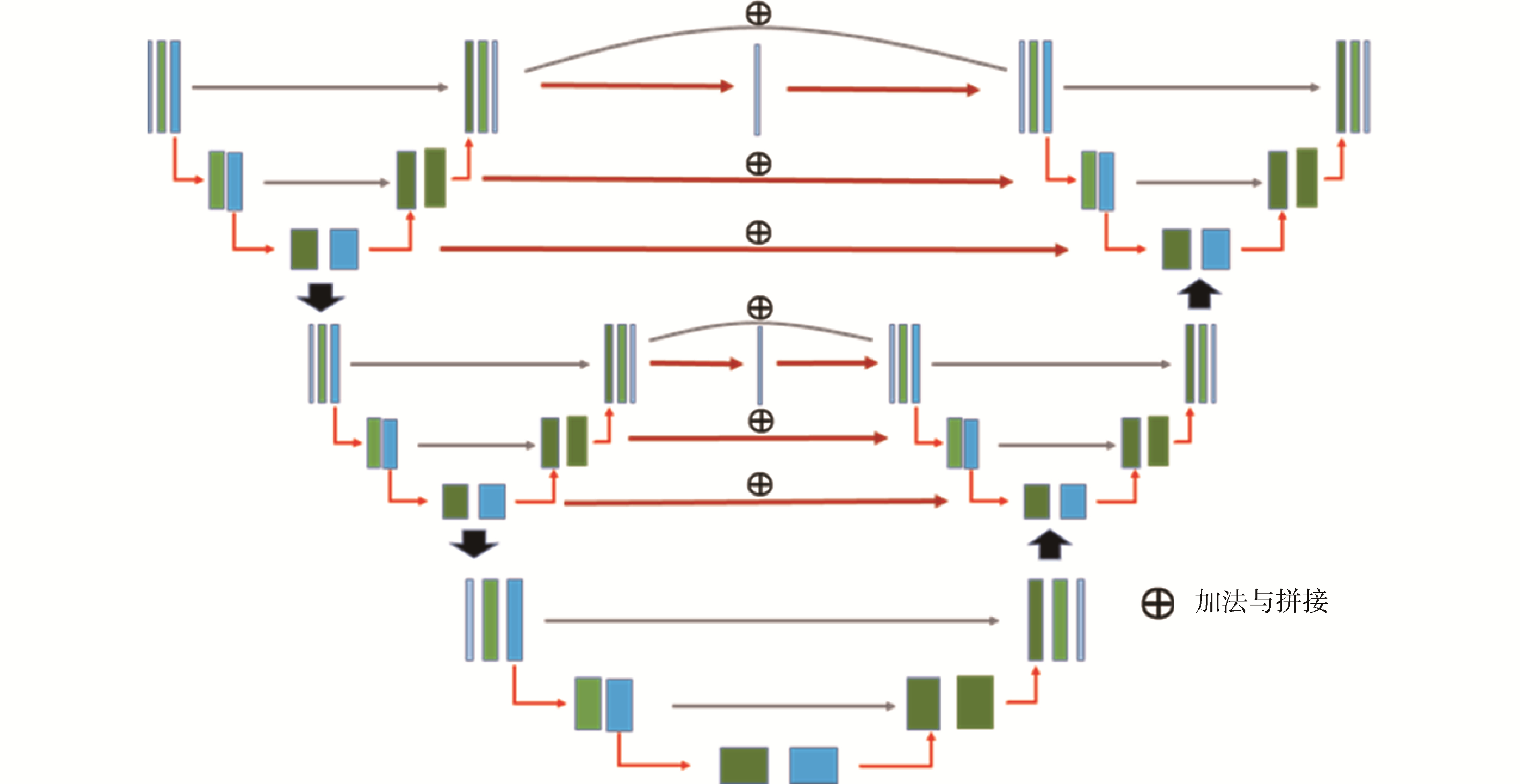

本文提出的UU-Net借鉴了级联U-Net的构想,并加以改进,使其能更充分地利用像素的上下文特征、纹理特征等各种信息,解决细小血管难以分割的问题。在U-Net内部,我们引入残差结构代替普通卷积,使得网络深度增加,能获取更多的信息,同时延缓模型训练中的梯度消失。在U-Net模块之间,我们对特征图进行Addition或者Concatenation操作,构建出多条传递信息的路径,每一条传递信息的路径实质是一个FCN变体。因此,我们的网络能够获取到图像中的更多信息,包括上下文特征。

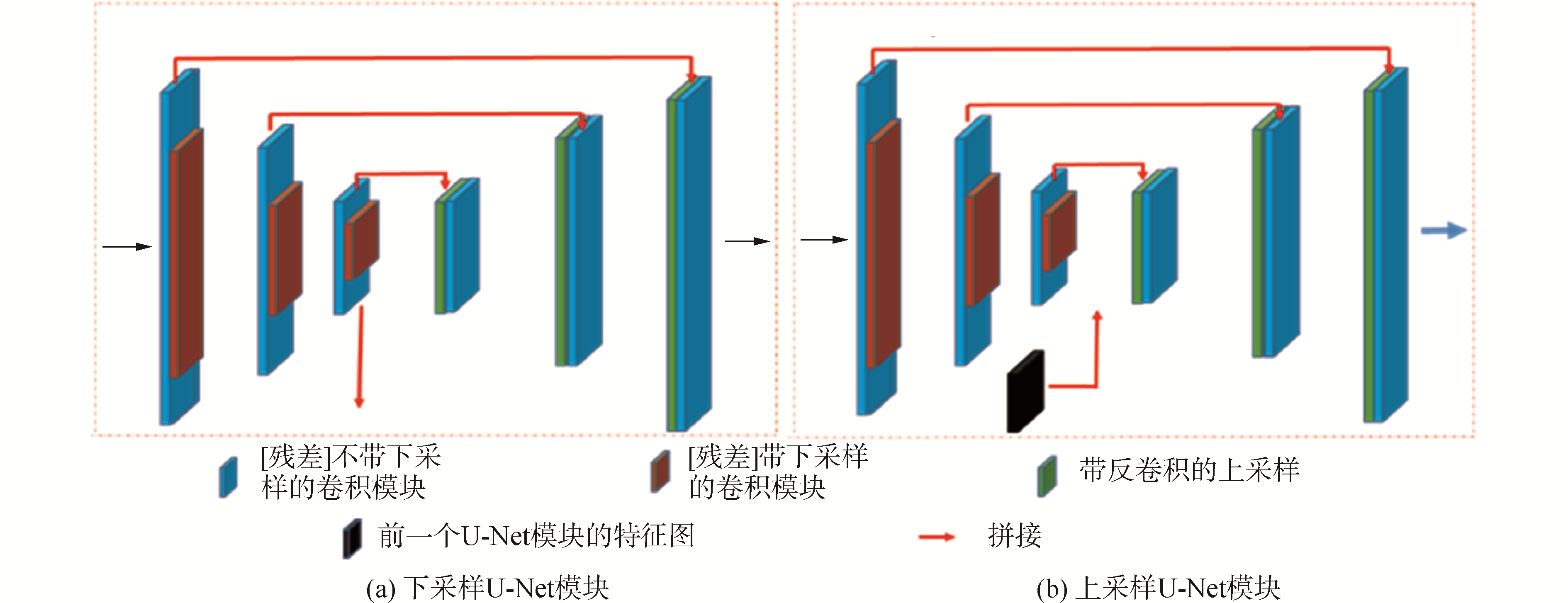

1 UU-Net模型的设计 1.1 U-Net模块简介原始U-Net网络及其各种基于U-Net变体,都有编码器-解码器的结构。图 1展示了U-Net的简化版,左侧为编码器,用于下采样;右侧为解码器,用于上采样。将使用步幅为2的卷积实现从小感受野特征到大感受野特征的下采样,特征通道数增加一倍,避免了使用MaxPooling[19]缩减特征图造成的信息损失;使用步幅为2的转置卷积[20]实现上采样,特征通道数减小一倍。在每一个U-Net简化模块中,设定的缩放比例为4倍或者8倍。

|

Download:

|

| 图 1 简化版的U-Net模型 Fig. 1 simplified model of U-Net | |

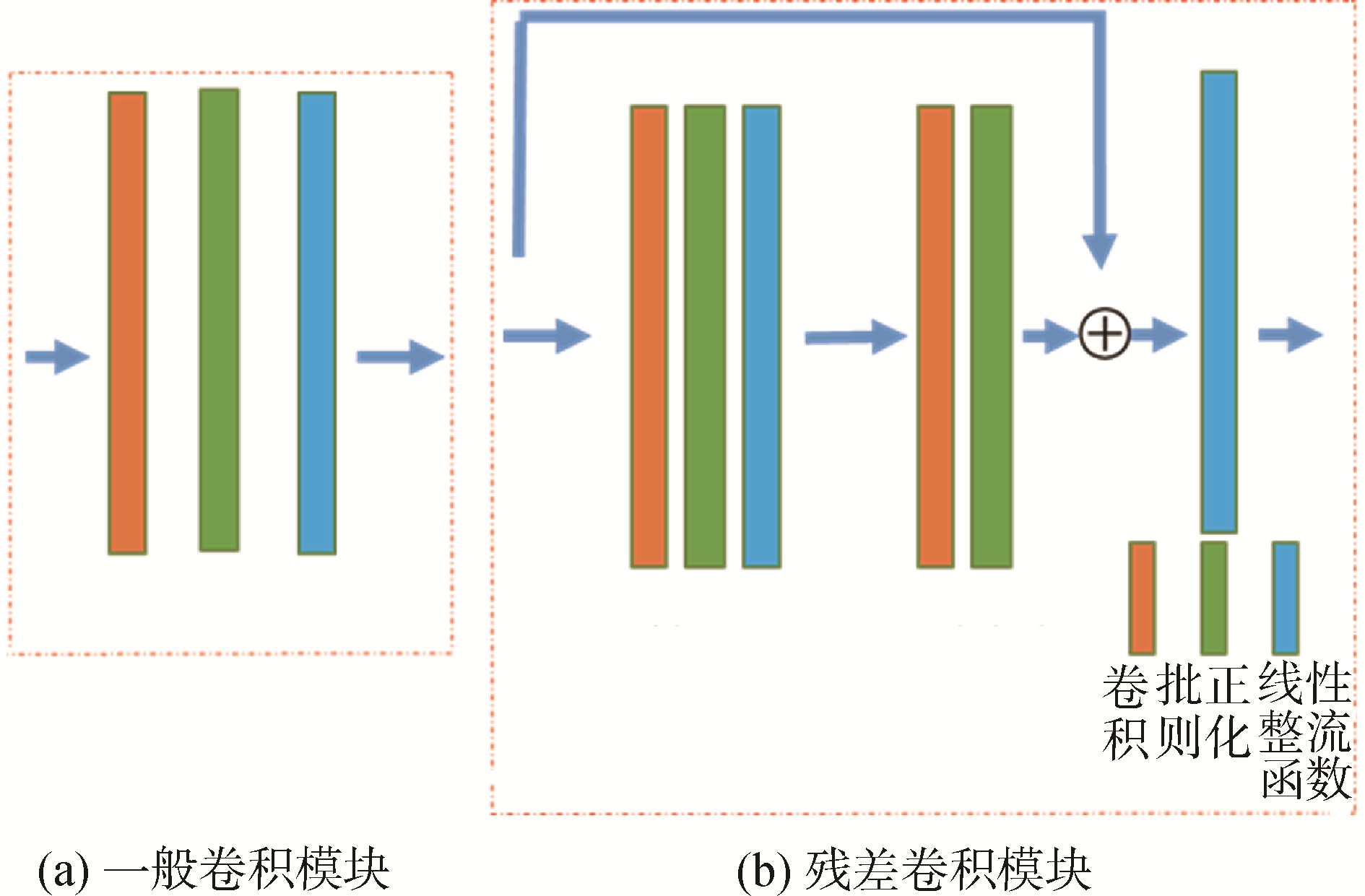

神经网络的深度对图像分割等计算机视觉任务有比较大的影响,理论而言,较深的网络能够拟合更加复杂的函数,从而导致更好的效果。但实际并非如此,随着网络深度的增加,分割效果在深度达到临界点后会开始下降。这是因为网络越深,梯度消失的现象越明显,从而导致网络的分割效果变差。本文使用了ResNet[21]和Batch Normalization[22]延缓网络传播过程中的梯度消失。ResNet的数学原理如下:假设输入X到输出Y的映射为即:Y=H(X);输入X通过多个非线性层后,结果Y满足另一个映射为F,即:Y=F(X),其中F与H之间满足:F(X)=H(X)-X。因此,原始映射H将被表示为F(X)+X。在前馈神经网络中,可以通过“跳层”的连接方式,可以实现需要的映射H,如图 2。在UU-Net模型中,我们利用这种残差思想来构建U-Net内的卷积块,其本质就是利用残差卷积模块替换普通卷积模块,批量正则化则运用于模型训练。

|

Download:

|

| 图 2 2种卷积块 Fig. 2 Two kinds of convolution module | |

LadderNet本质是一个U-Net链。前一个U-Net解码器的中间结果与后一个U-Net编码器通过Addition连接,后者在各个尺度的特征图上得到额外的信息补充。同时,这种方式能构建多条路径传递信息,每一条路径都相当于一个FCN变体。因此,LadderNet网络具有捕获更复杂特征和产生更高精度的潜力。实验表明,该网络在DRIVE数据集上取得了很好的分割效果。

本文借鉴LadderNet构建多路径捕获更多高级特征的思想来建立UU-Net模型,整体结构如图 3。通过堆叠残差卷积模块,构建了2类U-Net的模块,如图 4,分别用于外层U形的编码器与解码器,简称为外U编码器模块与外U解码器模块。其本质都是简化的U-Net模型,内部的“跳层”采用了Concatenation进行连接。外U编码器模块中最小的特征图将作为下层的外U编码器模块的输入;外U解码器模块与外U编码器模块在对应大小的特征图上进行Addition操作,即外U编码器模块的解码部分产生的中间结果与外U解码器模块的编码部分Addition,这样后者在各个尺度的特征图上得到了额外的信息补充,同时,从输入到输出增加了多个的路径。相比LadderNet,不仅利用残差卷积块增加了外U形结构的深度,还通过双层结构在参数增量较少的情况下构造出更多条的路径,即增加了更多的FCN变体。

|

Download:

|

| 图 3 UU-Net的整体结构 Fig. 3 The Structure of UU-Net | |

|

Download:

|

| 图 4 外U编码器模块 Fig. 4 U-shaped network | |

视网膜数据集DRIVE[23]是一个视网膜血管分割的权威数据集,共包含40张通过照相机拍摄的RGB视网膜图像及由专家标注的视网膜血管掩码图像,其中前20张图像及其标注图像为训练样本, 后20张图像及其标注图像为测试样本,图像大小为584×564。为了提升模型的分割效果,增强模型的鲁棒性,同时降低过拟合的风险,对图像质量进行增强并扩充了图像数量。

视网膜图像通过相机获取并使用了点光源,导致了图像采集的过程中存在光照不均匀、血管自身和背景对比度较低等问题。首先通过:

| ${\rm{Gray}} =0.299 R+0.587 G+0.114 B $ | (1) |

将RGB彩色图像转为灰度图,再采用限制对比度自适应直方图均衡(CLAHE)[24]对图像进行数据增强。式子中R代表图像中红色通道的值,G代表图像绿色通道的值,B代表图像蓝色通道的值。

2.2 模型训练损失函数:对于视网膜血管的分割,实际上是对图像中每个像素进行分类。因此,将优化的损失函数为交叉熵函数为:

| $\operatorname{Loss}=-\sum\limits_{i} p_{i} \cdot \log \hat{P}_{i} $ | (2) |

式中:i表示类别种类; Pi表示真实值的概率;

数据预处理:神经网络模型对参数的训练需要大量的样本,DRIVE只有少量的数据。因此,在训练过程中,首先对图像进行128×128随机裁剪,得到用于训练的Patches;然后对这些Patches分别进行水平翻转、垂直翻转、旋转90°、180°、270°;再以此为基础,最后在-10°~10°范围内随机旋旋转,以此对训练数据集进行扩充。

模型训练的参数设置:网络中的权重与偏差参数采用Xavier方法进行初始化;模型训练的batch size设定为64;采用Adam算法对目标函数进行优化,整个训练迭代200个epoch,前100个epoch的学习率设为0.000 5,后100个的学习率设为0.000 1。

2.3 性能评估为了定量分析模型的分割结果,同时,更好地与其他网络进行对比。采用准确率(Accuracy-AC)、灵敏度(Sensitivity-SE)、特异性(Specificity-SP)、F1-Score 4个指标,计算公式为(3)~(6)以及受试者接受者工作特性曲线和准确率-召回率曲线2个指标来评测视网膜血管的分割结果:

| $A_{C}=\frac{T_{P}+T_{N}}{T_{P}+T_{N}+F_{P}+F_{N}} $ | (3) |

| $S_{E}=\frac{T_{P}}{T_{P}+F_{N}} $ | (4) |

| $S_{P}=\frac{T_{N}}{T_{N}+F_{P}} $ | (5) |

| $\left\{\begin{array}{l}P_{\text {recision }}=\frac{T_{P}}{T_{P}+F_{P}} \\ R_{\text {ecall }}=\frac{T_{P}}{T_{P}+F_{P}} \\ F_{1-S_{\text {core }}}=\frac{2 \times P_{\text {recision }} \times R_{\text {ecall }}}{P_{\text {recision }}+R_{\text {ecall }}}\end{array}\right. $ | (6) |

式中:TP为真阳性,指图像中标注为血管像素,预测结果也为血管像素的总个数;TN为真阴性,指图像中标注为背景像素,预测结果也为背景像素的总个数;FP为假阳性,指图像中标注为背景像素,预测结果为血管像素的总个数;FN为假阴性,指图像中标注为血管像素,预测结果为背景像素的总个数;

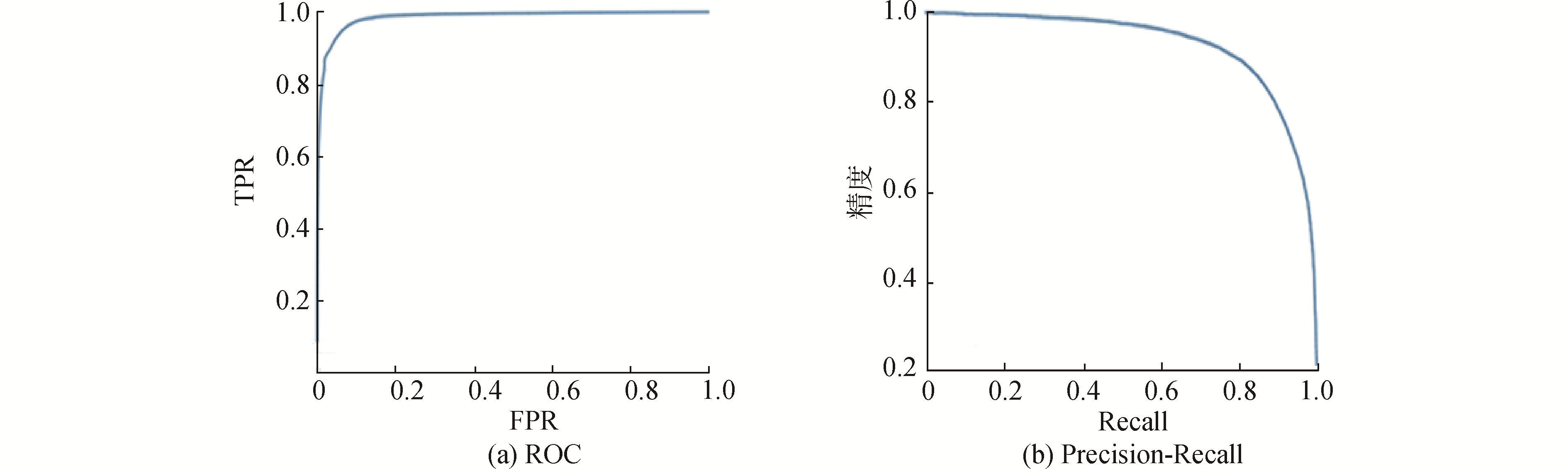

受试者工作特性曲线(ROC)以假阳性率为横坐标,以真阳性率为纵坐标,反映了设定不同阈值时的灵敏度和特异性变化的情况,曲线下的面积(AUC)为ROC曲线下方的面积,AUC越接近1,说明算法分割效果越好。

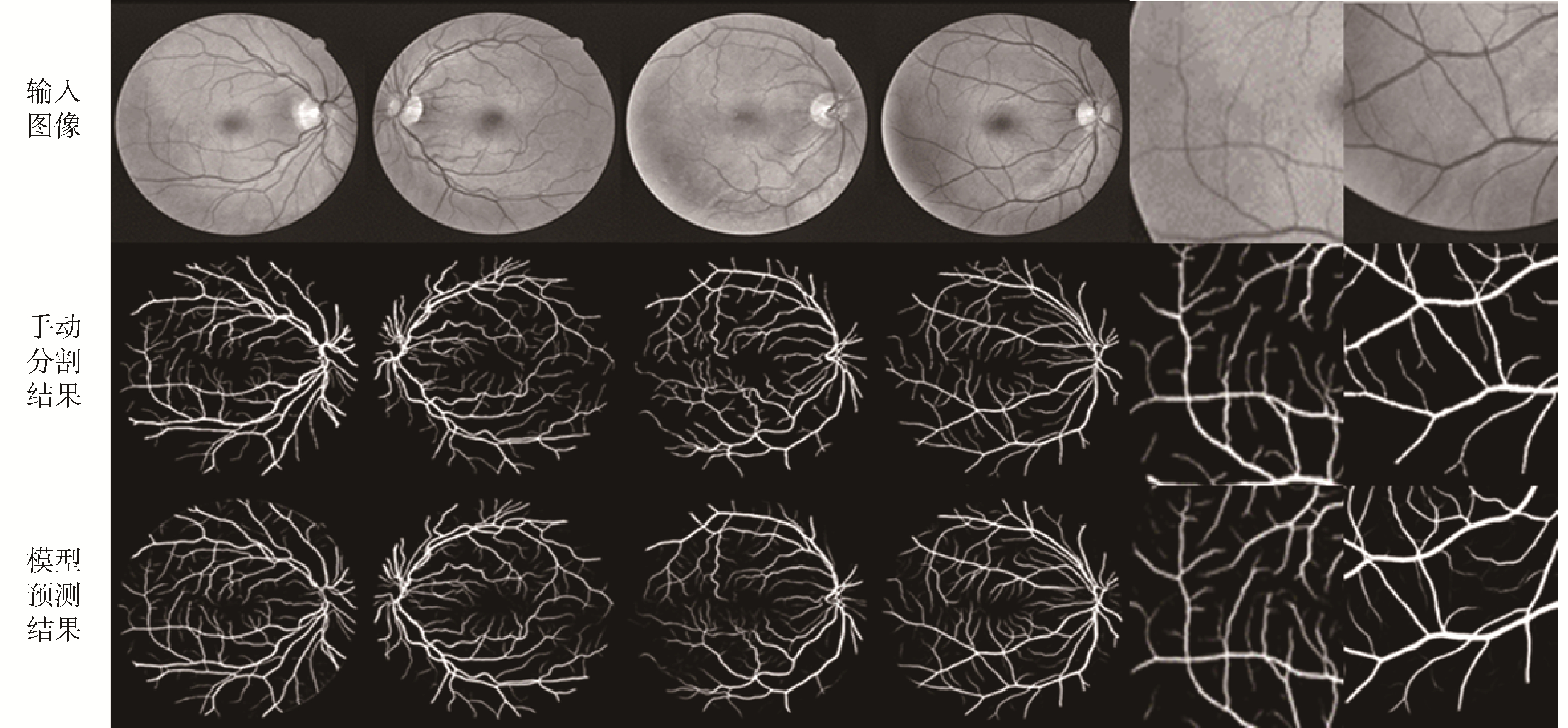

在DRIVE的测试数据集上,本文通过训练的最优模型进行分割预测,从20个预测结果中随机选择了4个,如图 5的前4列,直观上UU-Net预测的结果非常接近于真实的视网膜血管分割结果,即专家手动的分割结果;后两列是图像细节的放大结果,可以看出,对于血管末梢的分割,整体效果很好。从数据上看,如图 6,训练出的最好的模型得到ROC曲线下的面积为0.985 1,高于LadderNet等网络在ROC曲线下的面积,是目前最优的结果。同时,精准-召回率曲线下的面积为0.926 4,也高于之前最优的算法。

|

Download:

|

| 图 5 DRIVE数据集上的测试结果 Fig. 5 The results of testing on DRIVE | |

|

Download:

|

| 图 6 DRIVE数据集上的ROC曲线与Precision-Recall曲线 Fig. 6 ROC curve and precision-recall curve on DRIVE | |

表 1为几个基于U-Net的常见算法在DRIVE数据集上5个评测指标上的定量结果。可以看出,除了特异性SP,提出的UU-Net模型在F1-Score,平均准确率AC,灵敏度SE,受试者接受者工作特性曲线下的面积AUC上都具有最佳的预测结果。根据原理,知道敏感度和特异性关注某一类甚于另一类,而AC、AUC和F1-score等指标则同时基于2类的分割效果来评估模型的性能。因为UU-Net模型在AU、AUC和F1-Score上都有最高的得分,因此,相比之前的模型,我们的模型在整体上有最好的表现。

| 表 1 基于U-Net的常见算法在DRIVE数据集上的视网膜血管分割性能对比 Table 1 Retinal vessel segment performance of common semantical algorithm based on U-Net on DRIVE |

1) 构造更多信息流传播路径与信息融合能提高模型的特征提取能力:该模型通过在U-Net内部采用串联方式连接,U-Net模块之间采用加法连接构建出多条从输入到输出的信息流传送路径,每条路径都等价于一个FCN变体,能更好的获取图像中像素的上下文特征、纹理特征等高级特征。

2) 融入残差模块能提升模型的分割效果:采用残差模块替代普通卷积模块,增加更多的网络层,提高分割效果。

| [1] |

PROKOFYEVA E, ZRENNER E. Epidemiology of major eye diseases leading to blindness in Europe:a literature review[J]. Ophthalmic research, 2012, 47(4): 171-188. (  0) 0)

|

| [2] |

FRAZ M M, REMAGNINO P, HOPPE A, et al. Blood vessel segmentation methodologies in retinal images-a survey[J]. Computer methods and programs in biomedicine, 2012, 108(1): 407-433. (  0) 0)

|

| [3] |

ORLANDO J I, PROKOFYEVA E, BLASCHKO M B. A discriminatively trained fully connected conditional random field model for blood vessel segmentation in fundus images[J]. IEEE transactions on biomedical engineering, 2017, 64(1): 16-27. (  0) 0)

|

| [4] |

RADHA R, LAKSHMAN B. Retinal image analysis using morphological process and clustering technique[J]. Signal & image processing, 2013, 4(6): 55-69. (  0) 0)

|

| [5] |

KHARGHANIAN R, AHMADYFARD A. Retinal blood vessel segmentation using Gabor wavelet and line operator[J]. International journal of machine learning and computing, 2012, 2(5): 593-597. (  0) 0)

|

| [6] |

AKRAM M U, KHAN S A. Multilayered thresholding-based blood vessel segmentation for screening of diabetic retinopathy[J]. Engineering with computers, 2013, 29(2): 165-173. (  0) 0)

|

| [7] |

蒋芸, 谭宁. 基于条件深度卷积生成对抗网络的视网膜血管分割[J/OL]. 自动化学报.[2019-11-22].https://www.cnki.net/KCMS/detail/11.2109.tp.20180827.1833.002.html. DOI:10.16383/j.aas.c180285. JIANGYun, TAN Ning. Retinal vessel segmentation based on conditional deep convolutional generative adversarial networks[J]. Acta automatica sinica.[2019-11-22]. https://www.cnki.net/KCMS/detail/11.2109.tp.20180827.1833.002.html. DOI:10.16383/j.aas.c180285. (  0) 0)

|

| [8] |

梁礼明, 盛校棋, 郭凯, 等. 基于改进的U-Net眼底视网膜血管分割[J]. 计算机应用究, 2020, 37(4): 1247-1251. LIANG Liming, SHENG Xiaoqi, GUO Kai, et al. Improved U-Net fundus retinal vessels segmentation[J]. Application research of computers, 2020, 37(4): 1247-1251. (  0) 0)

|

| [9] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe, 2012: 1097-1105.

(  0) 0)

|

| [10] |

LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA, 2015: 3431-3440.

(  0) 0)

|

| [11] |

ZEILER M D, FERGUS R. Visualizing and understanding convolutional networks[C]//Proceedings of the 13th European Conference on Computer Vision. Zurich, Switzerland, 2014: 818-833.

(  0) 0)

|

| [12] |

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[J]. arXiv preprint arXiv: 1409.1556, 2014.

(  0) 0)

|

| [13] |

SZEGEDY C, LIU W, JIA Y Q, et al. Going deeper with convolutions[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA, 2015: 1-9.

(  0) 0)

|

| [14] |

CHEN L C, PAPANDREOU G, SCHROFF F, et al. Rethinking atrous convolution for semantic image segmentation[J]. arXiv preprint arXiv: 1706.05587, 2017.

(  0) 0)

|

| [15] |

LIN Guosheng, MILAN A, SHEN Chunhua, et al. RefineNet: multi-path refinement networks for high-resolution semantic segmentation[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA, 2017: 5168-6177.

(  0) 0)

|

| [16] |

LIN T Y, DOLLÁR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA, 2017: 936-944.

(  0) 0)

|

| [17] |

ALOM M Z, HASAN M, YAKOPCIC C, et al. Recurrent residual convolutional neural network based on U-Net (R2u-Net) for medical image segmentation[J]. arXiv preprint arXiv: 1802.06955, 2018.

(  0) 0)

|

| [18] |

ZHUANG Juntang. LadderNet: multi-path networks based on U-Net for medical image segmentation[J]. arXiv preprint arXiv: 1810.07810, 2018.

(  0) 0)

|

| [19] |

TOLIAS G, SICRE R, J? GOU H. Particular object retrieval with integral max-pooling of CNN activations[J]. arXiv preprint arXiv: 1511.05879, 2015.

(  0) 0)

|

| [20] |

ZEILER M D, TAYLOR G W, FERGUS R. Adaptive deconvolutional networks for mid and high level feature learning[C]//Proceedings of 2011 International Conference on Computer Vision. Barcelona, Spain, 2011: 2018-2025.

(  0) 0)

|

| [21] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA, 2016: 770-778.

(  0) 0)

|

| [22] |

IOFFE S, SZEGEDY C. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]//Proceedings of the 32nd International Conference on Machine Learning. Lille, France, 2015.

(  0) 0)

|

| [23] |

STAAL J, ABRAMOFF M D, NIEMEIJER M, et al. Ridge-based vessel segmentation in color images of the retina[J]. IEEE transactions on medical imaging, 2004, 23(4): 501-509. (  0) 0)

|

| [24] |

REZA A M. Realization of the contrast limited adaptive histogram equalization (CLAHE) for real-time image enhancement[J]. Journal of VLSI signal processing systems for signal, image and video technology, 2004, 38(1): 35-44. (  0) 0)

|

| [25] |

GLOROT X, BENGIO Y. Understanding the difficulty of training deep feedforward neural networks[C]//Proceedings of the Thirteenth International Conference on Artificial Intelligence and Statistics. Chia Laguna Resort, Sardinia, Italy, 2010: 249-256.

(  0) 0)

|

| [26] |

ROYCHOWDHURY S, KOOZEKANANI D D, PARHI K K. Blood vessel segmentation of fundus images by major vessel extraction and subimage classification[J]. IEEE journal of biomedical and health informatics, 2015, 19(3): 1118-1128. (  0) 0)

|

2020, Vol. 41

2020, Vol. 41