2. 黑龙江科技大学 计算机与信息工程学院, 黑龙江 哈尔滨 150022;

3. 北京电子工程总院, 北京 100854

2. College of Computer and Information Engineering, Heilongjiang University of Science and Technology, Harbin 150022, China;

3. Beijing General Institute of Electronic Engineering, Beijing 100854, China

近年来,得益于高速计算芯片及大量的标注数据,卷积神经网络作为当下最流行的深度学习模型在医疗领域、制造业领域及商业数据分析领域等常规模式识别问题上都取得了突破性的进展。然而作为典型的模式识别问题,水下目标识别目前的主要方法仍聚焦在水下目标的声信号处理方法的研究上。目前的常规水下目标识别方法主要集中在传统的包络调制检测(detection of envelope modulation on noise,DEMON)与低频分析和记录(low frequency analysis and recording,LOFAR)特征提取和其他现代信号处理技术的特征提取上。本文尝试将卷积神经网络引入水下目标识别领域,利用卷积运算强大的非线性拟合能力有效地提高水下目标识别的准确率。卷积神经网络作为典型的深度学习模型其模型的训练与优化需要大量的标记数据,而水下目标识别领域鲜有公开的大量的数据集。水声目标识别作为海战场情报处理的重要组成,是现代化海洋作战的重要保障。目前水声目标识别的依据主要围绕噪声特征、目标运动特征、目标尺度特征、目标排水量、目标声呐特征以及目标运动逻辑特征等7大特征展开。以上目标特征多从目标声学特性中获取,近年来,随着多传感器综合识别手段的发展,水下目标识别技术不再局限于目标声学应用。由于并行运算能力的提升以及GPU加速技术的出现,深度学习方法被应用到水下目标识别中,Kamal等[9]将DBN结构用于水下目标识别,40个类别的分类问题中最高获得了90.23%的正确识别率。Ferguson等[10]通过对比卷积神经网络与常规识别方法,发现卷积神经网络在浅水域水面目标的识别中可以在更大范围内以较强的鲁棒性获取目标。相比于国外的研究,国内利用深度学习开展水下目标识别工作进行较晚,王强等[11]从实测水声数据中提取MFCC(Mel-frequency cepstral coefficients),与64个FIR(finite impulse response)滤波器进行卷积变换并比较DBN与CNN模型上的识别率。Xu等[12]则将AutoEncoder运用在水下目标识别任务中且达到了90%以上的准确率。

针对传统卷积神经网络在过小数据集上训练容易产生模型过拟合现象无法直接应用于水下目标识别任务的问题,本文基于生物学提出的注意力概念提出适用于水下目标识别的快速降维卷积模型(fast reduced dimension convolution model based attention,FRD-CMA)。FRD-CMA模型依照特征映射的收敛方向作为模型分析数据的注意力并指导池化运算,从而使卷积神经网络池化运算可以面向任务对特征进行降维。通过实验对比,FRD-CMA模型可降低模型在较小数据集下训练的过拟合风险从而适用于水下目标识别任务。

1 快速降维卷积模型大数据时代的到来使得卷积神经网络的结构不断优化,其应用领域也逐渐得到延伸。自从AlexNet[1]在海量图像分类领域取得了突破性的成果;近年来,卷积神经网络的结构研究仍然有着很高的热度,一些具有优秀性能的网络结构被提出[4-5]。自2012年,Krizhevsky等提出的AlexNet[1]在大型图像数据库ImageNet[6]的图像分类竞赛中以准确度超越第2名11%的巨大优势夺得了冠军,使得卷积神经网络成为了学术界的焦点后,不断有新的卷积神经网络模型被提出,如牛津大学的VGG(Visual Geometry Group)[7]、Google的GoogLeNet[8]和微软的ResNet[5]等,这些网络都一次次刷新了AlexNet在ImageNet上创造的纪录。

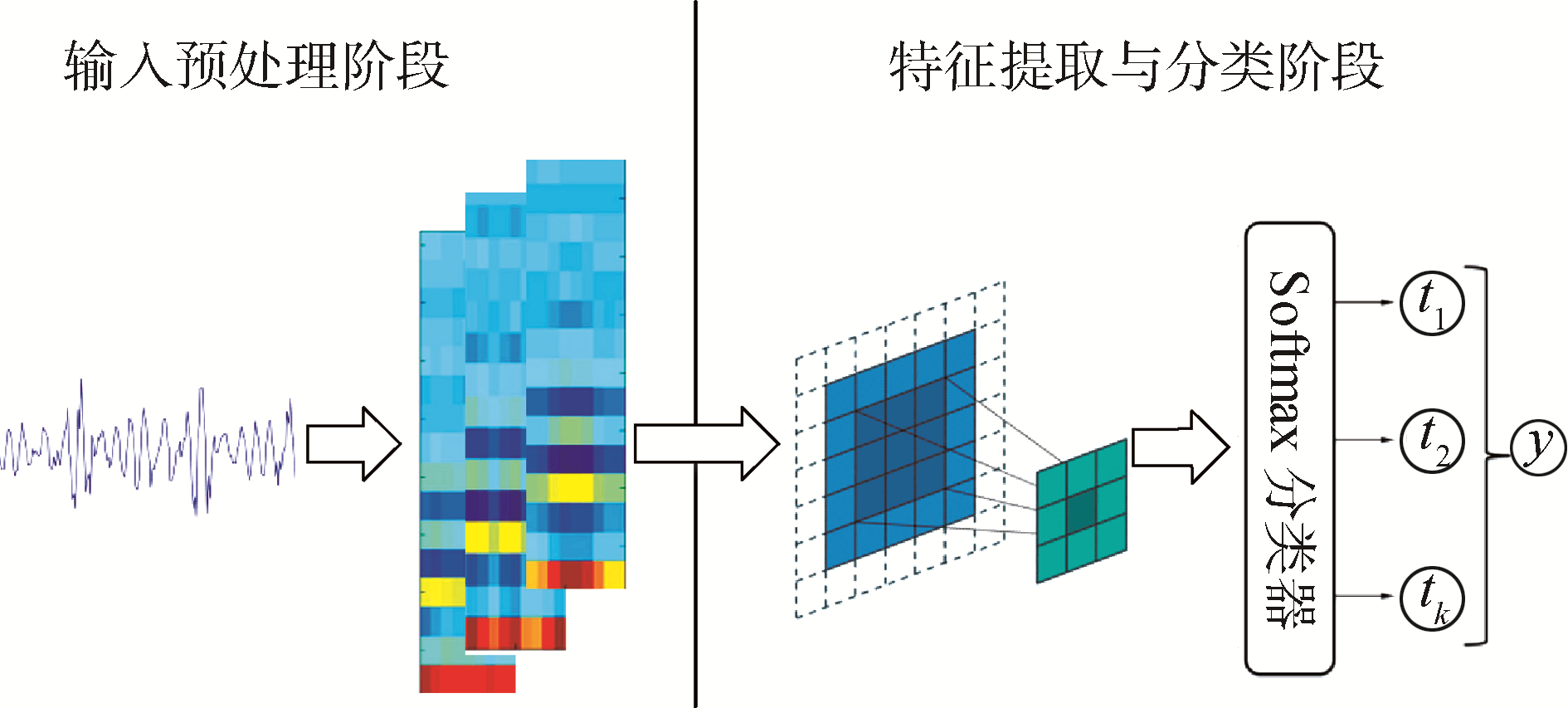

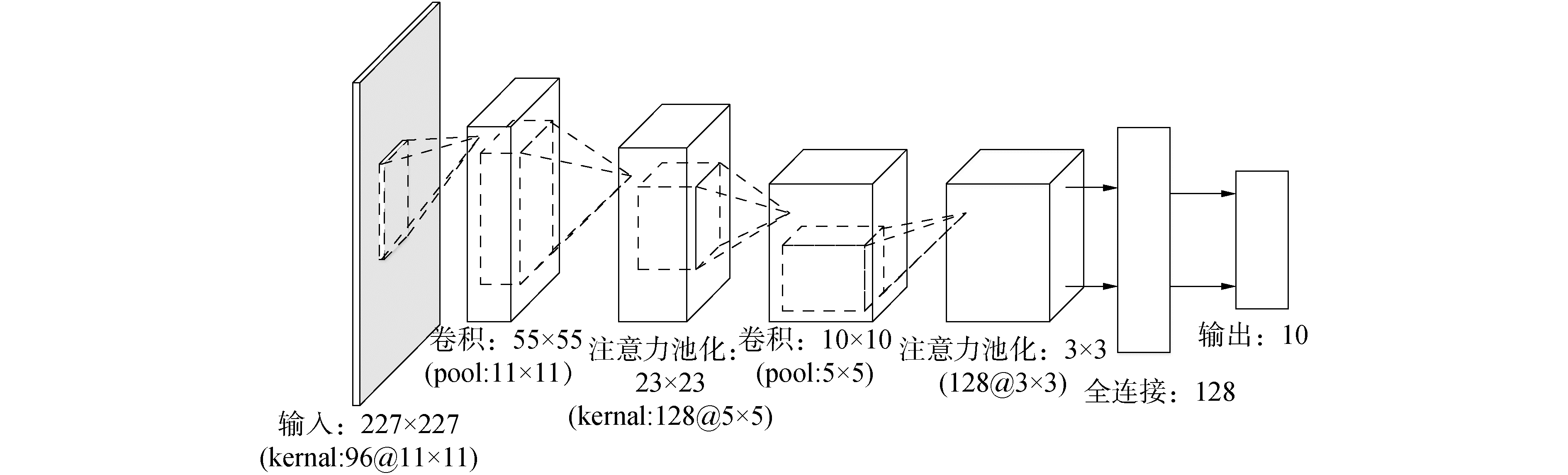

本文用于水下目标识别的卷积神经网络模型结构如图 1所示。模型从整体上分为2个阶段:第1阶段是对于网络的训练数据进行预处理。数据预处理[13]在深度学习算法中起举足轻重的作用,实际情况中,将数据做归一化和白化处理后,很多算法能够发挥最佳效果。数据预处理的结果直接送入深度学习模型进行训练,虽然深度学习模型自身具有参数的调整能力,但深度学习算法对数据预处理非常敏感,数据预处理对深度学习的结果影响较大;第2阶段是基于卷积神经网络的特征提取与分类阶段,目前在水下目标识别领域鲜有公开的数据集可用,因此研究人员都在其自身采集的实验数据上尝试进行水下目标的特征提取与分类。因为经费、场地等诸多原因,无法形成巨大的数据集用来训练深度网络模型。因此,在规模较少的水下目标识别数据集上应用深度学习模型需要对模型进行精简与调整。

|

Download:

|

| 图 1 FRD-CMA模型构建过程 Fig. 1 Building process of FRD-CMA model | |

数据预处理作为深度学习模型训练的一个重要部分,一直以来都受到学者的关注,在数据预处理阶段,本文所采用的方法与以往直接使用Mel-Frequency对噪声数据做特征提取不同。

本文使用首先对水下目标的噪声数据以100 ms为单位进行分段,针对每段噪声数据提取其MFCC,将噪声数据变成定长的矢量化数据。将上一步处理所得到的定长的矢量化数据按实际实验中水听器的排布位置以及其时序关系进行拼接,形成一个完整的时段水听阵特征,继而再将形成的水听阵特征转成对应的图片以作为输入数据集。本文所述数据预处理过程如图 2所示。

|

Download:

|

| 图 2 噪声数据预处理过程 Fig. 2 Preprocessing process of noise data | |

每段噪声数据通过上一步得到的MFCC按多路水听器的排放位置以及每段噪声数据的时序关系进行拼接,从而形成深度学习模型输入数据集。拼接后的数据如图 3所示。

|

Download:

|

| 图 3 多路水听器采集噪声特征图 Fig. 3 Characteristic map of multichannel hydrophone acquisition noise | |

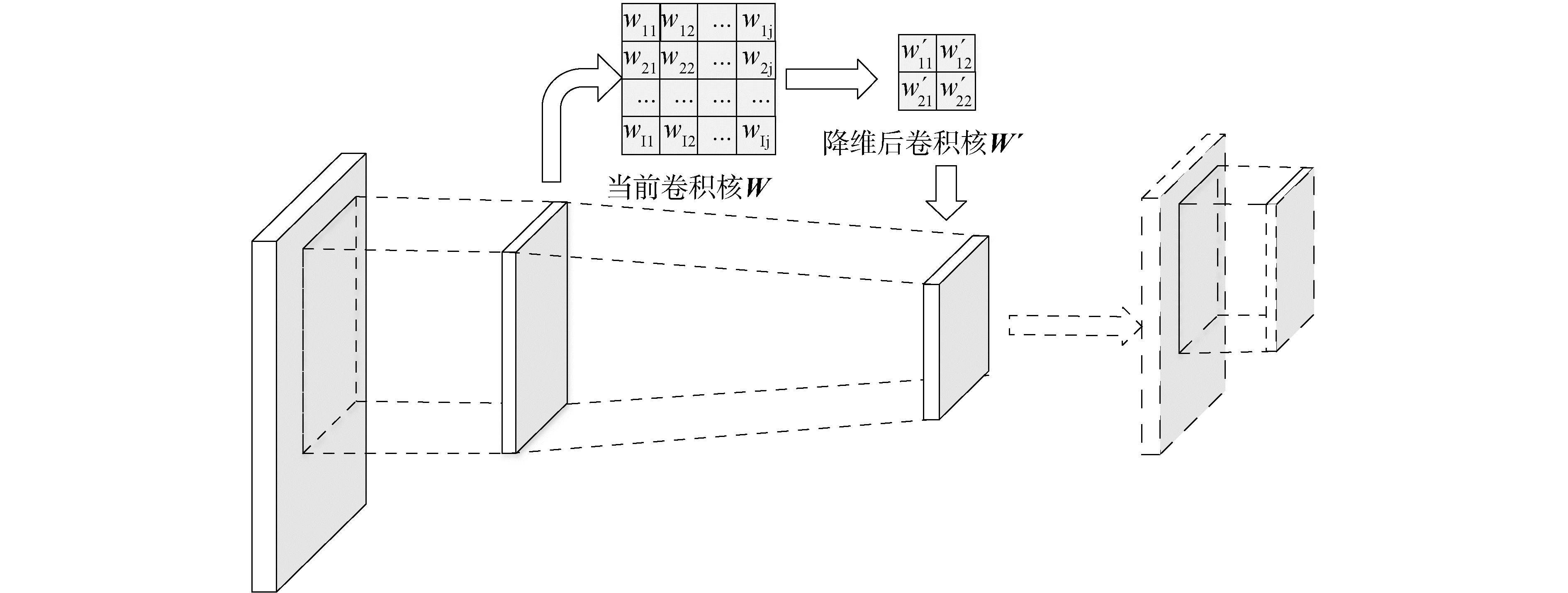

注意力机制是一个将编码器-解码器结构从固定长度的内部表征中解放出来的方法。通过保持模型对输入序列处理过程中每一步的中间输出结果,训练模型学习如何选择性地关注输入,并将其与输出序列中的项联系起来。生物学论证人们在进行观察图像的时候,并不是一次就把整幅图像的每个位置像素都看过,大多是根据需求将注意力集中到图像的特定部分。而且人类会根据之前观察的图像学习到未来要观察图像注意力应该集中的位置[14]。本模型使用注意力模型来加速池化操作的降维过程,其结构如图 4所示。

|

Download:

|

| 图 4 基于注意力的池化操作 Fig. 4 Attention based pooled operations | |

简单的说,模型在进行池化时充分考虑上一层卷积核的作用,在提取卷积核的特征的基础上进行池化。其池化算法如算法所示。

算法:层间池化

输入:上层卷积核

输出:卷积核特征与池化结果

步骤1) 得到卷积核;

步骤2) 判断卷积核散度并提取卷积核特征;

步骤3) 利用提取的卷积核特征选择池化方法;

如果特征向量提取成功,用特征向量乘以卷积核大小的区域进行池化,超出图像部分补0,以完成池化。

如果卷积核特征提取失败,以卷积核大小区域采用均值池化方法进行池化操作。

步骤4) 返回池化操作结果。

模型使用CLi表示,其计算方法如下:

| $ \boldsymbol{C}_{L_{i}}=\boldsymbol{e}\left(k_{i}\right) \boldsymbol{A}\left(k_{i}\right) $ | (1) |

式中:下标“Li”表示第L层第i个池化结果;e(ki)表示第ki个卷积核所提取的特征向量;A(ki)表示第ki个卷积核所覆盖的区域。

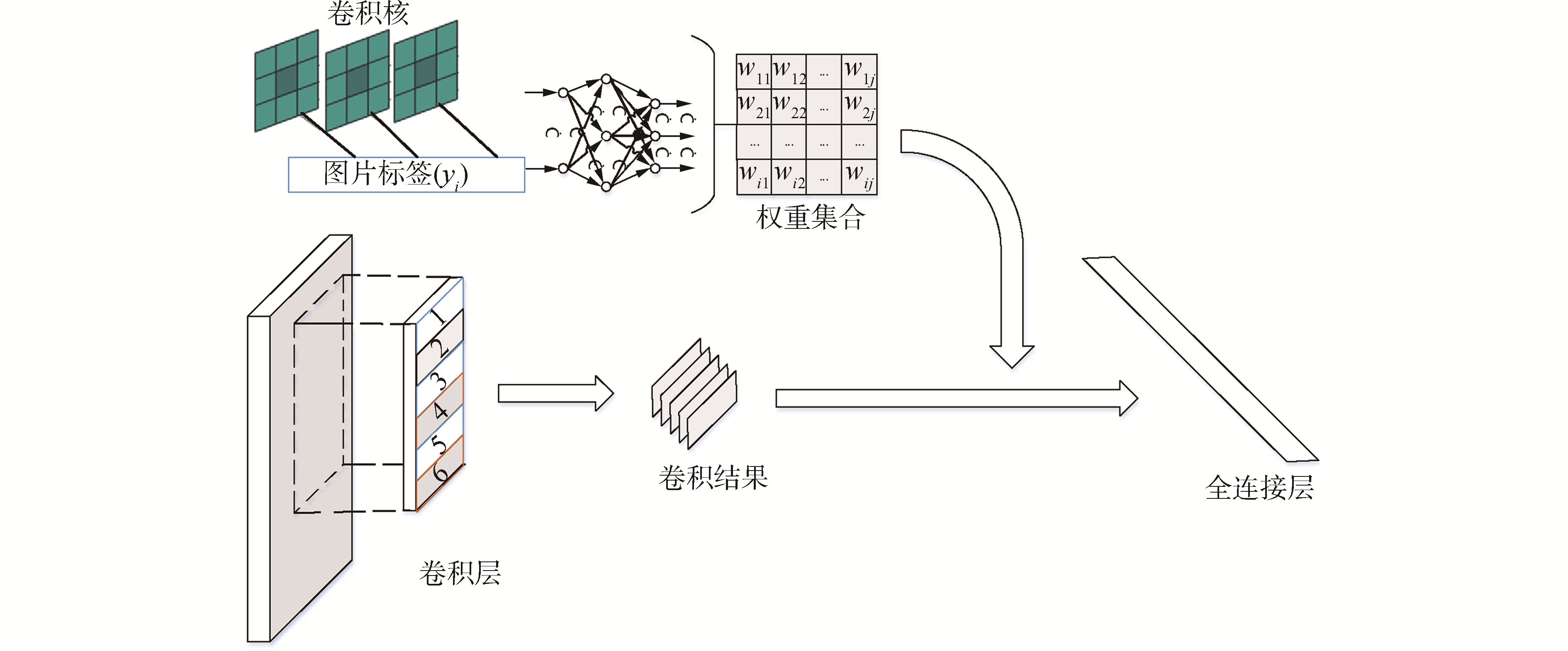

1.2.2 注意力加权连接全连接层在整个卷积神经网络中起到“分类器”的作用。如果卷积层、池化层和激活函数层等操作是将原始数据映射到隐层特征空间,全连接层则起到将学到的“分布式特征表示”映射到样本标记空间的作用[3]。在实际使用中,全连接层可由1×1卷积操作实现以达到快速计算结果,同时,1×1卷积核可以起到一个跨通道聚合的作用,所以可进一步起到降维(或者升维)的作用,起到减少参数的目的[15]。卷积层模仿人的视觉通路提取特征,全连接层一般负责分类或者回归,由于全连接层会丢失一些特征位置信息。

全连接的核心操作就是矩阵向量乘积,本质就是由一个特征空间线性变换到另一个特征空间。目标空间的任一维都认为会受到源空间的每一维的影响。本文利用卷积核特征将卷积神经网络提取的特征,即最后一层结果,基于注意力模型进行加权处理,从而既考虑卷积处理的特点,又保留了特征的位置信息。图 5描述的是全连接层的注意力拼接模型。

|

Download:

|

| 图 5 基于注意力的特征拼接操作 Fig. 5 Attention based feature connection operations | |

Ii代表了基于卷积核影响的注意力模型,则其计算方法如下:

| $ \boldsymbol{I}_{i}=\sum\limits_{i=1}^{m} \boldsymbol{w}_{i} \boldsymbol{R}_{k_{i}} $ | (2) |

式中:wi为一个权重向量,其记录每一维特征在整个特征图中的比重;Rki为全连接层之前模型处理结果。

wi的计算以MLP计算得到,其方法如下:

| $ \boldsymbol{w}_{i}=f\left(\boldsymbol{k}_{i}, y_{i}\right) $ | (3) |

式中f(·)表示一个前馈神经网络。前馈神经网络以卷积核为输入,以ki代表其所对应的卷积核,yi表示此特征所对应的标签。

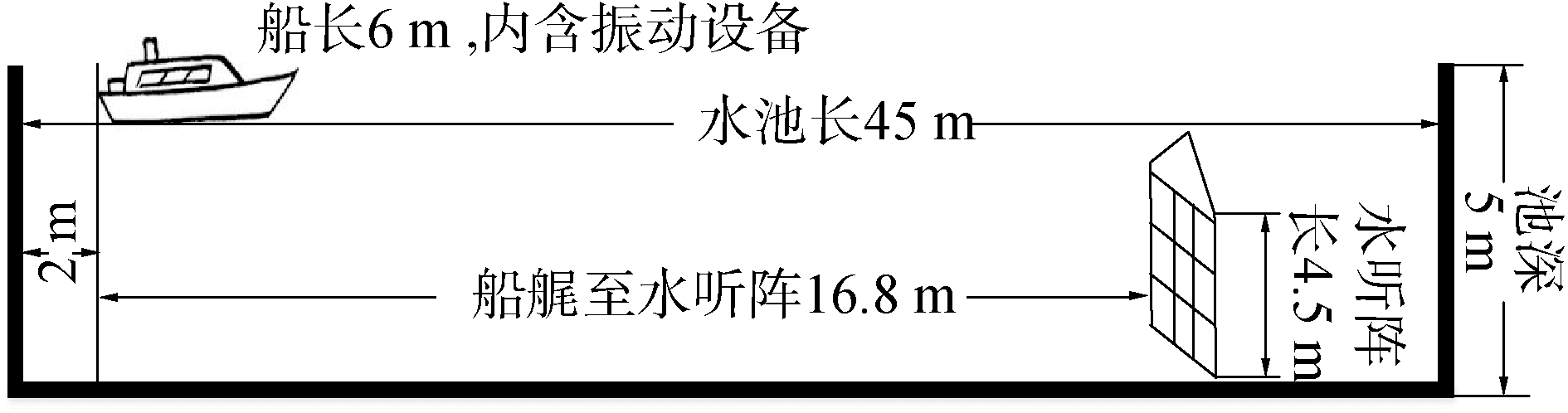

2 FRD-CMA模型实验与结果分析 2.1 数据集与实验设置水下目标辐射噪声的数据采集在信道消声水池与真实水域2种采集场景下展开,信道消声水池数据用于验证模型在水下目标识别任务上的表示能力;真实水域数据则用于验证模型在实际场景中鲁棒性。信道消声水池实验通过在信道消声水池中布置不同水下目标声响设备来模拟水下目标识别的环境。目标放置位置正对水听器,池边水听器阵自下而上排列,水听阵内含16只水听器,每只水听器对应相同编号通道,其中末端水听器距离池底0.5 m,其他水听器每个间距0.25 m安置,阵缆共长4.5 m。测量时间6 min,频带25.6 kHz。采集的所有信号均为电压值。为实现精细化的水下目标识别,信道消声水池实验尝试使用不同的功率放大器来模拟不同船体的本艇自身噪声,同时船体分别使用20%、50%和80%的功率在水中航行。具体实验环境及测量工况如图 6所示。

|

Download:

|

| 图 6 信道消声水池实验数据采集方案 Fig. 6 Experimental data acquisition scheme of channel anechoic tank | |

船体使用不同的速度进行航行,实验将其定义为3类不同的目标,其具体数据量如表 1所示。

| 表 1 实验数据总量及分布情况 Table 1 The total amount and distribution of experimental data |

从表 1可知,实验对3类目标做精细化分类,样本总数为18 270个,其中13 250个样本作为训练集使用,占总体样本的72.5%,5 020个样本作为测试集使用,占总体样本集的为27.5%。

此外,为检验真实水下环境中不同方位入射的声信号以及水听器的相对位置变化所导致的特征变化,本文通过在真实水域中布置多个水下目标噪声采集设备来收集真实场景下的实验数据。真实水域的采集方案中目标船只携带发声设备在水中按实验要求以不同速度沿不同的方向运动,从而采集不同声况下的数据。按照船体距离采集点的不同,录取多组数据。实验中设计船只以不同的距离和速度在水中航行,记录水听器接收的噪声数据。真实水域实验方案如图 7所示,实验共记录约56 G数据。

|

Download:

|

| 图 7 真实水域实验数据采集方案 Fig. 7 Experimental data acquisition scheme in real waters | |

目标船体使用不同发声体模拟不同目标且用不同的速度进行航行,实验将其定义为多类不同的目标,其具体数据量如表 2所示。

| 表 2 真实水域实验数据总量及分布情况(船约正北) Table 2 Experiment data size and distribution of real waters (the target ship heading north) |

本文实验所采用的卷积模型的网络结构如图 8所示。整个模型结构一共有2层卷积、2层池化以及一个全连接层组成,输入为227×227大小的图片,本模型参数与AlexNet的参数量对比如表 3所示。

|

Download:

|

| 图 8 FRD-CMA的训练模型 Fig. 8 Training model of FRD-CMA | |

| 表 3 AlexNet模型参数与FRD-CMA模型参数对比 Table 3 Comparison of parameters of AlexNet model and FRD-CMA model |

由表 3可知,FRDCMA模型比AlexNet模型所需参数大为减少,参数量的减少一方面可以提高模型的使用效率,另一方面可以使得模型在所用数据集上可以加速模型的收敛。

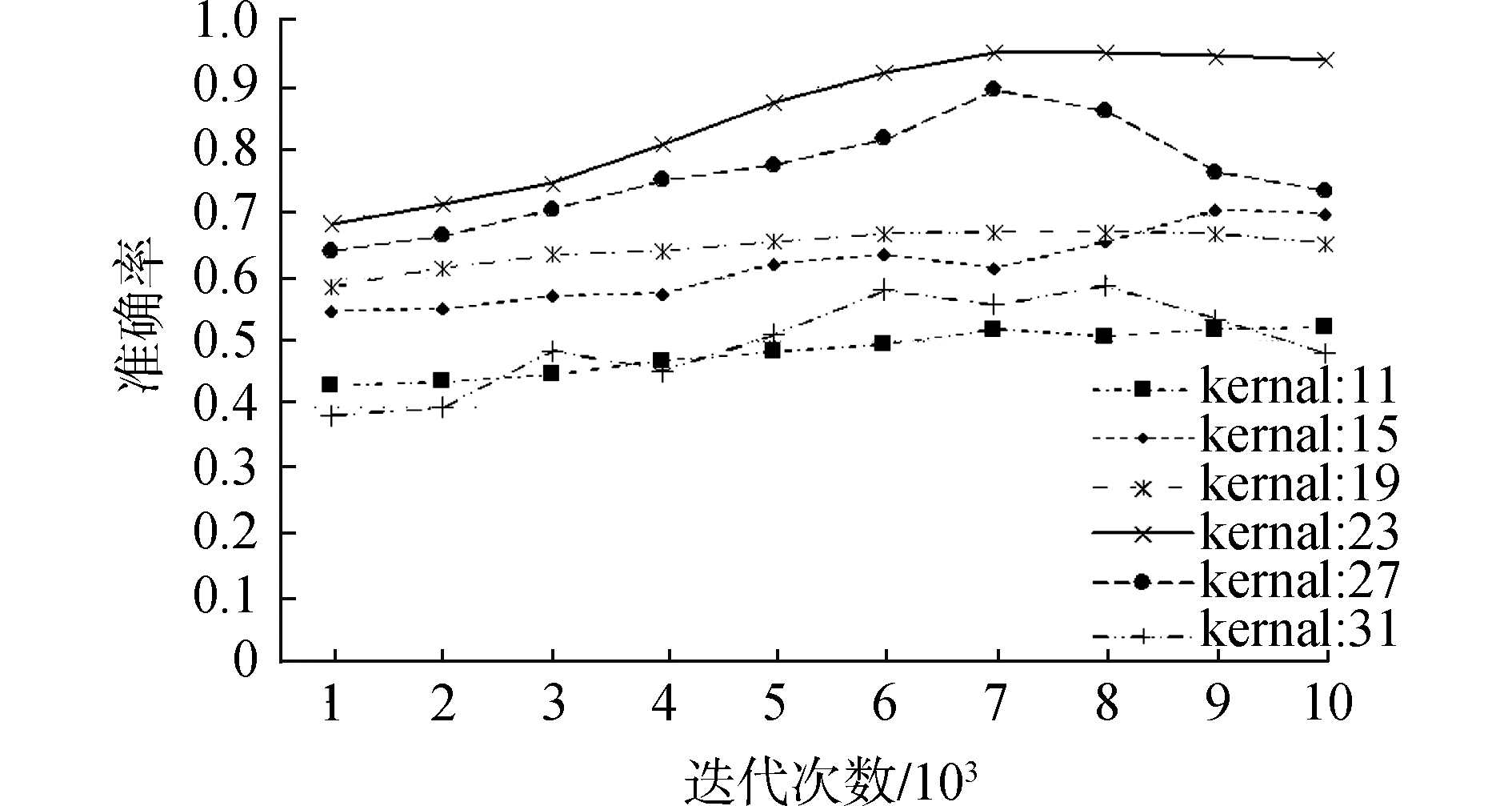

2.1.2 模型定型实验本文在模型设计过程借鉴优秀的AlexNet模型。首先在水下目标数据集上针对不同的卷积核做模型改进实验。图 9描述的是不同卷积核(初始选择)在水下目标识别任务中的准确率,线段的精细反映了相应的准确率。从图中可以观察到,随着迭代次数的增加,模型的准确率都在上升,在迭代的中后期,模型都趋于收敛。当卷积核大小为11×11与23×23时,模型的识别率达到最好的状态,分别为94.33%与93.42%。同时,其他的卷积核大小作用在水下目标任务上时,其准确率并不是按卷积核大小线性变化的。按其准确率排列,当卷积核大小为19时,模型的准确率为78.7%;当卷积核大小为27时,模型的准确率为70.9%;当卷积核大小为15时,模型的准确率为67.9%;而当卷积核大小为31时,模型的准确率为53.7%。

|

Download:

|

| 图 9 不同卷积核的实验比较 Fig. 9 Experimental comparison of different convolution kernels | |

此外,对比卷积核为11与23的曲线可以知道,卷积核大小为11的准确率曲线与卷积核大小为23的准确率曲线均在迭代的中后期趋于平缓,这说明模型在经历过前期的迭代后,趋于收敛。卷积核大小为11的准确率曲线要早于卷积核大小为23的准确率曲线进入平缓期,这说明卷积核大小为11时模型要提前进入收敛期。同时,在卷积核大小为11的曲线下面积(AOC)明显大于卷积核大小为23的AOC,这说明卷积核大小为11时,模型作用此水下目标识别任务的性能最优。

2.2 特征提取及实验结果比较表 4显示了使用MFCC矢量拼接多路水听器输入的方法与单纯使用MFCC与其他分类器在的分类结果的对比结果。其中使用MFCC矢量拼接方法融合多路水听器的方法明显高于单纯使用MFCC对声音进行描述的方法。相比最低的识别准确率,FRD-CMA接合MFCC矢量拼接的方法要高近16.1%。

| 表 4 各模型的训练时间对比 Table 4 Comparison of training time of each model |

从表 4可以看出多路水听器数据融合对提升水下目标识别的准确率有较大的影响。此外,使用WAV作为卷积神经网络输入的水下目标识别任务,分类准确率表现一般,明显低于其他方法,与其他3种分类模型进行比较,其中使用噪声数据作为数据输入的效果最差,可以看出水中混响对水下目标的识别效果影响较大,同时也说明数据的预处理对模型训练的影响较大。

表 4列出各模型在训练过程中的时间消耗,各模型均以相同样本数并迭代10 000次计数,其中FRD-CMA模型耗时最少,以噪声数据为输入的卷积神经网络最长,两者相差近3倍,主要原因在于数据的预处理对模型训练的影响。另外,FRD-CMA拥有比AlexNet更为简化的结构以及快速的降维梯度,因此,FRD-CMA模型在参数上明显少于AlexNet模型训练时间的基础上,达到甚至超过AlexNet模型所获得的分别准确率。

3 结论1) 针对目前水下目标识别中数据量偏小容易引起模型过拟合现象的问题,提出一个可以快速降维的注意力池化卷积模型(FRD-CMA),应用此模型以卷积核作为注意力参考,可快速的对模型进行面向应用任务的降维操作。

2) 针对水下目标识别的任务基于卷积核与标签的关系对卷积神经网络提取的特征进行加权重建,以此来强化待全连接的特征图,从空间和通道2个维度进行加权。

3) 以不同模型接受不同输入进行比较,确定了适用于水下目标辐射噪声的卷积神经网络参数,并通过实验验证FRD-CMA模型在有效提高现有深度学习在水下目标识别任务的准确率基础上,较大幅度地缩短模型训练时间,同时降低了模型训练过拟合的风险。

| [1] |

KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet classification with deep convolutional neural networks[C]//Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe, Nevada, 2012.

(  0) 0)

|

| [2] |

GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA, 2014: 580-587.

(  0) 0)

|

| [3] |

SHELHAMER E, LONG J, DARRELL T. Fully convolutional networks for semantic segmentation[J]. IEEE transactions on pattern analysis and machine intelligence, 2017, 39(4): 640-651. DOI:10.1109/TPAMI.2016.2572683 (  0) 0)

|

| [4] |

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[J]. arXiv preprint arXiv: 1409.1556, 2014. http://www.oalib.com/paper/4068791#.XSVTIPk6t_c

(  0) 0)

|

| [5] |

HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Deep residual learning for image recognition[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA, 2016.

(  0) 0)

|

| [6] |

DENG Jia, DONG Wei, SOCHER R, et al. ImageNet: a large-scale hierarchical image database[C]//Proceedings of 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami, FL, USA, 2009.

(  0) 0)

|

| [7] |

LAWRENCE S, GILES C L, TSOI A C, et al. Face recognition:a convolutional neural-network approach[J]. IEEE transactions on neural networks, 1997, 8(1): 98-113. (  0) 0)

|

| [8] |

SZEGEDY C, LIU Wei, JIA Yangqing, et al. Going deeper with convolutions[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA, 2015: 1-9.

(  0) 0)

|

| [9] |

KAMAL S, MOHAMMED S K, PILLAI P R S, et al. Deep learning architectures for underwater target recognition[C]//Proceedings of 2013 Ocean Electronics. Kochi, India, 2013.

(  0) 0)

|

| [10] |

FERGUSON E L, RAMAKRISHNAN R, WILLIAMS S B, et al. Convolutional neural networks for passive monitoring of a shallow water environment using a single sensor[C]//Proceedings of 2017 IEEE International Conference on Acoustics, Speech and Signal Processing. New Orleans, LA, USA, 2017.

(  0) 0)

|

| [11] |

王强, 曾向阳.深度学习方法及其在水下目标识别中的应用[C]//中国声学学会水声学分会2015年学术会议论文集.武汉, 2015.

(  0) 0)

|

| [12] |

CAO Xu, ZHANG Xiaomin, YU Yang, et al. Deep learning-based recognition of underwater target[C]//Proceedings of 2016 IEEE International Conference on Digital Signal Processing. Beijing, China, 2016.

(  0) 0)

|

| [13] |

NG A, NGIAM J, FOO C Y, et al. UFLDL Tutorial[M/OL]. 2013[10-04-2013]. http://ufldl.stanford.edu/wiki/index.php/UFLDL_Tutorial.

(  0) 0)

|

| [14] |

MNIH V, HEESS N, GRAVES A, et al. Recurrent models of visual attention[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal, Canada, 2014: 2204-2212.

(  0) 0)

|

| [15] |

LIN M, CHEN Q, YAN S. Network In Network[J/OL] 2013, https://ui.adsabs.harvard.edu/abs/2013arXiv1312.4400L.

(  0) 0)

|

2019, Vol. 40

2019, Vol. 40