多光谱图像的光谱信息较为丰富,但其空间分辨率较低。而全色图像的空间分辨率普遍较高,能够详尽地描述图像空间细节信息但无法细致表现其光谱特性,缺少光谱信息。因此,为了有效地结合2类图像的优势,将多光谱图像与全色图像进行融合,获得具有高空间分辨率和丰富光谱信息的多光谱图像。

多光谱与全色图像融合的传统方法主要有分量替代法及多分辨率分析法[1-2]。分量替代法包含亮度-色度-饱和度(intensity-hue-saturation, IHS)变换法[3-4]及主成分分析法(principal component analysis,PCA)[5]等。其中,IHS变换法和PCA法能有效地提高多光谱图像的空间分辨率,但光谱损失较为严重,现已很少单独被使用。在多分辨率分析法中,小波变换[6]能较好地保留光谱信息,但表示的方向性信息却比较有限,且缺乏平移不变性,难以实现对图像轮廓和边缘细节的最佳表达。为了解决小波变换方向性信息有限这一不足,Do等[7]提出了轮廓波(contourlet transform, CT)变换。CT具有局部性、多尺度和多方向等优点,但其缺乏平移不变性,易出现虚假信息,影响视觉效果。因此,文献[8]提出了非下采样轮廓波变换(non-subsampled contourlet transform, NSCT),解决了CT变换中平移不变性的问题,能充分提取待融合图像中的方向信息,有效地消除了Gibbs现象,提供了一种更优的图像分解方法。

脉冲耦合神经网络(pulse coupled neural network, PCNN)是单层人工神经网络模型,其具有无需训练、同步激发、变阈值等特性,目前,在图像融合领域应用广泛。文献[9]首先对图像进行小波分解,然后将图像的变换特征采用PCNN处理,以实现特征聚类,从而根据图像的聚类结果来实现图像融合,由于其参数均为固定的经验值,神经元之间的局部链接范围也被设定为固定大小,因此效果并不是很理想。而文献[10]只是对PCNN的链接强度系数β进行了自适应处理,其他参数仍然采用固定的经验值。PCNN模型中参数的选取直接影响其对图像子带信息的利用,影响图像的融合效果。上述方法虽然有针对性的解决了一些问题,但仍面临PCNN参数选取不易确定这一问题。

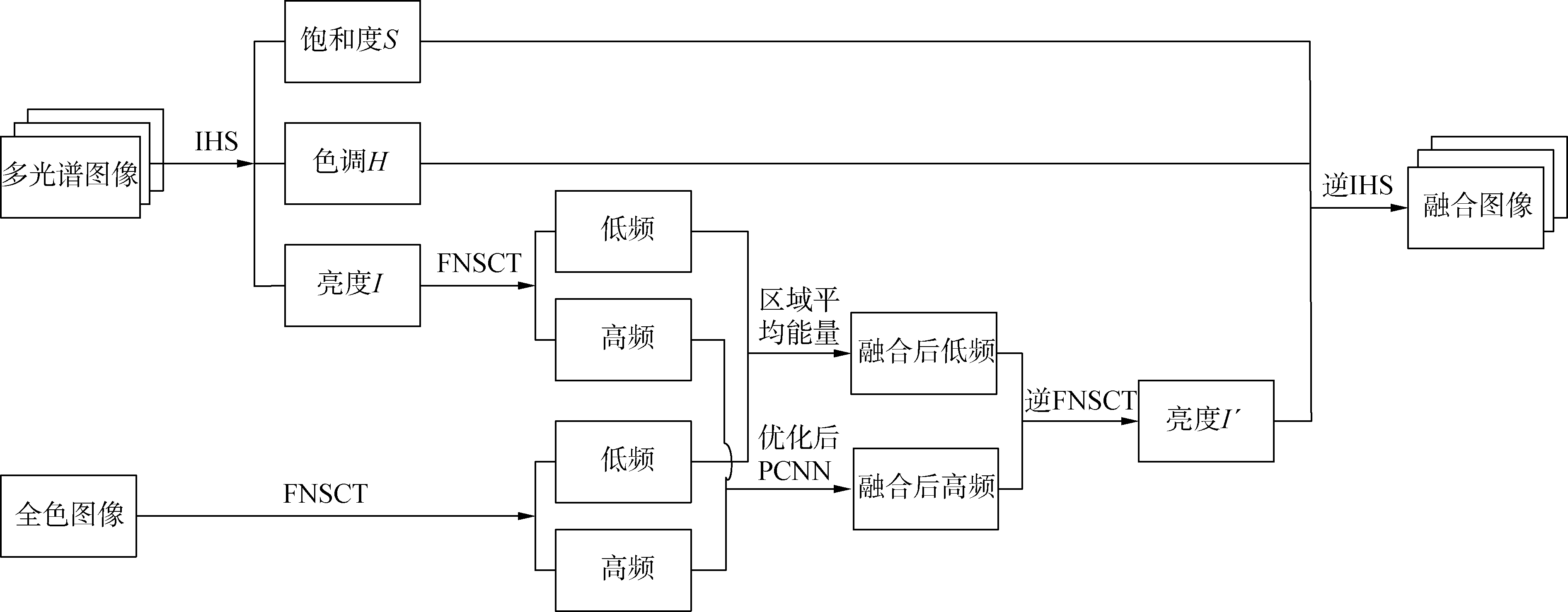

为了解决上述问题,获得空间细节信息更丰富、清晰度更高、并具有较少光谱失真的融合图像,本文提出一种基于快速非下系样轮廓波变换(fast non-subsampled contourlet transform, FNSCT)与萤火虫优化的自适应PCNN相结合的多光谱与全色图像融合算法。首先,多光谱图像需经过IHS变换,然后,将其亮度分量与全色图像分别通过FNSCT分解,获得分解后各自的高低频子带系数;低频子带系数采用区域平均能量融合准则进行融合;而高频子带系数的融合方法则采用萤火虫优化的自适应PCNN准则,该准则通过图像的空间频率特征自适应地选取算法的链接强度以及链接范围,并利用萤火虫优化算法对自适应PCNN进行优化,确定算法的其余参数,获得参数最优的PCNN模型;最后,通过FNSCT逆变换和IHS逆变换进行重构得到融合图像。

1 FNSCT、PCNN以及萤火虫算法的基本原理 1.1 快速非下采样轮廓波变换非下采样轮廓波变换通过非下采样金字塔(non-subsampled pyramid, NSP)和非下采样方向滤波器组(non-subsampled directional filter bank, NSDFB)2部分实现对图像的分解。

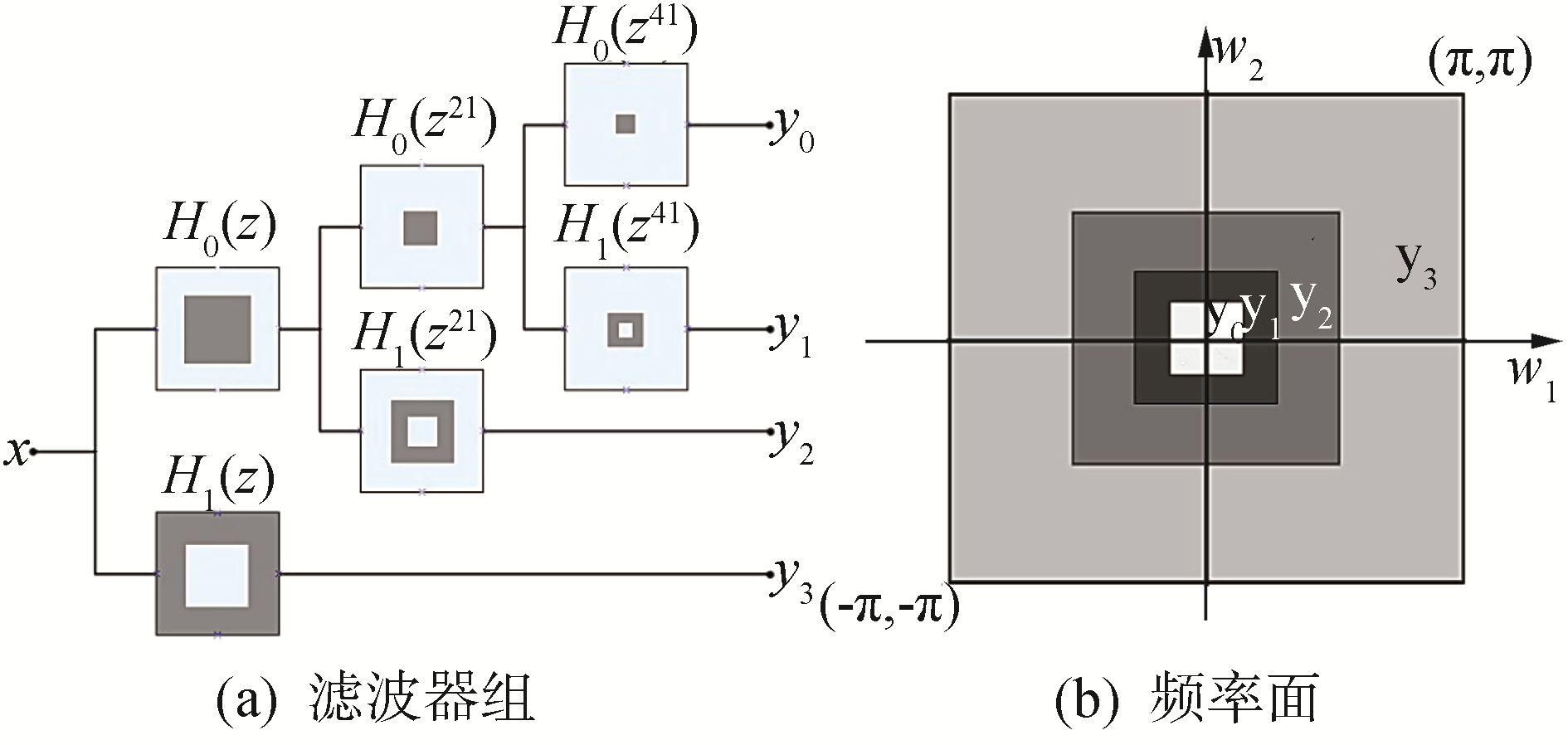

NSP实现了NSCT的多尺度子带分解,具有平移不变性。一个K级的NSP分解可以将源图像分解为1幅低频子带图像和K幅不同尺度的高频图像。图 1给出了3级金字塔分解过程及相应的频率面图。

|

Download:

|

| 图 1 3级NSP滤波器组及其频率面 Fig. 1 Three-stage NSP and its frequency domain support | |

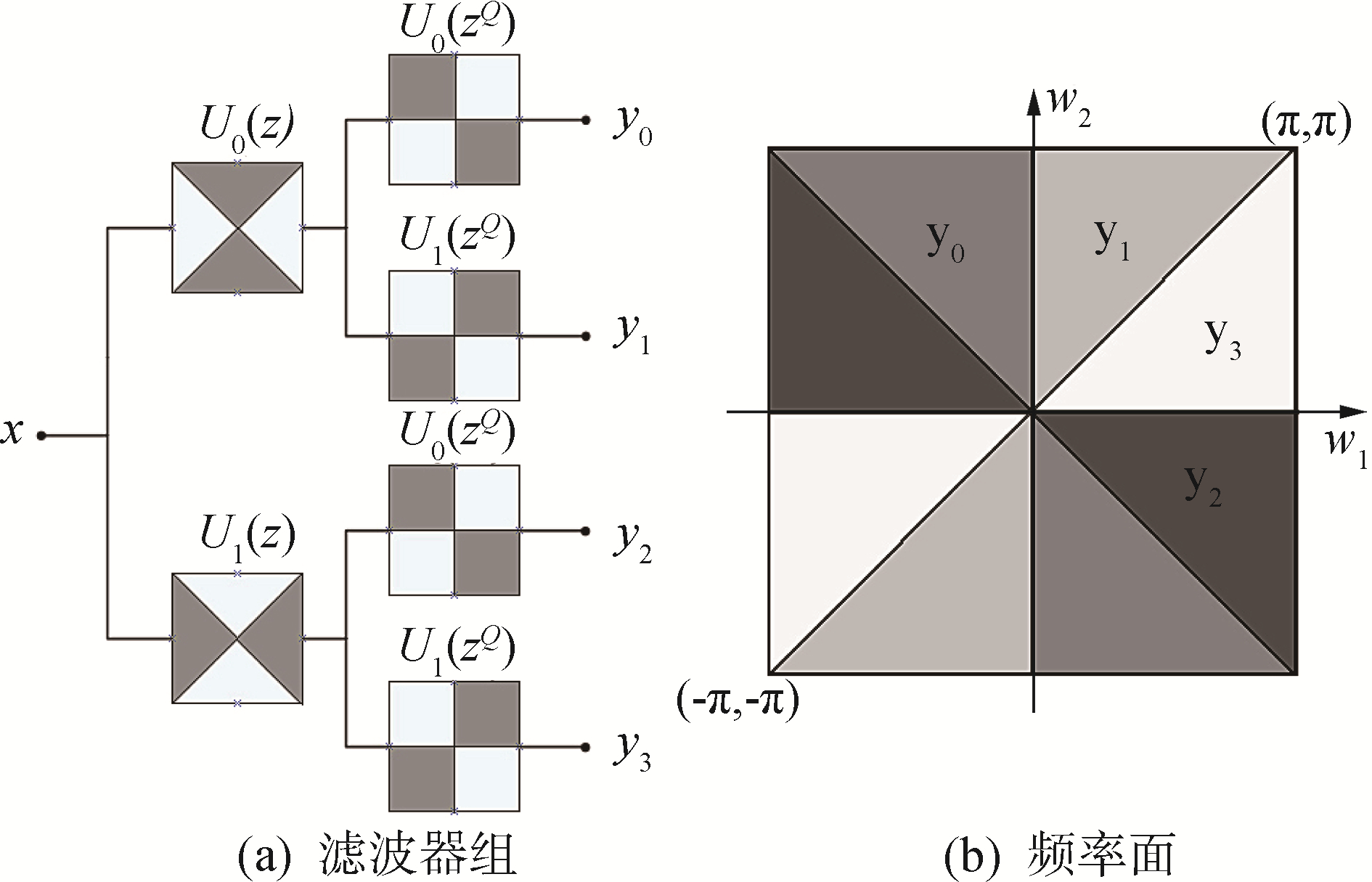

NSDFB是通过树状结构的方向滤波器组对NSP分解后所得的图像进行方向分解,获取更精细的方向信息。图 2给出了2级NSDFB滤波器组的分解过程及相应的频率面图。

|

Download:

|

| 图 2 2级NSDFB滤波器组及其频率面 Fig. 2 Two-stage NSDFB and its frequency decomposition | |

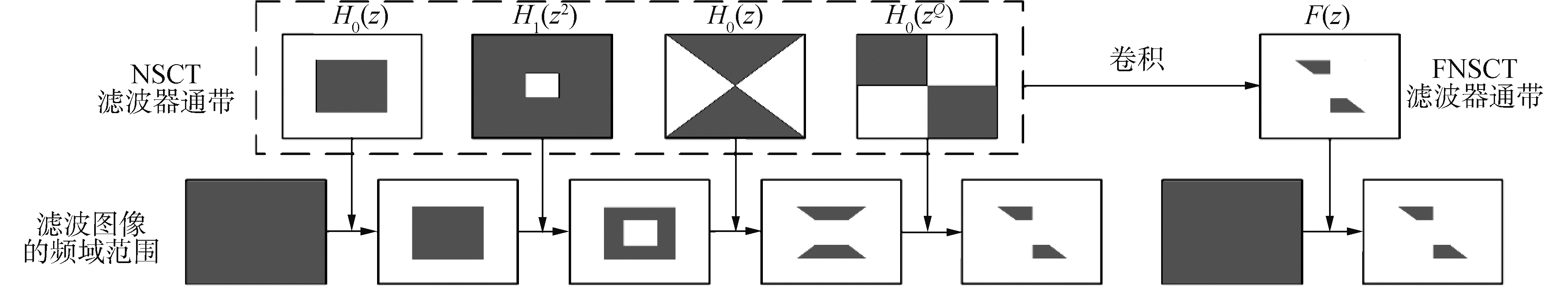

FNSCT用多通道滤波器组代替传统NSCT的树形滤波器组结构[11],每幅子带图像只需经过一次滤波,使图像的滤波运算次数减少很多,因此FNSCT相比传统NSCT提高了分解效率,图 3为快速NSCT中滤波器的示意图。图 3中H0(z)和H1(z2)分别表示NSP中低通和高通滤波器,U0(z)和U1(zQ)分别表示NSDFB中的扇形滤波器和象限滤波器,F(z)表示FNSCT中的通道滤波器:

| $ \mathit{\boldsymbol{F}}\left( z \right) = {\mathit{\boldsymbol{H}}_0}\left( z \right){\mathit{\boldsymbol{H}}_1}\left( {{z^2}} \right){\mathit{\boldsymbol{U}}_0}\left( z \right){\mathit{\boldsymbol{U}}_1}\left( {{z^Q}} \right) $ | (1) |

|

Download:

|

| 图 3 FNSCT的实现 Fig. 3 Illustration of FNSCT | |

PCNN是由Eckhorn等模拟猫大脑皮层对视觉信号的处理机制而提出的一种单层反馈神经网络模型[12]。它由多个神经元相互连接而成,每个神经元均由接收域、耦合连接调制域及脉冲发生器3部分组成。由于标准的PCNN模型需要确定太多实验参数,所以本文采用简化的PCNN模型。

| $ {\mathit{\boldsymbol{L}}_{ij}}\left( n \right) = {{\bf{e}}^{ - {a_L}}}{\mathit{\boldsymbol{L}}_{ij}}\left( {n - 1} \right) + {\mathit{\boldsymbol{V}}_L}\sum\limits_{kl} {{\mathit{\boldsymbol{W}}_{ijkl}}{\mathit{\boldsymbol{Y}}_{kl}}\left( {n - 1} \right)} $ | (3) |

| $ {\mathit{\boldsymbol{U}}_{ij}}\left( n \right) = {\mathit{\boldsymbol{F}}_{ij}}\left( n \right)\left[ {1 + {\mathit{\boldsymbol{\beta }}_{ij}}{\mathit{\boldsymbol{L}}_{ij}}\left( n \right)} \right] $ | (4) |

| $ {\mathit{\boldsymbol{Y}}_{ij}}\left( n \right) = \left\{ \begin{array}{l} 1, \;\;\;\;{\mathit{\boldsymbol{U}}_{ij}}\left( n \right) \ge {\mathit{\boldsymbol{\theta }}_{ij}}\left( {n - 1} \right)\\ 0, \;\;\;\;{\mathit{\boldsymbol{U}}_{ij}}\left( n \right) < {\mathit{\boldsymbol{\theta }}_{ij}}\left( {n - 1} \right) \end{array} \right. $ | (5) |

| $ {\mathit{\boldsymbol{\theta }}_{ij}} = {{\bf{e}}^{ - {a_\theta }}}{\mathit{\boldsymbol{\theta }}_{ij}}\left( {n - 1} \right) + {\mathit{\boldsymbol{V}}_\theta }{\mathit{\boldsymbol{Y}}_{ij}}\left( n \right) $ | (6) |

式中:(i, j)为像素点的坐标位置;Sij为外部输入项;Fij表示反馈输入;Lij表示链接输入;β为神经元之间链接强度;Wijkl则为链接系数矩阵,其中,k, l为链接范围大小;Uij为内部活动项;Yij表示最后的输出;θij是动态阈值,当Yij产生输出时,动态阈值θij会增加,神经元不再产生输出,于是动态阈值开始指数衰减,当其小于Uij时,会再次产生脉冲输出,如此循环。aL和aθ分别表示链接输入和阈值函数的时间衰减函数,VL和Vθ分别为链接输入和阈值函数的放大系数。

1.3 萤火虫算法萤火虫算法(firefly algorithm, FA)是一种群体搜索的智能优化算法[13],它是对萤火虫群体行为的模拟,通过萤火虫个体之间相互吸引移动来进行寻优,属于一种群智能算法。

萤火虫算法首先要将萤火虫i的绝对亮度Ii与算法的目标函数建立联系,一般采用萤火虫的绝对亮度值来表示萤火虫当前位置的目标函数值。当萤火虫i的绝对亮度大于萤火虫j的绝对亮度时,萤火虫j将会被萤火虫i吸引,并向其移动。移动距离的大小取决于萤火虫之间的吸引力,即相对亮度。由于萤火虫的亮度会受到环境中空气吸收的影响,因此萤火虫i对萤火虫j的相对亮度则定义为:

| $ {\mathit{\boldsymbol{I}}_{ij}}\left( {{r_{ij}}} \right) = {\mathit{\boldsymbol{I}}_i}{{\rm{e}}^{ - \gamma r_{ij}^2}} $ | (7) |

式中:Ii表示萤火虫i的绝对亮度;γ为光吸收系数,一般情况下设为常数;r代表萤火虫i与萤火虫j之间的距离;rij为萤火虫i到萤火虫j的笛卡尔距离,即:

| $ {r_{ij}} = \left\| {{x_i} - {x_j}} \right\| = \sqrt {\sum\limits_{k = 1}^d {{{\left( {{x_{i, k}} - {x_{j, k}}} \right)}^2}} } $ | (8) |

假设萤火虫i对萤火虫j的相对亮度成比例,则根据相对亮度的定义,萤火虫i对萤火虫j的吸引力β为:

| $ {\mathit{\boldsymbol{\beta }}_{ij}}\left( {{\mathit{\boldsymbol{r}}_{ij}}} \right) = {\beta _0}{{\rm{e}}^{ - \gamma r_i^2j}} $ | (9) |

式中:β0为最大吸引力,即在r=0处萤火虫的吸引力,一般β0取1。γ仍为光吸收系数,代表吸引力的变化,它的值对萤火虫算法的收敛速度和优化效果有很大影响,一般γ∈[0.01, 100]。

萤火虫向萤火虫移动并更新其位置信息,萤火虫的位置更新公式如下

| $ {\mathit{\boldsymbol{x}}_j}\left( {t + 1} \right) = {\mathit{\boldsymbol{x}}_j}\left( t \right) + {\mathit{\boldsymbol{\beta }}_{ij}}\left( {{r_{ij}}} \right)\left( {{\mathit{\boldsymbol{x}}_i}\left( t \right) - {\mathit{\boldsymbol{x}}_j}\left( t \right)} \right) + \alpha {\mathit{\boldsymbol{\varepsilon }}_j} $ | (10) |

式中:xi和xj分别表示萤火虫i和萤火虫j的位置,βij(rij)为萤火虫间的吸引力,t为迭代次数,α为常数,α∈[0, 1],εj为随机数向量。

2 结合FNSCT和萤火虫优化PCNN的图像融合算法 2.1 IHS变换IHS是依赖RGB图像的一种变换,将RGB图像分别用I、H、S 3个分量表示。色调H和饱和度S一般代表图像的光谱信息,调整图像的亮度分量,一般不会对图像造成光谱信息的缺失,因此IHS变换更适合于多光谱与全色图像的融合。IHS变换过程如下:

1) 对多光谱图像进行IHS变换,获得图像的I、H、S分量;

2) 融合多光谱图像的I分量与全色图像,得到融合I′分量;

3) 将分量I′与分离的色调H分量和饱和度S分量进行IHS逆变换,实现图像融合。

2.2 高低频融合规则 2.2.1 低频系数融合规则低频子带是对图像的基本近似,描述了图像的基本结构,包含了图像的大部分能量。低频子带的融合,可以采取简单的加权权值法,该方法虽抑制了图像中的噪声,但同时也造成了一定程度的信息冗余,导致图像失真。因此本文采用区域平均能量法,通过计算图像中每个像素点邻域内平均能量的匹配度来确定像素点的低频融合权值。

定义图像n×n区域内的平均能量EX(i, j)为:

| $ {\mathit{\boldsymbol{E}}_X}\left( {i, j} \right) = \frac{1}{{n \times n}}\sum\limits_{m = - \frac{{n - 1}}{2}}^{m = \frac{{n - 1}}{2}} {\sum\limits_{r = - \frac{{n - 1}}{2}}^{r = \frac{{n - 1}}{2}} {{c^2}\left( {i + m, j + r} \right)} } $ | (11) |

式中:EX(i, j)为像素点(i, j)的区域平均能量,X代表源图像,c为低频分量系数。

定义区域平均能量匹配度为:

| $ \begin{array}{*{20}{c}} {\mathit{\boldsymbol{M}}\left( {i, j} \right) = \frac{2}{{{\mathit{\boldsymbol{E}}_A} + {\mathit{\boldsymbol{E}}_B}}} \cdot }\\ {\sum\limits_{m = - \frac{{n - 1}}{2}}^{m = \frac{{n - 1}}{2}} {\sum\limits_{r = - \frac{{n - 1}}{2}}^{r = \frac{{n - 1}}{2}} {{c_A}\left( {i + m, j + r} \right){c_B}\left( {i + m, j + r} \right)} } } \end{array} $ | (12) |

根据算术平方数的性质可知:

| $ 0 \le \mathit{\boldsymbol{M}}\left( {i, j} \right) \le {n^2} $ | (13) |

为了方便两幅图像M(i, j)的对比,归一化处理,归一化后的区域平均能量匹配系数定义为M′(i, j):

| $ \begin{array}{*{20}{c}} {\mathit{\boldsymbol{M'}}\left( {i, j} \right) = \frac{2}{{{n^2}\left( {{\mathit{\boldsymbol{E}}_A} + {\mathit{\boldsymbol{E}}_B}} \right)}} \cdot }\\ {\sum\limits_{m = - \frac{{n - 1}}{2}}^{m = \frac{{n - 1}}{2}} {\sum\limits_{r = - \frac{{n - 1}}{2}}^{r = \frac{{n - 1}}{2}} {{c_A}\left( {i + m, j + r} \right){c_B}\left( {i + m, j + r} \right)} } } \end{array} $ | (14) |

归一化区域平均能量匹配系数体现了两幅图像的特征相似程度,M′(i, j)越大,表示2幅图像中特征越接近,相反,则特征差异较大。

根据M′(i, j)可以确定两幅图像的低频系数,阈值λ取0.5。若M′(i, j)≤λ且EA(i, j)≥EB(i, j), 则说明当M′(i, j)≤0.5时,源图像A中像素点的区域平均能量值大于源图像B中的,则选取源图像A中的低频系数作为融合图像的低频系数;反之,若M′(i, j)≤λ且EA(i, j)<EB(i, j),则选择源图像B中的低频系数作为融合图像的低频系数;若M′(i, j)>λ,则说明两幅源图像中像素点(i, j)处的区域平均能量相差不大,此时可将二者在像素点(i, j)处的低频系数进行加权平均作为最终融合图像的低频系数。具体选取规则如下:

| $ \begin{array}{*{20}{c}} {{\mathit{\boldsymbol{C}}_F}\left( {i, j} \right) = }\\ {\left\{ \begin{array}{l} {\mathit{\boldsymbol{C}}_A}\left( {i, j} \right), \;\;\;\mathit{\boldsymbol{M'}}\left( {i, j} \right) \le \lambda , {\mathit{\boldsymbol{E}}_A}\left( {i, j} \right) \ge {E_B}\left( {i, j} \right)\\ {\mathit{\boldsymbol{C}}_B}\left( {i, j} \right), \;\;\;\mathit{\boldsymbol{M'}}\left( {i, j} \right) \le \lambda , {\mathit{\boldsymbol{E}}_A}\left( {i, j} \right) < {\mathit{\boldsymbol{E}}_B}\left( {i, j} \right)\\ 0.5 \times \left( {{\mathit{\boldsymbol{C}}_A}\left( {i, j} \right) + {\mathit{\boldsymbol{C}}_n}\left( {i, j} \right)} \right), \;\;\;\;\mathit{\boldsymbol{M'}}\left( {i, j} \right) > \lambda \end{array} \right.} \end{array} $ | (15) |

高频子带的融合一般采取绝对值取大、局部梯度和局部方差等规则。这些规则只考虑了单个像素或者窗口内像素,对图像细节信息提取不够充分,为了更好地利用图像的全局信息,针对高频系数,本文采用基于萤火虫优化的自适应PCNN融合方法。

在PCNN中,需要确定的参数很多,其中链接强度决定了线性链接输入对内部活动项的贡献程度,在融合过程中起着重要作用。在传统的基于PCNN的图像融合算法中,β一般根据经验值来确定,通常所有神经元β取相同的值[14]。而有学者考虑到,人眼视觉神经系统中各个神经元的链接强度不会完全相同,而是受到图像子带特征的影响。特征越显著,其空间频率也会越大,因此本文采用图像中每个像素点的空间频率作为其链接强度系数。神经元具有越显著的特征,其受到相邻神经元影响就越大,被捕获点火也就会越早,点火次数就越多。为了增强相邻神经元对该神经元的影响程度,图像中包含较多显著特征的神经元的链接范围也应增大。因此,链接范围也可以通过图像特征自适应地进行选取。当图像中(i, j)点处的空间频率大于图像中所有3×3邻域内最大空间频率的一半时,PCNN的链接范围取5×5;若小于,则取3×3。具体的链接强度和链接范围的确定方法如下。

首先计算图像中各像素点的空间频率:

| $ \begin{array}{*{20}{c}} {\mathit{\boldsymbol{S}}{\mathit{\boldsymbol{F}}_{i, j}} = \sqrt {\frac{1}{{\left( {2P + 1} \right)\left( {2Q + 1} \right)}}} \cdot }\\ {\sqrt {\sum\limits_{m = i - P}^{i + P} {\sum\limits_{m = j - Q}^{j + Q} {\left[ {{{\left( {{\mathit{\boldsymbol{C}}_{m, n + 1}} - {\mathit{\boldsymbol{C}}_{m, n}}} \right)}^2} + {{\left( {{\mathit{\boldsymbol{C}}_{m + 1, n}} - {\mathit{\boldsymbol{C}}_{m, n}}} \right)}^2}} \right]} } } } \end{array} $ | (16) |

式中:C(i, j)代表(i, j)处的子带系数,(2P+1)×(2Q+1)为滑动窗口的大小,P、Q取正整数,本文选取3×3的窗口。对于链接范围,可以选取3×3和5×5两种链接范围:

| $ k = l = \left\{ \begin{array}{l} 5, \;\;\;\;\mathit{\boldsymbol{S}}{\mathit{\boldsymbol{F}}_{i, j}} \ge \frac{1}{2}\max \left( {\mathit{\boldsymbol{S}}{\mathit{\boldsymbol{F}}_{p, q}}} \right)\\ 3, \;\;\;\;\mathit{\boldsymbol{S}}{\mathit{\boldsymbol{F}}_{i, j}} < \frac{1}{2}\max \left( {\mathit{\boldsymbol{S}}{\mathit{\boldsymbol{F}}_{p, q}}} \right) \end{array} \right. $ | (17) |

PCNN中其他参数的选取也会影响融合质量,因此本文采用萤火虫优化方法对其他参数进行寻优处理,每个萤火虫代表一个参数,即X=(X1, X2, X3, X4)=(aL, aθ, VL, Vθ),其中,aθ、VB分别为阈值的衰减指数和放大系数;aL、VL分别为链接衰减指数和放大系数。

图像融合质量既需要主观判断,同时也需要通过客观评价指标进行衡量。因而利用寻优特性的萤火虫算法也应以评价指标作为目标函数,本文选取的指标为平均梯度(average gradient, AG)。

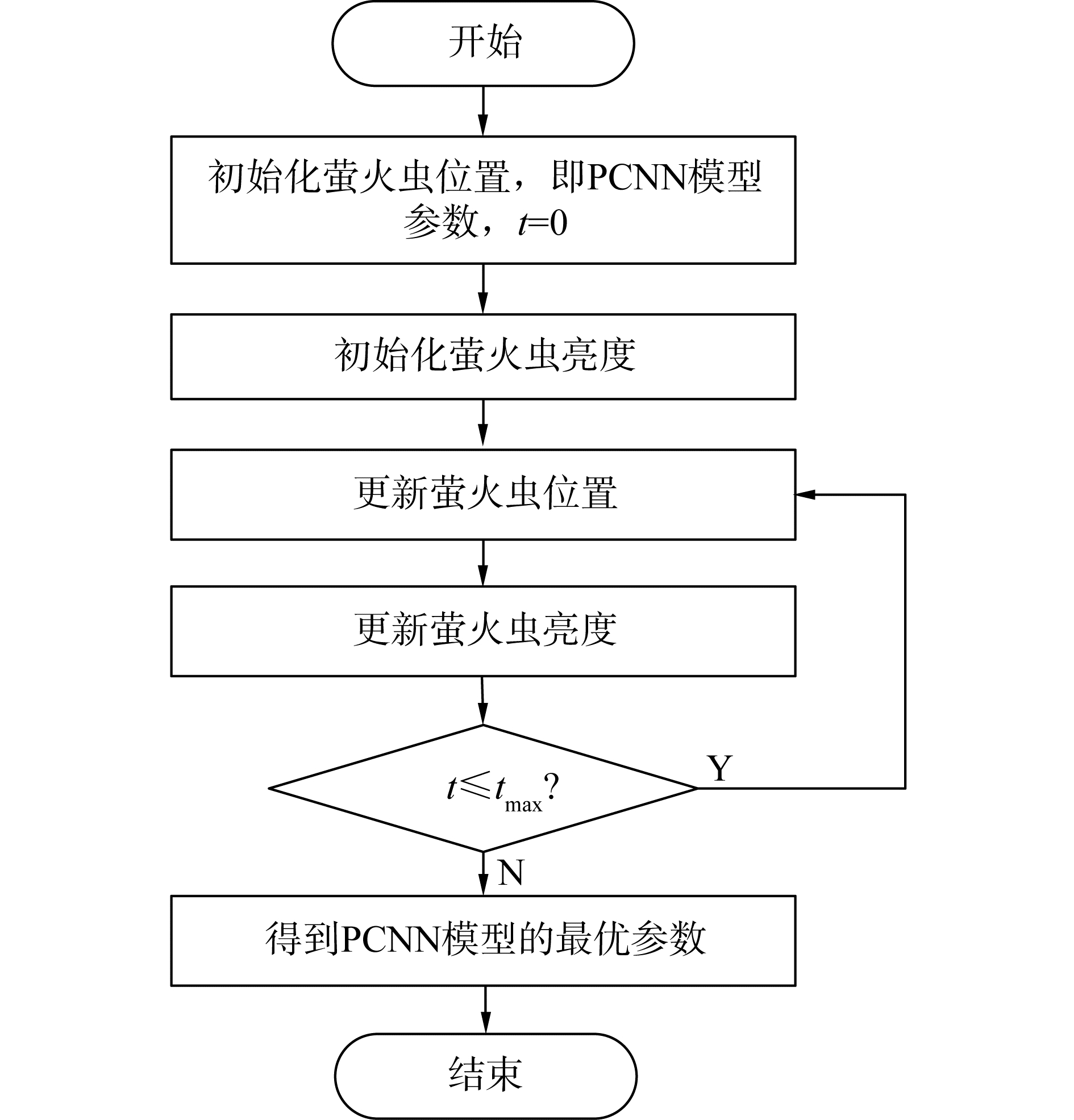

萤火虫算法对PCNN模型的优化过程如下:

1) 初始化每只萤火虫的位置,萤火虫位置即为PCNN模型参数aθ、Vθ、aL、VL;

2) 将萤火虫的位置代入目标函数,对萤火虫亮度进行初始化,目标函数为融合图像的平均梯度;

3) 根据萤火虫之间的吸引规则对萤火虫的位置进行更新,再计算目标函数,更新萤火虫的亮度;

4) 优化次数t加1,当t≤tmax时返回第3步;

5) 当t≤tmax,迭代结束,获得最优的目标函数与萤火虫位置,获得最优模型。

萤火虫优化PCNN模型流程图如图 4所示。

|

Download:

|

| 图 4 萤火虫优化PCNN模型流程图 Fig. 4 Flow diagram of firefly optimization of PCNN model | |

1) 将多光谱图像进行IHS变换,分离出多光谱图像的I分量;

2) 分别对多光谱图像的I分量和全色图像进行FNSCT分解,获取各自的高低频系数;

3) 通过不同的融合方法对高低频系数进行处理,低频子带利用区域平均能量法进行融合,高频系数则采用萤火虫优化的PCNN进行融合;

4) 对3)处理后的高低频系数进行FNSCT逆变换,得到融合后的亮度分量I′;

5) 将I′分量与原多光谱图像分解后得到的H、S分量进行IHS逆变换,获得最终的融合图像。

图 5给出了本文的算法框图。

|

Download:

|

| 图 5 算法框图 Fig. 5 Framework of the proposed algorithm | |

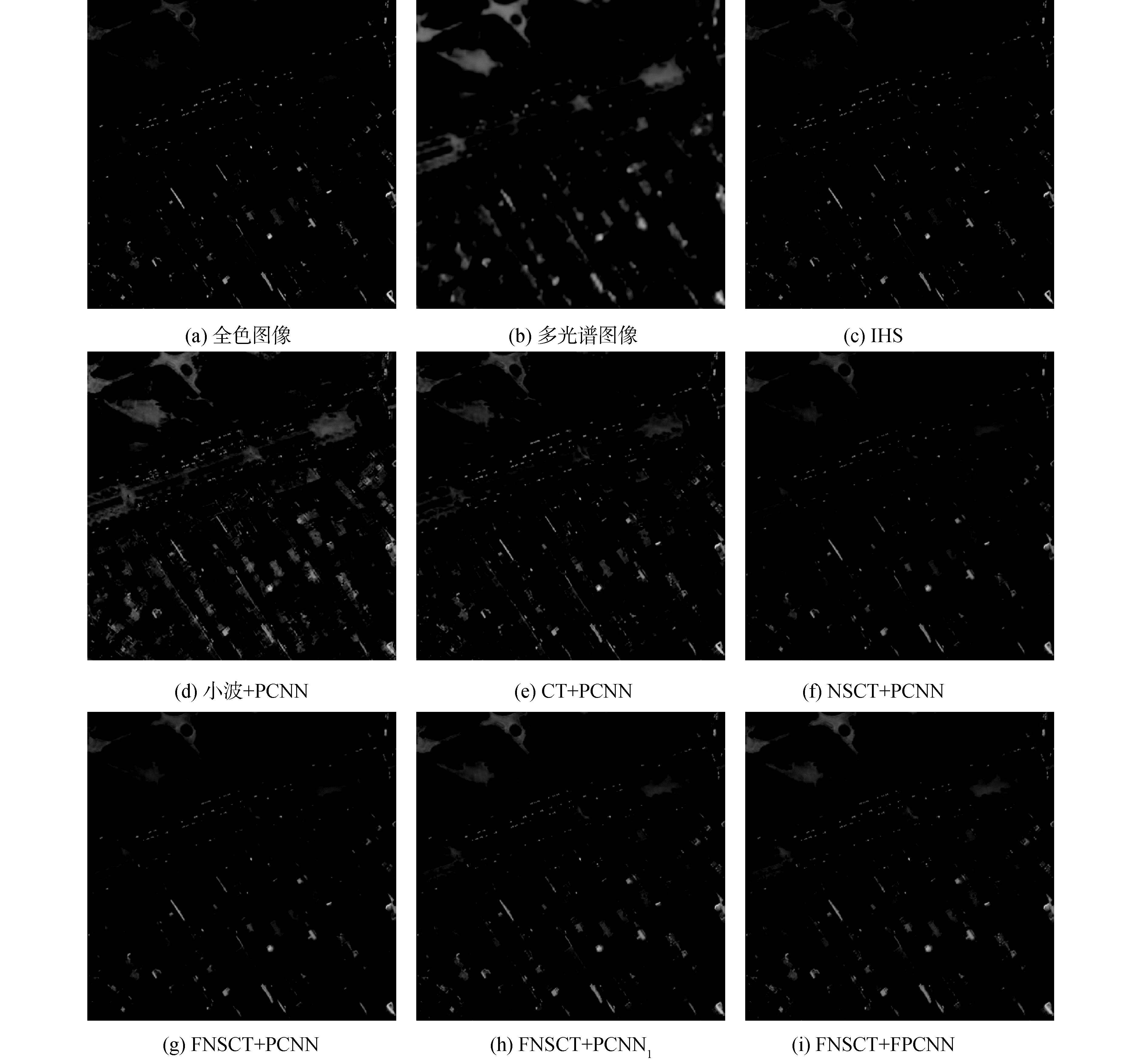

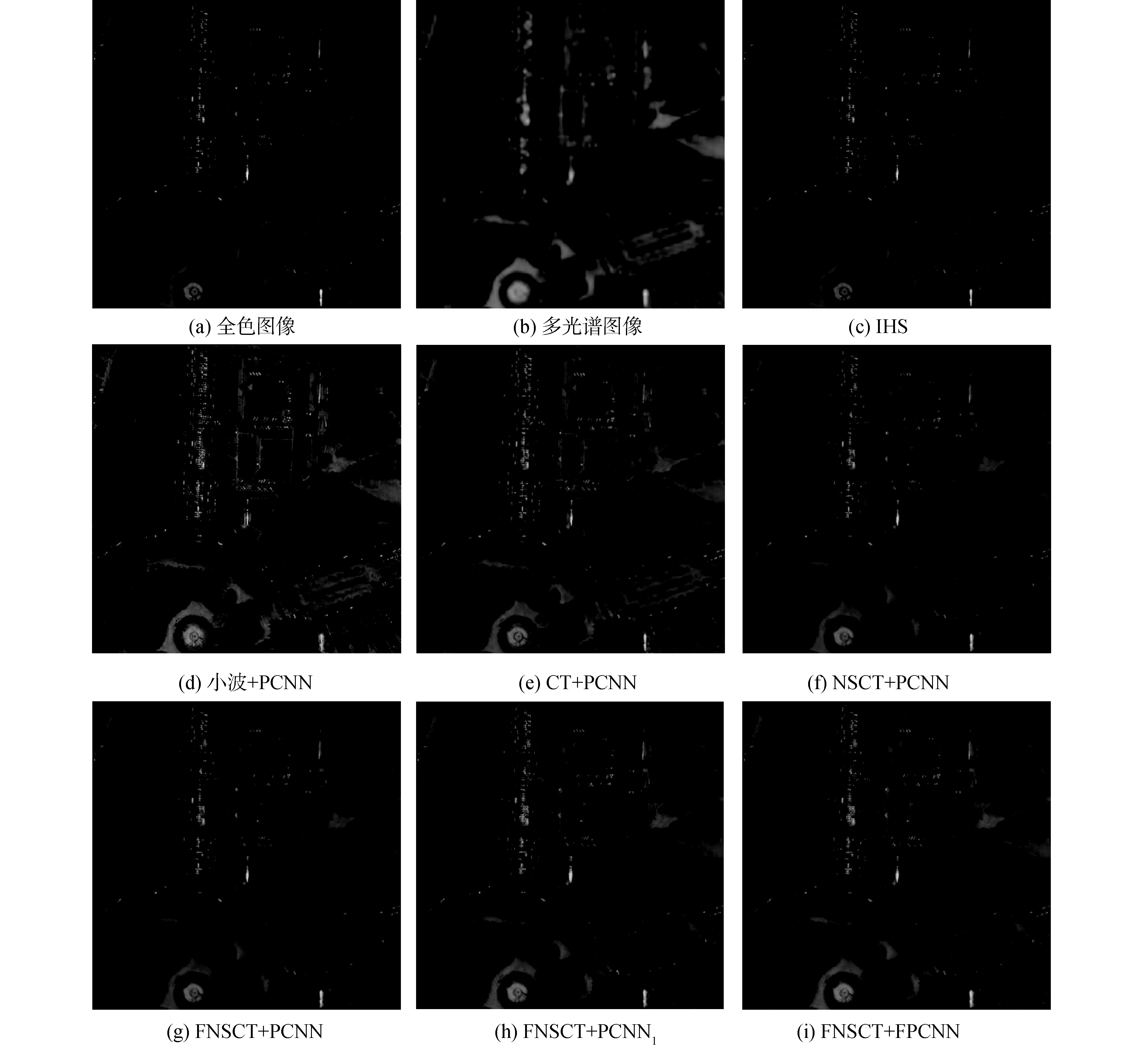

为验证其有效性,对大量多光谱与全色图像进行了融合实验。并与传统的基于IHS变换、小波变换+PCNN、CT+PCNN、NSCT+PCNN、以及2种FNSCT+PCNN等融合方法进行了比较[10, 14-16]。第1种FNSCT+PCNN方法中链接强度与链接范围均为常数,记为FNSCT+PCNN;第2种方法对PCNN的链接强度进行了自适应化,链接系数及其他参数仍为常数,记为FNSCT+PCNN1。

实验数据选自Pléiades卫星采集的法国南部图卢兹的城市图像,图像大小为1 024×1 024,本文截取了其中2组400×400的图像进行了实验,将2组实验数据定义为Pléiades-Ⅰ和Pléiades-Ⅱ。

实验中,萤火虫算法参数设置为:最大吸引力β=0.2,光吸收系数γ=1,α=0.5,迭代次数N=50。对比算法的PCNN1和PCNN2的参数设置如下,N=10,αL=1,αθ=2,VL=1,Vθ=20,w=[0.707 1 0.707;1 0 1; 0.707 1 0.707]。PCNN1中β=0.1。本文仿真实验环境为Matlab 2014a,实验平台处理器为Intel(R)Core(TM)i7-4 770 K,主频3.50 GHz,内存16.0 GB。

实验结果如图 6、7所示,图 6(a)、图 7(a)、图 6(b)、图 7(b)分别表示Pléiades-Ⅰ和Pléiades-Ⅱ两组数据源的全色图像和上采样后的多光谱图像;图 6(c)、图 7(c)为基于传统的IHS变换所得的融合图像,虽然空间信息有所加强,但融合图像中出现较明显的光谱失真现象,光谱损失严重;图 6(d)、图 7(d)为小波变换与PCNN结合的融合结果,可以看出图像在纹理细节方面较模糊,且和原多光谱图像相比,图像色调偏浅,存在一定程度的光谱失真;图 6(e)、图 7(e)为轮廓波变换与PCNN相结合的融合结果,可以看出,在边缘细节部分较图 6(d)、图 7(d)有一定的提升,但图像整体色调更浅,光谱失真较重;图 6(f)、图 7(f)和图 6(g)、图 7(g)分别采用的是NSCT与PCNN结合方法和FNSCT与PCNN结合方法的融合图像,融合结果在空间分辨率与光谱信息的留存率上均有所提高;图 6(h)、图 7(h)为FNSCT与自适应PCNN的融合结果,融合图像在光谱方面得到增强,但部分细节之处仍有待加强;本文方法所得融合结果如图 6(i)、图 7(i)所示,在视觉效果上与图 6(h)、图 7(h)相差不大,但细节之处略有提升,也充分保留了多光谱图像的光谱信息。

|

Download:

|

| 图 6 Pléiades-Ⅰ源图像及融合结果 Fig. 6 The original images and fusion results of Pléiades-Ⅰ | |

|

Download:

|

| 图 7 Pléiades-Ⅱ源图像及融合结果 Fig. 7 The original images and fusion results of Pléiades-Ⅱ | |

本文选取信息熵(information entropy, IE)、平均梯度、相关系数(correlation coefficient, CC)、光谱扭曲度(degree of distortion, DD)、光谱角(spectral angle mapper, SAM)和相对整体维数综合误差(ERGAS)作为客观评价指标[17]来客观评价融合图像质量。IE表示图像所包含的信息量,其值越大,代表融合图像包含的信息越多,融合质量越高;AG能够评价图像的清晰度,AG值越大,图像越清晰;CC反映了融合图像与多光谱图像的相关程度,相关系数值越大,融合图像保留的光谱信息越多;DD直接反映融合图像较多光谱图像的光谱损失程度,其值越小,光谱损失越少,融合图像的效果越好;SAM反映整幅图像的光谱失真程度,光谱角越小,图像的光谱失真越少;ERGAS用来衡量光谱质量,其值越小,融合图像质量越高。2组实验数据的客观评价指标如表 1、表 2所示。

| 表 1 Pléiades-Ⅰ源图像融合结果的性能分析 Table 1 Performance comparison of fusion results using Pléiades-Ⅰ images |

| 表 2 Pléiades-Ⅱ源图像融合结果的性能分析 Table 2 Performance comparison of fusion results using Pléiades-Ⅱ images |

从表 1和表 2给出的客观评价指标中可以看出,基于IHS方法得到的融合结果在AG指标中效果相对较好,但其他指标均较差,特别是DD、SAM和ERGAS,融合图像丢失了大量的光谱信息,造成了严重的光谱失真;小波变换与PCNN结合及CT与PCNN结合方法中,DD、SAM和ERGAS指标下降幅度较大,光谱信息损失较IHS方法相比有所减少,但仍存在一定的光谱失真,且空间表现能力也较低。NSCT与PCNN结合方法和FNSCT与PCNN结合方法相比前3种算法,DD、SAM和ERGAS指标有所下降,IE、AG和CC指标略有提高,表示图像更好地留存了光谱信息,且图像的空间信息也有所增强,2种方法的各项指标相差不大,区别在于FNSCT与PCNN结合方法运算速度更快;FNSCT+PCNN1方法在IE和AG指标上得以提升,图像清晰度较高,但在DD,SAM和ERGAS指标上降低较少,在光谱留存方面略有提高;本文提出的算法是对上述算法的综合与改进,利用了IHS变换获取多光谱图像的亮度分量,并对PCNN算法的链接范围进行了自适应改进以及对PCNN算法的其他参数的优化。通过实验证明,FNSCT+FPCNN在客观指标上具有较好的表现,与其他方法相比,获得了较高的IE、AG、CC以及较低的DD、SAM和ERGAS,说明本文所提出的方法在提高图像空间分辨率的同时很好地留存了光谱信息。

4 结论1) 本文提出了一种基于FNSCT)与萤火虫优化的自适应PCNN相结合的遥感图像融合算法,该算法充分利用了FNSCT灵活的多尺度和多方向的特性。

2) 对于高频子带,通过空间频率特征设置链接强度、选取链接范围,并利用具有较高寻优精度的萤火虫优化算法选取PCNN的其他参数;低频子带部分则采用区域平均能量法融合低频系数,更好地实现了多光谱与全色图像的融合。

3) 实验结果表明,本文提出的算法在多光谱与全色图像融合上能够达到较好的客观指标与视觉效果,获得既具有较高空间分辨率又具有丰富光谱信息的融合图像。

| [1] |

WU Jin, HUANG Honglin, QIU Ya, et al. Remote sensing image fusion based on average gradient of wavelet transform[C]//Proceedings of 2005 IEEE International Conference Mechatronics and Automation. Niagara Falls, Ont., Canada, 2005, 4: 1817-1821. https://www.researchgate.net/publication/4239594_Remote_sensing_image_fusion_based_on_average_gradient_of_wavelet_transform

(  0) 0)

|

| [2] |

AMOLINS K, ZHANG Yun, DARE P. Wavelet based image fusion techniques-an introduction, review and comparison[J]. ISPRS journal of photogrammetry and remote sensing, 2007, 62(4): 249-263. DOI:10.1016/j.isprsjprs.2007.05.009 (  0) 0)

|

| [3] |

CHOI M. A new intensity-hue-saturation fusion approach to image fusion with a tradeoff parameter[J]. IEEE transactions on geoscience and remote sensing, 2006, 44(6): 1672-1682. DOI:10.1109/TGRS.2006.869923 (  0) 0)

|

| [4] |

RAHMANI S, STRAIT M, MERKURJEV D, et al. An adaptive IHS pan-sharpening method[J]. IEEE geoscience and remote sensing letters, 2010, 7(4): 746-750. DOI:10.1109/LGRS.2010.2046715 (  0) 0)

|

| [5] |

YANG Wenkao, WANG Jing, GUO Jing. A novel algorithm for satellite images fusion based on compressed sensing and PCA[J]. Mathematical problems in engineering, 2013, 2013: 708985. (  0) 0)

|

| [6] |

辛亚楠, 邓磊. 基于小波变换的遥感图像融合方法研究[J]. 激光与光电子学进展, 2013, 50(2): 021001. XIN Ya'nan, DENG Lei. An improved remote sensing image fusion method based on wavelet transform[J]. Laser & optoelectronics progress, 2013, 50(2): 021001. (  0) 0)

|

| [7] |

DO M N, VETTERLI M. The contourlet transform:an efficient directional multiresolution image representation[J]. IEEE transactions on image processing, 2005, 14(12): 2091-2106. DOI:10.1109/TIP.2005.859376 (  0) 0)

|

| [8] |

DA CUNHA A L, ZHOU J, DO M N. The nonsubsampled contourlet transform:theory, design, and applications[J]. IEEE transactions on image processing, 2006, 15(10): 3089-3101. DOI:10.1109/TIP.2006.877507 (  0) 0)

|

| [9] |

KONG Weiwei, LIU Jianping. Technique for image fusion based on nonsubsampled shearlet transform and improved pulse-coupled neural network[J]. Optical engineering, 2013, 52(1): 017001. DOI:10.1117/1.OE.52.1.017001 (  0) 0)

|

| [10] |

郝文超, 贾年. NSCT域内基于自适应PCNN的红外与可见光图像融合方法[J]. 西华大学学报(自然科学版), 2014, 33(3): 11-15. HAO Wenchao, JIA Nian. Fusion algorithm of infrared and visible images based on adaptive PCNN in NSCT domain[J]. Journal of Xihua University (natural science edition), 2014, 33(3): 11-15. DOI:10.3969/j.issn.1673-159X.2014.03.003 (  0) 0)

|

| [11] |

赵春晖, 郭蕴霆. 一种快速的基于稀疏表示和非下采样轮廓波变换的图像融合算法[J]. 电子与信息学报, 2016, 38(7): 1773-1780. ZHAO Chunhui, GUO Yunting. Fast image fusion algorithm based on sparse representation and non-subsampled contourlet transform[J]. Journal of electronics & information technology, 2016, 38(7): 1773-1780. (  0) 0)

|

| [12] |

SUBASHINI M M, SAHOO S K. Pulse coupled neural networks and its applications[J]. Expert systems with applications, 2014, 41(8): 3965-3974. DOI:10.1016/j.eswa.2013.12.027 (  0) 0)

|

| [13] |

YANG Xinshe. Nature-inspired metaheuristic algorithms[M]. Frome: Luniver Press, 2008.

(  0) 0)

|

| [14] |

赵春晖, 季亚新. 基于二代曲波变换和PCNN的高光谱图像融合[J]. 哈尔滨工程大学学报, 2008, 29(7): 729-734. ZHAO Chunhui, JI Yaxin. Fusion of hyperspectral images based on second generation curvelet transform and pulse-coupled neural networks[J]. Journal of Harbin Engineering University, 2008, 29(7): 729-734. DOI:10.3969/j.issn.1006-7043.2008.07.016 (  0) 0)

|

| [15] |

薛寺中, 周爱平, 梁久祯. 基于小波变换的PCNN多传感器图像融合[J]. 计算机工程与应用, 2011, 47(35): 210-213. XUE Sizhong, ZHOU Aiping, LIANG Jiuzhen. Fusion of multi-sensor images based on wavelet transform and PCNN[J]. Computer engineering and applications, 2011, 47(35): 210-213. DOI:10.3778/j.issn.1002-8331.2011.35.059 (  0) 0)

|

| [16] |

李峤, 李海云. 基于Contourlet变换和PCNN的CT图像椎体解剖轮廓特征提取方法的研究[J]. 中国生物医学工程学报, 2010, 29(6): 841-845. LI Qiao, LI Haiyun. Contour extraction of vertebra CT image based on contourlet transform and PCNN[J]. Chinese journal of biomedical engineering, 2010, 29(6): 841-845. DOI:10.3969/j.issn.0258-8021.2010.06.008 (  0) 0)

|

| [17] |

殷明, 庞纪勇, 魏远远, 等. 结合NSDTCT和稀疏表示的遥感图像融合[J]. 光子学报, 2016, 45(1): 0110002. YIN Ming, PANG Jiyong, WEI Yuanyuan, et al. Remote sensing image fusion based on non-subsampled dual-tree complex contourlet transform and sparse representation[J]. Acta photonica sinica, 2016, 45(1): 0110002. (  0) 0)

|

2019, Vol. 40

2019, Vol. 40