集合预报这一思想首先是由Epstein和Leith提出的, 由于受到当时计算机条件的限制, 这一创造性的想法并未能在业务数值天气预报中得以实施。进入20世纪90年代, 随着大规模并行计算机的发展以及气象技术的进步, 集合数值预报不仅已成为数值预报的一个重要方向, 而且日趋成熟, 越来越显示出它的预报能力, 集合预报的应用也越来越受到重视。1999年11月在ECMWF每二年一次业务系统发展国际研讨会上, 几乎一半以上 (欧洲则所有的与会者) 的文章都是研讨集合预报的发展和应用问题[1]。

由于集合预报要做很多个样本 (少则几个, 多则几十个、几百个), 因此需要的计算机资源和能力都非常大。1992年集合预报系统首先在欧洲中期天气预报中心 (ECMWF) 和美国国家环境预报中心 (NCEP) 投入业务运行。在我国气象领域, 集合预报一直是一个重要的研究课题, 但由于缺少计算机资源, 只能采用时间滞后法, 建立的系统不能适应业务需求。

国产神威高性能计算机的诞生, 使高分辨率、多成员的集合预报系统的开发成为可能。这一系统的开发成功, 将使我国在集合预报领域处于国内领先、国际先进的地位, 并将在国民经济发展中发挥重要的作用, 产生很好的经济与社会效益。

经过北京北方计算中心和国家气象中心的共同努力, 神威集合数值预报系统在经过了实时试验运行和用户试用等阶段后, 于1999年12月下旬在国家气象中心投入准业务运行, 又于2000年3月投入正式业务运行。集合预报系统现主要应用于中央气象台中期和短期预报以及中期概率预报。

本文主要对基于神威巨型机的并行化集合数值天气预报的系统的组成、主要技术特点和应用前景作一简要介绍。

1 系统组成与功能神威集合数值天气预报系统以神威巨型计算机为开发平台, 以中国气象局业务运行的中期数值天气预报模式为基础, 并与国家气象中心的数据库、通信等支持系统相连接, 形成一套完整的集合数值天气预报业务系统。系统中采用奇异向量法产生初始扰动, 产生奇异向量的模式分辨率为T21L19, 预报模式的分辨率为T106L19, 集合预报成员为32个, 生成的数值预报产品达100种以上。

神威集合数值天气预报系统的主体部分由前处理、资料同化、集合预报初始场生成、模式预报、模式后处理、产品生成、可视化运行监控等七个子系统组成。

系统使用了神威计算机中的264个处理器、16个磁盘阵列, 存储总量达120GB, 程序总量36万行。其中对占用资源大, 数据文件交换量大、运行时间长的五个部分, 即资料同化、奇异向量生成、模式预报、模式后处理和产品生成子系统进行了并行处理。

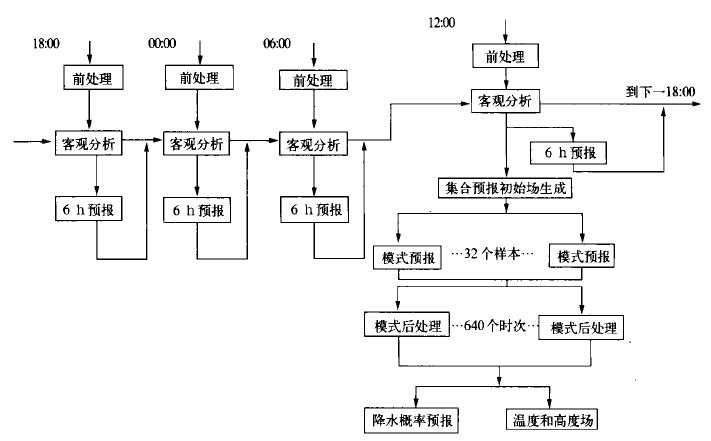

神威集合数值天气预报系统每天定时从4个时次的资料处理开始, 整个过程约需7 h左右。系统的总体结构和每日运行流程如图 1所示。

|

|

| 图 1. 神威集合数值天气预报系统总体结构和每日运行流程 (世界时) | |

2 系统实现的主要技术难点

集合数值天气预报在计算机软件实施上遇到的主要困难是:样本数多、解算量和数据传输量大。

在并行化集合预报系统中, 针对这些难点问题, 充分利用神威计算机多种并行机制的优势, 围绕多样本并行计算与控制这一核心, 不断优化程序结构, 根据各分系统的不同特点, 采取相应的并行策略, 加大并行度, 使得软件系统在功能实现、解算时效、日常运行等各个方面都满足了业务运行的需求。

神威集合数值天气预报系统软件的主要技术特点如下:

(1) 解决了异种机间的各种差异气象应用有长期技术和程序的积累, 集合数值天气预报系统不仅有依托原来相关的数据库、通信系统的要求, 而且系统中原来还有些程序是运行于异种机上的版本, 特定于机器环境的因素很多。在神威集合预报系统研制开发中主要解决了文件格式、数据表示、机器相关浮点常数、非标准数学函数、编译优化级等异种机间的差异。

(2) 根据集合预报各子系统的特点确定相应的并行机制在集合预报系统中, 资料同化、奇异向量生成、模式预报、模式后处理和产品生成等子系统, 占用的资源多, 数据文件交换量大、运行时间长, 因此必须做并行处理和优化。我们充分发挥神威并行机制多、内存大的优势, 结合各子系统的特点, 确定了相应的并行策略和优化策略。分别采用了并行任务创建与过程唤醒相结合、数据分布加消息传递、数据并行以及SPMD等并行方法, 并自行编写了高效的归约函数, 对重要部分的程序结构和数据结构进行了较大的修改优化。从而提高并行解算效率, 缩短运行时间, 满足了实际预报的时效要求。

(3) 根据集合预报各子系统的特点选择并组织好相应的I/O输入输出在集合预报系统中出现的频率高、数量大, 是贯通集合预报各子系统的主要途径之一。针对各子系统输入输出的特点, 并行化集合预报系统中设计了自动根据机器所提供的资源状况生成路径文件的方案, 使系统中所有输入输出路径可以很方便地根据机器环境、资源可用状况进行调整修改, 增强了系统的容错可靠性。而且, 输入输出路径的改变与各子系统程序无关, 给子系统间的连接和多样本运行带来极大的便利。

(4) 研制可视化实时监控系统, 完善运行系统的建立与管理对于结构复杂、环节众多、多样本运行的集合预报系统, 运行控制是不可忽视的重要方面。为使系统更加符合业务运行的要求, 完善运行系统的控制与管理, 我们使用UN IX环境下的Motif工具库, 研制开发了集合预报可视化实时监控系统。在集合预报各子系统中设置一些监控标志文件, 运行过程中这些文件适时为监控系统输出一些信息。监控系统根据这些信息显示运行情况, 查询运行时间、查询机器资源、控制运行流程, 进行出错报警, 提供容错处理等等。在运行过程中, 当机器出现一些使用软件可以绕开的故障时, 监控系统将进行容错处理, 使集合预报系统继续或降级运行。操作人员还可以通过人工修改时间和过程标志文件, 来达到从任何起点都能提交作业的目的, 从而实现了与在用T106L19业务系统的无缝连接。

3 应用发展前景计算已与理论研究、实验探求一起成为当代科学研究的三种基本手段。众多重大科学研究和工程技术领域都蕴藏着大量的计算要求, 许多还是无止境的, 神威计算机系统的研制成功并投入使用, 极大地增强了我国的超级计算能力, 能做许多过去想做而做不了的或者是目前国内别的计算机都不能做的课题。目前, 数值天气预报已成为气象工作者进行天气分析和预报的主要手段, 数值预报产品已成为现代天气预报的基础。中国气象局拟在“九五”期间增加非常规资料的应用, 提高资料分析同化的水平和模式分辨率, 采用更完善、更复杂的物理过程等方法, 提高预报准确率, 同时还要发展集合预报系统、建立全球、有限区、中尺度数值天气预报和集合预报体系。因此, 必然带来计算量的急剧增加, 对巨型计算机的需求是十分巨大、迫切的, 甚至是无止境的。神威集合数值天气预报系统的研制成功是国家气象中心和北京计算中心双方成功合作的结果, 同时也展现出神威计算机在气象领域里有十分广阔的应用前景, 我们将继续努力, 精诚合作, 优势互补, 凭借神威计算机, 研制开发出更多, 更好的气象产品, 为国民经济与社会发展提供更有力的服务保障。

| [1] | 中国气象学会数值天气预报委员会. 数值预报与并行计算研讨会论文摘要汇编. 2000. 105, 107. |

2002, 13 (2): 228-231

2002, 13 (2): 228-231