Fusion algorithm and platform development of ship navigation situation

-

摘要: 为使船舶航行操控人员或自动驾驶系统能够获得更为全面和精准的航行环境信息,提出一种融合雷达、船舶自动识别系统(automatic identification system,AIS)、可见光多源信息的目标融合算法,并开发可应用于实船的软件平台。首先,设计多源目标融合算法,根据同一性原理将雷达捕获目标与AIS解析目标融合,根据水平面坐标与垂直面坐标变换原理融合可见光目标;其次,设计船舶多源目标融合数据样本集制作原理,利用实船采集数据构建包含3种来源的数据样本,并开发多源目标识别算法;再次,设计船舶航行多源信息融合平台,开发可应用于实船的可视化人机交互界面;最后,利用实船开展算法验证和平台试验,验证融合算法的准确性和软件平台的有效性。多目标融合算法可实现3种来源目标的准确融合,融合软件平台可提供较为精准的可视化信息。Abstract: To enable ship navigation operators or auto drive system to obtain more comprehensive and accurate navigation environment information, we researched a target fusion algorithm that fuses radar, ship automatic identification system (AIS), and visible light multi-source information, and developed a software platform that can be applied to real ships. First of all, a multi-source target fusion algorithm was designed, which fuses the radar capture target and the AIS analytical target according to the principle of identity, and fuses the visible light target according to the principle of horizontal coordinate and vertical coordinate transformation. Second, the principle of making sample set of the multi-source target fusion data was designed, constructing data samples including three sources by using the data collected from the real ship, and developing the multi-source target recognition algorithm. Third, a multi-source information fusion platform of ship navigation was designed to develop a visual human-computer interaction interface that can be applied to real ships. Finally, the algorithm verification and platform test were carried out on a real ship to verify accuracy of the fusion algorithm and effectiveness of the software platform. The multi-target fusion algorithm can achieve accurate fusion of three source targets, and the fusion software platform can provide more accurate visual information.

-

Keywords:

- ship /

- navigation situation /

- data fusion /

- visible image /

- radar signal /

- AIS resolve /

- target recognition /

- platform development

-

目前随着船舶航运业的快速发展,船舶向大型化、多样化方向发展,船舶数量急剧增加,尤其是船舶在进出港、狭窄水道航行风险也随之增加,在这种情况下,仅依靠船载雷达和船舶自动识别系统(automatic identification system,AIS)开展船舶航行信息采集,已不能保证船舶的航行安全,需要引入更多的传感器来为船舶操控人员提供全方位三维化的航行场景信息,尤其将可见光图像引入,并采用多源信息融合技术将雷达、AIS和可见光目标识别结果融合,使船舶航行操控人员或自动驾驶系统能够获得更为全面和精准的航行环境信息。

船舶航行态势融合及平台开发,涉及多项研究内容,一些学者也开展过部分研究工作,例如沈庭钧[1]利用雷达、AIS以及其他导航数据,采用数据聚类、偏差检测及卡尔曼滤波算法开发基于多平台的信息融合算法;侯旺[2]详细介绍了船用雷达和AIS的数据融合算法,采用2种数据主次关联的方式,完成雷达回波目标与AIS解算目标的关联匹配工作;张阳等[3]开展近期船舶AIS数据和历史AIS数据的融合分析,利用LSTM网络训练预测模型,该方法较为新颖。

有些学者重点研究船舶航行信息融合可视化工作,这其中体现了界面的友好性和有效性,例如邱佳佳[4]开展船舶航行人机交互界面设计,将船舶实时航行状态、期望航行状态等清晰准确展示,利用OpenGL图像处理技术开展三维可视化显示,为船舶航行人员提供一种智能优化的导航界面;赵建等[5]设计开发一种融合AIS数据分析系统、智能中台以及其他智能化设备的可视化平台,并对船舶航行信息和船闸系统数据开展信息融合工作,该系统为航行操控人员提供了较为全面的可视化信息。

将可见光目标识别结果引入到船舶航行态势感知,为目标融合提供了高维的目标信息,可直接提供目标识别结果,也可通过图像识别框的坐标变换,识别目标位置坐标的获取,例如马瑞鑫等[6]结合三帧差分法与混合高斯背景减除法,提出一种船舶航行多源数据融合算法,完成了激光雷达点云数据与船舶航行AIS数据的特征融合工作,并采用卡尔曼滤波方法设计了目标跟踪任务;王维刚[7]利用YOLOv3网络训练获得船舶航行目标识别算法,并综合采用位置融合方法和属性融合方法,开展雷达目标、AIS目标、图像识别目标的多源融合工作,值得一提的是作者开发了一种集控制、感知和信息显示的人机交互系统。

还有些作者专门研究雷达和AIS这类船舶传统的感知信息,例如文献[8]介绍了当前雷达与AIS目标融合的常用方法及未来发展发现;文献[9]利用集中式、分散式、混合式方法介绍雷达和AIS目标融合算法,并详细介绍了核心算法的原理公式;文献[10]通过坐标变换并综合考虑AIS船舶目标各时间的航迹信息及雷达目标信息,利用模糊控制理论构建雷达和AIS目标融合算法;文献[11]在获得一段时间的雷达目标和AIS目标的运动状态,分别利用坐标变换、时间配准、信号滤波方式构建综合融合算法,该算法为船舶避碰提供较为准确的融合目标状态。Yang等[12]利用系统噪声和观测噪声能量有界特点,针对目标船AIS中导航信息,提出融合过滤算法和顺序融合滤波算法,实现对AIS信号和雷达信号的异步融合。Zhong等[13]、Zhang等[14]、Heymann等[15]利用卡尔曼滤波器融合船舶GPS信息及其他相关导航数据,并引入动态实时拟合法解决准确性问题,提高了船舶导航的稳定性。

虽然众多学者开展了深入的船舶目标融合算法和平台开发工作,但目前在该领域存在如下问题:首先,对雷达目标、AIS目标和可见光图像识别目标的融合研究较少;其次,在融合算法研究后,并没有专门的船舶航行态势融合平台的使用和验证。为解决以上问题,本文将构建船舶目标识别样本集和目标识别算法,开展雷达目标、AIS目标以及目标识别目标的融合算法研究,开发可实船应用的融合算法可视化平台,通过实船验证本文算法和人机交互平台的准确性和有效性。

1. 船舶航行多信息融合算法

目前典型的船舶航行多信息融合方法主要基于属性特征的多信息信息融合方法,本文针对雷达、AIS以及摄像头图像信息开展多信息融合工作,与前人相比扩展了信息融合类型,在不需要复杂的预处理的前提下开展目标融合工作。

1.1 信息预处理

对船舶航行过程的AIS、雷达、视觉信息进行预处理,按照时间戳对应划分各类信息源的数据信息,其中在获取AIS解码后的目标船状态后,考虑到AIS信息发送频率较低,AIS目标位置间歇性变化会影响到目标融合准确性和可视化,本文采用对目标船状态线性插值方法,将AIS目标运动平滑化处理,假设下一帧AIS信息之前,船舶保持当前航速、航向前进,按步长进行插值,保证后续目标融合的准确性。

1.2 雷达目标同一性检测

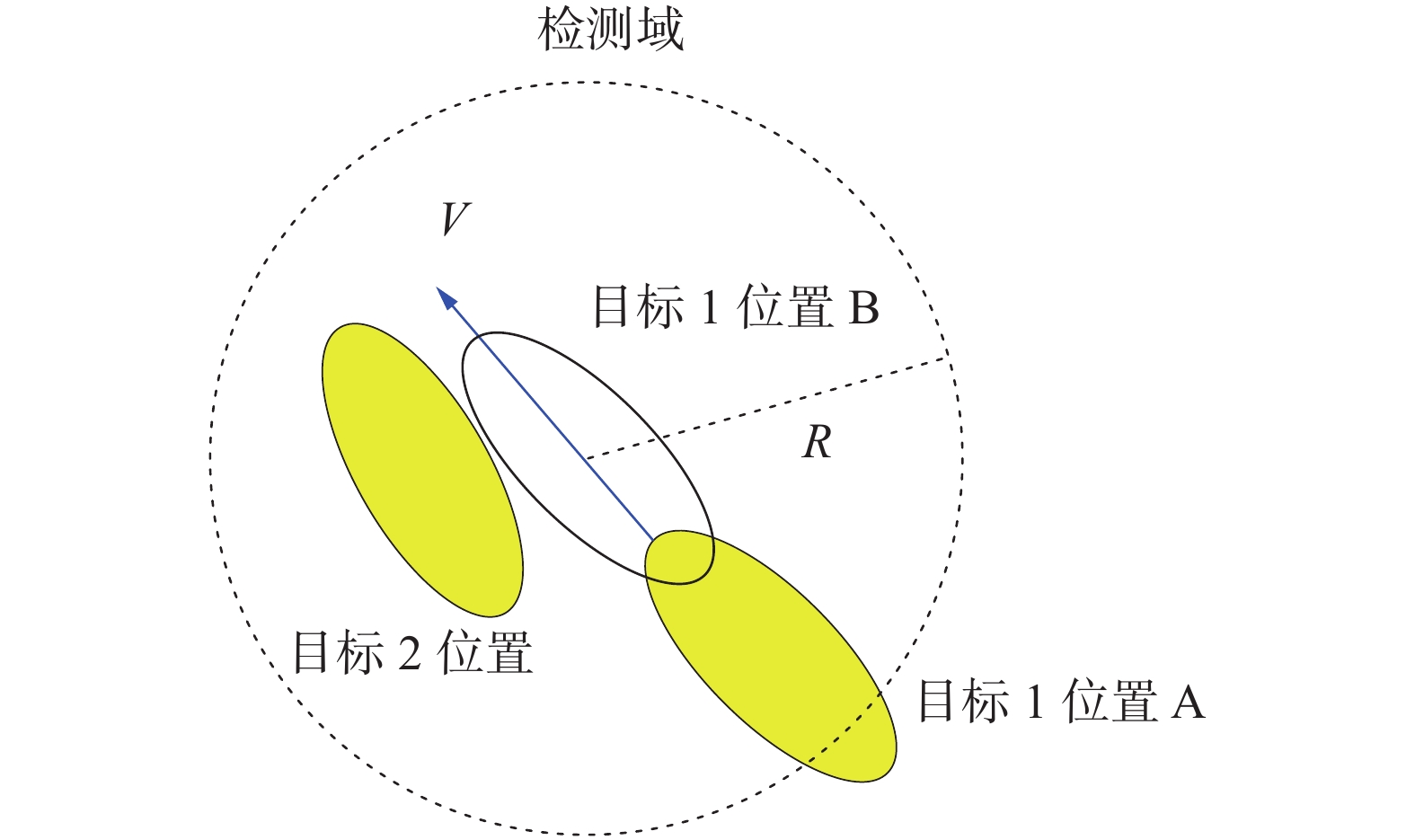

本文提出雷达目标同一性检测原理,如图1所示,根据当前时刻“目标1位置A”及当前目标的速度

$ V $ ,预测时长$ {t_d} $ 后的位置,即“目标1位置B”,并将以该位置为圆心,半径为R的区域为设定为检测域,如果在该检测域内、$ {t_d} $ 时刻后存在回波目标,如图1中所示“目标2位置”,则判定目标1与目标2来源于同一物体,即目标1经过$ {t_d} $ 时刻后运动到目标2位置。1.3 雷达信息与AIS信息融合

本文在解析雷达回波信息和AIS信息后,采用置信评价原理,判定2种信息源目标是否是同一目标。设置时间点

$ {t_0} $ 及时长$ {t_m} $ ,在$ {t_0} $ ~$ {t_0} + {t_m} $ 这段时间内,按照相同时间点等间隔均获取$ N $ 个雷达和AIS目标,在$ {t_0} $ ~$ {t_0} + {t_m} $ 时间内,按照式(1)~式(4)计算置信度。$$ \Delta p = \sum\limits_{k = 1}^N {\sqrt {{{({x_{rk}} - {x_{ak}})}^2} + {{({y_{rk}} - {y_{ak}})}^2}} } $$ (1) $$ \Delta V = \sum\limits_{k = 1}^N {({V_{rk}} - {V_{ak}})} $$ (2) $$ \Delta \theta = \sum\limits_{k = 1}^N {({\theta _{rk}} - {\theta _{ak}})} $$ (3) $$ J = {k_1}\Delta p + {k_2}\Delta V + {k_3}\Delta \theta $$ (4) 式中:

$ k_1 $ 、$ k_2 $ 和$ k_3 $ 为权重系数,$ ({x_{rk}},{y_{rk}}) $ 和$ ({x_{ak}},{y_{ak}}) $ 分别为雷达目标和AIS目标的位置,$ {V_{rk}} $ 和$ {V_{ak}} $ 分别为雷达目标和AIS目标的速度,$ {\theta _{rk}} $ 和$ {\theta _{ak}} $ 分别为雷达目标和AIS目标的航向。设定阈值$ {J_{{\text{set}}}} $ ,当$J < {J_{{\text{set}}}}$ 时,则表示在$ {t_0} $ ~$ {t_0} + {t_m} $ 这段时间内,该雷达和AIS目标指的是同一目标。1.4 雷达信息与视觉图像信息融合

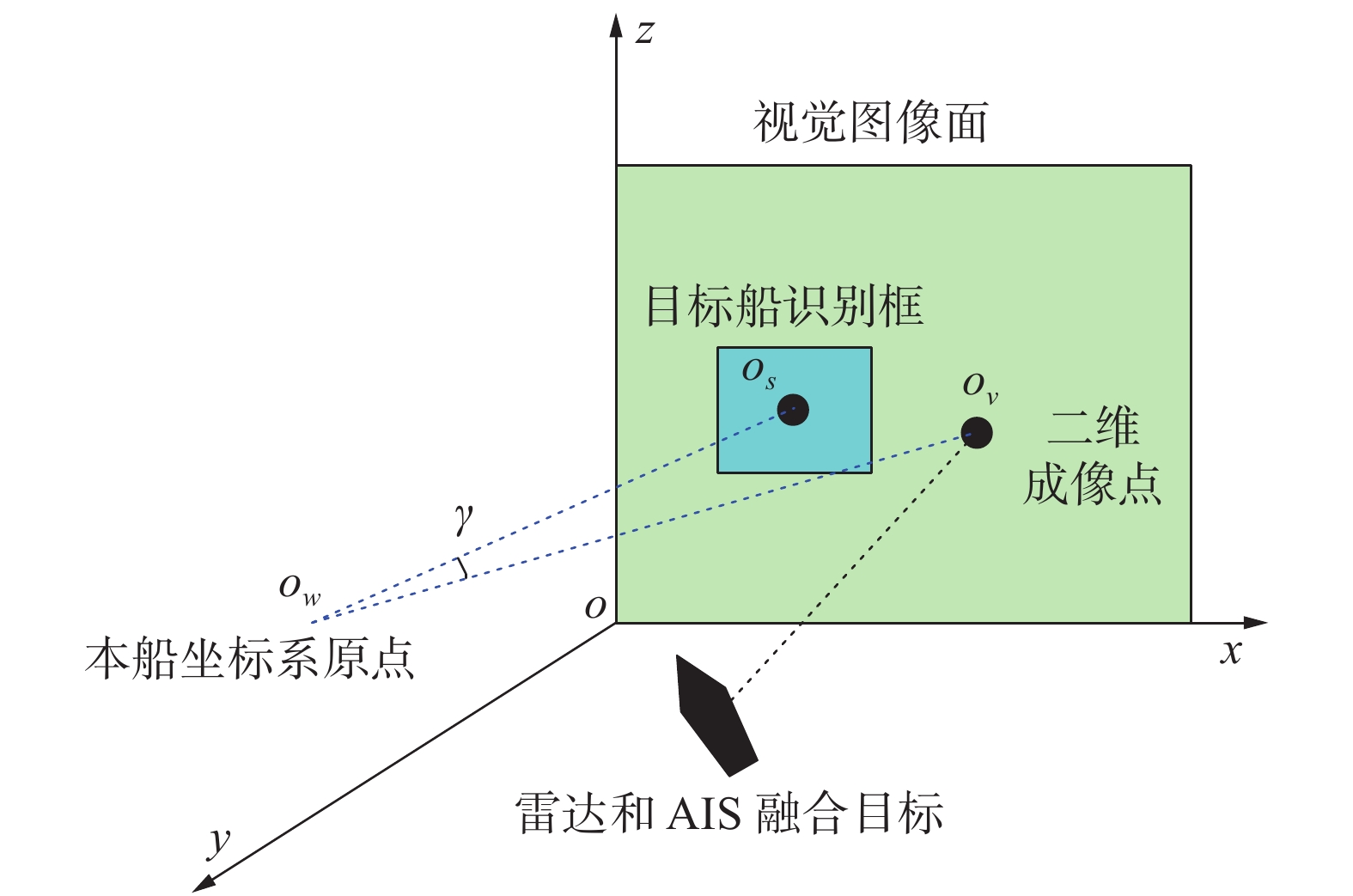

考虑到雷达和AIS目标是在三维空间内成像,本文采用三维坐标系映射为二维坐标方式对初步融合目标预处理。图2为雷达和AIS融合目标坐标变换示意。

如图2所示,空间直角坐标系

$ oxyz $ ,$ xy $ 平面为水平面,$ xz $ 面为垂直面,该平面为视觉图像所在平面,雷达和AIS融合后所示目标位于在水平面内,增加海平面信息后,成为三维坐标。将该目标空间位置$ ({x_c},{y_c},{z_c}) $ 向$ xz $ 平面做投影,形成图2所示二维成像点$ {o_v} $ ,坐标为$ ({x_v},{z_v}) $ 。为了能够识别可见光图像中的目标,本文采用YOLOv5s作为训练网络。由于本文仅使用该网络,并不对此改进创新,仅做简单介绍。YOLO算法将对象检测重新定义为一个回归问题。它将单个卷积神经网络(convolutional neural networks,CNN)应用于整个图像,将图像划分成为若干网格,并预测每个网格的类概率和边界框。然后,对于每个网格,网络都会预测一个边界框和与每个类别(船只、岛屿等)相对应的概率。每个边界框可以使用4个描述符进行描述:边界框的中心、高度、宽度、值映射到对象所属的类。最后对每个类的对象应用非最大抑制(non max suppression)的方法来过滤出置信度小于阈值的边界框,最终实现目标识别[16-17]。YOLO算法优点在于处理速度快,它能够处理实时视频流,延迟小于25 ms,能够满足信息融合算法中的目标识别需求,最终输出为图像中船只识别框的中心点、高度、宽度与船只种类。

在图像检测出目标船的基础上,获得目标船所在图像中位置,如图2所示目标船识别框,该框中心为

$ {o_s} $ ,坐标为$ ({x_s},{z_s}) $ 。将图像识别框中心$ {o_s} $ 和雷达AIS融合目标投影点$ {o_v} $ ,与本船坐标系原点$ {o_w} $ 连线,计算$ {o_w}{o_s} $ 与$ {o_w}{o_v} $ 直线夹角$ \gamma $ 。设定目标成像夹角阈值$ {\gamma _{\max }} $ ,当$ \gamma < {\gamma _{\max }} $ 时,表示雷达AIS融合目标与图像检测目标是同一目标,反之则不是同一目标。2. 海上目标多源数据集及识别网络

海上目标识别通常会使用计算机视觉、雷达、AIS等方法进行识别。为了船舶航行多源信息融合的研究,需要构建多源混合数据集。其中雷达、AIS的数据集的样本结构形式较为简单,易于获得。计算机视觉样本较为复杂,包含不同的航行环境、气象等条件、不同船舶类型。采用实船收集能获得的视觉样本有限,对不容易获取的海上目标样本,需要通过样本增广的方式进行样本扩充。对不同的航行环境、气象等条件下,融合雷达、AIS数据样本,设计不同的目标样本集,以此为基础构建多源混合数据集。

2.1 实船采集样本

实船采集部分通过12路360°全景可见光设备提供,将该设备安装在试验船桅杆高处,以15 s/次的频率持续拍摄周围海面,获得的图片12张为1组。同时保存下拍摄时的雷达、AIS数据。

2.2 增广样本

目标样本增广部分利用船舶航行仿真系统及三维视景系统,通过设置不同的船舶航行仿真场景,在三维场景中动态推演多船航行场景,并按照1 s/次的频率保存本船在三维场景观测目标船的视觉图像,并模拟雷达、AIS数据信号,利用CycleGAN网络将船舶仿真图像转换到航行图像[18-19]。

CycleGAN网络使用具有标签的数据集,该数据集实船采集工作基础上加以构建,网络判别器输入与它对应的掩码进行点乘处理,以此获取图片的前景信息。在网络的最后一层之前,将特征图与尺寸相同的掩码图开展点乘操作,实现将海面外其他位置设置为黑色,在最后一层卷积操作过程中,对输入图片开展拼接处理,引入原图其他部分数据,形成完整的航行图像。

这里令A和B分别表示选取的2张原始的船舶目标图像,

$ {G_{AB}} $ 、$ {D_A} $ 、$ {G_{BA}} $ 、$ {D_B} $ 分别表示由A船舶图像生成假B船舶图像的生成器、判别器,以及由B船舶图像生成假A船舶图像的生成器、判别器,另外$ a $ 、$ {a_f} $ 、$ b $ 、$ {b_f} $ 为设定参数常量,因此基于CycleGAN网络的船舶目标样本增广的总损失函数可表示为$$ \begin{split} & L\left( {{G_{AB}},{G_{BA}},{D_A},{D_B}} \right) ={L_{{\rm{GAN}}}}\left( {{G_{AB}},{D_B},A,B} \right)+\\ &\quad {L_{{\rm{GAN}}}}\left( {{G_{BA}},{D_A},B,A} \right) + \alpha {L_{{\rm{cyc}}}}\left( {{G_{AB}},{G_{BA}}} \right) \end{split}$$ 式中

${L_{{\rm{GAN}}}}( * )$ 和${L_{{\rm{cyc}}}}( * )$ 分别表示船舶目标图像循环对抗生成网络的判别损失函数和循环损失函数,具体如式(5)~式(7)所示。$$\begin{split} & {L_{{\text{GAN}}}}\left( {{G_{AB}},{D_B},A,B} \right) = E\left[ {\log {D_B}\left( {{b_f}} \right)} \right] + \\&\qquad E\left[ {\log \left( {1 - {D_B}\left( {{G_{AB}}{{\left( a \right)}_f}} \right)} \right)} \right] \end{split}$$ (5) $$ \begin{split} & {L_{{\text{GAN}}}}\left( {{G_{BA}},{D_A},B,A} \right) =E\left[ {\log {D_A}\left( {{a_f}} \right)} \right] + \\ &\qquad E\left[ {\log \left( {1 - {D_A}\left( {{G_{BA}}{{\left( b \right)}_f}} \right)} \right)} \right] \end{split}$$ (6) $$\begin{split} & {L_{{{{\rm{cyc}}}}}}\left( {{G_{AB}},{G_{BA}}} \right) = E\left[ {{{\left\| {{G_{BA}}\left( {{G_{AB}}{{\left( a \right)}_f}} \right) - {a_f}} \right\|}_1}} \right] + \\ &\qquad\qquad E\left[ {{{\left\| {{G_{AB}}\left( {{G_{BA}}{{\left( b \right)}_f}} \right) - {b_f}} \right\|}_1}} \right] \end{split}$$ (7) 将实船采集样本与增广样本汇总,利用Labelimg软件,采用人工方式标注图像样本,就能得到1个带目标识别标注的海上目标的视觉数据集。

结合保存的雷达、AIS样本数据,为视觉样本集中的标注目标添加该目标的当前时刻的雷达、AIS信息,将视觉视觉集扩展为海上目标识别多源混合数据集,数据集中的每张图像上的目标都拥有相应的雷达、AIS信息。在信息融合环节,模拟真实航行情况对每张图像进行处理时,能从数据集中获得当前画面中待识别船只的雷达、AIS信息。

3. 船舶航行态势融合平台开发

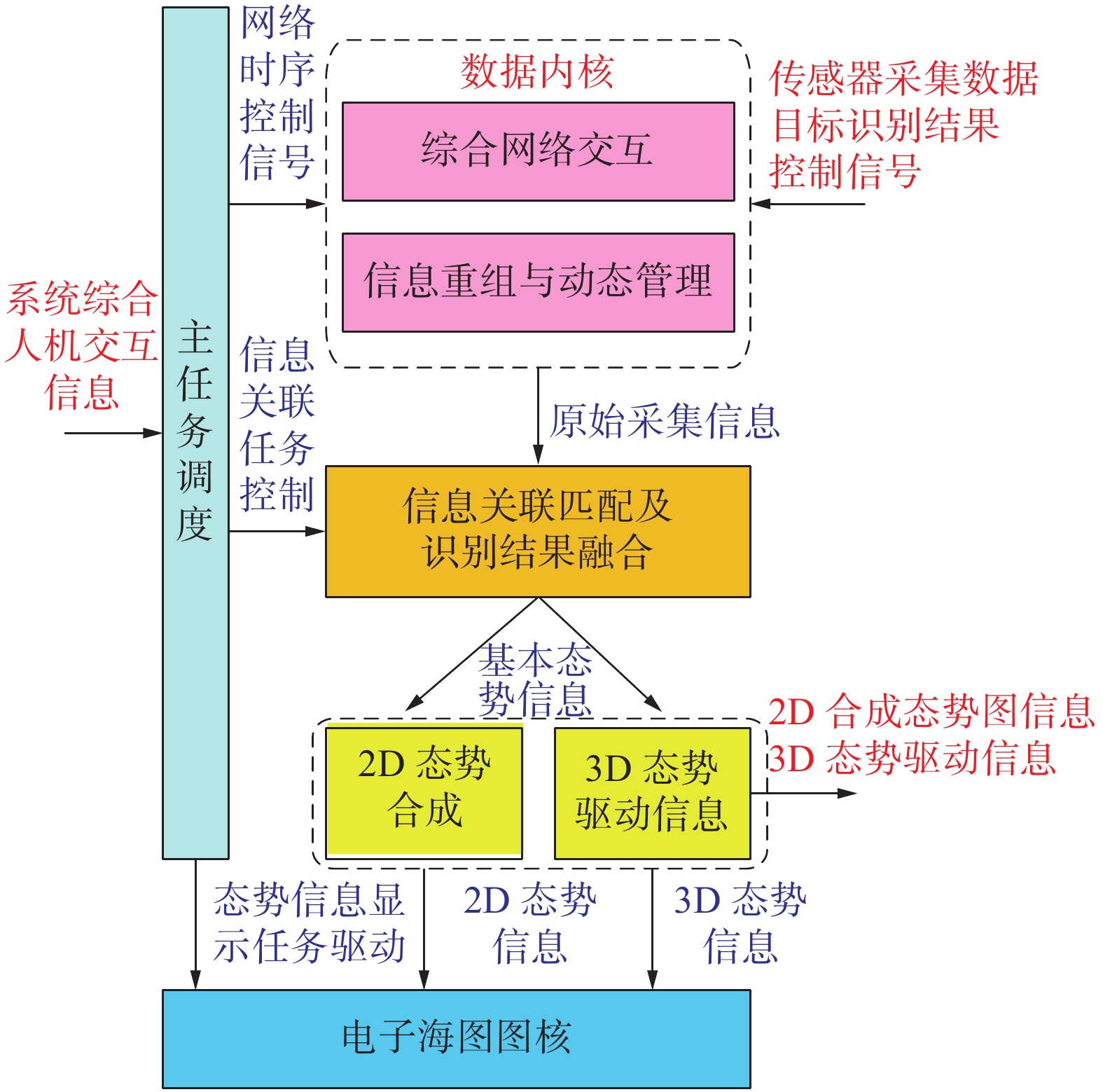

本文设计船舶航行态势融合平台,包括综合网络交互、信息重组与动态管理、主任务调度、信息关联匹配及识别结果融合、2D态势图合成、3D态势信息驱动和电子海图图核等模块,其中综合网络交互、信息重组与动态管理模块实现感知系统主要采集信息的网络抓取、信息变换及重组、动态访问管理等功能,称其为感知系统软件的数据内核,该子系统中各模块的信息流如图3所示。

主任务调度模块根据系统综合人机交互信息,确定系统当前主要工作任务,确定系统网络时序控制信号、信息关联任务控制信号以及船舶航行态势信息显示任务驱动信号。综合网络交互、信息重组与动态管理模块实现感知系统主要采集信息的网络抓取、信息变换及重组、动态访问管理等功能,数据内容接收网络时序控制信号,确定数据接收策略,从设备传感器、图像采集处理子系统等获取系统相关数据。

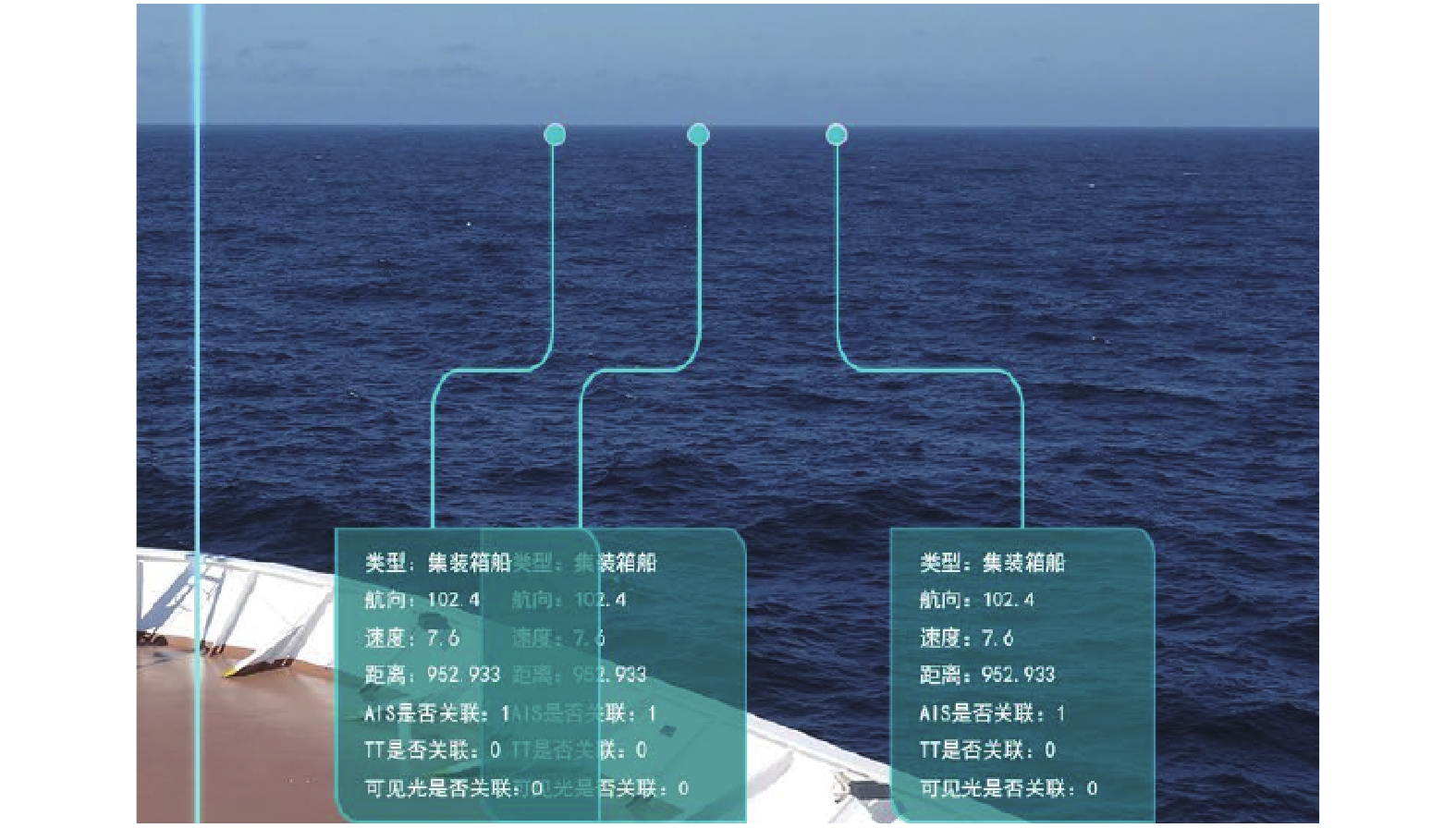

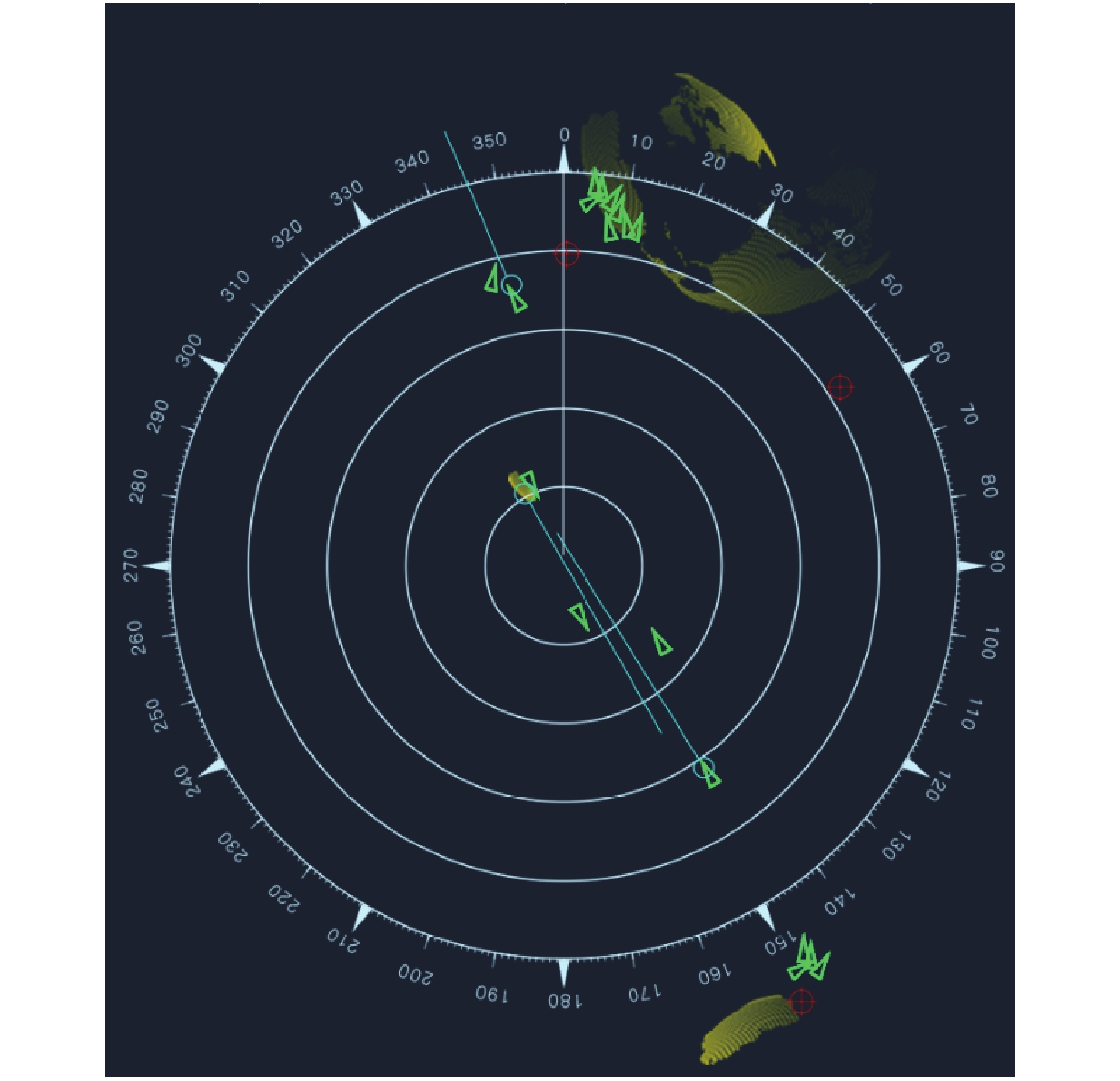

基于目标信息融合处理、多源信息综合检测、识别和跟踪结果信息,以多种手段实现环境认知结果展示。根据软件信息源与功能模式,软件界面分为增强现实(augmented reality,AR)和2D模式。AR模式是在航行视觉监视信息的基础上,动态叠加多源融合识别后的目标信息,包括目标分类、目标运动参数和运动趋势等信息,实现AR模式的航行环境呈现,具体实现效果如图4所示。

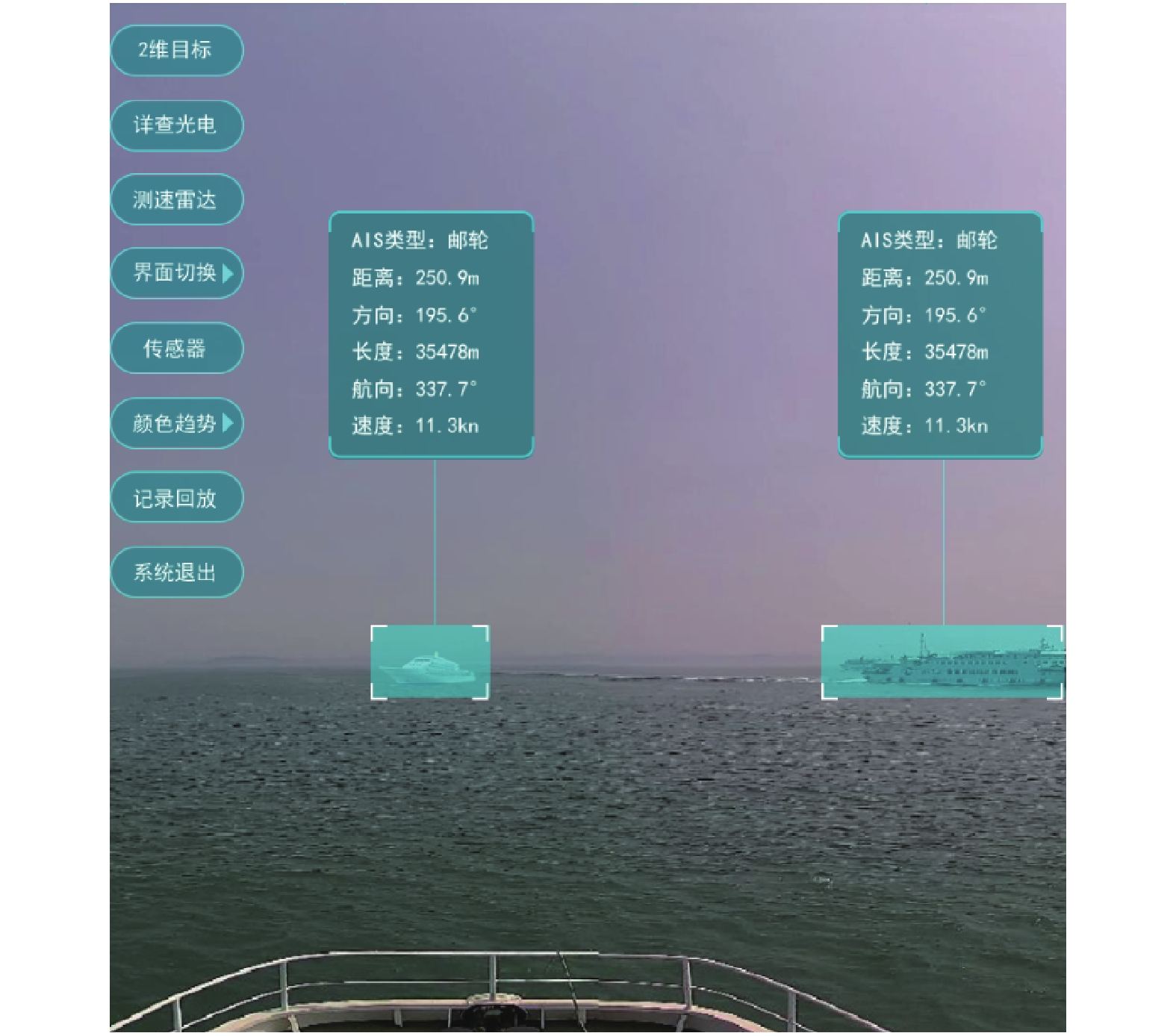

2D模式将航行环境的雷达图、全景视觉图像和局部视角的细节图像结合,实现目标属性信息自动关联、自动叠加和联动操作等,具体实现效果如图5所示。

4. 基于实船的算法及平台验证试验

为验证本文船舶航行多源信息融合算法及平台功能,本节利用作者所在团队自主设计的“海豚1”号为实船载体,开展实船验证试验,实船如图6所示。本次实船试验通过驾驶“海豚1”试验船在烟台海域长山国际航道和蓬莱港采集过往船只信息。开展雷达、AIS和图像信息融合能力试验以及目标识别能力试验,2D及AR界面如图7所示。从图7中可以看出,本文雷达TT捕获目标与AIS解析目标重合,并通过位置和方向解算,与图像中目标船坐标一致,且软件平台可对AR模式图像中目标船有效识别,同时可叠加雷达和AIS的状态信息。综上所示,本文通过实船实验完成了船舶航行多源信息的融合算法验证,并测试开发平台功能的有效性。

5. 结论

本文针对船舶航行任务,提出一种融合雷达、AIS和可见光图像信息的多源目标融合算法和软件平台,设计多源目标融合原理,并开发符合实船应用标准的可视化人机交互软件平台,结论如下:

1)多目标融合算法可实现雷达回波目标、AIS解析目标、可见光识别目标的准确融合;

2)融合软件平台在实船航行过程中可提供较为精准的可视化信息,符合实船使用标准。

后续将针对红外相机等其他传感器开展其他多源信息融合算法研究。

-

[1] 沈庭钧. 基于多平台信息融合的船舶导航技术[J]. 造船技术, 2022, 50(3): 53−57. doi: 10.12225/j.issn.1000-3878.2022.03.20220310 [2] 侯旺. 基于多源数据融合的船舶异常行为检测技术研究[D]. 成都: 电子科技大学. 2022. [3] 张阳, 高曙, 何伟, 等. 基于多模型融合的内河船舶航行轨迹预测方法[J]. 中国机械工程, 2022, 33(10): 1142−1152. doi: 10.3969/j.issn.1004-132X.2022.10.002 [4] 邱佳佳. 信息融合下船舶导航界面交互性设计[J]. 舰船科学技术, 2021, 43(20): 136−138. doi: 10.3404/j.issn.1672-7649.2021.10A.046 [5] 赵建, 张炜, 乔旭, 等. 基于多信息融合下智慧船闸系统的开发应用[J]. 中国水运, 2021, 21(4): 32−33,61. [6] 马瑞鑫, 李子龙, 陈静. 基于多源异构数据融合的船舶目标检测与跟踪技术研究[J]. 水道港口, 2021, 42(3): 392−398. doi: 10.3969/j.issn.1005-8443.2021.03.017 [7] 王维刚. 基于图像识别的船舶智能航行环境融合感知算法研究[D]. 武汉: 武汉理工大学, 2020. [8] 杨淑洁, 孙伟, 卢威, 等. 舰船雷达与AIS信息融合技术[J]. 舰船科学技术., 2021, 43(3): 167−171. [9] 丁凯, 周浚璠. 船舶雷达与目标自动识别技术的信息融合[J]. 电子世界, 2021(20): 58−59. doi: 10.19353/j.cnki.dzsj.2021.20.028 [10] 邢旭峰, 谢仕义, 黄妙芬, 等. 基于近海雷达与AIS探测目标融合算法研究[J]. 海洋技术学报, 2020, 39(3): 8−15. [11] 赵仓龙. AIS与雷达信号数据融合在船舶避碰系统中的应用[J]. 舰船科学技术, 2022, 44(12): 169−172. doi: 10.3404/j.issn.1672-7649.2022.12.035 [12] YANG Yanping, LI Ruiguang. Relatively-integrated ship navigation by H¥ fusion filters[J]. International journal of cognitive informatics and natural intelligence, 2022, 15(4): 1−12. [13] ZHONG Lin, JIANG Lifeng. Application research in integrated navigation system of measurement ship based on multiple data fusion technology[C]//16th International Conference on Optical Communications and Networks. Wuzhen: Institute of Electrical and Electronics Engineers Inc, 2017: 1-5. [14] ZHANG Hui, LIU Yongxin, JI Yonggang, et al. Vessel fusion tracking with a dual-frequency high-frequency surface wave radar and calibrated by an automatic identification system[J]. Acta oceanologica sinica, 2018, 7(7): 131−140. [15] HEYMANN F, BANYS P, SAEZ C. Radar image processing and AIS target fusion[J]. TransNav: international journal on marine navigation and safety of sea transportation, 2015, 9(3): 443−448. doi: 10.12716/1001.09.03.18 [16] 包晓敏, 王思琪. 基于深度学习的目标检测算法综述[J]. 传感器与微系统, 2022, 41(4): 5−9. doi: 10.13873/J.1000-9787(2022)04-0005-05 [17] 吕璐, 程虎, 朱鸿泰, 等. 基于深度学习的目标检测研究与应用综述[J]. 电子与封装, 2022, 22(1): 72−80. doi: 10.16257/j.cnki.1681-1070.2022.0114 [18] 田敏, 刘名果, 陈立家, 等. 面向样本扩充的新型风格迁移网络研究[J/OL]. (2021-10-27)[2022-10-17]. http://kns.cnki.net/kcms/detail/11.2127.TP.20211026.1445.006.html. [19] 李宝奇, 黄海宁, 刘纪元, 等. 基于改进CycleGAN的光学图像迁移生成水下小目标合成孔径声纳图像算法研究[J]. 电子学报, 2021, 49(9): 1746−1753. doi: 10.12263/DZXB.20200712

下载:

下载: