文章信息

- 赵小刚, 陈刚, 熊曾刚

- ZHAO Xiaogang, CHEN Gang, XIONG Zenggang

- 温度感知的高能效数据中心负载聚合算法

- A Thermal-Aware Energy-Efficient Workload Consolidation Method in Data Centers

- 武汉大学学报(理学版), 2017, 63(3): 265-273

- Journal of Wuhan University(Natural Science Edition), 2017, 63(3): 265-273

- http://dx.doi.org/10.14188/j.1671-8836.2017.03.012

-

文章历史

- 收稿日期:2016-03-16

2. 湖北工程学院 计算机与信息科学学院,湖北 孝感 432000

2. School of Computer and Information Science, Hubei Engineering University, Xiaogan 432000, Hubei, China

随着信息社会的迅速发展,网上购物、在线搜索和云计算服务等使得数据中心日益成为计算密集和存储密集的中心环节.海量的计算和存储需求使得数据中心必须增大硬件规模来获得快速的响应.而硬件规模的增长带来的不仅仅是购买成本的迅速增加,还有硬件能耗的增大,给数据中心带来巨大的运行成本.Thiboderau[1]估计,到2020年美国国内所有数据中心的能耗将达到1 390亿kW·h,花费137亿美金.巨大的能耗成本使得数据中心的运行维护成本已经远远超过了数据中心的建设成本[2, 3].

减小数据中心功耗是学术界和工业界的共识[4~7].数据中心功耗的一部分为硬件运行时需要的功耗,称为计算功耗.Intel等芯片公司主要从芯片级进行节能,如采用低电压集成电路,动态电压频率调整技术(dynamic voltage and frequency scaling,DVFS)[8]等.HP、IBM等服务器公司则主要从机架级进行节能,如刀片服务器集合层功耗管理[9];硬件功耗监控和功耗优化的一体化方案[10, 11].一些研究侧重于从数据中心负载的特性来减少功耗:如按照系统功率需求动态提供功耗的虚拟功耗技术,该技术基于可存储电能的电池设备[12];尽量减少CPU空闲时间的后填充任务发射技术[13];当CPU,硬盘或网络等空闲时将其转入休眠态节能[14, 15].这些技术都取得了不错效果,但都局限于部件级的节能,缺乏对温度升高引起的冷却功耗的关注.特别是采用节点休眠策略,虽然降低了计算功耗,但负载聚合在剩余的活动节点上,会造成计算和温度“热点”,带来局部计算瓶颈和局部温度的升高.

数据中心功耗的另一部分为冷却功耗.数据中心的持续健康运行需要较低的环境温度,由于制冷设备工作而产生的热循环现象是目前数据中心能耗效率低下的主因.研究表明比较理想的制冷功耗和硬件功耗为1:1,2011年对500个大型数据中心的调查发现[16],绝大多数的数据中心制冷功耗和硬件功耗比为1.8:1,由此可见数据中心的制冷成本非常高[17].冷却功耗的模拟计算涉及到比较复杂的热力学过程,而物理获取数据中心内各节点温度又需要大量温度传感器,因此很多研究关注如何对数据中心节点温度进行建模.文献[18]通过建模分析数据中心节点温度分布状态,估计其采用不同的作业调度算法后节点未来的温度变化,最终选择合适的调度方法,是一种离线作业调度策略;文献[19]通过时间序列方法估计未来5 min内数据中心节点温度变化情况,但缺乏实际的温度调节方案;文献[20]则从仿真角度出发,以流体热力学理论建模数据中心温度分布,温度预测准确度很高.这些方法都没有考虑由于紧急情况引起的温度异常的处理.

数据中心作业调度算法对数据中心冷却功耗影响较大.不同的调度算法会使数据中心节点的峰值温度不同,从而使得冷却设备的供应温度有差异.而数据中心的冷却功耗与冷却设备的供应温度成反比[21~24].目前大多数调度算法都是通过降低节点的峰值温度来减小对空调的制冷功耗要求.文献[22]采用控制算法来协调集群内主机功耗和主机上虚拟机的响应时间,但没有考虑温度的变化;算法MinHR[23]根据每个节点的HRF(heat recirculation fraction,热传递系数)来分配任务以降低峰值输入温度,对降低冷却功耗有一定效果;算法Xint[24]采用了基因算法离线进行计算作业调度,能够求得较优的冷却功耗,缺点是计算时间过长,不能用于在线作业调度.这些算法只考虑了降低功耗,降低系统峰值温度,但都没有考虑负载聚合对系统的性能和功耗的影响.

本文研究由于节点关闭后负载聚合在活动节点上带来的温度和性能的瓶颈问题,通过系统热传递矩阵建立数据中心功耗温度模型,特别针对数据中心内温度发生异常的情况,考虑如何采用负载聚合这种方法来降低系统温度,根据实测结果说明了聚合的必要条件,并通过定量分析法说明了三种在线算法对系统温度,性能和功耗的影响.

1 数据中心功耗模型数据中心中普遍采用刀片服务器,用机架方式将刀片服务器进行固定,通过空调来进行制冷.从图 1可以看出,同一机架中,空调供应的冷空气从底部向上部流动,从机架顶部散发的热空气被循环到空调处.因此,机架上部的服务器温度较高.而冷空气从刀片服务器的进风口流入,带走服务器内部工作部件(CPU、内存、硬盘、主板和网络设备等)的热量,从出风口流出.

|

| 图 1 数据中心空气流动示意图 Figure 1 Air flow in data center |

因此,研究数据中心功耗模型的主要工作是要计算机架中节点的功耗和带走节点产生热量的制冷设备功耗.

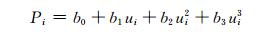

1.1 服务器功耗模型服务器节点工作部件的功耗通常与CPU利用率有关:CPU利用率越高,如内存、网卡和风扇等在功耗中占比较大部件的利用率也越高.早期部分研究认为服务器节点功耗与CPU利用率成一元线性相关[22~27],但有研究发现节点功耗应该与CPU利用率成指数关系[28, 29].因此,本文采用三阶模型,如(1) 所示.对三阶模型来说,负载对功耗的影响比一阶模型要小.

|

(1) |

bi为与i节点的硬件相关的常量,不同硬件设备大小不同.b0为节点空闲时的能量消耗,ui为i节点CPU利用率,Pi为i节点总功耗.而节点CPU利用率通常又与节点上的虚拟机个数成正比:

|

(2) |

mi为i节点上的虚拟机数量,而ci为单个虚拟机分配到的CPU资源.

1.2 功耗温度模型数据中心内服务器之间会存在热循环.研究表明,一台服务器的热量输出会对它周围所有服务器的输入温度产生影响.研究人员提出了很多方法来对数据中心内的热循环进行建模.这些模型的有效性已经被真实数据中心内传感器测得的温度数据验证过了[19, 20, 24].机器的输入温度与制冷设备供应温度,集群功耗向量以及数据中心内设备之间的热循环有关:

|

(3) |

tin为数据中心内所有节点温度向量,tsup为所有节点供应温度向量.其中D为热循环系数矩阵,利用D可以将功率消耗转化为温度,P为所有节点功率向量.

对于数据中心来说,通常需要保持较低的输入温度,否则机器内部的器件如CPU,硬盘,内存等会由于温度过高而降低寿命.即节点的输入温度不能超过某一阈值tred.

1.3 冷却功耗模型数据中心内必须配置冷却系统(computer room air-conditioning, CRAC).正是由于数据中心内节点运行产生的副产品——热量以及热量在数据中心内的循环,会使得数据中心内温度升高,而数据中心内的节点部件必须工作在较低温度.因此必须要用冷却系统将这些热量带出去,使得所有节点工作在温度阈值tred以下.冷却系统的设定供应温度Tsup会影响数据中心的功耗效率.而冷却系统效率是由CoP(coefficient of performance,性能系数)[23]来衡量的:

|

(4) |

(4) 式中Pc为数据中心的计算功耗,为所有节点所消耗的功耗之和,等于sum(P).PAC为CRAC功耗.当供应温度升高时,CoP的值也会增大.从(4) 式看出CoP越大,PAC会越小.因此减小制冷功耗的直接方法就是增大Tsup.

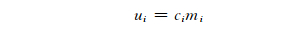

增大供应温度会带来输入温度的增加,而数据中心内所有机器要正常工作,输入温度tin不能超过阈值tred.所以节能的方法是尽可能调高提供温度,直到输入温度几乎到达阈值,这样制冷功耗最小.也就是说节能模式下新的供应温度T′sup满足

|

(5) |

从公式(5) 可以看出,如果可以合理进行作业调度,使得所有机器的输入温度tin的最大值达到最小化,那么就可以得到最大的供应温度,获得最小的冷却功耗.

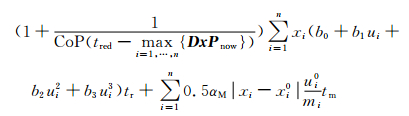

1.4 系统功耗模型根据1.3可知,系统所消耗的总功耗等于计算功耗加上冷却功耗:

|

(6) |

将(1)、(3) 和(4) 式带入(6) 式,得到

|

(7) |

一部分研究人员研究在计算功率一定的条件下进行任务调度来最小化系统峰值输入温度(公式5),从而达到最小化系统功耗的目的(公式7)[21~24].这种调度的依据是不同节点的热循环系数(Dij)不一致,调节P向量的分配,可以达到最小化Psum的作用.但D矩阵描述的节点间热传递的差异是有限的,任务调度获得的温度降低十分有限.

也有不少研究者发现节点的功耗模型中,b0的占比很大[25~27].节点空闲时消耗的功率几乎是总功率的50%左右,这表明计算功耗的非线性部分是造成整个数据中心能效低下的主因.而统计表明,数据中心在大部分的时间里总体利用率在20%~30%.因此在数据中心效率低下时,采用负载聚合方式,将多个负载较轻节点上的负载转移到一定数量的节点上,而将剩余节点转入休眠态.这样的好处是计算功耗得到了较大降低,功耗中的非线性占比下降.同时由于关闭的是轻载节点,节点的迁移开销也较小.

负载的集中也会带来一系列的问题:首先,负载的集中会造成局部的温度热点(公式(3)),整个系统的峰值输入温度升高,进而造成系统的冷却功耗增大,一定情况下冷却功耗的增大甚至超过计算功耗的降低;其次,节点内部件如CPU,硬盘等的寿命也会由于高温受到影响;最后,负载的集中会造成某些节点上负载过高,系统性能下降.因此,在进行负载聚合时必须充分考虑温度和性能的制约.

负载聚合包含两方面的问题:选择哪些节点关闭以及这些节点上的负载如何迁移.与以前的负载聚合研究关注计算功耗的降低[25~27]不同的是,我们的研究重点在于避免负载聚合造成的局部温度热点和性能的下降.因此本文进行聚合时不是直接选择关闭轻载节点,而是根据一定规则来选择活跃节点进行关闭和负载迁移.这里的规则是指在使数据中心峰值温度下降最大的同时,对系统整体性能影响最小.

本文中的负载聚合应用场景除了应用于数据中心负载低下的情况,还可应用于数据中心发生温度异常时的处理,如由于空调故障造成整个系统温度升高等.这里将节点的温度异常称为扰动.由于扰动会使得峰值温度超过最大温度阈值,需要通过一定方法使得峰值温度再次回到温度阈值以下.此时有两种方法可以采用:

1) 降低空调供应温度;

2) 通过负载聚合方式达到温度降低.

第一种方法可以有效保持温度阈值,但会带来冷却功耗的增大,因此不推荐使用;

第二种方法通过高能效负载聚合方式,既降低了计算功耗,又降低了冷却功耗,是我们推荐使用的.采用高能效负载聚合方法要尽量减少对系统性能的影响,这里的性能我们简化为系统响应时间,而系统响应时间在很多研究中显示其通常与节点的CPU利用率有关[26],因此可以定义在负载聚合时,节点的CPU利用率不要超过某一阈值,这样系统的性能可以得到一定保障.

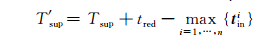

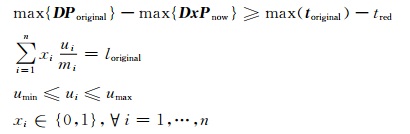

2.1 负载聚合算法目标为了在负载聚合后,系统的性能达到QoS要求,而能耗达到最小化,必须满足:

Minimize

|

(1) |

Subject to

|

(8) |

(8) 式表示的系统采用负载聚合后的能耗,其中包含两项内容:第一项为系统计算功耗和冷却能耗,第二项为关闭节点负载迁移的能耗,其中tr为系统运行时间,tm为负载迁移时间.其中向量x代表节点是活动还是休眠,1表示活跃,0表示休眠或关闭.toriginal为扰动发生时数据中心节点温度向量,loriginal为扰动发生时系统的负载,Poriginal为扰动发生时数据中心节点功耗向量,Pnow为采用休眠措施时节点功耗向量.除了变量xi和ui外,其余均为常量,xi0,ui0为扰动发生时节点状态和节点利用率, αM为每个虚拟机迁移的开销.最小化(8) 式时必须要满足如下限制:1) 负载聚合后的温度下降量要超过目前由于扰动引起的温度上升量;2) 负载聚合前后系统负载必须相等;3) 系统的服务质量不下降且能效比较高.

(8) 式表达的是一个非线性约束下求解最大值的优化问题,可以采用顺序二次规划(sequential quadratic programming, SQP)方法或遗传算法求最优解.但它们是在离线情况下采用的优化方法,且由于解空间较大,采用这些算法需要花费较长时间.

2.2 三种在线负载聚合算法由于离线遗传算法求全局最优解的时间过长,因此不适合在线的温度控制,这里我们采用启发式算法构造了三种节点选择策略和负载迁移策略,这三种算法综合考虑了(8) 式中的热传递和负载大小,依次为热传递最小聚合算法,迁移代价最小聚合算法和综合考虑热传递和迁移代价的混合热传递负载聚合算法.

节点的热效率反映的是节点和其相邻节点的热量传递的大小.数据中心热向量矩阵可以用R=(R1,R2,…, Ri, …, Rn)来表示[26],其中Ri为节点i产生的热量对所有节点的影响,vj为代表热循环重要性的权值,dij代表热循环矩阵D中的元素.

|

(9) |

Ri值反映了i节点功耗对所有节点温度影响的大小,节点的Ri值越小,说明其热效率越低.

热传递最小聚合(heat recirculation least consolidation, HRLC):该算法的目标是使剩余节点中的热量传递最小,也就是输入峰值温度最小.首先该算法按照节点热效率Ri对节点进行排序,当集群内有节点的最大输入温度超过温度阈值tred时,则从可用节点中选出具有最大Ri的节点,将其转入休眠态;关闭具有最大Ri的节点,可使集群峰值温度下降幅度最大.关闭该节点后,其负载转移到活动节点中具有最小Ri的可用节点上.

迁移代价最小聚合(migration cost least consolidation,MCLC):该算法使得负载聚合时迁移的代价最小.该算法按照节点的当前负载(ui)进行排序,当输入峰值温度超过温度阈值时,该算法选择具有最小负载的节点转入休眠态,而将该节点上的负载转移到剩余节点中具有最大负载的可用节点上.

混合热传递负载聚合(combined heat recirculation and workload consolidation,CHRWC):该算法综合考虑了负载和热传递,最小化热传递的同时最小化迁移代价.因此其定义了热传递负载参数:

|

(10) |

根据Ri/ui参数对节点进行排序,当输入峰值温度超过温度阈值时,该算法会选择具有最大Ri/ui的节点转入休眠态,同时将该节点上的负载转移到剩余节点中具有最小Ri/ui的可用节点上.

这三种算法计算速度很快,可以适用于在线任务调度情况.其中迁移代价最小聚合算法为传统负载聚合方法,用来对比说明本文设计的两种考虑了热传递的负载算法.

3 实验评估 3.1 实验环境 3.1.1 OpenFoam CFD仿真过程热循环矩阵D是通过采用一个开源的CFD仿真软件OpenFoam来模拟数据中心内节点的热量交互过程获取的,其获取过程与文献[30]相似.在功能强大的热力学仿真软件OpenFoam中,可以首先在数据中心网格配置文件中定义机房内节点,制冷设备的空间结构;接着定义机房内空气流速、空气密度等关键参数;最后需要定义热力学仿真中最重要的特征方程,包括:连续性方程、动量方程、能量方程、k方程等.其相关参数和特征方程的选取见文献[31],经过CFD模拟仿真后的温度最后与温度计实测的温度进行对比验证.

3.1.2 数据中心布局图 2描述了OpenFoam模拟的数据中心的物理架构.我们仿真了50个节点的数据中心,这50个节点被分布成两行多个42U工业标准机架.数据中心的空间大小为7.6 m×7.6 m×7.6 m.冷空气是通过一个空调来供应的,空气流速为8.5 m3/s.空调处于天花板上,离X轴大约2.79 m.中心共有10个机架,每个机架包含5个7U大小的节点.第一行离X轴大约2.5 m,而第二行距X轴为4.2 m.

|

| 图 2 数据中心物理架构 Figure 2 Layout of data center |

该物理架构来源于武汉大学国际软件学院云计算实验中心,在该平台上部署了学院的云实验系统,教师的软件实验课程均在云计算中心中的虚拟机上完成,目前已运行2年.其中有HP刀片服务器50台,服务器配置为:HP ProLiant DL380 G7(Xeon E5620 2.4GH, 6GB DDR3, 193GB Disk).我们在该平台上收集了一个月的节点负载记录,用来作为数据中心仿真模型的输入.此外我们通过功率计和温度计等收集了节点运行功耗和温度,对由CFD仿真工具仿真的节点热循环矩阵D进行了验证,误差率在3%以内.

数据中心仿真模型是在Matlab 2010b中建立的,其中节点的空闲功耗为120 W,机架电源设备和风扇的空载功耗为820 W.温度阈值为25 ℃,umin为0.1,umax为0.9.

3.1.3 负载迁移功耗测算负载迁移功耗是指负载从一个节点转移到另一个节点的过程中发生的额外功耗开销.目前数据中心基本都部署在云平台上,因此本文中的负载迁移就是虚拟机的迁移.虚拟机迁移涉及到虚拟机的内存状态和CPU寄存器内容的迁移等.虚拟机迁移过程中的迁移功耗可以定义为发生迁移时的源虚拟机和目标虚拟机的功耗与没有发生迁移之前的功耗之差.迁移功耗与较多因素相关[32],包括虚拟机内存大小,虚拟机个数,交换机带宽等.

一般来说,虚拟机迁移的时间会随着交换机的带宽的升高而呈指数级下降[32],而虚拟机功耗则随带宽增高线性增加,因此带宽的提高可以有效降低迁移的总体能耗.在带宽一定的条件下,虚拟机数量和虚拟机内存的增加会增大虚拟机功耗.

在该学院云计算实验中心中随机选取两台服务器作为虚拟机迁移测试的源主机和目标主机,两节点间的传输带宽为1Gb/s,服务器系统安装Fedora 20;在两台机器上均安装dstat程序来监控物理节点、虚拟主机CPU和内存等的利用率;默认选择KVM为虚拟机管理程序.采用AWE1611A功率分析仪测量主机功耗.实验中尝试将一个虚拟机从源节点迁移到目标节点,并将虚拟机的内存依次设置为1 GB,2 GB和4 GB,经过多次迁移测量后取均值得到其迁移开销为10 W,20W和40 W.

3.2 休眠策略假设目前数据中心空调的供应温度为12 ℃,当系统负载在50%时,采用随机负载分配方式,系统的输入峰值温度为24.5 ℃,系统正常工作.在以上条件下,如果由于人为因素或设备故障等原因,冷却设备的供应温度上升了2 ℃后,输入峰值温度达到26.5 ℃,超过25 ℃的温度阈值.此时通过负载聚合的方法来休眠一些节点来进行温度控制.下面分别在不同休眠策略下对三种不同的负载聚合方式进行考察.

3.2.1 休眠相同节点数目设休眠节点数为22.我们分别比较这三种在线负载聚合算法选择哪些节点来转入休眠状态,以及采取这些措施对系统功耗和性能的影响.选择休眠22个节点是为了突出迁移开销的比重,因为休眠节点越多,迁移开销也越大.

图 3展示了三种在线聚合算法在不同的迁移开销下休眠了22个节点后的总功耗.休眠22个节点后,三种算法的峰值输入温度都降低到了阈值以下.如图 3中所示,当虚拟机迁移开销为10 W时,热传递最小聚合(HRLC)算法总功耗最低:因为它考虑了热传递,峰值输入温度最小(图 4),冷却功耗最小;此时由于迁移开销较小,迁移功耗较低,因此其功耗最优.当开销增大到20 W和40 W,从图 3中可以看到此时混合热传递负载聚合(CHRWC)算法最优:因为该算法综合考虑了热传递和负载迁移的开销,而此时迁移开销已经较大,其与冷却功耗已经相当,因此综合考虑这两者关系的CHRWC算法获得最小功耗.迁移代价最小(MCLC)算法功耗最大,因为它完全没有考虑到热传递,总功耗最大.通常来说虚拟机的内存多为2 GB,所以后面的实验中采用的迁移开销均为20 W.

|

| 图 4 休眠节点数量相同时的最大输入温度比较 Figure 4 Peak mlet temperature comparison under same number of sleeping nodes |

|

| 图 3 不同迁移开销下的功耗比较(休眠节点为22) Figure 3 Power comparison under different migration cost (sleeping nodes is 22) |

图 4展示的是休眠不同数量的节点后,三种不同的聚合算法的峰值输入温度的比较.从图中可以看到,HRLC算法的峰值输入温度最小,而完全没有考虑热传递的MCLC峰值输入温度最大.当分别休眠5个和10个节点后,HRLC和CHRWC的峰值输入温度已经降低到阈值以下,而MCLC算法的峰值输入温度依然高于阈值,也就是该算法休眠10个节点依然不能保障系统正常工作.只有当休眠15个节点后,MCLC算法的温度才能低于25 ℃.

图 5为在半小时内采用不同休眠策略下系统能耗的比较,期间发生了两次负载聚合且每次聚合时间为30 s.从该图看出在迁移开销为20 W时,在休眠不同数量的节点条件下,HRLC算法具有最小能耗.因为CHRWC算法同时考虑负载和热传递,因此它也可以获得较小的能耗.MCLC算法由于只考虑了迁移开销的最小化,没有考虑冷却功耗,因此能耗最大.但无论哪种休眠策略,休眠节点后系统总体能耗是可以得到降低的.

|

| 图 5 30 min内休眠相同节点数量时的能耗比较 Figure 5 Energy comparison under same number of sleeping nodes in 30 min |

在本小节的实验中,实验环境同上节,不同之处在于该休眠策略不要求休眠节点数目相同,而要求三种聚合策略在发生温度异常时,都降低相同的温度.此处的集群为50个节点,系统负载为50%.

从图 6中看出在温度降低相同的情况下,HRLC算法关闭的节点最少,因为它优先关闭热效率低(Ri值大)的节点,温度下降最快.MCLC算法关闭的节点最多,因为它只关闭负载最低的节点,没有考虑节点热效率,这些节点的关闭对温度影响较小,因此其节点关闭得最多;CHRWC关闭的节点数目居中.

|

| 图 6 下降温度相同时的休眠节点数量比较 Figure 6 The number of sleeping nodes comparison undersame temperature reduction |

从图 7看出,由于MCLC关闭的节点数较多,所以它的性能受到影响最大,各节点负载较重,所以响应时间最长;HRLC算法的延迟最小,因为其关闭的节点数最少;CHRWC算法延迟时间则适中.

|

| 图 7 下降温度相同时的性能比较 Figure 7 Performance comparison under same temperature reduction |

本文定量分析了数据中心内的负载聚合方法对系统温度、性能和功耗的影响;特别针对数据中心发生温度异常情况下,如何采用负载聚合方法来降低系统峰值输入温度,保障系统部件健康运行.除了能像以往方法通过负载聚合来最小化峰值温度,降低冷却功耗外;本文采用的三种启发式在线方法对系统温度异常进行了处理,实验结果表明在降低相同温度和休眠相同数量节点的条件下,优先考虑节点热循环系数比优先考虑节点负载更能优化系统性能及功耗.

| [1] | THIBODEAU P. Data Centers Are the New Polluters [EB/OL].[2017-03-28]. http://www.computerworld.com/article/2598562/data-center/data-centers-are-the-new-polluters.html. |

| [2] | GADOMSKI R. Reducing Energy Consumption and Cost in the Data Center[EB/OL]. [2016-08-14]. http://www.gartner.com/DisplayDocument?ref=cl-ientFriendlyUrl & id=1818517. |

| [3] | BELADY C L. In the Data Center, Power and Cooling Costs More Than the It Equipment It Supports [EB/OL]. [2016-08-14]. http://www.electronics-cooling.com/2007/02/in-the-data-center-power-and-cooling-costs-more-than-the-it-equipment-it-supports/. |

| [4] | LI S, LE H, PHAM N, et al. Joint Optimization of Computing and Cooling Energy: Analytic Model and Machine Room Case Study[DB/OL].[2016-05-06]. http://ieeexplore.ieee.org/stamp/stamp.jsp?arnu-mber=6258012.DOI: 10.1109/ICDCS.2012.64. |

| [5] | PAROLINI L, SINOPOLI B, KROGH B H, et al. A Cyber-Physical-System Approach to Data Center Modeling and Control for Energy Efficiency[DB/OL].[2016-05-02]. http://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=6006498. DOI: 10.1109/JPROC.2011.2161244. |

| [6] | BREEN T J, WALSH E, PUNCH J, et al. From Chip to Cooling Tower Data Center modeling: Part Ⅰ Influence of Server Inlet Temperature and Temperature Rise across Cabinet[DB/OL].[2016-05-02].http://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber.DOI: 10.1109/ITHERM.2010.5501421. |

| [7] | CHEN Y, GMACH D, HYSER C, et al. Integrated Management of Application Performance, Power and Cooling in Data Centers [DB/OL].[2016-05-02].http://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=5488433.DOI:10.1109/NOMS.2010.5488433. |

| [8] | Intel.Dual-Core Intel Xeon Processor LV and ULV Datasheet[R/OL].[2016-10-02]. http://www.intel.com/content/dam/www/public/us/en/documents/datasheets/dual-core-xeon-lv-ulv-datasheet.pdf. |

| [9] | RANGANATHAN P, LEECH P, IRWIN D, et al. Ensemble-Level Power Management for Dense Blade Servers[DB/OL].[2016-05-02].http://dl.acm.org/citation.cfm?id=1136492 & CFID=918154871 & CFTOKEN=29872260.DOI:10.1109/ISCA.2006.20. |

| [10] | BRUNSCHWILER T, SMITH B, RUETSCHE E, et al. Toward zero emission data centers through direct reuse of thermal energy[J]. IBM Journal of Research and Development, 2009, 53(3) : 1–13. DOI:10.1147/JRD.2009.5429024 |

| [11] | GOIRI I, KATSAK W, LE K, et al. Parasol and Green Switch: Managing Datacenters Powered by Renewable Energy[DB/OL].[2016-05-02]. http://dl.acm.org/citation.cfm?id=2451123 & CFID=918154871 & CFTOKEN=29872260.DOI: 10.1145/2490301.2451123. |

| [12] | WANG D, REN C, SIVASUBRAMANIAM A. Virtualizing Power Distribution in Datacenters[DB/OL].[2016-05-02]. http://dl.acm.org/citation.cfm?id=2485973 & CFID=918154871 & CFTOKEN=29872260.DOI: 10.1145/2485922.2485973. |

| [13] | DAN T, ETSION Y, FEITELSON D G. Backfilling using system generated predictions rather than user runtime estimates[J]. IEEE Transactions on Parallel and Distributed Systems, 2007, 18(6) : 789–803. DOI:10.1109/TPDS.2007.70606 |

| [14] | MANZANARES A, QIN X, RUAN X, et al. PRE-BUD: Prefetching for energy-efficient parallel I/O systems with buffer disks[J]. ACM Transactions on Storage, 2011, 7(1) : 1–29. DOI:10.1145/1970343.1970346 |

| [15] | CHEN T, YANG Y, ZHANG H, et al. Network energy saving technologies for green wireless access networks[J]. IEEE Wireless Communications, 2011, 18(5) : 30–38. DOI:10.1109/MWC.2011.6056690 |

| [16] | MILLER R. Uptime Institute: The Average PUE is 1.8[EB/OL]. [2016-08-14]. http://www.datacenterknowledge.com/archives/2011/05/10/uptime-ins-titute-the-average-pue-is-1-8/. |

| [17] | MILLER R. Data Centers Move to Cut Water Waste [EB/OL]. [2016-08-14]. http://www.datacenterknowledge.com/archives/2009/04/09/data-centers-move-to-cut-water-waste/. |

| [18] | RAMOS L, BIANCHINI R. C-Oracle: Predictive Thermal Management for Data Centers[DB/OL].[2016-05-02].http://ieeexplore.ieee.org/stamp/sta-mp.jsp?arnumber=4658632. DOI: 10.1109/HPCA. 2008.4658632. |

| [19] | LI L, LIANG C J M, LIU J. ThermoCast: A Cyber-Physical Forecasting Model for Data Centers[DB/OL].[2016-05-02].http://dl.acm.org/citation.cfm?id=2020611 & CFID=918154871 & CFTOKEN=29872260.DOI: 10.1145/2020408.2020611. |

| [20] | CHOI J, KIM Y, SIVASUBRANMANIAM A. Modeling and Managing Thermal Profiles of Rack-mounted Servers with ThermoStat[DB/OL].[2016-05-02].http://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=4147661.DOI: 10.1109/HPCA.2007.346198. |

| [21] | WANG X, CHEN M. Cluster-Level Feedback Power Control for Performance Optimization[DB/OL].[2016-05-02].http://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=4658631.DOI: 10.1109/HPCA.2008.4658631. |

| [22] | WANG X, WANG Y. Coordinating power control and performance management for virtualized server clusters[J]. IEEE Trans on Parallel and Distributed Systems, 2011, 22(2) : 245–259. DOI:10.1109/TPDS.2010.91 |

| [23] | MOORE J, CHASE J, PARTHASARATHY R, et al. Making Scheduling Cool: Temperature-Aware Resource Assignment in Data Centers[DB/OL].[2016-05-09].https://www.usenix.org/legacy/event/usenix05/tech/general/full_papers/moore/moore.pdf. |

| [24] | TANG Q, GUPTA S K S, VARSAMOPOULOS G. Energy-efficient thermal aware task scheduling for homogeneous high-performance computing data centers: A cyber-physical approach[J]. IEEE Transactions on Parallel and Distributed Systems, 2008, 19(11) : 1458–1472. DOI:10.1109/TPDS.2008.111 |

| [25] | RAGHAVENDRA R, RANGANATHAN P, TALWAR V, et al. No "Power" Struggles: Coordinated Multi-Level Power Management for the Data Center[DB/OL].[2016-05-02].http://dl.acm.org/citation.cfm?id=1346289 & CFID=918154871 & CFTOKEN=29872260.DOI: 10.1145/1346281.1346289. |

| [26] | ABBASI Z, VARSAMOPOULOS G, GUPTA S K S. Thermal Aware Server Provisioning and Workload Distribution for Internet Data Centers[DB/OL].[2016-05-02].http://dl.acm.org/citation.cfm?id=1851493 & CFID=918154871 & CFTOKEN=29872260.DOI: 10.1145/1851476.1851493. |

| [27] | CHOI J, GOVINDAN S, URGAONKAR B, et al. Profiling, Prediction, and Capping of Power Consumption in Consolidated Environments [DB/OL]. [2016-05-02]. http://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=4770558.DOI: 10.1109/MASCOT.2008. 4770558 |

| [28] | HSU C H, POOLE S W. Power Signature Analysis of the SPECpower_ssj2008 Benchmark[DB/OL].[2016-05-02]. http://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=5762739.DOI: 10.1109/ISPASS.2011.5762739. |

| [29] | 罗亮, 吴文峻, 张飞. 面向云计算数据中心的能耗建模方法[J]. 软件学报, 2014, 25(7) : 1371–1387. LUO L, WU W J, ZHANG F. Energy modeling based on cloud data center[J]. Ruan Jian Xue Bao/Journal of Software, 2014, 25(7) : 1371–1387(Ch). DOI:10.13328/j.cnki.jos.004604(Ch) |

| [30] | JONAS M, GILBERT R R, FERGUSON J, et al. A Transient Model for Data Center Thermal Prediction[DB/OL].[2016-05-02]. http://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=6322262.DOI: 10.1109/IGCC.2012.6322262. |

| [31] | 叶如钢. CFD仿真建模技术在数据中心机房节能中的应用[J]. 节能环保, 2015, 4 : 244–245. YE R G. The application of CFD simulation technology the machine rooms of a data center[J]. Energy Reduction and Environmental Protection, 2015, 4 : 244–245(Ch). |

| [32] | STRUNK A, DARGIE W. Does Live Migration of Virtual Machines Cost Energy[DB/OL].[2016-05-02]. http://ieeexplore.ieee.org/stamp/stamp.jsp?arnumber=6531798.DOI: 10.1109/AINA.2013.137. |

2017, Vol. 63

2017, Vol. 63