文章信息

- 顾进广, 朱婷婷, 黄莉, 田萍芳

- GU Jinguang, ZHU Tingting, HUANG Li, TIAN Pingfang

- 知识图谱中链接数据质量评价研究综述

- A Review on Quality Assessment for Linked Data of Knowledge Graph

- 武汉大学学报(理学版), 2017, 63(1): 22-38

- Journal of Wuhan University(Natural Science Edition), 2017, 63(1): 22-38

- http://dx.doi.org/10.14188/j.1671-8836.2017.01.003

-

文章历史

- 收稿日期:2016-07-02

2. 智能信息处理与实时工业系统湖北省重点实验室,湖北 武汉 430065;

3. 湖北语言与智能信息处理研究基地(武汉大学),湖北 武汉 430072

2. Key Laboratory of Intelligent Information Processing and Real- time Industrial System of Hubei Province, Wuhan 430065,Hubei, China;

3. Hubei Provincial Language and Intelligent Information Processing Research Base(Wuhan University), Wuhan 430072, Hubei, China

2012年,为了让用户能够更快更简单的发现新的信息和知识,Google搜索发布了“知识图谱”(knowledge graph)——可以将搜索结果进行知识系统化,任何一个关键词都能获得完整的知识体系.Google的Singhal在介绍知识图谱时说:“a ‘graph’ —that understands real-world entities and their relationships and their relationships to one another:things,not strings” .知识图谱描述了真实世界中存在的各种实体(概念)以及实体间的关系(属性)[1].

Linked Data(链接数据)的思想是Berners-Lee于2006年提出,它是指用于发布和关联网络上的结构化数据(RDF数据)的集合[2],使用的是语义网的技术和标准.

为了从互联网中发现实体与实体之间的关系,知识图谱采用了Linked Data作为其表达形式,然而从相关研究中[3],我们毫不惊讶地发现Web上的RDF数据质量是参差不齐的[1].例如的数据是从半结构或非结构化的资源中提取的,这通常会存在信息不一致性、叙述有误和不完整等一系列问题;再如,在RDF数据集中,标签的公共属性不被重复利用,属性和类没有被定义而是虚构的,存在断链等.这些质量问题的存在无疑会污染Linked Data,影响用户对Linked Data的无障碍使用.

数据质量通常被定义为数据在某个应用或某个场景下的“适用性”(fitness for use)[4],而数据质量问题是指一系列的可能会影响使用该数据的应用程序的性能的问题,包括准确性、完整性、客观性、一致性、简洁性、可用性、实时性、可信度等因素[5].为了推动Linked Data的进一步发展,必须让数据提供者在将相关数据发布到Web前就保证数据质量,不仅要最大化的被用户所使用,而且要避免给Web of data带来污染.

当前一个非常重要的挑战是如何判定这些发布在Web上的数据的质量.对于这些半结构化的数据,我们需要更具体、客观和可衡量的数据质量指标,例如内容的正确性、语义表达的准确性或者内容覆盖度.目前关于Linked Data质量评价方面的研究工作还比较片面,这些数据的质量应该如何被监测和保证并没有一个普遍的规范和标准,对于数据质量维度和相关度量如何被定义更没有达到共识.因此,本文对现有的Linked Data质量评价的文献进行综述.我们将列举讨论当前研究Linked Data质量评价的文献,并比较这些文献对质量评价维度的类型划分,同时我们也会呈现一个全面的数据质量评价维度和相关描述.本文的目的是为了帮助相关研究者全面了解Linked Data质量评价的现有工作,以促进Linked Data质量研究工作的进一步发展.

1 质量评价的研究现状目前,很多LOD(linked open data)的数据质量相对较差,包括实体关系及实体属性描述不规范,使得Linked Data的语义信息不合理.Tim Berners-Lee在2006年提出了4条构建Linked Data的基本规则[2]:

1) 规则1:使用URIs定义事物;

2) 规则2:使用HTTP URIs,因此客户端(机器或者人类阅读器)能够查找这些名称;

3) 规则3:当查找一个URI,需要提供有用的且可理解的信息;

4) 规则4:链接其他数据,有利于查询到更多的数据和想要的信息.

Linked Data Community鼓励数据提供者通过遵守语义网标准的这种可互操作的方式来发布和使用Linked Data.然而随着Linked Data量的增长和质量问题的突出,上述4条规范对保证LOD数据的质量显然已不够.因此,相关研究者提出了各种LOD数据质量的评价框架、评价标准以及数据发布指南.

Knight等人[6]归纳了12个流行的信息质量框架,并对比了这12个框架,包括它们的结构模式、对质量维度的分类等.同时,他们提取出包含在这些框架中的20个最常见的质量维度:accuracy,consistency,security,timeliness,completeness,concise,reliability,accessibility,availability,objectivity,relevancy,usability,understandability,believability,navigation,reputation,useful,efficiency,value-added,并以该20个维度作为标准来评价数据质量.

Batini和Scannapieco[7]提供了一个对数据质量评价方法的全面的概述,分析了当前数据质量的各种问题及评估和提高数据质量的主要方法,同时他们加强了对数据来源(provenance)和数据可信度(trustworthiness)的关注,也提出了针对质量维度的分类、定义和指标的标准化的缺失问题.

Heath等人[8]提供了在Web上发布RDF的具体指南,详细讨论了产生Linked Data的过程,并且提出了“How to Publish Linked Data on the Web”,对此给出了7个具体的步骤,即发布Linked Data时应注意的一系列问题,包括词汇表的选择和重用、URI的使用、添加链接等.对于当前被提出的Linked Data面对的种种问题,Hogan等人[3]讨论了Linked Data发布时常见的错误,他们将这些错误划分为4种类型:可访问性和解引用(accessibility and dereferenceability)、语法错误(syntax errors)、推理——噪音和不一致(reasoning:noise and inconsistency)以及非权威的贡献者(non-authoritative contributions).在文献[8]提出的发布指南的基础之上,Hogan等人[9]又从中抽取出14条具体的建议,将这14条建议划分为4个范畴:naming,linking,describing resources,dereferencing resources,且进行直接的量化分析,然后评估RDF数据提供者与这些指南的一致性.此外,对于每一条指南,作者都列举出一致性分数排名前五位和后五位的域名,供相关研究者比较不同数据集的质量.他们将数据质量的一致性问题进行了全面阐述并量化,是目前评价一致性问题最全面、标准化的研究.

从用户的角度出发,Kandari等人[10]利用在现有的文献中已普遍确定的信息质量维度,得到一个信息质量维度的整合信息.另外通过问卷调查的反馈形式,作者总结了73个问题来测量22个信息质量维度对Web用户的重要性.在文献[10]中,作者还提出用一个新的框架来测量信息质量维度,得到一张关于信息质量维度的重要性排序表,认为有9个维度:understandability,accuracy,believability,navigation,amount of data,completeness,advertising,concise representation,consistent representation是在开发高质量的信息网站时不可忽视的,也是评价Linked Data质量的主要标准.

Assaf等人[11]描述Linked Data的质量时,根据数据管理过程,定义了5种类型的质量原则:数据来源的质量(quality of data source)、原始数据的质量(quality of raw data)、语义转换的质量(quality of the semantic conversion)、链接过程的质量(quality of the linking process)和全局质量(global quality),并对每种类型都罗列出其准则,即影响该类型数据质量原则的属性,也就是本文所说的质量维度.从不同的角度出发,Zaveri等人[12]展示了对Linked Data质量评估的方法进行系统综述的结果.他们收集过滤出12篇关于质量评价的文章,将这些文章包含的评估方法和分类方案进行比较,并给出对质量维度划分的6种类型.他们重新统一定义了数据质量方面的术语、维度和相关衡量指标,并将一个智能航班搜索引擎的例子贯穿于对每个数据质量维度的阐述中.文献[13]从质量的角度分析了DBpedia和最大的中文Linked Data Sets——Zhishi.me.

当前有许多关于Linked Data质量评价的研究成果,这些研究者都从不同的角度来讨论数据质量评价问题,并尝试将其标准化.每个研究者提出的划分维度的类型不一样,维度和对应的指标也不一样,也没有权威机构定制Linked Data质量评价的标准.随着数据发展产生的新特性,新的维度也在不断被提出,Linked Data相关领域的研究者在不断尝试将数据质量评价标准化.本文系统回顾了相关研究者的工作,并根据当前Linked Data面对的质量问题,重新划分质量维度的类型,为每种类型所对应的质量维度和相关描述作了一个全面的归纳分析.

2 质量评价的维度Linked Data质量的评价通常是指对Linked Data进行整合的数据集的质量评价,而这些数据集基本都是RDF数据集,所以Linked Data质量评价可以细指对Linked Data中不同RDF数据集的质量评价.质量评价的指标依赖于影响数据被使用时的因素,即质量维度.在现有的相关文献中,研究者们对质量维度的定义、质量维度的分类和归纳的质量维度个数都不一样.

2009年,Bizer等在文献[14]中,根据信息被使用的类型将质量维度划分为3个范畴:1) 基于内容的,指信息内容本身;2) 基于上下文的,指在信息被声明处的上下文信息;3) 基于等级的,指数据本身或信息提供者的等级.在此基础上,2013年Zaveri等人[12]将质量维度类型划分作了修改和扩展,将质量维度划分为6种类型:1) 上下文的维度;2) 可信度的维度;3) 内在的维度;4) 可访问性维度;5) 描述的维度;6) 数据集动态性.

虽然研究者对质量维度进行了不同的归纳和阐述,但没有给出一个非常全面的、清晰的质量维度列表和相关描述,罗列的质量维度只是针对某一个方面的,且质量维度之间本身有重叠或是模棱两可.

本文在文献[12]质量维度基础上,对Linked Data的质量维度和指标做出一些调整和修改,从Linked Data产生、被使用、维护过程的角度出发,将质量维度的类型划分为7种:1) 可信性,2) 资源描述,3) 冗余性,4) 实用性,5) 可访问性,6) 内在特性,7) 资源动态性.每种类型都与Linked Data数据的发展过程的特性相关,每种类型又包括了具体的质量维度,如表1所示.

| 阶段 | 类型 | 质量维度 |

| 产生阶段 | 可信性 | 出处,信誉,可信度,可验证性,许可证 |

| 资源描述 | URI,空节点,可理解性,可解释性 | |

| 冗余性 | 简洁性,复用词汇表,语义冗余 | |

| 使用阶段 | 实用性 | 可查询性,信息性 |

| 外在特性(可访问性) | 可用性,性能,安全性,响应时间 | |

| 内在特性 | 完整性,一致性,准确性,客观性,合理性,连通性 | |

| 维护阶段 | 资源动态性 | 波动性,实时性 |

可信性(trustworthiness)是指数据的公信力,它包含了5个质量维度,分别为:出处(provenance)、信誉(reputation)、可信度(believability)、可验证性(verifiability)和许可证(licensing).

2.1.1 出处数据出处指数据从创建开始的历史信息,包括数据的起源、发布者等信息.数据出处有助于将实体描述得更真实并可以再生.

一般情况下,如果数据出版人或者发布者的可信度较高时,那他们产生的数据的可信度也会随之较高.Hartig[15]讨论了各种与数据出处相关的问题,并提供了元数据文档.另外,他还讨论了当前在Linked Data词汇表中与数据出处相关的属性例如dcterms:creator,dcterms:source,dcterms:publisher,foaf:maker等.

2.1.2 信誉信誉是指用户对数据资源的可信性的判定结果.我们可以将历史信誉作为先验知识来判断数据来源的质量,数据的信誉主要与数据发布者、组织、团体等的实践经验相关,因此数据的信誉度可以由个人的经验或者他人的推荐所判定[16].

信誉通常用分数来表示,可以通过权威的机构或者投票来获得.例如通过对该数据领域相关组织的成员进行问卷调查获取反馈结果,或者利用PageRank来判定.因此,数据的信誉与社会相关,当某个发布者在一定程度上被相关权威机构、团体、个人所认可,那么与他相关的数据的信誉度就高;或者某个数据集由相关权威机构所推荐,那么该数据集的信誉度就高.

2.1.3 可信度最初,可信度指信息被用户认为是真实可信的程度[17],另外,可信度也被理解为用户对数据真实性的主观测量[18].在此基础上,文献[12]提出了一个广泛的定义:可信度指信息被公认为是正确、真实和可靠的程度.

数据可信度会帮助用户决定信息是否可以被相信,影响数据可信度的因素包括数据来源、数据提供者的声誉、用户先前的经验等.数据发布者的声誉会影响数据的可信度,如果某个发布者是知名的、有声誉的,那么该发布者提供的数据的可信度就会相应很高.数据可信度同样可以通过PageRank来获取,一般排名靠前的数据的可信度会更高.另外,数据被引用的情况也会影响数据可信度.因此,可信度是用户根据数据相关信息来主观判断得到的,并且用户可以根据判断结果给数据分配相应的可信度分数,后期可利用先前经验来高效判断可信度.

2.1.4 可验证性在文献[17]中,可验证性被描述为能够检查信息的正确性的程度和方便性.文献[19]将可验证性表述为一种提供给用户的用来检查数据正确性的手段.文献[11]将可验证性维度归纳到数据来源质量类型里,认为可验证性是指数据用户能否检查数据来源的正确性和准确性.综上,可验证性就是指数据用户可以评估数据正确性的程度,并将评估结果作为该数据可信度的一个结果.因此,用户希望他接收到的数据与他做过验证性的数据来自相同的资源.

可验证性能够通过公正可信的第三方机构验证真伪,判断数据提供者的相关信息,或者使用数据签名[20]来验证数据的序列号.当数据集提供者的可信度较低时,可验证性维度非常重要.例如,通过验证数据集提供的来源信息,包括使用的已存在的词汇表,或者数据签名中的序列号,用户以此来决定是否接受该信息.

2.1.5 许可证有研究者指出为了使用户根据明确的法律条款来使用数据,每一个数据文件应该包含一个许可证以指明哪些内容可以被使用[8, 9].文献[12]如下定义数据的许可证:予以用户在规定条件下复用数据的权限.

数据的许可证维度可以根据数据提供的机器可读的指示、人类可读的指示及内容限定可访问等信息来判断.提供许可证信息,可以使用户或第三方在法律允许下,放心的在权限范围内使用数据,包括复制数据、修改数据等[21],从而增加数据集的可用性.

2.2 资源描述资源描述(resource-description)维度是指数据提供者如何描述数据相关的维度,包括URI、空节点(blank node)、可理解性(understandability)和可解释性(interpretability).

2.2.1 URI文献[8]中给出这样的建议:在Linked Data的上下文中,我们只使用HTTP URIs.HTTP URIs可以被全局识别,且相关信息可以通过HTTP的方式返回.在当前的数据发布指南中,虽然我们建议尽可能使用HTTP URIs,但仍然会直接使用mailto:和tel:等来表示邮件和电话信息的URIs以识别一些传统大资源.

在此基础上,文献[9]表示对于新的标识应当使用HTTP URIs,这样使得资源可以被解引用.资源解引用对于定位信息很重要,也可以用于处理SPARQL查询.解引用可以为资源之间建立信任的关系,提高资源的可信度.另外,检索无解引用的资源会浪费计算时间,降低系统性能.

在资源命名的指南中,文献[8]同时建议使用短的、容易记忆的URIs.用户常常需要操作Web上的数据,所以URIs不能只是被计算机识别,信息的名称应该有利于人类读取、记忆和使用.同时,简短的URIs有利于磁盘读取和存储,占用较少的内存等.

另外,文献[8]也建议尽量使URIs保持持续稳定.后期改变URIs会破坏之前已建立的链接,严重影响应用的性能[22],所以一旦解引用被建立,就应该长期保持解引用.因此,为了不破坏解引用和映射,应该使用稳定的URIs,这样才不会损害相关性能.

2.2.2 空节点文献[8]提到,不鼓励使用空节点,因为有可能将一个外部RDF链接设置到一个空节点上,而且在空节点被使用后,合并不同的数据会变得更加困难.非空节点可以被外部文件相互引用,而空节点不行,所以当文件够多时,空节点的比例会升高.对此,文献[9]通过计算数据层的惟一URIs在包括空节点的所有URIs中所占的比例,得到数据集最低限度的使用空节点的指标.

使用空节点会影响数据的链接和复用,但是数据发布者仍然会以各种理由来使用空节点,例如使用空节点表示临时变量,或者用来表示不会被外部引用的资源,或者被作为简称使用.对此,RDF W3C Working Group讨论过将空节点转化为惟一URI的可能性[23].

2.2.3 可理解性文献[17]如下定义可理解性:数据易于被用户理解的程度.文献[12]将可理解性定义为数据被用户无歧义的理解和使用的难易程度.我们将可理解性解释为数据的内容能否被用户所理解.

可理解性可以通过检查是否提供人类可读的类、属性和实体标签来衡量,即数据中rdfs:label提供的数量,但是同一个概念用多个标签也会造成用户混淆.数据集中元数据的提供也可以用来评价它的可理解性.另外,数据集被鼓励提供关于URIs、SPARQL查询和使用词汇表的示例,这样用户可以更好的理解和使用数据集.所以为了加强数据可理解性,数据发布者应该尽量复用知名度高、已被广泛接受的格式、定义、标签、词汇表,以确保数据可以被用户理解.

2.2.4 可解释性文献[17]将可解释性描述为数据集使用合适的语言、符号、单位以及明确的定义的程度.文献[12]重新定义可解释性,指可解释性是数据的技术层面,即信息是否使用了合适的标记并且与用户的技术能力相一致.

可理解性可以通过判断object或者术语是否使用globally unique identifiers来衡量,也可以检测合适的语言、符号、单位和明确的定义的使用程度.数据集使用越多统一化的符号、术语[9],数据的可解释性越好,这除了有利于数据的使用性,也使数据集与其他数据源的合并更便捷.

2.3 冗余性冗余性(redundancy)主要是指数据集没有无关的、多余的信息,包括的质量维度有简洁性(conciseness)、复用词汇表(reuse vocabularies)和语义冗余(semantic redundancy).

2.3.1 简洁性在对简洁性的研究中,一般都将数据简洁性分为模式层(schema level)和数据层(data level)[24].在模式层,数据简洁性指不包含冗余的属性,即用不同的名称代表相同的属性.因此,模式层的简洁性与惟一属性(unique attribute)的个数相关,可以通过计算惟一属性的个数占所有属性个数的比例来测量.在数据层,数据简洁性指不包含冗余的对象,即用不同的标识去描述相同的对象.因此,数据层的简洁性与惟一对象(unique object)的个数相关,可以通过计算惟一对象的个数占所有对象个数的比例来测量.

在简洁性维度中,数据的惟一性[25]很重要.但是,对于孤岛数据,即与描述的实体无关的数据,即使是惟一的,对于数据本身也没有作用.所以,数据简洁性与属性、对象的惟一性相关,也与数据相关性关联.

2.3.2 复用词汇表复用词汇表,就是复用已存在、质量好的词汇表[26],如SIOC,Dublin Core,OPMV or PROV vocabulary.重新定义已存在的属性或者术语,会使得相同属性或术语被重复定义,导致不同数据集合并时造成冲突和冗余.所以,复用词汇表,即直接使用已被定义的属性和术语,消除内容冗余,避免用户产生歧义,也有助于数据集成和管理.

2.3.3 语义冗余RDF数据集的语义冗余是指如果将其中的一些三元组删除并不会导致数据含义的改变;从更广泛的角度来说,语义冗余指三元组模式的共同出现[27].在大部分情况下,删除这些三元组需要添加新的规则到数据集中,这样在需要的时候可以重新生成这些被删除的三元组.对于语义冗余,可以通过定义图模式(graph pattern)来确定规则去除冗余的三元组.

2.4 实用性文献[28]借鉴软件工程的相关方法,探讨从用户使用的角度来评价Linked Data的质量.包括可查询性(queriability)和信息性(informativity)两个维度.对于可查询性,主要通过构建查询的时间(query construction time)、尝试的次数(number of attempts)两个客观指标和一个查询难度(difficulty rating)主观指标来评价.对于查询难度,分为非常容易、容易、一般、难、非常难5个等级.信息性则直接采用准确率(precision)、召回率(recall)、返回信息的完整性(comprehensive informativity)等常用客观性指标及一个信息率的主观指标来评价.

2.5 外在特性(可访问性)数据的可访问性(accessibility)指数据是否可以正常的被访问和检索,包括可用性(availability)、性能(performance)、安全性(security)和响应时间(response-time)这4个维度.

2.5.1 可用性文献[17]将可用性维度定义为数据是可用的,或者容易和快速被检索的程度.文献[12]在此基础上,如下定义可用性:数据的可用性指信息是存在的、可获取的和可供使用的程度.

可用性维度与服务器的可访问性[29]、URIs的解引用性等相关,可由这些因素来测量,例如说用户访问时,出现404等服务端错误的概率.因此,网络拥塞、服务器不可用、死亡链接或解引用问题都会影响数据的可用性,可以通过克隆服务器或缓存信息等方法来解决.

2.5.2 性能文献[12]将性能描述为一个大数据集系统的性能,即一个数据资源的性能越好,则该系统处理数据的效率越高.性能可以由查询的响应时间来衡量,包括系统的低延迟和高吞吐量也会提高数据的性能维度.所以,在同时执行多条复杂的查询时,系统也应该可以无障碍、有效的处理,这样才能达到数据的性能要求.

2.5.3 安全性文献[17]中,安全性指对数据访问的限制性,且保证数据资源与用户之间的机密.文献[12]将安全性定义为访问数据的限制程度,以此来防止非法更改和误用.

安全性可以通过数据的访问、获取和重用是否需要通过网络安全技术来衡量.目前,为数据提供安全性措施需要一定代价,因此开放数据的安全性往往被忽视,造成数据被篡改、污染,但通常情况是数据变得不可用的代价会更大,所以我们还是应该重视数据安全性.利用基于私钥公钥加密的电子签名可以保证数据的安全性.另外,访问数据前需要登录和验证访问者的身份,或者使用安全凭证,或者通过SSH、SSL方式,都可以保证数据的安全性.当然,数据的安全性级别取决于数据是否可以被公开,当数据机密性特别高时,如政府、军事等方面的数据,数据安全性就非常重要.

2.5.4 响应时间响应时间指的是用户提交请求到接收到系统响应的延迟时间[17].响应时间通常与网络流量、服务器工作量、服务器性能、用户查询复杂度等因素相关.响应时间过长,会影响数据的可用性和可访问性.通过使用缓存技术和优先加载方案(按优先级先加载部分数据)可以提高响应时间,以保证数据用户的访问质量.

2.6 内在特性内在特性(intrinsic-properties)维度与数据内容相关,体现数据的正确性、逻辑一致性等.内在特性包括了6个维度:完整性(completeness)、一致性(consistency)、准确性(accuracy)、客观性(objectivity)、合理性(rationality)和连通性(interlinking).

2.6.1 完整性文献[17]中将完整性定义为信息没有丢失的程度.文献[25]进一步将完整性维度划分为以下几个方面:(a) 模式完整性,指实体和属性不缺失的程度;(b) 列完整性,指一个特定的属性不缺少值或者列;(c) 数量完整性,指信息系统里的实体与完整数量的比例.文献[24]则把完整性按模式层(schema level)和数据层(data level)来划分,模式层的完整性指数据集包含的属性是否完整,数据层的完全性则表示数据集包含的对象是否完整.

综上,完整性是指一个特定的数据集所有需要的、相关的信息是否都完整.我们将Linked Data的完整性维度归纳为以下几个分类:

a) 模式完整性:一个本体包含的类和属性是否完整;

b) 属性完整性:一个特定的属性的值是否缺失;

c) 数量完整性:一个数据集里对象(object)的数量比例;

d) 互连完整性:数据集里的实例互联的程度[30].

因此,通过计算数据集的类、属性、值和interlinks的数量并与标准的数据集比较,来衡量其完整性.Linked Data的完整性是非常重要的,发布者们常常通过将不同的资源整合来提高数据的完整性.

2.6.2 一致性一致性一般被解释为“数据之间没有冲突”.文献[12]将一致性的定义更具体化:关于知识库的特定的知识表述和推理机制,在逻辑和形式上是不矛盾的.

除了对于数据集中的对象、属性等信息的表达形式要统一,避免混淆冲突出现,另外在Linked Data中,会通过一定的推理策略来揭示隐含的知识,如果推理过程和结果存在矛盾性,会导致问题的出现.所以,Linked Data的推理规则集的一致性非常重要.

2.6.3 准确性文献[17]将准确性定义为一个信息系统描述的信息展示了真实世界的正确性和精确性的程度.另外,文献[25]将准确性划分为语法的准确性和语义的准确性.所以,我们从两个角度描述准确性:

a) 语法的准确性:包括是否使用错误的标签、不正确的注释等[31];

b) 语义的准确性:是否使用了不正确的值,影响数据表示真实世界的精确性.

通过检测数据是否有语法错误、是否存在错误的注释、是否有过时的属性和类、是否使用不当的词汇、字面量与数据类型对应的范围是否符合、是否使用不准确的分类、是否将不存在的断链作为外部链接使用等,可以判断数据的准确性程度.

2.6.4 客观性文献[17]认为客观性指信息是无偏见的、公正的.文献[12]在此基础上扩展了客观性的定义:客观性是指数据的解释和使用是公正、公平的程度.因此,客观性不是衡量数据质量,而是检测数据资源的真实性,例如数据是否涉及发布者的个人影响.不公正的数据会导致用户做出错误的判断.

2.6.5 合理性合理性是指数据的粒度大小,即对于特定的任务,要选择大小、覆盖范围都合适的数据.Linked Data包含的数据集体积都非常大,同时也应该有足够的广度和深度,包括覆盖范围(实体和属性的数目).但是对于某个特定的任务来说,数据集的体积越大,就不可避免的覆盖了很多领域的信息,有些信息与用户的查询任务无关,就会导致查询效率很低.

数据的合理性,可以通过数据集大小与查询时间、返回信息的相关性等来衡量.因此,数据集在保证覆盖度的基础上,也要确保数据关联性[17, 32],避免包含无关信息而造成数据污染.

2.6.6 连通性连通性指的是数据本身和数据集之间的连接性.主要涉及到的内容有外部链接[8]、owl:sameAs[9]和断链[33].

Linked Data主要通过抽取关联实体来扩展覆盖率,所以Linked Data之间最有价值的链接就是那些连接到由其他数据源发布的外部数据,因为他们将不同的孤岛数据集连接到一个Web上.例如在RDF数据集中,一个外部链接是指某个RDF三元组的主语或者宾语对应的URI是来自另外一个数据源.定义RDF链接到外部数据提供者,可以让用户在Web上偶然发现更多相关的信息,而这些信息是通过爬虫半自动化或者自动化的方式来抓取的,或者是用户通过浏览器直接获取的.Linked Data的相互关联性非常重要,实体的连通性可以让Linked Data获取到对应的知识体系所需要的信息.外部链接可以将孤岛数据连接起来,形成了网状结构的数据,而其中需求最大的节点也成为该网状结构的重要连接点,使Linked Data的知识体系达到广度和深度的要求.

一个owl:sameAs链接表示两个URI标记指向相同事物,所以使用owl:sameAs属性主要是为了映射两个不同的URI别名[34, 35].使用owl:sameAs不仅可以加强数据集本身的内部连接性(例如一个数据集中用两个URIs来表示同一个对象),更重要的是加强两个不同数据集之间的连接性(例如数据集 A 为了避免混淆,用别名描述数据集 B 中的某个对象,但两个对象表示的是同一个事物).

数据提供者常常使用链接将不同的数据资源连接在一起,但是资源在发布后会被主观的改动(例如连接目标被删除或者移动),这会导致数据之间的链接被破坏,即出现断链[33],从而严重影响用户的使用.为了维护数据的连通性,数据发布者应该实时检测和修复数据集中的断链.

2.7 资源动态性资源动态性(resource-dynamicity)与数据发布后期对数据的维护相关,即随着时间的推移,使数据集保持动态性,适应真实世界的变化.资源动态性包括两个质量维度:波动性(volatility)和实时性(timeliness).

2.7.1 波动性波动性由文献[12]最先定义的,它指数据保持有效的时间长度,即数据从发布时间到失效时间的时间差.对于波动性较大的数据,系统应该及时提醒,避免用户使用已失效的数据.

2.7.2 实时性实时性是指数据的更新状态,如数据更新的频率、是否包含过时的数据等,另外还包括了链接URIs的更新.除了在数据发布前要确保数据的质量问题,在发布后期也要实时维护数据.如删除过期的数据、增加最新的数据、修改错误的数据等,让数据实时地与真实的世界保持一致,才能让数据长时间的满足用户需求.另外,通过观察数据的最近更新时间[36],可以检测数据的实时性.

我们将质量维度划分为可信性、资源描述、冗余性、实用性、可访问性、内在特性和资源动态性7种类型,进一步对每种类型包含的质量维度的定义进行声明,且说明影响每个质量维度的指标因素.当前现有的Linked Data质量评价的量化方法研究主要集中在冗余性及可信性,后文将详细分析冗余度和可信性的评价方法.此外,随着Linked Data的推广和应用,Linked Data的变化也非常快,因此,Linked Data的波动性分析对动态环境下Linked Data质量的研究也是质量评价方向的研究重点.

3 冗余度评价方法与大多数信息系统一样,Linked Data中也存在冗余数据.数据的冗余意味着必须浪费空间去存储冗余信息.用户需要更多的存储空间去存储数据,同时也需要用更多的时间去下载数据集,这无疑会阻碍Linked Data的发展,冗余度评价是Linked Data质量评价中非常重要的一点.Linked Data的数据冗余主要来自于其知识体系中包含的不同的RDF数据集的冗余,所以根据RDF特征将其冗余度划分为结构冗余、语义冗余、空节点冗余三个方面.

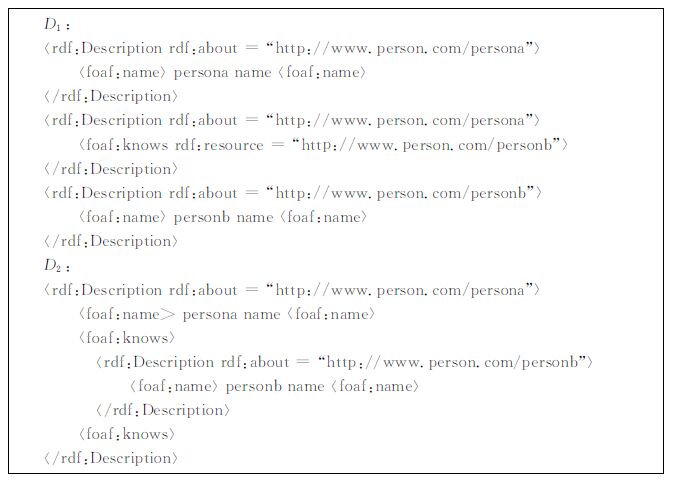

3.1 结构冗余Linked Data体系包含各种RDF三元组数据集,而三元组的呈现形式不同会导致RDF数据集的大小也不同.有如下两个数据集:

|

D 1和 D 2表示同一个RDF数据集,但它们对三元组的呈现形式不同,在 D 1中persona和personb的URI都出现了两次,但是在 D 2中都只出现了一次,这两个数据集表达了同样的意思,但 D 2在结构上比 D 1更简洁.

用| F |表示一个RDF数据集的大小,rb 表示数据集中所有资源的平均字节数,Nc 表示数据集中所有资源的出现总次数,我们可以得到如下公式:

| $\left| F \right|={{r}_{b}}\times {{N}_{c}}$ | (1) |

如果存在另外一种呈现形式,使得数据集中所有资源的出现总次数变少,所有资源的平均字节数变小,则该数据集存在结构冗余.令$\left| {\bar{F}} \right|$表示数据集变换了呈现形式后的大小,${{{\bar{r}}}_{b}}$表示所有资源的平均字节数,${{{\bar{N}}}_{c}}$表示资源的出现总次数,则$\left| {\bar{F}} \right|={{{\bar{r}}}_{b}}\times {{{\bar{N}}}_{c}}$,数据集的结构冗余度STRration为:

| $\text{ST}{{\text{R}}_{\text{ration}}}=\frac{\left| {\bar{F}} \right|}{\left| F \right|}$ | (2) |

如公式(2)所示,RDF数据集的结构冗余度可以通过计算改变数据集组织形式后数据集的大小与原数据集大小的比例得出.目前有很多的方法可以用来改变RDF数据集的呈现形式,其中HDT[37]和 K 2-triple[38]是两种比较好的方法.HDT将Linked Data Sets中的信息分解为三个部分:第一部分称为头部(header),头部保存了描述整个数据集的逻辑和物理元数据;第二部分称为字典(dictionary),字典部分主要是将数据集中的资源映射成为一个惟一ID,这样就减少了所有资源的平均占用字节数;第三部分称为三元组(triples),这一部分先将数据集中的三元组ID化,然后根据三元组的主语信息将三元组分组,进行压缩,尽可能将资源的出现次数降低.HDT保存了数据集的底层结构,同时避免了数据集中较长的以及重复的资源描述. K 2-triple方法主要是将数据集中的三元组基于谓词分为不相交的子集(主语,谓语)对,这些子集对再被高度地压缩为稀疏的二进制矩阵,这种方案也减少了所有资源的平均字节数和资源的出现总数.

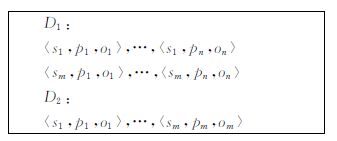

3.2 语义冗余Linked Data的语义冗余评价主要依赖于RDF数据的规则推理特性.通过规则推理,一个三元组可以推导出多个三元组.例如存在以下两个RDF数据集 D 1和 D 2:

|

同时,如果存在如下的规则 R :

| $\left\langle ?s,{{p}_{1}},{{o}_{1}} \right\rangle \to \left\langle ?s,{{p}_{2}},{{o}_{2}} \right\rangle ,\cdots ,\left\langle ?s,{{p}_{n}},{{o}_{n}} \right\rangle $ |

其中? s 表示对任意的 s .数据集 D 2依据规则R推理后的数据集记为 R ( D 2),可以得到 R D 2= D 1,即数据集 D 2通过规则R的推理可以得到数据集 D 1. D 2虽然比 D 1多 m ×( n -1)个三元组,当通过使用规则R,使得 D 1和 D 2具有相同的语义,这表示 D 1中存在冗余三元组,D 1具有语义冗余.令$\left| {{D}_{1}} \right|$、$\left| {{D}_{2}} \right|$、| R |分别表示 D 1中三元组数目、D 2中三元组数目以及 R 中三元组数目,SMRration表示 D 1的语义冗余度,则有如下计算公式:

| $\text{SM}{{\text{R}}_{\text{ration}}}=\frac{\left| {{D}_{2}} \right|+\left| R \right|}{\left| {{D}_{1}} \right|}$ | (3) |

如公式(3)所示,要想获得Linked Data的语义冗余度评价,首先需要挖掘其包含的RDF数据集中的规则,然后利用规则去除数据集中的冗余三元组,最后计算剩余三元组数目与原数据集中三元组数目的比例.规则挖掘是语义冗余度评价的核心,文献[39]采用频繁模式挖掘算法挖掘数据集中三元组之间的关联规则,它以数据集中三元组的主语作为惟一的标识符TID(transaction ID),以主语对应的宾语作为项,构建一个事务(transaction),整个数据集就变为了一个交易数据库,然后利用算法获得交易数据库中所有项的出现频率,即支持度(support),当某一项的支持度大于设定的阈值,则根据这一项构建intra-property规则.同样,以它的主语为TID,将谓语和宾语作为项构建事务,最后获得了inter-property规则.与文献[39]不同,文献[40]将RDF数据集看成一个图模型,它先将数据集中的三元组按照实体描述模块集中在一起,然后依据图的连接特性将这些实体描述模块连接在一起,从而形成了一种图模式规则.

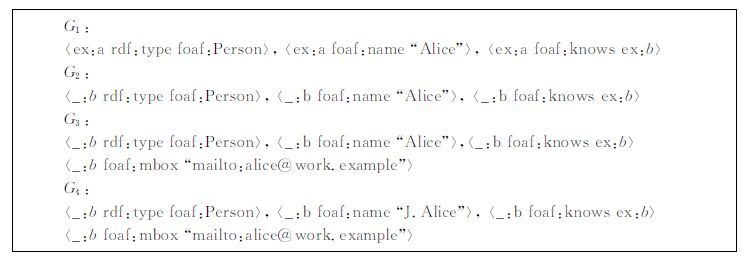

3.3 空节点冗余Linked Data的空节点冗余同样指其中RDF数据集的空节点冗余.空节点在RDF语义中只是作为一个标签来表示某些存在性的事物,因此,当某些具有空节点三元组的RDF数据集内有另外一些相同的三元组(不具备空节点)时,它们所声明的信息会跟其他的三元组产生混淆.例如存在以下三元组集:

|

如 G 1和 G 2同时存在于一个RDF数据集中,根据RDF语义中关于蕴含的定义,G 2空节点中rdf:type、foaf:name、foaf:knows所表示的信息在ex:a对应的rdf:type、foaf:name、foaf:knows中存在,因此,可以认为空白节点 G 2所表达的信息是冗余的.

令 Nb 是数据集中包含空白节点的冗余三元组,Nt 是数据集中三元组的综述,数据集的空节点冗余度为:

| $\text{R}{{\text{B}}_{\text{ration}}}\text{=}\frac{{{N}_{b}}}{{{N}_{t}}}$ | (4) |

如公式(4)数据集的空节点冗余度评价的重点在于寻找那些带空节点的冗余三元组.可以利用数据集间的继承关系来判断空白节点的冗余性,假设 G 1、G 2、G 3和 G 4位于同一个RDF数据集中,根据之前的分析可以判断空白节点 G 2为冗余信息;另外对比 G 1和 G 3,并不能判断ex:a资源中foax:mbox的值是否为 mailto:alice@work.example,因此无法判断 G 1是否包含 G 3;相比之下 G 4中foaf:name属性与 G 1,明显不同,以此可以断定 G 1不包含 G 4.根据这些判断的结果,可以对冗余的空白节点进行排除.文献[41]提出清除RDF数据集中所有的空白节点并没有实现,但是它提出可以通过去除一些包含冗余信息的空节点三元组并将一些空节点映射到URI标识使RDF数据集更加精简.

4 可信性评价方法随着Linked Data的发展和广泛应用,用户对获取到的信息的可信性的需求也越来越高.但是,目前缺少标准的方式去评价和查询Linked Data信息的可信度,使得Linked Data可信性评价方法成为该领域的研究重点.根据用户是否参与可信性评价,可以将Linked Data的可信性分为客观可信性和主观可信性两个方面.

4.1 客观可信性客观可信性指Linked Data内容本身的可信性,可以从Linked Data的排名、来源、第三方机构验证等方面去获取.

众所周知,网页的排名越高其可信性也越高,同样的,Linked Data的排名可作为其可信性的一个重要指标.此外,Linked Data的排名主要根据Linked Data中RDF数据的实体获得.RDF数据的实体间的关系可以看作网页之间的链接,因此可以采用PageRank的思想对RDF数据进行排名.但与网页间的链接关系不同,RDF数据中实体间的链接关系可以分为两种:内部链接,即数据集内部两个实体的关系;外部链接,即实体与另外一个数据集中实体的关系,关系不同会导致链接权重不同.如何确定链接权重是RDF数据排名算法必须考虑的一个重要方面.Delbru等人[42]提出的DING(dataset ranking)算法很好的考虑了这两类关系,DING是针对RDF数据中各个实体的一个排名算法,本质上它是PageRank算法的一个扩展.DING采用一种两层模型对RDF数据中的实体进行排名,第一层为数据集层,第二层为实体层.DING的算法过程可以分为三步:

1) 根据实体层间的外部链接关系得到数据集层中每个数据集的链接关系.然后根据权重公式计算链接权重,权重公式如下:

| ${{\omega }_{\sigma ,i,j}}=\frac{\left| {{L}_{\sigma ,i,j}} \right|}{\sum\limits_{{{L}_{\tau ,i,k}}}^{{}}{\left| {{L}_{\tau ,i,k}} \right|}}\times \log \frac{N}{1+\text{freq}\left( \sigma \right)}$ | (5) |

在公式(5)中,| Lσ,i,j |表示数据集i和j的链接关系 σ ,$\sum\limits_{{{L}_{\tau ,i,k}}}{\left| {{L}_{\tau ,i,k}} \right|}$表示 i 到其他数据集的链接关系的总数,N 表示数据集的总数,freq( σ )表示 σ 在所有数据集中的出现次数.最后结合PageRank思想,根据权重 wσ,i,j 得到数据集的排名公式:

| ${{r}^{k}}\left( {{D}_{j}} \right)=\alpha \sum\limits_{{{L}_{\sigma ,i,j}}}{{{r}^{k-1}}}\left( {{D}_{i}} \right){{\omega }_{\sigma ,i,j}}+\left( 1-\alpha \right)\frac{\left| {{E}_{{{D}_{j}}}} \right|}{\sum{\left| {{E}_{D}} \right|}}$ | (6) |

在公式(6)中,rk ( Dj )表示数据集 Dj 的排名,公式的前半部分表示链接到 Dj 的数据集所贡献的排名,后半部分表示从其余数据集跳转到 Dj 的概率,α 通常根据经验取值0.85.

2) 根据第一步得到的数据集的排名计算实体层中各个数据集实体的排名,采用链接计数的方法,对数据集中的任意一个实体 e ,它的排名为所有出现过它的数据集的排名之和:

| $r\left( j \right)=\sum\limits_{j\in {{D}_{k}}}{r}\left( {{D}_{k}} \right)$ | (7) |

3) 结合第一层的数据集间的排名信息和第二层中的实体排名形成每个实体的排名:

| ${{r}_{g}}\left( e \right)=r\left( e \right)\times r\left( D \right)$ | (8) |

得到RDF数据集中实体的排名后,可以间接得到数据集的排名,例如可以将数据集中所有实体的平均排名作为数据集的排名.

除了RDF数据的排名,RDF数据的来源也能从客观上得到知识Linked Data的可信性.数据的来源信息表示数据的发布者或者发布机构,若数据的来源具有较高的可信度,则它发布的信息也会比较可信.如果结合来源信息判断RDF数据的可信度,那么可信度的结果将会更加准确.如何获得RDF数据的来源信息是评价RDF是否可信的一个重要步骤,根据RDF数据组织信息的特殊性,RDF数据的来源可以通过以下两种方式获得:1) RDF数据中包含dcterms:creator,dcterms:source,dcterms:publisher,foaf:maker等谓语的三元组的宾语信息一般就是该数据的发布者;2) 如果第一种方式无法获得来源,则可以将数据集中所有主语对应的公共域名作为数据的来源.目前有关RDF来源信息的研究较多,它们提出很多来源模型,其中对来源信息分析较为透彻和全面的是Hartig等人[15]提出的来源图模型(简称Hartig模型).通过Hartig模型,既可以得到RDF数据的可信度,也可以得到RDF数据的准确性和实时性.Hartig模型是一个图模型,模型中的信息既包括RDF数据的访问信息,也包括数据的产生性,模型中的节点被分为三类来源信息:行为体(actors)、执行(executions)、产物(artifacts).每一个元素描述明确的来源信息,并且每个元素之间存在一定关系,即图模型的边,例如产物(一般指最终产生的数据集)是行为体的一个执行结果.在一个数据集产生的过程中会涉及到数据创建(执行)、数据创建者(行为体)、数据集(产物)这三个来源元素,这些元素存在各自的属性,如数据创建服务、数据创建设备、创建时间、创建准则等,这些属性反过来会提供更精确的来源信息.通过分析获得RDF数据的来源信息,然后依据Hartig模型构建来源模型,再结合可信性网络,即可从来源信息的角度客观的评价RDF数据的可信度.

另外,当某个数据集由第三方机构验证并推荐,那么该数据集的可信性就高,通常第三方机构可以通过数字签名来验证数据集.Rajabi等人[43]考虑利用PKI原则来获取Linked Data的可信性,该思想主要是通过对数据集的验证和认可来确定数据的可信性.首先,系统建立一个数据信任中心,每个数据集可从该信任中心获取数字证书,数字证书包括了数据集的名称、发布者等信息,用户可以通过数据集的数字证书来验证其可信性.此外,数据集之间进行通信时也需要检验对方的数据证书,如果验证通过,数据集之间就存在一个可信任关系,从而获取安全的解引用.

4.2 主观可信性主观可信度指数据用户主观的认为数据是可信的或者不可信的,例如用户对数据使用的反馈、他人对数据的推荐等.

Richardson等人[44]提出了利用信任网络来获取数据的信任度,该方案让每个用户显式地指定一组他信任的用户,由此产生的信任网络可以递归地用来计算用户对任何与其在同一连接信任图中的其他用户的信任度.这样,每个用户会接收到自己个性化设置的信任列表,与其他人可能完全不同.该方案主要基于递归传播信任,例如,如果A对B的信任值是 u ,而且 B 对 C 的信任值是 v ,那么A对C的信任值由 u 和 v 的函数所得到.因此,基于递归传播信任的思想,如果某个用户USER1对用户USER2的信任值很高,而用户USER2对某个数据资源dataset的信任值很高,那么用户USER1对数据资源dataset的可信度也会较高.

此外,Hartig等人[45]提出了一个信任模型tSPARQL,它将RDF语句与信任值关联起来.tSPARQL给RDF数据中的每个三元组分配一个主观的信任值,信任值是一个在[-1,1]之间的任意值.当信任值是0时,表示用户对数据的可信性不确定;当信任值是正数时,信任值越大则表明用户对数据的可信性越确定,如果信任值等于1则表明用户认为对应的三元组信息是完全正确的;当信任值是负数时,信任值的绝对值越大则表明用户对数据的可信性越不确定,信任值等于-1则表明用户认为对应的三元组信息是完全不正确的.为了方便的描述和获取RDF数据三元组的信任值,tSPARQL添加了TRUST AS和ENSURE TRUST两个从句到SPARQL查询语句中.因此,tSPARQL允许基于RDF的应用以这种简单的方式给RDF数据添加信任值,且用户可以通过tSPARQL模型获取数据的信任值.但是,tSPARQL思想中RDF应用给三元组设置信任值也是基于主观可信性进行分配的.

另外,用户反馈是用户对数据是否信任的最直接体现.当数据提供者在相关系统发布数据时,系统为该数据及数据提供者分配初始信任值.用户在获取数据时,可获取该数据的信任值,并在使用该数据后,可对该数据及数据提供者进行意见反馈或者评分反馈等.系统将反馈信息定期进行处理整合,依据相关算法获取该数据及数据提供者的新信任值,供后续用户使用.目前,通过用户反馈获取相关信息可信度的思想在电商等平台已被成熟使用,我们同样可以将其应用于Linked Data可信度的研究中.

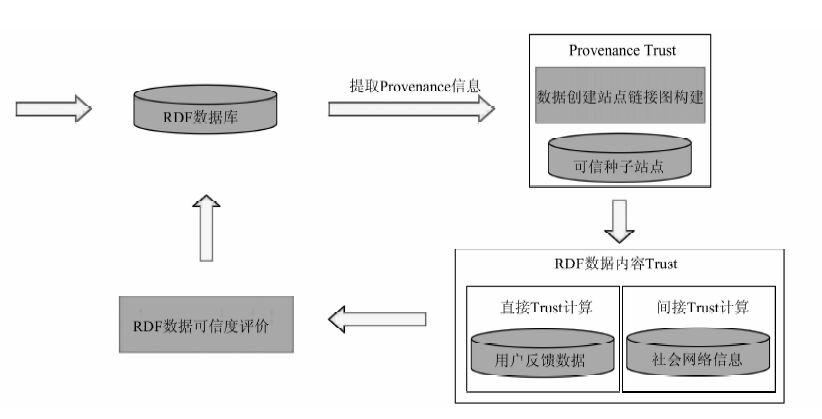

4.3 客观可信性与主观可信性文献[46]结合客观可信度和主观可信度构建了基于Trust的RDF评价模型,并利用RDF中的Provenance URI提取数据创建站点Provenance信息参与Trust计算,最终构建结合Provenance的RDF数据可信度计算模型PTREM,从而帮助用户对RDF数据进行可信度评价.PTREM模型主要包括站点Provenance信息Trust计算模块以及RDF数据内容Trust计算模块.PTREM模型框架如图1所示.

|

| 图 1 TPREM模型框架 Figure 1 TPREM model framework |

PTREM模型构架首先根据PLD(pay-leval domain)提取数据创建站点,计算完所有RDF数据的创建站点信息后,建立这些站点之间的链接图;然后通过预先选择的若干数据创建站点作为可信种子节点,并采用Trust值随路径长度按比例衰减的方式计算每一个数据创建站点的Trust值.在PTREM模型中,RDF数据可信度评价包括两部分,第一部分是计算RDF数据内容的Trust值,第二部分则是计算Provenance Trust值,并采用二者的平均值作为最终的Trust值.其中,RDF数据内容的Trust值又由直接Trust计算和间接Trust计算两部分组成,直接Trust计算利用用户与RDF数据的直接交互经验算出,例如用户反馈数据,而间接Trust计算主要通过Trust推导计算得出,例如社会网络信息.PTREM模型框架对RDF数据可信度评价的计算公式如下所示:

| $\begin{align} & T\left( A,B \right)=\left( \frac{{{T}^{\text{direct}}}\left( A,B \right)+{{T}^{\text{indirect}}}\left( A,B \right)}{2} \right)+ \\ & \text{PT}\left( \left( B.\text{provenance} \right) \right)/2 \\ \end{align}$ | (9) |

其中,T direct( A,B )表示用户 A 对RDF数据 B 的直接Trust值,T indirect( A,B )表示用户 A 对RDF数据 B 的间接Trust值,而PT( B .provenance)则表示RDF数据 B 的Provenance Trust值.

Provenance信息包括数据创建者、数据创建站点、数据发布时间等等,但在PTREM框架中,只采用了数据创建站点作为惟一因素.此外,在计算RDF数据Trust值时,只是简单的使用内容Trust和Provenance Trust的平均值,没有考虑二者的比例.在未来基于Provenance可信度评价的进一步研究中,需要更加全面的考虑Provenance信息,并且利用加权的方式计算最终Trust结果.

5 动态环境下数据波动性分析如2.7节“资源动态性”所述,数据发布后,随着时间的推移,数据集需要保持动态性以适应外界的变化.当一个Linked Data的概念或者关系发生变化后,如何保证其较高的质量是一个需要研究的课题,但目前这个方面尚是一个新的领域,研究Linked Data演化的许多方法对解决这个问题具有十分重要的参考价值,本节将重点介绍波动性分析方法,它对于量化Linked Data的变化是一条可行的实践方式.

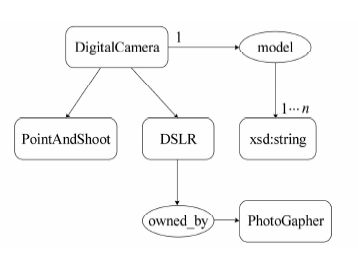

Linked Data中的数据集的主要构成元素分别为类、属性与实例.当数据集中某个元素因外界因素而发生改变时,因为元素间的语义关系,这一变化可能会对非兴趣点(直接发生改变的元素)产生波动影响.如图2所示.

|

| 图 2 本体示例图 Figure 2 An example of ontology |

图2包含信息如下:

1) 存在概念DigitalCamera,PointAndShoot与DSLR是其子概念;

2) DSLR拥有属性owned_by,表示DSLR的拥有者为PhotoGapher;

3) DigitalCamera拥有属性model,同时DigitalCamera拥有至少一种型号.

当外界因用户需求需要对DigitalCamera做出修改时,PointAndShoot与DSLR作为其直接子类必然会受到某种程度的影响.然而现实世界中的数据集庞大而复杂,我们并不能直接如本文中直接看出哪些元素会直接或间接受到兴趣点的波及,从而也无法及时对数据集做出正确的更正.为了方便的分析动态环境下数据的波动性,我们需要了解数据集中各元素间的直接或间接联系.元素间常见语义关系类型[47]如表2所示.

| 关系符号 | 关系表示 | 关系名称 | 复杂度 |

| r equivalent | owl:equivalentClass | 等价关系(概念) | 1 |

| r hyponymy | rdfs:subClassOf | 上下位关系 | 1 |

| r disjoint | owl:disjointWith | 不相交关系 | 1 |

| r complement | owl:complementOf | 互补关系 | 1 |

| r uq | owl:allValuesFrom | 全称量化关系 | 3 |

| r eq | owl:someValuesFrom | 存在量化关系 | 3 |

| r dr | owl:ObjectProperty | 定义域值域关系 | 2 |

| r drf | owl:FunctionalProperty | 函数型定义域值域关系 | 2 |

| r drif | owl:InverseFunctionalProperty | 反函数型定义域值域关系 | 2 |

| r drs | owl:SymmetricProperty | 对称型定义域值域关系 | 2 |

| r drt | owl:TransitiveProperty | 传递型定义域值域关系 | 2 |

| r card | owl:cardinality | 基数值约束关系 | 3 |

| r minCard | owl:minCardinality | 最小基数值约束关系 | 3 |

| r maxCard | owl:maxCardinality | 最大基数值约束关系 | 3 |

| r union | owl:unionOf | 包含关系 | 1 |

| r same | owl:sameAs | 等价关系(概念、实例) | 1 |

| 注:r equivalent和 r same表示的等价关系不同,前者表示类术语之间的等价关系,后者还可用于表示实例之间的等价关系 | |||

相对于一个本体而言,元素变化过程中的所有操作都可由两个基础操作——添加与删除,经过某种组合得到[48];而数据集中的属性的作用主要用于构建不同数据之间的语义关系.因而,我们可以将属性转化为不同数据间的语义关系.

图2中各元素间的关系经分析如下:

1) 元素节点如下:

V 1 =DigitalCamera;

V 2 =PointAndShoot;

V 3 =DSLR;

V 4 =PhotoGapher;

V 5 =xsd:string;

2) 元素关系如下:

〈 V 2 r hyponymy V 1〉;

〈 V 3 r hyponymy V 1〉;

〈 V 1 r minCard V 5〉;

〈 V 3 r dr V 4〉.

根据以上分析可得到 V 1- V 5的邻接矩阵,从而求得其可达矩阵如下:

| $M=\left[ \begin{array}{*{35}{l}} 0 & 1 & 1 & 0 & 0 \\ 0 & 0 & 0 & 0 & 0 \\ 0 & 0 & 0 & 0 & 0 \\ 0 & 0 & 1 & 0 & 0 \\ 1 & 1 & 1 & 0 & 0 \\ \end{array} \right]$ |

在可达矩阵中,非0元素代表列元素对行元素存在依赖关系,即行元素的变化会对列元素产生波及影响.因而可以轻易看出数据集中任一个元素对其他各元素的影响[49].

有了数据集中每个元素对其他元素的波动影响分析结果,当外界触发事件引起变化时,我们便能从中选择代价最小的兴趣点发生改变,从而在一定程度上保证修改数据的性能;同时根据数据集的可达矩阵,我们还能确保质量维度的内容特性,尤其是在兴趣点发生变化时,根据波及路径对数据集做出调整后依然能保证数据的一致性与完整性.

6 质量评价的工具在数据质量评价标准化的发展过程中,很多质量评价方法被提出的同时,研究者也设计了不同的质量评价工具来评价数据质量[13, 18, 23, 29].

Bizer等人[14]提出的WIQA工具需要人工干预,是完全手动的,它的主要目的是使用户基于一定的策略来过滤信息.Mendes等人[24]提出的Sieve也是完全手动的,它需要用户对评价指标分配权限,而且Sieve的最终目的是为了整合数据,质量评价只是整合数据过程的一部分.Flemming[19]提出的数据质量评价工具则需要用户回答关于数据的一系列问题,所以一定程度上需要人工干预,是半自动化的,它的主要目标就是对于发布的RDF数据进行质量评价;Hogan等人[3]则使用不同的检验器来检测数据的不同问题,例如使用W3C RDF 检验器检测语法错误、Vapour 检验器检测协议问题,还包括了一些命令行检测器,如使用Validating RDF Parser来检测语法问题.他们通过这种检验数据错误的方式来评价数据质量.此外,Guéret等人[30]提出的LINK-QA会自动的从Web上选择资源(例如SPARQL端点或者解引用的资源)作为输入,并生成质量评价报告.LINK-QA没有人工干预,所以是完全自动化的,但它需要用户在一定程度上掌握相关知识.本文对上述5种工具从提出的时间、自动化程度、支持的质量维度进行比较,如表3所示.

| 工具 | 时间 | 评价维度 | 自动化程度 |

| WIQA | 2009 | consistency,volatility,completeness,timeliness,accuracy,amount-of-data,availability,relevancy,interpretability,understandability,verifiability,security,reputation,licensing,objectivity,believability,response-time,versatility | 手动 |

| Flemming’s tool | 2010 | provenance,consistency,timeliness,amount-of-data,availability,versatility,understandability,verifiability,validity | 半自动 |

| RDFValidator | 2010 | consistency,completeness | 半自动 |

| LINK-QA | 2012 | completeness,interlinking | 自动 |

| Sieve | 2012 | consistency,currency,completeness, reputation,conciseness | 手动 |

下面,我们将详细讨论两种数据质量评价工具:Flemming的数据质量评价工具(http://sourceforge.net/apps/mediawiki/trdf/index.php?title=Quality_Criteria_for_Linked_D ata_sources)和Sieve[24].

6.1 Flemming的数据质量评价工具Flemming的数据质量评价工具是一个简单的用户界面.首先,用户需要在该界面输入数据集的详细信息(例如名称、URI和对应某个资源的3个实体),并且给每个预设定的质量维度分配一个权重.分配权重时可以给每个指标都分配1,或者根据数据资源对该维度设定的示范值来分配.在下一步中,用户需要回答与数据集相关的问题,这些问题不能被量化计算但对数据质量非常重要.然后,该工具会向用户展示一个质量维度的列表,并且每个质量维度指标会有对应的权重和计算值.最后,用户就可以得到该数据集的得分,得分是在0到100之间的数,分数越高,说明数据质量越好.

Flemming的数据质量评价工具的每一个步骤都非常清晰,并且问题也是列表的格式,用户使用的时候非常简单便捷.另外,每个质量维度的权重分配和计算非常直接而且容易调整.但是,该工具的使用者为了对每个质量维度指标正确的分配权重,必须对数据集有一定的了解.此外,不能全面考虑和计算那些非常重要但又不能被量化的质量维度,如准确性、一致性、简洁性等,由此导致它得到的质量分数的真实性不高.

6.2 SieveSieve是Linked Data整合框架(LDIF,Linked Data Integration Framework)的一个模块,它可以通过开源Scala API为用户的应用程序而定制,还可以通过配置参数来描述用户的具体任务需求.Sieve包括一个质量评价模块和一个数据整合模块.其中,以用户选择的元数据为指标,质量评价模块可以根据用户配置的评分函数来获取质量评价分数.数据整合模块能够根据质量分数解决冲突任务.

Sieve输入数据资源对应的元数据图,用户再根据此信息设置一个XML文件的配置属性,称为integration properties.数据质量产生的过程依赖于用户选择的衡量指标,每个指标对应一个评分函数,该函数的值等于0到1之间的数.Sieve只提供了几个评分函数(例如TimeCloseness、Preference),根据用户输入的数据信息来计算函数值.另外,整合函数(例如Filter、Average、Max、Min、First、Last、Random)使用输出的分数来整合资源.

Sieve主要用于整合资源而不是评价数据质量,数据质量评价部分只是整合数据过程的一个附件.此外,Sieve没有提供用户界面,用户必须掌握编程技能.

数据质量评价工具只能产生一份关于数据质量的评价报告,为用户对数据的使用与否提供意见,但是并不能解决数据的质量问题.所以,为了提高数据的使用性,Beek等人[50]提出了LOD Lanundromat(Linked Open Data清洗器),它是完全自动化的,可以处理数据的语法、重声明等问题,以提高数据的可用性.

7 结论与展望随着人工智能和大数据技术应用的不断深入,知识图谱越来越受到关注,一方面,知识图谱逐渐从提高搜索质量这一开放领域逐渐扩展至一些专有领域的应用,例如医学辅助决策、工业与物联网等、情报分析、知识发现与知识服务等;另一方面,知识图谱成为深度学习之外的另一个促进人工智能和大数据深入应用的引擎.同时,大数据通过采集、清洗、分析与发现之后最终的结果也大多以知识图谱的形式呈现.鉴于Linked Data质量在知识图谱中所起的作用,本文首先回顾了Linked Data质量评价的相关研究,分析了现有的数据质量评价维度、框架和数据发布指南.然后,根据Linked Data的发展过程,将衡量数据质量的维度划分为可信性、资源描述、冗余性、实用性、可访问性、内容特性和资源动态性,得到一个全面、清晰、具体的质量维度列表,并分别描述了每个数据质量维度特性.本文也着重分析了冗余度评价方法,分别从结构冗余、语义冗余和空节点冗余三个方面进行了分析.另外,我们还介绍了Linked Data的波动性分析方法,对评估Linked Data动态环境下的质量有重要性意义.最后,我们介绍几种数据质量评价工具,并从自动化、评价维度等角度进行比较.

研究数据质量评价维度和方法的目的就是解决数据质量问题,所以,Linked Data质量评价研究的新方向是利用数据质量评价报告有针对性的对已污染的数据进行清洗和修复.本文的目的是为了帮助相关研究者全面了解评价的现有工作,以促进Linked Data质量研究工作的进一步发展.在未来的工作中,作者将从以下几个方面对Linked Data质量评价工作展开研究:1) 冗余性量化计算;2) 动态环境下的Linked Data质量;3) 数据清洗和修复.

我们希望Linked Data质量评价的这些研究可以有助于用户对数据使用的选择性,包括数据发布者以此为基础和准则发布高质量的数据,以推动Linked Data的发展,使语义搜索更自动化.

| [1] | SINGHAL A. Introducing the Knowledge Graph: Things, Not Strings [EB/OL]. [2016-03-22]. https://googleblog.blogspot.jp/2012/05/introducing-knowledge-graph-things-not.html. |

| [2] | BERNERS-LEE T. Design Issues for the World Wide Web[EB/OL]. [2006-07-27].https://www.w3.org/DesignIssues/LinkedData.html. |

| [3] | HOGAN A, HARTH A, PASSANT A,et al. Weaving the Pedantic Web[DB/OL]. [2016-04-06]. http://events.linkeddata.org/ldow2010/papers/ldow 2010_paper04.pdf. |

| [4] | JURAN J. Quality Control Handbook[M]. New York: McGraw-Hill Higher Education, 1974. |

| [5] | WANG R Y, STRONG D M. Beyond accuracy: what data quality means to data consumers[J]. Journal of Management Information Systems, 1996, 12(4) : 5–33. DOI:10.1080/07421222.1996.11518099 |

| [6] | KNIGHT S A, BURN J M. Developing a framework for assessing information quality on the world wide web[J]. Informing Science, 2005, 8 : 159–172. |

| [7] | BATINI C, SCANNAPIECO M. Data Quality: Concepts, Methodologies and Techniques[M]. New York: Springer Publishing Company, 2006. |

| [8] | HEATH T, HAUSENBLAS M, BIZER C,et al. How to Publish Linked Data on the Web[DB/OL].[2016-04-09]. http://events.linkeddata.org/iswc2008 tutorial/how-to-publish-linked-data-iswc 2008-slides.pdf. |

| [9] | HOGAN A, UMBRICH J, HAUTH A, et al. An empirical survey of linked data conformance[J]. Journal of Web Semantics: Science, Services and Agents on the World Wide Web, 2012, 14(3) : 14–44. DOI:10.1016/j.websem.2012.02.001 |

| [10] | KANDARI J. Information quality on the world wide web: A user perspective [DB/OL] [2016-03-23]. http//digitial-commons.unl. edu/cgi/view cantent.cgi?article=1017 & context=imsediss. |

| [11] | ASSAF A, SENART A. Data quality principles in the semantic web[C]//2012 IEEE Sixth International Conference on Semantic Computing. New York: IEEE Press 2012: 226-229. DOI: 10.1109/ICSC.2012.39. |

| [12] | ZAVERI A, RULA A, MAURINO A,et al. Quality Assessment Methodologies for Linked Open Data[DB/OL]. [2016-06-23] https://www.researchgate.net/publication/235912899_Quality_Assessment_Methodologies_for_Linked_Open_Data. |

| [13] | MA Y, QI G. An analysis of data quality in DBpedia and zhishi.me[C]//Linked Data and Knowledge Graph. Berlin: Springer-Verlag, 2013: 106-117. DOI: 10.1007/978-3-642-54025-7_10. |

| [14] | BIZER C, CYGANIAK R. Quality-driven information filtering using the WIQA policy framework[J]. Web Semantics: Science, Services and Agents on the World Wide Web, 2009, 7(1) : 1–10. DOI:10.1016/j.websem.2008.02.005 |

| [15] | HARTIG O. Provenance Information in the Web of Data[DB/OL]. [2016-05-11].http://www.ceur-ws.org/Vol-538/ldow2009_paper18.pdf. |

| [16] | GIL Y, ARTZ D. Towards content trust of web resources[J]. Web Semantics: Science, Services and Agents on the World Wide Web, 2007, 5(4) : 227–239. DOI:10.1145/1135777.1135861 |

| [17] | BIZER C. Quality-Driven Information Filtering in the Context of Web-based Information Systems[M]. Saarbrücken: VDM Verlag, 2007. |

| [18] | JACOBI I, KAGAL L, KHANDELWAL A. Rule-Based Trust Assessment on the Semantic Web[DB/OL]. [2016-06-23]. http://www.defeasible.org/ruleml2011ijcai/files/Khandelwal.pdf. |

| [19] | FLEMMINGA. Quality Characteristics of Linked Data Publishing Datasources[D]. Berlin: Humboldt-Universittzu, 2010. |

| [20] | CARROLL J J. Signing RDF Graphs[DB/OL]. [2016-06-23].http://www.hpl.hp.com/techreports/2003/HPL-2003-142.pdf. |

| [21] | MILLER P, STYLES R, HEATH T. Open Data Commons, a License for Open Data[DB/OL]. [2016-05-11].http://www.ceur-ws.org/Vol-369/paper08.pdf. |

| [22] | POPITSCH N P, HASLHOFER B. DSNotify: handling broken links in the web of data[C]//Proceedings of the 19th International Conference on World Wide Web. New York: ACM, 2010: 761-770. DOI: 10.1145/1772690.1772768. |

| [23] | MALLEA A, ARENAS M, HOGAN A,et al. On blank nodes[C]. The Semantic Web-ISWC 2011. Berlin: Springer-Verlag, 2011:421-437. |

| [24] | MENDES P N, MVHLEISEN H, BIZER C. Sieve: Linked data quality assessment and fusion[C]// Proceedings of the 2012 Joint EDBT/ICDT Workshops. New York: ACM, 2012:116-123. |

| [25] | FVRBER C, HEPP M. Swiqa-A Semantic Web Information Quality Assessment Framework[DB/OL]. [2016-02-11]. http://xueshu.baidu.com/s?wd=paperuri%3A%289e9889f98c579cbbfda1f2f76f59768c%29&filter= sc_long_sign&tn=SE_xueshusource_2kduw22v & sc_vurl=http%3A%2F%2Fciteseerx. ist.psu.edu%2Fviewdoc%2Fdownload%3 Bjsessionid% 3DD925 2780874 DB1730A6E546515 955270% 3Fdoi%3D10.1.1.417.6788%26rep%3Drep1%26type%3Dpdf&ie=utf-8&sc_us=14357118553 70981076. |

| [26] | BERRUETAD, PHIPPSJ, MILESA,et al. Best Practice Recipes for Publishing RDF Vocabularies[DB/OL]. [2016-03-25]. https://www.w3.org/TR/swbp- vocab-pub/#ack. |

| [27] | WU H, VILLAZON-TERRAZAS B, PAN J Z,et al. How Redundant Is It?——An Empirical Analysis on Linked Datasets[DB/OL]. [2016-04-03]. https://www.researchgate.net/publication/289653017_How_redundant_is_it-An_empirical_analysis_on_linked_datasets. |

| [28] | RUAN T, LI Y, WANG H, et al. From Queriability to Informativity, Assessing “Quality in Use” of DBpedia and YAGO[DB/OL]. [2016-05-10]. http://link.springer.com/chapter/10.1007/978-3-319-3 4129-3_4. DOI: 10.1007/978-3-319-34129-3_4. |

| [29] | MöLLER K, HAUSENBLAS M, CYGANIAK R,et al. Learning from Linked Open Data Usage: Patterns & Metrics[DB/OL]. [2016-05-12]. http://richard.cyganiak.de/2008/papers/lod-usage-websci2010.pdf. |

| [30] | GUÉRET C, GROTH P, STADLER C,et al. Assessing linked data mappings using network measures[C]//The Semantic Web: Research and Applications. Berlin: Springer-Verlag, 2012:87-102. DOI: 10.1007/978-3-642-30284-8_13. |

| [31] | LEI Y, UREN V, MOTTA E. A framework for evaluating semantic metadata[C]//Proceedings of the 4th International Conference on Knowledge Capture. New York: ACM, 2007:135-142. |

| [32] | CHEN P, GARCIA W. Hypothesis generation and data quality assessment through association mining[C]//Cognitive Informatics (ICCI), 2010 9th IEEE International Conference. Washington D C: IEEE, 2010: 659-666. DOI: 10.1109/COGINF.2010.5599828. |

| [33] | HASLHOFER B, POPITSCH N. DSNotify-detecting and fixing broken links in linked data sets[C]//Database and Expert Systems Application. Washington D C:IEEE Computer Society. 2009: 89-93. DOI: 10.1109/DEXA.2009.13. |

| [34] | DING L, SHINAVIER J, FININ T,et al. owl: SameAs and Linked Data: An Empirical Study[DB/OL]. [2016-04-22] . http://journal.webscience.org/403/2/websci10_submission_123.pdf. |

| [35] | DING L, SHINAVIER J, SHANGGUAN Z,et al. SameAs networks and beyond: Analyzing deployment status and implications of owl: SameAs in linked data[C]//The Semantic Web-ISWC 2010. Berlin: Springer-Verlag, 2010: 145-160. DOI: 10.1007/978-3-642-17746-0_10. |

| [36] | UMBRICH J, HAUSENBLAS M, HOGAN A,et al. Towards Dataset Dynamics: Change Frequency of Linked Open Data Sources[DB/OL]. [2016-03-12]. https://aic.ai.wu.ac.at/~polleres/publications/umbr-etal-2010.pdf. |

| [37] | FERNÁNDEZ J D, MARTÍNEZ-PRIETO M A, GUTIÉRREZ C, et al. Binary RDF representation for publication and exchange (HDT)[J]. Web Semantics: Science, Services and Agents on the World Wide Web, 2013, 19(1) : 22–41. DOI:10.1016/j.websem.2013.01.002 |

| [38] | LVAREZ-GARCAS, BRISABOAN, FERNN-DEZ J D, 等. Compressed vertical partitioning for efficient RDF management[J]. Knowledge and Information Systems, 2015, 44(2) : 439–474. DOI:10.1007/s10115-014-0770-y |

| [39] | JOSHI A K, HITZLER P, DONG G. Logical linked data compression[C]//The Semantic Web: Semantics and Big Data. Berlin: Springer-Verlag, 2013: 170-184. DOI: 10.1007/978-3-642-38288-8_12. |

| [40] | PAN J Z, PÉREZ J M G, REN Y,et al. Graph pattern based RDF data compression[C]//Semantic Technology. Cham: Springer International Publishing. 2014: 239-256. DOI: 10.1007/978-3-319-15615-6_18. |

| [41] | CHEN L, ZHANG H, CHEN Y, et al. Blank nodes in RDF[J]. Journal of Software, 2012, 7(9) : 1993–1999. |

| [42] | DELBRU R, TOUPIKOV N, CATASTA M,et al. Hierarchical link analysis for ranking web data[C]//The Semantic Web: Research and Applications. Berlin: Springer-Verlag, 2010:225-239. DOI: 10.1007/978-3-642-13489-0_16. |

| [43] | RAJABI E, KAHANI M, SICILIA M A. Trustworthiness of Linked Data Using PKI[DB/OL]. [2016-03-25].http://www2012.org/proceedings/webscience/wwwwebsci2012_rajabi.pdf. |

| [44] | RICHARDSON M, AGRAWAL R, DOMINGOS P. Trust management for the semantic web[C]//The Semantic Web-ISWC 2003. Berlin:Springer-Verlag, 2003: 351-368. DOI: 10.1007/978-3-540-39718-2_23. |

| [45] | HARTIG O. Querying trust in RDF data with tSPARQL[C]//The Semantic Web: Research and Applications. Berlin: Springer-Verlag, 2009:5-20. DOI: 10.1007/978-3-642-02121-3_5. |

| [46] | 曹如进. 一个结合Provenance和语义社会网络的RDF数据可信评价模型[D]. 南京:东南大学, 2011. CAO R J. A RDF Data Trust Evaluation Model Based on Provenance and Semantic Social Network[D]. Nanjing: Southeast University, 2011(Ch). |

| [47] | 张祥, 李星, 温韵清, 等. 语义网虚拟本体构建[J]. 东南大学学报(自然科学版), 2015, 45(4) : 652–656. ZHANG X, LI X, WEN Y Q, et al. Building virtual ontologies in semantic web[J]. Journal of Southeast University (Natural Science Edition), 2015, 45(4) : 652–656(Ch). DOI:10.3969/j.issn.1001-0505,2015.04.007(Ch) |

| [48] | 刘晨, 韩燕波, 陈旺虎, 等. MINI——一种可减小变更影响范围的本体演化算法[J]. 计算机学报, 2008, 31(5) : 711–720. LIU C, HAN Y B, CHEN W H, et al. MINI:An ontology evolution algorithm for reducing impact ranges[J]. Chinese Journal of Computers, 2008, 31(5) : 711–720(Ch). |

| [49] | LV Q Y, ZHANG Y P, GU J G. The Analysis for Ripple-Effect of Ontology Evolution Based on Graph[DB/OL]. [2016-04-22]. http://link.sp ringer.com/chapter/10.1007/978-3-319-42089-9_19. DOI: 10.1007/978-3-319-42089-9_19. |

| [50] | BEEK W, RIETVELD L, BAZOOBANDI H R,et al. LOD Laundromat: A uniform way of publishing other people’s dirty data[C]//The Semantic Web-ISWC 2014. Cham: Springer International Publishing, 2014:213-228. DOI: 10.1007/978-3-319-11964-9_14. |

2017, Vol. 63

2017, Vol. 63